使用LVS和Squid构建代理服务器集群系统_薛建

第3单元 Squid代理服务的配置与应用

Squid代理服务的安装 Red Hat Enterprise Linux 6安装程序默认没 有安装Squid服务,可以使用下面的命令。

yum install “squid*” rpm -ivh squid-xxxx.rpm

配置文件:/etc/squid/squid.conf 启动脚本:squid 代理Web服务的默认端口为:3128

代理服务器的原理 代理服务器将Internet上主机的回应信息传送给 客户端A。 客户端B向代理服务器提出相同的请求。代理 服务器也首先与访问控制列表中的访问规则相 对照。 如果满足规则,则将缓存中的信息传送给客户 端B。

Squid简介 Squid是Linux和UNIX平台下最为流行的高性能 免费应用层代理服务器,它具有权限管理灵活 、性能高和效率快等特点。 Squid是一个由众多在互联网上的开发人员共同 努力而完成的一款高性能的代理缓冲服务器。 Squid的另一个优越性在于它使用访问控制列表 (ACL)和访问权限列表(ARL)进行权限管 理和内容过滤,这样可阻止特定的网络连接来 减少潜在的Internet非法连接,可以使用这些清 单来确保内部网的主机无法访问有威胁的或限 制访问不适宜的站点。

共享网络 加快访问速度,节约通信带宽 防止内部主机受到攻击 限制用户访问,完善网络管理

代理服务器的理

客户端A向代理服务器提出访问Internet的请求 。 代理服务器接受到请求后,首先与访问控制列 表中的访问规则相对照,如果满足规则,则在 缓存中查找是否存在需要的信息。 如果缓存中存在客户端A需要的信息,则将信 息传送给客户端。如果不存在,代理服务器就 代替客户端向Internet上的主机请求指定的信息 。 Internet上的主机将代理服务器的请求信息发送 到代理服务器中,同时代理服务会将信息存入 缓存中。

自己动手架设代理服务器

自己动手架设代理服务器代理服务器是一种在网络通信中起到中转作用的服务器。

它可以代替客户端向目标服务器发送请求,并将目标服务器的响应返回给客户端。

通过代理服务器,我们可以隐藏真实的客户端IP地址,提高连接速度,并且可以访问一些受限制的内容。

接下来,你需要选择适合的代理服务器软件。

常用的代理服务器软件有Squid、Nginx、Shadowsocks等。

这些软件各有不同的特点和配置方法,你可以根据自己的需求选择合适的软件。

以Squid为例,下面是搭建代理服务器的具体步骤:第二步,启动Squid服务。

在Linux系统上,你可以使用以下命令启动Squid服务:```sudo service squid start```在Windows系统上,你可以在安装目录中找到Squid的启动程序,并双击运行。

第三步,配置客户端代理。

在浏览器中配置代理,让浏览器使用你搭建的代理服务器访问互联网。

通常情况下,你需要设置代理服务器的IP地址和端口号。

具体操作方法可以参考浏览器的帮助文档。

使用代理服务器需要注意以下几点:首先,代理服务器的稳定性和性能是关键。

你需要选择高质量的机器和软件,并且及时进行服务器维护和升级。

其次,代理服务器有可能被滥用,用于非法活动,如攻击其他服务器、传播违法信息等。

所以,你需要设置访问控制策略,限制代理服务器的使用范围,并及时更新代理服务器的黑名单。

最后,代理服务器还可能会受到网络层面的限制,如被运营商封锁。

在使用代理服务器时,你需要留意这些限制,并尝试使用其他代理服务器或更换代理服务器的IP地址。

RHEL版项目防火墙与squid代理服务器的搭建

2019年1月29日星期二

Linux网络操作系统配置与管理

第2 页

14.2 项目知识准备

14.2.1 认识防火墙(firewall)

1.什么是防火墙

防火墙——是指设置在不同网络(如可信任的企业内部网和不可信的 公共网)或网络安全域之间的一系列部件的组合。 它是不同网络或网络安全域之间信息的唯一出入口,能根据企业的安 全策略控制(允许、拒绝、监测)出入网络的信息流,且本身具有较强 的抗攻击能力。 在逻辑上,防火墙是一个分离器、限制器和分析器,它能有效地监控内 部网和Internet之间的任何活动,保证了内部网络的安全。

表→链→规则的分层结构来组织规则

②iptables: 是Linux系统为用户提供的管理netfilter的一种工具,是编辑、 修改防火墙(过滤)规则的编辑器 通过这些规则及其他配置,告诉内核的netfilter对来自某些源、 前往某些目的地或具有某些协议类型的数据包如何处理。 这些规则会保存在内核空间之中。

2019年1月29日星期二

Linux网络操作系统配置与管理

第7 页

14.2.2 Linux防火墙概述

2.Linux防火墙的架构

Linux防火墙系统由以下两个组件组成: ①netfilter: netfilter是集成在内核中的一部分 作用是定义、保存相应的过滤规则。 提供了一系列的表,每个表由若干个链组成,而每条链可以由一 条或若干条规则组成。 netfilter是表的容器,表是链的容器,而链又是规则的容器。

项目14 防火墙与squid代理服务器的搭建

【职业知识目标】

了解:防火墙的基本概念、分类与作用;Squid代理服务 器的分类及特点 熟悉:Linux防火墙的架构及包过滤的匹配流程 掌握:iptables命令的格式和使用;NAT的配置方法; 会安装iptables软件包; 能使用iptables命令设置包过滤规则 会配置NAT服务 会安装Squid软件包 会架设普通代理、透明代理和反向代理服务器 会在客户端测试iptables和Squid的配置情况

ipvsadm -lnc的原理 -回复

ipvsadm -lnc的原理-回复IPVS(Internet Protocol Virtual Server)是一个组件,它允许在Linux 系统上实现负载均衡服务。

IPVS是通过ipvsadm工具来配置的,而ipvsadm工具的原理是基于LVS(Linux Virtual Server)的核心实现原理。

本文将详细解析ipvsadm lnc的原理。

1. LVS的概述LVS是一个开源的负载均衡软件,它的核心理念是将来自客户端的请求分发到一组后端服务器上,以实现流量的均衡分配。

LVS提供了多种负载均衡算法,包括轮询、加权轮询、最少连接等,以适应不同应用场景的需求。

2. IPVS的工作原理IPVS是LVS的内核部分,它通过在内核中创建虚拟服务器来实现负载均衡服务。

IPVS根据配置的负载均衡算法和后端服务器的状态信息,将客户端请求转发给最合适的后端服务器。

具体来说,IPVS的工作原理如下:- IPVS在内核空间中创建一个虚拟服务器,该虚拟服务器拥有独立的IP地址和端口号。

- 当客户端发送请求到虚拟服务器的IP地址和端口号时,该请求会被IPVS捕获。

- IPVS根据配置的负载均衡算法,选择一个后端服务器,并将请求转发给后端服务器。

- 后端服务器接收到请求后,处理该请求并返回响应给客户端。

3. ipvsadm工具的原理ipvsadm是一个命令行工具,用于配置IPVS的虚拟服务器、后端服务器和负载均衡算法等参数。

ipvsadm工具通过和内核进行交互,将配置信息传递给IPVS,并将其应用到实际的网络流量中。

ipvsadm工具的工作原理如下:- ipvsadm工具通过命令行参数指定需要配置的虚拟服务器、后端服务器和负载均衡算法等参数。

- ipvsadm与内核进行通信,将配置信息传递给内核中的IPVS。

- 内核根据ipvsadm提供的配置信息,更新IPVS的虚拟服务器和后端服务器表。

- 当有客户端请求到达时,IPVS根据配置的负载均衡算法选择一个后端服务器,并将请求转发给后端服务器。

linux--squid服务器的配置

一linux--squid服务器的配置[日期:2007-11-20] 来源:活力网路技术互动中心吴康[字体:大中小]squid代理服务由一台拥有标准IP地址的机器代替若干没有标准IP地址的机器和Internet上的其它主机打交道.squid工作机制与基本功能工作机制代理服务器有何优点1.快速的存取由于它是先将网页下载到本地使用,因此访问频率越高的站点速度就会越快。

2.降低网络的费用.Squid是Linux下最为流行的代理服务器软件,它功能强大。

Squid的做为代理服务器,性能远远超过WINNT加MSPROXY2.0,为几百人的小型局域网代理绰绰有余。

3, Squid配置参数squid的配置文件/etc/squid/squid.conf1. _port 10.10.10.1:31282.cache_mem指定squid可以使用的存理想值,建议设为存的1/3.3 cache_dir ufs /var/spool/squid 100 16 256定义硬盘缓存空间.4.简单的代理Squid 访问控制的两个要素例如:允许10.0.0.0/8的网段能上网,#vi /etc/squid/squid.confacl god src 192.168.100.0/24(1818行)_access allow god(1860行)ACL格式:acl 列表名称控制方式控制目标acl god src x.x.x.x/24控制方式src : 源地址(即客户机IP地址)dst : 目标地址(即服务器IP地址)srcdomain : 源名称dstdomain : 目标名称time : 时间url_regex : URL 规则表达式匹配例-根据ip控制A,只允许10.0.0.0/8的客户用代理.#vi /etc/squid/squid.confacl god src 10.0.0.0/8_access allow god在 _access deny all这一行前面添加B,多个ip时,可以建立一个脚本再设它的路径acl good src "/etc/squid/authorizedip.txt“C,根据时间控制time 参数S - Sunday,M - Monday,T - Tuesday,W - Wednesday,H - Thursday,F - FridayA - Saturday,例--控制部分客户机时间只允许10.0.0.0/8的客户在上班时间用代理,其他一律禁止。

Linux服务器集群系统――LVS(Linux Virtual Server)项目

背景当今计算机技术已进入以网络为中心的计算时期。

由于客户/服务器模型的简单性、易管理性和易维护性,客户/服务器计算模式在网上被大量采用。

在九十年代中期,万维网(World Wide Web)的出现以其简单操作方式将图文并茂的网上信息带给普通大众,Web也正在从一种内容发送机制成为一种服务平台,大量的服务和应用(如新闻服务、网上银行、电子商务等)都是围绕着Web进行。

这促进Internet用户剧烈增长和Internet流量爆炸式地增长,图1显示了1995至2000年与Internet连接主机数的变化情况,可见增长趋势较以往更迅猛。

Internet的飞速发展给网络带宽和服务器带来巨大的挑战。

从网络技术的发展来看,网络带宽的增长远高于处理器速度和内存访问速度的增长,如100M Ethernet、A TM、Gigabit Ethernet等不断地涌现,10Gigabit Ethernet即将就绪,在主干网上密集波分复用(DWDM)将成为宽带IP的主流技术[2,3],Lucent已经推出在一根光纤跑800Gigabit的WaveStar?OLS800G 产品[4]。

所以,我们深信越来越多的瓶颈会出现在服务器端。

很多研究显示Gigabit Ethernet 在服务器上很难使得其吞吐率达到1Gb/s的原因是协议栈(TCP/IP)和操作系统的低效,以及处理器的低效,这需要对协议的处理方法、操作系统的调度和IO的处理作更深入的研究。

在高速网络上,重新设计单台服务器上的网络服务程序也是个重要课题。

比较热门的站点会吸引前所未有的访问流量,例如根据Yahoo的新闻发布,Yahoo已经每天发送6.25亿页面。

一些网络服务也收到巨额的流量,如American Online的Web Cache 系统每天处理50.2亿个用户访问Web的请求,每个请求的平均响应长度为5.5Kbytes。

与此同时,很多网络服务因为访问次数爆炸式地增长而不堪重负,不能及时处理用户的请求,导致用户进行长时间的等待,大大降低了服务质量。

如何配置LVSNAT、LVSTUN、LVSDR方式的负载均衡集群

如何配置LVS/NAT、LVS/TUN、LVS/DR方式的负载均衡集群2010年10月28日星期四下午 02:29转载自yupanlovehlq最终编辑yupanlovehlq实例理解了上述关于请求转发方式和调度算法的基本概念后,就可以运用LVS来具体实现几种不同方式的负载均衡的集群系统。

LVS的配置是通过前面所安装的IP虚拟服务器软件ipvsadm来实现的。

ipvsadm与LVS的关系类似于 iptables和NetFilter的关系,前者只是一个建立和修改规则的工具,这些命令的作用在系统重新启动后就消失了,所以应该将这些命令写到一个脚本里,然后让它在系统启动后自动执行。

网上有不少配置LVS的工具,有的甚至可以自动生成脚本。

但是自己手工编写有助于更深入地了解,所以本文的安装没有利用其它第三方提供的脚本,而是纯粹使用ipvsadm命令来配置。

下面就介绍一下如何配置LVS/NAT、LVS/TUN、LVS/DR方式的负载均衡集群。

1.设定LVS/NAT方式的负载均衡集群NAT是指Network Address Translation,它的转发流程是:Director机器收到外界请求,改写数据包的目标地址,按相应的调度算法将其发送到相应Real Server上,Real Server处理完该请求后,将结果数据包返回到其默认网关,即Director机器上,Director机器再改写数据包的源地址,最后将其返回给外界。

这样就完成一次负载调度。

构架一个最简单的LVS/NAT方式的负载均衡集群如图2所示。

图2 LVS/NAT方式的集群简图Real Server可以是任何的操作系统,而且无需做任何特殊的设定,惟一要做的就是将其默认网关指向Director机器。

Real Server可以使用局域网的内部IP(192.168.0.0/24)。

Director要有两块网卡,一块网卡绑定一个外部IP地址 (10.0.0.1),另一块网卡绑定局域网的内部IP(192.168.0.254),作为Real Server的默认网关。

Linux服务器集群系统之LVS集群的体系结构

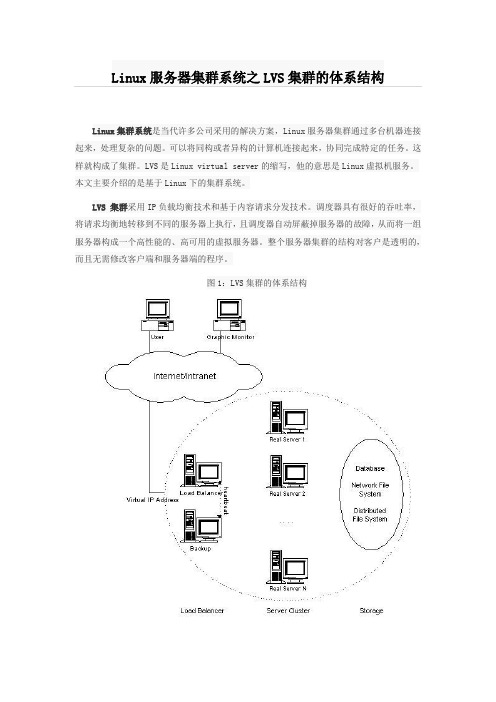

Linux集群系统是当代许多公司采用的解决方案,Linux服务器集群通过多台机器连接起来,处理复杂的问题。

可以将同构或者异构的计算机连接起来,协同完成特定的任务。

这样就构成了集群。

LVS是Linux virtual server的缩写,他的意思是Linux虚拟机服务。

本文主要介绍的是基于Linux下的集群系统。

LVS 集群采用IP负载均衡技术和基于内容请求分发技术。

调度器具有很好的吞吐率,将请求均衡地转移到不同的服务器上执行,且调度器自动屏蔽掉服务器的故障,从而将一组服务器构成一个高性能的、高可用的虚拟服务器。

整个服务器集群的结构对客户是透明的,而且无需修改客户端和服务器端的程序。

图1:LVS集群的体系结构为此,在设计时需要考虑系统的透明性、可伸缩性、高可用性和易管理性。

一般来说,LVS集群采用三层结构,其体系结构如图1所示,三层主要组成部分为:负载调度器(load balancer),它是整个集群对外面的前端机,负责将客户的请求发送到一组服务器上执行,而客户认为服务是来自一个IP地址(我们可称之为虚拟IP地址)上的。

服务器池(server pool),是一组真正执行客户请求的服务器,执行的服务有WEB、MAIL、FTP和DNS等。

共享存储(shared storage),它为服务器池提供一个共享的存储区,这样很容易使得服务器池拥有相同的内容,提供相同的服务。

调度器是服务器集群系统的唯一入口点(Single Entry Point),它可以采用IP负载均衡技术、基于内容请求分发技术或者两者相结合。

在IP负载均衡技术中,需要服务器池拥有相同的内容提供相同的服务。

当客户请求到达时,调度器只根据服务器负载情况和设定的调度算法从服务器池中选出一个服务器,将该请求转发到选出的服务器,并记录这个调度;当这个请求的其他报文到达,也会被转发到前面选出的服务器。

在基于内容请求分发技术中,服务器可以提供不同的服务,当客户请求到达时,调度器可根据请求的内容选择服务器执行请求。

Squid代理配置

Squid透明代理手记1,首先从下载squid-2.6.STABLE10-20070315.tar.gz最新版2,解压配置编译参数:./configure --prefix=/usr/local/squid #指定squid安装目录--mandir=/usr/share/man #指定man的安装目录--enable-async-io=20 #采用同步io提高性能,负载高可设大点--disable-icmp #禁止icmp协议代理(默认不允许)--enable-delay-pools #允许延迟限止带宽--enable-cache-digests #允许缓存摘要,可以加快请求缓冲内容的速度(集群用)--enable-snmp #允许snmp协议支持(如用mrtg进行流量监控等)--disable-ident-lookups #禁止使用RFC931识别--enable-epoll #支持epoll的IO模式,2.6以上内核才具有--enable-basic-auth-helpers="NCSA" #允许带密码验证,NCSA 风格的用户名和密码档--enable-linux-netfilter #允许透明代理--enable-arp-acl #允许基于MAC地址的存取过滤--enable-err-language="Simplify_Chinese" #支持的错误语言--enable-default-err-language="Simplify_Chinese" #指定默认的错误语言3,编译安装:make && make install4,添加squid启动用户和组:groupadd squiduseradd -g squid squid -s /sbin/nologin #根据cache_effective_user指定缓冲管理的用户mkdir var/cache #根据cache_dir指定chown -R squid:squid /usr/local/squid #更改目录所有者和组为squid连同子目录5,配置squid.conf首先生成干净的配置文件:mv squid.conf squid.conf.bakcat squid.conf.bak | grep -v "#" | grep -v "^$" > squid.conf#定义服务器地址和端口(做Proxy时最好用lan的ip来设定绑定端口,transparent表示支持透明代理)http_port 192.168.1.253:3128 transparent#定义服务器的名字visible_hostname ProxyServer#定义管理员邮件地址(在访问发生错误时,visible_hostname和cache_mgr这两个选项的值显示在错误提示页面内的相关位置)cache_mgr webmaster@#定义缓存内存空间cache_mem 32MBcache_swap_low 90cache_swap_high 95#定义缓冲最大值的内容maximum_object_size 4096 KB#定义缓存目录cache_dir ufs /usr/local/squid/var/cache 200 16 256#定义不缓冲的内容hierarchy_stoplist cgi-bin ?hierarchy_stoplist -i ^https:\\ ?acl QUERY urlpath_regex -i cgi-bin \? \.asp \.php \.jsp \.cgiacl denyssl urlpath_regex -i ^https:\\no_cache deny QUERYno_cache deny denysslipcache_size 1024ipcache_low 90ipcache_high 95fqdncache_size 1024#日志access_log /usr/local/squid/var/logs/access.log squidcache_log /usr/local/squid/var/logs/cache.log#cache_store_log /usr/local/squid/var/logs/store.logcache_store_log none#Dns服务器dns_nameservers 202.96.128.86 61.144.56.101#缓冲存取用户和组cache_effective_user squid squid#定义ACL#sexurl.txt列出要过滤网站地址的关键字,每个关键字占一行,如(取sina)即可#maclist.txt列出允许上网的主机的MAC地址,每个地址占一行,如00:50:56:C0:00:08acl all src 0.0.0.0/0.0.0.0 #定义所有的地址acl allow_lan src 192.168.1.0/24 #允许局域网lan访问的acl acl sexurl url_regex "/usr/local/squid/sexurl.txt" #定义色情网站过滤acl virurl url_regex "/usr/local/squid/virurl.txt" #定义病毒网站过滤#acl allowedmac arp "/etc/squid/maclist.txt"#定义访问策略http_access deny sexurl #拒绝色情网站http_access deny virurl #拒绝病毒网站http_access allow allow_lan #允许局域网ip访问http_access deny all #拒绝其它未定义的规则#http_access allow allowedmac#定义可缓冲的文件名:5,运行SQUID:sbin/squid -z #初始化生成缓冲目录sbin/squid -NCd1 #前台运行(显示很多运行日志)squid #直接运行bin/RunCache & #不间断运行启动步骤:squid -zsquid -NsYD /usr/local/squid/conf/squid.conf > squid.out 2>&1监控缓冲日志:tail -f /usr/local/squid/var/logs/access.log------------------------------------------------------------------------------------------6,操作系统优化:(1)加大系统的文件描述符限制:ulimit -n默认为1024增大为65536:ulimit -n 65536查看所有的系统限制:ulimit -a(2)加速回收TIME_WAIT的sockets:sysctl -a|grep net.ipv4.tcp_twsysctl -w net.ipv4.tcp_tw_reuse=1sysctl -w net.ipv4.tcp_tw_recycle =1(3)加大临时端口的范围(默认是1024-4999):echo "1024 40000" > /proc/sys/net/ipv4/ip_local_port_range(4)如果还做NAT的话,增加NAT表的限制:echo "65535" > /proc/sys/net/ipv4/ip_conntrack_max----------------------------------------------------------------------------------7,squidclient使用简介:查看帮助:./squidclient -h 192.168.1.123 -p 3128 mgr:/usr/local/squid/squidclientsquidclient -h 192.168.1.123 -p 3128 mgr:client_list //查看客户端列表squidclient -h 192.168.1.123 -p 3128 mgr:objects //取得已缓存的列表squidclient -h 192.168.1.123 -p 3128 mgr:info //取得运行状态经验技巧:打开一个网址,访问一下,看看有没有Cache到squidclient -h 192.168.1.123 -p 3128 mgr:objects | grep GET | grep 统计cache到的总数哈:squidclient -h 192.168.1.123 -p 3128 mgr:objects | grep GET | wc -l---------------------------------------------------------透明代理:iptables -t nat -A PREROUTING -i eth0 -p tcp -s 192.168.1.0/24 --dport 80 -j REDIRECT --to-ports 3128-----------------------------------------------------------------------------------错误FAQ:FATAL: ipcache_init: DNS name lookup tests failed.有3种方法解决这个问题1。

lvs 利用ipvsadm 脚本部署

如何在VMware上部署LVS/DR作者:张计超日期:2010-7-23目录一、LVS/DR原理 (2)二、硬件和软件要求 (2)三、配置与说明: (2)1. 配置目标:配置所有相关计算机全部位于同一物理网段的LVS/DR (2)2. 记号说明: (2)3. Director配置: (2)4. Real Server 配置 (2)四、测试部署和验证方法 (2)五、详细配置步骤: (2)1. 在VMware 安装Fedora 和Windows2003 (2)2. 网络配置: (3)3 RealServer配置: (3)1) 安装Microsoft Loopback Adpater, (3)2)配置Microsoft Loopback Adpater,即配置本地连接2 (4)3. Director配置 (7)4. 测试与验证 (8)六、参考资料 (11)七、附录:Microsoft Loopback Adapter安装方法 ............................... 错误!未定义书签。

一、LVS/DR原理参考网站:/node/28二、硬件和软件要求Windows Server 2003 (含IIS组件Fedora 8 Linux (安装时要选择“作为服务器”)一台Director:Linux两台Real server: Windows 2003一台Client: Linux/Windows三、配置与说明:1.配置目标:配置所有相关计算机全部位于同一物理网段的LVS/DR2.记号说明:Director: 调度机,做负载平衡Real Server: 真实服务器,提供Web服务的真实服务器VIP: 虚拟IP地址用于客户端访问时的IP地址,集群对外的IP地址。

RIP: Real Server 的IP地址DIP: Director的IP地址3.Director配置:i.安装ipvsadmii.编写lvsdr脚本iii.运行lvsdr脚本4.Real Server 配置iv.添加Microsoft Loopback Adapter 硬件v.通过注册表设置Microsoft Loopback Adapter的子网掩码为255.255.255.255 vi.配置IIS四、测试部署和验证方法1.从client用VIP 访问在两台Real Server 上的Web服务,2.arp –a 查看client机VIP 对应的网卡MAC地址是Director的;并多次访问查看调度算法是按照调度算法访问Web服务五、详细配置步骤:1.在VMware 安装Fedora 和Windows2003网卡各一个,并设置网络连接时自定义,选择VMnet22.网络配置:DIP: IP 10.1.1.1 netmask 255.255.255.0RIP01: IP 10.1.1.2 netmask 255.255.255.0RIP02: IP 10.1.1.3 netmask 255.255.255.0配置好以后,ping 测试网络连通性,成功以后再进行下面的步骤3Real Server配置:1)安装Microsoft Loopback Adapter,并在该设备上配置VIP:10.1.1.4 netmask 255.255.255.255参考微软网站:/kb/839013/安装结果是会产生一个本地连接2,如图:配置IP地址和子网掩码其中,10.1.1.4便是VIP地址,255.0.0.0是输入完IP地址后,系统自动填入的。

lvs+keepalive构建负载均衡及服务器集群之一群集软件的说明与安装

lvs+keepalive构建负载均衡及服务器集群之一群集软件的说明与安装一、 LVS集群的组成利用LVS架设的服务器集群系统由3个部分组成:最前端的是负载均衡层这里用(HA Load Balance表示),中间是服务器群组层(用Server Array表示),底端是数据共享存储层(用Shared Storage表示)。

二、LVS集群的特点LVS的IP负载均衡技术是通过VIP模块来实现的。

IPVS是LVS集群系统的核心软件,它主要作用是:安装在Director Server上,同时在Director Server上虚拟出一个IP地址,用户必须通过这个虚拟IP地址访问服务器。

这个虚拟IP一般称为LVS的VIP,即Virtual IP。

访问的请求首先经过VIP到达负载调度器,然后由负载调度器从Real Server列表中选取一个服务节点响应用户的请求。

IPVS实现负载均衡的方法有三种:VS/NAT:即Virtual Server via Network Address Translation,也就是网络地址翻译技术实现虚拟服务器。

VS/TUN:即Virtual Server via IP Tunneling,也就是通过IP隧道技术实现虚拟服务器。

VS/DR:即Virtual Server via Direct Routing,也就是且直接路由技术实现虚拟服务器。

DR是这3种负载调度方式中性能最好的,但是要求Director Server与Real Server必须由一块网卡连在同一物理网段上。

负载高度算法下面列举最常用的4种调度算法:轮叫调度(Round Robin)、加权轮叫调度(Weighted Round Robin)、最少连接高度(Least Connection)、加权最少连接调度(Weighted Least Coonection)。

三、适用环境目前LVS仅支持Linux和FreeBSD系统作为前端Director Server,但是支持大多数的TCP 和UDP协议。

Squid代理服务器的搭建与使用)赵田(

Squid代理服务器的搭建与使用一.实验目的

使用代理服务器使私有地址用户能够访问公有地址二.实验拓扑

三.实验步骤

(一)代理服务

1.配置ip地址搭建底层网路

Client

Internet_client

squid

测试底层网络2.安装squid的有关软件包并启动服务和初始化

查看软件包

启动服务

初始化

3.squid端配置

4.client端浏览器配置

5.Internet_client上搭建web站点

6.client端进行访问测试

(二)透明代理

1.squid端配置(实验一中的哪些配置也是需要有的)

2.防火墙的配置

3.client端访问测试

四.实验总结

1.试验中路由功能不需要启动

2.透明代理试验中client端浏览器中不需要任何设置

3.修改squid的主配置文件时设置权限的时候那些策略是成

对出现的,并且拒绝优先

4.透明代理的实验需要有防火墙的支持,所以配置防火墙的

策略配置也是必须的。

用Linux下的LVS软件实现Linux集群

mysql-5.1.40-linux-i686-glibc23.tar.gz安装笔记:1.首先添加mysql用户组Shell代码1.shell> groupadd mysql2.添加mysql用户,并指定到mysql用户组Shell代码1.shell> useradd -g mysql mysql3.解压缩mysql-version.tar.gz到安装目录(/usr/local/)Shell代码1.shell> cd /usr/local2.shell> gunzip < /path/to/mysql-VERSION-OS.tar.gz | tar xvf - 4.为创建mysql软连接mysql-VERSION-OSShell代码1.shell> ln -s full-path-to-mysql-VERSION-OS mysql2.shell> cd mysql5.设定mysql安装目录权限,设置owner为mysqlShell代码1.shell> chown -R mysql .6.执行mysql系统数据库初始化脚本Shell代码1.shell> scripts/mysql_install_db --user=mysql7.设定data目录权限,分配给mysql用户,为了mysql程序能读写data目录下的文件Shell代码1.shell> chown -R mysql data8.使用mysql帐号启动mysql应用Shell代码1.shell> bin/mysqld_safe --user=mysql &9.设置root密码Shell代码1.shell> bin/mysqladmin -u root password '123123'10.登录mysqlShell代码1.shell> bin/mysql -u root -p2.Enter password:登录成功会看到:Shell代码1.Welcome to the MySQL monitor. Commands end with ; or \g.2.Your MySQL connection id is 2293.Server version: 5.1.40-log MySQL Community Server (GPL)4.5.Type 'help;' or '\h' for help. Type '\c' to clear the current input statement.6.7.mysql>这时mysql已经装好了,可以查看数据库了,但在正式使用数据库开发与部署的时候还需要做一些工作:1.设定配置文件f按照需求copy my-***.cnf到/etc/f2.修改默认字符集utf8(1).[client]下加入default-character-set=utf8(2).[mysqld]下加入default-character-set=utf83.设置默认存储引擎mysql for linux的版本默认使用的数据库引擎是MyISAM,但只有InnoDB 引擎支持事务,所以需要修改配置:(1).[mysqld]下加入default-storage-engine=INNODB4.配置innodb参数(1).找到# Uncomment the following if you are using InnoDB tables去掉innodb_*下的所有#(2).如果安装mysql的目录不是默认的,则需要修改# mysql 默认安装目录为 /usr/local/mysql/# mysql 默认表空间目录安装目录为 /usr/local/mysql/data/innodb_data_home_dir=/usr/local/database/mysql/data/innodb_log_group_home_dir=/usr/local/database/mysql/data/ 5.设置系统服务让linux启动的时候就启动mysql服务Shell代码1.shell> cd /usr/local/mysql/2.shell> cp support-files/mysql.server /etc/init.d/mysql3.shell> chmod 777 /etc/init.d/mysql4.shell> chkconfig --add mysql5.shell> chkconfig --level 35 mysql on6.重启MySQL服务Shell代码1.shell> service mysql restarttar.gz以.tar.gz为扩展名的是一种压缩文件,在Linux和OSX下常见,Linux和OSX 都可以直接解压使用这种压缩文件。

LVS——squid 配置文档

系统版本CENTOS 5.4 x86_64软件版本 squid-2.6.STABLE9-20070207keepalived-1.1.19-1.i386ipvsadm-1.24-10.x86_64RIP1=192.168.8.195RIP2=192.168.8.194VIP1=192.168.8.197VIP2=192.168.8.196DIP1=192.168.8.198DIP2=192.168.8.199安装squid首先修改/usr/include/bits/typesizes.h将#define_FD_SETSIZE 1024修改为 #define_FD_SETSIZE 65536以root身份执行ulimit –HSn 40960解压squid-2.6.STABLE9-20070207.tar.gzTar zxf squid-2.6.STABLE9-20070207.tar.gz –C /tmp/Cd /tmp/squid-2.6.STABLE9-20070207./configure --prefix=/usr/local/squid --disable-internal-dns --disable-delay-pools --disable-mem-gen-trace --enable-kill-parent-hack --enable-icmp --enable-cache-digests --enable-epoll --enable-async-io=160 --enable-snmp --enable-default-err-language=Simplify_Chinese --enable-err-languages=Simplify_Chinese --enable-http-violationsMake && make install修改echo "131072" > /proc/sys/net/ipv4/netfilter/ip_conntrack_bucketsecho "131072" > /proc/sys/net/ipv4/ip_conntrack_maxecho "1024 64000" > /proc/sys/net/ipv4/ip_local_port_rangeecho 64000 > /proc/sys/fs/file-maxecho 8192 > /proc/sys/net/ipv4/tcp_max_syn_backlog添加用户、组和文件夹mkdir -p /usr/local/squid/var/cache/usr/sbin/groupadd squid/usr/sbin/useradd squid -g squid -d /usr/local/squidchown -R squid:squid /usr/local/squid/var/cachemkdir -p /home/squid-logmkdir -p /home/squid-log/accessmkdir -p /home/squid-log/storemkdir -p /home/squid-log/cachechown -R squid:squid /home/squid-log编写配置文件# visible namevisible_hostname 111# cache config: space use 1G and memory use 256Mcache_dir aufs /usr/local/squid/cache 30720 256 256 cache_swap_low 90cache_swap_high 95maximum_object_size 32768 KBmaximum_object_size_in_memory 8192 KBminimum_object_size 0 KBipcache_size 16384ipcache_low 80ipcache_high 90cache_mem 3072 MBcache_effective_user squidcache_effective_group squidrefresh_stale_hit 30 seconds#refreshrefresh_pattern -i \.flv$ 1440 50% 2880 ignore-reload refresh_pattern -i \.swf$ 1440 50% 2880 ignore-reload refresh_pattern -i .gif$ 3600 80% 36000 reload-into-ims refresh_pattern -i .jpg$ 3600 80% 36000 reload-into-ims refresh_pattern -i .jpg?$ 3600 80% 36000 reload-into-ims refresh_pattern -i .png$ 3600 80% 36000 reload-into-ims range_offset_limit 0 KBhttp_port 80 vhosticp_port 3310icp_hit_stale onicp_query_timeout 2000# Timeouts# forward_timeout 4 minutesforward_timeout 20 seconds# connect_timeout 1 minuteconnect_timeout 60 seconds# read_timeout 15 minutesread_timeout 5 minutes# request_timeout 5 minutesrequest_timeout 1 minutes# persistent_request_timeout 1 minutepersistent_request_timeout 30 seconds# client_lifetime 1 dayclient_lifetime 5 minutes# pconn_timeout 120 secondsshutdown_lifetime 30 seconds#shutdown_lifetime 15 secondshalf_closed_clients offserver_persistent_connections onclient_persistent_connections ondigest_generation offvia onforwarded_for onnegative_ttl 1 second# access arcacl all src 0.0.0.0/0.0.0.0cache_log /home/squid-log/cache/cache.logaccess_log /home/squid-log/access/access.log squidcache_dir aufs /usr/local/squid/var/cache/ 30720 256 256icp_access allow allhttp_access allow allserver_persistent_connections onclient_persistent_connections oncache_vary onacl apache rep_header Server ^Apachebroken_vary_encoding allow apacheacl Purge method PURGEacl Localhost src 127.0.0.1acl MANGER src 192.168.1.0http_access allow PURGE Localhosthttp_access allow PURGE MANGERhttp_access deny Purgecache_peer 123.125.20.18 parent 80 0 no-query no-digest no-netdb-exchange originserver name=acache_peer_domain a cache_peer 123.125.20.19 parent 80 0 no-query no-digest no-netdb-exchange originserver name=dcache_peer_domain d cache_peer 123.125.20.50 parent 80 0 no-query no-digest no-netdb-exchange originserver name=fcache_peer_domain f cache_peer 123.125.20.51 parent 80 0 no-query no-digest no-netdb-exchange originserver name=gcache_peer_domain g cache_peer 123.125.20.52 parent 80 0 no-query no-digest no-netdb-exchange originserver name=hcache_peer_domain h cache_peer 123.125.20.53 parent 80 0 no-query no-digest no-netdb-exchange originserver name=jcache_peer_domain j cache_peer 123.125.20.54 parent 80 0 no-query no-digest no-netdb-exchange originserver name=ccache_peer_domain c cache_peer 123.125.20.30 parent 80 0 no-query no-digest no-netdb-exchange originserver name=ecache_peer_domain e cache_peer 222.35.250.49 parent 80 0 no-query no-digest no-netdb-exchange originserver name=kcache_peer_domain k cache_peer 61.237.234.165 parent 80 0 no-query no-digest no-netdb-exchange originserver name=lcache_peer_domain l cache_peer 123.125.20.19 parent 80 0 no-query no-digest no-netdb-exchange originserver name=zcache_peer_domain z cache_peer 61.237.234.204 parent 80 0 no-query no-digest no-netdb-exchange originserver name=xcache_peer_domain x cache_peer 61.237.234.246 parent 80 0 no-query no-digest no-netdb-exchange originserver name=vcache_peer_domain v cache_peer 192.168.8.195 sibling 80 3310 name=cache2cache_peer_domain cache2测试开启服务/usr/local/squid/sbin/sqind –z/usr/local/squid/sbin/sqind –N –D –d 1/usr/local/squid/sbin/sqind –sYD测试方法删除DNS清楚IE缓存重新开启IE输入安装keepalivedCp keepalived-1.1.19-1.i386.rpm /tmp/Cd /tmp/Rpm –ivh keepalived-1.1.19-1.i386.rpm编写配置文件Vim /etc/keepalived/keepalived.conf! Configuration File for keepalivedglobal_defs {notification_email {soulsunshine@}notification_email_from sns-lvs@ smtp_server 127.0.0.1# smtp_connect_timeout 30router_id 111}vrrp_instance VI_1 {state MASTER //BACKUPinterface eth1virtual_router_id 51priority 100advert_int 1authentication {auth_type PASSauth_pass 1111}virtual_ipaddress {192.168.8.197192.168.8.196}}virtual_server 192.168.8.197 80 {delay_loop 6lb_algo wrrlb_kind DRpersistence_timeout 60protocol TCPreal_server 192.168.8.195 80 {weight 3TCP_CHECK {connect_timeout 10nb_get_retry 3delay_before_retry 3connect_port 80}}real_server 192.168.8.194 80 { weight 3TCP_CHECK {connect_timeout 10nb_get_retry 3delay_before_retry 3connect_port 80}}}virtual_server 192.168.8.196 80 {delay_loop 6lb_algo wrrlb_kind DRpersistence_timeout 60protocol TCPreal_server 192.168.8.195 80 {weight 3TCP_CHECK {connect_timeout 10nb_get_retry 3delay_before_retry 3connect_port 80}}real_server 192.168.8.194 80 { weight 3TCP_CHECK {connect_timeout 10nb_get_retry 3delay_before_retry 3connect_port 80}}}修改参数修改DIP主机上的参数:sysctl -w "net.ipv4.ip_forward=0"sysctl -w "net.ipv4.conf.all.send_redirects=1"sysctl -w "net.ipv4.conf.default.send_redirects=1"sysctl -w "net.ipv4.conf.eth0.send_redirects=1"ifconfig eth1 {VIP} netmask 255.255.255.255 broadcast {VIP} up route add -host {VIP} dev eth1修改real-server主机参数:sysctl -w "net.ipv4.ip_forward=0"sysctl -w "net.ipv4.conf.lo.arp_ignore=1"sysctl -w "net.ipv4.conf.all.arp_ignore=1"sysctl -w "net.ipv4.conf.lo.arp_announce=2"sysctl -w "net.ipv4.conf.all.arp_announce=2"ifconfig lo:0 {VIP} netmask 255.255.255.255 broadcast {VIP} up route add -host {VIP} dev lo:0安装ipvsadmRpm –ivh ipvsadm-1.24-10.x86_64.Rpm开启服务/etc/init.d/keepalived start/etc/init.d/ipvsadm start测试Watch ipvsadm –ln。

squid安装方法linux

搭建Linux安全的Squid代理服务器本文介绍Linux下非常著名、常用的Squid代理服务器的使用,并着重讲述如何使用其提供的访问控制策略,来保证代理服务器的合法使用。

代理服务器的功能是代理网络用户取得网络信息,它是网络信息的中转站。

随着代理服务器的广泛使用,随之而来的是一系列的安全问题。

由于没有对代理服务器的访问控制策略作全面细致的配置,导致用户可以随意地通过代理服务器访问许多色情、反动的非法站点,而这些行为往往又很难追踪,给管理工作带来极大的不便。

Squid是Linux下一个缓存Internet数据的代理服务器软件,其接收用户的下载申请,并自动处理所下载的数据。

也就是说,当一个用户想要下载一个主页时,可以向Squid发出一个申请,要Squid代替其进行下载,然后Squid连接所申请网站并请求该主页,接着把该主页传给用户同时保留一个备份。

当别的用户申请同样的页面时,Squid把保存的备份立即传给用户,使用户觉得速度相当快。

目前,Squid可以代理HTTP、FTP、GOPHER、SSL和WAIS协议,暂不能代理POP3、NNTP等协议。

Squid可以工作在很多操作系统中,如AIX、Digital、Unix、FreeBSD、HP-UX、Irix、Linux、NetBSD、Nextstep、SCO、Solaris、OS/2等。

安装和配置Squid Server通常说来,安装Squid有两种方法:一是从Red Hat Linux 9中获取该软件的RPM包进行;二是安装从Squid的官方站点/ 下载该软件的源码进行编译后安装。

目前网上最新的稳定版本为squid-2.5.STABLE10,下面以此版本为例对两种安装方法进行介绍。

Squid服务器工作原理示意图1.RPM包的安装首先,查看是否已经安装了squid:#rpm -qa | grep squidRed Hat Linux9自带了Squid安装软件包,将第一张安装光盘放入光驱后挂装光盘分区:#mount /mnt/cdrom然后,进入/mnt/cdrom/Red Hat/RPMS目录:#cd /mnt/cdrom/Red Hat/RPMS最后,执行安装:#rpm -ivh squid-2.5.STABLE1-2.i386.rpm当然,我们也可以在开始安装系统的过程中安装该软件。

Linux服务器技术项目十三

负载均衡集群(Load Balance Cluster, 简称LB Cluster)

负载均衡集群由两台或者两台以上的服务 器组成,分为前端负载调度和后端节点服务 两个部分,前端负载调度部分负责把客户端 的请求按照不同的策略分配给后端服务节点, 后端节点是真正提供应用程序服务的部分, 把一个高负荷的应用分散到多个节点来共同 完成,适用于业务繁忙、大负荷访问的应用 系统。

高可用性

服务出现故障时,集群系统可以自动将服务从故障节点 切换到另一个备用节点,从而提供不间断性服务。

可扩展性

可以向此集群中动态的加入一个或多个服务节点,从而 满足应用的需要。

恢复错误

当一个任务在一个节点上还没有完成时,由于某种原 因,执行失败,此时,另一个服务节点能接着完成此任务。

配置LVS集群

项目十三

集群类型 配置和管理集群

配置不同应用 类型的集群

当总公司的服务器区的主服务器发生故障,备份

服务器自动接受主服务器的工作,承担主服务器的工 作任务。设当总公司的web服务器、E-mail服务器、 DNS服务器等发生故障,应用虚拟的集群服务器(IP 地址:192.168.0.6)来承担相应服务器的工作任务, 网络拓扑图如下。

E-mail服务器 192.168.0.3

192.168.0.100

高可用集群(High Availability Cluster, 简称HA Cluster)

当应用程序出现故障,或者系统硬件、 网络出现故障时,应用可以自动、快速从一 个节点切换到另一个节点,从而保证应用持 续、不间断的对外提供服务。如双机热备、 双机互备、多机互备等都属于高可用集群, 这类集群一般都有两个或两个以上节点组成。

computer client1

lvs 转发的原理

lvs 转发的原理

LVS(Linux Virtual Server)是一种常用的负载均衡技术,它的转发原理基于 IP 负载均衡和内容交换。

LVS 使用了三种主要的转发方式:NAT(Network Address Translation,网络地址转换)、DR (Direct Routing,直接路由)和 TUN (IP Tunneling,IP 隧道)。

其中,NAT 模式是最常用的一种。

在 NAT 模式下,LVS 会将客户端的请求报文的目标 IP 地址修改为后端真实服务器的 IP 地址,并在转发给后端服务器之前,还会修改报文的源 IP 地址。

后端服务器处理完请求后,会将响应报文直接返回给 LVS,LVS 再将源 IP 地址修改为客户端的 IP 地址,然后发送给客户端。

通过这种方式,LVS 实现了将客户端的请求均匀地分配到多个后端服务器上,从而提高了系统的并发处理能力和可靠性。

此外,LVS 还可以根据不同的调度算法 (如轮询、加权轮询、最小连接数等)来决定将请求转发到哪个后端服务器,以实现更灵活的负载均衡。

LVS 转发的原理是通过对网络报文的地址进行转换和分发,将请求

均衡地分配到多个后端服务器上,从而提高系统的性能和可用性。

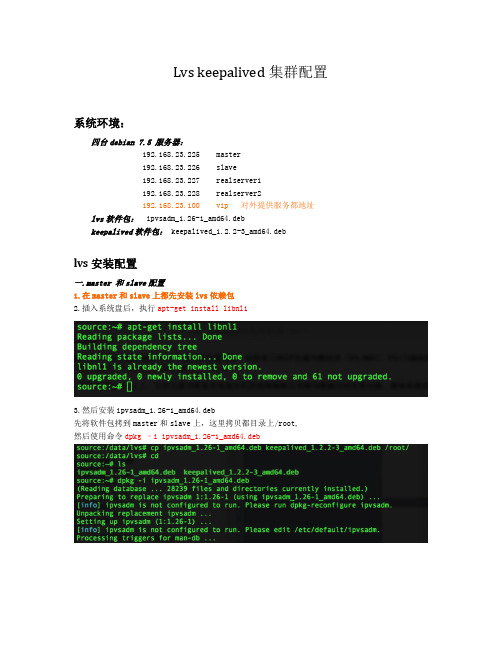

Lvs keepalived集群配置

Lvs keepalived集群配置系统环境:四台debian 7.5 服务器:192.168.23.225 master192.168.23.226 slave192.168.23.227 realserver1192.168.23.228 realserver2192.168.23.100 vip对外提供服务都地址lvs软件包:ipvsadm_1.26-1_amd64.debkeepalived软件包:keepalived_1.2.2-3_amd64.deblvs安装配置一.master 和slave配置1.在master和slave上都先安装lvs依赖包2.插入系统盘后,执行apt-get install libnl13.然后安装ipvsadm_1.26-1_amd64.deb先将软件包拷到master和slave上,这里拷贝都目录上/root,然后使用命令dpkg –i ipvsadm_1.26-1_amd64.deb4.安装完lvs软件包后,再安装keepalived软件包使用命令dpkg –i keepalived_1.2.2-3_amd64.deb二.master server上都配置文件修改1.创建keepaliaved.conf配置文件vim /etc/keepalived/keepalived.conf! Configuration File for keepalivedglobal_defs {router_id LVS_1}vrrp_instance VI_1 {state MASTERinterface eth0virtual_router_id 51priority 100advert_int 1authentication {auth_type PASSauth_pass 1111}virtual_ipaddress {192.168.23.100}}virtual_server 192.168.23.100 443 {delay_loop 6lb_algo dhlb_kind DR# persistence_timeout 60protocol TCPreal_server 192.168.23.227 443 {TCP_CHECK {connect_timeout 10nb_get_retry 3delay_before_retry 3 connect_port 443}}real_server 192.168.23.228 443 {TCP_CHECK {connect_timeout 10nb_get_retry 3delay_before_retry 3connect_port 443}}}virtual_server 192.168.23.100 22 {delay_loop 6lb_algo dhlb_kind DR# persistence_timeout 60protocol TCPreal_server 192.168.23.227 22 {TCP_CHECK {connect_timeout 10nb_get_retry 3delay_before_retry 3connect_port 22}}real_server 192.168.23.228 22 {TCP_CHECK {connect_timeout 10nb_get_retry 3delay_before_retry 3connect_port 22}}} virtual_server 192.168.23.100 3390 {delay_loop 6lb_algo dhlb_kind DR# persistence_timeout 60protocol TCPreal_server 192.168.23.227 3390 {TCP_CHECK { connect_timeout 10 nb_get_retry 3 delay_before_retry 3 connect_port 3390 } } real_server 192.168.23.228 3390 { TCP_CHECK { connect_timeout 10 nb_get_retry 3 delay_before_retry 3 connect_port 3390 } } }三.slave server上都配置文件修改创建keepaliaved.conf配置文件vim /etc/keepalived/keepalived.conf! Configuration File for keepalivedglobal_defs {router_id LVS_2}vrrp_instance VI_1 {state BACKUPinterface eth0virtual_router_id 51priority 50advert_int 1authentication {auth_type PASSauth_pass 1111}virtual_ipaddress {192.168.23.100}}virtual_server 192.168.23.100 443 {delay_loop 6lb_algo dhlb_kind DR# persistence_timeout 60protocol TCPreal_server 192.168.23.227 443 {TCP_CHECK {connect_timeout 10nb_get_retry 3delay_before_retry 3connect_port 443}}real_server 192.168.23.228 443 {TCP_CHECK {connect_timeout 10nb_get_retry 3delay_before_retry 3connect_port 443}}}virtual_server 192.168.23.100 22 {delay_loop 6lb_algo dhlb_kind DR# persistence_timeout 60protocol TCPreal_server 192.168.23.227 22 {TCP_CHECK {connect_timeout 10nb_get_retry 3delay_before_retry 3connect_port 22}} real_server 192.168.23.228 22 {TCP_CHECK {connect_timeout 10nb_get_retry 3delay_before_retry 3connect_port 22}}} virtual_server 192.168.23.100 3390 {delay_loop 6lb_algo dhlb_kind DR# persistence_timeout 60protocol TCPreal_server 192.168.23.227 3390 {TCP_CHECK {connect_timeout 10nb_get_retry 3delay_before_retry 3connect_port 3390}} real_server 192.168.23.228 3390 {TCP_CHECK {connect_timeout 10nb_get_retry 3delay_before_retry 3connect_port 3390}}}四.realserver上都配置配置前请确保后端web服务器https/ssh/3390端口协议处于工作状态每台realserver上都做以下操作1.创建本地回环接口网卡ifconfig lo:0 192.168.23.100 broadcast 192.168.23.100 netmask255.255.255.255 up2.关闭arp请求响应echo 1>/proc/sys/net/ipv4/conf/lo/arp_ignoreecho 2>/proc/sys/net/ipv4/conf/lo/arp_announceecho 1>/proc/sys/net/ipv4/conf/all/arp_ignoreecho 2>/proc/sys/net/ipv4/conf/all/arp_announce五.测试验证结果1.启动keepalived服务/etc/init.d/ipvsadm start/etc/init.d/keepalived start2.查看服务连接状态打开浏览器输入地址https://192.168.23.100出现如下界面,说明lvs目前工作是正常的使用ipvsadm –l查看后端连接状态如下:当前连接的realserver是192.168.23.227使用ssh 192.168.23.100方式连接时,连接的服务是192.168.23.228如下状态是因为手动把192.168.23.228的tomcat服务停止了,所以https协议服务器只有192.168.23.227一台服务器Forward 代表当前工作模式为dr路由模式Weight代表该realserver服务权重ActiveConn 代表当前有多少活动的请求连接InActConn 代表非活动连接数重启192.168.23.228的tomcat 服务后,该realserver2自动加到服务队列里了配置文件说明keepalive 配置文件各选项含义:global_defs {notification_email { #指定keepalived在发生切换时需要发送email的对象,一行一个 sysadmin@fire.loc}notification_email_from Alexandre.Cassen@firewall.loc #指定发件人smtp_server localhost #指定smtp服务器地址smtp_connect_timeout 30 #指定smtp连接超时时间router_id LVS_DEVEL #运行keepalived机器的一个标识}vrrp_sync_group VG_1{ #监控多个网段的实例group {inside_network #实例名outside_network}notify_master /path/xx.sh #指定当切换到master时,执行的脚本netify_backup /path/xx.sh #指定当切换到backup时,执行的脚本notify_fault "path/xx.sh VG_1" #故障时执行的脚本notify /path/xx.shsmtp_alert #使用global_defs中提供的邮件地址和smtp服务器发送邮件通知}vrrp_instance inside_network {state BACKUP #指定那个为master,那个为backup,如果设置了nopreempt这个值不起作用,主备靠priority决定interface eth0 #设置实例绑定的网卡dont_track_primary #忽略vrrp的interface错误(默认不设置)track_interface{ #设置额外的监控,里面那个网卡出现问题都会切换eth0eth1}mcast_src_ip #发送多播包的地址,如果不设置默认使用绑定网卡的primary ipgarp_master_delay #在切换到master状态后,延迟进行gratuitous ARP请求virtual_router_id 50 #VPID标记priority 99 #优先级,高优先级竞选为masteradvert_int 1 #检查间隔,默认1秒nopreempt #设置为不抢占注:这个配置只能设置在backup主机上,而且这个主机优先级要比另外一台高preempt_delay #抢占延时,默认5分钟debug #debug级别authentication { #设置认证auth_type PASS #认证方式auth_pass 111111 #认证密码}virtual_ipaddress { #设置vip192.168.202.200}}virtual_server 192.168.202.200 23 {delay_loop 6 #健康检查时间间隔lb_algo rr #lvs调度算法rr|wrr|lc|wlc|lblc|sh|dhlb_kind DR #负载均衡转发规则NAT|DR|RUNpersistence_timeout 5 #会话保持时间protocol TCP #使用的协议persistence_granularity <NETMASK> #lvs会话保持粒度virtualhost <string> #检查的web服务器的虚拟主机(host:头)sorry_server<IPADDR><port> #备用机,所有realserver失效后启用real_server 192.168.200.5 23 {weight 1 #默认为1,0为失效inhibit_on_failure #在服务器健康检查失效时,将其设为0,而不是直接从ipvs 中删除notify_up <string> | <quoted-string> #在检测到server up后执行脚本 notify_down <string> | <quoted-string> #在检测到server down后执行脚本TCP_CHECK {connect_timeout 3 #连接超时时间nb_get_retry 3 #重连次数delay_before_retry 3 #重连间隔时间connect_port 23 健康检查的端口的端口bindto <ip>}HTTP_GET | SSL_GET{url{ #检查url,可以指定多个path /digest <string> #检查后的摘要信息status_code 200 #检查的返回状态码}connect_port <port>bindto <IPADD>connect_timeout 5nb_get_retry 3delay_before_retry 2}SMTP_CHECK{host{connect_ip <IP ADDRESS>connect_port <port> #默认检查25端口bindto <IP ADDRESS>}connect_timeout 5retry 3delay_before_retry 2helo_name <string> | <quoted-string> #smtp helo请求命令参数,可选}MISC_CHECK{misc_path <string> | <quoted-string> #外部脚本路径misc_timeout #脚本执行超时时间misc_dynamic #如设置该项,则退出状态码会用来动态调整服务器的权重,返回0 正常,不修改;返回1,检查失败,权重改为0;返回2-255,正常,权重设置为:返回状态码-2}}。

lvs负载均衡技术高可用

lvs负载均衡技术高可用LVS+Keepalived实现高可用、负载均衡Web集群简介:LVS是Linu某VirtualServer的简写,Linu某虚拟服务器的意思,是一个虚拟的服务器集群系统,此项目由章文嵩博士于1998年5月成立,是中国最早出现的自由软件项目之一。

LVS负载均衡集群系统的优点:1、提高吞吐量想获得更高的吞吐量,在LVS中只需增加Real-erver即可,其开销只是线性增长。

如选择更换一台更高性能的服务器来获得相当的吞吐量,开销要大很多。

2、冗余如果LVS中某台Real-erver由于需要升级或其它原因不能对外提供服务,其退出及恢复工作并不会对用户造成服务中断。

3、适应性不管是需要吞吐量逐渐变化、还是快速变化,服务器的增减对客户都是透明的。

LVS负载均衡集群系统的三种转发机制:1、VirtualServerviaNAT(VS/NAT)VS/NAT网络地址转换模式,服务器可以运行任何支持TCP/IP协议的操作系统,它只需要一个公网IP地址配置在LVS主机上,后端真实服务器都可以使用私有地址。

它的缺点是扩充能力有限,当后端真实服务器达到一定数量时,LVS本机有可能成为集群瓶颈,因为整个集群中的客户端请求和响应封包都要通过LVS负载均衡主机。

2、VirtualServerviaIPTunneling(VS/TUN)VS/TUNIP隧道模式,负载均衡LVS主机只将请求分配到不同的真实服务器,真实服务器将结果直接返回给客户端。

这样LVS可以处理海量的请求,而不会成为集群系统瓶颈。

并且IP隧道模式不限制真实服务器位置,只要系统支持IP隧道协议并且网络可达就可以。

多了一层IP隧道的开销,且并不是所有系统都支持此协议。

3、VirtualServerviaDirectRouting(VS/DR)VS/DR直接路由模式,同样LVS主机只处理客户端到服务器端的连接,响应信息由真实服务器直接返回给客户端。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Abstract: LVS is an excellent open source software for cluster and IP Load balancing. Squid is also the most popular system for proxy service. This paper discusses how to set up efficient and reliable system based on LVS and Squid. Key words: load balance; proxy; LVS; Squid

2012 年 第 21 卷 第 11 期

计 算 机 系 统 应 用

使用 LVS 和 Squid 构建代理服务器集群系统①

薛

摘

建, 王信堂, 曲守宁

要: LVS 是优秀的集群及 IP 负载均衡开源软件, 同样 Squid 是目前最通用的开源代理服务系统软件. 本文讲

2

代理服务器集群的网络结构

我们搭建的代理服务器集群如图 2 所示, 包括一

台调度服务器和 3 台真实服务器, 采用 LVS 的 DR 工 作方式.

图 2 代理服务器集群系统 设备配置如下: 1 台 Linux 服务器做 Director server (192.168.8.2) , 操作系统 CentOS5. 3 台做 realserver(192.168.1.2, 192.168.1.3, 192. 168.1.4)操作系统 Debian6. Virtual IP: 192.168.1.1 Director: 192.168.1.5 RealServer1: 192.168.1.2 RealServer2: 192.168.1.3 RealServer3: 192.168.1.4 其中 Virtual IP : 192.168.1.1 就是对外提供服务的 IP, 在代理服务器集群中就是代理服务器的地址. 构建代理服务器集群主要工作包括配置调度服 务器和配置 Squid 代理服务器. 其中调度服务器配置 就是安装 LVS 软件及相关管理工具如 ldirectord 和 ipvsadm 等. 而配置代理服务器主要包括安装和优化 Squid 服务器.

1

lVS工作原理、架构及工作方式

LVS 是 Linux Virtual Server 的简写, 意即 Linux 虚

1.1 LVS 简介

① 收稿时间:2012-03-19;收到修改稿时间:2012-04-17

System Construction 系统建设

29

计 算 机 系 统 应 用

(济南大学 信息网络中心, 济南 250014)

述如何利用 LVS 和 Squid 构建高效可靠的代理服务器集群系统. 关键词: 负载均衡; Proxy; LVS 软件; Squid 软件

Building Cluster of Proxy Based on LVS and Squid

XUE Jian, WANG Xin-Tang, QU Shou-Ning

目前园区网(campus)出口大都采用防火墙活代 理服务器作为互联网的出口设备, 代理服务器由于具 有防火墙所不具备的缓存(cache)功能, 在许多大型 园区网的出口得到了广泛的应用. 代理服务器(Proxy Server)是介于客户端和 Web 服务器之间的一台服务 器, 使用代理服务器的内网计算机与 Internet 交换信息 时都先将信息发送给代理服务器 , 由其转发 , 并且将 收到的应答回送给该计算机. 作者工作单位的校园网是一个规模比较大的园区 网, 不仅为校内的办公、教学用计算机提供互联网出 口, 还为教工宿舍提供上网服务, 上网终端 5000 台左 右(不包括学生宿舍网的计算机), 对互联网访问的 稳定性和速度具有很高的要求 . 作者根据上述要求 , 经过不同集群软件和代理服务器软件的调研分析, 经 过长期测试, 成功配置出基于 LVS 和 Squid 的代理服 务器集群系统, 大大降低了互联网出口的平均无故障 时间, 网络服务质量得以提升.

扩展性 转发效率 对网络 环境要求 同一局域网 可跨广域网 必须在同一 VLAN 对真实服 务器要求 无 必须支持 IP Tunneling 无

DR

高

高

2 年 第 21 卷 第 11 期

计 算 机 系 统 应 用

可以看出, DR 和 TUN 方式的吞吐量和转发效率 要大大高于 NAT 方式, TUN 方式对真实服务器有要求, 必须支持 IP Tunneling, 且 TUN 方式调度机和真实服 务器可以不再一个网段的优势在局域网部署中没有任 何意义. DR 方式性能最优, 且我们构建的代理服务器 集群系统中的所有服务器恰好都位于同一物理网段 (VLAN)所以, 我们选择 DR 工作方式.

2012 年 第 21 卷 第 11 期

能受到限制. 1.3.2 TUN 方式 TUN(IP Tunneling)的转发流程是: Director 机器 收到外界请求, 按相应的调度算法将其通过 IP 隧道发 送到相应 Real Server, Real Server 处理完该请求后, 将 结果数据包直接返回给客户. 至此完成一次负载调度. 该方式中 Real Server 处理请求后直接将结果回应 给用户, 这样 Director 就只处理客户机与服务器的一 半连接, 极大地提高了 Director 的调度处理能力, 使集 群系统能容纳更多的节点数. 另外, TUN 方式中的 Real Server 可以分布在不同 的地理区域, 系统可以跨广域网运行 , 这样可以构筑 跨地域的集群, 其应对灾难的能力也更强. 如果要构 建跨地域跨广域网的集群系统 , 可以考虑采用 TUN 方式. TUN 方式中, 服务器需要为 IP 封装付出一定的资 图 1 系统总体框图 LVS 系统通常由调度机(Director)和多台真实服务 器(Real Server)构成, 调度机通过虚拟 IP(vertual IP Address)接受客户端的请求后按调度算法将其转发到 不同的真实服务器上, 真实服务器响应请求并将结果 返回, 根据 LVS 的工作方式不同, 返回结果将直接或 通过调度机返回客户端. 1.3 LVS 的三种工作方式及本项目的选择 LVS 有三种架构, 分别是 NAT、 TUN 和 DR 方式. 这三种工作方式适用于不同的应用环境, 以下我们分 析这三种工作方式的原理及优缺点, 并给出我们选择 DR 方式作为代理服务器集群实现机制的原因. 1.3.1 NAT 方式 NAT (Network Address Translation) 方式的转发流 程是: Director 服务器收到外界请求, 改写数据包的目 标 地 址 , 按 相 应 的 调 度 算 法 将 其 发 送 到 相 应 Real Server 上, Real Server 处理完该请求后, 将结果数据包 返回到其默认网关, 即 Director 机器上, Director 机器 再改写数据包的源地址 , 最后将其返回给外界 . 这样 就完成一次负载调度. 因为执行 NAT 需要重写流经 Director 的数据包, 在速度上有一定延迟 ; 另外 , 当用户的请求集中 , 而 服务器的回应数据量又很大的情况下 , 会对 Director 形成很大压力 , 成为新的瓶颈 , 从而使整个系统的性

# chkconfig ldirectord --list # chkconfig ldirectord on 3.3 编辑 ldirectord.cf 配置文件 Ldirectord 实际上是实现 LVS 调度功能的一个进 程, 其配置文件是 ldirectord.cf, 需要根据自己实际的 网络环境进行修改. 将 /usr/share/doc/heartbeat-ldirectord-2.1.3/ldirectord.cf 拷贝到/etc/ha.d/ldirectord.cf 并编辑, 修改完成 后如下所示: virtual=192.168.0.1:8000 real=192.168.0.2:8000 gate real=192.168.0.3:8000 gate real=192.168.0.4:8000 gate scheduler=wlc persistent=600 protocol=tcp checktype=connect checkport=8000 …… 其中 192.168.0.1 是提供服务的虚拟地址, 客户端浏览 器 的 代 理 服 务 器 都 设 置 成 这 个 地 址 ; 192.168.0.21921.68.0.4 是 3 台 Real Server 的地址; 负载均衡算法

30 系统建设 System Construction

NAT TUN 低 一般 低 较高

源 开 销 , 而 且 后 端 的 Real Server 必 须 是 支 持 IP Tunneling 的操作系统. 1.3.3 DR 方式 DR(Direct Routing)的转发流程是: Director 机器 收到外界请求, 按相应的调度算法将其直接发送到相 应 Real Server, Real Server 处理完该请求后, 将结果数 据包直接返回给客户, 完成一次负载调度. DR 方式与前面的 TUN 方式有些类似, 前台的 Director 机器也是只需要接收和调度外界的请求 , 而 不需要负责返回这些请求的反馈结果, 所以能够负载 更多的 Real Server, 提高 Director 的调度处理能力, 使 集群系统容纳更多的 Real Server. 另外, 由于 DR 方式 不需要封装和解封装 IP 隧道, 所以效率比 TUN 方式 更高. DR 需要改写请求报文的 MAC 地址, 所以所有 服务器必须在同一物理网段(VLAN)内. 1.3.4 工作方式比较及选型 三种工作方式总结比较表 1 所示: 表 1 LVS 三种工作方式总结比较