数据结构_9.search

c语言数据结构查找算法大全

printf("This number does not exist in this array.\n");

else

printf("a[%d]=%d\n",p,x);

}

9.2.2 折半查找(二分查找)

使用折半查找必须具备两个前提条件:

(1)要求查找表中的记录按关键字有序(设,从小到大有序) (2)只能适用于顺序存储结构

}

※折半查找算法性能分析:

在折半查找的过程中,每经过一次比较,查找范围都要缩小一半,所 以折半查找的最大查找长度为

MSL=[log2 n]+1

当n足够大时,可近似的表示为log2(n)。可见在查找速度上,折半查找 比顺序查找速度要快的多,这是它的主要优点。

结论:折半查找要求查找表按关键字有序,而排序是一 种很费时的运算;另外,折半查找要求表是顺序存储的,为 保持表的有序性,在进行插入和删除操作时,都必须移动大 量记录。因此,折半查找的高查找效率是以牺牲排序为代价 的,它特别适合于一经建立就很少移动、而又经常需要查找 的线性表。

查找技术分为: 1 静态查找表技术 顺序查找、折半查找、索引顺序查找 2 动态查找表技术 二叉查找树 3哈希表技术 哈希表技术

※查找算法的衡量指标

在查找一个记录时所做的主要操作是关键字的比较, 所以通常把查找过程中对关键字的平均比较次数作为衡量 一个查找算法效率优劣的标准,并称平均比较次数为平均 查找长度(Average Search Length)。平均查找长度的 定义为:

high2=N-1;

/*N为查找表的长度,high2为块在表中的末地址*/

else

high2=ID[low1+1].addr-1;

数据结构课程设计可选题目

数据结构课程设计可选题目一、课程设计的目的学习数据结构与算法的最终目的是解决实际的应用问题,特别是非数值计算类型的应用问题。

课程设计要求同学独立完成一个较为完整的应用需求分析,在完成设计和编程大型作业的过程中,深化对数据结构与算法课程中基本概念、理论和方法的理解;训练综合运用所学知识处理实际问题的能力,强化面向对象的程序设计理念;使同学的程序设计与调试水平有一个明显的提高。

二、数据结构课程设计可选题目1. 运动会分数统计(限1 人完成)任务:参加运动会有n个学校,学校编号为1……n。

比赛分成m个男子项目,和w个女子项目。

项目编号为男子1……m,女子m+1……m+w。

不同的项目取前五名或前三名积分;取前五名的积分分别为:7、5、3、2、1,前三名的积分分别为:5、3、2;哪些取前五名或前三名由学生自己设定。

(m<=20,n<=20)功能要求:1) 可以输入各个项目的前三名或前五名的成绩;2) 能统计各学校总分,3) 可以按学校编号或名称、学校总分、男女团体总分排序输出;4) 可以按学校编号查询学校某个项目的情况;可以按项目编号查询取得前三或前五名的学校;5) 数据存入文件并能随时查询;6) 规定:①输入数据形式和范围:可以输入学校的名称,运动项目的名称;②输出形式:有中文提示,各学校分数为整形;③界面要求:有合理的提示,每个功能可以设立菜单,根据提示,可以完成相关的功能要求。

④存储结构:学生自己根据系统功能要求自己设计,但是要求运动会的相关数据要存储在数据文件中。

(数据文件的数据读写方法等相关内容在c语言程序设计的书上)请在最后的上交资料中指明你用到的存储结构;⑤测试数据:要求使用a.全部合法数据;b.整体非法数据;c.局部非法数据进行程序测试,以保证程序的稳定。

测试数据及测试结果请在上交的资料中写明。

2. 飞机订票系统任务:通过此系统可以实现如下功能:⑴录入:可以录入航班情况(数据可以存储在一个数据文件中,数据结构、具体数据自定)⑵查询:可以查询某个航线的情况(如,输入航班号,查询起降时间,起飞抵达城市,航班票价,票价折扣,确定航班是否满仓);⑶可以输入起飞抵达城市,查询飞机航班情况;⑷订票:(订票情况可以存在一个数据文件中,结构自己设定)可以订票,如果该航班已经无票,可以提供相关可选择航班;⑸退票:可退票,退票后修改相关数据文件;⑹客户资料有姓名,证件号,订票数量及航班情况,订单要有编号。

数据结构查找表

如何进行查找

在一个结构中查找某个数据元素的过程,依赖于数据 元素在结构中的地位,即依赖于数据元素的组织关系 (人为的)。

在计算机中进行查找的方法随数据结构不同而不同。 即随查找表的不同而不同。

9.1 静态查找表

顺序表的查找 有序表的查找 静态树表的查找

查找表的结构 查找过程描述 查找性能分析 查找方法比较

n ASLbs log 2 ( 1) 1 s

9.2 动态查找表

动态查找表的ADT

动态查找表的特点是,表结构本身是在查找过程中动态生成的。即, 对于给定值key,若表中存在其关键字等于key的记录,则查找成 功返回;否则,插入关键字等于key的记录。

P226: SearchDSTable(DT,key ); InsertDSTable(&DT,e ); DeleteDSTable(&DT, e );

给定值进行比较的关键字个数最多也不超过log2 n 1

折半查找的ASL

假设有序表的长度为n=2h-1,则描述折半查找的判定树是深度 为h的满二叉树。 该树中层次为1的结点有1个,层次为2的结点有2个,…,层次 为h的结点有2h-1个。 假设有序表中每个记录的查找概率相等(Pi = 1/n)。

05 low 13 19 21 37 56 64 75 80 88 92 high

mid

high low

mid (low high) / 2

例子

给定值key = 21的查找过程: 给定值key = 85的查找过程:

下界low>上界high,查找不成功。

int Search_Bin( SSTable ST,KeyType key ){ low = 1; high = ST.length; while( low <= high ){ mid = ( low + high ) /2; if EQ( key , ST.elem[mid].key ) return mid; else if LT( key , ST.elem[mid].key ) high = mid-1; else low = mid +1; } return 0; }

大学数据结构课件--第9章 查找

二叉排序树既有类似于折半查找的特性,又采用了链表存储,它是动态 查找表的一种适宜表示。

注:若数据元素的输入顺序不同,则得到的二叉排序树形态 也不同!

17

二、二叉树的插入和删除操作

1、二叉排序树的插入和查找操作

例:输入待查找的关键字序列=(45,24,53,12,90)

折半查找举例:

已知如下11个元素的有序表:

(05 13 19 21 37 56 64 75 80 88 92), 请查找关键字为21和85的数据元素。

Low指向待查元 素所在区间的下 界

mid指向待查元素所在 high指向待查元素所

区间的中间位置

在区间的上界

8

9.1.2 折半查找(又称二分查找或对分查找)

balance。这样,可以得到AVL树的其它性质:

❖ 任一结点的平衡因子只能取:-1、0 或 1;如果树中任 意一个结点的平衡因子的绝对值大于1,则这棵二叉树 就失去平衡,不再是AVL树;

24

三、平衡二叉树

例:判断下列二叉树是否AVL树?

-1

1

-1

0

0

1

0

(a) 平衡树

2

-1

0

0

1

0

(b) 不是平衡树

(1)p为叶子结点,只需修改p双亲f的指针f->lchild=NULL或 f->rchild=NULL

(2)P只有左子树或右子树 ❖ P只有左子树,用P的左孩子代替P ❖ P只有右子树,用P的右孩子代替P

(3)P左、右子树均非空 (P左子树的根C的右子树分支找到S,S的右子树为空) ❖ P的左子树成为双亲f的左子树,P的右子树成为S的右子树 ❖ S的左子树成为S的双亲Q的右子树,用S取代p; 若C无右子树,用C取代p

《数据结构与算法分析》(C++第二版)【美】Clifford A.Shaffer著 课后习题答案 二

《数据结构与算法分析》(C++第二版)【美】Clifford A.Shaffer著课后习题答案二5Binary Trees5.1 Consider a non-full binary tree. By definition, this tree must have some internalnode X with only one non-empty child. If we modify the tree to removeX, replacing it with its child, the modified tree will have a higher fraction ofnon-empty nodes since one non-empty node and one empty node have been removed.5.2 Use as the base case the tree of one leaf node. The number of degree-2 nodesis 0, and the number of leaves is 1. Thus, the theorem holds.For the induction hypothesis, assume the theorem is true for any tree withn − 1 nodes.For the induction step, consider a tree T with n nodes. Remove from the treeany leaf node, and call the resulting tree T. By the induction hypothesis, Thas one more leaf node than it has nodes of degree 2.Now, restore the leaf node that was removed to form T. There are twopossible cases.(1) If this leaf node is the only child of its parent in T, then the number ofnodes of degree 2 has not changed, nor has the number of leaf nodes. Thus,the theorem holds.(2) If this leaf node is the child of a node in T with degree 2, then that nodehas degree 1 in T. Thus, by restoring the leaf node we are adding one newleaf node and one new node of degree 2. Thus, the theorem holds.By mathematical induction, the theorem is correct.32335.3 Base Case: For the tree of one leaf node, I = 0, E = 0, n = 0, so thetheorem holds.Induction Hypothesis: The theorem holds for the full binary tree containingn internal nodes.Induction Step: Take an arbitrary tree (call it T) of n internal nodes. Selectsome internal node x from T that has two leaves, and remove those twoleaves. Call the resulting tree T’. Tree T’ is full and has n−1 internal nodes,so by the Induction Hypothesis E = I + 2(n − 1).Call the depth of node x as d. Restore the two children of x, each at leveld+1. We have nowadded d to I since x is now once again an internal node.We have now added 2(d + 1) − d = d + 2 to E since we added the two leafnodes, but lost the contribution of x to E. Thus, if before the addition we had E = I + 2(n − 1) (by the induction hypothesis), then after the addition we have E + d = I + d + 2 + 2(n − 1) or E = I + 2n which is correct. Thus,by the principle of mathematical induction, the theorem is correct.5.4 (a) template <class Elem>void inorder(BinNode<Elem>* subroot) {if (subroot == NULL) return; // Empty, do nothingpreorder(subroot->left());visit(subroot); // Perform desired actionpreorder(subroot->right());}(b) template <class Elem>void postorder(BinNode<Elem>* subroot) {if (subroot == NULL) return; // Empty, do nothingpreorder(subroot->left());preorder(subroot->right());visit(subroot); // Perform desired action}5.5 The key is to search both subtrees, as necessary.template <class Key, class Elem, class KEComp>bool search(BinNode<Elem>* subroot, Key K);if (subroot == NULL) return false;if (subroot->value() == K) return true;if (search(subroot->right())) return true;return search(subroot->left());}34 Chap. 5 Binary Trees5.6 The key is to use a queue to store subtrees to be processed.template <class Elem>void level(BinNode<Elem>* subroot) {AQueue<BinNode<Elem>*> Q;Q.enqueue(subroot);while(!Q.isEmpty()) {BinNode<Elem>* temp;Q.dequeue(temp);if(temp != NULL) {Print(temp);Q.enqueue(temp->left());Q.enqueue(temp->right());}}}5.7 template <class Elem>int height(BinNode<Elem>* subroot) {if (subroot == NULL) return 0; // Empty subtreereturn 1 + max(height(subroot->left()),height(subroot->right()));}5.8 template <class Elem>int count(BinNode<Elem>* subroot) {if (subroot == NULL) return 0; // Empty subtreeif (subroot->isLeaf()) return 1; // A leafreturn 1 + count(subroot->left()) +count(subroot->right());}5.9 (a) Since every node stores 4 bytes of data and 12 bytes of pointers, the overhead fraction is 12/16 = 75%.(b) Since every node stores 16 bytes of data and 8 bytes of pointers, the overhead fraction is 8/24 ≈ 33%.(c) Leaf nodes store 8 bytes of data and 4 bytes of pointers; internal nodesstore 8 bytes of data and 12 bytes of pointers. Since the nodes havedifferent sizes, the total space needed for internal nodes is not the sameas for leaf nodes. Students must be careful to do the calculation correctly,taking the weighting into account. The correct formula looks asfollows, given that there are x internal nodes and x leaf nodes.4x + 12x12x + 20x= 16/32 = 50%.(d) Leaf nodes store 4 bytes of data; internal nodes store 4 bytes of pointers. The formula looks as follows, given that there are x internal nodes and35x leaf nodes:4x4x + 4x= 4/8 = 50%.5.10 If equal valued nodes were allowed to appear in either subtree, then during a search for all nodes of a given value, whenever we encounter a node of that value the search would be required to search in both directions.5.11 This tree is identical to the tree of Figure 5.20(a), except that a node with value 5 will be added as the right child of the node with value 2.5.12 This tree is identical to the tree of Figure 5.20(b), except that the value 24 replaces the value 7, and the leaf node that originally contained 24 is removed from the tree.5.13 template <class Key, class Elem, class KEComp>int smallcount(BinNode<Elem>* root, Key K);if (root == NULL) return 0;if (KEComp.gt(root->value(), K))return smallcount(root->leftchild(), K);elsereturn smallcount(root->leftchild(), K) +smallcount(root->rightchild(), K) + 1;5.14 template <class Key, class Elem, class KEComp>void printRange(BinNode<Elem>* root, int low,int high) {if (root == NULL) return;if (KEComp.lt(high, root->val()) // all to leftprintRange(root->left(), low, high);else if (KEComp.gt(low, root->val())) // all to rightprintRange(root->right(), low, high);else { // Must process both childrenprintRange(root->left(), low, high);PRINT(root->value());printRange(root->right(), low, high);}}5.15 The minimum number of elements is contained in the heap with a single node at depth h − 1, for a total of 2h−1 nodes.The maximum number of elements is contained in the heap that has completely filled up level h − 1, for a total of 2h − 1 nodes.5.16 The largest element could be at any leaf node.5.17 The corresponding array will be in the following order (equivalent to level order for the heap):12 9 10 5 4 1 8 7 3 236 Chap. 5 Binary Trees5.18 (a) The array will take on the following order:6 5 3 4 2 1The value 7 will be at the end of the array.(b) The array will take on the following order:7 4 6 3 2 1The value 5 will be at the end of the array.5.19 // Min-heap classtemplate <class Elem, class Comp> class minheap {private:Elem* Heap; // Pointer to the heap arrayint size; // Maximum size of the heapint n; // # of elements now in the heapvoid siftdown(int); // Put element in correct placepublic:minheap(Elem* h, int num, int max) // Constructor{ Heap = h; n = num; size = max; buildHeap(); }int heapsize() const // Return current size{ return n; }bool isLeaf(int pos) const // TRUE if pos a leaf{ return (pos >= n/2) && (pos < n); }int leftchild(int pos) const{ return 2*pos + 1; } // Return leftchild posint rightchild(int pos) const{ return 2*pos + 2; } // Return rightchild posint parent(int pos) const // Return parent position { return (pos-1)/2; }bool insert(const Elem&); // Insert value into heap bool removemin(Elem&); // Remove maximum value bool remove(int, Elem&); // Remove from given pos void buildHeap() // Heapify contents{ for (int i=n/2-1; i>=0; i--) siftdown(i); }};template <class Elem, class Comp>void minheap<Elem, Comp>::siftdown(int pos) { while (!isLeaf(pos)) { // Stop if pos is a leafint j = leftchild(pos); int rc = rightchild(pos);if ((rc < n) && Comp::gt(Heap[j], Heap[rc]))j = rc; // Set j to lesser child’s valueif (!Comp::gt(Heap[pos], Heap[j])) return; // Done37swap(Heap, pos, j);pos = j; // Move down}}template <class Elem, class Comp>bool minheap<Elem, Comp>::insert(const Elem& val) { if (n >= size) return false; // Heap is fullint curr = n++;Heap[curr] = val; // Start at end of heap// Now sift up until curr’s parent < currwhile ((curr!=0) &&(Comp::lt(Heap[curr], Heap[parent(curr)]))) {swap(Heap, curr, parent(curr));curr = parent(curr);}return true;}template <class Elem, class Comp>bool minheap<Elem, Comp>::removemin(Elem& it) { if (n == 0) return false; // Heap is emptyswap(Heap, 0, --n); // Swap max with last valueif (n != 0) siftdown(0); // Siftdown new root valit = Heap[n]; // Return deleted valuereturn true;}38 Chap. 5 Binary Trees// Remove value at specified positiontemplate <class Elem, class Comp>bool minheap<Elem, Comp>::remove(int pos, Elem& it) {if ((pos < 0) || (pos >= n)) return false; // Bad posswap(Heap, pos, --n); // Swap with last valuewhile ((pos != 0) &&(Comp::lt(Heap[pos], Heap[parent(pos)])))swap(Heap, pos, parent(pos)); // Push up if largesiftdown(pos); // Push down if small keyit = Heap[n];return true;}5.20 Note that this summation is similar to Equation 2.5. To solve the summation requires the shifting technique from Chapter 14, so this problem may be too advanced for many students at this time. Note that 2f(n) − f(n) = f(n),but also that:2f(n) − f(n) = n(24+48+616+ ··· +2(log n − 1)n) −n(14+28+316+ ··· +log n − 1n)logn−1i=112i− log n − 1n)= n(1 − 1n− log n − 1n)= n − log n.5.21 Here are the final codes, rather than a picture.l 00h 010i 011e 1000f 1001j 101d 11000a 1100100b 1100101c 110011g 1101k 11139The average code length is 3.234455.22 The set of sixteen characters with equal weight will create a Huffman coding tree that is complete with 16 leaf nodes all at depth 4. Thus, the average code length will be 4 bits. This is identical to the fixed length code. Thus, in this situation, the Huffman coding tree saves no space (and costs no space).5.23 (a) By the prefix property, there can be no character with codes 0, 00, or 001x where “x” stands for any binary string.(b) There must be at least one code with each form 1x, 01x, 000x where“x” could be any binary string (including the empty string).5.24 (a) Q and Z are at level 5, so any string of length n containing only Q’s and Z’s requires 5n bits.(b) O and E are at level 2, so any string of length n containing only O’s and E’s requires 2n bits.(c) The weighted average is5 ∗ 5 + 10 ∗ 4 + 35 ∗ 3 + 50 ∗ 2100bits per character5.25 This is a straightforward modification.// Build a Huffman tree from minheap h1template <class Elem>HuffTree<Elem>*buildHuff(minheap<HuffTree<Elem>*,HHCompare<Elem> >* hl) {HuffTree<Elem> *temp1, *temp2, *temp3;while(h1->heapsize() > 1) { // While at least 2 itemshl->removemin(temp1); // Pull first two treeshl->removemin(temp2); // off the heaptemp3 = new HuffTree<Elem>(temp1, temp2);hl->insert(temp3); // Put the new tree back on listdelete temp1; // Must delete the remnantsdelete temp2; // of the trees we created}return temp3;}6General Trees6.1 The following algorithm is linear on the size of the two trees. // Return TRUE iff t1 and t2 are roots of identical// general treestemplate <class Elem>bool Compare(GTNode<Elem>* t1, GTNode<Elem>* t2) { GTNode<Elem> *c1, *c2;if (((t1 == NULL) && (t2 != NULL)) ||((t2 == NULL) && (t1 != NULL)))return false;if ((t1 == NULL) && (t2 == NULL)) return true;if (t1->val() != t2->val()) return false;c1 = t1->leftmost_child();c2 = t2->leftmost_child();while(!((c1 == NULL) && (c2 == NULL))) {if (!Compare(c1, c2)) return false;if (c1 != NULL) c1 = c1->right_sibling();if (c2 != NULL) c2 = c2->right_sibling();}}6.2 The following algorithm is Θ(n2).// Return true iff t1 and t2 are roots of identical// binary treestemplate <class Elem>bool Compare2(BinNode<Elem>* t1, BinNode<Elem* t2) { BinNode<Elem> *c1, *c2;if (((t1 == NULL) && (t2 != NULL)) ||((t2 == NULL) && (t1 != NULL)))return false;if ((t1 == NULL) && (t2 == NULL)) return true;4041if (t1->val() != t2->val()) return false;if (Compare2(t1->leftchild(), t2->leftchild())if (Compare2(t1->rightchild(), t2->rightchild())return true;if (Compare2(t1->leftchild(), t2->rightchild())if (Compare2(t1->rightchild(), t2->leftchild))return true;return false;}6.3 template <class Elem> // Print, postorder traversalvoid postprint(GTNode<Elem>* subroot) {for (GTNode<Elem>* temp = subroot->leftmost_child();temp != NULL; temp = temp->right_sibling())postprint(temp);if (subroot->isLeaf()) cout << "Leaf: ";else cout << "Internal: ";cout << subroot->value() << "\n";}6.4 template <class Elem> // Count the number of nodesint gencount(GTNode<Elem>* subroot) {if (subroot == NULL) return 0int count = 1;GTNode<Elem>* temp = rt->leftmost_child();while (temp != NULL) {count += gencount(temp);temp = temp->right_sibling();}return count;}6.5 The Weighted Union Rule requires that when two parent-pointer trees are merged, the smaller one’s root becomes a child of the larger one’s root. Thus, we need to keep track of the number of nodes in a tree. To do so, modify the node array to store an integer value with each node. Initially, each node isin its own tree, so the weights for each node begin as 1. Whenever we wishto merge two trees, check the weights of the roots to determine which has more nodes. Then, add to the weight of the final root the weight of the new subtree.6.60 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15-1 0 0 0 0 0 0 6 0 0 0 9 0 0 12 06.7 The resulting tree should have the following structure:42 Chap. 6 General TreesNode 0 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15Parent 4 4 4 4 -1 4 4 0 0 4 9 9 9 12 9 -16.8 For eight nodes labeled 0 through 7, use the following series of equivalences: (0, 1) (2, 3) (4, 5) (6, 7) (4 6) (0, 2) (4 0)This requires checking fourteen parent pointers (two for each equivalence),but none are actually followed since these are all roots. It is possible todouble the number of parent pointers checked by choosing direct children ofroots in each case.6.9 For the “lists of Children” representation, every node stores a data value and a pointer to its list of children. Further, every child (every node except the root)has a record associated with it containing an index and a pointer. Indicatingthe size of the data value as D, the size of a pointer as P and the size of anindex as I, the overhead fraction is3P + ID + 3P + I.For the “Left Child/Right Sibling” representation, every node stores three pointers and a data value, for an overhead fraction of3PD + 3P.The first linked representation of Section 6.3.3 stores with each node a datavalue and a size field (denoted by S). Each child (every node except the root)also has a pointer pointing to it. The overhead fraction is thusS + PD + S + Pmaking it quite efficient.The second linked representation of Section 6.3.3 stores with each node adata value and a pointer to the list of children. Each child (every node exceptthe root) has two additional pointers associated with it to indicate its placeon the parent’s linked list. Thus, the overhead fraction is3PD + 3P.6.10 template <class Elem>BinNode<Elem>* convert(GTNode<Elem>* genroot) {if (genroot == NULL) return NULL;43GTNode<Elem>* gtemp = genroot->leftmost_child();btemp = new BinNode(genroot->val(), convert(gtemp),convert(genroot->right_sibling()));}6.11 • Parent(r) = (r − 1)/k if 0 < r < n.• Ith child(r) = kr + I if kr +I < n.• Left sibling(r) = r − 1 if r mod k = 1 0 < r < n.• Right sibling(r) = r + 1 if r mod k = 0 and r + 1 < n.6.12 (a) The overhead fraction is4(k + 1)4 + 4(k + 1).(b) The overhead fraction is4k16 + 4k.(c) The overhead fraction is4(k + 2)16 + 4(k + 2).(d) The overhead fraction is2k2k + 4.6.13 Base Case: The number of leaves in a non-empty tree of 0 internal nodes is (K − 1)0 + 1 = 1. Thus, the theorem is correct in the base case.Induction Hypothesis: Assume that the theorem is correct for any full Karytree containing n internal nodes.Induction Step: Add K children to an arbitrary leaf node of the tree withn internal nodes. This new tree now has 1 more internal node, and K − 1more leaf nodes, so theorem still holds. Thus, the theorem is correct, by the principle of Mathematical Induction.6.14 (a) CA/BG///FEDD///H/I//(b) CA/BG/FED/H/I6.15 X|P-----| | |C Q R---| |V M44 Chap. 6 General Trees6.16 (a) // Use a helper function with a pass-by-reference// variable to indicate current position in the// node list.template <class Elem>BinNode<Elem>* convert(char* inlist) {int curr = 0;return converthelp(inlist, curr);}// As converthelp processes the node list, curr is// incremented appropriately.template <class Elem>BinNode<Elem>* converthelp(char* inlist,int& curr) {if (inlist[curr] == ’/’) {curr++;return NULL;}BinNode<Elem>* temp = new BinNode(inlist[curr++], NULL, NULL);temp->left = converthelp(inlist, curr);temp->right = converthelp(inlist, curr);return temp;}(b) // Use a helper function with a pass-by-reference // variable to indicate current position in the// node list.template <class Elem>BinNode<Elem>* convert(char* inlist) {int curr = 0;return converthelp(inlist, curr);}// As converthelp processes the node list, curr is// incremented appropriately.template <class Elem>BinNode<Elem>* converthelp(char* inlist,int& curr) {if (inlist[curr] == ’/’) {curr++;return NULL;}BinNode<Elem>* temp =new BinNode<Elem>(inlist[curr++], NULL, NULL);if (inlist[curr] == ’\’’) return temp;45curr++ // Eat the internal node mark.temp->left = converthelp(inlist, curr);temp->right = converthelp(inlist, curr);return temp;}(c) // Use a helper function with a pass-by-reference// variable to indicate current position in the// node list.template <class Elem>GTNode<Elem>* convert(char* inlist) {int curr = 0;return converthelp(inlist, curr);}// As converthelp processes the node list, curr is// incremented appropriately.template <class Elem>GTNode<Elem>* converthelp(char* inlist,int& curr) {if (inlist[curr] == ’)’) {curr++;return NULL;}GTNode<Elem>* temp =new GTNode<Elem>(inlist[curr++]);if (curr == ’)’) {temp->insert_first(NULL);return temp;}temp->insert_first(converthelp(inlist, curr));while (curr != ’)’)temp->insert_next(converthelp(inlist, curr));curr++;return temp;}6.17 The Huffman tree is a full binary tree. To decode, we do not need to know the weights of nodes, only the letter values stored in the leaf nodes. Thus, we can use a coding much like that of Equation 6.2, storing only a bit mark for internal nodes, and a bit mark and letter value for leaf nodes.7Internal Sorting7.1 Base Case: For the list of one element, the double loop is not executed and the list is not processed. Thus, the list of one element remains unaltered and is sorted.Induction Hypothesis: Assume that the list of n elements is sorted correctlyby Insertion Sort.Induction Step: The list of n + 1 elements is processed by first sorting thetop n elements. By the induction hypothesis, this is done correctly. The final pass of the outer for loop will process the last element (call it X). This isdone by the inner for loop, which moves X up the list until a value smallerthan that of X is encountered. At this point, X has been properly insertedinto the sorted list, leaving the entire collection of n + 1 elements correctly sorted. Thus, by the principle of Mathematical Induction, the theorem is correct.7.2 void StackSort(AStack<int>& IN) {AStack<int> Temp1, Temp2;while (!IN.isEmpty()) // Transfer to another stackTemp1.push(IN.pop());IN.push(Temp1.pop()); // Put back one elementwhile (!Temp1.isEmpty()) { // Process rest of elemswhile (IN.top() > Temp1.top()) // Find elem’s placeTemp2.push(IN.pop());IN.push(Temp1.pop()); // Put the element inwhile (!Temp2.isEmpty()) // Put the rest backIN.push(Temp2.pop());}}46477.3 The revised algorithm will work correctly, and its asymptotic complexity will remain Θ(n2). However, it will do about twice as many comparisons, since it will compare adjacent elements within the portion of the list already knownto be sorted. These additional comparisons are unproductive.7.4 While binary search will find the proper place to locate the next element, it will still be necessary to move the intervening elements down one position in the array. This requires the same number of operations as a sequential search. However, it does reduce the number of element/element comparisons, and may be somewhat faster by a constant factor since shifting several elements may be more efficient than an equal number of swap operations.7.5 (a) template <class Elem, class Comp>void selsort(Elem A[], int n) { // Selection Sortfor (int i=0; i<n-1; i++) { // Select i’th recordint lowindex = i; // Remember its indexfor (int j=n-1; j>i; j--) // Find least valueif (Comp::lt(A[j], A[lowindex]))lowindex = j; // Put it in placeif (i != lowindex) // Add check for exerciseswap(A, i, lowindex);}}(b) There is unlikely to be much improvement; more likely the algorithmwill slow down. This is because the time spent checking (n times) isunlikely to save enough swaps to make up.(c) Try it and see!7.6 • Insertion Sort is stable. A swap is done only if the lower element’svalue is LESS.• Bubble Sort is stable. A swap is done only if the lower element’s valueis LESS.• Selection Sort is NOT stable. The new low value is set only if it isactually less than the previous one, but the direction of the search isfrom the bottom of the array. The algorithm will be stable if “less than”in the check becomes “less than or equal to” for selecting the low key position.• Shell Sort is NOT stable. The sublist sorts are done independently, andit is quite possible to swap an element in one sublist ahead of its equalvalue in another sublist. Once they are in the same sublist, they willretain this (incorrect) relationship.• Quick-sort is NOT stable. After selecting the pivot, it is swapped withthe last element. This action can easily put equal records out of place.48 Chap. 7 Internal Sorting• Conceptually (in particular, the linked list version) Mergesort is stable.The array implementations are NOT stable, since, given that the sublistsare stable, the merge operation will pick the element from the lower listbefore the upper list if they are equal. This is easily modified to replace“less than” with “less than or equal to.”• Heapsort is NOT stable. Elements in separate sides of the heap are processed independently, and could easily become out of relative order.• Binsort is stable. Equal values that come later are appended to the list.• Radix Sort is stable. While the processing is from bottom to top, thebins are also filled from bottom to top, preserving relative order.7.7 In the worst case, the stack can store n records. This can be cut to log n in the worst case by putting the larger partition on FIRST, followed by the smaller. Thus, the smaller will be processed first, cutting the size of the next stacked partition by at least half.7.8 Here is how I derived a permutation that will give the desired (worst-case) behavior:a b c 0 d e f g First, put 0 in pivot index (0+7/2),assign labels to the other positionsa b c g d e f 0 First swap0 b c g d e f a End of first partition pass0 b c g 1 e f a Set d = 1, it is in pivot index (1+7/2)0 b c g a e f 1 First swap0 1 c g a e f b End of partition pass0 1 c g 2 e f b Set a = 2, it is in pivot index (2+7/2)0 1 c g b e f 2 First swap0 1 2 g b e f c End of partition pass0 1 2 g b 3 f c Set e = 3, it is in pivot index (3+7/2)0 1 2 g b c f 3 First swap0 1 2 3 b c f g End of partition pass0 1 2 3 b 4 f g Set c = 4, it is in pivot index (4+7/2)0 1 2 3 b g f 4 First swap0 1 2 3 4 g f b End of partition pass0 1 2 3 4 g 5 b Set f = 5, it is in pivot index (5+7/2)0 1 2 3 4 g b 5 First swap0 1 2 3 4 5 b g End of partition pass0 1 2 3 4 5 6 g Set b = 6, it is in pivot index (6+7/2)0 1 2 3 4 5 g 6 First swap0 1 2 3 4 5 6 g End of parition pass0 1 2 3 4 5 6 7 Set g = 7.Plugging the variable assignments into the original permutation yields:492 6 4 0 13 5 77.9 (a) Each call to qsort costs Θ(i log i). Thus, the total cost isni=1i log i = Θ(n2 log n).(b) Each call to qsort costs Θ(n log n) for length(L) = n, so the totalcost is Θ(n2 log n).7.10 All that we need to do is redefine the comparison test to use strcmp. The quicksort algorithm itself need not change. This is the advantage of paramerizing the comparator.7.11 For n = 1000, n2 = 1, 000, 000, n1.5 = 1000 ∗√1000 ≈ 32, 000, andn log n ≈ 10, 000. So, the constant factor for Shellsort can be anything less than about 32 times that of Insertion Sort for Shellsort to be faster. The constant factor for Shellsort can be anything less than about 100 times thatof Insertion Sort for Quicksort to be faster.7.12 (a) The worst case occurs when all of the sublists are of size 1, except for one list of size i − k + 1. If this happens on each call to SPLITk, thenthe total cost of the algorithm will be Θ(n2).(b) In the average case, the lists are split into k sublists of roughly equal length. Thus, the total cost is Θ(n logk n).7.13 (This question comes from Rawlins.) Assume that all nuts and all bolts havea partner. We use two arrays N[1..n] and B[1..n] to represent nuts and bolts. Algorithm 1Using merge-sort to solve this problem.First, split the input into n/2 sub-lists such that each sub-list contains twonuts and two bolts. Then sort each sub-lists. We could well come up with apair of nuts that are both smaller than either of a pair of bolts. In that case,all you can know is something like:N1, N2。

数据结构-查找

数据结构-查找写在前⾯:这些内容是以考研的⾓度去学习和理解的,很多考试中需要⽤到的内容在实际应⽤中可能⽤不上,⽐如其中的计算问题,但是如果掌握这些东西会帮你更好的理解这些内容。

这篇关于查找的博客也只是⽤来记录以便于后续复习的,所以很多地⽅只是浅谈,并没有代码的实现如果有缘发现这篇⽂章想要深⼊了解或者因为作者表达能⼒差⽽看不懂以及有错的地⽅,欢迎留⾔指出来,我会尽快去完善的,期待有缘⼈内容多和杂,如果有机会我进⼀步进⾏梳理,将其重新梳理⼀⽚⽂章(会更注重于代码)本来只是想简单写⼀下的,但是不⼩⼼就get不到重点了本来打算等逐步完善和优化后再发出来的,但那样继续往前总感觉有所顾及,所以就先给这⼏天查找的复习暂时告⼀段落吧。

导学概览总体(⼀)概念查找:在数据集合中查找特定元素的过程查找表(查找结构):同⼀类型数据元素构成的集合静态查找表:只涉及查找,不存在修改适⽤:顺序查找,折半查找,散列查找等动态查找表:动态插⼊和删除,对查找表进⾏修改适⽤:⼆叉排序树,散列查找等所有数据结构都可以看作是查找表,对于折半查找和顺序查找这些都属于查找算法关键字:数据元素中唯⼀标识该元素的某数据项的值主关键字:此关键字能唯⼀表⽰⼀个数据元素次关键字:此关键字⽤以识别若⼲记录(⼀对多)说明:在查找表中每个数据元素就相当于⼀条记录,包含有不同的数据项,例如拿学⽣为例,⼀个学⽣作为数据元素,那么学号,⾝⾼,姓名就是这个元素中的数据项,每个学⽣都有特定的学号,因此学号可以作为关键字。

(当然如果数据项包含⾝份证号,你⽤⾝份证号⾛位关键字也可以)0x01平均查找长度(重点注意:作为查找算法效率衡量的主要指标,那么查找算法的性能分析肯定是重点分析平均查找长度的,因此必须熟练掌握。

提⼀嘴,算法效率的度量前⾯学过时间和空间复杂度,但是算法效率的度量不是只取决于时间和空间复杂度,针对不同的算法还可能会有其他⼀些辅助度量,如查找算法中的平均查找长度。

【填空题】考研数据结构填空题整理

【填空题】考研数据结构填空题整理数据结构填空题题源来⾃《算法与数据结构考研试题精析》⼀、概论1. 在数据结构中,数据的逻辑结构分线性结构和线性结构。

2. 链接存储的特点是利⽤指针来表⽰数据元之间的逻辑关系。

3. 数据的物理结构包括数据元素的表⽰和数据元素间关系的表⽰。

4. 对于给定的n个元素,可以构造出的逻辑结构有集合、线性结构、树形结构、图结构四种。

5. 数据结构由数据的逻辑结构、存储结构和运算三部分组成。

6. ⼀个数据结构在计算机中的表⽰称为存储结构。

7. 数据的逻辑结构是指数据的组织形式,即数据元素之间逻辑关系的总体。

8. 数据结构是研讨数据的逻辑结构和物理结构,以及它们之间的相互关系,并对与这种结构定义相应的操作,设计出相应的算法。

9. 抽象数据类型的定义仅取决于它的⼀组逻辑特性,⽽与在计算机内部如若表⽰和实现⽆关,即不论其内部结构如何变化,只要它的数学特性不变,都不影响其外部使⽤。

⼆、线性表1. 在单链表中设置头结点的作⽤是有头结点后,插⼊元素和删除元素的算法统⼀了,不再需要判断是否在第⼀个元素之前插⼊和删除第⼀个元素。

2. 根据线性表的链式存储结构中每⼀个结点包含的指针个数,将线性链表分成单链表和双链表;⽽⼜根据指针的连接⽅式,链表⼜可分成链表和静态链表。

3. 链接存储的特点是利⽤指针来表⽰数据元素之间的逻辑关系。

4. 顺序存储结构是通过结点物理上相邻表⽰元素之间的关系的;链式存储结构是通过结点指针表⽰元素之间的关系的。

5. 循环单链表的最⼤优点是:从任⼀结点出发都可访问到链表中每⼀个元素。

6. 指针p指向单链表的某个结点,在指针p所指结点之前插⼊s所指结点。

操作序列: s->next=p->next;p->next=s;p->data<-->s->data 。

这⾥⽤交换两结点数据的办法达到在结点前插⼊结点的⽬的。

7. 判断带头结点的双循环链表L仅有⼀个元素结点的条件是 L->next->next=L&&L->prior->prior==L&&L->next!=L 。

查找-数据结构

平均查找长度:为确定记录在查找表中 的位置,需和给定值进行比较的关键字 个数的期望值称为查找算法在查找成功 时的平均查找长度,简称ASL。

对于含有n个记录的表,查找成功时的平 均查找长度为: n ASL PiCi i 1

其找到中表:中Pi为其查关找键表字中与第给i定个值记相录等的的概第率,i个C记i为 录时和给定值已进行过比较的关键字个数。

(1)若*p 为叶子结点,直接删除即可。

45

45

12

3

37

53

f

100

24

p

61

60

90

12

53

3

删除24

f->lchild = null; delete p;

37

100

61

60

90

78

78

(2)若*p结点只有左子树PL或只有右子树PR,此 时只要令PL或PR直接成为*f的左子树即可

f

F

f

F

p

P

p

二叉排序树的插入

基本思想:

若二叉排序树为空,则待插结点作为根结点插入 到空树中;

若待插结点的关键字值和根结点的关键字值相等, 则说明树中已有此结点,无需插入;

若待插结点的关键字值小于根结点的关键字值, 则将待插结点插入到根的左子树中;

若待插结点的关键字值大于根结点的关键字值, 则将待插结点插入到根的右子树中;

mid low

mid low

mid low

mid low

mid

mid

mid

mid

6

3

9

1

47

10

2

58

11

由此可见,二分查找过程恰好是走了一条从判 定树的根到被查结点的路径,比较的关键字个 数恰为该结点在判定树中的层数。

数据结构之查找课件PPT课件

索引表的定义

struct indexterm {

keytype key; int low, high; }; typedef struct indexterm index[MAXITEM]; 这里的keytype可以是任何相应的数据类型, 如int、float、或char等,在算法中,我们规 定keytype缺省是int类型。

int blksearch (sqlist r, index idx, int k, bn)

{

/*bn为块的个数*/

int i, j, mid, low=1, high=bn, find=0;

while (low<=high && !find)

{

➢ 顺序查找的优点是算法简单、适应面广,且 不要求表中数据有序。缺点是平均查找长度 较大,特别是当n较大时,查找效率较低, 不宜采用。

2.折半查找

➢ 折半查找又称二分查找(Birary search)。 ➢ 假设记录在查找表R[1…n]中按关键字排列有

序。首先用k与查找表中间元素的关键字比 较,。。。。。。

➢ 在实际应用问题中,每个记录一般包含 有多个数据域,查找是根据其中某一个 指定的域进行的,这个作为查找依据的 域称为关键字(key)。

➢ 顺序查找的线性表定义如下:

Typedef struct rectype {

keytype key; itemtype item1 …… }rectype;

➢ 比较结果有三种可能:

⑴ 如果r[m].key>k,说明如果存在欲查找的元素, 该元素一定在数组的前半部分,查找范围缩小了 一半,修改查找范围的的上界high=m-1,继续对 数组的前半部分进行二分查找;

数据结构 第九章查找

第九章查找:习题习题一、选择题1.散列表查找中k个关键字具有同一散列值,若用线性探测法将这k个关键字对应的记录存入散列表中,至少要进行( )次探测。

A. kB.k+lC. k(k+l)/2D. l+k (k+l)/22.下述命题( )是不成立的。

A. m阶B-树中的每一个结点的子树个数都小于或等于mB. m阶B-树中的每一个结点的子树个数都大于或等于『m/2-1C. m阶B-树中的每一个结点的子树高度都相等D.m阶B-树具有k个子树的非叶子结点含有(k-l)个关键字3.如果要求一个基本线性表既能较快地查找,又能适应动态变化的要求,可以采用( ) 查找方法。

A.分块B. 顺序C. 二分D.散列4.设有100个元素,用折半查找法进行查找时,最大比较次数是( ),最小比较次数是( )。

A.7,1B.6,lC.5,1D. 8,15.散列表长m=15,散列表函数H(key)=key%13。

表中已有4个结点:addr(18)=5;addr(32)=6; addr(59)=7; addr(73)=8;其余地址为空,如果用二次探测再散列处理冲突,关键字为109的结点的地址是( )。

A. 8B. 3C. 5D. 46.用分块查找时,若线性表中共有729个元素,查找每个元素的概率相同,假设采用顺序查找来确定结点所在的块时,每块应分( )个结点最佳。

A. 15B. 27C. 25D. 307.散列函数有一个共同性质,即函数值应当以( )取其值域的每个值。

A.同等概率B. 最大概率C. 最小概率D.平均概率8.设散列地址空间为O..m-1,k为关键字,假定散列函数为h(k)=k%p,为了减少冲突,一般应取p为( )。

A.小于m的最大奇数B. 小于m的最大素数C.小于m的最大偶数D.小于m的最大合数9.当向一棵m阶的B-树做插入操作时,若使一个结点中的关键字个数等于( ),则必须分裂成两个结点。

A.mB. m-lC.m+lD.[m+1]10.当向一棵m阶的B壤f做删除操作时,若使一个结点中的关键字个数等于( ),则可能需要用它的左兄弟或右兄弟结点合并成一个结点。

数据结构-C语言描述(第三版)(陈慧南)章 (9)

第9章 跳表和散列表 typedef int KeyType; typedef struct entry{ KeyType Key; DataType Data ; }Entry; typedef Entry T; typedef struct skipnode{ T Element; struct skipnode* Link[1]; } SkipNode;

函数CreateSkipList同时为表头结点、表尾结点和Last数组 分配空间。表头结点中有MaxLevel+1个用于指向各级链的指针, 它们被初始化为指向表尾结点。

第9章 跳表和散列表

9.2.2 跳表的搜索

本小节中我们介绍两个搜索跳表的函数 Search和SaveSearch。 前者是字典(集合)上定义的函数,后者是为了实现插入和删除 运算而设计的私有函数,并不面向用户。SaveSearch函数除了 包括Search函数的全部功能外,还把每一级遇到的最后一个结 点的地址存放在数组Last中。

第9章 跳表和散列表

例如要在图9-1(c)的跳表中搜索关键字值43。首先由第2层 表头指针开始向右搜索,令22与43比较,因为22<43,向右搜索; 令与43比较,现有≥43,所以下降到1层;令48与43比较,这 时 有 48≥43 , 再 次 下 降 到 第 0 层 ; 最 后 令 43 与 43 比 较 , 这 时 有 43≥43。在第0层的元素关键字值与待查关键字值比较后,还需 最后进行一次比较,以确定两关键字值是否相等,若两者相等, 则搜索成功,否则搜索失败。所以,在搜索过程中,与待查关 键字值43比较的跳表中的关键字值依次为22,,48,43,43。

第9章 跳表和散列表

当我们用C语言描述结点结构类型SkipNode时,我们定义 了长度为1的指针数组struct skipnode* Link[1],事实上,数组 Link的实际长度在动态分配跳表的结点空间时确定。函数 SkipNode* NewSkipNode(int lev)用于在动态创建跳表结点时, 根据所确定的该结点的级数(层次)申请元素域和指定数目的指 针域所需的空间大小。数组名称Link是该数组存储块的地址。

数据结构_第9章_查找2-二叉树和平衡二叉树

F

PS

C

PR

CL Q

QL SL S SL

10

3

18

2

6 12

6 删除10

3

18

2

4 12

4

15

15

三、二叉排序树的查找分析

1) 二叉排序树上查找某关键字等于给定值的结点过程,其实 就是走了一条从根到该结点的路径。 比较的关键字次数=此结点的层次数; 最多的比较次数=树的深度(或高度),即 log2 n+1

-0 1 24

0 37

0 37

-0 1

需要RL平衡旋转 (绕C先顺后逆)

24

0

-012

13

3573

0

01

37

90

0 53 0 53

0 90

作业

已知如下所示长度为12的表:

(Jan, Feb, Mar, Apr, May, June, July, Aug, Sep, Oct, Nov, Dec)

(1) 试按表中元素的顺序依次插入一棵初始为空的二叉 排序树,画出插入完成之后的二叉排序树,并求其在 等概率的情况下查找成功的平均查找长度。

2) 一棵二叉排序树的平均查找长度为:

n i1

ASL 1

ni Ci

m

其中:

ni 是每层结点个数; Ci 是结点所在层次数; m 为树深。

最坏情况:即插入的n个元素从一开始就有序, ——变成单支树的形态!

此时树的深度为n ; ASL= (n+1)/2 此时查找效率与顺序查找情况相同。

最好情况:即:与折半查找中的判ห้องสมุดไป่ตู้树相同(形态比较均衡) 树的深度为:log 2n +1 ; ASL=log 2(n+1) –1 ;与折半查找相同。

数据结构 查找

生成二叉排序树过程。

10 3 2 7 8 18 12

注:二叉排序树与关键字排列顺序有关,排列顺 序不一样,得到的二叉排序树也不一样。

二叉排序树的建立的算法

反复调用二叉排序树的插入算法即可 Bitree Creat (int n) { //建立含有n个结点的二叉排序树

Bitree T= NULL;

for ( int i=1; i<=n; i++) {

else if LT(key,p->key) p->lchild=s;

else p->rchild=s

return TRUE; }

//被插结点*s为右孩子

else return FALSE;

}// Insert BST

//树中已有关键字相同的结点,不再插入

4)二叉排序树的建立

例:关键字序列{ 10、18、3、8、12、2、7、3 }

5)二叉排序树上的删除

对于二叉排序树,删去树上一个结点相当于删去有序 序列中的一个记录,在删除某个结点之后依旧要保持二叉 排序树的特性。

如何在二叉排序树上删去一个结点呢?

设在二叉排序树上被删结点为*p(指向结点的指针为 p),其双亲结点为*f,设*p是*f的左孩子。 f F p P c PR C q Q s CL S QL SL

low

( 08,

( 08,

mid

14,

14,

high

55, 68, 79,

79,

23,

23,

37,

37,

46,

46,

91 )

low

55,

mid

68,

high

91 )

low mid

数据结构第九章:查找

low high mid

8

1 5

2 13

3 19

4 21

5 37

6 56

7 64

8 75

9 80

10 88

11 92

high low 1 5 2 13 3 19 4 21 5 37 6 56 6 3 1 2

算法描述: 算法描述:ENTER

9

7 64

8 75

9 80

10 88

11 92

判定树: 判定树:

17

考试题型介绍: 考试题型介绍:

1. 填空题 若用链表存储一棵二叉树时,每个结点除数据域外, 若用链表存储一棵二叉树时,每个结点除数据域外,还有指向左孩子和右 孩子的两个指针。在这种存储结构中, 个结点的二叉树共有 个结点的二叉树共有________个 孩子的两个指针。在这种存储结构中,n个结点的二叉树共有 个 指针域,其中有________个指针域是存放了地址,有 指针域,其中有 个指针域是存放了地址, 个指针域是存放了地址 ________________个指针是空指针。 个指针是空指针。 个指针是空指针 2. 选择题 设有序表中有1000个元素,则用二分查找查找元素X最多需要比较( )次 个元素,则用二分查找查找元素 最多需要比较 最多需要比较( 设有序表中有 个元素 A. 25 3. 简答题 已知序列( , , , , , , , , , ) 已知序列(10,18,4,3,6,12,1,9,18,8)请用快速排序写出每一 趟排序的结果。 趟排序的结果。 4. 算法题 设计判断单链表中元素是否是递增的算法。 设计判断单链表中元素是否是递增的算法。 已知: 已知: 1. 单链表已存在,并带有头结点; 单链表已存在,并带有头结点; 2. 要求写出详细的算法步骤或画出详细的流程图; 要求写出详细的算法步骤或画出详细的流程图; B. 10 C. 7 D. 1

数据结构-第9章 查找

静态查找表 对查找表的查找仅是以查询为 目的,不改动查找表中的数据。 动态查找表 在查找的过程中同时插入不存 在的记录,或删除某个已存在的记录。

查找成功 查找表中存在满足查找条件的记 录。 查找不成功 查找表中不存在满足查找条件 的记录。

内查找 整个查找过程都在内存中进行。 外查找 在查找过程中需要访问外存。 平均查找长度ASL——查找方法时效的度量 为确定记录在查找表中的位置,需和给定值 进行比较的关键字个数的期望值。 n 查找成功时的ASL计算方法: ASL pici

3. 在二叉排序树上的操作

1)查找

[例] Key=28 f 24 12 T

45

53 28 90

Key=32 T 45 24 53 12 f 28 90 32

[算法描述]

2) 插入

[算法描述]

3) 生成

查找算法

返回

BiTree SearchBST(BiTree T,KeyType key){

//在根指针T所指二叉树中递归地查找某关键字等于 //key的数据元素,若查找成功,则返回指向该数据元 //素结点的指针,否则返回空指针

图9.1 用折半查找法查找12、50的过程 其中mid=(low+high)/2,当high<low时,表 示不存在这样的子表空间,查找失败。

成功! 位 置 1 2 3 4 5 6 7 8 9 10 11

值

6 12 15 18 22 25 28 35 45 58 60

low hign mid mid hign mid low mid (a) 用折半查找法查找12的过程

[性能分析] • 空间:一个辅助空间。 • 时间: 查找成功时的平均查找长度 设表中各记录查找概率相等 n ASLs(n)= PiCi =(1+2+ ... +n)/n =(n+1)/2 i 1 [算法特点] • 算法简单,对表结构无任何要求 • n很大时查找效率较低 • 改进措施:非等概率查找时,可将查找概率高 的记录尽量排在表后部。

严蔚敏版数据结构C语言版PPT第九章

度较大,特别不适用于表长较大的查找表。

数

据 结

若以有序表表示查找表,则查找过程

构 可以基于“折半”进行。

折半查找只适用于有序表,且限于顺序存储结构

13

第 9 章 查找 9.2 基于线性表的查找 ②折半查找

基本思想: 数 1.首先确定查找表的中间位置;

据

结 2.然后将待查的值与中间位置的值进行比较, 构 若相等,则查找成功并返回此位置,否则须

50 -2 60 1

80 0 (a)一棵平衡二叉排序树

58 0 (b)一棵失去平衡的二叉排序树

30

第 9 章 查找

9.4 计算式查找法—哈希表

哈希表是什么?

以上两节讨论的表示查找表的各种结构的

数

共同特点:

据

结

1.记录在表中的位置和它的关键

构

字之间不存在一个确定的关系;

2.查找的过程为给定值依次和关 键字集合中各个关键字进行比较;

23

第 9 章 查找 9.3 基于树的查找 ①二叉排序树

例如: 50

数

30

80

据 结

20

40

90

构

10 25 35

66 85

23

88

不 是二叉排序树。

24

第 9 章 查找

9.3 基于树的查找 ①二叉排序树 查找算法

若二叉排序树为空,则查找不成功;

否则,

数 1. 若给定值等于根结点的关键字,则查找成功;

线性表的三种查找方法比较

顺序查找 折半查找 分块查找

数

据 表的结构 有序、无序

有序

表间有序

结

构 表的存储 顺序、链式

顺序

顺序、链式

数据结构英文术语

数据结构英文术语English:Data structures are fundamental components of computer science, providing a way to organize and store data efficiently to perform various operations such as insertion, deletion, and searching. There are several common data structures, each with its own strengths and weaknesses. Arrays, for example, are a simple data structure that stores elements of the same type sequentially in memory, allowing for fast access but limited flexibility in size. Linked lists, on the other hand, consist of nodes where each node contains a data element and a reference to the next node, providing dynamic size and efficient insertion and deletion at the cost of increased memory overhead. Stacks and queues are abstract data types that can be implemented using arrays or linked lists, with stacks following the Last In First Out (LIFO) principle and queues following the First In First Out (FIFO) principle. Trees, including binary trees, AVL trees, and red-black trees, are hierarchical data structures that are commonly used for hierarchical representation and searching. Graphs are another essential data structure used to represent networks and relationships between entities, with various algorithms such as depth-first searchand breadth-first search applied for traversal and pathfinding. Hash tables provide fast data retrieval by mapping keys to values using a hash function, offering constant-time average-case performance for insertion, deletion, and search operations under certain conditions. Each data structure has its own advantages and use cases, and understanding them is crucial for designing efficient algorithms and systems.中文翻译:数据结构是计算机科学的基本组成部分,提供了一种有效地组织和存储数据以执行插入、删除和搜索等各种操作的方式。

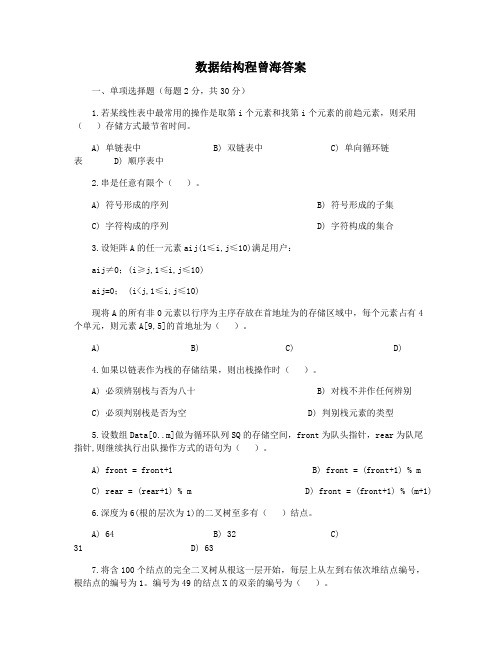

数据结构程曾海答案

数据结构程曾海答案一、单项选择题(每题2分,共30分)1.若某线性表中最常用的操作是取第i个元素和找第i个元素的前趋元素,则采用()存储方式最节省时间。

A) 单链表中 B) 双链表中C) 单向循环链表 D) 顺序表中2.串是任意有限个()。

A) 符号形成的序列B) 符号形成的子集C) 字符构成的序列D) 字符构成的集合3.设矩阵A的任一元素aij(1≤i,j≤10)满足用户:aij≠0;(i≥j,1≤i,j≤10)aij=0;(i<j,1≤i,j≤10)现将A的所有非0元素以行序为主序存放在首地址为的存储区域中,每个元素占有4个单元,则元素A[9,5]的首地址为()。

A) B) C) D)4.如果以链表作为栈的存储结果,则出栈操作时()。

A) 必须辨别栈与否为八十B) 对栈不并作任何辨别C) 必须判别栈是否为空D) 判别栈元素的类型5.设数组Data[0..m]做为循环队列SQ的存储空间,front为队头指针,rear为队尾指针,则继续执行出队操作方式的语句为()。

A) front = front+1 B) front = (front+1) % mC) rear = (rear+1) % m D) front = (front+1) % (m+1)6.深度为6(根的层次为1)的二叉树至多有()结点。

A) 64 B) 32 C)31 D) 637.将含100个结点的完全二叉树从根这一层开始,每层上从左到右依次堆结点编号,根结点的编号为1。

编号为49的结点X的双亲的编号为()。

A) 24 B) 25 C)23 D) 无法确认8.设有一个无向图和,如果为的生成树,则下面不正确的说法是()。

A) 为的子图 B) 为的相连分量C) 为的极小连通子图且 D) 为的一个无环子图9.用线性观测法搜寻闭散列表,可能将必须观测多个杂凑地址,这些边线上的键值()。

A) 一定都是同义词B) 一定都不是同义词C) 多相同 D) 不一定都就是同义词10.二分查找要求被查找的表是()。

高中信息技术《数据与数据结构》练习题(附答案解析)

高中信息技术《数据与数据结构》练习题(附答案解析)学校:___________姓名:___________班级:___________一、选择题1.依次在初始为空的队列中插入元素 a,b,c,d 以后,紧接着做了两次删除操作,此时的队首元素是()A.a B.b C.c D.d2.()是重复反馈过程的活动,其目的通常是逼近所需目标或结果。

是直接或间接地调用函数自身。

A.举递归B.递归代C.迭代递归D.递归迭代3.小明和小华玩猜数字的游戏,所猜数字不超过800,小明首先猜400,小华说大了,小明又猜200,当小华再次说大了,小明猜100,当小华说小了,小明猜150,以此类推,直到猜到正确的数字。

上述方法中蕴含的算法思想是()A.穷举算法B.递归算法C.二分查找法D.顺序查找法4.二分查找算法利用的算法思想是()A.分治策略B.穷举法C.回溯法D.递归法5.加密算法操作中的一组数字被称为(),比如凯撒密码的密钥为3,加密和解密使用同一个密钥,被称为()体制。

A.密钥对称加密B.公钥非对称加密C.密钥非对称加密D.公钥对称加密6.直接或间接地调用函数自身的方法为(),不断用变量的旧值推出新值的过程为().A.递归枚举B.迭代枚举C.迭代递归D.递归迭代7.树的递归定义如下:树是由n(n())个节点组成的()集合。

若n(),则称为()。

任何一个非空树均满足以下二个条件:(1)仅有一个()。

(2)当n>0时,其余节点可分为m(m>=0)个互不相交的有限集合,其中每个集合又是一棵树,并称为()。

A.>0;有限;=0;空树;根节点;根的子树B.>=0;有限;>0;空树;根节点;根的子树C.>=0;有限;=0;空树;根的子树;根节点D.>=0;有限;=0;空树;根节点;根的子树8.有如下Python程序代码:s="ABCDEF";head=0;tail=0que=[""]*100for i in range(len(s)):if i%2==0:que[tail]=s[i]else:que[tail]=s[len(s)-i]tail=tail+1for i in range(len(s)):print(que[head],end="")head=head+1以上程序运行后,打印出列表的情况是:()A.ABCDEF B.FEDCBA C.ACEFDB D.AFCDEB9.一个栈的入栈序列为1,2,3,4,5,其出栈序列为s1,s2,s3,s4,s5。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

如何减少判断 条件?

2.该程序最耗时的 该程序最耗时的 操作在哪里?如何 操作在哪里 如何 改进? 改进

改进的顺序查找算法: 改进的顺序查找算法

思考: 思考 如果查找失败, 如果查找失败,需 要比较多少次? 要比较多少次?

Tips: 采用改进算法可以提高大约 30%的性能,但是你知道吗, 的性能, 的性能 但是你知道吗, 还有更快的改进方法,详见: 还有更快的改进方法,详见: Knuth教授的经典巨作 计 教授的经典巨作<<计 教授的经典巨作 算机程序设计艺术 >>第三 第三 卷,第六章

第九章 查找

基本概念 静态查找表 动态查找表 哈希表

日常生活中的查找问题: 日常生活中的查找问题

看电视,查找特定的频道 翻阅字典,查找生词 在图书馆查阅资料 思考: 思考 …..

1. 2.

以上的查找策略都一样吗? 影响查找方法的因素有哪些 呢?

基本概念: 基本概念:

查找表: 查找表 同一类型的数据元素(或记录)构成的集合 例子: 例子:

3.

索引顺序表的查找

•索引顺序查找又称为分块查找 分块查找 •对查找表分块,然后建立索引表 •索引表按关键字排序,对应块中的记录无序

有序Biblioteka 无序小结: 小结:思考题: 思考题 现有一个电话簿文件,里面包含了大约1亿个电话号码(8位) , 现在希望从中查找一个给定的号码key,请分别考虑 以下情况: • 可用内存1M • 可用内存100M 给出你的查找方案,并说明原因?

性能分析: 性能分析

平均查找长度ASL = (N+1)/2

折半查找

特点:

1.针对有序表的查找算法 2.适于顺序存储的线性结构,不适合链表 3.性能为O(lgN) , 比顺序查找的O(N)要好 例子: 例子:

Tips: 1. 2. 把递归程序展开,可以 把递归程序展开 可以 得到教材上的算法9.2 得到教材上的算法 第一个折半查找程序发 布于1946年,但直到 布于 年 但直到 1962年才出现第一没有 年才出现第一没有 bug的折半查找程序 的折半查找程序 你知道吗, 你知道吗,还有更快的 折半查找程序: 详见: 折半查找程序 详见: Jon Bentley的 <<编程 的 编程 珠玑>>第九章 珠玑 第九章

参考书目:

<<编程珠玑>> [美] Jon Bentley <<计算机程序设计艺术>>第三卷 [美] Knuth 中国电力出版社.2004 国防工业出版社 .2002

世上没有最快的查找算法,只有最合适的算法. 不同的 应用场合,需采用不同的策略.

举一反三: 举一反三 以上的情景你在以前的数据 结构中碰到过吗?

静态查找表

已知 查找表 T: ( 2,5,3,7,4,1 ), 查找key=5,6

思考: 思考 1.影响程序执行时 影响程序执行时 间的因素是哪些? 间的因素是哪些

记录的唯一 标识

关键字: 准考证号,姓名,政治成绩,语文成绩,数学成绩 主关键字: 准考证号

查找: 查找 给定的某个值key,在查找表中查找关键字为key的数据元素(记录)。

查找的分类

静态查找: 静态查找 动态查找: 动态查找

查找表的内容不变 查找表的内容经常会受到插入/删除记录的影响

提示: 提示