阿里云API用户需求分析-into100沙龙第4期

目标客户群分析

CC综合交易市场目标客户群体分析目录:一、调研样本区域分布二、调研对象业态分析三、客户入驻意向分析一、1455调研样本分布二、调研对象业态分析目前我们所调研的1455家经销商,主要由EE经销商和FF经销商两部分构成,其中EE经销商1228家、FF专卖及EE附带商品2业务的商家227家,其各自所占比例如下:、FF经销商比例图表各地区商品2所占调研比例的情况如下:地区CC AA BB DD GG HH调研总数113361162161408363FF商户165124625832所占比例15%15%15%39%15%9%分析结论:整个泛CC地区处于丘陵地带,受地形限制,目前FF 较之EE的市场占有CC量要少近八成。

此情况缘于EE本身的性能以及消费者对商品2的认知度造成。

商品2作为近年的新兴项目,未来还具非常大的发展空间。

但是商品2行业的发展也受到政策性、产业技术性、行业整合速度等众多因素影响,可以预见,就地区而言,短期市场占有率增幅不会太大。

现阶段,根据CC地区商品2的市场占有率可以得出:CC配件市场的业态分布设计中,商品2与商品1的比例最高不宜超过3:7。

备注:现阶段,三轮车(含电动)暂无调研数据。

三、客户入驻意向分析入驻意向客户群分析:在现阶段已调研的1455个经销商中,有入驻意愿的商家共计491家,其中明确表示愿意入驻的49家。

入驻意向客户群分布如下:入驻意向客户分布图示XXXXXXXXXXXXXXXXXXX XXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXXX上图明显标示出XX及外围镇、CC辖区5个县市的入驻意向商家占总数的比例最大,合计达到263家,占意向客户总数的54%。

其中明确表示愿意的客户达到41家,占明确表示愿意商家总数的84%。

aliyun sls like 用法 -回复

aliyun sls like 用法-回复关于"aliyun sls like 用法",我将为你提供一篇1500-2000字的文章,详细解释Aliyun SLS的用法及其步骤。

文章标题:完全解析Aliyun SLS Like的用法及步骤引言:Aliyun SLS(Simple Log Service)是阿里云日志服务平台。

它为用户提供了一种简单、可靠且高效的分布式日志服务。

在SLS中,像(like)操作允许用户按照指定的日志查询条件,实现精确的关键字搜索。

本文将深入探讨Aliyun SLS Like的用法,以帮助读者更好地理解该功能,并了解其详细步骤。

第一部分:Aliyun SLS简介首先,我们需要了解Aliyun SLS的背景和基本概念。

Aliyun SLS是阿里云提供的一种集中管理日志数据的服务。

它支持将来自多个数据源的日志实时采集并存储,然后进行分析和查询。

Aliyun SLS使用基于标签(Tag)的分层存储结构,实现了日志的高可靠性和高可用性。

第二部分:Like操作简介在Aliyun SLS中,Like操作提供了一种模糊查询的方法。

它允许用户按照指定的日志查询条件进行关键字搜索,以找到符合特定模式的日志。

Like操作支持通配符和正则表达式,以便更灵活地进行查询。

第三部分:Like操作的使用步骤接下来,我们将逐步讲解使用Like操作的步骤。

步骤1:登录阿里云SLS控制台首先,你需要在阿里云官网上登录自己的账号,并进入SLS控制台。

在控制台页面上方的搜索栏中,找到并点击“查询分析”。

步骤2:新建查询分析任务在查询分析界面中,你需要点击“新建查询分析任务”按钮。

接着,你可以选择要查询的项目和日志仓库,并设置查询语句。

步骤3:输入Like语句在查询语句部分,你可以输入Like语句以实现模糊查询。

Like关键字后面跟着日志的字段名以及匹配模式。

例如,你可以输入类似于“like ip '192.168.'”的语句来查找以192.168开头的IP地址。

ecsi模型的概念 -回复

ecsi模型的概念-回复ECSI模型(Expectations, Confirmations, Satisfactions, and Importance)是一种常用的市场研究工具,用于评估顾客对产品或服务的满意度和重要性。

该模型最早由美国学者Larry Lapide在1984年提出,是从顾客角度评估企业绩效的重要工具之一。

ECSI模型基于以下四个关键要素:期望(Expectations)、确认(Confirmations)、满意度(Satisfactions)和重要性(Importance)。

下面将逐步解释这些要素在ECSI模型中的作用及其应用。

1. 期望(Expectations):期望是指顾客对产品或服务的主观预期,即顾客对产品或服务的期望水平。

顾客的期望可以通过市场调研、竞争对手分析和历史数据等途径获取。

在ECSI模型中,期望水平被认为是顾客对产品或服务的基准线,即顾客期望企业能够达到的最低要求。

如果企业无法满足顾客的期望,顾客可能对产品或服务感到失望,从而对企业形成负面的印象。

2. 确认(Confirmations):确认是指顾客对产品或服务是否达到预期的主观评价。

在ECSI模型中,确认可以看作是顾客对企业产品或服务质量的判断。

当顾客对产品或服务的实际体验与其期望一致时,就会产生积极的确认。

相反,如果顾客对产品或服务的实际体验低于期望水平,就会产生负面的确认。

通过对确认的评估,企业可以了解到顾客对其产品或服务的满意程度。

3. 满意度(Satisfactions):满意度是指顾客对产品或服务的整体满意程度。

它综合考虑了顾客的期望和确认,并对顾客对产品或服务的总体评价进行量化。

在ECSI模型中,满意度可以通过定量或定性的方法进行测量。

通过了解顾客的满意度水平,企业可以了解到自身在市场竞争中的优势和劣势,从而做出相应的调整和改进。

4. 重要性(Importance):重要性是指顾客对产品或服务各个要素的重视程度。

阿里云调研报告范文

阿里云调研报告范文阿里云调研报告一、调研目的与背景近年来,云计算技术的快速发展对企业的信息化建设提出了新的要求。

作为国内领先的云计算服务提供商,阿里云在市场中占据了重要的地位。

为了更好地了解阿里云的市场竞争优势和用户满意度,本次调研旨在通过收集、分析数据,撰写一份调研报告,为企业做出科学决策和战略规划提供依据。

二、调研方法与步骤1. 调研方法:本次调研采用问卷调查和深度访谈相结合的方式,旨在全面了解阿里云用户的使用情况和体验。

2. 调研步骤:(1)编制问卷:根据调研目的编制调研问卷,包括用户基本信息、使用习惯、满意度评价等方面。

(2)问卷调查:在目标用户群体中进行问卷调查,收集用户的真实反馈。

(3)深度访谈:选取部分问卷回收用户进行深度访谈,进一步了解阿里云在用户心目中的地位。

(4)数据收集与分析:整理问卷和访谈资料,进行数据统计和分析,形成调研报告。

三、调研结果与分析1. 用户基本信息(1)年龄分布:调研结果显示,阿里云用户的年龄主要集中在25-35岁,占比达到60%。

(2)行业分布:用户主要集中在互联网行业,占比超过50%。

2. 使用习惯与满意度评价(1)产品选择:调研结果显示,用户大多选择阿里云的云服务器和数据库产品,占比分别为70%和60%。

(2)产品体验:用户对阿里云的产品性能和稳定性普遍表示满意,其中性能满意度达到80%,稳定性满意度达到75%。

(3)技术支持:用户普遍认为阿里云的技术支持及时响应、专业负责,满意度超过70%。

(4)价格与性价比:用户认为阿里云的价格相对其他竞争对手较高,但由于产品性能和稳定性较好,性价比满意度仍达到60%。

3. 用户需求与改进建议(1)灵活性需求:用户普遍反映希望阿里云能提供更多灵活的配置选项,以满足不同业务需求。

(2)安全性需求:用户对阿里云的安全性能表示满意,但仍建议加强对DDoS攻击的防护能力。

(3)技术支持需求:用户希望阿里云在技术支持方面能够提供更多的文档和教程,方便用户在使用过程中的问题解决。

阿里云内容安全API参考(检测服务)说明书

内容安全API参考(检测服务)··法律声明法律声明阿里云提醒您在阅读或使用本文档之前仔细阅读、充分理解本法律声明各条款的内容。

如果您阅读或使用本文档,您的阅读或使用行为将被视为对本声明全部内容的认可。

1. 您应当通过阿里云网站或阿里云提供的其他授权通道下载、获取本文档,且仅能用于自身的合法合规的业务活动。

本文档的内容视为阿里云的保密信息,您应当严格遵守保密义务;未经阿里云事先书面同意,您不得向任何第三方披露本手册内容或提供给任何第三方使用。

2. 未经阿里云事先书面许可,任何单位、公司或个人不得擅自摘抄、翻译、复制本文档内容的部分或全部,不得以任何方式或途径进行传播和宣传。

3. 由于产品版本升级、调整或其他原因,本文档内容有可能变更。

阿里云保留在没有任何通知或者提示下对本文档的内容进行修改的权利,并在阿里云授权通道中不时发布更新后的用户文档。

您应当实时关注用户文档的版本变更并通过阿里云授权渠道下载、获取最新版的用户文档。

4. 本文档仅作为用户使用阿里云产品及服务的参考性指引,阿里云以产品及服务的“现状”、“有缺陷”和“当前功能”的状态提供本文档。

阿里云在现有技术的基础上尽最大努力提供相应的介绍及操作指引,但阿里云在此明确声明对本文档内容的准确性、完整性、适用性、可靠性等不作任何明示或暗示的保证。

任何单位、公司或个人因为下载、使用或信赖本文档而发生任何差错或经济损失的,阿里云不承担任何法律责任。

在任何情况下,阿里云均不对任何间接性、后果性、惩戒性、偶然性、特殊性或刑罚性的损害,包括用户使用或信赖本文档而遭受的利润损失,承担责任(即使阿里云已被告知该等损失的可能性)。

5. 阿里云网站上所有内容,包括但不限于著作、产品、图片、档案、资讯、资料、网站架构、网站画面的安排、网页设计,均由阿里云和/或其关联公司依法拥有其知识产权,包括但不限于商标权、专利权、著作权、商业秘密等。

非经阿里云和/或其关联公司书面同意,任何人不得擅自使用、修改、复制、公开传播、改变、散布、发行或公开发表阿里云网站、产品程序或内容。

阿里云市场接入大鱼服务API文档

阿里云大鱼服务 API 使用文档 1. 简介 本文档描述了阿里云用户开通大鱼服务后可通过开发者平台提供的 API 接口使用大鱼通信服务能力,从而实现短信验用大鱼服务 API 条件如下: ! ! ! ! ! ! 通过阿里云实名认证 绑定手机号 入驻阿里云开发者平台成为阿里云开发者,平台地址: 绑定并激活阿里云账户对应的淘宝账号 通过对应支付宝账号的实名认证 开通大鱼服务

系统异常返回结果示例 { errorCode: API 调用异常码,如参数出错,流控限制等 errorMessage: API 调用具体异常信息 }

2

阿里云大鱼服务 API 使用文档 5. API 列表 短信发送 API 描述

" "

API 英文名:sendSms 向指定手机号码发送模板短信,模板内可设置部分变量。使用前需要在阿里大鱼管理中心添加短信签名与短信模板。测试 时请直接使用正式环境请求地址。

3.

安全&Key 服务端针对每次 API 调用都会做安全校验,阿里云开发者在每次 API 调用时需要附带一对 Key 和 Secret。阿里云开发者在开通

大鱼服务后,可以通过创建大鱼应用获取应用对应的 Key 和 Secret,每个应用对应一对 Key 和 Secret。阿里云开发者每次 API 请求 都必须附带 Key 和 Secret,详见具体 API 调用示例。

请求结果处理 当 API 调用返回的 HTTP Status Code 为 200 时,表示 API 调用成功,请求返回内容即 API 定义的返回结果,请按照具体 API 返回 结果示例处理 API 调用结果;当 HTTP Status Code 为非 200 时,表示 API 调用出现系统异常,请按照具体异常信息进行处理。

api调研报告

api调研报告API 调研报告一、引言API(Application Programming Interface)是应用程序编程接口的缩写,是一种使不同软件之间能够交互的工具。

随着互联网和移动互联网的发展,API 的应用越来越广泛,对于不同系统之间的数据传输和功能共享起到了重要的作用。

本报告旨在对当前的API 技术进行调研和总结,并分析其当前的应用情况。

二、API 技术概述API 是一种软件接口,用于定义不同软件系统之间的交互方式。

通过使用 API,一个软件系统可以请求另一个系统的数据或功能,并进行相应的操作。

在互联网和移动互联网应用中,API被广泛用于实现不同应用程序之间的数据共享和功能集成。

常见的 API 包括 Web API、移动 API、桌面 API 等,用于不同终端设备上的应用程序开发。

Web API 是指通过 HTTP 协议提供数据和服务的接口,常用于网页应用程序之间的交互。

移动API 则用于移动设备应用程序之间的数据交换和功能使用。

桌面 API 则是用于桌面应用程序的开发,例如操作系统提供的各种接口和库。

三、API 的应用场景1. 数据共享:各种应用程序可以通过 API 共享数据,例如天气预报应用可以通过调用某个气象局的 API 获取实时天气数据。

2. 功能集成:不同应用程序之间可以通过API 实现功能集成,例如在线支付系统可以通过 API 调用银行系统的接口完成支付。

3. 第三方开发:API 可以开放给第三方开发者使用,使其可以开发基于该 API 的应用程序,例如 Facebook、Twitter 等社交媒体平台的 API。

4. 云计算服务:云计算平台的 API 可以让开发者以编程的方式调用云计算服务,例如亚马逊的 AWS API。

5. 数据存储和查询:API 可以提供数据的存储和查询服务,例如数据库的 API。

四、目前的 API 应用情况1. Web API:随着互联网的发展,Web API 的应用越来越广泛。

数据化运营管理 第2章 市场与行业数据分析

2.1市场分析概述2.2数据化展现市场行情2.3行业数据挖掘2.4实战训练市场分析在经营决策中的作用主要体现在以下几个方面发现机会针对电商环境而言,市场分析的目的主要是分析市场规模、发展方向、行业周期和消费者层级等。

门市场规模:通过分析市场规模,可以了解市场的大小,这可以帮口助网店卖家为进入市场做好相应的准备。

市场发展方向:通过分析市场,可以发现消费者的需求情况,可以分析电商平台引导了哪些品类,可以在一定程度上了解竞争对手的情况。

行业周期:通过分析市场,能够更加清楚行业的周期变化情况,口有利于控制并调整运营策略。

消费者层级:通过分析市场,就能更准确地找到网店应该针对哪种层级的消费者,来进行有针对性的运营、营销、沟通与维护。

2.1市场分析概述2.2数据化展现市场行情2.3行业数据挖掘2.4实战训练毛呢外套磐[自定改王透视表裤子毛计卫衣牛仔891011121314清选棒要分析的数横4送择一个表或区域u 泉/区域9:-20181$^1::W313.[(]:设置展」'使用外学数据源@)尸[宙谢gm ]的名称波森油署加口道和齐的位m ,谶工糜寇2:选中城有工作秀位置4):;函1L 喉二]U 肖」/。

■叫-1U.70^交易指数18,204,582交易增K 幅度137.74%5,208,7205,122,8155,090,5125.074.312 1.37%0.43%'.Q2%182%1.10*1.08%I.75H!.64%L59H L05H 1.39,1.34H 1.33M 1.32M 41.51%-17.41%13.35%30.97%151617181920力234567BC D A |子行业1创建数据透视表AI子行业2添加字段56789101112131415在以下区域同掩动字收二1列标英求和女:支付金额较父行业占比行标签唐装/民族服装/舞台服装套装/学生校服/工作制服Tit 半身褶背心吊带讨初大码女装短外套风衣醇纱/旗袍/礼解希子番丝杉/M 纺拒连衣裙马夹毛呢外套毛衣毛针织杉楠衣/楠*体胸牛仔巷皮草皮衣校朋渐灰型mwr ,支付金看取行业占比-及付子订*敦骏父行也占比ir aw 0.95440.48330.11840.58550.28130.42920.24720.22061.20920.21061.91120.07280.66070.40120.58990.30960.00890.64170.32430.10.10480.75141:lt(l 才和喷支I /林亮林送」行标婆子行北如字婚停X 地提要耒加费报都障投8H 事哀/缄杉03812这里以整理好的从2017年11月至2018年10月这个时期的女装行业下各子行业的数据为例,介绍利用Excel 分析市场容量大小的方法,其具体操作如下。

elasticsearch7.6的javaapi的用法 -回复

elasticsearch7.6的javaapi的用法-回复标题:Elasticsearch 7.6 的Java API 的用法指南引言:Elasticsearch 是一个开源的全文搜索和分析引擎,它提供了丰富的查询功能和高性能的数据处理能力。

在Elasticsearch 7.6 版本中,Java API 是与Elasticsearch 进行交互的重要工具。

本文将详细介绍Elasticsearch 7.6 的Java API 的用法,帮助开发者更好地理解和使用该工具。

第一节:了解Elasticsearch 7.6 的Java API1.1 概述1.2 Java API 与RESTful API 的关系1.3 Java API 的优势和适用场景第二节:使用Java API 进行数据索引2.1 Maven 依赖配置2.2 连接Elasticsearch 集群2.3 创建索引2.4 添加文档数据2.5 更新文档数据2.6 删除文档数据第三节:使用Java API 进行数据查询3.1 基本搜索3.2 复合搜索(AND/OR)3.3 分页和排序3.4 聚合查询第四节:使用Java API 进行数据分析4.1 词项统计4.2 热门词汇分析4.3 相关性分析4.4 相似性分析第五节:使用Java API 进行索引维护5.1 索引设置管理5.2 索引别名管理5.3 索引优化5.4 索引备份和恢复第六节:使用Java API 进行集群管理6.1 集群状态查询6.2 节点状态查询6.3 集群健康监控6.4 集群自动扩容和缩容结论:本文详细介绍了Elasticsearch 7.6 的Java API 的用法,包括数据索引、数据查询、数据分析、索引维护和集群管理等方面。

通过学习和使用Java API,开发者可以更好地进行Elasticsearch 数据的操作和管理,提高搜索和分析引擎的性能和效果。

作为Elasticsearch 的核心组件之一,Java API 在实际开发中具有重要的作用。

云业务需求分析报告

云业务需求分析报告标题:云业务需求分析报告摘要:本报告对云业务需求进行了全面的分析,包括市场需求、用户需求和技术需求。

通过调研和数据分析,我们对云业务的发展趋势和未来需求进行了预测,为相关企业提供了有针对性的建议,以满足市场和用户的需求。

一、引言近年来,随着云计算技术的快速发展,云业务在各个行业得到了广泛应用。

云业务的优势在于弹性高、成本低、资源共享等特点,能够为企业提供更灵活、高效的IT服务。

本报告旨在通过对云业务需求的深入分析,为相关企业提供有针对性的解决方案。

二、市场需求分析1. 市场概况随着企业数字化转型的加速,云业务市场进入了快速增长的阶段。

根据统计数据显示,全球云业务市场规模从2018年的5000亿美元增长到2020年的8000亿美元,预计未来几年将保持较高的增长率。

2. 市场趋势(1)行业需求增加:各行各业对IT资源的需求不断增加,特别是在大数据、人工智能、物联网等新兴技术的推动下,云业务的市场需求将持续增长。

(2)混合云模式兴起:企业在使用云服务时倾向于选择混合云模式,将公有云和私有云相结合,以满足不同的应用需求和数据安全性要求。

(3)多云管理需求增加:随着企业使用多个云提供商的增加,多云管理平台的需求也越来越大,以便统一管理和监控云资源。

三、用户需求分析1. 小型企业需求(1)成本控制:小型企业通常对成本比较敏感,因此希望通过云业务来减少硬件设备及人力成本。

(2)快速部署:小型企业追求敏捷创新,希望能够快速部署应用和服务,云业务的弹性和高效性能满足了这一需求。

2. 大型企业需求(1)弹性扩展:大型企业的业务需求通常具有高峰和低谷期,云业务能够提供弹性扩展的能力,满足业务峰值时的需求。

(2)安全性保障:大型企业对数据安全性要求较高,希望能够通过云业务提供的安全性措施保障数据的安全。

四、技术需求分析1. 基础设施建设(1)网络带宽:云业务需要有足够的网络带宽来保证数据传输的稳定和快速。

阿里云-对象存储服务OSS API手册

API手册OSS API 文档简介阿里云对象存储服务(Object Storage Service,简称OSS),是阿里云对外提供的海量,安全,低成本,高可靠的云存储服务。

用户可以通过本文档提供的简单的REST接口,在任何时间、任何地点、任何互联网设备上进行上传和下载数据。

基于OSS,用户可以搭建出各种多媒体分享网站、网盘、个人和企业数据备份等基于大规模数据的服务。

请确保在使用这些接口前,已充分了解了OSS产品说明、使用协议和收费方式。

API概览基本概念本文中出现的一些术语请参考OSS 基本概念关于Service操作关于Bucket的操作关于Object的操作关于Multipart Upload的操作---跨域资源共享(CORS)访问控制用户签名验证(Authentication)OSS通过使用AccessKeyId/ AccessKeySecret对称加密的方法来验证某个请求的发送者身份。

AccessKeyId用于标示用户,AccessKeySecret是用户用于加密签名字符串和OSS用来验证签名字符串的密钥,其中AccessKeySecret必须保密,只有用户和OSS知道。

AccessKey 根据所属账号的类型有所区分阿里云账户AccessKey:每个阿里云账号提供的AccessKey拥有对拥有的资源有完全的权限RAM账户AccessKey:RAM账户由阿里云账号授权生成,所拥的AccessKey拥有对特定资源限定的操作权限STS临时访问凭证:由阿里云账号或RAM账号生成,所拥的AccessKey在限定时间内拥有对特定资源限定的操作权限。

过期权限收回。

详情请参考OSS产品文档中访问身份验证当用户想以个人身份向OSS发送请求时,需要首先将发送的请求按照OSS指定的格式生成签名字符串;然后使用AccessKeySecret对签名字符串进行加密产生验证码。

OSS收到请求以后,会通过AccessKeyId找到对应的AccessKeySecret,以同样的方法提取签名字符串和验证码,如果计算出来的验证码和提供的一样即认为该请求是有效的;否则,OSS将拒绝处理这次请求,并返回HTTP 403错误。

阿里桌面云调研报告模板

阿里桌面云调研报告模板阿里桌面云调研报告模板1. 调研目的本次调研的目的是为了了解阿里桌面云的发展现状,分析其市场竞争力和未来发展潜力,为决策者提供参考依据。

2. 调研方法本次调研采用了多种方法,包括文献资料调研、网络搜索、访谈等。

通过这些方法,我们对阿里桌面云的技术特点、市场应用、竞争对手等方面进行了全面的了解和分析。

3. 调研结果3.1 技术特点阿里桌面云采用了虚拟化和云计算技术,通过将桌面环境部署在云端服务器上,用户可以随时随地通过网络访问自己的桌面。

这种方式可以提高工作效率和数据安全性,节省企业IT成本。

3.2 市场应用阿里桌面云主要应用于企业和教育领域。

企业可以通过阿里桌面云实现员工的远程办公,提高生产力和企业灵活性。

教育机构可以利用阿里桌面云提供学生远程实验环境,提升教学质量。

3.3 竞争对手目前,阿里桌面云的主要竞争对手包括华为云、腾讯云和微软Azure等。

这些云计算巨头都推出了自己的桌面云产品,并在技术、市场份额等方面与阿里桌面云展开竞争。

4. 市场竞争力分析阿里桌面云作为阿里巴巴集团旗下的产品,在技术实力和市场影响力方面具有一定优势。

其采用了成熟的云计算和虚拟化技术,得到了客户的广泛认可和应用。

同时,阿里桌面云借助阿里巴巴集团的品牌影响力和服务生态圈,拥有较强的市场竞争力。

5. 发展潜力分析随着云计算和远程办公的普及,阿里桌面云的发展前景广阔。

企业和教育机构的需求不断增长,远程办公和教学的风潮也日益流行。

阿里桌面云在技术和服务方面的持续创新,将为其提供更大的发展空间。

6. 建议针对阿里桌面云的发展,我们提出以下建议:- 加强研发力量,不断迭代升级产品技术,提升用户体验;- 拓展市场渠道,加强与合作伙伴的合作,扩大市场份额;- 适应不同行业的需求,推出针对不同行业的解决方案。

7. 结论通过对阿里桌面云的调研分析,我们认为阿里桌面云具有较强的市场竞争力和广阔的发展潜力。

决策者可以将阿里桌面云作为企业和教育机构的远程办公和教学解决方案的首选,并加大对其研发和市场推广的支持。

阿里云客户工作证培训+阿里云客服基础业务认证在线+线上+语音+居家+兼职+客服专项考试试题及答案

双十二-阿里云客户工作证培训+阿里云客服基础业务认证-在线+线上+语音+居家+兼职+客服--专项-考试试题及答案一、单选题1. 在接待客户参观时,带领客户参观工厂内部是不必要的,不需要安排在参观行程中;这样的说法正确么A、错误B、正确正确答案: A2. 请问专项客服的培训时间约7-10天,您是否接受?A、不,时间太长了B、是的,我接受正确答案: B3. 通过对外贸流程的学习,我们发现在往来磋商阶段主要围绕价格术语和付款方式进行洽谈,这样的说法正确么A、错误B、正确正确答案: B4. 天猫超市的优惠券,是天猫超市所有商品都适用的——以上说法是否正确A、错误B、正确正确答案: A5. 阿里巴巴集团的愿景是让世界没有难做的生意()。

A、正确B、错误正确答案: B6. 阿里人才观是聪明、皮实、乐观、自省()。

A、正确B、错误正确答案: A7. VRShowroom实景适应所有想还原商家线的样品间的厂家()。

A、正确B、错误正确答案: B8. 以下哪项描述不符合闪电退换货服务的适用范围?AA、适用于所有淘宝买家B、适用于所有天猫商家C、适用于支持“七天无理由退换货”的商品D、仅适用于满足特定条件的买家9. 自2022年5月1日(含)起开通服务CGS新签商家,须同时完成全部“新手推荐任务”后,再开启商家星级的评定和享受对应的星级权益()。

A、正确B、错误正确答案: A10. 请问您以前是否做过客服呢?(所有客户服务类型的岗位,如销售、服务接待都算)A、没有做过B、是的,做过正确答案: B11. 退款主要是离线处理客户及电话和客户沟通A、正确B、错误正确答案: A12. 以下哪个不属于国际直营部门承接的店铺A、天猫国际进口超市国内现货B、天猫国际妙颜社C、天猫超市D、天猫国际进口超市13. 判决退款属于哪个环节?A、处理方向B、反弹申诉正确答案: B14. 请问您是否曾经报名过语音专项客服,并多次放弃过面试/培训/拨测?A、没有,我还没有报名成功过语音专项岗位B、是的,我以前报名过,但是因为设备不符合放弃了C、是的,我以前报名过,但是因为没时间放弃了正确答案: A15. 语音专项客服的要求较多,报名时可能出现提示"报名失败",无法出具更详细的解释,只能等待下次报名,请问您是否了解该规则?A、不了解B、了解正确答案: B16. 客服小A在培训期间,私自添加其他培训人员,建立小群,询问或购买答案,小A做法是否正确?A、错误B、正确正确答案: A17. 直通车通过对实时竞价,提升位置信息排名()。

2023阿里云ACA云计算试题及答案

2023阿里云ACA云计算试题及答案—、单选题(在每小题列出的四个选项中,只有一个最符合题目要求的选项)1.在阿里云对象存储0SS创建存储空间时,不能选择的存储类型是A.标准存储B.低频访问C.归档存储D.SSD存储答案:D2.创建阿里云专有网络VPC时,需要指定网段地址,如果想要使用A类的IPv4地址段0,那么默认子网掩码的位数是A.8B.12C.16D.24答案:D3.用户使用阿里云云服务器ECS时,忘记了ECS实例的登录密码,用户可以通过重置密码的方式设置新的密码。

下面关于重置密码说法中不正确的是A.关机状态不可以重置密码B.运行状态的ECS可以重置密码C.Windows系统也可以重置密码D.运行状态的ECS重香密码后必须重启才能生效答案:A4.为了实现跨地域()级别的高可用,可以采用的是A.DNSB.内容分发网络CDNC.弹性伸缩ASD.负载均衡SLB答案:A5.阿里云PolarDBMySQL使用时,为了增加数据库安全,仅允许管理员所在的IP地址连接数据库工具是A.黑名单B.白名单C.安全组D.访问控制答案:C6.下列关于阿里云地域(Region)和可用区()的说法中,正确的是A.一个Region可以包含多个ZoneB.一个Zone可以包含多个RegionC.Region之间可以通过阿里云内网进行互联D.Zone一般是基于地理位置进行划分的答案:A7.阿里云云服务器ECS中挂载云盘对地域和可用区有要求,下面关于云盘与云服务器ECS的地域和可说法中,正确的是A.云服务器ECS和云盘可以不同地域B.云服务器ECS和云盘地域相同,可用区可以不同C.云服务器ECS和云盘的地过和可用区都必须相同D.云盘可以在不同可用区之间迁移答案:C8.创建阿里云云服务器ECS时,可以采用自定义密码的方式。

下面可以作为云服务器初始密码的是A.1comB、C、1234_abcdD、1234_!答案:C9.用户使用阿里云弹性伸缩AS时,具体的操作步骤是A.创建伸缩组-创建伸缩规则一创建伸缩配置-创建伸缩任务B.创建伸缩组-创建伸缩任务一创建伸缩规则-创建伸缩配置C.创建伸缩配置-创建伸缩组-创建伸缩规则-创建伸缩任务D.创建伸缩组-创建伸缩配置-创建伸缩任务一创建伸缩规则答案:D10.阿里云内容分发网络CDN可以为用户提供访问加速。

双十一阿里云客服专员+阿里云客服基础业务认证在线+线上+语音+居家+兼职+客服专项考试试题及答案

双十一-阿里云客服专员+阿里云客服基础业务认证-在线+线上+语音+居家+兼职+客服--专项-考试试题及答案一、单选题1. 请问您是否确认,自己要报名云客服?A、不是,只是来看看B、是的,我想成为云客服正确答案: B2. 阿里巴巴集团的愿景是让世界没有难做的生意()。

A、正确B、错误正确答案: B3. 商家星级中包含3个买家服务基础要求门槛指标,这类指标任意一个未到一定标准,商家将无法晋级至星级商家(降为0星)()。

A、正确B、错误正确答案: A4. 请问您是否有耳麦,或打算采购耳麦?A、没有,我也不打算买B、是的,我家里有耳麦正确答案: B5. 报关委托书为一式三联,其中第一联白联为委托方留存;A、错误B、正确正确答案: A6. 请问专项客服岗位需要面试吗?A、不需要面试B、需要面试正确答案: B7. 在与其竞争的客户情况都不变的条件下,当其推广产品的推广评分越高,其获得相应排名的出价将越低,而且获得一次点击所需要支付的费用也越低()。

A、正确B、错误正确答案: A8. 商家面对CRO处理后不能使用一达通出口()。

A、正确B、错误正确答案: B9. 关闭账户必须累计满足48分关店制或者3振关店制即可()。

B、错误正确答案: B10. 每个主账号下面有几个子账号A、 6B、 4C、 5正确答案: C11. 请问您是否有过3个月以上的客服经验?A、客服经验时长低于3个月B、有3个月以上客服经验正确答案: B12. 以下哪项描述不符合闪电退换货服务的适用范围?AA、适用于所有淘宝买家B、适用于所有天猫商家C、适用于支持“七天无理由退换货”的商品D、仅适用于满足特定条件的买家正确答案: A13. 若要发布品牌产品,需先提供授权证明经平台审核B、正确正确答案: B14. 只要是88VIP会员在猫超购买商品后都可享受0秒退服务A、错误B、正确正确答案: B15. 云客服成立于哪一年?A、 2010年B、 2008年C、 2014年D、 2011年正确答案: A16. 请问云客服是否有自己的百度百科?A、有B、没有正确答案: A17. 汽车到店安装服务可以取消吗?A、不可以正确答案: B18. 如果名下有店铺且在运营中,是否可以报名专项客服?A、不可以B、可以正确答案: A19. 出现纠纷小二介入后,从凭证审核开始,淘宝一般会在多久时间内介入核实?A、立刻给出回复B、 24小时C、 48小时D、 72小时正确答案: C20. 商品发货后()天系统默认确认收货A、 15B、 30C、 10正确答案: C二、多选题1. 如何找回淘宝注册的所有账户名信息呢?A、手机端:1手淘登录页面点击【更多选项】;2选择【找回会员名】,输入身份证号和真实姓名;3扫脸认证通过,就可以知道会员名了。

阿里云客流分析产品介绍

阿里云客流分析产品线下场景的客流数字化喜超&逍彦目录1. 目标市场与客户需求2. 阿里云客流分析产品功能介绍1.目标市场与客户需求产品目标场景本产品主要⾯面向线下商业场景中的客流数据化。

本产品定位购物中⼼心对到场客流数据化商圈购物中⼼心⻔门店⻔门店进店和店内客流数据化周边客流关注点客流分析部署方案购物中心 出入口集团总部X购物中心 …购物中心楼层 区域间通道出入口商户出入口 收银区 店内区域【购物中心】对客流分析的需求⽤用户⻆角⾊色 (Role)客流数据需求(Data)业务⾏行行动(Action)价值回报(Value)招商⼈人员分布• 公共区域客流分布购物中⼼心各⼊入⼝口、重点通道客流量量分布• ⽇日常招商调整• 公共区域⼴广告精准招商• 提⾼高招商效率,降低招商成本• 增加⼴广告收⼊入• 各商户客流分布商户到店客流的总趋势、性别、年年龄分布• ⽇日常商户管理理如:异动商户管控• 探索创新更更合理理的租⾦金金模式如:是否可以结合客流量量和商户营收的定租• 提⾼高商户管理理效率• 保障租⾦金金收⼊入营销⼈人员趋势与动因• 客流趋势及动因总趋势,不不同性别、年年龄客流趋势;天⽓气、节假⽇日、活动等因素vs流量量• 营销活动时点地点形式选择• 营销活动效果评价• 提⾼高营销活动效益运营⼈人员峰值• 公共区域、各商户客流峰值购物中⼼心各⼊入⼝口、通道、商户出⼝口• ⼈人员调配优化客流超出预期的⾼高峰时间点和位置识别,优化物业、公共设施维护、安保、保洁等⼈人员任务分配• 提⾼高⼈人⼒力力投⼊入效率• 降低安全事件概率决策者总体与异常• 客流总体情况及客流异常正常客流量量;客流异常:总量量、趋势、性别年年龄结构、重点商户等客流量量较⼤大变化• 对外,购物中⼼心⼈人⽓气数据说明• 对内,以客流数据为抓⼿手的管理理活动• 提⾼高决策管理理者对外交流的效率和影响⼒力力• 增加管理理层与执⾏行行层的上下协同效率客流数据是购物中⼼心的核⼼心数据,是购物中⼼心开展管理理活动的重要抓⼿手。

fence_aliyun用法 -回复

fence_aliyun用法-回复“fence_aliyun用法”是指在云计算平台阿里云上使用fence_aliyun工具进行故障隔离和恢复的方法。

本文将逐步介绍fence_aliyun的用法,包括安装配置、命令参数和实际案例等。

第一步:安装配置fence_aliyun1. 安装依赖软件在安装fence_aliyun之前,需要确保系统已经安装了以下软件:- fence-agents:计算节点电源控制代理的软件包,可以通过系统的软件包管理器进行安装。

- sshpass:用于自动化SSH密码认证的工具,通过系统的软件包管理器进行安装。

2. 下载并安装fence_aliyun从fence_aliyun的官方GitHub仓库上下载最新版本的源代码,解压缩后执行以下命令进行安装:cd fence_aliyunmake install3. 配置fence_aliyun在安装目录下的/etc/fence_aliyun/fence_aliyun.conf文件中,配置fence_aliyun的参数,包括Access Key和Access Secret等,以便与阿里云API进行认证和授权。

第二步:fence_aliyun的命令参数fence_aliyun提供了一系列命令参数,用于实现故障隔离和恢复功能的自定义配置。

以下是一些常用的命令参数:1. version:查看fence_aliyun的版本信息。

2. -o, action:指定动作,包括on(打开电源)、off(关闭电源)和reboot(重启)。

3. -n, node:指定要执行动作的节点名称。

4. -l, login:指定登录计算节点的用户名。

5. -p, password:指定登录计算节点的密码。

6. -c, config:指定配置文件的路径。

7. api-key:指定阿里云API的Access Key。

8. api-secret:指定阿里云API的Access Secret。

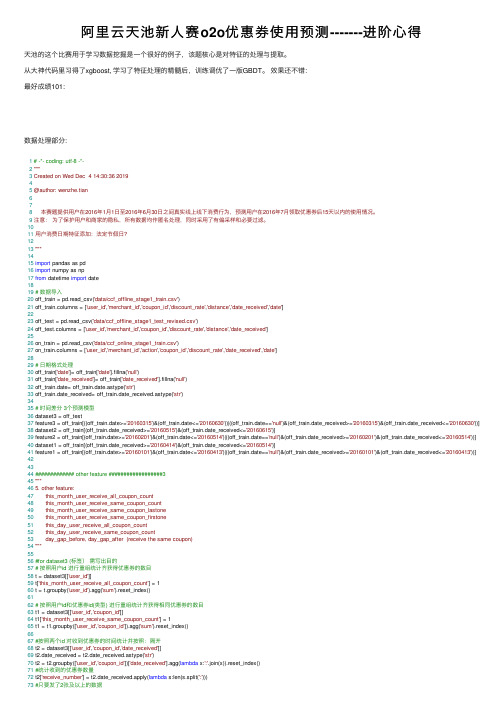

阿里云天池新人赛o2o优惠券使用预测-------进阶心得

阿⾥云天池新⼈赛o2o优惠券使⽤预测-------进阶⼼得天池的这个⽐赛⽤于学习数据挖掘是⼀个很好的例⼦,该题核⼼是对特征的处理与提取。

从⼤神代码⾥习得了xgboost, 学习了特征处理的精髓后,训练调优了⼀版GBDT。

效果还不错:最好成绩101:数据处理部分:1# -*- coding: utf-8 -*-2"""3Created on Wed Dec 4 14:30:36 201945@author: wenzhe.tian678本赛题提供⽤户在2016年1⽉1⽇⾄2016年6⽉30⽇之间真实线上线下消费⾏为,预测⽤户在2016年7⽉领取优惠券后15天以内的使⽤情况。

9注意:为了保护⽤户和商家的隐私,所有数据均作匿名处理,同时采⽤了有偏采样和必要过滤。

1011⽤户消费⽇期特征添加:法定节假⽇?1213"""1415import pandas as pd16import numpy as np17from datetime import date1819# 数据导⼊20 off_train = pd.read_csv('data/ccf_offline_stage1_train.csv')21 off_train.columns = ['user_id','merchant_id','coupon_id','discount_rate','distance','date_received','date']2223 off_test = pd.read_csv('data/ccf_offline_stage1_test_revised.csv')24 off_test.columns = ['user_id','merchant_id','coupon_id','discount_rate','distance','date_received']2526 on_train = pd.read_csv('data/ccf_online_stage1_train.csv')27 on_train.columns = ['user_id','merchant_id','action','coupon_id','discount_rate','date_received','date']2829# ⽇期格式处理30 off_train['date']= off_train['date'].fillna('null')31 off_train['date_received']= off_train['date_received'].fillna('null')32 off_train.date= off_train.date.astype('str')33 off_train.date_received= off_train.date_received.astype('str')3435# 时间差分 3个预测模型36 dataset3 = off_test37 feature3 = off_train[((off_train.date>='20160315')&(off_train.date<='20160630'))|((off_train.date=='null')&(off_train.date_received>='20160315')&(off_train.date_received<='20160630'))]38 dataset2 = off_train[(off_train.date_received>='20160515')&(off_train.date_received<='20160615')]39 feature2 = off_train[(off_train.date>='20160201')&(off_train.date<='20160514')|((off_train.date=='null')&(off_train.date_received>='20160201')&(off_train.date_received<='20160514'))]40 dataset1 = off_train[(off_train.date_received>='20160414')&(off_train.date_received<='20160514')]41 feature1 = off_train[(off_train.date>='20160101')&(off_train.date<='20160413')|((off_train.date=='null')&(off_train.date_received>='20160101')&(off_train.date_received<='20160413'))] 424344############# other feature ##################345"""465. other feature:47 this_month_user_receive_all_coupon_count48 this_month_user_receive_same_coupon_count49 this_month_user_receive_same_coupon_lastone50 this_month_user_receive_same_coupon_firstone51 this_day_user_receive_all_coupon_count52 this_day_user_receive_same_coupon_count53 day_gap_before, day_gap_after (receive the same coupon)54"""5556#for dataset3 (标签)需写出⽬的57# 按照⽤户id 进⾏重组统计齐获得优惠券的数⽬58 t = dataset3[['user_id']]59 t['this_month_user_receive_all_coupon_count'] = 160 t = t.groupby('user_id').agg('sum').reset_index()6162# 按照⽤户id和优惠券id(类型) 进⾏重组统计齐获得相同优惠券的数⽬63 t1 = dataset3[['user_id','coupon_id']]64 t1['this_month_user_receive_same_coupon_count'] = 165 t1 = t1.groupby(['user_id','coupon_id']).agg('sum').reset_index()6667#按照两个id 对收到优惠券的时间统计并按照:隔开68 t2 = dataset3[['user_id','coupon_id','date_received']]74 t2 = t2[t2.receive_number>1]75#添加最早和最晚获取优惠券的时间数据并只取这两个数据和两个id作为t276 t2['max_date_received'] = t2.date_received.apply(lambda s:max([int(float(d)) for d in s.split(':')]))77 t2['min_date_received'] = t2.date_received.apply(lambda s:min([int(float(d)) for d in s.split(':')]))78 t2 = t2[['user_id','coupon_id','max_date_received','min_date_received']]7980# t2按照两个id81 t3 = dataset3[['user_id','coupon_id','date_received']]82 t3 = pd.merge(t3,t2,on=['user_id','coupon_id'],how='left')8384 t3.max_date_received=t3.max_date_received.astype('float')85 t3.date_received=t3.date_received.astype('float')86 t3['this_month_user_receive_same_coupon_lastone'] = t3.max_date_received - t3.date_received87 t3['this_month_user_receive_same_coupon_firstone'] = t3.date_received - t3.min_date_received88def is_firstlastone(x):89if x==0:90return 191elif x>0:92return 093else:94return -1 #those only receive once9596 t3.this_month_user_receive_same_coupon_lastone = t3.this_month_user_receive_same_coupon_lastone.apply(is_firstlastone)97 t3.this_month_user_receive_same_coupon_firstone = t3.this_month_user_receive_same_coupon_firstone.apply(is_firstlastone)98 t3 = t3[['user_id','coupon_id','date_received','this_month_user_receive_same_coupon_lastone','this_month_user_receive_same_coupon_firstone']] 99100 t4 = dataset3[['user_id','date_received']]101 t4['this_day_user_receive_all_coupon_count'] = 1102 t4 = t4.groupby(['user_id','date_received']).agg('sum').reset_index()103104 t5 = dataset3[['user_id','coupon_id','date_received']]105 t5['this_day_user_receive_same_coupon_count'] = 1106 t5 = t5.groupby(['user_id','coupon_id','date_received']).agg('sum').reset_index()107108 t6 = dataset3[['user_id','coupon_id','date_received']]109 t6.date_received = t6.date_received.astype('str')110 t6 = t6.groupby(['user_id','coupon_id'])['date_received'].agg(lambda x:':'.join(x)).reset_index()111 t6.rename(columns={'date_received':'dates'},inplace=True)112113def get_day_gap_before(s):114 date_received,dates = s.split('-')115 dates = dates.split(':')116 gaps = []117for d in dates:118 this_gap = (date(int(date_received[0:4]),int(date_received[4:6]),int(date_received[6:8]))-date(int(d[0:4]),int(d[4:6]),int(d[6:8]))).days119if this_gap>0:120 gaps.append(this_gap)121if len(gaps)==0:122return -1123else:124return min(gaps)125126def get_day_gap_after(s):127 date_received,dates = s.split('-')128 dates = dates.split(':')129 gaps = []130for d in dates:131 this_gap = (date(int(d[0:4]),int(d[4:6]),int(d[6:8]))-date(int(date_received[0:4]),int(date_received[4:6]),int(date_received[6:8]))).days132if this_gap>0:133 gaps.append(this_gap)134if len(gaps)==0:135return -1136else:137return min(gaps)138139140 t7 = dataset3[['user_id','coupon_id','date_received']]141 t7 = pd.merge(t7,t6,on=['user_id','coupon_id'],how='left')142 t7['date_received_date'] = t7.date_received.astype('str') + '-' + t7.dates143 t7['day_gap_before'] = t7.date_received_date.apply(get_day_gap_before)144 t7['day_gap_after'] = t7.date_received_date.apply(get_day_gap_after)145 t7 = t7[['user_id','coupon_id','date_received','day_gap_before','day_gap_after']]146147 other_feature3 = pd.merge(t1,t,on='user_id')148 other_feature3 = pd.merge(other_feature3,t3,on=['user_id','coupon_id'])149 other_feature3 = pd.merge(other_feature3,t4,on=['user_id','date_received'])150 other_feature3 = pd.merge(other_feature3,t5,on=['user_id','coupon_id','date_received'])151 other_feature3 = pd.merge(other_feature3,t7,on=['user_id','coupon_id','date_received'])152 other_feature3.to_csv('data/other_feature3.csv',index=None)153print (other_feature3.shape)154155156157#for dataset2158 t = dataset2[['user_id']]159 t['this_month_user_receive_all_coupon_count'] = 1160 t = t.groupby('user_id').agg('sum').reset_index()169 t2['receive_number'] = t2.date_received.apply(lambda s:len(s.split(':')))170 t2 = t2[t2.receive_number>1]171 t2['max_date_received'] = t2.date_received.apply(lambda s:max([int(float(d)) for d in s.split(':')]))172 t2['min_date_received'] = t2.date_received.apply(lambda s:min([int(float(d)) for d in s.split(':')]))173 t2 = t2[['user_id','coupon_id','max_date_received','min_date_received']]174175 t3 = dataset2[['user_id','coupon_id','date_received']]176 t3 = pd.merge(t3,t2,on=['user_id','coupon_id'],how='left')177 t3['this_month_user_receive_same_coupon_lastone'] = t3.max_date_received - t3.date_received.astype('float').astype('int')178 t3['this_month_user_receive_same_coupon_firstone'] = t3.date_received.astype('float').astype('int') - t3.min_date_received179def is_firstlastone(x):180if x==0:181return 1182elif x>0:183return 0184else:185return -1 #those only receive once186187 t3.this_month_user_receive_same_coupon_lastone = t3.this_month_user_receive_same_coupon_lastone.apply(is_firstlastone)188 t3.this_month_user_receive_same_coupon_firstone = t3.this_month_user_receive_same_coupon_firstone.apply(is_firstlastone)189 t3 = t3[['user_id','coupon_id','date_received','this_month_user_receive_same_coupon_lastone','this_month_user_receive_same_coupon_firstone']] 190191 t4 = dataset2[['user_id','date_received']]192 t4['this_day_user_receive_all_coupon_count'] = 1193 t4 = t4.groupby(['user_id','date_received']).agg('sum').reset_index()194195 t5 = dataset2[['user_id','coupon_id','date_received']]196 t5['this_day_user_receive_same_coupon_count'] = 1197 t5 = t5.groupby(['user_id','coupon_id','date_received']).agg('sum').reset_index()198199 t6 = dataset2[['user_id','coupon_id','date_received']]200 t6.date_received = t6.date_received.astype('str')201 t6 = t6.groupby(['user_id','coupon_id'])['date_received'].agg(lambda x:':'.join(x)).reset_index()202 t6.rename(columns={'date_received':'dates'},inplace=True)203204def get_day_gap_before(s):205 date_received,dates = s.split('-')206 dates = dates.split(':')207 gaps = []208for d in dates:209 this_gap = (date(int(date_received[0:4]),int(date_received[4:6]),int(date_received[6:8]))-date(int(d[0:4]),int(d[4:6]),int(d[6:8]))).days210if this_gap>0:211 gaps.append(this_gap)212if len(gaps)==0:213return -1214else:215return min(gaps)216217def get_day_gap_after(s):218 date_received,dates = s.split('-')219 dates = dates.split(':')220 gaps = []221for d in dates:222 this_gap = (date(int(d[0:4]),int(d[4:6]),int(d[6:8]))-date(int(date_received[0:4]),int(date_received[4:6]),int(date_received[6:8]))).days223if this_gap>0:224 gaps.append(this_gap)225if len(gaps)==0:226return -1227else:228return min(gaps)229230231 t7 = dataset2[['user_id','coupon_id','date_received']]232 t7 = pd.merge(t7,t6,on=['user_id','coupon_id'],how='left')233 t7['date_received_date'] = t7.date_received.astype('str') + '-' + t7.dates234 t7['day_gap_before'] = t7.date_received_date.apply(get_day_gap_before)235 t7['day_gap_after'] = t7.date_received_date.apply(get_day_gap_after)236 t7 = t7[['user_id','coupon_id','date_received','day_gap_before','day_gap_after']]237238 other_feature2 = pd.merge(t1,t,on='user_id')239 other_feature2 = pd.merge(other_feature2,t3,on=['user_id','coupon_id'])240 other_feature2 = pd.merge(other_feature2,t4,on=['user_id','date_received'])241 other_feature2 = pd.merge(other_feature2,t5,on=['user_id','coupon_id','date_received'])242 other_feature2 = pd.merge(other_feature2,t7,on=['user_id','coupon_id','date_received'])243 other_feature2.to_csv('data/other_feature2.csv',index=None)244print (other_feature2.shape)245246247248#for dataset1249 t = dataset1[['user_id']]250 t['this_month_user_receive_all_coupon_count'] = 1251 t = t.groupby('user_id').agg('sum').reset_index()260 t2['receive_number'] = t2.date_received.apply(lambda s:len(s.split(':')))261 t2 = t2[t2.receive_number>1]262 t2['max_date_received'] = t2.date_received.apply(lambda s:max([int(float(d)) for d in s.split(':')]))263 t2['min_date_received'] = t2.date_received.apply(lambda s:min([int(float(d)) for d in s.split(':')]))264 t2 = t2[['user_id','coupon_id','max_date_received','min_date_received']]265266 t3 = dataset1[['user_id','coupon_id','date_received']]267 t3 = pd.merge(t3,t2,on=['user_id','coupon_id'],how='left')268 t3['this_month_user_receive_same_coupon_lastone'] = t3.max_date_received - t3.date_received.astype('float').astype('int')269 t3['this_month_user_receive_same_coupon_firstone'] = t3.date_received.astype('float').astype('int') - t3.min_date_received270def is_firstlastone(x):271if x==0:272return 1273elif x>0:274return 0275else:276return -1 #those only receive once277278 t3.this_month_user_receive_same_coupon_lastone = t3.this_month_user_receive_same_coupon_lastone.apply(is_firstlastone)279 t3.this_month_user_receive_same_coupon_firstone = t3.this_month_user_receive_same_coupon_firstone.apply(is_firstlastone)280 t3 = t3[['user_id','coupon_id','date_received','this_month_user_receive_same_coupon_lastone','this_month_user_receive_same_coupon_firstone']] 281282 t4 = dataset1[['user_id','date_received']]283 t4['this_day_user_receive_all_coupon_count'] = 1284 t4 = t4.groupby(['user_id','date_received']).agg('sum').reset_index()285286 t5 = dataset1[['user_id','coupon_id','date_received']]287 t5['this_day_user_receive_same_coupon_count'] = 1288 t5 = t5.groupby(['user_id','coupon_id','date_received']).agg('sum').reset_index()289290 t6 = dataset1[['user_id','coupon_id','date_received']]291 t6.date_received = t6.date_received.astype('str')292 t6 = t6.groupby(['user_id','coupon_id'])['date_received'].agg(lambda x:':'.join(x)).reset_index()293 t6.rename(columns={'date_received':'dates'},inplace=True)294295def get_day_gap_before(s):296 date_received,dates = s.split('-')297 dates = dates.split(':')298 gaps = []299for d in dates:300 this_gap = (date(int(date_received[0:4]),int(date_received[4:6]),int(date_received[6:8]))-date(int(d[0:4]),int(d[4:6]),int(d[6:8]))).days301if this_gap>0:302 gaps.append(this_gap)303if len(gaps)==0:304return -1305else:306return min(gaps)307308def get_day_gap_after(s):309 date_received,dates = s.split('-')310 dates = dates.split(':')311 gaps = []312for d in dates:313 this_gap = (date(int(d[0:4]),int(d[4:6]),int(d[6:8]))-date(int(date_received[0:4]),int(date_received[4:6]),int(date_received[6:8]))).days314if this_gap>0:315 gaps.append(this_gap)316if len(gaps)==0:317return -1318else:319return min(gaps)320321322 t7 = dataset1[['user_id','coupon_id','date_received']]323 t7 = pd.merge(t7,t6,on=['user_id','coupon_id'],how='left')324 t7['date_received_date'] = t7.date_received.astype('str') + '-' + t7.dates325 t7['day_gap_before'] = t7.date_received_date.apply(get_day_gap_before)326 t7['day_gap_after'] = t7.date_received_date.apply(get_day_gap_after)327 t7 = t7[['user_id','coupon_id','date_received','day_gap_before','day_gap_after']]328329 other_feature1 = pd.merge(t1,t,on='user_id')330 other_feature1 = pd.merge(other_feature1,t3,on=['user_id','coupon_id'])331 other_feature1 = pd.merge(other_feature1,t4,on=['user_id','date_received'])332 other_feature1 = pd.merge(other_feature1,t5,on=['user_id','coupon_id','date_received'])333 other_feature1 = pd.merge(other_feature1,t7,on=['user_id','coupon_id','date_received'])334 other_feature1.to_csv('data/other_feature1.csv',index=None)335print (other_feature1.shape)336337338339340341342############# coupon related feature #############348def calc_discount_rate(s):349 s =str(s)350 s = s.split(':')351if len(s)==1:352return float(s[0])353else:354return 1.0-float(s[1])/float(s[0])355356def get_discount_man(s):357 s =str(s)358 s = s.split(':')359if len(s)==1:360return'null'361else:362return int(s[0])363364def get_discount_jian(s):365 s =str(s)366 s = s.split(':')367if len(s)==1:368return'null'369else:370return int(s[1])371372def is_man_jian(s):373 s =str(s)374 s = s.split(':')375if len(s)==1:376return 0377else:378return 1379380#dataset3381 dataset3['day_of_week'] = dataset3.date_received.astype('str').apply(lambda x:date(int(x[0:4]),int(x[4:6]),int(x[6:8])).weekday()+1)382 dataset3['day_of_month'] = dataset3.date_received.astype('str').apply(lambda x:int(x[6:8]))383 dataset3['days_distance'] = dataset3.date_received.astype('str').apply(lambda x:(date(int(x[0:4]),int(x[4:6]),int(x[6:8]))-date(2016,6,30)).days) 384 dataset3['discount_man'] = dataset3.discount_rate.apply(get_discount_man)385 dataset3['discount_jian'] = dataset3.discount_rate.apply(get_discount_jian)386 dataset3['is_man_jian'] = dataset3.discount_rate.apply(is_man_jian)387 dataset3['discount_rate'] = dataset3.discount_rate.apply(calc_discount_rate)388 d = dataset3[['coupon_id']]389 d['coupon_count'] = 1390 d = d.groupby('coupon_id').agg('sum').reset_index()391 dataset3 = pd.merge(dataset3,d,on='coupon_id',how='left')392 dataset3.to_csv('data/coupon3_feature.csv',index=None)393#dataset2394 dataset2['day_of_week'] = dataset2.date_received.astype('str').apply(lambda x:date(int(x[0:4]),int(x[4:6]),int(x[6:8])).weekday()+1)395 dataset2['day_of_month'] = dataset2.date_received.astype('str').apply(lambda x:int(x[6:8]))396 dataset2['days_distance'] = dataset2.date_received.astype('str').apply(lambda x:(date(int(x[0:4]),int(x[4:6]),int(x[6:8]))-date(2016,5,14)).days) 397 dataset2['discount_man'] = dataset2.discount_rate.apply(get_discount_man)398 dataset2['discount_jian'] = dataset2.discount_rate.apply(get_discount_jian)399 dataset2['is_man_jian'] = dataset2.discount_rate.apply(is_man_jian)400 dataset2['discount_rate'] = dataset2.discount_rate.apply(calc_discount_rate)401 d = dataset2[['coupon_id']]402 d['coupon_count'] = 1403 d = d.groupby('coupon_id').agg('sum').reset_index()404 dataset2 = pd.merge(dataset2,d,on='coupon_id',how='left')405 dataset2.to_csv('data/coupon2_feature.csv',index=None)406#dataset1407 dataset1['day_of_week'] = dataset1.date_received.astype('str').apply(lambda x:date(int(x[0:4]),int(x[4:6]),int(x[6:8])).weekday()+1)408 dataset1['day_of_month'] = dataset1.date_received.astype('str').apply(lambda x:int(x[6:8]))409 dataset1['days_distance'] = dataset1.date_received.astype('str').apply(lambda x:(date(int(x[0:4]),int(x[4:6]),int(x[6:8]))-date(2016,4,13)).days) 410 dataset1['discount_man'] = dataset1.discount_rate.apply(get_discount_man)411 dataset1['discount_jian'] = dataset1.discount_rate.apply(get_discount_jian)412 dataset1['is_man_jian'] = dataset1.discount_rate.apply(is_man_jian)413 dataset1['discount_rate'] = dataset1.discount_rate.apply(calc_discount_rate)414 d = dataset1[['coupon_id']]415 d['coupon_count'] = 1416 d = d.groupby('coupon_id').agg('sum').reset_index()417 dataset1 = pd.merge(dataset1,d,on='coupon_id',how='left')418 dataset1.to_csv('data/coupon1_feature.csv',index=None)419420421############# merchant related feature #############422"""4231.merchant related:424 total_sales. sales_use_coupon. total_coupon425 coupon_rate = sales_use_coupon/total_sales.426 transfer_rate = sales_use_coupon/total_coupon.427 merchant_avg_distance,merchant_min_distance,merchant_max_distance of those use coupon428429"""430431#for dataset3432 merchant3 = feature3[['merchant_id','coupon_id','distance','date_received','date']]433438 t1['total_sales'] = 1439 t1 = t1.groupby('merchant_id').agg('sum').reset_index()440441 merchant3.coupon_id=merchant3.coupon_id.replace(np.nan,'null')442 t2 = merchant3[(merchant3.date!='null')&(merchant3.coupon_id!='null')][['merchant_id']]443 t2['sales_use_coupon'] = 1444 t2 = t2.groupby('merchant_id').agg('sum').reset_index()445446 t3 = merchant3[merchant3.coupon_id!='null'][['merchant_id']]447 t3['total_coupon'] = 1448 t3 = t3.groupby('merchant_id').agg('sum').reset_index()449450 t4 = merchant3[(merchant3.date!='null')&(merchant3.coupon_id!='null')][['merchant_id','distance']]451 t4.replace('null',-1,inplace=True)452#t4.distance = t4.distance.astype('int')453 t4.replace(-1,np.nan,inplace=True)454 t5 = t4.groupby('merchant_id').agg('min').reset_index()455 t5.rename(columns={'distance':'merchant_min_distance'},inplace=True)456457 t6 = t4.groupby('merchant_id').agg('max').reset_index()458 t6.rename(columns={'distance':'merchant_max_distance'},inplace=True)459460 t7 = t4.groupby('merchant_id').agg('mean').reset_index()461 t7.rename(columns={'distance':'merchant_mean_distance'},inplace=True)462463 t8 = t4.groupby('merchant_id').agg('median').reset_index()464 t8.rename(columns={'distance':'merchant_median_distance'},inplace=True)465466 merchant3_feature = pd.merge(t,t1,on='merchant_id',how='left')467 merchant3_feature = pd.merge(merchant3_feature,t2,on='merchant_id',how='left')468 merchant3_feature = pd.merge(merchant3_feature,t3,on='merchant_id',how='left')469 merchant3_feature = pd.merge(merchant3_feature,t5,on='merchant_id',how='left')470 merchant3_feature = pd.merge(merchant3_feature,t6,on='merchant_id',how='left')471 merchant3_feature = pd.merge(merchant3_feature,t7,on='merchant_id',how='left')472 merchant3_feature = pd.merge(merchant3_feature,t8,on='merchant_id',how='left')473 merchant3_feature.sales_use_coupon = merchant3_feature.sales_use_coupon.replace(np.nan,0) #fillna with 0474 merchant3_feature['merchant_coupon_transfer_rate'] = merchant3_feature.sales_use_coupon.astype('float') / merchant3_feature.total_coupon 475 merchant3_feature['coupon_rate'] = merchant3_feature.sales_use_coupon.astype('float') / merchant3_feature.total_sales476 merchant3_feature.total_coupon = merchant3_feature.total_coupon.replace(np.nan,0) #fillna with 0477 merchant3_feature.to_csv('data/merchant3_feature.csv',index=None)478479480#for dataset2481 merchant2 = feature2[['merchant_id','coupon_id','distance','date_received','date']]482483 t = merchant2[['merchant_id']]484 t.drop_duplicates(inplace=True)485486 t1 = merchant2[merchant2.date!='null'][['merchant_id']]487 t1['total_sales'] = 1488 t1 = t1.groupby('merchant_id').agg('sum').reset_index()489490 merchant2.coupon_id=merchant2.coupon_id.replace(np.nan,'null')491 t2 = merchant2[(merchant2.date!='null')&(merchant2.coupon_id!='null')][['merchant_id']]492 t2['sales_use_coupon'] = 1493 t2 = t2.groupby('merchant_id').agg('sum').reset_index()494495 t3 = merchant2[merchant2.coupon_id!='null'][['merchant_id']]496 t3['total_coupon'] = 1497 t3 = t3.groupby('merchant_id').agg('sum').reset_index()498499 t4 = merchant2[(merchant2.date!='null')&(merchant2.coupon_id!='null')][['merchant_id','distance']]500 t4.replace('null',-1,inplace=True)501#t4.distance = t4.distance.astype('int')502 t4.replace(-1,np.nan,inplace=True)503 t5 = t4.groupby('merchant_id').agg('min').reset_index()504 t5.rename(columns={'distance':'merchant_min_distance'},inplace=True)505506 t6 = t4.groupby('merchant_id').agg('max').reset_index()507 t6.rename(columns={'distance':'merchant_max_distance'},inplace=True)508509 t7 = t4.groupby('merchant_id').agg('mean').reset_index()510 t7.rename(columns={'distance':'merchant_mean_distance'},inplace=True)511512 t8 = t4.groupby('merchant_id').agg('median').reset_index()513 t8.rename(columns={'distance':'merchant_median_distance'},inplace=True)514515 merchant2_feature = pd.merge(t,t1,on='merchant_id',how='left')516 merchant2_feature = pd.merge(merchant2_feature,t2,on='merchant_id',how='left')517 merchant2_feature = pd.merge(merchant2_feature,t3,on='merchant_id',how='left')518 merchant2_feature = pd.merge(merchant2_feature,t5,on='merchant_id',how='left')519 merchant2_feature = pd.merge(merchant2_feature,t6,on='merchant_id',how='left')520 merchant2_feature = pd.merge(merchant2_feature,t7,on='merchant_id',how='left')521 merchant2_feature = pd.merge(merchant2_feature,t8,on='merchant_id',how='left')522 merchant2_feature.sales_use_coupon = merchant2_feature.sales_use_coupon.replace(np.nan,0) #fillna with 0523 merchant2_feature['merchant_coupon_transfer_rate'] = merchant2_feature.sales_use_coupon.astype('float') / merchant2_feature.total_coupon 524 merchant2_feature['coupon_rate'] = merchant2_feature.sales_use_coupon.astype('float') / merchant2_feature.total_sales。

系统性能测试报告

系统项目性能测试报告X有限责任公司日期:年月日修订控制页目录1. 测试目的 (1)2. 测试地点 (1)3. 测试环境 (1)3.1. 服务器、客户端环境 (1)3.2. 测试工具 (2)4. 测试规模及限制 (2)5. 测试进程说明 (2)5.1. 测试模型 (2)5.2. 测试案例 (3)5.3. 测试场景 (3)测试场景与虚拟并发用户分配表 (3)6. 测试结果 (4)6.1. 平均响应时间 (4)6.2. 过失率统计 (5)6.3. 主机系统资源消耗 (5)7. 性能测试总结 (5)8. 大数据量业务测试数据 (6)8.1. 测试参数 (6)8.2. 测试结果 (6)本报告是针对系统的功能完全性、高可靠性的集群、系统容量等多方面而进行的。

其目的主要是验证系统架构设计决策的正确性,检验架构设计是否有能力承当高并发登录系统进行交易和大数据量的批量处理业务,根据用户提出的业务需求组织利用典型业务来验证系统是否能够适应,发觉现有系统中可能存在的性能方面问题,提出可行性建议,以尽可能着落后续工作风险,为系统的稳固运行提供保证。

主要测试目标以下:(1)获得系统的性能表现,为系统上线提供根据。

(2)考核系统的并发性和效率情形,为代码优化提供指导。

(3)获得系统性能较优的参数配置,为系统调优提供根据。

(4)获得系统在不同负载下的主机资源消耗情形,为硬件配置提供根据。

2.测试地点3.测试环境3.1.服务器、客户端环境本次测试的服务器环境为系统的生产主机,客户环境为1台P4 1.6G 的便携式笔记本。

本次测试使用的设备清单以下:测试工具特点介绍:LoadRunner是用于猜测系统行动和性能的压力测试工具。

它通过模拟大量用户来对全部企业的基础设施进行测试,以发觉问题。

LoadRunner 使用虚拟用户来最小化测试的硬件和人员需求。

虚拟用户是一个代理,它模拟真实的用户来测试程序。

通过使用虚拟用户生成器,用户可以生成虚拟用户。

ODPS——精选推荐

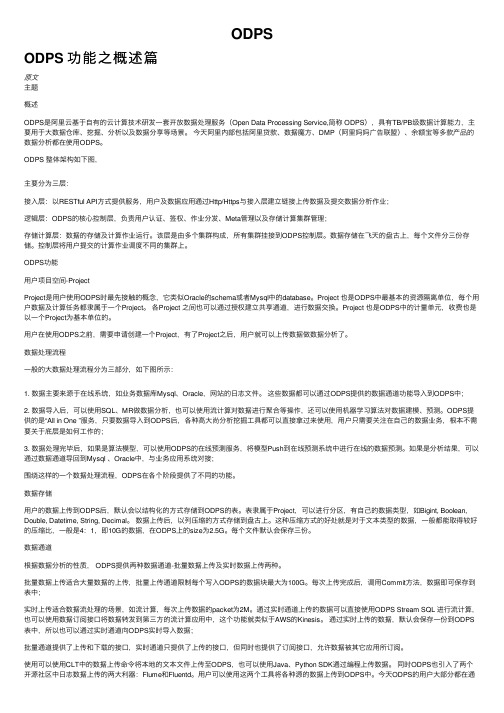

原⽂ODPSODPS 功能之概述篇主题概述ODPS是阿⾥云基于⾃有的云计算技术研发⼀套开放数据处理服务(Open Data Processing Service,简称 ODPS),具有TB/PB级数据计算能⼒,主要⽤于⼤数据仓库、挖掘、分析以及数据分享等场景。

今天阿⾥内部包括阿⾥贷款、数据魔⽅、DMP(阿⾥妈妈⼴告联盟)、余额宝等多款产品的数据分析都在使⽤ODPS。

ODPS 整体架构如下图,主要分为三层:接⼊层:以RESTful API⽅式提供服务,⽤户及数据应⽤通过Http/Https与接⼊层建⽴链接上传数据及提交数据分析作业;逻辑层:ODPS的核⼼控制层,负责⽤户认证、签权、作业分发、Meta管理以及存储计算集群管理;存储计算层:数据的存储及计算作业运⾏。

该层是由多个集群构成,所有集群挂接到ODPS控制层。

数据存储在飞天的盘古上,每个⽂件分三份存储。

控制层将⽤户提交的计算作业调度不同的集群上。

ODPS功能⽤户项⽬空间-ProjectProject是⽤户使⽤ODPS时最先接触的概念,它类似Oracle的schema或者Mysql中的database。

Project 也是ODPS中最基本的资源隔离单位,每个⽤户数据及计算任务都⾪属于⼀个Project。

各Project 之间也可以通过授权建⽴共享通道,进⾏数据交换。

Project 也是ODPS中的计量单元,收费也是以⼀个Project为基本单位的。

⽤户在使⽤ODPS之前,需要申请创建⼀个Project,有了Project之后,⽤户就可以上传数据做数据分析了。

数据处理流程⼀般的⼤数据处理流程分为三部分,如下图所⽰:1. 数据主要来源于在线系统,如业务数据库Mysql、Oracle,⽹站的⽇志⽂件。

这些数据都可以通过ODPS提供的数据通道功能导⼊到ODPS中;2. 数据导⼊后,可以使⽤SQL、MR做数据分析,也可以使⽤流计算对数据进⾏聚合等操作,还可以使⽤机器学习算法对数据建模、预测。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

移动应用/手 游开发者

3

用户的痛点

API BUG太多

参数必传、参数校验等无法用文字表达清楚;SDK和API的BUG会叠加在一 起;API手册本身也有错误。 API功能不够丰富 云监控、云盾API、ECS实例创建时间等信息

API稳定性不够

产品经常宕机升级 API使用不够安全 AccessKeyId不能更换 API使用门槛太高 签名算法很复杂、有些简单的管理功能也需要编程

4

我们在做什么

控制台基于API 将阿里云的控制台构建在自己的开放API之上 重构SDK,产品API、SDK同步发布,基于SDK测试所有的API

避免API覆盖不全,错误码覆盖不全;SDK的功能和API同步发布

补全产品线功能,发布新的产品和特性。 ECS补齐包年包月API、云盾/云监控API近期发布、 制定API SLA (Q2发布) 补齐API Handy工具

5月底发布CLI工具、Eclipse等IDE工具

5

还可以做什么

SDK第三方合作机制来自API论坛、开发者社区等线下活动

6

还可以做什么

产品的持续能力

用户运营(谁在用API、用户口碑、使用障碍、谁用了一次就不用了)

API运营(性能、响应时间)

API对开发者场景的延伸(第三方API)

阿里云API对用户需求的挖掘

2015年04月15日

1

我是谁

李祖合 产品经理 负责阿里云API、SDK、CLI工具

旺旺:祖合

2

谁是我的客户

为用户开发云资源管控系统的开发者 机 房

IDC

PaaS

渠 道

集 团

国 企

政 府

移动应用/手游的开发者

IDC共建+ 合作运营商

大企业客户

为大型国企、电商、政府部门运维IT基础设施的开发者 合作伙伴、解决方案提供商 渠道、PaaS平台、IDC合作伙伴等

竞争对手在做什么

7

一些思考

找到真正这款产品的3个用户,提炼这些用户的通用场景

用户运营,从用户的日常调用数据中发现需求

利用生态的力量,让用户去解决用户的问题

8