一种采用抽样策略的PSO 算法

粒子群优化算法(PSO)综述介绍

带收缩因子的PSO算法:

vi

t 1

X [ v i 1U 1 ( pbi x i ) 2U 2 ( gb x i )]

t t t t t t t

收缩因子保证了收敛性并提高了收敛速度。 显然,该迭代公式和标准迭代公式相比并无本质区别, 只要适当选取参数,二者完全相同。

局部PSO算法:

在计算机上模拟该模型的结果显示:当g_increment较大 时,所有的个体很快地聚集到“谷地”上;反之,粒子缓 慢地摇摆着聚集到“谷地”的四周。 受此模型启发Kennedy和Eberhart设计出了一种演化优化 算法,并通过不断的试验和试错,最后将此算法的基本型 固定为:

vi

t 1

v i 1U 1 ( pbi x i ) 2U 2 ( gb x i )

vi

t 1

v i 1U 1 ( pbi x i ) 2U 2 ( lb x i )

t t t t t为自身最优位置 pbest和种群最优位置gbest。 对应的,在局部版本中,微粒除了追随自身最优位置 pbest之外,不跟踪种群最优位置gbest,而是跟踪拓 扑邻域中的所有微粒的最优位置lbest。

算法思想:

1.初始化种群数量,使他们随机的分布在平面上; 2.根据模型评估每个粒子的位置; 3.如果一个粒子当前的位置比它之前的的位置好,则记录下 新位置,记为pbest;

4.确定种群中最好的粒子的位置,记为gbest;

5.根据公式:

vi

t 1

v i 1U 1 ( p bi x i ) 2U 2 ( g b x i )

背景知识:

粒子群优化算法(Particle Swarm Optimization——PSO), 是由J. Kennedy和R. C. Eberhart于1995年提出的一种基 于种群的随机的优化算法。

pso算法步骤

pso算法步骤PSO算法是一种优化算法,是由“Particle Swarm Optimization”,即粒子群优化算法发展而来的,在解决复杂问题和进行多目标优化方面表现出色。

PSO算法通常适用于连续优化问题,可以优化函数、离散问题以及混合问题。

PSO算法步骤第一步:设定参数在使用PSO算法之前,必须先设定相关参数,这是PSO算法使用过程的一项重要任务。

这些参数决定了粒子在搜索空间中移动的方式和速度,以及算法搜索解的效率。

1. 粒子群规模:$N$2. 惯性权重:$w$3. 最大迭代次数:$T_{max}$4. 每个粒子的学习因子$c_1,c_2$5. 粒子的位置和速度范围:$x_{min}$和$x_{max}$6. 收敛精度第二步:初始化粒子群在PSO算法的第二步中,每个粒子将在解空间中随机生成一个初始位置并随机赋予一个速度。

每个粒子的位置和速度是由以下公式计算得出的:$$x_i(0)=x_{min}+(x_{max}-x_{min})\times rand$$其中$x_{min}$和$x_{max}$是自变量的最小值和最大值,$rand$表示在0和1之间的随机数。

第三步:粒子的运动和更新在这个步骤中,每个粒子都会根据自己的位置和速度更新自己的位置和速度。

这个过程被描述如下:$$v_i(t+1)=wv_i(t)+c_1r_{1i}(p_i-x_i(t))+c_2r_{2i}(g-x_i(t))$$其中,$p_i$是粒子$i$搜索到的最佳位置,$g$是当前所有粒子中最优的位置,$r_{1i}$和$r_{2i}$是0到1之间的随机数。

第四步:评价适应度在此步骤中,需要计算每个粒子在当前位置所对应的适应度值。

这个过程是用来评估点的好坏,估算梯度,对于不同的优化问题有不同的定义方法。

第五步:更新全局最优在这一步中,需要判断每个粒子的适应度值是否比当前的全局最优适应值更好。

如果是,那么需要更新当前全局最优适应值和位置:$$f_{best}=\min(f_{best},f_i)$$$$x_{best}=x_i$$其中,$f_i$是第$i$个粒子的适应度值,$f_{best}$是当前全局最优适应值,$x_{best}$是当前全局最优位置。

pso算法概要

PSO算法是Kennedy和Eberhart在1995年提出的一种进 化计算方法。它通过模拟鸟群的捕食行为来实现优化问题 的求解。在算法中,每个优化问题的可行解都是搜索空间 中的一只鸟,称之为“粒子”。每个“粒子”都有两个参量,一 个是在搜索空间中的位置,另一个是“粒子”的飞翔速度。 PSO算法首先随机生成一个粒子种群,然后追随当前最优 例子在种群中进行迭代搜索,直到达到要求,停止搜索。 PSO算法与GA算法类似,但其个体具有飞行速度参量,从 而可以更快的速度收敛到目标区域(值)。

二、PSO算法的发展

1、PSO算法

1)初始化粒子种群(群体规模为M),包括粒子的位置 和飞行速度;初始化变量pbest和gbest(其中pbest为每个 粒子所搜索到的当前最优解,gbest为整个群体所搜索到的 当前最优解) 2)评价每个粒子的适应度; 3)把比较每个粒子当前适应值与pbest和gbest进行比较, 如果当前粒子优于pbest,则设pbest为当前值;如果当前粒 子优于gbest,则设gbest为当前值; 4)根据方程(1)和(2)变化当前粒子的位置和飞行速度; vid vid c1 * rand ( ) * ( pid xid )

c2 * rand ( ) * ( p gd xid ) xid xid vid

(1) ( 2)

其中

vid : 第i个粒子的第d个速度分量; c1 , c2 : 加速度常数; rand ( ) : 在[0, 1]间均匀分布随机函数; pid : 第i个粒子的pbest的第d各分量; xid : 第i个粒子的第d个位置分量; p gd : gbest的第d个位置分形式的PSO算法中,粒子的飞行追随pbest和lbest (当前粒子的拓扑邻域中的最优粒子)。这种PSO算法可 以提高算法的收敛精度,但是容易陷入局部最优。邻域的 大小一般设为种群大小的15%左右为宜。 3、带惯性权重的PSO算法 惯性权重w 使微粒保持运动惯性, 使其有扩展搜索空间的趋 势, 有能力探索新的区域。引入惯性权重w 可消除对V max的 需要, 因为它们的作用都是维护全局和局部搜索能力的平衡。 这样, 当V max增加时, 可通过减小w 来达到平衡搜索。而w 的 减小可使得所需的迭代次数变小。从这个意义上看, 可以将 V max固定为每维变量的变化范围, 只对w 进行调节。这种算 法可以用方程(3),(4)来描述。

求解并联冷机负荷分配问题的改进FODPSO算法

第52卷第6期2021年6月中南大学学报(自然科学版)Journal of Central South University (Science and Technology)V ol.52No.6Jun.2021求解并联冷机负荷分配问题的改进FODPSO 算法于军琪,赵泽华,赵安军,王福,陈时羽(西安建筑科技大学建筑设备科学与工程学院,陕西西安,710055)摘要:针对并联冷机负荷分配问题,以系统总功率最小为优化目标,建立满足系统末端负荷需求的并联冷机负荷分配优化模型,提出一种改进分数阶达尔文粒子群优化(IFODPSO)算法,以每台冷机的部分负荷率为优化变量进行求解,优化并联冷机系统的运行策略以节能。

首先,针对基本分数阶达尔文粒子群优化(FODPSO)算法粒子初始化过于分散的问题,提出利用蒙特卡洛方法结合基本算数运算符生成初始种群;其次,针对其在高维优化中难以同时搜寻到每一维最优解的问题,引入多重优化提高算法稳定性并加快收敛速度;第三,针对易陷入局部最优的问题,通过自适应多策略行为使粒子能够根据其适应度选择合适的更新方式,提高了算法的搜索能力;最后,以2个典型的并联冷机系统作为案例验证所提出算法的性能,并与其他现有优化算法的实验结果进行对比。

研究结果表明:相比于其他算法,IFODPSO 算法在并联冷机负荷分配问题的求解中能够取得更加显著的节能效果,得到更优的运行策略,同时收敛精度、收敛速度和稳定性都有了显著提高。

关键词:负荷分配;并联冷机;分数阶达尔文粒子群优化算法;蒙特卡洛;多重优化;自适应多策略中图分类号:TU831.6文献标志码:A开放科学(资源服务)标识码(OSID)文章编号:1672-7207(2021)06-1901-14Improved FODPSO algorithm for load distribution of parallel chillersYU Junqi,ZHAO Zehua,ZHAO Anjun,WANG Fu,CHEN Shiyu(School of Building Equipment Science and Engineering,Xi'an University of Architecture and Technology,Xi'an 710055,China)Abstract:Aiming at load distribution problem of parallel chillers,an optimization model of load distribution of parallel chillers was established and the end load requirement was satisfied.An improved fractional order Darwinian particle swarm optimization(IFODPSO)algorithm was proposed to optimize the operation strategy with收稿日期:2021−01−15;修回日期:2021−03−20基金项目(Foundation item):国家重点研发计划项目(2017YFC0704100);安徽建筑大学智能建筑与建筑节能安徽省重点实验室2018年度开放课题(IBES2018KF08)(Project(2017YFC0704100)supported by the National Key Research and Development Program of China;Project(IBES2018KF08)supported by the Anhui Jianzhu University Intelligent Building and Building Energy Saving Anhui Key Laboratory Opening Project in 2018)通信作者:赵安军,博士,副教授,从事智能建筑暖通空调控制与优化研究;E-mail :******************DOI:10.11817/j.issn.1672-7207.2021.06.020引用格式:于军琪,赵泽华,赵安军,等.求解并联冷机负荷分配问题的改进FODPSO 算法[J].中南大学学报(自然科学版),2021,52(6):1901−1914.Citation:YU Junqi,ZHAO Zehua,ZHAO Anjun,et al.Improved FODPSO algorithm for load distribution of parallel chillers[J].Journal of Central South University(Science and Technology),2021,52(6):1901−1914.第52卷中南大学学报(自然科学版)the partial load rate of each chiller as the optimization variable to save energy.Firstly,Monte Carlo method combined with the basic arithmetic operator was used to solve the problem of too much scattered particle initialization in the basic fractional order Darwinian particle swarm optimization(FODPSO)algorithm.Secondly, multi-optimization was introduced to find the optimal solution of each dimension at the same time,which improved the stability and accelerated the convergence speed of the algorithm.Thirdly,the adaptive multi-strategy behavior enabled particles to choose appropriate update mode according to its fitness to improve the search abilityof the algorithm for local optimal problem.Finally,two typical parallel chiller systems were taken as examples to verify the performance of the proposed algorithm,and the experimental results of other existing optimization algorithms were compared.The results show that compared with other algorithms,IFODPSO algorithm can achieve more significant energy-saving effect in solving the load distribution problem of parallel chillers,and can search for a better operation strategy.Meanwhile,the convergence accuracy,convergence speed and stability are significantly improved.Key words:load distribution;parallel chiller system;fractional order Darwinian particle swarm optimization algorithm(FODPSO);Monte Carlo;multi-optimization;adaptive multi-strategy近年来,随着人们对舒适性要求的不断提高,作为中央空调系统的主要耗能设备的冷水机组在大型公共建筑中得到了更加广泛的应用,其运行能耗约占中央空调系统总能耗的60%,而该能耗约占建筑总能耗的25%~40%[1]。

优化算法——粒子群算法(PSO)

优化算法——粒子群算法(PSO)粒子群优化算法(Particle Swarm Optimization,PSO)是一种基于鸟群智能行为的全局优化算法,最初由Kennedy和Eberhart于1995年提出。

PSO是一种启发式算法,通过模拟鸟群中鸟的群体行为来寻找问题的最优解。

PSO算法的基本思想是通过每个粒子的个体最优位置和整个群体的全局最优位置来实现过程。

在算法开始时,所有粒子根据问题的空间范围随机初始化,每个粒子具有一个速度和位置。

粒子根据自身的速度依次更新位置,并根据当前位置和历史最优位置来更新速度和个体最优位置。

整个群体通过比较个体最优位置来更新全局最优位置。

更新速度和位置的过程通过调整权重因子来实现。

PSO算法的关键是如何设置速度更新公式和适应度函数。

速度更新公式包括两个部分:粒子的个体最优位置和整个群体的全局最优位置。

粒子根据自身的速度和个体最优位置来调整速度,以向个体最优位置靠近。

同时,粒子还需要考虑整个群体的全局最优位置,以保持协作和合作。

适应度函数用于评估每个粒子的位置的好坏,它是问题特定的,需要根据具体问题来设计。

PSO算法的特点是简单、易于实现和收敛速度快。

与其他算法相比,PSO算法具有以下优势:1.不需要问题的导数信息。

PSO算法只需要计算目标函数即可,不依赖于问题的导数信息,适用于非线性和高度复杂的问题。

2.全局能力强。

通过群体的协作和合作,PSO算法具有很好的全局能力,能够找到问题的全局最优解。

3.算法参数少且易于调整。

PSO算法只有几个参数需要调整,调整参数相对简单,不需要复杂的参数优化过程。

然而,PSO算法也存在一些问题:1.容易陷入局部最优解。

由于算法的随机性和全局能力,PSO算法容易陷入局部最优解,无法找到问题的全局最优解。

为了克服这个问题,研究者提出了很多改进的PSO算法,如自适应权重PSO、混合PSO等。

2.对问题的形状和维度敏感。

PSO算法对问题形状和维度敏感,对于特定形状的问题(如凸函数),PSO算法能够找到最优解,但对于非凸函数等形状复杂的问题,可能会出现收敛速度较慢或找不到最优解的情况。

常用竞争算法

竞争算法是启发式搜索算法的一种,其主要特点是使用概率机制在候选解中搜索最优解。

下面介绍几种常见的竞争算法:

粒子群优化(Particle Swarm Optimization,PSO):PSO 是一种模拟鸟群、鱼群等动物群体智能行为的优化算法,通过个体和群体历史最佳位置的引导来更新粒子的速度和位置,以实现全局最优解的搜索。

蚁群优化(Ant Colony Optimization,ACO):ACO模拟了蚁群的觅食行为,通过蚂蚁之间的信息交流和食物的积累来寻找最短路径或最优解。

差分进化(Differential Evolution,DE):DE是一种直接、简单且高效的全局优化算法,通过种群中个体的差异来产生新的个体,以实现全局最优解的搜索。

模拟退火(Simulated Annealing,SA):SA模拟了固体退火的过程,通过逐渐降低温度来控制解的搜索过程,以实现全局最优解的搜索。

遗传算法(Genetic Algorithm,GA):GA模拟了生物进化过程中的自然选择和遗传机制,通过种群的遗传、交叉和变异等操作来寻找最优解。

这些算法各有特点,适用于不同的问题和场景。

选择合适的算法需要考虑问题的性质、解空间的大小和复杂性、搜索空间的维度和连续性等因素。

pso算法综述

第2章微粒群优化算法综述微粒群优化算法(PSO)是一种基于种群的随机优化技术,由Eberhart 和Kennedy于1995年提出[1-2]。

微粒群算法模仿昆虫、兽群、鸟群和鱼群等的群集行为,这些群体按照一种合作的方式寻找食物,群体中的每个成员通过学习它自身的经验和其他成员的经验来不断改变其搜索模式。

Kennedy和Eberhart提出微粒群算法的主要设计思想与两个方面的研究密切相关:一是进化算法,微粒群算法和进化算法一样采用种群的方式进行搜索,这使得它可以同时搜索待优化目标函数解空间中的较多区域。

二是人工生命,即研究具有生命特征的人工系统,它采用的主要工具是计算机,主要方法是利用计算机编程模拟。

Millonas在用人工生命理论来研究群居动物的行为时,对于如何采用计算机构建具有合作行为的群集人工生命系统,提出了五条基本原则[13]:(1)邻近原则(Proximity Principle):群体应该能够执行简单的空间和时间运算。

(2)质量原则(Quality Principle):群体应该能感受到周围环境中质量因素的变化,并对其产生响应。

(3)反应多样性原则(Principle of Diverse Response):群体不应将自己获取资源的途径限制在狭窄的范围之内。

(4)稳定性原则(Principle of Stability):群体不应随着环境的每一次变化而改变自己的行为模式。

(5)适应性原则(Principle of Adaptability):当改变行为模式带来的回报是值得的时候,群体应该改变其行为模式。

其中4、5两条原则是同一个问题的两面。

微粒群系统满足以上五条原则。

近十余年来,针对微粒群算法展开的研究很多。

目前国内外已有多人从多个方面对微粒群算法进行过综述[14-27];并出现了多本关于微粒群算法的专著[11, 28-29]和以微粒群算法为主要研究内容的博士论文[3, 30-36]。

PSO算法的改进

PSO算法的改进PSO(粒子群优化)算法是一种仿真人群集群行为的智能优化算法,被广泛应用于优化问题的解决。

然而,传统的PSO算法存在一些问题,如易陷入局部最优解、速度较慢等。

为了克服这些问题,许多改进的PSO算法被提出。

下面将重点介绍几种常见的改进方法。

1.离散PSO算法传统的PSO算法是基于连续空间的优化方法,对二进制优化问题不太适应。

离散PSO算法通过将连续速度和位置转化为离散的形式,采用二进制编码方法,从而适应离散化问题。

此外,离散PSO算法还引入了局部机制,通过随机抽取一部分粒子进行局部,提高效率。

2.遗传算法融合PSO算法遗传算法(GA)是一种启发式算法,具有全局能力。

将GA和PSO相结合可以将它们的优点互补,提高效率和收敛性。

一种常见的方法是将GA的交叉、变异和选择操作应用于PSO的位置和速度更新过程中,以增加算法的多样性和全局能力。

3.多种群PSO算法传统的PSO算法通常只有一个粒子群集合,大多数粒子都在不同的空间探索,导致效率较低。

多种群PSO算法引入了多个群体,每个群体独立,交流信息,以提高能力。

这样可以加快全局速度并避免陷入局部最优解。

4.改进粒子选择策略在传统的PSO算法中,每个粒子只根据自己的历史最优和全局最优进行更新。

这种选择策略可能导致算法收敛速度慢。

改进的策略包括引入粒子选择机制来根据适应度值选择邻居,以更好地利用信息,加速收敛。

5.参数自适应方法传统的PSO算法需要手动设置参数,对不同问题的适应性较差。

参数自适应方法通过利用优化问题本身的信息来自动调整参数,提高算法的性能和鲁棒性。

常见的方法包括自适应惯性权重、自适应学习因子等。

6.混合PSO算法混合PSO算法将PSO和其他优化算法相结合,以提高能力和收敛性。

例如,将模拟退火算法的随机性质引入PSO中,可以在全局和局部之间取得平衡。

此外,还可以将模糊逻辑、神经网络等方法与PSO相结合,以改善算法的性能。

总之,PSO算法作为一种全局优化方法,经过多年研究和改进,已经形成了众多的改进版本。

非线性正余弦优化算法改进跟随者公式

非线性正余弦优化算法改进跟随者公式在过去的几十年里,科学界研究已经展示,非线性系统的控制可以被改进并优化,以提高控制参数和控制性能。

非线性系统的控制一直都是非常棘手的,而正余弦优化(PSO)算法就是一种用于改进和优化非线性系统控制的一种算法。

本文将重点介绍正余弦优化(PSO)算法在跟随者公式中的应用,并进行改进。

正余弦优化(PSO)算法是一种基于群体智能的迭代优化算法,以极大化或极小化目标函数的值。

它是基于一组解决问题的灵活可靠的搜索策略,它能够在搜索空间内发现最佳解,并可以用于有限的搜索性能。

它的优势在于,它可以搜索全局极值,并且可以处理复杂的优化问题。

跟随者公式是一种控制策略,用于提高控制器性能,并对控制参数进行优化。

它使用目标函数来表示控制参数,并使用粒子群算法来搜索最优控制参数。

传统的跟随者公式搜索最优控制参数的效果不佳,因此建议使用正余弦优化(PSO)算法来进行改进。

为了改进跟随者公式,我们实现了一种基于正余弦优化(PSO)算法的改进方法,用来寻找控制参数的最优值,以提高控制器性能。

首先,选择一组有限个控制参数,然后计算它们在目标函数中的值,以确定最优控制参数。

其次,使用正余弦优化(PSO)算法计算控制参数的最优值,从而实现控制器性能的改进。

最后,比较改进后的控制参数和传统的控制参数的性能,以便评估改进后的控制参数的效果。

实验结果表明,使用正余弦优化(PSO)算法改进跟随者公式可以提高控制器性能和控制参数的精确性,并显示出较高的收敛性和较低的浪费率。

由此可以看出,使用正余弦优化(PSO)算法来改进跟随者公式是一种有效的方法,可以提高控制器性能和可靠性。

总而言之,正余弦优化(PSO)算法对跟随者公式的改进是一种有效的方法,可以提升控制参数的准确性和控制器性能。

改进后的跟随者公式可以在不影响其本身性能方面有效地解决控制问题。

此外,由于正余弦优化(PSO)算法的优势,它可以用于复杂的优化问题。

标准粒子群算法(PSO)及其Matlab程序和常见改进算法

一、粒子群算法概述粒子群优化算法(PSO)是一种进化计算技术(evolutionary computation),1995 年由Eberhart 博士和kennedy 博士提出,源于对鸟群捕食的行为研究。

该算法最初是受到飞鸟集群活动的规律性启发,进而利用群体智能建立的一个简化模型。

粒子群算法在对动物集群活动行为观察基础上,利用群体中的个体对信息的共享使整个群体的运动在问题求解空间中产生从无序到有序的演化过程,从而获得最优解。

PSO中,每个优化问题的解都是搜索空间中的一只鸟。

我们称之为“粒子”。

所有的粒子都有一个由被优化的函数决定的适应值(fitness value),每个粒子还有一个速度决定他们飞翔的方向和距离。

然后粒子们就追随当前的最优粒子在解空间中搜索。

PSO 初始化为一群随机粒子(随机解)。

然后通过迭代找到最优解。

在每一次迭代中,粒子通过跟踪两个”极值”来更新自己。

第一个就是粒子本身所找到的最优解,这个解叫做个体极值pBest。

另一个极值是整个种群目前找到的最优解,这个极值是全局极值gBest。

另外也可以不用整个种群而只是用其中一部分作为粒子的邻居,那么在所有邻居中的极值就是局部极值。

二、算法原理粒子群算法采用常数学习因子,及惯性权重,粒子根据如下的公式更新自己的速度和位置。

V ki=ωk V i−1i+c1r1(Q bi−Q k−1i)+c2r2(Q bg−Q k−1i)Q ki=Q k−1i+V ki三、算法步骤1、随机初始化种群中各微粒的位置和速度;2、评价个粒子的适应度,将各粒子的位置和适应度储存在各微粒的pbest(Q bi)中,将所有pbest中适应度最优的个体的位置和适应度存储在gbest(Q bg)中。

3、更新粒子的速度和位移。

V ki=ωk V i−1i+c1r1(Q bi−Q k−1i)+c2r2(Q bg−Q k−1i)Q ki=Q k−1i+V ki4、对每个微粒,与其前一个最优位置比较,如果较好,则将其作为当前的最优位置。

pso算法python

pso算法pythonPSO算法(Particle Swarm Optimization,粒子群优化算法)是一种基于群体行为的启发式优化算法,由Kennedy和Eberhart于1995年提出。

PSO算法是一种基于群体智能的优化方法,其灵感来源于鸟群或鱼群等生物群体协同行动的行为。

PSO算法的基本思想是通过模拟群体中个体之间的协作和信息共享,来寻找全局最优解。

PSO算法模拟了鸟群中个体飞行时的行为,在搜索过程中通过个体之间的合作来寻找最优解。

PSO算法通过不断更新粒子的速度和位置来实现全局搜索,从而找到最优解。

PSO算法的特点包括易于实现、易于收敛、对初始值不敏感等。

因此,PSO算法在工程优化、神经网络训练、特征选择、模式识别等领域得到了广泛的应用。

PSO算法的基本原理PSO算法基于群体智能的原理,主要由粒子群的群体行为和信息传递两个基本部分组成。

粒子群的位置和速度分别代表了可能的解和搜索的方向,通过不断迭代更新粒子的位置和速度,最终找到最优解。

粒子群的基本行为是模拟了鸟群或鱼群等生物群体的行为。

在PSO 算法中,每个粒子都有自己的位置和速度,同时也有了个体的最优位置和全局最优位置。

粒子群中的每个粒子都通过不断的更新自己的位置和速度来模拟搜索过程,从而找到全局最优解。

粒子群的信息传递是通过个体和全局最优位置来实现的。

在搜索过程中,每个粒子都会根据自己的最优位置和全局最优位置来更新自己的速度和位置,从而实现信息的共享和传递。

通过不断更新粒子的速度和位置,PSO算法可以在搜索空间中找到全局最优解。

PSO算法的步骤PSO算法的基本步骤包括初始化粒子群、更新粒子速度和位置、评估适应度、更新个体和全局最优位置、判断停止条件等。

1.初始化粒子群PSO算法首先需要初始化一个粒子群,包括设定粒子的初始位置和速度、个体和全局最优位置等。

通常情况下,粒子的初始位置和速度是随机生成的,个体和全局最优位置可以初始化为无穷大。

PSO算法在优化问题中的应用分析

PSO算法在优化问题中的应用分析引言:优化问题是现实生活和科学研究中经常遇到的一类问题,在许多领域中被广泛应用。

传统的优化方法往往需要依赖于目标函数的特殊结构,对问题有一定的先验知识要求,同时也容易陷入局部最优解。

然而,粒子群优化(Particle Swarm Optimization,PSO)算法作为一种经典的优化算法,具有自适应性强、全局搜索能力好等优点,在解决各种优化问题中取得了显著的成绩。

本文将对PSO算法在优化问题中的应用进行深入分析和探讨。

一、PSO算法的原理及流程PSO算法是一种模拟鸟群觅食行为的随机搜索算法,通过模拟鸟群中的个体之间的信息交流和合作,以动态调整个体的搜索方向,达到寻优的目的。

PSO算法的基本原理是通过不断更新和调整粒子的位置和速度来搜索最优解。

每个粒子表示一个候选解,通过跟踪自身历史最优和邻域最优解,并结合全局最优解进行位置和速度的更新。

其基本流程如下:1. 初始化粒子群,包括粒子的位置和速度。

2. 根据目标函数计算粒子群中每个粒子的适应度值。

3. 更新每个粒子的速度和位置。

4. 判断终止条件是否满足,如果满足则结束算法,否则返回第2步。

5. 输出全局最优解作为优化问题的解。

二、PSO算法在函数优化中的应用1. 单目标函数优化在单目标函数优化中,PSO算法可以用来求解最大值或最小值。

通过不断优化个体的位置和速度,粒子群往往能够在较短的时间内接近甚至达到全局最优解。

2. 多目标函数优化对于多目标函数优化问题,PSO算法可以通过引入多个适应度值来评估粒子的优劣,并利用非支配排序和拥挤度距离等方法来维护粒子群的多样性和收敛性。

通过多次迭代,PSO算法可以得到一组近似的最优解,形成一个Pareto前沿。

三、PSO算法在工程优化中的应用1. 电力系统优化电力系统优化是一个复杂的多变量、非线性、多目标的优化问题。

PSO算法可以应用于优化电力系统的发电调度、输电网优化和电力市场建设等问题。

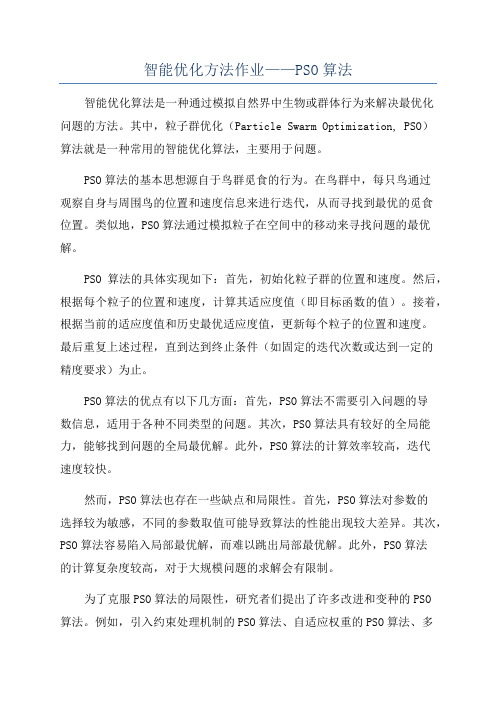

智能优化方法作业——PSO算法

智能优化方法作业——PSO算法智能优化算法是一种通过模拟自然界中生物或群体行为来解决最优化问题的方法。

其中,粒子群优化(Particle Swarm Optimization, PSO)算法就是一种常用的智能优化算法,主要用于问题。

PSO算法的基本思想源自于鸟群觅食的行为。

在鸟群中,每只鸟通过观察自身与周围鸟的位置和速度信息来进行迭代,从而寻找到最优的觅食位置。

类似地,PSO算法通过模拟粒子在空间中的移动来寻找问题的最优解。

PSO算法的具体实现如下:首先,初始化粒子群的位置和速度。

然后,根据每个粒子的位置和速度,计算其适应度值(即目标函数的值)。

接着,根据当前的适应度值和历史最优适应度值,更新每个粒子的位置和速度。

最后重复上述过程,直到达到终止条件(如固定的迭代次数或达到一定的精度要求)为止。

PSO算法的优点有以下几方面:首先,PSO算法不需要引入问题的导数信息,适用于各种不同类型的问题。

其次,PSO算法具有较好的全局能力,能够找到问题的全局最优解。

此外,PSO算法的计算效率较高,迭代速度较快。

然而,PSO算法也存在一些缺点和局限性。

首先,PSO算法对参数的选择较为敏感,不同的参数取值可能导致算法的性能出现较大差异。

其次,PSO算法容易陷入局部最优解,而难以跳出局部最优解。

此外,PSO算法的计算复杂度较高,对于大规模问题的求解会有限制。

为了克服PSO算法的局限性,研究者们提出了许多改进和变种的PSO算法。

例如,引入约束处理机制的PSO算法、自适应权重的PSO算法、多种群PSO算法等等。

这些改进和变种的PSO算法能够在一定程度上提高算法的性能,并在一些特定的问题中取得了良好的效果。

总的来说,粒子群优化(PSO)算法是一种常用的智能优化算法,能够较好地解决最优化问题。

它通过模拟粒子在空间中的移动来问题的最优解。

虽然PSO算法存在一些缺点和局限性,但通过改进和变种的PSO算法,可以提高算法的性能并扩展其应用范围。

粒子群算法的各种变体算法

粒子群算法的各种变体算法

粒子群算法(PSO)是一种启发式优化算法,最初由Kennedy和Eberhart在1995年提出。

它模拟了鸟群或鱼群中个体之间的协作

和竞争关系,在解决优化问题时具有较好的收敛性和全局寻优能力。

随着研究的深入,人们提出了许多粒子群算法的变体,以应对不同

类型的优化问题和改善算法性能。

以下是一些常见的粒子群算法的

变体:

1. 改进的粒子群算法(IPSO),IPSO通过改变粒子的速度更

新公式、邻域拓扑结构或者引入新的搜索策略来增强PSO的全局搜

索能力和局部搜索能力。

2. 多种群粒子群算法(MPSO),MPSO将种群划分为多个子种群,每个子种群独立进行搜索,并通过信息共享来提高全局搜索能力。

3. 自适应粒子群算法(APSO),APSO通过自适应地调整算法

参数或者搜索策略来适应不同的优化问题,提高算法的鲁棒性和适

用性。

4. 混沌粒子群算法(CPSO),CPSO引入了混沌序列来增加算

法的随机性,提高搜索的多样性和全局寻优能力。

5. 多目标粒子群算法(MOPSO),MOPSO针对多目标优化问题

进行了改进,通过引入帕累托最优解集和多目标优化策略来寻找最

优的解集。

6. 基于改进策略的粒子群算法(SPSO),SPSO通过引入新的

搜索策略,如局部搜索、动态权重、自适应参数等,来提高算法的

收敛速度和全局搜索能力。

这些粒子群算法的变体在不同的优化问题中都有其独特的优势,研究人员可以根据具体的问题特点选择合适的算法来进行求解。

同时,随着对粒子群算法的研究不断深入,相信会有更多新的变体算

法被提出来,以满足不断变化的优化问题需求。

遗传粒子群算法

遗传粒子群算法1、简介遗传粒子群算法(Particle Swarm Optimization,简称PSO)是一种基于群体智能的进化计算方法,是KennethO.Stanley和ReennC.Eberhart于1995年提出的,采用类群智能策略来解决一些复杂的优化问题。

它的概念来源于动物行为学中某种鸟类群体捕食行为的研究,常用于求解非线性优化问题,其准确性、简单性、高效性等均比较好。

遗传粒子群算法可以被视为一种动态搜索算法,它最初由一组随机初始化的参数(称为“粒子”),伴随迭代运算而不断地调整参数而显现出一种聚类现象,最终趋于一个有意义的局部或全局搜索最优解的稳定状态。

遗传粒子群算法的优势主要是它是一种无参数设定的自适应优化算法,而且不需要关于函数的任何先验知识,所以它在优化过程中没有终止条件,而且具有较强的自适应能力。

2、算法原理遗传粒子群算法是一种基于群体智能的进化计算方法,通过个体间的交流和自身的学习来实现全局最优解的搜索。

粒子群算法在每次迭代中更新粒子的速度和位置,从而实现全局最优解的搜索。

算法的运行步骤如下:(1) 初始化粒子群,每个粒子有一组参数坐标及一组随机速度(2) 计算粒子的适应值,每个粒子各自计算自己的适应值,并以此更新自己的最优位置(3) 更新粒子的速度和位置,根据计算出的最优位置更新粒子的速度和位置(4) 更新记录的全局最优位置,每次更新粒子后,比较每个粒子的适应值,将当前最优的粒子位置记录下来,作为全局最优的解(5) 重复执行步骤2-4,直到满足算法终止条件3、算法优化遗传粒子群算法的参数和变量可以通过调整来实现优化。

它们主要有:(1) 粒子个数:每个粒子有一组参数坐标及一组随机速度,粒子的个数决定了算法的搜索范围和精度,粒子越多,搜索范围越广,精度也越高。

(2) 最大速度:为了避免速度过大而错过最优解,最大速度通常被设定在一个范围内,即不允许超过最大速度。

(3) 行为因子:更新粒子位置的行为因子需要合适的调整,合理的行为因子可以有效的控制粒子的搜索过程。

pso算法 matlab程序

pso算法 matlab程序PSO算法,即粒子群优化算法(Particle Swarm Optimization),是一种启发式优化算法,常用于解决搜索和优化问题。

在Matlab中实现PSO算法可以通过以下步骤:步骤1,初始化粒子群。

首先,需要初始化一群粒子,每个粒子都代表了搜索空间中的一个候选解。

每个粒子都有自己的位置和速度。

可以使用随机数函数在搜索空间内随机生成粒子的初始位置和速度。

步骤2,计算适应度。

接下来,需要计算每个粒子的适应度,适应度函数根据具体问题而定。

适应度函数可以是需要最小化或最大化的目标函数。

步骤3,更新粒子的速度和位置。

根据PSO算法的原理,需要根据当前位置和速度以及个体最优位置和全局最优位置来更新粒子的速度和位置。

这个过程可以通过一些数学公式来实现,通常包括学习因子、惯性权重等参数。

步骤4,更新个体和全局最优位置。

在更新粒子的过程中,需要不断更新个体最优位置和全局最优位置。

如果某个粒子找到了比之前更好的位置,就需要更新个体最优位置;如果整个粒子群中出现了更好的位置,就需要更新全局最优位置。

步骤5,重复迭代。

以上步骤需要进行多次迭代,直到满足停止迭代的条件。

通常可以设置迭代次数或者适应度达到某个阈值时停止迭代。

在Matlab中,可以使用循环结构来实现迭代过程,同时根据上述步骤编写相应的代码来实现PSO算法。

常用的Matlab函数和工具包如“fmincon”、“Global Optimization Toolbox”等也可以用来实现PSO算法。

总结来说,实现PSO算法的关键在于理解其基本原理,正确地编写粒子的更新规则和适应度函数,并进行合适的迭代和终止条件设置。

希望这些信息能帮助你在Matlab中实现PSO算法。

pso算法python

pso算法pythonPSO算法是一种基于群体智能的优化算法。

其基本思想就是通过多个粒子之间的群体行为,来寻找最优解。

PSO算法的这种群体行为是根据每个粒子当前的位置和速度来进行的。

具体来说,PSO算法是这样工作的:首先,算法随机生成一些初始的粒子,并对每个粒子的位置和速度进行初始化。

接着,算法不断迭代,每一次迭代中,粒子的位置和速度都会根据一些规则进行更新。

例如,每个粒子会根据自己的历史最优位置和整个群体的历史最优位置调整自己的速度和位置。

然后,算法会判断整个群体是否已经找到了最优解。

如果没有找到,就继续迭代,否则,算法结束,得到最优解。

下面是一个简单的Python实现:```pythonimport randomimport mathclass Particle():def __init__(self, dim, min_x, max_x):self.position = [random.uniform(min_x, max_x) for i in range(dim)]self.velocity = [0.0] * dimself.best_pos = self.position[:]self.best_score = float('inf')def update_velocity(self, best_pos_g):w = 0.5 # 惯性权重c1 = c2 = 1 # 学习因子for i in range(len(self.velocity)):r1 = random.random()r2 = random.random()vel_cognitive = c1 * r1 * (self.best_pos[i] - self.position[i])vel_social = c2 * r2 * (best_pos_g[i] -self.position[i])self.velocity[i] = w * self.velocity[i] +vel_cognitive + vel_socialdef update_position(self, bounds):for i in range(len(self.position)):self.position[i] += self.velocity[i]if self.position[i] > bounds[i][1]:self.position[i] = bounds[i][1]self.velocity[i] = 0.0elif self.position[i] < bounds[i][0]:self.position[i] = bounds[i][0]self.velocity[i] = 0.0def evaluate(self, cost_func):self.score = cost_func(self.position)if self.score < self.best_score:self.best_pos = self.position[:]self.best_score = self.scoreclass PSO():def __init__(self, cost_func, dim, n_particles, n_iter, bounds):self.cost_func = cost_funcself.dim = dimself.n_particles = n_particlesself.n_iter = n_iterself.bounds = boundsself.particles = [Particle(dim, bounds[i][0], bounds[i][1]) for i in range(dim)]self.best_pos_g = [random.uniform(bounds[i][0], bounds[i][1]) for i in range(dim)]self.best_score_g = float('inf')def run(self):for iter in range(self.n_iter):for particle in self.particles:particle.evaluate(self.cost_func)if particle.score < self.best_score_g:self.best_pos_g = particle.position[:]self.best_score_g = particle.scorefor particle in self.particles:particle.update_velocity(self.best_pos_g)particle.update_position(self.bounds)def get_best_position(self):return self.best_pos_gdef get_best_score(self):return self.best_score_g```在这个实现中,Particle类表示一个粒子,包含了位置、速度、历史最优位置和历史最优得分等信息。

PSO算法使用简介

PSO算法使用简介1 PSO工具箱简介PSOt为PSO的工具箱,该工具箱将PSO算法的核心部分封装起来,提供给用户的为算法的可调参数,用户只需要定义好自己需要优化的函数(计算最小值或者最大值),并设置好函数自变量的取值范围、每步迭代允许的最大变化量(称为最大速度,Max_V)等,即可自行优化。

与遗传算法相比,PSO仅需要调整少数几个参数即可实现函数的优化。

该算法对待优化函数没有任何特别的要求(如可微分、时间连续等),因而其通用性极强,对多变量、高度非线性、不连续及不可微的情况更加具有其优势。

该工具箱的使用主要分为几个步骤:1) 在Matlab中设置工具箱的路径;2) 定义待优化函数;3) 调用PSO算法的核心函数:pso_Trelea_vectorized()。

其中第三步最关键,用户需要根据自己的需要设置好参数,可使算法极快收敛。

下面对各个步骤一一介绍。

2 设置工具箱的路径2.1 在Matlab的命令窗口点击"File-->Set Path....",如下图:2.2 在弹出的对话框中点击"Add Folder",然后浏览找到工具箱放置的位置,如下图2.3 若想用到该工具箱所带的测试函数,还需要用如上同样的方法,设置路径指向工具箱下的"testfunctions"文件夹;2.4 若想用于训练神经网络的训练,设置路径指向工具箱下的"testfunctions"文件夹"nnet"3 定义待优化函数(参见文件test_func.m)用户根据自己的需要,定义需要优化的函数。

举个例子,若想计算如下二元函数的最小值z= 0.5*(x-3)^2+0.2*(y-5)^2-0.1其中自变量x、y的范围均为[-50, 50]。

可按下面的方法定义该待优化函数:%%----------------------------------------------------------------%%function z=test_func(in)nn=size(in);x=in(:,1);y=in(:,2);nx=nn(1);for i=1:nxtemp = 0.5*(x(i)-3)^2+0.2*(y(i)-5)^2-0.1;z(i,:) = temp;end%%----------------------------------------------------------------%% 需要特别指出的是:PSO算法的核心函数pso_Trelea_vectorized()自动初始化一组随机变量,因而待优化函数test_func(in)中的输入in是一个矩阵,由一组x和y的值组成,对应的,函数的输出z为一个向量4 定义待优化函数(参见文件test_main.m)当定义好待优化函数后,设置相应的参数,然后就可以调用PSO进行优化了,对上面优化问题,按下面的方式进行调用:%%----------------------------------------------------------------%%clearclcx_range=[-50,50]; %参数x变化范围y_range=[-50,50]; %参数y变化范围range = [x_range;y_range]; %参数变化范围(组成矩阵)Max_V = 0.2*(range(:,2)-range(:,1)); %最大速度取变化范围的10%~20%n=2; %待优化函数的维数,此例子中仅x、y两个自变量,故为2 pso_Trelea_vectorized('test_func',n,Max_V,range) %调用PSO核心模块%%----------------------------------------------------------------%%5 PSO算法中相关参数的说明5.1 工具箱中相关参数的含义在该工具箱中,用户可以设置PSO算法的13个参数(参见pso_Trelea_vectorized()的注释部分),但实际上,有些参数采用采用算法提供的默认值即可,算法的默认值说明如下(在pso_Trelea_vectorized函数的定义中,用变量Pdef表示,若用户在pso_Trelea_vectorized 的调用中赋以数值,则会覆盖相应的参数。

pso优化算法原理

pso优化算法原理PSO优化算法原理PSO(Particle Swarm Optimization)优化算法是一种模拟鸟群或鱼群等群体行为的智能优化算法。

该算法通过模拟粒子的行为来搜索最优解,广泛应用于函数优化、机器学习、图像处理等领域。

PSO算法的核心思想是通过模拟粒子的群体行为来搜索最优解。

在算法开始时,随机生成一群粒子,每个粒子代表问题的一个解。

每个粒子都有自身的位置和速度,通过更新速度和位置来搜索最优解。

在PSO算法中,每个粒子都有一个适应度函数,用来评估该粒子的解的质量。

适应度函数根据问题的具体要求而定,可以是目标函数的值、误差的大小等。

粒子通过不断更新自身的速度和位置来搜索适应度函数值最小的解。

粒子的速度更新是通过两个方向的变化来实现的,分别是个体最优和群体最优。

个体最优是指粒子自身历史上最好的位置,群体最优是指整个粒子群体历史上最好的位置。

粒子根据个体最优和群体最优的信息来调整自身的速度和位置,以期望找到更好的解。

具体来说,粒子的速度更新公式如下:V(t+1) = w * V(t) + c1 * r1 * (Pbest - X(t)) + c2 * r2 * (Gbest - X(t))其中,V(t+1)表示粒子在下一次迭代中的速度,w为惯性因子,用来平衡上一次速度和本次速度的重要性;c1和c2为加速系数,分别表示个体和群体对速度变化的影响力;r1和r2为随机数;Pbest 表示粒子自身历史上最好的位置;Gbest表示整个粒子群体历史上最好的位置;X(t)为粒子在当前位置的坐标。

粒子的位置更新公式如下:X(t+1) = X(t) + V(t+1)其中,X(t+1)表示粒子在下一次迭代中的位置,X(t)为粒子在当前位置的坐标,V(t+1)为粒子在下一次迭代中的速度。

通过不断迭代更新粒子的速度和位置,直到满足停止条件为止。

停止条件可以是达到一定的迭代次数,或者粒子的适应度函数值达到一定的阈值。

pso算法数学理解

pso算法数学理解PSO算法是一种常用的优化算法,它的数学理解可以从多个方面进行解释。

下面将从数学模型、算法流程和优化原理三个方面对PSO 算法进行详细的解析。

一、数学模型PSO算法的数学模型可以用向量的方式表示。

假设有N个粒子,每个粒子的位置用一个D维向量表示,记作x_i=(x_i1, x_i2, ..., x_iD),其中i=1,2,...,N。

每个粒子都有一个对应的速度v_i=(v_i1, v_i2, ..., v_iD)。

此外,每个粒子还有一个对应的适应度值f_i,用来评估粒子的优劣程度。

二、算法流程PSO算法的基本思想是模拟鸟群觅食的行为,即通过粒子之间的协作和信息共享来寻找最优解。

其具体流程如下:1. 初始化粒子群的位置和速度,设置适应度函数;2. 根据适应度函数,更新每个粒子的适应度值;3. 更新全局最优解和每个粒子的个体最优解;4. 根据全局最优解和个体最优解,计算每个粒子的速度和位置;5. 判断是否满足停止条件,若满足则输出最优解,否则返回步骤2。

三、优化原理PSO算法的优化原理可以从两个方面解释:局部搜索和全局搜索。

1. 局部搜索:粒子通过个体最优解进行局部搜索,即根据自身经验来调整速度和位置,以期望找到离个体最优解更接近的解。

2. 全局搜索:粒子通过全局最优解进行全局搜索,即根据全局最优解的信息来调整速度和位置,以期望找到全局最优解。

PSO算法通过不断地更新粒子的速度和位置,使得粒子在解空间中搜索到最优解。

其核心思想是通过粒子之间的信息交流和协作来加速搜索过程,从而提高优化效果。

总结:通过以上的数学模型、算法流程和优化原理的解析,我们可以更好地理解PSO算法的数学原理。

PSO算法是一种基于群体智能的优化算法,通过模拟鸟群觅食的行为,通过粒子之间的协作和信息共享来寻找最优解。

其核心思想是通过不断地更新粒子的速度和位置,使得粒子在解空间中搜索到最优解。

PSO算法在实际应用中具有较好的收敛性和全局搜索能力,被广泛应用于各种优化问题的求解。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

(5)

4) 中间粒子 4 (������itemp(4)). 该粒子的每一维等于 ������ 对应维最大值和最小值中绝对值较小者, 即

������itemp(4)������ = {

min(������(:, ������)), ∣ min(������(:, ������))∣ < ∣ max(������(:, ������))∣;

策

第 30 卷

真测试. 测试结果表明, 相比于经典 PSO 算法, 经过改 进的新算法的性能有一定的提高. 基本粒子群算法和 拉丁超立方抽样算法的步骤详见文献 [1] 和文献 [16], 文中不再赘述.

1 改进算法

1.1 基于 LHS 抽样策略和中间粒子选择的粒子更 新方式

在 PSO 中, 参数 ������、������1 和 ������2 如何变化往往通过经 验值或实验指定[17-18], 缺乏灵活性. 有学者提出利用 分层算法改进 PSO[19], 取得了良好的效果. 然而, 由于 群体较多, 较大地增加了计算量. 对此, 文中提出一种 新思路, 即通过 LHS 抽样产生多个粒子的速度和位 置, 再通过一定的规则, 从这些速度和位置向量中选 择恰当的元素作为下一轮迭代中粒子的速度和位置. 基本步骤如图 1 所示.

方式, 不过由于参数是确定的, 粒子下一次迭代中的

位置和速度也随之确定, 粒子没有其他选择, 缺乏灵

活性. 而在采用 LHS 的抽样方法中, 通过抽样, 可以

取得多组参数, 得到多个中间粒子, 可以选择其中最

优的粒子进入下一次迭代, 并且下一代的种群可以体

现出群体进化的趋势, 有利于提升个体在进化中的灵

< ω1,c ,11 c12 > → vi1 & xi1

X ( itemp 1)

< ω2,c ,12 c22 > → vi2 & xi2 [X ] X ( itemp 2)

x

i

X ( itemp 3)

v i

< ωh,c ,1h c2h > → vih & xih

X ( itemp 4)

xi (t+1) vi (t+1)

1) 中间粒子 1 (������itemp(1)). 该粒子的每一维等于

������ 对应维的平均值, 即

∑ℎ ������������,������

������itemp(1)������

=

������=1

ℎ

, ������ = 1, 2, ⋅ ⋅ ⋅ , ������. (3)

2) 中间粒子 2 (������itemp(2)). 该粒子的每一维等于

Abstract: There’re some issues such as fixed parameters’ value and easy to fall into local optimum in classical PSO algorithm and many improvements. Therefore, an improved PSO algorithm via sampling strategy(SS-PSO) is proposed. Firstly, replacement of the particles’ speed and location via Latin hypercube sampling(LHS) is proposed for speeding up the convergence process. Then, correction of the global best location via random sampling is proposed for fine tuning the global best location. Finally, “double sampling” LHS is proposed for local search to improve the convergence precision. Two new improvements are used to compare with the SS-PSO algorithm. The results show that the SS-PSO algorithm can improve the PSO’s algorithm performance in some extent. Keywords: particle swarm optimization;sampling strategy;local search;global optimization

一种基于随机采样的最优位置修正方法, 以微调全局最优; 提出“双抽样”LHS 局部搜索方法, 以提高收敛精度. 与其

他新近提出的两个算法进行对比, 结果显示 SS-PSO 在一定程度上提高了算法的性能.

关键词: 粒子群优化算法;抽样策略;局部搜索;全局优化

中图分类号: TP306.1

文献标志码: A

������ 对应维的中值, 即

������itemp(2)������ = median(������(:, ������)), ������ = 1, 2, ⋅ ⋅ ⋅ , ������. (4)

3) 中间粒子 3 (������itemp(3)). 该粒子的每一维等于 ������ 对应维最大值和最小值中绝对值较大者, 即

权粒子的 PSO 算法; 文献 [14] 提出了一种基于中断因 子的粒子群算法, 用于使算法尽快跳出局部最优; 文 献 [15] 将梯度信息和吸引-排斥机制融合, 提出了基 于多样性导向的 PSO 算法. 以上算法虽然在一定程度 上改善了原始算法的性能, 但是在收敛精度和稳定性 上仍然存在欠缺.

本文提出一种采用抽样策略的粒子群优化算 法 (SS-PSO). 针对基本算法收敛较慢、参数取值固定 的问题, 提出基于 LHS[16]的粒子位置和速度更新方 式, 从多组中间粒子中抽取位置和速度, 克服参数取 值固定的影响, 提高收敛速度; 针对全局最优位置容 易停滞的问题, 提出基于随机采样的最优位置修正方 法, 及时发现更优的空间位置; 针对易于陷入局部最 优的问题, 使用“双抽样”方法进行 LHS 局部搜索, 提 高收敛精度. 最后针对几个常用的测试函数进行了仿

������������������ = ������������ + ������������������.

(2)

Step 3 对于产生的 ℎ 组位置向量, 可以构成大小

为 ℎ × ������ 的矩阵 ������, 矩阵的每一行代表一个粒子的位

置. 从矩阵 ������ 中按照下列各式提取出 4 个中间粒子.

0引 言

近年来, 学者们提出了一系列新颖的群智能优 化算法. 其中, 粒子群优化算法[1]以其流程简单、易于 实现而得到较多青睐, 并被推广到各个应用领域[2-7]. 然而, 粒子群算法容易早熟收敛、收敛精度低等缺陷 使其应用受到了限制. 对此, 学者们从不同角度提出 了多种改进方法[8-15]. 文献 [8] 研究了粒子群进化公 式中随机性的相关问题, 并提出了基于与全局最优 位置距离的粒子群算法; 文献 [9] 研究了算法的速度 与惯性权重的关系, 并提出了根据速度信息调整参 数的粒子群算法; 文献 [10] 提出了一种加快粒子群收 敛速度的向心加速粒子群算法; 文献 [11] 提出了综合 学习粒子群算法, 利用一种新的粒子综合学习方式 改善了算法的性能; 文献 [12] 提出了一种基于振荡权 重和加速因子的粒子群算法; 文献 [13] 提出了采用加

∑ℎ ������������,������

������

(������

+

1)������

=

������=1

ℎ

, ������ = 1, 2, ⋅ ⋅ ⋅ , ������.

(7)

在基本粒子群算法及各改进方式中, 各个参数的

取值都是由某个模型指定的. 这样, 在下一次迭代中,

各个参数的值唯一并且确定. 这种方式是现在通用的

Step 5 速度的更新. 在 Step 2 所述的过程中, 也

产生了大小为 ℎ × ������ 的速度矩阵, 记为 ������ , 其每一行代

表一个速度向量. 为了反映粒子运动的平均趋势, 设

置第 ������ 个粒子在下一轮迭代中的速度 ������������ 为 ������ 中每一

维的平均值.

������itemp(3)������ = {

min(������(:, ������)), ∣ min(������(:, ������))∣ > ∣ max(������(:, ������))∣;

max(������(:, ������)), else.

������ = 1, 2, ⋅ ⋅ ⋅ , ������.

活性和种群的收敛速度.

表 1 统计了在不同问题中, 4 个中间粒子被取到

作为下一轮迭代粒子位置的比例, 展示了该方法对不

同性质问题的灵活适应性, 其中每个测试函数独立运

行 10 次, 维数为 30 维.

表 1 各中间粒子被取到的比例统计 (30������) %

函数名

粒子 1

粒子 2

粒子 3

max(������(:, ������)), else.

������ = 1, 2, ⋅ ⋅ ⋅ , ������.

(6)

Step 4 计算式 (3) ∼ (6) 所表示的 4 个中间粒子的

适应度值, 取其中适应度值最佳 (对于求最小值问题,

即适应度值最小) 的中间粒子的位置作为下一轮迭代

的第 ������ 个粒子的位置.

第 30 卷 第 10 期 Vol. 30 No. 10

控制与决策

Control and Decision