好懂的人工神经网络算法教程

人工神经网络算法

/s/blog_5bbd6ec00100b5nk.html人工神经网络算法(2008-11-20 17:24:22)标签:杂谈人工神经网络算法的作用机理还是比较难理解,现在以一个例子来说明其原理。

这个例子是关于人的识别技术的,在门禁系统,逃犯识别,各种验证码破译,银行预留印鉴签名比对,机器人设计等领域都有比较好的应用前景,当然也可以用来做客户数据的挖掘工作,比如建立一个能筛选满足某种要求的客户群的模型。

机器识别人和我们人类识别人的机理大体相似,看到一个人也就是识别对象以后,我们首先提取其关键的外部特征比如身高,体形,面部特征,声音等等。

根据这些信息大脑迅速在内部寻找相关的记忆区间,有这个人的信息的话,这个人就是熟人,否则就是陌生人。

人工神经网络就是这种机理。

假设上图中X(1)代表我们为电脑输入的人的面部特征,X(2)代表人的身高特征X(3)代表人的体形特征X(4)代表人的声音特征W(1)W(2)W(3)W(4)分别代表四种特征的链接权重,这个权重非常重要,也是人工神经网络起作用的核心变量。

现在我们随便找一个人阿猫站在电脑面前,电脑根据预设变量提取这个人的信息,阿猫面部怎么样,身高多少,体形胖瘦,声音有什么特征,链接权重初始值是随机的,假设每一个W均是0.25,这时候电脑按这个公式自动计算,Y=X(1)*W(1)+X(2)*W(2)+X(3)*W(3)+X(4)*W(4)得出一个结果Y,这个Y要和一个门槛值(设为Q)进行比较,如果Y>Q,那么电脑就判定这个人是阿猫,否则判定不是阿猫.由于第一次计算电脑没有经验,所以结果是随机的.一般我们设定是正确的,因为我们输入的就是阿猫的身体数据啊.现在还是阿猫站在电脑面前,不过阿猫怕被电脑认出来,所以换了一件衣服,这个行为会影响阿猫的体形,也就是X(3)变了,那么最后计算的Y值也就变了,它和Q比较的结果随即发生变化,这时候电脑的判断失误,它的结论是这个人不是阿猫.但是我们告诉它这个人就是阿猫,电脑就会追溯自己的判断过程,到底是哪一步出错了,结果发现原来阿猫体形X(3)这个体征的变化导致了其判断失误,很显然,体形X(3)欺骗了它,这个属性在人的识别中不是那么重要,电脑自动修改其权重W(3),第一次我对你是0.25的相信,现在我降低信任值,我0.10的相信你.修改了这个权重就意味着电脑通过学习认为体形在判断一个人是否是自己认识的人的时候并不是那么重要.这就是机器学习的一个循环.我们可以要求阿猫再穿一双高跟皮鞋改变一下身高这个属性,让电脑再一次进行学习,通过变换所有可能变换的外部特征,轮换让电脑学习记忆,它就会记住阿猫这个人比较关键的特征,也就是没有经过修改的特征.也就是电脑通过学习会总结出识别阿猫甚至任何一个人所依赖的关键特征.经过阿猫的训练电脑,电脑已经非常聪明了,这时你在让阿猫换身衣服或者换双鞋站在电脑前面,电脑都可以迅速的判断这个人就是阿猫.因为电脑已经不主要依据这些特征识别人了,通过改变衣服,身高骗不了它.当然,有时候如果电脑赖以判断的阿猫关键特征发生变化,它也会判断失误.我们就不要要求这么高了,不要说电脑,就是人类也无能为力,你的一个好朋友你经过多次的识记肯定认识吧,但是他整了容你们在大街上邂逅.你可能觉得这个人声音好熟悉,体形好熟悉,----都像自己一个朋友,就是脸长的不像.你不敢贸然上去搭讪吧(否定的判断).因为我们判定一个人是否是自己的朋友的时候依靠的关键的特征就是面部特征,而他恰恰就是改变了这一特征.当然也存在我们把一个拥有和我们朋友足够多相似特征的人判定为我们的朋友,这就是认错人的现象了.这些问题电脑也会出现.不过这个算法还是有比较积极的意义的,实现了一定程度上的智能化.下面是这种方法的理论解释:人工神经网路学习是要透过我们的头脑,因而研究大脑神经细胞的运作,可以帮助我们了解学习在脑神经是如何完成的,进而可以模拟神经细胞的运作以达到類似学习的功能。

《人工神经网络算法》课件

计算网络输出

添加标题

反向传播误差

添加标题

重复以上步骤直到达到预设 的停止条件,如损失函数值 小于某个阈值或达到预设的

迭代次数。

添加标题

添加标题

输入训练数据

添加标题

计算损失函数

添加标题

更新网络权重和偏置

常见的人工神经网 络算法

前馈神经网络算法

概念:一种多层感知器模型,输入层、隐藏层和输出层之间没有反馈连 接

特点:易于训练,适合处理线性和非线性问题

应用:图像识别、语音识别、自然语言处理等领域

结构:输入层、隐藏层和输出层,其中隐藏层可以有多个

训练方法:反向传播算法,通过调整权重和偏置来最小化损失函数

优缺点:优点是易于实现,缺点是难以处理时间序列数据

循环神经网络算法

特点:能够处理序列数据,如 语音、文本等

理复杂问题

深度学习技术 将更加安全, 能够更好地保 护用户隐私和

数据安全

人工神经网络算法与其他算法的结合应用

人工神经网络算法与深度学习的结合:提高模型的准确性和泛化能力 人工神经网络算法与强化学习的结合:解决复杂决策问题,提高模型的适应性和学习能力 人工神经网络算法与自然语言处理的结合:提高文本理解和生成能力,实现人机交互 人工神经网络算法与图像处理的结合:提高图像识别和生成能力,实现图像理解和生成

1986年, Rumelha rt等人提 出反向传 播算法, 解决了多 层神经网 络的训练 问题

1998年, LeCun等 人提出卷 积神经网 络,开启 了深度学 习的新时 代

2012年, Hinton等 人提出深 度信念网 络,进一 步推动了 深度学习 的发展

2015年, Google 的 AlphaGo 战胜人类 围棋冠军, 标志着人 工智能的 突破性进 展

第6章人工神经网络算法ppt课件

4.随机型神经网络 随机型神经网络其基本思想是:不但让网络的误差和能量函数向减小的方

向变化,而且还可按某种方式向增大的方向变化,目的是使网络有可能跳出局部 极小值而向全局最小点收敛。随机型神经网络的典型算法是模拟退火算法。

曲线越陡。

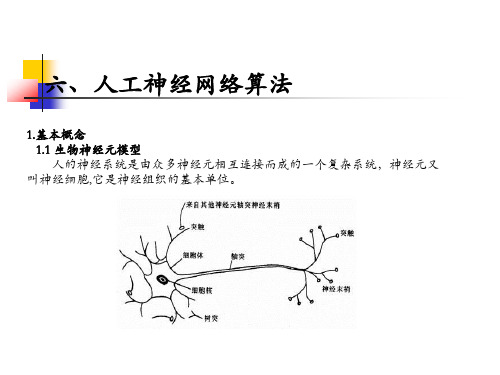

六、人工神经网络算法

1.基本概念 1.2 人工神经元模型 神经元采用了不同的激活函数,使得神经元具有不同的信息处理特性,并且

神经元的信息处理特性是决定神经网络整体性能的主要因素之一。 下面介绍四种常用的激活函数形式:

(4)高斯函数。高斯函数(也称钟型函数)也是极为重要的一类激活函数,常用 于径向基神经网络(RBF网络),其表达式为:

通过调整权值和阈值,使得误差能量达到最小时,网络趋于稳定状态,学习

结束。

(1)输出层与隐含层之间的权值调整。对每一个 wjk 的修正值为:

w jk

E

w jk

E

netk

netk w jk

J

式中: 为学习步长,取值介于(0,1),对式 netk wjkOj 求偏导得:

j0

netk wjk

Oj

x1

w1i

x2

w2ifΒιβλιοθήκη yixnwni

x0 1

六、人工神经网络算法

1.基本概念 1.2 人工神经元模型 在神经元中,对信号进行处理采用的是数学函数,通常称为激活函数、激励

函数或挤压函数,其输入、输出关系可描述为

u j

f

n

wij xi

j

i1

y f uj

式中xi i 1,2,,n是从其它神经元传来的输入信号; j 是该神经元的阈值;

人工神经网络的算法(完整版)

BP 网络的算法 设网络输入为X ,输入神经元有r 个;隐含层有1s 个神经元,激发函数为1F ;输出层内有2s 个神经元,对应的激活函数为2F 。

输出为Y ,目标矢量为T 。

(1) 信息的正向传递① 隐含层中第i 个神经元的输出为:1,2,1),11(111s i b x w f y rj i j ij i =+=∑= (4.15)② 输出层第k 个神经元的输出为:2,,2,1),212(2211s k b y w f y s i k i ki k =+=∑=(4.16)③ 定义误差函数为:∑=-=212)2(21),(s k k ky t B W E (4.17)(2) 求权值的变化及误差的反向传播① 输出层的权值变化对从第i 个输入到第k 个输出的权值变化为:i kii k k kikk kiki y y f y t w y y Ew E w 112)2(22222ηδηηη='-=∂∂∂∂-=∂∂-=∆ (4.18)式(4.18)中,kk k k k k ki y t e f e f y t 222)2(-='='-=;δ。

同理可得:ki k k kik kkik f y t b y y E b E b δηηηη⋅='⋅-=∂∂⋅∂∂-=∂∂-=∆2)2(22222 (4.19)② 隐含层权值的变化对从第j 个输入到第i 个输出的权值,其变化量为:jij j ki s k k k iji ik kijij x x f w f y t w y y y y E w E w ⋅⋅=⋅'⋅'-=∂∂⋅∂∂⋅∂∂-=∂∂-=∆∑=δηηηη122)2(111221121(4.20)式(4.20)中,∑=='=212,1s k kiki i i ij w e f e δδ同理可得:ij i b ηδ=∆1。

(三)BP 网络的设计和训练 1)BP 网络的设计 设计BP 网络的结构,包括的内容为:①网络的层数;②每层的神经元数;③初始权值的选取;④期望误差的选取。

人工神经网络的算法和应用

人工神经网络的算法和应用人工神经网络是一种由多个节点和连接组成的计算模型,其灵感来自于生物神经网络。

与传统的机器学习模型相比,人工神经网络可以处理更加复杂的任务,并且能够进行自适应性的学习,从而实现高效的模式识别和数据分析。

在本文中,我们将探讨人工神经网络的算法和应用。

一、算法1.感知机算法感知机算法是最早的人工神经网络算法之一,它基于一种称为感知机的计算单元。

感知机可以被看作是多个独立的逻辑门,通过输入和输出之间的权重调整来实现逻辑运算。

感知机算法的缺点在于它只适用于线性可分问题。

如果数据不能被线性分割,那么感知机就无法解决这个问题。

因此,感知机主要用于二元分类和线性回归问题。

2.反向传播算法反向传播算法是一种基于梯度下降的优化算法。

它通过不断调整权重和偏置,使神经网络的预测结果更加接近于实际值。

反向传播算法的优点在于它可以处理非线性可分问题,并且具有更好的精度和收敛速度。

然而,反向传播算法也有一些缺点,例如容易收敛到局部最优解、容易受到梯度消失和爆炸等问题的影响。

3.长短时记忆(LSTM)算法LSTM算法是一种专门用于处理序列数据的神经网络算法。

它通过引入“门”机制来控制信息的流动,并且能够长时间记忆先前的信息。

LSTM算法在自然语言处理、语音识别、股价预测等领域得到了广泛应用。

二、应用1.图像识别图像识别是人工神经网络的一个重要应用领域。

通过训练神经网络模型,图像识别系统可以实现对于图片中物体和场景的识别和分类。

在医疗诊断、自动驾驶、安防等领域,图像识别技术已经得到了广泛应用。

2.自然语言处理自然语言处理是另一个重要的应用领域。

通过训练神经网络模型,自然语言处理系统可以实现对于自然语言的理解和生成。

自然语言处理技术在智能客服、智能翻译、信息提取、情感分析等方面得到了广泛应用。

3.股价预测股价预测是人工神经网络在金融领域的应用之一。

通过训练神经网络模型,股价预测系统可以实现对于股票价格的预测。

神经网络算法的代码实现详解

神经网络算法的代码实现详解神经网络算法是一种模拟人脑神经系统的计算模型,它通过构建多层神经元网络来实现对数据的学习与预测。

本文将对神经网络算法的代码实现进行详细解析,通过Python语言实现。

1.数据准备首先,我们需要准备训练数据和测试数据。

训练数据是用来训练神经网络的样本,通常包含一组输入数据和对应的输出数据。

测试数据则是用来测试训练后的神经网络模型的准确性。

2.构建神经网络结构接下来,我们需要构建神经网络的结构。

神经网络通常由多层神经元组成,每层神经元与上一层的神经元全连接。

我们可以使用Python的Numpy库来创建神经网络的结构,其中的矩阵运算能够高效地实现神经网络算法。

3.定义激活函数神经网络中,每个神经元都需要一个激活函数来对输入数据进行处理,并输出非线性的结果。

常用的激活函数有sigmoid函数、ReLU 函数等。

我们可以在构建神经网络结构时定义激活函数。

4.前向传播前向传播是指从输入层开始,逐层计算神经元的输出,直到输出层为止。

这一过程可以通过矩阵运算实现,其中每一层的输出都是上一层输出与权重矩阵的乘积再经过激活函数处理得到。

最终,输出层的输出即为神经网络的预测结果。

5.反向传播反向传播是指根据预测结果,逐层更新权重矩阵,以使得预测结果与实际结果尽可能接近。

反向传播算法通过计算误差项,逆向更新权重矩阵。

误差项的计算根据损失函数的不同而有所差异,常用的损失函数有均方误差、交叉熵等。

6.更新权重矩阵根据反向传播算法计算得到的误差项,我们可以更新每一层的权重矩阵。

更新的方法一般是使用梯度下降算法,通过计算每个权重的梯度值以及学习率,来逐步调整权重的取值。

7.训练神经网络模型在完成以上步骤后,我们可以开始训练神经网络模型。

训练过程即是重复进行前向传播和反向传播,以不断更新权重矩阵。

通过多次迭代,使得神经网络模型的预测结果逼近真实结果。

8.测试神经网络模型在训练完成后,我们需要使用测试数据对神经网络模型进行测试,以评估其性能。

人工神经网络多层前向网络及BP学习算法

y1

x1

x2

y2

xm

yp

xM

yP

i (1,2, , I ) j (1,2, , J )

神经元旳输入用u表达,鼓励输出用v表达,u, v旳上

标表达层,下标表达层中旳某个神经元,如

u

I i

表达I

层(即第1隐层)旳第i个神经元旳输入。设全部旳

神经元旳鼓励函数均用Sigmoid函数。设训练样本集

为X=[X1,X2,…,Xk,…,XN],相应任一训练样本: Xk= [xk1,xk2,…, kM]T,(k=1,2,…,N)旳实际输出为: Yk= [yk1, yk2,…,ykP]T,期望输出为dk= [dk1,dk2,…, dkP]T。 设n为迭代次数,权值和实际输出是n旳函数。

E(n) wij(n)

E(n) uJj (n)

uJj (n) wij(n)

E(n) uJj (n)

viI

(n)

设局部梯度为:

J j

(n)

E(n) uJj (n)

E(n) vJj (n) vJj (n) uJj (n)

vJj uJj

(n) (n)

f

'

(uJj

(n))

E(n)

1 2

P

ek2p(n)

p1

E(n)

vJj (n)

pP1ekp(n)evkJjp((nn))

pP1ekp(n)eukpPp((nn))uvJpP j ((nn))

e k( n p ) d k( n p ) y k( n p ) d k( n p ) f( u p P ( n ))

ekp(n) upP(n)

f

'

(upP(n))

人工神经网络ppt课件

人工神经网络ppt课件

感知器

• 一种类型的ANN系统是以感知器为基础

• 感知器以一个实数值向量作为输入,计 算这些输入的线性组合,如果结果大于 某个阈值,就输出1,否则输出-1

o(x1,..xn .), 11w 0w 1o x1 t.h..ew nrxnw 0ise

其 值 率中,。每用特个来别w决地i是定 ,一输-w个入0是实xi阈对数值感常。知量器,输或出叫的做贡权献

• 算法的一种常用改进方法是随着梯度下降步数 的增加逐渐减小学习速率

2019.12.18

机器学习-人工神经网络 作者:Mitchell 译者:曾华军等 讲者:陶晓鹏

26

梯度下降的随机近似

• 梯度下降是一种重要的通用学习范型,它是搜 索庞大假设空间或无限假设空间一种策略

• 梯度下降应用于满足以下条件的任何情况

2019.12.18

机器学习-人工神经网络 作者:Mitchell 译者:曾华军等 讲者:陶晓鹏

33

可微阈值单元

• 使用什么类型的单元来构建多层网络?

• 多个线性单元的连接仍产生线性函数,而我们 希望构建表征非线性函数的网络

Байду номын сангаас

• 感知器单元可以构建非线性函数,但它的不连 续阈值使它不可微,不适合梯度下降算法

2019.12.18

机器学习-人工神经网络 作者:Mitchell 译者:曾华军等 讲者:陶晓鹏

25

梯度下降法则的推导(4)

• 梯度下降算法如下

– 选取一个初始的随机权向量 – 应用线性单元到所有的训练样例,根据公式4.7计算

每个权值的w 更新权值

• 因为误差曲面仅包含一个全局的最小值,所以 无论训练样例是否线性可分,算法都会收敛到 具有最小误差的权向量,条件是使用足够小的 学习速率

人工神经网络算法推导精品PPT课件

(3)当感知器神经网络的所有输入样本中存在奇异的样 本,即该样本向量同其他所有的样本向量比较起来特 别大或特别小时,网络训练花费的时间将很长。解决 这种问题的方法可以采用标准化感知器学习规则。

对训练样本集中的每一组输入能提供一组目标输 出

网络根据目标输出与实际输出的误差信号来调节

网络参数

教师

t(n)

期望输出

实际输出

输入

环境

神经网络

比较

a(n)

p(n)

误差信号

e(n)

非监督学习与再励学习

学习 方法

非监督学习:不存在教 师,网络根据外部数据 的统计规律来调节系统 参数,以使网络输出能 反映数据的某种特性

感知器计算说明

• 例1:苹果和橘子的自动分类问题

• 用一组传感器测量水果的三个特征:外形、质 地和重量。如果水果基本上是圆形的,外形传 感器输出为1,若水果接近于椭圆,外形传感 器输出为0;如果水果表面光滑,质地传感器 输出为1,若水果表面粗糙,质地传感器输出 为0;如果水果重量超过1磅,重量传感器输出 为1,若水果轻于1磅,重量传感器输出为0;

再励学习:外部环境对 网络输出只给出评价信 息而非正确答案,网络 通过强化受奖励的动作 来改善自身的性能

输入

环境 神经网络

输出 输入

环境

神经网络

评价信息

Hebb学习

学习 方法

Hebb学习规则:

BP神经网络算法步骤

BP神经网络算法步骤

1.初始化神经网络参数

-设置网络的输入层、隐藏层和输出层的神经元数目。

-初始化权重和偏置参数,通常使用随机小值进行初始化。

2.前向传播计算输出

-将输入样本数据传入输入层神经元。

-根据权重和偏置参数,计算隐藏层和输出层神经元的输出。

- 使用激活函数(如Sigmoid函数)将输出映射到0到1之间。

3.计算误差

4.反向传播更新权重和偏置

-根据误差函数的值,逆向计算梯度,并将梯度传播回网络中。

-使用链式法则计算隐藏层和输出层的梯度。

-根据梯度和学习率参数,更新权重和偏置值。

5.重复迭代训练

-重复执行2-4步,直到网络输出误差满足预定的停止条件。

-在每次迭代中,使用不同的训练样本对网络进行训练,以提高泛化性能。

-可以设置训练轮数和学习率等参数来控制训练过程。

6.测试和应用网络

-使用测试集或新样本对训练好的网络进行测试。

-将测试样本输入网络,获取网络的输出结果。

-根据输出结果进行分类、回归等任务,评估网络的性能。

7.对网络进行优化

-根据网络在训练和测试中的性能,调整网络的结构和参数。

-可以增加隐藏层的数目,改变激活函数,调整学习率等参数,以提高网络的性能。

以上是BP神经网络算法的基本步骤。

在实际应用中,还可以对算法进行改进和扩展,如引入正则化技术、批量更新权重等。

同时,数据的预处理和特征选择也对网络的性能有着重要的影响。

在使用BP神经网络算法时,需要根据实际问题对网络参数和训练策略进行适当调整,以获得更好的结果。

第三讲(2)人工神经网络(BP算法)

1974年,Werbos已提出了该方法

2。弱点 :训练速度非常慢、局部极小点的逃离问题、算法 不一定收敛。 3。优点:广泛的适应性和有效性。

4.1 概述

一、简介

BP算法即反向传播算法,有时也称为BP模型; BP算法是为了解决多层前向神经网络的权系数优化而提出来

的,通常暗示着神经网络的拓扑结构是一种无反馈的多层前向

Xim = Yi

(期望输出)

误差信号e

反向传播修改权系数

2、反向传播 称 为一般化的Delta法则,由公式可知 求取本层 dik时,要用到高一层的 dik+1 ;可见,误差函数的求 取是从输出层开始,到输入层的反向传播过程; 通过多个样本的反复训练,同时向误差渐渐减小的方向对权 系数进行修正,以达最终消除误差。从上面公式也可以知道,

Real Distribution

Overfitted

4.2 BP网的学习算法

二、BP算法原理 (六)几个问题

收敛速度问题 局部极小点问题 网络瘫痪问题 :训练中当训练步长会变得非常小,将导致训练速度降得非 常低,最终导致网络停止收敛 稳定性问题 步长问题 BP网络的收敛是基于无穷小的权修改量 步长太小,收敛就非常慢 步长太大,可能会导致网络的瘫痪和不稳定 自适应步长,使得权修改量能随着网络的训练而不断变化。

输出Y=(Y1,Y2,…,Yn)。 3.计算各层的输出。 对于第k层第i个神经元的输出Xik,有:

4.2 BP网的学习算法

二、BP算法原理 (四)BP算法的执行步骤 4.求各层的学习误差dik对于输出层有:

If k=m

else

5.修正权系数Wij和阀值θ

4.2 BP网的学习算法

二、BP算法原理 (四)BP算法的执行步骤

人工神经网络方法

04

人工神经网络的实现

数据预处理

数据清洗:去除异常值、缺失值和重复值 数据转换:将数据转换为适合神经网络处理的格式 数据标准化:将数据缩放到统一的标准范围内 数据归一化:将数据缩放到[0,1]或[-1,1]范围内

网络训练

训练方法:通过有标签数据进行优化 训练过程:前向传播和反向传播 训练目的:最小化损失函数 训练技巧:梯度下降法、批量梯度下降法、随机梯度下降法等

模型评估与调优

模型评估指标:准确率、召回率、F1值等 过拟合与欠拟合问题:介绍过拟合和欠拟合的概念及解决方法 超参数优化:介绍常见的超参数优化方法,如网格搜索、随机搜索等 模型调优技巧:介绍一些常用的模型调优技巧,如特征选择、数据增强等

03

常见的人工神经网络算法

感知机算法

定义:感知机算法是一种二类分类的线性分类模型 特点:简单、易于实现、训练速度快 应用:模式识别、文本分类、图像识别等领域 局限:只能处理线性可分的数据集

多层感知机算法

定义:多层感知机是一种前馈人工神经网络模型,由输入层、隐藏层和输出层组成。 作用:用于分类和识别复杂模式。 工作原理:通过反向传播算法对网络进行训练,不断调整权重以最小化输出误差。 应用领域:图像识别、语音识别、自然语言处理等。

型

通过训练,人 工神经网络可 以学习和识别

模式

人工神经网络 广泛应用于图 像识别、语音 识别、自然语 言处理等领域

人工神经网络 由输入层、隐 藏层和输出层 组成,通过权

重连接

人工神经网络的基本原理

神经元模型:模拟生物神经元的基本结构和功能 前向传播:输入信号通过神经元网络传递,经过各层处理后得到输出结果 反向传播:根据输出结果和实际值的误差,调整网络中的权重和偏置参数 训练过程:反复迭代前向传播和反向传播,逐渐优化网络性能

人工神经网络课件

目录

• 神经网络基本概念 • 前馈神经网络 • 反馈神经网络 • 深度学习基础 • 优化算法与技巧 • 实践应用与案例分析

01 神经网络基本概念

生物神经网络简介

01

02

03

生物神经网络组成

生物神经网络由大量神经 元通过突触连接而成,具 有并行处理、分布式存储 和自学习等特性。

信号传递方式

每次只利用一个样本的梯度信息进行参数更新,计算量小,收敛速度快,但容易受到噪声干扰, 陷入局部最优解。

小批量梯度下降法(Mini-Batch Gradie…

折中方案,每次利用一小批样本的梯度信息进行参数更新,兼具批量梯度下降法和随机梯度下降 法的优点。

正则化方法防止过拟合

L1正则化(Lasso)

01

RNN在自然语言处理领域有广泛应用,如机器翻译、文本生成、情感分析等,同时也可以应用于语音识别 和图像处理等领域。

05 优化算法与技巧

梯度下降法及其改进算法

批量梯度下降法(Batch Gradient Des…

利用整个数据集的梯度信息进行参数更新,计算量大,收敛速度慢,但能找到全局最优解。

随机梯度下降法(Stochastic Gradien…

03 反馈神经网络

反馈神经网络结构

01

02

03

04

神经元之间相互连接,形成反 馈回路。

网络中的每个神经元都接收来 自其他神经元的信号,并产生

输出信号。

输出信号会再次作为输入信号 反馈到网络中,影响其他神经

元的输出。

通过不断调整神经元之间的连 接权重,网络可以学习并适应

不同的输入模式。

Hopfield网络模型与算法

批处理、随机梯度下降等优化策略

人工神经网络算法(基础精讲)

26

二、人工神经网络的 学习方法

27

2.1学习机理

学习机理

人工神经网络信息处理可以用数学过程来说明,这个过程可以 分为两个阶段:执行阶段和学习阶段。

学习是智能的基本特征之一,人工神经网络最具有吸引力的特 点是它能从环境中学习的能力,并通过改变权值达到预期的目的。 神经网络通过施加于它的权值和阈值调节的交互过程来学习它的环 境,人工神经网络具有近似于与人类的学习能力,是其关键的方面 之一。

net= wi xi

输出

11

1.5人工神经元模型

上面的神经元模型可以用一个数学表达式进行抽象与概括,从 而得到神经元的数学模型:

n

o f wjxj

j 1

w x 神经元的网络输入记为net,即

n

net=

jj

j 1

12

1.5人工神经元模型

有时为了方便起见,常把-Ɵ也看成是恒等于1的输入X0 的权值 ,这时上面的数学模型可以写成:

神经元和神经网络的关系是元素与整体的关系。 人工神经网络中的神经元常称为节点或处理单元,每个节点均 具有相同的结构,其动作在时间和空间上均同步。

22

1.7人工神经网络模型 人工神经网络的基本属性

1)非线性 2)非局域性 3)非定常性 4)非凸性

23

1.7人工神经网络模型

神经网络模型

神经元的连接方式不同,网络的拓扑结构也不同,人工神经网 络的拓扑结构是决定人工神经网络特征的第二要素,根据神经元之 间连接的拓扑结构不同,可将人工神经网络分成两类,即分层网络 和相互连接型网络。

WT j

人工神经网络算法精讲

6.1 概述

6.1.2 人工神经网络的发展

• 第二次高潮期 —— Hopfield网络模型的出现 和人工神经网络的复苏

– 1982年,John Hopfield向美国科学院递交了有关神经网络的 报告,主要内容就是建议收集和重视以前对神经网络的工作, 其中特别强调了每种模型的实用性。 – 根据对神经网络的数学分析和深入理解, Hopfield揭示了以 往的网络是如何工作的,可以做些什么,并提出了他自己的 模型,能从失真的或不完善的数据图像中获得完整的数据图 像,引起了美国军方的兴趣。 – 当时,人工智能对自动制导车的研究失败,而利用神经网络 有可能解决这个问题,从而使人们的注意力重新投向人工神 经网络,导致了人工神经网络的第二次高潮。

6.1 概述

6.1.2 人工神经网络的发展

• 第二次高潮期 —— Hopfield网络模型的出现 和人工神经网络的复苏

6.1 概述

6.1.1 什么是人工神经网络

• 总结和讨论

– 传统计算机采用的是串行处理方式,限制了大量信息的快速 传输和处理,即使用了多个处理器并行工作,还是会把许多 时间浪费在完成串行操作上,而且问题的并行化分解和并行 程序的编写也是一个难题。 – 虽然至今开发出的超型计算机,其速度和容量都大得惊人, 但仍不能很好地完成诸如小孩可以做到的事情,如认识面孔、 学习说话、识别图像等。 – 尽管人工神经网络还是生物大脑的极低水平的模仿,但在图 像识别、语音识别、记忆、预测以及优化等方面表现出了良 好的智能特性和应用前景,可以完成传统计算机不易实现的 智能性工作。

6.1 概述

6.1.1 什么是人工神经网络

• 人工神经网络的两种操作过程

– 训练学习

• 训练时,把要教给神经网络的信息(外部输入)作为网 络的输入和要求的输出,使网络按某种规则(称为训练 算法)调节各处理单元间的连接权值,直至加上给定输 入,网络就能产生给定输出为止。 • 这时,各连接权已调接好,网络的训练就完成了。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

我见过的最脑残也是最好懂的人工神经网络算法教程来源:赵昂的日志用平常语言介绍神经网络(Neural Networks in Plain English)因为我们没有能够很好了解大脑,我们经常试图用最新的技术作为一种模型来解释它。

在我童年的时候,我们都坚信大脑是一部电话交换机。

(否则它还能是什么呢?) 我当时还看到英国著名神经学家谢林顿把大脑的工作挺有趣地比作一部电报机。

更早些时候,弗罗伊德经常把大脑比作一部水力发电机,而莱布尼茨则把它比作了一台磨粉机。

我还听人说,古希腊人把大脑功能想象为一付弹弓。

显然,目前要来比喻大脑的话,那只可能是一台数字电子计算机了。

-John R.Searle [注1]神经网络介绍(Introduction to Neural Networks )曾有很长一个时期,人工神经网络对我来说是完全神秘的东西。

当然,有关它们我在文献中已经读过了,我也能描述它们的结构和工作机理,但我始终没有能“啊哈!”一声,如同你头脑中一个难于理解的概念有幸突然得到理解时的感觉那样。

我的头上好象一直有个榔头在敲着,或者像电影Animal House(中文片名为“动物屋”)中那个在痛苦地尖叫“先生,谢谢您,再给我一个啊!”的可怜家伙那样。

我无法把数学概念转换成实际的应用。

有时我甚至想把我读过的所有神经网络的书的作者都抓起来,把他们缚到一棵树上,大声地向他们吼叫:“不要再给我数学了,快给我一点实际东西吧!”。

但无需说,这是永远不可能发生的事情。

我不得不自己来填补这个空隙...由此我做了在那种条件下唯一可以做的事情。

我开始干起来了。

<一笑>这样几个星期后,在一个美丽的日子里,当时我在苏格兰海边度假,当我越过一层薄雾凝视着狭长的海湾时,我的头脑突然受到一个冲击。

一下子悟到了人工神经网络是怎样工作的。

我得到“啊哈!”的感觉了!但我此时身边只有一个帐篷和一个睡袋,还有半盒子的脆玉米片,没有电脑可以让我迅速写出一些代码来证实我的直觉。

Arghhhhh!这时我才想到我应该买一台手提电脑。

不管怎样,几天后我回到家了,我立刻让我的手指在键盘上飞舞起来。

几个小时后我的第一人工神经网络程序终于编成和运行了,并且工作得挺好!自然,代码写的有点乱,需要进行整理,但它确实已能工作了,并且,更重要的是,我还知道它为什么能工作!我可以告诉你,那天我是一位非常得意的人。

我希望本书传递给你的就是这种“啊哈!”感觉。

当我们学完遗传算法时,你可能已尝到了一点感觉,但你希望这种感觉是美妙的话,那就要等把神经网络部分整个学完。

生物学的神经网络-大脑(A Biological Neural Network–The Brain )你的大脑是一块灰色的、像奶冻一样的东西。

它并不像电脑中的CPU那样,利用单个的处理单元来进行工作。

如果你有一具新鲜地保存到福尔马林中的尸体,用一把锯子小心地将它的头骨锯开,搬掉头盖骨后,你就能看到熟悉的脑组织皱纹。

大脑的外层象一个大核桃那样,全部都是起皱的[图0左] ,这一层组织就称皮层(Cortex)。

如果你再小心地用手指把整个大脑从头颅中端出来,再去拿一把外科医生用的手术刀,将大脑切成片,那么你将看到大脑有两层[图0右] : 灰色的外层(这就是“灰质”一词的来源,但没有经过福尔马林固定的新鲜大脑实际是粉红色的。

) 和白色的内层。

灰色层只有几毫米厚,其中紧密地压缩着几十亿个被称作neuron(神经细胞、神经元)的微小细胞。

白色层在皮层灰质的下面,占据了皮层的大部分空间,是由神经细胞相互之间的无数连接组成。

皮层象核桃一样起皱,这可以把一个很大的表面区域塞进到一个较小的空间里。

这与光滑的皮层相比能容纳更多的神经细胞。

人的大脑大约含有1OG(即100亿)个这样的微小处理单元;一只蚂蚁的大脑大约也有250, OOO个。

以下表1 显示了人和几种动物的神经细胞的数目。

表l 人和几种动物的神经细胞的数目动物种类经细胞的数目(数量级)蜗牛10,000 (=10^4)蜜蜂100,000 (=10^5)蜂雀10,000,000 (=10^7)老鼠100,000,000 (=10^8)人类10,000,000,000 (=10^10)大象100,000,000,000 (=10^11)图0-1 大脑半球像核桃图0-2 大脑皮层由灰质和白质组成图0 大脑的外形和切片形状图1 神经细胞的结构在人的生命的最初9个月内,这些细胞以每分钟25,000个的惊人速度被创建出来。

神经细胞和人身上任何其他类型细胞十分不同,每个神经细胞都长着一根像电线一样的称为轴突(axon)的东西,它的长度有时伸展到几厘米[译注],用来将信号传递给其他的神经细胞。

神经细胞的结构如图1 所示。

它由一个细胞体(soma)、一些树突(dendrite) 、和一根可以很长的轴突组成。

神经细胞体是一颗星状球形物,里面有一个核(nucleus)。

树突由细胞体向各个方向长出,本身可有分支,是用来接收信号的。

轴突也有许多的分支。

轴突通过分支的末梢(terminal)和其他神经细胞的树突相接触,形成所谓的突触(Synapse,图中未画出),一个神经细胞通过轴突和突触把产生的信号送到其他的神经细胞。

每个神经细胞通过它的树突和大约10,000个其他的神经细胞相连。

这就使得你的头脑中所有神经细胞之间连接总计可能有l,000,000,000,000,000个。

这比100兆个现代电话交换机的连线数目还多。

所以毫不奇怪为什么我们有时会产生头疼毛病!有趣的事实曾经有人估算过,如果将一个人的大脑中所有神经细胞的轴突和树突依次连接起来,并拉成一根直线,可从地球连到月亮,再从月亮返回地球。

如果把地球上所有人脑的轴突和树突连接起来,则可以伸展到离开们最近的星系!神经细胞利用电-化学过程交换信号。

输入信号来自另一些神经细胞。

这些神经细胞的轴突末梢(也就是终端)和本神经细胞的树突相遇形成突触(synapse),信号就从树突上的突触进入本细胞。

信号在大脑中实际怎样传输是一个相当复杂的过程,但就我们而言,重要的是把它看成和现代的计算机一样,利用一系列的0和1来进行操作。

就是说,大脑的神经细胞也只有两种状态:兴奋(fire)和不兴奋(即抑制)。

发射信号的强度不变,变化的仅仅是频率。

神经细胞利用一种我们还不知道的方法,把所有从树突上突触进来的信号进行相加,如果全部信号的总和超过某个阀值,就会激发神经细胞进入兴奋(fire)状态,这时就会有一个电信号通过轴突发送出去给其他神经细胞。

如果信号总和没有达到阀值,神经细胞就不会兴奋起来。

这样的解释有点过分简单化,但已能满足我们的目的。

神经细胞利用电-化学过程交换信号。

输入信号来自另一些神经细胞。

这些神经细胞的轴突末梢(也就是终端)和本神经细胞的树突相遇形成突触(synapse),信号就从树突上的突触进入本细胞。

信号在大脑中实际怎样传输是一个相当复杂的过程,但就我们而言,重要的是把它看成和现代的计算机一样,利用一系列的0和1来进行操作。

就是说,大脑的神经细胞也只有两种状态:兴奋(fire)和不兴奋(即抑制)。

发射信号的强度不变,变化的仅仅是频率。

神经细胞利用一种我们还不知道的方法,把所有从树突上突触进来的信号进行相加,如果全部信号的总和超过某个阀值,就会激发神经细胞进入兴奋(fire)状态,这时就会有一个电信号通过轴突发送出去给其他神经细胞。

如果信号总和没有达到阀值,神经细胞就不会兴奋起来。

这样的解释有点过分简单化,但已能满足我们的目的。

正是由于数量巨大的连接,使得大脑具备难以置信的能力。

尽管每一个神经细胞仅仅工作于大约100Hz的频率,但因各个神经细胞都以独立处理单元的形式并行工作着,使人类的大脑具有下面这些非常明显的特点:能实现无监督的学习。

有关我们的大脑的难以置信的事实之一,就是它们能够自己进行学习,而不需要导师的监督教导。

如果一个神经细胞在一段时间内受到高频率的刺激,则它和输入信号的神经细胞之间的连接强度就会按某种过程改变,使得该神经细胞下一次受到激励时更容易兴奋。

这一机制是50多年以前由Donard Hebb在他写的Organination of Beh avior一书中阐述的。

他写道:“当神经细胞A的一个轴突重复地或持久地激励另一个神经细胞B后,则其中的一个或同时两个神经细胞就会发生一种生长过程或新陈代谢式的变化,使得激励B细胞之一的A 细胞的效能会增加”与此相反的是,如果一个神经细胞在一段时间内不受到激励,那么它的连接的有效性就会慢慢地衰减。

这一现象就称可塑性(plasticity)。

对损伤有冗余性(tolerance)。

大脑即使有很大一部分受到了损伤,它仍然能够执行复杂的工作。

一个著名的试验就是训练老鼠在一个迷宫中行走。

然后,科学家们将其大脑一部分一部分地、越来越大地加以切除。

他们发现,即使老鼠的很大的一部大脑被切除后,它们仍然能在迷宫中找到行走路径。

这一事实证明了,在大脑中,知识并不是保存在一个局部地方。

另外所作的一些试验则表明,如果大脑的一小部分受到损伤,则神经细胞能把损伤的连接重新生长出来。

处理信息的效率极高。

神经细胞之间电-化学信号的传递,与一台数字计算机中CPU的数据传输相比,速度是非常慢的,但因神经细胞采用了并行的工作方式,使得大脑能够同时处理大量的数据。

例如,大脑视觉皮层在处理通过我们的视网膜输入的一幅图象信号时,大约只要100ms的时间就能完成。

考虑到你的神经细胞的平均工作频率只有100Hz,100ms的时间就意味只能完成10个计算步骤!想一想通过我们眼睛的数据量有多大,你就可以看到这真是一个难以置信的伟大工程了。

善于归纳推广。

大脑和数字计算机不同,它极擅长的事情之一就是模式识别,并能根据已熟悉信息进行归纳推广(generlize)。

例如,我们能够阅读他人所写的手稿上的文字,即使我们以前从来没见过他所写的东西。

它是有意识的。

意识(consciousness)是神经学家和人工智能的研究者广泛而又热烈地在辩论的一个话题。

有关这一论题已有大量的文献出版了,但对于意识实际究竟是什么,至今尚未取得实质性的统一看法。

我们甚至不能同意只有人类才有意识,或者包括动物王国中人类的近亲在内才有意识。

一头猩猩有意识吗?你的猫有意识吗?上星期晚餐中被你吃掉的那条鱼有意识吗?因此,一个人工神经网络(Artificial neural network,简称ANN)就是要在当代数字计算机现有规模的约束下,来模拟这种大量的并行性,并在实现这一工作时,使它能显示许多和生物学大脑相类似的特性。

下面就让我们瞧瞧它们的表演吧!***************************************************************888(连载之二)3 数字版的神经网络(The Digital Version)上面我们看到了生物的大脑是由许多神经细胞组成,同样,模拟大脑的人工神经网络ANN是由许多叫做人工神经细胞(Artificial neuron,也称人工神经原,或人工神经元)的细小结构模块组成。