第38课:MapReduce内幕解密以及动手编程实战 学习笔记

运用实例简述mapreduce原理

运用实例简述mapreduce原理MapReduce是一种编程模型和模型化的方法,用于大规模数据集(如分布式文件系统)的并行处理。

它通常用于处理和转换大数据集,以进行数据挖掘、机器学习、数据库等领域的应用。

MapReduce原理的核心思想是将一个复杂的问题拆解成多个小问题,然后将小问题分配给多个处理器(可以是多个计算机或处理器),最后将处理结果汇总并生成最终结果。

这个过程主要包括两个阶段:Map阶段和Reduce阶段。

1.Map阶段:Map阶段的任务是将输入数据集分解为多个小的数据块,并对每个数据块进行处理,生成中间结果。

这个过程通常是一个用户定义的函数,它接受输入数据块并产生一组键-值对。

这些键-值对随后被合并并发送到Reduce阶段。

举个例子,假设我们要对一个大规模的文本文件进行词频统计。

Map阶段会将文本文件分解为单词,并对每个单词生成一个键值对(键为单词,值为该单词在文本中出现的次数)。

2.Reduce阶段:Reduce阶段的任务是将Map阶段产生的中间结果进行汇总,并执行用户定义的Reduce函数,对汇总后的键值对进行处理并生成最终结果。

Reduce函数通常也是用户自定义的函数,它接受一组键值对并产生一个输出结果。

同样以词频统计为例,Reduce阶段会对所有相同的单词进行计数,并将结果输出为一个新的文本文件,其中包含每个单词及其对应的频数。

MapReduce原理的优势在于它能够充分利用多台计算机或处理器的计算资源,实现大规模数据的并行处理。

同时,MapReduce还提供了简单易用的编程接口,使得用户可以轻松地处理大规模数据集。

在实际应用中,MapReduce已被广泛应用于各种领域,如数据挖掘、机器学习、数据库等。

通过MapReduce,我们可以轻松地处理和分析大规模数据集,从而获得更有价值的信息和知识。

需要注意的是,MapReduce原理并不是适用于所有类型的大规模数据处理任务。

对于一些特定的任务,可能需要使用其他类型的并行处理模型和方法。

mapreduce基础概念

MapReduce是一种大数据处理模型,用于并行处理大规模的数据集。

它由Google在2004年提出,并成为Apache Hadoop的核心组件之一。

MapReduce模型的设计目的是为了简化并行计算任务,使得开发人员可以在分布式系统上高效地处理大规模数据。

MapReduce模型的基本概念如下:1. 输入数据集:MapReduce将输入数据集分割成多个小数据块,并且每个数据块可以由一个或多个键值对组成。

2. 映射 Map)函数:映射函数是并行处理输入数据块的核心操作。

它将输入数据块的每个键值对进行处理,并生成一系列中间键值对。

映射函数可以根据需求进行自定义操作,比如提取关键词、计数等。

3. 中间数据集:MapReduce将映射函数生成的中间键值对根据键进行分组,将具有相同键的值组合在一起,形成中间数据集。

4. 归约 Reduce)函数:归约函数对每个中间键值对的值列表进行处理,并生成最终的输出结果。

归约函数通常是进行聚合操作,比如求和、求平均值等。

5. 输出数据集:MapReduce将归约函数处理后的结果保存在输出数据集中。

MapReduce模型的工作过程如下:1. 切分输入数据集:将大规模的输入数据集切分成多个小数据块,并分配给不同的计算节点。

2. 映射:每个计算节点将分配到的数据块使用映射函数进行处理,并生成中间键值对。

3. 分组:根据中间键的值,将相同键的中间值进行分组,以便后续的归约操作。

4. 归约:每个计算节点对分组后的中间值进行归约操作,生成最终的输出结果。

5. 合并输出结果:将所有计算节点的输出结果进行合并,形成最终的输出数据集。

MapReduce模型的优点包括:- 可扩展性:可以处理非常大规模的数据,并利用分布式计算资源进行并行处理,提高处理效率。

- 容错性:MapReduce具备容错机制,当某个计算节点发生故障时,可以重新分配任务到其他节点上。

- 灵活性:开发人员可以根据具体需求自定义映射和归约函数,实现各种数据处理操作。

mapreduce数据处理原理

MapReduce数据处理原理1. 概述MapReduce是一种用于大规模数据处理的编程模型,由Google首先提出并应用于分布式计算中。

它通过将大规模数据集划分为小的子集,并在多个计算节点上同时进行处理,从而实现高效的数据处理。

MapReduce的核心思想是将复杂的数据处理任务分解成简单的、可并行执行的任务。

2. 基本原理MapReduce模型基于两个基本操作:Map和Reduce。

下面将详细介绍这两个操作以及它们在数据处理中的作用。

2.1 Map操作Map操作是将输入数据集中的每个元素进行转换,并生成一个键值对集合作为输出。

具体来说,Map操作接受一个键值对作为输入,经过转换后输出一个新的键值对。

在Map操作中,用户需要自定义一个Map函数,该函数接受输入键值对作为参数,并根据具体需求进行转换操作。

在词频统计任务中,用户可以定义一个Map函数来将输入文本切分成单词,并为每个单词生成一个键值对(单词,1)。

2.2 Reduce操作Reduce操作是将经过Map操作后生成的键值对集合按照键进行分组,并对每个组进行聚合计算。

具体来说,Reduce操作接受一个键和与该键相关联的一组值作为输入,经过聚合计算后输出一个新的键值对。

在Reduce操作中,用户需要自定义一个Reduce函数,该函数接受输入键和与之相关联的值集合作为参数,并根据具体需求进行聚合计算。

在词频统计任务中,用户可以定义一个Reduce函数来对每个单词出现的次数进行累加。

2.3 数据流MapReduce模型通过Map和Reduce操作将数据流划分为三个阶段:输入阶段、中间阶段和输出阶段。

在输入阶段,原始数据集被划分成多个小的数据块,并分配给不同的计算节点进行处理。

每个计算节点上的Map操作并行处理自己分配到的数据块,并生成中间结果。

在中间阶段,所有计算节点上生成的中间结果被按照键进行分组,相同键的结果被发送到同一个Reduce操作所在的计算节点。

mapreduce编程模型的原理

mapreduce编程模型的原理MapReduce编程模型的原理MapReduce是一种分布式计算模型,它可以将大规模数据集分成多个小数据集,然后在多个计算节点上并行处理这些小数据集,最后将结果合并成一个最终结果。

MapReduce编程模型的原理是将数据处理过程分成两个阶段:Map阶段和Reduce阶段。

Map阶段Map阶段是将输入数据集分成若干个小数据集,然后在多个计算节点上并行处理这些小数据集。

在Map阶段中,每个计算节点都会执行相同的Map函数,将输入数据集中的每个元素映射成一个键值对。

Map函数的输入是一个键值对,输出也是一个键值对。

Map 函数的输出会被分成若干个小数据集,然后传输到Reduce节点上。

Reduce阶段Reduce阶段是将Map阶段输出的若干个小数据集合并成一个最终结果。

在Reduce阶段中,每个计算节点都会执行相同的Reduce 函数,将Map阶段输出的若干个小数据集合并成一个最终结果。

Reduce函数的输入是一个键和一个值的列表,输出也是一个键和一个值的列表。

Reduce函数的输出会被合并成一个最终结果。

MapReduce编程模型的优点MapReduce编程模型的优点是可以处理大规模数据集,可以在多个计算节点上并行处理数据,可以容错,可以自动处理节点故障,可以自动处理数据分片和数据传输。

MapReduce编程模型的优点是可以处理大规模数据集,可以在多个计算节点上并行处理数据,可以容错,可以自动处理节点故障,可以自动处理数据分片和数据传输。

MapReduce编程模型的应用MapReduce编程模型的应用包括数据挖掘、机器学习、搜索引擎、图像处理、自然语言处理等领域。

MapReduce编程模型的应用可以处理大规模数据集,可以在多个计算节点上并行处理数据,可以容错,可以自动处理节点故障,可以自动处理数据分片和数据传输。

MapReduce编程模型的实现MapReduce编程模型的实现包括Hadoop、Spark、Flink等分布式计算框架。

mapreduce编程单词计数重点与难点

MapReduce编程单词计数重点与难点随着大数据技术的快速发展,MapReduce编程模型成为了处理大规模数据的重要工具之一。

在MapReduce编程中,单词计数是一个常见的任务,用来统计大规模文本数据中各个单词出现的次数。

本文将重点探讨MapReduce编程单词计数的重点与难点。

一、MapReduce编程概述1.1 MapReduce编程模型MapReduce是谷歌公司提出的一种用于大规模数据处理的编程模型。

它将数据处理过程分为两个阶段:Map阶段和Reduce阶段。

Map阶段负责将输入数据分割成若干个子问题,并由各个Map任务进行处理;Reduce阶段负责将Map任务的输出结果进行合并和整理,得到最终的输出结果。

1.2 MapReduce编程框架在实际的MapReduce编程中,通常会使用一些开源的MapReduce编程框架,如Hadoop、Spark等。

这些框架提供了一些API和工具,帮助开发者更加方便地实现MapReduce程序,并运行在分布式系统上。

二、单词计数的重点2.1 数据预处理在进行单词计数之前,需要对输入的文本数据进行预处理,包括分词、过滤停用词等操作。

这一步骤的准确性和效率将直接影响到最终的计数结果。

2.2 Map阶段在Map阶段,需要将文本数据转化为键值对的形式,其中键表示单词,值表示单词出现的次数。

在此阶段,需要考虑如何实现高效的分词和计数逻辑,处理不同格式的文本数据,以及处理文本中的特殊字符等问题。

2.3 Reduce阶段在Reduce阶段,需要将Map任务的输出结果进行整合,计算出各个单词的总出现次数。

在此阶段,需要考虑如何合并不同Map任务的输出结果,解决数据倾斜和大量小文件等问题,以及实现高效的Reduce 逻辑。

2.4 结果输出需要将最终的计数结果输出到指定的数据存储中,如HDFS、数据库等。

在此过程中,需要考虑如何实现数据的持久化和容错,以及结果的格式化和展示等问题。

MapReduce工作原理图文详解

MapReduce⼯作原理图⽂详解前⾔:MapReduce是⼀种编程模型,⽤于⼤规模数据集(⼤于1TB)的并⾏运算。

概念"Map(映射)"和"Reduce(归约)",和它们的主要思想,都是从函数式编程语⾔⾥借来的,还有从⽮量编程语⾔⾥借来的特性。

它极⼤地⽅便了编程⼈员在不会分布式并⾏编程的情况下,将⾃⼰的程序运⾏在上。

当前的软件实现是指定⼀个Map(映射)函数,⽤来把⼀组键值对映射成⼀组新的键值对,指定并发的Reduce(归约)函数,⽤来保证所有映射的键值对中的每⼀个共享相同的键组。

呵呵,下⾯我们进⼊正题,这篇⽂章主要分析以下两点内容:⽬录:1.MapReduce作业运⾏流程2.Map、Reduce任务中Shuffle和排序的过程正⽂:1.MapReduce作业运⾏流程下⾯贴出我⽤visio2010画出的流程⽰意图:流程分析:1.在客户端启动⼀个作业。

2.向JobTracker请求⼀个Job ID。

3.将运⾏作业所需要的资源⽂件复制到HDFS上,包括MapReduce程序打包的JAR⽂件、配置⽂件和客户端计算所得的输⼊划分信息。

这些⽂件都存放在JobTracker专门为该作业创建的⽂件夹中。

⽂件夹名为该作业的Job ID。

JAR⽂件默认会有10个副本(mapred.submit.replication属性控制);输⼊划分信息告诉了JobTracker应该为这个作业启动多少个map任务等信息。

4.JobTracker接收到作业后,将其放在⼀个作业队列⾥,等待作业调度器对其进⾏调度(这⾥是不是很像微机中的进程调度呢,呵呵),当作业调度器根据⾃⼰的调度算法调度到该作业时,会根据输⼊划分信息为每个划分创建⼀个map任务,并将map任务分配给TaskTracker执⾏。

对于map和reduce任务,TaskTracker根据主机核的数量和内存的⼤⼩有固定数量的map 槽和reduce槽。

mapreduce的工作原理

mapreduce的工作原理

MapReduce是一种用于处理大规模数据集的编程模型和算法。

它的工作原理基于分而治之的思想,将数据分割成多个小块,并在不同的计算节点上进行并行处理,然后将中间结果进行合并,最终得到最终的结果。

MapReduce的过程可以分为两个阶段:Map阶段和Reduce阶段。

在Map阶段,输入的大数据集被拆分为多个小数据块,并由

不同的计算节点进行并行处理。

每个计算节点都会执行用户定义的Map函数,该函数将每个输入数据块转化为一系列(键,值)对的中间结果。

这个过程中,Map函数是独立执行的,

从而实现了并行处理。

在Reduce阶段,所有的中间结果会被按照键进行排序,并进

行分组。

然后,每个计算节点都会执行用户定义的Reduce函数,该函数将每个组的值进行聚合并生成最终结果。

在Reduce阶段,数据的处理是有序的,以确保数据的正确性和

一致性。

MapReduce的工作原理主要基于数据的分割、并行处理和结

果的合并。

通过将大规模数据集划分为小块并在多个计算节点上同时处理,可以大幅提高数据处理的效率和速度。

同时,通过中间结果的合并,可以得到最终的结果。

这种分布式计算模型在处理大规模数据时具有优势,并被广泛应用于各种领域,如搜索引擎、数据分析和机器学习等。

MapReduce技术原理深入理解

➢ MapReduce方法则是:

➢ 1.给在座的所有玩家中分配这摞牌 ➢ 2.让每个玩家数自己手中的牌有几张是黑桃,然后把这个数目汇报给你 ➢ 3.你把所有玩家告诉你的数字加起来,得到最后的结论

MapReduce概述

➢ MapReduce是一种分布式计算模型,由Google提出,主要用于 搜索领域,解决海量数据的计算问题.

➢ MapReduce是分布式运行的,由两个阶段组成:Map和Reduce, Map阶段是一个独立的程序,有很多个节点同时运行,每个节点 处理一部分数据。Reduce阶段是一个独立的程序,有很多个节 点同时运行,每个节点处理一部分数据【在这先把reduce理解为 一个单独的聚合程序即可】。

➢ 2.4 框架把reduce的输出保存到HDFS中。 ➢ 至此,整个reduce阶段结束。 ➢ 例子:实现WordCountApp

shuffle过程

• 1.每个map有一个环形内存缓冲区,用于存储map的输出。默认大小100MB (io.sort.mb属性),一旦达到阀值0.8(io.sort.spill.percent),一个后台线 程把内容溢写到(spill)磁盘的指定目录(mapred.local.dir)下的一个新建文 件中。

MapReduce默认输入处理类

➢ InputFormat

➢ 抽象类,只是定义了两个方法。

➢ FileInputFormat

➢ FileInputFormat是所有以文件作为数据源的InputFormat实现的基类, FileInputFormat保存作为job输入的所有文件,并实现了对输入文件计 算splits的方法。至于获得记录的方法是有不同的子类—— TextInputFormat进行实现的。

好程序员大数据笔记-hadoop之MapReduce运行机制

【原创技术贴】hadoop之MapReduce运行机制首先客户端编写mapreduce程序,配置mapreduce的作业也就是job,接下来进行job提交,将job提交到JobTracker上,此时JobTracker就会对这个job进行构建,具体来说,就是分配一个新的job任务的ID值,接下来就是检查操作。

这个检查就是确定输出目录是否存在,如果存在,那么job就不能正常运行下去,JobTracker会抛出错误给客户端,并且还会检查输入目录是否存在,如果不存在同样抛出错误,存在JobTracker会根据输入,计算输入分片(Input Split),如果分片计算不出来也会抛出错误,这些都处理完成,JobTracker就会配置Job需要的资源。

分配资源完成后,JobTracker就会初始化作业,初始化主要做的是将Job放入一个内部的队列,让配置好的作业调度器能调度到这个作业中,作业调度器会初始化这个job,也就是创建一个正在运行的job对象(封装任务和记录信息),以便JobTracker跟踪job的状态和进程。

初始化完毕后,作业调度器会获取输入分片信息(input split),每个分片创建一个map任务。

接下来就是任务分配,此时tasktracker会运行一个简单的循环机制定期发送心跳给jobtracker,心跳间隔是5秒,程序员可以配置这个时间,心跳就是jobtracker和tasktracker沟通的桥梁,通过心跳,jobtracker可以监控tasktracker是否存活,也可以获取tasktracker处理的状态和问题,同时tasktracker也可以通过心跳里的返回值获取jobtracker给它的操作指令。

任务分配好后就是执行任务了。

在任务执行时候jobtracker 可以通过心跳机制监控tasktracker的状态和进度,同时也能计算出整个job的状态和进度,而tasktracker也可以本地监控自己的状态和进度。

简述mapreduce数据处理流程

MapReduce数据处理流程1. 介绍MapReduce是一种用于处理大规模数据集的并行计算模型,由Google在2004年提出,并在后来的几年中被广泛应用于大数据处理领域。

它通过将大任务划分成多个小任务,然后进行并行处理,最后将结果合并起来,以实现高效的数据处理。

2. MapReduce的基本原理MapReduce的处理流程可以分为两个阶段:Map阶段和Reduce阶段。

2.1 Map阶段在Map阶段中,输入数据被划分成多个独立的数据块,并由多个Map任务并行处理。

每个Map任务将输入数据块作为输入,执行特定的计算操作,并输出一系列键值对。

这些键值对被称为中间结果。

Map阶段的处理流程如下: 1. 输入数据被划分成多个数据块。

2. 每个Map任务读取一个数据块,并对其进行处理。

3. Map任务执行特定的计算操作,将输入数据转换为一系列键值对。

4. Map任务将中间结果输出。

2.2 Reduce阶段在Reduce阶段中,中间结果被合并和处理,以生成最终的结果。

Reduce任务将中间结果按照键进行分组,并对每个键对应的值进行聚合操作,最终输出最终结果。

Reduce阶段的处理流程如下: 1. 中间结果被合并和排序,按照键进行分组。

2. 每个Reduce任务处理一个键对应的值的集合。

3. Reduce任务执行特定的聚合操作,将值集合转换为最终结果。

4. Reduce任务将最终结果输出。

3. MapReduce的工作流程3.1 数据划分和输入在MapReduce的工作流程中,首先需要将输入数据划分成多个数据块,并将这些数据块分配给不同的Map任务进行处理。

数据划分的目的是将大规模数据集分解成小块,以便并行处理。

3.2 Map阶段在Map阶段中,每个Map任务读取一个数据块,并对其进行处理。

具体的处理操作由用户自定义的Map函数决定。

Map函数将输入数据转换为一系列键值对,并将其输出作为中间结果。

mapreduce编程实验报告心得

mapreduce编程实验报告心得一、实验背景MapReduce是一种分布式计算框架,主要用于大规模数据处理。

它可以将一个大型数据集分成许多小的数据块,并在多台计算机上并行处理这些数据块。

MapReduce框架由Google公司提出,被广泛应用于搜索引擎、社交网络等领域。

二、实验目的本次实验的目的是掌握MapReduce编程模型及其应用。

通过实现一个简单的WordCount程序,学习MapReduce编程的基本流程和技巧。

三、实验环境本次实验使用Hadoop作为分布式计算框架,Java作为编程语言。

四、实验步骤1. 编写Mapper类Mapper类负责将输入文件中的每一行文本转换成(key,value)对,并输出给Reducer进行处理。

在WordCount程序中,我们需要将每个单词作为key,出现次数作为value输出。

下面是Mapper类代码:```javapublic class WordCountMapper extends Mapper<LongWritable, Text, Text, IntWritable> {private final static IntWritable one = new IntWritable(1);private Text word = new Text();public void map(LongWritable key, Text value, Context context) throws IOException, InterruptedException {String line = value.toString();StringTokenizer tokenizer = new StringTokenizer(line);while (tokenizer.hasMoreTokens()) {word.set(tokenizer.nextToken());context.write(word, one);}}}2. 编写Reducer类Reducer类负责将Mapper输出的(key,value)对进行归并,统计每个单词出现的次数。

mapreduce工作原理

mapreduce工作原理

MapReduce是一种分布式计算模型,用于处理大规模的数据集。

它的工作原理可以简单概括为两个过程:Map过程和Reduce过程。

在Map过程中,输入数据集被分割成多个小块,并由多个

Map任务并行处理。

每个Map任务都会对输入数据集中的每

个元素执行相同的操作,并生成中间键值对。

这些中间键值对会被存储在内存中的缓冲区内。

接下来是Shuffle过程,该过程负责将Map任务生成的中间键

值对按照键的值进行排序和分区,并将同一个键的中间键值对传递给同一个Reduce任务进行处理。

Shuffle过程可以确保相

同键的中间键值对被发送到同一个Reduce任务。

在Reduce过程中,每个Reduce任务并行处理一组中间键值对。

Reduce任务会将它们从存储在内存中的缓冲区中取出,并按

照键的值进行合并和计算。

最终的计算结果会被写入一个输出文件中。

整个MapReduce过程中,数据的读取、处理和写入都是在分

布式计算集群中进行的,可以充分利用集群中的多台计算机资源来加速处理过程。

MapReduce模型的并行处理能力和可靠

性使得它成为处理大规模数据集的一种理想选择。

mapreduce数据处理原理

MapReduce数据处理原理一、概述在大数据时代,数据处理变得越来越重要。

MapReduce是一种经典的数据处理模型,它以其高效、可扩展和容错等特点被广泛应用于分布式数据处理。

本文将详细介绍MapReduce的原理,包括其基本概念、流程、组成部分以及实现方式等。

二、MapReduce基本概念MapReduce是一种将大规模数据集并行处理的编程模型。

它由两个阶段组成,即Map阶段和Reduce阶段。

在Map阶段中,原始数据被切分成若干个小数据块,然后通过Map函数进行处理;在Reduce阶段中,Map阶段的输出被分类整理并传递给Reduce函数进行进一步处理。

下面我们将详细介绍MapReduce的基本概念。

2.1 Map函数Map函数是MapReduce的核心部分之一。

它接收一个输入键值对,将其转换为若干个中间键值对。

通常情况下,Map函数的输入是一行文本,输出是零个或多个中间结果。

2.2 Reduce函数Reduce函数是MapReduce的另一个核心部分。

它接收同一个键的多个值,并将它们聚合为一个或多个结果。

Reduce函数的输入是一个键和与该键相关的一个或多个值,输出是最终的结果。

2.3 MapReduce过程MapReduce过程由Map阶段和Reduce阶段组成。

首先,在Map阶段中,原始数据被切分成若干个小数据块,每个小数据块由一个Map任务处理。

然后,Map任务对每个小数据块分别执行Map函数,生成中间键值对。

接着,在Reduce阶段中,中间结果被分类整理,并根据键进行排序。

每个键及其相关的值被传递给一个或多个Reduce任务,Reduce任务通过Reduce函数将多个值聚合为一个或多个结果。

三、MapReduce过程详解3.1 数据划分在MapReduce过程中,原始数据被划分成若干个小数据块,每个小数据块由一个Map任务处理。

数据划分的目的是将原始数据分解成多个小块,使得每个Map任务可以并行处理自己的数据。

MapReduce进阶理论笔记1

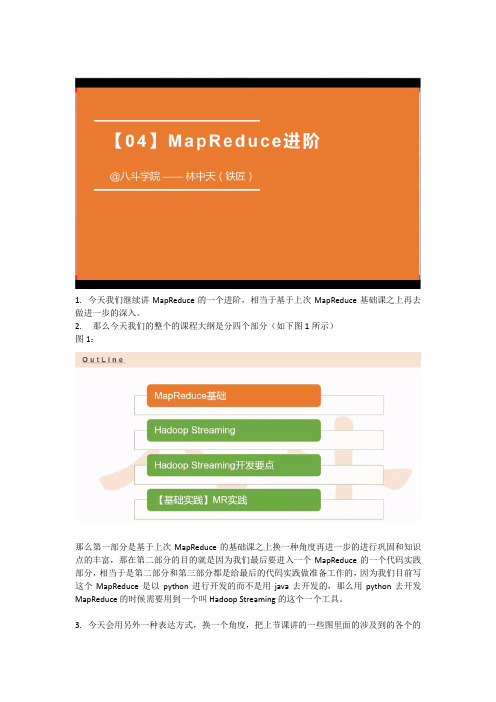

1.今天我们继续讲MapReduce的一个进阶,相当于基于上次MapReduce基础课之上再去做进一步的深入。

2.那么今天我们的整个的课程大纲是分四个部分(如下图1所示)图1:那么第一部分是基于上次MapReduce的基础课之上换一种角度再进一步的进行巩固和知识点的丰富,那在第二部分的目的就是因为我们最后要进入一个MapReduce的一个代码实践部分,相当于是第二部分和第三部分都是给最后的代码实践做准备工作的,因为我们目前写这个MapReduce是以python进行开发的而不是用java去开发的,那么用python去开发MapReduce的时候需要用到一个叫Hadoop Streaming的这个一个工具。

3.今天会用另外一种表达方式,换一个角度,把上节课讲的一些图里面的涉及到的各个的一个细节和环节再做一些细致的拆解,这样的话有助于加深印象(如下图2所示)图2:在这个图2里面看上去很复杂,但是拆解完了以后从头到尾学完之后就贼清晰了。

在这个图里面有6个Map和两个Reduce加起来就有8个独立的进程空间,当这个MapReduce 跑起来的时候,是需要占用8个进程的空间,那这些进程中有可能在同一个节点上或者同一个机器上运行的也有可能都不在同一个节点上不同机器上运行的,说到进程这个事情,为何MapReduce采用的是多进程并发方式而不是多线程的并发方式呢?首先这个多进程并发的模型便于每一个任务去占用资源去进行控制,因为这个进程空间是独享的。

那么进程有什么样子的优势?可以方便的对于每一个任务进行控制和调配这是进程的优点,那么缺点就是进程相对比线程来说它会消耗更多的启动时间,也就是说进程的启动要比线程启动要慢很多,所以MapReduce只适合做一些批量操作,适合高吞吐的情况下不能寄托它太多的实效性。

如图二里面左边和右边可以认为是两个机器两个节点,相当于这两个不同的机器同时并发执行。

那么MapReduce的数据源是来自HDFS上面的,数据源都是以File的方式表示,那这里面就涉及到了HDFS的一些概念,当你提交一个大文件,这个文件会被切分成多个小的文件,那么HDFS是一个文件系统,文件系统里面它就有一个数据单位,这个数据单位就是Block,默认是64M内存,并且在没有配置的情况这个Block会给你做三个备份,这个三个备份存在了不同的机器上,就避免了某一台机器挂掉了之后数据丢失的问题。

hadoop mapreduce原理及操作

hadoop mapreduce原理及操作Hadoop MapReduce是一种分布式计算框架,主要用于处理大规模数据集。

其原理是将数据分成多个小数据块,并在分布式计算集群上的多个节点上并行处理这些数据块。

MapReduce程序主要由两个阶段组成:Map阶段和Reduce阶段。

1. Map阶段:在Map阶段,输入数据被分成多个小数据块,然后在每个数据块上执行Map函数。

Map函数接收键值对(key/value)作为输入,并根据指定的映射规则生成新的键值对。

Map函数的输出会按照特定的规则进行分组和排序,然后传输给Reduce任务。

2. Reduce阶段:在Reduce阶段,Map阶段生成的键值对会被传输到Reduce任务进行处理。

Reduce函数接收一组键值对,并根据指定的聚合规则计算出最终的结果。

Reduce任务的主要目的是将Map阶段生成的中间数据整合成最终的结果。

Hadoop MapReduce的操作主要包括以下几个步骤:1. 编写MapReduce程序:根据需求编写Map和Reduce函数,并配置相关参数。

2. 数据输入:将待处理的数据加载到Hadoop分布式文件系统(HDFS)中,以便在MapReduce任务中使用。

3. 启动MapReduce任务:通过提交MapReduce作业(Job)到Hadoop 集群来启动计算任务。

Hadoop框架会自动分配计算资源、调度任务并监控进度。

4. 执行Map阶段:Map阶段在Hadoop集群的各个节点上并行执行,对输入数据进行处理并生成中间结果。

5. 执行Reduce阶段:Reduce阶段在Hadoop集群的主节点上执行,对Map阶段生成的中间结果进行整合和处理,得出最终结果。

6. 输出结果:将最终结果存储到HDFS中,以便后续的分析和处理。

7. 监控和调试:通过Hadoop提供的监控工具(如JMX)来查看任务进度、资源使用情况等,以便对MapReduce程序进行优化和调试。

mapreduce编程模型及三个步骤

mapreduce编程模型及三个步骤MapReduce编程模型是一种用于处理大规模数据集的分布式计算模型,它由Google公司提出并应用于其搜索引擎等大数据处理场景中。

该模型将计算任务划分为Map和Reduce两个阶段,并通过横向扩展多个计算节点来实现高效的并行计算。

一、MapReduce编程模型的基本思想MapReduce编程模型的基本思想是将大规模数据集拆分成多个小块,分发到不同的计算节点上进行并行处理,最终将结果合并输出。

其中,每个计算节点都具备独立的计算能力和存储空间,可以在不影响其他节点的情况下进行本地计算和存储。

具体来说,MapReduce编程模型包含三个核心组件:输入数据集、Map函数和Reduce函数。

输入数据集是指需要处理的原始数据集合,可以是文本、图像、音频等各种形式的数据。

Map函数则负责对输入数据集中每个元素进行映射操作,并输出一个键值对(key-value pair)。

最后,Reduce函数则根据Map函数输出的键值对对结果进行聚合操作,并输出最终结果。

二、MapReduce编程模型的三个步骤1. Map阶段在Map阶段中,输入数据集被切分成多个小块,并分发到不同的计算节点上。

每个计算节点都会执行相同的Map函数,对输入数据集中的每个元素进行映射操作,并输出一个键值对。

其中,键值对中的键表示元素的标识符,值则表示元素经过映射后得到的结果。

Map函数通常由用户自行定义,其输入参数包括输入数据元素和对应的标识符。

用户需要根据具体的业务需求编写相应的Map函数,并保证其具备高效、可扩展、容错等特性。

2. Shuffle阶段在Map阶段完成后,所有计算节点会将自己所产生的键值对按照键进行排序,并将相同键的值聚合在一起。

这个过程被称为Shuffle(洗牌)操作。

Shuffle操作是MapReduce编程模型中非常重要的一个步骤,它决定了Reduce阶段所需要处理的数据量和负载均衡情况。

mapreduce的工作原理

mapreduce的工作原理

MapReduce 是一种在大型数据集上分布式运行计算的编程模型和算法。

其工作原理主要分为两个步骤:Map 和Reduce。

1. Map 阶段:

Map 阶段是指将输入数据分成若干个小数据块,然后对每个数据块分别应用一个Map 函数,将数据块转换成一个键值对列表。

这个键值对列表中的键是某种描述符,值是包含着这个描述符的数据。

这个Map 函数可以并行运行,也就是可以在不同计算节点上同时运行。

2. Reduce 阶段:

Reduce 阶段是指将Map 阶段产生的若干键值对列表按照键进行排序,并将相同键的值进行聚合。

Reduce 函数通常与Map 函数位于不同的计算节点上,并且对每个不同的键值对列表,Reduce 函数只会在一个节点上执行。

Reduce 函数对键值对进行聚合,并生成一个输出键值对列表,其中输出键的数量通常比输入键的数量少。

整个MapReduce 过程的主要思想是将整个数据集的处理过程拆分成多个小的子过程,并在分布式计算节点中进行并行处理,最后将所有子过程的结果合并

成最终的输出结果。

这样就可以有效地处理大量数据,缩短计算时间和提高计算效率。

大数据培训难?Hadoop MapReduce原理讲解

大数据培训难?Hadoop MapReduce原理讲解MapReduce是一种编程模型,用于大规模数据集的分布式运算。

1、MapReduce通俗解释图书馆要清点图书数量,有10个书架,管理员为了加快统计速度,找来了10个同学,每个同学负责统计一个书架的图书数量。

张同学统计书架1王同学统计书架2刘同学统计书架3……过了一会儿,10个同学陆续到管理员这汇报自己的统计数字,管理员把各个数字加起来,就得到了图书总数。

这个过程就可以理解为MapReduce的工作过程。

2、MapReduce中有两个核心操作(1)map管理员分配哪个同学统计哪个书架,每个同学都进行相同的“统计”操作,这个过程就是map。

(2)reduce每个同学的结果进行汇总,这个过程是reduce。

3、MapReduce工作过程拆解下面通过一个景点案例(单词统计)看MapReduce是如何工作的。

有一个文本文件,被分成了4份,分别放到了4台服务器中存储Text1:the weather is goodText2:today is goodText3:good weather is goodText4:today has good weather现在要统计出每个单词的出现次数。

4、MapReduce编程思路了解了MapReduce的工作过程,我们思考一下用代码实现时需要做哪些工作?在4个服务器中启动4个map任务每个map任务读取目标文件,每读一行就拆分一下单词,并记下来次单词出现了一次目标文件的每一行都处理完成后,需要把单词进行排序在3个服务器上启动reduce任务每个reduce获取一部分map的处理结果reduce任务进行汇总统计,输出最终的结果数据但不用担心,MapReduce是一个非常优秀的编程模型,已经把绝大多数的工作做完了,我们只需要关心2个部分:map处理逻辑——对传进来的一行数据如何处理?输出什么信息?reduce处理逻辑——对传进来的map处理结果如何处理?输出什么信息?编写好这两个核心业务逻辑之后,只需要几行简单的代码把map和reduce装配成一个job,然后提交给Hadoop集群就可以了。

加行第三十八课思考题+串讲

加行第三十八课思考题+串讲(实用版)目录1.概述第三十八课的内容2.第三十八课的思考题3.串讲第三十八课的主要知识点正文【概述第三十八课的内容】第三十八课是我们课程中的一个重要环节,主要涉及的知识点包括数据的处理和分析。

在这节课中,我们学习了如何使用 Python 进行数据处理和分析,掌握了一些基本的数据处理方法和技巧。

此外,我们还学习了如何使用 Python 进行可视化分析,以便更好地理解数据。

【第三十八课的思考题】1.如何使用 Python 进行数据清洗?2.如何使用 Python 进行数据可视化分析?3.如何使用 Python 进行数据统计分析?【串讲第三十八课的主要知识点】1.数据清洗数据清洗是数据处理中的一个重要环节,主要是对数据进行预处理,以便后续的分析和处理。

在 Python 中,我们可以使用 Pandas 库进行数据清洗。

Pandas 库提供了许多数据处理功能,如数据筛选、数据排序、数据合并等。

通过这些功能,我们可以有效地对数据进行清洗,提高数据质量。

2.数据可视化分析数据可视化分析是数据分析中的一个重要环节,主要是通过可视化的方式来呈现数据,以便更好地理解数据。

在 Python 中,我们可以使用Matplotlib 库进行数据可视化分析。

Matplotlib 库提供了许多数据可视化功能,如绘制折线图、柱状图、饼图等。

通过这些功能,我们可以方便地对数据进行可视化分析,提高数据分析效率。

3.数据统计分析数据统计分析是数据处理中的一个重要环节,主要是对数据进行统计分析,以便更好地理解数据。

在 Python 中,我们可以使用 NumPy 库进行数据统计分析。

NumPy 库提供了许多数据统计功能,如求和、求平均值、求方差等。

通过这些功能,我们可以方便地对数据进行统计分析,提高数据分析效率。

总结:第三十八课是我们课程中的一个重要环节,主要涉及的知识点包括数据的处理和分析。

在这节课中,我们学习了如何使用 Python 进行数据处理和分析,掌握了一些基本的数据处理方法和技巧。

实验MapReduce编程初级实践

实验3 MapReduce编程初级实践1.实验目的1.通过实验掌握基本的MapReduce编程方法;2.掌握用MapReduce解决一些常见的数据处理问题,包括数据去重、数据排序和数据挖掘等。

2.实验平台已经配置完成的Hadoop伪分布式环境。

3.实验内容和要求1.编程实现文件合并和去重操作对于两个输入文件,即文件A和文件B,请编写MapReduce程序,对两个文件进行合并,并剔除其中重复的内容,得到一个新的输出文件C。

下面是输入文件和输出文件的一个样例供参考。

实验最终结果(合并的文件):代码如下:package ;import class Merge {public static class Map extends Mapper<Object, Text, Text, Text> {private static Text text = new Text();public void map(Object key, Text value, Context context)throws IOException, InterruptedException {text = value;(text, new Text(""));}}public static class Reduce extends Reducer<Text, Text, Text, Text> {public void reduce(Text key, Iterable<Text> values, Context context) throws IOException, InterruptedException {(key, new Text(""));}}public static void main(String[] args) throws Exception {Configuration conf = new Configuration();("", "");String[] otherArgs = new String[] { "input", "output" };if != 2) {"Usage: Merge and duplicate removal <in> <out>");(2);}Job job = (conf, "Merge and duplicate removal");;;;;;(job, new Path(otherArgs[0]));(job, new Path(otherArgs[1]));(true) 0 : 1);}}2. 编写程序实现对输入文件的排序现在有多个输入文件,每个文件中的每行内容均为一个整数。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

一:基于Yarn的MapReduce架构

1,MapReduce程序是基于Mapper和Reducer两大阶段构成的,其中Mapper是把一个计算任务分成很多小任务进行并行计算,Reducer是做最后的统计工作的;

2,Hadoop 2.x开始MapReduce的运行是基于Yarn进行的:

3,当ResourceManager接收到Client提交程序的请求的时候会根据集群资源的状况在某个NodeManage所在的节点上命令NodeManager来启动改程序的第一个Container,该Container就是程序的ApplicationMaster,负责程序的任务调度的执行过程,ApplicationMaster转过来向ResourceManager注册自己,注册之后会向ResourceManager申请具体的Container计算资源。

4,如何知道一个程序中的ApplicationMaster需要多少个Container呢?

ApplicationMaster在启动的时候会运行程序的main方法,该方法中会有数据的输入和相关的配置,通过这些内容就可以知道需要多少Container;

5,MapReduce运行在Yarn上的总结:

6,Hadoop MapReduce中的MRAppMaster相当于Spark中的Driver,Hadoop MapReduce 中的YarnChild相当于Spark中的CoarseGrainedExecutorBackend;。