Connected Rotation-invariant Size-Shape Granulometries

特征点匹配 旋转平移变换矩阵

特征点匹配旋转平移变换矩阵全文共四篇示例,供读者参考第一篇示例:特征点匹配是计算机视觉中的一个重要领域,它通过检测图像中的关键点,然后在不同图像之间进行匹配,从而实现物体识别、图像配准等任务。

而在进行特征点匹配时,通常需要对图像进行旋转、平移等变换,这就需要使用旋转平移变换矩阵来实现。

在进行特征点匹配时,最常用的算法之一是基于SIFT算法的特征点匹配。

SIFT算法是一种用来检测和描述图像中的局部特征的算法,它能够在不同尺度和旋转角度下检测出图像的关键点,并生成对应的特征向量。

通过比对两幅图像中的特征向量,就可以实现特征点的匹配。

在进行特征点匹配时,通常需要考虑到图像之间可能存在的旋转、平移等变换。

对于旋转变换,我们可以通过计算两幅图像之间的旋转角度,并利用旋转矩阵来进行坐标变换,从而实现特征点的匹配。

而对于平移变换,则可以通过计算两幅图像之间的平移向量,并利用平移矩阵来进行坐标变换。

旋转平移变换矩阵的一般形式为:\[\begin{pmatrix}x' \\y' \\1\end{pmatrix}=\begin{pmatrix}cos\theta & -sin\theta & t_x \\ sin\theta & cos\theta & t_y \\ 0 & 0 & 1\end{pmatrix}\begin{pmatrix}x \\y \\1\end{pmatrix}\]\( \theta \)为旋转角度,\( t_x \)、\( t_y \)为平移向量,\( x \)、\( y \)为特征点的坐标。

通过将特征点的坐标与旋转平移变换矩阵相乘,就可以得到经过变换后的特征点的新坐标。

特征点匹配与旋转平移变换矩阵在计算机视觉领域中具有重要的应用价值。

通过对图像中的特征点进行匹配,并利用旋转平移变换矩阵实现图像的变换,可以实现物体识别、视觉导航、图像配准等多种应用。

【国家自然科学基金】_迭代学习_基金支持热词逐年推荐_【万方软件创新助手】_20140731

107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143 144 145 146 147 148 149 150 151 152 153 154 155 156 157 158 159 160

53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106

科研热词 迭代学习控制 非线性系统 支持向量机 半监督学习 贝叶斯网络 权值直接确定 隶属度 迭代 自适应迭代学习控制 聚类 线性时变系统 策略迭代 神经网络 核函数 无监督学习 故障诊断 多例学习 增量学习 参数学习 分类权 人工神经网络 rbf神经网络 lyapunov-like函数 em算法 backstepping adaboost 鲁棒性 高斯函数 高分辨距离像(hrrp) 马尔科夫毯预测 马尔可夫链蒙特卡罗框架 风险指数 预测模型 预测控制 项目多类属 非齐次的 非负矩阵分解 非脆弱控制 非线性特征 非线性参数化系统 非线性参数化不确定 非监督学习 非完整系统 雷达自动目标识别(ratr) 集成学习 随机半监督采样 阈值 遥感影像 遗传算法 逼近性能 递推学习观测器 递归最小二乘

科研热词 迭代学习控制 非线性系统 流形学习 正交多项式 非参数自适应控制 非参数动态线性化 非一致目标跟踪 随机初始条件 间歇过程 部分最小二乘 遗传算法 迭代学习 自适应迭代学习控制 终端控制 离散系统 离散t-s模糊系统 神经网络 盲均衡 模型参考自适应 复合能量函数 参数辨识 半监督学习 入口匝道调节 人脸识别 主元回归 bp神经网络 鲁棒性 高阶学习控制律 高分辨距离像 饱和 预载 雷达自动目标识别 集成isgnn 隐密分析 随机逼近 随机离散系统 随机时廷 降维 量测噪声 重复性 迭代竞价 迭代最近点算法 迭代学习辨识 迭代学习算法 迭代保局投影算法 进化bp神经网络 边际费希尔分析(mfa) 轨迹跟踪 贝叶斯公式 误差分级迭代 识别与评价 设计结构矩阵

生成亚像素光条提取并生成点集进行双目三维重建和圆柱拟合求半径的程序-概述说明以及解释

生成亚像素光条提取并生成点集进行双目三维重建和圆柱拟合求半径的程序-概述说明以及解释1.引言概述部分是文章的引言,用于向读者介绍本文的研究背景、目的和重要性。

首先,我们需要简要概括本文要解决的问题和研究内容。

然后,可以介绍相关领域的现状和该问题存在的挑战。

最后,强调本文的研究目的和创新点。

以下是1.1 概述部分的内容参考:"亚像素光条提取、双目三维重建以及圆柱拟合求半径是计算机视觉领域中的研究热点。

本文旨在研究一种新的方法,通过生成亚像素光条提取并生成点集,实现双目三维重建和圆柱拟合求半径的程序。

这一方法具有广泛的应用前景,可在工业制造、机器人导航、虚拟现实等领域中发挥重要作用。

在过去的几十年里,图像处理和计算机视觉技术取得了巨大的进展,但在亚像素光条提取、双目三维重建和圆柱拟合求半径方面仍然存在一些挑战。

传统的方法通常受限于像素级别的精度,难以捕捉到细节信息,而新的亚像素光条提取技术通过子像素级别的精确度,提供更精确的图像信息。

本文的主要目的是通过结合亚像素光条提取、双目三维重建和圆柱拟合求半径的程序,实现对三维场景的精确重建和圆柱体参数的准确测量。

同时,我们将实验验证所提出方法的有效性,并对实验结果进行评估和分析。

本文的创新点在于采用了一种全新的生成亚像素光条提取并生成点集的方法,能够提高重建和测量的准确性和稳定性。

我们认为,本研究的成果将为相关领域的研究和应用提供有益的参考,并为未来的研究工作提供新的思路和方向。

"在编写文章的其他部分时,请注意按照大纲的结构逐步展开,提供详细的介绍、分析和实验验证。

同时,也可根据具体情况自行调整和完善文章的内容。

1.2文章结构文章结构部分的内容如下:文章结构部分旨在介绍本文的整体结构和各个章节的内容安排。

本文分为引言、正文和结论三个部分。

在引言部分,首先对整篇文章进行概述,简要介绍文章研究的背景和意义。

接着对文章的结构进行概括性描述,说明各章节的内容安排和逻辑顺序。

纹理物体缺陷的视觉检测算法研究--优秀毕业论文

摘 要

在竞争激烈的工业自动化生产过程中,机器视觉对产品质量的把关起着举足 轻重的作用,机器视觉在缺陷检测技术方面的应用也逐渐普遍起来。与常规的检 测技术相比,自动化的视觉检测系统更加经济、快捷、高效与 安全。纹理物体在 工业生产中广泛存在,像用于半导体装配和封装底板和发光二极管,现代 化电子 系统中的印制电路板,以及纺织行业中的布匹和织物等都可认为是含有纹理特征 的物体。本论文主要致力于纹理物体的缺陷检测技术研究,为纹理物体的自动化 检测提供高效而可靠的检测算法。 纹理是描述图像内容的重要特征,纹理分析也已经被成功的应用与纹理分割 和纹理分类当中。本研究提出了一种基于纹理分析技术和参考比较方式的缺陷检 测算法。这种算法能容忍物体变形引起的图像配准误差,对纹理的影响也具有鲁 棒性。本算法旨在为检测出的缺陷区域提供丰富而重要的物理意义,如缺陷区域 的大小、形状、亮度对比度及空间分布等。同时,在参考图像可行的情况下,本 算法可用于同质纹理物体和非同质纹理物体的检测,对非纹理物体 的检测也可取 得不错的效果。 在整个检测过程中,我们采用了可调控金字塔的纹理分析和重构技术。与传 统的小波纹理分析技术不同,我们在小波域中加入处理物体变形和纹理影响的容 忍度控制算法,来实现容忍物体变形和对纹理影响鲁棒的目的。最后可调控金字 塔的重构保证了缺陷区域物理意义恢复的准确性。实验阶段,我们检测了一系列 具有实际应用价值的图像。实验结果表明 本文提出的纹理物体缺陷检测算法具有 高效性和易于实现性。 关键字: 缺陷检测;纹理;物体变形;可调控金字塔;重构

Keywords: defect detection, texture, object distortion, steerable pyramid, reconstruction

II

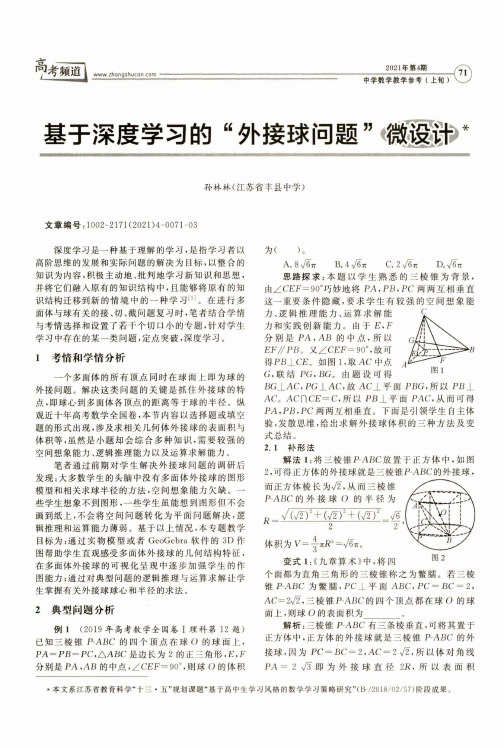

基于深度学习的“外接球问题”微设计

基于深度学习的“外接球问题”微设计〃@老M谙l2021年第4期t I --------------------------------------------------------------------------------------------------------------------------------------------------------------------------( 11 /1-丨mm --------------------------------------------------------------------------------------------------------------------------------------------- 中学数学教学参考(上旬>孙林林(江苏省丰县中学)文章编号:1002-2171 (2021)4-0071-03深度学习是一种基于理解的学习,是指学习者以高阶思维的发展和实际问题的解决为目标,以整合的 知识为内容,积极主动地、批判地学习新知识和思想, 并将它们融人原有的知识结构中,且能够将原有的知 识结构迁移到新的情境中的一种学习[1]。

在进行多 面体与球有关的接、切、截问题复习时,笔者结合学情 与考情选择和设置了若干个切口小的专题,针对学生 学习中存在的某一类问题,定点突破,深度学习。

1考情和学情分析一个多面体的所有顶点同时在球面上即为球的 外接问题。

解决这类问题的关键是抓住外接球的特 点,即球心到多面体各顶点的距离等于球的半径。

纵 观近十年高考数学全国卷,本节内容以选择题或填空 题的形式出现,涉及求相关几何体外接球的表面积与 体积等,虽然是小题却会综合多种知识,需要较强的 空间想象能力、逻辑推理能力以及运算求解能力。

笔者通过前期对学生解决外接球问题的调研后 发现:大多数学生的头脑中没有多面体外接球的图形 模型和相关求球半径的方法,空间想象能力欠缺。

遥感图像分类中的遗传算法LVQ神经网络运用

遥感图像分类中的遗传算法LVQ神经网络运用

遥感图像分类是遥感领域中一项重要的研究方向,通常采用多种分类方法进行处理,

以达到有效分类和提高分类精度的目的。

而遗传算法(Genetic Algorithm,GA)是一种基于生物学进化理论的搜索和优化算法,在图像分类中应用广泛。

基于遗传算法的复合分类方法中,常采用的是多层神经网络(Multi-Layer Perceptron,MLP),它是一种前向反馈神经网络,具有多个输入层、隐藏层和输出层。

其中,隐藏层的神经元数量对分类性能的影响非常重要。

在遗传算法中,将神经元数量作为遗传算法的优

化目标,通过遗传算法进行优化,并将优化的结果输入到LVQ神经网络中进行分类。

LVQ神经网络(Learning Vector Quantization,LVQ)是一种监督学习神经网络,它根据分类的目标进行训练,具有快速收敛和较好的分类性能。

在LVQ神经网络中,每个神

经元表示一个类别,输入样本通过计算到各神经元的距离来确定所属的类别。

遗传算法则

通过不断迭代的过程寻找最佳分类结果,提高分类精度。

简单来说,遗传算法LVQ神经网络的分类过程是这样的:首先,使用遗传算法对神经

元数量进行优化,得到优化结果,然后将结果作为LVQ神经网络的分类依据,在LVQ神经

网络中对输入的遥感图像进行分类,最终得到有效的分类结果。

总之,遗传算法LVQ神经网络运用于遥感图像分类中,通过遗传算法的优化和LVQ神

经网络的分类,可以有效地提高遥感图像的分类精度和处理效率。

这种复合分类方法具有

较强的可扩展性和适应性,未来将在遥感领域中得到广泛应用。

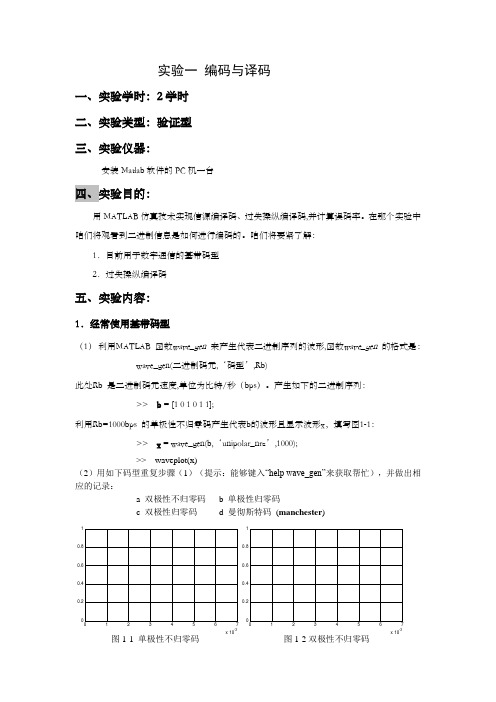

数据通信原理实验指导书

实验一编码与译码一、实验学时:2学时二、实验类型:验证型三、实验仪器:安装Matlab软件的PC机一台四、实验目的:用MATLAB仿真技术实现信源编译码、过失操纵编译码,并计算误码率。

在那个实验中咱们将观看到二进制信息是如何进行编码的。

咱们将要紧了解:1.目前用于数字通信的基带码型2.过失操纵编译码五、实验内容:1.经常使用基带码型(1)利用MATLAB 函数wave_gen 来产生代表二进制序列的波形,函数wave_gen 的格式是:wave_gen(二进制码元,‘码型’,Rb)此处Rb 是二进制码元速度,单位为比特/秒(bps)。

产生如下的二进制序列:>> b = [1 0 1 0 1 1];利用Rb=1000bps 的单极性不归零码产生代表b的波形且显示波形x,填写图1-1:>> x = wave_gen(b,‘unipolar_nrz’,1000);>> waveplot(x)(2)用如下码型重复步骤(1)(提示:能够键入“help wave_gen”来获取帮忙),并做出相应的记录:a 双极性不归零码b 单极性归零码c 双极性归零码d 曼彻斯特码(manchester)x 10-3x 10-3图1-1 单极性不归零码图1-2双极性不归零码x 10-3x 10-32.过失操纵编译码(1) 利用MATLAB 函数encode 来对二进制序列进行过失操纵编码, 函数encode 的格式是:A .code = encode(msg,n,k,'linear/fmt',genmat)B .code = encode(msg,n,k,'cyclic/fmt',genpoly)C .code = encode(msg,n,k,'hamming/fmt',prim_poly)其中A .用于产生线性分组码,B .用于产生循环码,C .用于产生hamming 码,msg 为待编码二进制序列,n 为码字长度,k 为分组msg 长度,genmat 为生成矩阵,维数为k*n ,genpoly 为生成多项式,缺省情形下为cyclpoly(n,k)。

机器学习基本概念总结

机器学习基本概念总结本文首发于 github,最新版以 github 为主,建议去 github 阅读,可能不是最新版。

如果看完文章有所收获,一定要先点赞后收藏。

毕竟,赠人玫瑰,手有余香。

深度学习是机器学习的一个特定分支。

为了全面理解深度学习,我们必须深入了解机器学习的基本原理。

机器学习的本质属于应用统计学,更注重如何用计算机对复杂函数进行统计估计,较少关注为这些函数提供置信区间。

大多数机器学习算法可以分为有监督学习和无监督学习。

将优化算法、代价函数、模型、数据集等不同的算法部分结合起来,可以建立一个完整的机器学习算法。

一,余弦相似度与欧氏距离1.1,余弦相似度通过对两个文本分词,TF-IDF 算法向量化,利用空间中两个向量的夹角,来判断这两个向量的相似程度:(计算夹角的余弦,取值 0-1)•当两个向量夹角越大,距离越远,最大距离就是两个向量夹角180°;•夹角越小,距离越近,最小距离就是两个向量夹角0°,完全重合。

•夹角越小,相似度越高。

但是有可能一篇文章中的特征分类器太多,导致整个向量的维数很高,对于大数据的计算来说计算代价太大。

计算两个向量a、b的夹角余弦:我们知道,余弦定理:cos(\theta) = \frac {a^2+b^2+c^2}{2ab} ,由此推得两个向量夹角余弦的计算公式如下:cos(\theta) = \frac {ab}{||a|| \times ||b||} = \frac {x_{1}x_{2}+y_1y_2}{\sqrt{x^2_1+y^2_1}\sqrt{x^2_2+y^2_ 2}}(分子就是两个向量的内积,分母是两个向量的模长乘积)1.2,欧式距离欧式距离和 L2 范数计算公式相同。

在欧几里得空间中,欧式距离其实就是向量空间中两点之间的距离。

点 x = (x_{1}, ..., x_{n}) 和 y = (y_{1}, ...,y_{n}) 之间得欧氏距离计算公式如下:d(x,y) = \sqrt {((x_{1}-y_{1})^{2} + (x_{2}-y_{2})^{2} + ... + (x_{n}-y_{n})^{2})}1.3,余弦相似度和欧氏距离的区别•欧式距离和余弦相似度都能度量 2 个向量之间的相似度•放到向量空间中看,欧式距离衡量两点之间的直线距离,而余弦相似度计算的是两个向量之间的夹角•没有归一化时,欧式距离的范围是[0, +∞],而余弦相似度的范围是 [-1, 1];余弦距离是计算相似程度,而欧氏距离计算的是相同程度(对应值的相同程度)•在归一化的情况下,空间可以想象成一个超球面(三维)。

maxpool2d计算公式

maxpool2d计算公式Maxpool2d是深度学习中常用的一种池化层,它用于减小特征图的大小,同时保留图像中最重要的特征。

Maxpool2d的计算公式如下:-输入:一张mxn的特征图-池化核大小:kxk- 步长(stride):s- 补零(padding):p输出的特征图大小计算公式如下:output_size = ((m - k + 2p)/s) + 1output_width = ((n - k + 2p)/s) + 1其中,m和n分别是输入特征图的高度和宽度。

池化核(kernel)指的是在进行池化操作时,对输入特征图进行采样的窗口大小。

通常用一个正方形的窗口表示,大小为k x k。

池化核的大小一般是根据具体网络结构进行设定的。

步长(stride)是指在进行池化操作时,池化核在特征图上移动的步长。

步长的值决定了特征图的下采样程度,即输出特征图的大小。

补零(padding)是指在进行池化操作时,对输入特征图进行填充的操作。

填充的目的是为了保持输出特征图的大小与输入特征图相同,使得卷积神经网络的各个层之间能够对齐。

池化操作的具体步骤如下:1.将特征图用池化核窗口进行采样,得到每个窗口内的最大值。

2.将得到的最大值填充到输出特征图的相应位置。

池化操作的作用主要有以下几点:1.减小参数:池化操作通过保留每个窗口内的最大值,减小了特征图的尺寸,从而减小了网络的参数数量。

2.减小过拟合:池化操作通过对特征图进行下采样,保留了重要的特征信息,减少了对细节的依赖,从而降低了网络的过拟合风险。

3.提取关键特征:池化操作通过保留每个窗口内的最大值,强调了图像中最重要的特征信息,并且通过减小尺寸,将重要的特征集中到一个更小的特征图中。

总结来说,Maxpool2d通过对特征图进行下采样和特征选择,能够有效地减小网络的参数数量和计算复杂度,提升网络的计算效率和泛化能力。

同时,它可以保留图像中最重要的特征信息,有利于网络的特征提取和表达能力。

空间奈奎斯特采样定理

空间奈奎斯特采样定理

空间奈奎斯特采样定理(Spatial Nyquist Sampling Theorem)是数字图像处理和计算机视觉领域中的一项重要原理,类似于时间信号处理中的奈奎斯特采样定理。

该定理指出,为了避免出现混叠(aliasing)现象,对于连续的二维空间信号(如图像),在进行离散化采样时,采样频率必须满足特定条件。

具体来说,对于一幅二维空间信号(例如图像),如果其最高频率成分为f_max,则为了能够完全恢复原始信号而没有信息丢失,采样频率(空间采样率)必须至少是f_max的两倍。

数学表达式如下:

采样频率≥ 2 * f_max

其中,f_max是原始信号中的最高频率成分。

简单解释:在对图像进行数字化处理时,我们将其分为像素,并在每个像素点上记录颜色值。

如果我们的采样频率低于信号中的最高频率成分的两倍,那么在还原图像时,会出现混叠现象,导致图像出现失真。

因此,空间奈奎斯特采样定理

要求采样频率至少为最高频率成分的两倍,以避免信息丢失。

实际应用中,为了更好地处理信号,通常会选择更高的采样频率。

rknn算法的原理和步骤

RKNN算法是一种深度学习模型压缩和优化的算法。

它可以将大型的深度学习模型压缩成小型的模型,从而在低功耗设备上实现高效的推理。

本文将介绍RKNN算法的原理和步骤。

一、RKNN算法的原理RKNN算法的原理基于两个核心技术:量化和剪枝。

1. 量化(Quantization)量化是将浮点数转换为定点数或整数的过程。

在深度学习中,我们通常使用32位或64位的浮点数来表示权重和激活值。

但是,在低功耗设备上进行推理时,使用32位或64位的浮点数会浪费大量的计算资源和存储空间。

因此,在RKNN算法中,我们需要将浮点数量化为8位或16位的定点数或整数。

量化的过程如下:a. 将浮点数映射到一个有限的整数集合中。

b. 将整数集合中的整数编码为二进制数。

c. 将二进制数解码为整数,并将其映射回浮点数。

d. 对量化后的浮点数进行校准,以保持精度。

2. 剪枝(Pruning)剪枝是指通过删除冗余的权重和神经元来减少模型的大小和计算量。

在深度学习中,许多神经元可能对最终的输出贡献不大,或者可以由其他神经元来代替。

因此,我们可以通过剪枝来减少模型的大小和计算量。

剪枝的过程如下:a. 计算每个神经元对最终输出的贡献。

b. 删除对最终输出贡献较小的神经元。

c. 更新剩余神经元之间的权重。

二、RKNN算法的步骤RKNN算法的步骤如下:1. 模型训练首先,我们需要使用深度学习框架(如TensorFlow、PyTorch)训练一个大型的深度学习模型。

该模型通常包含数百万个参数和大量的神经元。

2. 量化接下来,我们使用量化技术将模型的权重和激活值从32位或64位的浮点数量化为8位或16位的定点数或整数。

这将大幅减少模型的大小和计算量。

3. 剪枝然后,我们使用剪枝技术删除模型中不必要的权重和神经元。

这将再次减少模型的大小和计算量。

4. 生成RKNN模型最后,我们使用RKNN工具(如Rockchip NPU SDK)将量化和剪枝后的模型转换为RKNN模型。

pyramid attention network(pan)相关计算公式

pyramid attention network(pan)相关计算公式Pyramid Attention Network (PAN) 相关计算公式引言:Pyramid Attention Network (PAN) 是一种用于计算机视觉任务的深度神经网络模型。

它通过引入金字塔注意力机制,能够有效地捕捉图像中不同尺度的特征信息。

本文将详细介绍 PAN 模型的计算公式,帮助读者更好地理解和应用这一先进的视觉模型。

1. 输入层PAN 模型的输入是一张图像,可以表示为 X,其尺寸为 H × W × C,分别表示图像的高度、宽度和通道数。

2. 特征提取模块PAN 模型首先通过特征提取模块将输入图像 X 转换为特征图 F。

这一模块通常使用卷积神经网络(CNN),可以表示为 F = CNN(X)。

3. 金字塔注意力机制PAN 模型的核心是金字塔注意力机制,它能够在不同尺度上对特征图进行加权融合,以捕捉多尺度的特征信息。

3.1 金字塔池化首先,通过金字塔池化操作,我们可以得到不同尺度的特征图。

假设金字塔池化操作的尺度为 S,那么对于特征图F,我们可以得到金字塔特征图 P = {P1, P2, ..., PS},其中 Pi 的尺寸为H/2^i × W/2^i × C。

3.2 金字塔注意力机制对于每个金字塔特征图 Pi,我们需要计算其注意力权重Ai。

这一权重可以通过以下公式计算得到:Ai = softmax(ReLU(Wap⊗fap + Wap⊗gaa + Wap⊗haa + bap))其中⊗表示卷积操作,fap 表示 Pi 与自身的卷积,gaa 表示 Pi 与所有金字塔特征图的卷积,haa 表示 Pi 与所有金字塔特征图的平均池化,Wap 和 bap 是可学习的参数。

3.3 加权融合通过金字塔注意力机制计算得到的注意力权重 Ai 可以用于加权融合特征图 Pi,得到最终的特征图 Oi。

opencv 棋盘格检测原理

opencv 棋盘格检测原理OpenCV是一个广泛应用于计算机视觉领域的开源库,它提供了丰富的图像处理和计算机视觉算法。

其中一个常见的应用就是棋盘格检测,用于标定相机、测量距离、3D重建等。

棋盘格检测原理基于图像处理和计算机视觉算法,它通过分析棋盘格的几何特征来实现。

下面将详细介绍棋盘格检测的原理和步骤。

1.准备棋盘格图像首先,我们需要准备一张包含标定棋盘格的图像。

标定棋盘格是一个方形的格子模式,通常由黑色和白色的正方形交错组成。

要特别注意棋盘格将保持平整,避免出现扭曲或形变。

一般情况下,我们会在棋盘格的四个角上放置一些辅助点(标定点)来帮助定位和确定角点的坐标。

2.灰度化和图像处理将棋盘格图像转换为灰度图像,这是因为灰度图像只包含亮度信息而没有颜色信息,这可以简化图像处理的操作,并提高算法的鲁棒性。

在OpenCV中可以使用cvtColor()函数将彩色图像转换为灰度图像。

3.角点检测角点是棋盘格最重要的特征,它们是棋盘格边缘的交点。

通过检测这些角点,我们可以基于它们来计算相机的内外参数。

在OpenCV中有几种角点检测算法可供选择,最常用的是Harris角点检测和Shi-Tomasi角点检测。

- Harris角点检测:这种算法通过计算灰度值变化的局部自相关来检测角点。

它会分析图像中每个像素点的灰度值,并通过一个特定的响应函数来评估角点的强度。

在OpenCV中,可以使用cornerHarris()函数来实现Harris角点检测。

- Shi-Tomasi角点检测:Shi-Tomasi角点检测算法是对Harris角点检测算法的改进。

它使用的评估函数比Harris更加准确,可以得到更好的角点检测结果。

在OpenCV中,可以使用goodFeaturesToTrack()函数来实现Shi-Tomasi 角点检测。

4.清理和筛选角点由于角点检测算法会产生大量的角点候选,我们需要对它们进行清理和筛选,以获取最准确和最稳定的角点。

如何处理卷积神经网络中的类别不平衡问题

如何处理卷积神经网络中的类别不平衡问题卷积神经网络(Convolutional Neural Networks,简称CNN)是一种在计算机视觉领域广泛应用的深度学习模型。

它通过多层卷积和池化操作来提取图像的特征,并通过全连接层进行分类或回归任务。

然而,在实际应用中,我们经常会遇到一个问题,那就是类别不平衡。

类别不平衡是指训练数据中不同类别的样本数量差异过大的情况。

例如,在一个二分类问题中,正样本的数量远远小于负样本的数量。

这种情况下,CNN往往会倾向于将样本分类为数量较多的类别,而忽略了数量较少的类别。

为了解决类别不平衡问题,我们可以采取以下几种方法。

首先,一种常见的方法是重采样。

这种方法通过增加少数类别的样本数量或减少多数类别的样本数量来达到平衡的效果。

常用的重采样方法包括过采样和欠采样。

过采样是指通过复制少数类别的样本来增加其数量,而欠采样则是通过删除多数类别的样本来减少其数量。

这种方法的优点是简单易行,但也存在一些问题,比如过采样容易导致过拟合,而欠采样可能会丢失一些重要的信息。

其次,另一种方法是修改损失函数。

在CNN中,通常使用交叉熵作为损失函数来衡量模型预测结果与真实标签之间的差异。

当类别不平衡时,我们可以修改交叉熵损失函数,引入类别权重来平衡不同类别之间的重要性。

具体来说,可以通过给少数类别赋予较大的权重,使模型更加关注少数类别。

这种方法的优点是简单有效,但需要手动调整类别权重,可能需要一定的经验和领域知识。

另外,一种更加复杂的方法是引入样本生成技术。

这种方法通过生成新的样本来平衡不同类别之间的数量差异。

常用的样本生成技术包括SMOTE(Synthetic Minority Over-sampling Technique)和GAN(Generative Adversarial Networks)。

SMOTE通过在少数类别样本之间插值生成新的样本,从而增加其数量。

而GAN则通过生成器和判别器的对抗训练来生成逼真的少数类别样本。

onnx 中的公式

onnx 中的公式ONNX是一种开源的深度学习模型交换格式,它能够让不同的深度学习框架之间互相转换模型,使得深度学习应用更加便捷。

在ONNX 中,存在多种公式,这些公式包含了不同的数学运算和神经网络层,本文将介绍ONNX中的一些常用公式。

1. 矩阵乘法公式矩阵乘法是深度学习模型中最基本的数学运算之一,其公式为: C=AB其中,A、B、C分别为矩阵,A的列数等于B的行数。

在ONNX中,矩阵乘法公式的实现可以使用Gemm节点,其输入参数包括A、B、C、alpha、beta等。

2. 卷积公式卷积层是深度学习中经常使用的神经网络层之一,其公式为:y(i,j)=b+∑(k,l) x(i+k,j+l)w(k,l)其中,x为输入数据,w为卷积核,b为偏置项,(i,j)为输出特征图的坐标,(k,l)为卷积核在输入数据上的偏移量。

在ONNX中,卷积层的实现可以使用Conv节点,其输入参数包括输入数据、卷积核、步长、填充等。

3. 池化公式池化层是深度学习中常用的降采样层,其公式为:y(i,j)=max((k,l)∈R(x(i+k,j+l)))其中,x为输入数据,R为池化窗口,y为输出数据,max为取最大值操作。

在ONNX中,池化层的实现可以使用MaxPool节点或AveragePool 节点,其输入参数包括输入数据、池化窗口、步长、填充等。

4. 激活函数公式激活函数是深度学习中常用的非线性变换,其公式为:y=f(x)其中,x为输入数据,f为激活函数,y为输出数据。

在ONNX中,常用的激活函数包括Sigmoid、ReLU、Tanh等,其实现可以使用Sigmoid节点、Relu节点、Tanh节点等。

总结:本文介绍了一些ONNX中常用的公式,包括矩阵乘法、卷积、池化和激活函数等。

了解这些公式,可以更好地理解深度学习模型的基本运算和神经网络层的实现方式。

orbslam用到的算法与公式

orbslam用到的算法与公式ORB-SLAM(Oriented Fast and Rotated Brief-SLAM)是一种基于特征点的实时单目视觉SLAM系统。

它结合了FAST角点检测与描述子BRIEF描述子,利用这两种特征来进行地图构建、相机跟踪和定位。

ORB-SLAM主要分为三个模块:定位追踪,建图和回环检测。

下面将具体介绍这三个模块的相关算法与公式。

1. 定位追踪:ORB-SLAM利用特征点来追踪相机的运动。

在某一帧中提取到的特征点经过特征点跟踪算法获得其在连续帧中的匹配点,进而计算相机的运动。

ORB-SLAM采用光流法将特征点在连续帧之间进行跟踪,具体算法如下:- 特征点提取:ORB-SLAM利用FAST算法检测候选角点,并根据Harris角点响应进行精确定位。

- 描述子计算:对于检测到的候选角点,ORB-SLAM使用BRIEF描述子对其进行描述,通过矩形区域采样得到二进制描述子。

- 最小二乘法:ORB-SLAM采用最小二乘法对当前帧和上一帧之间的特征点进行匹配,得到2D-2D匹配点对。

- 位姿估计:利用匹配点对通过PnP算法(Perspective-n-Point)估计相机的位姿(旋转和平移)。

- 三角化:对于2D-2D匹配点对,ORB-SLAM通过三角化算法从而得到3D点云。

- 重定位:当相机丢失跟踪时,ORB-SLAM采用方向信息与重定位模型计算相机的位置,并利用特征点描述子进行重定位。

2. 建图:ORB-SLAM通过连续帧间的视觉里程计得到相机的运动轨迹,并同时构建地图。

主要使用几何和视差约束来进行地图构建,具体算法如下:- 初始化:ORB-SLAM从两个单独视野(例如初始的两帧)中进行初始化,同时计算两个视野中的匹配点,进行位姿计算和三角化重建。

- 回环检测:ORB-SLAM利用回环检测模块来发现已经访问过的位置,通过计算两个视野之间的相似性得到回环检测。

- 位姿优化:利用词袋模型和位姿图优化方法进行地图管理和位姿优化。

如何解决深度学习模型中的类别不均衡问题

如何解决深度学习模型中的类别不均衡问题深度学习模型在处理类别不均衡问题时,往往会面临一些挑战。

类别不均衡是指数据集中不同类别样本数量不平衡,导致模型训练过程中对少数类别的学习效果较差。

为了解决这个问题,我们可以采取以下几种方法。

首先,可以通过重采样方法解决类别不均衡问题。

重采样方法包括过采样和欠采样两种策略。

过采样通过增加少数类别的样本数量,使得各个类别的样本数量相对平衡。

常见的过采样方法有SMOTE(Synthetic Minority Over-sampling Technique)和ADASYN(Adaptive Synthetic Sampling)。

欠采样则是通过减少多数类别的样本数量,同样可以达到数据集平衡的效果。

然而,过采样可能会引入冗余的样本,而欠采样则可能会丢失重要的信息。

因此,在使用这些方法时需要权衡,选择适合具体问题的方法。

其次,通过调整模型的损失函数来解决类别不均衡问题也是一种常用方法。

传统的损失函数,如交叉熵损失函数,对于每个类别的样本都赋予相同的权重。

当数据集中存在类别不均衡问题时,可以通过修改损失函数的权重,使得模型更加关注少数类别的样本。

具体的方法包括使用加权交叉熵损失函数或改变样本权重的方式来调整损失函数。

通过这种方式,可以使得模型更加关注少数类别,提高其分类的准确性。

另外,使用集成学习方法也可以解决类别不均衡问题。

集成学习通过将多个基分类器的预测结果进行组合,达到更好的分类性能。

对于类别不均衡问题,可以使用一些针对性的集成方法,如基于Bagging的方法和基于Boosting的方法。

这些方法可以通过对样本进行有放回或无放回的抽样来生成多个子样本集,并训练多个基分类器。

然后,通过对基分类器的预测结果进行投票或加权平均,最终得到集成分类器的预测结果。

这种方法可以充分利用数据集中的信息,提高模型对少数类别样本的分类性能。

此外,还可以通过生成新的合成样本来解决类别不均衡问题。

《视觉SLAM十四讲》笔记(ch7)

《视觉SLAM⼗四讲》笔记(ch7)ch7 视觉⾥程计1本章⽬标:1.理解图像特征点的意义,并掌握在单副图像中提取出特征点及多副图像中匹配特征点的⽅法2.理解对极⼏何的原理,利⽤对极⼏何的约束,恢复出图像之间的摄像机的三维运动3.理解PNP问题,以及利⽤已知三维结构与图像的对应关系求解摄像机的三维运动4.理解ICP问题,以及利⽤点云的匹配关系求解摄像机的三维运动5.理解如何通过三⾓化获得⼆维图像上对应点的三维结构本章⽬的:基于特征点法的vo,将介绍什么是特征点,如何提取和匹配特征点,以及如何根据配对的特征点估计相机运动和场景结构,从⽽实现⼀个基本的两帧间视觉⾥程计。

特征点:⾓点、SIFT(尺度不变特征变换,Scale-Invariant Feature Transform)、SURF、、ORB(后三个是⼈⼯设计的特征点,具有更多的优点)特征点的组成:1.关键点:指特征点在图像⾥的位置2.描述⼦:通常是⼀个向量,按照某种⼈为设计的⽅式,描述了该关键点周围像素的信息。

相似的特征应该有相似的描述⼦(即当两个特征点的描述⼦在向量空间上的距离相近,认为这两个特征点是⼀样的)以ORB特征为代表介绍提取特征的整个过程:ORB特征:OrientedFAST关键点+BRIEF关键⼦提取ORB特征的步骤:1.提取FAST⾓点:找出图像中的“⾓点”,计算特征点的主⽅向,为后续BRIEF描述⼦增加了旋转不变特性FAST⾓点:主要检测局部像素灰度变化明显的地⽅特点:速度快缺点:1).FAST特征点数量很⼤且不确定,但是我们希望对图像提取固定数量的特征2).FAST⾓点不具有⽅向信息,并且存在尺度问题解决⽅式:1).指定要提取的⾓点数量N,对原始FAST⾓点分别计算Harris响应值,然后选取前N个具有最⼤响应值的⾓点作为最终的⾓点集合2).添加尺度和旋转的描述 尺度不变性的实现:构建图像⾦字塔,并在⾦字塔的每⼀层上检测⾓点(⾦字塔:指对图像进⾏不同层次的降采样,以获得不同分辨率的图像)特征旋转的实现:灰度质⼼法(质⼼:指以图像块灰度值作为权重的中⼼)2.计算BRIEF描述⼦:对前⼀步提取出的特征点周围图像区域进⾏扫描特点:使⽤随机选点的⽐较,速度⾮常快,由于使⽤了⼆进制表达,存储起来也⼗分⽅便,适⽤于实时的图像匹配在不同图像之间进⾏特征匹配的⽅法:1.暴⼒匹配:浮点类型的描述⼦,使⽤欧式距离度量⼆进制类型的描述⼦(⽐如本例中的BRIEF描述⼦),使⽤汉明距离度量缺点:当特征点数量很⼤时,暴⼒匹配法的运算量会变得很⼤2.快速近似最近邻(FLANN):适合匹配特征点数量极多的情况实践部分:1.OpenCV的图像特征提取、计算和匹配的过程:演⽰如何提取ORB特征并进⾏匹配代码: 1 #include <iostream>2 #include <opencv2/core/core.hpp>3 #include <opencv2/features2d/features2d.hpp>4 #include <opencv2/highgui/highgui.hpp>56using namespace std;7using namespace cv;89int main(int argc,char** argv)10 {11if(argc!=3)12 {13 cout<<"usage:feature_extraction img1 img2"<<endl;14return1;15 }1617//读取图像18 Mat img_1=imread(argv[1],CV_LOAD_IMAGE_COLOR);19 Mat img_2=imread(argv[2],CV_LOAD_IMAGE_COLOR);2021//初始化22 vector<KeyPoint> keypoints_1,keypoints_2;//关键点,指特征点在图像⾥的位置23 Mat descriptors_1,descriptors_2;//描述⼦,通常是向量24 Ptr<ORB> orb=ORB::create(500,1.2f,8,31,0,2,ORB::HARRIS_SCORE,31,20);2526//第⼀步:检测OrientFAST⾓点位置27 orb->detect(img_1,keypoints_1);28 orb->detect(img_2,keypoints_2);2930//第2步:根据⾓点位置计算BRIEF描述⼦31 orb->compute(img_1,keypoints_1,descriptors_1);32 orb->compute(img_2,keypoints_2,descriptors_2);3334 Mat outimg1;35 drawKeypoints(img_1,keypoints_1,outimg1,Scalar::all(-1),DrawMatchesFlags::DEFAULT);36 imshow("1.png的ORB特征点",outimg1);37 Mat outimg2;38 drawKeypoints(img_2,keypoints_2,outimg2,Scalar::all(-1),DrawMatchesFlags::DEFAULT);39 imshow("2.png的ORB特征点",outimg2);4041//第3步:对两幅图像中的BRIEF描述⼦进⾏匹配,使⽤Hamming距离42 vector<DMatch> matches;43//特征匹配的⽅法:暴⼒匹配44 BFMatcher matcher(NORM_HAMMING);45 matcher.match(descriptors_1,descriptors_2,matches);46// for(auto it=matches.begin();it!=matches.end();++it)47// {48// cout<<*it<<" ";49// }50// cout<<endl;5152//第4步:匹配点对筛选53 distance是min_dist5455double min_dist=10000,max_dist=0;5657//找出所有匹配之间的最⼩距离和最⼤距离,即最相似的和最不相似的和最不相似的两组点之间的距离58for(int i=0;i<descriptors_1.rows;++i)59 {60double dist=matches[i].distance;61// cout<<dist<<endl;62if(dist<min_dist) min_dist=dist;63if(dist>max_dist) max_dist=dist;64 }6566 printf("--Max dist:%f\n",max_dist);67 printf("--Min dist:%f\n",min_dist);6869//当描述⼦之间的距离⼤于两倍的最⼩距离时,即认为匹配有误70//但有时候最⼩距离会⾮常⼩,设置⼀个经验值作为下限71 vector<DMatch> good_matches;72for(int i=0;i<descriptors_1.rows;++i)73 {74if(matches[i].distance<=max(2*min_dist,30.0))75 {76 good_matches.push_back(matches[i]);77 }78 }7980//第5步:绘制匹配结果81 Mat img_match;82 Mat img_goodmatch;83 drawMatches(img_1,keypoints_1,img_2,keypoints_2,matches,img_match);84 drawMatches(img_1,keypoints_1,img_2,keypoints_2,good_matches,img_goodmatch);85 imshow("所有匹配点对",img_match);86 imshow("优化后匹配点对",img_goodmatch);87 waitKey(0);8889return0;90 }实验结果:1.png中提取到的特征点2.png中提取到的特征点匹配结果: 所有点对匹配结果 优化后的匹配点对结果(筛选依据是Hamming距离⼩于最⼩距离的两倍)结果分析:尽管在这个例⼦中利⽤⼯程经验优化筛选出正确的匹配,但并不能保证在所有其他图像中得到的匹配都是正确的,所以,在后⾯的运动估计中,还要使⽤去除误匹配的算法。

一种用于谱聚类图像分割的像素相似度计算方法

一种用于谱聚类图像分割的像素相似度计算方法

纳跃跃;于剑

【期刊名称】《南京大学学报:自然科学版》

【年(卷),期】2013()2

【摘要】图像分割是许多计算机视觉任务中的关键步骤,而谱聚类算法是目前图像分割的主要方法之一.为了使用谱聚类算法进行图像分割,首先需要计算用于反映像素间相似程度的相似矩阵,所采用的相似度计算方法是否能真实的反映出像素间的视觉相似度将显著影响算法的输出结果.针对普聚类图像分割算法的相似度计算问题,提出了一种新的像素间相似度计算方法.与传统方法相比,该方法不但考虑了像素自身的特征,而且考虑了其邻域内像素的视觉特征,以及两像素之间的边缘信息,使得计算所得的相似度更加符合人类的直观感受,且不易受到纹理的影响.另外,提出了一种针对该相似度计算方法的相似矩阵构造方法.在BSDS300图像库上的实验表明,使用该相似度能得到较好的图像分割结果.

【总页数】10页(P159-168)

【关键词】相似度;相似矩阵;谱聚类;图像分割

【作者】纳跃跃;于剑

【作者单位】北京交通大学计算机与信息技术学院

【正文语种】中文

【中图分类】TP391.41

【相关文献】

1.基于相似度矩阵的谱聚类集成图像分割 [J], 张琦;卢志茂;徐森;刘晨;隋毅

2.基于改进的相似度度量的谱聚类图像分割方法 [J], 邹旭华;叶晓东;谭治英;陆凯

3.谱聚类图像分割中相似度矩阵构造研究 [J], 李扬;陆璐;崔红霞

4.一种基于自适应超像素的改进谱聚类图像分割方法 [J], 覃正优;林一帆;陈瑜萍;林富强

5.一种新的基于超像素的谱聚类图像分割算法 [J], 高尚兵;周静波;严云洋

因版权原因,仅展示原文概要,查看原文内容请购买。

基于投影残差量化哈希的近似最近邻搜索

基于投影残差量化哈希的近似最近邻搜索

杨定中;陈心浩

【期刊名称】《计算机工程》

【年(卷),期】2015(041)012

【摘要】针对投影哈希中投影误差较大,二进制编码时原始信息丢失严重等问题,提出一种近似最近邻搜索方法.该方法通过多阶段量化策略减少编码过程中的投影及量化误差.在每阶段训练时,对前一阶段的量化残差采用投影、按维度训练码书及量化、反投影等运算生成各阶段的子量化器.子量化器按投影后数据的维度提供多个哈希函数,最终的哈希函数由各阶段哈希函数共同构成.在最近邻搜索时,给二进制编码加上权重以便对搜索结果进行重排,提高搜索精度.实验结果表明,基于投影残差量化哈希的近似最近邻的搜索性能优于当前主流的哈希方法.

【总页数】6页(P161-165,170)

【作者】杨定中;陈心浩

【作者单位】中南民族大学实验教学中心,武汉430074;中南民族大学实验教学中心,武汉430074

【正文语种】中文

【中图分类】TP37

【相关文献】

1.近似最近邻搜索算法——位置敏感哈希 [J], 高毫林;徐旭;李弼程

2.基于最近邻量化距离聚类的残差中心聚合图像表示 [J], 张琳娜; 梁列全; 郑心炜;

阚世超; 岑翼刚

3.近似最近邻搜索中投影增强型残差量化方法 [J], 艾列富;程宏俊;冯学军

4.基于邻居聚类的近似最近邻搜索 [J], 赵增;李明勇;胡航飞

5.基于近似最近邻搜索的改进PRM算法 [J], 薛阳;孙越;叶晓康;李蕊;华茜

因版权原因,仅展示原文概要,查看原文内容请购买。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Connected Rotation-invariant Size-Shape Granulometries Erik R.Urbach,Jos B.T.M.Roerdink and Michael H.F.Wilkinson Institute of Mathematics and Computing Science,University of GroningenP.O.Box800,9700A V Groningen,The Netherlandserik,roe,michael@cs.rug.nlAbstractIn this paper we describe a rotation-invariant multi-scale morphological method for texture paredwith existing methods our method has three advantages.First,it can be implemented efficiently.Furthermore,ourmethod can be used for the computation of size and strictshape attributes,which we use for the computation of2-Dsize-shape pattern spectra.Finally,our method is rotation-invariant.Although the latter can also be approximated by morphological methods by using structuring elements at different angles,this tends to be computationally intensive.1.IntroductionPattern spectra are commonly used tools for image anal-ysis and classification[6,11],which can be computed us-ing a technique from mathematical morphology known as granulometries[2,9].Intuitively,a size granulometry can be considered as a set of sieves of different grades,each al-lowing details of certain size classes to pass.More formally, a size granulometry consists of an ordered set of operators each of which converts an image to a new image in which features smaller than a particular size are absent.Granu-lometries based on shape have also been proposed[2,14]. Granulometries are often computed usingfilters with struc-turing elements.Connectedfilters can also be used for this purpose[2,10].These are operators which only ever merge flat zones,or change their gray level,but never split them This means no new edges are introduced.In the following our method is discussed which is based on Salembier’s Max-tree algorithm.An existing method us-ing structuring elements is discussed briefly in section3.2. The performance of both methods is discussed in section4 using the application of diatom identification.Diatoms[13]are unicellular algae with highly ornate sil-ica shells,which consist of two halves called valves.Exam-ples of diatom valves are shown in Fig.1.Both the shapes of these shells and the textures or ornamentation are distinc-tive characteristics of individual species or u-ally,diatoms are identified manually,using both the internal texture and the outline shape.To automate the whole pro-cess of diatom identification the Automatic Diatom Identifi-cation And Classification project(ADIAC)[4]was started. The methods described in this paper compute the feature vectors from the ornamentation only.2.TheoryA size granulometry is a set of operators with from some totally ordered set(usually or),with the following three properties(1)(2)(3) for all.Since(1)and(2)define as anti-extensive and increasing,respectively,and(3)implies idempotence, it can be seen that size granulometries are sets of openings.Let denote the scaling of an image by a scalar fac-tor,then an operator is said to be scale-invariant iffor all.A scale-invariant opera-tor is therefore sensitive to shape rather than to size.A shape granulometry[14]is a set of operators with from some totally ordered set,with the follow-ing three properties(4)(5)(6)for all and.Thus,a shape granulometry con-sists of operators which are anti-extensive,and idempotent, but not necessarily increasing.Size pattern spectra were introduced by Maragos[6].Es-sentially they are a histogram containing the number of pix-els,or the amount of image detail,over a range of size classes.If is the scale parameter of a size granulome-try,the size class of is the smallest value of for which.Shape pattern spectra can be defined in a simi-lar way[14].The pattern spectrum is usually defined as a function of scale:d20865070Figure 2.The peak components of a gray level image(left),the corresponding at-tributes(middle)and the Max-tree(right)class between and,and shape class between and. Note that and are the members of and imme-diately preceding and,respectively.The computation of a2-D pattern spectrum from an image is performed as fol-lows:Set all elements of the array to zero.Compute a Max-tree according to the algorithm in[9].As the Max-tree is built,compute the area and moment of inertia of each node.For each node:–Compute the size class from the area.–Compute the shape class from(8)In our case the size classes run from pixel to pixels(the largest image we could handle in our software).For the shape parameter(theo-retical minimum),and;in both cases two values were chosen for:4and8.The resulting,,and pattern spectra are then mapped in lexicographic or-der into1-D vectors.Until now the assumption was made that pattern spec-tra were based on2-D size-shape granulometries.However, many images contain both bright and dark image details. To obtain information about the dark patterns,anti-size and anti-shape granulometries are required,which are based on closings and thickenings respectively.Instead of designing new algorithms for the computation of pattern spectra based on these anti-size and anti-shape granulometries,these were implemented as the computation of pattern spectra of in-verted images.As can be expected,the best performance was obtained by the concatenation of the down-sized vec-tor of the normal image with the down-sized vector of the inverted image to a single feature vector.3.2.Pattern spectra based on structuring elementsAn existing method using structuring elements was de-scribed by Dougherty et al.in[1,12].We implemented a method according to these papers,which computes mul-tivariate pattern spectra using the following multivariategranulometry:.In order to re-duce computing time,our implementation of this multivari-ate method uses only the horizontal and the vertical lin-ear structuring element sequences.Two pattern spectra are computed using openings with,one for the normal and one for the inverted image.Instead of us-ing the integrated pattern spectra,we use the differentiated (in two dimensions)pattern spectra.Similar to the case of the Max-tree described earlier,the two pattern spec-tra are combined to a single1-D feature vector containing 64values.4.ResultsThe performance of both the Max-tree based method and the method using structuring elements in the applica-tion of diatom identification was measured using decision trees built with the C4.5algorithm[7].To increase the sta-bility of the decision tree classifiers,bagging[3]with25 trees and10runs was used.The original set of781diatom images,all of which had been aligned manually to the same orientation,consisted of37classes.C4.5identified81.0%,85.1%,and85.8%of these images correctly for respectively the Max-tree4x4, the Max-tree4x8,and the Max-tree8x4method,whereas 90.8%were identified correctly using the structuring ele-ments method.In practice it would be undesirable for a user to have to align every image manually,which means that a method should thus be invariant to rotation.Although most of the diatom images in the set used could be aligned to have the largest axis of the valve horizontally in the image,this causes problems for diatoms with a circular or triangular contour,but with non-symmetric ornamentation patterns, like the one shown in Fig.1(left).Another problem are di-atoms shells where an orientation might be possible to com-pute for a given image,but where the orientation can vary w.r.t.the ornamentation between images of the same class, like the one shown Fig.1(middle).In Fig.3(left)the perfor-mance of both methods is shown for images rotated at dif-ferent angles.As can be seen,while our method using the Max-tree algorithm with rotation-invariant attributes per-forms equally well for any rotation angle,the method us-ing structuring elements only performs well for the original image set,and due to the symmetry of most diatoms,also for the image set rotated at180degrees.The influence of noise on the performance of both methods was also mea-sured by evaluating image sets created from the originalimage set by adding Gaussian noise with standard devia-tions between and.The result of this test is shown in Fig.3(right).On a1GHz Celeron PC our meth-ods based on the Max-tree needed0.4seconds to compute both pattern spectra of a typical621x501diatom -ing the same image the computation time for the method us-ing structuring elements was1.8seconds.Note that contrary to structuring elements methods,the computation time for our Max-tree method is independent of the number of size and shape classes.5.ConclusionsMethods using pattern spectra for the computation of feature vectors are very suitable for image classification. An existing method using structuring elements was com-pared with a new method based on Salembier’s Max-tree algorithm.For image sets without orientation or where the images were manually aligned to the have same orientation, the existing method performs better than our method.How-ever,when rotation-invariance is desired,like in the case of images with different orientations,our Max-tree with its rotation-invariant attributes is preferable over methods based on linear structuring elements,since the latter are not invariant to rotation.Although rotation-invariance might be approximated by using linear structuring elements at many orientations,this is no option when large sets of images are used due to the sharp increase in computation time. Our method can also be used for other applications where rotation-invariance is desirable,like classification of pollen grains[8],where all grains have a more or less round shape, but whose patterns are not always symmetric.Finally,when pattern spectra with a large number of size or shape classes needs to be computed,our method is also preferable since methods based on structuring elements needs tofilter an im-age for every class used,while our method computes a pat-tern spectrum in a single run.It should be noted here,that the performance of our method might be improved signifi-cantly by using other attributes.Therefore,other attributes need to be investigated.References[1]S.Batman and E.Dougherty.Size distributions for multi-variate morphological granulometries:texture classification and statistical properties.Optical Engineering,36(5):1518–1529,May1997.[2] E.J.Breen and R.Jones.Attribute openings,thinnings andputer Vision and Image Understanding, 64(3):377–389,1996.[3]L.Breiman.Bagging predictors.Machine Learning,24:123–140,1996.[4]J.M.H.Du Buf and M.M.Bayer,editors.Automatic Di-atom Identification.Series in Machine Perception and Ar-tificial Intelligence.World Scientific Publishing Co.,Singa-pore,2002.[5]P.Ghosh and B.Chanda.Bi-variate pattern spectrum.InProceedings SIBGRAPI’98,pages476–483,Rio de Janeiro, 20-23October1998.IEEE Comp.Soc.[6]P.Maragos.Pattern spectrum and multiscale shape represen-tation.IEEE Trans.Patt.Anal.Mach.Intell.,11:701–715, 1989.[7]R.Quinlan.C4.5:Programs for Machine Learning.MorganKaufmann,San Mateo,USA,1993.[8]O.Ronneberger,H.Burkhardt,and E.Schultz.General-purpose object recognition in3d volume data sets using gray-scale invariants-classification of airborne pollen-grains recorded with a confocal laser scanning microscope.In Proc.of the ICPR,Quebec,Canada,September2002.[9]P.Salembier,A.Oliveras,and L.Garrido.Anti-extensiveconnected operators for image and sequence processing.IEEE Transactions on Image Processing,7:555–570,1998.[10]P.Salembier and J.Serra.Flat zonesfiltering,connectedoperators,andfilters by reconstruction.IEEE Trans.Image Proc.,4:1153–1160,1995.[11]J.Serra.Image Analysis and Mathematical Morphology,vol-ume1.Academic Press,New York,2edition,1982. [12]K.Sivakumar,M.J.Patel,N.Kehtarnavaz,Y.Balgu-runathan,and E.R.Dougherty.A constant time algorithm for erosions/dilations with applications to morphological texture feature computation.Real-Time Imaging,6:223–239,2000.[13] E.F.Stoermer and J.P.Smol.The Diatoms:Applications forthe Environmental and Earth Sciences.Cambridge Univer-sity Press,1999.[14] E.R.Urbach and M.H.F.Wilkinson.Shape-only granu-lometries and grey-scale shapefilters.In Proceedings of the ISMM2002,pages305–314,2002.。