htmlparser

bs4解析xml文件,制作xml文件

bs4解析xml⽂件,制作xml⽂件使⽤BS4解析XML⽂件⽤法1. html.parserfrom bs4 import BeautifulSoupsoup = BeautifulSoup(html, "html.parser")两个参数:第⼀个参数是要解析的html⽂本,第⼆个参数是使⽤那种解析器,对于HTML来讲就是html.parser,这个是bs4⾃带的解析器2.soup = BeautifulSoup(html, "lxml")查找所有符合条件的标签a)使⽤tag查找soup.find_all('b')b)正则表达式查找soup.find_all(pile("^b"))c)按列表中提供的tab查找soup.find_all(["a", "b"])d)实例解析html将dt中class和ul中text找到放⼈字典中b.html内容:<div class="MuneDown"><dl><dt class="menuListBox"><ul class="a"> xxx</ul></dt><dd class="adMuneBox validateArea" _bamboo_rep_transid="150166001-1" _bamboo_rep_menuid="" modulecode="module_nav_myunicom" _bamboo_rep_productlink="" validatetype="module_logo_area_2" rowrecordid="b6303d42ec84468 </dl></div></div>View Code代码如下:#!/usr/bin/env python#coding:utf-8import osimport sysimport lxmlfrom bs4 import BeautifulSoupxml_file = sys.argv[1]with open(xml_file, 'r') as f:xml = f.read()soup = BeautifulSoup(xml, 'lxml')link_content = soup.select("div[class='MuneDown']")result = {}for item in link_content:dt = item.dt["class"][0]ul = item.select("ul[class='a']")[0].get_text()print("dt:{}".format(dt))print("ul: {}".format(ul))result[dt] = ulprint(result)View Code运⾏结果:dt:menuListBoxul: xxx{'menuListBox': ' xxx'}参考链接:第⼆部分制作lxml⽂件代码⽰例:#!/usr/bin/env python#coding:utf-8from xml.dom.minidom import Documentimport xml.dom.minidomdoc = Document() #创建DOM⽂档对象Object = doc.createElement('Objects')doc.appendChild(Object)label_name='person'label=15label_attribute = ("name", "lala")xmin=207ymin=106xmax=489ymax=381score=0.99566object_name = doc.createElement(label_name)#object_name.setAttribute('物体类别',label_name)#设置命名空间Object.appendChild(object_name)object_label =doc.createElement('label')object_label.setAttribute(label_attribute[0],label_attribute[1])object_label_text = doc.createTextNode(str(label)) #元素内容写⼊object_label.appendChild(object_label_text)object_name.appendChild(object_label)object_xmin =doc.createElement('xmin')object_xmin_text = doc.createTextNode(str(xmin)) #元素内容写⼊object_xmin.appendChild(object_xmin_text)object_name.appendChild(object_xmin)object_ymin =doc.createElement('ymin')object_ymin_text = doc.createTextNode(str(ymin)) #元素内容写⼊object_ymin.appendChild(object_ymin_text)object_name.appendChild(object_ymin)object_xmax =doc.createElement('xmax')object_xmax_text = doc.createTextNode(str(xmax)) #元素内容写⼊object_xmax.appendChild(object_xmax_text)object_name.appendChild(object_xmax)object_ymax =doc.createElement('ymax')object_ymax_text = doc.createTextNode(str(ymax)) #元素内容写⼊object_ymax.appendChild(object_ymax_text)object_name.appendChild(object_ymax)object_score= doc.createElement('score')object_score_text = doc.createTextNode(str(score)) #元素内容写⼊object_score.appendChild(object_score_text)object_name.appendChild(object_score)f = open('parameter.xml','w')doc.writexml(f,indent = '\t',newl = '\n', addindent = '\t',encoding='utf-8') f.close()⽣成xml⽂件如下<?xml version="1.0" encoding="utf-8"?><Objects><person><label name="lala">15</label><xmin>207</xmin><ymin>106</ymin><xmax>489</xmax><ymax>381</ymax><score>0.99566</score></person></Objects>参考链接:。

HTMLParser提取网页超链接研究

Ke r s HT y wo d : ML as r; a e a ay i i f r ain e t c o P r e p g n lss; n o m t xr t n o ai

关键 词 : H ML asr T P r ;页面 解析 ; 息提 取 e 信

HTMI a s rE ta tW e a e . re x r c b P g P

LN n u A GF  ̄ e

(c ol f noma o cec n n ier g, ca nvr t o hn Q n do 2 6 o ) Sh o o fr t nSineadE gn e n O enU iesy f ia, ig a 6 Jo I i i i C

研 究的热点 D I 用 H ML a e 5对 We 。利 T P r r[ s 1 b页 面 内 容 进 行 解

析 [ 6 1 以过 滤掉垃圾信息 ,提 取出网页超链 接 ,从而获 取 ,可

有用的信息。

2 信息提 取

为了更好地实现 H ML asr T P r 提取 网页超链接 ,下面主要 e 介绍一下 H M P r r T L as 的应用以及 网页超链 接提取算法。 e

,

efc v l c e s t t e e h p ri k s a mp ra t se e n n .W e p o o e t e u e o p n s u c o l t f t ey a c s o h s y el s a n i o t n tp i W b mi ig ei n n r p s h s fo e o r e to s o a he e W e a e HT c iv b p g ML a s rp re e ta tw b p g y e l k i r e o g i s f li oma in f r u t e e eo me t P r e a s , x r c e a e h p r n n o d rt an u e u n r t o r rd v l p/iai / k一 u 0一 c bn一 3 w n d 66 1 /r e b 2 n r s d 6 1 r2- 4 - 2一 i— mo d b ej b

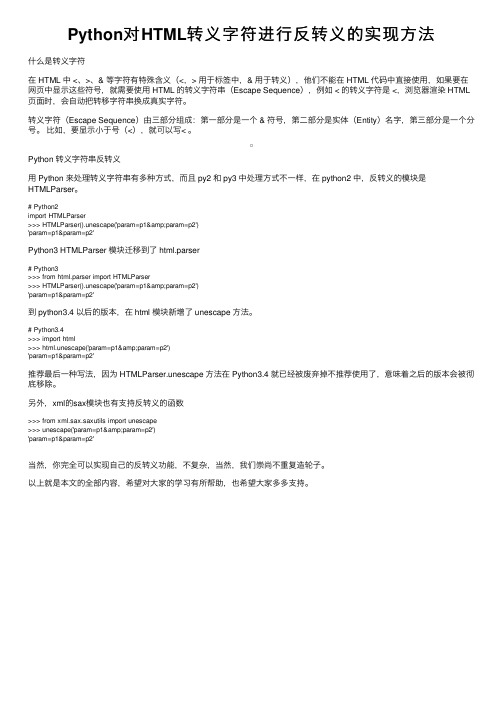

Python对HTML转义字符进行反转义的实现方法

Python对HTML转义字符进⾏反转义的实现⽅法什么是转义字符在 HTML 中 <、>、& 等字符有特殊含义(<,> ⽤于标签中,& ⽤于转义),他们不能在 HTML 代码中直接使⽤,如果要在⽹页中显⽰这些符号,就需要使⽤ HTML 的转义字符串(Escape Sequence),例如 < 的转义字符是 <,浏览器渲染 HTML 页⾯时,会⾃动把转移字符串换成真实字符。

转义字符(Escape Sequence)由三部分组成:第⼀部分是⼀个 & 符号,第⼆部分是实体(Entity)名字,第三部分是⼀个分号。

⽐如,要显⽰⼩于号(<),就可以写< 。

Python 转义字符串反转义⽤ Python 来处理转义字符串有多种⽅式,⽽且 py2 和 py3 中处理⽅式不⼀样,在 python2 中,反转义的模块是HTMLParser。

# Python2import HTMLParser>>> HTMLParser().unescape('param=p1&param=p2')'param=p1¶m=p2'Python3 HTMLParser 模块迁移到了 html.parser# Python3>>> from html.parser import HTMLParser>>> HTMLParser().unescape('param=p1&param=p2')'param=p1¶m=p2'到 python3.4 以后的版本,在 html 模块新增了 unescape ⽅法。

# Python3.4>>> import html>>> html.unescape('param=p1&param=p2')'param=p1¶m=p2'推荐最后⼀种写法,因为 HTMLParser.unescape ⽅法在 Python3.4 就已经被废弃掉不推荐使⽤了,意味着之后的版本会被彻底移除。

domparser解析html例子

在学习DOMParser解析HTML的例子之前,让我们先了解一下DOMParser的定义和作用。

DOMParser是一种在JavaScript中使用的解析器,用于将字符串解析为DOM文档。

它可以将一个字符串表示的XML或HTML源代码解析成一个DOM Document对象。

通过DOMParser,我们可以方便地访问和操作解析后的DOM文档,实现对HTML或XML内容的动态修改和操作。

现在,让我们以一个简单的例子来说明DOMParser的使用和具体效果。

假设我们有一个包含HTML源代码的字符串,如下所示:```html<html><body><h1>DOMParser Example</h1><p>This is a simple example of using DOMParser to parse HTML.</p></body></html>```现在,我们需要使用DOMParser来解析上述的HTML字符串,并获取其中的标题和段落内容。

我们可以使用以下JavaScript代码来实现:```javascriptconst htmlString = `<html><body><h1>DOMParser Example</h1><p>This is a simple example of using DOMParser to parse HTML.</p></body></html>`;const parser = new DOMParser();const doc = parser.parseFromString(htmlString, 'text/html');const title = doc.querySelector('h1').textContent;const paragraph = doc.querySelector('p').textContent;console.log('Title:', title);console.log('Paragraph:', paragraph);```上述代码首先定义了一个包含HTML源代码的字符串htmlString,然后利用DOMParser的parseFromString方法将其解析为一个DOM Document对象doc。

parser中文API以及 示例

中文APIpackage parser;import java.io.BufferedReader;import java.io.BufferedWriter;import java.io.FileWriter;import java.io.IOException;import java.io.InputStream;import java.io.InputStreamReader;import .MalformedURLException;import .URL;/*** 基本能实现网页抓取,不过要手动输入URL 将整个html内容保存到指定文件** @author chenguoyong**/public class ScrubSelectedWeb {private final static String CRLF = System.getProperty("line.separator");/*** @param args*/public static void main(String[] args) {try {URL ur = new URL("http://10.249.187.199:8083/injs100/");InputStream instr = ur.openStream();String s, str;BufferedReader in = new BufferedReader(new InputStreamReader(instr));StringBuffer sb = new StringBuffer();BufferedWriter out = new BufferedWriter(new FileWriter("D:/outPut.txt"));while ((s = in.readLine()) != null) {sb.append(s + CRLF);}System.out.println(sb);str = new String(sb);out.write(str);out.close();in.close();} catch (MalformedURLException e) {e.printStackTrace();} catch (IOException e) {e.printStackTrace();}}}基本能实现网页抓取,不过要手动输入URL,此外没有重构。

正则表达式%2B_HTMLParser使用详解-2010-03-21

“勉强模式”限定符:

在限定符之后添加问号(?),则使限定符成为“勉强模式”。勉强模式的限定符,总 是尽可能少的匹配。如果之后的表达式匹配失败,勉强模式也可以尽可能少的再匹 配一些,以使整个表达式匹配成功。

限定符

{m, n}? {m, }? ??

说明

表达式尽量只匹配m次,最多重复n次。 表达式尽量只匹配m次,最多可以匹配任意次。 表达式尽量不匹配,最多匹配1次,相当于 {0, 1}?

转义符

\a \f \n \r \t \v

说明

响铃符 = \x07 换页符 = \x0C,换页符 响铃符 = \x07,换行 („\u000A‟) 回车符 = \x0D,回车 („\u000D‟) 制表符 = \x09,间隔 („\u0009‟) 垂直制表符 = \x0B

\e \x20 \u002B \x{20A060}

Java正则表达式入门 + HTMLParser使用

详解

一、 Java正则表达式入门 众所周知,在程序开发中,难免会遇到需要匹配、查找、 替换、判断字符串的情况发生,而这些情况有时又比较复杂, 如果用纯编码方式解决,往往会浪费程序员的时间及精力。 因此,学习及使用正则表达式,便成了解决这一矛盾的 主要手段。 大家都知道,正则表达式是一种可以用于模式匹配和替换的 规范,一个正则表达式就是由普通的字符(例如字符a到z) 以及特殊字符(元字符)组成的文字模式,它 用以描述在查 找文字主体时待匹配的一个或多个字符串。正则表达式作为 一个模板,将某个字符模式与所搜索的字符串进行匹配。 自从jdk1.4推出java.util.regex包,就为我们提供了很好的 JAVA正则表达式应用平台。

ESC 符 = \x1B, Escape 使用两位十六进制表示形式,可与该编号的字符匹配 使用四位十六进制表示形式,可与该编号的字符匹配 使用任意位十六进制表示形式,可与该编号的字符匹配

使用HtmlParser解析HTML(C#版)

使⽤HtmlParser解析HTML(C#版)本⽂介绍了.net 版的⼀个HTMLParser⽹页解析开源类库(Winista.HTMLParser)的功能特性、⼯作原理和使⽤⽅法。

对于使⽤.net进⾏Web信息提取的开发⼈员进⾏了⼀次HTMLParser的初步讲解。

应⽤实例将会在⽇后的⽂中介绍,敬请关注。

⼀、背景知识HTMLParser原本是⼀个在sourceforge上的⼀个Java开源项⽬,使⽤这个Java类库可以⽤来线性地或嵌套地解析HTML⽂本。

他的功能强⼤和开源等特性吸引了⼤量Web信息提取的⼯作者。

然⽽,许多.net开发者朋友⼀直在寻找⼀种能在.net中使⽤的HTMLParser类库,笔者将介绍Winista.HTMLParser类库,对⽐于其他原本数量就⾮常少的.net版HTMLParser类库,Winista的版本的类库结构可以说更接近于原始Java版本。

该类库⽬前分为Utltimate、Pro、Lite和Community四个版本,前三个版本都是收费的。

只有Community版本可以免费下载并查看所有的源码。

当前Community最新版本1.8 下载。

该版本的类库⽂档下载。

⼆、功能和特性1.可以在任何.net语⾔中使⽤(C#,,J#等)2.可以解析⼏乎所有的Html标签,并且可以通过标签类别、属性或正则表达式来搜索标签。

有些甚⾄在Java版本中⽆法⽀持的标签也在这个版本中得到了⽀持。

3.设置可扩展的过滤器来过滤结果集中不需要的标签。

4.⾼性能的API接⼝使得你能处理许多常见的问题,如:哪些是页⾯中的外部链接?哪些是图⽚?哪些是不同的表格?页⾯中有错误的链接吗等等问题。

5.⼀个基于Http协议引擎的配置⽂件使得你能通过⼀个指定的URL地址来获得该页⾯内容。

该爬⾍可以遵循robot.txt协议⽂件来获得组织和允许访问的列表。

6.Http协议引擎能够完整地处理来⾃任何站点的反馈。

三、词法分析的⼯作原理HTMLParser的词法分析器对HTML进⾏了4级封装,从低级到⾼级的顺序为:ParserStream、Source、Page、Lexer。

基于HTML Parser的BBS信息抽取系统的设计与实现

P re 的一些基础类 , 中最 为重要 的是 P re 。P re asr 其 a sr asr

是 HT asr ML P r 的最 核心的类。og hmlasrb a s e r . t p r .en e 包对 V s o 和 F l r ii r t i e 的方法进行 了封装 , t 定义 了针对一 些常用 HT ML元素操作 的 Jv B a , a a en 简化对常用元素 的 提取操 作 。o g. t p r e . o e 包 定义 了基 础的 r h ml a s r n d s nd, o e 包括 : srcNo e e r No e a No e Ab ta t d 、R ma k d 、T g d 、 T x No e 。o g h ml as rt g 包 定义了 HT et d 等 r . t p re . s a ML P r e 进行解析 的网页 中的各种标签 【。 asr l 1

定 向采集各 BB S上开放 数据信 息源 , 将数据 经过分析 、 整理后得到作者信 息、发帖信息 、回复数 、正文 内容等 信息 , 并存人 数据 库 , 以备后 期查询 等用户 应用 。 BBS信 息抽 取 系统 主要 模 块结 构包 括 4个 : 息 信 抓取 模块 、信 息 解析 模块 、数 据库 存 储模 块 、结果 显

以 B S站点 URL为输入 , 此过程 中, B 在 加入正则 匹配方

法 , 到各个 网页 信息 , 得 交给信 息解析 模块 。信 息抓 取 模块分 为三部分 : 版块 信息抓取 部分 、帖子基 本信息 抓

取部 分 、正 文信 息抓取 部分 。

版块信息抓取部分根据输入的站点 URL 通过 HT , ML

3 2 信 息解析模块 .

HTMLParser使用详解

HTMLParser使⽤详解声明:本⼈来⾃转载/doc/8576448f6529647d27285286.html /HTMLParser具有⼩巧,快速的优点,缺点是相关⽂档⽐较少(英⽂的也少),很多功能需要⾃⼰摸索。

对于初学者还是要费⼀些功夫的,⽽⼀旦上⼿以后,会发现HTMLParser的结构设计很巧妙,⾮常实⽤,基本你的各种需求都可以满⾜。

这⾥我根据⾃⼰这⼏个⽉来的经验,写了⼀点⼊门的东西,希望能对新学习HTMLParser的朋友们有所帮助。

(不过当年⾼考本⼈语⽂只⽐及格⾼⼀分,所以⽂法⽅⾯的问题还希望⼤家多多担待)HTMLParser的核⼼模块是org.htmlparser.Parser类,这个类实际完成了对于HTML页⾯的分析⼯作。

这个类有下⾯⼏个构造函数:public Parser ();public Parser (Lexer lexer, ParserFeedback fb);public Parser (URLConnection connection, ParserFeedback fb) throws ParserException;public Parser (String resource, ParserFeedback feedback) throws ParserException;public Parser (String resource) throws ParserException;public Parser (Lexer lexer);public Parser (URLConnection connection) throws ParserException;和⼀个静态类public static Parser createParser (String html, String charset);对于⼤多数使⽤者来说,使⽤最多的是通过⼀个URLConnection或者⼀个保存有⽹页内容的字符串来初始化Parser,或者使⽤静态函数来⽣成⼀个Parser对象。

Python中的HTML解析技巧

Python中的HTML解析技巧Python中的HTML解析技巧随着Web应用的不断发展和普及,HTML作为Web页面的基础语言,已经成为了Web开发中不可或缺的一部分。

无论是搜索引擎爬虫、数据挖掘还是Web页面开发,对HTML的解析都是必不可少的。

在Python 中,有许多强大的HTML解析库,比如BeautifulSoup、lxml、pyquery 等,这些库能够轻松地从HTML文档中抽取出我们需要的信息,为Python开发者的工作带来了极大的便利。

本文将介绍Python中的HTML解析技巧,以及常用的HTML解析库。

HTML基本语法在介绍HTML解析技巧前,需要先了解HTML基本语法。

HTML是一种标记语言,由一些标记组成,它们可以在文本中定义结构和样式。

HTML文档主要由以下4个基本部分组成:1. Doctype声明:该部分用于告诉浏览器该HTML文件使用的标准,一般为<!DOCTYPE html>。

2. HTML标签:该部分用于定义文档的根元素,一般为<html>。

3. Head标签:该部分用于定义文档的头部信息,例如标题、样式表等,一般为<head>。

4. Body标签:该部分用于定义文档的内容,一般为<body>。

除此之外,HTML还有许多其他标签,例如文本标签、图像标签、表格标签、链接标签等等,这里不再赘述。

Python中的HTML解析技巧Python中有许多强大的HTML解析库,能够将HTML文档转化为Python程序可以读取和处理的数据结构,为我们提供了极大的便利。

本章将介绍Python中常用的HTML解析库以及其用法。

1. BeautifulSoup库BeautifulSoup是Python中最为流行的HTML解析库之一,它能够将HTML文档转化为Python中的对象,方便进行数据的抽取和处理。

以下是使用BeautifulSoup对HTML进行解析的基本步骤:1.安装BeautifulSoup库pip install beautifulsoup42.导入BeautifulSoup库from bs4 import BeautifulSoup3.解析HTML文档soup = BeautifulSoup(html_doc, 'html.parser')其中,html_doc为HTML文档的字符串表示。

delphi htmlparser使用方法

delphi htmlparser使用方法# Delphi HTMLParser 使用方法Delphi HTMLParser 是一个强大的组件,用于解析HTML 文档,提取所需的数据,或者对HTML 文档进行操作。

以下将详细介绍Delphi HTMLParser 的使用方法。

## 一、准备工作在使用Delphi HTMLParser 之前,需要确保以下准备工作已完成:1.下载并安装Delphi HTMLParser 组件。

2.在Delphi 项目中引用HTMLParser 单元。

## 二、创建HTMLParser 实例首先,需要创建一个`THTMLParser` 类的实例:```delphiprocedure TForm1.Button1Click(Sender: TObject);varHTMLParser: THTMLParser;beginHTMLParser := THTMLParser.Create;// 其他代码end;```## 三、加载HTML 文档可以通过以下方式加载HTML 文档:1.从字符串加载:```delphiHTMLParser.LoadFromStream(TStringStream.Create("<html>...</ht ml>"));```2.从文件加载:```delphiHTMLParser.LoadFromFile("C:pathtoyourfile.html");```## 四、解析HTML 文档加载HTML 文档后,可以通过以下方法开始解析:```delphiHTMLParser.Execute;```## 五、提取数据在解析过程中,可以通过以下方式提取所需的数据:1.使用`OnElement` 事件处理标签:```delphiprocedure TForm1.HTMLParserOnElement(Sender: TObject; Tag: TTag);beginif = "div" thenMemo1.Lines.Add(Tag.OuterHTML);end;```2.使用`OnTextNode` 事件处理文本节点:```delphiprocedure TForm1.HTMLParserOnTextNode(Sender: TObject; TextNode: TTextNode);beginMemo1.Lines.Add(TextNode.Text);end;```## 六、遍历标签属性如果需要遍历标签的属性,可以使用以下代码:```delphiprocedure TForm1.HTMLParserOnElement(Sender: TObject; Tag: TTag);varI: Integer;beginfor I := 0 to Tag.AttributeCount - 1 dobeginMemo1.Lines.Add(Tag.AttributeName[I] + "=" +Tag.AttributeValue[I]);end;end;```## 七、修改HTML 文档如果需要对HTML 文档进行修改,可以在`OnElement` 事件中进行如下操作:```delphiprocedure TForm1.HTMLParserOnElement(Sender: TObject; Tag: TTag);beginif = "div" thenbeginTag.AddAttribute("class", "newClass");Tag.InnerHTML := "New Content";end;end;```## 八、保存修改后的HTML 文档将修改后的HTML 文档保存到文件或字符串:1.保存到文件:```delphiHTMLParser.SaveToFile("C:pathtoyourfile.html");```2.保存到字符串:```delphiMemo1.Text := HTMLParser.Document.OuterHTML;```以上就是Delphi HTMLParser 的使用方法。

HTMLParser-API

CssSelectorNodeFilter 接受所有支持CSS2选择器的节点.

HasAttributeFilter 接受所有否含有某个属性(还可以设置该属性的值)的节点.

HasChildFilter 接受所有含有子节点符合该Filter的节点.

RegexFilter 接受所有满足指定正则表达式的String Nodes.

StringFilter 接受所有满足指定String的String Nodes.

TagNameFilter 接受所有满足指定Tag名的TagNodes.

XorFilter 相当于一个XOR操作符,接受所有只满足其中1个Filter的节点.�

HasParentFilter 接受所有含有父节点符合该Filter的节点.

HasSiblingFilter 接受所有含有兄弟节点符合该Filter的节点.

IsEqualFilter 接受所有和某个特定的节点相同的节点.

LinkRegexFilter 接受所有linkTag标签的link值.匹配给定的正则表达式的节点.

LinkStringFilter 接受所有linkTag标签的link值,匹配给定的字符串的节.

NodeClassFilter 接受所有接受指定的类的节点.

NotFilter 接受所有不符合Filter的节点.

OrFilter 相当于一个AND操作符,接受所有满足两个Filter中任意一个的节点.

Htmlparser使用入门

使用Htmlparser生成Dom树一.H tmlparser简介什么是Htmlparser?顾名思义Htmlparser是一种解析分析提取Html的工具。

如果想抓取网页的数据有什么办法,正则表达式?字符串截取?但是如果网站改版这些都将不好使用。

Htmlparser可以很好的对html标签进行操作。

➢文本信息抽取,例如对html进行有效信息搜索➢链接提取,用于自动给页面的链接文本加上链接的标签➢资源提取,例如对一些图片、声音的资源的处理这样如果使用Htmlparser将Html字符串生成Dom树就可以对Dom树进行操作,也不用担心网站改版,嘿嘿,是不是很方便?二.H tmlparser生成Dom树Htmlparser中的节点分为3种:TextNode,TagNode,RemarkNode。

(1)在生成Dom树时首先需要根据url获取Html字符串,如何获取Html 字符此处不在描述(在获取Html字符串时,如果解码方式不正确将产生乱码)。

(2)新建一个XmlDocument对象,并添加根节点“root”。

(3)根据Html字符串生成一个parser对象(代码1),生成NodeFilter 对象filter(代码2)。

(4)根据parser对象的Parser(NodeFilter filter)方法可以获取到需要过滤的节点集合NodeList。

(5)接下来就可以使用递归向Xml添加Dom节点了。

循环NodeList,将节点转成ITag,判断ITag不为空并且ITag不是结束标签(IsEndTag),将ITag的标签名称(TagName)添加在Xml上还可以设置节点的属性(style、with…),再判断ITag的子字节点(Children)是否为空,如果不为空,判断ITag的FirstChild是不是TextNode节点并且节点名称不是“script"、“style”,将ITag的FirstChild文本ToPlainTextString添加在Xml节点上.获取当前ITag的子节点(Children),如果不为空递归。

基于HTMLParser的Web文献信息提取

基于HTMLParser的Web文献信息提取摘要:基于HTMLParser对网页进行解析,可抽取标签间的Link、image、meta 和title 等信息。

使用HTMLParser来提取Web文献中的题名、关键字、摘要、作者、来源等信息,清洗后存入MySql 数据库当中,以备后续数据挖掘使用。

对此进行了论述。

关键词:HTMLParser;Web文献;信息提取大量的科研项目,每年都会有数以万计的文献产生。

随之而来的问题是如此多的文献数据让人难以消化,无法从表面上看出它们所蕴涵的有用信息,更不用说有效地指导进一步的工作。

如何从大量的数据中找到真正有用的信息成为人们关注的焦点,数据挖掘技术也正是伴随着这种需求从研究走向应用。

近年来,随着Web技术的快速普及和迅猛发展,使各种信息可以以非常低的成本在网络上获得。

本文就是要利用网络爬虫技术,对Web文献进行抓取数据,构建数据仓库,以挖掘出有用的信息。

1HTMLParser简介HTMLParser是一个纯的Java写的HTML解析的库,它不依赖于其它的Java库文件,主要用于改造或提取html。

它提供了接口,支持线性和嵌套HTML文本。

在实际的项目中只需要将htmlparser.jar 导入classpath中,就可以使用Htmlparser提供的API了。

HTMLParser项目主要可以用在以下两个方面:(1)信息提取。

文本信息抽取,例如对HTML进行有效信息搜索;链接提取,用于自动给页面的链接文本加上链接的标签;资源提取,例如对一些图片、声音的资源的处理;链接检查,用于检查HTML中的链接是否有效;页面内容的监控。

(2)信息转换。

链接重写,用于修改页面中的所有超链接;网页内容拷贝,用于将网页内容保存到本地;内容检验,可以用来过滤网页上一些令人不愉快的字词;HTML信息清洗,把本来乱七八糟的HTML信息格式化;转成XML格式数据。

HTMLParser由Node、AbstractNode 和Tag 来表达HTML。

beautifulsoup函数用法

beautifulsoup函数用法

BeautifulSoup 是一个 Python 库,用于从 HTML 或 XML 文件中提取数据。

它提供了一种易于使用的方法来操作和解析这些标记语言。

下面是一些常见的 BeautifulSoup 函数用法:

1. `BeautifulSoup(html_doc, 'html.parser')`: 这是创建 BeautifulSoup 对象的基本语法。

第一个参数是要解析的 HTML 或 XML 文档,第二个参数是解析器的名称。

2. `find_all(tag, attributes=None)`: 该函数用于查找文档中所有具有指定标签名的元素。

你可以通过提供可选的属性关键字参数来进一步限定查找条件。

3. `find(tag, attributes=None)`: 这是`find_all`的简化版本,它只返回文档中第一个找到的具有指定标签名和属性的元素。

4. `get_text()`: 该函数用于获取一个元素或多个元素的文本内容。

它将提取元素内部的文本,忽略任何嵌套的标签。

5. `attrs`: 这是一个属性字典,它允许你访问和修改元素的属性。

6. `decompose()`: 该函数用于从文档中删除一个元素及其子元素。

这些只是 BeautifulSoup 库的一些基本函数用法,还有许多其他函数和方法可用于处理文档、查找和修改元素、解析属性等。

具体的用法取决于你的具体需求和文档结构。

如果你需要更详细的信息,我建议你参考 BeautifulSoup 的官方文档,那里提供了更全面的函数参考和示例。

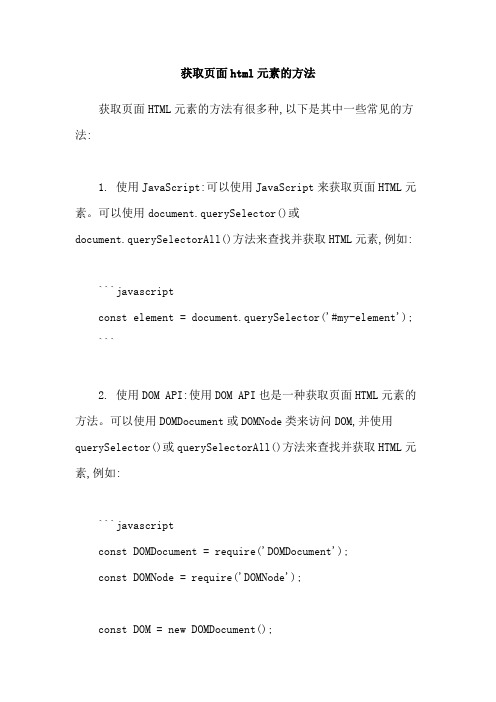

获取页面html元素的方法

获取页面html元素的方法获取页面HTML元素的方法有很多种,以下是其中一些常见的方法:1. 使用JavaScript:可以使用JavaScript来获取页面HTML元素。

可以使用document.querySelector()或document.querySelectorAll()方法来查找并获取HTML元素,例如:```javascriptconst element = document.querySelector('#my-element'); ```2. 使用DOM API:使用DOM API也是一种获取页面HTML元素的方法。

可以使用DOMDocument或DOMNode类来访问DOM,并使用querySelector()或querySelectorAll()方法来查找并获取HTML元素,例如:```javascriptconst DOMDocument = require('DOMDocument');const DOMNode = require('DOMNode');const DOM = new DOMDocument();DOM. loadHTML(<HTML content>);const element = DOM.getElementById('my-element');```3. 使用HTMLparser:使用HTMLparser也可以获取页面HTML元素。

HTMLparser是一个NodeTraversal接口,可以解析HTML文件并将其转换为Node对象。

可以使用HTMLparser的next()方法来查找并获取HTML元素,例如:```javascriptconst HTMLparser = require('htmlparser');const DOM = new DOMDocument();e(DOM);const element = HTMLparser.parse(<HTML content>);```4. 使用CSS选择器:使用CSS选择器也可以获取页面HTML元素。

C#下解析HTML的两种方法介绍

C#下解析HTML的两种⽅法介绍在搜索引擎的开发中,我们需要对Html进⾏解析。

本⽂介绍C#解析HTML的两种⽅法。

在搜索引擎的开发中,我们需要对⽹页的Html内容进⾏检索,难免的就需要对Html进⾏解析。

拆分每⼀个节点并且获取节点间的内容。

此⽂介绍两种C#解析Html的⽅法。

⽤.WebClient下载Web Page存到本地⽂件或者String中,⽤正则表达式来分析。

这个⽅法可以⽤在Web Crawler 等需要分析很多Web Page的应⽤中。

估计这也是⼤家最直接,最容易想到的⼀个⽅法。

转⾃⽹上的⼀个实例:所有的href都抽取出来:复制代码代码如下:using System;using ;using System.Text;using System.Text.RegularExpressions;namespace HttpGet{class Class1{[STAThread]static void Main(string[] args){.WebClient client = new WebClient();byte[] page = client.DownloadData("");string content = System.Text.Encoding.UTF8.GetString(page);string regex = "href=[\\\"\\\'](http:\\/\\/|\\.\\/|\\/)?\\w+(\\.\\w+)*(\\/\\w+(\\.\\w+)?)*(\\/|\\?\\w*=\\w*(&\\w*=\\w*)*)?[\\\"\\\']";Regex re = new Regex(regex);MatchCollection matches = re.Matches(content);System.Collections.IEnumerator enu = matches.GetEnumerator();while (enu.MoveNext() && enu.Current != null){Match match = (Match)(enu.Current);Console.Write(match.Value + "\r\n");}}}}利⽤ 解析Html。

PythonHTML解析器BeautifulSoup用法实例详解【爬虫解析器】

PythonHTML解析器BeautifulSoup⽤法实例详解【爬⾍解析器】本⽂实例讲述了Python HTML解析器BeautifulSoup⽤法。

分享给⼤家供⼤家参考,具体如下:BeautifulSoup简介我们知道,Python拥有出⾊的内置HTML解析器模块——HTMLParser,然⽽还有⼀个功能更为强⼤的HTML或XML解析⼯具——BeautifulSoup(美味的汤),它是⼀个第三⽅库。

简单来说,BeautifulSoup最主要的功能是从⽹页抓取数据。

本⽂我们来感受⼀下BeautifulSoup的优雅⽽强⼤的功能吧!BeautifulSoup安装BeautifulSoup3 ⽬前已经停⽌开发,推荐在现在的项⽬中使⽤BeautifulSoup4,不过它已经被移植到bs4了,也就是说导⼊时我们需要 import bs4 。

可以利⽤ pip 或者 easy_install 两种⽅法来安装。

下⾯采⽤pip安装。

pip install beautifulsoup4pip install lxml建议同时安装"lxml"模块,BeautifulSoup⽀持Python标准库中的HTML解析器(HTMLParser),还⽀持⼀些第三⽅的解析器,如果我们不安装它,则 Python 会使⽤ Python默认的解析器,lxml 解析器更加强⼤,速度更快,推荐安装。

创建对象安装后,创建对象:soup = BeautifulSoup(markup='html⽂件', 'lxml')格式化输出:soup.prettify()BeautifulSoup四⼤对象类型BeautifulSoup将复杂HTML⽂档转换成⼀个复杂的树形结构,每个节点都是Python对象,所有对象可以归纳为4种:Tag(标签)NavigableString(内容)BeautifulSoup(⽂档)Comment(注释)1.Tag类型即HTML的整个标签,如获取<title>标签:print soup.title#<title>The Dormouse's story</title>Tag有两个重要属性:name,attrs。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

htmlparser所有的filterhtmlparser所有的TagsHtmlparseUtil.java文章分类:Java编程该类并不是一个通用的工具类,需要按自己的要求实现,这里只记录了Htmlparse.jar包的一些用法。

仅此而已!详细看这里:/blog/704311Java代码1.import java.util.*;2.import org.htmlparser.Node;3.import org.htmlparser.NodeFilter;4.import org.htmlparser.Parser;5.import org.htmlparser.filters.AndFilter;6.import org.htmlparser.filters.HasAttributeFilter;7.import org.htmlparser.filters.NodeClassFilter;8.import org.htmlparser.filters.TagNameFilter;9.import org.htmlparser.tags.BodyTag;10.import org.htmlparser.tags.LinkTag;11.import org.htmlparser.util.NodeList;12.import org.htmlparser.util.ParserException;13.14./**15. * httpclient与htmlparse对网页的解析16. *17. * @author Administrator18. *19. */20.public class HtmlparseUtil {21. WebHttpClient util=new WebHttpClient();22. /**23. * 获得网页中的超链接,将href和text保存在Map中:map(href,text)24. * @param url25. * @param charset26. * @return27. */28. public Map<String, String> linkGet(String url, String charset) {29. String content=util.getWebContentByGet(url,charset);30. Map<String, String> linkMap = new HashMap<String, String>();31. try {32. //开始解析33. Parser parser = Parser.createParser(content, charset);34. // 过滤出<a></a>标签35. NodeFilter linkFilter = new NodeClassFilter(LinkTag.class);36. NodeList list = parser.extractAllNodesThatMatch(linkFilter);37. Node node = null;38. for (int i = 0; i < list.size(); i++) {39. node = list.elementAt(i);40. // 获得网页中的链接map(href,text)41. linkMap.put(((LinkTag) node).getLink(), this.processText(((LinkTag) node).getLinkText()));42. }43. } catch (ParserException e) {44. e.printStackTrace();45. }46. return linkMap;47. }48.49. /**50. * 获得网页<body></body>标签中的内容,保存在body中51. * @param url52. * @param charset53. * @return54. */55. public String bodyGet(String url, String charset) {56. String content=util.getWebContentByGet(url,charset);57. String body = "";58. try {59. Parser parser = Parser.createParser(content, charset);60. // 过滤<body></body>标签61. NodeFilter bodyFilter = new NodeClassFilter(BodyTag.class);62. NodeList list = parser.extractAllNodesThatMatch(bodyFilter);63. Node node = null;64. for (int i = 0; i < list.size(); i++) {65. node = list.elementAt(i);66. // 获得网页内容保存在content中67. body = ((BodyTag) node).getBody();68. }69. } catch (ParserException e) {70. e.printStackTrace();71. }72. return body;73. }74.75. /**76. * 过滤出class为term的<span>元素,并获得他们的文本77. * @param url78. * @param charset79. * @return80. */81. public Map<String,String> termGet(String url, String charset) {82. String content=util.getWebContentByGet(url,charset);83.84. Map<String, String> map = new HashMap<String, String>();85. try {86. //开始解析87. // 过滤出class为term的<span>元素88. Parser parser = Parser.createParser(content, charset);89. AndFilter filter =90. new AndFilter(new TagNameFilter("span"),new HasAttributeFilter("class","term"));91.92. Node node = null;93. NodeList nodeList = parser.parse(filter);94.95. for (int i = 0; i < nodeList.size(); i++) {96. node = nodeList.elementAt(i);97. map.put("term", node.toPlainTextString());98. }99. // 过滤出class为start-time的<span>元素100. Parser parser2 = Parser.createParser(content, charset); 101. AndFilter filter2 =102. new AndFilter(new TagNameFilter("span"),new HasAttribut eFilter("class","start-time"));103. NodeList nodeList2 = parser2.parse(filter2);104. for (int i = 0; i < nodeList2.size(); i++) {105. node = nodeList2.elementAt(i);106. map.put("start-time", node.toPlainTextString()); 107. }108. // 过滤出id为J_SingleEndTimeLabel的<span>元素109. Parser parser3 = Parser.createParser(content, charset); 110. AndFilter filter3 =111. new AndFilter(new TagNameFilter("span"),new HasAttribut eFilter("id","J_SingleEndTimeLabel"));112. NodeList nodeList3 = parser3.parse(filter3);113. for (int i = 0; i < nodeList3.size(); i++) {114. node = nodeList3.elementAt(i);115. map.put("end-time", node.toPlainTextString()); 116. }117.118. // 过滤出class为box post的<div>元素119. Parser parser4 = Parser.createParser(content, charset); 120. AndFilter filter4 =121. new AndFilter(new TagNameFilter("div"),new HasAttribute Filter("class","box post"));122. NodeList nodeList4 = parser4.parse(filter4);123. for (int i = 0; i < nodeList4.size(); i++) {124. node = nodeList4.elementAt(i);125. String temp=node.toPlainTextString().trim();126. temp=temp.substring(10,20).trim();127. map.put("pre-term", temp);128. }129.130. // 过滤出class为J_AwardNumber的<span>元素131. Parser parser5 = Parser.createParser(content, charset); 132.// AndFilter filter5 =133.// new AndFilter(new TagNameFilter("span"),new HasAttrib uteFilter("class","J_AwardNumber"));134. NodeList nodeList5 = parser5.parse(new HasAttributeFilter("class","J_AwardNumber"));135. StringBuffer buffer=new StringBuffer();136. for (int i = 0; i < nodeList5.size(); i++) {137. node = nodeList5.elementAt(i);138. buffer.append(","+node.toPlainTextString());139. }140. buffer.append("|");141.142. // 过滤出class为blue J_AwardNumber的<span>元素143. Parser parser6 = Parser.createParser(content, charset); 144.// AndFilter filter6 =145.// new AndFilter(new TagNameFilter("span"),new HasAttrib uteFilter("class","blue J_AwardNumber"));146. NodeList nodeList6 = parser6.parse(new HasAttributeFilter("class","blue J_AwardNumber"));147. for (int i = 0; i < nodeList6.size(); i++) {148. node = nodeList6.elementAt(i);149. buffer.append(node.toPlainTextString()+",");150. }151.152. map.put("numbers", buffer.toString());153. } catch (ParserException e) {154. // TODO Auto-generated catch block155. e.printStackTrace();156. }157.158. return map;159. }160.161. private String processText(String content){162. content=content.trim().replaceAll(" ", "");163.// content=content.replaceAll("<p>", "\n");164.// content=content.replaceAll("</TD>", "");165.// content=content.replaceAll("</div>", "");166.// content=content.replaceAll("</a>", "");167.// content=content.replaceAll("<a href=.*>", "");168. return content;169. }170.171. public static void main(String[] str) {172.173. String url="/lottery/order/lottery_dlt .htm?type=1";174. HtmlparseUtil util=new HtmlparseUtil();175. Map<String,String> map=util.termGet(url, "gb2312");176. System.out.println("term="+map.get("term"));//<span class="term ">第<em>10074</em>期</span>177. System.out.println("start-time="+map.get("start-time"));// 178. System.out.println("end-time="+map.get("end-time"));// 179. System.out.println("pre-term="+map.get("pre-term"));// 180. System.out.println("numbers="+map.get("numbers"));//181.182. /*183. Map<String, String> linkMap = util.linkGet(url, "gb2312"); 184. for (String s : linkMap.keySet()) {185. System.out.println(s + " = " + linkMap.get(s));186. //如果是个链接,则再获取它的<body>中的内容187.// if (s.startsWith("http")) {188.// util.bodyGet(s, "gb2312");189.// }190. }191. */192.193. }194.195.}。