基于HTMLParser视频信息抽取系统的设计与实现

视频内容识别 毕业设计

视频内容识别毕业设计视频内容识别毕业设计近年来,随着互联网的快速发展和智能设备的普及,人们对于视频内容的需求也越来越高。

然而,由于视频内容庞大且多样化,如何高效地对视频进行分类和识别成为了一个亟待解决的问题。

在这样的背景下,本文将探讨一种基于人工智能技术的视频内容识别方法,以实现视频内容的自动分类和标注。

首先,我们需要明确视频内容识别的目标。

视频内容识别的主要目的是通过对视频进行分析,识别出其中的关键信息,如人物、物体、场景等,并将其进行分类和标注。

这样一来,用户可以更加方便地搜索和浏览感兴趣的视频内容,提升其使用体验。

为了实现视频内容识别,我们可以借助计算机视觉和深度学习等人工智能技术。

首先,我们需要对视频进行分帧处理,将视频分解成一帧一帧的图像。

然后,利用图像处理算法,如边缘检测、颜色分析等,提取出每一帧图像的特征。

接下来,我们可以利用深度学习模型,如卷积神经网络(CNN)或循环神经网络(RNN),对这些特征进行学习和分类。

通过训练模型,我们可以使其具备识别不同视频内容的能力。

在视频内容识别的过程中,还需要解决一些挑战。

首先,视频内容庞大且多样化,需要处理大量的数据和场景。

这就要求我们设计高效的算法和模型,以提高识别的准确性和速度。

其次,视频内容可能包含复杂的动作和变化,如快速移动、光照变化等,这对于模型的鲁棒性提出了更高的要求。

此外,由于视频内容的多样性,我们还需要建立一个完善的标注数据集,以供模型的训练和评估。

为了验证视频内容识别方法的有效性,我们可以选择一些具有代表性的视频数据集进行实验。

通过与手动标注的结果进行对比,我们可以评估模型的准确性和性能。

此外,我们还可以通过用户调研和反馈等方式,了解用户对于视频内容识别的需求和满意度,以进一步改进模型和算法。

综上所述,视频内容识别是一个具有挑战性的问题,但也是一个充满机遇的领域。

通过利用人工智能技术,我们可以实现对视频内容的自动分类和标注,提升用户的使用体验。

Python网络爬虫中的在线视频与直播数据抓取

Python网络爬虫中的在线视频与直播数据抓取随着互联网和数字技术的快速发展,在线视频和直播已经成为人们日常娱乐和获取信息的重要方式。

Python作为一种强大的编程语言,可以用于实现网络爬虫,并能够帮助我们抓取在线视频和直播数据,为用户提供更好的观看体验和使用感受。

本文将介绍Python网络爬虫中抓取在线视频和直播数据的方法和技巧。

一、在线视频数据抓取在网络上,有许多平台提供了丰富多样的在线视频资源,如优酷、腾讯视频、爱奇艺等。

我们可以利用Python编写网络爬虫程序,来抓取这些平台上的视频数据。

1. 网页分析与解析首先,我们需要通过发送HTTP请求,获取目标网页的HTML源代码。

然后,利用Python中的解析库(如BeautifulSoup、lxml等)对源代码进行解析和提取,从而获取视频的相关信息,如标题、播放量、评论等。

2. URL拼接与下载接下来,我们需要从视频信息中提取出视频的URL链接。

有些平台可能会对视频链接进行加密或者隐藏,我们可以通过分析网页中的JavaScript脚本,来获取真实的视频链接。

获取到视频链接后,我们可以使用Python的下载库(如requests、urllib等)来进行视频的下载。

3. 视频解码与播放在下载完成后,视频文件通常是经过编码的,我们可以使用Python 的解码库(如ffmpeg、cv2等)来进行视频解码工作,并通过Python 的图形库(如opencv、pygame等)来进行视频的播放。

二、直播数据抓取与在线视频不同,直播数据是实时生成的,我们需要通过爬虫程序来实时抓取直播平台上的数据。

1. 弹幕数据抓取直播平台上,观众可以实时发送消息,这些消息通常以弹幕的形式出现在视频画面上。

我们可以通过网络爬虫程序抓取直播平台的弹幕数据,进而进行分析和处理。

2. 实时数据采集与展示除了弹幕数据,直播平台上还会提供其他实时数据,如在线观看人数、点赞数量等。

我们可以编写爬虫程序,实时获取这些数据,并通过可视化工具(如matplotlib、Tableau等)进行展示和分析。

基于HTMLParser的BT种子网页信息抽取

表 述 的 we b页面 经浏览 器分 析后 只适 合浏 览 , 不适 合 作 为一 种数 据交换 的方式 由机器 处理 。为 了有 效地 利 用 互联 网上 的信 息 , 息抽 取技术 应 运而 生 。 信

③ 包 含种 子信 息 的<tbe a l>块 中只有 一行 一列 ,

互 联 网上信 息 量 的激增 , 迫切 需 要一 些 自动 化 的 工具 帮助人 们 在海 量信息 源 中迅速 找到 真正需 要 的信

息 , 标 题 、 接 、mal 图 片 等 , HTML语 言 所 如 链 e i和 而

① 种 子 信息 网页 大部分趋 于结构化 ;

② 大部 分 的种 子信 息 内容 几 乎都集 中在 hml t 的

网页结 构 的完善 。 本 文 利 用 HTML asr 析 技 术 抽 取 相关 种 子 P re 解……; J 来自…一 相对路径结合 I 1 i

;

… …

k

—

节点内容特 征 I ;

J

—

0 … . HmlP r r . t as I e

… …

…

…

{ 数 库l 参 特征 一 一 !

2 1 信 息 抽 取 模 型 .

HTML asr HTML 1a e P re 、 C e n r等 , 主 要 功 能 是 信 息 其 的提 取和 信息 的转 化 。

目前 , 解析 器 的信息 提取 功能被 广 泛应用 , 过与 通

B 种 子 信 息 抽 取 模 型 主要 分 为信 息 定 位 、 构 T 结 预处 理 、 息抽 取 和信息 重构存 储 4个模 块 , 信 如图 1 所

对定位 的信 息块 进行 预处 理 ,总结 出抽取 规 则 ,实现 了B 种子 网页信 息抽取 , 以此建 立 了一种针 对 B 种 子 T 并 T

视频流处理中的内容识别和提取研究

视频流处理中的内容识别和提取研究随着互联网和移动设备的流行,视频流已经成为了人们获取信息和娱乐的主要渠道之一。

然而,视觉信息的处理和识别一直是计算机领域的一个难点问题。

随着计算机视觉和深度学习技术的不断发展,视频流处理中的内容识别和提取也获得了长足的进展。

一、视频流处理中的内容识别技术内容识别是指通过计算机视觉和机器学习的方法,对视频流中的内容进行自动识别和分类。

这些内容包括人物、场景、物体、语音等等。

一般来说,内容识别技术可以分为两个阶段:特征提取和模式识别。

特征提取是指通过对视频流进行图像处理和分析,提取出其中的关键特征。

这些特征可以包括色彩、纹理、形状、运动等等。

在接下来的模式识别阶段,这些特征会被输入到分类器中,来进行分类和识别。

目前,常用的特征提取方法包括手工设计的特征和基于深度学习的特征。

手工设计的特征通常基于图像的颜色、纹理和形状等视觉特征,然后结合传统的机器学习算法进行分类。

而基于深度学习的特征则采用神经网络来自动地学习图像特征,并通过几层网络来提取更高层次的语义特征。

二、视频流处理中的内容提取技术内容提取是指通过内容识别技术,从视频流中提取出有用的信息。

这些信息可以包括关键帧、文本、语音、人脸等等。

通过内容提取技术,我们可以把一段视频转化为含有各种元素的数据文件。

这些数据文件可以被用于搜索、分类、分析和编辑视频流。

目前,视频流中的内容提取技术主要包括图像检索、文本识别、语音识别和人脸识别等。

图像检索可用于从给定的视频流中检索出与给定图像相似的图像。

文本识别可用于识别视频流中的屏幕文本,并提供OCR效果。

语音识别可用于从视频流中提取出相应的语音信息。

人脸识别可用于从视频流中识别出特定人物的面部特征,并实现类似身份验证的作用。

三、视频流处理中的应用场景视频流处理中的内容识别和提取技术已经被广泛应用于各个领域。

其中一些应用场景包括:1. 视频搜索和推荐。

通过自动化的视频流处理和内容提取技术,可以实现更加准确和高效的视频搜索和推荐服务。

《2024年基于Python的电影数据爬取与数据可视化分析研究》范文

《基于Python的电影数据爬取与数据可视化分析研究》篇一一、引言随着互联网的迅猛发展,电影产业日益繁荣,大量的电影数据和观众反馈信息为我们提供了研究电影市场的机会。

本文旨在通过Python语言进行电影数据的爬取,并利用数据可视化技术对所获取的数据进行分析,以揭示电影市场的趋势和观众喜好。

二、电影数据爬取(一)爬虫技术概述Python语言因其强大的数据处理能力和丰富的库资源,成为电影数据爬取的首选工具。

本文将使用Python的requests库进行网页请求,BeautifulSoup库进行HTML解析,以及pandas库进行数据处理。

(二)数据来源与选择本文选择IMDb等知名电影网站作为数据来源,主要爬取电影名称、导演、演员、票房、评分等关键信息。

(三)爬虫实现过程首先,根据目标网站的HTML结构,编写相应的爬虫代码。

其次,利用requests库发送请求并获取网页内容。

接着,使用BeautifulSoup库解析HTML,提取所需数据。

最后,将数据保存为CSV文件或直接存入数据库。

三、数据预处理与清洗(一)数据预处理获取的原始数据需要进行预处理,如去除重复数据、转换数据格式等。

本文使用pandas库对数据进行预处理和清洗。

(二)缺失值与异常值处理针对缺失值和异常值,采用填充法、插值法或直接删除法进行处理。

对于存在问题的数据,需要分析原因并作出相应处理。

四、数据可视化分析(一)可视化工具选择本文选择matplotlib、seaborn和pyecharts等工具进行数据可视化。

这些工具提供了丰富的图表类型和交互功能,便于我们进行深入分析。

(二)数据分析与可视化展示1. 电影类型与票房分析:通过柱状图展示不同类型电影的票房情况,分析电影类型与票房的关系。

2. 导演与电影评分分析:利用饼状图展示高评分导演的分布情况,探究导演对电影评分的影响。

3. 演员与电影票房对比分析:通过散点图展示演员知名度与电影票房的关系,揭示演员对电影票房的贡献。

视频内容分析与检索系统设计与实现

视频内容分析与检索系统设计与实现摘要:随着网络视频的快速发展,设计和实现一种高效的视频内容分析与检索系统变得越来越重要。

本文将介绍一个视频内容分析与检索系统的设计与实现过程。

首先,我们将讨论系统的需求分析和功能设计,然后详细描述系统的架构和模块设计。

接着,我们将介绍视频内容分析的关键技术,并阐述系统中的视频特征提取、目标检测与跟踪、视频内容分类等模块的实现方法。

最后,我们将讨论系统的性能评估和未来的发展方向。

一、引言随着移动互联网和在线视频平台的迅猛发展,海量的视频数据被不断地产生和上传。

这些视频数据的内容往往是无结构、无标签的,因此如何高效地检索和分析视频内容成为了一个重要的研究课题。

视频内容分析与检索系统的设计与实现具有很大的实际应用价值。

二、系统需求分析与功能设计在设计视频内容分析与检索系统之前,我们首先需要对系统进行需求分析。

系统的主要功能包括视频内容的检索、目标检测与跟踪、视频内容分类等。

根据用户需求,系统还应具备直观的用户界面和友好的交互方式。

三、系统架构和模块设计系统的架构采用分布式的设计方案,包括前端用户界面、视频服务器、数据库服务器和分布式计算服务器等。

前端用户界面负责接收用户输入的查询请求,并将查询结果显示给用户。

视频服务器用于存储和管理海量的视频数据。

数据库服务器负责存储视频的元数据和索引信息。

分布式计算服务器用于处理视频内容分析的各个模块。

四、视频特征提取视频特征提取是视频内容分析的基础。

本系统采用多种特征提取方法,包括颜色直方图、文本特征、运动特征等。

在特征提取的过程中,我们需要解决视频帧间关联性的问题,以及提高特征的表达能力和鲁棒性。

五、目标检测与跟踪目标检测与跟踪是视频内容分析中的关键环节。

本系统采用深度学习的方法进行目标检测与跟踪,通过构建卷积神经网络模型,实现对视频中目标物体的准确检测和跟踪。

六、视频内容分类视频内容分类是根据视频内容特征将视频归类的过程。

本系统采用机器学习的方法进行视频内容分类,通过构建分类器模型,实现对视频的自动分类。

基于HTML Parser的BBS信息抽取系统的设计与实现

P re 的一些基础类 , 中最 为重要 的是 P re 。P re asr 其 a sr asr

是 HT asr ML P r 的最 核心的类。og hmlasrb a s e r . t p r .en e 包对 V s o 和 F l r ii r t i e 的方法进行 了封装 , t 定义 了针对一 些常用 HT ML元素操作 的 Jv B a , a a en 简化对常用元素 的 提取操 作 。o g. t p r e . o e 包 定义 了基 础的 r h ml a s r n d s nd, o e 包括 : srcNo e e r No e a No e Ab ta t d 、R ma k d 、T g d 、 T x No e 。o g h ml as rt g 包 定义了 HT et d 等 r . t p re . s a ML P r e 进行解析 的网页 中的各种标签 【。 asr l 1

定 向采集各 BB S上开放 数据信 息源 , 将数据 经过分析 、 整理后得到作者信 息、发帖信息 、回复数 、正文 内容等 信息 , 并存人 数据 库 , 以备后 期查询 等用户 应用 。 BBS信 息抽 取 系统 主要 模 块结 构包 括 4个 : 息 信 抓取 模块 、信 息 解析 模块 、数 据库 存 储模 块 、结果 显

以 B S站点 URL为输入 , 此过程 中, B 在 加入正则 匹配方

法 , 到各个 网页 信息 , 得 交给信 息解析 模块 。信 息抓 取 模块分 为三部分 : 版块 信息抓取 部分 、帖子基 本信息 抓

取部 分 、正 文信 息抓取 部分 。

版块信息抓取部分根据输入的站点 URL 通过 HT , ML

3 2 信 息解析模块 .

python parser用法

一、简介Python是一种流行的编程语言,被广泛用于数据分析、网络编程、机器学习等领域。

Python解释器(interpreter)是Python程序执行的引擎,而parser则是Python中用于解析和处理语法结构的重要工具之一。

本文将介绍Python中parser的用法,帮助读者更好地了解和使用parser模块。

二、 parser模块概述1. parser模块是Python标准库中的一个模块,用于解析和处理文本、代码等结构化的数据。

2. parser模块提供了一些常用的类和方法,能够帮助用户解析和处理HTML、XML、JSON等格式的数据。

3. parser模块的主要作用是将复杂的数据结构转换为Python对象,方便程序对其进行处理和分析。

三、 parser模块的基本用法1. 解析HTML使用parser模块可以方便地解析HTML文档,提取其中的标签和内容,进行数据分析和处理。

```pythonfrom html.parser import HTMLParserclass MyHTMLParser(HTMLParser):def handle_starttag(self, tag, attrs):print("Encountered a start tag:", tag)def handle_endtag(self, tag):print("Encountered an end tag :", tag)def handle_data(self, data):print("Encountered some data :", data)parser = MyHTMLParser()parser.feed('<html><head><title>Test</title></head>''<body><h1>Parse me!</h1></body></html>')```3. 解析JSON使用parser模块可以解析JSON格式的数据,将其转换为Python中的列表、字典等数据结构,便于程序进行处理和分析。

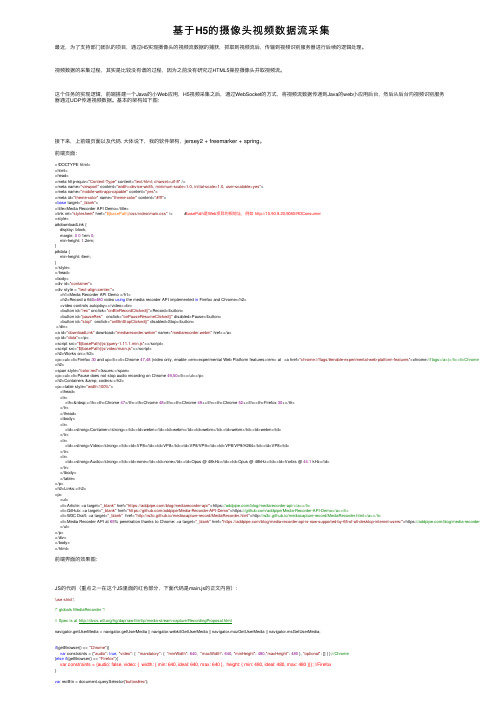

基于H5的摄像头视频数据流采集

基于H5的摄像头视频数据流采集最近,为了⽀持部门团队的项⽬,通过H5实现摄像头的视频流数据的捕获,抓取到视频流后,传输到视频识别服务器进⾏后续的逻辑处理。

视频数据的采集过程,其实是⽐较没有谱的过程,因为之前没有研究过HTML5操控摄像头并取视频流。

这个任务的实现逻辑,前端搭建⼀个Java的⼩Web应⽤,H5视频采集之后,通过WebSocket的⽅式,将视频流数据传递到Java的web⼩应⽤后台,然后从后台向视频识别服务器通过UDP传递视频数据。

基本的架构如下图:接下来,上前端页⾯以及代码. ⼤体说下,我的软件架构,jersey2 + freemarker + spring。

前端页⾯:<!DOCTYPE html><html><head><meta http-equiv="Content-Type" content="text/html; charset=utf-8" /><meta name="viewport" content="width=device-width, minimum-scale=1.0, initial-scale=1.0, user-scalable=yes"><meta name="mobile-web-app-capable" content="yes"><meta id="theme-color" name="theme-color" content="#fff"><base target="_blank"><title>Media Recorder API Demo</title><link rel="stylesheet" href="${basePath}/css/video/main.css" /> #basePath是Web项⽬的根地址,例如 http://10.90.9.20:9080/RDConsumer<style>a#downloadLink {display: block;margin: 00 1em 0;min-height: 1.2em;}p#data {min-height: 6em;}</style></head><body><div id="container"><div style = "text-align:center;"><h1>Media Recorder API Demo </h1><h2>Record a 640x480 video using the media recorder API implemented in Firefox and Chrome</h2><video controls autoplay></video><br><button id="rec" onclick="onBtnRecordClicked()">Record</button><button id="pauseRes" onclick="onPauseResumeClicked()" disabled>Pause</button><button id="stop" onclick="onBtnStopClicked()" disabled>Stop</button></div><a id="downloadLink" download="mediarecorder.webm" name="mediarecorder.webm" href></a><p id="data"></p><script src="${basePath}/js/jquery-1.11.1.min.js"></script><script src="${basePath}/js/video/main.js"></script><h2>Works on:</h2><p><ul><li>Firefox 30 and up</li><li>Chrome 47,48 (video only, enable <em>experimental Web Platform features</em> at <a href="chrome://flags/#enable-experimental-web-platform-features">chrome://flags</a>)</li><li>Chrome 49+</li></ul> <h2><span style="color:red">Issues:</span><p><ul><li>Pause does not stop audio recording on Chrome 49,50</li></ul></p><h2>Containers & codecs:</h2><p><table style="width:100%"><thead><tr><th> </th><th>Chrome 47</th><th>Chrome 48</th><th>Chrome 49+</th><th>Chrome 52+</th><th>Firefox 30+</th></tr></thead><tbody><tr><td><strong>Container</strong></td><td>webm</td><td>webm</td><td>webm</td><td>webm</td><td>webm</td></tr><tr><td><strong>Video</strong></td><td>VP8</td><td>VP8</td><td>VP8/VP9</td><td>VP8/VP9/H264</td><td>VP8</td></tr><tr><td><strong>Audio</strong></td><td>none</td><td>none</td><td>Opus @ 48kHz</td><td>Opus @ 48kHz</td><td>Vorbis @ 44.1 kHz</td></tr></tbody></table></p><h2>Links:</h2><p><ul><li>Article: <a target="_blank" href="https:///blog/mediarecorder-api/">https:///blog/mediarecorder-api/</a></li><li>GitHub: <a target="_blank" href="https:///addpipe/Media-Recorder-API-Demo">https:///addpipe/Media-Recorder-API-Demo</a></li><li>W3C Draft: <a target="_blank" href="http://w3c.github.io/mediacapture-record/MediaRecorder.html">http://w3c.github.io/mediacapture-record/MediaRecorder.html</a></li><li>Media Recorder API at 65% penetration thanks to Chrome: <a target="_blank" href="https:///blog/media-recorder-api-is-now-supported-by-65-of-all-desktop-internet-users/">https:///blog/media-recorder-api-is-now-su </ul></p></div></body></html>前端界⾯的效果图:JS的代码(重点之⼀在这个JS⾥⾯的红⾊部分,下⾯代码是main.js的正⽂内容):'use strict';/* globals MediaRecorder */// Spec is at /hg/dap/raw-file/tip/media-stream-capture/RecordingProposal.htmlnavigator.getUserMedia = navigator.getUserMedia || navigator.webkitGetUserMedia || navigator.mozGetUserMedia || navigator.msGetUserMedia;if(getBrowser() == "Chrome"){var constraints = {"audio": true, "video": { "mandatory": { "minWidth": 640, "maxWidth": 640, "minHeight": 480,"maxHeight": 480 }, "optional": [] } };//Chrome}else if(getBrowser() == "Firefox"){var constraints = {audio: false, video: { width: { min: 640, ideal: 640, max: 640 }, height: { min: 480, ideal: 480, max: 480 }}}; //Firefox}var recBtn = document.querySelector('button#rec');var pauseResBtn = document.querySelector('button#pauseRes');var stopBtn = document.querySelector('button#stop');var videoElement = document.querySelector('video');var dataElement = document.querySelector('#data');var downloadLink = document.querySelector('a#downloadLink');videoElement.controls = false;function errorCallback(error){console.log('navigator.getUserMedia error: ', error);}/*var mediaSource = new MediaSource();mediaSource.addEventListener('sourceopen', handleSourceOpen, false);var sourceBuffer;*/var mediaRecorder;var chunks = [];var count = 0;var wsurl = "ws://10.90.9.20:9080/RDConsumer/websocket"var ws = null;function createWs(){var url = wsurl;if ('WebSocket'in window) {ws = new WebSocket(url);} else if ('MozWebSocket'in window) {ws = new MozWebSocket(url);} else {console.log("您的浏览器不⽀持WebSocket。

基于HtmlParser的网页信息提取

兵 工 自动 化

网络与售息技市

Ne wo k a d I f r t n T c n l g t r n n o ma i e h o o y o

O. . u o a i n I A,t m t o

2 0 , 12 , . 0 7 Vo . 6 No 7

,

u e t e HTM LP r e o e t a t e h p ri kso a e n h s h a s rt x r h y e ln n p g s a d t e URL n o m a o n t e h me a e n l s s c r e p n i g i f r t n o h o i p g ,a a y i o r s o d n

摘要 :基 于 H ML asr HT T P re 对 ML进行 网 页解 析 ,可 抽取 标 签 间 的 Ln 、i g 、mea和 t e等信 息 。即使 用 ik ma e t i d Ht P re 来提取 网 页 当中的 超链接 信 息 ,提 取 首 页 URL信 息 ,分 析 所有 UR mlasr L对应 的页 面并提 取 L n ik信 息,信 息 清洗后 存 入 S QL数 据 库 当中 ,以备 后 续工 作使 用 。 关 键 词 :H mlasr t P re;信 息抽 取 ; 网页解析

20 0 7年第 2 6卷第 7期

文 章编 号 : 1 0 — 5 6 ( 0 7)0 0 101 0 6 17 2 0 7 0 4

基 于 Ht P re 网页信 息提 取 mlasr的

李 伟 ,黄颖 ( 西理 工 大学 信 息工 程学 院,江 西 赣 州 3 10 ) 江 40 0

A bsr t tac :W e A na ys sba e n HTM LPa s r c n e ta ln , ma e , b l i s d o r e . a x r i ks i g s me a a d t l n o m a o e we n t g , h ti , t n te i f r t n b t e a s t a s i i

Python中的HTML解析技巧

Python中的HTML解析技巧Python中的HTML解析技巧随着Web应用的不断发展和普及,HTML作为Web页面的基础语言,已经成为了Web开发中不可或缺的一部分。

无论是搜索引擎爬虫、数据挖掘还是Web页面开发,对HTML的解析都是必不可少的。

在Python 中,有许多强大的HTML解析库,比如BeautifulSoup、lxml、pyquery 等,这些库能够轻松地从HTML文档中抽取出我们需要的信息,为Python开发者的工作带来了极大的便利。

本文将介绍Python中的HTML解析技巧,以及常用的HTML解析库。

HTML基本语法在介绍HTML解析技巧前,需要先了解HTML基本语法。

HTML是一种标记语言,由一些标记组成,它们可以在文本中定义结构和样式。

HTML文档主要由以下4个基本部分组成:1. Doctype声明:该部分用于告诉浏览器该HTML文件使用的标准,一般为<!DOCTYPE html>。

2. HTML标签:该部分用于定义文档的根元素,一般为<html>。

3. Head标签:该部分用于定义文档的头部信息,例如标题、样式表等,一般为<head>。

4. Body标签:该部分用于定义文档的内容,一般为<body>。

除此之外,HTML还有许多其他标签,例如文本标签、图像标签、表格标签、链接标签等等,这里不再赘述。

Python中的HTML解析技巧Python中有许多强大的HTML解析库,能够将HTML文档转化为Python程序可以读取和处理的数据结构,为我们提供了极大的便利。

本章将介绍Python中常用的HTML解析库以及其用法。

1. BeautifulSoup库BeautifulSoup是Python中最为流行的HTML解析库之一,它能够将HTML文档转化为Python中的对象,方便进行数据的抽取和处理。

以下是使用BeautifulSoup对HTML进行解析的基本步骤:1.安装BeautifulSoup库pip install beautifulsoup42.导入BeautifulSoup库from bs4 import BeautifulSoup3.解析HTML文档soup = BeautifulSoup(html_doc, 'html.parser')其中,html_doc为HTML文档的字符串表示。

《2024年基于Python的电影数据爬取与数据可视化分析研究》范文

《基于Python的电影数据爬取与数据可视化分析研究》篇一一、引言随着互联网的迅猛发展,电影产业已经成为人们生活中不可或缺的一部分。

对于电影数据的获取与分析,不仅可以为观众提供更好的观影体验,还能为电影产业提供有价值的参考信息。

本文旨在研究基于Python的电影数据爬取与数据可视化分析方法,通过爬取电影数据,进行数据清洗、分析和可视化处理,从而为电影产业的决策提供科学依据。

二、电影数据爬取2.1 爬虫技术概述Python作为一种强大的编程语言,在数据爬取方面具有广泛的应用。

本文采用Python的爬虫技术,通过模拟浏览器行为,从电影相关网站中获取数据。

在爬取过程中,需要遵循网站的robots协议,避免对网站造成过大的负担。

2.2 数据来源与爬取策略本文选择多个电影相关网站作为数据来源,如豆瓣电影、时光网等。

针对不同网站的结构和特点,制定相应的爬取策略。

首先,通过分析网站的HTML结构,确定数据的存储位置;其次,利用Python的requests库发送HTTP请求,获取网页内容;最后,通过BeautifulSoup库解析网页内容,提取出所需的数据。

三、数据清洗与处理3.1 数据清洗在获取原始数据后,需要进行数据清洗工作。

主要包括去除重复数据、处理缺失值、纠正错误数据等。

通过数据清洗,可以保证数据的准确性和可靠性。

3.2 数据处理数据处理是数据分析的重要环节。

本文采用Python的pandas 库对数据进行处理,包括数据转换、数据聚合、数据筛选等。

通过数据处理,将原始数据转化为可用于分析的形式。

四、数据分析与可视化4.1 数据分析方法本文采用描述性统计、相关性分析、聚类分析等方法对电影数据进行分五、析。

描述性统计可以了解数据的整体情况;相关性分析可以揭示不同数据之间的关联性;聚类分析可以将电影进行分类,便于后续的分析和研究。

4.2 数据可视化数据可视化可以将复杂的数据以直观的方式展现出来,有助于更好地理解数据。

基于HTMLParser的Web文献信息提取

V 1 ONO2 o. 1 .

Fe . Ol b 2 l

基于 H TM P e L as r的 W e r b文 献 信 息 提 取

龚 真 平

( 南 交通 大 学 软 件 学 院 , 川 成 都 6 0 3 ) 西 四 1 0 1

摘 要 : 于 HT 基 ML asr 网 页进 行 解 析 , P re 对 可抽 取标 签 间的 ln 、 g 、 t a k i emea和 t l 信 息 。使 用 H ma ie等 t TMI asr re P

前 者 基 类 是 Co o i Ta , 子 类 含 B d T g等 2 mp s e g 其 t oy a 7个 子

近 年来 , 随着 We b技 术 的快 速 普 及 和 迅 猛 发 展 , 使各 种信 息 可 以 以非 常 低 的 成 本 在 网 络 上 获 得 。本 文 就 是 要

来提 取 W e b文献 中的 题 名 、 关键 字 、 要 、 者 、 源 等 信 息 , 洗 后 存 入 M y q 摘 作 来 清 S l数 据 库 当 中 , 备 后 续数 据 挖 掘 使 以

用 。 对 此 进 行 了论 述 。

关键 词 : HTML asrWe P re; b文 献 ; 息提 取 信

用的 1 0个 网 页 解 析 的 平 均 时 间 为 6 。最 长 的 居 然 达 到 s

2 S 而 且 运 行 的 时 候 还 要 考 虑 网 络 情 况 。 因 此 本 文 会 采 6,

用 多 线 程技 术 , 多个 解 析 爬 虫 同 时对 网页信 息进 行 爬 取 让

( 里 可 以采 用 hdo 这 a o p分 布 式 架 构 , 者 可 以 自行 研 究 ) 读 。 本 文 以 知 网 的 文 献 资 料 为 实 验 对 象 , 入 某 个 主 题 , 取 输 抓

Htmlparser使用入门

使用Htmlparser生成Dom树一.H tmlparser简介什么是Htmlparser?顾名思义Htmlparser是一种解析分析提取Html的工具。

如果想抓取网页的数据有什么办法,正则表达式?字符串截取?但是如果网站改版这些都将不好使用。

Htmlparser可以很好的对html标签进行操作。

➢文本信息抽取,例如对html进行有效信息搜索➢链接提取,用于自动给页面的链接文本加上链接的标签➢资源提取,例如对一些图片、声音的资源的处理这样如果使用Htmlparser将Html字符串生成Dom树就可以对Dom树进行操作,也不用担心网站改版,嘿嘿,是不是很方便?二.H tmlparser生成Dom树Htmlparser中的节点分为3种:TextNode,TagNode,RemarkNode。

(1)在生成Dom树时首先需要根据url获取Html字符串,如何获取Html 字符此处不在描述(在获取Html字符串时,如果解码方式不正确将产生乱码)。

(2)新建一个XmlDocument对象,并添加根节点“root”。

(3)根据Html字符串生成一个parser对象(代码1),生成NodeFilter 对象filter(代码2)。

(4)根据parser对象的Parser(NodeFilter filter)方法可以获取到需要过滤的节点集合NodeList。

(5)接下来就可以使用递归向Xml添加Dom节点了。

循环NodeList,将节点转成ITag,判断ITag不为空并且ITag不是结束标签(IsEndTag),将ITag的标签名称(TagName)添加在Xml上还可以设置节点的属性(style、with…),再判断ITag的子字节点(Children)是否为空,如果不为空,判断ITag的FirstChild是不是TextNode节点并且节点名称不是“script"、“style”,将ITag的FirstChild文本ToPlainTextString添加在Xml节点上.获取当前ITag的子节点(Children),如果不为空递归。

parsevideo解析

parsevideo解析解析视频是指根据视频内容和特征,通过运用相关的技术手段,将视频进行处理、分析、转换等操作的过程。

这其中包括视频的压缩、编码、解码、特征提取、目标检测等多个方面。

下面将对视频解析的相关内容进行解析和讨论。

1. 视频压缩和编码解码技术:视频压缩是指通过利用视频中的冗余信息,对视频进行有损或无损的压缩,从而减小视频的存储空间和传输带宽。

常用的视频压缩和编码标准包括H.264、H.265、AVC、MPEG-2等。

视频解码是指将视频进行解码为原始的像素数据,以供后续处理。

视频编码解码技术的发展不仅提高了视频的质量和压缩比,也降低了视频处理和传输的成本。

2. 视频特征提取技术:视频特征提取是指从视频中提取出能够代表视频内容和特征的信息。

常用的视频特征包括颜色特征、纹理特征、形状特征、运动特征等。

通过对视频进行特征提取,可以用于视频分类、目标跟踪、内容检索等应用。

视频特征提取技术的研究和应用,为视频内容的理解和分析提供了基础支持。

3. 视频目标检测和跟踪技术:视频目标检测是指在视频中自动检测出感兴趣的目标物体,常用的方法包括基于深度学习的目标检测算法(如Faster R-CNN、YOLO等)和基于传统特征的目标检测算法(如HOG、SIFT等)。

视频目标跟踪是指在视频序列中追踪目标物体的位置和运动轨迹,可以应用于视频监控、无人驾驶等领域。

视频目标检测和跟踪技术的研究和应用,提高了视频处理和应用的智能化和自动化水平。

4. 视频内容理解和分析技术:视频内容理解和分析是指对视频进行深层次的分析和理解,以获得更高级别的语义和语境信息。

视频内容理解和分析技术包括视频分割、事件检测、行为识别等。

通过对视频内容的理解和分析,可以实现视频智能检索、剪辑、重编、智能推荐等应用。

视频内容理解和分析技术的研究和应用,提升了视频处理和应用的人机交互和智能化能力。

5. 视频处理和应用平台技术:视频处理和应用平台技术是指为视频解析和应用提供软硬件环境和支持的平台技术。

基于python的电影票房爬取与可视化系统的设计与实现任务书-概述说明以及解释

基于python的电影票房爬取与可视化系统的设计与实现任务书-概述说明以及解释1.引言1.1 概述电影票房爬取与可视化系统的设计与实现旨在利用Python语言开发一个功能强大的系统,实现对电影票房数据的自动爬取和可视化展示。

随着信息技术的快速发展和互联网的普及,电影市场的竞争日益激烈,了解电影票房成为了制定市场策略和评估电影市场表现的重要依据。

本文的主要目标是通过设计和实现一个基于Python的系统,自动爬取各个电影票房的相关数据,并将这些数据通过可视化展示,使用户能够直观地了解电影票房的情况。

通过数据的可视化分析,用户可以更好地了解电影市场的趋势,为电影制片方、电影院和电影观众提供参考依据。

在系统的设计过程中,主要涉及两个核心模块:电影票房数据的爬取和数据的可视化展示。

首先,通过对电影票房相关网页的数据进行爬取,获取各个电影的票房信息。

然后,对获取的数据进行清洗和整理,以便更好地进行数据分析和可视化展示。

最后,通过设计合适的数据可视化方法和技术,将清洗后的数据以直观、易懂的方式展示给用户。

本文将以以下结构进行阐述:首先在引言部分给出全文的概述,明确文章的结构和目的。

接下来在正文部分,详细介绍电影票房爬取的实现步骤,包括如何爬取网页数据以及如何清洗和整理数据。

然后,探讨数据可视化系统的设计需求和架构设计。

最后,在结论部分评估实现效果,并提出系统优化方向。

通过本次设计与实现,我们希望能够为用户提供一个方便、高效的电影票房数据获取和分析工具,以帮助他们更加准确地评估电影市场的发展趋势和影片表现,进而提高决策的准确性和效果。

同时,也希望本文能够为其他开发者提供一些参考,以促进电影票房数据爬取与可视化系统的研究与应用。

1.2 文章结构文章结构本文共分为三个主要部分:引言、正文和结论。

1. 引言在引言部分,首先概述了文章的主题,即基于Python的电影票房爬取与可视化系统的设计与实现。

接着介绍了文章的结构,包括各个章节的内容及其安排顺序。

基于HTMLParser的Web文献信息提取

基于HTMLParser的Web文献信息提取摘要:基于HTMLParser对网页进行解析,可抽取标签间的Link、image、meta 和title 等信息。

使用HTMLParser来提取Web文献中的题名、关键字、摘要、作者、来源等信息,清洗后存入MySql 数据库当中,以备后续数据挖掘使用。

对此进行了论述。

关键词:HTMLParser;Web文献;信息提取大量的科研项目,每年都会有数以万计的文献产生。

随之而来的问题是如此多的文献数据让人难以消化,无法从表面上看出它们所蕴涵的有用信息,更不用说有效地指导进一步的工作。

如何从大量的数据中找到真正有用的信息成为人们关注的焦点,数据挖掘技术也正是伴随着这种需求从研究走向应用。

近年来,随着Web技术的快速普及和迅猛发展,使各种信息可以以非常低的成本在网络上获得。

本文就是要利用网络爬虫技术,对Web文献进行抓取数据,构建数据仓库,以挖掘出有用的信息。

1HTMLParser简介HTMLParser是一个纯的Java写的HTML解析的库,它不依赖于其它的Java库文件,主要用于改造或提取html。

它提供了接口,支持线性和嵌套HTML文本。

在实际的项目中只需要将htmlparser.jar 导入classpath中,就可以使用Htmlparser提供的API了。

HTMLParser项目主要可以用在以下两个方面:(1)信息提取。

文本信息抽取,例如对HTML进行有效信息搜索;链接提取,用于自动给页面的链接文本加上链接的标签;资源提取,例如对一些图片、声音的资源的处理;链接检查,用于检查HTML中的链接是否有效;页面内容的监控。

(2)信息转换。

链接重写,用于修改页面中的所有超链接;网页内容拷贝,用于将网页内容保存到本地;内容检验,可以用来过滤网页上一些令人不愉快的字词;HTML信息清洗,把本来乱七八糟的HTML信息格式化;转成XML格式数据。

HTMLParser由Node、AbstractNode 和Tag 来表达HTML。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

基于HTMLParser视频信息抽取系统的设计与实现摘要目前视频网站成为人们上网时不可或缺的娱乐途径,但现在的视频网站对视频的分类以及描述参差不齐,其主要原因就是没有构建统一的视频信息知识库,而构建知识库的核心技术就是网络爬虫的设计。

本文针对视频类网站进行了详细研究。

通过深入分析视频类网站页面的树形结构的构架,并基于htmlparser 的信息提取方法,从种子页面中提取出相关的视频信息用于视频信息知识库的构建。

关键词网络爬虫;视频爬取;htmlparser中图分类号tp39 文献标识码a 文章编号 1674-6708(2011)55-0207-02随着互联网的普及,越来越多的人们把自己的娱乐时间投入到网络视频上,而面对海量的视频人们只能通过视频网站的介绍决定自己是否感兴趣,而往往各个视频网站对同一视频的描述以及分类会有不同,这使得用户不能得到关于视频的准确描述信息,为了应对这样的挑战,我们需要构建一个统一的视频信息知识库,而构建知识库的核心技术就是网络爬虫的设计。

视频信息抽取系统在这样的研究背景下产生,目前信息抽取的关键技术有:命名实体识别,句法分析,篇章分析与推理,知识获取。

针对视频网站页面的特点,我们需要直接抽取相关标签中的视频信息。

1 htmlparser与node1.1 htmlparser爬虫程序中,对于html网页的处理是核心的一个环节。

对于java 来说,htmlparser是比较著名并且得到广泛应用的一个。

htmlparser的主页是http:///,最后的更新是2006年9月的1.6版。

htmlparser具有小巧,快速的优点,缺点是相关文档比较少,很多功能需要自己摸索。

htmlparser 的核心模块是org.htmlparser.parser类,这个类实际完成了对于html页面的分析工作。

这个类有下面几个构造函数:public parser ();public parser (lexer lexer, parserfeedback fb);public parser (urlconnection connectionparserfeedback fb) throws parserexception;public parser (string resource,parserfeedback feedback) throws parserexception;public parser (string resource) throws parserexception;public parser (lexer lexer);public parser (urlconnection connection) throws parserexception;和一个静态类 public static parser createparser (string html, string charset);对于大多数使用者来说,使用最多的是通过一个urlconnection或者一个保存有网页内容的字符串来初始化parser,或者使用静态函数来生成一个parser对象。

parserfeedback的代码很简单,是针对调试和跟踪分析过程的,一般不需要改变。

1.2 nodehtmlparser将解析过的信息保存为一个树的结构。

node是信息保存的数据类型基础。

它的定义如下:public interface node extends cloneable; 具体对节点的操作就是通过node的成员函数实现。

2 系统的结构及实现本系统首先利用htmlparser递归抽取各视频url信息,然后再利用得到的url抽取对应视频的详细信息。

2.1 抽取网站内视频信息算法输入:某一视频网站播放页面地址(url)。

输出:此网站内视频的详细信息。

算法:1)提取页面视频url(n个);2)递归处理页面的n个视频url,分别提取各url对应页面上的n个视频的url信息;3)将抽取到的视频url保存至数据库;4)分析url对应页面并提取相关视频信息,并将其保存至数据库。

2.2 系统结构1)抽取网站内部所有视频url模块该模块实现的主要功能是利用htmlparser包通过递归抽取各页面中的视频url。

2)抽取各url对应页面视频信息模块该模块的功能是首先从之前抽取到的url获得该url对应视频页面的字符流,然后通过解析这些字符流从中得到此页面对应视频的详细信息。

3)存储模块该模块利用mysql保存抽取的视频信息,并不断更新检查是否有重复。

2.3 系统实现2.3.1 抽取网站内部所有视频url抽取url算法为extractlinks(string url)该算法实现了递归获取网站内所有视频的url,并存于movielinks中。

算法所需全局变量及所用到的函数定义如下:aarraylist movielinks = new arraylist();//存放视频url boolean ismovieurl(string url);//判断次url是否是正确的视频url递归搜索部分代码如下:public void extractlinks(string url)this.parser = new parser(url);//htmlparser入口parser.setencoding(gb2312);node[] links =parser.extractallnodesthatare(linktag.class);//解析出所有页面链接标签for(int i=0;i”)));……//使用相应的方法}2.3.3 存储视频信息采用jdbc方式操作数据库,类dbconnection负责与数据库的链接。

类moviedal封装了类movie的存取。

部分代码如下:public class dbconnection { //数据库连接类public connectionget connection() throws sqlexception,instantiationexception, illegalaccessexception,classnotfoundexception{dbproperty pro = new dbproperty();connection conn = null;class.forname(pro.getclassname()).newinstance();string url = pro.geturl();string user = pro.getusername();string password = pro.getpassword();conn = drivermanager.getconnection(url,user,password);return conn;}public moviedal{ //数据访问层类public insertmovie(movie m) //添加数据方法{dbconnection db = new dbconnection();string sql=”insert into movie values(‘”+m.getname()+”’,’”+m.geturl()+”’,…)”;try{conn =db. getconnection();stmt = conn.createstatement();stmt.executeupdate(sql);}catch(sqlexception sqle){throw new sqlexception(“insert data exception:” + sqle.getmessage());}}}本文基于htmlparser,对html内容进行解析,将html中有关视频的信息解析到预先定义好的对象数组中,具有快速,准确的特点。

本文的方法对web页面中视频信息的提取具有指导意义。

参考文献[1]郭志红.基于web资源的信息抽取技术[j].情报科学,2002,20(12):1282-1284.[2]李昌清,李艳霞,李胜利,等.基于动态异构的web信息集成网页分析方法[j].计算机应用研究.[3]许建潮,侯锟.web信息的自主抽取方法[j].计算机工程与应用.[4]nicholas kushmerick.wrapper induction:efficiency and expressiveness.artifical intelligence 118(2000):15-68.[5]arasu,a.,and garcia-molina,h.extracting structured data from web pages.in acm sigmod international conf.on management of data(sigmod 2003), san diego,california(2003).[6]wang,j.,and lochovsky,f.data-rich section extraction from html pages.in proceedings of the 3rd international conference on web information systems engineering(wise 2002),12-14 december 2002,singapore, proceedings (2002),ieee computer society,pp.313-322.[7]韩家炜,孟小峰,等.web挖掘研究[j].计算机研究与发展.[8]徐远超,刘江华,刘丽,珍关永.基于web的网络爬虫的设计与实现[j].微计算机信息.[9]yong wang,yiqun liu,et al.a news page discovery policy for instant crawlers.lncs.2008,4993:520-525.。