SAS第三十三课逐步回归分析

逐步回归分析

逐步回归分析引言逐步回归分析是一种回归分析的方法,它通过逐步加入和删除自变量,来选择最佳的自变量子集,以建立最佳的回归模型。

在统计学和数据分析中广泛应用,尤其在多变量分析中,逐步回归可以帮助我们确定对目标变量有较强预测能力的自变量。

逐步回归的基本原理在逐步回归中,我们首先选择一个自变量作为基础模型,并对其进行回归分析。

然后,我们逐步地加入剩余的自变量,并根据一定的准则来评估加入自变量后模型的性能。

如果加入自变量后模型的性能显著提升,那么就将该自变量加入模型中。

反之,如果加入自变量后模型的性能没有显著提升,那么就将该自变量排除在外。

这样反复进行,直到所有可能的自变量都被考虑过,得到最佳的回归模型。

逐步回归的基本原理可以用以下步骤总结:1.初始化一个基础模型,选定第一个自变量。

2.对基础模型进行回归分析并评估其性能。

3.遍历剩余的自变量,依次加入到基础模型中,并评估加入自变量后模型的性能。

4.根据一定准则(如F统计量、AIC、BIC等)来判断加入自变量后模型的性能是否显著提升。

5.如果加入自变量后模型的性能显著提升,那么将该自变量加入模型中。

6.反之,如果加入自变量后模型的性能没有显著提升,那么将该自变量排除在外。

7.重复步骤3-6,直到所有可能的自变量都被考虑过,得到最佳的回归模型。

逐步回归的优缺点逐步回归作为一种特定的变量选择方法,具有以下优点:•可以帮助我们快速确定对目标变量有较强预测能力的自变量,避免了将所有自变量都加入模型中的复杂性和冗余性。

•可以降低模型的复杂度,减少过拟合的可能性。

•可以提高模型的解释能力,筛选出与目标变量相关性高的自变量。

然而,逐步回归也存在一些缺点:•过于依赖于原始数据的初始情况,可能导致不同初始情况下得到不同的最终模型。

•不能保证得到全局最优解,只能得到局部最优解。

•在特征空间较大的情况下,计算复杂度较高。

逐步回归的应用场景逐步回归适用于以下情况:1.当自变量较多时,希望从中选出对目标变量有较强预测能力的子集。

SAS 逐步回归

9

九种模型

none(全回归模型). 不对回归变量进行筛选,建立与全部自变量的全回 归模型. forward(前进法). 前进法以模型中没有变量开始,对每个自变量, forward计算反映自变量对模型的贡献的F 统计量.这些 F 统计量与model语句中给出的slentry=水平上的值相比 较,如果F 统计量的显著水平没有一个比slentry=水平上 (如果缺省slentry=这个参数,则显著水平假设为0.50) 的值大,则forward停止.否则,forward在模型中加入具 有最大F 统计量的变量,然后forward再计算这些变量的F 统计量直到剩下的变量都在模型的外面,再重复估计过 程.变量就这样一个接一个地进入模型直到剩下的变量 没有一个可以产生显著的F统计量.一旦一个变量进入 了模型,它就不再出去了.

3

proc reg语句

proc reg语句用于调用reg过程.其中的语句选项较 多,功能复杂; 此处的选项将会对同一reg过程步中所有的model 语句发生作用. proc reg语句的主要选项及其功能和用法见下表.

4

proc reg语句的主要选项

选 项 alpha= corr outest= 功能和用法 为当前过程步中所创建的各种可信区间指定其置信水平( 为当前过程步中所创建的各种可信区间指定其置信水平(除某些语句中另 外设置了置信水平者外).须设置为0~1之间的值,默认值为 ).须设置为 之间的值, 外设置了置信水平者外).须设置为 之间的值 默认值为0.05. . 给出有关model语句和 语句中的所有变量的相关矩阵. 语句和var语句中的所有变量的相关矩阵 给出有关 语句和 语句中的所有变量的相关矩阵. 将参数估计值以及模型拟合过程的相应统计量(可选) 将参数估计值以及模型拟合过程的相应统计量(可选)输出到所指定的数 据集中. 据集中. 须设置为一个非负数所组成的列表(或单个数值),以列表中的每一个数 须设置为一个非负数所组成的列表(或单个数值),以列表中的每一个数 ), 值作为岭常数K进行岭回归分析 进行岭回归分析, 值作为岭常数 进行岭回归分析,并将每一次岭回归分析所得的参数估计 值输出到" 选项所指定的输出数据集中. 值输出到"outest="选项所指定的输出数据集中.输出数据集中岭常数 选项所指定的输出数据集中 输出数据集中岭常数K 存储在变量"_RIDGE_"下,相应估计值所对应的"_TYPE_"变量值为 存储在变量" 下 相应估计值所对应的" 变量值为 语句将被忽略. "RIDGE".设置此选项时,restrict语句将被忽略. .设置此选项时, 语句将被忽略 过程中所用到的变量的合计值, 将reg过程中所用到的变量的合计值,均数,方差,标准差以及未校正的 过程中所用到的变量的合计值 均数,方差, 离均差平方和等在结果中显示. 离均差平方和等在结果中显示. 将参数估计值的标准误,可信区间, 值 针对参数为零的检验假设) 将参数估计值的标准误,可信区间,t值(针对参数为零的检验假设)以 及相应的P值输出到 值输出到" 选项所指定的输出数据集中. 及相应的 值输出到"outest="选项所指定的输出数据集中. 选项所指定的输出数据集中

SAS整理下之相关分析和回归分析

SAS整理下之相关分析和回归分析相关分析1.⽤INSIGHT模块作相关分析先说⼀下建⽴数据集,找到题中的某句话的意思是,“为了弄清楚。

形成的原因,或者是为了分析。

的影响因素。

”找到这句话就成功⼀半了,将这个。

元素就写到Y的列下,其他的元素就设成X1 X2。

这样,有⼏个元素就⼏列,但是Y只有⼀列,⽽X就看题中给得了!!1. 制作散点图⾸先制作变量之间的散点图,以便判断变量之间的相关性。

步骤如下:1) 在INSIGHT模块中,打开数据集;2) 选择菜单“Analyze(分析)”→“Scatter Plot (Y X)(散点图)”;3) 在打开的“Scatter Plot (Y X)”对话框中选定Y变量:Y;选定X变量:x1、x2、x3、x4;4) 单击“OK”按钮,得到变量的分析结果。

从各散点的分布情况看,初步有⼀个跟每个元素的线性关系密切或不密切就⾏了。

2. 相关系数计算1) 在INSIGHT模块中,打开数据集;2) 选择菜单“Analyze(分析)”→“Multivariate (Y X)(多变量)”;3) 在打开的“Multivariate (Y X)”对话框中选定Y变量:Y;选定X变量:x1、x2、x3、x4;4) 单击“OK”按钮,得到分析结果。

结果显⽰各变量的统计量和相关(系数)矩阵,从相关矩阵中可以看出,相关系数⾼的就关系密切,相关系数低的就关系不密切。

5) 为了检验各总体变量的相关系数是否为零,选择菜单:“Tables”→“CORR p-values”,得到相关系数为零的原假设的p值,如图所⽰。

基于这些p值,拒绝原假设,即Y因素与其他⼏个变量之间均存在着显著的正相关关系;若p值>0.05,则⽆法拒绝原假设。

3. 置信椭圆继续上述步骤。

6) 选择菜单:“Curves”→“Scatter Plot Cont Ellipse”→“Prediction:95%”,得到Y与其他⼏个变量的散点图及预测值的置信椭圆变量Y和x1间散点图上的这个椭圆被拉得很长,表明变量Y和x1之间有很强的相关性。

逐步回归分析

逐步回归分析在自变量很多时,其中有的因素可能对应变量的影响不是很大,而且x之间可能不完全相互独立的,可能有种种互作关系。

在这种情况下可用逐步回归分析,进行x因子的筛选,这样建立的多元回归模型预测效果会更较好。

逐步回归分析,首先要建立因变量y与自变量x之间的总回归方程,再对总的方程及每—个自变量进行假设检验。

当总的方程不显著时,表明该多元回归方程线性关系不成立;而当某—个自变量对y影响不显著时,应该把它剔除,重新建立不包含该因子的多元回归方程。

筛选出有显著影响的因子作为自变量,并建立“最优”回归方程。

回归方程包含的自变量越多,回归平方和越大,剩余的平方和越小,剩余均方也随之较小,预测值的误差也愈小,模拟的效果愈好。

但是方程中的变量过多,预报工作量就会越大,其中有些相关性不显著的预报因子会影响预测的效果。

因此在多元回归模型中,选择适宜的变量数目尤为重要。

逐步回归在病虫预报中的应用实例:以陕西省长武地区1984~1995年的烟蚜传毒病情资料、相关虫情和气象资料为例(数据见DATA6.xls),建立蚜传病毒病情指数的逐步回归模型,说明逐步回归分析的具体步骤。

影响蚜传病毒病情指数的虫情因子和气象因子一共有21个,通过逐步回归,从中选出对病情指数影响显著的因子,从而建立相应的模型。

对1984~1995年的病情指数进行回检,然后对1996~1998年的病情进行预报,再检验预报的效果。

变量说明如下:y:历年病情指数x1:前年冬季油菜越冬时的蚜量(头/株)x11:5月份均温 x12:5月份降水量 x13:6月份均温 x14:6月份降水量x2:前年冬季极端气温 x3:5月份最高气温x4:5月份最低气温x5:3~5月份降水量x6:4~6月份降水量x7:3~5月份均温x8:4~6月份均温x9:4月份降水量x10:4月份均温x15:第一次蚜迁高峰期百株烟草有翅蚜量 x16:5月份油菜百株蚜量x17:7月份降水量x18:8月份降水量x19:7月份均温x20:8月份均温x21:元月均温1)准备分析数据在SPSS数据编辑窗口中,用“File→Open→Data”命令,打开“DATA6.xls”数据文件。

三、用SAS做回归分析

数学建模培训 徐雅静 08年7月

Ⅲ 用SAS做回归分析

在分析结果的Test for Distribution(分布检验)表中看到, p值大于0.05,不能拒绝原假设,表明可以接受误差正态 性的假定。

所以,模型

是合适的,用其对不良贷款进行预

测会更符合Y实ˆ 际0。.0331 x1

数学建模培训 徐雅静 08年7月

Ⅲ 用SAS做回归分析

2. 多元线性回归

引入数据集Mylib.BLDK中的所有4个自变量对不良贷款 建立多元线性回归。

(1) 分析步骤 在INSIGHT模块中打开数据集Mylib.BLDK。 1) 选择菜单“Analyze”→“Fit(Y X)(拟合)”,打开 “Fit(Y X)”对话框; 2) 在“Fit(Y X)”对话框中,选择变量Y,单击“Y”按钮, 将Y设为响应变量;选择变量x1、x2、x3、x4,单击“X”按钮, 将x1、x2、x3、x4设为自变量; 3) 单击“OK”按钮,得到分析结果。

数学建模培训 徐雅静 08年7月

Ⅲ 用SAS做回归分析

(3) 利用回归方程进行估计和预测 例如,要估计贷款余额为100亿元时,所有分行不良贷 款的平均值。 1) 回到数据窗口,点击数据表的底部,增加一个新行; 在第一个空行中,在x1列填入100,并按Enter键;

2) 自动计算出Y的预测值并将结果显示在P_Y列之中, 这样可以得到任意多个预测值。上图表明,贷款余额为 100亿元时,所有分行不良贷款的平均值约为2.96亿元。

spssau逐步回归分析操作

逐步回归分析逐步回归分析研究X(自变量,通常为量数据)对Y(因变量,定量数据)的影响关系情况,X可以为多个,但并非所有X均会对Y产生影响;当X个数很多时,可以让系统自动识别出有影响的X;这一自动识别分析方法则称为逐步回归分析;如果全部X均没有显著性,此时系统默认返回回归分析结果分析步骤共为四步,分别是:第一步:首先对模型情况进行分析首先分析最终余下的X情况;以及被模型自动排除在外的X; 接着对模型拟合情况(比如R平方为,则说明所有余下X可以解释Y 30%的变化原因),模型共线性问题(VIF值小于5则说明无多重共线性).第二步:分析X的显著性模型余下的X一定具有显著性;具体分析X的影响关系情况即可.第三步:判断X对Y的影响关系方向回归系数B值大于0说明正向影响,反之负向影响.第四步:其它比如对比影响程度大小(回归系数B值大小对比X对Y的影响程度大小)分析项逐步回归分析说明网购满意度,重复购买意愿网购满意度20项;其中具体那几项会影响到样本重复购买意愿20项过多,让软件自动删除掉没有影响的项,余下有影响的项分析结果表格示例如下:非标准化系数标准化系数t p VIF R2调整R2FB标准误Beta常数-*-**分析项1*分析项2**分析项3* p< ** p<备注:逐步回归分析仅在回归分析的基础上,加入了一项功能,即自动化移除掉不显著的X,通常逐步回归分析用于探索研究中。

逐步回归分析之后,可对回归模型进行检验。

可包括以下四项:多重共线性:可查看VIF值,如果全部小于10(严格是5),则说明模型没有多重共线性问题,模型构建良好;反之若VIF大于10说明模型构建较差。

自相关性:如果D-W值在2附近(~之间),则说明没有自相关性,模型构建良好,反之若D-W值明显偏离2,则说明具有自相关性,模型构建较差。

自相关问题产生时建议对因变量Y数据进行查看。

残差正态性:在分析时可保存残差项,然后使用“正态图”直观检测残差正态性情况,如果残差直观上满足正态性,说明模型构建较好,反之说明模型构建较差。

(整理)SAS讲义第三十三课逐步回归分析.

第三十三课 逐步回归分析一、 逐步回归分析在一个多元线性回归模型中,并不是所有的自变量都与因变量有显著关系,有时有些自变量的作用可以忽略。

这就产生了怎样从大量可能有关的自变量中挑选出对因变量有显著影响的部分自变量的问题。

在可能自变量的整个集合有40到60个,甚至更多的自变量的那些情况下,使用“最优”子集算法可能并不行得通。

那么,逐步产生回归模型要含有的X 变量子集的自动搜索方法,可能是有效的。

逐步回归方法可能是应用最广泛的自动搜索方法。

这是在求适度“好”的自变量子集时,同所有可能回归的方法比较,为节省计算工作量而产生的。

本质上说,这种方法在每一步增加或剔除一个X 变量时,产生一系列回归模型。

增加或剔除一个X 变量的准则,可以等价地用误差平方和缩减量、偏相关系数或F 统计量来表示。

无疑选择自变量要靠有关专业知识,但是作为起参谋作用的数学工具,往往是不容轻视的。

通常在多元线性模型中,我们首先从有关专业角度选择有关的为数众多的因子,然后用数学方法从中选择适当的子集。

本节介绍的逐步回归法就是人们在实际问题中常用的,并且行之有效的方法。

逐步回归的基本思想是,将变量一个一个引入,引入变量的条件是偏回归平方和经检验是显著的,同时每引入一个新变量后,对已选入的变量要进行逐个检验,将不显著变量剔除,这样保证最后所得的变量子集中的所有变量都是显著的。

这样经若干步以后便得“最优”变量子集。

逐步回归是这样一种方法,使用它时每一步只有一个单独的回归因子引进或从当前的回归模型中剔除。

Efroymoson (1966)编的程序中,有两个F 水平,记作F in 和F out ,在每一步时,只有一个回归因子,比如说X i ,如果剔除它可能引起RSS 的减少不超过残差均方MSE (即ESS/(N-k-1))的F out 倍,则将它剔除;这就是在当前的回归模型中,用来检验 βi =0的F 比=MSE x x x RSS x x x x RSS i i i /)),,(),,,((121121---ΛΛ是小于或等于F out 。

逐步回归分析

小,预测值 的误差也愈小,模拟的效果愈好。但是方程中的变量过多,预报工作量就会越

m 大,其中有些相关性不显著的预报因子会影响预测的效果。因此在多元回归模型中,选择适

o 宜的变量数目尤为重要。

c 逐步回归在病虫预报中的应用实例:

. 以陕西省长武地区 1984~1995 年的烟蚜传毒病情资料、相关虫情和气象资料为例(数

j 据见 DATA6.xls),建立蚜传病毒病情指数的逐步回归模型,说明逐步回归分析的具体步骤。

0t 影响蚜传病毒病情指数的虫情因子和气象因子一共有 21 个,通过逐步回归,从中选出对病

0 情指数影响显著的因子,从而建立相应的模型。对 1984~1995 年的病情指数进行回检,然

0 后对 1996~1998 年的病情进行预报,再检验预报的效果。

圣才学习网

表 6-10 是逐步回归每一步进入或剔除回归模型中的变量情况。 网 表 6-11 是逐步回归每一步的回归模型的统计量:R 是相关系数;R Square 相关系数的

图 3-7“Save”对话框

①“Predicted Values”预测值栏选项:

Unstandardized 非标准化预测值。就会在当前数据文件中新添加一个以字符“PRE_”

开头命名的变量,存放根据回

归模型拟合的预测值。

Standardized 标准化预测值。

Adjusted 调整后预测值。

S.E.of mean predictions 预测值的标准误。

网 习 学 计 统 华 中 图 3-4

“Stepping Method Criteria”框里的设置用于逐步回归分析的选择标准。 其中“Use probability of F”选项,提供设置显著性 F 检验的概率。如果一个变量的 F 检 验概率小于或等于进入“Entry”栏里设置的值,那么这个变量将被选入回归方程中;当回归 方程中变量的 F 值检验概率大于剔除“Removal”栏里设置的值,则该变量将从回归方程中被 剔除。由此可见,设置 F 检验概率时,应使进入值小于剔除值。 “Ues F value”选项,提供设置显著性 F 检验的分布值。如果一个变量的 F 值大于所设置 的进入值(Entry),那么这个变量将被选入回归方程中;当回归方程中变量的 F 值小于设置 的剔除值(Removal),则该变量将从回归方程中被剔除。同时,设置 F 分布值时,应该使 进入值大于剔除值。

SAS第三十三课逐步回归分析

第三十三课 逐步回归分析一、 逐步回归分析在一个多元线性回归模型中,并不是所有的自变量都与因变量有显著关系,有时有些自变量的作用可以忽略。

这就产生了怎样从大量可能有关的自变量中挑选出对因变量有显著影响的部分自变量的问题。

在可能自变量的整个集合有40到60个,甚至更多的自变量的那些情况下,使用“最优”子集算法可能并不行得通。

那么,逐步产生回归模型要含有的X 变量子集的自动搜索方法,可能是有效的。

逐步回归方法可能是应用最广泛的自动搜索方法。

这是在求适度“好”的自变量子集时,同所有可能回归的方法比较,为节省计算工作量而产生的。

本质上说,这种方法在每一步增加或剔除一个X 变量时,产生一系列回归模型。

增加或剔除一个X 变量的准则,可以等价地用误差平方和缩减量、偏相关系数或F 统计量来表示。

无疑选择自变量要靠有关专业知识,但是作为起参谋作用的数学工具,往往是不容轻视的。

通常在多元线性模型中,我们首先从有关专业角度选择有关的为数众多的因子,然后用数学方法从中选择适当的子集。

本节介绍的逐步回归法就是人们在实际问题中常用的,并且行之有效的方法。

逐步回归的基本思想是,将变量一个一个引入,引入变量的条件是偏回归平方和经检验是显著的,同时每引入一个新变量后,对已选入的变量要进行逐个检验,将不显著变量剔除,这样保证最后所得的变量子集中的所有变量都是显著的。

这样经若干步以后便得“最优”变量子集。

逐步回归是这样一种方法,使用它时每一步只有一个单独的回归因子引进或从当前的回归模型中剔除。

Efroymoson (1966)编的程序中,有两个F 水平,记作F in 和F out ,在每一步时,只有一个回归因子,比如说X i ,如果剔除它可能引起RSS 的减少不超过残差均方MSE (即ESS/(N-k-1))的F out 倍,则将它剔除;这就是在当前的回归模型中,用来检验 βi =0的F 比=MSE x x x RSS x x x x RSS i i i /)),,(),,,((121121--- 是小于或等于F out 。

用SAS作回归分析

用SAS 作回归分析前面我们介绍了相关分析,并且知道变量之间线性相关的程度可以通过相关系数来衡量。

但在实际工作中,仅仅知道变量之间存在相关关系往往是不够的,还需要进一步明确它们之间有怎样的关系。

换句话说,实际工作者常常想知道某些变量发生变化后,另一个相关变量的变化程度。

例如,第六章中已经证明消费和收入之间有很强的相关关系,而且也知道,消费随着收入的变化而变化,问题是当收入变化某一幅度后,消费会有多大的变化?再比如,在股票市场上,股票收益会随着股票风险的变化而变化。

一般来说,收益和风险是正相关的,也就是说,风险越大收益就越高,风险越小收益也越小,著名的资本资产定价模型(CAPM )正说明了这种关系。

现在的问题是当某个投资者知道了某只股票的风险后,他能够预测出这只股票的平均收益吗?类似这类通过某些变量的已知值来预测另一个变量的平均值的问题正是回归分析所要解决的。

第一节 线性回归分析方法简介一、回归分析的含义及其所要解决的问题“回归”(Regression)这一名词最初是由19世纪英国生物学家兼统计学家F.Galton(F.高尔顿)在一篇著名的遗传学论文中引入的。

高尔顿发现,虽然有一个趋势:父母高,儿女也高;父母矮,儿女也矮,但给定父母的身高,儿女辈的平均身高却趋向于或者“回归”到全体人口的平均身高的趋势。

这一回归定律后来被统计学家K.Pearson 通过上千个家庭成员身高的实际调查数据进一步得到证实,从而产生了“回归”这一名称。

当然,现代意义上的“回归”比其原始含义要广得多。

一般来说,现代意义上的回归分析是研究一个变量(也称为因变量Dependent Variable 或被解释变量Explained Variable )对另一个或多个变量(也称为自变量Independent Variable 或Explanatory Variable )的依赖关系,其目的在于通过自变量的给定值来预测因变量的平均值或某个特定值。

逐步回归分析结果解读

逐步回归分析结果解读

一步回归分析是通过研究因变量Y和自变量X的关系来对研究对象的特征进行分析。

可以检验自变量中哪个变量对因变量(即结果)有影响,以及影响程度有多大,从而决定用哪几个自变量去预测因变量。

一步回归分析结果的解读一般包括以下三个方面:

一是研究自变量与因变量的相关性。

这一步回归结果中会列出每一个自变量的协整系数,可以清楚的知道每一个自变量与因变量相关性的大小,从而选择有用的因素用于预测结果。

二是建立统计模型。

研究的过程中,要构建一个定性和定量数据分析的统计模型来描述自变量和因变量之间的线性关系,同时也能准确预测因变量的值。

三是验证统计模型。

一步回归结果中也记录着一系列的统计检验,如F检验,偏差平方和,R方,可以用于检验回归模型的整体拟合水平,也可以更好的研究自变量与因变量之间的相关关系,判断回归模型可否用于预测因变量。

总的来说,从一步回归分析的结果来解读,可以了解自变量和因变量之间的关系,构建一个统计模型来准确预测因变量的值,还可以通过一系列的统计检验来验证回归模型的有效性。

用SAS作回归分析RegressionAnalysis

交互项的检验

使用交互项的系数检验,判断交 互项是否显著,从而决定是否保 留交互项。

交互项模型的应用

场景

适用于研究多个因素之间相互作 用对因变量的影响,以及解释复 杂现象时使用。

06

案例分享与实战演练

案例一:使用SAS进行线性回归分析

总结词

线性回归分析是一种常用的回归分析方法,用于探索自变量和因变量之间的线 性关系。

表示为 y = f(x),其中 f 是一个非线性函数。

03

多重回归

当一个因变量受到多个自变量的影响时,可以使用多重回归分析。多重

回归模型可以表示为 y = b0 + b1x1 + b2x2 + ... + bnxn,其中 b0

是截距,b1, b2, ..., bn 是自变量的系数。

回归分析在统计学中的重要性

线性关系检验

通过散点图、残差图和正态性检验等手段,检验因变 量与自变量之间是否存在线性关系。

独立性检验

检查自变量之间是否存在多重共线性,确保自变量之 间相互独立。

误差项的独立性检验

检验误差项是否独立,即误差项与自变量和因变量是 否独立。

模型的评估与优化

模型评估

01

通过R方、调整R方、AIC等指标评估模型的拟合优度。

使用SAS进行线性回归分析

线性回归模型的建立

确定自变量和因变量

首先需要明确回归分析的目的,并确定影响因变量的自变量。

数据准备

确保数据清洗无误,处理缺失值、异常值和离群点。

模型建立

使用SAS的PROC REG或PROC GLMSELECT过程,输入自变量和 因变量,选择线性回归模型。

模型的假设检验

02

SAS系统和数据分析多元线性回归分析

第三十二课 多元线性回归分析一、 多元回归模型表示法通常,回归模型包括k 个变量,即一个因变量和k 个自变量(包括常数项)。

由于具有N 个方程来概括回归模型:N t X X X Y t kt k t t t ,,2,1,22110 =+++++=εββββ(32.1)模型的相应矩阵方程表示为:εβ+=X Y(32.2)式中;⎪⎪⎪⎪⎪⎭⎫⎝⎛=⎪⎪⎪⎪⎪⎭⎫ ⎝⎛=⎪⎪⎪⎪⎪⎭⎫⎝⎛=⎪⎪⎪⎪⎪⎭⎫ ⎝⎛=N k kN N k k N X XX X X X X Y Y Y Y εεεεββββ2110121211121,,111, (32.3)其中,Y 为因变量观察的N 列向量,X 为自变量观察的N × (k +1) 矩阵,β为末知参数的(k +1) )列向量,ε 为误差观察的N 列向量。

在矩阵X 表达式中,每一个元素X ij 都有两个下标,第一个下标表示相应的列(变量),第二个下标表示相应的行(观察)。

矩阵X 的每一列表示相应的给定变量的N 次观察的向量,与截矩有关的所有观察值都等于1。

经典的线性回归模型的假设可以阐述如下: ● 模型形式由(32.1)给定;● 矩阵X 的元素都是确定的,X 的秩为(k+1),且k 小于观察数N ;● ε 为正态分布,E (ε )=0 和()I E 2σεε=' ,式中I 为N×N 单位矩阵。

根据X 的秩为(k+1) 的假定,可以保证不会出现共线性。

如果出现完全共线性,矩阵X 的一列将为其余列的线性组合,而X 的秩将小于(k+1) ),关于误差的假设是最有用的假设,因为用它可以保证最小二乘法估计过程的统计性质。

除了正态性外,我们还假定每一个误差项的平均值为0,方差为常数, 以及协方差为 0 。

假若我们按Y 的分布来表示第三个假设,则可写成下式:),(~2I X N Y σβ(32.4)二、 最小二乘法估计我们的目的是求出一个参数向量使得残差平方和最小,即:εεεˆˆˆ12'==∑=Nt t ESS (32.5)式中:Y Y ˆˆ-=ε (32.6) βˆˆX Y =(32.7)其中,εˆ表示回归残差的N 列向量,而Y ˆ表示Y 拟合值的N 列向量,βˆ表示为估计参数的(k +1) 列向量,将式(32.6)和式(32.7)代入式(32.5),则得:()()βββββˆˆˆ2 ˆˆX X Y X Y Y X Y X Y ESS ''+''-'=-'-= (32.8)为了确定最小二乘法估计量,我们求ESS 对βˆ进行微分,并使之等于0,即: 0ˆ22ˆ='+'-=∂∂ββX X Y X ESS (32.9)所以:())(ˆ1Y X X X ''=-β(32.10)被称为“交叉乘积矩阵”,即X X '矩阵能够保证逆变换,这是因为我们假设X 的秩为(k +1),该假设直接导致了X X '的非奇异性。

逐步回归法

逐步回归法

一、逐步回归法介绍

逐步回归的基本思想是通过剔除变量中不太重要又和其他变量高度相关的变量,降低多重共线性程度。

将变量逐个引入模型,每引入一个解释变量后都要进行F检验,并对已经选入的解释变量逐个进行t检验,当原来引入的解释变量由于后面解释变量的引入变得不再显著时,则将其删除,以确保每次引入新的变量之前回归方程中只包含显著性变量。

这是一个反复的过程,直到既没有显著的解释变量选入回归方程,也没有不显著的解释变量从回归方程中剔除为止,以保证最后所得到的解释变量集是最优的。

逐步回归法的好处是将统计上不显著的解释变量剔除,最后保留在模型中的解释变量之间多重共线性不明显,而且对被解释变量有较好的解释贡献。

但是应特别注意,逐步回归法可能因为删除了重要的相关变量而导致设定偏误。

二、逐步型选元法

逐步回归法选择变量的过程包含两个基本步骤:一是从回归模型中剔出经检验不显著的变量,二是引入新变量到回

归模型中,常用的逐步型选元法有向前法和向后法。

向前法:向前法的思想是变量由少到多,每次增加一个,直至没有可引入的变量为止。

具体步骤如下。

依此方法重复进行,每次从未引入回归模型的自变量中选取一个,直到经检验没有变量引入为止。

向后法与向前法正好相反,它事先将全部自变量选入回归模型,再逐个剔除对残差平方和贡献较小的自变量。

SPSS有话说:逐步回归

SPSS有话说:逐步回归逐步回归分析研究X对Y的影响关系情况,X可以为多个,但并⾮所有X均会对Y产⽣影响;当X 个数很多时,可以让系统⾃动识别出有影响的X;这⼀⾃动识别分析⽅法则称为逐步回归分析。

SPSS有话说概述逐步回归分析是多元回归分析中的⼀种⽅法。

回归分析是⽤于研究多个变量之间相互依赖的关系,⽽逐步回归分析往往⽤于建⽴最优或合适的回归模型,从⽽更加深⼊地研究变量之间的依赖关系。

因为逐步回归分析仅显⽰对因变量有显著预测作⽤的⾃变量,剔除不显著的⾃变量,有过滤和筛选的功能。

特别提⽰分层回归是对若⼲个⾃变量x进⾏分群组分析,主要⽤于模型的⽐较,或者说对变量重要性进⾏判定。

逐步回归是让软件按照⾃变量重要性的⼤⼩,选择变量构建回归模型,如果软件⼀共发现3个有意义的变量,则会构建3个模型,分别为x1,x1+x2,x1+x2+x3;其中变量重要性x1>x2>x3;简单的说,逐步回归按照变量个数递增,建模并计算R2改变;⽽分层回归是按照层的数⽬递增建模并计算R2改变。

注意⼀点,逐步回归和分层回归都可以计算R2的改变量,当分层回归每层仅放⼊⼀个变量时,其结果和逐步回归⼀致。

当分层回归每层的变量数不为1个变量时,结果与逐步回归不同。

逐步先重要变量,后次要变量(结果⽽⾔);分层先想控制变量,后想研究的变量(操作⽽⾔)。

操作步骤问题:检验时间管理倾向的三个维度(时间监控观、时间效能感和时间价值感)是否对拖延⾏为有显著预测⼒?时间价值感对拖延⾏为不具有显著预测作⽤,系统将其⾃动剔除,不显⽰在表格中,只保留显著的结果。

另外,模型按照先重要后次要的原则呈现,因此,时间监控观>时间效能感>时间价值感。

SAS第三十三课逐步回归分析

第三十三课逐步回归分析逐步回归分析在一个多元线性回归模型中,并不是所有的自变量都与因变量有显著关系,有时有些自变量的作用可以忽略。

这就产生了怎样从大量可能有关的自变量中挑选出对因变量有显著影响的部分自变量的问题。

在可能自变量的整个集合有40到60个,甚至更多的自变量的那些情况下,使用“最优” 子集算法可能并不行得通。

那么,逐步产生回归模型要含有的X 变量子集的自动搜索方法,可能是有效的。

逐步回归方法可能是应用最广泛的自动搜索方法。

这是在求适度“好”的自变量子集时,同所有可能回归的方法比较,为节省计算工作量而产生的。

本质上说,这种方法在每一步增加或剔除一个X 变量时,产生一系列回归模型。

增加或剔除一个X 变量的准则,可以等价地用误差平方和缩减量、偏相关系数或F 统计量来表示。

无疑选择自变量要靠有关专业知识,但是作为起参谋作用的数学工具,往往是不容轻视的。

通常在多元线性模型中,我们首先从有关专业角度选择有关的为数众多的因子,然后用数学方法从中选择适当的子集。

本节介绍的逐步回归法就是人们在实际问题中常用的,并且行之有效的方法。

逐步回归的基本思想是,将变量一个一个引入,引入变量的条件是偏回归平方和经检验是显著的,同时每引入一个新变量后,对已选入的变量要进行逐个检验,将不显著变量剔除,这样保证最后所得的变量子集中的所有变量都是显著的。

这样经若干步以后便得“最优”变量子集。

逐步回归是这样一种方法,使用它时每一步只有一个单独的回归因子引进或从当前的回归模型中剔除。

Efroymoson (1966)编的程序中,有两个F水平,记作F in和F out,在每一步时,只有一个回归因子,比如说X i,如果剔除它可能引起RSS 的减少不超过残差均方MSE(即ESS/(N-k-1))的F out倍,则将它剔除;这就是在当前的回归模型中,用来检验i=0 的F 比= (RSS(x1, x2 , x i 1,x i) RSS(x1,x2, x i 1)) / MSE是小于或等于F out。

SAS 逐步回归 PPT课件

model语句选项(1)

选项 selection= best=

include=

maxstep= noint slentry= slstay=

功能和用法

指定模型选择的方法,可以是前进法(forward)、后退法(backward)、逐 步法(stepwise)等九种方法。

在模型选择方法为RSQUARE、ADJRSQ或CP时使用。当模型选择方法为 ADJRSQ或CP时,此选项用来指定最佳模型的最大个数;当模型选择方法为 RSQUARE时,此选项用来为每一种大小的模型指定其最佳模型的最大个数。 这些最佳模型将在结果中显示或输出到“outest=”选项所指定数据集中。 要求在变量筛选时必须将model语句中所列自变量中的前n个包括在模型中, 变量筛选过程仅在剩余的自变量中进行。当模型选择方法为NONE时此选项 无效。 须设置为正整数。在模型选择方法为FORWARD、BACKWARD或 STEPWISE时,用来指定进行变量筛选的最大步数。对于FORWARD或 BACKWARD方法,此选项的默认值为模型中所包含的自变量个数,而对于 STEPWISE方法,此默认值为上述默认值的三倍。

ridge须设置为一个非负数所组成的列表或单个数值以列表中的每一个数值作为岭常数k进行岭回归分析并将每一次岭回归分析所得的参数估计值输出到outest选项所指定的输出数据集中

SAS-逐步回归

南京医科大学流行病与卫生统计学系 柏建岭

1

reg过程

reg过程是专门用于回归分析的SAS过程,可提供绝大多数 常用的线性回归分析功能;

归模型。 forward(前进法)。

前进法以模型中没有变量开始,对每个自变量, forward计算反映自变量对模型的贡献的F 统计量。这些 F 统计量与model语句中给出的slentry=水平上的值相比 较,如果F 统计量的显著水平没有一个比slentry=水平上 (如果缺省slentry=这个参数,则显著水平假设为0.50) 的值大,则forward停止。否则,forward在模型中加入具 有最大F 统计量的变量,然后forward再计算这些变量的F 统计量直到剩下的变量都在模型的外面,再重复估计过 程。变量就这样一个接一个地进入模型直到剩下的变量 没有一个可以产生显著的F统计量。一旦一个变量进入 了模型,它就不再出去了。

逐步回归分析计算法

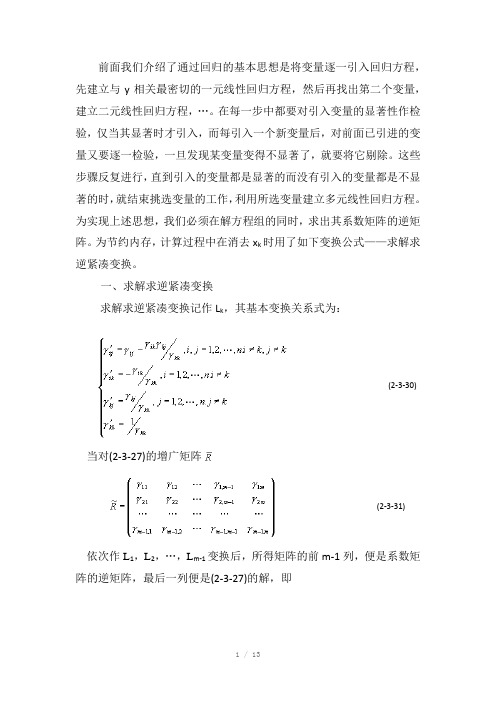

前面我们介绍了通过回归的基本思想是将变量逐一引入回归方程,先建立与y相关最密切的一元线性回归方程,然后再找出第二个变量,建立二元线性回归方程,…。

在每一步中都要对引入变量的显著性作检验,仅当其显著时才引入,而每引入一个新变量后,对前面已引进的变量又要逐一检验,一旦发现某变量变得不显著了,就要将它剔除。

这些步骤反复进行,直到引入的变量都是显著的而没有引入的变量都是不显著的时,就结束挑选变量的工作,利用所选变量建立多元线性回归方程。

为实现上述思想,我们必须在解方程组的同时,求出其系数矩阵的逆矩阵。

为节约内存,计算过程中在消去x k时用了如下变换公式——求解求逆紧凑变换。

一、求解求逆紧凑变换求解求逆紧凑变换记作L k,其基本变换关系式为:(2-3-30) 当对(2-3-27)的增广矩阵(2-3-31)依次作L1,L2,…,L m-1变换后,所得矩阵的前m-1列,便是系数矩阵的逆矩阵,最后一列便是(2-3-27)的解,即求解求逆紧凑变换具有以下性质:(1) 若对作了L k1, L k2,…,L k L变换,则得如下子方程组(2-3-32)的解及相应的系数矩阵的逆矩阵,其中k1,k2,…,k l互不相同,若记L k1L k2…L k l,则(2-3-33),j=1,2,…,l(2) L i L j=L j L i,即求解求逆紧凑变换结果与变换顺序无关。

(3) L k L k=(4) 若,ij=1,2,…,m-1,记L k1L k2…L k l则中的元素具有以下性质:式中上行为对作了变换L i,L j或两个变换均未作过;下行为对作过变换L i和L j之一。

二、逐步回归的计算过程逐步回归计算过程就是反复对增广矩阵作L k变换,并利用变换性质将选变量与作检验等步骤结合起来。

为了检验方便,对再增加一行,使其变成对称方阵,并记作R(0),即(2-3-34)选变量具体步骤如下:1.选第一个变量选第一个变量就是从m-1个一元线性回归方程(i=1,2,…,m-1) (2-3-35)中找一个回归平方和最大的方程。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

第三十三课逐步回归分析一、逐步回归分析在一个多元线性回归模型中,并不是所有的自变量都与因变量有显著关系,有时有些自变量的作用可以忽略。

这就产生了怎样从大量可能有关的自变量中挑选出对因变量有显著影响的部分自变量的问题。

在可能自变量的整个集合有40到60个,甚至更多的自变量的那些情况下,使用“最优”子集算法可能并不行得通。

那么,逐步产生回归模型要含有的X变量子集的自动搜索方法,可能是有效的。

逐步回归方法可能是应用最广泛的自动搜索方法。

这是在求适度“好”的自变量子集时,同所有可能回归的方法比较,为节省计算工作量而产生的。

本质上说,这种方法在每一步增加或剔除一个X变量时,产生一系列回归模型。

增加或剔除一个X变量的准则,可以等价地用误差平方和缩减量、偏相关系数或F统计量来表示。

无疑选择自变量要靠有关专业知识,但是作为起参谋作用的数学工具,往往是不容轻视的。

通常在多元线性模型中,我们首先从有关专业角度选择有关的为数众多的因子,然后用数学方法从中选择适当的子集。

本节介绍的逐步回归法就是人们在实际问题中常用的,并且行之有效的方法。

逐步回归的基本思想是,将变量一个一个引入,引入变量的条件是偏回归平方和经检验是显著的,同时每引入一个新变量后,对已选入的变量要进行逐个检验,将不显著变量剔除,这样保证最后所得的变量子集中的所有变量都是显著的。

这样经若干步以后便得“最优”变量子集。

逐步回归是这样一种方法,使用它时每一步只有一个单独的回归因子引进或从当前的回归模型中剔除。

Efroymoson (1966)编的程序中,有两个F水平,记作F in和F out,在每一步时,只有一个回归因子,比如说X i ,如果剔除它可能引起RSS 的减少不超过残差均方MSE (即ESS/(N-k-1))的F out 倍,则将它剔除;这就是在当前的回归模型中,用来检验 错误!未找到引用源。

i =0的F 比=MSE x x x RSS x x x x RSS i i i /)),,(),,,((121121---ΛΛ是小于或等于F out 。

若剔除的变量需要选择,则就选择使RSS 减少最少的那一个(或等价的选择F 比最小的)。

用这种方式如果没有变量被剔除,则开始引进一个回归因子,比如X j ,如果引进它后使RSS 的增加,至少是残差均方的F in 倍,则将它引进。

即若在当前模型加X j 项后,为了检验 错误!未找到引用源。

j =0的F 比,F ≥F in 时,则引进X j ,其次,若引进的变量需要选择,则选择F 比最大的。

程序按照上面的步骤开始拟合,当没有回归因子能够引进模型时,该过程停止。

二、 变量选择的方法若在回归方程中增加自变量X i ,称为“引入”变量X i ,将已在回归方程中的自变量X j 从回归方程中删除,则称为“剔除”变量X j 。

无论引入变量或剔除变量,都要利用F 检验,将显著的变量引入回归方程,而将不显著的从回归方程中剔除。

记引入变量F 检验的临界值为F in (进),剔除变量F 检验的临界值为F out (出),一般取F in ≥F out ,它的确定原则一般是对k 个自变量的m 个(m ≤k ),则对显著性水平df 1=1,df 2=1--m N 的F 分布表的值,记为F *,则取F in =F out = F *。

一般来说也可以直接取F in =F out =2.0或2.5。

当然,为了回归方程中还能够多进入一些自变量,甚至也可以取为1.0或1.5。

1. 变量增加法首先对全部k 个自变量,分别对因变量Y 建立一元回归方程,并分别计算这k 个一元回归方程的k 个回归系数F 检验值,记为{11211,,k F F F Λ},选其最大的记为1i F =max{11211,,k F F F Λ},若有1i F ≥ F in ,则首先将X 1引入回归方程,不失一般性,设X i 就是X 1。

接着考虑X 1分别与X 2,X 3,...,X k 与因变量Y 二元回归方程,对于这k -1个回归方程中X 2,...,X k 的回归系数进行F 检验,计算得的F 值,并选其最大的F 值2j F ,若2j F ≥F in ,则接着就将X j 引入回归方程,不失一般性,设X j 就是X 2。

对已经引入回归方程的变量X 1和X 2,如同前面的方法做下去,直至所有末被引入方程的变量的F 值均小于F in 时为止。

这时的回归方程就是最终选定的回归方程。

显然,这种增加法有一定的缺点,主要是,它不能反映后来变化的情况。

因为对于某个自变量,它可能开始是显著的,即将其引入到回归方程,但是,随着以后其他自变量的引入,它也可能又变为不显著的了,但是,也并没有将其及时从回归方程中剔除掉。

也就是增加变量法,只考虑引入而不考虑剔除。

2. 变量减少法与变量增加法相反,变量减少法是首先建立全部自变量X 1,X 2,...,X k 对因变变量Y 的回归方程,然后对k 个回归系数进行F 检验,记求得的F 值为{11211,,k F F F Λ},选其最小的记为1i F =min{11211,,k F F F Λ},若有1i F ≤F out ,则可以考虑将自变量X i 从回归方程中剔除掉,不妨设X i 就取为X 1。

再对X 2,X 3,...,X k 对因变量Y 建立的回归方程中重复上述过程,取最小的F 值为2j F ,若有2j F ≤F out ,则将X j 也从回归方程中剔除掉。

不妨设X j 就是X 2。

重复前面的做法,直至在回归方程中的自变量F 检验值均大于F out ,即没有变量可剔除为止。

这时的回归方程就是最终的回归方程。

这种减少法也有一个明显的缺点,就是一开始把全部变量都引入回归方程,这样计算量比较大。

若对一些不重要的变量,一开始就不引入,这样就可以减少一些计算。

3. 变量增减法前面的二种方法各有其特点,若自变量X 1,X 2,...,X k 完全是独立的,则可结合这二种方法,但是,在实际的数据中,自变量X 1,X 2,...,X k 之间往往并不是独立的,而是有一定的相关性存在的,这就会使得随着回归方程中变量的增加和减少,某些自变量对回归方程的贡献也会发生变化。

因此一种很自然的想法是将前二种方法综合起来,也就是对每一个自变量,随着其对回归方程贡献的变化,它随时可能被引入回归方程或被剔除出去,最终的回归模型是在回归方程中的自变量均为显著的,不在回归方程中的自变量均不显著。

三、 引入变量和剔除变量的依据如果在某一步时,已有l 个变量被引入到回归方程中,不妨设为l X X X ,,,21Λ,即已得回归方程ll X X X Y ββββ++++=Λ22110ˆ (33.1)并且有平方和分解式 ESS RSS TSS += (33.2)显然,回归平方和RSS 及残差平方和ESS 均与引入的变量相关。

为了使其意义更清楚起见,将其分别设为RSS (l X X X ,,,21Λ)及ESS (l X X X ,,,21Λ)。

下面我们来考虑,又有一个变量i X (l<i ≤k )被引入回归方程中,这时对于新的回归方程所对应的平方和分解式为TSS = RSS (l X X X ,,,21Λ,i X )+ ESS (l X X X ,,,21Λ, i X ) (33.3) 当变量X i 引入后,回归平方和从RSS (l X X X ,,,21Λ)增加到RSS (l X X X ,,,21Λ,i X ),而相应的残差平方和却从ESS (l X X X ,,,21Λ)降到ESS (l X X X ,,,21Λ, i X ),并有RSS (l X X X ,,,21Λ , i X )-RSS (l X X X ,,,21Λ)= ESS (l X X X ,,,21Λ)-ESS (l X X X ,,,21Λ , i X ) (33.4)记),,,(),,,,(2121l i l i X X X RSS X X X X RSS W ΛΛ-=,它反映了由于引入i X 后,i X 对回归平方和的贡献,也等价于引入i X 后残差平方和所减少的量,称其为i X 对因变量Y 的方差贡献,故考虑检验统计量()()()1/,,,,,,,2121--=l N X X X X ESS X X X W F i l l i i ΛΛ (33.5)其中N 为样本量,l 是已引入回归方程的变量个数,这时若有in i F F ≥,则可以考虑将自变量i X 引入回归方程,否则不能引入。

实际上大于F in 的变量开始时可能同时有几个,那么是否将它们都全部引入呢?实际编程序时并不是一起全部引入,而是选其最大的一个引入回归方程。

关于剔除变量,如果已有l 个变量被引入回归方程,不失一般性,设其为l X X X ,,,21Λ,所对应的平方和分解公式为:),,,,(),,,,,(2121l i l i X X X X ESS X X X X RSS TSS ΛΛΛΛ+= (33.6) 其中l i ,,2,1Λ=为了研究每个变量在回归方程中的作用,我们来考虑分别删掉X i (i =1,2,...,l 后相应的平方和分解公式为:),,,,,(),,,,(11211121l i i l i i X X X X X ESS X X X X X RSS TSS ΛΛΛΛ+-+-+= (33.7) 这时,回归平方和从),,,,,(21l i X X X X RSS ΛΛ降为),,,,(1121l i i X X X X X RSS ΛΛ+-,同时残差也发生相应的变化。

残差平方和从),,,,(21l i X X X X ESS ΛΛ增加到),,,,,(1121l i i X X X X X ESS ΛΛ+-,i X 对回归平方和的贡献,也等价于删除i X 后残差平方和所增加的量,同理可表示为:),,,,(),,,,(),,,,(),,,,(211121112121l i l i i l i i l i i X X X X ESS X X X X X ESS X X X X X RSS X X X X RSS W ΛΛΛΛΛΛΛΛ-=-=+-+- (33.8)与前同理,我们来构造检验统计量 ()()()1/,,,,,,,,,2121--=l N X X X X ESS X X X X W F l i l i i i ΛΛΛΛ (33.9)显然,这时F i 越小,则说明i X 在回归方程中起的作用(对回归方程的贡献)越小,也就是若有out i F F ≤,则可以考虑将自变量i X 从回归方程中剔除掉,我们在编程序时,每次只剔除一个,因此,我们每次选择最小的),,,min(21l i F F F F Λ=来与out F 进行比较。