机器学习中的核函数

径向核函数-概述说明以及解释

径向核函数-概述说明以及解释1.引言1.1 概述径向核函数(Radial Basis Function,RBF)是一种在机器学习领域广泛应用的核函数,它通过映射数据到高维特征空间来解决非线性分类和回归问题。

RBF核函数的特点是能够捕获数据之间的非线性关系,从而提高模型的泛化能力和预测准确性。

本文将从理解径向核函数的原理和应用、对其优缺点进行分析,并在结论部分对其进行总结和展望,以期为读者提供全面的了解和认识。

1.2 文章结构文章结构部分:本文主要分为三个部分,分别是引言、正文和结论。

在引言部分,将介绍径向核函数的概念和目的,为读者提供对该主题的初步了解。

同时,也会介绍本文的结构和内容安排,为读者呈现清晰的阅读框架。

正文部分将深入探讨径向核函数的理解和应用。

通过对径向核函数的原理和算法进行解析,帮助读者更好地理解其在机器学习和模式识别领域中的作用。

同时,本文还将探讨径向核函数的优缺点,对其在实际应用中的效果进行分析和评价。

结论部分将对全文进行总结,回顾本文所探讨的内容和观点。

同时,还将展望径向核函数在未来的应用前景,探讨其可能的发展方向。

最后,通过一些结束语,为本文画上一个完美的句号。

1.3 目的本文旨在深入探讨径向核函数在机器学习领域的应用及其原理。

通过对径向核函数的理解和应用实例的展示,我们希望读者能够更加全面地了解这一重要的核函数,并能够在实际问题中灵活运用。

同时,我们也将对径向核函数的优缺点进行分析,帮助读者在选择合适的核函数时有所侧重和考虑。

最终,我们希望通过本文的阐述,为读者提供了解径向核函数的深入洞察,并为其在实际应用中提供指导和帮助。

2.正文2.1 理解径向核函数径向核函数(RBF)是一种常用的核函数,也称为高斯核函数。

在支持向量机(SVM)等机器学习算法中,径向核函数被广泛应用于非线性分类和回归问题。

理解径向核函数的关键在于理解其计算方式和作用原理。

径向核函数的计算方式是通过测量数据点与指定中心点之间的距离来评估它们之间的相似性。

matlab核函数

matlab核函数在MATLAB中,核函数主要用于支持向量机(SVM)和其他机器学习算法。

这些函数用于计算两个向量之间的相似性或距离。

以下是一些常见的核函数:1. **线性核函数(Linear Kernel)**:```matlabK = x * y';```2. **多项式核函数(Polynomial Kernel)**:```matlabK = (gamma * x * y' + coef0)^degree;```3. **高斯径向基函数(Gaussian RBF Kernel)**:```matlabK = exp(-gamma * (x - y)' * (x - y));```4. **Sigmoid核函数(Sigmoid Kernel)**:```matlabK = tanh(gamma * x * y' + coef0);```其中,`x` 和`y` 是输入向量,`gamma` 和`coef0` 是核函数的参数,`degree` 是多项式核函数的度数。

在MATLAB的机器学习工具箱中,你可以使用`fitcknn` 函数来训练一个基于核的k近邻(KNN)分类器,其中你可以选择不同的核函数类型。

例如:```matlab% 创建一些数据X = [randn(100, 2) randn(100, 2)]; % 创建两个类别Y = [ones(100, 1) -1*ones(100, 1)]; % 对应的标签% 使用'rbf' 核函数训练一个基于核的KNN分类器SVMModel = fitcknn(X, Y, 'KernelFunction', 'rbf');```请注意,选择哪种核函数通常取决于你的具体应用和数据特性。

不同的核函数可能会产生不同的结果,因此需要根据你的问题进行适当的调整和实验。

贝叶斯优化核函数简介

贝叶斯优化核函数简介

贝叶斯优化(Bayesian optimization)是一种基于贝叶斯推断的优化方法,用于在复杂的搜索空间中找到最优解。

在机器学习和优化领域中被广泛应用。

核函数是机器学习中常用的一个概念,它可以衡量两个样本之间的相似度。

核函数将输入样本映射到一个高维特征空间,通过计算在该特征空间中的内积来度量样本之间的相似度。

贝叶斯优化的核函数是用于在搜索空间中定义样本之间相似度的函数,常用的核函数有高斯核函数(也称为径向基函数)和线性核函数等。

它们根据样本的特征来计算样本之间的相似度。

贝叶斯优化中的核函数可以用于以下两个方面:

1. 代理模型:贝叶斯优化通常使用代理模型来近似目标函数。

核函数可以用于定义代理模型中样本之间的相似度,例如高斯过程回归中的核函数。

通过观察已经评估过的样本点和目标函数值之间的关系,贝叶斯优化可以使用核函数构建代理模型,并使用该模型进行进一步的优化和探索。

2. 采样策略:贝叶斯优化根据代理模型的预测结果来选择下一个样本点进行评估,以在搜索空间中找到更好的解。

核函数可以用于计算不同样本点之间的相似度,进而选择具有高不确定性或潜在好潜力的样本点进行采样。

常用的策略包括最大化期望改进(Expected Improvement)和置信上界(Upper Confidence Bound),它们利用核函数的特性来平衡探索和利用之间的权衡。

总之,贝叶斯优化中的核函数在定义样本之间的相似度、构建代理模型和制定采样策略等方面起着重要的作用。

通过合理选择核函数,可以提高优化算法的效率和准确性。

常见的核函数

常见的核函数核函数是机器学习中一种常用的方法,它主要用于将高维空间中的数据映射到低维空间中,从而提升算法的性能。

核函数在SVM、PCA、KPCA等机器学习算法中广泛应用。

下面我们将介绍常见的核函数。

1. 线性核函数线性核函数是最简单的核函数之一,它是一种将数据点映射到低维空间的方式,其表达式如下:K(x_i, x_j) = (x_i * x_j)其中x_i, x_j是样本数据集中的两个数据,返回一个标量值。

线性核函数的优点在于需要的计算量较小,适用于大型数据集,但它的缺点是它只能处理线性分离的数据。

2. 多项式核函数其中x_i, x_j是样本数据集中的两个数据,c是一个常数,d是多项式的度数。

多项式核函数适用于非线性分离的数据。

3. 径向基函数(RBF)核函数其中x_i, x_j是样本数据集中的两个数据,gamma是一个正常数,||x_i - x_j||^2表示两个数据点之间的欧几里得距离的平方。

4. Sigmoid核函数其中x_i, x_j是样本数据集中的两个数据,alpha和beta是Sigmoid函数参数。

Sigmoid核函数适用于二分类问题。

上述四种核函数都是常见的核函数,它们各自有不同的优劣势,在不同的机器学习算法中应该选择适当的核函数来处理不同的数据。

除了上述四种常见的核函数,还有其他的一些核函数也具有重要的应用价值。

5. Laplacian核函数Laplacian核函数计算方式类似于径向基函数,但是它将样本数据点间的距离转化成样本数据点间的相似度,其表达式如下:K(x_i, x_j) = exp(-gamma * ||x_i - x_j||)其中gamma和径向基函数中的参数相同。

Laplacian核函数在图像识别和自然语言处理等领域有着广泛的应用。

6. ANOVA核函数ANOVA核函数通常用于数据分析和统计学中,它对混合多种类型数据的模型有较好的表现,其表达式如下:其中h_i和h_j是从样本数据点中提取出来的特征,gamma是一个常数。

核函数的计算与应用

核函数的计算与应用核函数在机器学习和模式识别领域中扮演着重要的角色。

它们能够将输入数据映射到更高维度的特征空间,从而解决线性不可分的问题。

本文将介绍核函数的计算方法,并探讨其在支持向量机(SVM)和主成分分析(PCA)等算法中的应用。

一、核函数的计算方法核函数是一种在机器学习中常用的函数,用于将低维空间的数据映射到高维空间。

常见的核函数包括线性核函数、多项式核函数、高斯径向基函数等。

1. 线性核函数线性核函数是最简单的核函数之一,它可以直接对原始特征进行线性变换。

其计算方法为:K(x, y) = x·y2. 多项式核函数多项式核函数通过多项式的方式将数据映射到高维空间。

其计算方法为:K(x, y) = (x·y + c)^d3. 高斯径向基函数(RBF)高斯径向基函数是一种常用的核函数,它可以将数据映射到无穷维的特征空间。

其计算方法为:K(x, y) = exp(-γ ||x-y||^2)其中,γ为高斯核函数的带宽参数,||x-y||表示输入数据x和y之间的欧氏距离。

二、核函数在支持向量机中的应用支持向量机是一种常用的分类器,它能够在非线性可分问题上取得较好的性能。

核函数在支持向量机中起到了关键作用。

1. 线性支持向量机线性支持向量机通过线性核函数对数据进行映射,从而实现特征的扩展。

它在处理线性可分问题时表现出色,计算效率高。

2. 非线性支持向量机非线性支持向量机通过非线性核函数对数据进行映射,从而解决非线性可分问题。

常用的非线性核函数包括多项式核函数和高斯径向基函数。

三、核函数在主成分分析中的应用主成分分析是一种常用的降维技术,它通过将高维数据映射到低维空间,提取出最重要的特征。

核函数在主成分分析中也有广泛的应用。

1. 核主成分分析(Kernel PCA)核主成分分析是主成分分析的扩展形式,它通过非线性核函数将数据映射到高维空间,再进行降维操作。

相比传统主成分分析,核主成分分析能够更好地处理非线性关系。

高斯径向基核函数

高斯径向基核函数

高斯径向基核函数是一种在机器学习中广泛应用的核函数,它的形式为:

K(x_i, x_j) = exp(-γ ||x_i - x_j||)

其中,x_i和x_j分别表示数据集中的两个样本,γ为高斯函数的带宽参数,||.||表示欧氏距离。

高斯径向基核函数可以将数据从低维空间映射到高维空间,从而更容易处理线性不可分的问题。

在支持向量机、核主成分分析、径向基函数神经网络等领域广泛应用。

在实际使用中,高斯径向基核函数的带宽参数γ需要进行调参,不同的γ值会对分类结果产生不同的影响。

一般而言,γ越大,模型越接近高斯分布,分类结果可能会出现过拟合;γ越小,模型越接近于线性,分类结果可能会出现欠拟合。

因此,需要根据具体问题和数据特点来选择合适的γ值。

- 1 -。

高斯过程核函数选取

高斯过程核函数选取高斯过程是一种常用的机器学习方法,核函数是高斯过程的重要组成部分。

核函数的选取直接影响到高斯过程的性能和效果。

以下是一些常用的高斯过程核函数及其特点:1. 高斯核函数(Gaussian Kernel):也称为径向基函数(Radial Basis Function,RBF)核函数,是高斯过程中最常用的核函数之一。

它的形式为:$k(x,x')=\sigma^2\exp(-\frac{\|x-x'\|^2}{2l^2})$,其中$\sigma^2$和$l$是超参数,$\|x-x'\|$表示$x$和$x'$之间的欧几里得距离。

高斯核函数的优点是具有很好的拟合能力和泛化能力,但是超参数的选择比较困难。

2. 线性核函数(Linear Kernel):线性核函数的形式为$k(x,x')=x^Tx'$,其中$x$和$x'$是输入向量。

线性核函数的优点是计算速度快,但是它的拟合能力比较弱。

3. 多项式核函数(Polynomial Kernel):多项式核函数的形式为$k(x,x')=(x^Tx'+c)^d$,其中$c$和$d$是超参数。

多项式核函数的优点是可以处理非线性问题,但是超参数的选择比较困难。

4. 指数核函数(Exponential Kernel):指数核函数的形式为$k(x,x')=\exp(-\frac{\|x-x'\|}{l})$,其中$l$是超参数。

指数核函数的优点是可以处理非线性问题,但是它的拟合能力比较弱。

5. Laplace核函数(Laplace Kernel):Laplace核函数的形式为$k(x,x')=\exp(-\frac{\|x-x'\|}{l})$,其中$l$是超参数。

Laplace核函数的优点是可以处理非线性问题,但是它的拟合能力比较弱。

以上是一些常用的高斯过程核函数及其特点,具体选取哪种核函数需要根据具体问题进行选择。

sigmoid核函数

sigmoid核函数

Sigmoid核函数,又称为S型函数,是一种非线性的函数,具有良好的分类性能,是计算机视觉任务中非常常用的对象分类函数。

Sigmoid核函数本质上是一种非线性变换,将一个持续变化的实数型输入信号变换为一个位值信号量,以此来模拟类比晶体管する二进制逻辑电路的分类器,从而实现对输入信号的二元分类。

Sigmoid核函数的函数公式为:

f(x) = 1/(1+e^-x)

其中,e是自然对数的底数,x为自变量。

Sigmoid核函数的函数图如下所示:

Sigmoid核函数的特点在于,当自变量的值越来越大,函数的值也越来越大,但不会越大越好,而是有一个临界点,当自变量超过临界点时,函数值固定为1,当自变量小于临界点时,函数值固定为0.同时,Sigmoid核函数的函数形态较为平滑,函数导数也很大,因此在求解梯度下降法的时候,可以多次调整自变量的取值,使模型的参数在迭代的过程中变化得更加平滑,从而提高求解的效率,减少计算量。

Sigmoid核函数在计算机视觉任务中广泛的使用,在识别技术中,用来实现细化分类。

比如,给定一系列距离信息,用Sigmoid核函数可以将其划分为两类,一类属于已知物体,另一类属于其他物体,从而实现物体分类的功能。

此外,Sigmoid核函数还可以用在机器学习领域,如深度学习中的神经网络,用于处理分类问题,如多分类,回

归等。

综上所述,Sigmoid核函数能够比较准确的对实数型输入进行分类,对于计算机视觉和深度学习任务具有良好的拟合作用,是一种处理函数,具有很强的实用价值。

柯西核函数

柯西核函数1. 前言柯西核函数是机器学习中常用的一种核函数,它可以用于支持向量机、K近邻等算法中。

本文将详细介绍柯西核函数的定义、性质以及如何在Python中实现。

2. 柯西核函数的定义柯西核函数是一种径向基函数(RBF)的变体,它的定义如下:$$K(x_i, x_j) = \frac{1}{1 + \gamma ||x_i - x_j||^2}$$其中,$x_i$和$x_j$是输入数据点,$\gamma$是一个常数。

可以看出,柯西核函数与RBF核函数的主要区别在于分母上多了一个常数1。

3. 柯西核函数的性质柯西核函数具有以下性质:- 对称性:$K(x_i, x_j) = K(x_j, x_i)$;- 半正定性:对于任意$n$个数据点$x_1, x_2, ..., x_n$和实数$c_1,c_2, ..., c_n$,有$\sum_{i=1}^{n}\sum_{j=1}^{n}c_ic_jK(x_i,x_j) \ge 0$。

4. 如何在Python中实现柯西核函数下面给出一个Python实现柯西核函数的示例代码:```pythonimport numpy as npdef cauchy_kernel(X, gamma):n_samples = X.shape[0]K = np.zeros((n_samples, n_samples))for i in range(n_samples):for j in range(n_samples):K[i,j] = 1 / (1 + gamma * np.linalg.norm(X[i] - X[j])**2)return K```上述代码中,输入参数X是一个$n \times d$的矩阵,表示$n$个$d$维数据点。

gamma是柯西核函数中的常数。

输出结果K是一个$n \times n$的矩阵,表示每两个数据点之间的核函数值。

5. 柯西核函数的应用柯西核函数可以用于支持向量机、K近邻等算法中。

支持向量机的常见核函数

支持向量机的常见核函数支持向量机是一个流行的机器学习算法,用于分类和回归问题。

核函数是支持向量机中的一个重要组成部分,可以将非线性问题转换为线性问题,从而使该算法更加灵活和强大。

本文将介绍支持向量机的常见核函数及其应用。

一、线性核函数线性核函数是支持向量机最简单的核函数。

该函数对输入的数据进行线性变换,并将非线性问题转换为线性问题。

它的形式为:K(x, y) = x*y,其中x和y表示输入数据的向量。

由于该函数可以充分利用支持向量机的优秀属性,因此被广泛用于大规模数据的分类和回归任务中。

二、多项式核函数多项式核函数在将数据映射到高维空间时,采用多项式式函数进行变换。

该函数的形式为:K(x, y) =(x*y+c)^d,其中c是常数,d为指数。

该核函数可以捕获更多的非线性特征,并提高分类和回归的准确性。

在处理文本分类和图像识别等领域的问题时,多项式核函数非常有效。

三、高斯核函数高斯核函数是支持向量机中最常用的核函数之一。

该函数将数据映射到无限维的空间中,通过测量数据点之间的相似性来建立分类器。

这个核函数的形式为:K(x, y) = exp( -||x-y||^2/2σ^2 ),其中σ是核函数中的参数,控制了点之间的相似性。

高斯核函数在信号处理、生物信息学和语音识别等领域被广泛使用,并且对噪声数据具有良好的鲁棒性。

四、Sigmoid核函数Sigmoid核函数采用Sigmoid函数对数据进行变换,将非线性问题转换为线性问题,从而实现分类和回归的功能。

该函数的形式为:K(x, y) = tanh(αx*y + r ),其中α是一个常数,r是Sigmoid函数的阈值。

Sigmoid核函数通常用于二进制分类问题,例如卫星图像中的目标识别任务。

以上是支持向量机中常见的四种核函数,它们可以充分利用支持向量机的方法来解决分类和回归问题。

在实际应用中,根据不同数据的需求和分析任务,选择合适的核函数可以提高支持向量机的分类和回归的效果。

核函数的实现和应用

核函数的实现和应用核函数是一种优秀的机器学习算法,它可以将高维度数据通过非线性变换映射到低维度的子空间中,用来进行分类或回归。

简单来说,核函数就是一种基于向量内积的函数,可以应用于支持向量机(SVM)等机器学习算法中,使得分类器的性能更加优秀。

一、核函数的实现核函数的实现通常有两种方法:一种是通过数值计算来实现,这种方法适用于简单的核函数,例如径向基函数(RBF)核函数;另一种是通过显式地定义核函数来实现,这种方法适用于复杂的核函数,例如多项式核函数。

1. 数值计算法对于径向基函数核函数,其公式如下:K(x_i, x_j) = exp(-||x_i-x_j||^2/2sigma^2 )其中,x_i和x_j分别表示训练集中的两个样本,sigma为高斯核的带宽参数。

该公式可以通过数值计算来实现,具体步骤如下:(1)计算训练集样本之间的欧几里得距离。

(2)将欧几里得距离除以2sigma^2 。

(3)将结果取负值并进行指数运算。

(4)最终得到核函数的值。

2. 定义核函数法对于复杂的核函数,可以显式地将核函数定义出来,并直接应用到机器学习算法中。

例如,多项式核函数的定义如下:K(x_i, x_j) = (x_i^Tx_j + c)^d其中,c和d分别为常数,x_i和x_j分别表示训练集中的两个样本。

这种方法的优点是可以更容易地定义出多种复杂的核函数,缺点是实现时需要考虑到纬度的规模。

二、核函数的应用核函数在机器学习中有着广泛的应用,下面将具体介绍一些核函数在SVM等机器学习算法中的应用。

1. 线性核函数线性核函数是SVM最简单的核函数之一,其公式如下:K(x_i, x_j) = x_i^Tx_j这种核函数的主要优点是计算速度快、参数较少,且在数据集线性可分的情况下具有好的分类性能。

2. 多项式核函数K(x_i, x_j) = (x_i^Tx_j + c)^d其中,c和d分别为常数。

该核函数的优点在于其能够表达出非线性的分类决策边界,但是需要注意的是,该核函数容易产生过拟合现象。

核函数公式

核函数公式

核函数是机器学习中常用的一种工具,用于将低维数据映射到高维特征空间中,以便更好地进行分类或回归等任务。

核函数的本质是一种相似度度量,它通过计算两个样本在特征空间中的距离来确定它们的相似程度。

本文将介绍常见的几种核函数及其特点。

1. 线性核函数

线性核函数是最简单的核函数之一,它的公式为K(x,y)=x*y。

它的特点是将数据映射到同一维度的特征空间中,效果较差,适用于数据本身线性可分的情况。

2. 多项式核函数

多项式核函数是将数据映射到高维特征空间的一种方式,它的公式为K(x,y)=(x*y+1)^d,其中d为多项式的次数。

它的特点是可以处理一些非线性可分的情况,但需要选择合适的多项式次数,否则会出现过拟合或欠拟合的问题。

3. 径向基核函数

径向基核函数是常用的一种核函数,它的公式为K(x,y)=exp(-||x-y||^2/2σ^2),其中σ为控制函数衰减速度的参数。

它的特点是可以将数据映射到无穷维的特征空间中,适用于处理复杂的非线性可分问题。

但需要注意的是,径向基核函数对参数的选择比较敏感,不当的参数选择可能会导致分类效果不佳。

4. Sigmoid核函数

Sigmoid核函数是一种常用的核函数,它的公式为K(x,y)=tanh(αx*y+β),其中α和β为参数。

它的特点是可以处理一些非线性可分的问题,但需要选择合适的参数,否则会出现过拟合或欠拟合的问题。

此外,Sigmoid核函数在实践中并不常用。

以上是常见的几种核函数,它们各自有不同的特点和适用范围。

在使用核函数时,需要根据具体问题选择合适的核函数及其参数,以获得最佳的分类或回归效果。

机器学习:SVM(核函数、高斯核函数RBF)

机器学习:SVM(核函数、⾼斯核函数RBF)⼀、核函数(Kernel Function) 1)格式K(x, y):表⽰样本 x 和 y,添加多项式特征得到新的样本 x'、y',K(x, y) 就是返回新的样本经过计算得到的值;在 SVM 类型的算法 SVC() 中,K(x, y) 返回点乘:x' . y'得到的值; 2)多项式核函数业务问题:怎么分类⾮线性可分的样本的分类?内部实现:1. 对传⼊的样本数据点添加多项式项;2. 新的样本数据点进⾏点乘,返回点乘结果;多项式特征的基本原理:依靠升维使得原本线性不可分的数据线性可分;升维的意义:使得原本线性不可分的数据线性可分;例:1. ⼀维特征的样本,两种类型,分布如图,线性不可分:2.3. 为样本添加⼀个特征:x2,使得样本在⼆维平⾯内分布,此时样本在 x 轴升的分布位置不变;如图,可以线性可分:4. 3)优点 / 特点不需要每次都具体计算出原始样本点映射的新的⽆穷维度的样本点,直接使⽤映射后的新的样本点的点乘计算公式即可;减少计算量减少存储空间1. ⼀般将原始样本变形,通常是将低维的样本数据变为⾼维数据,存储⾼维数据花费较多的存储空间;使⽤核函数,不⽤考虑原来样本改变后的样⼦,也不⽤存储变化后的结果,只需要直接使⽤变化的结果进⾏运算并返回运算结果即可;核函数的⽅法和思路不是 SVM 算法特有,只要可以减少计算量和存储空间,都可以设计核函数⽅便运算;对于⽐较传统的常⽤的机器学习算法,核函数这种技巧更多的在 SVM 算法中使⽤; 4)SVM 中的核函数svm 类中的 SVC() 算法中包含两种核函数:1. SVC(kernel = 'ploy'):表⽰算法使⽤多项式核函数;2. SVC(kernel = 'rbf'):表⽰算法使⽤⾼斯核函数;SVM 算法的本质就是求解⽬标函数的最优化问题;求解最优化问题时,将数学模型变形: 5)多项式核函数格式:from sklearn.svm import SVCsvc = SVC(kernel = 'ploy')思路:设计⼀个函数( K(x i, x j) ),传⼊原始样本(x(i)、 x(j)),返回添加了多项式特征后的新样本的计算结果(x'(i) . x'(j));内部过程:先对 x i、x j添加多项式,得到:x'(i)、 x'(j),再进⾏运算:x'(i) . x'(j);1. x(i)添加多项式特征后:x'(i);2. x(j)添加多项式特征后:x'(j);3. x(i) . x(j)转化为:x'(i) . x'(j);其实不使⽤核函数也能达到同样的⽬的,这⾥核函数相当于⼀个技巧,更⽅便运算;⼆、⾼斯核函数(RBF)业务问题:怎么分类⾮线性可分的样本的分类? 1)思想业务的⽬的是样本分类,采⽤的⽅法:按⼀定规律统⼀改变样本的特征数据得到新的样本,新的样本按新的特征数据能更好的分类,由于新的样本的特征数据与原始样本的特征数据呈⼀定规律的对应关系,因此根据新的样本的分布及分类情况,得出原始样本的分类情况。

机器学习中的核函数优化研究

机器学习中的核函数优化研究机器学习是一种利用计算机系统实现“自学习”的方法,它的目标是使机器能够逐渐地提高其性能。

在机器学习领域中,核函数是一种非常重要的工具,其优化研究也是热点话题。

所谓核函数,就是一种将非线性可分问题转化为线性可分问题的数学工具。

简单来说,如果在一个高维空间中,两个数据点之间的关系是非线性的,那么它们在低维空间中的关系则是线性的,通过核函数的变换,可以将数据转化到低维空间中,从而提高模型精度。

由于核函数在机器学习中的应用十分广泛,因此如何对核函数进行优化成为了一个研究热点。

目前,研究人员提出的主要方法有以下几种。

1.特征空间随机映射由于核函数将高维空间中的数据映射到低维空间中,对于比较大的数据集,随机映射是一种常见的方法。

随机映射可以将原始数据点通过一些随机映射的方法,转化为低维空间中的点,从而加快计算速度。

此外,随机映射还可以防止过拟合。

2.泰勒展开式方法另一种常见的核函数优化方法是使用泰勒展开式,这种方法可以对核函数进行一系列的近似和推导,从而得到最优解。

泰勒展开式方法的优点在于可以避免精度损失,但缺点是计算复杂度较高,需要大量的计算和存储资源。

3.蒙特卡罗方法蒙特卡罗方法是一种常见的数值计算方法,可以用来对复杂的问题进行求解。

在核函数优化中,蒙特卡罗方法可以用来计算核函数的期望值,从而得到最优的核函数。

由于该方法需要对大量的数据进行计算,因此需要使用并行计算等技术,以提高计算速度。

4.梯度下降方法梯度下降方法是一种基于误差反向传播的优化算法,主要用于神经网络和其他机器学习模型中的权重更新。

在核函数优化中,梯度下降方法可以用来求解最优核函数,从而更好地拟合模型。

总的来说,核函数优化是机器学习领域中的一个热门话题,不同的优化方法具有各自的优缺点。

研究人员需要根据自己的需求和实际情况,选择合适的方法进行优化。

相信随着技术的不断进步和不断研究,核函数优化的效果将得到进一步的提高。

协方差函数和核函数的关系

协方差函数和核函数的关系

协方差函数和核函数是统计学和机器学习中常用的两种函数,它们在很多领域都有着广泛的应用。

协方差函数是描述两个变量之间关系的函数,它可以用于描述两个随机变量之间的相关性。

而核函数则是一种用于将特征映射到高维空间的函数,它可以将原始的低维数据转换为高维数据,从而使得数据在高维空间中更容易被分类。

协方差函数和核函数之间的关系在很多情况下是很紧密的。

事实上,有些核函数可以被表示为协方差函数的形式,这种表示方式被称为协方差核函数。

协方差核函数的优点是它们可以很容易地与精度矩阵相关的先验分布相结合,从而形成贝叶斯模型。

此外,协方差核函数还可以用于描述多维随机变量的联合分布,因此在许多分析问题时也会被广泛使用。

在实际应用中,协方差函数和核函数通常会结合使用。

例如,在使用高斯过程回归时,协方差函数可以用于描述观测值之间的相关性,而核函数则可以用于将输入数据映射到高维空间中,从而使得数据在高维空间中更容易被处理。

因此,了解协方差函数和核函数之间的关系对于理解这些方法的工作原理以及如何在实际应用中使用它们是

非常重要的。

- 1 -。

核函数推导过程

核函数推导过程核函数是机器学习中一个重要的概念,能够帮助我们从低维空间将数据映射到高维空间,从而让线性分类器能够处理非线性问题。

本文将简要介绍核函数的定义和推导过程。

首先,我们来看一下什么是核函数。

核函数可以描述为一个函数 K(x, y),它能够将输入数据 x 和 y 映射到一个高维或无限维的特征空间,从而更好地区分不同的数据类别。

具体来说,核函数的作用是将两个样本映射到同一空间中,当它们之间的距离很短时,它们被认为是相似的,距离较大时则认为它们是不相似的。

接下来,我们来看一下核函数的推导过程。

假设我们有一个低维空间中的向量 x 和 y,现在我们想将它们映射到高维空间。

假设我们有一个线性函数 f(x),它能够将 x 映射到高维空间,如下所示:f(x) = (w1 x1 + w2 x2 + … + wn xn)T其中,w 是一个权重向量。

为了描述 y 在高维空间中的点,我们可以将线性函数应用于 y,得到:f(y) = (w1 y1 + w2 y2 + … + wn yn)T现在,我们需要定义核函数并推导出它的具体形式。

我们定义核函数为:K(x, y) = φ(x)T φ(y)其中,φ 表示将向量 x 映射到高维空间后的结果。

我们可以将φ 写成下面的形式:φ(x) = (φ1(x), φ2(x), …, φn(x))T接下来,我们可以将核函数表示为:K(x, y) = (φ1(x)φ1(y) + φ2(x)φ2(y) + … + φn(x)φn(y))这样我们就得到K 的具体形式,可以将其应用于分类器或聚类算法中。

总结一下,核函数是一个非常强大的工具,可以帮助我们将数据从低维空间映射到高维空间,从而更好地区分不同的数据类别。

在实际应用中,我们可以使用不同类型的核函数来处理不同类型的数据集,从而获得更好的分类和聚类结果。

高斯核函数的宽度参数

高斯核函数的宽度参数

高斯核函数是机器学习中常用的核函数之一,它可以将数据映射到高维空间中进行分类或回归。

其中,高斯核函数的宽度参数是影响函数形状的重要参数。

高斯核函数的形式为:

K(x, y) = exp(-||x-y||^2 / (2σ^2))

其中,x和y是数据点,||x-y||是欧几里得距离,σ是宽度参数。

当σ较小时,高斯核函数的值会随着距离的增加而降低得很快,这会使得模型过于复杂,可能出现过拟合的情况;而当σ较大时,高斯核函数的值会缓慢降低,这会使得模型过于简单,可能出现欠拟合的情况。

因此,选择合适的σ值对于机器学习任务的性能至关重要。

通常情况下,可以通过交叉验证等方法来确定最优的σ值。

- 1 -。

高斯径向基核函数的作用

高斯径向基核函数的作用高斯径向基核函数在机器学习和模式识别领域中起着重要的作用。

它是一种常用的核函数,用于将数据从低维空间映射到高维空间,以便于更好地进行分类或回归任务。

让我们了解一下什么是核函数。

在机器学习中,核函数是一种将数据从原始空间映射到特征空间的函数。

它的作用是通过对输入数据进行非线性映射,将原本线性不可分的数据转换为线性可分的形式。

这样一来,我们就可以使用线性分类器或回归器来处理这些数据。

高斯径向基核函数,也称为高斯核函数或径向基函数,是一种常用的核函数之一。

它的形式为:k(x, x') = exp(-||x - x'||^2 / (2 * σ^2))其中,x和x'分别是输入样本的特征向量,||x - x'||^2表示两个特征向量之间的欧氏距离的平方,σ是高斯核函数的参数,控制着样本点分布的广度。

高斯径向基核函数的作用是通过计算样本点之间的相似性来实现数据的非线性映射。

具体来说,对于给定的输入样本x,高斯径向基核函数会计算它与其他样本点之间的相似性,并将相似性作为新的特征表示。

相似性由欧氏距离计算得到,距离越近相似性越高。

通过使用高斯径向基核函数,我们可以将原始数据映射到高维空间中的非线性特征空间。

在这个高维空间中,数据更容易被线性分类器或回归器分割或拟合。

这是因为高斯径向基核函数能够将数据在特征空间中进行更加准确的分类或回归。

使用高斯径向基核函数的算法有很多,比如支持向量机(SVM)、径向基函数网络(RBFN)等。

这些算法在分类、回归、聚类等任务中表现出了很好的性能。

它们的成功离不开高斯径向基核函数在数据映射方面的作用。

总结一下,高斯径向基核函数在机器学习和模式识别领域中具有重要的作用。

它通过计算样本点之间的相似性,将数据从低维空间映射到高维空间,使得数据更容易被线性分类器或回归器处理。

高斯径向基核函数的应用广泛,能够提高分类、回归、聚类等任务的性能。

poly核函数

poly核函数

Poly核函数是一种常用的机器学习中的核技术,它利用多项式函数将低维度的输入数据映射到高维度的空间来进行分类。

它通常用于分类和回归问题,可以有效地提高学习算法的准确性和鲁棒性。

Poly核函数可以将输入数据映射到高维空间,使结果更加接近实际数据分布,从而提高分类能力。

它可以处理非线性关系,探测数据中潜在的相关性和特征。

Poly核函数可以用于分类,它可以将输入数据映射到高维空间,从而有效地增强了模型的鲁棒性和准确性。

它将原有输入数据的维度扩展为更多的维度,使模型具有更强的表示能力,可以处理复杂的分类问题。

此外,由于Poly核函数可以有效解决线性模型无能力模拟非线性关系的问题,所以它也可以用于解决回归问题。

Poly核函数的优点不仅仅局限于分类和回归问题,它还可以有效提高模型的准确性和鲁棒性。

Poly核函数的高维空间不仅可以更好地表示数据,而且可以更好地拟合数据,使模型能够更好地拟合数据,从而达到更好的分类和回归效果。

尽管Poly核函数很强大,但它也有一些局限性。

首先,它增加了计算量,因为它需要对每一个特征进行拆分,从而增加了模型计算量。

其次,由于训练太过复杂,如果数据量过大,可能会导致模型出现过拟合的情况。

因此,使用poly核函数时,需要仔细选取正则化系数来减少模型的过拟合问题。

综上所述,Poly核函数是一种非常有用的机器学习技术,可以

有效地提高模型的准确性和鲁棒性,有效地拟合分类和回归问题。

尽管它也有一些缺点,但它仍然是一项非常有用的技术,可以有效地改善模型的性能。

核函数的带宽

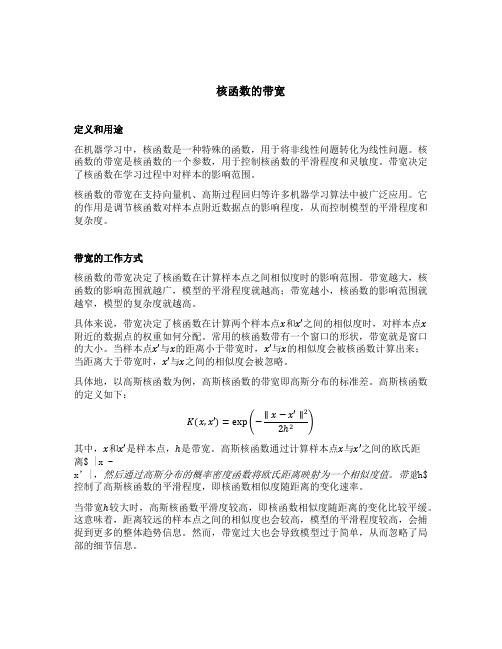

核函数的带宽定义和用途在机器学习中,核函数是一种特殊的函数,用于将非线性问题转化为线性问题。

核函数的带宽是核函数的一个参数,用于控制核函数的平滑程度和灵敏度。

带宽决定了核函数在学习过程中对样本的影响范围。

核函数的带宽在支持向量机、高斯过程回归等许多机器学习算法中被广泛应用。

它的作用是调节核函数对样本点附近数据点的影响程度,从而控制模型的平滑程度和复杂度。

带宽的工作方式核函数的带宽决定了核函数在计算样本点之间相似度时的影响范围。

带宽越大,核函数的影响范围就越广,模型的平滑程度就越高;带宽越小,核函数的影响范围就越窄,模型的复杂度就越高。

具体来说,带宽决定了核函数在计算两个样本点x和x′之间的相似度时,对样本点x 附近的数据点的权重如何分配。

常用的核函数带有一个窗口的形状,带宽就是窗口的大小。

当样本点x′与x的距离小于带宽时,x′与x的相似度会被核函数计算出来;当距离大于带宽时,x′与x之间的相似度会被忽略。

具体地,以高斯核函数为例,高斯核函数的带宽即高斯分布的标准差。

高斯核函数的定义如下:K(x,x′)=exp(−∥x−x′∥22ℎ2)其中,x和x′是样本点,ℎ是带宽。

高斯核函数通过计算样本点x与x′之间的欧氏距离$ |x -x’|,然后通过高斯分布的概率密度函数将欧氏距离映射为一个相似度值。

带宽h$控制了高斯核函数的平滑程度,即核函数相似度随距离的变化速率。

当带宽ℎ较大时,高斯核函数平滑度较高,即核函数相似度随距离的变化比较平缓。

这意味着,距离较远的样本点之间的相似度也会较高,模型的平滑程度较高,会捕捉到更多的整体趋势信息。

然而,带宽过大也会导致模型过于简单,从而忽略了局部的细节信息。

当带宽ℎ较小时,高斯核函数的平滑度较低,即核函数相似度随距离的变化比较剧烈。

这意味着,距离较远的样本点之间的相似度较低,模型的复杂度较高,会更加关注局部的细节信息。

然而,带宽过小会导致模型过于复杂,容易受到噪声的干扰。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Kernel Functions for Machine Learning Applications机器学习中的核函数1.核函数概述In recent years, Kernel methods have received major attention, particularly due to the increased popularity of the Support Vector Machines. Kernel functions can be used in many applications as they provide a simple bridge from linearity to non-linearity for algorithms which can be expressed in terms of dot products. In this article, we will list a few kernel functions and some of their properties.Many of these functions have been incorporated in , a extension framework for the popular Framework which also includes many other statistics and machine learning tools.2.机器学习中的核函数Kernel Methods(核函数方法)Kernel methods are a class of algorithms for pattern analysis or recognition, whose best known element is the support vector machine (SVM). The general task of pattern analysis is to find and study general types of relations (such as clusters, rankings, principal components, correlations, classifications) in general types of data (such as sequences, text documents, sets of points, vectors, images, graphs, etc) (Wikipedia, 2010a).The main characteristic of Kernel Methods, however, is their distinct approach to this problem. Kernel methods map the data into higher dimensional spaces in the hope that in this higher-dimensional space the data could become more easily separated or better structured. There are also no constraints on the form of this mapping, which could even lead to infinite-dimensional spaces. This mapping function, however, hardly needs to be computed because of a tool called the kernel trick.The Kernel Trick(核函数构造)The kernel trick is a mathematical tool which can be applied to any algorithm which solely depends on the dot product between two vectors. Wherever a dot product is used, it is replaced by a kernel function. When properly applied, those candidate linear algorithms are transformed into a non-linear algorithms (sometimes with little effort or reformulation). Those non-linear algorithms are equivalent to their linear originals operating in the range space of a feature space φ. However, because kernels are used, the φ function does not need to be ever explicitly computed. This is highly desirable, as we noted previously, because this higher-dimensional feature space could even be infinite-dimensional and thus infeasible to compute. There are also no constraints on the nature of the input vectors. Dot products could be defined between any kind of structure, such as trees or strings.Kernel Properties(核函数特性)Kernel functions must be continuous, symmetric, and most preferably should have a positive (semi-) definite Gram matrix. Kernels which are said to satisfy the Mercer's theorem are positivesemi-definite, meaning their kernel matrices have no non-negative Eigen values. The use of a positive definite kernel insures that the optimization problem will be convex and solution will be unique.However, many kernel functions which aren’t strictly positive definite also have been shown to perform very well in practice. An example is the Sigmoid kernel, which, despite its wide use, it is not positive semi-definite for certain values of its parameters. Boughorbel (2005) also experimentally demonstrated that Kernels which are only conditionally positive definite can possibly outperform most classical kernels in some applications.Kernels also can be classified as anisotropic stationary, isotropic stationary, compactly supported, locally stationary, nonstationary or separable nonstationary. Moreover, kernels can also be labeled scale-invariant or scale-dependant, which is an interesting property as scale-invariant kernels drive the training process invariant to a scaling of the data.Choosing the Right Kernel(怎样选择正确的核函数)Choosing the most appropriate kernel highly depends on the problem at hand - and fine tuning its parameters can easily become a tedious and cumbersome task. Automatic kernel selection is possible and is discussed in the works by Tom Howley and Michael Madden.The choice of a Kernel depends on the problem at hand because it depends on what we are trying to model. Apolynomial kernel, for example, allows us to model feature conjunctions up to the order of the polynomial. Radial basis functions allows to pick out circles (or hyperspheres) - in constrast with the Linear kernel, which allows only to pick out lines (or hyperplanes).The motivation behind the choice of a particular kernel can be very intuitive and straightforward depending on what kind of information we are expecting to extract about the data. Please see the final notes on this topic from Introduction to Information Retrieval, by Manning, Raghavan and Schütze for a better explanation on the subject.Kernel Functions(常见的核函数)Below is a list of some kernel functions available from the existing literature. As was the case with previous articles, every LaTeX notation for the formulas below are readily available from their alternate text html tag. I can not guarantee all of them are perfectly correct, thus use them at your own risk. Most of them have links to articles where they have been originally used or proposed.1. Linear KernelThe Linear kernel is the simplest kernel function. It is given by the inner product <x,y> plus an optional constant c. Kernel algorithms using a linear kernel are often equivalent to their non-kernel counterparts, i.e. KPCA with linear kernel is the same as standard PCA.2. Polynomial KernelThe Polynomial kernel is a non-stationary kernel. Polynomial kernels are well suited for problems where all the training data is normalized.Adjustable parameters are the slope alpha, the constant term c and the polynomial degree d.3. Gaussian KernelThe Gaussian kernel is an example of radial basis function kernel.The adjustable parameter sigma plays a major role in the performance of the kernel, and should be carefully tuned to the problem at hand. If overestimated, the exponential will behave almost linearly and the higher-dimensional projection will start to lose its non-linear power. In the other hand, if underestimated, the function will lack regularization and the decision boundary will be highly sensitive to noise in training data.4. Exponential KernelThe exponential kernel is closely related to the Gaussian kernel, with only the square of the norm left out. It is also a radial basis function kernel.5. Laplacian KernelThe Laplace Kernel is completely equivalent to the exponential kernel, except for being less sensitive for changes in the sigma parameter. Being equivalent, it is also a radial basis function kernel.It is important to note that the observations made about the sigma parameter for the Gaussian kernel also apply to the Exponential and Laplacian kernels.6. ANOVA KernelThe ANOVA kernel is also a radial basis function kernel, just as the Gaussian and Laplacian kernels. It is said toperform well in multidimensional regression problems (Hofmann, 2008).7. Hyperbolic Tangent (Sigmoid) KernelThe Hyperbolic Tangent Kernel is also known as the Sigmoid Kernel and as the Multilayer Perceptron (MLP) kernel. The Sigmoid Kernel comes from the Neural Networks field, where the bipolar sigmoid function is often used as anactivation function for artificial neurons.It is interesting to note that a SVM model using a sigmoid kernel function is equivalent to a two-layer, perceptron neural network. This kernel was quite popular for support vector machines due to its origin from neural network theory. Also, despite being only conditionally positive definite, it has been found to perform well in practice.There are two adjustable parameters in the sigmoid kernel, the slope alpha and the intercept constant c. A common value for alpha is 1/N, where N is the data dimension. A more detailed study on sigmoid kernels can be found in theworks by Hsuan-Tien and Chih-Jen.8. Rational Quadratic KernelThe Rational Quadratic kernel is less computationally intensive than the Gaussian kernel andcan be used as an alternative when using the Gaussian becomes too expensive.9. Multiquadric KernelThe Multiquadric kernel can be used in the same situations as the Rational Quadratic kernel. As is the case with the Sigmoid kernel, it is also an example of an non-positive definite kernel.10. Inverse Multiquadric KernelThe Inverse Multi Quadric kernel. As with the Gaussian kernel, it results in a kernel matrix with full rank (Micchelli, 1986) and thus forms a infinite dimension feature space.11. Circular KernelThe circular kernel is used in geostatic applications. It is an example of an isotropic stationary kernel and is positive definite in .12. Spherical KernelThe spherical kernel is similar to the circular kernel, but is positive definite in R3.13. Wave KernelThe Wave kernel is also symmetric positive semi-definite (Huang, 2008).14. Power KernelThe Power kernel is also known as the (unrectified) triangular kernel. It is an example of scale-invariant kernel (Sahbi and Fleuret, 2004) and is also only conditionally positive definite.15. Log KernelThe Log kernel seems to be particularly interesting for images, but is only conditionally positive definite.16. Spline KernelThe Spline kernel is given as a piece-wise cubic polynomial, as derived in the works by Gunn (1998).17. B-Spline (Radial Basis Function) KernelThe B-Spline kernel is defined on the interval [−1, 1]. It is given by the recursive formula:In the work by Bart Hamers it is given by:Alternatively, Bn can be computed using the explicit expression (Fomel, 2000):Where x+ is defined as the truncated power function:18. Bessel KernelThe Bessel kernel is well known in the theory of function spaces of fractional smoothness. It is given by:where J is the Bessel function of first kind. However, in the Kernlab for R documentation, the Bessel kernel is said to be:19. Cauchy KernelThe Cauchy kernel comes from the Cauchy distribution (Basak, 2008). It is a long-tailed kernel and can be used to give long-range influence and sensitivity over the high dimension space.20. Chi-Square KernelThe Chi-Square kernel comes from the Chi-Square distribution.21. Histogram Intersection KernelThe Histogram Intersection Kernel is also known as the Min Kernel and has been proven useful in image classification.22. Generalized Histogram IntersectionThe Generalized Histogram Intersection kernel is built based on the Histogram Intersection Kernel for image classification but applies in a much larger variety of contexts (Boughorbel, 2005). It is given by:23. Generalized T-Student KernelThe Generalized T-Student Kernel has been proven to be a Mercel Kernel, thus having a positive semi-definite Kernel matrix (Boughorbel, 2004). It is given by:24. Bayesian KernelThe Bayesian kernel could be given as:However, it really depends on the problem being modeled. For more information, please see the work by Alashwal, Deris and Othman, in which they used a SVM with Bayesian kernels in the prediction of protein-protein interactions.25. Wavelet KernelThe Wavelet kernel (Zhang et al, 2004) comes from Wavelet theory and is given as:Where a and c are the wavelet dilation and translation coefficients, respectively (the form presented above is a simplification, please see the original paper for details). A translation-invariant version of this kernel can be given as:Where in both h(x) denotes a mother wavelet function. In the paper by Li Zhang, Weida Zhou, and Licheng Jiao, the authors suggests a possible h(x) as:Which they also prove as an admissible kernel function.See also(推荐阅读)Kernel Support Vector Machines (kSVMs)Principal Component Analysis (PCA)3.参考文献On-Line Prediction Wiki Contributors. "Kernel Methods." On-Line Prediction Wiki. /?n=Main.KernelMethods (accessed March 3, 2010). Genton, Marc G. "Classes of Kernels for Machine Learning: A Statistics Perspective." Journal of Machine Learning Research 2 (2001) 299-312.Hofmann, T., B. Schölkopf, and A. J. Smola. "Kernel methods in machine learning." Ann. Statist. Volume 36, Number 3 (2008), 1171-1220.Gunn, S. R. (1998, May). "Support vector machines for classification and regression." Technical report, Faculty of Engineering, Science and Mathematics School of Electronics and Computer Science.Karatzoglou, A., Smola, A., Hornik, K. and Zeileis, A. "Kernlab – an R package for kernel Learning." (2004).Karatzoglou, A., Smola, A., Hornik, K. and Zeileis, A. "Kernlab – an S4 package for kernel methods in R." J. Statistical Software, 11, 9 (2004).Karatzoglou, A., Smola, A., Hornik, K. and Zeileis, A. "R: Kernel Functions." Documentation for package 'kernlab' version 0.9-5. /Rdoc/library/kernlab/html/dots.html (accessed March 3, 2010). Howley, T. and Madden, M.G. "The genetic kernel support vector machine: Description and evaluation". Artificial Intelligence Review. Volume 24, Number 3 (2005), 379-395.Shawkat Ali and Kate A. Smith. "Kernel Width Selection for SVM Classification: A Meta-Learning Approach." International Journal of Data Warehousing & Mining, 1(4), 78-97, October-December 2005.Hsuan-Tien Lin and Chih-Jen Lin. "A study on sigmoid kernels for SVM and the training of non-PSD kernels by SMO-type methods." Technical report, Department of Computer Science, National Taiwan University, 2003.Boughorbel, S., Jean-Philippe Tarel, and Nozha Boujemaa. "Project-Imedia: Object Recognition." INRIA - INRIA Activity Reports - RalyX. http://ralyx.inria.fr/2004/Raweb/imedia/uid84.html (accessed March 3, 2010).Huang, Lingkang. "Variable Selection in Multi-class Support Vector Machine and Applications in Genomic Data Analysis." PhD Thesis, 2008.Manning, Christopher D., Prabhakar Raghavan, and Hinrich Schütze. "Nonlinear SVMs." The Stanford NLP (Natural Language Processing) Group. /IR-book/html/htmledition/nonlinear-svms-1.html(accessed March 3, 2010).Fomel, Sergey. "Inverse B-spline interpolation." Stanford Exploration Project, 2000./public/docs/sep105/sergey2/paper_html/node5.html (accessed March 3, 2010).Basak, Jayanta. "A least square kernel machine with box constraints." International Conference on Pattern Recognition 2008 1 (2008): 1-4.Alashwal, H., Safaai Deris, and Razib M. Othman. "A Bayesian Kernel for the Prediction of Protein - Protein Interactions." International Journal of Computational Intelligence 5, no. 2 (2009): 119-124.Hichem Sahbi and François Fleuret. “Kernel methods and scale invariance using the triangular kernel”. INRIA Research Report, N-5143, March 2004.Sabri Boughorbel, Jean-Philippe Tarel, and Nozha Boujemaa. “Generalized histogram intersection kernel for image recognition”. Proceedings of the 2005 Conference on Image Processing, volume 3, pages 161-164, 2005.Micchelli, Charles. Interpolation of scattered data: Distance matrices and conditionally positive definite functions. Constructive Approximation 2, no. 1 (1986): 11-22.Wikipedia contributors, "Kernel methods," Wikipedia, The Free Encyclopedia, /w/index.php?title=Kernel_methods&oldid=340911970 (ac cessed March 3, 2010).Wikipedia contributors, "Kernel trick," Wikipedia, The Free Encyclopedia, /w/index.php?title=Kernel_trick&oldid=269422477 (access ed March 3, 2010).Weisstein, Eric W. "Positive Semidefinite Matrix." From MathWorld--A Wolfram Web Resource./PositiveSemidefiniteMatrix.htmlHamers B. "Kernel Models for Large Scale Applications'', Ph.D. , Katholieke Universiteit Leuven, Belgium, 2004.Li Zhang, Weida Zhou, Licheng Jiao. Wavelet Support Vector Machine. IEEE Transactions on System, Man, and Cybernetics, Part B, 2004, 34(1): 34-39.。