NVIDIA深度学习实验室解决方案

英伟达研究报告2021

英伟达研究报告2021英伟达(NVIDIA)是一家总部位于美国的半导体公司,专注于设计和生产图形处理器(GPU)和系统芯片。

该公司成立于1993年,起初主要从事计算机显卡业务,如今已经发展成为全球领先的人工智能和深度学习解决方案供应商之一。

在过去的几年里,英伟达在人工智能领域的研究和应用方面取得了显著进展。

根据最新的研究报告,英伟达在2021年底之前将继续致力于推动人工智能的发展,并为其提供更多的高性能计算和深度学习解决方案。

首先,英伟达将继续加大对GPU技术的研发投入。

GPU是人工智能计算的核心处理单元,其高并发计算能力使得它在深度学习和机器学习任务中表现出色。

因此,英伟达将不断提升GPU的性能和能效,以满足不断增长的人工智能应用需求。

其次,英伟达还将继续加强与全球科研机构和企业的合作,推动人工智能技术的前沿研究。

例如,英伟达已经与多家大学和研究所合作,共同开展基于GPU的机器学习和深度学习研究。

这种合作模式有助于加快科技进步,并将最新的研究成果转化为实际应用,推动人工智能技术的发展。

另外,英伟达还将持续推动人工智能在各个行业的应用落地。

据报告显示,英伟达已在金融、医疗、交通、农业等领域取得了一定的成果,为这些行业提供了高性能计算和深度学习解决方案。

未来,英伟达将继续与各个行业的合作伙伴合作,共同探索人工智能在产业转型中的应用潜力,并为客户提供更好的解决方案。

最后,英伟达还将继续推动人工智能的生态系统建设。

该公司已经建立了一个庞大的开发者社区,为开发者提供免费的开发工具和支持,推动人工智能技术的创新和应用。

英伟达还通过举办人工智能开发者大会和竞赛等活动,促进了全球范围内的人工智能技术交流和合作。

综上所述,英伟达在未来的研究报告中将继续致力于推动人工智能的发展。

通过加强对GPU技术的研发投入、与科研机构和企业的合作、推动人工智能在各个行业的应用落地以及推动人工智能生态系统建设,英伟达将继续在人工智能领域保持领先地位,并为客户提供更好的解决方案。

显卡和深度学习为深度学习爱好者推荐的显卡选择

显卡和深度学习为深度学习爱好者推荐的显卡选择深度学习是一种在人工智能领域中发展迅猛的技术,它需要强大的计算能力来处理大量的数据和复杂的计算任务。

而显卡作为计算机硬件的重要组成部分之一,对于深度学习的性能和效果有着重要的影响。

本文将为深度学习爱好者推荐一些适用于深度学习的显卡选择,并介绍它们的特点和性能。

一、NVIDIA GeForce系列显卡1. NVIDIA GeForce GTX 1080 TiNVIDIA GeForce GTX 1080 Ti是一款性能强大的显卡,拥有3584个CUDA核心和11GB的显存。

它的高性能和大显存容量使其在深度学习任务中表现优秀。

其强大的浮点运算能力和高速的内存带宽,能够快速处理大规模的神经网络模型,加速深度学习的训练和推断过程。

2. NVIDIA GeForce RTX 2080 TiNVIDIA GeForce RTX 2080 Ti是NVIDIA最新推出的一款显卡,它采用了基于Turing架构的GPU,拥有4352个CUDA核心和11GB的GDDR6显存。

相比于前一代显卡,RTX 2080 Ti在深度学习任务中能够提供更高的计算性能和更快的内存带宽。

同时,它还支持硬件加速的光线追踪技术,为深度学习和计算机图形学提供了更高的表现力。

二、AMD Radeon系列显卡1. AMD Radeon RX 5700 XTAMD Radeon RX 5700 XT是AMD最新推出的一款显卡,它采用了基于RDNA架构的GPU,拥有2560个流处理器和8GB的GDDR6显存。

它在深度学习任务中表现出色,能够处理大规模的神经网络模型,并为深度学习的训练和推断提供强大的计算性能。

2. AMD Radeon VIIAMD Radeon VII是一款高性能的显卡,拥有3840个流处理器和16GB的HBM2显存。

它采用了先进的制程工艺和高带宽内存技术,为深度学习任务提供出色的性能和内存带宽。

NVIDIA Tesla M40数据中心深度学习培训加速器说明书

Tesla M40 | DaTa sheeT | Jan16Power your data center with the world’s fastest deep learning training accelerator .Deep learning is redefining what’s possible, from image recognition and natural language processing to neural machine translation and imageclassification. From early-stage startups to large web service providers, deep learning has become the fundamental building block in delivering amazing solutions for end users.Deep learning models typically take days to weeks to train, forcing scientists to make compromises between accuracy and time to deployment. The NVIDIA Tesla M40 GPU accelerator, based on the ultra-efficient NVIDIA Maxwell™ architecture, is designed to deliver the highest single precision performance. Together with its high memory density, this makes the Tesla M40 the world’s fastest accelerator for deep learning training.Running Caffe and Torch on the Tesla M40 delivers the same model within hours versus days on CPU-based compute systems:013425Number of DaysReduce training time from 5 days to less than 10 hoursNote affe benchmark w th AlexNet, tra n ng 1 3M mages w th 90 epochs | PU server uses 2x Xeon E5-2699v3 PU, 128 B System Memory, Ubuntu 14 0413x FASTER TRAININGGPU Server with 4x Tesla M409.6 HoursDual-CPU Server5 DaysFEATURESNVIDIA GPU Boost ™ delivering up to 7 Teraflops of single-precision performance12 GB of GDDR5 memory for training large deep learning modelsServer-qualified to deliver maximum uptime in the data centerSPECIFICATIONSGPU Architecture NVIDIA Maxwell NVIDIA CUDA ® Cores 3072Single-Precision Performance 7 Teraflops with NVIDIA GPU Boost Double-Precision Performance 0.2 Teraflops GPU Memory 12 GB GDDR5Memory Bandwidth 288 GB/sSystem Interface PCI Express 3.0 x16Max Power Consumption 250 W Thermal Solution PassiveForm Factor 4.4” H × 10.5” L, Dual Slot, Full Height Compute APIsCUDA, DirectCompute, OpenCL ™, OpenACCnVIDIa ®Tesla ®M40 GPU aCCeleRaTORDeeP leaRnInG eCOsYsTeM BUIlT FOR Tesla PlaTFORMThe Tesla M40 accelerator provides a powerful foundation for customers to leverage best-in-class software and solutions for deep learning. NVIDIA cuDNN, DIGITS ™ andvarious deep learning frameworks are optimized for the NVIDIA Maxwell ™ architecture and Tesla M40 to power the next generation machine learning applications.FrameworksDeep learning sDK© 2015 NVIDIA Corporation. All rights reserved. NVIDIA, the NVIDIA logo, Tesla, NVIDIA GPU Boost, CUDA, and NVIDIA Maxwell aretrademarks and/or registered trademarks of NVIDIA Corporation in the U.S. and other countries. OpenCL is a trademark of Apple Inc. used under license to the Khronos Group Inc. All other trademarks and copyrights are the property of their respective owners.To learn more about the NVIDIA Tesla M40 visit /tesla-m40nVIDIa cuDnncuDNN provides GPU-accelerated deep neural network primitives, low memory overhead, flexible data layouts, and support for:>2D and 3D datasets>Forward and backward convolution routines>Arbitrary dimension ordering, striding, and sub- regions for 4d tensors means, allowing for easy integration into any neural net implementation >Tensor transformation functions>Neuron activations forward and backward (Rectified Linear , Sigmoid, Hyperbolic Tangent)>Context-based API for easy multithreading>Automatic best algorithm selection for convolutions >The latest NVIDIA GPU architecturesnVIDIa DIGITsDIGITS is an interactive deep neural network development environment that allows data scientists to: >Design and visualize deep neural networks>Schedule, monitor , and manage DNN training jobs>Manage GPU resources, allowing users to train multiple models in parallel>Visualize accuracy and loss in real time while training >Track datasets, results, and trained neural networks >Automatically scale training jobs across multiple GPUs。

深度学习的实验报告(3篇)

第1篇一、实验背景随着计算机技术的飞速发展,人工智能领域取得了显著的成果。

深度学习作为人工智能的一个重要分支,在图像识别、语音识别、自然语言处理等方面取得了突破性进展。

手写数字识别作为计算机视觉领域的一个重要任务,具有广泛的应用前景。

本实验旨在利用深度学习技术实现手写数字识别,提高识别准确率。

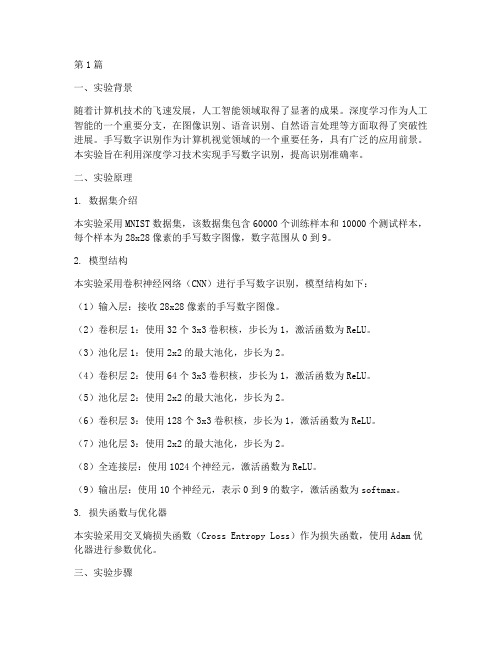

二、实验原理1. 数据集介绍本实验采用MNIST数据集,该数据集包含60000个训练样本和10000个测试样本,每个样本为28x28像素的手写数字图像,数字范围从0到9。

2. 模型结构本实验采用卷积神经网络(CNN)进行手写数字识别,模型结构如下:(1)输入层:接收28x28像素的手写数字图像。

(2)卷积层1:使用32个3x3卷积核,步长为1,激活函数为ReLU。

(3)池化层1:使用2x2的最大池化,步长为2。

(4)卷积层2:使用64个3x3卷积核,步长为1,激活函数为ReLU。

(5)池化层2:使用2x2的最大池化,步长为2。

(6)卷积层3:使用128个3x3卷积核,步长为1,激活函数为ReLU。

(7)池化层3:使用2x2的最大池化,步长为2。

(8)全连接层:使用1024个神经元,激活函数为ReLU。

(9)输出层:使用10个神经元,表示0到9的数字,激活函数为softmax。

3. 损失函数与优化器本实验采用交叉熵损失函数(Cross Entropy Loss)作为损失函数,使用Adam优化器进行参数优化。

三、实验步骤1. 数据预处理(1)将MNIST数据集分为训练集和测试集。

(2)将图像数据归一化到[0,1]区间。

2. 模型训练(1)使用训练集对模型进行训练。

(2)使用测试集评估模型性能。

3. 模型优化(1)调整学习率、批大小等超参数。

(2)优化模型结构,提高识别准确率。

四、实验结果与分析1. 模型性能评估(1)准确率:模型在测试集上的准确率为98.5%。

(2)召回率:模型在测试集上的召回率为98.2%。

(3)F1值:模型在测试集上的F1值为98.4%。

英伟达 tesla p100 应用性能指南- hpc 和深度学习应用说明书

HPC 及深度學習應用APR 2017TESLA P100 效能指南現代的高效運算(HPC)資料中心是解決部分全球最重要之科學與工程挑戰的關鍵。

NVIDIA® Tesla®加速運算平台利用領先業界的應用程式支援這些現代化資料中心,促進 HPC 與 AI 工作負載。

Tesla P100 GPU 是現代資料中心的引擎,能以更少的伺服器展現突破性效能,進而實現更快的解析能力,並大幅降低成本。

每一個 HPC 資料中心都能自 Tesla 平台獲益。

在廣泛的領域中有超過 400 個HPC 應用程式,採用 GPU 最佳化,包括所有前 10 大 HPC 應用程式和各種主要深度學習架構。

採用加速 GPU 應用程式的研究領域包括:超過 400 個 HPC 應用及所有深度學習架構皆是採用加速 GPU。

>若想要取得最新 GPU 加速應用目錄,請造訪:/teslaapps>若想要立即在 GPU 上使用簡易指示,快速執行廣泛的加速應用,請造訪:/gpu-ready-apps分子動力(MD)代表 HPC 資料中心的大部分工作負載。

100% 頂尖 MD 應用皆是採用 GPU 加速,以使科學家能進行從前僅有 CPU 版本之傳統應用項目無法執行的模擬工作。

在執行 MD 應用時,配備 Tesla P100 GPU 的資料中心可節省高達 60% 的伺服器取得成本。

TESLA 平台及適用 MD 的 P100 的關鍵功能>搭載 P100 的伺服器,最多可取代 40 部適用 HOOMD-Blue、LAMMPS、AMBER、GROMACS 和 NAMD 等應用的 CPU 伺服器>100% 頂尖 MD 應用項目皆採用加速 GPU>FFT 和 BLAS 等關鍵數學程式庫>每一個 GPU 之單精度效能高達每秒 11 TFLOPS>每一個 GPU 之記憶體頻寬高達每秒 732 GB檢視所有相關的應用項目:/molecular-dynamics-appsHOOMD-BLUE循序寫入 GPU 的粒子動力封裝版本1.3.3加速功能CPU 和 GPU 可用版本延展性多 GPU 和多節點更多資訊/hoomd-blueLAMMPS典型粒子動力封裝版本2016加速功能Lennard-Jones、Gay-Berne、Tersoff 更多勢能延展性多 GPU 和多節點更多資訊/lammpsGROMACS模擬含複雜連結互動的生物模型分子版本5.1.2加速功能PME ,顯性與隱性溶劑延展性多 GPU 和多節點擴展至 4xP100更多資訊/gromacs黃色在生物分子上模擬分子動力的程式套件版本16.3加速功能PMEMD 顯性溶劑和 GB 、顯性及隱性溶劑、REMD 、aMD延展性多 GPU 和多節點更多資訊/amberNAMD專為高效模擬大分子系統而設計版本2.11加速功能PME 全靜電和眾多模擬功能延展性高達 100M 原子,多 GPU,擴展為 2xP100更多資訊/namd量子化學(QC)模擬是探索新藥物與原料的關鍵,且會耗費大部分 HPC 資料中心的工作負載。

如何配置一台高效的GPU(深度学习)服务器

目前GPU深度学习服务器在AI、视频处理、科学计算等领域都有广泛应用。

随着NVIDIA推出更多的GPU硬件和工具软件,如何配置一台属于自己的GPU服务器,在开发者的工作中成为了重中之重。

文章大概:1、硬件平台的搭建o 深度学习服务器的性能需求o NVIDIA GPU的性能特点o 硬件环境的配置搭配要点2、软件环境的配置o 深度学习环境的系统配置,环境搭建o NVIDIA CUDA的安装o 介绍NVIDIA Deep Learning 相关SDK工具,包括类似于Transfer Learning Toolkit,CuDNN,CuBlas, TesnorRT…o NVIDIA GPU Cloud 介绍o 成熟的解决方案或者案例最近开始学习深度学习(Deep Learning)技术,特别是google的Tensorflow深度学习包开源后,深度学习已经成为大数据领域的重大计算革命,配合Teras顶层框架,使得Deep learning的学习成本降低。

(百度也开源了飞桨开源平台也不错)目前Deep learning技术应用越来越广,一切数据都是图,CNN卷积神经网络技术充满了神奇的计算魅力。

DL技术广泛应用于:图像处理、人脸识别、自动驾驶、聊天机器人、AI人工智能、机器语言翻译、图片推荐系统、声音处理、音乐作曲、机器写作等领域。

现今,日益完善的深度学习技术和-AI-服务愈加受到市场青睐。

与此同时,数据集不断扩大,计算模型和网络也变得越来越复杂,这对于硬件设备也提出了更为严苛的需求。

如何利用有限的预算,最大限度升级系统整体的计算性能和数据传输能力成为了最为重要的问题。

由于,做深度学习,需要很多科学计算学习包。

以及深度学习框架(tensorflow)我这里选择的是下载Anaconda(集成环境。

Anaconda installer archivehttps:///archive/)。

推荐配置如果您是高校学生或者高级研究人员,并且实验室或者个人资金充沛,建议您采用如下配置:主板:X99型号或Z170型号CPU: i7-5830K或i7-6700K 及其以上高级型号内存:品牌内存,总容量32G以上,根据主板组成4通道或8通道SSD:品牌固态硬盘,容量256G以上显卡:NVIDIA GTX 1080ti、NVIDIA GTX TITAN、NVIDIA GTX 1080、NVIDIA GTX 1070、NVIDIA GTX 1060 (顺序为优先建议,并且建议同一显卡,可以根据主板插槽数量购买多块,例如X99型号主板最多可以采用×4的显卡)电源:由主机机容量的确定,一般有显卡总容量后再加200W即可最低配置如果您是仅仅用于自学或代码调试,亦或是条件所限仅采用自己现有的设备进行开发,那么您的电脑至少满足以下几点:CPU:Intel第三代i5和i7以上系列产品或同性能AMD公司产品内存:总容量4G以上如果是先可以玩玩Keras文档说明中的几个案例,都有详细的代码和说明。

深度学习实验报告

一、实验背景与目的随着信息技术的飞速发展,大数据时代的到来为人工智能领域带来了前所未有的机遇。

深度学习作为一种先进的人工智能技术,在图像识别、自然语言处理、语音识别等领域取得了显著的成果。

本实验旨在通过深度学习技术实现图像识别,并对其性能进行评估和优化。

二、实验内容与方法1. 数据集介绍本实验使用的数据集为MNIST手写数字数据集,包含0-9共10个数字的28x28像素灰度图像,共60000个训练样本和10000个测试样本。

2. 模型构建实验采用卷积神经网络(CNN)模型进行图像识别。

模型结构如下:- 输入层:28x28像素的灰度图像- 卷积层1:32个3x3卷积核,步长为1,激活函数为ReLU- 池化层1:2x2的最大池化- 卷积层2:64个3x3卷积核,步长为1,激活函数为ReLU- 池化层2:2x2的最大池化- 全连接层1:512个神经元,激活函数为ReLU- 全连接层2:10个神经元,激活函数为Softmax3. 实验步骤(1)数据预处理:将图像数据归一化到[0, 1]区间,并进行随机翻转、旋转等数据增强操作。

(2)模型训练:使用Adam优化器,学习率为0.001,批大小为64,训练轮次为10轮。

(3)模型评估:使用测试集对模型进行评估,计算准确率、召回率、F1分数等指标。

三、实验结果与分析1. 模型性能经过训练,模型在测试集上的准确率达到99.15%,召回率为99.17%,F1分数为99.16%。

结果表明,所构建的CNN模型在MNIST手写数字识别任务上具有较好的性能。

2. 模型优化为了进一步提高模型性能,我们对以下方面进行了优化:(1)调整网络结构:在模型中加入Dropout层,防止过拟合;增加卷积层数量,提高模型的表达能力。

(2)调整训练参数:使用学习率衰减策略,防止模型在训练过程中出现过拟合;调整批大小,提高训练速度。

(3)数据增强:增加数据增强操作,提高模型对输入数据的鲁棒性。

NVIDIA深度学习性能指南说明书

Get Started With Deep Learning PerformanceGetting Started | NVIDIA DocsTable of ContentsChapter 1. Overview (1)Chapter 2. Recommendations (2)2.1. Operating In Math-Limited Regime Where Possible (2)2.2. Using Tensor Cores Efficiently With Alignment (2)2.3. Choosing Parameters To Maximize Execution Efficiency (3)Chapter 3. Checklists (4)Chapter 4. How This Guide Fits In (5)Chapter 1.OverviewGPUs accelerate machine learning operations by performing calculations in parallel. Many operations, especially those representable as matrix multiplies, will see good acceleration right out of the box. Even better performance can be achieved by tweaking operation parameters to efficiently use GPU resources.This document presents the tips that we think are most widely useful. We link to each of the other pages, with more in-depth information, where appropriate. If you want to jump straight to optimizing a network, read our Checklists!Chapter 2.Recommendations2.1. Operating In Math-Limited RegimeWhere PossibleGPUs excel at performing calculations in parallel, but data also needs to be loaded and stored around those calculations, and thus data movement speed can also limit achievable performance. If the speed of a routine is limited by calculation rate (math-limited or math-bound), performance can be improved by enabling Tensor Cores and following our other recommendations.On the other hand, if a routine is limited by the time taken to load inputs and write outputs (bandwidth-limited or memory-bound), speeding up calculation does not improve performance. For fully-connected and convolutional layers, this occurs mostly when one or more parameters of a layer are small.In other words, if an operation is memory-bound, tweaking parameters to more efficiently utilize the GPU is ineffective. Operations not representable as matrix multiplies, including activation functions, pooling, and batch normalization, are nearly always memory-bound. Those with an equivalent matrix multiply, including fully-connected, convolutional, and recurrent layers, may be memory-bound or math-bound depending on their sizes. Larger layers tend to have more calculations relative to the number of memory accesses, a ratio that we refer to as arithmetic intensity. If arithmetic intensity exceeds a particular threshold (dependent on the GPU type and the type of calculation being done), the operation is math-bound and can be optimized effectively with our tips. See Understanding Performance and Math and Memory Bounds for background and details.2.2. Using Tensor Cores Efficiently WithAlignmentTensor Cores are most efficient when key parameters of the operation are multiples of4 if using TF32, 8 if using FP16, or 16 if using INT8 (equivalently, when key dimensions of the operation are aligned to multiples of 16 bytes in memory). For fully-connected layers, the relevant parameters are the batch size and the number of inputs and outputs; for convolutional layers, the number of input and output channels; and for recurrent layers, theRecommendationsminibatch size and hidden sizes. With NVIDIA® cuBLAS 11.0 or higher and NVIDIA CUDA®Deep Neural Network library (cuDNN) 7.6.3 or higher, Tensor Cores can be used even if this requirement is not met, though performance is better if it is. In earlier versions, Tensor Cores may not be enabled if one or more dimensions aren’t aligned. This requirement is based on how data is stored and accessed in memory. Further details can be found in Tensor Core Requirements.TF32, a datatype introduced with the NVIDIA Ampere Architecture, works with existing FP32 code to leverage Tensor Cores. More detail on TF32 can be found at this link. Mixed precision is another option for networks that currently use FP32, and works with both the NVIDIA Ampere Architecture and NVIDIA Volta™ and NVIDIA Turing™ GPUs. The NVIDIA Training with Mixed Precision Guide explains how to use mixed precision with Tensor Cores, including instructions for getting started quickly in a number of frameworks.2.3. Choosing Parameters To MaximizeExecution EfficiencyGPUs perform operations efficiently by dividing the work between many parallel processes. Consequently, using parameters that make it easier to break up the operation evenly will lead to the best efficiency. This means choosing parameters (including batch size, input size, output size, and channel counts) to be divisible by larger powers of two, at least 64, and up to 256. There is no downside to using values divisible by 512 and higher powers of two, but there is less additional benefit. Divisibility by powers of two is most important for parameters that are small; choosing 512 over 520 has more impact than choosing 5120 over 5128. Additionally,for these tweaks to improve efficiency, the operation must already be math-bound, which usually requires at least one parameter to be substantially larger than 256. See Operating In Math-Limited Regime Where Possible and other linked sections about calculating arithmetic intensity.More specific requirements for different routines can be found in the corresponding checklist and guide. Background on why this matters can be found in GPU Architecture Fundamentals and Typical Tile Dimensions in CUBLAS and Performance.Chapter 3.ChecklistsWe provide the following quick start checklists with tips specific to each type of operation.‣Checklist for Fully-Connected Layers‣Checklist for Convolutional Layers‣Checklist for Recurrent Layers‣Checklist for Memory-Limited LayersChapter 4.How This Guide Fits InNVIDIA’s GPU deep learning platform comes with a rich set of other resources you can useto learn more about NVIDIA’s Tensor Core GPU architectures as well as the fundamentals of mixed-precision training and how to enable it in your favorite framework.The NVIDIA V100 GPU architecture whitepaper provides an introduction to NVIDIA Volta,the first NVIDIA GPU architecture to introduce Tensor Cores to accelerate Deep Learning operations. The equivalent whitepaper for the NVIDIA Turing architecture expands on thisby introducing NVIDIA Turing Tensor Cores, which add additional low-precision modes. The whitepaper for the NVIDIA Ampere architecture introduces Tensor Core support for additional precisions (including TF32, which works with existing FP32 workloads to leverage Tensor Cores), up to 2x throughput with the Sparsity feature, and virtual partitioning of GPUs with the Multi-Instance GPU feature.The NVIDIA Training With Mixed Precision User's Guide describes the basics of training neural networks with reduced precision such as algorithmic considerations following from the numerical formats used. It also details how to enable mixed precision training in your framework of choice, including TensorFlow, PyTorch, and MXNet. The easiest and safest way to turn on mixed precision training and use Tensor Cores is through Automatic Mixed Precision, which is supported in PyTorch, TensorFlow, and MxNet.Additional documentation is provided to help explain how to:‣Tweak parameters of individual operations by type, with examples:‣NVIDIA Optimizing Linear/Fully-Connected Layers User's Guide‣NVIDIA Optimizing Convolutional Layers User's Guide‣NVIDIA Optimizing Recurrent Layers User's Guide‣NVIDIA Optimizing Memory-Limited Layers User's Guide‣Understand the ideas behind these recommendations:‣NVIDIA GPU Performance Background User's Guide‣NVIDIA Matrix Multiplication Background User's GuideNoticeThis document is provided for information purposes only and shall not be regarded as a warranty of a certain functionality, condition, or quality of a product. NVIDIA Corporation (“NVIDIA”) makes no representations or warranties, expressed or implied, as to the accuracy or completeness of the information contained in this document and assumes no responsibility for any errors contained herein. NVIDIA shall have no liability for the consequences or use of such information or for any infringement of patents or other rights of third parties that may result from its use. This document is not a commitment to develop, release, or deliver any Material (defined below), code, or functionality.NVIDIA reserves the right to make corrections, modifications, enhancements, improvements, and any other changes to this document, at any time without notice. Customer should obtain the latest relevant information before placing orders and should verify that such information is current and complete.NVIDIA products are sold subject to the NVIDIA standard terms and conditions of sale supplied at the time of order acknowledgement, unless otherwise agreed in an individual sales agreement signed by authorized representatives of NVIDIA and customer (“Terms of Sale”). NVIDIA hereby expressly objects to applying any customer general terms and conditions with regards to the purchase of the NVIDIA product referenced in this document. No contractual obligations are formed either directly or indirectly by this document.NVIDIA products are not designed, authorized, or warranted to be suitable for use in medical, military, aircraft, space, or life support equipment, nor in applications where failure or malfunction of the NVIDIA product can reasonably be expected to result in personal injury, death, or property or environmental damage. NVIDIA accepts no liability for inclusion and/or use of NVIDIA products in such equipment or applications and therefore such inclusion and/or use is at customer’s own risk. NVIDIA makes no representation or warranty that products based on this document will be suitable for any specified use. Testing of all parameters of each product is not necessarily performed by NVIDIA. It is customer’s sole responsibility to evaluate and determine the applicability of any information contained in this document, ensure the product is suitable and fit for the application planned by customer, and perform the necessary testing for the application in order to avoid a default of the application or the product. Weaknesses in customer’s product designs may affect the quality and reliability of the NVIDIA product and may result in additional or different conditions and/or requirements beyond those contained in this document. NVIDIA accepts no liability related to any default, damage, costs, or problem which may be based on or attributable to: (i) the use of the NVIDIA product in any manner that is contrary to this document or (ii) customer product designs.No license, either expressed or implied, is granted under any NVIDIA patent right, copyright, or other NVIDIA intellectual property right under this document. Information published by NVIDIA regarding third-party products or services does not constitute a license from NVIDIA to use such products or services or a warranty or endorsement thereof. Use of such information may require a license from a third party under the patents or other intellectual property rights of the third party, or a license from NVIDIA under the patents or other intellectual property rights of NVIDIA.Reproduction of information in this document is permissible only if approved in advance by NVIDIA in writing, reproduced without alteration and in full compliance with all applicable export laws and regulations, and accompanied by all associated conditions, limitations, and notices.THIS DOCUMENT AND ALL NVIDIA DESIGN SPECIFICATIONS, REFERENCE BOARDS, FILES, DRAWINGS, DIAGNOSTICS, LISTS, AND OTHER DOCUMENTS (TOGETHER AND SEPARATELY, “MATERIALS”) ARE BEING PROVIDED “AS IS.” NVIDIA MAKES NO WARRANTIES, EXPRESSED, IMPLIED, STATUTORY, OR OTHERWISE WITH RESPECT TO THE MATERIALS, AND EXPRESSLY DISCLAIMS ALL IMPLIED WARRANTIES OF NONINFRINGEMENT, MERCHANTABILITY, AND FITNESS FOR A PARTICULAR PURPOSE. TO THE EXTENT NOT PROHIBITED BY LAW, IN NO EVENT WILL NVIDIA BE LIABLE FOR ANY DAMAGES, INCLUDING WITHOUT LIMITATION ANY DIRECT, INDIRECT, SPECIAL, INCIDENTAL, PUNITIVE, OR CONSEQUENTIAL DAMAGES, HOWEVER CAUSED AND REGARDLESS OF THE THEORY OF LIABILITY, ARISING OUT OF ANY USE OF THIS DOCUMENT, EVEN IF NVIDIA HAS BEEN ADVISED OF THE POSSIBILITY OF SUCH DAMAGES. Notwithstanding any damages that customer might incur for any reason whatsoever, NVIDIA’s aggregate and cumulative liability towards customer for the products described herein shall be limited in accordance with the Terms of Sale for the product.GoogleAndroid, Android TV, Google Play and the Google Play logo are trademarks of Google, Inc.TrademarksNVIDIA, the NVIDIA logo, CUDA, Merlin, RAPIDS, Triton Inference Server, Turing and Volta are trademarks and/or registered trademarks of NVIDIA Corporation in the United States and other countries. Other company and product names may be trademarks of the respective companies with which they are associated.Copyright© 2020-2023 NVIDIA Corporation & affiliates. All rights reserved.。

NVIDIA深度学习优化指南说明书

Profiling Deep Learning Networks Poonam Chitale, David Zier NVIDIADEEP LEARNING OPTIMIZATIONSystem Level Tuning●System Tuning○Thread Synchronization, Multi GPU and node communication○Memory management & Kernel profiling●Leveraging/Optimizing Hardware ●Input Pipeline Optimization ●Many others….Performance Analysis at System and DNN Level & Visualization DNN Level Tuning●Algorithm Techniques & Data Representations ●Pruning ●Calibration ●Quantization ●Many others….VisualizationOptimal data processing, batching, copying,managing pipelineMaximum parallelcomputation,fast matrixoperations, precisionSystem wide tracing,thread synchronization,memory transfersKernel tuningTYPICAL CHALLENGESSYSTEM TUNINGDATA CENTERCLUSTERLEVELMaximum availability andutilization in Data CenterLayer fusion, calibrating,optimized inferenceCALIBRATIONDNNALGORITHMSINPUT PIPELINEDL PROFILING NEEDS OF DIFFERENT PERSONASData Scientists & AppliedResearchersResearchersReduce Training time, focus on data, develop and apply the best models for the applicationsFast development of best performant models for research,challenge and domainsSysadmins & DevOpsOptimized utilization and uptime, monitor GPU workloads, leverage hardwareDL PROFILING: TOOLS & TECHNOLOGIESData Scientists & AppliedResearchers ResearchersSysadmins & DevOpsUse Tensorboard type ofvisualization Developer ToolsUse Advanced APIs Developer ToolsTools: NSIGHT Tools, NVVP, NVPROF, DCGM, NVML APIs: NVTX, CUPTIUse Data Center Monitoring Toolsetc...INPUT DATA PIPELINE OPTIMIZATIONHighly dependent on application use casesTraining Data PreparationPreprocessing and augmentation can become complex, learnings from a medical imaging segmentation use case:●Cropping multiple batches from one single volume.●Unzipping files and saving to local disk at first epoch.●Storing foreground voxel coordinates to local disk space at first epoch.●Caching etc…NVIDIA DALI: DAta loading LIbrary:A GPU-accelerated data augmentation and image loading library for optimizing data pipelines of deep learning frameworks.TENSORBOARDData Visualization ●Tensorboard is the most popularvisualization tools used by datascientists and applied researchers usingTensorflow.●Useful to understand network graphtopology, training etc●PyTorch users seem to useTensorboardX (also Visdom )●MXBoard is a similar tool for mxnetNVIDIA NSIGHT TOOLSNSIGHT PRODUCT FAMILYStandalone Performance Tools, IDE PluginsStandalone Performance ToolsNsight Systems System wide tracing, application algorithm tuningNsight Compute Debug/Optimize specific CUDA kernelsNsight Graphics Debug/Optimize specific graphics API and ShadersIDE PluginsNsight Visual Studio/Eclipse Edition editor, debugger, performance analysisNsight Systems System-wide application algorithm tuningNsight ComputeCUDA API Debugging & KernelProfilingNsight GraphicsGraphics Debugging & ProfilingIDE PluginsNsight EclipseEdition/Visual Studio(Editor, Debugger) NSIGHT PRODUCT FAMILYNSIGHT SYSTEMSSystem-wide Performance AnalysisObserve Application Behavior: CPU threads, GPU traces, Memory Bandwidth and moreLocate Optimization Opportunities: CUDA & OpenGL APIs, Unified Memory transfers, User Annotations using NVTXReady for Big Data: Fast GUI capable of visualizing in excess of 10 million events on laptops, Container support, Minimum user privilegeshttps:///nsight-systemsProcessesand threadsCUDA and OpenGL API trace Multi-GPUKernel and memory transfer activitiescuDNN and cuBLAS trace Thread/core migration Thread stateNVTX RangesNVIDIA NSIGHT COMPUTE Next Generation Kernel Profiler▶Interactive CUDA API debugging and kernel profiling▶Fast Data Collection▶Improved Workflow and Fully Customizable (Baselining, Programmable UI/Rules)▶Command Line, Standalone, IDE Integration ▶Platform Support▶OS: Linux (x86, ARM), Windows▶GPUs: Pascal, Volta, TuringKernelProfile Comparisons with BaselineMetric DataSource CorrelationAPIs & Libraries : NVTX and CUPTINVIDIA TOOLS EXTENSION LIBRARY (NVTX)●NVTX is a platform agnostic, toolsagnostic API●Allows developers toannotate(mark) source code,events, code ranges etc ●NVIDIA optimized Tensorflow, PyTorch, MXnet haveNVTX annotations built in!●Enables a better more effective user experiencewith Nsight Tools, NVVP, NVPROFPREVIEW: TENSORFLOW WITH NVTX ANNOTATIONComing soon ….●Library developed specifically for annotatingTensorflow to help visualize network better inNsight Systems●Workflow:○Import nvtx_tf library○Annotate python code○Run tensorflow○Get data through a profiler such as NsightSystemsPREVIEW: PyTorch WITH NVTX ANNOTATIONComing soon ….Library for effectively using NVTX marker for PyTorch •Custom NVTX marker as a python dictionary with module name, function name, arguments (tensor shapes & type, scalar type & value).Workflow:○Import library○Annotate python code○Run with profiler import torch.cuda.profiler as profiler import nvtx_pynvtx_py.nvtx.init()withtorch.autograd.profiler.emit_nvtx(): for epoch in range(100):for iteration in range(100):….CUDA PROFILING TOOLS INTERFACE (CUPTI) Build your own GPU performance tuning tools● C APIs to enable creation of profiling andtracing tools that target CUDA applications●Supports multiple APIs -CUDA API trace, GPUactivity trace, GPU performance counters andmetrics, PC sampling, Profiling (UnifiedMemory, OpenACC)●Available as a dynamic library on all CUDAsupported platformshttps:///cupti/Cupti/index.htmlGPUDriver ApplicationProfiling ToolCUPTITensor Cores for Deep LearningALGORITHM OPTIMIZATIONMixed Precision implementation using Tensor Cores on Turing and Volta GPUs Tensor Cores• A revolutionary technology that accelerates AI performance by enabling efficient mixed-precision implementation•Accelerate large matrix multiply and accumulate operations in a single operationMixed Precision TechniqueCombined use of different numerical precisions in a computational method; focus is on FP16 and FP32 combination.Benefits•Decreases the required amount of memory enabling training of larger models or training with larger mini-batchesShortens the training or inference time by lowering the required resources by using lower-precision arithmeticPREVIEW: NVIDIA DEEP LEARNING PROFILERDeep Learning ProfilerCore PurposeWho: A data scientist/deep learning researcherWhat: Able to•Easily profile a DNN•Understand GPU usage in terms of the model•Present results in familiar tools, such as TensorBoard •Leverage existing NVIDIA toolsDeep Learning Profiler WorkflowINPUT PROFILE OUTPUTCORRELATE ANALYZEGraphdef file generate in Tensorflow Use NSighttools togather kerneland timingprofile dataCorrelateprofile datawithTensorflowmodelGenerateTensorBoardevent filesand detailedreportsAnalyze inTensorBoardor other 3rdparty toolsArchitectureAutomates workflowNsight Systems•Gather timeline information•Determines Tensor Core usage from name of kernelsNsight Compute•Detailed kernel level profiling•Determines Tensor Core usage from GPU program countersUse NVTX markers to correlate kernels with DNN graph nodesAny number of reports can be generated•TB Event Files, CSV, JSON•Analyze with tool of your choiceNsightSystemsTimelineDataKernelProfileDNNGraphTB EventFilesTensorboardNsightComputeDeep Learning ProfilerNVTXmarkedProfileSummaryProfileSummaryReportFilesNVTXmarkedDeep Learning ProfilerCommand Line ExampleExample command to profile MobileNet V2 and generate a graphdef$ /usr/bin/python tf_cnn_benchmarks.py --num_gpus=1 --batch_size=8 --model=mobilenet --device=gpu --gpu_indices=1 --data_name=imagenet --data_dir=/data/train-val-tfrecord-480 --num_batches=1--use_fp16 --fp16_enable_auto_loss_scale --graph_file=/results/mobilenet_graph.pbExample Deep Learning Profiler command$ dlprof --in_graphdef=/results/mobilenet_graph.pb/usr/bin/python tf_cnn_benchmarks.py --num_gpus=1 --batch_size=8 --model=mobilenet --device=gpu --gpu_indices=1 --data_name=imagenet --data_dir=/data/train-val-tfrecord-480 --num_batches=1 --use_fp16 --fp16_enable_auto_loss_scale Launching TensorBoard$ tensorboard --logdir ./event_filesTensorboard Modifications Start TensorBoard with NVIDIA modificationsSelect Compatible using Tensor CoresSelect Compatible node not using Tensor Cores Compatibility details and panel providing guidance and links to help with mixed precisionOpNodes Summary Tab GPU Summary tab showing all the Nodes, compatible and using Tensor CoresGroup Node Summary Tab Roll up timing metrics and Tensor Core utilization per group nodeModel Summary TableModel Summary shows concise information on Tensor core usage31THANK YOU。

深度学习视频综合应用解决方案

深度学习视频综合应用解决方案一、方案目标与范围1.1 目标本方案旨在为企业提供一套全面的深度学习视频综合应用解决方案,主要目标包括:- 提升视频监控的智能化水平,实现实时异常检测。

- 优化视频内容分析,提取关键信息,支持数据驱动的决策。

- 降低人工审核成本,提高工作效率。

- 确保方案实施的可持续性和可扩展性,以适应未来需求变化。

1.2 范围本方案适用于以下几个领域:- 安全监控- 智能交通- 媒体娱乐- 教育培训二、组织现状与需求分析2.1 现状分析经过对现有视频监控及分析系统的调研,发现以下问题:1. 人工审核成本高:现有系统依赖人工审核,导致工作效率低下,且容易出现疏漏。

2. 信息提取不充分:缺乏智能化的数据分析工具,无法快速提取视频中的关键信息。

3. 数据孤岛现象:各部门之间数据共享困难,导致信息流通不畅。

2.2 需求分析为了解决以上问题,组织迫切需要以下功能:- 实时视频监控与异常检测。

- 自动化的视频内容分析与信息提取。

- 数据共享与分析平台,支持跨部门数据整合。

三、实施步骤与操作指南3.1 技术架构设计本方案将采用以下技术架构:1. 数据采集层:集成现有监控摄像头,支持多种视频格式。

2. 数据处理层:使用深度学习算法进行视频分析,主要包括:- 目标检测:使用YOLO或Faster R-CNN等模型进行目标识别。

- 行为识别:应用LSTM等时序模型识别异常行为。

3. 数据展示层:构建可视化界面,实时展示分析结果,支持报警功能。

3.2 实施步骤3.2.1 数据采集- 任务:整合现有视频监控设备,并确保数据传输稳定。

- 时间:1个月- 资源:IT团队、设备供应商- 数据:预计接入摄像头数量100个,日均视频数据量约1TB。

3.2.2 模型训练- 任务:收集标注数据,选择合适的模型进行训练。

- 时间:2个月- 资源:数据科学团队、GPU服务器3.2.3 系统集成- 任务:将数据采集、处理和展示层进行集成。

NVIDIADLSS技术评测为何它如此重要

NVIDIADLSS技术评测为何它如此重要NVIDIA DLSS 技术评测:为何它如此重要?近年来,随着电子游戏行业的蓬勃发展,对图形渲染质量的需求也变得越来越高。

然而,提升图形质量会带来更高的计算需求,给游戏开发者和玩家带来了很大的挑战。

在这种情况下,NVIDIA DLSS (Deep Learning Super Sampling)技术的出现成为了一种突破性的解决方案。

1. NVIDIA DLSS 技术简介NVIDIA DLSS 是一种利用深度学习进行实时图像重建的技术。

通过预先训练的人工智能模型,DLSS 可以将低分辨率的图像重建为高分辨率的图像,从而提升游戏画面的质量。

2. 解决游戏图形渲染挑战在过去,提升游戏画面质量往往意味着增加游戏的分辨率或者使用更高的抗锯齿技术。

然而,这种做法对图形卡的计算性能要求非常高。

而 NVIDIA DLSS 技术的出现,为了同时满足高质量图形和高帧率的需求,提供了有效的解决方案。

3. 图像质量的提升DLSS 通过深度学习模型,对游戏图像进行分析和重建,使得画面的细节更加清晰、真实,同时减少马赛克和锯齿状的边缘。

这种通过AI 模型提升画面质量的方式,远超传统的图像处理技术,使得游戏画面更加逼真,给玩家带来更出色的沉浸感。

4. 计算资源的节约DLSS 技术在重建图像时,采用了神经网络模型,这意味着只需要输入低分辨率图像和一些训练参数,就可以输出高分辨率的图像。

相比传统的渲染方式,使用 DLSS 技术可以节省大量的计算资源,提升游戏的性能,达到更高的帧率。

5. 支持更高的游戏设置由于 DLSS 可以极大地减少计算负载,游戏开发者可以在保持高帧率的情况下,提供更丰富的游戏设置选项。

玩家可以在享受顺畅游戏体验的同时,根据自己的电脑性能和偏好,选择更高的图形质量设置。

6. 未来的发展潜力随着人工智能技术的不断发展和硬件性能的持续提升,NVIDIA DLSS 技术有着广阔的发展潜力。

深度学习技术在网络入侵检测中的应用-Nvidia

深度学习技术在网络入侵检测中的应用案例简介•本案例中,北京邮电大学移动互联网安全技术国家工程实验室研究团队致力于将最新的深度学习技术应用于网络入侵检测,积极探索利用人工智能解决网络安全问题的新思路。

•本案例中使用的NVIDIA GPU:10块 Tesla K80。

Case Introduction•In this case, the research team belongs to the National Engineering Laboratory for Mobile Network Security Technologies, Beijing University of Posts and Telecommunications. They devote to applying the latest deep learning technology to network intrusion detection, and actively exploring new ideas of using artificial intelligence to solve cyber security problems.•The major product utilized in the case is 10 NVIDIA Tesla K80 GPUs.现状从全球范围来看,网络空间安全形势不容乐观。

继早期的蠕虫病毒、特洛伊木马和僵尸网络之后,近年来又兴起了被称为APT(高级持续威胁)的新型网络攻击手段。

2017年上半年,勒索病毒WannaCry更是在全球范围内肆虐,通过网络造成一场严重的灾难。

最新统计数据显示,WannaCry勒索病毒至少感染了150个国家的30万台电脑,波及了众多行业,包括金融、能源、医疗等,造成经济损失约达80亿美元,成为多年以来影响力最大的病毒之一。

简言之,不断爆发的大规模网络攻击一方面证明了传统安全防护技术的缺陷和不足,另一方面则呼唤着新一代网络安全技术的出现。

深度学习技术的计算资源要求及优化方法

深度学习技术的计算资源要求及优化方法在当今信息技术快速发展的时代,深度学习技术逐渐成为人工智能领域的关键技术。

然而,深度学习模型的训练和推断过程需要大量的计算资源支持。

因此,了解深度学习技术的计算资源要求以及相应的优化方法变得至关重要。

首先,深度学习模型训练所需的计算资源通常是巨大的。

这是因为深度学习模型的训练需要进行大量的矩阵计算和参数更新,以调整模型的权重和偏差。

这一过程对于中小型计算机而言可能会面临巨大的挑战,因为它们无法提供足够的计算能力来处理庞大的数据量和复杂的计算任务。

为了满足深度学习模型的计算资源要求,一种常见的做法是通过使用图形处理单元(GPU)来加速计算。

由于GPU在图像处理方面具有出色的性能,它们也被广泛应用于深度学习领域。

GPU具有大量的并行计算单元,能够同时处理多个任务,从而显著加快深度学习模型的训练速度。

此外,还有专门针对深度学习任务设计的Tensor Processing Unit(TPU)等专用硬件,可以进一步提高深度学习计算的效率。

除了硬件方面的优化,还可以通过软件和算法来提高深度学习技术的计算效率。

首先,合理选择深度学习框架也是非常重要的。

目前,常用的深度学习框架如TensorFlow、PyTorch和Caffe等都提供了对GPU和其他加速硬件的良好支持,可以更好地利用硬件资源。

其次,对于较大的深度学习模型,可以通过网络剪枝和压缩等技术来减少模型的复杂度和参数量,从而降低计算资源需求。

此外,还可以使用深度学习模型量化技术,将浮点数表示的模型参数转换为定点数表示,以减少计算和存储开销。

另外,深度学习技术的计算资源需求也受到数据规模和训练策略的影响。

较大的数据集通常需要更多的计算资源来进行训练,但也会获得更好的模型性能。

因此,在资源有限的情况下,需要在数据规模和计算资源之间进行权衡。

此外,选择合适的训练策略,如批量梯度下降(Batch Gradient Descent)和随机梯度下降(Stochastic Gradient Descent)等,也可以进一步优化计算资源的使用效率。

NVIDIA一种先进的深度学习方法可用于对图像进行编辑

NVIDIA 一种先进的深度学习方法可用于对图像进行

编辑

NVIDIA 研究团队研发出了一种先进的深度学习方法,可用于对图像进行编辑,或对有空白或像素缺失的受损图像进行重建。

应用该方法,研究人员能够通过先清除内容再填充所产生的空白这样的操作,对图像进行编辑。

这个“图像修复”的过程,可灵活应用于图片编辑软件中,用以移除不需要的内容,同时用计算机生成的逼真图像进行填充。

“我们的模型能够很好地处理任何形状、大小、位置、或与图像边界的任意距离的空白,之前的深度学习方法主要集中于图像中心的矩形区域,且通常依赖成本颇高的后期处理,”NVIDIA研究人员在其研究报告中指出。

“此外,我们的模型能够更好地处理更大的空白区域。

”

为准备训练其神经网络,团队首先生成了55116 个任意形状和大小的随机条纹和空白。

他们还生成了近25000 个条纹和空白用于测试。

根据其相对于输入图像的大小,这些均被进一步分为六类,以期提高图像重建的准确性。

生成的用于训练的蒙版示例。

科研实验室-服务器的使用和管理指南

安装cuDNN

下载完成后可以使用以下命令安装。

34

安装深度学习框架

这里以PyTorch框架为例,打开PyTorch官网,选择对应的平台以及Python和 CUDA的版本,执行网页中给出的命令即可。

35

目录

1 Linux

Linux基础概念 Linux常用命令

2 GPU

GPU基础概念 GPU深度学习组件的安装

易于迁移

如果你想将你的项目发布出去,那么Docker将是一个很好的选择,因为其具有开箱即用这

一优点。

更加轻松的维护和拓展

Docker官方维护了一系列高质量的镜像,我们自身可以在这些镜像的基础上根据自身的需 要进行进一步的定制,大大降低了维护的成本。

38

Docker基本概念

commit

镜像

Docker 镜像是一个特殊的文件系统,除 了提供容器运行时所需的程序、库、资 源、配置等文件外,还包含了一些为运 行时准备的一些配置参数。镜像不包含 任何动态数据,其内容在构建之后也不 会被改变。

货物

Docker

集装箱

服务器

货轮

37

Docker的优势

快速配置环境

深度学习的开发环境配置起来常常比较繁琐,对于刚刚入门者更是如此。使用Docker可以 只输入1行命令快速配置好环境进行实验。

一致的运行环境

深度学习实验由于需要大量的计算,常常在高性能服务器上运行,使用Docker可以保证本 地开发环境与服务器环境一致,确保不会出现因为环境问题导致的错误。

6

环境变量

环境变量一般是指在操作系统中用来指定操作系统运行环境的一些参数,实 质上是一系列键值对。在命令行界面中可以使用env命令查看所有的环境变 量。PATH环境变量是一个重要的环境变量,其指定了系统应该到什么目录 中去查找可执行命令。

显卡机器学习技术深度学习的利器

显卡机器学习技术深度学习的利器显卡:机器学习技术深度学习的利器过去几年,机器学习和深度学习技术在众多领域如图像识别、自然语言处理以及智能推荐系统等方面取得了巨大成功。

这些成功的背后离不开强大的计算能力,而显卡作为一种高性能计算设备,在机器学习和深度学习中发挥着重要的作用。

本文将讨论显卡在机器学习技术深度学习中的应用,并探讨其成为这些技术利器的原因。

一、显卡在机器学习中的应用1. 并行计算能力机器学习和深度学习中常见的计算任务包括矩阵运算、向量计算以及神经网络的训练和推理等。

这些计算任务通常可以通过并行计算来加速。

而显卡在设计上具有大量的处理单元和高带宽内存,能够同时执行多个计算任务,从而大大提升了计算效率。

2. 高性能计算平台显卡厂商如英伟达和AMD都提供了针对机器学习和深度学习的高性能计算平台,如NVIDIA的CUDA和AMD的ROCm等。

这些平台提供了丰富的工具和库,能够帮助开发人员更方便地进行机器学习和深度学习的开发和优化。

同时,显卡驱动程序和硬件架构也在不断优化,以应对不断增长的计算需求。

3. 大规模数据处理能力在机器学习和深度学习中,大规模数据集的处理是一项重要的任务。

显卡的高性能计算能力和大容量显存使得它能够高效地处理大规模数据集,加速数据的加载、处理和传输。

二、显卡成为机器学习技术利器的原因1. 高性能和效率相比于传统的CPU,显卡在并行计算和浮点运算上具有极高的效率。

显卡的大量处理单元可以同时处理多个计算任务,更快地完成计算任务。

而且显卡在处理相同计算负载时,其功耗通常比CPU低,因此在性能和能效方面都具有优势。

2. 开放的生态系统显卡厂商提供的高性能计算平台和开发工具使得机器学习和深度学习的开发更加便捷。

这些平台和工具具有广泛的支持和社区,开发人员可以方便地分享经验和代码,并从中受益。

此外,显卡的通用计算能力也为其他领域的计算加速提供了可能。

3. 不断创新的硬件架构显卡厂商在硬件架构上进行不断创新,以满足机器学习和深度学习的需求。

深度学习技术的硬件要求与配置建议

深度学习技术的硬件要求与配置建议深度学习技术作为一种强大的机器学习方法,在人工智能领域得到了广泛应用。

然而,由于深度学习算法的计算复杂度和存储需求较高,所以对硬件的要求也相应增加。

本文将为您介绍深度学习技术的硬件要求,并提供相应的配置建议。

首先,深度学习算法对计算能力有较高的要求。

在训练深度学习模型时,需要进行大量的矩阵运算和浮点计算。

因此,一台配备有强大的GPU(图形处理器)的计算机往往是深度学习任务的首选。

由于GPU具备大量的并行计算单元,可以显著加速深度学习算法的运行速度。

目前,NVIDIA的GPU产品在深度学习领域应用广泛,如NVIDIA GeForce系列和NVIDIA Tesla系列。

其次,内存容量也是深度学习任务中的关键要素。

在进行模型训练时,需要加载大量的数据和模型参数到内存中,并进行反向传播计算。

因此,建议配置具备较大内存容量的计算机,以保证能够高效地处理大规模的数据和模型。

当前,一台配备16GB以上内存的计算机已经能够满足一般的深度学习任务需求。

存储器的速度和容量也对深度学习任务的效率产生着重要的影响。

深度学习模型的参数通常会存储在硬盘或固态硬盘(SSD)中,并在训练或推断过程中进行频繁的读写操作。

因此,选择高速、大容量的存储设备可以提高深度学习任务的整体性能。

此外,还建议采用RAID技术以提升数据存储的安全性和容错性。

网络的带宽和稳定性对于深度学习任务的数据传输也非常重要。

在进行深度学习模型的训练时,通常需要从云端或者相对较大的数据集中加载数据。

因此,具备高速、稳定的网络连接将大大减少数据传输的时间。

建议使用高速的宽带网络,并保持网络连接的稳定性,以提高深度学习任务的效率。

此外,合理的功耗和散热设计也是进行深度学习任务的关键。

运行深度学习任务时,GPU和CPU通常会高负载运行,产生大量的热量。

因此,需要配置有效的散热设备和散热系统,以保证计算机的稳定运行。

同时,合理控制计算机的功耗,以避免过高的功耗对硬件造成损害。

基于TensorRT的深度学习模型在嵌入式系统上的部署优化

基于TensorRT的深度学习模型在嵌入式系统上的部署优化深度学习技术在近年来取得了巨大的发展,已经在各个领域展现出了强大的应用潜力。

然而,随着深度学习模型变得越来越复杂和庞大,如何高效地部署这些模型成为了一个亟待解决的问题。

特别是在嵌入式系统中,由于硬件资源有限、功耗限制等因素,对深度学习模型的部署提出了更高的要求。

TensorRT简介TensorRT是英伟达(NVIDIA)推出的用于深度学习推理(inference)加速的库,它能够将训练好的深度学习模型优化并部署到各种平台上,包括服务器、台式机、笔记本电脑以及嵌入式系统等。

TensorRT通过减少网络中冗余的计算、精简网络结构、优化内存使用等方式,显著提高深度学习模型的推理速度,同时降低系统资源的占用率。

深度学习模型在嵌入式系统上的挑战在嵌入式系统上部署深度学习模型面临诸多挑战。

首先,嵌入式设备通常具有有限的计算资源和内存空间,无法承受过大的模型。

其次,嵌入式设备对实时性要求较高,需要在有限的时间内完成推理任务。

此外,嵌入式设备通常工作在功耗受限的环境下,需要尽可能降低能耗。

TensorRT在嵌入式系统上的优势基于TensorRT进行深度学习模型部署优化可以带来诸多优势。

首先,TensorRT能够针对不同硬件平台进行优化,充分利用硬件资源,提高推理速度。

其次,TensorRT支持多种深度学习框架,包括TensorFlow、PyTorch等,方便用户灵活选择模型训练框架。

此外,TensorRT还提供了丰富的API接口和工具,方便用户进行模型转换、优化和部署。

基于TensorRT的深度学习模型部署流程选择合适的深度学习模型:根据实际需求选择适合嵌入式系统部署的轻量级模型,如MobileNet、YOLO等。

训练和优化模型:使用常见的深度学习框架如TensorFlow或PyTorch进行模型训练,并通过TensorRT进行优化。

转换模型格式:将训练好的模型转换为TensorRT支持的格式,如ONNX或TensorFlow SavedModel。

3090大模型训练案例

3090大模型训练案例一、介绍3090大模型是指使用NVIDIA GeForce RTX 3090显卡进行训练的深度学习模型。

由于RTX 3090具备强大的计算能力和显存容量,适合处理大规模数据和复杂模型,因此在训练大模型时被广泛应用。

以下是几个3090大模型训练案例的介绍。

二、3090大模型训练案例1. 自然语言处理任务在自然语言处理领域,BERT和GPT等大型预训练模型需要大量的计算资源进行训练。

使用3090大模型进行训练可以提高训练速度和模型效果,加快模型在文本分类、命名实体识别等任务上的表现。

2. 计算机视觉任务在计算机视觉领域,使用3090大模型进行图像分类、目标检测、图像分割等任务的训练可以提高模型的准确性和鲁棒性。

例如,可以使用大模型对ImageNet数据集进行训练,从而得到更好的图像分类结果。

3. 语音识别任务在语音识别领域,使用3090大模型进行声学模型和语言模型的训练可以提高语音识别系统的准确率和鲁棒性。

通过使用大模型,可以更好地建模声学特征和语言信息,从而提升语音识别的性能。

4. 强化学习任务在强化学习领域,使用3090大模型进行价值函数和策略函数的训练可以加速强化学习算法的收敛速度和性能。

大模型可以更好地表示状态和动作空间,从而提高强化学习算法对环境的建模能力。

5. 推荐系统任务在推荐系统领域,使用3090大模型进行CTR(点击率)预测模型的训练可以提高推荐算法的效果。

大模型可以更好地捕捉用户行为和物品特征之间的复杂关系,从而提升推荐系统的准确性和个性化程度。

6. 机器翻译任务在机器翻译领域,使用3090大模型进行神经机器翻译模型的训练可以提高翻译质量和流畅度。

大模型可以更好地建模源语言和目标语言之间的关系,从而改善翻译结果的准确性和自然度。

7. 图神经网络任务在图神经网络领域,使用3090大模型进行图表示学习和图分类任务的训练可以提高对图结构数据的建模能力。

大模型可以更好地捕捉节点之间的复杂关系,从而改善图神经网络的性能。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

NVIDIA深度学习实验室解决方案

1深度学习实验室建设的意义和背景 人工智能人才市场需求量大

有预测在2018年百分之八十的企业将部署人工智能产业链,国家和企业都需要大量的人才补充,而我们的高校和职校还没有建立完整的教育课程和实践环境。

GPU资源相对集中,个人无法承受

由于GPU相对昂贵,普通学生无法承担,往往是学校的超算中心和部分教授有购买力,但是深度学习框架大量开源,学生有能力自学理论知识但无实践环境来检验自学效果。

虽然有部分师生用消费级卡来实验,但是这与企业的使用环境相去甚远。

校级GPU平台资源浪费、管理困难

大多数学校发现校级GPU计算资源被初学者占用,往往导致真正科研计算任务匮乏计算资源,基于Docker环境的计算管理环境常常发生计算资源抢占现象,让管理者应接不暇各种投诉。

管理者非常需要了解GPU的使用情况。

人工智能教师队伍缺乏,教程不系统

虽然人工智能教材不断涌现,但是学校的这方面的师资队伍还处于建设初期,教师没有经过系统的学习和实践过程。

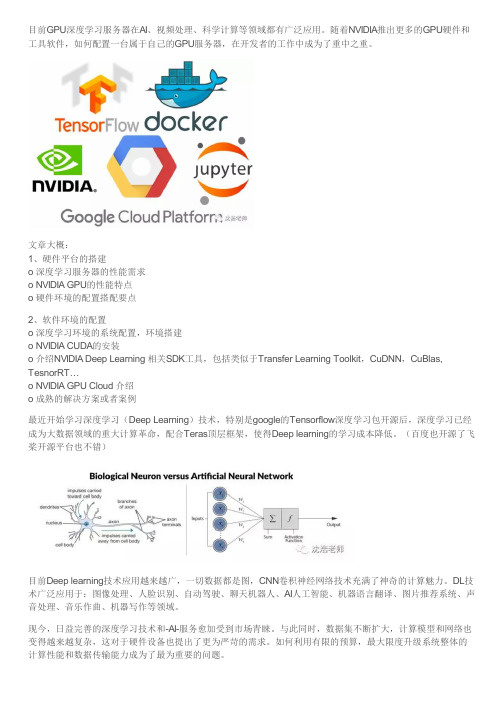

2NVIDIA深度学习解决方案

NVIDIA深度学习解决方案是NVIDIA公司推出的基于NVIDIA GPU虚拟化以及NVIDIA Docker技术,再配合NVIDIA深度学习学院培训体系的一体化人工智能实验室解决方案。

该方案采用以用户为中心的计算模式、按需向用户提供GPU资源、框架资源、深度学习环境。

保障用户对GPU资源的独享,保证用户获取足够的自由度和较高的用户体验,同时满足集中管理和数据安全的需求,灵活和快速部署实验环境。

NVIDIA GPU虚拟化解决方案最新的Virtual GPU 5.0版本为GPU虚拟化带来了新的环境实现,支持在GPU虚拟环境下的深度学习框架的搭建和计算,是教育单位的人工智能实验室得以实现的重要技术平台。

2.1深度学习实验室方案架构

从架构图来看整个方案由以下几个核心组件构成:

NVIDIA Tesla GPU (P40)

服务器虚拟化平台

NVIDIA Virtual GPU 软件(Quadro vDWS版本)

NVIDIA Docker

深度学习框架(Framework)

通过整个架构图我们可以看到,单台服务器配合单片Tesla P40 GPU卡最大可以支持24个vGPU的实例,每vGPU配置1GB显存(P40-1Q)。

所以单台服务器最大可用支撑24个用于教学的深度学习环境。

NVIDIA Virtual GPU 软件(Quadro vDWS版本) 我们在服务器虚拟化平台,通过NVIDIA Virtual GPU软件对GPU计算资源进行切割,按需求进行分配,依托NVIDIA Docker技术快速部署各种深度学习实践环境,包括Ubuntu操作系统和框架,用户通过笔记本、PC进行连接,进行AI实验、模型实践和推演产品的互动教学和体验。

目前Tesla所有的P系列在Virtual GPU 5.0上支持虚拟化,并且vGPU同时支持图形计算以及人工智能应用。

NVIDIA Docker

Docker是用户在部署人工智能训练平台的时候最常用的解决方案, 其快速的应用程序部署功能非常适合于深度学习框架的部署。

常见的基于Docker部署的应用主要以CPU应用为主,而所有的深度学习框架更适合使用GPU进行训练,可以提供更高的训练效率和准确度。

如果在不使用NVIDIA Docker的情况下,Docker无法直接调用GPU 且对容器和底层操作系统的GPU驱动有版本一致的要求。

也就是说无法实现底层硬件无关性的要求,这是和Docker本身倡导的可移植性相违背的,也给用户在使用过程中带来了不便。

通过NVIDIA Docker(基于Docker的Plug-in)技术,可以实现在容器中便利的使用NVIDIA GPU。

NVIDIA Docker主要有以下优势:

实现底层GPU设备的硬件无关性

可以在容器中运行多个版本的NVIDIA驱动和CUDA版本

NVIDIA Tesla GPU

NVIDIA Tesla并行计算架构从G80架构,经历了Fermi、Kepler、Maxwell、Pascal,每一代架构更新都带来产品工艺、计算能力、存储带宽等方面的巨大提升,与CPU相比GPU发展更快,具有更强大的计算能力。

NVIDIA Tesla GPU专为数据中心设计,许多CUDA软件特性都是专为GPGPU而设计的。

目前所有的Tesla P系列GPU都可以支持虚拟化,通过虚拟化解决方案可以实现GPU资源的按需切割和细颗粒度管理,提升GPU卡的资源利用率。

NVIDIA Tesla P40

在众多的Tesla GPU中我们为什么采用P40做为搭建深度学习实验室解决方案的首选GPU呢?

NVIDIA Tesla P40 的主要目的是为深度学习部署提供更大的吞吐量。

每个GPU 可带来47 TOPS(万亿次运算/秒)的推理性能和INT8 运算能力,使得一台配备8 个Tesla P40 的服务器可提供相当于超过140 台CPU 服务器的性能。

随着模型的准确性和复杂性越来越高,CPU 已经无法再提供互动用户体验。

Tesla P40 可在极其复杂的模型中实现实时响应,能够降低延迟,将性能提升为CPU 的30 倍以上。

NVIDIA Tesla P40 加速器的特性和利益点

提供140 倍的吞吐量以应对爆炸性数据的挑战

Tesla P40 配备新的Pascal 架构,可带来超过47 TOPS 的深度学习推理性能。

在处理深度学习工作负载方面,一台使用8 个Tesla P40 的服务器最多可替代140 台只使

用CPU 的服务器,因而可以大幅提升吞吐量并降低购买成本。

通过单一的训练和推理平台简化了操作

目前,深度学习模型在GPU 服务器上接受训练,但在CPU 服务器上部署,以便进行推理。

Tesla P40 提供极简工作流程,因此组织可以使用相同的服务器进行迭代和部署。

实时推理

Tesla P40 具备INT8 运算能力,可在极其复杂的深度学习模型中实现实时响应,能将推理性能速度提升高达30 倍。

使用NVIDIA 深度学习SDK 加快了部署速度

通过NVIDIA 深度学习SDK 中所包含的TensorRT 以及Deep Stream SDK,客户可以轻松顺畅地利用新INT8 运算能力和视频转码等推理功能。

深度学习框架

深度学习框架是为了更轻松、高效地研究和应用深度学习。

目前主流的深度学习框架都很好的支持GPU加速。

使用框架的主要好处包括:

框架可专门为深度神经网络(DNN)训练所需的计算提供支持高度优化GPU的代码NVIDIA 的框架经过调优和测试,可提供非常出色的GPU 性能 借助这些框架,用户可以通过简单的命令行或Python 等脚本语言接口访问代码。

许多功能强大的DNN 都可通过这些框架来训练和部署,而无需编写任何GPU 或复杂的编译代码,与此同时仍从GPU 加速带来的训练速度提高中受益

3AI专业教师资源培养

通过NVIDIA的深度学习学院,可以为学校培养AI专业教师,教师可以叠加人工智能概念及基本知识、深度学习的技术和算法等,架构学校自身教学和实验内容。

学校建立系统的AI教学课程也得以实现。

培训组织和个人,用深度学习的方法解决有挑战的问题

由认证的专家讲授,提供现场培训和在线课程

覆盖应用使用案例的全工作流程(自动驾驶汽车,推荐引擎,医疗图像分类,智能视频分析等)

4方案优势

4.1常见深度学习实验室解决方案对比

差一般强

不可复用可复用可复用

好差(会出现资源抢占)好

单机管理模式集中管理,粗颗粒度集中管理,细颗粒度

不支持不支持支持

传统的PC+独立GPU卡的方式部署整个深度学习的教学环境,学校的实训教室管理人员无法对GPU资源进行管理,每用户完全独占当前PC的GPU资源。

即使出现部分用户GPU资源不足,而另一部分用户GPU资源闲置的情况,我们也无法进行按需的调整。

而GPU虚拟化解决方案把GPU部署在数据中心,此GPU具备比前端PC上使用的GPU更强的计算能力,我们可以按照用户的实际需求对GPU资源进行切割和调整,从而实现GPU资源的最大化利用。

在GPU虚拟化解决方案出现之前,多数用户采用Docker的方案来实现对GPU资源的使用和共享,然而完全基于Docker方式构建的深度学习实验室方案在资源隔离、监控管理、对多种GPU负载的支持存在很大的问题,所以在教学环境场景也不是最佳的选择。

利用NVIDIA深度学习实验室解决方案可以方便制作针对Docker软件环境模板,通过模板可以实现深度学习教学环境的批量创建、更新以达到快速部署的目的。

深度学习框架的更新均可在模板虚拟机中完成,更新完成后通过模板进行快速复制,大大简化了用户教训环境的配置和部署。

同时提供完善的GPU监控功能,对服务器上的物理GPU 和虚拟机中的vGPU(包括在其上运行的进程)的GPU资源占用情况进行实时数据统计,并能反映目前物理机、虚拟机的资源瓶颈。