深度高可用集群软件产品手册

HACMP(高可用集群软件)的安装和使用

高可用集群软件(HACMP)的安装和使用HACMP软件的安装:命令:smit屏幕显示系统管理菜单:System ManagementSoftware Installation and MaintenanceSoftware License ManagementDevicesSystem Storage Management (Physical & Logical Storage) Security & UsersCommunications Applications and ServicesPrint SpoolingProblem DeterminationPerformance & Resource SchedulingSystem EnvironmentsProcesses & SubsystemsRemote Customer Support and ServicesApplicationsUsing SMIT (information only)选择:Software Installation and Maintenance屏幕显示软件安装和维护菜单:选择:Install and Update Software屏幕显示软件安装和更新菜单:选择:Install and Update from LASEST Available Software屏幕显示软件安装和更新(从最后有效软件中)菜单:Install and Update from LASEST Available SoftwareType or select a value for the entry fieldpress Enter AFTER making all desired changes.[Entry Fields]* INPUT device / directory for software [/dev/cd0]显示软件安装和更新(从最后有效软件中)参数屏幕:Install and Update from LASEST Available SoftwareType or select a value for the entry fieldpress Enter AFTER making all desired changes.[Entry Fields]* INPUT device / directory for software /dev/cd0* SOFTWARE to install [_all_latest]PREVIEW only noCOMMIT software updates? yesSAVE replaced files noAUTOMATION install requisite software? yesEXPEND file systems if space needed ? yesOVERWRITE same or newer versions? noVERIFY install and check file sizes? noInclude corresponding LANGUAGE filesets? yesDELETE output? no按ENTER键,即可安装HACMP软件光盘上的全部软件。

中标麒麟高可用集群软件(龙芯版)V7.0 产品白皮书说明书

中标软件有限公司

目录

目录

目录 ...................................................................................................................................................i 前言 ..................................................................................................................................................v 内容指南 ........................................................................................................................................vii 中标麒麟高可用集群产品介绍....................................................................................................... 9 1 概述 ............................................................................................................................................ 11

第 i 页 / 共 54 页

联想 SureHA Cluster高可用软件 说明书

SureHA工作原理

故障监视原理 在SureHA 中通过执行服务器监视、业务监视、内部监视3个监视任务,可以迅速确切 地查出故障。以下介绍这些监视的详细内容。 服务器监视 服务器监视是失效切换型集群系统中最基本的监视功能,用于监视配置集群的服务 器是否中断。 SureHA是为了服务器监视,定期在各服务器之间进行生存确认。该生存确认称为心

运行业务应用程序的服务器(当前服务器)发生故障时,集群系统查出故障并在 交接业务的服务器(待机服务器)中自动运行业务应用程序,交接业务。这称为失效切 换。集群系统交接的业务由磁盘、IP地址、应用程序等资源构成。

在没有集群化的系统中使用其它服务器重启应用程序时,客户端必须再次连接 不同的IP地址。但是多数的集群系统里不是以业务为单位给服务器分配IP,而是分配 其它网络的IP地址(虚拟IP地址)。因此客户端没必要去区分正在执行业务的是当前服 务器还是待机服务器,如同连接同一个服务器一样,可以持续的运行业务。

高可用(HA)集群

◆一般提升系统可用性时,会认为对构成系统的组件进行冗余化,消除Single Point of Failure是重要的。所谓Single Point of Failure指的是计算机的构成要素(硬件的组 件)因为只有一个,所以该处发生故障时会有使业务停止的弱点。所谓HA集群是使 用多台节点进行冗余化操作、将系统停止时间控制在最小限度,提升业务可用性 (availability)的集群系统。

4 联想SureHA Cluster高可用软件介绍

图 N + M 结构

联想SureHA高可用产品介绍

联想SureHA高可用就是通过冗余化(集群化)的系统结构,当前服务器发生故障时,自 动用待机服务器交接业务的软件,该软件实现了系统可用性和扩展性的飞越性的提 高。

数据库高可用性的说明书

数据库高可用性的说明书1. 引言数据库作为现代信息系统的核心组成部分,承载了大量的数据和应用。

在面对各种故障和意外情况时,确保数据库的高可用性是至关重要的。

本说明书将介绍数据库高可用性的概念、原理、技术和最佳实践,以帮助您有效保障数据库系统的稳定运行。

2. 数据库高可用性的概述数据库高可用性是指数据库系统在面对故障或意外情况时,能够提供持续的、不间断的数据存取和服务。

通过采用高可用性的架构和技术手段,可以最大程度地减少数据库系统的停机时间,确保数据的完整性和可用性。

3. 高可用性的原理为实现数据库的高可用性,需要考虑以下几个关键原理:3.1 冗余备份:通过建立冗余的数据库备份,保证在主数据库出现故障时,备用数据库可以迅速接管服务,并确保数据的持续可用性。

3.2 自动故障切换:采用自动故障切换技术,当主数据库出现故障时,能够自动将服务转移到备用数据库,以实现数据库系统的无缝切换,最大限度地减少业务中断。

3.3 数据同步机制:通过实现数据的实时同步或定期同步,确保主数据库和备用数据库之间的数据一致性,减少数据丢失的风险。

3.4 监控和告警:建立完善的数据库监控和告警系统,实时监测数据库的运行状态,及时发现并处理潜在故障,保障数据库系统的稳定性和可用性。

4. 高可用性的实现技术为了实现数据库的高可用性,可以采用以下几种常见的技术:4.1 数据库复制技术:通过主备复制、主主复制等技术手段,将数据实时或定期地同步到备用数据库中,实现数据的冗余备份和故障切换。

4.2 数据库集群技术:通过在多台服务器上部署数据库实例,并将其组成集群,实现数据的分布式存储和负载均衡,提高数据库的可扩展性和容错性。

4.3 虚拟化技术:利用虚拟化技术实现数据库的快速备份、快速恢复和故障迁移,提高数据库的可靠性和可用性。

4.4 容器化技术:通过将数据库容器化,实现快速部署、动态扩缩容和服务隔离,提高数据库的弹性和可用性。

5. 数据库高可用性的最佳实践为了确保数据库的高可用性,以下是几个值得注意的最佳实践:5.1 定期备份和恢复测试:定期进行数据库备份,并进行恢复测试,确保备份数据的完整性和可用性,减少数据丢失的风险。

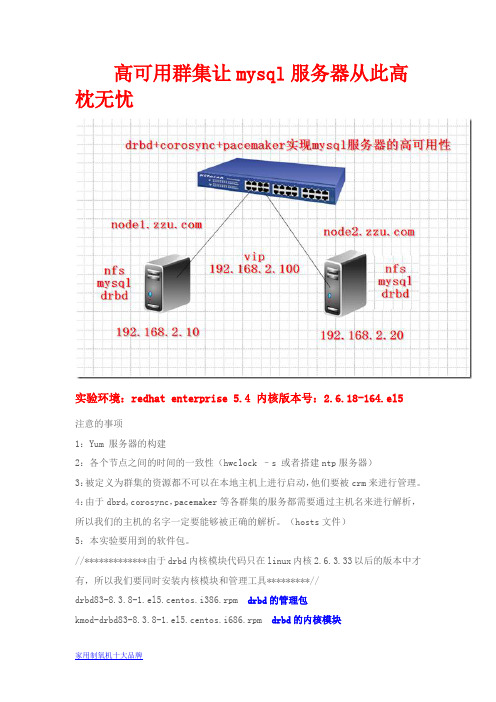

mysql服务器高可用性集群配置

高可用群集让mysql服务器从此高枕无忧实验环境:redhat enterprise 5.4 内核版本号:2.6.18-164.el5注意的事项1:Yum 服务器的构建2:各个节点之间的时间的一致性(hwclock –s 或者搭建ntp服务器)3:被定义为群集的资源都不可以在本地主机上进行启动,他们要被crm来进行管理。

4:由于dbrd,corosync,pacemaker等各群集的服务都需要通过主机名来进行解析,所以我们的主机的名字一定要能够被正确的解析。

(hosts文件)5:本实验要用到的软件包。

//*************由于drbd内核模块代码只在linux内核2.6.3.33以后的版本中才有,所以我们要同时安装内核模块和管理工具*********//drbd83-8.3.8-1.el5.centos.i386.rpm drbd的管理包kmod-drbd83-8.3.8-1.el5.centos.i686.rpm drbd的内核模块//*************由于drbd内核模块代码只在linux内核2.6.3.33以后的版本中才有,所以我们要同时安装内核模块和管理工具*********//cluster-glue-1.0.6-1.6.el5.i386.rpm 为了在群集中增加对更多节点的支持cluster-glue-libs-1.0.6-1.6.el5.i386.rpmcorosync-1.2.7-1.1.el5.i386.rpm corosync的主配置文件corosynclib-1.2.7-1.1.el5.i386.rpm corosync的库文件heartbeat-3.0.3-2.3.el5.i386.rpm 我们的heartbeat在这里是做四层的资源代理用的heartbeat-libs-3.0.3-2.3.el5.i386.rpm heartbeat的库文件ldirectord-1.0.1-1.el5.i386.rpm 在高可用性群集中实验对后面realserver的探测libesmtp-1.0.4-5.el5.i386.rpmopenais-1.1.3-1.6.el5.i386.rpm做丰富pacemake的内容使用openaislib-1.1.3-1.6.el5.i386.rpm openais 的库文件pacemaker-1.1.5-1.1.el5.i386.rpm pacemake的主配置文档pacemaker-libs-1.1.5-1.1.el5.i386.rpm pacemaker的库文件pacemaker-cts-1.1.5-1.1.el5.i386.rpmperl-TimeDate-1.16-5.el5.noarch.rpmresource-agents-1.0.4-1.1.el5.i386.rpm 开启资源代理用的mysql-5.5.15-linux2.6-i686.tar.gz mysql的绿色软件说明:资源的下载地址/data/402802具体的实验步骤:一:修改群集中各节点的网络参数node1:[root@node1 ~]# vim /etc/sysconfig/networkNETWORKING=yesNETWORKING_IPV6=noHOSTNAME=[root@node1 ~]# vim /etc/hosts192.168.2.10 node1192.168.2.20 node2[root@node1 ~]#hostnamenode2:[root@node2 ~]# vim /etc/sysconfig/networkNETWORKING=yesNETWORKING_IPV6=noHOSTNAME=[root@node2 ~]# vim /etc/hosts192.168.2.10 node1192.168.2.20 node2[root@node2 ~]#hostname二:同步群集中各节点的时间node1:[root@node1~]# hwclock -snode2:[root@node2 ~]# hwclock -s三:在各个节点上面产生密钥实现无密码的通讯node1:[root@node1 ~]# ssh-key -t rsa 产生一个rsa的非对称加密的私钥对[root@node1 ~]# ssh-copy-id -i .ssh/id_rsa.pub node2 拷贝到node2节点node2:[root@node2 ~]# ssh-key -t rsa 产生一个rsa的非对称加密的私钥对[root@node2 ~]# ssh-copy-id -i .ssh/id_rsa.pub node2 拷贝到node1节点四:在各个节点上面配置好yum客户端node1:[root@node1 ~]# vim /etc/yum.repos.d/server.repo[rhel-server]name=Red Hat Enterprise Linux serverbaseurl=file:///mnt/cdrom/Serverenabled=1gpgcheck=1gpgkey=file:///mnt/cdrom/RPM-GPG-KEY-redhat-release[rhel-vt]name=Red Hat Enterprise Linux vtbaseurl=file:///mnt/cdrom/VTenabled=1gpgcheck=1gpgkey=file:///mnt/cdrom/RPM-GPG-KEY-redhat-release[rhel-cluster] 做群集需要用到的仓库name=Red Hat Enterprise Linux clusterbaseurl=file:///mnt/cdrom/Clusterenabled=1gpgcheck=1gpgkey=file:///mnt/cdrom/RPM-GPG-KEY-redhat-release[rhel-clusterstorage] 做群集文件系统需要用到的仓库name=Red Hat Enterprise Linux clusterstoragebaseurl=file:///mnt/cdrom/ClusterStorageenabled=1gpgcheck=1gpgkey=file:///mnt/cdrom/RPM-GPG-KEY-redhat-release node2:[root@node2 ~]# vim /etc/yum.repos.d/server.repo [rhel-server]name=Red Hat Enterprise Linux serverbaseurl=file:///mnt/cdrom/Serverenabled=1gpgcheck=1gpgkey=file:///mnt/cdrom/RPM-GPG-KEY-redhat-release [rhel-vt]name=Red Hat Enterprise Linux vtbaseurl=file:///mnt/cdrom/VTenabled=1gpgcheck=1gpgkey=file:///mnt/cdrom/RPM-GPG-KEY-redhat-release [rhel-cluster] 做群集需要用到的仓库name=Red Hat Enterprise Linux clusterbaseurl=file:///mnt/cdrom/Clusterenabled=1gpgcheck=1gpgkey=file:///mnt/cdrom/RPM-GPG-KEY-redhat-release [rhel-clusterstorage] 做群集文件系统需要用到的仓库name=Red Hat Enterprise Linux clusterstorage baseurl=file:///mnt/cdrom/ClusterStorageenabled=1gpgcheck=1gpgkey=file:///mnt/cdrom/RPM-GPG-KEY-redhat-release五:将下载好的rpm包上传到linux上的各个节点node1:[root@node1 ~]# ll-rw-r--r-- 1 root root 221868 May 9 10:34 drbd83-8.3.8-1.el5.centos.i386.rpm -rw-r--r-- 1 root root 44377 May 9 10:34 ldirectord-1.0.1-1.el5.i386.rpm -rw-r--r-- 1 root root 271360 May 8 13:07cluster-glue-1.0.6-1.6.el5.i386.rpm 为了在群集中增加对更多节点的支持-rw-r--r-- 1 root root 133254 May 8 13:07cluster-glue-libs-1.0.6-1.6.el5.i386.rpm-rw-r--r-- 1 root root 170052 May 8 13:07corosync-1.2.7-1.1.el5.i386.rpm corosync的主配置文件-rw-r--r-- 1 root root 158502 May 8 13:07corosynclib-1.2.7-1.1.el5.i386.rpm corosync的库文件-rw-r--r-- 1 root root 165591 May 8 13:07heartbeat-3.0.3-2.3.el5.i386.rpm 我们的heartbeat在这里是做四层的资源代理用的-rw-r--r-- 1 root root 289600 May 8 13:07heartbeat-libs-3.0.3-2.3.el5.i386.rpm heartbeat的库文件-rw-r--r-- 1 root root 60458 May 813:07 libesmtp-1.0.4-5.el5.i386.rpm-rw-r--r-- 1 root root 126663 May 5 11:26 libmcrypt-2.5.7-5.el5.i386.rpm -rw-r--r-- 1 root root 207085 May 8 13:07openais-1.1.3-1.6.el5.i386.rpm 做丰富pacemake的内容使用-rw-r--r-- 1 root root 94614 May 8 13:07openaislib-1.1.3-1.6.el5.i386.rpm-rw-r--r-- 1 root root 796813 May 8 13:07pacemaker-1.1.5-1.1.el5.i386.rpm pacemake的主配置文档-rw-r--r-- 1 root root 207925 May 8 13:07pacemaker-cts-1.1.5-1.1.el5.i386.rpm-rw-r--r-- 1 root root 332026 May 8 13:07pacemaker-libs-1.1.5-1.1.el5.i386.rpm pacemaker的库文件-rw-r--r-- 1 root root 32818 May 8 13:07perl-TimeDate-1.16-5.el5.noarch.rpm-rw-r--r-- 1 root root 388632 May 8 13:07resource-agents-1.0.4-1.1.el5.i386.rpm-rw-r--r-- 1 root root 162247449 May 9 16:44mysql-5.5.15-linux2.6-i686.tar.gznode2:[root@node2 ~]# ll-rw-r--r-- 1 root root 221868 May 9 10:34 drbd83-8.3.8-1.el5.centos.i386.rpm -rw-r--r-- 1 root root 44377 May 9 10:34 ldirectord-1.0.1-1.el5.i386.rpm -rw-r--r-- 1 root root 271360 May 8 13:07cluster-glue-1.0.6-1.6.el5.i386.rpm 为了在群集中增加对更多节点的支持-rw-r--r-- 1 root root 133254 May 8 13:07cluster-glue-libs-1.0.6-1.6.el5.i386.rpm-rw-r--r-- 1 root root 170052 May 8 13:07corosync-1.2.7-1.1.el5.i386.rpm corosync的主配置文件-rw-r--r-- 1 root root 158502 May 8 13:07corosynclib-1.2.7-1.1.el5.i386.rpm corosync的库文件-rw-r--r-- 1 root root 165591 May 8 13:07heartbeat-3.0.3-2.3.el5.i386.rpm 我们的heartbeat在这里是做四层的资源代理用的-rw-r--r-- 1 root root 289600 May 8 13:07heartbeat-libs-3.0.3-2.3.el5.i386.rpm heartbeat的库文件-rw-r--r-- 1 root root 60458 May 813:07 libesmtp-1.0.4-5.el5.i386.rpm-rw-r--r-- 1 root root 126663 May 5 11:26 libmcrypt-2.5.7-5.el5.i386.rpm-rw-r--r-- 1 root root 207085 May 8 13:07openais-1.1.3-1.6.el5.i386.rpm 做丰富pacemake的内容使用-rw-r--r-- 1 root root 94614 May 8 13:07openaislib-1.1.3-1.6.el5.i386.rpm-rw-r--r-- 1 root root 796813 May 8 13:07pacemaker-1.1.5-1.1.el5.i386.rpm pacemake的主配置文档-rw-r--r-- 1 root root 207925 May 8 13:07pacemaker-cts-1.1.5-1.1.el5.i386.rpm-rw-r--r-- 1 root root 332026 May 8 13:07pacemaker-libs-1.1.5-1.1.el5.i386.rpm pacemaker的库文件-rw-r--r-- 1 root root 32818 May 8 13:07perl-TimeDate-1.16-5.el5.noarch.rpm-rw-r--r-- 1 root root 388632 May 8 13:07resource-agents-1.0.4-1.1.el5.i386.rpm-rw-r--r-- 1 root root 162247449 May 9 16:44mysql-5.5.15-linux2.6-i686.tar.gz六:在各节点上面安装所有的rpm包node1: [root@node1 ~]# yum localinstall *.rpm -y --nogpgchecknode2: [root@node2~]# yum localinstall *.rpm -y --nogpgcheck七:在各节点上增加一个大小类型都相关的drbd设备(sdb1)Node1:[root@node1 ~]# fdisk /dev/sdbCommand (m for help): nCommand actione extendedp primary partition (1-4)pPartition number (1-4): 1First cylinder (1-522, default 1):Using default value 1Last cylinder or +size or +sizeM or +sizeK (1-522, default 522): +1000M Command (m for help): pDisk /dev/sdb: 4294 MB, 4294967296 bytes255 heads, 63 sectors/track, 522 cylindersUnits = cylinders of 16065 * 512 = 8225280 bytesDevice Boot Start End Blocks Id System/dev/sdb1 1 123 987966 83 Linux[root@node1 ~]# partprobe /dev/sdb //重新加载内核模块[root@node1 ~]# cat /proc/partitionsmajor minor #blocks name8 0 20971520 sda8 1 104391 sda18 2 1052257 sda28 3 19808145 sda38 16 4194304 sdb8 17 987966 sdb1Node2:[root@node2 ~]# fdisk /dev/sdbCommand (m for help): nCommand actione extendedp primary partition (1-4)pPartition number (1-4): 1First cylinder (1-522, default 1):Using default value 1Last cylinder or +size or +sizeM or +sizeK (1-522, default 522): +1000M Command (m for help): pDisk /dev/sdb: 4294 MB, 4294967296 bytes255 heads, 63 sectors/track, 522 cylindersUnits = cylinders of 16065 * 512 = 8225280 bytesDevice Boot Start End Blocks Id System/dev/sdb1 1 123 987966 83 Linux[root@node2 ~]# partprobe /dev/sdb //重新加载内核模块[root@node2 ~]# cat /proc/partitionsmajor minor #blocks name8 0 20971520 sda8 1 104391 sda18 2 1052257 sda28 3 19808145 sda38 16 4194304 sdb8 17 987966 sdb1八:配置drbdnode1:1: 复制样例配置文件为即将使用的配置文件.[root@node1 ~]# cp /usr/share/doc/drbd83-8.3.8/drbd.conf /etc/2:将文件global_common.conf 备份一份[root@node1 ~]# cd /etc/drbd.d/[root@node1 drbd.d]# ll-rwxr-xr-x 1 root root 1418 Jun 4 2010 global_common.conf[root@node1 drbd.d]# cp global_common.conf global_common.conf.bak3:编辑global_common.conf[root@node1 drbd.d]# vim global_common.confglobal {usage-count no; 不开启统计}common {protocol C;handlers {pri-on-incon-degr"/usr/lib/drbd/notify-pri-on-incon-degr.sh;/usr/lib/drbd/notify-emergency-reboot.sh; echo b > /proc/sysrq-trigger ; reboot -f";pri-lost-after-sb"/usr/lib/drbd/notify-pri-lost-after-sb.sh;/usr/lib/drbd/notify-emergency-reboot.sh; echo b > /proc/sysrq-trigger ; reboot -f";local-io-error "/usr/lib/drbd/notify-io-error.sh;/usr/lib/drbd/notify-emergency-shutdown.sh; echo o >/proc/sysrq-trigger ; halt -f";}startup {wfc-timeout 120; 等待连接的超时时间degr-wfc-timeout 120; 等待降级的节点连接的超时时间}disk {on-io-error detach; 当出现I/O错误,节点要拆掉drbd设备 }net {cram-hmac-alg "sha1"; 使用sha1加密算法实现节点认证shared-secret "mydrbdlab"; 认证码,两个节点内容要相同}syncer {rate 100M; 定义同步数据时的速率}}4:定义mysql的资源[root@node1 drbd.d]# vim mysql.resresource mysql {on {device /dev/drbd0;disk /dev/sdb1;address 192.168.2.10:7789;meta-disk internal;}on {device /dev/drbd0;disk /dev/sdb1;address 192.168.2.20:7789;meta-disk internal;}}5:将以上的drbd.*文件都拷贝到node2上面[root@node1 drbd.d]# scp -r /etc/drbd.* node2:/etc/ 6:node1初始化定义的mysql的资源并启动相应的服务[root@node1 drbd.d]# drbdadm create-md mysql Writing meta data...initializing activity logNOT initialized bitmapNew drbd meta data block successfully created. [root@node1 drbd.d]# service drbd start7:node2初始化定义的mysql的资源并启动相应的服务[root@node2 drbd.d]# drbdadm create-md mysqlWriting meta data...initializing activity logNOT initialized bitmapNew drbd meta data block successfully created.[root@node2 drbd.d]# service drbd start8: 使用drbd-overview命令来查看启动状态[root@node1 drbd.d]# drbd-overview0:mysql Connected Secondary/Secondary Inconsistent/Inconsistent C r---- 从上面的信息中可以看出此时两个节点均处于Secondary状态。

深信服云计算产品解决方案及服务手册

分布式虚拟交换机 全网流量可视

虚拟路由器 一键故障检测

业务逻辑拓扑“ 所 画 即 所 得 ”

06

深信服云计算产品解决方案及服务

安全虚拟化 aSEC

深信服 aSEC 是深信服安全与虚拟化深度融合的产物,基于 NFV 网络功能虚拟化的思想,使深信服安全功能不再依赖专用 硬件,通过创新的所画即所得方式以及虚拟化技术,资源可以充分灵活共享,实现业务安全的快速部署,并基于实际业务 进行弹性伸缩、故障隔离等。

Contents

目录

业务概述 品牌成绩 产品介绍

服务器虚拟化 超融合软件 超融合一体机 云管平台

云计算服务

托管云服务

解决方案

超融合解决方案

关键业务承载解决方案 云数据中心建设解决方案 数据中心容灾备份解决方案 涉密虚拟化场景解决方案

云计算解决方案

私有云建设解决方案 分支云建设解决方案 容器云建设解决方案 托管专属云解决方案 同架构混合云解决方案

产品

服务器虚拟化 超融合软件

超融合一体机 云管平台

深信服云计算业务图谱

服务

托管云

解决方案

超融合解决方案

关键业务承载解决方案 超 融合数据中心建设解决方案

超融合容灾备份解决方案 涉密虚拟化场景解决方案

云计算解决方案

私有云建设解决方案 分支云建设解决方案 容器云建设解决方案 托管专属云解决方案 同架构混合云解决方案

01

品牌成绩

IDC 发布的《中国超融合市场跟踪研究报告,2018》排行榜中,超融合软件市场占有率深信服排名第二,超融 合软硬件整体市场占有率深信服稳居前三。数据来源:《IDCChina HCI Market Key Vendor Analysis,2018》 入围 Gartner 2016 年《X86 服务器虚拟化基础架构魔力象限》,国内仅两家入围 首 批获得 2017 年可信云《云计算超融合架构可信认证》,国内首家通过 首批通过 CSA 云安全成熟度模型 CSA-CMMI5认证 成为业界具备权威影响力的开放数据中心委员会(ODCC)白金会员 广东省智能云计算工程技术研究中心 荣获 2018 年 Cloud500 卓越云基础设施提供商 荣获 Cloud China 2017 年云帆奖“云计算最具影响力企业奖” 年增长 1000+ 云计算案例,累计帮助超过近万家用户实现业务云化,承载用户关键业务的比例超过 60%,成为 中华人民共和国农业部、华侨城集团、武汉大学、上海联合产权交易所等众多用户首选的云计算品牌

Blue Prism Hub and Interact 4.6 高可用性配置指南说明书

Hub and Interact 4.6高可用性配置指南文档修订版:2.0商标和版权本指南中包含的信息是 Blue Prism Limited 和/或附属公司的专有和机密信息,未经获授权的 Blue Prism 代表的书面同意,不得披露给第三方。

未经 Blue Prism Limited 或其附属公司的书面同意,不得以任何形式或通过任何手段(电子或实物形式,包括复制)翻印或传输本文档中的任何部分。

© Blue Prism Limited 2001—2023“Blue Prism”、“Blue Prism”徽标和 Prism 设备是 Blue Prism Limited 及其附属公司的商标或注册商标。

保留所有权利。

其他所有商标在本指南中的使用均得到认可,并用于各自所属方的利益。

Blue Prism Limited 及其附属公司对本指南中引用的外部网站的内容概不负责。

Blue Prism Limited, 2 Cinnamon Park, Crab Lane, Warrington, WA2 0XP, 英国。

在英国境内注册:注册编号:4260035。

电话:+44 370 879 3000。

网站:目录高可用性配置4目标读者4先决条件5 Rabbit MQ 集群5 SQL 高可用性组5负载均衡器6 Web 服务器6 Blue Prism 软件和脚本6基础设施示例7使用 HAProxy 的高可用性配置7使用 IIS ARR 和 HAProxy 的高可用性配置8使用应用程序网关的高可用性配置9 HAProxy 负载均衡器—配置示例10负载均衡器脚本示例 (HAProxy)10初始安装和配置13安装 Blue Prism Hub13安装 Blue Prism Interact13配置安装13脚本解决方案14脚本摘要14重要信息14 Functions.ps1 脚本15 Prepare.ps1 脚本16 Setup.ps1 脚本19测试您的高可用性环境21日志记录23高可用性配置高可用性通过使用多台服务器确保系统始终可用。

联鼎软件技术 LanderVault 集群模块 LanderCluster 6 产品技术手册

产品技术手册高可用产品技术白皮书LanderVault 集群模块LanderCluster 6Copyright 1999’-2008’ Lander Software Corporation. All rights reserved.本手册简明阐述了系统及方案基本特性与说明版权所有联鼎软件技术有限公司目录1集群(高可用)概述 (1)1.1高可用的基本概念 (1)1.1.1高可用技术中的几个术语 (1)1.1.2分析用户的可用性需求 (2)1.1.3选择一个解决方案 (2)1.2高可用是业务的需求 (2)1.2.1高可用是一种保障 (2)1.2.2高可用存在商机 (3)1.3高可用系统的衡量标准 (3)1.3.1可用性计算 (3)1.3.2期望运行时间 (3)1.3.3计算平均故障间隔时间 (4)1.4实现高可用的难点 (4)1.4.1高可用计算实现的难点 (4)1.4.2Duration of Outage (损耗时间) (4)1.4.3系统损耗的时间分析 (4)1.4.4造成非计划宕机的原因 (5)1.4.5非计划宕机的损害 (5)1.5高可用准备 (5)1.5.1定义高可用目标 (5)1.5.2建立相应的高可用物理环境 (6)1.5.3建立自动的处理流程 (6)1.5.4开发及测试环境 (6)1.5.5按照需求配置硬件 (6)1.5.6定义操作流程 (6)1.5.7灾难恢复准备 (6)1.5.8管理员的培训 (6)1.5.9记录每一个细节 (7)1.5.10高可用系统实现的要点 (7)1.5.11底层硬件的可靠性 (7)1.5.12软件的品质 (7)1.5.13集群技术服务 (7)1.6集群避免单点故障 (7)1.6.1单点故障 (8)1.6.2避免电源的单点故障 (8)1.6.3避免硬盘的单点故障 (8)1.6.4通过磁盘阵列(RAID)保护数据安全 (9)1.7认识SAN存储结构 (11)1.7.1存储区域网介绍 (11)1.7.2SAN的优势 (12)1.7.3SAN的适用环境 (13)1.7.4存储区域网(SAN)的特点 (13)1.7.5SAN存储系统五大组成 (13)1.8认识ISCSI存储结构 (13)1.8.3技术优势 (13)1.964位技术 (14)1.10虚拟化 (14)1.10.1纯软件虚拟化 (14)1.10.2CPU虚拟化技术 (15)1.10.3文件虚拟化 (15)1.10.4存储虚拟化 (15)1.10.5虚拟主机 (16)1.11刀片服务器 (16)1.12避免系统处理单元单点故障 (16)1.12.1单机高可用的实现 (16)1.12.2通过集群来避免单点故障 (16)1.13几种类型存储技术介绍 (17)1.13.1DAS-直接连接存储 (17)1.13.2NAS-网络连接存储 (17)1.13.3SAN-存储区域网络 (18)1.13.4SAS-串行SCSI技术 (18)2LanderCluster概述 (20)2.1LanderCluster的版本情况 (20)2.2LanderCluster的体系结构 (20)2.2.1执行树模型(Execute Tree Model) (20)2.2.2执行对象模型Execute Object Model (21)2.2.3监控对象模型Monitor Object Model (21)2.2.4事件对象模型Event Object Model (21)2.2.5集群原理模型Cluster Elements Model (21)2.2.6关键技术 (21)2.3LanderCluster集群系统工作原理 (22)2.4LanderCluster集群系统监控原理 (22)2.4.1网络状态监控 (22)2.4.2应用监控 (22)2.4.3集群软件运行状态监控 (23)2.4.4存储子系统监控 (23)2.5LanderCluster集群系统的特性 (23)2.5.1系统健康与可用性评价体系 (23)2.5.2前瞻预警体系 (23)2.5.3故障分级处理 (23)2.5.4深度应用侦测代理(User Application Agent) (24)2.5.5支持虚拟化环境 (24)2.5.6采用任务提交、确认机制 (24)2.5.7集群配置安装维护简单 (24)2.5.8管理员密码验证 (24)2.5.9集群软件自身监控功能 (24)2.5.10对应用程序的灵活监控功能 (24)2.5.11支持多台服务器集群方式 (25)2.5.14支持更多存储环境包括ISCSI (25)2.5.15支持多种应用系统 (25)2.5.16LanderCluster灵活性 (25)2.5.17中英文管理界面可根据需要选择 (25)2.5.18创新支持跨平台系统集群 (25)2.6LanderCluster版本比较 (26)3LanderCluster规划技术要点 (27)3.1LanderCluster硬件配置概述 (27)3.2集群设备选型要点 (27)3.3LanderCluster简单双机集群环境 (28)3.4LanderCluster复杂双机集群环境 (28)3.4.1对等双机(Active/Active) (29)3.4.2双机双柜 (29)3.4.3异地双机(容灾) (30)3.4.4纯软件双机 (30)3.5LanderCluster多节点集群环境 (30)3.5.1多节点- 多备一 (31)3.5.2多节点-多机互备 (31)4附录 (32)4.1运行LanderCluster的系统需求 (32)4.2典型解决方案 (32)1 集群(高可用)概述在学习使用LanderCluster集群软件包之前,必须对集群技术中的一些概念有所了解,这样才能帮助我们更好的掌握LanderCluster的原理、安装设置和管理。

Red Hat Enterprise Linux 7 高可用性附加组件参考指南说明书

Red Hat Enterprise Linux 7High Availability Add-On 参考配置和管理高可用性附加组件参考指南Last Updated: 2021-09-14Red Hat Enterprise Linux 7 High Availability Add-On 参考配置和管理高可用性附加组件参考指南Enter your first name here. Enter your surname here.Enter your organisation's name here. Enter your organisational division here. Enter your email address here.法律通告Copyright © 2021 | You need to change the HOLDER entity in the en-US/High_Availability_Add-On_Reference.ent file |.The text of and illustrations in this document are licensed by Red Hat under a Creative Commons Attribution–Share Alike 3.0 Unported license ("CC-BY-SA"). An explanation of CC-BY-SA is available at/licenses/by-sa/3.0/. In accordance with CC-BY-SA, if you distribute this document or an adaptation of it, you must provide the URL for the original version.Red Hat, as the licensor of this document, waives the right to enforce, and agrees not to assert, Section 4d of CC-BY-SA to the fullest extent permitted by applicable law.Red Hat, Red Hat Enterprise Linux, the Shadowman logo, the Red Hat logo, JBoss, OpenShift, Fedora, the Infinity logo, and RHCE are trademarks of Red Hat, Inc., registered in the United States and other countries.Linux ® is the registered trademark of Linus Torvalds in the United States and other countries. Java ® is a registered trademark of Oracle and/or its affiliates.XFS ® is a trademark of Silicon Graphics International Corp. or its subsidiaries in the United States and/or other countries.MySQL ® is a registered trademark of MySQL AB in the United States, the European Union and other countries.Node.js ® is an official trademark of Joyent. Red Hat is not formally related to or endorsed by the official Joyent Node.js open source or commercial project.The OpenStack ® Word Mark and OpenStack logo are either registered trademarks/service marks or trademarks/service marks of the OpenStack Foundation, in the United States and other countries and are used with the OpenStack Foundation's permission. We are not affiliated with, endorsed or sponsored by the OpenStack Foundation, or the OpenStack community.All other trademarks are the property of their respective owners.摘要红帽高可用性附加组件参考提供有关为红帽企业 Linux 7 安装、配置和管理红帽高可用性附加组件的参考信息。

高可用集群解决方案

高可用集群解决方案

《高可用集群解决方案》

在当今数字化时代,企业对于系统的稳定性和可用性要求越来越高。

为了保障业务的正常运行,高可用集群解决方案成为了企业的迫切需求。

高可用集群是一种通过将多台服务器进行集群化部署,实现故障转移和负载均衡的方式,以提高系统的稳定性和可用性。

高可用集群解决方案通常包括硬件和软件两个层面的技术。

在硬件方面,企业可以通过在多台服务器上部署相同的硬件设备,以实现冗余备份和故障转移。

同时,还可以借助负载均衡器来分担服务器的负载,提高系统的性能和稳定性。

在软件方面,高可用集群解决方案会使用一些特定的软件工具来实现故障检测、故障转移和数据同步等功能,从而保障整个系统的稳定性和可用性。

对于企业来说,选择合适的高可用集群解决方案非常重要。

首先,企业需要根据自身的业务需求和数据规模来选择适合的集群解决方案。

其次,企业还需考虑集群解决方案的成本和部署难度,以确保自身能够承受并维护这样的解决方案。

最后,企业还需考虑解决方案的可扩展性和未来的升级计划,以确保投资的长期有效性。

总的来说,高可用集群解决方案是企业保障系统稳定性和可用性的重要手段。

通过合理选择和部署适合自身业务需求的集群

解决方案,企业可以确保系统随时可用,从而提高业务的竞争力和用户体验。

VMware vSphere 5.1 高可用性 ---- 群集、HA、DRS、FT

VMware vSphere 5.1 高可用性在本节中主要讲的是集群的一些功能和配置,相比5.0的设置,没有太大的变化。

VMware vSphere为虚拟机提供虚拟化的基础架构,将现有的物理资源转化成虚拟资源,将物理资源分成若干资源,为每个虚拟机提供包括CPU、内存等虚拟资源。

要想很好地分配这些资源,就必须要使用资源池。

资源池是灵活管理资源的逻辑抽象。

资源池可以分组为层次结构,用于对可用的CPU 和内存资源按层次结构进行分区。

群集中的资源池比单个ESXi主机上的还要重要,因为在群集中创建资源之后,整个资源池管理的就是所有的ESXi主机资源了。

所管理的资源是所有ESXi主机上的CPU和内存的资源总和。

高可用性和双机热备是VMware vSphere 5.1最重要的一部分,高可用并不是vSphere独有的,企业使用高可用就是为了服务的连续性和数据的安全性,HA是以一群ESXi服务器为主的群集功能,主要是目的是当虚拟机运行的主机发生故障时能及时转移主机,避免长时间的停机。

而FT双机热备则是保证虚拟机最长时间不停机,将虚拟机以双机热备的方式同时在两台主机运行,大大增强了业务的可连续性。

本节中主要讲的是讲的一下内容:一、建立群集二、设置HA高可用性三、测试HA高可用性四、设置DRS五、建立FT双机热备无论是计划停机时间还是非计划停机时间,都会带来相当大的成本。

但是,用于确保更高级别可用性的传统解决方案都需要较大开销,并且难以实施和管理。

VMware 软件可为重要应用程序提供更高级别的可用性,并且操作更简单,成本更低。

使用vSphere,组织可以轻松提高为所有应用程序提供的基准级别,并且以更低成本和更简单的操作来实现更高级别的可用性。

使用vSphere,可以独立于硬件、操作系统和应用程序提供更高可用性,减少常见维护操作的计划停机时间,在出现故障时提供自动恢复。

vSphere 可以减少计划的停机时间,防止出现非计划停机,并迅速从断电中恢复。

FAS3200系列产品说明书

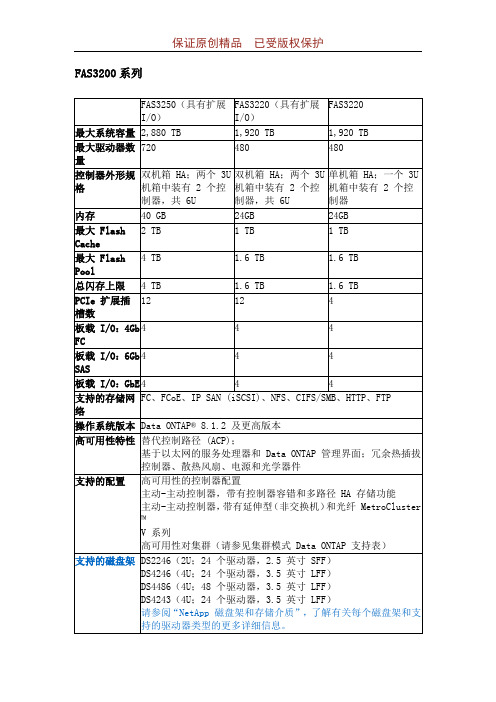

FAS3200系列特性FAS3250(具有扩展 I/O)FAS3220(具有扩展 I/O)FAS3220最大系统容量2,880TB 1,920TB 1,920TB最大驱动器数量720 480 480控制器外形规格双机箱 HA;在两个 3U机箱中有 2 个控制器,共 6U双机箱 HA;在两个 3U机箱中有 2 个控制器,共 6U单机箱 HA;在一个3U 机箱中有 2 个控制器内存40GB 24GB 24GB最大FlashCache2TB 1TB 1TB最大FlashPool4 TB 1.6 TB 1.6 TB总闪存量 4 TB 1.6 TB 1.6 TBPCIe 扩展插槽数12 12 4板载I/O:4GbFC4 4 4板载I/O:6GbSAS4 4 4板载I/O:GbE4 4 4支持的存储网络FC; FCoE; IP SAN (iSCSI); NFS; CIFS/SMB; HTTP; FTP操作系统版本Data ONTAP® 8.1.2 及更高版本FAS2200系列FAS2240-2FAS2240-4FAS2220单控制器双控制器单控制器双控制器单控制器双控制器最大原始容502 TB 502 TB 552 TB 552 TB 228 TB 228 TB功能 FAS2240-2 FAS2240-4 FAS2220最大系统容量502 TB 552 TB 228 TB最大驱动器数量144 144 60内存 12 GB 12 GB 12 GB控制器外形规格一个 2U 机箱中有 1 个或 2 个控制器一个 4U 机箱中有 1 个或 2 个控制器一个 2U 机箱中有 1 个或 2 个控制器最大FlashPoolGB GB GB板载I/O:GbE8 8 8板载I/O:SAS4 4 48 Gb光纤通道支持是1*是1*否10GbE支持是1*是1*是1,2支持的存储网络FC、IPSAN (iSCSI)、CIFS、NFSFC、IPSAN (iSCSI)、CIFS、NFSIPSAN (iSCSI)、CIFS、NFS操作系统版本Data ONTAP 8.1 或更高版本Data ONTAP 8.1.1 或更高版本软件NetApp FAS3200 系列包含的Data ONTAP Essentials:软件效率:FlexVol®、重复数据删除、压缩和精简配置可用性:多路径 I/O、MultiStore®、MetroCluster(仅限 7-模式环境)数据保护:RAID-DP®、Snapshot™、NearStore®和 Open SystemsSnapVault®性能:FlexShare®、FlexCache管理:OnCommand System Manager、OnCommand Unified Manager、Workflow Automation数据协议:系统附带您选定的一个 SAN 或 NAS 协议(iSCSI、FC、NFS、CIFS)。

ROSE高可用性软件销售手册

ROSE高可用性软件销售手册一.功能介绍ROSE是一个提供防止关键业务主机因不可避免的意外性或计划性宕机问题的高可用性软件。

ROSE软件同时安装在两台主机上,用于监视系统的状态、协调两台主机的工作和维护系统的可用性。

它能侦测应用级系统软件、硬件发生的故障,并及时的进行错误隔绝和恢复,以最低成本提供用户近乎不停顿的计算机作业环境。

用户为何需要我们的软件?⏹用户的服务器中运行着整个公司的重要信息。

⏹系统宕机是不可避免的,它将给用户的业务带来极大的损失。

⏹用户需要一个可靠的、易操作的、高可用的解决方案,将不可避免的宕机次数减少到最小。

⏹当一台服务器发生问题时,必须在最短时间内自动切换到备份服务器。

对用户来说,整个操作必须是无需人工干预的。

也就是说,ROSE软件可以实现:假设用户有两台服务器正在运行着某个关键性应用,当其中一台服务器发生故障时,另一台服务器则自动接管原先由故障服务器运行的服务。

二.特性与优势三.支持的平台SCO UnixwareSCO OpenserverWindows NT4.0Windows 2000LinuxSun Solaris四.支持的应用File sharingPrinter spoolerInternet server(WWW, FTP, etc.)RDBMS(Microsoft, Oracle, Sybase, Informix)Microsoft Exchange Server and Lotus Notes ServerNT service-based applicationsTCP/IP or computer name-based applications五.产品价格Product List List Price RMBROSE for WindowsNT ¥36000ROSE for Windows2000 ¥36000ROSE for SCO Openserver ¥36000ROSE for SCO Unixware ¥36000ROSE for Linux ¥36000ROSE for IBM EXP15/200 (SCO Open Server)¥45000六.应用案例七.常见问题1.ROSE高可用性软件有几种工作模式?I主从方式工作原理:主机工作,从机处于监控准备状况;当主机宕机时,从机接管主机的一切工作,待主机恢复正常后,按使用者的设定以自动或手动方式将服务切换回主机上运行。

使用Docker构建高可用的数据库集群指南

使用Docker构建高可用的数据库集群指南近年来,随着云计算和大数据的发展,建立高可用的数据库集群对于保证系统的稳定性和扩展性变得越来越重要。

Docker作为一种轻量级的容器化技术,为构建高可用的数据库集群提供了更加便捷和灵活的解决方案。

本文将介绍如何使用Docker来构建高可用的数据库集群,帮助读者更好地应对日益变化的业务需求。

第一步:选择适合的数据库在构建高可用的数据库集群之前,我们首先需要选择适合的数据库。

根据实际需求和业务规模,可以选择MySQL、Oracle、PostgreSQL等常见的关系型数据库,也可以选择MongoDB、Redis等非关系型数据库。

这里以MySQL为例,介绍如何使用Docker构建高可用的MySQL集群。

第二步:创建Docker镜像在使用Docker构建高可用的数据库集群之前,我们需要创建Docker镜像。

Docker镜像是Docker容器运行的基础,包含了操作系统、运行环境和应用程序等。

可以通过Dockerfile来定义镜像的内容和构建过程,也可以通过从Docker Hub下载现成的镜像。

第三步:配置数据库集群在配置数据库集群之前,我们需要确定集群的规模和拓扑结构。

根据业务需求和性能要求,可以选择主从复制、分片、水平扩展等不同的集群模式。

一般情况下,高可用的数据库集群至少包括一个主节点和一个备节点,以实现数据的冗余和故障转移。

在配置数据库集群时,需要注意以下几个方面:1. 主从复制:通过主从复制,可以实现数据的冗余和故障转移。

在MySQL中,可以通过配置binlog和relay log实现主从同步。

2. 节点角色切换:在高可用的数据库集群中,节点角色的切换十分重要。

当主节点出现故障时,需要将备节点切换为主节点,以确保数据的可用性。

可以使用工具如HAProxy等来实现节点角色的切换。

3. 监控和报警:在数据库集群运行过程中,需要及时监控节点的状态和性能指标,以便及时发现和解决问题。

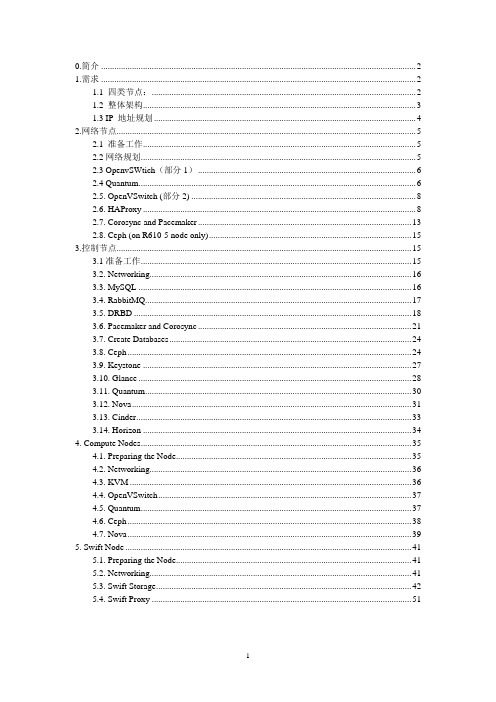

Openstack 高可用部署指导手册

0.简介 (2)1.需求 (2)1.1 四类节点: (2)1.2 整体架构 (3)1.3 IP 地址规划 (4)2.网络节点 (5)2.1 准备工作 (5)2.2网络规划 (5)2.3 OpenvSWtich(部分1) (6)2.4 Quantum (6)2.5. OpenVSwitch (部分2) (8)2.6. HAProxy (8)2.7. Corosync and Pacemaker (13)2.8. Ceph (on R610-5 node only) (15)3.控制节点 (15)3.1准备工作 (15)3.2. Networking (16)3.3. MySQL (16)3.4. RabbitMQ (17)3.5. DRBD (18)3.6. Pacemaker and Corosync (21)3.7. Create Databases (24)3.8. Ceph (24)3.9. Keystone (27)3.10. Glance (28)3.11. Quantum (30)3.12. Nova (31)3.13. Cinder (33)3.14. Horizon (34)4. Compute Nodes (35)4.1. Preparing the Node (35)4.2. Networking (36)4.3. KVM (36)4.4. OpenVSwitch (37)4.5. Quantum (37)4.6. Ceph (38)4.7. Nova (39)5. Swift Node (41)5.1. Preparing the Node (41)5.2. Networking (41)5.3. Swift Storage (42)5.4. Swift Proxy (51)0.简介本手册指导大家如何一步一步构建一套多节点的高可用性(High Availability)Openstack 云平台,该套平台同时利用Ceph作为Glance和Cinder的后端存储,Swift作为对象存储,Openvswitch作为Quantum 组件1.需求1.1 四类节点:Controller,Network,Compute and Swift1.2 整体架构1.3 IP 地址规划2.网络节点2.1 准备工作·安装Uubuntu 13.04·添加ceph节点条目到/etc/hosts文件10.30.30.3 R710-310.30.30.2 R710-210.30.30.5 R610-5`更新系统apt-get update -yapt-get upgrade -yapt-get dist-upgrade -y·安装ntp服务apt-get install -y ntp添加控制节点作为NTP服务器,然后重启服务echo "server 10.10.10.3" >> /etc/ntp.confecho "server 10.10.10.2" >> /etc/ntp.confservice ntp restart·安装其他服务apt-get install -y vlan bridge-utils·开启IP_Forwardingsed -i 's/#net.ipv4.ip_forward=1/net.ipv4.ip_forward=1/' /etc/sysctl.confsysctl -p2.2网络规划•编辑/etc/network/interfaces, 下面的示例是R610-5 节点, R610-4 节点根据实际作出相关修改. 同时R610-4 不需要配置eth3 storage IP ,因为其上并没有ceph组件运行auto eth0iface eth0 inet staticaddress 192.168.1.30netmask 255.255.255.0gateway 192.168.1.1dns-nameservers 8.8.8.8#Openstack managementauto eth1iface eth1 inet staticaddress 10.10.10.5netmask 255.255.255.0#VM trafficauto eth2iface eth2 inet staticaddress 10.20.20.5netmask 255.255.255.0#Storage network for cephauto eth3iface eth3 inet staticaddress 10.30.30.5netmask 255.255.255.0重启网络service networking restart2.3 OpenvSWtich(部分1)•安装openVSwitchapt-get install -y openvswitch-switch openvswitch-datapath-dkms•创建网桥#br-int will be used for VM integrationovs-vsctl add-br br-int#br-ex is used to make to VM accessible from the external networkovs-vsctl add-br br-ex#br-eth2 is used to establish VM internal trafficovs-vsctl add-br br-eth2ovs-vsctl add-port br-eth2 eth22.4 Quantum•安装Quantum openvswitch agent, l3 agent, dhcp agent and metadata-agent组件apt-get -y install quantum-plugin-openvswitch-agent quantum-dhcp-agent quantum-l3-agent quantum-metadata-agent•编辑/etc/quantum/quantum.conf[DEFAULT]auth_strategy = keystonerabbit_host = 10.10.10.101rabbit_password=yourpassword[keystone_authtoken]auth_host = 10.10.10.200auth_port = 35357auth_protocol = httpadmin_tenant_name = serviceadmin_user = quantumadmin_password = yourpasswordsigning_dir = /var/lib/quantum/keystone-signing•编辑/etc/quantum/api-paste.ini[filter:authtoken]paste.filter_factory = keystoneclient.middleware.auth_token:filter_factoryauth_host = 10.10.10.200auth_port = 35357auth_protocol = httpadmin_tenant_name = serviceadmin_user = quantumadmin_password = yourpassword•编辑the OVS plugin configuration file/etc/quantum/plugins/openvswitch/ovs_quantum_plugin.ini with:: [DATABASE]sql_connection=mysql://quantum:******************.10.100/quantum[OVS]tenant_network_type = vlannetwork_vlan_ranges = physnet1:1000:1100integration_bridge = br-intbridge_mappings = physnet1:br-eth2[SECURITYGROUP]firewall_driver = quantum.agent.linux.iptables_firewall.OVSHybridIptablesFirewallDriver •Update /etc/quantum/metadata_agent.ini with:[DEFAULT]auth_url = http://10.10.10.200:35357/v2.0auth_region = RegionOneadmin_tenant_name = serviceadmin_user = quantumadmin_password = yourpasswordnova_metadata_ip = 10.10.10.200nova_metadata_port = 8775metadata_proxy_shared_secret = demo•编辑/etc/sudoers to give quantum user full access like:Defaults:quantum !requirettyquantum ALL=NOPASSWD: ALL•重启所有服务cd /etc/init.d/; for i in $( ls quantum-* ); do sudo service $i restart; done2.5. OpenVSwitch (部分2)•编辑the /etc/network/interfaces to become like this:auto eth0iface eth0 inet manualup ifconfig $IFACE 0.0.0.0 upup ip link set $IFACE promisc ondown ip link set $IFACE promisc offdown ifconfig $IFACE down•添加eth0 到网桥br-ex#此步骤执行后,会失去internet连接,但不会影响openstack工作ovs-vsctl add-port br-ex eth0•添加external IP 到br-ex 使其恢复internet连接, 添加如下内容到/etc/network/interfaces auto br-exiface br-ex inet staticaddress 192.168.1.30netmask 255.255.255.0gateway 192.168.1.1dns-nameservers 8.8.8.8•重启网络以及quantum服务service networking restartcd /etc/init.d/; for i in $( ls quantum-* ); do sudo service $i restart; done2.6. HAProxy•安装包到两个网络节点apt-get install -y haproxy•Disable auto-start by 编辑ing /etc/default/haproxyENABLED=0•编辑两个节点的/etc/haproxy/haproxy.cfg配置文件,内容一致。

高可用集群软件的技术简介ppt

非计划停机因素

• 40% 硬件故障 • 31% 软件故障 • 20% 用户错误 • 9% 其他错误

9%

31%

20%

40%

-

关键业务停滞带来的潜在损失

• 客户流失

• 错过商业机会

• 丧失在行业内地位

企

• 生产能力下降

业

• 恢复系统的额外支出

核

• 罚款

心 竞

• 法律责任

争

• 名誉损害

力

• 生命危险

该部署方式有效的优化了系统结构同时使整个集群中应用环境达到高可clientactiveactiveserverlanderclusterlanderclusteractiveactiveserveractiveactiveserverfcswich侦测到server1故障发布接管命令package用户透过应用服务器访问数据1111server发生故障应用停止用户无法正常访问2222landercluster侦测到server故障进入接管状态3333landercluster接管packagr1完成任务接管4444用户通过landercluster再次顺利访问数据同时landercluster将通过各种手段通知管理员5555每个package包含ip地址系统服务系统进程用户应用package36多节点多机互备这个方式中多个生产服务器工作在一个集群中通过合理定义备援规则使环境中服务器相互备援任何一个任务停止工作都将由其它服务器接管任务是一种设备利用率最佳的部署方式

-

软件环境

操作系统

根据业务系统所选择的操作系统,在实现HA系统时,要求两 个节点的操作系统版本一致。并根据数据库系统及其HA系统的 要求,安装相应的操作系统补丁程序,并根据数据库要求调整 系统参数

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

深度高可用集群软件产品手册版本1.0文档编号密级适用范围制定审核发布日期更新日期1.1.总体实现方案 (1)1.1.1.适用场景 (1)1.1.2.方案概述 (1)1.1.3.方案设计 (2)1.2.产品功能说明 (4)1.2.1.双机热备功能 (4)1.2.2.多机集群功能 (5)1.2.3.多机双柜功能 (6)1.3.产品性能说明 (7)1.3.1.双机热备性能指标 (7)1.3.2.多机集群性能指标 (9)1.3.3.多机双柜性能指标 (11)1.1.总体实现方案1.1.1.适用场景在生产环境中,当一台业务服务器发生故障时,能通过各种策略确保及时切换另一台服务器提供相应的业务访问,从而确保客户业务访问的连续性和稳定性。

客户对高可用集群的基本需求包括:⏹业务系统的运行可靠性要求高,需要尽量避免业务中断;⏹业务系统对数据的可靠性、完整性要求高,需要进行实时备份;⏹针对多应用系统,要求业务服务器运行多项应用系统。

高可用集群应用通过在服务器设备之间连接“心跳线”的冗余机制,实时监视彼此的运行状态;而数据被存放于共享存储设备上。

采用心跳技术,确保在网络故障时对数据的全面保护。

当工作主机发生故障,备机将及时侦测到故障信息并接管主机上运行的业务。

1.1.2.方案概述深度高可用集群应用解决方案是深度科技开发的智能、多层次高可用软件产品。

基于深度服务器的深度高可用集群应用方案,进一步提升了软硬件系统及应用的稳定性和可靠性,更有效的保障虚拟化服务与数据备份安全可靠,支持双机互备、多机保护,磁盘心跳、智能切换保护等功能。

针对不同客户需求和应用场景,深度高可用集群应用方案支持多种部署方式,包括:⏹双机热备⏹双机互备⏹级联等多种模式。

1.1.3.方案设计深度高可用集群应用解决方案是深度科技开发的智能、多层次高可用软件产品。

基于深度服务器的深度高可用集群应用方案,进一步提升了软硬件系统及应用的稳定性和可靠性,更有效的保障虚拟化服务与数据备份安全可靠,支持双机互备、多机保护,磁盘心跳、智能切换保护等功能。

针对不同客户需求和应用场景,深度高可用集群应用方案支持多种部署方式,包括:双机热备、双机互备、级联等多种模式。

1.双机热备:在生产环境中,由一台服务器运行业务(高可用主机),同时,在另一台服务器中部署与生产环境完全一致的业务系统,作为高可用备机。

当生产环境出现故障,业务将被实时切换至高可用备机,从而确保其运行的连续性和稳定性。

系统部署如下图所示:磁盘心跳线磁盘心跳线2.双机互备:双机互备是指在生产环境中,两台服务器分别运行不同的应用系统,并互为备份;当某一应用发生故障时,它将被切换至正常工作的服务器上;同时,接管该应用的服务器仍保持原有业务不受影响地正常运行。

系统部署图如下:磁盘心跳线磁盘心跳线3.级联模式:级联模式适用于多系统集群环境下的多机互备方案,其中,集群的任意一台服务器设备既作为生产环境中提供应用服务的高可用主机,同时也作为其他某一台服务器设备上所运行应用的高可用备机;级联模式为双机互备的多级模式。

系统部署图如下:网络心跳线应用1运行应用n等待应用2运行应用1等待应用n运行应用n-1等待1.2.产品功能说明1.2.1.双机热备功能Deepin HA是一套解决服务器单点故障,为企业提供业务连续性,解决服务器宕机问题的高可用软件。

Deepin HA软件同时安装在两台主机上,用于监视协调两台主机的工作,可以自动检测出故障主机,准确、快速地将原主机的应用系统切换到另一台主机上继续运行,及时地进行错误隔绝、恢复,以最低成本实现用户几乎不停顿的业务应用。

使用Deepin HA双机热备软件,部署在两台服务器中,两两之间通过心跳连接(硬件连接或软件连接),当服务器出现宕机情况是能够迅速将主营服务器上的应用和业务切换到备机上,解决服务器单点故障问题,保证企业业务不间断运行,实现了业务的连续性。

部署了Deepin HA双机热备软件,任何导致系统宕机或服务中断的故障,都会自动触发Deepin HA软件流程来进行错误判定、故障隔离,并通过联机恢复来继续执行中断的服务。

Deepin HA全面的监测功能、快速的切换功能及基于驱动层的锁卷功能将为用户提供更为安全、可靠的高可用解决方案。

Heartbeat Array ActiveStandbyI P SAN存储阵列1.2.2.多机集群功能Deepin Cluster多节点集群产品,具有稳定可靠、易于管理、集群工作方式灵活多样、节点和任务伸缩性强、保护用户投资、整合优化系统环境的功能和特点,能支持不超过32个节点的复杂应用集群环境。

Deepin Cluster是深度科技基于Deepin HA技术升级衍生出来的一款多机集群软件,对于多节点高可用,可以理解为多机互备,多个服务器连接在一个共享存储设备上,同时运行多个不同应用,在其中任意服务器出现故障时,其它服务器根据备援策略进行接管服务,保证整个集群中的服务都能高可用。

不仅支持传统主从和主主,Cluster还可支持一对多、多对多、多机互备等多种集群备份。

1.2.3.多机双柜功能为了解决共享磁盘模式的单点数据故障问题,以及纯软件模式的速度慢、数据安全性低、存储空间小等问题,我们推出双机双柜高可用软件。

如下图,采用完全独立的两套磁盘阵列实时存储双份数据,解决了整个系统的单点数据故障问题,把数据和服务器也进行了分离,这样数据存储的速度比传统方式快很多.,保证了核心应用系统7*24*365不间断运行,确保核心信息系统访问的不间断运行及在线数据的安全性。

1.3.产品性能说明1.3.1.双机热备性能指标⏹该方案运行稳定,可以做到对故障服务器的准确切换,且保证被备机接管的任务能够正常、快速的运行。

⏹该方案支持双节点到多节点的平滑扩展,方便整合现有资源。

⏹切换速度快,特有的切换技术设计能够在5秒钟内对故障服务器进行切换。

⏹该方案对服务器的监测和故障诊断全面、精确,可以对用户的网络资源、本地资源、应用程序、数据库、操作系统、第三方程序等多个方面进行检测。

⏹该方案能够对软件的操作权限设置口令保护,服务器管理,机房管理人员可根据此权限设定管理流程及策略,避免他人的误操作。

⏹该方案系统的运行对于服务器本身的性能影响极小,不会妨碍服务器业务的正常运行。

⏹全方位检测:对用户的网络资源、应用程序、数据库、操作系统、第三方程序进行检测。

⏹单资源多进程检测:创建一个服务来同时监控多个进程。

⏹本地资源监控:当本地资源出现故障可以恢复应用程序或对服务器进行重新启动。

⏹冗余心跳:支持TCP/IP、RS232通讯协议。

⏹用户计划性切换(手动切换)和故障自动切换功能。

⏹透明切换功能:用户无需在客户端做任何改动便可以完成主备机切换。

⏹快速切换功能:切换的时间小于5秒。

⏹支持中英文版界面切换功能。

⏹支持第三方应用功能:为用户的第三方应用程序提供接口,并可实现第三方应用程序热备。

⏹锁卷功能:从驱动层面进行数据保护,相比其他软件从软件层面的保护更安全、稳定。

⏹用户共享文件的权限保护功能:当在主机上设置了共享权限,切换到备机时,权限依然存在。

1.3.2.多机集群性能指标⏹支持多种群集工作模式不仅支持传统的单活(Active/Standby)、双活(Active/Active),还支持N和N+1多节点集群备份。

目前Deepin Cluster最多支持32个节点的群集工作模式。

⏹全面支持虚拟化支持虚拟化存储环境,支持虚拟化操作系统环境VMware,支持虚拟环境与物理环境之间以及虚拟化系统)之间的自由切换。

⏹配有可扩展平台多机集群支持的模式1-N配置这个配置方式是一个标准的多机配置方案。

在这个cluster中,每台服务器都能运行客户的应用服务,平时仅由主服务器提供应用服务,其余服务器都是备用服务器。

一旦主服务器发生故障,cluster依照切换策略,会把任务切换到顺位的备份服务器中,如果顺位服务器也发生故障,应用服务会继续按照结点优先级切换到下一台,直到服务能够接管。

这种配置方式一般用于那些要保证应用服务100%能够24小时在线的客户环境。

N-1配置这个配置方式是所有的服务器都在一个cluster中,其中一个服务器作为cluster中其它服务的备份服务器,一旦某个主服务器系统出现故障,任务会按照策略把该服务器的任务切换到该备份服务器。

某种意义而言,其为双机系统的扩展版本,但这种体系结构配置对客户有多个服务的环境是非常优化的系统配置,同时能够让整个集群集中管理并且能够达到高可用。

M-N配置这个方式中多个生产服务器工作在一个集群中,通过合理定义备援策略,服务器相互备援,任何一个任务停止工作都将由其它服务器接管任务,是一种设备利用率最佳的部署方式。

该部署方式同样有效的优化了系统结构,需要注意的是在定义备援策略时,仔细分析各服务器处理能力、任务的兼容性问题。

在M-N方式中当主节点发生故障时,允许多个备份节点按照一定的优先级次序恢复一个资源组。

对于在一对节点上的资源恢复,如果节点A发生故障了,资源将会切换到节点B上;如果节点B再发生故障而节点A仍然不可用,资源将会失效切换到节点C上。

多个备份节点被指定一个优先级。

在上面的例子中,节点A有最高的优先级,节点B有第二优先级,而节点C有最低优先级。

Deepin Cluster按优先级次序测验节点来决定在故障切换时哪一个服务器将进行工作。

1.3.3.多机双柜性能指标避免存储单点故障⏹使用简易整个设置过程可以通过一个简单设置过程实现整个集群的配置,提示清晰明了,监控界面直观,日志强大完备。

电脑管理人员可以在15分钟内学会设置、使用该软件,在配置集群过程中,不需要机器重新启动,就可以运行集群环境。

⏹相互监控采用严格的检测方式,每个节点将自身的状态信息如网络、硬件以及软件等信息传递到对方节点中,使集群在任何时候均知道对方运行的状态。

当故障发生时可以进行故障快速处理。

⏹灵活配置以配置成多种工作方式:主从方式、主主模式、N+1模式、M+N模式;并且可以在后续多节点版本上,平滑过渡到多节点集群环境。

同时灵活的进程监控机制,监控的进程可以任意定制。

⏹远程管理功能支持远程管理方式,其工作方式是后台运行集群管理程序,而管理、设置功能完全可以在网络上的任何一台工作站上实现(当然,管理功能也可以在服务器端实现)。

这样使得管理员不必经常跑到机房里面察看集群状态,而只要在自己位置上就可以实现管理;同时,在环境中有多个集群环境时,就可以通过登陆到不同的集群上,实现集中的远程管理。

⏹虚拟化远程镜像⏹块级实时镜像采用块级实时镜像,即主服务器上的一个写操作必须在两台服务器上都写入成功后再进行下一个写操作,从而保证任何时候两台服务器的数据完全一致。

⏹镜像效率高采用块级实时镜像,写操作时,只需要同时往远程磁盘写一个I/O操作;避免了基于文件系统镜像必须在本地和远程分别进行打开、读写、修改属性、关闭等需要多个I/O操,能有效地防止基于文件系统镜像在大量小文件时,读写效率极差的问题。