基于3D 体感技术的动态手势识别

手势识别技术

远程医疗:医生通过手势识别技术 进行远程诊断和治疗。

手术辅助:医生通过手势识别技术 进行手术辅助,提高手术精度和效 率。

添加标题

添加标题

添加标题

添加标题

康复训练:患者通过手势识别技术 进行康复训练,提高手部灵活性和 力量。

医疗影像分析:医生通过手势识别 技术对医疗影像进行分析,辅助疾 病诊断和治疗。

04

更高的准确性和灵敏度

更广泛的应用领域

更多的交互方式

更强的隐私保护

医疗保健:用于诊断和监测病情,如手势辅助沟通、手部运动监测等。 娱乐产业:实现更真实的虚拟现实和增强现实体验,如游戏操控、手势识别互动等。 智能家居:控制智能家居设备,如灯光、空调等,提高生活便利性。 教育领域:辅助特殊教育和学习障碍人士的学习,如手势辅助沟通、手势辅助学习等。

汇报人:

汇报人:

01

02

03

04

05

01

手势识别技术 是指通过计算 机视觉技术对 手势进行自动

识别

手势识别技术 可以应用于人 机交互、智能 家居、虚拟现

实等领域

手势识别技术 主要分为基于 图像和基于深 度学习两种方

法

基于图像的手 势识别技术主 要通过对手势 图像进行特征 提取和比对实

现识别

基于深度学习 的方法则通过 训练大量神经 网络模型进行

定期更新软件:定 期更新手势识别技 术的软件和系统, 以获得更好的使用 体验和安全性。

建立自己的手势识别技术标准。

加强与科研机构合作,不断更新和 优化技术。

添加标题

添加标题Biblioteka 添加标题添加标题结合自身业务特点,开发具有特色 的手势识别应用。

基于Leap Motion和支持向量机的手势识别

2)卡}I对坐怀信息的选取方 法 :首先获取 手掌心 和各 个

,

关 点的 :维坐标点数据 ,然后求 出 l5个关节点的三维坐

标数据相对于掌心 :三维坐标数据的坐标值

,●f 耪 ,

图 3 手 指 关节 点对 应 位 置

图 4 两 向量 之 间所 成 角度

2.2.3 炎 点角度 和相对坐标求取

data,establish gesture recognition mode1.After normalization of feature data,support vector machine(SVM )

classif ier is used for training,modeling and classification,and gesture recognition is realized.The experim ental results show that the method which uses angle data and coordinate data as gesture feature is feasible,the average recognition rate is respectively 96.6% and 91.8% .It can be concluded that using angle data as feature value has higher accuracy and robustness,and it can avoid the limitation of a simple eigenvalue,it has strong convincing.

随着传感技术 的发 展 以及 应用 的普及 ,深度 摄像 头引 起 了越 来 越 多人 的 注意 ,同时 各类 3D应用 也 层 出不 穷 。 尽管微软 Kinect价廉且普 及广 ,但其对人 体手部信 息 的识 别和处理复杂 ,必须经过繁杂 的图像处理等识别过程 ,难 以 实现快速 的估计 手 部姿 态 J。而其 他更 高性 能 的深 度摄 像头价格 昂贵 ,难 以普 及 。不 同于 Kinect对视 野范 围 内追 踪到物体 的整体框架描 述 ,Leap Motion仅针对 手部 信息 的 追踪 描述 ,通过对 手部信息包括骨骼点 、关节点等的精细化 描述 ,并 利 用 其 实 现对 手 势 的 特 征 提 取 和 准 确 识 别 。

基于Leap Motion手语语音转换的设计与实现

基于Leap Motion手语语音转换的设计与实现作者:姜檬郭仁春李俊龙王志淳来源:《无线互联科技》2020年第07期摘; ;要:文章介绍了基于Leap Motion手语语音转换的原理以及在实际中如何实现应用,其能够将手语手势翻译成所需语言,并且以语音的形式传递消息,实现为聋哑人“发声”的目的。

Leap Motion手语语音转换的硬件部分采用Leap Motion体感控制器,能够实时采集人手指的坐标、加速度、方向等动态手势的运动信息。

软件采用Unity 3D三维引擎,提供了开发手势识别的SDK,并给出了一些基本手的模型,在Unity 3D中完成由手势到文字,再到语音的转换。

关键词:动态手势识别;厉动;Unity 3D1; ; 手势识别手势识别是手语语音转换的首要步骤,包括手势的采集与手势识别。

手势的釆集广泛使用的方法有数据手套[1]、专业的视频釆集摄像机等[2]。

而手势识别的研究方向有两个:一个是静态手势识别,另一个是动态手势识别。

静态手势识别始于20世纪初,主要利用获取到的单个时间点的手势图像中手的形状、手指的姿态等信息进行手势表达含义的识别[3]。

相比于静态手势识别,动态手势识别要稍晚一些,需要对连续一段时间的手势图像信息进行图像处理,通过获取处理后的连续时间内手、手指的位置、速度等数据信息来识别手势表达的意义[4]。

本文提出的基于Leap Motion的手语语音转换是基于视觉(图像)的手势识别系统[5],采用的手势识别系统是Leap Motion体感控制器,是支持C#语言的三维引擎,且提供了手势开发的软件开发工具包(Software Development Kit,SDK),为手势定义成文字提供了便利条件。

本文是使用C#语言对手语语音转换进行开发的。

2; ; Leap Motion手语语音转换的原理2.1; Leap Motion功能介绍本文采用的Leap Motion是Leap公司最新研发的体感控制器,是一款微米级3D手动交互设备,十分小巧且应用广泛。

基于单片机的手势检测识别系统设计与实现

一、概述近年来,随着科技的不断进步和人们对智能化设备的需求日益增长,手势检测识别技术越来越受到人们的关注。

通过手势检测识别技术,人们可以方便地与电子设备进行交互,实现更加智能、便捷的操作体验。

设计并实现一套基于单片机的手势检测识别系统具有重要的意义。

二、系统设计1. 系统需求分析根据市场调研和用户需求,本手势检测识别系统应具备以下功能:① 能够准确快速地识别用户手势;② 具备一定的环境适应能力,能够在不同光线和背景条件下进行有效的识别;③ 具备一定的用户交互性,能够实现与其他设备的连接;④ 能够在一定程度上对用户手势进行记录和分析,以优化用户体验。

2. 系统总体架构设计本系统采用基于单片机的方案,以STM32系列单片机为主控芯片,搭建一套完整的手势检测识别系统。

系统总体架构主要包括图像采集模块、图像处理模块、手势识别模块和用户交互模块等部分。

3. 系统具体设计方案① 图像采集模块:本系统采用摄像头作为图像采集设备,通过摄像头捕获用户手势图像,然后传输给单片机进行处理。

② 图像处理模块:采用图像处理算法对采集到的图像进行预处理,包括去噪、边缘检测、二值化等步骤,以提高后续的手势识别效果。

③ 手势识别模块:基于预处理后的图像,采用机器学习或深度学习算法进行手势识别,将用户的手势信息转化为电信号,并传输给单片机。

④ 用户交互模块:通过单片机实现与其他设备的连接,将用户手势转化为相应的操作指令,实现用户与设备的交互。

⑤ 数据存储和分析模块:对用户手势进行记录和分析,提取用户习惯和行为特征,以优化用户体验。

三、系统实现1. 硬件设计系统硬件设计主要包括单片机模块、摄像头模块、LED显示模块等,其中单片机模块作为系统的主控制部分,负责整个系统的数据处理和控制。

2. 软件设计系统软件设计包括图像处理算法的实现、手势识别算法的导入、用户交互界面的设计等。

3. 系统集成与调试将硬件及软件部分进行集成,并进行整体功能测试和性能调试,确定系统的稳定性和准确性。

手势识别与姿态估计算法研究

手势识别与姿态估计算法研究摘要:手势识别与姿态估计是计算机视觉领域中的热门研究方向之一。

随着智能设备的普及和人机交互技术的发展,手势识别和姿态估计的应用越来越广泛。

本文将介绍手势识别与姿态估计算法的研究进展,包括传统方法和深度学习方法,并讨论其在图像识别、虚拟现实、智能交通等领域的应用。

1. 引言手势识别与姿态估计是研究人类动作行为和空间定位的重要领域之一。

通过利用计算机视觉技术,可以将人的手势或身体姿态转化为计算机能够理解和处理的信息,实现与计算机的自然交互。

手势识别与姿态估计在图像识别、虚拟现实、智能交通等领域具有广泛的应用前景。

2. 传统方法传统的手势识别与姿态估计方法主要基于计算机视觉中的特征提取和分类算法。

传统方法主要包括以下几种技术:形状分析、运动分析、模型匹配和机器学习。

形状分析是指通过对手势或姿态形状的描述和分析来进行识别和估计。

运动分析是指通过分析手势或姿态的运动模式和轨迹来进行识别和估计。

模型匹配是指通过将手势或姿态与已有的模型进行匹配来进行识别和估计。

机器学习是指通过构建分类器来自动学习和识别手势或姿态。

3. 深度学习方法深度学习是近年来兴起的一种机器学习方法,具有较强的数据驱动能力和自动特征学习能力。

深度学习在手势识别与姿态估计领域取得了显著的进展。

深度学习方法主要包括基于卷积神经网络(CNN)的方法和基于循环神经网络(RNN)的方法。

CNN方法可以通过学习空间特征和纹理特征来实现手势识别和姿态估计。

RNN方法可以通过学习时间序列特征和运动模式来实现手势识别和姿态估计。

4. 应用领域手势识别与姿态估计在多个领域都有广泛的应用。

在图像识别领域,手势识别和姿态估计可以应用于人脸识别、物体识别等任务,提高识别的准确性和稳定性。

在虚拟现实领域,手势识别和姿态估计可以用于手部交互、虚拟角色动作捕捉等场景,增强用户与虚拟环境的互动体验。

在智能交通领域,手势识别和姿态估计可以用于驾驶员行为识别、手势交通信号灯控制等应用,提高交通安全性和驾驶体验。

基于3D 体感技术的动态手势识别

第27卷第4期2012年8月光电技术应用ELECTRO-OPTIC TECHNOLOGY APPLICATIONVol.27,No.4August ,2012随着机器智能领域的迅猛发展,手作为人身体上最灵活的一个部位及人机交互的一个媒介,得到越来越多的应用。

因此基于手势识别的各种应用也是层出不穷。

手势是一种自然而直观的人际交流模式。

手势识别也理所当然地成为了实现新一代人机交互不可缺少的一项关键技术。

然而,由于手势本身具有的多样性(包括肤色、形态的差异性)、多义性(不同手势具有不同的意义)、以及时间和空间上的差异性(会受到光照等因素的影响)等特点,加之人手是复杂变形体及视觉本身的不适定性,因此基于视觉的手势识别是一个极富挑战性并具有很大应用空间的研究方向[1]。

1手势识别技术的发展手势识别分为两种,一种是静态的手势识别,即在摄像头下检测到某个手势时就给出命令。

另一种是动态手势识别,即能够识别手做的一些动作。

随着3D 体感技术的出现,手势识别进入一个全新的领域。

1.1静态手势识别静态手势识别的常用方法主要有:基于模版匹配的,用边缘特征像素点作为识别特征,并利用Hausdorff 距离模板匹配完成静态手势识别[2];基于SVM 支持向量机,通过皮肤颜色模型进行手势分割,并用傅里叶描述子描述轮廓,采用针对小样本特别有效且范化误差有界的最小二乘支持向量机(LS -SVM )作为分类器进行手势识别[3]以及集合模版匹配和机器学习理论的手势识别方法[4]等。

但由于静态手势识别技术应用的局限性较大,不够灵活,使用人数在减少。

收稿日期:2012-06-24作者简介:淦创(1990-),男,辽宁锦州人,大学本科,研究方向为计算机图像处理.·信号与信息处理·基于3D 体感技术的动态手势识别淦创(北京航空航天大学,北京100191)摘要:提出了一种基于3D 体感机Kinect 的图像处理手势识别算法,通过深度图像和骨骼图像的方法实现动态手势识别。

三种简单手势识别

三、手势辨认

3.1、设计思绪

常用旳静态手势特征有轮廓、位置、面积、分 布等。

本文主要利用对手势面积大小旳辨认来到达手 势辨认旳目旳,这里直接比较手型面积有交大困难。 在手势旳定位与分割时,产生了手势区域旳方框, 我们利用这个面积来替代手势旳面积,具有很好旳 效果。当用摄像头采集到手势时,先将采集到旳手 势与采集到旳手势库进行比较,比较得出与摄像头 所得手势较吻合旳旳手势,在屏幕上显示有关手势 旳名称。

简朴手势辨认

一、背景

伴随计算机旳发展,人机交互技术由老式旳鼠标键盘 时代发展到了以语音输入、动作辨认等技术为代表旳自然交 互时代n1。尤其是视觉计算技术旳发展,使计算机取得了初 步视觉感知旳能力,能“看懂”顾客旳动作。手势辨认作为 一种直观自然旳输入方式,把人们从老式接触性旳输入装置 中解放出来,能够以一种更自然旳方式与计算机交互,使计 算机界面变得愈加易‘引。

2.3、手势建模

在手势辨认框架中,手势模型是一种最 基本旳部分。根据不同旳应用背景,手势辨 认采用旳模型会有不同,而对于不同旳手势 模型,采用旳手势检测与跟踪算法、特征提 取、辨认技术也会有差别。手势建模主要分 为基于表观旳手势模型与基于三维旳手势模 型。

2.4、手势特征提取

手势特征旳提取是与手势模型亲密有关旳,不 同旳手势模型会有不同有手势特征。例如基于模型 旳手势模型有手旳每个关节旳状态特征,基于表观 模型旳手势特征是轮廓特征、位置特征等。静态手 势辨认和动态于势辨认旳特征也不同,静态手势旳 特征只是描述旳手旳静态信息,例如轮廓、面积等。 动态手势特征是连续旳静态特征序列。

AR中的手势识别与交互设计

AR(增强现实)是一种将虚拟世界与现实世界相结合的技术,通过手势识别与交互设计,可以实现更加自然、直观的用户交互。

在AR中,手势识别与交互设计是至关重要的环节,它能够为用户提供更加丰富、有趣的体验。

一、手势识别手势识别是AR中的一项关键技术,它能够识别用户的手势并与之互动。

在AR中,手势识别主要包括以下几种类型:1. 手势跟踪:通过摄像头或传感器对用户的手部动作进行跟踪,识别出手掌、手指等部位的形状和动作。

2. 手势识别:利用计算机视觉技术,识别出用户手势的含义,例如挥手、握拳、滑动等。

3. 手势控制:通过手势实现对虚拟物体的操控,例如拖动、旋转、缩放等。

手势识别在AR中的应用非常广泛,例如在游戏、教育、医疗等领域。

通过手势识别,用户可以更加自然地与虚拟物体进行交互,从而获得更加沉浸式的体验。

二、交互设计在AR中,交互设计是指如何将虚拟物体与现实世界相结合,为用户提供更加自然、直观的交互方式。

以下是交互设计的一些关键要素:1. 虚拟物体与现实世界的融合:将虚拟物体放置在现实环境中,使其看起来自然、真实。

2. 交互方式的设计:根据不同的应用场景和用户需求,设计不同的交互方式,例如触摸、滑动、拖动等。

3. 交互反馈:为用户提供及时的反馈,例如虚拟物体位置的改变、交互效果的呈现等。

通过合理的交互设计,用户可以更加轻松地与虚拟物体进行互动,从而获得更加流畅、自然的体验。

三、应用场景手势识别与交互设计在许多领域都有应用,以下是一些常见的应用场景:1. 游戏娱乐:在游戏中利用手势识别与交互设计,可以为用户提供更加丰富的游戏体验。

例如,玩家可以通过手势操控虚拟角色、触发特殊技能等。

2. 教育学习:在教育领域中,利用AR技术可以实现更加直观、生动的学习体验。

通过手势识别与交互设计,学生可以更加轻松地理解抽象的概念和知识。

3. 工业应用:在工业领域中,AR可以用于指导工人进行操作、培训新员工等。

通过手势识别与交互设计,可以简化操作流程、提高工作效率。

手势识别技术原理及解决方案

手势识别对于我们来说并不陌生,手势识别技术很早就有,目前也在逐渐成熟,现在大部分消费类应用都在试图增加这一识别功能,无论是智能家居,智能可穿戴以及VR 等应用领域,增加了手势识别控制功能,必能成为该应用产品的一大卖点。

手势识别可以带来很多的好处,功能炫酷,操作方便,在很多应用场合都起到了良好的助力功能。

手势识别技术的发展说起手势识别技术的发展,可以粗略分为两个阶段:二维手势识别以及三维手势识别。

早期的手势识别识别是基于二维彩色图像的识别技术,所谓的二维彩色图像是指通过普通摄像头拍出场景后,得到二维的静态图像,然后再通过计算机图形算法进行图像中内容的识别。

二维的手型识别的只能识别出几个静态的手势动作,而且这些动作必须要提前进行预设好。

相比较二维手势识别,三维手势识别增加了一个Z轴的信息,它可以识别各种手型、手势和动作。

三维手势识别也是现在手势识别发展的主要方向。

不过这种包含一定深度信息的手势识别,需要特别的硬件来实现。

常见的有通过传感器和光学摄像头来完成。

手势识别的关键技术手势识别中最关键的包括对手势动作的跟踪以及后续的计算机数据处理。

关于手势动作捕捉主要是通过光学和传感器两种方式来实现。

手势识别推测的算法,包括模板匹配技术(二维手势识别技术使用的)、通过统计样本特征以及深度学习神经网络技术。

根据硬件实现方式的不同,目前行业内所采用的手势识别大约有三种:1、结构光(Structure Light),通过激光的折射以及算法计算出物体的位置和深度信息,进而复原整个三维空间。

结构光的代表产品有微软的Kinect一代。

不过由于以来折射光的落点位移来计算位置,这种技术不能计算出精确的深度信息,对识别的距离也有严格的要求。

2、光飞时间(TIme of Flight),加载一个发光元件,通过CMOS传感器来捕捉计算光子的飞行时间,根据光子飞行时间推算出光子飞行的距离,也就得到了物体的深度信息。

代表作品为Intel带手势识别功能的三维摄像头。

基于LeapMotion的动态手势识别研究

基于LeapMotion的动态手势识别研究摘要:随着科技的发展、时代的进步,手势识别技术已经由理论阶段慢慢转变成产品落地阶段。

但之前普遍研究都采用普通摄像头来获取手势手部特征与运动轨迹特征而无法获取深度三维特征,因此本文采用LeapMotion深度相机进行动态手势识别,通过使用LeapMotion采集动态手语数据并使用HMM模型完成动态手势识别判定。

关键词:人机交互;手势识别;LeapMotion;HMM;1引言近些年,人机交互正在飞速发展,已从键鼠输入交互发展到更为自然的手势交互。

其中基于视觉的手势识别技术更是被广泛应用。

在基于视觉的手势识别领域中,深度相机广受研究者喜爱[1]。

因为它比普通摄像头抗干扰能力强、拥有更高质量的图像分割技术、能提供深度三维特征信息,为后续的动态手势识别提供有效的数据支撑。

2LeapMotion2.1LeapMotion概述LeapMotion是体感传感器公司Leap研发的基于视觉的体感传感器。

它支持PC端和Mac端,用户使用时,挥动手指就可以实现PPT翻页、文章浏览、音乐播放与暂停等功能,也可以在3D空间拼接和拆分模型,还可以进行绘画与书写等等[2]。

它使用了红外摄像技术,它拥有150度超广视野,能有效检测设备上方0.03米至0.6米,可同时追踪10个手指,精度高达0.01毫米,实时捕捉每秒超200帧数据[3]。

它还提供了包含Python、Java等多种开发语言的API接口,方便用户进行二次开发与设计。

2.2LeapMotion设备介绍LeapMotion传感器整体采用了右手直角坐标系。

其中,原点设立于设备的上表面正中心、X轴与设备的长边平行,Z轴与设备的短边平行。

Y轴则垂直于设备的正表面。

LeapMotion一共拥有两个高帧率的广角镜头和四个红外LED。

表面的滤光层对进出光波进行了过滤,只允许红外光波进出,实现了初步的数据处理,降低后期模型运算复杂度;再通过双目广角摄像头捕捉手部关键点三维位置信息,最后建立手部立体模型;3动态手势数据的采集手势追踪的实时性和准确性是动态手势识别中的重点。

云触——基于三维图像的远距离手势控制装置

云触——基于三维图像的远距离手势控制装置赵航;孙毅;李纪伟;孙盛阳【摘要】作品针对目前常用的机械臂控制方式存在灵活性差、精度低、灵敏度低、操作复杂等缺点设计了基于手势控制的智能互动机械臂.系统基于深度信息实现了肢体动作和机械的智能交互,为实现复杂灵活控制机械臂提供了一种新的操纵方式,其控制更加精准、灵活,能够用尽量少的简单指令指挥机械臂进行复杂动作,完全可满足当前机械臂应用领域的要求.系统采用多信息融合技术提取手臂姿态和深度信息.设备组成包括二维色彩摄像头与三维深度摄像头,二者组合作为视觉传感器,将手的二维图像信息与深度信息发送至计算机端进行数据处理,并持续跟踪手部变化,将得到的手势指令信息通过算法转换,将手势运动解析为机械臂各自由度的指令集,经网络发送至机械臂,从而实现手势控制机械臂运动.【期刊名称】《物联网技术》【年(卷),期】2018(008)012【总页数】7页(P8-14)【关键词】三维图像;手势控制【作者】赵航;孙毅;李纪伟;孙盛阳【作者单位】国防科技大学;国防科技大学;国防科技大学;国防科技大学【正文语种】中文1 应用背景与作品简介1.1 应用背景随着现代工业与服务业的迅速细分发展,机械臂作为重要的基础智能装备发挥着极大的作用。

机械臂具有运行速度快、稳定性高、精确度高、安全性好等优点,被应用于诸多领域,如搬运行业、喷漆行业、精准焊接、流水线装配等程式化、流程化的生产环节已完全可代替人工进行高强度、高重复的工作。

在医疗手术、微电子制造与封装、远程操作、反恐排爆、位置环境探索等领域,甚至能够完成多种人工无法完成的操作。

近年来,随着人类对深海、太空、环境工程、远程医疗、家居服务等领域研究与应用的多样化需求,机械臂控制技术向大需求、多样化、智能化方向迅猛发展已成趋势。

20世纪60年代以来,美国、德国、日本等发达国家将机器人特别是工业机械臂确定为国家重要的研究发展方向,大大推动了其工业化发展进程,也为国家创造了巨大的经济效益。

基于机器视觉技术的智能手势识别系统设计与实验

基于机器视觉技术的智能手势识别系统设计与实验近年来,人工智能技术在各个领域持续迭代升级,为各行业带来巨大创新空间。

其中,基于机器视觉技术的智能手势识别系统备受关注。

手势识别系统可以识别人体动作和姿态,将人的非语言行为转化为机器可以理解的数字信号,让计算机可以更直观、更智能地与人互动,可以广泛应用于人机交互、智慧家居、虚拟现实、辅助医疗等领域。

本文将介绍手势识别系统的设计原理、系统构成和实验结果,以期为智能手势技术爱好者提供一些参考。

一、手势识别系统设计原理手势识别系统是一种基于机器视觉技术的人机交互系统,需要完成对人体动作的实时、准确、稳定识别。

其基本原理是将人体动作或手势的图像进行处理,提取出图像特征,然后应用机器学习或模式识别算法对特征进行分类。

传统手势识别系统的设计流程一般包括以下几个步骤:1. 数据采集:收集手势动作的图像或视频数据。

2. 图像预处理:对采集的数据进行去噪、平滑、滤波、分割等预处理操作,以提高后续特征提取的准确性和稳定性。

3. 特征提取:从预处理后的图像中提取出用于描述手势动作的特征,例如手指的曲度、手掌的面积、手背的角度、手部骨骼坐标等。

4. 特征匹配:将提取出的手势特征与已知的手势模板进行匹配,通过模板匹配、机器学习等方法识别手势类型。

5. 输出结果:将识别的手势类型转化为计算机可以理解的数字信号输出,如键盘键值、鼠标坐标、控制指令等。

二、手势识别系统构成手势识别系统可以分为硬件部分和软件部分两个部分,下面介绍一下每个部分的构成和功能。

1. 硬件部分:硬件部分主要包括图像采集设备、嵌入式系统和外围配件三个部分。

图像采集设备:一般采用深度相机、红外线摄像头、 RGBD相机等设备,可以获取到三维空间中的手势动作信息。

嵌入式系统:嵌入式系统可以将图像采集设备采集到的数据进行处理、存储和输出。

嵌入式系统通常选择高性能、低功耗的处理器,如NVIDIA Jetson Nano, Raspberry Pi和Arduino,这些嵌入式系统使用比较普遍。

基于模式识别的手势识别技术分析

基于模式识别的手势识别技术分析手势识别技术是近年来发展迅速的一项技术,它利用电脑视觉技术和模式识别算法,能够实时地对人体动作进行感知和识别。

手势识别技术在人机交互、虚拟现实、智能家居等领域有着广泛的应用前景。

本文将对基于模式识别的手势识别技术进行分析。

一、手势识别技术概述手势识别技术是指通过分析和识别人体手部或身体姿势的动态信息,来判断人体意图或进行交互的一项技术。

手势识别技术的基本流程包括图像采集、前处理、特征提取和分类识别等步骤,其中模式识别算法起到了核心作用。

二、模式识别算法在手势识别中的应用1. 静态手势识别静态手势识别常用于图像处理和计算机视觉领域,其目标是通过图像中的手势特征来进行识别。

常见的特征包括手指数量、手掌形状、手指间距离等,模式识别算法如支持向量机(SVM)和人工神经网络(ANN)常被应用于静态手势识别中。

2. 动态手势识别动态手势识别是指对特定的手势动作进行实时感知和识别。

与静态手势不同,动态手势需要考虑时间序列信息。

常用的模式识别算法包括隐马尔可夫模型(HMM)、条件随机场(CRF)等。

这些算法能够对手势的时间演变进行建模,从而提高识别的准确率。

三、基于模式识别的手势识别技术存在的问题及解决方案1. 多样性问题不同人的手势表达方式可能存在差异,这给手势识别带来了挑战。

为解决这一问题,可以通过多样性数据集的收集和模型的训练来提高识别准确率。

2. 干扰问题手势识别技术容易受到光照条件、背景干扰等因素的影响。

为应对干扰问题,可以采用背景建模、光照校正等预处理方法,提高手势识别的鲁棒性。

3. 实时性问题手势识别技术在实时性要求较高的场景中应用较为困难。

针对这一问题,可以通过优化算法和硬件设备,提高处理速度和响应时间。

四、手势识别技术的应用前景手势识别技术在多个领域具有广泛的应用前景。

在人机交互上,手势识别可以替代传统的键盘鼠标操作,使得人机交互更加自然和高效。

在虚拟现实领域,手势识别可以实现用户与虚拟环境的交互,提供沉浸式的体验。

Unity3D中使用LeapMotion进行手势控制

Unity3D中使⽤LeapMotion进⾏⼿势控制Leap Motion作为⼀款⼿势识别设备,相⽐于Kniect,长处在于准确度。

在我的毕业设计《场景漫游器》的开发中。

Leap Motion的⼿势控制作为重要的⼀个环节。

以此,谈谈开发中使⽤Leap Motion进⾏⼿势识别的实现⽅式以及须要注意的地⽅。

⼀、对Leap Motion的能⼒进⾏评估在设定⼿势之前。

我们必须知道Leap Motion能做到哪种程度,以免在设定⽅案之后发现⾮常难实现。

这个评估依靠实际对设备的使⽤体验。

主要从三个⽅⾯:1.Leap Motion提供的可视化的⼿势识别界⾯2.SDK⽂档说明3.Leap商店中的APP基本能够的得出:1.Leap Motion的识别对于⽔平⽅向或者以⽔平⽅向为基础⼿势可以较好的识别。

2.对于握拳或者垂直的⾏为识别会出现误差。

这样的误差和详细的⼿势⾏为有关。

3.不应该过分依赖⾼准确度,Leap Motion能检測到毫⽶级别是没错的,可是有时候会把你伸直的⼿指识别成弯曲的。

所以要做好最坏的打算。

⼆、实际的须要移动、旋转、点击button、缩放和旋转物体、关闭程序、暂停,主要的功能需求是这样。

有⼀些原则:1.同样环境下的⼿势应该接近和⽅便的转换。

旋转和移动的之间的转换应该设计的⾮常⾃然。

2.⼿势避免冲突,⼿势过于相似不是什么好事。

⽐⽅三个伸直的⼿指和四个伸直的⼿指不应该被设计成两个⼿势。

当然这不是绝对的。

假设你进⾏⼀个缓慢的动作⽽且动作是⾯向Leap Motion的摄像头,这时候应该相信它。

⾄少要针对这个⼿势做⼀个单独的測试。

三、考虑主要的数据结构和算法的轮廓Leap Motion的SDK在第⼀部分的时候已经浏览过。

最起码能知道Leap Motion能够包括的信息。

从SDK看来这是⾮常丰富的,既然设计⾃⼰的⼿势,那么最好不要依赖于SKD开发包的炫酷的⼿势。

⾮常可能,这些⼿势仅仅是官⽅⽤来演⽰或者炫耀的。

VR中的手势识别与动作追踪

在虚拟现实(VR)中,手势识别和动作追踪技术是实现沉浸式体验的关键要素。

这些技术能够捕捉用户的动作,并将其转化为计算机可以理解的信号,从而在虚拟环境中实现相应的互动。

以下是关于VR中的手势识别与动作追踪的一些关键点。

一、手势识别手势识别是指在VR环境中识别和理解用户手势的过程。

这包括识别手指动作、手掌位置、手臂运动等。

手势识别技术通常基于计算机视觉和机器学习算法。

1. 深度学习模型:深度学习模型,如卷积神经网络(CNN),在处理手势识别问题时表现优异。

这些模型可以从图像中提取特征,并识别出各种手势,如挥手、挥手接住物体、指向等。

2. 硬件支持:手势识别需要高性能的硬件设备,如高分辨率摄像头和强大的处理器。

这些设备能够捕捉到足够清晰的图像,以便算法能够准确地识别手势。

3. 交互方式:手势识别不仅限于传统的操纵杆和按钮式交互。

现在,一些高级系统能够识别并响应更自然的手部动作,如捏、推、抓等。

这些动作可以被用来控制虚拟环境中的对象,如开关门、调整灯光等。

二、动作追踪动作追踪是确定用户在虚拟环境中的位置和方向的过程。

这通常涉及到使用多个传感器或摄像头来捕捉用户的运动,并将其转化为计算机可以理解的坐标数据。

1. 传感器技术:使用惯性传感器(如加速度计和陀螺仪)的设备可以追踪用户的运动。

这些设备可以嵌入到头显或附加到衣物上,以提供精确的运动跟踪。

2. 光学追踪技术:光学追踪系统使用激光、红外光或可见光来跟踪物体的运动。

这些系统通常由一组传感器组成,可以捕捉到用户的运动并生成精确的位置数据。

3. 空间锚定:为了确保追踪的准确性,有时需要在虚拟环境中设置锚点或标记,以确保用户在虚拟世界中的位置被正确记录。

三、结合手势识别与动作追踪将手势识别与动作追踪相结合,可以为VR提供一种自然、直观的交互方式。

用户可以通过简单的肢体语言来控制虚拟环境中的对象,而无需依赖传统的输入设备。

这种结合使VR体验更加自然、流畅,同时也提高了用户的参与度和沉浸感。

基于leapmotion的动态手势识别

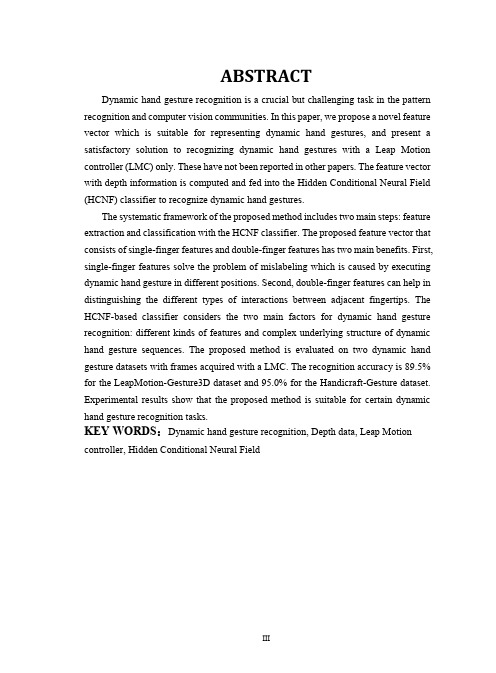

ABSTRACTDynamic hand gesture recognition is a crucial but challenging task in the pattern recognition and computer vision communities. In this paper, we propose a novel feature vector which is suitable for representing dynamic hand gestures, and present a satisfactory solution to recognizing dynamic hand gestures with a Leap Motion controller (LMC) only. These have not been reported in other papers. The feature vector with depth information is computed and fed into the Hidden Conditional Neural Field (HCNF) classifier to recognize dynamic hand gestures.The systematic framework of the proposed method includes two main steps: feature extraction and classification with the HCNF classifier. The proposed feature vector that consists of single-finger features and double-finger features has two main benefits. First, single-finger features solve the problem of mislabeling which is caused by executing dynamic hand gesture in different positions. Second, double-finger features can help in distinguishing the different types of interactions between adjacent fingertips. The HCNF-based classifier considers the two main factors for dynamic hand gesture recognition: different kinds of features and complex underlying structure of dynamic hand gesture sequences. The proposed method is evaluated on two dynamic hand gesture datasets with frames acquired with a LMC. The recognition accuracy is 89.5% for the LeapMotion-Gesture3D dataset and 95.0% for the Handicraft-Gesture dataset. Experimental results show that the proposed method is suitable for certain dynamic hand gesture recognition tasks.KEY WORDS:Dynamic hand gesture recognition, Depth data, Leap Motion controller, Hidden Conditional Neural Field目录摘要 (I)ABSTRACT (III)目录 (V)第1章绪论 (1)1.1引言 (1)1.2国内外研究现状 (4)1.2.1基于数据手套的手势识别 (4)1.2.2基于计算机视觉的手势识别 (5)1.2.3基于深度信息的手势识别 (6)1.3研究内容 (7)1.4论文结构 (8)第2章特征的分析与提取 (11)2.1三维梯度方向直方图 (11)2.2 DT特征 (12)2.3链码(Chain Code) (13)2.4单指特征与双指特征 (13)2.4.1单指特征 (14)2.4.2双指特征 (15)2.5本章小结 (15)第3章分类器模型 (17)3.1隐马尔科夫模型 (17)3.1.1隐马尔科夫模型的定义 (17)3.1.2隐马尔科夫模型的三个基本问题 (19)3.1.3隐马尔科夫模型的局限性 (20)3.2条件随机场 (20)3.2.1概率无向图 (20)3.2.2条件随机场的定义与形式 (23)3.2.3条件随机场的基本问题 (24)3.2.4条件随机场的特点 (25)3.3隐条件随机场 (25)3.3.1隐条件随机场的定义 (26)3.3.2隐条件随机场的学习与推断 (28)3.4隐条件神经场 (29)3.4.1隐条件神经场的定义 (29)3.4.2隐条件神经场的学习与推断 (31)3.5本章小结 (31)第4章实验结果与分析 (32)4.1动态手势数据库 (32)4.1.1基于Leap Motion的动态手势采集系统 (32)4.1.2动态手势数据库 (33)4.2实验结果与分析 (36)4.3本章小结 (41)第5章总结与展望 (44)5.1总结 (44)5.2工作展望 (45)参考文献 (46)发表论文和参加科研情况说明 (51)致谢 (53)第1章绪论1.1引言人机交互技术[1](Human-Computer Interaction)是研究人与机器之间相互作用的技术,该技术的研究目的是利用一切可能的信息及其通道进行人与机器之间的沟通与交流,从而提升人机交互技术的自然性和高效性。

浅谈基于深度相机的手势识别系统

i n f o r ma i t o n , d e p t h i ma g e i n f o m a r t i o n d a t e s wi l l p l a y i n n a i mp o r t nt a r o l e i n d e v e l o p me n t s a n d a p p l i c a t i o n s o f h a n d r e c o g n i i t o n s y s t e m, a n d a t l a s t we wi l l i n t r o d u c e t h e d e v e l o p me n t p r o s p e c s t o f t h e De p t h Ca m e r a . Ke y wo r d s : Ha nd g e s ur t e r e c o g n i t i o n ; De p t h c m e a r a ; s k e l e t o n i fo n r ma i t o n ; De p t h i ma g e

Di s c u s s i o n of g e s t ur e r e c og ni t i o n s y s t e m ba s e d o n de pt h c a me r a

Ab s t r a c t : Wi t h t h e c o mp u t e r i n t e r a c t i v e t e c h n o l o g y d e v e l o p i n g , h a n d g e s t u r e —a s a na ur t a l nd a i n t u i t i v e i n t e r p e r s o n l a c o mmu n i c a i t o n

基于Leap Motion手势识别的机器人控制系统

基于Leap Motion手势识别的机器人控制系统陶林;李凯格;王淼【摘要】设计一种通过识别手势对SCARA机器人进行控制的机器人控制系统.Leap Motion体感控制器采集手部信息数据,计算机对数据进行处理,识别出手势,同时对手掌位置坐标进行坐标转换,通过串口将数据发给机器人控制器,控制器控制机器人完成相应的动作.该系统通过了3D仿真检测,在SCARA机器人平台上运行良好,实现了通过手势对SCARA机器人进行控制的功能.【期刊名称】《制造业自动化》【年(卷),期】2015(037)024【总页数】4页(P64-66,81)【关键词】LeapMotion;手势识别;SCARA机器人;控制系统【作者】陶林;李凯格;王淼【作者单位】广东工业大学自动化学院,广州 510006;广东省自动化研究所广东省现代控制技术重点实验室广东省现代控制与光机电技术公共实验室,广州 510070;广东工业大学自动化学院,广州 510006【正文语种】中文【中图分类】TP273.50 引言随着机器人控制技术的快速发展,各种机器人已广泛应用于工业、农业、科研、教育以及人们的生活等诸多领域[1]。

但目前机器人的操控方式却较单调,现有的控制方式基本上是通过人机界面、示教器、遥控器来实现的。

这些控制方式需要依靠计算机来完成,人机交互通常都是依靠鼠标、键盘、触摸屏。

因此,通常要求操作者掌握一些计算机输入设备操作方法,并且操作程序复杂繁琐,人与机器人交互方式不够直接。

基于这点提出了一种新的机器人控制方式——体感控制,即操作者可以通过手势对机器人进行控制,让人直接用自己的手来指挥机器人进行动作,完成需要人机协作才能完成的任务。

本文将Leap Motion体感技术与机器人控制技术相结合,实现了机器人控制方式上的创新和更加自然的人机交互[2]。

1 总体结构与原理机器人控制系统通过Leap Motion体感控制器获取手掌的空间位运动信息,数据经过滤波削抖处理,识别出手势,结合机器人控制技术,实现了手势对机器人的控制,使机器人更加智能化。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

第27卷第4期2012年8月光电技术应用ELECTRO-OPTIC TECHNOLOGY APPLICATIONVol.27,No.4August ,2012随着机器智能领域的迅猛发展,手作为人身体上最灵活的一个部位及人机交互的一个媒介,得到越来越多的应用。

因此基于手势识别的各种应用也是层出不穷。

手势是一种自然而直观的人际交流模式。

手势识别也理所当然地成为了实现新一代人机交互不可缺少的一项关键技术。

然而,由于手势本身具有的多样性(包括肤色、形态的差异性)、多义性(不同手势具有不同的意义)、以及时间和空间上的差异性(会受到光照等因素的影响)等特点,加之人手是复杂变形体及视觉本身的不适定性,因此基于视觉的手势识别是一个极富挑战性并具有很大应用空间的研究方向[1]。

1手势识别技术的发展手势识别分为两种,一种是静态的手势识别,即在摄像头下检测到某个手势时就给出命令。

另一种是动态手势识别,即能够识别手做的一些动作。

随着3D 体感技术的出现,手势识别进入一个全新的领域。

1.1静态手势识别静态手势识别的常用方法主要有:基于模版匹配的,用边缘特征像素点作为识别特征,并利用Hausdorff 距离模板匹配完成静态手势识别[2];基于SVM 支持向量机,通过皮肤颜色模型进行手势分割,并用傅里叶描述子描述轮廓,采用针对小样本特别有效且范化误差有界的最小二乘支持向量机(LS -SVM )作为分类器进行手势识别[3]以及集合模版匹配和机器学习理论的手势识别方法[4]等。

但由于静态手势识别技术应用的局限性较大,不够灵活,使用人数在减少。

收稿日期:2012-06-24作者简介:淦创(1990-),男,辽宁锦州人,大学本科,研究方向为计算机图像处理.·信号与信息处理·基于3D 体感技术的动态手势识别淦创(北京航空航天大学,北京100191)摘要:提出了一种基于3D 体感机Kinect 的图像处理手势识别算法,通过深度图像和骨骼图像的方法实现动态手势识别。

首先在Kinect 提供的骨骼图像中20个骨点中,选取2个离手部最近的骨骼点,通过追踪这两个骨骼点的位置来实现对手部的追踪,再通过判断手部的深度(即其相对于摄像头的距离)的变化来实现动态手势识别。

关键词:深度图像;骨骼图像;手部追踪;动态手势识别中图分类号:TN94文献标识码:A文章编号:1673-1255(2012)04-0055-04Dynamic Gesture Recognition Based on 3D KinectGAN Chuang(Beijing University of aeronautics and astronautics,Beijing 100191,China )Abstract :A kind of gesture recognition algorithm of image processing based on 3D Kinect is proposed.Thedynamic gesture recognition algorithm is performed by skeleton images and depth images.At first,two skeleton points which are nearest to hands are choosen from 20skeleton points in a skeleton image.The process of tracking hands is performed by tracking the positions of the two skeleton points.Then the dynamic gesture recognition pro⁃cess is realized by the change of depths of hands (the distance between a hand and a camera).Key words :depth image;skeleton image;hands tracking;dynamic gesture recognition光电技术应用第27卷1.2动态手势识别技术在静态技术基础上发展起来的是动态手势识别,即在视频流下能够对手部做出一些动作进行识别,这种识别的难度要比静态手势识别难度大很多,但却更具有实用性。

动态手势识别的方法主要有:采用Camshift算法对手势进行分割,从而达到手势识别的功能[5];通过双目视觉系统来建立数学模型,并结合图像分割技术进行手势判断[6];基于机器学习进行手势识别,首先采用AdaBoost算法遍历图像,完成静态手势的识别工作,在动态手势的识别过程中,运用了光流法结合模板匹配的方法[7]等。

虽然手势识别方法取得了一些很好的效果,但这些现存方法都无法克服当光照条件变化较大或人体肤色差异性较大时会出现系统失灵的情况,这时往往需要重新调整各种参数来使得系统正常工作,从而大大降低了系统的稳定性。

其不稳定原因主要在于根据人手的颜色进行图像分割的处理过程会受到光照、遮挡等各种因素的影响,进而对后续的手势识别产生干扰。

因此提升手在摄像头下的识别精度成为了一个研究的重点。

1.3基于Kinect体感技术的动态手势识别技术Kinect是美国微软公司于2010年推出的XBOX360游戏机体感周边外设的正式名称,起初名为Natal,意味初生。

它实际上是一种3D体感摄影机,利用即时动态捕捉、影像辨识、麦克风输入、语音辨识、社群互动等功能让玩家摆脱传统游戏手柄的束缚,通过自己的肢体控制游戏,从而实现与互联网玩家互动,分享图片和影音信息等交互功能[8]。

微软推出Kinect后,深度图像和骨骼图像技术使得手势识别进入一个全新的领域。

由于Kinect在硬件上采用了CMOS红外感应设备,可以提供关于人的骨骼图和整个镜头下的深度图像,因此在对这两种类型的图像深入研究的基础上,提出了一种可以进行动态手势识别的方法,并在识别准确度上有了较大的改进。

1.3.1深度图像的产生机理Kinect采用了基于光编码(light coding)[9]理论的技术,可以直接获取物体与摄像头之间的距离。

其基本思想是通过连续光(近红外线)对测量空间进行编码,再经过感应器得到编码的光线,在将数据传递给晶片进行运算解码后,产生一张具有深度的图像。

其核心之一就是结构光技术,它与传统的技术有很大的差异性。

它的光源打出去的并不是一幅周期性变化的二维的图像编码,而是一个具有三维纵深的“体编码”。

这种光源叫做激光散斑(laser speck⁃le),是当激光照射到粗糙物体或穿透毛玻璃后形成的随机衍射斑点。

这些散斑具有高度的随机性,而且会随着距离的不同变换图案,空间中任何两处的散斑都会是不同的图案,等于是将整个空间加上了标记,所以任何物体进入该空间以及移动时,都可确切记录物体的位置。

Kinect另一核心技术在于光源标定[10],测量前对原始空间的散斑图案做记录,先做一次光源的标定,其采用的方法是每隔一段距离,取一个参考平面,然后把参考平面上的散斑图案记录下来;假设Kinect规定的用户活动范围是距离摄像头1~4m,每隔10cm 取一个参考平面,标定后保存了30幅散斑图像;测量时拍摄一幅待测场景的散斑图案,将这幅图像和保存的30幅参考图像依次做互相关运算,得到30幅相关度图像;空间中有物体存在的位置,在相关度图像上就会显示出峰值。

把这些峰值一层层叠在一起,经过插值运算,即可得到整个场景的三维形状[11]。

1.3.2骨骼点追踪技术Kinect骨架追踪处理流程的核心是一个不受周围环境的光照影响的CMOS红外传感器。

该传感器通过黑白光谱的方式来感知环境:纯黑代表无穷远,纯白代表无穷近。

黑白间的灰色地带对应物体到传感器的物理距离。

它收集视野范围内的每一点,并形成一幅代表周围环境的景深图像。

传感器以每秒30帧的速度生成景深图像流,实时3D地再现周围环境[12]。

骨骼点追踪采用了机器学习技术,通过建立了庞大的图像资料库,形成智慧辨识能力,尽可能理解使用者的肢体动作所代表的涵义。

Kinect对深度图像进行像素级评估,来辨别人体的不同部位,其基本思想是先采用分割策略将人体从背景环境中区分出来,得到追踪对象背景物体剔除后的深度图,然后把深度图像传进一个可辨别人体部位的机器学习系统中,该系统将给出某个特定像素属于身体某个部位的可能,然后将这些数据输入到集群系统中,从而训练Kinect像素级辨认身体部位的能力。

Kinect会评估Exemplar输出的每一个可能的像素来确定关节56第4期淦创:基于3D 体感技术的动态手势识别点,然后根据追踪到的20个关节点来生成一幅人体骨骼图[13]。

两幅经辨识的人体动态骨骼如图1所示。

2基于深度图和骨骼图的动态手势识别技术动态手势识别技术主要分为两个步骤,第一个步骤是对手的部位进行追踪,即在视频流中每一帧中准确找到手的位置。

第二个步骤是识别不同的手部动态动作。

2.1基于Kinect 骨点图手部追踪要想进行手势识别,第一步要先在图像中找到手的位置,并在视频流中追踪手的位置。

传统的手势识别方法大多数都是利用肤色分割并结合一些连通域的形状在图像中寻找手的位置,这种方法需要设定阈值。

当光照变化很大或人的肤色差异性很大时都会出现问题,进而阻碍了手势识别技术的实际应用。

而Kinect 的出现解决了上述问题产生的识别干扰,通过Kinect 的骨骼图像可知,手势追踪主要就是追踪Kinect 人体控制点位置图2中的A 点和B 点。

由于Kinect 的平台本身可以提供骨骼点的地理坐标,因此可根据坐标来完成对手部的追踪。

在应用方面,Kinect 硬件可提供手在空间中的位置变化信息,可通过对该信息的比例变换,完成手势对目标物体的控制功能。

以鼠标控制为例,来验证此算法的实用性。

可实现的功能有:(1)当镜头下的手上下左右移动时,鼠标也会跟随着手进行相应幅度的上下左右晃动,即完成手对鼠标的控制;(2)当手的前后变化距离达到一定程度时,可以完成对鼠标左键的按下与抬起的操作。

实现的方法是:Kinect 本身具有可以提供骨点图的功能,通过控制(图2)所示A 点在空间上下左右变化的值从而设定相应的鼠标上下左右变化的值,进而完成对鼠标的控制。

对20个身高、体重、年龄不同的人进行了10种比例的实验。

手部与鼠标做上下移动的实验结果如表1所示,手部与鼠标做左右移动的实验结果如表2所示。

从表1、表2可知,当人手掌的上下和左右移动距离与对应鼠标的移动距离之比分别为8:1和6:1时,体感交互满意度较高。

2.2基于Kinect 深度图像的动态手势识别算法由Kinect 的深度图像技术可知某点距离摄像头的距离,因此利用Kinect 就可以完成对手势伸展的动作识别,并据此进行控制。