【黑马程序员】爬虫视频教程

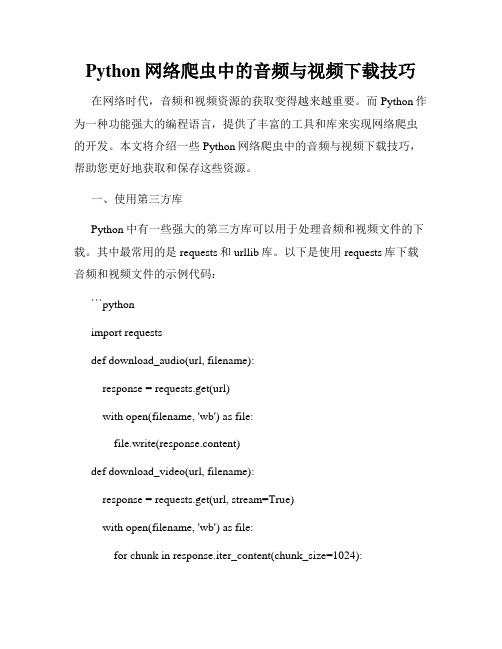

Python网络爬虫中的音频与视频下载技巧

Python网络爬虫中的音频与视频下载技巧在网络时代,音频和视频资源的获取变得越来越重要。

而Python作为一种功能强大的编程语言,提供了丰富的工具和库来实现网络爬虫的开发。

本文将介绍一些Python网络爬虫中的音频与视频下载技巧,帮助您更好地获取和保存这些资源。

一、使用第三方库Python中有一些强大的第三方库可以用于处理音频和视频文件的下载。

其中最常用的是requests和urllib库。

以下是使用requests库下载音频和视频文件的示例代码:```pythonimport requestsdef download_audio(url, filename):response = requests.get(url)with open(filename, 'wb') as file:file.write(response.content)def download_video(url, filename):response = requests.get(url, stream=True)with open(filename, 'wb') as file:for chunk in response.iter_content(chunk_size=1024):if chunk:file.write(chunk)```上述代码中,download_audio函数用于下载音频文件,download_video函数用于下载视频文件。

您只需要传入对应的URL和保存的文件名即可。

二、音频下载技巧1. 了解音频格式在下载音频文件之前,了解文件的格式是十分重要的。

不同的音频格式可能需要不同的处理方式。

常见的音频格式有MP3、WAV、FLAC等。

2. 解析音频源有些网站会将音频资源隐藏在其他的网页元素中,下载前您可能需要通过解析源代码或是使用相关工具来定位到音频文件的URL。

3. 多线程下载如果需要下载大量的音频文件,可以考虑使用多线程来提高下载速度。

Python爬虫实战教学

Python爬虫实战教学第一章:爬虫基础知识Python爬虫是一种自动爬取网站信息的技术,可以用来获取大量数据。

在进行Python爬虫实战前,我们首先需要了解一些基础知识。

1.1 爬虫的原理爬虫的原理是通过发送HTTP请求到目标网站,然后解析网页获取所需的信息。

可以使用Python的第三方库,如Requests库来发送HTTP请求,并使用正则表达式或者解析库(如BeautifulSoup、XPath等)来解析网页。

1.2 HTTP请求与响应在Python中,我们可以使用Requests库发送HTTP请求,并获取响应内容。

可以设置请求头、请求体、代理IP等信息,以模拟浏览器的行为。

1.3 网页解析网页解析是爬虫的核心部分,常用的解析方法有正则表达式、BeautifulSoup、XPath等。

使用这些方法可以从网页中提取出所需的信息。

这些解析方法各有特点,根据不同的场景选择合适的方法。

第二章:爬虫实战准备在进行爬虫实战之前,我们需要做一些准备工作。

2.1 安装Python和相关库首先,我们需要安装Python,并安装相关的第三方库,如Requests、BeautifulSoup等。

可以使用pip命令来安装这些库。

2.2 确定爬取目标在进行爬虫实战之前,我们需要明确我们要爬取的目标,确定目标网站的URL和需要提取的信息。

2.3 分析网页在确定目标网站后,我们需要分析网页的结构,找出目标信息所在的位置、标签等。

可以使用浏览器的开发者工具来分析网页。

第三章:实战案例一——爬取天气信息3.1 网页分析首先,我们需要分析天气网站的网页结构,找出所需的天气信息所在的位置。

可以使用浏览器的开发者工具来分析。

3.2 发送HTTP请求使用Requests库发送HTTP请求到天气网站,并获取响应内容。

3.3 解析网页使用解析库(如BeautifulSoup)来解析网页,提取出所需的天气信息。

3.4 数据处理与存储对提取出的天气信息进行数据处理(如去除空白字符、转换格式等),并将数据保存到本地文件或者数据库。

黑马python6.5 讲义

一、介绍在当今信息化时代,计算机编程已成为一项不可或缺的技能。

在各种编程语言中,Python因其简洁、易学、功能强大等优点,越来越受到人们的青睐。

为了满足社会对Python编程的需求,黑马程序员推出了Python6.5讲义。

本讲义旨在帮助学习者系统、全面地掌握Python编程语言,掌握Python编程的核心技术,掌握数据分析和可视化处理技术,达到能够独立开发Python程序的水平。

二、课程设置1. 第一部分:Python基础1.1 Python环境搭建1.2 变量和数据类型1.3 字符串和编码1.4 列表和元组1.5 条件和循环1.6 函数和模块2. 第二部分:Python进阶2.1 面向对象编程2.2 异常处理2.3 文件操作2.4 正则表达式2.5 网络编程2.6 并发编程3. 第三部分:数据分析与可视化3.1 Numpy库与数组操作3.2 Pandas库与数据处理3.3 Matplotlib库与数据可视化3.4 数据分析案例实战4. 第四部分:实战项目4.1 案例一:爬虫实战4.2 案例二:数据分析报告生成4.3 案例三:Web开发与接口对接三、课程特色1. 专业讲师团队Python6.5讲义由黑马程序员的专业讲师团队授课,团队成员均具备丰富的实战经验,能够结合实际项目案例进行讲解,使学习者能够更好地理解Python编程的应用场景。

2. 实战案例课程设置了丰富的实战案例,学习者可通过实际项目的练习,将所学的知识运用到实际场景中,培养编程思维和解决问题的能力。

3. 互动式学习课程采用互动式教学模式,学员可以与讲师进行实时互动交流,及时解决疑惑,提高学习效率。

4. 课后辅导学员完成每个模块的学习后,均有专门的课后辅导,通过作业、练习等形式,巩固所学知识,确保学习效果。

四、学习收获通过本次Python6.5讲义的学习,学员将获得以下收获:1. 掌握Python编程的基础知识和核心技术,能够独立开发Python 程序;2. 能够运用Python进行数据分析和可视化处理,为后续的数据处理工作打下基础;3. 通过实战项目的练习,提高编程实践能力,为日后的工作和学习打下坚实基础。

Python爬虫基础课件(PPT版)

基于Scrapy框架的网站爬虫实例

Scrapy框架介绍

爬虫实例

学习使用Scrapy框架构建Python 爬虫系统的基本概念和使用方法。

分享一些使用Scrapy框架构建的 实际爬虫项目的案例和经验。

数据抓取效果

展示使用Scrapy框架进行网站数 据抓取的实际效果和成果。

了解常见的爬虫错误和异常, 并学习如何处理和避免它们。

3 最佳实践

分享一些爬虫性能优化和错误处理的最佳实践和技巧。

持续学习与社区分享

探讨如何在Python爬虫领域持续学习和改进自己的技能,并与社区分享经验和知识。

常见爬虫面试题及解答技巧

解答一些常见的Python爬虫面试题,并分享解答技巧和策略。

数据分析案例

分享一些实践案例,如新闻抓取、 价格监测和社交媒体数据分析。

展示一些实际项目中使用Python 爬虫进行数据提取的案例和应用。

介绍一些使用爬虫获取数据并进 行数据分析的实践案例。

爬虫性能优化和错误处理方法

1 性能优化

学习如何优化爬虫的性能, 包括并发请求、异步爬取和 缓存技术。

2 错误处理

介绍如何构建分布式爬虫系统,包括任务调度、数 据同步和通信机制。

数据清洗和预处理方法

数据清洗

学习如何清理和处理爬虫获取的原始数据,如 去除重复项和处理缺失值。

数据预处理

介绍常见的数据预处理方法,如数据规范化和 特征选择。

爬虫数据的可视化分析和展示

1 可视化工具

探索用于可视化爬虫数据 的常用工具和库,如 Matplotlib和Seaborn。

2 数据on进行数据分析, 包括数据聚合、统计分析 和生成可视化图表。

分享一些使用可视化工具 分析爬虫数据的实际案例。

python爬取视频教程

python爬取视频教程爬取视频教程是一项非常有用和流行的技能,在这个数字化时代,互联网上存在着丰富的视频教程资源,使用Python编程语言可以方便地爬取这些视频教程并保存到本地。

以下我将介绍如何使用Python爬取视频教程。

首先,我们需要了解一些基本的爬虫概念和工具。

Python中最主要的爬虫库是requests和beautifulsoup。

requests可以发送HTTP请求并获取网页内容,beautifulsoup则可以解析网页内容。

我们还可以使用其他的第三方库来进一步处理视频,如FFmpeg、OpenCV等。

接下来,我们需要找到要爬取的目标网站。

可以选择一些专门提供视频教程的网站,如Youtube、B站等。

这些网站提供了API接口,可以方便地获取视频相关的信息。

我们可以使用requests库发送GET请求,获取返回的网页内容。

然后,我们需要在网页中找到视频的链接。

这就需要用到beautifulsoup库,它可以解析HTML文档,并提供了一些简单而强大的方法来提取并操作数据。

我们可以使用beautifulsoup 找到视频标签,并提取其中的链接信息。

接下来,我们可以使用requests库进一步获取视频的内容,并保存到本地。

在请求时,我们需要设置一些请求头(User-Agent、Referer等),以模拟浏览器行为,防止被网站屏蔽。

可以使用requests库的get方法下载视频数据,并使用Python 的文件操作将数据保存到本地文件中。

最后,如果需要进一步处理视频,如转换格式、剪辑、提取关键帧等,可以使用FFmpeg、OpenCV等库进行处理。

FFmpeg是一个强大的多媒体处理工具,可以进行视频的转码、剪辑等操作。

OpenCV是一个计算机视觉库,可以处理视频帧图像,提取关键帧等。

总结起来,使用Python爬取视频教程需要以下步骤:选择目标网站、使用requests库获取网页内容、使用beautifulsoup库解析网页内容、找到视频链接、使用requests库下载视频、(可选)使用FFmpeg、OpenCV等库进一步处理视频。

Python网络爬虫实践教程

Python网络爬虫实践教程一、什么是网络爬虫网络爬虫,也称为网络蜘蛛或网络机器人,是一种自动获取互联网信息的程序工具。

通过模拟浏览器行为,爬虫程序可以访问网页、提取网页中的数据,在大规模数据采集、搜索引擎、数据分析等领域发挥着重要作用。

二、网络爬虫的基本原理网络爬虫的基本原理是通过发送HTTP请求,并解析响应得到的HTML文档来获取网页数据。

首先,我们需要使用Python中的requests库发送网络请求,并获得服务器的响应。

然后,通过解析HTML文档,提取出我们需要的数据。

三、准备工作在开始编写网络爬虫之前,我们需要安装Python以及相关的库。

首先,需要安装Python解释器和pip包管理工具。

然后,使用pip安装requests、beautifulsoup和lxml等库。

四、发送HTTP请求在编写爬虫程序之前,我们需要了解如何使用Python发送HTTP请求。

使用requests库发送GET请求非常简单,只需要调用get方法,并提供目标网址即可。

如果需要发送POST请求,同样使用post方法,并在参数中传递需要提交的数据。

五、解析HTML文档解析HTML文档是爬虫中非常重要的一步。

Python提供了多种解析HTML的库,其中比较常用的是beautifulsoup和lxml。

通过指定解析器,我们可以轻松地提取出HTML文档中的各个元素,并进行进一步的处理。

六、处理反爬机制为了阻止爬虫程序的访问,许多网站采取了反爬机制,例如设置验证码、限制IP访问频率等。

对于这些反爬措施,我们可以通过使用代理IP、设置请求头信息、使用验证码识别技术等方法来绕过。

七、数据存储与分析在爬虫过程中,我们通常需要将获取的数据进行存储和分析。

常用的数据存储方式包括将数据保存到数据库、文本文件、Excel 表格或者CSV文件中。

而要对数据进行分析,可以使用Python中的数据分析库,如pandas、numpy等。

八、实践案例:爬取豆瓣电影数据为了更好地理解网络爬虫的实践过程,我们以爬取豆瓣电影数据为例进行讲解。

黑马程序员python程序开发案例教程第16章用户登录项目

黑马程序员python程序开发案例教程第16章用户登录项目《黑马程序员Python程序开发案例教程》第16章:用户登录项目,将通过一个完整的用户登录项目,帮助读者掌握Python Web开发中的用户登录功能。

1. 需求分析用户登录项目需要实现以下功能:用户注册:用户可以注册账号,填写用户名、密码等信息。

用户登录:用户可以登录账号,输入用户名和密码进行验证。

密码重置:如果用户忘记密码,可以通过邮箱找回密码。

权限控制:根据用户角色或权限,限制用户访问某些页面。

2. 技术选型为了实现上述功能,我们需要选择合适的技术和框架。

在本项目中,我们将使用以下技术:Python语言:Python是一种简单易学、功能强大的编程语言,适合Web 开发。

Flask框架:Flask是一个轻量级的Web框架,可以帮助我们快速搭建Web应用程序。

SQLAlchemy:一个ORM框架,用于操作数据库。

Flask-Mail:用于发送邮件。

Flask-Login:用于处理用户登录和权限控制。

3. 开发流程数据库设计:根据需求设计数据库表结构,包括用户表、角色表等。

注册和登录功能实现:编写注册和登录的表单页面,处理表单提交,验证用户输入,存储用户信息到数据库。

密码重置功能实现:当用户忘记密码时,通过邮箱发送找回密码的链接,用户点击链接后可以重置密码。

权限控制功能实现:根据用户角色或权限,限制用户访问某些页面。

可以使用Flask-Login提供的装饰器login_required来限制未登录用户访问某些页面。

测试和部署:对项目进行测试,确保各项功能正常工作,然后将项目部署到服务器上。

4. 代码实现由于篇幅限制,这里只给出部分关键代码实现。

完整的代码实现请参考《黑马程序员Python程序开发案例教程》的配套源代码。

注册表单页面():```html<form action="/register" method="post"><label for="username">Username:</label><input type="text" name="username" required><label for="password">Password:</label><input type="password" name="password" required><input type="submit" value="Register"></form>```处理注册请求的Python代码():```pythonfrom flask import Flask, render_template, request, redirect, url_for, flash, sessionfrom flask_sqlalchemy import SQLAlchemyfrom flask_mail import Mail, Messagefrom import generate_password_hash, check_password_hashfrom flask_login import UserMixin, LoginManager, login_user, logout_user, login_required, current_userimport random, stringapp = Flask(__name__)['SECRET_KEY'] = 'your secret key' 设置秘钥以保护应用程序的安全性。

python爬虫讲解

python爬虫讲解

Python爬虫是一种自动化获取网络数据的技术,它可以快速地从各种网站上抓取大量数据,使得数据处理更加高效。

本文将深入讲解Python爬虫的原理、常用工具和常见问题,帮助读者掌握Python 爬虫的基础知识和实际应用技巧。

我们将从以下几个方面进行讲解: 1. Python爬虫的基本原理和工作流程:介绍Python爬虫的基本概念和原理,以及Python爬虫的工作流程和技术实现。

2. Python爬虫的常用工具和库:介绍Python爬虫中常用的工具和库,如Requests、BeautifulSoup、Scrapy等,帮助读者快速入门。

3. Python爬虫的实际应用:通过实际案例,介绍Python爬虫的实际应用场景,如爬取电商网站商品信息、爬取新闻、爬取社交媒体等。

4. Python爬虫的进阶技巧:介绍Python爬虫的一些进阶技巧,如多线程爬虫、分布式爬虫、反爬虫技术等,帮助读者深入了解Python 爬虫的高级应用和技术。

本文旨在为读者提供一份全面的Python爬虫入门指南,帮助读者快速学习和掌握Python爬虫技术,提升数据处理效率和数据分析能力。

- 1 -。

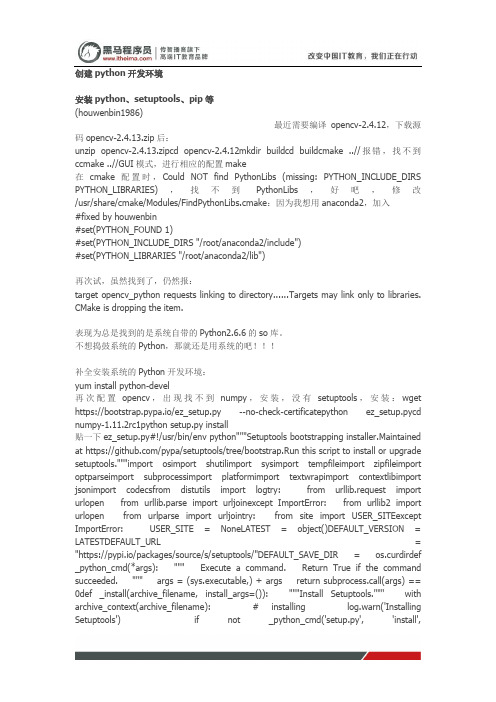

黑马程序员Python教程创建python开发环境

安装python、setuptools、pip等(houwenbin1986)最近需要编译opencv-2.4.12,下载源码opencv-2.4.13.zip后:unzip opencv-2.4.13.zipcd opencv-2.4.12mkdir buildcd buildcmake ..//报错,找不到ccmake ..//GUI模式,进行相应的配置make在cmake配置时,Could NOT find PythonLibs (missing: PYTHON_INCLUDE_DIRS PYTHON_LIBRARIES),找不到PythonLibs,好吧,修改/usr/share/cmake/Modules/FindPythonLibs.cmake:因为我想用anaconda2,加入#fixed by houwenbin#set(PYTHON_FOUND 1)#set(PYTHON_INCLUDE_DIRS "/root/anaconda2/include")#set(PYTHON_LIBRARIES "/root/anaconda2/lib")再次试,虽然找到了,仍然报:target opencv_python requests linking to directory......Targets may link only to libraries. CMake is dropping the item.表现为总是找到的是系统自带的Python2.6.6的so库。

不想捣鼓系统的Python,那就还是用系统的吧!!!补全安装系统的Python开发环境:yum install python-devel再次配置opencv,出现找不到numpy,安装,没有setuptools,安装:wget https://bootstrap.pypa.io/ez_setup.py --no-check-certificatepython ez_setup.pycd numpy-1.11.2rc1python setup.py install贴一下ez_setup.py#!/usr/bin/env python"""Setuptools bootstrapping installer.Maintained at https:///pypa/setuptools/tree/bootstrap.Run this script to install or upgrade setuptools."""import osimport shutilimport sysimport tempfileimport zipfileimport optparseimport subprocessimport platformimport textwrapimport contextlibimport jsonimport codecsfrom distutils import logtry: from urllib.request import urlopen from urllib.parse import urljoinexcept ImportError: from urllib2 import urlopen from urlparse import urljointry: from site import USER_SITEexcept ImportError: USER_SITE = NoneLATEST = object()DEFAULT_VERSION = LATESTDEFAULT_URL = "https://pypi.io/packages/source/s/setuptools/"DEFAULT_SAVE_DIR = os.curdirdef _python_cmd(*args): """ Execute a command. Return True if the command succeeded. """ args = (sys.executable,) + args return subprocess.call(args) == 0def _install(archive_filename, install_args=()): """Install Setuptools.""" with archive_context(archive_filename): # installing log.warn('Installing Setuptools') if not _python_cmd('setup.py', 'install',*install_args): log.warn('Something went wrong during the installation.') log.warn('See the error message above.') # exitcode will be 2 return 2def _build_egg(egg, archive_filename, to_dir): """Build Setuptools egg.""" with archive_context(archive_filename): # building an egg log.warn('Building a Setuptools egg in %s', to_dir) _python_cmd('setup.py', '-q', 'bdist_egg', '--dist-dir', to_dir) # returning the result log.warn(egg) if not os.path.exists(egg): raise IOError('Could not build the egg.')class ContextualZipFile(zipfile.ZipFile): """Supplement ZipFile class to support context manager for Python 2.6.""" def __enter__(self): return self def __exit__(self, type, value, traceback): self.close() def __new__(cls, *args, **kwargs): """Construct a ZipFile or ContextualZipFile as appropriate.""" if hasattr(zipfile.ZipFile, '__exit__'): return zipfile.ZipFile(*args, **kwargs) return super(ContextualZipFile, cls).__new__(cls)@contextlib.contextmanagerdefarchive_context(filename): """ Unzip filename to a temporary directory, set to the cwd. The unzipped target is cleaned up after. """ tmpdir = tempfile.mkdtemp() log.warn('Extracting in %s', tmpdir) old_wd = os.getcwd() try: os.chdir(tmpdir) with ContextualZipFile(filename) as archive: archive.extractall() # going in the directory subdir = os.path.join(tmpdir, os.listdir(tmpdir)[0]) os.chdir(subdir) log.warn('Now working in %s', subdir) yield finally: os.chdir(old_wd) shutil.rmtree(tmpdir)def _do_download(version, download_base, to_dir, download_delay): """Download Setuptools.""" py_desig = 'py{sys.version_info[0]}.{sys.version_info[1]}'.format(sys=sys) tp = 'setuptools-{version}-{py_desig}.egg' egg = os.path.join(to_dir, tp.format(**locals())) if not os.path.exists(egg): archive = download_setuptools(version, download_base, to_dir, download_delay) _build_egg(egg, archive, to_dir) sys.path.insert(0, egg) # Remove previously-imported pkg_resources if present (see # https:///pypa/setuptools/pull-request/7/ for details). if 'pkg_resources' in sys.modules: _unload_pkg_resources() import setuptools setuptools.bootstrap_install_from = eggdef use_setuptools( version=DEFAULT_VERSION, download_base=DEFAULT_URL, to_dir=DEFAULT_SAVE_DIR, download_delay=15): """ Ensure that a setuptools version is installed. Return None. Raise SystemExit if the requested version or later cannot be installed. """ version = _resolve_version(version) to_dir = os.path.abspath(to_dir) # prior to importing, capture the module state for # representative modules. rep_modules = 'pkg_resources', 'setuptools' imported = set(sys.modules).intersection(rep_modules) try: import pkg_resources pkg_resources.require("setuptools>=" + version) # a suitable version is already installed return except ImportError: # pkg_resources notavailable; setuptools is not installed; download pass except pkg_resources.DistributionNotFound: # no version of setuptools was found; allow download pass except pkg_resources.VersionConflict as VC_err: if imported: _conflict_bail(VC_err, version) # otherwise, unload pkg_resources to allow the downloaded version to # take precedence. del pkg_resources _unload_pkg_resources() return _do_download(version, download_base, to_dir, download_delay)def _conflict_bail(VC_err, version): """ Setuptools was imported prior to invocation, so it is unsafe to unload it. Bail out. """ conflict_tmpl = textwrap.dedent(""" The required version of setuptools (>={version}) is not available, and can't be installed while this script is running. Please install a more recent version first, using 'easy_install -U setuptools'. (Currently using {VC_err.args[0]!r}) """) msg = conflict_tmpl.format(**locals()) sys.stderr.write(msg) sys.exit(2)def _unload_pkg_resources(): sys.meta_path = [ importer for importer in sys.meta_path if importer.__class__.__module__ != 'pkg_resources.extern' ] del_modules = [ name for name in sys.modules if name.startswith('pkg_resources') ] for mod_name in del_modules: del sys.modules[mod_name]def _clean_check(cmd, target): """ Run the command to download target. If the command fails, clean up before re-raising the error. """ try: subprocess.check_call(cmd) except subprocess.CalledProcessError: if os.access(target, os.F_OK): os.unlink(target) raisedef download_file_powershell(url, target): """ Download the file at url to target using Powershell. Powershell will validate trust. Raise an exception if the command cannot complete. """ target = os.path.abspath(target) ps_cmd = ( "[.WebRequest]::DefaultWebProxy.Credentials = " "[.CredentialCache]::DefaultCredentials; " '(new-object .WebClient).DownloadFile("%(url)s", "%(target)s")' % locals() ) cmd = [ 'powershell', '-Command', ps_cmd, ] _clean_check(cmd, target)def has_powershell(): """Determine if Powershell is available.""" if platform.system() != 'Windows': return False cmd = ['powershell', '-Command', 'echo test'] with open(os.path.devnull, 'wb') as devnull: try: subprocess.check_call(cmd, stdout=devnull, stderr=devnull) except Exception: return False return Truedownload_file_powershell.viable = has_powershelldef download_file_curl(url, target): cmd = ['curl', url, '--location', '--silent', '--output', target] _clean_check(cmd, target)def has_curl(): cmd = ['curl', '--version'] with open(os.path.devnull, 'wb') as devnull: try: subprocess.check_call(cmd, stdout=devnull, stderr=devnull) except Exception: return False return Truedownload_file_curl.viable = has_curldef download_file_wget(url, target): cmd = ['wget', url, '--quiet', '--output-document', target] _clean_check(cmd, target)def has_wget(): cmd = ['wget', '--version'] with open(os.path.devnull, 'wb') asdevnull: try: subprocess.check_call(cmd, stdout=devnull, stderr=devnull) except Exception: return False return Truedownload_file_wget.viable = has_wgetdef download_file_insecure(url, target): """Use Python to download the file, without connection authentication.""" src = urlopen(url) try: # Read all the data in one block. data = src.read() finally: src.close() # Write all the data in one block to avoid creating a partial file. with open(target, "wb") as dst: dst.write(data)download_file_insecure.viable = lambda: Truedef get_best_downloader(): downloaders = ( download_file_powershell, download_file_curl, download_file_wget, download_file_insecure, ) viable_downloaders = (dl for dl in downloaders if dl.viable()) return next(viable_downloaders, None)def download_setuptools( version=DEFAULT_VERSION, download_base=DEFAULT_URL, to_dir=DEFAULT_SAVE_DIR, delay=15, downloader_factory=get_best_downloader): """ Download setuptools from a specified location and return its filename. `version` should be a valid setuptools version number that is available as an sdist for download under the `download_base` URL (which should end with a '/'). `to_dir` is the directory where the egg will be downloaded. `delay` is the number of seconds to pause before an actual download attempt. ``downloader_factory`` should be a function taking no arguments and returning a function for downloading a URL to a target. """ version = _resolve_version(version) # making sure we use the absolute path to_dir = os.path.abspath(to_dir) zip_name = "setuptools-%s.zip" % version url = download_base + zip_name saveto = os.path.join(to_dir, zip_name) if not os.path.exists(saveto): # Avoid repeated downloads log.warn("Downloading %s", url) downloader = downloader_factory() downloader(url, saveto) return os.path.realpath(saveto)def _resolve_version(version): """ Resolve LATEST version """ if version is not LATEST: return version meta_url = urljoin(DEFAULT_URL, '/pypi/setuptools/json') resp = urlopen(meta_url) with contextlib.closing(resp): try: charset = ().get_content_charset() except Exception: # Python 2 compat; assume UTF-8 charset = 'UTF-8' reader = codecs.getreader(charset) doc = json.load(reader(resp)) return str(doc['info']['version'])def _build_install_args(options): """ Build the arguments to 'python setup.py install' on the setuptools package. Returns list of command line arguments. """ return ['--user'] if er_install else []def _parse_args(): """Parse the command line for options.""" parser = optparse.OptionParser() parser.add_option( '--user', dest='user_install', action='store_true', default=False, help='install in user site package') parser.add_option( '--download-base', dest='download_base', metavar="URL", default=DEFAULT_URL, help='alternative URL from where to download the setuptools package') parser.add_option( '--insecure',dest='downloader_factory', action='store_const', const=lambda: download_file_insecure, default=get_best_downloader, help='Use internal, non-validating downloader' ) parser.add_option( '--version', help="Specify which version to download", default=DEFAULT_VERSION, ) parser.add_option( '--to-dir', help="Directory to save (and re-use) package", default=DEFAULT_SAVE_DIR, ) options, args = parser.parse_args() # positional arguments are ignored return optionsdef _download_args(options): """Return args for download_setuptools function from cmdline args.""" return dict( version=options.version, download_base=options.download_base,downloader_factory=options.downloader_factory, to_dir=options.to_dir, )def main(): """Install or upgrade setuptools and EasyInstall.""" options = _parse_args() archive = download_setuptools(**_download_args(options)) return _install(archive, _build_install_args(options))if __name__ == '__main__': sys.exit(main())配置opencv,编译OK!同理,安装pip-8.1.2:tar xzf pip-8.1.2.tar.gzcd pip-8.1.2python setup.py install。

【黑马18期Java毕业生】黑马程序员Java全套资料+视频+工具

【⿊马18期Java毕业⽣】⿊马程序员Java全套资料+视频+⼯具Java学习路线图引⾔:⿊马程序员:深知⼴⼤爱好Java的⼈学习是多么困难,没视频没资源,上⽹花钱还⽼被骗。

为此我们历时⼀个⽉整理这套Java学习路线图,不管你是不懂电脑的⼩⽩,还是已经步⼊开发的⼤⽜,这套路线路你都值得拥有,⼩⽩看上⾯的视频可以成功学会Java并且顺利⼯作,⼤神看了上⾯的资源肯定会谆谆乐道,路线图的宗旨就是分享,专业,便利,让喜爱Java的⼈,都能平等的学习。

从今天起不要在找借⼝,不要再说想学Java却没有资源,赶快⾏动起来,Java等你来探索,⾼薪可能只差下载观看了。

获取更多资源+学习交流+问题解答,就加QQ:2212232413⼀、Java学习路线图—流程篇:⼆、Java学习路线图—视频篇:1、第⼀阶段-Java基础⼊门Java视频篇第⼀阶段-Java基础⼊门本阶段PHP课程共计11个知识点,2个免费学习视频推荐1、周期与⽬标:学习周期:35天学完后⽬标:可进⾏⼩型应⽤程序开发,对数据库进⾏基本的增删改查管理2、知识点:1)计算机基础知识(理解)计算机基础、DOS常⽤命令、Java概述、JDK配置、环境变量配置、Java程序⼊门2)编程基础(掌握)常量与变量、数据类型、运算符、流程控制语句、⽅法、数组3)⾯相对象(重点)类与对象、封装、继承、多态、抽象类、接⼝4)常⽤类(理解)常⽤类介绍、正则表达式5)集合(重点)Collection集合、List集合、Set集合、Map集合6)异常(理解)异常处理⽅式、⾃定义异常7)IO(掌握)File类、递归、字节流、字符流、转换流、缓冲流8)多线程(理解)多线程、线程池9)⽹络编程(理解)⽹络编程10)反射(理解)反射11)MySQL及JDBC开发(重点)MySQL数据库、JDBC、DBUtils、DBCP连接池3、该阶段免费配套视频1)(此免费视频对应上述1,2,3,4,5,6,7,8,9,10知识点)2)》(此免费视频对应上述1,2,3,4,5,6,7,8,9,10知识点)4、精品推荐视频张孝祥09年Struts开发视频教程张孝祥_Java⾼新技术2、第⼆阶段-JavaWeb阶段Java视频篇第⼆阶段-JavaWeb阶段本阶段PHP课程共计4个⼤知识点,4个免费学习视频推荐1、周期与⽬标:学习周期:33天学完后⽬标:可以仿制任何⽹站前端页⾯,解决⽹页浏览器兼容性问题,解决PC端和移动端兼容性问题;使⽤前端脚本进⾏相关⽹页功能特效编写,使⽤JavaWeb核⼼技术轻松写出任何⽹站功能模块,使⽤JavaWeb⾼级部分知识解决⽹站的相关⾼并发问题,⽆压⼒胜任javaEE开发⼯程师职位。

Python网络爬虫的与视频爬取技术

Python网络爬虫的与视频爬取技术Python网络爬虫与视频爬取技术随着互联网的快速发展和大数据时代的来临,网上视频资源成为人们日常娱乐、学习的重要来源之一。

而Python作为一种简洁、易学且功能强大的编程语言,为我们提供了许多优秀的网络爬虫工具和框架,使得爬取网上视频内容变得更加容易和高效。

本文将介绍Python网络爬虫的原理、常见的爬取视频的方法以及相关的应用场景。

一、Python网络爬虫的原理网络爬虫是一种模拟浏览器行为,通过访问网络资源并获取数据的程序。

Python的网络爬虫通常分为四个步骤:发送请求、获取响应、解析内容和存储数据。

1. 发送请求:Python中常用的发送网络请求的库有urllib和requests。

我们可以使用这些库发送HTTP请求,例如GET请求获取网页内容。

2. 获取响应:通过发送的请求,服务器会返回响应数据。

我们可以通过Python的库来获取并处理响应,如requests库的response对象。

3. 解析内容:一般情况下,响应数据是HTML、XML或JSON格式的文档。

我们可以使用一些解析库(如BeautifulSoup、lxml、json)来提取有用的信息,例如视频链接、标题、作者等。

4. 存储数据:获取到解析后的数据后,我们可以将其存储到本地文件或数据库中,以供后续分析和使用。

二、爬取视频的方法在网上爬取视频涉及到不同的来源和格式,我们需要针对性地选择相应的方法进行爬取。

1. 网页视频许多视频网站会将视频以网页的形式展现,我们可以通过分析网页结构并提取视频的URL来实现爬取。

常用的方法是使用正则表达式或XPath来定位视频链接,然后以适当的方式进行下载保存。

2. 视频API一些视频网站会提供API接口,以供开发者获取视频数据。

通过访问这些接口,我们可以直接获取到视频的链接、信息等。

我们需要根据各个网站提供的API文档,以及相应的认证或授权方式,编写适当的Python代码进行数据获取。

Python网络爬虫与数据可视化实战教程

Python网络爬虫与数据可视化实战教程第一章网络爬虫基础知识网络爬虫作为数据获取的重要工具,在实际应用中具有广泛的用途。

本章将介绍网络爬虫的基础知识,包括爬虫的工作原理、常用的爬虫框架以及如何选择爬取目标网站。

1.1 网络爬虫的工作原理网络爬虫的工作原理是模拟浏览器的行为,通过发送HTTP请求获取网页内容,并解析网页中的数据。

具体步骤包括发送请求、接收响应、解析HTML、数据处理等。

1.2 常用的爬虫框架Python提供了丰富的爬虫框架,其中Scrapy是最流行的框架之一。

本节将介绍Scrapy的基本用法,并通过实例演示如何使用Scrapy进行网页爬取。

1.3 确定爬取目标在进行网页爬取之前,需要确定爬取的目标网站。

本节将介绍如何选择合适的目标网站,并分析目标网站的页面结构,为后续的爬取工作做好准备。

第二章网络爬虫实战本章将通过实战案例介绍网络爬虫的实际应用。

首先,我们将使用Scrapy框架进行网页爬取,并将爬取的数据保存到本地文件中。

其次,我们将通过分析爬取的网页数据,提取出有用的信息,并对这些信息进行清洗和整理。

2.1 使用Scrapy进行网页爬取Scrapy是一款强大的Python爬虫框架,具有高度的可扩展性和灵活性。

本节将通过实例演示如何使用Scrapy框架进行网页爬取,并介绍Scrapy的基本组件和用法。

2.2 数据清洗与整理在网页爬取过程中,获取到的数据可能存在噪声和冗余。

本节将介绍如何对爬取的数据进行清洗和整理,提取出有用的信息,并将其保存到数据库中。

第三章数据可视化基础数据可视化是将数据转化为直观、易于理解的图形形式,有助于人们更好地理解数据的意义和关系。

本章将介绍数据可视化的基础知识,包括常用的数据可视化工具和图表类型。

3.1 数据可视化工具Python提供了多种数据可视化工具,包括Matplotlib、Seaborn和Plotly等。

本节将介绍这些常用的数据可视化工具的基本用法,并通过实例演示如何使用这些工具进行数据可视化。

python爬虫实战案例爬取爱奇艺vip视频

python爬虫实战案例爬取爱奇艺vip视频一、实战背景爱奇艺的VIP视频只有会员能看,普通用户只能看前6分钟。

比如加勒比海盗5的URL:/v_19rr7qhfg0.html#vfrm=19-9-0-1我们怎么免费看VIP视频呢?一个简单的方法,就是通过旋风视频VIP解析网站。

URL:/这个网站为我们提供了免费的视频解析,它的通用解析方式是:/index.php?url=[播放地址或视频id]比如,对于绣春刀这个电影,我们只需要在浏览器地址栏输入:/index.php?url=/v_19rr 7qhfg0.html#vfrm=19-9-0-1这样,我们就可以在线观看这些VIP视频了:但是这个网站只提供了在线解析视频的功能,没有提供下载接口,如果想把视频下载下来,我们就可以利用网络爬虫进行抓包,将视频下载下来。

二、实战升级分析方法相同,我们使用Fiddler进行抓包:我们可以看到,有用的请求并不多,我们逐条分析。

我们先看第一个请求返回的信息。

可以看到第一个请求是GET请求,没有什么有用的信息,继续看下一条。

我们看到,第二条GET请求地址变了,并且在返回的信息中,我们看到,这个网页执行了一个POST请求。

POST请求是啥呢?它跟GET请求正好相反,GET是从服务器获得数据,而POST请求是向服务器发送数据,服务器再根据POST请求的参数,返回相应的内容。

这个POST请求有四个参数,分别为time、key、url、type。

记住这个有用的信息,我们在抓包结果中,找一下这个请求,看看这个POST请求做了什么。

很显然,这个就是我们要找的POST请求,我们可以看到POST请求的参数以及返回的json格式的数据。

其中url存放的参数如下:xfsub_api\/url.php?key=02896e4af69fb18f70129b6046d7c718& amp;time=1505724557&url=http%3A%2F%2Fwww.iqiyi. com%2Fv_19rr7qhfg0.html&type=&xml=1这个信息有转义了,但是没有关系,我们手动提取一下,变成如下形式:xfsub_api/url.php?key=02896e4af69fb18f70129b6046d7c718& amp;time=1505724557&url=/v_19rr7 qhfg0.html&type=&xml=1我们已经知道了这个解析视频的服务器的域名,再把域名加上:/xfsub_api\url.php?key=02896e4af69fb18f7 0129b6046d7c718&time=1505724557&url=http://ww /v_19rr7qhfg0.html&type=&xml=1这里面存放的是什么东西?不会视频解析后的地址吧?我们有浏览器打开这个地址看一下:果然,我们可以看到视频地址近在眼前啊,URL如下:/vod.do?fmt=4&pno=1121& fid=1FEA2622E0BD9A1CA625FBE9B5A238A6&file=/c 1/2017/09/06_0/1FEA2622E0BD9A1CA625FBE9B5A238A6_ 20170906_1_1_705.mp4我们再打开这个视频地址:瞧,我们就这样得到了这个视频在服务器上的缓存地址。

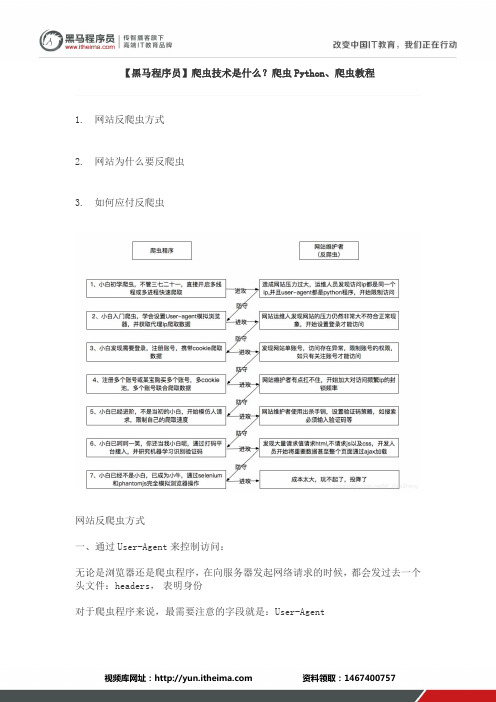

黑马程序员爬虫技术是什么?爬虫python、爬虫教程

【黑马程序员】爬虫技术是什么?爬虫Python、爬虫教程1.网站反爬虫方式2.网站为什么要反爬虫3.如何应付反爬虫网站反爬虫方式一、通过User-Agent来控制访问:无论是浏览器还是爬虫程序,在向服务器发起网络请求的时候,都会发过去一个头文件:headers,表明身份对于爬虫程序来说,最需要注意的字段就是:User-Agent很多网站都会建立user-agent白名单,只有属于正常范围的user-agent才能够正常访问。

解决方法:可以自己设置一下user-agent,或者更好的是,可以从一系列的user-agent里随机挑出一个符合标准的使用二、通过JS脚本来防止爬虫:举个例子:如果想爬取某个网站,在请求之前,它会有一个验证页面来验证你是否机器。

它是怎么实现的呢:* 他会通过js代码生成一大段随机的数字,然后要求浏览器通过js的运算得出这一串数字的和,再返回给服务器.解决方法:使用PhantomJS* PhantomJS是一个Python包,他可以在没有图形界面的情况下,完全模拟一个”浏览器“,js脚本验证什么的再也不是问题了。

三、通过IP限制来反爬虫:如果一个固定的ip在短暂的时间内,快速大量的访问一个网站,那自然会引起注意,管理员可以通过一些手段把这个ip给封了,爬虫程序自然也就做不了什么了。

解决方法:比较成熟的方式是:IP代理池简单的说,就是通过ip代理,从不同的ip进行访问,这样就不会被封掉ip了。

可是ip代理的获取本身就是一个很麻烦的事情,网上有免费和付费的,但是质量都层次不齐。

如果是企业里需要的话,可以通过自己购买集群云服务来自建代理池。

def get_ip_poll():'''模拟代理池返回一个字典类型的键值对,'''ip_poll = ["http://xx.xxx.xxx.xxx:8000","http://xx.xxx.xxx.xxx:8111","http://xx.xxx.xxx.xxx:802","http://xx.xxx.xxx.xxx:9922","http://xx.xxx.xxx.xxx:801"]addresses = {}addresses['http'] = ip_poll[random.randint(0, len(ip_poll))]return addresses四、通过robots.txt来限制爬虫:世界上做爬虫最大最好的就是Google了,搜索引擎本身就是一个超级大的爬虫,Google开发出来爬虫24h不间断的在网上爬取着新的信息,并返回给数据库,但是这些搜索引擎的爬虫都遵守着一个协议:robots.txtrobots.txt(统一小写)是一种存放于网站根目录下的ASCII编码的文本文件,它通常告诉网络搜索引擎的漫游器(又称网络蜘蛛),此网站中的哪些内容是不应被搜索引擎的漫游器获取的,哪些是可以被漫游器获取的。

爬虫跳过vip原理

爬虫跳过vip原理

爬虫跳过VIP原理主要是利用一些技术手段,模拟正常用户的行为,以绕过VIP会员的限制,实现免费获取VIP资源的目的。

具体实现方式有多种,下面列举其中几种常见的方法:

1.代理IP:通过使用代理IP,可以隐藏爬虫的真实IP地址,从而

避免被目标网站封禁。

同时,代理IP还可以模拟不同地区、不同网络环境的用户访问,增加爬虫的隐蔽性。

2.模拟用户行为:通过模拟正常用户的浏览行为,如使用不同的浏

览器、修改User-Agent、模拟点击、拖动等操作,使爬虫看起来更像是一个真实用户在操作,从而避免被检测到。

3.限制请求频率:为了避免被目标网站识别为恶意爬虫,需要限制

请求的频率和速度。

可以通过设置合理的延迟、使用随机间隔时间等方式,使爬虫的请求频率与正常用户的行为相匹配。

4.伪装请求头:修改请求头信息,如Referer、Accept-Encoding、

Accept-Language等,使其看起来像是正常用户的请求,从而避免被目标网站屏蔽。

5.使用虚拟机:通过在虚拟机上运行爬虫,可以模拟不同的操作系

统和浏览器环境,使爬虫更加难以被检测和识别。

黑马程序员 beego框架讲义

黑马程序员 beego框架讲义黑马程序员的Beego框架讲义是一份非常全面的教学材料,涵盖了Beego框架的各个方面,从基础到高级内容都有涉及。

Beego是一个基于Go语言的开源Web应用框架,它具有高性能、强大的功能和良好的扩展性,因此备受开发者青睐。

在黑马程序员的讲义中,你将会学习到如何使用Beego框架快速搭建Web应用,包括路由设计、控制器的使用、模板的渲染、ORM对象关系映射、中间件的使用等方面的知识。

讲义首先会介绍Beego框架的基本概念和特点,让学习者对框架有一个整体的认识。

接着会详细讲解Beego框架的安装和配置,包括环境搭建、项目初始化等内容,让学习者能够快速上手。

在讲义的后续部分,会深入讲解Beego框架中的路由设计,包括RESTful路由、参数传递等内容,让学习者掌握灵活的路由配置和设计。

除此之外,讲义还会介绍Beego框架中控制器的使用,包括如何编写控制器、处理请求和返回响应等内容。

同时也会涉及Beego框架中模板的使用,让学习者了解如何利用模板引擎进行页面渲染。

此外,讲义还会介绍Beego框架中ORM对象关系映射的使用方法,让学习者能够方便地操作数据库。

在讲义的高级内容部分,会涉及Beego框架中中间件的使用,包括日志中间件、权限验证中间件等,让学习者了解如何利用中间件增强Web应用的功能和安全性。

此外,讲义还会介绍Beego框架中的一些高级特性和扩展,如国际化、错误处理、WebSocket等,让学习者对Beego框架有一个更加全面的了解。

总的来说,黑马程序员的Beego框架讲义涵盖了Beego框架的方方面面,无论是初学者还是有一定经验的开发者,都能从中获得丰富的知识和经验。

这份讲义对于想要学习和掌握Beego框架的人来说是一份非常宝贵的学习资料。

黑马程序员python600集讲义

黑马程序员Python600集讲义一、简介1.1 Python的重要性Python作为一种高级编程语言,具有简洁易读、功能强大、可扩展性强等特点,在互联网、人工智能、数据分析等领域得到了广泛的应用。

学习Python编程对于IT从业者和计算机专业学生来说具有非常重要的意义。

1.2 黑马程序员Python600集讲义概述黑马程序员是国内知名的IT培训机构,其推出的Python600集讲义是一套系统全面的Python学习教材,内容涵盖了Python基础语法、面向对象编程、GUI编程、网络编程、数据库操作、数据分析等方面,适合初学者和有一定编程基础的学习者使用。

二、课程内容2.1 Python基础语法在Python600集讲义中,详细介绍了Python的基础语法,包括变量、数据类型、运算符、条件语句、循环语句等内容。

通过理论与实践结合的方式,学习者能够快速掌握Python编程的基本知识。

2.2 面向对象编程面向对象编程是Python编程中非常重要的一个方面,在Python600集讲义中,对面向对象编程的原理、概念、继承、多态等内容进行了详细讲解,并提供了大量的实例演练,帮助学习者深入理解面向对象编程的精髓。

2.3 GUI编程Python的GUI编程是学习者比较关注的一个方面,Python600集讲义中涵盖了Tkinter、PyQt等GUI编程工具的使用方法,通过实例演练,学习者能够掌握如何使用Python开发各种图形界面应用程序。

2.4 网络编程网络编程是Python应用十分广泛的一个领域,Python600集讲义中对socket编程、HTTP协议、网络爬虫等内容进行了系统讲解,帮助学习者掌握Python在网络编程方面的应用技巧。

2.5 数据库操作Python与数据库的结合也是学习者关注的重点之一,Python600集讲义中介绍了Python对MySQL、MongoDB等数据库的操作方法,包括连接、查询、插入、更新、删除等操作,帮助学习者掌握Python 与数据库交互的技能。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

【黑马程序员】爬虫视频教程

黑马程序员免费视频库:?2020sxkyk

1.网站反爬虫方式

2.网站为什么要反爬虫

3.如何应付反爬虫

网站反爬虫方式

一、通过User-Agent来控制访问:

无论是浏览器还是爬虫程序,在向服务器发起网络请求的时候,都会发过去一个

头文件:headers,表明身份

对于爬虫程序来说,最需要注意的字段就是:User-Agent

很多网站都会建立user-agent白名单,只有属于正常范围的user-agent才能够正常访问。

解决方法:

可以自己设置一下user-agent,或者更好的是,可以从一系列的user-agent里随机挑出一个符合标准的使用

二、通过JS脚本来防止爬虫:

举个例子:如果想爬取某个网站,在请求之前,它会有一个验证页面来验证你是否机器。

它是怎么实现的呢:

* 他会通过js代码生成一大段随机的数字,然后要求浏览器通过js的运算得出这一串数字的和,再返回给服务器.

解决方法:使用PhantomJS

* PhantomJS是一个Python包,他可以在没有图形界面的情况下,完全模拟一个”浏览器“,js脚本验证什么的再也不是问题了。

三、通过IP限制来反爬虫:

如果一个固定的ip在短暂的时间内,快速大量的访问一个网站,那自然会引起注意,管理员可以通过一些手段把这个ip给封了,爬虫程序自然也就做不了什么了。

解决方法:

比较成熟的方式是:IP代理池

简单的说,就是通过ip代理,从不同的ip进行访问,这样就不会被封掉ip了。

可是ip代理的获取本身就是一个很麻烦的事情,网上有免费和付费的,但是质量都层次不齐。

如果是企业里需要的话,可以通过自己购买集群云服务来自建代理池。

def get_ip_poll():

'''

模拟代理池

返回一个字典类型的键值对,

'''

ip_poll = ["http://xx.xxx.xxx.xxx:8000",

"http://xx.xxx.xxx.xxx:8111",

"http://xx.xxx.xxx.xxx:802",

"http://xx.xxx.xxx.xxx:9922",

"http://xx.xxx.xxx.xxx:801"]

addresses = {}

addresses['http'] = ip_poll[random.randint(0, len(ip_poll))]

return addresses

四、通过robots.txt来限制爬虫:

世界上做爬虫最大最好的就是Google了,搜索引擎本身就是一个超级大的爬虫,Google开发出来爬虫24h不间断的在网上爬取着新的信息,并返回给数据库,但是这些搜索引擎的爬虫都遵守着一个协议:robots.txt

robots.txt(统一小写)是一种存放于网站根目录下的ASCII编码的文本文件,它通常告诉网络搜索引擎的漫游器(又称网络蜘蛛),此网站中的哪些内容是不应被搜索引擎的漫游器获取的,哪些是可以被漫游器获取的。

因为一些系统中的URL是大小写敏感的,所以robots.txt的文件名应统一为小写。

robots.txt应放置于网站的根目录下。

如果想单独定义搜索引擎的漫游器访问子目录时的行为,那么可以将自定的设置合并到根目录下的robots.txt,或者使用robots元数据(Metadata,又称元数据)。

robots.txt协议并不是一个规范,而只是约定俗成的,所以并不能保证网站的隐私。

注意robots.txt是用字符串比较来确定是否获取URL,所以目录末尾有与没有斜杠“/”表示的是不同的URL。

robots.txt允许使用类似"Disallow: *.gif"这样的通配符[1][2]。

当然在特定情况下,比如说我们爬虫的获取网页的速度,和人类浏览网页是差不多的,这并不会给服务器造成太大的性能损失,在这种情况下,我们是可以不用恪守robots协议的。