数据挖掘分类实验详细报告概论

数据分析与挖掘实验报告

《数据挖掘》实验报告目录1.关联规则的基本概念和方法 (1)1.1数据挖掘 (1)1.1.1数据挖掘的概念 (1)1.1.2数据挖掘的方法与技术 (1)1.2关联规则 (2)1.2.1关联规则的概念 (2)1.2.2关联规则的实现——Apriori算法 (3)2.用Matlab实现关联规则 (5)2.1Matlab概述 (5)2.2基于Matlab的Apriori算法 (6)3.用java实现关联规则 (10)3.1java界面描述 (10)3.2java关键代码描述 (13)4、实验总结 (18)4.1实验的不足和改进 (18)4.2实验心得 (19)1.关联规则的基本概念和方法1.1数据挖掘1.1.1数据挖掘的概念计算机技术和通信技术的迅猛发展将人类社会带入到了信息时代。

在最近十几年里,数据库中存储的数据急剧增大。

数据挖掘就是信息技术自然进化的结果。

数据挖掘可以从大量的、不完全的、有噪声的、模糊的、随机的实际应用数据中,提取隐含在其中的,人们事先不知道的但又是潜在有用的信息和知识的过程。

许多人将数据挖掘视为另一个流行词汇数据中的知识发现(KDD)的同义词,而另一些人只是把数据挖掘视为知识发现过程的一个基本步骤。

知识发现过程如下:·数据清理(消除噪声和删除不一致的数据)·数据集成(多种数据源可以组合在一起)·数据转换(从数据库中提取和分析任务相关的数据)·数据变换(从汇总或聚集操作,把数据变换和统一成适合挖掘的形式)·数据挖掘(基本步骤,使用智能方法提取数据模式)·模式评估(根据某种兴趣度度量,识别代表知识的真正有趣的模式)·知识表示(使用可视化和知识表示技术,向用户提供挖掘的知识)。

1.1.2数据挖掘的方法与技术数据挖掘吸纳了诸如数据库和数据仓库技术、统计学、机器学习、高性能计算、模式识别、神经网络、数据可视化、信息检索、图像和信号处理以及空间数据分析技术的集成等许多应用领域的大量技术。

数据挖掘分类算法实验报告

数据挖掘分类算法实验报告数据挖掘分类算法实验报告一、引言数据挖掘是一种通过从大量数据中发现模式、规律和知识的过程。

在现代社会中,数据挖掘已经成为了一项重要的技术,广泛应用于各个领域。

其中,分类算法是数据挖掘中的一种重要技术,它可以将数据集中的样本分为不同的类别,从而实现对数据的有效分类和预测。

二、实验目的本实验旨在比较和评估常见的数据挖掘分类算法,包括决策树、朴素贝叶斯和支持向量机。

通过对多个数据集的实验,对这些算法的分类性能进行评估,并分析其适用场景和优缺点。

三、实验方法1. 数据集选择本实验选择了三个不同类型的数据集,包括鸢尾花数据集、心脏病数据集和手写数字数据集。

这些数据集代表了常见的分类问题,具有不同的特征和类别分布。

2. 特征选择和预处理在进行分类算法之前,需要对原始数据进行特征选择和预处理。

特征选择是为了从原始数据中选择出最具有代表性和区分度的特征,以提高分类算法的效果。

预处理包括数据清洗、缺失值处理和数据标准化等步骤,以确保数据的质量和一致性。

3. 算法实现和评估在实验中,我们使用Python编程语言实现了决策树、朴素贝叶斯和支持向量机三种分类算法。

对于每个数据集,我们将数据集划分为训练集和测试集,使用训练集对分类模型进行训练,然后使用测试集评估分类算法的性能。

评估指标包括准确率、召回率和F1值等。

四、实验结果与分析1. 鸢尾花数据集实验结果在对鸢尾花数据集进行分类实验时,我们发现决策树算法表现最好,准确率达到了95%以上,而朴素贝叶斯算法和支持向量机算法的准确率分别为90%和93%。

这说明决策树算法在处理鸢尾花数据集时具有较好的分类能力。

2. 心脏病数据集实验结果对于心脏病数据集,朴素贝叶斯算法表现最好,准确率超过了90%,而决策树算法和支持向量机算法的准确率分别为85%和88%。

这说明朴素贝叶斯算法在处理心脏病数据集时具有较好的分类效果。

3. 手写数字数据集实验结果在对手写数字数据集进行分类实验时,支持向量机算法表现最好,准确率超过了98%,而决策树算法和朴素贝叶斯算法的准确率分别为90%和92%。

数据挖掘实验报告二

实验二

一、基本原理

分类算法是解决分类问题的方法,是数据挖掘、机器学习和模式识别中一个重要的研究领域。

分类算法通过对已知类别训练集的分析,从中发现分类规则,以此预测新数据的类别。

分类算法的应用非常广泛,银行中风险评估、客户类别分类、文本检索和搜索引擎分类、安全领域中的入侵检测以及软件项目中的应用等。

二、实验目的:

掌握CART决策树构建分类模型。

三、实验内容

对所有窃漏电用户及真诚用户的电量、告警及线损数据和该用户在当天是否窃漏电的标识,按窃漏电评价指标进行处理并选取其中291个样本数据,得到专家样本,使用CART 决策树实现分类预测模型。

注意:数据的80%作为训练样本,剩下的20%作为测试样本。

四、实验步骤

1、对数据进行预处理

2、把数据随机分为两部分,一部分用于训练,一部分用于测试。

分成testData和trainData文件即测试数据和训练数据数据的80%作为训练样本,剩下的20%作为测试样本。

和构建的CART决策树模型分别对训练数据和测试数据进行分类。

构建的神经网络模型分别对训练数据和测试数据进行分类。

5、对比分析CART决策树和神经网络模型对数据处理的结果。

五、实验结果

六、思考与分析

尝试采用神经网络对数据进行分类,并与CART决策树的结果进行比较。

答:与神经网络相比,决策树可以很好地处理非数值型的数据,但是决策树对连续的数据(比如连续的数值型数据)不太擅长。

数据挖掘实验报告结论(3篇)

第1篇一、实验概述本次数据挖掘实验以Apriori算法为核心,通过对GutenBerg和DBLP两个数据集进行关联规则挖掘,旨在探讨数据挖掘技术在知识发现中的应用。

实验过程中,我们遵循数据挖掘的一般流程,包括数据预处理、关联规则挖掘、结果分析和可视化等步骤。

二、实验结果分析1. 数据预处理在实验开始之前,我们对GutenBerg和DBLP数据集进行了预处理,包括数据清洗、数据集成和数据变换等。

通过对数据集的分析,我们发现了以下问题:(1)数据缺失:部分数据集存在缺失值,需要通过插补或删除缺失数据的方法进行处理。

(2)数据不一致:数据集中存在不同格式的数据,需要进行统一处理。

(3)数据噪声:数据集中存在一些异常值,需要通过滤波或聚类等方法进行处理。

2. 关联规则挖掘在数据预处理完成后,我们使用Apriori算法对数据集进行关联规则挖掘。

实验中,我们设置了不同的最小支持度和最小置信度阈值,以挖掘出不同粒度的关联规则。

以下是实验结果分析:(1)GutenBerg数据集在GutenBerg数据集中,我们以句子为篮子粒度,挖掘了林肯演讲集的关联规则。

通过分析挖掘结果,我们发现:- 单词“the”和“of”在句子中频繁出现,表明这两个词在林肯演讲中具有较高的出现频率。

- “and”和“to”等连接词也具有较高的出现频率,说明林肯演讲中句子结构较为复杂。

- 部分单词组合具有较高的置信度,如“war”和“soldier”,表明在林肯演讲中提到“war”时,很可能同时提到“soldier”。

(2)DBLP数据集在DBLP数据集中,我们以作者为单位,挖掘了作者之间的合作关系。

实验结果表明:- 部分作者之间存在较强的合作关系,如同一研究领域内的作者。

- 部分作者在多个研究领域均有合作关系,表明他们在不同领域具有一定的学术影响力。

3. 结果分析和可视化为了更好地展示实验结果,我们对挖掘出的关联规则进行了可视化处理。

通过可视化,我们可以直观地看出以下信息:(1)频繁项集的分布情况:通过柱状图展示频繁项集的分布情况,便于分析不同项集的出现频率。

数据挖掘实验报告三

实验三一、实验原理K-Means算法是一种 cluster analysis 的算法,其主要是来计算数据聚集的算法,主要通过不断地取离种子点最近均值的算法。

在数据挖掘中,K-Means算法是一种cluster analysis的算法,其主要是来计算数据聚集的算法,主要通过不断地取离种子点最近均值的算法。

算法原理:(1) 随机选取k个中心点;(2) 在第j次迭代中,对于每个样本点,选取最近的中心点,归为该类;(3) 更新中心点为每类的均值;(4) j<-j+1 ,重复(2)(3)迭代更新,直至误差小到某个值或者到达一定的迭代步数,误差不变.空间复杂度o(N)时间复杂度o(I*K*N)其中N为样本点个数,K为中心点个数,I为迭代次数二、实验目的:1、利用R实现数据标准化。

2、利用R实现K-Meams聚类过程。

3、了解K-Means聚类算法在客户价值分析实例中的应用。

三、实验内容依据航空公司客户价值分析的LRFMC模型提取客户信息的LRFMC指标。

对其进行标准差标准化并保存后,采用k-means算法完成客户的聚类,分析每类的客户特征,从而获得每类客户的价值。

编写R程序,完成客户的k-means聚类,获得聚类中心与类标号,并统计每个类别的客户数四、实验步骤1、依据航空公司客户价值分析的LRFMC模型提取客户信息的LRFMC指标。

2、确定要探索分析的变量3、利用R实现数据标准化。

4、采用k-means算法完成客户的聚类,分析每类的客户特征,从而获得每类客户的价值。

五、实验结果客户的k-means聚类,获得聚类中心与类标号,并统计每个类别的客户数六、思考与分析使用不同的预处理对数据进行变化,在使用k-means算法进行聚类,对比聚类的结果。

kmenas算法首先选择K个初始质心,其中K是用户指定的参数,即所期望的簇的个数。

这样做的前提是我们已经知道数据集中包含多少个簇.1.与层次聚类结合经常会产生较好的聚类结果的一个有趣策略是,首先采用层次凝聚算法决定结果粗的数目,并找到一个初始聚类,然后用迭代重定位来改进该聚类。

数据挖掘分类实验详细报告

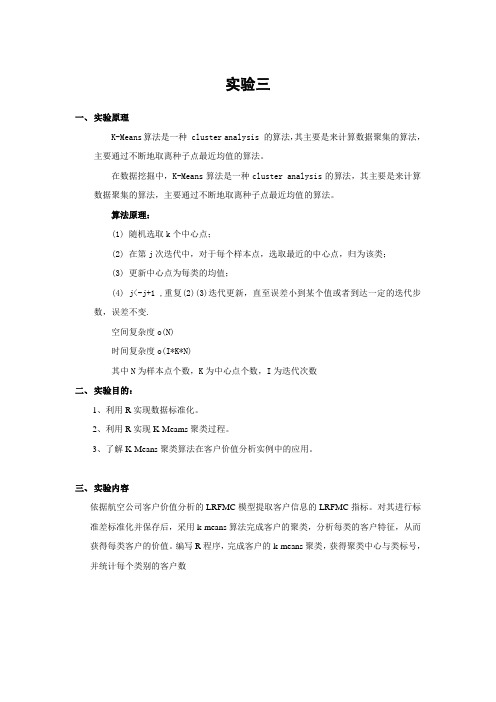

《数据挖掘分类实验报告》信息安全科学与工程学院1120362066 尹雪蓉数据挖掘分类过程(1)数据分析介绍本次实验为典型的分类实验,为了便于说明问题,弄清数据挖掘具体流程,我们小组选择了最经典的决策树算法进行具体挖掘实验。

(2)数据准备与预处理在进行数据挖掘之前,我们首先要对需要挖掘的样本数据进行预处理,预处理包括以下步骤:1、数据准备,格式统一。

将样本转化为等维的数据特征(特征提取),让所有的样本具有相同数量的特征,同时兼顾特征的全面性和独立性2、选择与类别相关的特征(特征选择)3、建立数据训练集和测试集4、对数据集进行数据清理在本次实验中,我们选择了ILPD (Indian Liver Patient Dataset) 这个数据集,该数据集已经具有等维的数据特征,主要包括Age、Gender、TB、DB、Alkphos、Sgpt、Sgot、TP、ALB、A/G、classical,一共11个维度的数据特征,其中与分类类别相关的特征为classical,它的类别有1,2两个值。

详见下表:本实验的主要思路是将该数据集分成训练集和测试集,对训练集进行训练生成模型,然后再根据模型对测试集进行预测。

数据集处理实验详细过程:●CSV数据源处理由于下载的原始数据集文件Indian Liver Patient Dataset (ILPD).csv(见下图)中间并不包含属性项,这不利于之后分类的实验操作,所以要对该文件进行处理,使用Notepad文件,手动将属性行添加到文件首行即可。

●平台数据集格式转换在后面数据挖掘的实验过程中,我们需要借助开源数据挖掘平台工具软件weka,该平台使用的数据集格式为arff,因此为了便于实验,在这里我们要对csv文件进行格式转换,转换工具为weka自带工具。

转换过程为:1、打开weka平台,点击”Simple CLI“,进入weka命令行界面,如下图所示:2、输入命令将csv文件导成arff文件,如下图所示:3、得到arff文件如下图所示:内容如下:建立数据训练集、校验集和测试集通过统计数据信息,可知整个数据集带有classical标号的数据一共有583行,为了避免数据的过度拟合,我们要把数据训练集、校验集、测试集分开。

数据挖掘分类实验报告

数据挖掘分类实验报告《数据挖掘分类实验报告》数据挖掘是一门利用统计学、机器学习和人工智能等技术,从大量的数据中发现隐藏的模式和知识的学科。

在数据挖掘中,分类是一种常见的任务,它通过对数据进行分析和学习,将数据划分到不同的类别中。

本文将通过一个数据挖掘分类实验报告,介绍数据挖掘分类的实验过程和结果。

实验数据集选取了一个包含多个特征和标签的数据集,以便进行分类任务。

首先,我们对数据集进行了数据预处理,包括数据清洗、特征选择、特征变换等步骤,以确保数据的质量和适用性。

接着,我们将数据集划分为训练集和测试集,用训练集训练分类模型,并用测试集评估模型的性能。

在实验中,我们尝试了多种分类算法,包括决策树、支持向量机、朴素贝叶斯等。

通过对比不同算法的准确率、精确率、召回率和F1值等指标,我们评估了各个算法在该数据集上的表现。

实验结果显示,不同算法在不同数据集上表现出不同的性能,决策树算法在某些数据集上表现较好,而支持向量机在另一些数据集上表现更优秀。

此外,我们还进行了特征重要性分析,通过对特征的重要性进行排序,找出对分类任务最具有区分性的特征。

这有助于我们理解数据集的特点,并为进一步优化分类模型提供了指导。

综合实验结果,我们得出了一些结论和启示。

首先,不同的分类算法适用于不同的数据集和任务,需要根据具体情况选择合适的算法。

其次,特征选择和特征重要性分析对于提高分类模型的性能至关重要,需要充分利用数据挖掘技术进行特征工程。

最后,数据挖掘分类实验是一个迭代的过程,需要不断尝试和调整,以优化分类模型的性能。

通过本次数据挖掘分类实验报告,我们深入了解了数据挖掘分类的实验过程和方法,对数据挖掘技术有了更深入的理解,也为实际应用中的分类任务提供了一定的指导和启示。

希望本文能够对读者有所启发,促进数据挖掘领域的研究和实践。

数据挖掘分类实验详细报告

数据挖掘分类实验详细报告一、引言数据挖掘是从大量数据中提取隐藏在其中的有价值信息的过程。

数据挖掘分类实验是数据挖掘领域中的一项重要任务,其目标是根据已有的数据样本,构建一个能够准确分类未知数据的分类模型。

本报告旨在详细描述数据挖掘分类实验的过程、方法和结果。

二、实验背景本次实验的数据集是一个关于电子商务的数据集,包含了一些与电子商务相关的特征和一个分类标签。

我们的任务是根据这些特征,预测一个电子商务网站上的用户是否会购买某个产品。

三、数据预处理在进行数据挖掘实验之前,我们需要对数据进行预处理。

首先,我们检查数据集是否存在缺失值或异常值。

对于缺失值,我们可以选择删除含有缺失值的样本,或者使用插补方法进行填充。

对于异常值,我们可以选择删除或者进行修正。

其次,我们对数据进行特征选择,选择与分类目标相关性较高的特征。

最后,我们对数据进行归一化处理,以消除不同特征之间的量纲差异。

四、特征工程特征工程是指根据领域知识和数据分析的结果,构建新的特征或者对原有特征进行转换,以提高分类模型的性能。

在本次实验中,我们根据电子商务领域的经验,构建了以下特征:1. 用户年龄:将用户的年龄分为青年、中年和老年三个年龄段,并进行独热编码。

2. 用户性别:将用户的性别进行独热编码。

3. 用户所在地区:将用户所在地区进行独热编码。

4. 用户购买历史:统计用户过去一段时间内的购买次数、购买金额等指标。

五、模型选择与训练在本次实验中,我们选择了三种常用的分类模型进行训练和比较:决策树、支持向量机和随机森林。

1. 决策树:决策树是一种基于树结构的分类模型,通过划分特征空间,将数据样本划分到不同的类别中。

2. 支持向量机:支持向量机是一种通过在特征空间中构建超平面,将不同类别的样本分开的分类模型。

3. 随机森林:随机森林是一种基于决策树的集成学习方法,通过构建多个决策树,最终根据投票结果进行分类。

我们将数据集划分为训练集和测试集,使用训练集对模型进行训练,使用测试集评估模型的性能。

数据挖掘实验报告

数据挖掘实验报告一、实验背景。

数据挖掘是指从大量的数据中发现隐藏的、有价值的信息的过程。

在当今信息爆炸的时代,数据挖掘技术越来越受到重视,被广泛应用于商业、科研、医疗等领域。

本次实验旨在通过数据挖掘技术,对给定的数据集进行分析和挖掘,从中发现有用的信息并进行分析。

二、实验目的。

本次实验的目的是通过数据挖掘技术,对给定的数据集进行分析和挖掘,包括数据的预处理、特征选择、模型建立等步骤,最终得出有用的信息并进行分析。

三、实验内容。

1. 数据预处理。

在本次实验中,首先对给定的数据集进行数据预处理。

数据预处理是数据挖掘过程中非常重要的一步,包括数据清洗、数据变换、数据规约等。

通过数据预处理,可以提高数据的质量,为后续的分析和挖掘奠定基础。

2. 特征选择。

在数据挖掘过程中,特征选择是非常关键的一步。

通过特征选择,可以筛选出对挖掘目标有用的特征,减少数据维度,提高挖掘效率。

本次实验将对数据集进行特征选择,并分析选取的特征对挖掘结果的影响。

3. 模型建立。

在数据挖掘过程中,模型的建立是非常重要的一步。

通过建立合适的模型,可以更好地挖掘数据中的信息。

本次实验将尝试不同的数据挖掘模型,比较它们的效果,并选取最优的模型进行进一步分析。

4. 数据挖掘分析。

最终,本次实验将对挖掘得到的信息进行分析,包括数据的趋势、规律、异常等。

通过数据挖掘分析,可以为实际问题的决策提供有力的支持。

四、实验结果。

经过数据预处理、特征选择、模型建立和数据挖掘分析,我们得到了如下实验结果:1. 数据预处理的结果表明,经过数据清洗和变换后,数据质量得到了显著提高,为后续的分析和挖掘奠定了基础。

2. 特征选择的结果表明,选取的特征对挖掘结果有着重要的影响,不同的特征组合会对挖掘效果产生不同的影响。

3. 模型建立的结果表明,经过比较和分析,我们选取了最优的数据挖掘模型,并对数据集进行了进一步的挖掘。

4. 数据挖掘分析的结果表明,我们发现了数据中的一些有意义的趋势和规律,这些信息对实际问题的决策具有重要的参考价值。

数据挖掘实例实验报告(3篇)

第1篇一、实验背景随着大数据时代的到来,数据挖掘技术逐渐成为各个行业的重要工具。

数据挖掘是指从大量数据中提取有价值的信息和知识的过程。

本实验旨在通过数据挖掘技术,对某个具体领域的数据进行挖掘,分析数据中的规律和趋势,为相关决策提供支持。

二、实验目标1. 熟悉数据挖掘的基本流程,包括数据预处理、特征选择、模型选择、模型训练和模型评估等步骤。

2. 掌握常用的数据挖掘算法,如决策树、支持向量机、聚类、关联规则等。

3. 应用数据挖掘技术解决实际问题,提高数据分析和处理能力。

4. 实验结束后,提交一份完整的实验报告,包括实验过程、结果分析及总结。

三、实验环境1. 操作系统:Windows 102. 编程语言:Python3. 数据挖掘库:pandas、numpy、scikit-learn、matplotlib四、实验数据本实验选取了某电商平台用户购买行为数据作为实验数据。

数据包括用户ID、商品ID、购买时间、价格、商品类别、用户年龄、性别、职业等。

五、实验步骤1. 数据预处理(1)数据清洗:剔除缺失值、异常值等无效数据。

(2)数据转换:将分类变量转换为数值变量,如年龄、性别等。

(3)数据归一化:将不同特征的范围统一到相同的尺度,便于模型训练。

2. 特征选择(1)相关性分析:计算特征之间的相关系数,剔除冗余特征。

(2)信息增益:根据特征的信息增益选择特征。

3. 模型选择(1)决策树:采用CART决策树算法。

(2)支持向量机:采用线性核函数。

(3)聚类:采用K-Means算法。

(4)关联规则:采用Apriori算法。

4. 模型训练使用训练集对各个模型进行训练。

5. 模型评估使用测试集对各个模型进行评估,比较不同模型的性能。

六、实验结果与分析1. 数据预处理经过数据清洗,剔除缺失值和异常值后,剩余数据量为10000条。

2. 特征选择通过相关性分析和信息增益,选取以下特征:用户ID、商品ID、购买时间、价格、商品类别、用户年龄、性别、职业。

数据挖掘实验报告

数据挖掘实验报告一、实验背景随着信息技术的快速发展,数据量呈爆炸式增长,如何从海量的数据中提取有价值的信息成为了一个重要的研究课题。

数据挖掘作为一种从大量数据中发现潜在模式和知识的技术,已经在众多领域得到了广泛的应用,如市场营销、金融风险预测、医疗诊断等。

本次实验旨在通过对实际数据的挖掘和分析,深入理解数据挖掘的基本流程和方法,并探索其在解决实际问题中的应用。

二、实验目的1、熟悉数据挖掘的基本流程,包括数据预处理、数据探索、模型选择与训练、模型评估等。

2、掌握常见的数据挖掘算法,如决策树、聚类分析、关联规则挖掘等,并能够根据实际问题选择合适的算法。

3、通过实际数据的挖掘实验,提高对数据的分析和处理能力,培养解决实际问题的思维和方法。

三、实验数据本次实验使用了一份关于客户消费行为的数据集,包含了客户的基本信息(如年龄、性别、职业等)、消费记录(如购买的商品类别、购买金额、购买时间等)以及客户的满意度评价等。

数据总量为 10000 条,数据格式为 CSV 格式。

四、实验环境操作系统:Windows 10编程语言:Python 37主要库:Pandas、NumPy、Scikitlearn、Matplotlib 等五、实验步骤1、数据预处理数据清洗:首先,对数据进行清洗,处理缺失值和异常值。

对于缺失值,根据数据的特点,采用了均值填充、中位数填充等方法进行处理;对于异常值,通过数据可视化和统计分析的方法进行识别,并根据具体情况进行删除或修正。

数据转换:将数据中的分类变量进行编码,如将性别(男、女)转换为 0、1 编码,将职业(教师、医生、工程师等)转换为独热编码。

数据标准化:对数据进行标准化处理,使得不同特征之间具有可比性,采用了 Zscore 标准化方法。

2、数据探索数据可视化:通过绘制柱状图、箱线图、散点图等,对数据的分布、特征之间的关系进行可视化分析,以便更好地理解数据。

统计分析:计算数据的均值、中位数、标准差、相关系数等统计量,对数据的基本特征进行分析。

数据挖掘实验二:实验报告

一、实验说明及目的1、使用真实数据进行数据挖掘实验,实验前进行数据的预处理。

2、训练一些不同类型的模型(具体类型可以讨论),与此同时分析哪些参数将对支持向量机(SVM)模型的性能产生影响。

3、通过实验来分析预测,将其他一些属性作为森林覆盖类型(Cover_Type 属性)的模型输入所产生的效果。

原始数据和数据的描述见网址/databases/covertype/covertype.html4、该实验将使学生理解完成一次真实数据预处理以及在数据挖掘过程中对属性、数据覆盖类型等方面的分析工程。

二、实验具体任务及其说明1、数据预处理工作(1)数据样本的生成:根据原始数据集生成统一的随机样本,样本数据量大约是原始数据量的10%,要求使用不重复抽样。

(任务1)(2)森林覆盖值的映射:变换不同种类的属性,将森林覆盖值2映射到0,将其他值所有森林覆盖值(1,3,4,5,6,7)映射到1。

(任务2)(3)数据预处理技巧:自行决定是否需要其他的数据预处理,注意某些Weka软件的使用技巧,如一些输入输出格式问题。

有时某些方法也做必要的调整,在某些情况下必须对数据有明确的预处理,做数据预处理时可以查看Weka软件针对该技巧或方法的描述。

(4)预处理说明:原始数据集非常大,具有7种类型的森林覆盖,检查整个数据集装载到Weka软件是发生的情况,如果机器内存耗尽,可以尽量增大堆的大小试试。

Weka使用指南对此有描述如何操作。

)2、模型训练工作(1)使用Weka分类器的评价工具进行预测。

使用Naïve Bayes 分类器对抽样样本进行训练以预测变换的森林覆盖类型(即是映射到种类0还是1),使用10层交叉验证来评估变换的模型,Weka软件中自带有对其分类器的表现评价器,使用自带的评价器来确定变换模型的精确度和变动率指标(ROC)。

(任务3)(2)对SVM模型进行训练:使用Weka软件的SMO分类器对支持向量机(SVM)模型进行训练,训练2种形式的SVM模型,一种是带多项式核函数的SVM模型,另一种是带径向基核函数(RBF Kernel)的SVM模型。

数据挖掘weka数据分类实验报告

一、实验目的使用数据挖掘中的分类算法,对数据集进行分类训练并测试。

应用不同的分类算法,比较他们之间的不同。

与此同时了解Weka平台的基本功能与使用方法。

二、实验环境实验采用Weka 平台,数据使用Weka安装目录下data文件夹下的默认数据集iris.arff。

Weka是怀卡托智能分析系统的缩写,该系统由新西兰怀卡托大学开发。

Weka使用Java 写成的,并且限制在GNU通用公共证书的条件下发布。

它可以运行于几乎所有操作平台,是一款免费的,非商业化的机器学习以及数据挖掘软件。

Weka提供了一个统一界面,可结合预处理以及后处理方法,将许多不同的学习算法应用于任何所给的数据集,并评估由不同的学习方案所得出的结果。

三、数据预处理Weka平台支持ARFF格式和CSV格式的数据。

由于本次使用平台自带的ARFF格式数据,所以不存在格式转换的过程。

实验所用的ARFF格式数据集如图1所示图1 ARFF格式数据集(iris.arff)对于iris数据集,它包含了150个实例(每个分类包含50个实例),共有sepal length、sepal width、petal length、petal width和class五种属性。

期中前四种属性为数值类型,class属性为分类属性,表示实例所对应的的类别。

该数据集中的全部实例共可分为三类:Iris Setosa、Iris Versicolour和Iris Virginica。

实验数据集中所有的数据都是实验所需的,因此不存在属性筛选的问题。

若所采用的数据集中存在大量的与实验无关的属性,则需要使用weka平台的Filter(过滤器)实现属性的筛选。

实验所需的训练集和测试集均为iris.arff。

四、实验过程及结果应用iris数据集,分别采用LibSVM、C4.5决策树分类器和朴素贝叶斯分类器进行测试和评价,分别在训练数据上训练出分类模型,找出各个模型最优的参数值,并对三个模型进行全面评价比较,得到一个最好的分类模型以及该模型所有设置的最优参数。

数据挖掘分类实验报告

数据挖掘分类实验报告数据挖掘分类实验报告引言:数据挖掘是一项重要的技术,通过分析和挖掘数据中的模式、关联和趋势,可以帮助我们了解数据背后的隐藏信息。

其中,数据挖掘分类是一种常见的数据挖掘任务,旨在将数据集中的样本划分到不同的类别中。

本实验报告将介绍我们在数据挖掘分类实验中所采用的方法和结果。

一、数据集介绍我们选择了一个包含各种特征的数据集,其中包括数值型、离散型和文本型特征。

该数据集用于预测一家电子商务网站上的用户是否会购买某个产品。

数据集中共有1000个样本,每个样本包含20个特征和一个目标变量。

我们的目标是根据这些特征预测用户是否会购买产品。

二、数据预处理在进行分类实验之前,我们首先对数据进行了预处理。

预处理的过程包括缺失值处理、特征选择和特征缩放。

我们使用均值填充的方法来处理缺失值,同时采用方差选择法对特征进行选择,以提高分类模型的性能。

此外,我们还对数值型特征进行了标准化处理,以消除不同特征之间的量纲差异。

三、分类模型选择在本实验中,我们尝试了多种分类算法,并比较它们在数据集上的性能。

我们选择了决策树、支持向量机和随机森林这三种经典的分类算法作为我们的候选模型。

决策树算法基于对特征进行逐层划分,通过构建决策树来实现分类。

支持向量机算法通过在特征空间中找到一个最优超平面来实现分类。

随机森林算法则是通过构建多个决策树,并通过投票的方式来决定最终的分类结果。

四、实验结果与分析我们将数据集分为训练集和测试集,其中训练集占总样本数的70%,测试集占30%。

通过使用不同的分类算法在训练集上进行训练,并在测试集上进行测试,我们得到了以下结果。

决策树算法在测试集上的准确率为80%,召回率为75%。

这意味着该算法能够正确分类80%的样本,并且能够找到75%的正样本。

支持向量机算法在测试集上的准确率为85%,召回率为80%。

相比之下,随机森林算法在测试集上的准确率达到了90%,召回率为85%。

由此可见,随机森林算法在本实验中表现出了最佳的分类性能。

数据挖掘实验报告(两篇)2024

引言概述:数据挖掘是一项广泛应用于各个行业的技术,通过对大数据的处理和分析,可以发现隐藏在数据中的有价值信息。

本文是数据挖掘实验报告(二),将对具体的数据挖掘实验进行详细的阐述和分析。

本实验主要聚焦于数据预处理、特征选择、模型建立和评估等关键步骤,以增加对实验过程和结果的理解,提高实验的可靠性和准确性。

通过实验结果的分析和总结,可以帮助读者更好地理解数据挖掘的方法和技术,并为实际应用提供参考和指导。

正文内容:1. 数据预处理在进行数据挖掘之前,首先需要对原始数据进行预处理。

数据预处理的目的是清洗数据、处理缺失值和异常值等数据问题,以确保数据的质量和准确性。

在本实验中,我们采用了多种方法对数据进行预处理。

其中包括数据清洗、缺失值处理和异常值检测等。

具体的操作包括了数据去重、数据标准化、缺失值的填补和异常值的处理等。

2. 特征选择特征选择是数据挖掘的关键步骤之一,它的目的是从原始数据中选择出对问题解决有价值的特征。

在本实验中,我们通过使用相关性分析、方差选择和递归特征消除等方法,对原始数据进行特征选择。

通过分析特征与目标变量之间的关系,我们可以得出最有价值的特征,从而减少计算复杂度和提高模型准确性。

3. 模型建立模型建立是数据挖掘实验的核心步骤之一。

在本实验中,我们采用了多种模型进行建立,包括决策树、支持向量机、朴素贝叶斯等。

具体而言,我们使用了ID3决策树算法、支持向量机算法和朴素贝叶斯算法等进行建模,并通过交叉验证和网格搜索等方法选择最佳的模型参数。

4. 模型评估模型评估是对建立的模型进行准确性和可靠性评估的过程。

在本实验中,我们采用了多种评估指标进行模型评估,包括准确率、召回率、F1分数等。

通过对模型的评估,我们可以得出模型的准确性和可靠性,并进一步优化模型以达到更好的效果。

5. 结果分析与总结总结:本文是对数据挖掘实验进行详细阐述和分析的实验报告。

通过对数据预处理、特征选择、模型建立和评估等关键步骤的分析和总结,我们得出了对数据挖掘方法和技术的深入理解。

数据挖掘实验报告

《数据挖掘》实验报告1

实验序号:1 实验项目名称:数据挖掘入门及C4.5算法

由classifier output中的correctly classified instances项得知该模型的准确度有96%。

本实验分析的是根据花瓣的宽度和长度不同判断出不同种类的鸢尾花。

例如,当宽度小于0.6时,即为iris-setosa,当花瓣宽度小于等于1.7而长度小于等于4.9时,为iris-versicolor.

2、使用RandomTree算法得到的决策树如下

可见,该模型的正确率为92%,且得到的决策树较之J48算法得到的决策树更为复杂,正确率更低,没有达到最优化。

五、分析与讨论

1、C4.5算法的优点:产生的分类规则易于理解,准确率较高。

缺点:在构造树的过程中,需要对数据集进行多次的顺序扫描和排序,因而导致算法的低效。

此外,C4.5只适合于能够驻留于内存的数据集,当训练集大得无法在内存容纳时程序无法运行。

2、剪枝有以下几点原则:①正确性:因为它能够“剪去”搜索树中的一些“枝条”,

《数据挖掘》实验报告2实验序号:4 实验项目名称:Apriori。

数据挖掘实验报告

数据挖掘实验报告一、实验背景数据挖掘作为一种从大量数据中发现未知、隐藏和有用信息的技术,正日益受到广泛关注。

在本次实验中,我们尝试运用数据挖掘方法对给定的数据集进行分析和挖掘,以期能够从中获取有益的知识和见解。

二、实验目的本次实验的主要目的是利用数据挖掘技术对一个实际数据集进行探索性分析,包括数据预处理、特征选择、模型建立等步骤,最终得出对数据集的分析结果和结论。

三、实验数据集本次实验使用的数据集为XXX数据集,包含了XXX个样本和XXX个特征。

数据集中涵盖了XXX方面的信息,包括但不限于XXX、XXX、XXX等。

四、实验步骤1. 数据预处理在数据挖掘过程中,数据预处理是至关重要的一步。

我们首先对原始数据进行清洗和处理,包括缺失值处理、异常值处理、数据转换等,以确保数据的准确性和可靠性。

2. 特征选择特征选择是指从所有特征中选择最具代表性和价值的特征,以提高模型的效果和准确性。

我们通过相关性分析、主成分分析等方法对特征进行筛选和优化,选取最具信息量的特征用于建模。

3. 模型建立在特征选择完成后,我们利用机器学习算法建立模型,对数据集进行训练和预测。

常用的模型包括决策树、支持向量机、神经网络等,我们根据实际情况选择合适的模型进行建模。

4. 模型评估建立模型后,我们需要对模型进行评估和验证,以确保模型的泛化能力和准确性。

我们采用交叉验证、ROC曲线、混淆矩阵等方法对模型进行评估,得出模型的性能指标和结果。

五、实验结果与分析经过一系列步骤的数据挖掘分析,我们得出了如下结论:XXX。

我们发现XXX,这表明XXX。

同时,我们还对模型的准确性和可靠性进行了评估,结果显示XXX,证明了我们建立的模型具有较好的预测能力和泛化能力。

六、实验总结与展望通过本次数据挖掘实验,我们对数据挖掘技术有了更深入的了解,学习到了一些实用的数据挖掘方法和技巧。

未来,我们将进一步探究数据挖掘领域的新技术和新方法,提高数据挖掘的应用能力和实践水平。

数据挖掘分类实验详细报告

数据挖掘分类实验详细报告《数据挖掘分类实验报告》信息安全科学与工程学院1120362066尹雪蓉数据挖掘分类过程(1)数据分析介绍本次实验为典型的分类实验,为了便于说明问题,弄清数据挖掘具体流程,我们小组选择了最经典的决策树算法进行具体挖掘实验。

(2)数据准备与预处理在进行数据挖掘之前,我们首先要对需要挖掘的样本数据进行预处理,预处理包括以下步骤:1、数据准备,格式统一。

将样本转化为等维的数据特征(特征提取),让所有的样本具有相同数量的特征,同时兼顾特征的全面性和独立性2、选择与类别相关的特征(特征选择)3、建立数据训练集和测试集4、对数据集进行数据清理在本次实验中,我们选择了ILPD (Indian Liver Patient Dataset) 这个数据集,该数据集已经具有等维的数据特征,主要包括Age、Gender、TB、DB、Alkphos、Sgpt、Sgot、TP、ALB、A/G、classical,一共11个维度的数据特征,其中与分类类别相关的特征为classical,它的类别有1,2两个值。

详见下表:本实验的主要思路是将该数据集分成训练集和测试集,对训练集进行训练生成模型,然后再根据模型对测试集进行预测。

数据集处理实验详细过程:●CSV数据源处理由于下载的原始数据集文件Indian Liver Patient Dataset (ILPD).csv(见下图)中间并不包含属性项,这不利于之后分类的实验操作,所以要对该文件进行处理,使用Notepad文件,手动将属性行添加到文件首行即可。

●平台数据集格式转换在后面数据挖掘的实验过程中,我们需要借助开源数据挖掘平台工具软件weka,该平台使用的数据集格式为arff,因此为了便于实验,在这里我们要对csv文件进行格式转换,转换工具为weka自带工具。

转换过程为:1、打开weka平台,点击”Simple CLI“,进入weka命令行界面,如下图所示:2、输入命令将csv文件导成arff文件,如下图所示:3、得到arff文件如下图所示:内容如下:建立数据训练集、校验集和测试集通过统计数据信息,可知整个数据集带有classical标号的数据一共有583行,为了避免数据的过度拟合,我们要把数据训练集、校验集、测试集分开。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

《数据挖掘分类实验报告》

信息安全科学与工程学院

1120362066 尹雪蓉数据挖掘分类过程

(1)数据分析介绍

本次实验为典型的分类实验,为了便于说明问题,弄清数据挖掘具体流程,我们小组选择了最经典的决策树算法进行具体挖掘实验。

(2)数据准备与预处理

在进行数据挖掘之前,我们首先要对需要挖掘的样本数据进行预处理,预处理包括以下步骤:

1、数据准备,格式统一。

将样本转化为等维的数据特征(特征提取),让所有的样

本具有相同数量的特征,同时兼顾特征的全面性和独立性

2、选择与类别相关的特征(特征选择)

3、建立数据训练集和测试集

4、对数据集进行数据清理

在本次实验中,我们选择了ILPD (Indian Liver Patient Dataset) 这个数据集,该数据集已经具有等维的数据特征,主要包括Age、Gender、TB、DB、Alkphos、Sgpt、Sgot、TP、ALB、A/G、classical,一共11个维度的数据特征,其中与分类类别相关的特征为classical,它的类别有1,2两个值。

详见下表:

本实验的主要思路是将该数据集分成训练集和测试集,对训练集进行训练生成模型,然后再根据模型对测试集进行预测。

数据集处理实验详细过程:

●CSV数据源处理

由于下载的原始数据集文件Indian Liver Patient Dataset (ILPD).csv(见下图)中间并不包含属性项,这不利于之后分类的实验操作,所以要对该文件进行处理,使用Notepad文件,手动将属性行添加到文件首行即可。

●平台数据集格式转换

在后面数据挖掘的实验过程中,我们需要借助开源数据挖掘平台工具软件weka,该平台使用的数据集格式为arff,因此为了便于实验,在这里我们要对csv文件进行格式转换,转换工具为weka自带工具。

转换过程为:

1、打开weka平台,点击”Simple CLI“,进入weka命令行界面,如下图所示:

2、输入命令将csv文件导成arff文件,如下图所示:

3、得到arff文件如下图所示:

内容如下:

建立数据训练集、校验集和测试集

通过统计数据信息,可知整个数据集带有classical标号的数据一共有583行,为了避免数据的过度拟合,我们要把数据训练集、校验集、测试集分开。

在本次实验中,我们的拆分

策略是训练集500行,校验集和测试集83行,由于数据集中有416行的classical标识为1,167行的classical标识为2,为了能在训练分类模型时有更加全面的信息,我们将167条classical标识为2与333行classical标识为1的数据全部作为模型训练集,而剩下的83条classical为1的数据将全部用于测试集,这是因为在校验的时候,两种类标号的数据作用区别不大,但是在训练数据模型是,需要更加全面的信息,特别是不同类标号的数据的合理比例对训练模型的质量有较大的影响。

在做预测测试之前,需要将测试集的分类标号去掉作为预测数据集。

数据训练集、校验集和测试集建立步骤:

1、复制原始数据集arff文件,作为总的训练数据集,文件名称改为build_model.arff。

如下图所示:

2、根据拆分策略,从原始数据集DataSet_original.arff文件中的数据里面,选取分类

标号为1的数据83作为校验数据集,该数据集文件名为validate_data.arff。

3、将剩下的DataSet_orginal.arff文件改名为train_data.arff

4、由于原始数据集都是有类标号的数据集,为了方便进行预测测试,我们将校验数

据集复制一份后,将分类标号去掉加入?,作为预测数据集。

如图所示:

数据清理

在进行数据搜集和整理的过程中,我们发现如果属性的类型为数值型的话,在做关联分析时将不能得到结果,因为关联分析无法处理数值型数据。

由于现实世界中数据大体上都是不完整,不一致的脏数据,无法直接进行数据挖掘或挖掘结果差强人意。

为了提高数据挖掘的质量,需要对数据进行预处理,预处理有多种方法:数据清理、数据集成、数据变换、数据归约等。

常用的数据清理主要分为两类:空缺值的处理和噪声数据处理。

空缺值处理主要是使用最可能的值填充空缺值,比如可以用回归、贝叶斯形式化方法工具或判定树归纳等确定空缺值。

这类方法依靠现有的数据信息来推测空缺值,使空缺值有更大的机会保持与其他属性之间的联系。

同时还可以用一个全局常量替换空缺值、使用属性的平均值填充空缺值或将所有元组按某些属性分类,然后用同一类中属性的平均值填充空缺值。

不过这些方法有局限性,当空缺值很多的情况下,这些方法的使用可能会误导挖掘结果;除了空缺值处理还有噪声数据处理,噪声是一个测量变量中的随机错误或偏差,包括错误的值或偏离期望的孤立点值。

常用分箱、回归、计算机检查和人工检查结合、聚类等方法进行噪音处理。

在本次试验中,我们对数据集进行了数据处理后使得需要分析的数据变为分类型,这样就可以关联分析得以顺利进行,在具体执行的过程中我们利用了weka平台自带的数据预处理库实现数据预处理。

具体实验过程见下文。

(3)实验过程

A、环境搭建

本实验的数据集选择Indian Liver Patient Dataset (ILPD),借助数据挖掘平台Weka3.6.9,编程环境为Eclipse + JDK7

1、数据集获取

选择Indian Liver Patient Dataset (ILPD)这个数据集,进入下载页面下载数据集

(详见下图)

2、Weka安装

下载Weka安装包weka-3-6-9-x64.exe,运行安装即可。

(如下图)安装界面:

安装完成:

Weka工作界面:

B、实验步骤

1、开发平台搭建

打开eclipse,点击File->New->Project…,新建Java Project工程,如下图所示:

新建一个java工程dataminingtest,配置build path将所需要的weka.jar和其它一些需要的jar包,导入该工程,如下图所示:

备注:由于调用weka算法时候可能会产生jar包依赖关系错误,需要额外加入一些jar包。

2、导入数据

将数据准备时的arff文件导入,数据打印出来后,如下图所示:

3、数据预处理

在本次试验中,我们使用weka的Filter作为数据预处理工具,该工具的一般流程是:实例化过滤器->传入过滤器参数->通过eFilter使用过滤器。

由于本实验采用的决策树J48算法的数据集需要离散化,故采用离散化过滤。

实现结果如下图所示:

过滤完成后的数据集变化情况如下图所示:

备注:由于最后一列classical的类型为Numeric,在weka平台上需要进行nominal类型转换。

转换方式也是使用Filter,效果如下图所示:

4、选择算法,建立模型

为了获取最优化的模型,需要对决策的参数进行配置,这里我们借助weka平台

通过修改树的实例/叶子节点数来获取最优的模型。

实验步骤如下所示:

1、打开weka软件平台,点击进入Explorer,选择open file…,打开train_data.arff

文件,如下图所示:

2、在Filter区域选择choose,在unsupervised节点下选择attribute下的

NumericToNominal与Discretize,选择后点击“Apply”,即可完成数据预处理,结果如下图所示:

3、点击进入classify页面,在classifier区域选择trees下的J48算法,Test Options

中选择cross-validation ,在Folds框里填上10,如下所示:

4、使用默认配置,点击start,得到结果如下图所示:

5、由结果可知,在默认配置下,分类的正确率为62.4%,为了获取最优化模型,

我们修改树的节点和实例数来进行测试,测试结果如下表所述:

从表格可知当实例数为20的时候,正确率最高,所以我们将该配置作为标准生成模型,模型生成方式为,在Result list区域,右键点击实例为20的那条记录,出现右键菜单,选择save model生成模型即可。

步骤如下所示:

(4)模型评估

为了评估该模型的正确性,我们使用测试集进行校验。

校验结果如下所示:

从预测结果来看,83个数据里面,只有4个值预测错误,其他皆预测正确,实际测试结果正确率为95.2%。

代码实现附录:1、数据导入:

2、数据离散化预处理:

3、数据类型转换

4、创建模型

5、导出模型

6、导入模型

7、数据预测。