非负矩阵分解法介绍

非负矩阵分解算法

非负矩阵分解算法

1 非负矩阵分解

非负矩阵分解(Non-Negative Matrix Factorization,NMF)是

一种特殊的矩阵分解,它采用的分解维度包含非负的值。

NMF的定义是这样的:给定一个m阶n列非负矩阵A,有k非负数,将其分解成两个

m阶n列非负矩阵W和H,使得:A = WH.NMF可以应用于许多不同领域,包括信号处理、数据挖掘、图像处理、信息检索、自然语言处理等领域。

2 优点

非负矩阵分解具有许多优点:首先,非负矩阵分解有着很明显的

几何解释,可以用于多维数据挖掘,聚类和可视化。

其次,它的算法

本身不需要依赖于边界条件和/或初始条件,算法具有高度稳定性,用

于提取潜在信息特征,例如隐藏结构、主题、技能、现象等。

此外,

非负矩阵分解可以用较少的计算消耗从较大的数据集中提取有用的特征,从而降低空间需求并提高运行效率。

3 应用

非负矩阵分解的应用较广泛,在数据挖掘领域可用于高维数据降维、高维数据可视化、文本挖掘、模式挖掘以及聚集分析等方面。

在

信号处理方面,NMF可以用来提取信号中的有效信息,从而获得必要信息。

此外,NMF也可以用于表示图像并对其进行分类。

在自然语言处

理(Natural Language Processing)领域,NMF可以把文本表示成主题,以帮助文本分类、信息检索和在线推荐等任务。

4 结论

可以看出,非负矩阵分解在数据挖掘和信号处理等多领域具有重要的应用价值,特别是其几何解释、算法稳定性以及计算代价等众多优势的共同作用。

然而,NMF的应用还有待更多的研究,才能令它登上数据挖掘技术的高峰,为社会带来更多的发展。

非负矩阵分解应用

非负矩阵分解应用介绍非负矩阵分解(Non-Negative Matrix Factorization, NMF)是一种用于数据分析和模式识别的数学方法。

它是一种矩阵分解技术,可以将一个非负矩阵分解为两个非负矩阵的乘积。

NMF 在许多领域中都有广泛的应用,如文本挖掘、图像处理、信号处理等。

本文将为您介绍非负矩阵分解的原理、应用领域以及一些相关的方法和算法。

原理非负矩阵分解的基本原理是将一个给定的非负矩阵分解为两个非负矩阵的乘积。

假设我们有一个非负矩阵 V(m x n),我们希望找到两个非负矩阵 W(m x r)和 H (r x n),使得V ≈ WH,其中 r 是预先设置的一个参数。

在非负矩阵分解中,矩阵 W 和 H 都必须是非负的。

这是因为非负矩阵分解常用于数据的非负性问题,如文档词频矩阵、图像的像素强度矩阵等。

通过非负矩阵分解,我们可以得到对原始矩阵 V 的低秩近似表示,这有助于提取 V 中的潜在特征和结构。

非负矩阵分解可以通过不同的优化方法来实现,如乘法更新法、梯度下降法等。

这些方法都迭代地更新矩阵 W 和 H,直到满足停止准则。

应用领域非负矩阵分解在许多领域中都有广泛的应用。

以下是一些常见的应用领域:文本挖掘在文本挖掘中,非负矩阵分解可以用于主题建模和文档聚类。

通过将文档-词矩阵进行非负矩阵分解,我们可以得到文档和主题之间的关系,从而进行主题提取和文档分类。

图像处理在图像处理中,非负矩阵分解可以用于图像分析和图像压缩。

通过将图像的像素矩阵进行非负矩阵分解,我们可以提取图像中的特征,并进行图像压缩和重建。

信号处理在信号处理中,非负矩阵分解可以用于语音信号分析和音乐信号分析。

通过将语音信号或音乐信号的频谱矩阵进行非负矩阵分解,我们可以提取信号中的特征,并进行语音识别和音乐分类等任务。

社交网络分析在社交网络分析中,非负矩阵分解可以用于用户-用户矩阵和用户-物品矩阵的分解。

通过将社交网络中的用户-用户矩阵进行非负矩阵分解,我们可以发现用户之间的关系和潜在的社区结构。

nmf的名词解释

nmf的名词解释引言在当今信息爆炸的时代,我们对于各种新概念和技术的了解变得非常重要。

本文将重点解释NMF,即非负矩阵分解(Non-Negative Matrix Factorization)的含义和应用。

希望通过深入探讨这一概念,能够让读者对于该技术有一个全面而清晰的认识。

一、什么是NMF?非负矩阵分解是一种在数据挖掘和机器学习领域常用的技术。

它可以将一个非负矩阵分解为两个非负矩阵的乘积。

换句话说,给定一个非负矩阵V,NMF的目标是找到两个非负矩阵W和H,使得它们的乘积W*H近似等于V。

其中,W被视为一组基向量,H则表示基向量在该矩阵上的线性组合。

二、NMF的原理和优势NMF的原理基于独立成分分析(Independent Component Analysis)和低秩分解(Low-Rank Decomposition)。

通过将非负矩阵分解为低秩的非负部分和非负权重系数,我们能够更好地理解数据中的隐藏模式和因素。

NMF的优势在于它能够提取出数据的局部特征,而不受全局线性关系的限制。

这意味着NMF可以捕捉到一些难以用其他方法表示的非线性关系,从而更好地挖掘数据的内在结构。

三、NMF的应用领域1. 文本挖掘在文本挖掘中,NMF可以帮助我们从大量的文本数据中提取主题信息。

通过将文档-词频矩阵进行NMF分解,我们可以发现文本集合中隐藏的主题结构,并识别关键词,从而实现文本分类和聚类等任务。

2. 图像处理NMF在图像处理领域也有广泛的应用。

它可以帮助我们提取图像的基础元素,如边缘、纹理等。

通过NMF分解得到的基向量,我们可以进行图像重构、图像压缩和图像分割等任务,从而改善图像处理的效果和质量。

3. 音频处理在音频处理方面,NMF可以用来分离复杂的音频信号。

通过将混合的音频信号矩阵进行NMF分解,我们可以恢复出原始信号的成分,从而实现音频去噪、音频源分离等任务。

4. 社交网络分析由于社交网络的庞大和复杂性,NMF可以帮助我们从海量的社交网络数据中发现用户群体和社区结构。

非负矩阵因子分解算法

非负矩阵因子分解算法非负矩阵因子分解(Non-negative Matrix Factorization, NMF)是一种常用的非负矩阵分解技术,它在许多领域中都得到广泛应用。

NMF的目的是将一个非负矩阵分解为两个非负的低秩矩阵,从而提取出矩阵的潜在特征。

在NMF中,给定一个非负矩阵V,我们希望找到两个非负矩阵W和H,使得V≈W×H,其中W是一个m×r的非负矩阵,H是一个r×n的非负矩阵,r是预先设定的秩。

W和H都是非负的这个约束使得NMF能够提取出不具有线性线性相关性的特征。

NMF的优化问题可以定义为最小化目标函数:min||V - WH||,其中||.||表示矩阵的F范数为了求解这个优化问题,可以使用迭代的方法逐步优化W和H。

具体来说,首先初始化W和H为非负矩阵,然后交替更新W和H,直到满足终止条件。

1.初始化W和H为非负矩阵,可以使用随机值或者根据先验知识给定的初值。

2.更新W:固定H,通过最小化目标函数得到最优的W。

2.1计算乘法更新规则:W = W * (VH^T) / (WHH^T)2.2对W进行非负约束处理,将所有小于0的元素置为0。

3.更新H:固定W,通过最小化目标函数得到最优的H。

3.1计算乘法更新规则:H = H * (W^TV) / (W^TWH)3.2对H进行非负约束处理,将所有小于0的元素置为0。

4.判断终止条件,可以设置迭代次数上限或者设定一个阈值,当目标函数下降到一定程度或者迭代次数达到上限时,停止迭代。

5.重复步骤2和3,直到满足终止条件。

NMF的优点是提取到的特征是非负的,因此可以应用于文本挖掘、图像处理和声音信号处理等领域。

此外,NMF还具有良好的可解释性,因为W和H可以看作是每个特征在样本中的贡献度和每个样本在特征上的表示。

然而,NMF也存在一些局限性。

首先,NMF是一个非凸优化问题,因此可能会陷入局部最优解。

其次,NMF对初始值较为敏感,不同的初始值可能会导致不同的结果。

非负矩阵分解算法综述

E U W#iHij . i= 1 此外, BNMF 常被有盲信号 分离背景 的学者 解释为

含噪声项的产生式模型: V= WH+ E[10] , E 是 M @N 的 噪声矩阵. 不同的 BNMF 算法也常可被解释为 遵循了不 同的 E分布假设下的最大似然算法.

根据需要, 可给上述模型 中的 W和 H 施加 更多的 限制, 构成 INMF.

2 NMF 简介

定义 对一个 M 维的随机向量 v 进行了 N 次的观 测, 记这些 观测 为 vj , j = 1, 2, , , N , 取 V= [ V#1, V#2, , , V#N ] , 其中 V#j = vj, j = 1, 2, , , N, BNMF 要求发现非 负的 M @L 的基矩阵 W= [ W#1, W#2, , , W#N ] 和 L @N 的系数矩阵 H = [ H#1, H#2, , , H#N ] , 使 V U WH[1] , 这 也可 以 用 向 量 标 量 积 的 形 式 更 为 直 观 地 表 示 为 V#j

Ke y words: non2negative matrix factorization; multivariate data representation; feature extraction

1 引言

在信号处理、神经网络、模式识别、计算机视觉和图 象工程的研究中, 如何构造一个能使多维观测数据被更 好描述的变换方法始终是 一个非 常重要 的问 题. 通常, 一个好的变换方法应具备 两个基 本的特 性: ( 1) 可 使数 据的某种潜在结构变得清晰; ( 2) 能使数据的 维数得到 一定程度的约减.

主分量分析、线 性鉴别 分析、投影寻 踪、因 子分析、

冗余归约和独立分量分析是一些最常用的变换方法. 它 们因被施加的限制不同而有着本质的区别, 然而, 它们 有两个共同 的特 点: ( 1) 允 许负的 分解量 存在 ( 允 许有 减性的描述) ; ( 2) 实现线性的维数约减. 区别于它们, 一 种新 的变 换方 法 ) ) ) 非负 矩 阵分 解( Nonnegative Matrix Factor, NMF) [1]由 Lee 和 Seung 在5Nature6 上提出, 它使分 解后的所有分量均为非负值(要求纯加性的描述) , 并且 同时实现非 线性 的维 数 约减. NMF 的 心理 学和 生 理学 构造依据是对整体 的感知 由对组成 整体的 部分的 感知 构成的( 纯 加性的 ) [2~ 6], 这也 符合直 观的理 解: 整 体是 由部分组成的[1], 因此它在某种意义上抓住了智能数据 描述的本质. 此外, 这 种非负 性的限 制导致 了相应 描述 在一定程度上的稀疏性[1], 稀疏性的表述已被证明是介 于完全分布式的描 述和单 一活跃 分量 的描述 3 间 的一

非负矩阵分解

非负矩阵分解非负矩阵分解(NonnegativeMatrixFactorization,NMF)是一种重要的数值分解技术,它可以将一个实对称矩阵分解成两个非负矩阵,其中元素都大于等于零。

它可以用来提取相关数据之间的关系,从而从模糊的数据中提取出有价值的信息,因此经常被应用于聚类、概念提取等机器学习的领域中。

首先,要理解NMF,我们需要介绍其基本概念,它是一种矩阵分解技术,一般可以将一个实对称矩阵分解为两个非负的矩阵,这些元素都大于等于零。

其中,一个矩阵称为基矩阵,用来描述数据之间的关系;另一个称为内积矩阵,用来描述数据之间的相关性。

NMF由布罗基-亨利林(Brock-Hennely)在1999年提出,是一种重要的半正则化方法,能够从给定的非负矩阵中恢复出潜在的内容主题,其计算结果可以看作是一种“直观的抽象”,可以给出一个“更容易理解”的表示。

NMF的思想是将一个非负实矩阵X分解成两个非负矩阵W和H,令X≈WH,这两个矩阵的元素均为非负值,分别叫做基矩阵W和内积矩阵H,其计算过程是令X,W,H分别尽可能接近W,H,X,使得W 和H的乘积最小。

W和H可以用来描述原始矩阵X中的数据之间的关系,而不是直接用原始矩阵来表示X。

NMF有很多应用,如用于聚类分析,文档检索,内容提取,图像处理等机器学习领域,其主要的优点是:(1)能够从模糊的数据中提取出有价值的信息,(2)可以自动化,减少神经网络算法中专家知识的应用,(3)可以用于实时处理大量数据,(4)可以用于视觉系统,提出新的视觉模型,从而对计算机视觉系统有很大帮助。

NMF在聚类分析中也有很好的应用,它可以自动发现原始数据中的隐藏信息,并把它们聚合成不同的类别。

它的聚类特性使得它可以用来处理复杂数据集,具有很多分类任务的优点。

例如,可以使用NMF来分析文本数据,将一些紧密相关的文本聚合到一起;可以用来分析视觉数据,将图像中的主要特征提取出来;还可以用来分析声音数据,将语音识别任务简化成一个重要的计算任务。

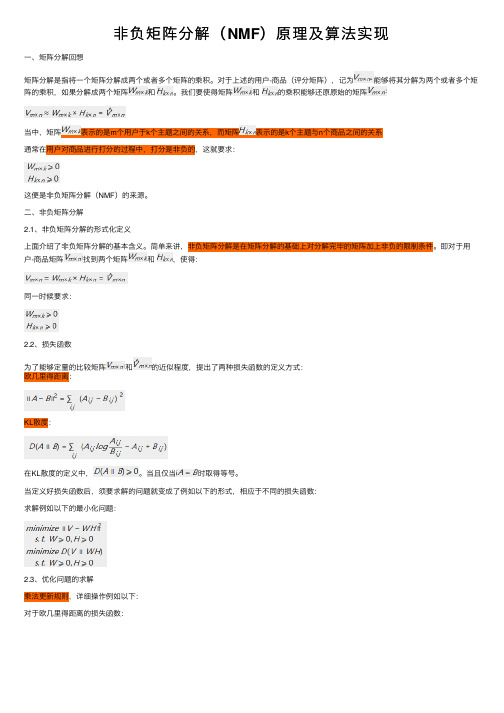

非负矩阵分解(NMF)原理及算法实现

⾮负矩阵分解(NMF)原理及算法实现⼀、矩阵分解回想矩阵分解是指将⼀个矩阵分解成两个或者多个矩阵的乘积。

对于上述的⽤户-商品(评分矩阵),记为能够将其分解为两个或者多个矩阵的乘积,如果分解成两个矩阵和。

我们要使得矩阵和的乘积能够还原原始的矩阵当中,矩阵表⽰的是m个⽤户于k个主题之间的关系,⽽矩阵表⽰的是k个主题与n个商品之间的关系通常在⽤户对商品进⾏打分的过程中,打分是⾮负的,这就要求:这便是⾮负矩阵分解(NMF)的来源。

⼆、⾮负矩阵分解2.1、⾮负矩阵分解的形式化定义上⾯介绍了⾮负矩阵分解的基本含义。

简单来讲,⾮负矩阵分解是在矩阵分解的基础上对分解完毕的矩阵加上⾮负的限制条件。

即对于⽤户-商品矩阵找到两个矩阵和,使得:同⼀时候要求:2.2、损失函数为了能够定量的⽐较矩阵和的近似程度,提出了两种损失函数的定义⽅式:欧⼏⾥得距离:KL散度:在KL散度的定义中,。

当且仅当时取得等号。

当定义好损失函数后,须要求解的问题就变成了例如以下的形式,相应于不同的损失函数:求解例如以下的最⼩化问题:2.3、优化问题的求解乘法更新规则,详细操作例如以下:对于欧⼏⾥得距离的损失函数:对于KL散度的损失函数:上述的乘法规则主要是为了在计算的过程中保证⾮负,⽽基于梯度下降的⽅法中,加减运算⽆法保证⾮负。

事实上上述的惩罚更新规则与梯度下降的算法是等价的。

以下以平⽅距离为损失函数说明上述过程的等价性:平⽅损失函数能够写成:使⽤损失函数对求偏导数:依照梯度下降法的思路:即为:令,即能够得到上述的乘法更新规则的形式。

2.4、⾮负矩阵分解的实现1from numpy import *2from pylab import *3from numpy import *45def load_data(file_path):6 f = open(file_path)7 V = []8for line in f.readlines():9 lines = line.strip().split("\t")10 data = []11for x in lines:12 data.append(float(x))13 V.append(data)14return mat(V)1516def train(V, r, k, e):17 m, n = shape(V)18#先随机给定⼀个W、H,保证矩阵的⼤⼩19 W = mat(random.random((m, r)))20 H = mat(random.random((r, n)))21#K为迭代次数22for x in range(k):23#error24 V_pre = W * H25 E = V - V_pre26#print E27 err = 0.028for i in range(m):29for j in range(n):30 err += E[i,j] * E[i,j]31print(err)32 data.append(err)3334if err < e:35break36#权值更新37 a = W.T * V38 b = W.T * W * H39#c = V * H.T40#d = W * H * H.T41for i_1 in range(r):42for j_1 in range(n):43if b[i_1,j_1] != 0:44 H[i_1,j_1] = H[i_1,j_1] * a[i_1,j_1] / b[i_1,j_1]4546 c = V * H.T47 d = W * H * H.T48for i_2 in range(m):49for j_2 in range(r):50if d[i_2, j_2] != 0:51 W[i_2,j_2] = W[i_2,j_2] * c[i_2,j_2] / d[i_2, j_2]5253return W,H,data5455565758if__name__ == "__main__":59#file_path = "./data_nmf"60# file_path = "./data1"61 data = []62# V = load_data(file_path)63 V=[[5,3,2,1],[4,2,2,1,],[1,1,2,5],[1,2,2,4],[2,1,5,4]]64 W, H ,error= train(V, 2, 100, 1e-5 )65print (V)66print (W)67print (H)68print (W * H)69 n = len(error)70 x = range(n)71 plot(x, error, color='r', linewidth=3)72 plt.title('Convergence curve')73 plt.xlabel('generation')74 plt.ylabel('loss')75 show()这⾥需要注意训练时r值的选择:r可以表⽰和主题数或者你想要的到的特征数K值的选择:k表⽰训练的次数,设置的越⼤模型的拟合效果越好,但是具体设置多少,要根据性价⽐看,看误差曲线的变化。

矩阵的非负分解

矩阵的非负分解矩阵的非负分解是一种在数学和计算科学中广泛应用的算法,它涉及将一个矩阵分解为非负矩阵的乘积。

这种分解在许多领域都有应用,包括机器学习、图像处理、统计和优化。

下面我们将详细介绍矩阵的非负分解及其相关概念。

一、矩阵分解矩阵分解,也称为矩阵因子分解或矩阵分解,是将一个复杂矩阵分解为几个简单的、易于处理的矩阵。

这些简单的矩阵通常具有特殊的结构,例如正交矩阵、对角矩阵或稀疏矩阵。

矩阵分解在解决各种问题中非常有用,因为它可以将一个复杂的问题转化为几个简单的子问题。

二、非负矩阵非负矩阵是指其所有元素均为非负数的矩阵。

非负矩阵在经济学、生物学、网络分析等领域有广泛的应用。

非负矩阵具有一些特殊的性质,例如它的特征值都是非负的,并且它的谱半径也小于等于它的最大特征值。

三、非负矩阵分解非负矩阵分解是一种特殊的矩阵分解方法,它要求分解后的矩阵是非负的。

这种方法在处理图像、文本等数据时非常有用,因为这些数据通常都具有非负性。

例如,在图像处理中,像素值是非负的,因此非负矩阵分解可以用于图像的表示和压缩。

在文本处理中,单词频数也是非负的,因此非负矩阵分解可以用于文本的表示和聚类。

四、算法实现非负矩阵分解的方法有多种,其中比较常用的是交替最小二乘法(Alternating Least Squares,简称ALS)。

该方法的基本思想是:对于一个给定的非负矩阵,首先将其分解为两个初始的非负矩阵,然后不断迭代更新这两个矩阵,直到满足一定的停止条件为止。

在迭代过程中,ALS 方法按照如下方式更新矩阵:1. 固定其中一个矩阵,对另一个矩阵进行优化;2. 固定另一个矩阵,对第一个矩阵进行优化;3. 重复上述步骤,直到达到停止条件。

一般来说,ALS 方法能够找到局部最优解而非全局最优解,但它在实践中表现出的效果往往非常好。

此外,由于非负矩阵分解的应用广泛,许多编程语言和工具包都提供了现成的ALS 实现,使得使用者可以更加方便地进行计算。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

報告者:李建德

大綱

簡介 非負矩陣分解法 演算法步驟 NMF訓練-以圖像為例

2

簡介

Bell Laboratory的D.D. Lee與Massachusetts Institute of Technology的H.S. Seung所發展出來 找出表面事物中所隱藏的特徵 以局部特徵的方式去辨識物體 非負元素值的限制條件

3

非負矩陣分解法

非負矩陣表示法:

[V ]nm [W ]nr [ H ]rm

其中參數r有(n+m)r<nm之限制

[V]為受測樣本群所組成的,其中m為受測樣本集合的樣本數,n為樣本特徵維度 [W]是由受測樣本的基底特徵所組成 [H]代表 [W]對應到[H]的特徵組合比例

4

演算法步驟

決定r值

灰階影像資料

8

NMF訓練-以圖像為例

NMF

9

NMF訓練-以圖像為例

某一樣本對應之 特徵參數 NMF基底影像

重建影像

原始影像

10

應用混音

單一通道混音分離之流程圖

11

將訓練樣 本置入[V]

[W][H]初 始化

[W]行向量 正規化

更新[W][H]

MSE=0或 收斂則停止 疊代

5

演算法步驟

W更新:H更新:6NMF訓練-以圖像為例

145 105 213

94 213 94

224 156 103

145

94

224

105

213

156

213

94

103

7

NMF訓練-以圖像為例