火车头采集器-采集与发布带图片的文章

火车头采集器发布模块设置以及制作

火车头采集器发布设置,要更好的使用火车头采集器软件,必须需要有基本的HTML基础,能看得懂网页源码,网页结构。

同时如果用到web发布或数据库发布,则对自己文章系统及数据存储结构要非常了解。

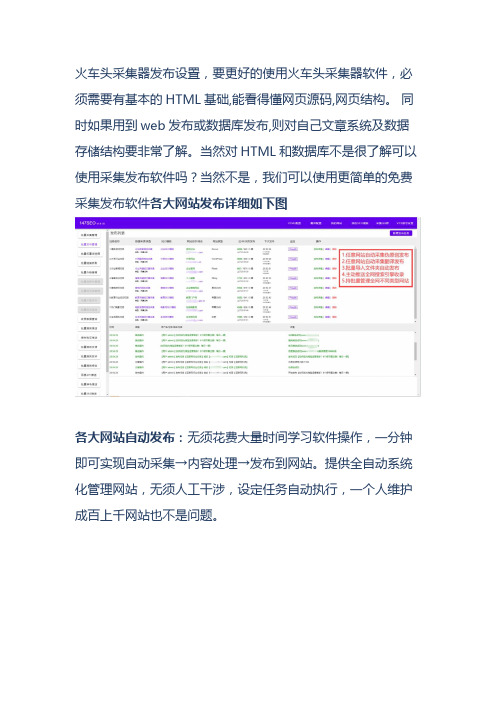

当然对HTML和数据库不是很了解可以使用采集发布软件吗?当然不是,我们可以使用更简单的免费采集发布软件各大网站发布详细如下图各大网站自动发布:无须花费大量时间学习软件操作,一分钟即可实现自动采集→内容处理→发布到网站。

提供全自动系统化管理网站,无须人工干涉,设定任务自动执行,一个人维护成百上千网站也不是问题。

1、CMS发布:目前是市面上唯一同时支持帝国、易优、ZBLOG、织梦、WordPress、苹果CMS、人人CMS、米拓CMS、云优CMS、小旋风站群蜘蛛池、Thinkcmf、PHPCMS、Pboot、Fadmin、Destoon、海洋CMS、极致CMS、Emlog、Emlogpro、Typecho、TWCMS、WordPress社区版本、迅睿CMS、WXYCM、DZ论坛等各大CMS,并且可同时批量管理并发布的工具2、对应栏目:相应文章可发布对应栏目(支持多栏目随机发布文章)3、定时发布:可控制发布间隔/单日总发布数量4、监控数据:软件上直接监控已发布、待发布、是否伪原创、发布状态、网址、程序、发布时间、全网搜索引擎推送收录等指定网站采集:任意网站的数据都可以抓取,所见即所得的操作方式,只要点点鼠标就能轻松获得自己想要的数据,支持多任务同时采集!输入关键词采集文章:同时创建多个采集任务(一个任务可支持上传1000个关键词,软件同时还配备了关键词挖掘功能)监控采集: 能够定时的对目标网站进行采集,频率可以选择10分钟、20分钟、根据用户需求自定义设置监控采集(自动过滤重复,监控新增文章)。

标题处理设置: 根据标题或关键词自动生成标题(不管是双标题还是三标题都可以自由生成,间隔符号自定义填写,自建标题库生成,自媒体标题党生成,标题替换等等)图片处理设置:图片加标题水印/图片加关键词水印/自定义图片水印/自定义图片库替换。

火车头采集器教程课件

目录

• 火车头采集器简介 • 采集规则设置 • 数据处理与导出 • 采集器高级功能 • 采集器安全与优化

01

火车头采集器简介

火车头采集器的功能与特点

数据采集

火车头采集器能够抓取 网页数据,支持多种数 据格式,如文本、图片

、视频等。

自动化处理

通过预设规则,火车头 采集器能够自动化地处 理和整理数据,提高工

数据导出格式与工具

01பைடு நூலகம்

02

03

04

CSV格式

常见的数据交换格式,易于阅 读和编辑。

Excel格式

强大的电子表格格式,支持多 种数据分析工具。

JSON格式

轻量级的数据交换格式,易于 在网络上传输。

FTP导出

通过FTP协议将数据传输到远 程服务器。

数据导出常见问题与解决方案

数据丢失

确保在导出前备份原始数据,以防数据丢失 。

任务执行策略

根据实际需求,可以设置多种任务 执行策略,如单次执行、循环执行 等,以满足不同场景下的数据采集 需求。

03

数据处理与导出

数据清洗与整理

数据清洗

数据转换

去除重复、错误或不完整的数据,确 保数据质量。

将数据从一种格式转换为另一种格式 ,以便与其他系统或工具兼容。

数据整理

对数据进行分类、排序和组织,以便 更好地分析和使用。

下载安装

用户需要先下载和安装火车头 采集器软件,根据提示进行安 装操作。

配置采集任务

在系统中,用户可以根据实际 需求配置采集任务,包括目标 网站、数据抓取规则等。

数据导出

抓取到的数据可以导出为多种 格式,如Excel、CSV等,方便 用户进行后续处理和分析。

locoy火车头采集教程与实例

火车头采集教程火车头采集基本流程:系统设置→新建站点→新建任务→采集网址→采集内容→发布内容→抓数据。

1.新建站点:据你自己的需求为任务建立统一的站点,以方便管理。

点击菜单上:站点→新建站点打开如下图:可以填写站点名,站点地址,网址深度(0,代表根据地址直接采内容。

1,代表根据地址采内容地址,然后根据内容地址采内容。

2,代表根据地址采列表地址,然后根据列表地址采内容地址,再根据内容地址采内容。

),站点描述。

2.新建任务:任务是采集器采集数据时的基本工作单元,它一定是建立在站点中的。

采集器通过运行任务来采集发布数据。

任务工作的步骤总体可以分为三步:采网址,采内容,发内容。

一个任务的运行可以任意选择哪几步。

而采集器又可以同时运行多个任务(默认设置是同时最多运行3个任务)。

选择站点点击右键选择“从该站点新建任务”。

任务的编辑界面如图:采集器的使用最主要的就是对任务的设置。

而采集数据可以分为两步,第一步是:采网址,第二步:采内容。

3.采集网址:采网址,就是从列表页中提取出内容页的地址。

从页面自动分析得到地址连接:以/book/01.45.52_P1.html页面为例。

我们来采集这个网址上的书信息。

这个页面中有很多书信息的链接,要采集每个链接中书内容.首先需要将每个书信息的链接地址抓取到也就是抓取内容页的地址。

先将该列表页地址添加到采集器里。

点击“<<向导添加”后弹出“添加开始采集地址”对话框。

我们选择“单条网址”如图:点击添加把/book/01.45.52_P1.html地址添加到下面框中,点击完成即实现增加列表地址。

如果我们选择“批量/多页”,如图:可用通配符:(*)可以代替页码变化时的地址之间的差异。

数字变化可以设置你要爬取该列表页多少页。

间隔倍数可以数字页码变化的倍数。

你也可以设置字母变化。

设置完之后点击添加按钮把列表地址添加到下框中,点击完成即可完成列表地址设置。

你也可以选择文本导入和正则提取在这里就不一一讲了,因为这二种基本用的很少。

火车头采集器介绍与使用流程说明

五、字段处理

• 网页编码设定: • 每个网站都有一个相对应的编码:如UTF-8。如果选错编码,则采集

出来的数据就会呈现一种乱码格式。 • 大多数的网页编码火车头都可以自动识别,如不能则需要手动指定一

二、创建任务

• 1.新建分组

填写分组名称

二、创建任务

• 2网址

三、采集网址

• 点击“添加”按钮出现如下界面

三、采集网址

• 切换至“批量/多页”选项卡,可以批量添加网址

网址通用序号用通 配符(*)替换

这添加方式主要用来处理分页网址

三、采集网址

• 切换至“其他网址格式”选项卡,也可以批量添加网址

日期格式

网址通用序号用通 配符(*)替换

这添加方式主要用来处理含有日期的网址

三、采集网址

• 多级网址采集

点击‘添加’按钮

网址过滤条件

三、采集网址

• 手动采集配置链接地址规则:

• 手动连接格式是将需要的网址用参数来获得并组合成我们需要的网址。 这个好处是处理网址那块有规律的网址很好处理。而且可以用这方法 采集需要的字段,如:公告新闻类的标题、日期等。

火车采集器是目前信息采集与信息挖掘处理类软件中最流行、性价比 最高、使用人数最多、市场占有率最大、使用周期最长的智能采集程 序。

一、软件介绍

• 火车采集器数据发布原理:

• 在我们将数据采集下来后数据默认是保存在本地的,我们可以使用以 下几种方式对种据进行处理。

• 1.不做任何处理。因为数据本身是保存在数据库的(access或是 db3),您如果只是想看一下,直接用相关软件查看就可以了。

火车头erphpdown采集规则-定义说明解析

火车头erphpdown采集规则-概述说明以及解释1.引言1.1 概述概述部分:火车头erphpdown是一款功能强大的采集工具,它可以帮助用户快速、高效地采集互联网上的各种数据。

随着互联网的迅速发展,各种信息在网上不断涌现,因此在信息获取方面的需求越来越高。

火车头erphpdown通过自定义采集规则的方式,可以针对不同的网站和数据源进行采集,将所需的数据提取出来,方便用户进行分析和利用。

本文将围绕火车头erphpdown采集规则展开讨论。

首先,将介绍火车头erphpdown采集规则的背景,包括其诞生的背景和发展的历程,为读者提供一个全面的了解。

然后,将详细介绍火车头erphpdown采集规则的定义,包括其基本组成和结构,以及常用的采集规则示例。

接着,将介绍火车头erphpdown采集规则的使用方法,包括如何创建和编辑采集规则,以及如何应对不同的采集需求。

最后,将通过一些实际案例来展示火车头erphpdown采集规则的应用,以帮助读者更好地理解和掌握其使用技巧。

相对于其他采集工具,火车头erphpdown采集规则具有一些独特的优势。

首先,它具有较强的灵活性,用户可以自定义采集规则,满足特定的采集需求。

其次,火车头erphpdown采集规则具有强大的数据提取能力,可以将所需的数据从杂乱的页面中提取出来,并进行整理和清洗。

此外,火车头erphpdown采集规则还支持多线程,能够提高采集效率。

当然,火车头erphpdown采集规则也存在一些局限性。

由于采集规则的制定需要具备一定的编程知识和技巧,对于一些非专业用户来说可能较为困难。

另外,由于互联网内容的多样性和变化性,火车头erphpdown 的采集能力可能在某些情况下受到限制。

然而,随着互联网的不断发展,火车头erphpdown采集规则的发展前景仍然值得期待。

随着技术的不断创新和完善,火车头erphpdown有望在采集规则的功能和性能方面继续提升,为用户提供更多更好的采集体验。

火车采集器采集说明

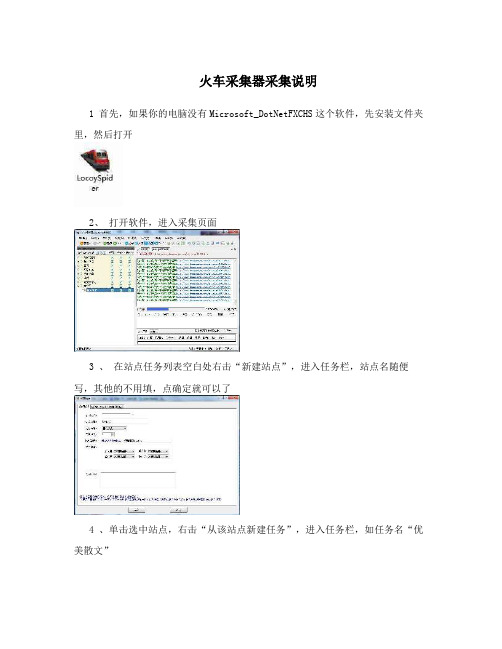

火车采集器采集说明1 首先,如果你的电脑没有Microsoft_DotNetFXCHS这个软件,先安装文件夹里,然后打开2、打开软件,进入采集页面3 、在站点任务列表空白处右击“新建站点”,进入任务栏,站点名随便写,其他的不用填,点确定就可以了4 、单击选中站点,右击“从该站点新建任务”,进入任务栏,如任务名“优美散文”5、单击“向导添加”,进入采集地址6、地址栏,从采集页面第二页,网址复制,可能图看不清,网址,记住把数字标记为同样,选中数字,然后点(*),变成(*).html,如果想采集多的数字变化从1到你采集的页面,然后点击“添加”按钮,出现这个页面,点击完成就可以了。

7、在输入随便一篇采集文章的网址,选中数字,点击(*)按钮,变成8、这个页面的需要文章列表源代码,右击选择产看“网页源代码”9、最重要的,代码不能出错,再次强调文章列表的源代码,进入到源代码,找到文章列表开始处的靠近的源代码,如选中一段代码,复制,然后按Ctrl+f 键,输入框粘贴,看选中的源代码是否是第1条,记住,所选源代码必须是第一条(我用的是谷歌浏览器,显示的是0,其他的浏览器只要是第一条即可),确定所选是第一条源代码,就输入,结束代码和开始代码一样,文章列表结束处找代码10、上述第一步,结束之后,第二步采集内容规则所选标签随自己选择,不需要的可以删。

11、单击打开“内容”标签,随便打开文章页,右击“查看源代码”,和上述文章列表开始和结束的源代码一样,必须是第一条12、自定义数据里面除了段落、换行<br>、换行Tab\r\n\t三个不要,如图,单击确定。

13、单击第三步:发布内容设置在方式二:保存为本地文件,启用前打钩,保存格式为.Txt,保存位置自定义,保存位置设置好以后,单击保存按钮14、打开站点,选中任务,右击开始任务采集,这样就可以了。

火车头采集器教程演示文稿

四、采集内容

双击上图窗口中的“标题”标签,將“源代码”中对应的标题符段中,点击确定,标题标签设置完成。

第16页,共31页。

四、采集内容

第二、资讯内容

查看本页面“源文件”,找到文章内容部分。如下图:

第17页,共31页。

四、采集内容

第30页,共31页。

五、发布内容

12、在配置名中输入要采集的栏目名称,点击保存配置。

13、设置完成后点击保存。 发布内容部分结束

第31页,共31页。

1、双击上图窗口中的“资讯内容”标签,將“源代码”中对应的资讯内容开始代码和结 束代码分别输入到开始字符段和结束字符段中。 2、勾选“HTML标签排除”中的“链接”、“层”、“Span”、“图象”、“脚本”选项。

3、选择“内容排除”中的添加项,將资讯内容代码中的无用代码和文本添加在此选项中,过滤 废物信息。 4、点击确定,资讯内容标签设置完成。

將“源代码”中对应的关键词开始代码和结束代码分别输入到开始字符段和结束字符段中,点击

确定,信息关键词和meta关键词标签设置完成。

注释:有些文章关键词部分设有大量广告语或与本文无关的内容,这样的文章关键词我们不给予采集。可以将 标题的采集方法复制到关键词采集中。

第24页,共31页。

四、采集内容

第五、责任编辑

第一、标题

查看本页面“源文件”搜索title代码,找到文章内容部分。如下图:

注释:一般情况下检索<title></title>都可以采集到我们需要的标题标签,但由于这篇文章此代码中

设计到其他网站logo及列表分类不确定信息,所以选择

<div id=“title”><h1></h1>中内容来代替。如果没有合适字段,可利用“内容排除”选项进行筛选。

火车头采集器采集文章使用教程实例

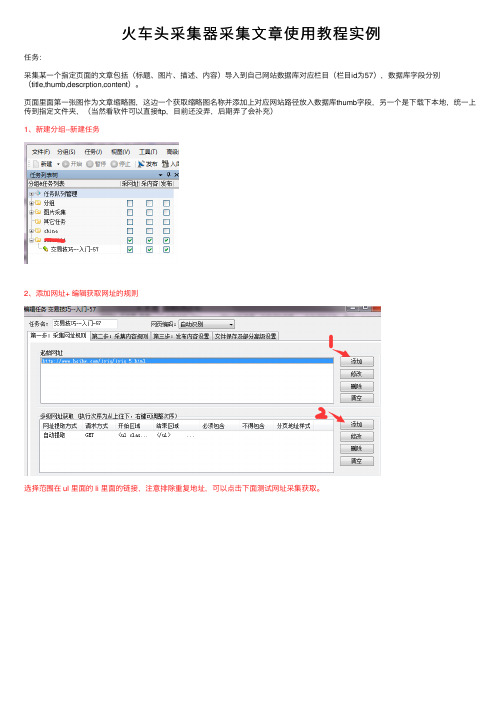

⽕车头采集器采集⽂章使⽤教程实例任务:采集某⼀个指定页⾯的⽂章包括(标题、图⽚、描述、内容)导⼊到⾃⼰⽹站数据库对应栏⽬(栏⽬id为57),数据库字段分别(title,thumb,descrption,content)。

页⾯⾥⾯第⼀张图作为⽂章缩略图,这边⼀个获取缩略图名称并添加上对应⽹站路径放⼊数据库thumb字段,另⼀个是下载下本地,统⼀上传到指定⽂件夹,(当然看软件可以直接ftp,⽬前还没弄,后期弄了会补充)1、新建分组--新建任务2、添加⽹址+ 编辑获取⽹址的规则选择范围在 ul ⾥⾯的 li ⾥⾯的链接,注意排除重复地址,可以点击下⾯测试⽹址采集获取。

可以看到有采集到的⽂章链接了。

3、采集内容规则我这边需要采集下⾯图上展⽰数据(catid是栏⽬id,可以将采集到的数据放⼊对应栏⽬,设置固定值就好)着重说下内容和图⽚的采集,标题和描述同理内容采集内容采集:打开⼀个采集的⽂章页⾯,查看源代码(禁了右键的f11 或者在⽹址前⾯加上 view-source: ⼀样可以查看):选中⽂章开头⼀个位置,截取⼀段在ctrl+f 搜下是否唯⼀⼀段,若是就可以放在位置下图1处,结尾同开头⼀样。

我截取内容不想⾥⾯还带有链接图⽚可以数据处理,添加--html标签排除--选好确定--确定还有需要下载页⾯图⽚,勾选和填写下⾯选项图⽚采集:(1)选中范围和内容⼀样(⽂章内图⽚)(2)数据处理选提取第⼀张图⽚内容是:/2017/33/aa.jpg(3)只要aa.jpg,正则过滤 ,获取内容:aa.jpg (4)数据库存储有前缀,添加上, upload/xxxxx/找⼀个页⾯测试⼀下,可以看到对应项⽬都获取到了。

4、发布内容设置,这⾥以⽅式三发布到数据库为例⼦,编辑后回到这边勾选刚定义的模块就好:5、我需要保存图⽚到本地,要设置下保存⽂件的路径(ftp后续会试着使⽤)。

6、保存,查看刚新建的任务,右键开始任务运⾏,这边就可以看到⽂字和图⽚都下载下来了,数据库⾥⾯也可以看到了。

火车采集器采集原理,流程介绍

火车采集器采集原理,流程介绍先说一下,什么是数据采集呢?我们可以这样理解,我们打开一个网站,看到有一篇文章很不错,于是我们就将文章的标题和内容复制了一下,将这篇文章转到我们的网站上.我们的这个过程,就可以称作一个采集,将别人网站上对自己有用的信息转到自己网站上.采集器也是这样,不过整个过程是由软件完成的.我们可以这样理解,我们复制文章的标题和内容,是我们可以知道什么地方是内容,什么地方是标题, 但是软件是不知道的,所以我们要告诉软件,要怎么采,这就是写规则的过程..我们复制完了,打开我们网站,比如论坛发帖的地方,然后粘帖发表,对软件来说,就是模仿我们发表帖子的过程,去发表文章,怎么发布,这就是发布模块的事了..火车采集器就是一款用来采集数据的软件,它是目前网络上最强大的采集器.它几乎可以采到你所见到的任何网页内容。

火车采集器数据抓取原理:火车采集器如何去抓取数据,取决于您的规则。

您要获取一个栏目的网页里的所有内容,需要先将这个网页的网址采下来,这就是采网址。

程序按您的规则抓取列表页面,从中分析出网址,然后再去抓取获得网址的网页里的内容。

再根据您的采集规则,对下载到的网页分析,将标题内容等信息分离开来并保存下来。

如果您选择了下载图片等网络资源,程序会对采集到的数据进行分析,找出文章下载地址并下载到本地。

火车采集器数据发布原理:在我们将数据采集下来后数据默认是保存在本地的,我们可以使用以下几种方式对种据进行处理。

1.不做任何处理。

因为数据本身是保存在数据库的(access或是db3),您如果只是想看一下,直接用相关软件查看就可以了。

2.web发布到网站。

程序会模仿浏览器向您的网站发送数据,可以实现您手工发布的效果。

3.直接入数据库。

您只需写几个SQL语句,程序会将数据按您的SQL语句导入到数据库中。

4.保存为本地文件。

程序会读取数据库里的数据,按一定格式保存为本地sql或是文本文件。

火车采集器工作流程:火车头采集是可以分成两个步骤的,一是采集数据,二是发布数据。

火车头采集步骤和数据导出详解

火车头采集步骤和数据导出详解火车头采集是指通过特定的设备和技术手段,对火车头进行数据采集和监测的过程。

火车头是火车的关键部件,对其进行数据采集和监测可以帮助运维人员了解火车头的工作状态,及时发现问题并采取相应的措施,提高列车的安全性和运行效率。

一、准备工作:1.确定采集目标:根据实际需求确定需要采集的数据类型和参数。

通常包括火车头的速度、温度、振动、轴承磨损情况等。

2.选择采集设备:根据采集目标选择合适的采集设备。

常见的设备包括传感器、数据采集器、数据传输设备等。

3.安装采集设备:将选择的采集设备安装在火车头上。

根据需要进行布线、连接传感器、设置传感器参数等工作。

4.配置采集软件:根据采集设备的要求,配置采集软件。

通常需要设置数据采集频率、存储路径、采集模式等参数。

二、数据采集:1.启动采集设备:确保采集设备已经正确安装并与火车头建立了连接后,可以启动采集设备。

根据实际情况,可以手动启动或者设置自动启动。

2.开始采集:采集设备启动后,开始自动采集火车头的相关数据。

设备会按照预设的频率进行数据采集,并将采集到的数据进行存储或实时传输。

3.数据质量控制:在采集过程中,需要对数据进行质量检验和控制。

例如,通过采集设备的设定检测数据的完整性、准确性等指标。

4.故障检测与维护:在数据采集过程中,及时发现和处理采集设备的故障和问题,确保数据采集的连续性和准确性。

三、数据导出:1.数据存储:采集设备将采集到的数据按照预设的存储路径进行存储。

可以选择本地存储、云端存储等方式。

2.数据处理:将存储的原始数据进行处理和分析,提取有用信息。

例如,可以利用图表、统计分析等方法展示数据的变化和趋势。

3. 数据导出:将处理后的数据进行导出,以供后续使用。

可以选择导出为Excel表格、CSV文件等常见格式,以便于后续的数据分析和应用。

4.数据备份:对导出的数据进行及时的备份和存档,以防止数据丢失或损坏。

总结:火车头采集涉及到准备工作、数据采集和数据导出三个主要环节。

火车头采集器教程演示文稿

火车头采集器教程演示文稿一、介绍你好,大家好!今天我非常荣幸给大家介绍一个非常实用的工具,火车头采集器。

它是一款强大的网络数据采集工具,可以帮助我们快速获取互联网上的各种信息。

二、功能1.数据采集:可以采集各种网站上的数据,如商品信息、新闻、评论等。

2.数据筛选:可以根据指定的条件对采集到的数据进行筛选和整理,提高数据的质量。

3. 数据导出:可以将采集到的数据导出为Excel、CSV等格式,方便进行后续分析和处理。

4.定时采集:可以设置定时任务,实现自动采集数据功能。

5.模拟登录:可以模拟用户的登录操作,以获得更多的数据。

6.反爬虫模式:可以通过一系列的反爬虫策略,规避网站的反爬虫机制,提高数据采集的成功率。

三、操作步骤下面我将为大家演示如何使用火车头采集器进行数据采集。

1.打开火车头采集器软件,点击左上角的“新建任务”按钮。

2.在弹出的窗口中,输入任务名称和要采集的网站URL,点击确定。

5.等待采集完成后,点击“导出数据”按钮,选择导出格式和保存路径,并点击确定。

6.打开导出的文件,即可查看采集到的数据。

四、常见问题及解决方法1.采集速度较慢:可以尝试调整线程数和延时时间,以提高采集速度。

2.采集到的数据不完整:可以检查采集器的配置是否正确,并尝试使用正则表达式提取所需数据。

3.被网站反爬虫封IP:可以使用代理IP或者设置访问频率来规避网站的反爬虫机制。

4.无法模拟登录:可以检查登录账号和密码是否正确,并确保网站的登录接口没有变动。

5.无法启动采集器:可以检查网络连接是否正常,并尝试重新安装软件。

五、总结火车头采集器是一款功能强大、易于操作的网络数据采集工具,可以帮助我们快速获取互联网上的各种信息。

通过本次演示,我相信大家已经对火车头采集器的使用有了初步的了解。

希望大家能够通过学习和实践,更好地应用这个工具,在数据采集和处理方面取得更好的成果。

谢谢大家!。

火车头简单使用说明

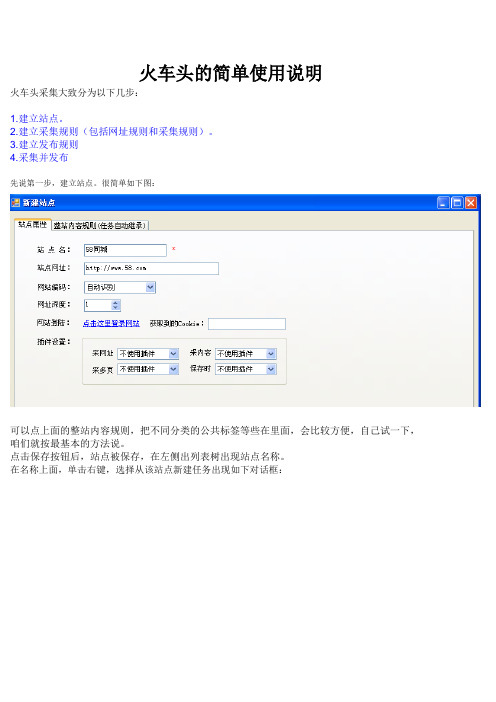

火车头的简单使用说明火车头采集大致分为以下几步:1.建立站点。

2.建立采集规则(包括网址规则和采集规则)。

3.建立发布规则4.采集并发布先说第一步,建立站点。

很简单如下图:可以点上面的整站内容规则,把不同分类的公共标签等些在里面,会比较方便,自己试一下,咱们就按最基本的方法说。

点击保存按钮后,站点被保存,在左侧出列表树出现站点名称。

在名称上面,单击右键,选择从该站点新建任务出现如下对话框:点击向导添加,添加要采集的信息的列表页地址,找到列表页的分页规则,可以批量添加,也可以单页添加,建议先用单页,一是错误少,二十一次采集太多,你不怕把搜索引擎惹怒了。

好了不说废话,上图!点击添加后,单击完成,回到上一页,开始测试网址采集,当然最好添加一些必须有和不得包含的字符,过滤掉没用的链接。

还是看图:用鼠标随便选中一个链接,点浏览页面,看看有没有没用的东西,如果没有,选中一个页面,点击测试该页,出现如下图界面:上图中的标签,是很关键的东西,什么是没用的标签,什么是有用的标签呢?有用的,就是你发表信息的时候能用到的,比如说标题、电话等等。

火车头默认带着的时间、出处等就是没用的,干掉它!那么,怎么样建立标签呢?我拿标题来说一下,其他都类似了。

查看被采集内容页的源文件,找到标题的地方,看看被什么网页标签包围着,就是它了:这样标题就可以采集到了,类似的方法建立其他标签,即可采集到其他内容,下图是我采集:至此,采集部分完成,一些步骤说的比较简单,用的时候再摸索一下吧!然后,打开相应的data文件夹中找到与站点相同名字的文件夹,进入打开ACCESS文件导出数据为excel文件,整理数据之后导入数据库即可。

火车头采集器的发布和采集规则

火车头采集器的发布和采集规则一、发布规则:2.任务设置:用户可以创建多个采集任务,每个任务都有独立的设置。

用户需指定采集的目标网站和所需的数据类型。

可以设置采集频率、起止时间、采集深度等参数,以满足不同的需求。

3.管理代理:为了提高采集效率和降低封禁风险,用户可以选择使用代理服务器进行采集。

用户应提供合法而有效的代理服务器,并确保代理服务器没有被目标网站封禁。

4.定时发布:用户可以设置采集器自动发布采集结果的时间和方式。

可以选择通过电子邮件、短信、FTP等方式,将数据发送到指定的目标。

二、采集规则:1.合法性:用户应遵守法律法规,不得通过采集器采集非法或侵犯他人权益的信息。

用户有责任保护目标网站的合法权益,并不得恶意攻击、破坏或侵犯目标网站的运营。

2.频率限制:用户应合理设置采集器的采集频率,避免对目标网站造成过大的访问压力。

采集器应尊重目标网站的访问频次限制,避免超出合理的范围,以免被目标网站封禁。

4.指定目标:用户应明确指定采集的目标网站和数据类型,不得随意改变目标,也不得将采集器用于未经授权的网站和信息。

5.版权保护:用户在采集过程中,应尊重作品的著作权、版权和知识产权等法律法规。

不得采集、传播他人作品的内容,除非获得了合法的授权或符合适用的公平使用规定。

6.信息处理:用户应对采集到的数据进行合理的处理和使用,不得将数据用于违法、不当的目的。

用户有责任保护采集到的数据的安全性,避免数据泄露、篡改或滥用。

总之,火车头采集器的发布和采集规则是以合法、合规为基础的。

在使用采集器时,用户需要遵守相关法律法规,尊重他人的权益和隐私,并承担适当的责任来保护数据的安全性和合法性。

火车头采集器的发布和采集规则

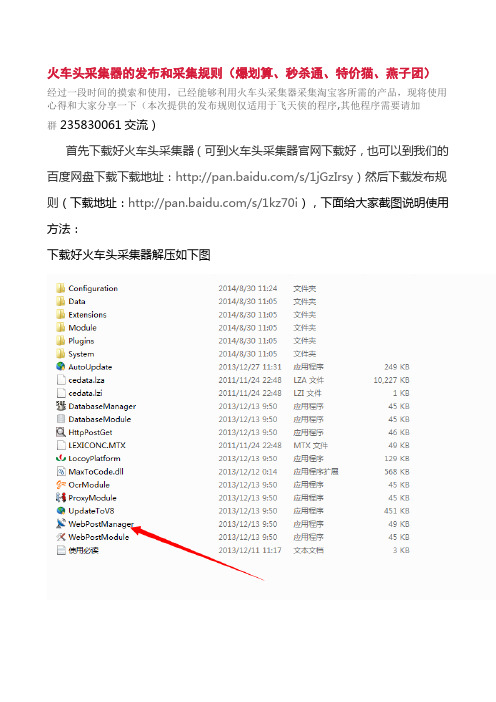

火车头采集器的发布和采集规则(爆划算、秒杀通、特价猫、燕子团)

经过一段时间的摸索和使用,已经能够利用火车头采集器采集淘宝客所需的产品,现将使用心得和大家分享一下(本次提供的发布规则仅适用于飞天侠的程序,其他程序需要请加

群235830061交流)

首先下载好火车头采集器(可到火车头采集器官网下载好,也可以到我们的

百度网盘下载下载地址:/s/1jGzIrsy)然后下载发布规

则(下载地址:/s/1kz70i),下面给大家截图说明使用

方法:

下载好火车头采集器解压如下图

以上是发布规则的使用方法

接下来咱们说一下采集规则的使用方法,首先下载特价猫、燕子团和秒杀通的采集规则(下载地址:

/s/1ntiHlJb,并以其中一个为例来截图说明,下面截图怎么操作:

打开所下载软件解压的文件夹,

完成以上各部之后就可以采集了。

可以到我的网站看看采集效果 更多火车头采集器交流请加群:235830061

本文出自:

/article/read/id/1263. html,若转载,请注明出处。

火车头采集器介绍及使用流程说明

处理之后的效果

四、采集内容

• 备注:

• 前后字符串截取与正则提取是火车头最基本、最常用的两种采集方式,其原 理就是通过网页源代码中的前后关键字来获取所要采集的内容,通常这类前 后的关键字在网页源代码中具有一定的唯一性。

五、字段处理

• 火车头采集器除了有最基本的采集截取之外,还有大量的对数据自动 作特殊处理的功能。 • 内容替换:内容替换功能是将采集后的字段中的一些内容替换成需要 的格式,如有时采到的日期为xxxx年xx月xx日,而我们需要xxxx-xx-xx 的格式,就可以采取这个功能。

火车头采集器 介绍及使用流程说明

目录

一、软件介绍 二、创建任务 三、采集网址 四、采集内容 五、字段处理

一、软件介绍

• 《火车采集器》能为您做些什么呢? 1、网站内容维护:可以定时采集新闻、文章等任何您想采集的内容, 并自动发布到您的网站。 2、Internet数据挖掘:可以从指定网站抓取所需数据,通过分析和处 理后保存到您的数据库。 3、网络信息监控:通过自动采集,可以监控论坛等社区类网站,让 您第一时间发现您所关注的内容。 4、文件批量下载:可以批量下载PDF、RAR、图片等各种文件,并同 时采集其相关信息。 火车采集器是目前信息采集与信息挖掘处理类软件中最流行、性价比 最高、使用人数最多、市场占有率最大、使用周期最长的智能采集程 序。

选中即可

五、字段处理

• 采集记录筛选 • 有时有些记录不需要怎么办?火车采集器的记录筛选功能可以完成这 个工作。火车采集器记录筛选有以下几个处理方法: • 选中“内容过滤”就可对数据进行相关的过滤,如不得为空、不得重 复等。

五、字段处理

• 标签组合 • 有时我们会需要取几个字段来做数据的唯一性判断时就会用到标签组 合采集。

火车头采集器使用教程

1、火车头介绍2、什么是信息采集3、什么是火车头4、火车头是干啥的5、火车头规则定制6、规则编写流程7、采网址详解8、采内容详解9、注意事项什么是火车头?我们打开一个网站,看到有一篇文章很不错,于是我们就将文章的标题和内容复制了一下,将这篇文章转到我们的网站上.我们的这个过程,就可以称作一个采集,将别人网站上对自己有用的信息转到自己网站上;互联网上的内容,大多数都是通过复制-修改-黏贴的过程产生的,所以信息采集很重要,也很普遍,我们平台发到网站上的文章,多数也是这样的一个过程;为什么很多人感觉新闻更新很麻烦,因为这个工作是重复的,枯燥乏味的,浪费时间的;火车头是目前国内使用人数最多、功能最完善、网站程序支持最全面、数据库支持最丰富的软件产品;现在是大数据时代,它可以快速、批量、海量的获取到互联网上的数据,并按照我们需要的格式存储起来;说的简单一点,对我们来说有什么用?我们需要更新新闻,需要发商机,如果让你准备1000篇文章,你要用多久?5个小时?在有规则的情况下,火车头只需要5分钟!前提是有规则,所以我们要先学写规则,写规则如果数量的话,一个规则几分钟就好了,但刚开始学的时候会比较慢;名称解释与规则编写流程以火车头8.6版本为准第1步:打开—登录第2步:新建分组第3步:右击分组,新建任务,填写任务名;第4步:写采集网址规则(起始网址和多级网址获取)第5步:写采集内容规则(如标题、内容)第6步:发布内容设置勾选启用方式二(1)保存格式:一条记录保存为一个txt;(2)保存位置自定义;(3)文件模板不用动;(4)文件名格式:点右边的倒立笔型选[标签:标题];(5)文件编码可以先选utf-8,如果测试时数据正常,但保存下来的数据有乱码则选gb2312;第7步:采集设置,都选100;a.单任务采集内容线程个数:同时可以采集几个网址;b.采集内容间隔时间毫秒数:两个任务的间隔时间;c.单任务发布内容线程个数:一次保存多少条数据;d.发布内容间隔时间毫秒数:两次保存数据的时间间隔;附注:如果网站有防屏蔽采集机制(如数据很多但只能采集一部分下来,或提示多久才能打开一次页面),则适当调小a值和调大b的值;第8步:保存、勾选并开始任务(如果是同一分组的,可以在分组上批量选中)以前的方式:比如我要准备n篇文章,要先找到这个文章是在哪个网站上的(如是采集同行A还是同行B),是在其哪个栏目下的(如是产品信息还是新闻信息),在这个栏目下有n条信息,我要选哪一条,然后进去后把标题复制下来,把内容复制下来再进到另一个页面把标题内容复制下来,以此类推,然后同样的流程我要执行n遍;怎么转换:怎么把这个流程转化为软件操作呢?我要准备n篇新闻,这就表明要n个标题+对应的内容,要n个新闻链接,这n个新闻链接是从一个网站的新闻栏目上找的,而这个网站的新闻栏目有可能是很多页,比如10页,这个时候再从同行A的网站—栏目—内页;即先找到要采集的网站,打开这个网站的栏目页(确定好是采集新闻还是产品),写网址规则采集栏目下的所有新闻链接,然后写内容规则采集所有新闻链接中的标题和内容,最后保存下来;采网址详解-具体操作找到要采集网址的栏目页,如新闻栏目复制栏目的第一页链接url,起始网址右侧中点添加,在单条网址中黏贴栏目的第一页链接后点添加,如用右边的(*)代替,因为第1页已经添加了,还剩9页,这时在等差数列那一行把项数改成9,首项是2(因为第2页的链接是,然后点添加-完成;1、点对应右侧的添加,然后如下图所示是示例,右侧大图是说明;2、点击保存后点右下角的看看是否能采集到新闻网址,如果能采集到则正确,双击一个新闻网址进到下一步;如果采集到的不正确,返回修改直到成功;网址过滤可以自己观察其对应的规律;1、到采集内容规则这里后,把作者、时间、出处都选中后删掉,如右面第一张图,因为这些标签正常情况下都用不到;2、选中标题标签点修改,或直接双击该标签,进入编辑界面;3、进入后标签名的“标题”别改,改过后是要改对应的模板的;4、下面的数据提取方式:前后截取和开始结束字符串,也尽量用默认的,在不熟练的情况下不要改;5、点击下面数据处理的添加—内容替换,如右图;6、内容替换将标题后面的都替换为空,如果不替换的话采集的是页面title,这时需要打开两个新闻页面,看看这两个新闻页面的公共部分是什么,把公共部分替换掉例:如下面两个标题,“- 顶尖SEO团队”是公共部分,即把其替换为“空”;【图文】你知道螺旋加料机的加工方法吗螺旋加料机原理你了解吗【图文】气动式加料机的优点是什么你知道粉末加料机工作原理吗例:如下面的则需要把“-健康网”替换成“空”;例:如下面的则需要把“-健康网”替换成“空”;我喜欢吃西瓜-健康网苹果好吃吗?-健康网1、选中内容点编辑,或直接双击进入到内容标签编辑界面,标签名千万别改;2、写开始和结束字符串,就是找能把所有新闻都包裹起来的,在所有新在所有新闻页面中都是闻页面中都有的,且是唯一的一段字符串;即这个页面模板中的唯一代码串;举例:采集内容的时候,需要选择内容区域,因为要采集的可能是n篇,如100篇,这个时候就需要想法怎么能写一个采集到全部的,方法就是打开两个新闻链接如,查看第一篇新闻的源文件,找到新闻正文,然后向上找离新闻第一句话最近的,在这个页面中是唯一的一段代码(如果不唯一,软件能知道从第几个开始吗?),但又不是新闻中的内容,如<div id=“zoom”>,复制后在第二篇新闻页面源文件中搜一下看看有没有,如果有,则可采用;同理找到新闻最后一句话,向下找离其最近的页面中唯一的一段代码,复制后在第二篇新闻页面源文件中搜一下看看有没有,如果有,则可采用;数据处理:因为采集的是其他网站的信息,里面有可能有其他网站的资料,如公司名、联系方式、品牌等信息,也可能有其他网站的超链接等信息,这个时候就需要对信息进行过滤处理;数据处理—添加—下面对应的参数HTML标签过滤:滚动轴横向拉到最后,在所有标签前面打钩后点确定;内容替换:将这个网站的信息替换成自己的,原则是先整后拆,有公司名、电话号(拆分)、手机号(拆分)、邮箱、公司地址(拆分)、品牌名、网址(拆分);其中拆分的意思是对这个数据进行拆解替换,这个时候就需要做如下替换:因为在新闻中,,这是时候就需要对其拆解替换才能替换干净,可以多看一下他的新闻中,可能会用什么样的格式;注:数据处理还有很多技巧,需要自己在使用的过程中琢磨,更是采集的核心,如果处理不好,有可能是为他人做嫁衣,所以一定要仔细观察,考虑全面,如果处理好了,采集下来的文章甚至可以直接就发布(非自己企业站)注意事项1、右击分组:会出现如下图菜单,正常都能用到;新建任务:在此分组上新建任务;运行该分组下所有任务:顾名思义;新建任务:在该分组下再建分组;编辑/删除分组:编辑/删除当前分组;导入/导出分组规则:可以导出当前分组下的所有任务,并导入到同版本火车头上;导入任务至该分组:将导出的单个任务导入到该分组下面;黏贴任务到该分组下:要复制过任务后此项才出现,可以黏贴多个同样的任务,然后再黏贴后的任务上进行编辑即可;开始任务:和菜单栏上的开始一样;编辑任务:编辑已经写好的任务;导出任务:可以将当前规则导出,在其他同版本工具上导入,但导入数据时需重复上面的第6步-发布内容设置,必须要重新选/填一遍;复制任务到黏贴板:复制后,选择一个任务分组并右击,可以黏贴不同数量的任务到那个分组中,这样就避免同一个任务多次编写了;清空任务所有采集数据:新如果之前采集过任务想重新采集的,则需求先清空;3、其他设置:顶部菜单栏中点击工具—选项,配置全局选项和默认选项;全局选项:可以调整下同时运行任务最大个数,正常是5即可,可不调;默认选项:是否忽略大小写点是;。

火车头采集器-采集与发布带图片的文章

火车头采集器-采集与发布带图片的文章如何使用火车头采集器火车头采集器7.6 免费版,功能有很多限制,但我已使用它实现了采集与发布(带图片、排版)。

图片是通过采集程序下载到本地,放在一个约定好名字的文件夹中,最后人工上传到服务器DZ程序运行目录下的pic目录下。

下载火车头采集器7.6版本LocoySpider_V7.6_Build20120912.Free.zip,解决后可运行。

需要.NET 环境。

程序是Discuz!X 2.5 GBK版本。

核心工作有两部分:1、采集,2、发布。

本文重点说如何发布(带图片、排版),简单说如何采集。

一、新建一个使用UBB格式的Web在线发布模块因为采集下来的文章内容是HTML格式,如:正文这样带有HTML标签的文本。

而DZ论坛使用的是UUB格式,如:[p]正文[/p],所以在发布时要做一个自动转换。

下面就是设置这个自动转换功能。

如果你的文章发布的DZ门户,就不需要转换为UBB.1、打开发布模块配置:2、以软件里自带的Discuz!X 2.0论坛为模板进行修改。

我试过了可以正常住Discuz!X 2.5发布文章。

3、设置为:对[标签: 内容]做UBB转换,如下图中的样子:最后,另存为一个新的“发布模块”,起一个新名字,后面要使用。

4、在“内容发布参数”选项卡中修改:[标签: 内容] 的值可以用使用{0} 来替代。

如下图:黄色框内的[标签: 内容]替换成{0},如下图第一部分工作就完成了。

二、使用Web在线发布模块前面我新建了一个新的Web在线发布模块,下面就是使用它。

第一步:新一个“发布”,操作如下图:注意:请到论坛的后台修改设置,要求登录时不需要输入验证码,才能登录成功,才能测试成功,记得以后要改回来啊。

最后保存时要起个新名字。

三、准备采集这里以火车自带的采集演示来说明。

鼠标右击“腾讯新闻”—“编辑任务”,打开如下窗口。

如下图设置,使用前一步建立的“发布模块”,可以把采集到的内容发布到论坛的某个栏目中。

火车头采集教程讲解(附图)

到这里,我们的地址就添加完成了。。。那么下边,我们来设置区域列表。。。

我们先设置第一个。。。“文章内容页面地址必须包含。。。不得包含。。。” 我们随便点开 /forum-60-1.html 这个网址中的两篇文章,看下 URL。。 就是文章地址。。 /thread-88312-1-1.html /thread-88373-1-1.html 发现以上两个地址。。。那么他们其中只有 /thread-88373-1-1.html 红 色部分在变动。。。那么,文章内容必须包含。。。我们写 /thread-(*)-(*)-(*).html 这样就可以,那么我们点击“开始测试网 址采集”

这个,也可以采集成功。。。 那么,为了让大家更直白的了解火车,我们还是写一下。。。。 那么我们打开 /forum-60-1.html 这个地址,在页面中,点击右键,选 择“查看源文件”(因为不好截图。。。)

发现上边的东西出现,都是一些猥琐的 html 代码。。。 我们怎么定义文章地址的区域呢?看下图

<!DOCTYPE html PUBLIC "-//W3C//DTD XHTML 1.0 Transitional//EN"

"/TR/xhtml1/DTD/xhtml1-transitional.dtd">

<html xmlns="/1999/xhtml">

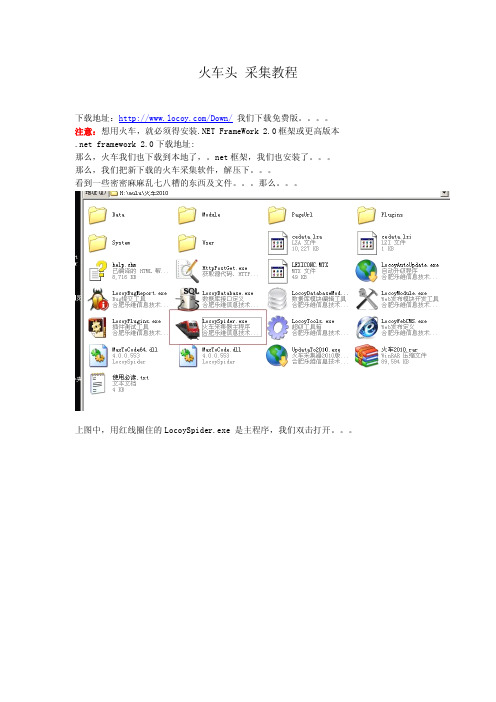

上图中,用红线圈住的 LocoySpider.exe 是主程序,我们双击打开。。。

ps:这里说下,上图中,有好多任务是我自己用的。。。新程序,并没有那么多。。。 我们会看到火车的界面,看起来非常复杂,是吧? 呵呵,其实并没有那么复杂,对于新手, 有好多东西是用不到的。。。下边会一一的讲解。。。 我们先补习一下,火车头采集软件的工作原理。。。 因为我们浏览到的网页,最后都是通过 html 输出的,那么意味着,我们可以查看到 html 的源码,那么火车头为什么会采集到内容呢? 我们看下网站的基本结构。。。

火车头采集文章锻炼排序

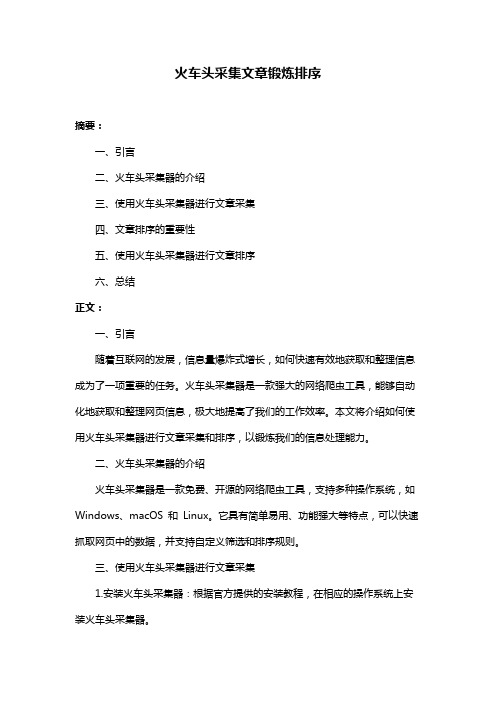

火车头采集文章锻炼排序摘要:一、引言二、火车头采集器的介绍三、使用火车头采集器进行文章采集四、文章排序的重要性五、使用火车头采集器进行文章排序六、总结正文:一、引言随着互联网的发展,信息量爆炸式增长,如何快速有效地获取和整理信息成为了一项重要的任务。

火车头采集器是一款强大的网络爬虫工具,能够自动化地获取和整理网页信息,极大地提高了我们的工作效率。

本文将介绍如何使用火车头采集器进行文章采集和排序,以锻炼我们的信息处理能力。

二、火车头采集器的介绍火车头采集器是一款免费、开源的网络爬虫工具,支持多种操作系统,如Windows、macOS 和Linux。

它具有简单易用、功能强大等特点,可以快速抓取网页中的数据,并支持自定义筛选和排序规则。

三、使用火车头采集器进行文章采集1.安装火车头采集器:根据官方提供的安装教程,在相应的操作系统上安装火车头采集器。

2.创建新项目:打开火车头采集器,点击“新建”按钮,创建一个新的项目。

3.添加任务:在项目列表中,点击“添加任务”按钮,选择“采集任务”,填写任务名称、URL 和抓取间隔等信息。

4.设置采集规则:在任务中添加采集规则,选择需要抓取的网页元素,如标题、内容、图片等。

5.保存并运行任务:完成采集规则设置后,点击“保存”按钮,然后点击“运行”按钮,开始执行采集任务。

四、文章排序的重要性对于采集到的文章,有时需要按照一定的规则进行排序,以方便我们阅读和整理。

文章排序可以帮助我们更快地找到所需的信息,提高我们的工作效率。

五、使用火车头采集器进行文章排序1.创建自定义字段:在火车头采集器中,点击“数据”菜单,选择“自定义字段”,添加需要排序的字段,如时间、关键词等。

2.设置排序规则:在采集任务中,选择需要排序的字段,设置升序或降序排列。

3.保存并运行任务:完成排序规则设置后,点击“保存”按钮,然后点击“运行”按钮,开始执行采集任务。

此时,采集到的文章将按照设定的规则进行排序。

火车头采集:如何下载文章里面的图片

火车头采集:如何下载文章里面的图片火车头采集:如何下载文章里面的图片很多客户会采集文字信息,但是就是不会下载图片,现在我给大家说一下怎么下载图片。

比如我们要下载这篇文章的图片/jingdian/sichuan/2009/0910/21770.html,首先采集到这篇文章的内容,采集完内容之后我们开始处理图片的下载。

你如果直接点击下载图片肯定是不行的,因为采集器下载图片的格式必须是标准的这种<img src='参数'/>格式,其中参数表示完整的图片地址。

一般文章里面的图片都不是这种标准的格式,而且源代码里面的图片地址也不一定是完整的,比如上面这个例子,源代码里面图片的格式这样的<img height='345' alt='' width='600' border='0' src='..\..\..\uploads\090910\1_163419_1.jpg' />,所以我们要把这种不标准的格式替换成标准的图片格式,并且把源代码里面的图片地址补完整。

经过这个替换之后原来的图片的img格式就替换为采集器可以识别的标准格式了。

如果文章内容里面只有图片的部分地址,没有img格式,处理方法是一样的,比如上面的文章的图片地址可以从两个地址获取到,我们也可以从这个链接这里获取到,也可以这样内容替换,将这个<a target='_blank' href='..\..\..\uploads\参数\参数'>替换为<img src='/jingdian/uploads/[参数1]/[参数2]'/>,不管怎么处理。

最终采集的时候是标准的img格式就可以了。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

如何使用火车头采集器

火车头采集器7.6 免费版,功能有很多限制,但我已使用它实现了采集与发布(带图片、排版)。

图片是通过采集程序下载到本地,放在一个约定好名字的文件夹中,最后人工上传到服务器DZ程序运行目录下的pic目录下。

下载火车头采集器7.6版本LocoySpider_V7.6_Build20120912.Free.zip,解决后可运行。

需要.NET 环境。

程序是Discuz!X 2.5 GBK版本。

核心工作有两部分:1、采集,2、发布。

本文重点说如何发布(带图片、排版),简单说如何采集。

一、新建一个使用UBB格式的Web在线发布模块

因为采集下来的文章内容是HTML格式,如:<p>正文</p>这样带有HTML标签的文本。

而DZ论坛使用的是UUB格式,如:[p]正文[/p],所以在发布时要做一个自动转换。

下面就是设置这个自动转换功能。

如果你的文章发布的DZ门户,就不需要转换为UBB.

1、打开发布模块配置:

2、以软件里自带的Discuz!X 2.0论坛为模板进行修改。

我试过了可以正常住Discuz!X 2.5发布文章。

3、设置为:对[标签: 内容]做UBB转换,如下图中的样子:

最后,另存为一个新的“发布模块”,起一个新名字,后面要使用。

4、在“内容发布参数”选项卡中修改:[标签: 内容] 的值可以用使用{0} 来替代。

如下图:

黄色框内的[标签: 内容]替换成{0},如下图

第一部分工作就完成了。

二、使用Web在线发布模块

前面我新建了一个新的Web在线发布模块,下面就是使用它。

第一步:新一个“发布”,操作如下图:

注意:请到论坛的后台修改设置,要求登录时不需要输入验证码,才能登录成功,才能测试成功,记得以后要改回来啊。

最后保存时要起个新名字。

三、准备采集

这里以火车自带的采集演示来说明。

鼠标右击“腾讯新闻”—“编辑任务”,打开如下窗口。

如下图设置,使用前一步建立的“发布模块”,可以把采集到的内容发布到论坛的某个栏目中。

设置如下图:

下面还有图:

对于采集工作,还有一些重要的设置,很重要。

如果你不是使用火车头自带的演示任务,而是自己新建采集任务,下面的内容就很重要。

下面的设置,是对采集的文章正文进行的设置。

“开始字符串”,“结束字符串”是所有设置中最重要的内容,它用来分析页面的HTML源码,找出文章正文的开始点与结束点。

下图中使用的是火车头为腾讯准备默认值,不需要修改。

如果你不采集腾讯而采其它网站,这个就要你自己看HTML源码来人工分析了。

采集时,可选择性的过滤掉一些HTML标签,如<script><iframe>,

如果你不知道要去掉哪些,就什么也不用改,使用默认值吧。

下载的图片存目录设置

图片下载后被保存在:

火车头软件安装目录\Data\LocoySpider\80\ 文件夹中。

为什么叫80,其实叫什么都可以,但为了方便管理,这个腾讯采集任务编号是80,所以放在80文件夹中。

以后是腾讯采集任务,采集下来图片都放在这里,方便管理。

腾讯采集任务编号,请再后面一张图片中查看。

客户通过浏览器访问我论坛的文章里的图片时,统一访问服务器上DZ程序的根目录下的./pic/目录,使用相对路径,pic目录下面我们再新建一个80目录,

所以,把火车头安装目录下的\Data\LocoySpider\中的80 文件夹,COPY到服务器DZ程序的根目录下的pic目录中,这样,图片就存储在了:服务器DZ程序的根目录\pic\80\ 目录

同时文章中的图片的地址是指向./pic/80/xxx.jpg 。

文章就可以显示图片了。

补充:后来经过实践,目录定为:/data/attachment/pic ,好处是:为了通过程序取文章中的第一张图片做为文章的“封面”,这个路径是合适的。

四、什么样的数据容易采集

请看这个新闻列表:/newsgn/zhxw/shizhengxinwen.htm

有文章列表的、URL地址有规律的文章,容易采集。

采集时优先找以上条件的文章进行采集。

一般知名大网站都可以。

知名大网站页面的HTML源码很简洁,方便人工分析,找出文章正文起点与终点的HTML标记。

.。