机器学习十大算法的每个算法的核心思想、工作原理、适用情况及优缺点

总结机器学习小白必学的10种算法

总结机器学习小白必学的10种算法

在机器学习中,有一种叫做「没有免费的午餐」的定理。

简而言之,它指出没有任何一种算法对所有问题都有效,在监督学习(即预测建模)中尤其如此。

例如,你不能说神经网络总是比决策树好,反之亦然。

有很多因素在起作用,例如数据集的大小和结构。

因此,你应该针对具体问题尝试多种不同算法,并留出一个数据「测试集」来评估性能、选出优胜者。

当然,你尝试的算法必须适合你的问题,也就是选择正确的机器学习任务。

打个比方,如果你需要打扫房子,你可能会用吸尘器、扫帚或拖把,但是你不会拿出铲子开始挖土。

大原则

不过也有一个普遍原则,即所有监督机器学习算法预测建模的基础。

机器学习算法被描述为学习一个目标函数f,该函数将输入变量X 最好地映射到输出变量Y:Y = f(X)

这是一个普遍的学习任务,我们可以根据输入变量X 的新样本对Y 进行预测。

我们不知道函数 f 的样子或形式。

如果我们知道的话,我们将会直接使用它,不需要用机器学习算法从数据中学习。

最常见的机器学习算法是学习映射Y = f(X) 来预测新X 的Y。

这叫做预测建模或预测分析,我们的目标是尽可能作出最准确的预测。

对于想了解机器学习基础知识的新手,本文将概述数据科学家使用的top 10 机器学习算法。

1. 线性回归

线性回归可能是统计学和机器学习中最知名和最易理解的算法之一。

预测建模主要关注最小化模型误差或者尽可能作出最准确的预测,以可解释性为代价。

我们将借用、重用包括统计学在内的很多不同领域的算法,并将其用于这些目的。

机器学习算法的原理及应用分析

机器学习算法的原理及应用分析机器学习一直是人工智能研究领域中的热门话题。

随着互联网的发展和智能设备的普及,机器学习的应用范围越来越广泛。

机器学习算法是机器学习的关键组成部分。

本文将介绍机器学习算法的原理和应用分析。

一、机器学习算法的原理机器学习算法指的是用于从数据中提取模式和规律的计算机程序,其基本原理是通过将输入数据与所需输出数据进行比对,找到相应的规律和模式。

机器学习算法主要分为三种类型:监督学习、无监督学习和强化学习。

1.监督学习监督学习是指通过给算法提供已知数据来进行训练,从而让算法能够进行推断和预测。

常见的监督学习算法有决策树、朴素贝叶斯、支持向量机和神经网络等。

决策树是一种基于树状结构进行决策的算法,它的每个节点都表示一个属性,每个叶子节点都表示一个分类。

通过将样本集递归地进行划分,最终得到一个决策树。

朴素贝叶斯算法是一种基于贝叶斯定理和特征条件独立假设的算法。

它通过统计每个特征的类别和条件概率来计算分类概率。

支持向量机是一种基于间隔最大化的分类算法。

它通过寻找一个最优的超平面将数据进行分类。

神经网络算法是一种模仿人类神经系统进行学习和推断的算法。

它通过一系列神经元的相互连接来实现数据的分类和预测。

2.无监督学习无监督学习是指在没有给定数据的类别标签的情况下,通过对数据的统计特征进行分析,来获取数据内在的结构和模式。

常见的无监督学习算法有聚类和降维等。

聚类算法是一种基于相似度度量的算法,它将数据集划分为若干个簇,每个簇内的数据相似度较高,而簇间的相似度较低。

降维算法是一种将高维数据投影到低维空间的算法,它可以帮助我们在不损失重要信息的前提下,降低计算复杂度。

3.强化学习强化学习是一种通过试错的方法来学习和优化策略的机器学习算法。

它通常工作在环境和智能体的交互中,智能体在环境中采取不同的动作,从而获得奖励或惩罚。

常见的强化学习算法有Q-learning和Deep Q-network等。

机器学习算法解析

机器学习算法解析随着人工智能技术的不断发展,机器学习已经成为了其中非常重要的一部分。

机器学习算法则是机器学习领域的核心,它能够让机器自动地从数据中学习模型,从而能够更好地完成各种任务。

在本文中,我们将对机器学习算法进行解析,以帮助读者更好地了解这一领域。

一、机器学习算法的分类机器学习算法可以被分为监督学习、无监督学习和增强学习三类。

监督学习是指通过输入-输出数据对来进行学习,这类算法需要有标记的数据作为输入,从中学习出一个模型,然后对新的数据进行预测。

无监督学习是指从没有标记的数据中学习模型,这类算法通常用于聚类和降维等任务。

增强学习则是一类通过与环境交互的方式来进行学习的算法,其目的在于通过与环境的交互来学习出一个策略,并进行优化。

二、机器学习算法的常见模型1.线性模型线性模型是一种通过线性方程来描述变量之间关系的模型。

线性回归和逻辑回归是线性模型的代表,它们常被用于解决分类和回归问题。

2.决策树决策树是一种通过树形结构描述分类和回归问题的模型。

它将数据分割成一系列的分支和节点,在每个节点上通过对某个特征的判断来进行分类或回归。

3.支持向量机支持向量机通常用于解决分类问题,它通过一个超平面将数据分为两类,并最大化两类数据点到超平面的距离。

它的优点在于能够对高维数据进行分类。

4.朴素贝叶斯朴素贝叶斯是一种基于贝叶斯定理的分类算法,它假设每个特征之间是独立的。

在分类时,朴素贝叶斯算法将根据每个特征的概率来计算某个类别的概率。

5.神经网络神经网络模型是一种通过仿真大脑神经元之间的交互来解决问题的模型。

它通常用于解决分类和回归问题,需要大量的训练数据和计算资源。

三、机器学习算法的优缺点机器学习算法具有以下优点:1.能够对大型数据进行处理,从而能够发现数据中潜在的结构和规律。

2.能够自动地处理数据,从而能够提高工作效率。

3.能够不断地通过数据进行更新和优化,从而能够提高准确性。

但机器学习算法也存在一些缺点:1.需要大量的数据和计算资源来进行训练。

机器学习必知的10大算法

机器学习必知的10大算法机器学习算法可以分为三大类:监督学习、无监督学习和强化学习。

以下介绍 10 个关于监督学习和无监督学习的算法。

•监督学习可用于一个特定的数据集(训练集)具有某一属性(标签),但是其他数据没有标签或者需要预测标签的情况。

•无监督学习可用于给定的没有标签的数据集(数据不是预分配好的),目的就是要找出数据间的潜在关系。

•强化学习位于这两者之间,每次预测都有一定形式的反馈,但是没有精确的标签或者错误信息。

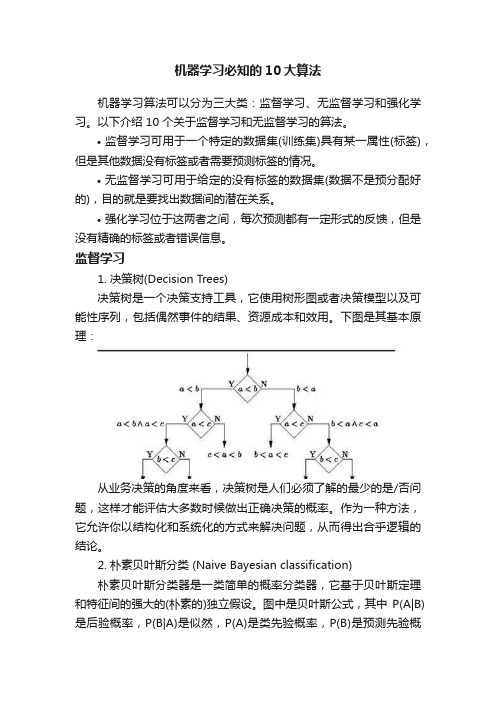

监督学习1. 决策树(Decision Trees)决策树是一个决策支持工具,它使用树形图或者决策模型以及可能性序列,包括偶然事件的结果、资源成本和效用。

下图是其基本原理:从业务决策的角度来看,决策树是人们必须了解的最少的是/否问题,这样才能评估大多数时候做出正确决策的概率。

作为一种方法,它允许你以结构化和系统化的方式来解决问题,从而得出合乎逻辑的结论。

2. 朴素贝叶斯分类 (Naive Bayesian classification)朴素贝叶斯分类器是一类简单的概率分类器,它基于贝叶斯定理和特征间的强大的(朴素的)独立假设。

图中是贝叶斯公式,其中P(A|B)是后验概率,P(B|A)是似然,P(A)是类先验概率,P(B)是预测先验概率。

一些应用例子:判断垃圾邮件对新闻的类别进行分类,比如科技、政治、运动判断文本表达的感情是积极的还是消极的人脸识别3. 最小二乘法(Ordinary Least Squares Regression)如果你懂统计学的话,你可能以前听说过线性回归。

最小二乘法是一种计算线性回归的方法。

你可以将线性回归看做通过一组点来拟合一条直线。

实现这个有很多种方法,“最小二乘法”就像这样:你可以画一条直线,然后对于每一个数据点,计算每个点到直线的垂直距离,然后把它们加起来,那么最后得到的拟合直线就是距离和尽可能小的直线。

线性指的是你用来拟合数据的模型,而最小二乘法指的是你最小化的误差度量。

机器学习常用算法解析

机器学习常用算法解析机器学习是计算机科学与人工智能的一个分支,其目的是让机器通过数据和算法的学习,实现特定任务。

在机器学习领域中,算法是非常重要的组成部分,各种算法模型不仅有着不同的特点,而且适用于不同的场景。

本文将介绍机器学习中常用的算法,包括线性回归、决策树、支持向量机、朴素贝叶斯、神经网络等。

一、线性回归算法线性回归算法是机器学习中最常用的算法之一,其用于预测因变量与一个或多个自变量之间的关系。

例如,在预测一个房子的售价中,我们可以将房屋面积作为自变量,而售价作为因变量。

根据已有数据进行模型训练,我们可以得到一个线性方程,即y = mx + b,其中y为因变量,x为自变量,m和b分别为斜率和截距。

通过这个方程,我们可以根据房屋面积预测出售价。

二、决策树算法决策树算法是一种基于树结构的分类与回归方法,其将数据集分成多个小组,并且根据特定规则进行分组。

每个节点代表一个属性,每个分支代表一个判断条件,通过比较分支上不同属性的取值,进行不同类别的分类。

决策树算法的优势在于模型可解释性高、易于理解和实现。

常用的决策树算法有ID3、C4.5和CART等。

三、支持向量机算法支持向量机算法是一种用于二分类和多分类的有监督学习方法。

其基本思想是寻找一个最优的超平面,将数据集分成不同的类别。

其中,超平面可以是一个线性的判定面,或者是一个非线性的判定面。

支持向量机算法在实际应用中广泛,其在文本分类、图像分类、手写数字识别等领域有着广泛应用。

四、朴素贝叶斯算法朴素贝叶斯算法是统计学习中的一种算法,其基于贝叶斯定理,假设各个特征之间是独立的。

在分类问题中,朴素贝叶斯算法可以计算出一个样本属于各个类别的概率,并将概率最大的类别作为分类结果。

在文本分类、垃圾邮件过滤、情感分析等领域有着广泛应用。

五、神经网络算法神经网络算法是机器学习中的一种模拟人类神经元之间相互连接和相互作用的算法模型。

它模拟生物神经元之间的相互作用,通过多层神经元的迭代训练,学习到输入与输出之间的关系。

人工智能十大算法总结(精选五篇)

人工智能十大算法总结(精选五篇)第一篇:人工智能十大算法总结5-1 简述机器学习十大算法的每个算法的核心思想、工作原理、适用情况及优缺点等。

1)C4.5 算法:ID3 算法是以信息论为基础,以信息熵和信息增益度为衡量标准,从而实现对数据的归纳分类。

ID3 算法计算每个属性的信息增益,并选取具有最高增益的属性作为给定的测试属性。

C4.5 算法核心思想是ID3 算法,是ID3 算法的改进,改进方面有:1)用信息增益率来选择属性,克服了用信息增益选择属性时偏向选择取值多的属性的不足;2)在树构造过程中进行剪枝3)能处理非离散的数据4)能处理不完整的数据C4.5 算法优点:产生的分类规则易于理解,准确率较高。

缺点:1)在构造树的过程中,需要对数据集进行多次的顺序扫描和排序,因而导致算法的低效。

2)C4.5 只适合于能够驻留于内存的数据集,当训练集大得无法在内存容纳时程序无法运行。

2)K means 算法:是一个简单的聚类算法,把n 的对象根据他们的属性分为k 个分割,k < n。

算法的核心就是要优化失真函数J,使其收敛到局部最小值但不是全局最小值。

其中N 为样本数,K 是簇数,rnk b 表示n 属于第k 个簇,uk 是第k 个中心点的值。

然后求出最优的uk优点:算法速度很快缺点是,分组的数目k 是一个输入参数,不合适的k 可能返回较差的结果。

3)朴素贝叶斯算法:朴素贝叶斯法是基于贝叶斯定理与特征条件独立假设的分类方法。

算法的基础是概率问题,分类原理是通过某对象的先验概率,利用贝叶斯公式计算出其后验概率,即该对象属于某一类的概率,选择具有最大后验概率的类作为该对象所属的类。

朴素贝叶斯假设是约束性很强的假设,假设特征条件独立,但朴素贝叶斯算法简单,快速,具有较小的出错率。

在朴素贝叶斯的应用中,主要研究了电子邮件过滤以及文本分类研究。

4)K 最近邻分类算法(KNN)分类思想比较简单,从训练样本中找出K个与其最相近的样本,然后看这k个样本中哪个类别的样本多,则待判定的值(或说抽样)就属于这个类别。

快速入门机器学习:10个常用算法简介

快速入门机器学习:10个常用算法简介1. 引言1.1 概述:机器学习是一门涉及分析数据和构建预测模型的领域,它能够让计算机通过从数据中学习规律、模式和知识,作出智能决策或预测。

随着人工智能和大数据的快速发展,机器学习在各个领域都获得了广泛应用。

本篇文章将给读者带来关于机器学习中最常用的10种算法的简介。

无论你是刚刚开始接触机器学习还是想要巩固自己对这些算法的理解,这篇文章都会为你提供一个快速入门的指南。

1.2 文章结构:本文将按照以下结构展开内容:- 引言:简要介绍文章背景和目标。

- 机器学习简介:第二节将讨论机器学习的定义、应用领域以及发展历程。

- 常用算法类型:第三节将解释三种常见的机器学习算法类型:监督学习、无监督学习、半监督学习。

- 常用机器学习算法简介:第四节将深入探讨三种常见的监督学习算法:线性回归模型、逻辑回归模型和决策树算法。

- 其他常用算法简介:第五节将介绍三种其他常用的机器学习算法:支持向量机(SVM)、K均值聚类算法(K-means)和随机森林(Random Forest)。

通过这样的文章结构,读者们将能够对不同类型的算法有一个清晰的概念,并且了解每个算法的基本原理和应用场景。

1.3 目的:本文的目标是帮助读者快速了解机器学习中最常用的十种算法。

通过这篇文章,读者可以获得对于这些算法的基本认知,并且能够判断何时使用某个特定的算法以及如何开始在实际问题中应用它们。

我们相信,通过阅读本文,您将收获关于机器学习算法的全面理解,并且为进一步学习和探索领域打下坚实基础。

让我们一起开始这个令人兴奋而又有趣的旅程吧!2. 机器学习简介2.1 定义机器学习是一种人工智能领域的研究分支,旨在通过计算机系统从数据中学习模式和规律,以便能够做出准确预测或自动决策,而无需明确编程。

机器学习的目标是建立能够自动进行学习和推断的算法和模型。

2.2 应用领域机器学习在许多领域都得到了广泛的应用。

例如,在医疗保健领域,机器学习可用于诊断疾病、制定治疗方案和预测患者病情。

机器学习算法的分类与比较

机器学习算法的分类与比较机器学习是人工智能领域的重要组成部分,它通过从数据中学习模式和规律,使计算机能够自动完成任务和做出决策。

在机器学习中,算法的选择是非常关键的,不同的算法适用于不同的问题场景。

本文将对机器学习算法进行分类与比较,帮助读者了解各种算法的优缺点及应用范围。

一、监督学习算法监督学习是机器学习中最常用的方法之一,它通过已知输入和输出的训练数据,建立一个模型来预测新的输入数据的输出。

以下是几种常见的监督学习算法:1. 岭回归(Ridge Regression):适用于线性回归问题,通过引入正则化项以解决过拟合问题。

2. 逻辑回归(Logistic Regression):适用于二分类问题,通过对样本进行概率建模,能够输出实例属于某个类别的概率。

3. 决策树(Decision Tree):根据特征的取值将样本逐步分割为不同的叶子节点,并学习出一系列规则用于分类问题。

4. 支持向量机(Support Vector Machine):通过找到一个最优超平面来实现对样本的分类,主要用于二分类问题。

5. 随机森林(Random Forest):将多个决策树进行组合,通过投票或平均值来进行分类,具有较好的鲁棒性和准确性。

二、无监督学习算法无监督学习是指从无标签数据中学习模型的机器学习方法,其目标是发现数据中的隐藏结构和模式。

以下是几种常见的无监督学习算法:1. K-means聚类算法:根据样本之间的距离将数据集划分为K个簇,每个簇内的样本具有相似性。

2. 主成分分析(Principal Component Analysis,PCA):通过线性变换将高维数据转换为低维数据,以尽可能保持数据的方差。

3. Apriori算法:用于关联分析,它通过频繁项集的挖掘来发现数据中的关联关系。

4. 高斯混合模型(Gaussian Mixture Model,GMM):假设数据由多个高斯分布组成,通过最大似然估计来估计分布的参数。

10 大常用机器学习算法,包括线性回归、Logistic 回归、线性判别分析、朴素贝叶斯、KNN、随机森林等

1.线性回归在统计学和机器学习领域,线性回归可能是最广为人知也最易理解的算法之一。

预测建模主要关注的是在牺牲可解释性的情况下,尽可能最小化模型误差或做出最准确的预测。

我们将借鉴、重用来自许多其它领域的算法(包括统计学)来实现这些目标。

线性回归模型被表示为一个方程式,它为输入变量找到特定的权重(即系数 B),进而描述一条最佳拟合了输入变量(x)和输出变量(y)之间关系的直线。

我们将在给定输入值 x的条件下预测 y,线性回归学习算法的目的是找到系数 B0 和 B1 的值。

我们可以使用不同的技术来从数据中学习线性回归模型,例如普通最小二乘法的线性代数解和梯度下降优化。

线性回归大约有 200 多年的历史,并已被广泛地研究。

在使用此类技术时,有一些很好的经验规则:我们可以删除非常类似(相关)的变量,并尽可能移除数据中的噪声。

线性回归是一种运算速度很快的简单技术,也是一种适合初学者尝试的经典算法。

2. Logist ic回归Logis t ic回归是机器学习从统计学领域借鉴过来的另一种技术。

它是二分类问题的首选方法。

像线性回归一样, Log is t ic回归的目的也是找到每个输入变量的权重系数值。

但不同的是,Logis t ic回归的输出预测结果是通过一个叫作「log is t ic函数」的非线性函数变换而来的。

log is t ic函数的形状看起来像一个大的「 S」,它会把任何值转换至 0-1 的区间内。

这十分有用,因为我们可以把一个规则应用于log is t ic函数的输出,从而得到 0-1区间内的捕捉值(例如,将阈值设置为 0.5,则如果函数值小于 0.5,则输出值为 1),并预测类别的值。

Logis t ic由于模型的学习方式,Logis t i c回归的预测结果也可以用作给定数据实例属于类 0 或类 1的概率。

这对于需要为预测结果提供更多理论依据的问题非常有用。

与线性回归类似,当删除与输出变量无关以及彼此之间非常相似(相关)的属性后, Log is t ic回归的效果更好。

机器学习和十大机器学习算法

15

Autoencoder

01.

自编码器是一种用于数据降维和异常检测的神经网络模型。它通过编码和解 码两个步骤来学习数据的低维表示,并用于数据压缩和异常检测等任务

02.

以上是一些常见的机器学习算法,它们在不同的任务和应用领域中都有广泛的应用。然而,机器学习 领域仍在快速发展,新的算法和技术不断涌现,为解决复杂的问题提供了更多的可能性

朴素贝叶斯是一种基于贝叶斯定理的分类器

x

它假设输入数据的每个特征之间是独立的,并使用这 个假设来计算输入数据属于每个类别的概率

6

逻辑回归

7

神经网络

8

01

梯度提升树是一 种通过迭代地添 加简单模型(如决 策树)来构建复杂 模型的方法

梯度提升树

02

这种方法在处理 大量特征和复杂 关系时特别有效

-

请各位老师批评指正!

THESIS DEFENSE POWERPOINT

XXXXXXXXXX

指导老师:XXX

答 辩 人 :XXX

以上就是常见的十大机器学习算法。然而,这只是冰 山一角,机器学习领域正在快速发展,每天都会有新 的算法和技术被提出

除了上述十大机器学习算法,还有一些其他的机器学 习算法也值得关注,例如

11

卷积神经网络(CNN)

卷积神经网络是一种专门用于处理图像数据的 神经网络

它通过使用卷积层、池化层和全连接层等组件 来学习图像中的特征,并用于图像分类、目标

1 线性回归 3 决策树和随机森林 5 朴素贝叶斯 7 神经网络 9 集成方法

-

2 支持向量机 4 K-近邻算法 6 逻辑回归 8 梯度提升树

10 贝叶斯网络

机器学习和十大机器学习算法

十种机器学习算法总结

⼗种机器学习算法总结⼴义来说,有三种机器学习算法1、监督式学习⼯作机制:这个算法由⼀个⽬标变量或结果变量(或因变量)组成。

这些变量由已知的⼀系列预⽰变量(⾃变量)预测⽽来。

利⽤这⼀系列变量,我们⽣成⼀个将输⼊值映射到期望输出值的函数。

这个训练过程会⼀直持续,直到模型在训练数据上获得期望的精确度。

监督式学习的例⼦有:回归、决策树、随机森林、K – 近邻算法、逻辑回归等。

2、⾮监督式学习⼯作机制:在这个算法中,没有任何⽬标变量或结果变量要预测或估计。

这个算法⽤在不同的组内聚类分析。

这种分析⽅式被⼴泛地⽤来细分客户,根据⼲预的⽅式分为不同的⽤户组。

⾮监督式学习的例⼦有:关联算法和 K – 均值算法。

3、强化学习⼯作机制:这个算法训练机器进⾏决策。

它是这样⼯作的:机器被放在⼀个能让它通过反复试错来训练⾃⼰的环境中。

机器从过去的经验中进⾏学习,并且尝试利⽤了解最透彻的知识作出精确的商业判断。

强化学习的例⼦有马尔可夫决策过程。

常见机器学习算法名单这⾥是⼀个常⽤的机器学习算法名单。

这些算法⼏乎可以⽤在所有的数据问题上:1. 线性回归2. 逻辑回归3. 决策树4. SVM5. 朴素贝叶斯6. K最近邻算法7. K均值算法8. 随机森林算法9. 降维算法10. Gradient Boost 和 Adaboost 算法1、线性回归线性回归通常⽤于根据连续变量估计实际数值(房价、呼叫次数、总销售额等)。

我们通过拟合最佳直线来建⽴⾃变量和因变量的关系。

这条最佳直线叫做回归线,并且⽤ Y= a *X + b 这条线性等式来表⽰。

理解线性回归的最好办法是回顾⼀下童年。

假设在不问对⽅体重的情况下,让⼀个五年级的孩⼦按体重从轻到重的顺序对班上的同学排序,你觉得这个孩⼦会怎么做?他(她)很可能会⽬测⼈们的⾝⾼和体型,综合这些可见的参数来排列他们。

这是现实⽣活中使⽤线性回归的例⼦。

实际上,这个孩⼦发现了⾝⾼和体型与体重有⼀定的关系,这个关系看起来很像上⾯的等式。

10种机器学习算法介绍

线性回归

针对线性回归容易出现欠拟合的问题,采取局部加权线性回归。

在该算法中,赋予预测点附近每一个点以一定的权值,在这上面基于波长函数来进行普通的线

性回归.可以实现对临近点的精确拟合同时忽略那些距离较远的点的贡献,即近点的权值大,远 点的权值小,k为波长参数,控制了权值随距离下降的速度,越大下降的越快。

缺点:

(1) SVM算法对大规模训练样本难以实施

(2) 用SVM解决多分类问题存在困难

经典的支持向量机算法只给出了二类分类的算法,而在数据挖掘的实际应用中,一般要解决多类 的分类问题。

朴素贝叶斯

#Import Library from sklearn.naive_bayes import GaussianNB #Assumed you have, X (predictor) and Y (target) for training data set and x_test(predictor) of test_dataset # Create SVM classification object model = GaussianNB() # there is other distribution for multinomial classes like Bernoulli Naive Bayes, Refer link # Train the model using the training sets and check score model.fit(X, y) #Predict Output predicted= model.predict(x_test)

终止树

(1)节点达到完全纯性; (2)树的深度达到用户指定的深度; (3)节点中样本的个数少于用户指定的个数; (4) 异质性指标下降的最大幅度小于用户指定的幅度。

机器学习常用算法

机器学习常用算法机器学习是当今最热门的领域之一,它已经成为各行各业发展的重要手段之一。

它的发展离不开算法的支持,因此本文将介绍机器学习中使用的常用算法,以及它们的优缺点。

首先,机器学习中使用最广泛的算法是逻辑回归。

它是一种概率模型,用来建立一个根据样本特征预测其所属类别的函数。

逻辑回归算法有许多优点,其中最重要的是它的计算效率非常高,可以快速地完成分类任务;另外,它只需要少量的训练样本就可以得到较高的准确率,而且它可以直接处理多维数据。

但是,这种模型的缺点也很明显,例如它对异常值比较敏感,在特征空间中很容易产生过拟合,而且它也不能很好地处理大量类别数据。

另一种常用的算法是支持向量机(SVM),它是一种监督学习模型,用来建立一个可以将新样本有效地分类的函数。

支持向量机的优点是它可以map出非线性的决策边界,由于其强大的泛化能力,使它在解决非线性问题时表现得更好。

SVM也有一些缺点,它的训练效率较低,尤其是在处理较大的数据集时;另外,当输入维度较高时,SVM容易发生过拟合。

最后,决策树也是一种常用的机器学习算法。

它是一种基于树结构的模型,用来模拟特征空间中各个属性对分类结果的影响。

决策树可以给出一个直观的分类结果,它还可以保持较高的精度,而且不会出现过拟合的情况。

但是,决策树的缺点也是显而易见的,由于其贪心方法,它很容易陷入局部最优解,而且它对非线性特征空间的分类能力也不强。

总而言之,不同的机器学习算法都有各自的优缺点,有时需要根据实际情况来选择合适的模型。

例如,当要处理多维数据时,可以选择逻辑回归模型;当要处理非线性特征时,支持向量机可能更好;当要处理大量类别数据时,决策树可能更适合。

正确的选择和使用机器学习模型对于机器学习的发展有着重要的意义,在此基础上,新的算法可以得到更好的结果和更高的精度。

机器学习的算法资料

机器学习的算法资料

一、机器学习的算法

1.K-近邻算法(K-Nearest Neighbors Algorithm)

K-近邻算法(K-Nearest Neighbors Algorithm)是一种简单的机器学习算法,它被广泛用于分类和回归问题。

该方法根据数据点的特征值将目标对象与其他对象区分开来,并使用它们的距离来预测新样本的结果。

K-近邻算法主要特点是简单有效且不需要大量的训练时间。

2.决策树(Decision Tree)

决策树是一种经典、非参数机器学习算法,它可以用来解决分类和回归问题。

它的核心思想是通过将给定的数据划分为不同的组,以最小化正在考虑的损失函数作为标准。

它可以形象地描述为树形结构,每一个非叶子节点代表一个特征属性,每一个叶子节点代表一个分类或输出结果。

3.逻辑回归(Logistic Regression)

逻辑回归是一种广泛使用的分类算法,它使用概率来预测目标变量的取值。

它是通过建立一个模型来表示相关性,来预测分类变量的概率,并给出预测结果。

逻辑回归模型通常使用“Sigmoid函数”来预测概率,并以此作为决策依据来预测类别。

4.支持向量机(Support Vector Machine)

支持向量机(SVM)是一种基于核函数的机器学习算法,它可以用于分类和回归。

SVM的核心思想是将数据映射到高维空间,并在此基础上建立一个最佳的决策面,以决定分类边界。

机器学习算法

机器学习算法机器学习是一种人工智能的技术,通过让计算机根据大量的数据自动学习和改进,使其能够预测、识别和判断。

在机器学习中,算法的选择是至关重要的,不同的算法适用于不同的问题和数据集。

本文将介绍几种常见的机器学习算法,并探讨它们的优缺点以及应用领域。

一、线性回归算法线性回归算法是机器学习中最简单也是最常用的算法之一。

它适用于处理数值型数据,并通过找到最佳拟合线来建立变量之间的线性关系。

线性回归算法的优点是计算速度快、可解释性强,适用于预测和建模。

然而,线性回归算法对异常值敏感,并且只能处理线性关系的数据。

二、逻辑回归算法逻辑回归算法是一种分类算法,常用于处理二分类问题。

它将输入变量与输出变量之间的关系建模为概率分布,并使用逻辑函数将概率映射到0和1之间的值。

逻辑回归算法具有较低的计算复杂度和内存占用,适用于大规模数据集和实时应用。

然而,逻辑回归算法只能处理线性可分的数据,并且对于处理多分类问题的效果不佳。

三、决策树算法决策树算法是一种基于树形结构的分类和回归算法。

它通过在每个节点上选择最佳的特征进行分割,将数据集划分为不同的子节点,并最终得到一个决策树模型。

决策树算法易于理解和解释,对于数据集中的异常值和缺失值具有较好的容错性。

然而,决策树算法容易过拟合,并且对于连续型数据和特征关联性较强的数据处理效果不佳。

四、支持向量机算法支持向量机算法是一种常用的分类算法,通过在高维空间中构建一个超平面将不同类别的样本分开。

支持向量机算法具有较好的泛化性能和鲁棒性,并且适用于处理非线性可分的数据。

然而,支持向量机算法对大规模数据集和高维特征空间的处理效率较低。

五、神经网络算法神经网络算法是一种模仿人脑神经系统运作的算法,由多个神经元组成的网络通过学习权重和激活函数来实现数据的预测和分类。

神经网络算法能够处理复杂的非线性关系,并具有较强的自适应能力和容错性。

然而,神经网络算法的学习过程较为耗时,并且对于超参数的选择和网络结构的设计要求较高。

机器学习算法的原理与应用

机器学习算法的原理与应用机器学习算法是当今人工智能领域中的核心方法之一,它的应用范围非常广泛。

本文将介绍机器学习算法的原理以及其在不同领域中的应用。

一、机器学习算法的原理机器学习算法是通过训练数据集来学习和构建模型,然后利用该模型对新的数据进行预测或分类。

其基本原理可以概括为以下几个步骤:1. 数据收集和预处理:选择合适的数据集,并对数据进行预处理,如数据清洗、特征选择、特征变换等。

2. 模型选择和训练:选择合适的机器学习模型,并使用训练数据对模型进行训练。

常见的机器学习算法包括决策树、神经网络、支持向量机等。

3. 模型评估和优化:使用测试数据对训练好的模型进行评估,并通过调整模型参数或改进算法来优化模型的性能。

4. 模型应用和预测:使用优化后的模型对新的数据进行预测或分类,得出相应的结果。

二、机器学习算法的应用机器学习算法在各个领域中有着广泛的应用。

以下是几个常见的应用领域:1. 自然语言处理:机器学习算法在自然语言处理中有着广泛的应用,如文本分类、情感分析、机器翻译等。

通过训练模型,计算机能够理解和生成人类语言,实现智能对话和信息处理。

2. 图像识别:图像识别是机器学习算法的另一个重要应用领域。

通过训练模型,计算机能够识别和分类图像中的对象或特征,如人脸识别、车牌识别等。

3. 推荐系统:推荐系统是利用机器学习算法为用户提供个性化推荐的技术。

通过分析用户的历史行为和偏好,计算机能够向用户推荐相关的商品、新闻、音乐等信息。

4. 医疗诊断:机器学习算法在医疗诊断中的应用也越来越广泛。

通过训练模型,计算机能够对医学影像进行分析和诊断,辅助医生进行疾病的检测和判断。

5. 金融风控:机器学习算法在金融风控领域有着重要的应用。

通过训练模型,计算机能够对用户的信用评估、欺诈检测等进行预测和判断,提供风险警示。

总结:机器学习算法的原理基于数据训练和模型构建,其应用领域包括自然语言处理、图像识别、推荐系统、医疗诊断和金融风控等。

常见机器学习算法的原理和应用分析

常见机器学习算法的原理和应用分析机器学习(Machine Learning, ML)是人工智能(Artificial Intelligence, AI)的核心领域之一,是一种通过样本数据对机器进行训练、自主探索特征规律及进行预测、判断等任务的方法。

机器学习算法是机器学习的核心内容,针对不同的问题和数据,具有不同的算法模型。

本文将针对常见机器学习算法的原理和应用进行分析。

一、监督学习算法监督学习算法是最为常见的机器学习算法,它的训练样本包含输入和输出的对应关系。

在监督学习算法中,常用的模型有决策树、随机森林、朴素贝叶斯、支持向量机等。

1. 决策树决策树(Decision Tree)是一种基于树形结构进行决策分析的算法。

通过将数据样本划分成多个类别,并形成一颗树状结构,确定样本通过树状结构的哪个分支可归属于哪个类别。

在决策树的构建过程中,通常采用递归的形式,对样本数据进行分裂。

具体地,根据所有属性的每个划分,都计算一个信息增益,并选择信息增益最大的属性作为当前节点的划分属性,对该属性进行划分。

直到叶子节点的样本属于同一类,或者节点所代表的属性集合为空时迭代结束。

2. 随机森林随机森林(Random Forest)是一种基于多个决策树构建的集成模型,以降低模型方差,提高模型精度。

随机森林的构建方式是通过对多个决策树在选择属性、分裂点时采用随机方法,形成多个弱分类器,共同进行综合决策。

随机森林的训练过程中,先利用自助式(Bootstrap)采样原始数据形成数据集,再分别随机选择每棵树的属性和分裂点,构建决策树。

最后,通过投票方式将多个决策树的结果进行集成,形成一个最终的整体结果。

3. 朴素贝叶斯朴素贝叶斯(Naive Bayes)是一种基于贝叶斯定理而来的分类算法,其基本思想是通过先验概率和概率密度函数,通过样本数据推导后验概率,最后对样本进行分类。

朴素贝叶斯算法假设所有特征都是相互独立的,并把各个特征的概率合成后,再根据贝叶斯公式计算后验概率,进行分类。

轻松看懂机器学习十大常用算法知识分享

轻松看懂机器学习十大常用算法通过本篇文章可以对ML的常用算法有个常识性的认识,没有代码,没有复杂的理论推导,就是图解一下,知道这些算法是什么,它们是怎么应用的,例子主要是分类问题。

每个算法都看了好几个视频,挑出讲的最清晰明了有趣的,便于科普。

以后有时间再对单个算法做深入地解析。

今天的算法如下:1. 决策树2. 随机森林算法3. 逻辑回归4. SVM5. 朴素贝叶斯6. K最近邻算法7. K均值算法8. Adaboost 算法9. 神经网络10. 马尔可夫1. 决策树根据一些feature进行分类,每个节点提一个问题,通过判断,将数据分为两类,再继续提问。

这些问题是根据已有数据学习出来的,再投入新数据的时候,就可以根据这棵树上的问题,将数据划分到合适的叶子上。

Input age. gender, occupattion. ... Does ttie person like computer gamespr&dichon seme In each leaf 一—* +22. 随机森林视频在源数据中随机选取数据,组成几个子集Subwt 3$4jb«et 1Subsgt 2S矩阵是源数据,有1-N条数据,A B C是feature,最后一列C是类别feature A of the 1st sample c J A 1 /HI fc\ -I- I- ■ ■ * V /AN /BN IcN 由S 随机生成M 个子矩阵 Create random subsets这M 个子集得到M 个决策树 目最多,就将此类别作为最后的预测结果C} J 将新数据投入到这M 个树中,得到 M 个分类结果,计数看预测成哪一类的数tree M3. 逻辑回归视频当预测目标是概率这样的,值域需要满足大于等于0,小于等于1的,这个时候单纯的线性模型是做不到的,因为在定义域不在某个范围之内时,值域也超出了规定区间。

所以此时需要这样的形状的模型会比较好那么怎么得到这样的模型呢?这个模型需要满足两个条件大于等于0,小于等于1大于等于0的模型可以选择绝对值,平方值,这里用指数函数,一定大于0小于等于1用除法,分子是自己,分母是自身加上1,那一定是小于1的了通过源数据计算可以得到相应的系数了最后得到logistic的图形4. SVMsupport vector mach ine要将两类分开,想要得到一个超平面,最优的超平面是到两类的margin达到最大,margin就是超平面与离它最近一点的距离,如下图,Z2>Z1 ,所以绿色的超平面比较好The best chok;e wiN be Efie r------------------------------- i将这个超平面表示成一个线性方程,在线上方的一类,都大于等于1,另一类Vrr G class 1V T £ clciss 2小化分母,于是变成了一个优化问题The total margin is computed by举个栗子,三个点,找到最优的超平面,定义了 weight vector =(2, 3)- (1,1)点到面的距离根据图中的公式计算所以得到total margin 的表达式如下,目标是最大化这个 margin ,就需要最 Mnm<zing thus termwil maim 英1 the耗冲蛊bib 期net parallel PERPENDICUL?得到weight vector 为(a, 2a),将两个点代入方程,代入(2 , 3)另其值=1,代入(1, 1)另其值=-1,求解出a和截矩w0的值,进而得到超平面的表达式ExampleI 叩峠|H iiill忆川a求出来后,代入(a, 2a)得到的就是support vector a和w0 代入超平面的方程就是support vector machi ne原始问题是:给你一句话,它属于哪一类5.朴素贝叶斯视频举个在NLP 的应用给一段文字,返回情感分类,这段文字的态度是 positive ,还是negativeY ( I levs this navies it 1 s. but wi th B«tirical humor« Th* diais >freat and th-e AdvAhture fleedeB are 亠 It Md-nAqes CQ be whtMlcAl and wtil 1.日 laughing •£ the CMvtntiona of th* ftiry genre. I wouldrecomend it to just atout ■nyo“B ・ I*v« ・M 小 it eeveral t LJitefi a.nd I !m hu&pp 予to d« it again whvnvvflr I h«vt a friand who hasn 11 seen it yet , )=c 亠为了解决这个问题,可以只看其中的一些单词X 1>0¥4 林耳祁0耳畫*義專0鼻注 輛蜩中出 xxxxxxK utlrlioailxxxitxxxxxx MjCXXXJtMXXXX f ・t XXXXXMXHIO C X M X X M X XX X XMXXXXM fun MXXK KxrxxKxxxxxxxlALuicftl xxxx rQumtic XJCJCX 丄augiliiEkgXXXXX KM XJCXXJCXX KXXXXXX XXXXXXXXJCxx^x^xxxjcxxxxx r«eom*nd KX >:XXXXXKXKXXXXXJC3EXXXXXXJQ( XXX3EXXXKX XJCSQ^vral XXJUU JLXKXX XJtJLXXXX xxxxx liappyxxx XJC xxxx againXXXXXKXXXMXXXXXXXXXXXKXXXYXXXX XXXXXKXKXXXX XXXXX )=c © 这段文字,将仅由一些单词和它们的计数代表Y (great 右— 2 love -—* 2 recommend 1 laugh 1 happy 1 • • ■ •…通过bayes rules变成一个比较简单容易求得的问题•Assigning each word: P(word | c)•Assigning each sentence. P(s|c)=[I P(word|c)C\a^ pm1_love this fun film(JJ0.01忆岬th-i0 101.050010.1C.OS fun0.1film P 估 |pos)=0.0000005问题变成,这一类中这句话出现的概率是多少,当然,别忘了公式里的另外两个概率栗子:单词love在positive的情况下出现的概率是0.1,在negative 的情况下出现的概率是0.001Model negI o DOW 0 01P(s|posJ > P(s|neR)6. K最近邻视频k n earest n eighbours给一个新的数据时,离它最近的k个点中,哪个类别多,这个数据就属于哪一love this fun film栗子:要区分猫和狗,通过claws和sou nd两个feature来判断的话,圆形和三角形是已知分类的了,那么这个star代表的是哪一类呢Who Is this??SOUNDk = 3时,这三条线链接的点就是最近的三个点,那么圆形多一些,所以这个star就是属于猫SOUND7. K均值视频想要将一组数据,分为三类,粉色数值大,黄色数值小最开心先初始化,这里面选了最简单的3 , 2, 1作为各类的初始值剩下的数据里,每个都与三个初始值计算距离,然后归类到离它最近的初始值所在类别分好类后,计算每一类的平均值,作为新一轮的中心点(about) 9几轮之后,分组不再变化了,就可以停止了8. Adaboost视频adaboost 是bosti ng 的方法之一bosting就是把若干个分类效果并不好的分类器综合起来考虑,会得到一个效果比较好的分类器。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

5-1简述机器学习十大算法的每个算法的核心思想、工作原理、适用情况及优缺点等。

1)C4.5算法:

ID3算法是以信息论为基础,以信息熵和信息增益度为衡量标准,从而实现对数据的归纳分类。

ID3算法计算每个属性的信息增益,并选取具有最高增益的属性作为给定的测试属性。

C4.5算法核心思想是ID3算法,是ID3算法的改进,改进方面有:

1)用信息增益率来选择属性,克服了用信息增益选择属性时偏向选择取值多的属性的不足;

2)在树构造过程中进行剪枝

3)能处理非离散的数据

4)能处理不完整的数据

C4.5算法优点:产生的分类规则易于理解,准确率较高。

缺点:

1)在构造树的过程中,需要对数据集进行多次的顺序扫描和排序,因而导致算

法的低效。

2)C4.5只适合于能够驻留于内存的数据集,当训练集大得无法在内存容纳时程

序无法运行。

2)K means 算法:

是一个简单的聚类算法,把n的对象根据他们的属性分为k个分割,k < n。

算法的核心就是要优化失真函数J,使其收敛到局部最小值但不是全局最小值。

,其中N为样本数,K是簇数,r nk b表示n属于第k个簇,u k是第k个中心点的值。

然后求出最优的u k

优点:算法速度很快

缺点是,分组的数目k是一个输入参数,不合适的k可能返回较差的结果。

3)朴素贝叶斯算法:

朴素贝叶斯法是基于贝叶斯定理与特征条件独立假设的分类方法。

算法的基础是概率问题,分类原理是通过某对象的先验概率,利用贝叶斯公式计算出其后验概率,即该对象属于某一类的概率,选择具有最大后验概率的类作为该对象所属的类。

朴素贝叶斯假设是约束性很强的假设,假设特征条件独立,但朴素贝叶斯算法简单,快速,具有较小的出错率。

在朴素贝叶斯的应用中,主要研究了电子邮件过滤以及文本分类研究。

4)K最近邻分类算法(KNN)

分类思想比较简单,从训练样本中找出K个与其最相近的样本,然后看这k个样本中哪个类别的样本多,则待判定的值(或说抽样)就属于这个类别。

缺点:

1)K值需要预先设定,而不能自适应

2)当样本不平衡时,如一个类的样本容量很大,而其他类样本容量很小时,有可能导致当输入一个新样本时,该样本的K个邻居中大容量类的样本占多数。

该算法适用于对样本容量比较大的类域进行自动分类。

5)EM最大期望算法

EM算法是基于模型的聚类方法,是在概率模型中寻找参数最大似然估计的算法,其中概率模型依赖于无法观测的隐藏变量。

E步估计隐含变量,M步估计其他参数,交替将极值推向最大。

EM算法比K-means算法计算复杂,收敛也较慢,不适于大规模数据集和高维数据,但比K-means算法计算结果稳定、准确。

EM经常用在机器学习和计算机视觉的数据集聚(Data Clustering)领域。

6)PageRank算法

是google的页面排序算法,是基于从许多优质的网页链接过来的网页,必定还是优质网页的回归关系,来判定所有网页的重要性。

(也就是说,一个人有着越多牛X朋友的人,他是牛X的概率就越大。

)

优点:

完全独立于查询,只依赖于网页链接结构,可以离线计算。

缺点:

1)PageRank算法忽略了网页搜索的时效性。

2)旧网页排序很高,存在时间长,积累了大量的in-links,拥有最新资讯的新网页排名却很低,因为它们几乎没有in-links。

7)AdaBoost

Adaboost是一种迭代算法,其核心思想是针对同一个训练集训练不同的分类器(弱分类器),然后把这些弱分类器集合起来,构成一个更强的最终分类器(强分类器)。

其算法本身是通过改变数据分布来实现的,它根据每次训练集之中每个样本的分类是否正确,以及上次的总体分类的准确率,来确定每个样本的权值。

将修改过权值的新数据集送给下层分类器进行训练,最后将每次训练得到的分类器最后融合起来,作为最后的决策分类器。

整个过程如下所示:

1. 先通过对N个训练样本的学习得到第一个弱分类器;

2. 将分错的样本和其他的新数据一起构成一个新的N个的训练样本,通过对这个样本的学习得到第二个弱分类器;

3. 将1和2都分错了的样本加上其他的新样本构成另一个新的N个的训练样本,通过对这个样本的学习得到第三个弱分类器;

4. 如此反复,最终得到经过提升的强分类器。

目前AdaBoost算法广泛的应用于人脸检测、目标识别等领域。

8)Apriori算法

Apriori算法是一种挖掘关联规则的算法,用于挖掘其内含的、未知的却又实际存在的数据关系,其核心是基于两阶段频集思想的递推算法。

Apriori算法分为两个阶段:

1)寻找频繁项集

2)由频繁项集找关联规则

算法缺点:

1)在每一步产生侯选项目集时循环产生的组合过多,没有排除不应该参与组合的元素;

2)每次计算项集的支持度时,都对数据库中的全部记录进行了一遍扫描比较,需要很大的I/O负载。

9)SVM支持向量机

支持向量机是一种基于分类边界的方法。

其基本原理是(以二维数据为例):如果训练数据分布在二维平面上的点,它们按照其分类聚集在不同的区域。

基于分类边界的分类算法的目标是,通过训练,找到这些分类之间的边界(直线的――称为线性划分,曲线的――称为非线性划分)。

对于多维数据(如N维),可以将它们视为N维空间中的点,而分类边界就是N维空间中的面,称为超面(超面比N维空间少一维)。

线性分类器使用超平面类型的边界,非线性分类器使用超曲面。

支持向量机的原理是将低维空间的点映射到高维空间,使它们成为线性可分,再使用线性划分的原理来判断分类边界。

在高维空间中是一种线性划分,而在原有的数据空间中,是一种非线性划分。

SVM在解决小样本、非线性及高维模式识别问题中表现出许多特有的优势,并能够推广应用到函数拟合等其他机器学习问题中。

10)CART分类与回归树

是一种决策树分类方法,采用基于最小距离的基尼指数估计函数,用来决定由该子数据集生成的决策树的拓展形。

如果目标变量是标称的,称为分类树;如果目标变量是连续的,称为回归树。

分类树是使用树结构算法将数据分成离散类的方法。

优点

1)非常灵活,可以允许有部分错分成本,还可指定先验概率分布,可使用自动的成本复杂性剪枝来得到归纳性更强的树。

2)在面对诸如存在缺失值、变量数多等问题时CART 显得非常稳健。