生物数据挖掘聚类分析实验报告

《数据仓库与数据挖掘》实验二聚类分实验报告37

实验二、聚类分析实验报告一、实验目的通过计算机编程实现并验证谱系聚类法的模式分类能力,了解和掌握最小距离归类原则在模式识别中的重要作用与地位。

二、实验内容1)用Matlab 实现谱系聚类算法,并对给定的样本集进行分类;2)通过改变实验参数,观察和分析影响谱系聚类算法的分类结果与收敛速度的因素;三、实验原理、方法和手段人类认识世界往往首先将被认识的对象进行分类,聚类分析是研究分类问题的多元数据分析方法,是数值分类学中的一支。

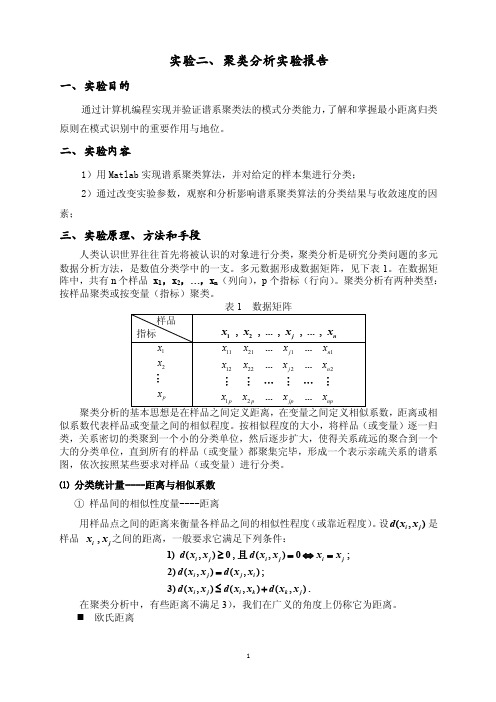

多元数据形成数据矩阵,见下表1。

在数据矩阵中,共有n 个样品 x 1,x 2,…,x n (列向),p 个指标(行向)。

聚类分析有两种类型:按样品聚类或按变量(指标)聚类。

距离或相似系数代表样品或变量之间的相似程度。

按相似程度的大小,将样品(或变量)逐一归类,关系密切的类聚到一个小的分类单位,然后逐步扩大,使得关系疏远的聚合到一个大的分类单位,直到所有的样品(或变量)都聚集完毕,形成一个表示亲疏关系的谱系图,依次按照某些要求对样品(或变量)进行分类。

⑴ 分类统计量----距离与相似系数① 样品间的相似性度量----距离用样品点之间的距离来衡量各样品之间的相似性程度(或靠近程度)。

设(,)i j d x x 是样品 ,i j x x 之间的距离,一般要求它满足下列条件:1)(,)0,(,)0;2)(,)(,);3)(,)(,)(,).i j i j i j i j j i i j i k k j d x x d x x x x d x x d x x d x x d x x d x x ≥=⇔==≤+且在聚类分析中,有些距离不满足3),我们在广义的角度上仍称它为距离。

欧氏距离1221(,)()pi j ik jk k d x x x x =⎡⎤=-⎢⎥⎣⎦∑⏹ 绝对距离1(,)||pi j ik jk k d x x x x ==-∑⏹ Minkowski 距离11(,)()pmm i j ik jk k d x x x x =⎡⎤=-⎢⎥⎣⎦∑⏹ Chebyshev 距离1(,)max ||i j ik jk k pd x x x x ≤≤=-⏹ 方差加权距离12221()(,)pik jk i j k k x x d x x s =⎡⎤-=⎢⎥⎢⎥⎣⎦∑ 其中 221111,().1n n ik k ik k i i x x s x x n n ====--∑∑ ⏹ 马氏距离112(,)()()T i j i j i j d x x x x S x x -⎡⎤=--⎣⎦其中 S 是由样品12,,...,,...,j n x x x x 算得的协方差矩阵:1111,()()1n n T i i i i i x x S x x x x n n ====---∑∑ 样品聚类通常称为Q 型聚类,其出发点是距离矩阵。

数据挖掘分类算法实验报告

数据挖掘分类算法实验报告数据挖掘分类算法实验报告一、引言数据挖掘是一种通过从大量数据中发现模式、规律和知识的过程。

在现代社会中,数据挖掘已经成为了一项重要的技术,广泛应用于各个领域。

其中,分类算法是数据挖掘中的一种重要技术,它可以将数据集中的样本分为不同的类别,从而实现对数据的有效分类和预测。

二、实验目的本实验旨在比较和评估常见的数据挖掘分类算法,包括决策树、朴素贝叶斯和支持向量机。

通过对多个数据集的实验,对这些算法的分类性能进行评估,并分析其适用场景和优缺点。

三、实验方法1. 数据集选择本实验选择了三个不同类型的数据集,包括鸢尾花数据集、心脏病数据集和手写数字数据集。

这些数据集代表了常见的分类问题,具有不同的特征和类别分布。

2. 特征选择和预处理在进行分类算法之前,需要对原始数据进行特征选择和预处理。

特征选择是为了从原始数据中选择出最具有代表性和区分度的特征,以提高分类算法的效果。

预处理包括数据清洗、缺失值处理和数据标准化等步骤,以确保数据的质量和一致性。

3. 算法实现和评估在实验中,我们使用Python编程语言实现了决策树、朴素贝叶斯和支持向量机三种分类算法。

对于每个数据集,我们将数据集划分为训练集和测试集,使用训练集对分类模型进行训练,然后使用测试集评估分类算法的性能。

评估指标包括准确率、召回率和F1值等。

四、实验结果与分析1. 鸢尾花数据集实验结果在对鸢尾花数据集进行分类实验时,我们发现决策树算法表现最好,准确率达到了95%以上,而朴素贝叶斯算法和支持向量机算法的准确率分别为90%和93%。

这说明决策树算法在处理鸢尾花数据集时具有较好的分类能力。

2. 心脏病数据集实验结果对于心脏病数据集,朴素贝叶斯算法表现最好,准确率超过了90%,而决策树算法和支持向量机算法的准确率分别为85%和88%。

这说明朴素贝叶斯算法在处理心脏病数据集时具有较好的分类效果。

3. 手写数字数据集实验结果在对手写数字数据集进行分类实验时,支持向量机算法表现最好,准确率超过了98%,而决策树算法和朴素贝叶斯算法的准确率分别为90%和92%。

(完整版)生物数据挖掘-决策树实验报告

实验四决策树一、实验目的1.了解典型决策树算法2.熟悉决策树算法的思路与步骤3.掌握运用Matlab对数据集做决策树分析的方法二、实验内容1.运用Matlab对数据集做决策树分析三、实验步骤1.写出对决策树算法的理解决策树方法是数据挖掘的重要方法之一,它是利用树形结构的特性来对数据进行分类的一种方法。

决策树学习从一组无规则、无次序的事例中推理出有用的分类规则,是一种实例为基础的归纳学习算法。

决策树首先利用训练数据集合生成一个测试函数,根据不同的权值建立树的分支,即叶子结点,在每个叶子节点下又建立层次结点和分支,如此重利生成决策树,然后对决策树进行剪树处理,最后把决策树转换成规则。

决策树的最大优点是直观,以树状图的形式表现预测结果,而且这个结果可以进行解释。

决策树主要用于聚类和分类方面的应用。

决策树是一树状结构,它的每一个叶子节点对应着一个分类,非叶子节点对应着在某个属性上的划分,根据样本在该属性上的不同取值将其划分成若干个子集。

构造决策树的核心问题是在每一步如何选择适当的属性对样本进行拆分。

对一个分类问题,从已知类标记的训练样本中学习并构造出决策树是一个自上而下分而治之的过程。

2.启动Matlab,运用Matlab对数据集进行决策树分析,写出算法名称、数据集名称、关键代码,记录实验过程,实验结果,并分析实验结果(1)算法名称: ID3算法ID3算法是最经典的决策树分类算法。

ID3算法基于信息熵来选择最佳的测试属性,它选择当前样本集中具有最大信息增益值的属性作为测试属性;样本集的划分则依据测试属性的取值进行,测试属性有多少个不同的取值就将样本集划分为多少个子样本集,同时决策树上相应于该样本集的节点长出新的叶子节点。

ID3算法根据信息论的理论,采用划分后样本集的不确定性作为衡量划分好坏的标准,用信息增益值度量不确定性:信息增益值越大,不确定性越小。

因此,ID3算法在每个非叶节点选择信息增益最大的属性作为测试属性,这样可以得到当前情况下最纯的划分,从而得到较小的决策树。

数据挖掘实验报告结论(3篇)

第1篇一、实验概述本次数据挖掘实验以Apriori算法为核心,通过对GutenBerg和DBLP两个数据集进行关联规则挖掘,旨在探讨数据挖掘技术在知识发现中的应用。

实验过程中,我们遵循数据挖掘的一般流程,包括数据预处理、关联规则挖掘、结果分析和可视化等步骤。

二、实验结果分析1. 数据预处理在实验开始之前,我们对GutenBerg和DBLP数据集进行了预处理,包括数据清洗、数据集成和数据变换等。

通过对数据集的分析,我们发现了以下问题:(1)数据缺失:部分数据集存在缺失值,需要通过插补或删除缺失数据的方法进行处理。

(2)数据不一致:数据集中存在不同格式的数据,需要进行统一处理。

(3)数据噪声:数据集中存在一些异常值,需要通过滤波或聚类等方法进行处理。

2. 关联规则挖掘在数据预处理完成后,我们使用Apriori算法对数据集进行关联规则挖掘。

实验中,我们设置了不同的最小支持度和最小置信度阈值,以挖掘出不同粒度的关联规则。

以下是实验结果分析:(1)GutenBerg数据集在GutenBerg数据集中,我们以句子为篮子粒度,挖掘了林肯演讲集的关联规则。

通过分析挖掘结果,我们发现:- 单词“the”和“of”在句子中频繁出现,表明这两个词在林肯演讲中具有较高的出现频率。

- “and”和“to”等连接词也具有较高的出现频率,说明林肯演讲中句子结构较为复杂。

- 部分单词组合具有较高的置信度,如“war”和“soldier”,表明在林肯演讲中提到“war”时,很可能同时提到“soldier”。

(2)DBLP数据集在DBLP数据集中,我们以作者为单位,挖掘了作者之间的合作关系。

实验结果表明:- 部分作者之间存在较强的合作关系,如同一研究领域内的作者。

- 部分作者在多个研究领域均有合作关系,表明他们在不同领域具有一定的学术影响力。

3. 结果分析和可视化为了更好地展示实验结果,我们对挖掘出的关联规则进行了可视化处理。

通过可视化,我们可以直观地看出以下信息:(1)频繁项集的分布情况:通过柱状图展示频繁项集的分布情况,便于分析不同项集的出现频率。

聚类分析算法实验报告(3篇)

第1篇一、实验背景聚类分析是数据挖掘中的一种重要技术,它将数据集划分成若干个类或簇,使得同一簇内的数据点具有较高的相似度,而不同簇之间的数据点则具有较低相似度。

本实验旨在通过实际操作,了解并掌握聚类分析的基本原理,并对比分析不同聚类算法的性能。

二、实验环境1. 操作系统:Windows 102. 软件环境:Python3.8、NumPy 1.19、Matplotlib 3.3.4、Scikit-learn0.24.03. 数据集:Iris数据集三、实验内容本实验主要对比分析以下聚类算法:1. K-means算法2. 聚类层次算法(Agglomerative Clustering)3. DBSCAN算法四、实验步骤1. K-means算法(1)导入Iris数据集,提取特征数据。

(2)使用Scikit-learn库中的KMeans类进行聚类,设置聚类数为3。

(3)计算聚类中心,并计算每个样本到聚类中心的距离。

(4)绘制聚类结果图。

2. 聚类层次算法(1)导入Iris数据集,提取特征数据。

(2)使用Scikit-learn库中的AgglomerativeClustering类进行聚类,设置链接方法为'ward'。

(3)计算聚类结果,并绘制树状图。

3. DBSCAN算法(1)导入Iris数据集,提取特征数据。

(2)使用Scikit-learn库中的DBSCAN类进行聚类,设置邻域半径为0.5,最小样本数为5。

(3)计算聚类结果,并绘制聚类结果图。

五、实验结果与分析1. K-means算法实验结果显示,K-means算法将Iris数据集划分为3个簇,每个簇包含3个样本。

从聚类结果图可以看出,K-means算法能够较好地将Iris数据集划分为3个簇,但存在一些噪声点。

2. 聚类层次算法聚类层次算法将Iris数据集划分为3个簇,与K-means算法的结果相同。

从树状图可以看出,聚类层次算法在聚类过程中形成了多个分支,说明该算法能够较好地处理不同簇之间的相似度。

数据挖掘聚类算法课程设计报告

数据挖掘聚类问题(Plants Data Set)实验报告1.数据源描述1.1数据特征本实验用到的是关于植物信息的数据集,其中包含了每一种植物(种类和科属)以及它们生长的地区。

数据集中总共有68个地区,主要分布在美国和加拿大。

一条数据(对应于文件中的一行)包含一种植物(或者某一科属)及其在上述68个地区中的分布情况。

可以这样理解,该数据集中每一条数据包含两部分内容,如下图所示。

图1 数据格式例如一条数据:abronia fragrans,az,co,ks,mt,ne,nm,nd,ok,sd,tx,ut,wa,wy。

其中abronia fragrans是植物名称(abronia是科属,fragrans是名称),从az一直到wy 是该植物的分布区域,采用缩写形式表示,如az代表的是美国Arizona州。

植物名称和分布地区用逗号隔开,各地区之间也用逗号隔开。

1.2任务要求聚类。

采用聚类算法根据某种特征对所给数据集进行聚类分析,对于聚类形成的簇要使得簇内数据对象之间的差异尽可能小,簇之间的差距尽可能大。

2.数据预处理2.1数据清理所给数据集中包含一些对聚类过程无用的冗余数据。

数据集中全部数据的组织结构是:先给出某一科属的植物及其所有分布地区,然后给出该科属下的具体植物及其分布地区。

例如:abelmoschus,ct,dc,fl,hi,il,ky,la,md,mi,ms,nc,sc,va,pr,viabelmoschus esculentus,ct,dc,fl,il,ky,la,md,mi,ms,nc,sc,va,pr,viabelmoschus moschatus,hi,pr上述数据中第行给出了所有属于abelmoschus这一科属的植物的分布地区,接下来的两行分别列出了属于abelmoschus科属的两种具体植物及其分布地区。

从中可以看出后两行给出的所有地区的并集正是第一行给出的地区集合。

在聚类过程中第行数据是无用的,因此要对其进行清理。

数据挖掘实验报告-聚类分析

资料范本本资料为word版本,可以直接编辑和打印,感谢您的下载数据挖掘实验报告-聚类分析地点:__________________时间:__________________说明:本资料适用于约定双方经过谈判,协商而共同承认,共同遵守的责任与义务,仅供参考,文档可直接下载或修改,不需要的部分可直接删除,使用时请详细阅读内容数据挖掘实验报告(三)聚类分析姓名:李圣杰班级:计算机1304学号:1311610602一、实验目的掌握k-means聚类方法;通过自行编程,对三维空间内的点用k-means方法聚类。

二、实验设备PC一台,dev-c++5.11三、实验内容1.问题描述:立体空间三维点的聚类.说明:数据放在数据文件中(不得放在程序中),第一行是数据的个数,以后各行是各个点的x,y,z坐标。

2.设计要求读取文本文件数据,并用K-means方法输出聚类中心3. 需求分析k-means 算法接受输入量k;然后将n个数据对象划分为 k个聚类以便使得所获得的聚类满足:同一聚类中的对象相似度较高;而不同聚类中的对象相似度较小。

聚类相似度是利用各聚类中对象的均值所获得一个“中心对象”(引力中心)来进行计算的。

k-means算法的工作过程说明如下:首先从n个数据对象任意选择k个对象作为初始聚类中心,而对于所剩下的其它对象,则根据它们与这些聚类中心的相似度(距离),分别将它们分配给与其最相似的(聚类中心所代表的)聚类。

然后,再计算每个所获新聚类的聚类中心(该聚类中所有对象的均值),不断重复这一过程直到标准测度函数开始收敛为止。

一般都采用均方差作为标准测度函数,具体定义如下:(1)其中E为数据库中所有对象的均方差之和,p为代表对象的空间中的一个点,mi为聚类Ci的均值(p和mi均是多维的)。

公式(1)所示的聚类标准,旨在使所获得的k个聚类具有以下特点:各聚类本身尽可能的紧凑,而各聚类之间尽可能的分开。

四、实验步骤Step 1.读取数据组,从N个数据对象任意选择k个对象作为初始聚类中心;Step 2.循环Step 3到Step 4直到每个聚类不再发生变化为止;Step 3.根据每个聚类对象的均值(中心对象),计算每个对象与这些中心对象的距离,并根据最小距离重新对相应对象进行划分;Step 4.重新计算每个(有变化)聚类的均值(中心对象)。

数据挖掘实验报告

数据挖掘实验报告一、实验背景。

数据挖掘是指从大量的数据中发现隐藏的、有价值的信息的过程。

在当今信息爆炸的时代,数据挖掘技术越来越受到重视,被广泛应用于商业、科研、医疗等领域。

本次实验旨在通过数据挖掘技术,对给定的数据集进行分析和挖掘,从中发现有用的信息并进行分析。

二、实验目的。

本次实验的目的是通过数据挖掘技术,对给定的数据集进行分析和挖掘,包括数据的预处理、特征选择、模型建立等步骤,最终得出有用的信息并进行分析。

三、实验内容。

1. 数据预处理。

在本次实验中,首先对给定的数据集进行数据预处理。

数据预处理是数据挖掘过程中非常重要的一步,包括数据清洗、数据变换、数据规约等。

通过数据预处理,可以提高数据的质量,为后续的分析和挖掘奠定基础。

2. 特征选择。

在数据挖掘过程中,特征选择是非常关键的一步。

通过特征选择,可以筛选出对挖掘目标有用的特征,减少数据维度,提高挖掘效率。

本次实验将对数据集进行特征选择,并分析选取的特征对挖掘结果的影响。

3. 模型建立。

在数据挖掘过程中,模型的建立是非常重要的一步。

通过建立合适的模型,可以更好地挖掘数据中的信息。

本次实验将尝试不同的数据挖掘模型,比较它们的效果,并选取最优的模型进行进一步分析。

4. 数据挖掘分析。

最终,本次实验将对挖掘得到的信息进行分析,包括数据的趋势、规律、异常等。

通过数据挖掘分析,可以为实际问题的决策提供有力的支持。

四、实验结果。

经过数据预处理、特征选择、模型建立和数据挖掘分析,我们得到了如下实验结果:1. 数据预处理的结果表明,经过数据清洗和变换后,数据质量得到了显著提高,为后续的分析和挖掘奠定了基础。

2. 特征选择的结果表明,选取的特征对挖掘结果有着重要的影响,不同的特征组合会对挖掘效果产生不同的影响。

3. 模型建立的结果表明,经过比较和分析,我们选取了最优的数据挖掘模型,并对数据集进行了进一步的挖掘。

4. 数据挖掘分析的结果表明,我们发现了数据中的一些有意义的趋势和规律,这些信息对实际问题的决策具有重要的参考价值。

聚类分析中实验报告

一、实验背景聚类分析是数据挖掘中的一种无监督学习方法,通过对数据集进行分组,将相似的数据对象归为同一类别。

本实验旨在通过实践,加深对聚类分析方法的理解,掌握常用的聚类算法及其应用。

二、实验目的1. 理解聚类分析的基本原理和方法。

2. 掌握常用的聚类算法,如K-means、层次聚类、密度聚类等。

3. 学习使用Python等工具进行聚类分析。

4. 分析实验结果,总结聚类分析方法在实际应用中的价值。

三、实验环境1. 操作系统:Windows 102. 编程语言:Python3.83. 数据库:SQLite 3.32.24. 聚类分析库:scikit-learn 0.24.2四、实验步骤1. 数据准备- 下载并导入实验数据集,本实验使用的是Iris数据集,包含150个样本和4个特征。

- 使用pandas库对数据进行预处理,包括缺失值处理、异常值处理等。

2. 聚类算法实现- 使用scikit-learn库实现K-means聚类算法。

- 使用scikit-learn库实现层次聚类算法。

- 使用scikit-learn库实现密度聚类算法(DBSCAN)。

3. 结果分析- 使用可视化工具(如matplotlib)展示聚类结果。

- 分析不同聚类算法的优缺点,对比聚类效果。

4. 实验总结- 总结实验过程中遇到的问题和解决方法。

- 分析聚类分析方法在实际应用中的价值。

五、实验结果与分析1. K-means聚类- 使用K-means聚类算法将数据集分为3个类别。

- 可视化结果显示,K-means聚类效果较好,将数据集分为3个明显的类别。

2. 层次聚类- 使用层次聚类算法将数据集分为3个类别。

- 可视化结果显示,层次聚类效果较好,将数据集分为3个类别,且与K-means聚类结果相似。

3. 密度聚类(DBSCAN)- 使用DBSCAN聚类算法将数据集分为3个类别。

- 可视化结果显示,DBSCAN聚类效果较好,将数据集分为3个类别,且与K-means聚类结果相似。

对数据进行聚类分析实验报告

对数据进行聚类分析实验报告数据聚类分析实验报告摘要:本实验旨在通过对数据进行聚类分析,探索数据点之间的关系。

首先介绍了聚类分析的基本概念和方法,然后详细解释了实验设计和实施过程。

最后,给出了实验结果和结论,并提供了改进方法的建议。

1. 引言数据聚类分析是一种将相似的数据点自动分组的方法。

它在数据挖掘、模式识别、市场分析等领域有广泛应用。

本实验旨在通过对实际数据进行聚类分析,揭示数据中的隐藏模式和规律。

2. 实验设计与方法2.1 数据收集首先,我们收集了一份包含5000条数据的样本。

这些数据涵盖了顾客的消费金额、购买频率、地理位置等信息。

样本数据经过清洗和预处理,确保了数据的准确性和一致性。

2.2 聚类分析方法本实验采用了K-Means聚类算法进行数据分析。

K-Means算法是一种迭代的数据分组算法,通过计算数据点到聚类中心的距离,将数据点划分到K个不同的簇中。

2.3 实验步骤(1)数据预处理:对数据进行归一化和标准化处理,确保每个特征的权重相等。

(2)确定聚类数K:通过执行不同的聚类数,比较聚类结果的稳定性,选择合适的K值。

(3)初始化聚类中心:随机选取K个数据点作为初始聚类中心。

(4)迭代计算:计算数据点与聚类中心之间的距离,将数据点划分到距离最近的聚类中心所在的簇中。

更新聚类中心的位置。

(5)重复步骤(4),直到聚类过程收敛或达到最大迭代次数。

3. 实验结果与分析3.1 聚类数选择我们分别执行了K-Means算法的聚类过程,将聚类数从2增加到10,比较了每个聚类数对应的聚类结果。

通过对比样本内离差平方和(Within-Cluster Sum of Squares, WCSS)和轮廓系数(Silhouette Coefficient),我们选择了最合适的聚类数。

结果表明,当聚类数为4时,WCSS值达到最小,轮廓系数达到最大。

3.2 聚类结果展示根据选择的聚类数4,我们将数据点划分为四个不同的簇。

数据挖掘实例实验报告(3篇)

第1篇一、实验背景随着大数据时代的到来,数据挖掘技术逐渐成为各个行业的重要工具。

数据挖掘是指从大量数据中提取有价值的信息和知识的过程。

本实验旨在通过数据挖掘技术,对某个具体领域的数据进行挖掘,分析数据中的规律和趋势,为相关决策提供支持。

二、实验目标1. 熟悉数据挖掘的基本流程,包括数据预处理、特征选择、模型选择、模型训练和模型评估等步骤。

2. 掌握常用的数据挖掘算法,如决策树、支持向量机、聚类、关联规则等。

3. 应用数据挖掘技术解决实际问题,提高数据分析和处理能力。

4. 实验结束后,提交一份完整的实验报告,包括实验过程、结果分析及总结。

三、实验环境1. 操作系统:Windows 102. 编程语言:Python3. 数据挖掘库:pandas、numpy、scikit-learn、matplotlib四、实验数据本实验选取了某电商平台用户购买行为数据作为实验数据。

数据包括用户ID、商品ID、购买时间、价格、商品类别、用户年龄、性别、职业等。

五、实验步骤1. 数据预处理(1)数据清洗:剔除缺失值、异常值等无效数据。

(2)数据转换:将分类变量转换为数值变量,如年龄、性别等。

(3)数据归一化:将不同特征的范围统一到相同的尺度,便于模型训练。

2. 特征选择(1)相关性分析:计算特征之间的相关系数,剔除冗余特征。

(2)信息增益:根据特征的信息增益选择特征。

3. 模型选择(1)决策树:采用CART决策树算法。

(2)支持向量机:采用线性核函数。

(3)聚类:采用K-Means算法。

(4)关联规则:采用Apriori算法。

4. 模型训练使用训练集对各个模型进行训练。

5. 模型评估使用测试集对各个模型进行评估,比较不同模型的性能。

六、实验结果与分析1. 数据预处理经过数据清洗,剔除缺失值和异常值后,剩余数据量为10000条。

2. 特征选择通过相关性分析和信息增益,选取以下特征:用户ID、商品ID、购买时间、价格、商品类别、用户年龄、性别、职业。

聚类分析实验报告结论(3篇)

第1篇本次聚类分析实验旨在深入理解和掌握聚类分析方法,包括基于划分、层次和密度的聚类技术,并运用SQL Server、Weka、SPSS等工具进行实际操作。

通过实验,我们不仅验证了不同聚类算法的有效性,而且对数据理解、特征选择与预处理、算法选择、结果解释和评估等方面有了更为全面的认知。

以下是对本次实验的结论总结:一、实验目的与意义1. 理解聚类分析的基本概念:实验使我们明确了聚类分析的定义、目的和应用场景,认识到其在数据挖掘、市场分析、图像处理等领域的重要性。

2. 掌握聚类分析方法:通过实验,我们学习了K-means聚类、层次聚类等常用聚类算法,并了解了它们的原理、步骤和特点。

3. 提高数据挖掘能力:实验过程中,我们学会了如何利用工具进行数据预处理、特征选择和聚类分析,为后续的数据挖掘工作打下了基础。

二、实验结果分析1. K-means聚类:- 实验效果:K-means聚类算法在本次实验中表现出较好的聚类效果,尤其在处理规模较小、结构较为清晰的数据时,能快速得到较为满意的聚类结果。

- 特点:K-means聚类算法具有简单、高效的特点,但需要事先指定聚类数目,且对噪声数据敏感。

2. 层次聚类:- 实验效果:层次聚类算法在处理规模较大、结构复杂的数据时,能较好地发现数据中的层次关系,但聚类结果受距离度量方法的影响较大。

- 特点:层次聚类算法具有自适应性和可解释性,但计算复杂度较高,且聚类结果不易预测。

3. 密度聚类:- 实验效果:密度聚类算法在处理噪声数据、非均匀分布数据时,能较好地发现聚类结构,但对参数选择较为敏感。

- 特点:密度聚类算法具有较好的鲁棒性和可解释性,但计算复杂度较高。

三、实验结论1. 聚类算法的选择:根据实验结果,K-means聚类算法在处理规模较小、结构较为清晰的数据时,具有较好的聚类效果;层次聚类算法在处理规模较大、结构复杂的数据时,能较好地发现数据中的层次关系;密度聚类算法在处理噪声数据、非均匀分布数据时,能较好地发现聚类结构。

数据挖掘6个实验实验报告

中南民族大学计算机科学学院《数据挖掘与知识发现》综合实验报告姓名年级专业软件工程指导教师学号序号实验类型综合型2016年12 月10 日一、使用Weka建立决策树模型1、准备数据:在记事本程序中编制ColdType-training.arff,ColdType-test.arff。

2、加载和预处理数据。

3、建立分类模型。

(选择C4.5决策树算法)4、分类未知实例二、使用Weka进行聚类1、准备数据:使用ColdType.csv文件作为数据集。

2、加载和预处理数据。

3、聚类(用简单K -均值算法)4、解释和评估聚类结果三、完成感冒类型的相关操作及相应处理结果1.加载了ColdType-training.arff文件后的Weka Explorer界面:2.感冒类型诊断分类模型输出结果:Sore-throat = Yes| Cooling-effect = Good: Viral (2.0)4.感冒类型诊断聚类结果:Cluster centroids:Cluster#Attribute Full Data 0 1(10) (5) (5) ================================================= Increased-lym Yes Yes No Leukocytosis Yes No Yes Fever Yes Yes Yes Acute-onset Yes Yes No Sore-throat Yes No Yes Cooling-effect Good Good Notgood Group Yes Yes NoTime taken to build model (full training data) : 0 seconds=== Model and evaluation on training set ===Clustered Instances0 5 ( 50%)1 5 ( 50%)Class attribute: Cold-typeClasses to Clusters:0 1 <-- assigned to cluster5 1 | Viral0 4 | BacterialCluster 0 <-- ViralCluster 1 <-- BacterialIncorrectly clustered instances : 1.010 %分析:由诊断聚类结果图可知,聚类中有两个簇Cluster0和Cluster1,分别对应Viral类和Bacterial类,但有一个实例被聚类到错误的簇,聚类错误率为10%。

数据挖掘实验报告

数据挖掘实验报告一、实验背景随着信息技术的快速发展,数据量呈爆炸式增长,如何从海量的数据中提取有价值的信息成为了一个重要的研究课题。

数据挖掘作为一种从大量数据中发现潜在模式和知识的技术,已经在众多领域得到了广泛的应用,如市场营销、金融风险预测、医疗诊断等。

本次实验旨在通过对实际数据的挖掘和分析,深入理解数据挖掘的基本流程和方法,并探索其在解决实际问题中的应用。

二、实验目的1、熟悉数据挖掘的基本流程,包括数据预处理、数据探索、模型选择与训练、模型评估等。

2、掌握常见的数据挖掘算法,如决策树、聚类分析、关联规则挖掘等,并能够根据实际问题选择合适的算法。

3、通过实际数据的挖掘实验,提高对数据的分析和处理能力,培养解决实际问题的思维和方法。

三、实验数据本次实验使用了一份关于客户消费行为的数据集,包含了客户的基本信息(如年龄、性别、职业等)、消费记录(如购买的商品类别、购买金额、购买时间等)以及客户的满意度评价等。

数据总量为 10000 条,数据格式为 CSV 格式。

四、实验环境操作系统:Windows 10编程语言:Python 37主要库:Pandas、NumPy、Scikitlearn、Matplotlib 等五、实验步骤1、数据预处理数据清洗:首先,对数据进行清洗,处理缺失值和异常值。

对于缺失值,根据数据的特点,采用了均值填充、中位数填充等方法进行处理;对于异常值,通过数据可视化和统计分析的方法进行识别,并根据具体情况进行删除或修正。

数据转换:将数据中的分类变量进行编码,如将性别(男、女)转换为 0、1 编码,将职业(教师、医生、工程师等)转换为独热编码。

数据标准化:对数据进行标准化处理,使得不同特征之间具有可比性,采用了 Zscore 标准化方法。

2、数据探索数据可视化:通过绘制柱状图、箱线图、散点图等,对数据的分布、特征之间的关系进行可视化分析,以便更好地理解数据。

统计分析:计算数据的均值、中位数、标准差、相关系数等统计量,对数据的基本特征进行分析。

数据挖掘实验报告总结

数据挖掘实验报告总结在前段时间的实验课上,学习了一门课程,叫数据挖掘。

这次实验主要分析了数据挖掘中的特征选取技术和主题模型方法,学习的过程中,对这两个知识点有了进一步的理解,而且也增加了自己在这方面的经验。

一、实验名称:特征选择二、实验内容:(一)概述:本实验从实际应用出发,给出特征选择方法的应用实例,通过数据挖掘来识别特定人群,在数据挖掘过程中,我们将数据特征选择作为一个重要环节。

特征选择主要包括对分类特征空间以及特征权重的确定,而决定特征权重的一个重要因素就是样本数据中的特征之间的相似性。

实验目的是为了提高特征选择效率,本实验通过一组真实的数据,让我们对不同的特征分别做相关性分析,从而得到样本中最重要的特征。

1、特征:给定的实验数据总共包含1000个样本,数据按照各种特征标准被分成10个特征空间,即共有10个不同的特征空间,由于一般情况下,其中5-6个特征在特征空间的划分上会比较接近,因此将它们定义为一个特征空间,剩余的另外3个特征空间可以视为一个特征空间。

2、方法:本实验主要采用KMS方法,即基于信息熵的特征选择方法。

它能够从多个特征中选择一个最合适的特征,它也被称为聚类特征选择。

KMS方法是特征选择方法中使用最广泛的方法,这是因为它与具体的应用场景相关,在实际应用过程中,要考虑多个条件的限制,从而得到最好的结果。

KMS方法主要分为两个阶段,第一个阶段是信息熵( K)值计算。

K值反映出在所有的特征中哪个特征排序最靠前,它表示数据特征的相似度,所以一般情况下K值小的特征更受青睐。

第二阶段是聚类,聚类是一种更细致的过程,在计算K 值后,再将数据空间划分为相应的类别,每个类别又可以看作一个聚类。

3、考虑到一个样本数据量很大,所以整个过程用了一个小时,而且完全不需要人工干预,这样一来,大大减少了实验过程中的人力和时间的消耗。

整个实验过程中,所有的特征都经过信息熵的计算,不管是初始特征还是特征权重,都被赋予一个信息熵值。

聚类分析实验报告体会(3篇)

第1篇随着大数据时代的到来,数据挖掘技术在各个领域得到了广泛应用。

聚类分析作为数据挖掘中的关键技术之一,对于发现数据中的潜在结构具有重要意义。

近期,我参与了一次聚类分析实验,通过实践操作,我对聚类分析有了更深入的理解和体会。

一、实验背景与目的本次实验旨在通过实际操作,掌握聚类分析的基本原理和方法,并运用SQL Server、Weka、SPSS等工具进行聚类分析。

实验过程中,我们构建了合规的数据集,并针对不同的数据特点,选择了合适的聚类算法进行分析。

二、实验过程与步骤1. 数据准备:首先,我们需要收集和整理实验所需的数据。

数据来源可以是公开数据集,也可以是自行收集的数据。

在数据准备过程中,我们需要对数据进行清洗和预处理,以确保数据的准确性和完整性。

2. 数据探索:对数据集进行初步探索,了解数据的分布特征、数据量、数据类型等。

这一步骤有助于我们选择合适的聚类算法和数据预处理方法。

3. 建立数据模型:根据实验目的和数据特点,选择合适的聚类算法。

常见的聚类算法有K-means、层次聚类、密度聚类等。

在本实验中,我们选择了K-means算法进行聚类分析。

4. 聚类分析:使用所选算法对数据集进行聚类分析。

在实验过程中,我们需要调整聚类参数,如K值(聚类数量)、距离度量方法等,以获得最佳的聚类效果。

5. 结果分析:对聚类结果进行分析,包括分类关系图、分类剖面图、分类特征和分类对比等。

通过分析结果,我们可以了解数据的潜在结构和规律。

6. 实验总结:对实验过程和结果进行总结,反思数据理解、特征选择与预处理、算法选择、结果解释和评估等方面的问题。

三、实验体会与反思1. 数据理解的重要性:在进行聚类分析之前,我们需要对数据有深入的理解。

只有了解数据的背景、分布特征和潜在结构,才能选择合适的聚类算法和参数。

2. 特征选择与预处理:特征选择和预处理是聚类分析的重要步骤。

通过选择合适的特征和预处理方法,可以提高聚类效果和模型的可靠性。

数据挖掘实验报告(两篇)2024

引言概述:数据挖掘是一项广泛应用于各个行业的技术,通过对大数据的处理和分析,可以发现隐藏在数据中的有价值信息。

本文是数据挖掘实验报告(二),将对具体的数据挖掘实验进行详细的阐述和分析。

本实验主要聚焦于数据预处理、特征选择、模型建立和评估等关键步骤,以增加对实验过程和结果的理解,提高实验的可靠性和准确性。

通过实验结果的分析和总结,可以帮助读者更好地理解数据挖掘的方法和技术,并为实际应用提供参考和指导。

正文内容:1. 数据预处理在进行数据挖掘之前,首先需要对原始数据进行预处理。

数据预处理的目的是清洗数据、处理缺失值和异常值等数据问题,以确保数据的质量和准确性。

在本实验中,我们采用了多种方法对数据进行预处理。

其中包括数据清洗、缺失值处理和异常值检测等。

具体的操作包括了数据去重、数据标准化、缺失值的填补和异常值的处理等。

2. 特征选择特征选择是数据挖掘的关键步骤之一,它的目的是从原始数据中选择出对问题解决有价值的特征。

在本实验中,我们通过使用相关性分析、方差选择和递归特征消除等方法,对原始数据进行特征选择。

通过分析特征与目标变量之间的关系,我们可以得出最有价值的特征,从而减少计算复杂度和提高模型准确性。

3. 模型建立模型建立是数据挖掘实验的核心步骤之一。

在本实验中,我们采用了多种模型进行建立,包括决策树、支持向量机、朴素贝叶斯等。

具体而言,我们使用了ID3决策树算法、支持向量机算法和朴素贝叶斯算法等进行建模,并通过交叉验证和网格搜索等方法选择最佳的模型参数。

4. 模型评估模型评估是对建立的模型进行准确性和可靠性评估的过程。

在本实验中,我们采用了多种评估指标进行模型评估,包括准确率、召回率、F1分数等。

通过对模型的评估,我们可以得出模型的准确性和可靠性,并进一步优化模型以达到更好的效果。

5. 结果分析与总结总结:本文是对数据挖掘实验进行详细阐述和分析的实验报告。

通过对数据预处理、特征选择、模型建立和评估等关键步骤的分析和总结,我们得出了对数据挖掘方法和技术的深入理解。

聚类分析法实训报告范文

一、实训背景随着大数据时代的到来,数据分析在各个领域都扮演着越来越重要的角色。

聚类分析法作为一种重要的数据分析方法,能够帮助我们根据数据的特点和特征,将相似的数据归为一类,从而发现数据中隐藏的规律和模式。

为了提高我们对聚类分析法的理解和应用能力,我们进行了本次实训。

二、实训目标1. 掌握聚类分析的基本概念和原理。

2. 熟悉常用的聚类分析方法,如K-means聚类、层次聚类等。

3. 学会使用SPSS等软件进行聚类分析。

4. 通过实际案例,提高运用聚类分析法解决实际问题的能力。

三、实训内容1. 聚类分析的基本概念和原理聚类分析是将一组数据根据相似性或距离进行分组的过程。

通过聚类分析,我们可以将数据划分为若干个类别,使得同一类别内的数据尽可能相似,不同类别之间的数据尽可能不同。

聚类分析的基本原理如下:(1)相似性度量:选择合适的相似性度量方法,如欧氏距离、曼哈顿距离等。

(2)聚类算法:选择合适的聚类算法,如K-means聚类、层次聚类等。

(3)聚类结果评估:评估聚类结果的合理性,如轮廓系数、内聚度和分离度等。

2. 常用的聚类分析方法(1)K-means聚类:K-means聚类是一种迭代优化算法,通过迭代计算聚类中心,将数据点分配到最近的聚类中心所在的类别。

(2)层次聚类:层次聚类是一种自底向上的聚类方法,通过不断合并距离最近的类别,形成树状结构。

3. 软件应用本次实训使用SPSS软件进行聚类分析。

SPSS软件具有操作简便、功能强大等特点,能够满足我们对聚类分析的需求。

四、实训案例案例一:客户细分某银行希望通过聚类分析,将客户分为不同的类别,以便更好地进行客户管理和营销。

我们收集了以下数据:- 客户年龄- 客户收入- 客户储蓄量- 客户消费频率使用K-means聚类方法,将客户分为四个类别:- 高收入、高消费群体- 中等收入、中等消费群体- 低收入、低消费群体- 高收入、低消费群体通过聚类分析,银行可以根据不同客户群体的特点,制定相应的营销策略。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

实验三 聚类分析一、实验目的1. 了解典型聚类算法2. 熟悉聚类分析算法的思路与步骤3. 掌握运用Matlab 对数据集做聚类分析的方法二、实验内容1. 运用Matlab 对数据集做K 均值聚类分析2. 运用Matlab 对数据集做基于密度的聚类分析三、实验步骤1.写出对聚类算法的理解聚类分析又称群分析,它是研究(样品或指标)分类问题的一种统计分析方法,同时也是数据挖掘的一个重要算法。

聚类(Cluster )分析是由若干模式(Pattern )组成的,通常,模式是一个度量(Measurement )的向量,或者是多维空间中的一个点。

聚类分析以相似性为基础,在一个聚类中的模式之间比不在同一聚类中的模式之间具有更多的相似性。

在数据中发现数据对象之间的关系,将数据进行分组,组内的相似性越大,组间的差别越大,则聚类效果越好。

在进行聚类分析时,出于不同的目的和要求,可以选择不同的统计量和聚类方法。

2.写出K-means 算法步骤通过迭代把数据对象划分到不同的簇中,以求目标函数最大化,从而使生成的簇尽可能地紧凑和独立。

具体步骤如下:(1)首先,随机选取k 个对象作为初始的k 个簇的质心;(2)然后,将其余对象根据其与各个簇质心的距离分配到最近的簇;(3)再要求形成的簇的质心。

这个迭代重定位过程不断重复,直到目标函数最小化为止。

设p 表示数据对象,i c 表示 簇i C 的均值,通常采用的目标函数形式为平法误差准则函数: 21||||∑∑=∈-=k i C p i i c p E (欧几里得距离)3.写出DBSCAN 算法步骤与均值漂移聚类类似,DBSCAN 也是基于密度的聚类算法。

具体步骤如下:(1)首先确定半径r 和minPoints. 从一个没有被访问过的任意数据点开始,以这个点为中心,r为半径的圆内包含的点的数量是否大于或等于minPoints,如果大于或等于minPoints则改点被标记为central point,反之则会被标记为noise point。

(2)重复1的步骤,如果一个noise point存在于某个central point为半径的圆内,则这个点被标记为边缘点,反之仍为noise point。

重复步骤1,直到所有的点都被访问过。

4.启动Matlab,运用Matlab对数据集进行K-means算法、DBSCAN算法聚类分析,写出关键代码,数据集名称,记录实验过程,实验结果,并分析实验结果。

(1)K-means算法:1)关键代码:% k-均聚类算法clcclear;% main variablesdim = 30; % 模式样本维数k = 4; % 设有k个聚类中心load('testSet.txt');PM=testSet;% 模式样本矩阵N = size(PM,1);figure();subplot(1,2,1);for(i=1:N)plot(PM(i,1),PM(i,2), '*r'); % 绘出原始的数据点hold onendxlabel('X');ylabel('Y');title('聚类之前的数据点');CC = zeros(k,dim); % 聚类中心矩阵,CC(i,:)初始值为i号样本向量D = zeros(N,k); % D(i,j)是样本i和聚类中心j的距离C = cell(1,k); %% 聚类矩阵,对应聚类包含的样本。

初始状况下,聚类i(i<k)的样本集合为[i],聚类k的样本集合为[k,k+1,...N]for i = 1:k-1C{i} = [i];endC{k} = k:N;B = 1:N; % 上次迭代中,样本属于哪一聚类,设初值为1B(k:N) = k;for i = 1:kCC(i,:) = PM(i,:);endwhile 1change = 0;%用来标记分类结果是否变化% 对每一个样本i,计算到k个聚类中心的距离for i = 1:Nfor j = 1:k% D(i,j) = eulerDis( PM(i,:), CC(j,:) );D(i,j) = sqrt((PM(i,1) - CC(j,1))^2 + (PM(i,2) - CC(j,2))^2); endt = find( D(i,:) == min(D(i,:)) ); % i属于第t类if B(i) ~= t % 上次迭代i不属于第t类change = 1;% 将i从第B(i)类中去掉t1 = C{B(i)};t2 = find( t1==i );t1(t2) = t1(1);t1 = t1(2:length(t1));C{B(i)} = t1;C{t} = [C{t},i]; % 将i加入第t类B(i) = t;endendif change == 0 %分类结果无变化,则迭代停止break;end% 重新计算聚类中心矩阵CCfor i = 1:kCC(i,:) = 0;iclu = C{i};for j = 1:length(iclu)CC(i,:) = PM( iclu(j),: )+CC(i,:);endCC(i,:) = CC(i,:)/length(iclu);endendsubplot(1,2,2);plot(CC(:,1),CC(:,2),'o')hold onfor(i=1:N)if(B(1,i)==1)plot(PM(i,1),PM(i,2),'*b'); %作出第一类点的图形 hold onelseif(B(1,i)==2)plot(PM(i,1),PM(i,2), '*r'); %作出第二类点的图形 hold onelseif(B(1,i)==3)plot(PM(i,1),PM(i,2),'*g'); %作出第三类点的图形 hold onelseplot(PM(i,1),PM(i,2), '*m'); %作出第四类点的图形 hold onendendxlabel('X');ylabel('Y');title('聚类之后的数据点');% 打印C,CCfor i = 1:k %输出每一类的样本点标号str=['第' num2str(i) '类包含点: ' num2str(C{i})]; disp(str);end;2)数据集名称:Breast Cancer Wisconsin (Diagnostic)3)实验结果:第1类包含点: 20 23 77 90 99 121 124 131 134 141 149 159 167 171 173 180 210 221 222 226 228 248 272 288 295 296 297 309 310 313 314 323 327 337 348 372 381 385 391 402 407 419 422 454 473 483 485 1 494 512 514 528 529 530 6 21 22 49 60 61 64 72 74 82 85 93 102 106 129 138 140 144 145 146 153 154 155 160 174 175 176 184 186 190 227 241 242 250 277 280 282 285 293 307 308 312 317 325 331 334 343 345 346 350 355 358 375 379 382 387 388 389 399 405 427 438 440 443 475 476 479 505 506 511 521 526 541 52 70 75 115 117 118 125 137 147 196 206 235 269 271 274 321 341 349 359 404 423 429 478 486 487 489 501 503 520 525 533 547 548 47 111 170 216 225 256 316 320 342 351 365 376 392 412 435 492 509 126 188 258 396 400 441 455 508 30 69 143 189 207 276 326 498 218 247 294 384 398 223 339 411 531 139 535第2类包含点: 78 86 109 122 123 128 142 162 163 187 213 254 255 283 301 318 2 353 364 369 373 374 35 445 488 499 504 57 7 28 76 120 158 168 178 202 208 231 253 278 284 322 433 450 480 490 518 3 18 71 157 165 181 219 238 5 273 324 329 336 338 344 54 366 370 401 409 26 493 500 517 522 534 536 19 24 25 36 83 96 133 135 198 199 211 46 265 340 394 434 565 79 245 251 263 303 330 390 462 262 564 203 469 237第3类包含点:367 182 371 281 261 220 275 415 73 34 442 447 11 452 461 14 119 266 354 33 29 510 240 84 88 257 214 563 260 259 566 567 568 16 39 234 66 91 101 127 31 194 195 215 233 239 378 386 169 43 453 456 457 458 459 463 472 474 502 542 543 544 553 555 13 561 562 130 204 232 244 460 556 558 446 249第4类包含点: 362 236 95 161 403 230 108 406 62 408 63 410 395 148 413 103 164 416 417 418 217 420 421 166 397 424 425 426 116 428 335 430 50 432(2)DBSCAN算法:1)关键代码:function [IDX, isnoise]=DBSCAN(X,epsilon,MinPts)C=0;n=size(X,1);IDX=zeros(n,1);D=pdist2(X,X);visited=false(n,1);isnoise=false(n,1);for i=1:nif ~visited(i)visited(i)=true;Neighbors=RegionQuery(i);if numel(Neighbors)<MinPts% X(i,:) is NOISEisnoise(i)=true;elseC=C+1;ExpandCluster(i,Neighbors,C);Endendendfunction ExpandCluster(i,Neighbors,C)IDX(i)=C;k = 1;while truej = Neighbors(k);if ~visited(j)visited(j)=true;Neighbors2=RegionQuery(j);if numel(Neighbors2)>=MinPtsNeighbors=[Neighbors Neighbors2]; %#okendendif IDX(j)==0IDX(j)=C;endk = k + 1;if k > numel(Neighbors)break;endendendfunction Neighbors=RegionQuery(i)Neighbors=find(D(i,:)<=epsilon);endend2)数据集:Iris3)实验结果:4.扩展作业:选取医学图像,运用K-means算法、DBSCAN算法进行医学图像分割1)关键代码:function [C, label, J] = kmeans(I, k)[m, n, p] = size(I);X = reshape(double(I), m*n, p);rng('default');C = X(randperm(m*n, k), :);J_prev = inf; iter = 0; J = []; tol = 1e-2;while true,iter = iter + 1;dist = sum(X.^2, 2)*ones(1, k) + (sum(C.^2, 2)*ones(1, m*n))' - 2*X*C'; [~, label] = min(dist, [], 2) ;for i = 1:k,C(i, :) = mean(X(label == i , :));endJ_cur = sum(sum((X - C(label, :)).^2, 2));J = [J, J_cur];display(sprintf('#iteration: %03d, objective fcn: %f', iter, J_cur)); if norm(J_cur-J_prev, 'fro') < tol,break;endJ_prev = J_cur;endclear all; close all;I = imread('./1.png');[m, n, p] = size(I);k = 7;[C, label, J] = kmeans(I, k);I_seg = reshape(C(label, :), m, n, p);figuresubplot(1, 2, 1), imshow(I, []), title('原图')subplot(1, 2, 2), imshow(uint8(I_seg), []), title('聚类图')figureplot(1:length(J), J), xlabel('#iterations') 2)实验结果:。