实验三K均值聚类算法实验报告

聚类分析实验报告

聚类分析实验报告一、实验目的:通过聚类分析方法,对给定的数据进行聚类,并分析聚类结果,探索数据之间的关系和规律。

二、实验原理:聚类分析是一种无监督学习方法,将具有相似特征的数据样本归为同一类别。

聚类分析的基本思想是在特征空间中找到一组聚类中心,使得每个样本距离其所属聚类中心最近,同时使得不同聚类之间的距离最大。

聚类分析的主要步骤有:数据预处理、选择聚类算法、确定聚类数目、聚类过程和聚类结果评价等。

三、实验步骤:1.数据预处理:将原始数据进行去噪、异常值处理、缺失值处理等,确保数据的准确性和一致性。

2.选择聚类算法:根据实际情况选择合适的聚类算法,常用的聚类算法有K均值算法、层次聚类算法、DBSCAN算法等。

3.确定聚类数目:根据数据的特征和实际需求,确定合适的聚类数目。

4.聚类过程:根据选定的聚类算法和聚类数目进行聚类过程,得到最终的聚类结果。

5. 聚类结果评价:通过评价指标(如轮廓系数、Davies-Bouldin指数等),对聚类结果进行评价,判断聚类效果的好坏。

四、实验结果:根据给定的数据集,我们选用K均值算法进行聚类分析。

首先,根据数据特点和需求,我们确定聚类数目为3、然后,进行数据预处理,包括去噪、异常值处理和缺失值处理。

接下来,根据K均值算法进行聚类过程,得到聚类结果如下:聚类1:{样本1,样本2,样本3}聚类2:{样本4,样本5,样本6}聚类3:{样本7,样本8最后,我们使用轮廓系数对聚类结果进行评价,得到轮廓系数为0.8,说明聚类效果较好。

五、实验分析和总结:通过本次实验,我们利用聚类分析方法对给定的数据进行了聚类,并进行了聚类结果的评价。

实验结果显示,选用K均值算法进行聚类分析,得到了较好的聚类效果。

实验中还发现,数据预处理对聚类分析结果具有重要影响,必要的数据清洗和处理工作是确保聚类结果准确性的关键。

此外,聚类数目的选择也是影响聚类结果的重要因素,过多或过少的聚类数目都会造成聚类效果的下降。

k-means算法实验报告

.哈尔滨工业大学数据挖掘理论与算法实验报告(2014年度秋季学期).课程编码S1300019C授课教师高宏学生姓名赵天意学号14S101018学院电气工程及自动化学院一、实验内容设计实现 k 均值聚类算法。

二、实验设计随机生成 2 维坐标点,对点进行聚类,进行k=2 聚类, k=3 聚类,多次 k=4 聚类,分析比较实验结果。

三、实验环境及测试数据实验环境: Windows7操作系统,Python2.7 IDLE测试数据:随机生成 3 个点集,点到中心点距离服从高斯分布:集合大小中心坐标半径11005,52 210010,62 31008,102四、实验过程编写程序随机生成测试点集,分别聚成2, 3, 4 类,观察实验结果多次 4 聚类,观察实验结果五、实验结果初始随机点:2聚类迭代 -平方误差1234561337677639634633633聚类中心与类中点数9.06 ,8.291915.05 ,5.011093聚类123456789101112 810692690688686681565385369.4369.8373700 4.99 ,5.05108,7.92 ,10.489310.15 ,6.16994聚类迭代 27次,平方误差 344.897291273 7.95,,10.56904.89,5.001038.41,6.313810.75 ,6.1,469多次4聚类迭代27次平方误差 352.19 4.95 ,5.031069.79 ,6.03937.85 ,10.509012.71 ,8.1611迭代 8 次平方误差356.1910.15 ,6.16997.92 ,10.48935.54 ,5.01674.09 ,5.1041迭代 7 次平方误差352.3510.39 ,6.04874.91 ,4.981038.00 ,10.79797.71 ,7.6931六、遇到的困难及解决方法、心得体会K-Means初值对最终的聚类结果有影响,不同初值,可能会有不同的聚类结果,也就是说, K-Means收敛于局部最优点K-Means趋向于收敛到球形,每类样本数相近K-Means随着k的增加,平方误差会降低,但聚类效果未必变好该例子, 2 聚类误差 633 , 3 聚类 370 ,4 聚类 350 ,可以发现 2 聚类到 3 聚类误差下降较快, 3 到 4 聚类误差下降较慢,所以 3 是最佳聚类个数。

如何使用K均值算法进行聚类分析(Ⅲ)

K均值算法是一种常用的聚类分析方法,它可以根据数据的特征将数据集分成若干个簇。

在实际应用中,K均值算法被广泛用于数据挖掘、模式识别、图像分割等领域。

本文将详细介绍如何使用K均值算法进行聚类分析,并且探讨一些常见的应用场景。

1. 算法原理K均值算法的原理比较简单,首先需要确定簇的数量K,然后随机选择K个数据点作为初始的聚类中心。

接着,将数据集中的每个数据点分配到与其最近的聚类中心所在的簇中。

然后重新计算每个簇的中心点,直到簇中心不再发生变化或者达到预设的迭代次数为止。

最终得到K个簇,每个簇包含一组相似的数据点。

2. 数据预处理在使用K均值算法进行聚类分析之前,需要对数据进行预处理。

首先需要对数据进行标准化处理,使得各个特征的取值范围相对一致。

其次,需要对数据进行降维处理,以减少计算复杂度和提高聚类效果。

最后,需要对数据进行缺失值处理和异常值处理,以确保数据的完整性和准确性。

3. 选择簇的数量K选择簇的数量K是K均值算法中的一个关键步骤。

通常情况下,可以通过肘部法则来确定最优的簇的数量。

肘部法则是通过绘制簇内平方和与簇的数量K的关系图,找到拐点所对应的K值作为最佳的簇的数量。

另外,可以通过轮廓系数等指标来评估不同K值下的聚类效果,选择使得聚类效果最优的簇的数量。

4. 聚类结果评估在得到聚类结果之后,需要对聚类结果进行评估。

通常可以使用簇内平方和、轮廓系数、Davies-Bouldin指数等指标来评估聚类的效果。

除此之外,还可以通过可视化的方式来展示聚类的结果,比如绘制簇的中心点、簇的分布图等。

通过对聚类结果的评估,可以调整算法参数,优化聚类效果。

5. 应用场景K均值算法在各个领域都有着广泛的应用。

在市场营销领域,可以使用K均值算法对客户进行分群,以便针对不同的客户群体制定个性化的营销策略。

在医疗领域,可以使用K均值算法对患者进行分组,以便进行疾病风险评估和治疗方案制定。

在金融领域,可以使用K均值算法对金融产品进行分群,以便推荐个性化的金融产品。

实验三-K-均值聚类算法实验报告

实验三K-Means聚类算法一、实验目的1) 加深对非监督学习的理解和认识2) 掌握动态聚类方法K-Means 算法的设计方法二、实验环境1) 具有相关编程软件的PC机三、实验原理1) 非监督学习的理论基础2) 动态聚类分析的思想和理论依据3) 聚类算法的评价指标四、算法思想K-均值算法的主要思想是先在需要分类的数据中寻找K组数据作为初始聚类中心,然后计算其他数据距离这三个聚类中心的距离,将数据归入与其距离最近的聚类中心,之后再对这K个聚类的数据计算均值,作为新的聚类中心,继续以上步骤,直到新的聚类中心与上一次的聚类中心值相等时结束算法。

实验代码function km(k,A)%函数名里不要出现“-”warning off[n,p]=size(A);%输入数据有n个样本,p个属性cid=ones(k,p+1);%聚类中心组成k行p列的矩阵,k表示第几类,p是属性%A(:,p+1)=100;A(:,p+1)=0;for i=1:k%cid(i,:)=A(i,:); %直接取前三个元祖作为聚类中心m=i*floor(n/k)-floor(rand(1,1)*(n/k))cid(i,:)=A(m,:);cid;endAsum=0;Csum2=NaN;flags=1;times=1;while flagsflags=0;times=times+1;%计算每个向量到聚类中心的欧氏距离for i=1:nfor j=1:kdist(i,j)=sqrt(sum((A(i,:)-cid(j,:)).^2));%欧氏距离end%A(i,p+1)=min(dist(i,:));%与中心的最小距离[x,y]=find(dist(i,:)==min(dist(i,:)));[c,d]=size(find(y==A(i,p+1)));if c==0 %说明聚类中心变了flags=flags+1;A(i,p+1)=y(1,1);elsecontinue;endendiflagsfor j=1:kAsum=0;[r,c]=find(A(:,p+1)==j);cid(j,:)=mean(A(r,:),1);for m=1:length(r)Asum=Asum+sqrt(sum((A(r(m),:)-cid(j,:)).^2));endCsum(1,j)=Asum;endsum(Csum(1,:))%if sum(Csum(1,:))>Csum2% break;%endCsum2=sum(Csum(1,:));Csum;cid; %得到新的聚类中心endtimesdisplay('A矩阵,最后一列是所属类别'); Afor j=1:k[a,b]=size(find(A(:,p+1)==j));numK(j)=a;endnumKtimesxlswrite('data.xls',A);五、算法流程图六、实验结果>>Kmeans6 iterations, total sum of distances = 204.82110 iterations, total sum of distances = 205.88616 iterations, total sum of distances = 204.8219 iterations, total sum of distances = 205.886........9 iterations, total sum of distances = 205.8868 iterations, total sum of distances = 204.8218 iterations, total sum of distances = 204.82114 iterations, total sum of distances = 205.88614 iterations, total sum of distances = 205.8866 iterations, total sum of distances = 204.821Ctrs =1.0754 -1.06321.0482 1.3902-1.1442 -1.1121SumD =64.294463.593976.9329七、实验心得初始的聚类中心的不同,对聚类结果没有很大的影响,而对迭代次数有显著的影响。

聚类分析算法实验报告(3篇)

第1篇一、实验背景聚类分析是数据挖掘中的一种重要技术,它将数据集划分成若干个类或簇,使得同一簇内的数据点具有较高的相似度,而不同簇之间的数据点则具有较低相似度。

本实验旨在通过实际操作,了解并掌握聚类分析的基本原理,并对比分析不同聚类算法的性能。

二、实验环境1. 操作系统:Windows 102. 软件环境:Python3.8、NumPy 1.19、Matplotlib 3.3.4、Scikit-learn0.24.03. 数据集:Iris数据集三、实验内容本实验主要对比分析以下聚类算法:1. K-means算法2. 聚类层次算法(Agglomerative Clustering)3. DBSCAN算法四、实验步骤1. K-means算法(1)导入Iris数据集,提取特征数据。

(2)使用Scikit-learn库中的KMeans类进行聚类,设置聚类数为3。

(3)计算聚类中心,并计算每个样本到聚类中心的距离。

(4)绘制聚类结果图。

2. 聚类层次算法(1)导入Iris数据集,提取特征数据。

(2)使用Scikit-learn库中的AgglomerativeClustering类进行聚类,设置链接方法为'ward'。

(3)计算聚类结果,并绘制树状图。

3. DBSCAN算法(1)导入Iris数据集,提取特征数据。

(2)使用Scikit-learn库中的DBSCAN类进行聚类,设置邻域半径为0.5,最小样本数为5。

(3)计算聚类结果,并绘制聚类结果图。

五、实验结果与分析1. K-means算法实验结果显示,K-means算法将Iris数据集划分为3个簇,每个簇包含3个样本。

从聚类结果图可以看出,K-means算法能够较好地将Iris数据集划分为3个簇,但存在一些噪声点。

2. 聚类层次算法聚类层次算法将Iris数据集划分为3个簇,与K-means算法的结果相同。

从树状图可以看出,聚类层次算法在聚类过程中形成了多个分支,说明该算法能够较好地处理不同簇之间的相似度。

K均值聚类

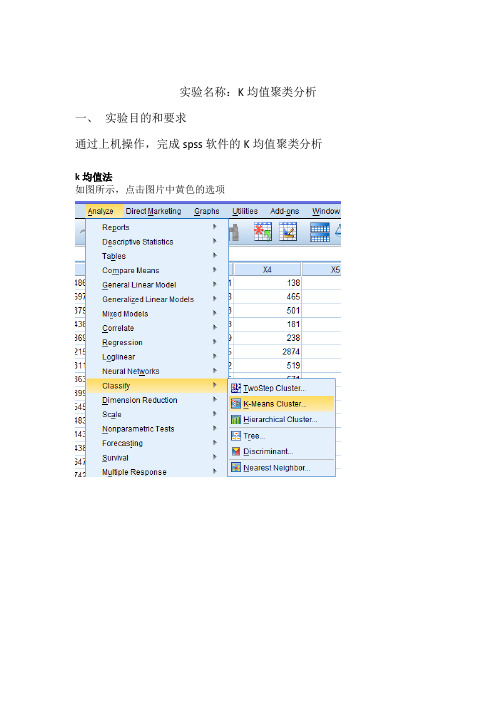

实验名称:K均值聚类分析一、实验目的和要求通过上机操作,完成spss软件的K均值聚类分析k均值法如图所示,点击图片中黄色的选项如图所示进行操作点击interate,按下图进行操作点击options,按下图进行操作点击Save 按下图进行操作结果与分析上表为初始类中心,通过该表可得到9个变量的初始类中心,该表为迭代历史表,该表给出了迭代过程中类中心的变动量,可以看出本次聚类过程进行了2次迭代,就收敛了。

Cluster MembershipCase Number 地区Cluster Distance1 北京 1 44568.4152 天津 4 42381.8363 石家庄4 26915.6304 太原 4 19555.5815 沈阳 4 16337.7836 大连 4 31007.6277 长春 4 20010.7888 哈尔滨 4 26575.1529 上海 4 93352.22910 南京 4 32733.44811 杭州 4 32602.47012 宁波 4 36201.89113 合肥 4 5489.31414 福州 4 13379.26515 厦门 4 56926.08916 南昌 4 22419.76817 济南 4 6901.07318 青岛 4 16839.72719 郑州 4 21258.50020 武汉 4 20666.40321 长沙 4 18185.01222 广州 1 44568.41523 深圳 2 .00024 南宁 4 35043.52425 海口 4 29088.11726 重庆 3 25822.76627 成都 3 25822.76628 贵阳 4 31336.32529 昆明 4 25999.05930 西安 4 24853.28631 兰州 4 32964.15932 西宁 4 39390.80633 银川 4 21601.67134 乌鲁木齐 4 17507.292该表为聚类成员,从表中可以看出,将34个地方分为4类北京,广州为第一类,深圳的为第二类,重庆,成都为第三类,剩下的为第四类。

聚类分析实验报告

聚类分析实验报告

《聚类分析实验报告》

在数据挖掘和机器学习领域,聚类分析是一种常用的技术,用于将数据集中的对象分成具有相似特征的组。

通过聚类分析,我们可以发现数据集中隐藏的模式和结构,从而更好地理解数据并做出相应的决策。

在本次实验中,我们使用了一种名为K均值聚类的方法,对一个包含多个特征的数据集进行了聚类分析。

我们首先对数据进行了预处理,包括缺失值处理、标准化和特征选择等步骤,以确保数据的质量和可靠性。

接着,我们选择了合适的K值(聚类的数量),并利用K均值算法对数据进行了聚类。

在实验过程中,我们发现K均值聚类方法能够有效地将数据集中的对象分成具有相似特征的组,从而形成了清晰的聚类结构。

通过对聚类结果的分析,我们发现不同的聚类中心代表了不同的数据模式,这有助于我们更好地理解数据集中的内在规律和特点。

此外,我们还对聚类结果进行了评估和验证,包括使用轮廓系数和肘部法则等方法来评价聚类的质量和效果。

通过这些评估方法,我们得出了实验结果的可靠性和有效性,证明了K均值聚类在本次实验中的良好表现。

总的来说,本次实验通过聚类分析方法对数据集进行了深入的挖掘和分析,得到了有意义的聚类结果,并验证了聚类的有效性和可靠性。

通过这一实验,我们对聚类分析方法有了更深入的理解,也为今后在实际应用中更好地利用聚类分析提供了有力支持。

K均值实验

K均值聚类一、实验意义及目的掌握K均值聚类算法原理,能够利用Matlab编制程序实现K均值聚类,熟悉基于Matlab 的算法处理函数,并能够利用算法解决简单问题。

二、实验内容(1)使用Matlab中的kmeans函数,对其进行聚类。

(2)针对实例数据~:按照K均值聚类原理,采用欧氏距离作为衡量,基于Matlab编制程序,将数据聚集为两类。

三、Matlab相关函数介绍(可采用help kmeans命令查看kmeans函数的使用方法)(1)kmeans函数1)[IDX, C] = kmeans(X, K):将输入的N个点分为K类。

参数:X:N×n的矩阵,每一行对应一个点,每个点为n维;K:要聚成的类别数;IDX:N×1的向量,其元素为每个点所属类的类序号;C:K个类的类重心坐标矩阵,一个K×n的的矩阵,每一行是每一类的类重心坐标。

2)[IDX, C, SUMD, D] =kmeans(..., 'PARAM1',val1, 'PARAM2',val2, ...):允许用户设置更多的参数及参数值,用来控制函数所用的迭代算法。

参数:sumd:1×K的向量,类内距离和向量(即类内各点与类重心距离之和);D:N×K的矩阵,每个点与每个类重心之间的距离矩阵。

其余参数:(2)silhouette函数根据聚类结果绘制轮廓图,从轮廓图上看每个点的分类是否合理。

轮廓图上第i个点的轮廓值定义为:其中是第i个点与同类的其他点之间的平均距离,b为一个向量,其元素是第i个点与不同类的类内各点之间的平均距离。

轮廓值的取值范围为[-1,1],值越大,说明第i个点的分类越合理;当时,说明第i个点的分类不合理,还有比目前分类更合理的方案。

调用格式:[S,H] = silhouette(X, CLUST,DISTANCE))参数:X:N×n的矩阵,每一行对应一个点,每个点为n维;CLUST:聚类结果,是由每个观测所属类的类序号构成的数值向量,或是由类名称构成的字符矩阵或字符串元胞数组;S:轮廓值向量,N×1的向量,其元素为相应点的轮廓值;h:图形句柄,指定h时绘制轮廓图。

聚类算法_实验报告

一、实验背景随着大数据时代的到来,数据量呈爆炸式增长,如何有效地对海量数据进行处理和分析成为了一个重要课题。

聚类算法作为一种无监督学习方法,在数据挖掘、模式识别等领域有着广泛的应用。

本实验旨在通过实际操作,了解聚类算法的基本原理、实现方法及其在实际问题中的应用。

二、实验目的1. 理解聚类算法的基本原理和流程;2. 掌握K-means、层次聚类、DBSCAN等常用聚类算法;3. 分析不同聚类算法在处理不同类型数据时的优缺点;4. 学会使用聚类算法解决实际问题。

三、实验环境1. 操作系统:Windows 102. 编程语言:Python3. 数据库:Pandas4. 机器学习库:Scikit-learn四、实验内容1. K-means聚类算法(1)数据准备本实验使用的数据集为Iris数据集,包含150个样本,每个样本有4个特征。

(2)算法实现使用Scikit-learn库中的KMeans类实现K-means聚类算法。

(3)结果分析通过绘制样本分布图,观察聚类效果。

根据聚类结果,将样本分为3类,与Iris数据集的类别标签进行对比。

2. 层次聚类算法(1)数据准备本实验使用的数据集为鸢尾花数据集,包含150个样本,每个样本有4个特征。

(2)算法实现使用Scikit-learn库中的AgglomerativeClustering类实现层次聚类算法。

(3)结果分析通过绘制树状图,观察聚类过程。

根据聚类结果,将样本分为3类,与鸢尾花数据集的类别标签进行对比。

3. DBSCAN聚类算法(1)数据准备本实验使用的数据集为Iris数据集。

(2)算法实现使用Scikit-learn库中的DBSCAN类实现DBSCAN聚类算法。

(3)结果分析通过绘制样本分布图,观察聚类效果。

根据聚类结果,将样本分为3类,与Iris 数据集的类别标签进行对比。

五、实验结果与分析1. K-means聚类算法K-means聚类算法在Iris数据集上取得了较好的聚类效果,将样本分为3类,与真实标签一致。

k均值聚类算法实验报告

k均值聚类算法实验报告一. 引言k均值聚类算法是一种常用的无监督学习算法,广泛应用于数据分析和模式识别领域。

该算法能够将一组数据点划分为k个不同的簇(cluster),其中每个簇具有相似的特征。

本实验旨在通过实现k均值聚类算法并对其进行实验,深入理解该算法的原理和应用。

二. 算法原理k均值聚类算法的主要思想是通过迭代优化的方式将数据点划分为k 个簇。

算法的步骤如下:1. 随机选择k个初始中心点作为簇的质心。

2. 根据每个数据点与各个簇质心的距离,将数据点分配到距离最近的簇中。

3. 更新每个簇的质心,即计算每个簇中所有数据点的平均值并将其作为新的质心。

4. 重复步骤2和步骤3,直到质心的位置不再发生变化或达到设定的迭代次数。

三. 实验步骤1. 数据准备:选择适当的数据集,并进行数据预处理,如去除异常值、缺失值处理等。

2. 初始化:随机选择k个数据点作为初始质心。

3. 迭代:根据每个数据点与质心的距离,将其分配到距离最近的簇中。

然后更新每个簇的质心。

4. 终止条件:当质心的位置不再发生变化或达到设定的迭代次数时,停止迭代。

5. 结果分析:根据聚类结果,评估算法的性能,并进行可视化展示。

四. 实验结果我们选择了一个包含身高和体重两个特征的数据集作为实验数据。

通过实验,我们成功实现了k均值聚类算法,并得到了如下的聚类结果:- 簇1: 身高较高,体重较重的数据点。

- 簇2: 身高中等,体重较重的数据点。

- 簇3: 身高较低,体重较轻的数据点。

通过对聚类结果的分析,我们可以发现k均值聚类算法能够有效地将数据点划分为不同的簇,并且每个簇具有相似的特征。

这对于进一步的数据分析和决策制定具有重要的意义。

五. 结论与展望本实验中我们实现了k均值聚类算法,并成功应用于一个包含身高和体重两个特征的数据集。

通过实验结果的分析,我们可以得出以下结论:1. k均值聚类算法能够有效地将数据点划分为不同的簇,并且每个簇具有相似的特征。

k均值聚类算法总结

k均值聚类算法总结k均值聚类算法是一种常用的无监督学习算法,它将数据集分成k个不同的簇或群集。

该算法的主要步骤如下:1. 初始化:选择k个初始的聚类中心点。

可以随机选择或者根据特定的启发式方法选择。

2. 分配:对于每个数据点,计算它与每个聚类中心的距离,并将其分配到最近的聚类中心。

3. 更新:根据分配的结果,重新计算每个聚类的中心点,通常是计算聚类中所有数据点的平均值。

4. 重复步骤2和步骤3,直到达到停止条件,例如中心点不再变化或达到最大迭代次数。

5. 输出:最终的聚类结果是k个簇,每个簇包含一组相似的数据点。

k均值聚类算法的优点包括简单易实现、计算效率高等。

但也存在一些限制,比如对初始聚类中心的选择敏感、可能收敛到局部最优解等。

在实际应用中,为了得到更好的聚类结果,可以采取以下策略:1. 选择合适的k值:可以使用目标函数、肘部法则、轮廓系数等方法来评估不同k值下的聚类效果,选择最优的k值。

2. 初始化策略:可以尝试不同的初始化方法,如随机初始化、K-means++等,以避免陷入局部最优解。

3. 处理异常值:异常值可能会对聚类结果产生较大影响,可以考虑对异常值进行处理或者使用其他鲁棒性较强的聚类算法。

4. 特征选择和降维:在进行聚类前,可以进行特征选择和降维,以减少数据维度和噪音,提高聚类效果。

5. 聚类结果评估:可以使用内部评价指标(如紧密性和分离性)或外部评价指标(如兰德指数和互信息)来评估聚类结果的好坏。

总结起来,k均值聚类算法是一种简单而有效的聚类算法,通过迭代优化聚类中心的位置,将数据集划分成不同的簇。

在应用时,需要注意选择合适的k值、初始化策略,处理异常值,并且根据具体问题进行特征选择和降维,以获得更好的聚类结果。

K-means算法分析实验报告

班级: 计算机127班姓名: 潘** 学号: 12*****120K-means算法实验报告K-means算法,也被称为k-平均或k-均值算法,是一种得到最广泛使用的聚类算法。

它是将各个聚类子集内的所有数据样本的均值作为该聚类的代表点,算法的主要思想是通过迭代过程把数据集划分为不同的类别,使得评价聚类性能的准则函数达到最优(平均误差准则函数E ),从而使生成的每个聚类(又称簇)内紧凑,类间独立。

欧氏距离➢ 1.为每个聚类确定一个初始聚类中心,这样就有K 个初始聚类中心。

➢ 2.将样本集中的样本按照最小距离原则分配到最邻近聚类➢ 3.使用每个聚类中的样本均值作为新的聚类中心。

➢ 4.重复步骤2.3直到聚类中心不再变化。

➢ 5.结束,得到K个聚类优点:➢是解决聚类问题的一种经典算法,简单、快速。

➢对处理大数据集,该算法是相对可伸缩和高效率的。

➢因为它的复杂度是0 (n k t ) , 其中, n 是所有对象的数目, k 是簇的数目, t 是迭代➢的次数。

通常k < <n 且t < <n 。

➢当结果簇是密集的,而簇与簇之间区别明显时, 它的效果较好。

缺点:➢在簇的平均值被定义的情况下才能使用,这对于处理符号属性的数据不适用。

➢必须事先给出k(要生成的簇的数目),而且对初值敏感,对于不同的初始值,可能会导致不同结果。

经常发生得到次优划分的情况。

解决方法是多次尝试不同的初始值。

➢它对于“躁声”和孤立点数据是敏感的,少量的该类数据能够对平均值产生极大的影响。

算法实例(C++代码)#include<iostream>#include<ctime>#include<iomanip>#include<cmath>using namespace std;const int M=51,N=2,P=3;struct node{double h;double v;} ;void main(){node n[M];node center[P];int a[M][N],c[P],t=1,T=10;int i,j,k;srand(int(time(0)));for(i=0;i<M;i++) //随机产生50个坐标{n[i].h=rand()%100;n[i].v=rand()%100;}for(j=0;j<M;j++){cout<<"(" <<setw(2)<<n[j].h<<",";cout<<setw(2)<<n[j].v<<")"<<" ";if((j+1)%3==0)cout<<endl;}do{for(i=0;i<P;i++)c[i] = rand()%M+1;}while(!(c[0]!=c[1]&&c[0]!=c[2]&&c[1]!=c[2]));cout<<"原始簇心中心"<<endl;for(i=0;i<P;i++){center[i].h=n[c[i]].h;cout<<"(" <<setw(8)<<center[i].h<<",";center[i].v=n[c[i]].v;cout<<setw(8)<<center[i].v<<")"<<" ";}cout<<"\n"<<"======================================"<<endl; //========================================int e[P],x;double min,E[P],tem[P][N],distance[P];while(T>t){for(i=0;i<P;i++){e[i]=0;E[i]=0.00;for(j=0;j<2;j++)tem[i][j]=0.00;}for(i=0,x=0;i<M;i++,x=0){for(k=0;k<P;k++)distance[k] = pow((n[i].h - center[k].h), 2)+pow((n[i].v - center[k].v), 2);for(k=1;k<P;k++)if(distance[x]>distance[k])x=k;a[x][e[x]++]=i;}//输出簇类======================================for(j=0;j<P;j++){cout<<"簇类"<<j+1<<endl;for(i=0;i<e[j];i++){E[j]+=pow((n[a[j][i]].h - center[j].h), 2)+pow((n[a[j][i]].v - center[j].v), 2);tem[j][0]+=n[a[j][i]].h;tem[j][1]+=n[a[j][i]].v;cout<<"(" <<setw(2)<<n[a[j][i]].h<<",";cout<<setw(2)<<n[a[j][i]].v<<")"<<" ";if((i+1)%3==0)cout<<endl;}cout<<endl;}//计算新的簇类中心============================================ for(i=0;i<P;i++){center[i].h=tem[i][0]/e[i];center[i].v=tem[i][1]/e[i];E[i]=sqrt(E[i]/(e[i]-1));}cout<<"平方偏差"<<E[0]+E[1]+E[2]<<endl;cout<<"第"<<t+1<<"次聚类的簇心"<<endl;for(i=0;i<P;i++){cout<<"(" <<setw(8)<<center[i].h<<",";cout<<setw(8)<<center[i].v<<")"<<" ";}cout<<"\n"<<"========================"<<endl;t++;}return;}实验结果:循环10次聚类观察平方偏差是否减少。

实验三报告实验三 Kmeans算法实现

北华大学开放实验报告实验名称:实验三Kmeans算法实现所属课程:模式识别班级:信息10—1学号:36姓名:张慧实验三、K_means算法实现一、背景知识简介:Kmeans算法是一种经典的聚类算法,在模式识别中得到了广泛的应用,基于Kmeans的变种算法也有很多,模糊Kmeans、分层Kmeans 等。

Kmeans和应用于混合高斯模型的受限EM算法是一致的。

高斯混合模型广泛用于数据挖掘、模式识别、机器学习、统计分析。

Kmeans的迭代步骤可以看成E步和M步,E:固定参数类别中心向量重新标记样本,M:固定标记样本调整类别中心向量。

K均值只考虑(估计)了均值,而没有估计类别的方差,所以聚类的结构比较适合于特征协方差相等的类别。

二、k-means聚类算法k-means 算法接受参数k ;然后将事先输入的n个数据对象划分为k个聚类以便使得所获得的聚类满足:同一聚类中的对象相似度较高;而不同聚类中的对象相似度较小。

聚类相似度是利用各聚类中对象的均值所获得一个“中心对象”(引力中心)来进行计算的。

K-means算法是最为经典的基于划分的聚类方法,是十大经典数据挖掘算法之一。

K-means算法的基本思想是:以空间中k个点为中心进行聚类,对最靠近他们的对象归类。

通过迭代的方法,逐次更新各聚类中心的值,直至得到最好的聚类结果。

(1)算法思路:首先从n个数据对象任意选择k 个对象作为初始聚类中心;而对于所剩下其它对象,则根据它们与这些聚类中心的相似度(距离),分别将它们分配给与其最相似的(聚类中心所代表的)聚类;然后再计算每个所获新聚类的聚类中心(该聚类中所有对象的均值);不断重复这一过程直到标准测度函数开始收敛为止。

一般都采用均方差作为标准测度函数. k个聚类具有以下特点:各聚类本身尽可能的紧凑,而各聚类之间尽可能的分开。

该算法的最大优势在于简洁和快速。

算法的关键在于初始中心的选择和距离公式。

(2)算法步骤:step.1---初始化距离K个聚类的质心(随机产生)step.2---计算所有数据样本与每个质心的欧氏距离,将数据样本加入与其欧氏距离最短的那个质心的簇中(记录其数据样本的编号)step.3---计算现在每个簇的质心,进行更新,判断新质心是否与原质心相等,若相等,则迭代结束,若不相等,回到step2继续迭代。

K-均值聚类算法报告

K-均值聚类算法报告1.算法思想K-均值算法也称C-均值算法,是根据函数准则进行分类的聚类算法,基于使聚类准则函数最小化。

K-均值算法的主要思想是先在需要分类的数据中寻找K 组数据作为初始聚类中心,然后计算其他数据距离这三个聚类中心的距离,将数据归入与其距离最近的聚类中心,之后再对这K 个聚类的数据计算均值,作为新的聚类中心,继续以上步骤,直到新的聚类中心与上一次的聚类中心值相等时结束算法。

准则函数:聚类集中每一样本点到该类中心的距离平方和。

对于第j 个聚类集,准则函数定义为:S j :第j 个聚类集(域),聚类中心为Zj ;Nj :第j 个聚类集Sj 中所包含的样本个数。

对所有K 个模式类有:K-均值算法的聚类准则:聚类中心的选择应使准则函数J 极小,即使Jj 的值极小。

即有:可解得:上式表明,Sj 类的聚类中心应选为该类样本的均值。

2.算法描述(1)任选K 个初始聚类中心:Z 1(1), Z 2(1),…,ZK (1)括号内序号:迭代运算的次序号。

(2)按最小距离原则将其余样品分配到K 个聚类中心中的某一 个,即:则 (3)计算各个聚类中心的新向量值:Nj :第j 类的样本数。

(4)如果 则回到(2),将模式样本逐个重新分类,重复迭代计算。

ji j N i j i j S J ∈-=∑=X Z X ,||||12ji K j j N i j i S J ∈-=∑∑==X Z X 112,||||0)()(||||1T 12=--∂∂=-∂∂∑∑==j N i j i j i j j N i j i j Z Z X Z X Z X Z j i j N i i j j S N ∈=∑=X X Z ,11{})()(,,2,1,)(min k D k K i k j j i =-==-Z X Z X )(k S X j ∈K j k j ,,2,1)1( =+Z ()K j N k k j S X j j ,,2,11)1( ==+∑∈X Z K j k k j j ,,2,1)()1( =≠+Z Z如果 ,则算法收敛,计算完毕。

K均值聚类

课程实验聚类分析实验实验目的:加深对K 均值聚类分析算法的理解,掌握K 均值聚类分析分类器的设计方法。

实验内容:根据实验数据设计K均值聚类分析分类器,实验数据采用遥感彩色图像,以图像的所有象素为样本集,每一象素点的R、G、B值作为其特征向量。

1)选择合适的类别数K和初始聚类中心。

2)选择距离测度。

3)设计迭代中止条件,或人为设定迭代次数。

4)循环迭代结束时,各类的所有象素其R、G、B值用各类中心的R、G、B值表示,画出分类结果图。

5)分析不同初始聚类中心和迭代条件对分类效果的影响。

实验报告要求:上交电子版实验报告,实验报告内容包括问题求解思路,实验结果图表、实验结果分析以及实验源程序。

(采用Matlab或 C语言)问题求解思路:1)以下2个条件为可控制量:①选择合适的类别数K和初始聚类中心②设定迭代次数以K 均值聚类分析算法为基础运用MATLAB编写程序2)设定迭代次数,得出分析后的图片与原图片进行比较。

3)根据取值的不同分析不同初始聚类中心和迭代条件对分类效果的影响。

实验结果图表:(1)K值为6,迭代次数不同时实验结果如下(2)K值为7,迭代次数不同时实验结果如下实验代码:clearall;closeall;clc;a=imread('K:\model.bmp');R=a(:,:,1);G=a(:,:,2);B=a(:,:,3);r=reshape(R,50141,1);g=reshape(G,50141,1);b=reshape(B,50141,1);p=double([r,g,b]);z1=p(randi(50141,1),:);z2=p(randi(50141,1),:);z3=p(randi(50141,1),:);z4=p(randi(50141,1),:);z5=p(randi(50141,1),:);z6=p(randi(50141,1),:);zn=p(randi(50141,1),:); %n为K值d1=zeros(1,50141);d2=zeros(1,50141);d3=zeros(1,50141);d4=zeros(1,50141);d5=zeros(1,50141);d6=zeros(1,50141);dn=zeros(1,50141);%n为K值d=zeros(1,50141);fori=1:5%i:m m%为迭代次数m1=0;m2=0;m3=0;m4=0;m5=0;m6=0;mn=0;%n为K值for j=1:50141d1(j)=sqrt(dot((p(j,:)-z1),(p(j,:)-z1)));d2(j)=sqrt(dot((p(j,:)-z2),(p(j,:)-z2)));d3(j)=sqrt(dot((p(j,:)-z3),(p(j,:)-z3)));d4(j)=sqrt(dot((p(j,:)-z4),(p(j,:)-z4)));d5(j)=sqrt(dot((p(j,:)-z5),(p(j,:)-z5)));d6(j)=sqrt(dot((p(j,:)-z6),(p(j,:)-z6)));dn(j)=sqrt(dot((p(j,:)-zn),(p(j,:)-zn)));%n为K值endfor j=1:50141k=min([d1(j),d2(j),d3(j),d4(j),d5(j),d6(j)]); if d1(j)==kd(j)=1;elseif d2(j)==kd(j)=2;elseif d3(j)==kd(j)=3;elseif d4(j)==kd(j)=4;elseif d5(j)==kd(j)=5;elseif d6(j)==kd(j)=6;elseifdn(j)==kd(j)=n;%为K值endendz1=[0 0 0];z2=[0 0 0];z3=[0 0 0];z4=[0 0 0];z5=[0 0 0];z6=[0 0 0];zn=[0 0 0];%n为K值for j=1:50141if d(j)==1z1=z1+p(j,:);m1=m1+1;elseif d(j)==2z2=z2+p(j,:);m2=m2+1;elseif d(j)==3z3=z3+p(j,:);m3=m3+1;elseif d(j)==4z4=z4+p(j,:);m4=m4+1;elseif d(j)==5z5=z5+p(j,:);m5=m5+1;elseif d(j)==6z6=z6+p(j,:);m6=m6+1;elseif d(j)==nzn=zn+p(j,:);mn=mn+1; %n为K值endendz1=z1/m1;z2=z2/m2;z3=z3/m3;z4=z4/m4;z5=z5/m5;z6=z6/m6;zn=zn/mn;%n为K值endfor j=1:50141if d(j)==1p(j,:)=z1;elseif d(j)==2p(j,:)=z2;elseif d(j)==3p(j,:)=z3;elseif d(j)==4p(j,:)=z4;elseif d(j)==5p(j,:)=z5;elseif d(j)==6p(j,:)=z6;elseif d(j)==np(j,:)=zn;%n为K值endendp=uint8(p);r=p(:,1);g=p(:,2);b=p(:,3);R=reshape(r,247,203);G=reshape(g,247,203);B=reshape(b,247,203);a(:,:,1)=R;a(:,:,2)=G;a(:,:,3)=B;subplot(1,2,1);imshow(imread('F:\matlab2012_a\bin\模式识别\实验三\model.bmp'));title('原图片');subplot(1,2,2);imshow(a);title('图片(分析后K值为7,迭代5次)');。

实验报告3聚类分析

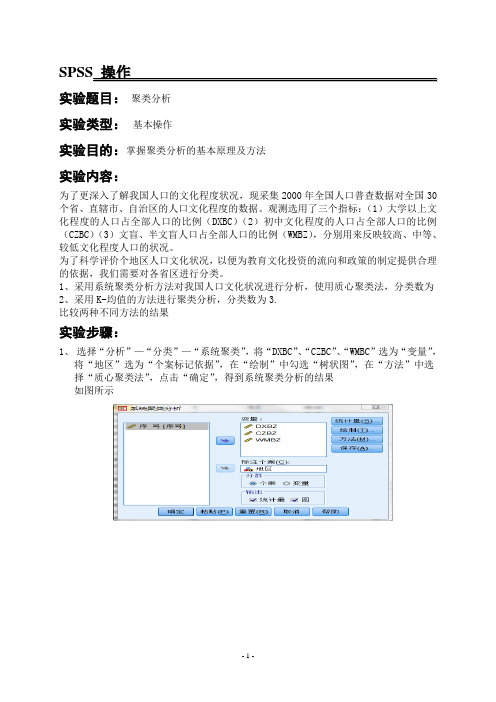

SPSS操作实验题目:聚类分析实验类型:基本操作实验目的:掌握聚类分析的基本原理及方法实验内容:为了更深入了解我国人口的文化程度状况,现采集2000年全国人口普查数据对全国30个省、直辖市、自治区的人口文化程度的数据。

观测选用了三个指标:(1)大学以上文化程度的人口占全部人口的比例(DXBC)(2)初中文化程度的人口占全部人口的比例(CZBC)(3)文盲、半文盲人口占全部人口的比例(WMBZ),分别用来反映较高、中等、较低文化程度人口的状况。

为了科学评价个地区人口文化状况,以便为教育文化投资的流向和政策的制定提供合理的依据,我们需要对各省区进行分类。

1、采用系统聚类分析方法对我国人口文化状况进行分析,使用质心聚类法,分类数为2、采用K-均值的方法进行聚类分析,分类数为3.比较两种不同方法的结果实验步骤:1、选择“分析”—“分类”—“系统聚类”,将“DXBC”、“CZBC”、“WMBC”选为“变量”,将“地区”选为“个案标记依据”,在“绘制”中勾选“树状图”,在“方法”中选择“质心聚类法”,点击“确定”,得到系统聚类分析的结果如图所示2、选择“分析”—“分类”—“K均值聚类”,将“DXBC”、“CZBC”、“WMBC”选为“变量”,将“地区”选为“个案标记依据”,将“聚类数”改为3,在“保存”项中,将“类聚成员”和“与类聚中心的距离”勾选,在“选项”中勾选“初始聚类中心”、“ANOVA表”、“每个个案的聚类信息”,然后点击确定,得到K均值聚类的结果如图所示实验结果:1.采用系统聚类分析方法对分析我国人口文化状况,使用质心聚类法,分类数为3从使用质心连接的树状图可得到,我国人口文化状况分为3类,第一类:浙江、陕西、河北、内蒙、江苏、河南、山东、河北、四川、海南、广东、新疆、广西、福建、江西、陕西、黑龙江、吉林、天津、上海、辽宁、北京;第二类:安徽、宁夏、甘肃、青海、贵州、云南6个省;第三类:西藏。

2.采用K均值的聚类分析方法,分类数为3最终聚类中心聚类1 2 3DXBZ 2.2 1.1 .6CZBZ 25.57 17.38 3.85WMBZ 13.2 23.0 44.4从最终聚类中心的结果可以得出如下结论:初中文化程度的人口占全国人口的比例(CZBZ)在一类和二类地区的中比较突出;在第三类地区中半文盲人口占全国人口的比例(WMBZ)比较突出;而且,由结果也可以看出,大学以上文化程度的人口占全国的比例(DXBZ)在三类地区中的所占比例都不高,也就是说,高等教育还有待加强。

聚类_实验报告

一、实验目的1. 理解K-均值聚类算法的基本原理和步骤。

2. 掌握K-均值聚类算法的编程实现。

3. 通过实际案例,验证K-均值聚类算法在数据挖掘中的有效性。

二、实验环境1. 操作系统:Windows 102. 编程语言:Python3.73. 数据集:使用UCI机器学习库中的鸢尾花数据集(Iris dataset)。

三、实验内容与方法1. K-均值聚类算法原理K-均值聚类算法是一种基于距离的聚类算法,其基本思想是将数据集中的数据点划分为K个簇,使得每个数据点与所属簇中心的距离最小。

算法步骤如下:(1)随机选择K个数据点作为初始聚类中心。

(2)将每个数据点分配到距离最近的聚类中心,形成K个簇。

(3)计算每个簇的中心,即该簇中所有数据点的均值。

(4)重复步骤(2)和(3),直到聚类中心不再发生显著变化。

2. 实验步骤(1)导入数据集```pythonfrom sklearn.datasets import load_irisiris = load_iris()X = iris.data```(2)选择K值根据数据集的特点和实际需求,选择合适的K值。

在本实验中,我们选择K=3,因为鸢尾花数据集包含3个类别。

(3)初始化聚类中心```pythonimport numpy as npdef initialize_centers(X, k):indices = np.random.choice(range(len(X)), k, replace=False)return X[indices]centers = initialize_centers(X, 3)```(4)计算距离```pythondef calculate_distance(x, center):return np.sqrt(np.sum((x - center) 2))```(5)分配数据点```pythondef assign_points(X, centers):clusters = [[] for _ in range(len(centers))]for x in X:distances = [calculate_distance(x, center) for center in centers]min_distance = min(distances)index = distances.index(min_distance)clusters[index].append(x)return clusters```(6)更新聚类中心```pythondef update_centers(clusters):new_centers = []for cluster in clusters:new_center = np.mean(cluster, axis=0) new_centers.append(new_center)return np.array(new_centers)```(7)迭代计算```pythondef k_means(X, k):centers = initialize_centers(X, k)while True:clusters = assign_points(X, centers) new_centers = update_centers(clusters) if np.allclose(new_centers, centers): breakcenters = new_centersreturn clusters, centers```(8)输出结果```pythonclusters, centers = k_means(X, 3)print("聚类结果:")for i, cluster in enumerate(clusters):print(f"簇{i}:{cluster}")print("聚类中心:")print(centers)```四、实验结果与分析1. 聚类结果根据实验结果,鸢尾花数据集被成功划分为3个簇,每个簇包含的数据点如下:簇0:[[5.1, 3.5, 1.4, 0.2], [4.9, 3.0, 1.4, 0.2], [4.7, 3.2, 1.3,0.2], ...]簇1:[[5.0, 3.6, 1.4, 0.2], [5.4, 3.9, 1.4, 0.2], [4.6, 3.4, 1.4,0.3], ...]簇2:[[5.2, 3.4, 1.4, 0.2], [4.4, 2.9, 1.4, 0.2], [4.9, 2.5, 1.4,0.2], ...]2. 聚类中心聚类中心如下:[[5.1, 3.5, 1.4, 0.2][5.2, 3.4, 1.4, 0.2][5.0, 3.6, 1.4, 0.2]]通过观察聚类结果和聚类中心,我们可以发现K-均值聚类算法在鸢尾花数据集上取得了较好的效果,成功地将数据划分为3个类别。

k均值聚类报告

K-均值聚类算法报告摘要K-均值是聚类方法中长用的一种划分方法,有很多优点,本文主要对K-均值是聚类方法的产生,工作原理,一般步骤,以及它的源码进行简单的介绍,了解K-均值是聚类!!!(一)课题名称:K-均值聚类(K-means clustering)(二)课题分析: J.B.MacQueen 在 1967 年提出的K-means算法[22]到目前为止用于科学和工业应用的诸多聚类算法中一种极有影响的技术。

它是聚类方法中一个基本的划分方法,常常采用误差平方和准则函数作为聚类准则函数,误差平方和准则函数定义为:K-means 算法的特点——采用两阶段反复循环过程算法,结束的条件是不再有数据元素被重新分配:① 指定聚类,即指定数据到某一个聚类,使得它与这个聚类中心的距离比它到其它聚类中心的距离要近。

② 修改聚类中心。

优点:本算法确定的K 个划分到达平方误差最小。

当聚类是密集的,且类与类之间区别明显时,效果较好。

对于处理大数据集,这个算法是相对可伸缩和高效的,计算的复杂度为O(NKt),其中N是数据对象的数目,t是迭代的次数。

一般来说,K<<N,t<<N 。

动态聚类方法是模式识别中一种普遍采用的方法,它具有以下3个要点:1:选定某种距离度量作为样本间的相似性度量2:确定某个评价聚类结果质量的准则函数3:给定某个初始分类,然后用迭代算法找出使准则函数取极值的最好的聚类结果处理流程:(1)从 n个数据对象任意选择 k 个对象作为初始聚类中心;(2)循环(3)到(4)直到每个聚类不再发生变化为止;(3)根据每个聚类对象的均值(中心对象),计算每个对象与这些中心对象的距离;并根据最小距离重新对相应对象进行划分;(4)重新计算每个(有变化)聚类的均值(中心对象)k-means 算法接受输入量 k ;然后将n个数据对象划分为 k个聚类以便使得所获得的聚类满足:同一聚类中的对象相似度较高;而不同聚类中的对象相似度较小。

机器学习实验3-K均值聚类

一、实验意义及目的掌握K均值聚类算法原理,能够利用MATLAB编程实现K均值聚类,熟悉基于Matlab的算法处理函数,并能够利用算法解决简单问题。

ab的算法处理函数,并能够利用算法解决简单问题二、算法原理k-means算法的思想比较简单,假设我们要把数据分成K个类,大概可以分为以下几个步骤:(1)随机选取k个点,作为聚类中心;(2)计算每个点分别到k个聚类中心的聚类,然后将该点分到最近的聚类中心,这样就行成了k个簇;(3)再重新计算每个簇的质心(均值);(4)重复以上2~4步,直到质心的位置不再发生变化或者达到设定的迭代次数。

类。

三、实验内容程序清单:clc,clear;%1、定义实例数据X=[0 0;1 0;0 1;1 1;2 1;1 2;2 2;3 2;6 6;7 6;8 6;6 7;7 7;8 7;9 7;7 8;8 8;9 8;8 9;9 9];[N,n]=size(X);%2、定义K值,即划分为两个聚类K=2;%3、调用kmeans函数[a b]=size(X);opts=statset('display','final');[idx,C]=kmeans(X,K,'Option',opts);[s,h]=silhouette(X,idx);c=randperm(N,K);clust=zeros(1,N);Z=zeros(K,n);for i=1:KZ(i,:)=X(c(i),:);endflag=0;%4、对实施数据进行多次迭代计算距离,分簇while flag==0for j=1:Nmin=1000000;for i=1:Kd=pdist2(X(j,:),Z(i,:));if min>dmin=d;clust(j)=i;endendendfor i=1:Kcount=zeros(1,n);number=0;for j=1:Nif clust(j)==inumber=number+1;for m=1:ncount(m)=count(m)+X(j,m);endendendif Z(i,:)==count/numberflag=1;elseZ(i,:)=count/numberendendend聚类结果:代码清单:clc;clear all;cat=imread('cat.jpg');[m,n]=size(cat);%两个class聚类global new_1,global class1,global class2; k=1;for j=1:1:nfor i=1:1:mnew_1(k)=cat(i,j);k=k+1;endend%对所有灰度值进行排序sort_cat=sort(new_1);%对直方图挑选两个中心点[p,xout]=hist(double(cat),2);xout1=xout(1,1);xout2=xout(2,1);min=3;j=1;new_xout1(j)=xout1;new_xout2(j)=xout2;%遍历所有的数进行聚类while(1)k1=1;k2=1;for i=1:1:m*nif( abs(sort_cat(i)- new_xout1(j)) < abs(sort_cat(i)-new_xout2(j)) )class1(k1)=sort_cat(i);k1=k1+1;elseclass2(k2)=sort_cat(i);k2=k2+1;endendj=j+1;new_xout1(j)=mean(class1);new_xout2(j)=mean(class2);if ( (abs(new_xout1(j)-new_xout1(j-1))<min) && (abs(new_xout2(j)-new_xout2(j-1))<min)) break;endend%获得阔值xout=[new_xout1(j),new_xout2(j)];mythreshlod=mean(xout);%划分图像i=1;j=1;for k=1:1:m*nif(new_1(k)<mythreshlod)new_1(k)=0;elsenew_1(k)=255;endendk_cat=reshape(new_1,[m,n]);%进行图像对比subplot(2,1,1);imshow(cat);title('原图')subplot(2,1,2);imshow(k_cat);title('K-means分割后')运行结果:四、实验感想通过这次实验,我学会了k均值聚类相关的分类方法,对数据分类有了进一步的认识,系统聚类是先把每个样本(或指标)各自作为一类,然后根据样本间的相似性和相邻性聚合,属于无监督学习,这对深入学习课程打下了坚实的基础。

模式识别 K均值聚类简单实现

J || x Ci || 2 , Ci 是第 i 类的聚类中心。

i 1 xCi

步骤如下: 1) 初始化:给定类别数 K,初始化聚类中心 C i (l ), i 1,2,..., k , l 1 2) 第 l 次迭代的修正: 逐个将样本 X {x1 , x 2 ,...., x n } 按照最小距离原则分配给 K 个聚类

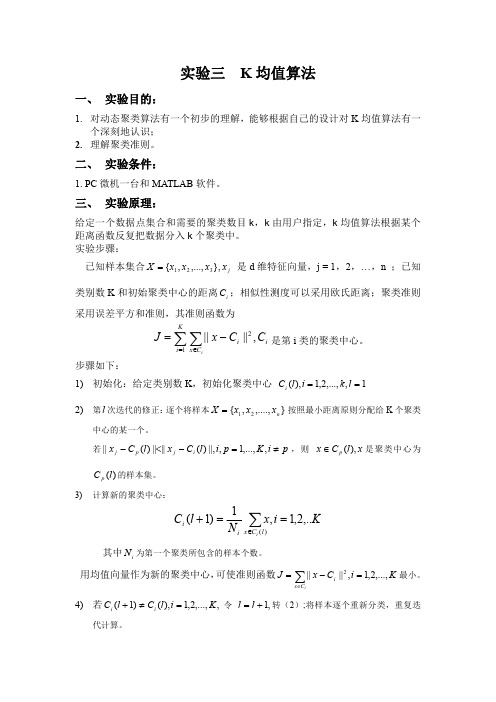

实验三 K 均值算法

一、 实验目的:

1. 对动态聚类算法有一个初步的理解,能够根据自己的设计对 K 均值算法有一 个深刻地认识; 2. 理解聚类准则。Fra bibliotek二、 实验条件:

1. PC 微机一台和 MATLAB 软件。

三、 实验原理:

给定一个数据点集合和需要的聚类数目 k,k 由用户指定,k 均值算法根据某个 距离函数反复把数据分入 k 个聚类中。 实验步骤: 已知样本集合 X {x1 , x 2 ,..., x3 }, x j 是 d 维特征向量,j = 1,2,…,n ;已知 类别数 K 和初始聚类中心的距离 C i ;相似性测度可以采用欧氏距离;聚类准则 采用误差平方和准则,其准则函数为

效果图:

六、 实验总结:

通过本次实验我进一步熟悉了 K 均值算法的相关知识。此外还在一定程度上锻 炼了我的编程能力及对 matlab 的使用。

中心的某一个。 若 || x j C p (l ) |||| x j C i (l ) ||, i, p 1,..., K , i p ,则 x C p (l ), x 是聚类中心为

C p (l ) 的样本集。

3) 计算新的聚类中心:

C i (l 1)

1 Ni

xCi ( l )

代计算。

若 C i (l 1) C i (l ), i 1,2,..., K , 算法收敛,计算完毕。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

实验三 K-Means聚类算法

一、实验目的

1) 加深对非监督学习的理解和认识

2) 掌握动态聚类方法K-Means 算法的设计方法

二、实验环境

1) 具有相关编程软件的PC机

三、实验原理

1) 非监督学习的理论基础

2) 动态聚类分析的思想和理论依据

3) 聚类算法的评价指标

四、算法思想

K-均值算法的主要思想是先在需要分类的数据中寻找K组数据作为初始聚类中心,然后计算其他数据距离这三个聚类中心的距离,将数据归入与其距离最近的聚类中心,之后再对这K个聚类的数据计算均值,作为新的聚类中心,继续以上步骤,直到新的聚类中心与上一次的聚类中心值相等时结束算法。

实验代码

function km(k,A)%函数名里不要出现“-”

warning off

[n,p]=size(A);%输入数据有n个样本,p个属性

cid=ones(k,p+1);%聚类中心组成k行p列的矩阵,k表示第几类,p是属性

%A(:,p+1)=100;

A(:,p+1)=0;

for i=1:k

%cid(i,:)=A(i,:); %直接取前三个元祖作为聚类中心

m=i*floor(n/k)-floor(rand(1,1)*(n/k))

cid(i,:)=A(m,:);

cid;

end

Asum=0;

Csum2=NaN;

flags=1;

times=1;

while flags

flags=0;

times=times+1;

%计算每个向量到聚类中心的欧氏距离

for i=1:n

for j=1:k

dist(i,j)=sqrt(sum((A(i,:)-cid(j,:)).^2));%欧氏距离 end

%A(i,p+1)=min(dist(i,:));%与中心的最小距离

[x,y]=find(dist(i,:)==min(dist(i,:)));

[c,d]=size(find(y==A(i,p+1)));

if c==0 %说明聚类中心变了

flags=flags+1;

A(i,p+1)=y(1,1);

else

continue;

end

end

i

flags

for j=1:k

Asum=0;

[r,c]=find(A(:,p+1)==j);

cid(j,:)=mean(A(r,:),1);

for m=1:length(r)

Asum=Asum+sqrt(sum((A(r(m),:)-cid(j,:)).^2)); end

Csum(1,j)=Asum;

end

sum(Csum(1,:))

%if sum(Csum(1,:))>Csum2

% break;

%end

Csum2=sum(Csum(1,:));

Csum;

cid; %得到新的聚类中心

end

times

display('A矩阵,最后一列是所属类别');

A

for j=1:k

[a,b]=size(find(A(:,p+1)==j));

numK(j)=a;

end

numK

times

xlswrite('data.xls',A);

五、算法流程图

六、实验结果

>>Kmeans

6 iterations, total sum of distances = 204.821

10 iterations, total sum of distances = 205.886

16 iterations, total sum of distances = 204.821

9 iterations, total sum of distances = 205.886

........

9 iterations, total sum of distances = 205.886

8 iterations, total sum of distances = 204.821

8 iterations, total sum of distances = 204.821

14 iterations, total sum of distances = 205.886

14 iterations, total sum of distances = 205.886

6 iterations, total sum of distances = 204.821

Ctrs =1.0754 -1.06321.0482 1.3902-1.1442 -1.1121

SumD =64.294463.593976.9329

七、实验心得

初始的聚类中心的不同,对聚类结果没有很大的影响,而对迭代次数有显著的影响。

数据的输入顺序不同,同样影响迭代次数,而对聚类结果没有太大的影响。