谢运洁-浅论Web使用挖掘

Web使用挖掘技术研究

Web使用挖掘技术研究随着信息技术的迅猛发展,互联网已经成为了人们生活和工作的主要载体之一,网络上的信息量也越来越庞大,如何从庞杂的网络信息中获取有用的信息,已经成为了一个重要的问题。

而挖掘技术的出现,为我们解决这一问题提供了无限可能。

Web使用挖掘技术研究指的是在互联网上使用挖掘技术,挖掘出有用的信息。

在Web使用挖掘技术研究中,最常见的挖掘技术包括文本挖掘、网络挖掘、数据挖掘等。

本文将围绕这些技术,详细介绍Web使用挖掘技术研究的相关内容和应用。

一、文本挖掘文本挖掘是从大规模文本数据中自动提取隐含的、以前未知的信息的一种技术。

文本挖掘是一种基于概率和统计分析的信息提取技术。

利用文本挖掘技术可以快速地过滤出相应的信息,而不必人工地检索。

文本挖掘的应用范围非常广泛,包括情感分析、主题分析、文本分类和信息抽取等。

首先,情感分析是指对文本的情感分析和判断,包括正面和负面情感识别等。

这种技术对于企业在市场营销中发挥重要的作用,能够及时了解消费者对产品的反馈和意见。

其次,主题分析是指对大量文本进行分析,提取其中的主题和关键词。

这种技术可以为企业提供市场营销方面最新的信息,以便更好地了解消费者的需求和利益。

如果企业可以了解消费者对某一种产品的喜好和不喜好,产品营销策略可以更加有效地制定。

再次,文本分类是指将文本数据分成不同的类别。

例如,在新闻领域,文本分类可以将新闻分成不同的类别,例如体育、科技、娱乐等,从而更加方便地阅读和查找。

最后,信息抽取是指从大量文本数据中自动提取并整合有用的信息。

这种技术可以快速地整理出大量的信息,方便使用者进行后续的分析和处理。

二、网络挖掘网络挖掘是指从各种网络数据中自动提取有用信息的技术。

网络数据可以包括互联网、社交媒体、电子邮件、业务应用程序等。

在社交媒体领域,可以使用网络挖掘技术,自动提取用户的兴趣和生活习惯等,从而为企业的市场营销做出决策提供参考。

在电子邮件领域,可以使用网络挖掘技术,提取出电子邮件中的信息并进行整理和分析。

WEB使用挖掘算法研究与实现的开题报告

WEB使用挖掘算法研究与实现的开题报告一、选题的背景与意义随着互联网的发展,Web应用已经成为人们重要的信息来源和交流平台。

Web使用数据挖掘技术对Web应用进行分析和挖掘已经成为一个热门的研究领域,这些数据挖掘技术可以用来预测用户行为、改进 Web 应用程序的性能,以及改善用户的 Web 使用体验。

Web 使用挖掘是指通过Web 应用程序中用户行为的挖掘,提取出有用的模式或规律,以实现一定的目标或具有价值的收获。

Web 使用挖掘不仅可以帮助开发人员更好地了解用户需求和行为,还可以帮助 WEB 应用程序更好地适应用户,从而提高用户的满意度。

因此,本文将研究并实现一种基于数据挖掘的 Web使用挖掘算法,旨在从用户行为中挖掘出有关用户情况的重要信息,以提高 Web 应用程序的性能、用户满意度和用户体验。

二、研究的内容和方法(一)研究的内容本文将研究基于数据挖掘的 Web使用挖掘算法,主要包括以下内容:1. 分析Web 应用程序用户的行为特征,包括用户的访问、点击、购买、搜索等行为。

2. 研究并构建数据模型来描述用户的行为特征,包括用户行为的时间、地点、频率等方面。

3. 借助数据挖掘技术,对用户行为数据进行挖掘,从中提取有用的模式和规律,如用户偏好、用户兴趣、用户需求等。

4. 根据挖掘结果进行用户行为预测、用户分类、用户推荐等,为 Web 应用程序提供有益的信息。

(二)研究的方法本文将主要采用以下方法:1. 系统性地了解 Web 使用挖掘的研究现状和相关理论,对常用的数据挖掘算法和技术进行学习和实践。

2. 通过数据分析,对Web 应用程序数据进行预处理和清理,构建用户行为数据模型,并进行可视化分析。

3. 采用特征选择和特征提取方法,对用户行为特征进行提取和优选,以利于后续的数据挖掘工作。

4. 采用机器学习方法和关联规则挖掘方法,对用户行为数据进行挖掘,并对挖掘结果进行解析、评估和优化。

5. 根据挖掘结果,对 Web 应用程序进行改进和优化,并对算法进行性能评估和对比分析。

一种改进的基于Web使用挖掘的数据预处理方法的研究

一种改进的基于Web使用挖掘的数据预处理方法的研究佚名【摘要】本文从各种数据源采集方法出发,分析各自的局限性,首先确定面向服务器端进行Web使用挖掘,然后进一步分析服务器端数据源的特性,给出针对此数据源的一种数据预处理方案及改进方法,提出数据净化、用户识别、会话识别等关键预处理步骤,为数据挖掘过程提供尽可能准确的目标数据。

%Based on the various data collecting methods, this paper analyses their respective limitations. First, the server is determined for Web usage mining. Then the characteristics of the server data sources are analyzed. For the data sources, a data pre-processing program and an improved method are put forward. The key pre-processing steps such as data cleaning, user identification, session identification, etc. are proposed, which provides accurate target data for the data mining process.【期刊名称】《安徽电子信息职业技术学院学报》【年(卷),期】2014(000)002【总页数】4页(P48-51)【关键词】Web使用挖掘;数据预处理;数据净化;用户识别;会话识别【正文语种】中文【中图分类】TP311.13Web数据预处理是Web使用挖掘的第一步,也是很重要的一步,它为后续的数据挖掘任务生成适合的目标数据。

Web使用挖掘技术的研究

3.Web使用挖掘(Web Usage Mining)

Web使用挖掘又叫Web 日志挖掘或Web用户访问模式挖 掘, 挖掘的对象是Web服务器上的信息, 包括服务 日志、 用户 注册信息等内容, 也有人通过客户端代理收集用户的行为, 这 些记录更准确更详细, 但是有可东西方文化交流与传播的不平 衡, 而且随着东西方文化交流的不断加强, 强势文化势必会逐 渐取得优势, 弱势文化则存在因失去 自 身特点而被同化的危 险。 如果没有构筑起坚实的人文素质基础, 当学生面对巨大的 文化差异时, 就极有可能承受不住文化冲击而发生认识偏差, 其极端的表现形式就是产生民族 自卑感或者盲 目排外 的意 识。所以, 英语教学应结合实际适当介绍我国文化 、 历史 、 地 理、 人文与 自然景观和各地风俗人情及我国改革开放的当代 成就, 有意识地引导学生了解我国源远流长的优秀文化传统、 悠久的灿烂文明史, 培养学生的民族 自尊心, 激发学生的民族

档, 并且是以某种格式(如HTM L(Hypertext M arkup Language, 超文本标识语言)或XM L(Extensible M arkup Language, 可扩展 性标识语言 ))呈现的 非结构化或半结构化数据, 这些数据的 特 点是结构不规则或不完整, 模式信息量大, 模式变化快, 大量

自豪感 。

听、 读、 说、 写的语言能力, 如何在中专英语教学中开展好人文

素质教育 , 既是一道重大的理论课题 , 更是一个迫切的实践课

题。广大中专英语教师不仅要有扎实的专业水平, 也要不断提 高人文素养, 觉对传统中专英语教学进行纠编, 要自 切合实际 在中专英语教学中积极开展人文素质教育, 促进学生素质全

的文档并没有任何排列次序, 也没有分类索引。 这些特征决定 了Web信息处理的难度相当大。

从Java Web应用到Web挖掘

从Java Web应用到Web挖掘李淑华【期刊名称】《软件》【年(卷),期】2016(037)007【摘要】随着web技术的发展,演示层、业务规则层从数据层分离出来。

模型视图控制器(MVC,Model View Controller)是第一个分离演示层和业务规则层的设计模式,提高了组件的灵活性和复用性。

在“浏览器-服务器”(Browser-Server)模式下,客户端只需要浏览器即可完成工作,有效地降低了运行与维护成本。

本文集中探讨如何用J2EE技术实现企事业单位内(Intranet)外(Internet)Web应用及Web Ming(挖掘)技术。

%Followed by the development of Web technology, presentation tier and business logic tier is separated from program. Model-View-Controller is the first design pattern which separates presentation tier and business logic tier, and improves the flexibility and reusability of components. Under Browser-Server pattern, clients can finalize its work only by Browser, which lower the cost of runnning and maintenance. This paper focuses on the implementation technology of Enterprise Intranet, Internet Spring Framework and Web mining.【总页数】3页(P132-134)【作者】李淑华【作者单位】哈尔滨市邮政公司函件广告局商函制作中心,黑龙江哈尔滨 150000【正文语种】中文【中图分类】TP3-05【相关文献】1.数据挖掘、Web挖掘与Web日志挖掘之研究 [J], 郭运宏2.Web日志挖掘与Web结构挖掘相结合的挖掘过程 [J], 刘丽娜;付帅3.利用Java实现基于XML的Web上的数据库挖掘Agent [J], 罗清磊;李卫华4.Web信息挖掘中Java搜索引擎技术的应用探究 [J], 罗伟生5.基于Java的搜索引擎技术在Web信息挖掘中的应用 [J], 褚丽莉因版权原因,仅展示原文概要,查看原文内容请购买。

试论数据挖掘技术在Web预取中的应用

试论数据挖掘技术在Web预取中的应用随着互联网的发展,人们对网页检索的需求也越来越高,提高网页搜索的效率成为了一个迫切需要解决的问题。

而数据挖掘技术的应用,为Web预取提供了新的解决方案。

本文将探讨数据挖掘技术在Web预取中的应用,并分析其在提高网页搜索效率方面所起到的作用。

一、数据挖掘技术在Web预取中的基本原理1.数据挖掘技术数据挖掘是一种通过从大量数据中寻找潜在模式、关联、趋势和规律的技术。

常用的数据挖掘技术包括关联规则挖掘、分类与预测、聚类分析和异常检测等。

在Web预取中,数据挖掘技术可以通过分析用户的浏览行为和网页内容来挖掘出用户的偏好和需求,从而进行智能化的预取决策。

2.Web预取Web预取是指在用户实际点击链接之前,提前获取并存储用户可能会访问的网页,以加快网页加载速度和提高用户体验。

传统的Web预取方法一般是通过页面的超链接进行预取决策,而数据挖掘技术可以为传统的Web预取方法提供更加智能化的决策支持。

二、数据挖掘技术在Web预取中的应用1.基于用户行为的预取数据挖掘技术可以通过分析用户的浏览历史和点击模式,挖掘出用户的偏好和兴趣。

基于用户行为的预取方法可以根据用户的偏好,提前获取并存储用户可能会访问的页面,从而减少用户等待时间,提高用户满意度。

2.基于网页内容的预取除了用户行为外,数据挖掘技术还可以通过分析网页的内容特征,挖掘出网页之间的关联和相似性。

基于网页内容的预取方法可以根据网页之间的关联和相似性,提前获取与当前页面相关的其它页面,从而提高网页的加载速度和用户体验。

3.基于预测的预取数据挖掘技术还可以通过建立预测模型,预测用户可能会访问的页面。

基于预测的预取方法可以根据预测模型的输出,提前获取并存储预测结果,从而降低网络延迟和减少用户等待时间。

三、数据挖掘技术在Web预取中的作用1.提高网页搜索效率数据挖掘技术可以通过分析用户的行为和网页内容,挖掘出用户的兴趣和需求,从而能够更加智能化地进行预取决策,提高网页搜索的效率。

数据挖掘技术在WEB的运用论文

数据挖掘技术在WEB的运用论文第1篇:数据挖掘技术在WEB的运用论文一、数据挖掘的背景互联网、计算机信息技术迅猛的发展势头,数据从结构化存储以及转化为非结构化的存储,数据存储形式的转变,不同数据类型的存储变多,音频、视频等大格式的信息存储在多个应用中实现。

行业中的计算机化、信息化和网络化,使计算机和服务器上积累了各种各样海量的数据。

传统的人工分析已经不能满足和适应如此大量的数据,各行各业都产生了巨大数据信息,包括生产加工、研究、物流运输、客户、营销、售后等数据,人们却不知道怎么利用这些数据实现价值的增长。

如果能将这些数据进行挖掘分析,很可能会产生巨大的商业价值,很多有价值的信息可以被发现。

现在,越来越多的公司和企业意识到数据挖掘的重要*,但是怎么能从如此海量的数据中挖掘出有价值有用的信息,已经成为研究的热门话题。

在传统的数据分析基础上,相关人员结合新开发人工智能和数据挖掘等相关的技术,数据库孕育而生,让我们能从海量的数据中挖掘出有价值的信息,促使信息化的发展,称之为数据挖掘。

二、数据挖掘的过程1、数据收集。

将要进行数据分析的海量数据资源收集到数据仓库中。

把不同来源、格式、特点*质的数据在逻辑上或物理上有机地集中,抽象出分析相关的数据,进行非结构化数据的分类,筛选出不相关或者无价值的数据,减少数据集的容量。

2、数据清洗和转换。

数据清洗是为了删除掉无用未完,继续阅读 >第2篇:电商网站设计中网络数据挖掘技术的运用论文在经济全球化的时代背景下,信息经济早已成为世界范围内的新的经济增长点,而且随着我国逐渐加强了与*经济的交流合作,使得企业的综合竞争力得到了增强,以此才能更好地应对全球市场中日趋激烈的竞争,同时我国还需要加强对电子商务所具有的众多优势的充分发挥,为企业的产品提供展现的舞台。

一、网络数据挖掘的重要*电子商务的开展与完善的电子商务平台是密切相连的,作为电子商务平台之一的电子商务网站也应该在创新中不断的完善,而且与传统商务相比,电子商务网站具有独特的优势。

搜索引擎中Web数据挖掘技术的应用价值研究

搜索引擎中Web数据挖掘技术的应用价值研究随着互联网、数字技术的发展,信息化时代已经深入到人们生活的各个方面。

在这个信息化时代,搜索引擎成为我们获取信息的主要途径之一,它帮助人们获取所需的信息资源。

然而,由于互联网上数据的泛滥和信息的碎片化,搜索引擎需要不断地更新和改进,充分发挥其搜索功能与价值。

Web数据挖掘技术(Web data mining)的应用,对于搜索引擎的发展至关重要。

本文将从Web数据挖掘技术的原理、应用和发展趋势三个方面,探讨其在搜索引擎中的应用价值。

一、Web数据挖掘技术Web数据挖掘技术,是指在海量的网络数据中发现潜在的数据模式,并将其转化为可操作的知识,用于支持决策和预测。

它是知识发现中的一部分,包括数据的获得、预处理、数据挖掘以及在线分析等多个过程。

数据挖掘技术是通过计算机处理大量数据,寻找数据的内在规律和联系。

而Web数据挖掘技术则是面向网络的数据挖掘方法,基于数据挖掘技术,结合网络的特点和应用领域的需求,寻找在网络中有价值的知识或是信息。

Web数据挖掘技术的具体内容包括数据抽取技术、数据清洗技术、数据集成技术、数据转换技术、数据规约技术、数据挖掘技术、模型评估技术。

二、Web数据挖掘技术在搜索引擎中的应用价值1、个性化搜索个性化搜索是一种以用户需求为出发点的搜索服务,它采用数据挖掘技术和机器学习算法,对人们的搜索行为进行统计分析,从而提供用户个性化服务,使用户更加便捷、高效地获取所需信息。

如百度搜索引擎就开展了大规模的个性化推荐研究,利用数据挖掘技术实现推荐算法。

通过对用户历史行为和个人兴趣分析,百度搜索引擎为用户推荐相关搜索词和资讯,提高用户的搜索效率。

2、智能问答系统随着人工智能技术的不断发展,智能问答系统成为搜索引擎中的新宠。

智能问答系统是一种基于大数据和自然语言处理技术的智能交互系统,它通过对用户的问题进行识别和分析,提供准确的答案。

通过对万维网的挖掘和分析,智能问答系统汇集海量知识和信息,提供多种查询方式,快速、准确地满足用户的需求。

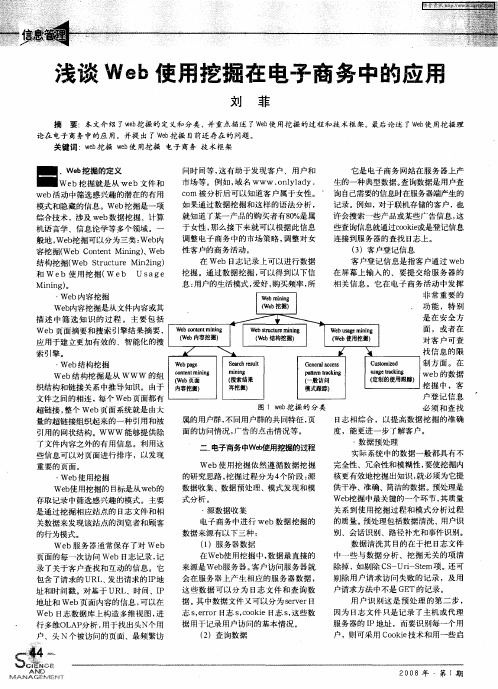

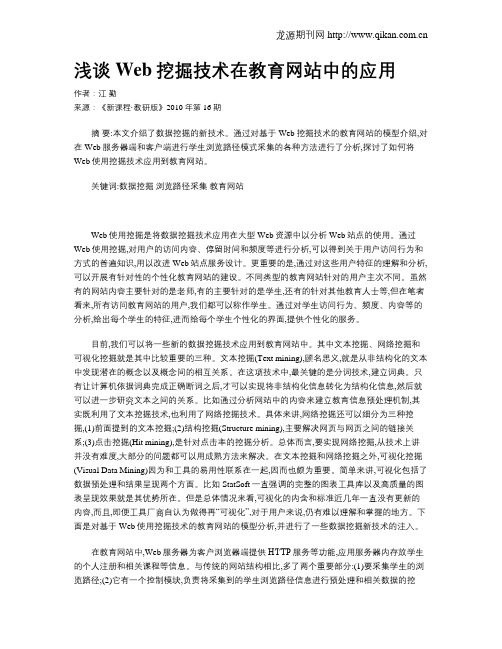

浅谈Web使用挖掘在电子商务中的应用

・

客户登记信息是指客户通过 we b 在 屏幕上输入 的 、要提 交给服务 器的 相关 信息 。它在 电子 商务活动 中发挥 非 常重要 的

功 能 ,特 别

W e mg miig bu c nn

・

Ie 掘 (b )l w挖 三

W e o tn miig bc ne t nn

是 在 安 全 方 面 ,或 者 在 对 客 户 可 查 找 信 息 的 限 制 方 面 。 在 we b的数 据 挖 掘 中 ,客 户 登 记 信 息 必 须 和 查 找

( e 内容挖掘) Wb

模式跟踪)

图 1w b 掘 的 分类 e挖

属的用户群 , 不同用 户群的共同特征 , 页 面 的访 问情况 , 广告 的点击情况等。 能更 进 一 步 了 解客 户 。

引用的 网状结构。www 能够提供除 了文件 内容之外的有用信息 。利用这 些信息可以对页面进行排序 ,以 发现

( b使用挖掘) We

W e a e bp g

c t n mi n on e t nig

S ac s l e rhr ut e

眦 nI g n

C ea a e s  ̄n rl c s .  ̄

pl 日啪 I kn r ig  ̄

Cutmic s o zd

u a e kI sg n ig 】

_ 一

,e 的 义 wb 挖掘 定

问时 间等 , 有 助 于 发 现 客 户 、 用 户 和 这 市 场 等 。例 如 , 名 www . ny a y. 域 o l ld c r 被 分 析 后 可 以知 道 客 户 属 于 女 性 。 o n

Web使用挖掘技术的研究的开题报告

Web使用挖掘技术的研究的开题报告一、选题背景近年来,随着互联网用户数量的迅速增长,网络上产生的数据量也以爆炸式增长的趋势呈现。

这些数据信息包含了大量有价值的信息,但如何从这些数据中挖掘出有用的信息并加以利用,已成为各行各业致力于解决的难题。

因此,本研究选题为“Web使用挖掘技术的研究”,旨在探究如何运用挖掘技术,从Web上获取有用的信息数据。

二、选题意义随着大数据技术的不断发展,Web挖掘技术的应用越来越广泛。

Web挖掘技术可以帮助企业、政府等机构进行市场分析、用户行为分析、竞争对手分析、网络安全等方面的工作,有很大的实际意义。

从大量的网络数据中获取有价值的信息,可以帮助企业更好地做出决策,提高经济效益。

同时,Web挖掘技术也可以帮助机关部门监测网络安全,预防和打击网络犯罪,为社会治理提供更多数据和手段。

三、研究内容本研究内容主要包括以下几个方面:1. Web挖掘技术的概念和原理:介绍Web挖掘技术的基础知识,包括数据挖掘、文本挖掘、Web挖掘等内容。

2. Web挖掘技术的应用:以市场分析、用户行为分析、竞争对手分析、网络安全等应用场景为例,介绍Web挖掘技术在实际工作中的应用方法。

3. 数据预处理:对从Web上获取的大量数据进行预处理,包括数据清洗、数据消重、数据标准化等,保证数据的有效性和准确性。

4. 数据挖掘:应用各种数据挖掘算法和技术,从Web数据中挖掘出有价值的信息,如特征分析、聚类分析、关联规则挖掘等。

5. 结果分析和应用:通过分析挖掘结果,提取有用信息并加以利用,如优化市场营销策略、提高网络安全等,为实际工作提供支持。

四、研究方法本研究采用实证研究方法,将Web挖掘技术应用于具体的应用场景,并通过数据实验和数据分析,得出科学结论。

具体研究方法包括:数据收集、数据预处理、数据挖掘、结果分析等。

五、预期目标通过运用Web挖掘技术,获取大量有用数据,得出科学结论,提高企业和政府的科学决策水平,为社会发展做出贡献。

浅析Web挖掘技术

浅析Web挖掘技术

白颖妹

【期刊名称】《科技信息》

【年(卷),期】2009(000)18X

【摘要】本文从Web数据挖掘的概念入手,介绍了Web挖掘的一般流程,重点阐述了Web挖掘任务的三种分类:Web内容挖掘、Web结构挖掘和Web使用挖掘,并给出实现这三类挖掘的常用技术和方法。

【总页数】0页(P182,185)

【作者】白颖妹

【作者单位】西安欧亚学院信息工程学院

【正文语种】中文

【中图分类】TP311.13

【相关文献】

1.浅析基于Web的数据挖掘技术 [J], 张嘉丰

2.浅析Web数据挖掘技术在无线电通信系统中的应用 [J], 王明新

3.浅析Web数据挖掘技术及数学思维方法对社会经济发展影响的研究 [J], 周檬

4.浅析Web内容挖掘技术 [J], 崔敏

5.浅析基于Web的数据挖掘技术 [J], 张嘉丰

因版权原因,仅展示原文概要,查看原文内容请购买。

Web挖掘

WEB挖掘-能挖到什么

·获取竞争对手和客户信息。Web不仅由页面组成,而

且还包含了从一个页面指向另一个页面的超链接。一 个Web页面的作者建立指向另一个页面的指针,就可 以看作是作者对另一页面的认可。把另一页面的来自 不同作者的注解收集起来,就可以用来反映该页面的 重要性,并可以很自然地用于权威页面的发现。另外 一种重要的Web页面是一个或多个Web页面,它提供 了指向权威页面的链接集合,称为Hub。Hub页面本 身可能并不突出,或者说可能没有几个链接指向它们, 但是 Hub页面却提供了指向就某个话题而言最为突出 的站点的链接。通过分析这类信息,企业可以获得零 售商、中间商、合作商以及竞争对手的信息。

●站点修改:站点的结构和内容是吸引用户的关键。Web 用法挖掘通过挖掘用户的行 为记录和反馈情况为站点设计者提供改进的依,比如页面连接情况应如何组织、那些页 面应能够直接访问等。 ●智能商务:用户怎样使用Web站点的信息无疑是电子商务销售商关心的重点,用户一 次访问的周期可分为被吸引、驻留、购买和离开四个步骤,Web用法挖掘可以通过分析 用户点击流等Web日志信息挖掘用户行为的动机,以帮助销售商合理安排销售策略。 ●Web特征描述:这类研究跟关注这样通过用户对站点的访问情况统计各个用户在页面 上的交互情况,对用户访问情况进行特征描述。

· 反竞争情报活动。反竞争情报是企业竞争情报活动的

重要组成部分。忽视竞争对手的竞争情报活动、低估 竞争对手搜集竞争情报的能力势必导致企业失去已有 的竞争优势。Web站点是企业与外界进行交流的窗口, 同时也是竞争对手获取竞争情报的一个重要信息源。 在竞争情报计算机系统中,可以充分利用Web挖掘技 术,通过运用分析访问者的IP地址、客户端所属域、 信息访问路径,统计敏感信息访问率等方法识别竞争 对手,保护企业敏感性信息。

远程教育中Web挖掘技术的研究

远程教育中Web挖掘技术的研究其主要思想在于通过信息系统来表示知识,通过信息系统实行知识简约,导出问题决策和分类规则,归纳后能够从知识库中抽取更有价值的隐含知识和潜在规律。

所以,粗糙集方法其实质就是在大量信息系统中实行信息系统属性约简,得到一种属性约简集的过程,最终得到抽取的规则和方法。

(2)遗传算法它的基本思想是模拟生物生存进化过程中最优解的算法,其借鉴的生物学基础就是遗传和进化。

通过遗传算法我们能够在数据库中实行搜索,并对其中随机产生的规则实行优化。

遗传算法优点有以下两点:①在适合值函数有噪声下,遗传算法能够以极大的概率找到整体最优解而不容易陷入局部最优;②大规模并行计算机很适用于遗传算法。

(3)决策树算法其主要方法是先对数据实行处理,然后用归纳算法产生可读的规则和决策树,最后对新数据实行决策分析。

决策树算法有以下几个特点:①决策树算法描述结构较简单,容易为人所理解;②效率高,适用于大规模数据的处理;③拥有较高的分辨进度。

二、Web数据挖掘技术在远程教育中的应用(1)远程教育介绍远程教育作为一种重要的教育方法,被广泛的用在高等教育,职业教育和成人教育中。

在现代远程教育中,学习者是通过点击鼠标和浏览网页来完成他们的学习过程,因而他们的学习习惯能够完全被系统日志记录。

我们只需要分析和挖掘系统日志,就能够很好的对学习者的学习习惯实行分析,同时也能够了解到远程教育系统是否能很好的服务于学习者。

(2)Web数据挖掘Web数据挖掘是数据挖掘技术与计算机网络技术的融合,网站上有三种类型数据,分别是:内容数据,结构数据以及使用数据。

Web数据挖掘一般包括数据获得,数据预处理,模式发现,模式分析四部分。

①数据获得:按照数据挖掘的目的获取不同学习者的数据。

Web内容挖掘收集的信息来自于我们的网站资源。

Web结构挖掘收集的数据来自于HTML内部痕迹和网页之间的超链接。

Web使用数据从客户端收集,数据包括IP地址,URL等。

浅谈Web挖掘技术在教育网站中的应用

浅谈Web挖掘技术在教育网站中的应用作者:江勤来源:《新课程·教研版》2010年第16期摘要:本文介绍了数据挖掘的新技术。

通过对基于Web挖掘技术的教育网站的模型介绍,对在Web服务器端和客户端进行学生浏览路径模式采集的各种方法进行了分析,探讨了如何将Web使用挖掘技术应用到教育网站。

关键词:数据挖掘浏览路径采集教育网站Web使用挖掘是将数据挖掘技术应用在大型Web资源中以分析Web站点的使用。

通过Web使用挖掘,对用户的访问内容、停留时间和频度等进行分析,可以得到关于用户访问行为和方式的普遍知识,用以改进Web站点服务设计。

更重要的是,通过对这些用户特征的理解和分析,可以开展有针对性的个性化教育网站的建设。

不同类型的教育网站针对的用户主次不同。

虽然有的网站内容主要针对的是老师,有的主要针对的是学生,还有的针对其他教育人士等,但在笔者看来,所有访问教育网站的用户,我们都可以称作学生。

通过对学生访问行为、频度、内容等的分析,给出每个学生的特征,进而给每个学生个性化的界面,提供个性化的服务。

目前,我们可以将一些新的数据挖掘技术应用到教育网站中。

其中文本挖掘、网络挖掘和可视化挖掘就是其中比较重要的三种。

文本挖掘(Text mining),顾名思义,就是从非结构化的文本中发现潜在的概念以及概念间的相互关系。

在这项技术中,最关键的是分词技术,建立词典。

只有让计算机依据词典完成正确断词之后,才可以实现将非结构化信息转化为结构化信息,然后就可以进一步研究文本之间的关系。

比如通过分析网站中的内容来建立教育信息预处理机制,其实既利用了文本挖掘技术,也利用了网络挖掘技术。

具体来讲,网络挖掘还可以细分为三种挖掘,(1)前面提到的文本挖掘;(2)结构挖掘(Structure mining),主要解决网页与网页之间的链接关系;(3)点击挖掘(Hit mining),是针对点击率的挖掘分析。

总体而言,要实现网络挖掘,从技术上讲并没有难度,大部分的问题都可以用成熟方法来解决。

浅谈Web使用模式挖掘在优化网站设计中的应用

浅谈Web使用模式挖掘在优化网站设计中的应用法金勇【期刊名称】《计算机光盘软件与应用》【年(卷),期】2011(000)017【摘要】With the network technology and the rapid development of computer technology, networks have become an important platform for people to obtain information.From the customer's point of view, if the file workers can track and analyze user browsing behavior on the site file,it helps to build intelligent web site and thus to optimize the site structure,and thus targeted to carry out network files of intelligence services.%随着网络技术和计算机技术的迅猛发展,网络已经成为人们获取信息的重要平台。

从客户的角度来看。

如果档案的工作者能跟踪并分析用户在档案网站上的浏览行为,就有助于建立智能化的web站点并从而来优化站点结构,从而进行有针对性的开展网络档案的智能服务。

【总页数】1页(P12-12)【作者】法金勇【作者单位】云南省易门县职业高级中学,云南玉溪651100【正文语种】中文【中图分类】TP393.092【相关文献】1.Web使用模式挖掘在优化网站设计中的应用 [J], 沈红超;冉文江2.Web使用模式挖掘在个性化远程教育中的应用 [J], 徐嘉莉3.Web使用模式挖掘技术在网站营销中的应用 [J], 王玉珍4.Web使用模式挖掘在商务网站链接结构优化中的应用 [J], 王玉珍5.Web使用模式挖掘在电子商务中的应用 [J], 王玉珍因版权原因,仅展示原文概要,查看原文内容请购买。

Web使用挖掘在网站优化中的应用研究

Web使用挖掘在网站优化中的应用研究[摘要]针对互联网用户访问Web服务器产生的日志,结合Web使用挖掘相关理论,采用Apriori算法挖掘用户的频繁访问模式。

首先进行数据预处理以保证数据的质量及提高挖掘的效率;然后对预处理后的数据采用Apriori算法进行关联规则挖掘,找出其中的频繁访问模式;最后分析结果,总结规则,提出建议。

[关键词]Web使用挖掘;数据预处理;Apriori算法;网站优化doi : 10 . 3969 / j . issn . 1673 - 0194 . 2009 . 21 . 001[中图分类号]F224.6;TP39[文献标识码]A[文章编号]1673 - 0194(2009)21 - 0004 - 031引言Web使用挖掘是应用数据挖掘技术从Web数据中发现用户访问模式的过程[1],从而可以为用户提供个性化服务,改进系统,优化站点。

本文通过对网站服务器日志进行挖掘,找出其中存在的频繁访问模式并提出网站改进意见。

2Web使用挖掘日志预处理方法2.1数据源Web使用挖掘主要的数据源有3种:Web服务器日志(Web server log)、代理服务器日志(Proxy log)和用户浏览网页所留下的Cookie文件。

在这3种数据中,Web服务器日志是最常用也是最直接的数据源,可以直接在Web服务器上生成;对于代理服务器日志文件来说,由于用户分布很广泛,网站用户可能通过大量的代理访问该网站的网页,所以收集使用代理所留下的日志文件比较困难;而对于单个用户来说,由于涉及隐私问题,所以在用户机上收集信息也会存在问题。

鉴于以上考虑,一般的Web使用挖掘大多采用Web服务器日志,所以Web使用挖掘通常也称为Web日志挖掘。

2.2 Web日志预处理过程Web日志预处理是在Web日志挖掘前,对Web日志数据进行清理、过滤以及重新组合的过程,其目的是剔除日志中对挖掘过程无用的属性及数据,并将Web日志数据转换为挖掘算法可识别的形式。

Web使用挖掘在网络学习中的应用研究

Web使用挖掘在网络学习中的应用研究汪志云【期刊名称】《广东技术师范学院学报(社会科学版)》【年(卷),期】2011(032)006【摘要】In discussing the application of usage mining in web learning, an improved vector's based cluster- ing algorithm is presented. First, according to the web site's structure a URL-UserID relevant matrix is set up, in which URL is used as row and UserID as c%在讨论Web使用挖掘在网络学习中的应用过程中,提出一种改进的基于向量的聚类算法.在算法中,首先以学习站点的URL为行、以USerID为列建立页面用户关联矩阵,元素值为学习者的访问次数,然后使用欧氏距离进行度量向量之间的相似性,对列向量进行相似性分析得到相似学习者群体,对行向量进行相似性度量获得相关Web页面.分析表明。

Web使用挖掘在网络学习中的应用是可行、有效的.【总页数】4页(P31-33,66)【作者】汪志云【作者单位】广东技术师范学院,广东广州510665【正文语种】中文【中图分类】G434【相关文献】1.Web使用挖掘在B2C网站中的应用研究 [J], 雷兵2.Web使用挖掘及其在电子商务中的应用研究 [J], 李海威;李小福;樊安之3.Web使用挖掘在网站优化中的应用研究 [J], 武森;吴庆海4.WEB使用挖掘在电子商务网站建设中的应用研究 [J], 魏妮妮;宋翌5.Web使用挖掘在网络学习中的应用研究 [J], 汪志云因版权原因,仅展示原文概要,查看原文内容请购买。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

浅Web使用挖掘谢运洁(武汉大学信息管理学院,重庆教育学院图书馆重庆 400067)摘要:系统介绍了Web使用挖掘的相关概念、基本流程以及各种方法在Web使用挖掘中的应用。

关键词:信息分析数据挖掘 Web使用挖掘正文:0引言随着Internet和网络技术的进一步发展,许多企业机构都拥有了自己的Web站点,向用户提供各种基于Web的信息服务,如电子商务、网上银行、用户反馈、技术支持等等,对他们来讲,如何更好地向用户提供更具有针对性的服务,根据用户的网络行为来推测企业未来的发展策略变得十分重要。

同时,Web网页在以惊人的速度增长,新闻、广告、教育、经济等各种信息充斥在用户面前,加上其更新速度也越来越快,使得用户在信息的海洋中无所适从,如何把信息在恰当的时间、恰当的地点以恰当的方式提供给用户更是我们必须解决的问题。

Web使用挖掘,其任务是挖掘Web用户的行为模式,根据挖掘结果改进站点结构,减少用户在获取所需信息或产品之前的寻找时间,向特定用户主动提供个性化服务。

1基本概念1.1Web数据挖掘Web数据挖掘是指利用数据挖掘技术对Web存取模式、Web结构和规则,以及动态Web内容的查找。

一般地,根据挖掘对象的不同,可以将Web数据挖掘分为三大类:Web内容挖掘(Web Content Mining)、Web结构挖掘(Web Structure Mining)和Web使用挖掘(Web Usage Mining),另外web结构挖掘可以被认为是Web内容挖掘的一部分,这样可以简单的把Web挖掘分为Web 内容挖掘和Web使用挖掘。

1.2Web使用挖掘Web使用挖掘是指利用数据挖掘技术对Web服务器中的日志记录进行分析,发现各种用户使用模式的过程,其目的在于更好的为用户提供各种服务。

Web使用挖掘可以挖掘出用户的隐藏信息,根据用户行为趋势确定企业未来的战略方向。

Web使用挖掘的基本流程主要包括数据准备、数据预处理、模式发现和模式分析几个步骤。

2数据准备Web使用挖掘的数据来源大致可分为三大块:服务器端(Server Log File)、中介代理端(Intermediary Data)以及客户端(Client Side Data)。

2.1服务器端数据2.1.1服务器日志文件(Server Log File)Web服务器日志文件是一个存储用户基本信息、描述用户浏览行为信息的文件。

特别是,它可以存储用户浏览网页时沿着网页链接所产生的点击流序列信息,是Web使用挖掘的主要数据来源。

Web服务器日志通常以两种格式存储文件:普通日志文件格式(Common Log File Format),它可以存储用户IP、用户名、请求文件名、文件大小及服务器名等最基本的信息;扩展日志格式(Extended Log Format),存储了一些额外的信息,比如主机地址、请求日期和时间、用户名、传输字节数、事务完成时间等。

Web使用挖掘把Web服务器日志作为主要的数据来源,但是由于Web高速缓存等的使用,Web服务器日志文件也有不尽人意的地方。

如,Web高速缓存是为了降低数据传输延迟而使用的工具,当用户提出请求时,缓存中会存储一份请求副本,若用户再次提出相同的请求,缓存会直接使用此副本而不会向服务器提出新的请求,这样,服务器日志文件中就不会存储这一请求的相关信息。

2.1.2Cookie除了使用Web服务器日志文件外,在Web使用挖掘中,Cookie也是重要的数据来源。

Cookie 是存储在用户计算机中包含会话信息的一个很小的数据文件。

它记录了用户会话信息,如用户ID、密码、浏览过的网页、停留时间等信息,都是Web使用挖掘所需的重要数据,特别是对后面的会话识别具有非常重要的作用。

但同样,Cookie也存在一些不够完美的地方,比如:多用户共用一台计算机时生成的信息会存储于同一个Cookie中,除非是多用户操作系统;单用户使用多台计算机时服务器也会认为是不同用户;另外用户出于隐私的考虑,有可能关闭了Cookie功能。

2.1.3用户注册信息多数Web网站需要用户注册,通过用户注册信息可以获得最直接、清楚的信息,如年龄、职业、收入等。

但如果站点是一般性网站,用户通常不会如实填写。

只有像网上银行这样对用户注册信息经过严格审核的网站,可以获得详细的用户信息,其真实度也较高。

但这也涉及用户隐私必须获得用户的同意,不是理想的渠道。

2.2中介代理服务器数据(Intermediary Data)2.2.1.代理服务器(Proxy Server)代理服务器是介于用户浏览器和Web服务器之间的一台服务器,当用户通过代理服务器上网时,浏览器不是直接向Web服务器提出请求,而是先向代理服务器发出请求,代理服务器在缓存中查找是否具有用户需要的信息(用户最近使用过),如果有就直接返回给用户,否则代理服务器代替用户向Web服务器发出请求,Web服务器再返回给代理服务器,代理服务器保存一份副本再传给用户。

类似于服务器日志,代理服务器也使用日志来记录用户的请求信息,因此代理服务器日志也是Web使用挖掘数据的重要来源,但是,还是存在像Web服务器一样的问题,即高速缓存的使用。

2.2.2嗅探器(Sniffer)Sniffer是一种利用以太网的特性把网络适配器置为杂乱模式状态的工具,一旦网卡设为这种模式,它就能接受传输在网络上的信息包,Sniffer分为软件和硬件两种。

使用Sniffer 的好处是可以获得即时信息;其次,重要的是所获得的信息不是存在LOG文件中的,便于整理;这些信息中包含详细的用户请求时间、服务器反应时间、用户名甚至用户口令等。

但其缺点是不能肯定收集到所有用户访问信息,最严重的是Sniffer通常是黑客使用的工具,对用户是种严重的隐私侵犯。

2.3客户端数据(Client Side Data)从客户端获取的数据较从服务器端获取的信息准确,因为不存在上文提到的缓存问题。

一个最常见的收集客户端数据的技术是利用远程代理(Remote Agent),通过Java或Javascript嵌入Web浏览器实现。

但收集客户端数据仍然有缺陷,例如隐私问题,需征得用户的同意。

3数据预处理这阶段主要完成对数据的清洗、过滤掉多余不相关的数据,和转换等过程,从中抽取出挖掘目标所需的会话和事务。

3.1数据过滤(Data Filtering)这一步的主要任务是对在数据准备阶段获得的数据进行过滤,剔除不相关和冗余的数据,特别是对从Web服务器和代理服务器中获得的数据进行过滤,因为它们记录了用户的所有行为包括一些与挖掘需求无关的行为;对用户注册信息进行确认、纠正和规范化等。

3.2.用户识别(User Identification)用户识别就是正确解决上文中提到的多用户共用一台计算机、单用户使用多台计算机等问题。

通常,单独一个IP地址是不能作为用户识别的标准的,因为一个IP地址有可能有多个用户在使用,而反之,同一用户也有可能有多个IP地址。

由于本地缓存和代理服务器的使用,使得有效识别和跟踪用户浏览行为非常复杂。

另外,如果可以使用Cookie,则可以更好的区分用户,但用户可能会出于隐私等原因而禁止了Cookie功能,所幸的是,据调查,90%以上用户的Cookie都可用。

3.3.会话识别(Session Identification )会话是一组由一个用户在一个时间段中向一个Web服务器请求的连续性的网页浏览集。

在Web使用挖掘中用户会话识别也是一个不可忽视的重要步骤,因为会话文件中包含用户的浏览行为信息,对于后面的模式发现有重要作用。

会话识别是基于这样一个前提:如果一个会话超过预定的时间戳,则这个时间点就是第二个会话的开始点。

由于浏览器自己的缓存机制和代理服务器的使用也会造成会话信息在日志中的缺省。

各种各样启发性的方法已用于用户会话识别。

Spiliopoulou于1999年将这些方法分为两类:基于时间和基于内容的方法。

基于时间的方法是使用一个时间上限值来标识用户浏览一个网页的会话或是一个连续性的会话,这个时间上限值通常为25.5-30min;基于内容的方法是根据网页的相关性将一个用户连续浏览的网页分成若干组,每一组即为一个会话。

3.4.事务识别(Transaction Identification)事务识别是指把用户在同一会话中浏览的网页划分为代表Web事务的逻辑单元。

用户在会话中所浏览的网页可以分为辅助页(AuxiliaryPage)和内容页(ContentPage)。

辅助页用于导航,即用户获得目标信息之前为了查找而点击的网页;而内容页就是向用户提供目标信息的页。

通过区分辅助页和内容页,可以获知网页对用户的重要性程度。

在生成事务文件时通常可生成两类事务文件:辅助-内容事务文件(Auxiliary-Content Transaction),从起始页到第一个内容页出现之间的浏览序列;内容事务文件(Content-Only Transaction),只包含内容页。

事务识别的方法主要有参考长度法(Reference Length)、最大向前参考法(Maximal Forward Reference)和时间窗口法(Time Window)。

参考长度法是根据判断用户花在一个网页上的时间来确定把它分为辅助页里还是内容页。

最大向前参考法是将一个事务确定为一个用户在一个会话中从起始页直到用户执行第一个后退键为止,它以用户的后退行为作为一个事务的终始点。

时间窗口法是根据用户在网页上停留的时间来直接划分事务,它不能区分出辅助页和内容页。

会话识别和事务识别在web使用挖掘中非常重要,直接影响后面的模式发现结果。

4.模式发现(Pattern Discovery)在这一阶段,在数据预处理的基础上,根据挖掘需求选择相应的模式发现方法。

常见的用于模式发现的方法有:聚类分析、分类、关联规则分析和时间序列分析四种。

分类是最早用于Web使用挖掘的方法。

但分类属于有指导学习,有指导学习需为数据做标识,而Web挖掘的对象是海量数据,对其进行标识并不现实,因此促使了无指导学习方法的产生,特别是聚类分析法。

4.1聚类分析法聚类分析的目的是要将数据集分成若干个类或簇,使得类中的对象之间具有高度相似性,而类间具有高度相异性。

为了降低误差,根据使用的相似性计算方法的不同,可将聚类分析法分为两类:一是对样品进行分类,称为Q型聚类分析,所用的统计量常用“距离”这一数据描述;二是对变量进行分类,称为R型聚类分析,所用的统计量常用“相似系数”这一术语描述。

在Web使用挖掘中,其目的是对会话和事务进行聚类,而每个会话和事务由多个属性构成,属于Q型聚类分析,这时其相似性要用“距离”来表示,但有的时候需要对属性或变量进行聚类时属于R型聚类分析,其相似性计算应该用“相似系数”。