用Apache Spark进行大数据处理——第一部分:入门介绍

Spark大数据分析与实战:RDD编程初级实践Spark大数据分析与实战:RDD编程初级实践

Spark⼤数据分析与实战:RDD编程初级实践Spark⼤数据分析与实战:RDD编程初级实践Spark⼤数据分析与实战:RDD编程初级实践⼀、安装Hadoop和Spark具体的安装过程在我以前的博客⾥⾯有,⼤家可以通过以下链接进⼊操作:** 提⽰:如果IDEA未构建Spark项⽬,可以转接到以下的博客: **⼆、启动Hadoop与Spark查看3个节点的进程master slave1 slave2Spark shell命令界⾯与端⼝页⾯三、spark-shell交互式编程请到教程官⽹的“下载专区”的“数据集”中下载chapter5-data1.txt,该数据集包含了某⼤学计算机系的成绩,数据格式如下所⽰: Tom,DataBase,80 Tom,Algorithm,50 Tom,DataStructure,60 Jim,DataBase,90 Jim,Algorithm,60 Jim,DataStructure,80 …… 请根据给定的实验数据,在spark-shell中通过编程来计算以下内容:** 如果找不到数据可以从这下载:数据集链接:提取码:z49l **(1)该系总共有多少学⽣;shell命令:val lines = sc.textFile("file:///opt/software/Data01.txt")lines.map(row=>row.split(",")(0)).distinct().count运⾏截图:(2)该系共开设来多少门课程;shell命令:lines.map(row=>row.split(",")(1)).distinct().count运⾏截图:(3)Tom同学的总成绩平均分是多少;shell命令:lines.filter(row=>row.split(",")(0)=="Tom").map(row=>(row.split(",")(0),row.split(",")(2).toInt)) .mapValues(x=>(x,1)).reduceByKey((x,y) => (x._1+y._1,x._2 + y._2)).mapValues(x => (x._1 / x._2)).collect()运⾏截图:(4)求每名同学的选修的课程门数;shell命令:lines.map(row=>(row.split(",")(0),1)).reduceByKey((x,y)=>x+y).collect运⾏截图:(5)该系DataBase课程共有多少⼈选修;shell命令:lines.filter(row=>row.split(",")(1)=="DataBase").count运⾏截图:(6)各门课程的平均分是多少;shell命令:lines.map(row=>(row.split(",")(1),row.split(",")(2).toInt)).mapValues(x=>(x,1)).reduceByKey((x,y) => (x._1+y._1,x._2 + y._2)).mapValues(x => (x._1 / x._2)).collect()运⾏截图:(7)使⽤累加器计算共有多少⼈选了DataBase这门课。

基于Spark的大数据分析与处理平台设计与实现

基于Spark的大数据分析与处理平台设计与实现一、引言随着互联网和物联网技术的快速发展,大数据已经成为当今社会中不可或缺的一部分。

大数据分析和处理已经成为各行各业的重要工具,帮助企业更好地理解市场趋势、优化运营效率、提升用户体验等。

在大数据处理领域,Apache Spark作为一种快速、通用、可扩展的大数据处理引擎,受到了广泛关注和应用。

二、Spark简介Apache Spark是一种基于内存计算的大数据并行计算框架,提供了丰富的API支持,包括Scala、Java、Python和R等语言。

Spark具有高容错性、高性能和易用性等特点,适用于各种大数据处理场景,如批处理、交互式查询、流式计算和机器学习等。

三、大数据分析与处理平台设计1. 架构设计在设计基于Spark的大数据分析与处理平台时,首先需要考虑整体架构设计。

典型的架构包括数据采集层、数据存储层、数据处理层和数据展示层。

其中,Spark通常被用于数据处理层,负责对海量数据进行分布式计算和分析。

2. 数据采集与清洗在构建大数据平台时,数据采集和清洗是至关重要的环节。

通过各种方式采集结构化和非结构化数据,并对数据进行清洗和预处理,以确保数据质量和准确性。

3. 数据存储与管理针对不同的业务需求,可以选择合适的数据存储方案,如HDFS、HBase、Cassandra等。

同时,需要考虑数据的备份、恢复和安全性等问题。

4. 数据处理与分析Spark提供了丰富的API和库,如Spark SQL、Spark Streaming、MLlib等,可以支持各种复杂的数据处理和分析任务。

通过编写Spark应用程序,可以实现对海量数据的实时处理和分析。

5. 数据展示与可视化为了更直观地展示分析结果,可以利用可视化工具如Tableau、Power BI等,将分析结果以图表或报表的形式展示给用户,帮助他们更好地理解数据。

四、平台实现步骤1. 环境搭建在搭建基于Spark的大数据平台之前,需要准备好相应的硬件设施和软件环境,包括服务器集群、操作系统、JDK、Hadoop等。

大数据处理平台Spark的安装和配置方法

大数据处理平台Spark的安装和配置方法大数据处理平台Spark是一种快速且可扩展的数据处理框架,具有分布式计算、高速数据处理和灵活性等优势。

为了使用Spark进行大规模数据处理和分析,我们首先需要正确安装和配置Spark。

本文将介绍Spark的安装和配置方法。

一、环境准备在开始安装Spark之前,需要确保我们的系统符合以下要求:1. Java环境:Spark是基于Java开发的,因此需要先安装Java环境。

建议使用Java 8版本。

2. 内存要求:Spark需要一定的内存资源来运行,具体要求取决于你的数据规模和运行需求。

一般情况下,建议至少有8GB的内存。

二、下载Spark1. 打开Spark官方网站(不提供链接,请自行搜索)并选择合适的Spark版本下载。

通常情况下,你应该选择最新的稳定版。

2. 下载完成后,将Spark解压到指定的目录。

三、配置Spark1. 打开Spark的安装目录,找到conf文件夹,在该文件夹中有一份名为spark-defaults.conf.template的示例配置文件。

我们需要将其复制并重命名为spark-defaults.conf,然后修改该文件以配置Spark。

2. 打开spark-defaults.conf文件,你会看到一些示例配置项。

按照需求修改或添加以下配置项:- spark.master:指定Spark的主节点地址,如local表示使用本地模式,提交到集群时需修改为集群地址。

- spark.executor.memory:指定每个Spark执行器的内存大小,默认为1g。

- spark.driver.memory:指定Spark驱动程序的内存大小,默认为1g。

3. 如果需要配置其他参数,可以参考Spark官方文档中的配置指南(不提供链接,请自行搜索)。

4. 保存并退出spark-defaults.conf文件。

四、启动Spark1. 打开命令行终端,进入Spark的安装目录。

利用Spark进行实时大数据处理的最佳实践

利用Spark进行实时大数据处理的最佳实践在当今数字化时代,大数据处理已成为企业不可或缺的一环。

为了满足日益增长的数据处理需求,传统的批处理方式已无法满足实时性和性能的要求。

而Apache Spark作为一个快速、通用、容错且易用的大数据处理引擎,成为了处理实时大数据的最佳实践之一。

Spark提供了丰富的API和内置的组件,可以在实时大数据处理过程中实现高效的数据处理和分析。

以下是利用Spark进行实时大数据处理的最佳实践。

1. 选择合适的集群模式:Spark可以在多种集群模式下运行,包括单机模式、本地模式、独立模式和云模式。

根据数据量和需求,选择合适的集群模式可以提高实时大数据处理的效率和性能。

2. 使用Spark Streaming处理流式数据:Spark Streaming是Spark的一部分,支持从各种数据源(如Kafka、Flume和HDFS)实时接收数据并进行处理。

使用Spark Streaming可以实时处理数据流,并支持窗口和滑动窗口操作,以满足不同的实时数据分析需求。

3. 使用Spark SQL进行结构化数据处理:Spark SQL是Spark的SQL查询引擎,可以通过SQL语句处理结构化数据。

通过使用Spark SQL,可以方便地进行实时查询、过滤和转换操作,以满足实时大数据处理的需求。

4. 使用Spark MLlib进行机器学习:Spark MLlib是Spark的机器学习库,提供了各种机器学习算法和工具,可以在实时大数据处理中应用机器学习。

通过使用Spark MLlib,可以进行实时的数据挖掘和模型训练,帮助企业发现隐藏在大数据中的信息和模式。

5. 使用Spark GraphX进行图处理:Spark GraphX是Spark的图处理库,用于处理大规模的图数据。

通过使用Spark GraphX,可以进行实时的图分析和图计算,帮助企业发现图数据中的关联和模式。

6. 使用Spark Streaming和Spark SQL进行流与批处理的无缝集成:Spark提供了将流处理和批处理无缝集成的能力,可以在同一个应用程序中同时处理实时数据流和批处理数据。

spark读取和处理zip、gzip、excel、等各种文件最全的技巧总结

spark读取和处理zip、gzip、excel、等各种⽂件最全的技巧总结⼀、当后缀名为zip、gzip,spark可以⾃动处理和读取1、spark⾮常智能,如果⼀批压缩的zip和gzip⽂件,并且⾥⾯为⼀堆text⽂件时,可以⽤如下⽅式读取或者获取读取后的schemaspark.read.text("xxxxxxxx/xxxx.zip")spark.read.text("xxxxxxxx/xxxx.zip").schemaspark.read.text("xxxxxxxx/xxxx.gz")spark.read.text("xxxxxxxx/xxxx.gz").schema2、当压缩的⼀批text⽂件⾥⾯的内容为json时,还可以通过read.json读取,并且⾃动解析为json数据返回spark.read.json("xxxxxxxx/xxxx.zip")spark.read.json("xxxxxxxx/xxxx.zip").schemaspark.read.json("xxxxxxxx/xxxx.gz")spark.read.json("xxxxxxxx/xxxx.gz").schemaspark.read.text("xxxxxxxx/*.zip")spark.read.text("xxxxxxxx/*")spark读取⽂件内容时是按⾏处理的,如果需要将⽂件⾥⾯多⾏处理为⼀⾏数据,可以通过设置multiLine=true(默认为false)spark.read.option("multiLine","true").json("xxxxxxxx/xxxx.zip")3、当zip或者gzip的⽂件没有任何后缀名或者后缀名不对时,那spark就⽆法⾃动读取了,但是此时可以通过类似如下的⽅式来读取spark.read.format("binaryFile").load("dbfs:/xxx/data/xxxx/xxxx/2021/07/01/*")读取到后,⾃⼰在代码中来解析处理读取的⼆进制⽂件数据spark.read.format("binaryFile").load("dbfs:/xxx/data/xxxx/xxxx/2021/07/01/*").foreach(data=>{// data解析})sep:default `,`encoding:default `UTF-8` decodes the CSV files by the given encoding typequote:default `"` sets a single character used for escaping quoted values where the separator can be part of the value. If you would like to turn off quotations, you need to set not `null` but an empty string. This behaviour is different from com.databricks.spark.csvescape:default `\` sets a single character used for escaping quotes inside an already quoted value.charToEscapeQuoteEscaping:default `escape` or `\0`comment:default empty stringheader:default `false`enforceSchema:default `true`inferSchema:(default `false`)samplingRatio:default is 1.0ignoreLeadingWhiteSpace:default `false`ignoreTrailingWhiteSpace:default `false`nullValue:default empty stringemptyValue:default empty stringnanValue:default `NaN`positiveInf:default `Inf`negativeInf:default `-Inf`dateFormat:default `yyyy-MM-dd`timestampFormat:default `yyyy-MM-dd'T'HH:mm:ss[.SSS][XXX]`maxColumns:default `20480`maxCharsPerColumn:default `-1`unescapedQuoteHandling:default `STOP_AT_DELIMITER`mode:default `PERMISSIVE`columnNameOfCorruptRecord:default is the value specified in `spark.sql.columnNameOfCorruptRecord`multiLine:default `false`locale:default is `en-US`lineSep:default covers all `\r`, `\r\n` and `\n`pathGlobFilter:an optional glob pattern to only include files with paths matching the pattern. The syntax follows <code>org.apache.hadoop.fs.GlobFilter</code>. It does not change the behavior of partition discovery.modifiedBefore(batch only): an optional timestamp to only include files with modification times occurring before the specified Time. The provided timestamp must be in the following form: YYYY-MM-DDTHH:mm:ss (e.g. 2020-06-01T13:00:00)modifiedAfter(batch only):an optional timestamp to only include files with modification times occurring after the specified Time. The provided timestamp must be in the following form: YYYY-MM-DDTHH:mm:ss (e.g. 2020-06-01T13:00:00)recursiveFileLookup: recursively scan a directory for files. Using this option disables partition discoverySkip to contentSearch or jump to…Pull requestsIssuesMarketplaceExplore@597365581apache/sparkPublic2.1k31.2k24.7kCodePull requests219ActionsProjectsSecurityInsightsspark/sql/core/src/main/scala/org/apache/spark/sql/DataFrameReader.scala@HyukjinKwonHyukjinKwon [SPARK-35250][SQL][DOCS] Fix duplicated STOP_AT_DELIMITER to SKIP_VAL……Latest commit 89f5ec7 on May 4History72 contributors@HyukjinKwon@cloud-fan@MaxGekk@rxin@srowen@liancheng@maropu@gatorsmile@viirya@gengliangwang@dongjoon-hyun@yaooqinn 1003 lines (944 sloc) 46.7 KB/** Licensed to the Apache Software Foundation (ASF) under one or more* contributor license agreements. See the NOTICE file distributed with* this work for additional information regarding copyright ownership.* The ASF licenses this file to You under the Apache License, Version 2.0* (the "License"); you may not use this file except in compliance with* the License. You may obtain a copy of the License at** /licenses/LICENSE-2.0** Unless required by applicable law or agreed to in writing, software* distributed under the License is distributed on an "AS IS" BASIS,* WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied.* See the License for the specific language governing permissions and* limitations under the License.*/package org.apache.spark.sqlimport java.util.{Locale, Properties}import scala.collection.JavaConverters._import com.fasterxml.jackson.databind.ObjectMapperimport org.apache.spark.Partitionimport org.apache.spark.annotation.Stableimport org.apache.spark.api.java.JavaRDDimport org.apache.spark.internal.Loggingimport org.apache.spark.rdd.RDDimport org.apache.spark.sql.catalyst.analysis.UnresolvedRelationimport org.apache.spark.sql.catalyst.csv.{CSVHeaderChecker, CSVOptions, UnivocityParser}import org.apache.spark.sql.catalyst.expressions.ExprUtilsimport org.apache.spark.sql.catalyst.json.{CreateJacksonParser, JacksonParser, JSONOptions}import org.apache.spark.sql.catalyst.util.{CaseInsensitiveMap, CharVarcharUtils, FailureSafeParser}import org.apache.spark.sql.connector.catalog.{CatalogV2Util, SupportsCatalogOptions, SupportsRead}import org.apache.spark.sql.connector.catalog.TableCapability._import mand.DDLUtilsimport org.apache.spark.sql.execution.datasources.DataSourceimport org.apache.spark.sql.execution.datasources.csv._import org.apache.spark.sql.execution.datasources.jdbc._import org.apache.spark.sql.execution.datasources.json.TextInputJsonDataSourceimport org.apache.spark.sql.execution.datasources.v2.{DataSourceV2Relation, DataSourceV2Utils}import org.apache.spark.sql.internal.SQLConfimport org.apache.spark.sql.types.StructTypeimport org.apache.spark.sql.util.CaseInsensitiveStringMapimport org.apache.spark.unsafe.types.UTF8String/*** Interface used to load a [[Dataset]] from external storage systems (e.g. file systems,* key-value stores, etc). Use `SparkSession.read` to access this.** @since 1.4.0*/@Stableclass DataFrameReader private[sql](sparkSession: SparkSession) extends Logging {/*** Specifies the input data source format.** @since 1.4.0*/def format(source: String): DataFrameReader = {this.source = sourcethis}/*** Specifies the input schema. Some data sources (e.g. JSON) can infer the input schema* automatically from data. By specifying the schema here, the underlying data source can* skip the schema inference step, and thus speed up data loading.** @since 1.4.0*/def schema(schema: StructType): DataFrameReader = {if (schema != null) {val replaced = CharVarcharUtils.failIfHasCharVarchar(schema).asInstanceOf[StructType]erSpecifiedSchema = Option(replaced)}this}/*** Specifies the schema by using the input DDL-formatted string. Some data sources (e.g. JSON) can* infer the input schema automatically from data. By specifying the schema here, the underlying* data source can skip the schema inference step, and thus speed up data loading.** {{{* spark.read.schema("a INT, b STRING, c DOUBLE").csv("test.csv")* }}}** @since 2.3.0*/def schema(schemaString: String): DataFrameReader = {schema(StructType.fromDDL(schemaString))}/*** Adds an input option for the underlying data source.** All options are maintained in a case-insensitive way in terms of key names.* If a new option has the same key case-insensitively, it will override the existing option.** You can set the following option(s):* <ul>* <li>`timeZone` (default session local timezone): sets the string that indicates a time zone ID* to be used to parse timestamps in the JSON/CSV datasources or partition values. The following * formats of `timeZone` are supported:* <ul>* <li> Region-based zone ID: It should have the form 'area/city', such as* 'America/Los_Angeles'.</li>* <li> Zone offset: It should be in the format '(+|-)HH:mm', for example '-08:00'* or '+01:00'. Also 'UTC' and 'Z' are supported as aliases of '+00:00'.</li>* </ul>* Other short names like 'CST' are not recommended to use because they can be ambiguous.* If it isn't set, the current value of the SQL config `spark.sql.session.timeZone` is* used by default.* </li>* </ul>** @since 1.4.0*/def option(key: String, value: String): DataFrameReader = {this.extraOptions = this.extraOptions + (key -> value)this}/*** Adds an input option for the underlying data source.** All options are maintained in a case-insensitive way in terms of key names.* If a new option has the same key case-insensitively, it will override the existing option.** @since 2.0.0*/def option(key: String, value: Boolean): DataFrameReader = option(key, value.toString)/*** Adds an input option for the underlying data source.** All options are maintained in a case-insensitive way in terms of key names.* If a new option has the same key case-insensitively, it will override the existing option.** @since 2.0.0*/def option(key: String, value: Long): DataFrameReader = option(key, value.toString)/*** Adds an input option for the underlying data source.** All options are maintained in a case-insensitive way in terms of key names.* If a new option has the same key case-insensitively, it will override the existing option.** @since 2.0.0*/def option(key: String, value: Double): DataFrameReader = option(key, value.toString)/*** (Scala-specific) Adds input options for the underlying data source.** All options are maintained in a case-insensitive way in terms of key names.* If a new option has the same key case-insensitively, it will override the existing option.** You can set the following option(s):* <ul>* <li>`timeZone` (default session local timezone): sets the string that indicates a time zone ID* to be used to parse timestamps in the JSON/CSV datasources or partition values. The following * formats of `timeZone` are supported:* <ul>* <li> Region-based zone ID: It should have the form 'area/city', such as* 'America/Los_Angeles'.</li>* <li> Zone offset: It should be in the format '(+|-)HH:mm', for example '-08:00'* or '+01:00'. Also 'UTC' and 'Z' are supported as aliases of '+00:00'.</li>* </ul>* Other short names like 'CST' are not recommended to use because they can be ambiguous.* If it isn't set, the current value of the SQL config `spark.sql.session.timeZone` is* used by default.* </li>* </ul>** @since 1.4.0*/def options(options: scala.collection.Map[String, String]): DataFrameReader = {this.extraOptions ++= optionsthis}/*** Adds input options for the underlying data source.** All options are maintained in a case-insensitive way in terms of key names.* If a new option has the same key case-insensitively, it will override the existing option.** You can set the following option(s):* <ul>* <li>`timeZone` (default session local timezone): sets the string that indicates a time zone ID* to be used to parse timestamps in the JSON/CSV datasources or partition values. The following * formats of `timeZone` are supported:* <ul>* <li> Region-based zone ID: It should have the form 'area/city', such as* 'America/Los_Angeles'.</li>* <li> Zone offset: It should be in the format '(+|-)HH:mm', for example '-08:00'* or '+01:00'. Also 'UTC' and 'Z' are supported as aliases of '+00:00'.</li>* </ul>* Other short names like 'CST' are not recommended to use because they can be ambiguous.* If it isn't set, the current value of the SQL config `spark.sql.session.timeZone` is* used by default.* </li>* </ul>** @since 1.4.0*/def options(options: java.util.Map[String, String]): DataFrameReader = {this.options(options.asScala)this}/*** Loads input in as a `DataFrame`, for data sources that don't require a path (e.g. external* key-value stores).** @since 1.4.0*/def load(): DataFrame = {load(Seq.empty: _*) // force invocation of `load(...varargs...)`}/*** Loads input in as a `DataFrame`, for data sources that require a path (e.g. data backed by* a local or distributed file system).** @since 1.4.0*/def load(path: String): DataFrame = {// force invocation of `load(...varargs...)`if (sparkSession.sessionState.conf.legacyPathOptionBehavior) {option("path", path).load(Seq.empty: _*)} else {load(Seq(path): _*)}}/*** Loads input in as a `DataFrame`, for data sources that support multiple paths.* Only works if the source is a HadoopFsRelationProvider.** @since 1.6.0*/@scala.annotation.varargsdef load(paths: String*): DataFrame = {if (source.toLowerCase(Locale.ROOT) == DDLUtils.HIVE_PROVIDER) {throw new AnalysisException("Hive data source can only be used with tables, you can not " +"read files of Hive data source directly.")}val legacyPathOptionBehavior = sparkSession.sessionState.conf.legacyPathOptionBehaviorif (!legacyPathOptionBehavior &&(extraOptions.contains("path") || extraOptions.contains("paths")) && paths.nonEmpty) {throw new AnalysisException("There is a 'path' or 'paths' option set and load() is called " +"with path parameters. Either remove the path option if it's the same as the path " +"parameter, or add it to the load() parameter if you do want to read multiple paths. " +s"To ignore this check, set '${SQLConf.LEGACY_PATH_OPTION_BEHAVIOR.key}' to 'true'.") }DataSource.lookupDataSourceV2(source, sparkSession.sessionState.conf).map { provider =>val catalogManager = sparkSession.sessionState.catalogManagerval sessionOptions = DataSourceV2Utils.extractSessionConfigs(source = provider, conf = sparkSession.sessionState.conf)val optionsWithPath = if (paths.isEmpty) {extraOptions} else if (paths.length == 1) {extraOptions + ("path" -> paths.head)} else {val objectMapper = new ObjectMapper()extraOptions + ("paths" -> objectMapper.writeValueAsString(paths.toArray))}val finalOptions = sessionOptions.filterKeys(!optionsWithPath.contains(_)).toMap ++optionsWithPath.originalMapval dsOptions = new CaseInsensitiveStringMap(finalOptions.asJava)val (table, catalog, ident) = provider match {case _: SupportsCatalogOptions if userSpecifiedSchema.nonEmpty =>throw new IllegalArgumentException(s"$source does not support user specified schema. Please don't specify the schema.")case hasCatalog: SupportsCatalogOptions =>val ident = hasCatalog.extractIdentifier(dsOptions)val catalog = CatalogV2Util.getTableProviderCatalog(hasCatalog,catalogManager,dsOptions)(catalog.loadTable(ident), Some(catalog), Some(ident))case _ =>// TODO: Non-catalog paths for DSV2 are currently not well defined.val tbl = DataSourceV2Utils.getTableFromProvider(provider, dsOptions, userSpecifiedSchema) (tbl, None, None)}import org.apache.spark.sql.execution.datasources.v2.DataSourceV2Implicits._table match {case _: SupportsRead if table.supports(BATCH_READ) =>Dataset.ofRows(sparkSession,DataSourceV2Relation.create(table, catalog, ident, dsOptions))case _ => loadV1Source(paths: _*)}}.getOrElse(loadV1Source(paths: _*))}private def loadV1Source(paths: String*) = {val legacyPathOptionBehavior = sparkSession.sessionState.conf.legacyPathOptionBehaviorval (finalPaths, finalOptions) = if (!legacyPathOptionBehavior && paths.length == 1) {(Nil, extraOptions + ("path" -> paths.head))} else {(paths, extraOptions)}// Code path for data source v1.sparkSession.baseRelationToDataFrame(DataSource.apply(sparkSession,paths = finalPaths,userSpecifiedSchema = userSpecifiedSchema,className = source,options = finalOptions.originalMap).resolveRelation())}/*** Construct a `DataFrame` representing the database table accessible via JDBC URL* url named table and connection properties.** @since 1.4.0*/def jdbc(url: String, table: String, properties: Properties): DataFrame = {assertNoSpecifiedSchema("jdbc")// properties should override settings in extraOptions.this.extraOptions ++= properties.asScala// explicit url and dbtable should override allthis.extraOptions ++= Seq(JDBCOptions.JDBC_URL -> url, JDBCOptions.JDBC_TABLE_NAME -> table) format("jdbc").load()}/*** Construct a `DataFrame` representing the database table accessible via JDBC URL* url named table. Partitions of the table will be retrieved in parallel based on the parameters* passed to this function.** Don't create too many partitions in parallel on a large cluster; otherwise Spark might crash* your external database systems.** @param url JDBC database url of the form `jdbc:subprotocol:subname`.* @param table Name of the table in the external database.* @param columnName the name of a column of numeric, date, or timestamp type* that will be used for partitioning.* @param lowerBound the minimum value of `columnName` used to decide partition stride.* @param upperBound the maximum value of `columnName` used to decide partition stride.* @param numPartitions the number of partitions. This, along with `lowerBound` (inclusive),* `upperBound` (exclusive), form partition strides for generated WHERE* clause expressions used to split the column `columnName` evenly. When* the input is less than 1, the number is set to 1.* @param connectionProperties JDBC database connection arguments, a list of arbitrary string* tag/value. Normally at least a "user" and "password" property* should be included. "fetchsize" can be used to control the* number of rows per fetch and "queryTimeout" can be used to wait* for a Statement object to execute to the given number of seconds.* @since 1.4.0*/def jdbc(url: String,table: String,columnName: String,lowerBound: Long,upperBound: Long,numPartitions: Int,connectionProperties: Properties): DataFrame = {// columnName, lowerBound, upperBound and numPartitions override settings in extraOptions.this.extraOptions ++= Map(JDBCOptions.JDBC_PARTITION_COLUMN -> columnName,JDBCOptions.JDBC_LOWER_BOUND -> lowerBound.toString,JDBCOptions.JDBC_UPPER_BOUND -> upperBound.toString,JDBCOptions.JDBC_NUM_PARTITIONS -> numPartitions.toString)jdbc(url, table, connectionProperties)}/*** Construct a `DataFrame` representing the database table accessible via JDBC URL* url named table using connection properties. The `predicates` parameter gives a list* expressions suitable for inclusion in WHERE clauses; each one defines one partition* of the `DataFrame`.** Don't create too many partitions in parallel on a large cluster; otherwise Spark might crash* your external database systems.** @param url JDBC database url of the form `jdbc:subprotocol:subname`* @param table Name of the table in the external database.* @param predicates Condition in the where clause for each partition.* @param connectionProperties JDBC database connection arguments, a list of arbitrary string* tag/value. Normally at least a "user" and "password" property* should be included. "fetchsize" can be used to control the* number of rows per fetch.* @since 1.4.0*/def jdbc(url: String,table: String,predicates: Array[String],connectionProperties: Properties): DataFrame = {assertNoSpecifiedSchema("jdbc")// connectionProperties should override settings in extraOptions.val params = extraOptions ++ connectionProperties.asScalaval options = new JDBCOptions(url, table, params)val parts: Array[Partition] = predicates.zipWithIndex.map { case (part, i) =>JDBCPartition(part, i) : Partition}val relation = JDBCRelation(parts, options)(sparkSession)sparkSession.baseRelationToDataFrame(relation)}/*** Loads a JSON file and returns the results as a `DataFrame`.** See the documentation on the overloaded `json()` method with varargs for more details.** @since 1.4.0*/def json(path: String): DataFrame = {// This method ensures that calls that explicit need single argument works, see SPARK-16009json(Seq(path): _*)}/*** Loads JSON files and returns the results as a `DataFrame`.** <a href="/">JSON Lines</a> (newline-delimited JSON) is supported by* default. For JSON (one record per file), set the `multiLine` option to true.** This function goes through the input once to determine the input schema. If you know the* schema in advance, use the version that specifies the schema to avoid the extra scan.** You can set the following JSON-specific options to deal with non-standard JSON files:* <ul>* <li>`primitivesAsString` (default `false`): infers all primitive values as a string type</li>* <li>`prefersDecimal` (default `false`): infers all floating-point values as a decimal* type. If the values do not fit in decimal, then it infers them as doubles.</li>* <li>`allowComments` (default `false`): ignores Java/C++ style comment in JSON records</li>* <li>`allowUnquotedFieldNames` (default `false`): allows unquoted JSON field names</li>* <li>`allowSingleQuotes` (default `true`): allows single quotes in addition to double quotes* </li>* <li>`allowNumericLeadingZeros` (default `false`): allows leading zeros in numbers* (e.g. 00012)</li>* <li>`allowBackslashEscapingAnyCharacter` (default `false`): allows accepting quoting of all* character using backslash quoting mechanism</li>* <li>`allowUnquotedControlChars` (default `false`): allows JSON Strings to contain unquoted* control characters (ASCII characters with value less than 32, including tab and line feed* characters) or not.</li>* <li>`mode` (default `PERMISSIVE`): allows a mode for dealing with corrupt records* during parsing.* <ul>* <li>`PERMISSIVE` : when it meets a corrupted record, puts the malformed string into a* field configured by `columnNameOfCorruptRecord`, and sets malformed fields to `null`. To* keep corrupt records, an user can set a string type field named* `columnNameOfCorruptRecord` in an user-defined schema. If a schema does not have the* field, it drops corrupt records during parsing. When inferring a schema, it implicitly* adds a `columnNameOfCorruptRecord` field in an output schema.</li>* <li>`DROPMALFORMED` : ignores the whole corrupted records.</li>* <li>`FAILFAST` : throws an exception when it meets corrupted records.</li>* </ul>* </li>* <li>`columnNameOfCorruptRecord` (default is the value specified in* `spark.sql.columnNameOfCorruptRecord`): allows renaming the new field having malformed string * created by `PERMISSIVE` mode. This overrides `spark.sql.columnNameOfCorruptRecord`.</li> * <li>`dateFormat` (default `yyyy-MM-dd`): sets the string that indicates a date format.* Custom date formats follow the formats at* <a href="https:///docs/latest/sql-ref-datetime-pattern.html">* Datetime Patterns</a>.* This applies to date type.</li>* <li>`timestampFormat` (default `yyyy-MM-dd'T'HH:mm:ss[.SSS][XXX]`): sets the string that* indicates a timestamp format. Custom date formats follow the formats at* <a href="https:///docs/latest/sql-ref-datetime-pattern.html">* Datetime Patterns</a>.* This applies to timestamp type.</li>* <li>`multiLine` (default `false`): parse one record, which may span multiple lines,* per file</li>* <li>`encoding` (by default it is not set): allows to forcibly set one of standard basic* or extended encoding for the JSON files. For example UTF-16BE, UTF-32LE. If the encoding* is not specified and `multiLine` is set to `true`, it will be detected automatically.</li>* <li>`lineSep` (default covers all `\r`, `\r\n` and `\n`): defines the line separator* that should be used for parsing.</li>* <li>`samplingRatio` (default is 1.0): defines fraction of input JSON objects used* for schema inferring.</li>* <li>`dropFieldIfAllNull` (default `false`): whether to ignore column of all null values or* empty array/struct during schema inference.</li>* <li>`locale` (default is `en-US`): sets a locale as language tag in IETF BCP 47 format.* For instance, this is used while parsing dates and timestamps.</li>* <li>`pathGlobFilter`: an optional glob pattern to only include files with paths matching* the pattern. The syntax follows <code>org.apache.hadoop.fs.GlobFilter</code>.* It does not change the behavior of partition discovery.</li>* <li>`modifiedBefore` (batch only): an optional timestamp to only include files with* modification times occurring before the specified Time. The provided timestamp* must be in the following form: YYYY-MM-DDTHH:mm:ss (e.g. 2020-06-01T13:00:00)</li>* <li>`modifiedAfter` (batch only): an optional timestamp to only include files with* modification times occurring after the specified Time. The provided timestamp* must be in the following form: YYYY-MM-DDTHH:mm:ss (e.g. 2020-06-01T13:00:00)</li>* <li>`recursiveFileLookup`: recursively scan a directory for files. Using this option* disables partition discovery</li>* <li>`allowNonNumericNumbers` (default `true`): allows JSON parser to recognize set of* "Not-a-Number" (NaN) tokens as legal floating number values:* <ul>* <li>`+INF` for positive infinity, as well as alias of `+Infinity` and `Infinity`.* <li>`-INF` for negative infinity), alias `-Infinity`.* <li>`NaN` for other not-a-numbers, like result of division by zero.* </ul>* </li>* </ul>** @since 2.0.0*/@scala.annotation.varargsdef json(paths: String*): DataFrame = format("json").load(paths : _*)/*** Loads a `JavaRDD[String]` storing JSON objects (<a href="/">JSON* Lines text format or newline-delimited JSON</a>) and returns the result as* a `DataFrame`.** Unless the schema is specified using `schema` function, this function goes through the* input once to determine the input schema.** @param jsonRDD input RDD with one JSON object per record* @since 1.4.0*/@deprecated("Use json(Dataset[String]) instead.", "2.2.0")def json(jsonRDD: JavaRDD[String]): DataFrame = json(jsonRDD.rdd)/*** Loads an `RDD[String]` storing JSON objects (<a href="/">JSON Lines* text format or newline-delimited JSON</a>) and returns the result as a `DataFrame`.** Unless the schema is specified using `schema` function, this function goes through the* input once to determine the input schema.** @param jsonRDD input RDD with one JSON object per record。

使用Spark进行实时数据分析的技巧与方法

使用Spark进行实时数据分析的技巧与方法随着大数据时代的到来,实时数据分析变得越来越重要。

作为一个功能强大的开源分析引擎,Spark 提供了一套灵活高效的工具和技巧,使实时数据分析更加便捷和高效。

本文将介绍使用 Spark 进行实时数据分析的技巧与方法。

一、实时数据分析的重要性实时数据分析是指对实时产生的数据进行实时处理和分析,以便及时做出决策或采取行动。

在当今信息化的社会中,实时数据分析能够帮助企业从数据中获取即时的信息和见解,有助于及时发现问题、优化业务和提高效率。

因此,掌握实时数据分析的技巧与方法对于企业来说至关重要。

二、使用 Spark 进行实时数据分析的技巧与方法1. 数据收集与准备在进行实时数据分析之前,首先需要收集和准备好需要分析的数据。

Spark 支持多种数据源,包括文件、数据库、数据流等。

可以根据实际情况选择合适的数据源,并使用 Spark 提供的 API 进行数据的读取和处理。

此外,还可以使用 Spark Streaming 作为实时数据流的源头,实现实时数据的收集和处理。

2. 实时数据流处理Spark Streaming 是 Spark 提供的一个用于处理实时数据流的模块,它能够将实时数据流切分成一系列小批次数据,并实时处理这些小批次数据。

使用 Spark Streaming 可以方便地进行实时数据的处理和转换。

可以使用 Spark Streaming 支持的各种操作,如 map、flatMap、filter、reduceByKey 等,对实时数据流进行处理和转换。

3. 实时数据分析在对实时数据进行处理和转换之后,接下来就是进行实时数据分析。

Spark 提供了一套强大的分析工具和 API,如Spark SQL、Spark MLlib 等,可以用于实时数据的查询、统计、挖掘和机器学习等任务。

可以根据实际需求选择合适的分析工具和 API,进行实时数据分析,并从中获取有价值的信息和见解。

结合Hadoop与Spark的大数据分析与处理技术研究

结合Hadoop与Spark的大数据分析与处理技术研究随着互联网的快速发展和信息化时代的到来,大数据技术逐渐成为各行各业关注的焦点。

在海量数据的背景下,如何高效地进行数据分析和处理成为了企业和组织面临的重要挑战。

Hadoop和Spark作为两大主流的大数据处理框架,各自具有独特的优势和适用场景。

本文将围绕结合Hadoop与Spark的大数据分析与处理技术展开深入研究。

一、Hadoop技术概述Hadoop作为Apache基金会的顶级项目,是一个开源的分布式计算平台,提供了可靠、可扩展的分布式计算框架。

其核心包括Hadoop Distributed File System(HDFS)和MapReduce计算模型。

HDFS是一种高容错性的分布式文件系统,能够存储海量数据并保证数据的可靠性和高可用性;MapReduce则是一种编程模型,通过将计算任务分解成多个小任务并行处理,实现了分布式计算。

在实际应用中,Hadoop广泛用于海量数据的存储和批量处理,例如日志分析、数据挖掘等场景。

通过搭建Hadoop集群,用户可以将数据存储在HDFS中,并利用MapReduce等工具进行数据处理和分析。

然而,由于MapReduce存在计算延迟高、不适合实时计算等缺点,随着大数据应用场景的多样化和复杂化,人们开始寻求更高效的大数据处理解决方案。

二、Spark技术概述Spark是另一个流行的大数据处理框架,也是Apache基金会的顶级项目。

与Hadoop相比,Spark具有更快的计算速度和更强大的内存计算能力。

Spark基于内存计算技术,将中间结果存储在内存中,避免了频繁的磁盘读写操作,从而大幅提升了计算性能。

除了支持传统的批处理作业外,Spark还提供了丰富的组件和API,如Spark SQL、Spark Streaming、MLlib(机器学习库)和GraphX(图计算库),满足了不同类型的大数据处理需求。

特别是Spark Streaming模块支持实时流式数据处理,使得Spark在实时计算领域具有重要应用前景。

Spark快速大数据分析ppt课件

核心概念与基本操作

Spark中对数据的所有操作不外乎:

1、创建RDD 2、转化已有RDD,即转化操作(transformation):由一个RDD生成一个新的RDD 3、调用RDD操作进行求值,即行动操作(action):会对一个RDD计算出一个结果

创建RDD的方式: 1、通过已有集合生成,用于原型开发和测试

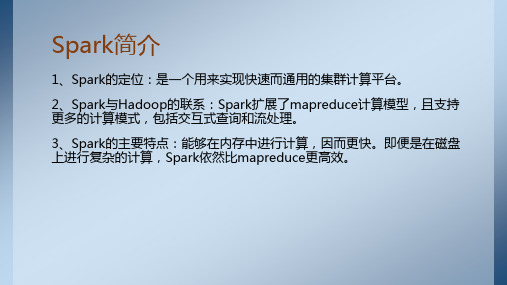

Spark简介

Spark主要包含了如下图所示的组件: 1、Spark Core:实现了Spark的基本功能,包含任务调度、 内存管理、错误恢复与存储系统交互等模块,还包含了对弹 性分布式数据集(Resilient Distributed Dataset)的API定义。

2、Spark SQL:是Spark操作结构化数据的程序包,通过 Spark SQL可以使用SQL或者Apache Hive版本的SQL方言 (HQL)来查询数据。

newRDD = RDD1.intersection(RDD2)

核心概念与基本操作

3、subtract操作,生成一个元素只存在于RDD1,不存在于RDD2的新 RDD,subtract会保留newRDD中的重复元素

newRDD = RDD1.subtract(RDD2) 4、distinct操作,生成一个去重后的新RDD

newRDD = oldRDD.filter(lambda x: x > 5)

2、map操作对RDD1中的每个元素进行函数操作后,将结果构成新的RDD,以下意为对 RDD中的每个元素进行平方构成新RDD

newRDD = oldRDD.map(lambda x: x ** 2)

3、flatMap操作和map操作类似,但是如果操作后的结果为一个列表,则取出列表中的 元素构成新RDD,而非将列表构成新RDD

大数据技术,Spark之RDD,这些就够了,RDD超详细讲解(一)

⼤数据技术,Spark之RDD,这些就够了,RDD超详细讲解(⼀)⼀、RDD为什么出现?在实际开发应⽤中,存在许多迭代式计算,这些应⽤场景的共同之处是,不同计算阶段之间会重⽤中间结果,即⼀个阶段的输出结果会作为下⼀个阶段的输⼊。

以前常⽤的MapReduce框架是把中间结果写⼊到HDFS中,带来了⼤量的数据复制、磁盘IO和序列化开销。

如果有⼀种⽅法,能将结果保存在内存当中,就可以⼤量减少IO消耗。

RDD⼀种弹性分布数据集,就是为了满⾜这种需求⽽出现的,它提供了⼀个抽象的数据架构,我们不必担⼼底层数据的分布式特性,只需将具体不同RDD之间的转换操作形成依赖关系,可以实现管道化,从⽽避免了中间结果的落地存储,⼤⼤降低了数据复制、磁盘IO和序列化开销。

⼆、RDD是什么?⼀个RDD就是⼀个分布式对象集合,本质上是⼀个只读的分区记录集合,每个RDD可以分成多个分区,每个分区就是⼀个数据集⽚段(HDFS上的块),并且⼀个RDD的不同分区可以被保存到集群中不同的节点上,RDD提供了⼀种⾼度受限的共享内存模型,即RDD是只读的记录分区的集合,不能直接修改,只能基于稳定的物理存储中的数据集来创建RDD,或者通过在其他RDD上执⾏确定的转换操作(如map、join和group RDD提供了⼀组丰富的操作以⽀持常见的数据运算,分为“⾏动”(Action)和“转换”(Transformation)两种类型的算⼦,前者⽤于执⾏计算并指定输出的形式,后者指定RDD之间的相互依赖关系。

两类操作的主要区别是,转换操作(⽐如map、filter、groupBy、join等)接受RDD并返回RDD,⽽⾏动操作(⽐如count、collect等)接受RDD但是返回⾮RDD(即输出⼀个值或结果)。

三、RDD的执⾏过程RDD开发执⾏1、RDD读⼊外部数据源(或者内存中的数据集)进⾏创建;注意:RDD读取数据时,⼀般默认2个分区。

2、RDD经过⼀系列的“转换”操作,每⼀次都会产⽣不同的RDD,供给下⼀个“转换”使⽤;3、最后⼀个RDD经“⾏动”操作进⾏处理,并输出到外部数据源,或者变成Scala/JAVA集合或变量。

Spark大数据平台搭建与部署实践指南

Spark大数据平台搭建与部署实践指南Spark大数据平台是一个快速、通用且易于使用的集群计算系统,它可以用于大规模数据处理和分析。

本文将介绍如何搭建与部署Spark大数据平台,并提供一些实践指南。

一、环境准备在开始之前,确保以下环境准备工作已经完成:1. Spark的安装包2. Hadoop集群(如果要在分布式模式下运行)3. Java开发环境二、搭建Spark大数据平台1. 解压Spark安装包将Spark安装包解压到你选择的目录下,例如/opt/spark。

2. 配置环境变量打开终端,编辑/etc/profile文件,并添加以下内容:export SPARK_HOME=/opt/sparkexport PATH=$PATH:$SPARK_HOME/bin:$SPARK_HOME/sbin保存并退出,然后运行以下命令使配置生效:source /etc/profile3. 配置Spark集群如果你要在分布式模式下运行Spark,请确保你已经设置好了Hadoop集群,并将其配置文件复制到Spark的配置目录中。

编辑$SPARK_HOME/conf/spark-env.sh文件,并添加以下内容:export HADOOP_CONF_DIR=/path/to/your/hadoop/conf保存并退出。

4. 启动Spark集群进入Spark安装目录,运行以下命令启动Spark集群:./sbin/start-all.sh这将启动Spark的Master和Worker进程。

5. 验证Spark集群打开浏览器,访问Spark的Web界面。

默认情况下,它可以通过http://localhost:8080访问。

你应该能够看到Spark集群的状态以及运行的应用程序。

三、实践指南1. 提高性能为了提高Spark集群的性能,你可以尝试以下方法:- 增加集群的计算资源,例如增加Worker节点或增加节点的内存和CPU核心。

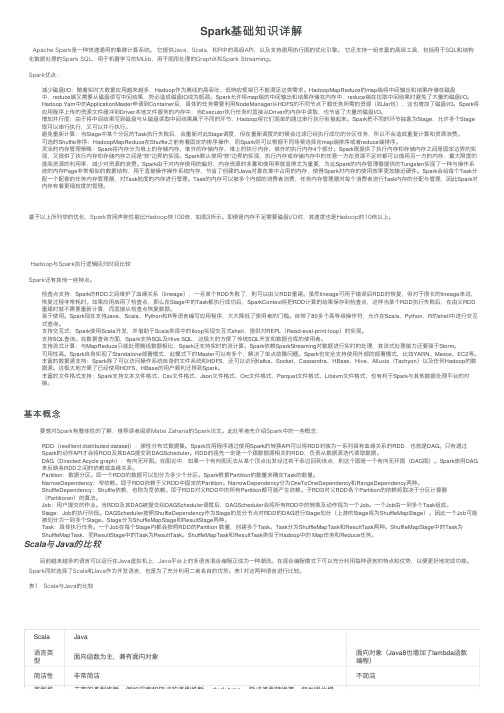

Spark基础知识详解

Spark基础知识详解Apache Spark是⼀种快速通⽤的集群计算系统。

它提供Java,Scala,和R中的⾼级API,以及⽀持通⽤执⾏图的优化引擎。

它还⽀持⼀组丰富的⾼级⼯具,包括⽤于SQL和结构化数据处理的Spark SQL,⽤于机器学习的MLlib,⽤于图形处理的GraphX和Spark Streaming。

Spark优点:减少磁盘I/O:随着实时⼤数据应⽤越来越多,Hadoop作为离线的⾼吞吐、低响应框架已不能满⾜这类需求。

HadoopMapReduce的map端将中间输出和结果存储在磁盘中,reduce端⼜需要从磁盘读写中间结果,势必造成磁盘IO成为瓶颈。

Spark允许将map端的中间输出和结果存储在内存中,reduce端在拉取中间结果时避免了⼤量的磁盘I/O。

Hadoop Yarn中的ApplicationMaster申请到Container后,具体的任务需要利⽤NodeManager从HDFS的不同节点下载任务所需的资源(如Jar包),这也增加了磁盘I/O。

Spark将应⽤程序上传的资源⽂件缓冲到Driver本地⽂件服务的内存中,当Executor执⾏任务时直接从Driver的内存中读取,也节省了⼤量的磁盘I/O。

增加并⾏度:由于将中间结果写到磁盘与从磁盘读取中间结果属于不同的环节,Hadoop将它们简单的通过串⾏执⾏衔接起来。

Spark把不同的环节抽象为Stage,允许多个Stage 既可以串⾏执⾏,⼜可以并⾏执⾏。

避免重新计算:当Stage中某个分区的Task执⾏失败后,会重新对此Stage调度,但在重新调度的时候会过滤已经执⾏成功的分区任务,所以不会造成重复计算和资源浪费。

可选的Shuffle排序:HadoopMapReduce在Shuffle之前有着固定的排序操作,⽽Spark则可以根据不同场景选择在map端排序或者reduce端排序。

灵活的内存管理策略:Spark将内存分为堆上的存储内存、堆外的存储内存、堆上的执⾏内存、堆外的执⾏内存4个部分。

基于Spark的大规模数据处理与可视化分析

基于Spark的大规模数据处理与可视化分析随着大数据时代的到来,有更多的组织和企业面临着处理大规模数据的挑战。

Spark作为一个快速、通用的大数据处理引擎,被广泛应用于大规模数据处理和可视化分析。

本文将介绍基于Spark的大规模数据处理和可视化分析的相关概念和技术。

首先,我们来了解一下Spark的基本概念。

Spark是一个开源的分布式计算系统,具有高效的处理速度和强大的扩展性。

它使用了内存计算的思想,使得处理大规模数据时能够获得很高的性能。

Spark提供了丰富的API,包括Scala、Java、Python和R等多种编程语言的接口,方便开发人员进行数据处理和分析。

大规模数据处理主要包括数据清洗、数据转换和数据分析等步骤。

Spark提供了强大的数据处理能力,可以处理结构化、半结构化和非结构化的大规模数据。

通过使用Spark的API,开发人员可以轻松地进行数据的清洗和转换。

例如,可以使用Spark的DataFrame API对数据进行过滤、排序和聚合等操作。

同时,Spark还支持复杂的数据操作,如图计算、机器学习和图像处理等。

可视化分析是将处理后的数据以可视化的方式展示出来,以便用户更直观地理解和分析数据。

Spark提供了可视化分析的相关工具和库,如Spark SQL、Spark Streaming和Spark MLlib等。

通过使用这些工具,开发人员可以将处理后的数据转化为图表、地图、仪表盘等形式,方便用户进行数据分析和决策。

基于Spark的大规模数据处理和可视化分析还需要考虑以下几个关键技术点:1. 分布式计算和集群管理:Spark利用分布式计算的思想,将大规模数据分割成多个小的数据块,并在集群中的多个节点上进行计算,从而提高计算效率和扩展性。

Spark的集群管理器可以自动监控和管理集群中的资源,保证计算任务的高可用性和可靠性。

2. 内存计算和缓存机制:Spark使用内存计算的方式来处理数据,将数据加载到内存中进行计算,避免了磁盘IO的开销,从而大大提高了计算速度。

基于Spark的大数据分析及数据可视化工具实践

基于Spark的大数据分析及数据可视化工具实践大数据分析越来越受到企业和研究机构的重视,因为它可以帮助他们更好地了解消费者、市场和竞争对手。

而Spark作为一个Apache基金会的开源大数据计算引擎,能够处理大规模数据的计算和分析,因此得到了广泛的应用。

在本文中,将介绍基于Spark 的数据分析和数据可视化工具的实践。

一、Spark的起源和特点Spark是UC Berkeley AMP实验室的开源项目,其设计目标是为了解决Hadoop MapReduce模型不足之处,Spark实现了内存计算,大大提高了计算速度。

与Hadoop相比,Spark克服了Hadoop 的较慢计算速度,支持交互式查询和流处理,并且在大规模复杂分析上具有优势。

因此,Spark在大量的数据处理任务中变得越来越重要。

Spark的主要特点包括:1. 快速计算。

Spark使用内存计算来提高处理速度,它能够在内存中处理数据,从而实现更快的计算速度。

2. 多语言支持。

Spark支持多种语言,包括Java、Scala、Python和R等,让开发人员可根据自己的比较熟练的编程语言来操作Spark。

3. 统一处理模型。

Spark提供了统一的处理模型,支持独立的应用程序和集群管理,同时也支持批处理、流处理、交互式查询和机器学习等多种处理方式。

二、大数据分析及可视化工具的使用很多企业、研究机构和开发人员已经开始使用Spark来处理大数据。

但是,处理大数据并不是只处理数据本身,还需要将处理结果转化为业务价值。

这就需要将Spark的处理结果进行可视化展示,为决策者提供数据支持。

因此,大数据分析和可视化工具也变得越来越重要。

下面将介绍一些实际的数据分析及可视化工具的应用。

1. Spark SQLSpark SQL是Spark的一个组件,它提供了一个关系型查询引擎,用于访问结构化数据。

Spark SQL能够与Hive相兼容,可以使用Hive的元数据存储和SQL语法。

Spark大数据处理架构设计与实践经验分享

Spark大数据处理架构设计与实践经验分享随着大数据时代的到来,对于数据处理和分析的需求日益增长。

传统的数据处理方式已经难以满足大规模数据的处理需求。

在这个背景下,Apache Spark的出现为大数据处理带来了全新的解决方案。

本文将分享Spark大数据处理架构设计和实践经验,探讨如何充分发挥Spark的优势进行高效的大数据处理。

首先,我们将介绍Spark的架构设计。

Spark采用了分布式的内存计算模型,通过将数据存储在内存中进行计算,大大提高了计算性能。

Spark的核心是弹性分布式数据集(RDD),RDD是一个容错的、可并行化的数据结构,能够在集群中进行分布式计算。

Spark的计算模型是基于RDD的转换(Transformation)和行动(Action)操作,通过一系列的转换操作构建数据处理的流程,最后触发行动操作执行计算。

其次,我们将分享Spark的实践经验。

在实际的大数据处理项目中,我们需要考虑以下几个方面。

首先是数据的预处理和清洗,包括数据的清理、转换和过滤等操作,以保证数据的准确性和一致性。

其次是合理的数据分区和调度策略,以避免数据倾斜和计算节点的负载不均衡问题。

此外,我们还需要充分利用Spark的并行计算能力,通过合理的并行化操作将计算任务分解为多个子任务并行执行,提高数据处理的效率。

最后是结果的输出和可视化,我们可以使用Spark的输出操作将处理结果保存到文件系统或者数据库中,并通过可视化工具展示结果,帮助我们更好地理解和分析数据。

此外,值得注意的是,Spark还支持多种数据处理引擎和编程语言,如Spark SQL、Spark Streaming、Spark MLlib等,可以根据具体的需求选择合适的引擎和语言进行数据处理。

在实践中,我们需要根据项目的具体要求选择合适的组件和工具来搭建Spark的架构,以满足不同数据处理场景的需求。

在实际的大数据处理项目中,我们还需要考虑数据安全和隐私保护的问题。

SPARK课件程介绍

04

Spark 的 API 比 Hadoop 的 API 更易用,且 Spark 支持多种语言(如 Scala、Python、Java、R 等), 而 Hadoop 主要支持 Java。

Spark 与 Flink 的比较

Spark 和 Flink 都是流处理框架,但 Flink 提供了更低延迟的流处理能力。

包括分类、回归、聚类、 协同过滤等常见的机器 学习任务。

MLlib还提供了特征提 取、转换和评估等工具, 以及一些常用的数据处 理技术,如特征选择和 特征转换。

MLlib支持分布式计算, 可以处理大规模数据集, 并且提供了良好的可扩 展性和性能。

04 Spark 优化与调优

Spark 性能优化

优化数据分区

Spark SQL支持多种数据源, 如CSV、JSON、Parquet、 ORC等,使得它能够处理各 种类型的数据。

Spark DataFrame

01

02

03

04

Spark DataFrame是Spark中 用于处理结构化数据的核心

数据结构。

它是一个分布式的数据表, 可以包含多种数据类型,如 整数、浮点数、字符串等。

通过合理的数据分区,减少数据倾斜,提高 计算效率。

优化数据序列化

启用缓存

对于频繁访问的数据,启用缓存机制,减少 重复计算。

选择高效的数据序列化方式,降低序列化和 反序列化开销。

02

01

使用压缩

对数据进行压缩,减少磁盘和网络IO开销。

04

03

Spark 资源调优

A

调整executor数量

根据集群资源情况,合理分配executor数量, 提高并行度。

Spark 提供了一个统一的编程模型,支持多种编程语言 ,包括 Scala、Java、Python 和 R。

(1)Spark简介

1.

如果Spark底层优化了,那么基于Spark底层的组件,也得到了相应的优化。例如,Spark底 层增加了一个优化算法,那么Spark的SQL和机器学习包也会自动的优化。 紧密集成,节省了各个组件组合使用时的部署,测试等时间。 当向Spark增加新的组件时,其它的组件,可以立刻享用新组件的功能。 无缝连接不同的处理模型。

2.

Shark是一种较老的基于Spark的SQL项目,它是基于Hive修改的,它现在已经被Spark SQL替 代了。

Spark的组件

1. 2.

Spark Streaming:

是实时数据流处理组件,类似Storm。 Spark Streaming提供了API来操作实时流数据。

Spark的组件

Spark系列课程大纲

Spark简介:Spark介绍,搭建Spark开发环境,开发简单的Spark程序 Spark核心概念RDDs:RDDs介绍,RDDs的操作,KeyValue对RDDs的操作,数据分片 Spark高级编程:累加器和广播变量 Spark管理与调优:集群管理,调优等

2.

3.

Spark Core提供了很多APIs来创建和操作这些集合(RDDs)。

Spark的组件

1.

Spark SQL:

是Spark处理结构化数据的库。它支持通过SQL查询数据,就像HQL(Hive SQL)一样,并且支 持很多数据源,像Hive表,JSON等。Spark SQL是在Spark 1.0版本中新加的。

2015

Spark简介

—by 球哥

大数据学习网介绍

我们的网址是: 我们提供专业的大数据学习视频,包括Hadoop,Spark,Storm,Mahout,机 器学习等。 我们定价合理,让每个人都学得起大数据。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

用Apache Spark进行大数据处理——第一部分:入门介绍什么是SparkApache Spark是一个围绕速度、易用性和复杂分析构建的大数据处理框架。

最初在2009年由加州大学伯克利分校的AMPLab开发,并于2010年成为Apache的开源项目之一。

与Hadoop和Storm等其他大数据和MapReduce技术相比,Spark有如下优势。

首先,Spark为我们提供了一个全面、统一的框架用于管理各种有着不同性质(文本数据、图表数据等)的数据集和数据源(批量数据或实时的流数据)的大数据处理的需求。

Spark可以将Hadoop集群中的应用在内存中的运行速度提升100倍,甚至能够将应用在磁盘上的运行速度提升10倍。

Spark让开发者可以快速的用Java、Scala或Python编写程序。

它本身自带了一个超过80个高阶操作符集合。

而且还可以用它在shell中以交互式地查询数据。

除了Map和Reduce操作之外,它还支持SQL查询,流数据,机器学习和图表数据处理。

开发者可以在一个数据管道用例中单独使用某一能力或者将这些能力结合在一起使用。

在这个Apache Spark文章系列的第一部分中,我们将了解到什么是Spark,它与典型的MapReduce解决方案的比较以及它如何为大数据处理提供了一套完整的工具。

Hadoop和SparkHadoop这项大数据处理技术大概已有十年历史,而且被看做是首选的大数据集合处理的解决方案。

MapReduce是一路计算的优秀解决方案,不过对于需要多路计算和算法的用例来说,并非十分高效。

数据处理流程中的每一步都需要一个Map阶段和一个Reduce阶段,而且如果要利用这一解决方案,需要将所有用例都转换成MapReduce模式。

在下一步开始之前,上一步的作业输出数据必须要存储到分布式文件系统中。

因此,复制和磁盘存储会导致这种方式速度变慢。

另外Hadoop解决方案中通常会包含难以安装和管理的集群。

而且为了处理不同的大数据用例,还需要集成多种不同的工具(如用于机器学习的Mahout和流数据处理的Storm)。

如果想要完成比较复杂的工作,就必须将一系列的MapReduce作业串联起来然后顺序执行这些作业。

每一个作业都是高时延的,而且只有在前一个作业完成之后下一个作业才能开始启动。

而Spark则允许程序开发者使用有向无环图(DAG)开发复杂的多步数据管道。

而且还支持跨有向无环图的内存数据共享,以便不同的作业可以共同处理同一个数据。

Spark运行在现有的Hadoop分布式文件系统基础之上(HDFS)提供额外的增强功能。

它支持将Spark应用部署到现存的Hadoop v1集群(with SIMR – Spark-Inside-MapReduce)或Hadoop v2 YARN集群甚至是Apache Mesos之中。

我们应该将Spark看作是Hadoop MapReduce的一个替代品而不是Hadoop的替代品。

其意图并非是替代Hadoop,而是为了提供一个管理不同的大数据用例和需求的全面且统一的解决方案。

Spark特性Spark通过在数据处理过程中成本更低的洗牌(Shuffle)方式,将MapReduce提升到一个更高的层次。

利用内存数据存储和接近实时的处理能力,Spark比其他的大数据处理技术的性能要快很多倍。

Spark还支持大数据查询的延迟计算,这可以帮助优化大数据处理流程中的处理步骤。

Spark 还提供高级的API以提升开发者的生产力,除此之外还为大数据解决方案提供一致的体系架构模型。

Spark将中间结果保存在内存中而不是将其写入磁盘,当需要多次处理同一数据集时,这一点特别实用。

Spark的设计初衷就是既可以在内存中又可以在磁盘上工作的执行引擎。

当内存中的数据不适用时,Spark操作符就会执行外部操作。

Spark可以用于处理大于集群内存容量总和的数据集。

Spark会尝试在内存中存储尽可能多的数据然后将其写入磁盘。

它可以将某个数据集的一部分存入内存而剩余部分存入磁盘。

开发者需要根据数据和用例评估对内存的需求。

Spark的性能优势得益于这种内存中的数据存储。

Spark的其他特性包括:∙支持比Map和Reduce更多的函数。

∙优化任意操作算子图(operator graphs)。

∙可以帮助优化整体数据处理流程的大数据查询的延迟计算。

∙提供简明、一致的Scala,Java和Python API。

∙提供交互式Scala和Python Shell。

目前暂不支持Java。

Spark是用Scala程序设计语言编写而成,运行于Java虚拟机(JVM)环境之上。

目前支持如下程序设计语言编写Spark应用:∙Scala∙Java∙Python∙Clojure∙RSpark生态系统除了Spark核心API之外,Spark生态系统中还包括其他附加库,可以在大数据分析和机器学习领域提供更多的能力。

这些库包括:∙Spark Streaming:o Spark Streaming基于微批量方式的计算和处理,可以用于处理实时的流数据。

它使用DStream,简单来说就是一个弹性分布式数据集(RDD)系列,处理实时数据。

∙Spark SQL:o Spark SQL可以通过JDBC API将Spark数据集暴露出去,而且还可以用传统的BI和可视化工具在Spark数据上执行类似SQL的查询。

用户还可以用Spark SQL 对不同格式的数据(如JSON,Parquet以及数据库等)执行ETL,将其转化,然后暴露给特定的查询。

∙Spark MLlib:o MLlib是一个可扩展的Spark机器学习库,由通用的学习算法和工具组成,包括二元分类、线性回归、聚类、协同过滤、梯度下降以及底层优化原语。

∙Spark GraphX:o GraphX是用于图计算和并行图计算的新的(alpha)Spark API。

通过引入弹性分布式属性图(Resilient Distributed Property Graph),一种顶点和边都带有属性的有向多重图,扩展了Spark RDD。

为了支持图计算,GraphX暴露了一个基础操作符集合(如subgraph,joinVertices和aggregateMessages)和一个经过优化的Pregel API变体。

此外,GraphX还包括一个持续增长的用于简化图分析任务的图算法和构建器集合。

除了这些库以外,还有一些其他的库,如BlinkDB和Tachyon。

BlinkDB是一个近似查询引擎,用于在海量数据上执行交互式SQL查询。

BlinkDB可以通过牺牲数据精度来提升查询响应时间。

通过在数据样本上执行查询并展示包含有意义的错误线注解的结果,操作大数据集合。

Tachyon是一个以内存为中心的分布式文件系统,能够提供内存级别速度的跨集群框架(如Spark和MapReduce)的可信文件共享。

它将工作集文件缓存在内存中,从而避免到磁盘中加载需要经常读取的数据集。

通过这一机制,不同的作业/查询和框架可以以内存级的速度访问缓存的文件。

此外,还有一些用于与其他产品集成的适配器,如Cassandra(Spark Cassandra 连接器)和R(SparkR)。

Cassandra Connector可用于访问存储在Cassandra数据库中的数据并在这些数据上执行数据分析。

下图展示了在Spark生态系统中,这些不同的库之间的相互关联。

图1. Spark框架中的库我们将在这一系列文章中逐步探索这些Spark库Spark体系架构Spark体系架构包括如下三个主要组件:∙数据存储∙API∙管理框架接下来让我们详细了解一下这些组件。

数据存储:Spark用HDFS文件系统存储数据。

它可用于存储任何兼容于Hadoop的数据源,包括HDFS,HBase,Cassandra等。

API:利用API,应用开发者可以用标准的API接口创建基于Spark的应用。

Spark提供Scala,Java和Python三种程序设计语言的API。

下面是三种语言Spark API的网站链接。

∙Scala API∙Java∙Python资源管理:Spark既可以部署在一个单独的服务器也可以部署在像Mesos或YARN这样的分布式计算框架之上。

下图2展示了Spark体系架构模型中的各个组件。

图2 Spark体系架构弹性分布式数据集弹性分布式数据集(基于Matei的研究论文)或RDD是Spark框架中的核心概念。

可以将RDD视作数据库中的一张表。

其中可以保存任何类型的数据。

Spark将数据存储在不同分区上的RDD之中。

RDD可以帮助重新安排计算并优化数据处理过程。

此外,它还具有容错性,因为RDD知道如何重新创建和重新计算数据集。

RDD是不可变的。

你可以用变换(Transformation)修改RDD,但是这个变换所返回的是一个全新的RDD,而原有的RDD仍然保持不变。

RDD支持两种类型的操作:∙变换(Transformation)∙行动(Action)变换:变换的返回值是一个新的RDD集合,而不是单个值。

调用一个变换方法,不会有任何求值计算,它只获取一个RDD作为参数,然后返回一个新的RDD。

变换函数包括:map,filter,flatMap,groupByKey,reduceByKey,aggregateByKey,pipe 和coalesce。

行动:行动操作计算并返回一个新的值。

当在一个RDD对象上调用行动函数时,会在这一时刻计算全部的数据处理查询并返回结果值。

行动操作包括:reduce,collect,count,first,take,countByKey以及foreach。

如何安装Spark安装和使用Spark有几种不同方式。

你可以在自己的电脑上将Spark作为一个独立的框架安装或者从诸如Cloudera,HortonWorks或MapR之类的供应商处获取一个Spark虚拟机镜像直接使用。

或者你也可以使用在云端环境(如Databricks Cloud)安装并配置好的Spark。

在本文中,我们将把Spark作为一个独立的框架安装并在本地启动它。

最近Spark刚刚发布了1.2.0版本。

我们将用这一版本完成示例应用的代码展示。

如何运行Spark当你在本地机器安装了Spark或使用了基于云端的Spark后,有几种不同的方式可以连接到Spark引擎。

下表展示了不同的Spark运行模式所需的Master URL参数。

如何与Spark交互Spark启动并运行后,可以用Spark shell连接到Spark引擎进行交互式数据分析。

Spark shell支持Scala和Python两种语言。

Java不支持交互式的Shell,因此这一功能暂未在Java 语言中实现。