Linux性能测试

Linux操作系统内核性能测试与调优

Linux操作系统内核性能测试与调优操作系统是计算机系统中最核心的软件之一,它负责协调和管理计算机硬件资源以及提供统一的用户界面。

Linux操作系统因其开放源代码、稳定性和安全性而备受欢迎。

然而,在大规模和高负载的环境中,Linux操作系统的性能可能会出现瓶颈。

因此,进行内核性能测试与调优是非常重要的。

一、性能测试的重要性在处理大量数据和并发用户请求时,操作系统的性能会成为瓶颈。

通过性能测试,我们可以了解操作系统在不同负载情况下的表现,进而定位和解决性能瓶颈。

性能测试有助于提高系统的响应时间、吞吐量和并发性能,从而确保系统的稳定运行。

二、性能测试的分类1. 压力测试:通过模拟实际用户行为或产生大量虚拟用户,并观察系统在负载增加的情况下的响应时间和吞吐量。

常用的压力测试工具包括Apache JMeter和Gatling等。

2. 负载测试:通过模拟实际业务场景,并且能够测试系统在高负载情况下的响应能力和稳定性。

这种测试方法可以帮助我们发现系统在繁忙时是否仍然能够正常工作,并识别可能存在的性能瓶颈。

3. 并发测试:通过模拟多个并发用户并行执行相同或不同的操作,以验证系统在并发访问下的性能表现。

这种测试方法可以评估系统的并发处理能力和资源利用率。

三、内核性能调优的重要性Linux操作系统的性能与其内核配置息息相关。

对内核的性能调优可以提高系统的响应速度、降低延迟和提高吞吐量。

通过调整内核参数和优化内核模块,可以使操作系统更好地适应特定的工作负载。

四、内核性能调优的方法1. 内核参数调整:根据系统的工作负载特点,适当调整内核参数。

例如,可以通过修改TCP/IP堆栈参数来提高网络性能,或者通过修改文件系统参数来提高磁盘I/O性能。

2. 内核模块优化:优化内核使用的模块,选择性加载和卸载不必要的模块,以减少内核的资源占用和启动时间。

3. 中断处理优化:通过合理分配和调整中断处理的优先级,减少中断处理的开销,提高系统的性能。

性能测试报告

性能测试报告目录一、性能测试概述 (3)1.1 测试目的 (3)1.2 测试环境 (4)1.3 测试范围 (5)1.4 测试方法 (6)二、硬件配置 (7)2.1 服务器配置 (8)2.2 网络配置 (9)2.3 存储配置 (11)三、软件环境 (12)3.1 操作系统版本 (13)3.2 数据库版本 (14)3.3 应用程序版本 (15)3.4 其他依赖软件版本 (16)四、性能测试指标 (18)4.1 响应时间 (18)4.2 并发用户数 (19)4.3 CPU使用率 (20)4.4 内存使用率 (21)五、性能测试结果分析 (22)5.1 响应时间分析 (23)5.2 并发用户数分析 (24)5.3 CPU使用率分析 (26)5.4 内存使用率分析 (27)5.5 磁盘I/O分析 (27)5.6 网络带宽分析 (28)5.7 吞吐量分析 (29)5.8 错误率分析 (30)5.9 稳定性分析 (31)5.10 可扩展性分析 (33)六、性能优化建议 (34)6.1 响应时间优化建议 (35)6.2 并发用户数优化建议 (36)6.3 CPU使用率优化建议 (37)6.4 内存使用率优化建议 (38)6.5 磁盘I/O优化建议 (39)6.6 网络带宽优化建议 (40)6.7 吞吐量优化建议 (41)6.8 错误率优化建议 (43)6.9 稳定性优化建议 (44)6.10 可扩展性优化建议 (45)一、性能测试概述性能测试是软件开发过程中的重要环节,旨在评估软件在特定负载和环境下,其性能表现是否满足预期的业务需求和用户要求。

通过性能测试,我们可以了解软件在不同场景下的响应速度、稳定性、可扩展性等方面的表现,从而为优化软件提供有力支持。

本次性能测试旨在对XX软件进行全面的评估,包括CPU使用率、内存占用、磁盘IO、网络带宽等关键指标。

测试环境采用模拟真实生产环境的硬件和软件配置,以确保测试结果的准确性和可靠性。

性能测试常见指标

性能测试常见指标最近在学习性能测试的东西,对于⼀些常见性能测试指标做些总结,保存在这⾥⽅便后期查阅,⽂中摘抄⾃某⼤神的博客,⽂末放原⽂链接,有需要的童鞋可以更深⼊了解!什么是性能测试?压⼒测试:强调极端暴⼒稳定性测试:在⼀定压⼒下,长时间运⾏的情况基准测试:在特定条件下的性能测试负载测试:不同负载下的表现容量测试:最优容量概述不同⼈群关注的性能指标各有侧重。

后台服务接⼝的调⽤者⼀般只关⼼吞吐量、响应时间等外部指标。

后台服务的所有者不仅仅关注外部指标,还会关注CPU、内存、负载等内部指标。

拿某打车平台来说,它所关⼼的是智能提⽰的外部指标能不能抗住因⼤波优惠所导致的流量激增。

⽽对于智能提⽰服务的开发、运维、测试⼈员,不仅仅关注外部指标,还会关注CPU、内存、IO等内部指标,以及部署⽅式、服务器软硬件配置等运维相关事项。

外部指标从外部看,性能测试主要关注如下三个指标吞吐量:每秒钟系统能够处理的请求数、任务数。

响应时间:服务处理⼀个请求或⼀个任务的耗时。

错误率:⼀批请求中结果出错的请求所占⽐例。

响应时间的指标取决于具体的服务。

如智能提⽰⼀类的服务,返回的数据有效周期短(⽤户多输⼊⼀个字母就需要重新请求),对实时性要求⽐较⾼,响应时间的上限⼀般在100ms以内。

⽽导航⼀类的服务,由于返回结果的使⽤周期⽐较长(整个导航过程中),响应时间的上限⼀般在2-5s。

对于响应时间的统计,应从均值、.90、.99、分布等多个⾓度统计,⽽不仅仅是给出均值。

下图是响应时间统计的⼀个例⼦吞吐量的指标受到响应时间、服务器软硬件配置、⽹络状态等多⽅⾯因素影响。

吞吐量越⼤,响应时间越长。

服务器硬件配置越⾼,吞吐量越⼤。

⽹络越差,吞吐量越⼩。

在低吞吐量下的响应时间的均值、分布⽐较稳定,不会产⽣太⼤的波动。

在⾼吞吐量下,响应时间会随着吞吐量的增长⽽增长,增长的趋势可能是线性的,也可能接近指数的。

当吞吐量接近系统的峰值时,响应时间会出现激增。

Linux下测试工具简介

iozone3_326

•

• • • • • • • • • •

测试步骤:

1、硬盘上有空闲空间,新建一20g的分区,格式化为ext3格式,然 后挂载分区 2、将测试工具包iozone3_326.tar拷贝到/opt目录下,并解压缩 3、进入测试工具iozone的目录: # cd iozone3_326/src/current 4、查看CPU位宽: # file /bin/ls 5、依据位宽大小选择编译方式,如果是32-bit,则执行: # make linux 如果是64-bit,则执行 # make linux-AMD64

lmbench-3.0-a7

• • • • • • 2、删除可能存在的编译文件和编译结果: # ls results | grep -vi Makefile | rm –rf # make clean 3.配置并运行一次: # make results 配置相关参数

– – – – – Options to control job placement,选择1 Memory设置为略大于4倍的cache size Email最好选择no,避免太长时间 其余选项保持默认即可 下次测试时,可以直接make rerun,不必重新配置

ltp-full-20091231

• 测试目的: – 为系统提供足够的压力,评估在超越最大负载的情况 下系统的运行,是系统在正常的情况下对某种负载强 度的承受能力的考验 。

• LTP套件的测试用例:包含了超过2000个测试用例,涵盖 了内核的大多数接口,如系统调用、内存、IPC、I/O、文 件系统和网络。 • LTP测试的过程主要分为两个阶段

• • •

4.写入结果并查看: # make see # mv results/summary.out results/`date+%y%m%d%H%M`.summay.out

Linux系统性能测试脚本使用Shell脚本实现对Linux系统性能的压力测试和评估

Linux系统性能测试脚本使用Shell脚本实现对Linux系统性能的压力测试和评估在开发和运维过程中,评估和测试系统性能是至关重要的。

这有助于发现可能存在的瓶颈和问题,以便及时采取措施进行优化和改进。

Linux系统提供了丰富的工具和命令来评估和测试系统性能,而其中使用Shell脚本来实现性能测试可以更加方便和有效。

一、性能测试的目的和重要性性能测试是为了评估计算机系统或软件在特定条件下的运行性能。

它可用于评估系统的稳定性、可靠性、可扩展性、响应时间等指标。

通过性能测试,我们可以发现系统的瓶颈,优化资源的利用,提高系统的吞吐量和响应速度。

二、Shell脚本的优势Shell脚本是Linux系统中常用的脚本语言,具有以下优势:1. 简单易用:Shell脚本语法相对简单,易于理解和学习,而且可以直接在终端运行,不需要编译和链接过程。

2. 灵活性高:Shell脚本可以通过调用系统命令和工具来实现各种功能,包括性能测试。

并且可以结合其他脚本语言进行更复杂的操作。

3. 命令丰富:在Linux系统中,有大量的命令和工具可供使用,可以通过Shell脚本集成这些命令和工具来完成性能测试任务。

三、Shell脚本实现性能测试的步骤1. 设定测试环境:在开始性能测试之前,需要准备适当的环境,并安装必要的工具和软件。

例如,可以使用yum命令安装sysstat工具和其他性能测试工具。

2. 编写Shell脚本:Shell脚本负责执行性能测试的具体步骤和命令。

可以使用循环结构和计时器来模拟实际的压力测试情况。

3. 运行脚本:通过运行Shell脚本,可以执行性能测试并获取测试结果。

测试结果可以保存到文件中以便后续分析和比较。

4. 分析测试结果:根据测试结果,可以进行性能评估和分析,找出性能瓶颈,并提出相应的优化建议。

四、Shell脚本示例下面是一个简单的Shell脚本示例,用于实现Linux系统的CPU、内存和磁盘性能测试。

```bash#!/bin/bash# 测试CPU性能echo "CPU性能测试开始..."sysbench --test=cpu --cpu-max-prime=20000 runecho "CPU性能测试结束。

性能测试工具Lmbench使用说明

cos性能测试工具Lmbench的安装使用与参数说明1 工具简介Linux性能测试工具Lmbench是一套简易可移植的,符合ANSI/C标准为UNIX/POSIX而制定的微型测评工具。

一般来说,它衡量两个关键特征:反应时间和带宽。

Lmbench旨在使系统开发者深入了解关键操作的基础成本。

其官方网站是: /lmbench/。

2 安装过程及一般错误解决办法安装使用Linux性能测试工具Lmbench 的安装相对比较简单,到其官方网站下载压缩包Lmbench3.tar.gz下面以lmbench3.tar.gz在/opt目录下为列,说明安装方法解压tar -xzvf lmbench3.tar.gzcd lmbench3make results如果在make 的时候出错,提示类似$make resultsmake[1]: Entering directory `/home/kyuan/lmbench3/src'gmake[2]: Entering directory `/home/kyuan/lmbench3/src'gmake[2]: *** No rule to make target `../SCCS/s.ChangeSet', needed by bk.ver'..gmake[2]: Leaving directory `/home/kyuan/lmbench3/src'make[1]: *** [lmbench] Error 2make[1]: Leaving directory `/home/kyuan/lmbench3/src'make: *** [results] Error 2这是需要修改src/Makefile,将这么一行(在231 行的样子),将$O/lmbench : ../scripts/lmbench bk.ver中的bk.ver 去掉,就可以了。

10大主流性能测试工具,总有一款适合你

10⼤主流性能测试⼯具,总有⼀款适合你由于开发的⽬的和侧重点不同,其市⾯上流⾏的压⼒/负载/性能测试⼯具多是来⾃国外,近年来国内的性能测试⼯具也如⾬后春笋崛起。

同时由于开发的⽬的和侧重点不同,其功能也有很⼤差异,下⾯就为您简单介绍10款⽬前最常见的测试产品。

功能也有很⼤差异,01kylinTOP测试与监控平台(商⽤)性能测试kylinTOP测试与监控平台是⼀款B/S架构的跨平台的集性能测试、⾃动化测试、业务监控于⼀体的测试平台,它是深圳是奇林软件有限公司旗下的⼀款产品,该⼯具开放10个免费虚拟⽤户可供学习和使⽤。

、⾃动化测试、业务监控于⼀体⾕歌和⽕狐都⽀持⾮常好。

在易⽤性上较好,录制脚本⽀持最新版本的浏览器,对⾕歌和⽕狐仿真能⼒上是⽬前业录制过程⾼效便捷这是其它性能⼯具⽆法⽐拟的。

仿真能⼒对⼀些https.的⽹站证书问题,都为⽤户⾃动处理好了,可以轻松录制。

录制过程⾼效便捷界做的最好的性能⼯具,可以做到完全仿真浏览器⾏为,也就是单⽤户的HTTP请求瀑布图可以和浏览器完全⼀样。

总之它是⽬前国内⼀款⾮常难可以完全替代国外的同类产品。

⽬前在军⼯领域、测评检测机构、国有企业、银⾏体系、⼤型企业有着⼴泛的应⽤。

⽀得好⽤的性能测试⼯具,可以完全替代国外的同类产品。

持的协议较多,尤其在视频领域⽀持的协议⾮常多,具有独特的优势。

02LoadRunner(商⽤)是⼀款C/S架构的商业版性能测试⼯具,在国内存在的时间较早,在国内在使⽤较⼴泛,知名度较⾼。

该⼯具免费开放了50个虚拟⽤户,可供学破解版的仿真度较差,HTTP的瀑布图是按两个两个并发(与习和使⽤。

在国内的⽹站上有破解版本,但是到了最新的12版本,不再有破解版。

破解版的仿真度较差,浏览器⾏为不⼀样),最新版本的仿真相对提⾼很多,对于HTTP静态请求相似度请求提⾼到80%,⽽动态请求就要差很多。

动态请求就要差很多。

很多不常⽤的协议都⽀持,如电⼦邮件相关协议都⽀持。

性能测试--瓶颈分析方法

性能测试--瓶颈分析方法1、内存分析方法内存分析用于判断系统有无内存瓶颈,是否需要通过增加内存等手段提高系统性能表现。

内存分析需要使用的计数器:Memory类别和Physical Disk类别的计数器。

内存分析的主要方法和步骤:〔1〕首先查看Memory\Available Mbytes指标如果该指标的数据比较小,系统可能出现了内存方面的问题,需要继续下面步骤进一步分析。

注:在UNIX/LINUX中,对应指标是FREE(KB)〔2〕注意Pages/sec、Pages Read/sec和Page Faults/sec的值操作系统回利用磁盘较好的方式提高系统可用内存量或者提高内存的使用效率。

这三个指标直接反应了操作系统进行磁盘交换的频度。

如果Pages/sec的技术持续高于几百,可能有内存问题。

Pages/sec值不一定大九说明有内存问题,可能是运行使用内存映射文件的程序所致。

Page Faults/sec说明每秒发生页面失效次数,页面失效次数越多,说明操作系统向内存读取的次数越多。

此事需要查看Pages Read/sec的计数值,该计数器的阀值为5,如果计数值超过5,则可以判断存在内存方面的问题。

注:在UNIX/LINUX系统中,对于指标是(page)si和(page)so.(3)根据Physical Disk计数器的值分析性能瓶颈对Physical Disk计数器的分析包括对Page Reads/sec和%Disk Time及Aerage Disk Queue Length的分析。

如果Pages Read/sec很低,同时%Disk Time 和Average Disk Queue Length的值很高,则可能有磁盘瓶颈。

但是,如果队列长度增加的同时Pages Read/sec并未降低,则是内存不足。

注:在UNIX/LINUX系统中,对应的指标是Reads(Writes)per sec、Percent of time the disk is busy和Average number of transactions waiting for service.2、处理器分析法〔1〕首先看System\%Total Processor Time 性能计数器的计数值该计数器的值表达服务器整体处理器利用率,对多处理器的系统而言,该计数器提醒所有CPU的平均利用率。

linux 测试用例

linux 测试用例

Linux测试用例是用于测试Linux操作系统功能和性能的一组

测试案例。

这些测试用例旨在验证Linux系统的稳定性、可靠性和

性能,并且通常涵盖了各种方面,包括文件系统、网络、内存管理、进程管理等。

以下是一些常见的Linux测试用例示例:

1. 文件系统测试,包括对文件读写、文件系统格式化、文件系

统扩展性等方面的测试。

2. 网络性能测试,测试网络传输速度、数据包丢失率、TCP/IP

协议栈性能等。

3. 内存管理测试,测试内存分配、释放、内存泄漏检测等。

4. 进程管理测试,包括进程创建、销毁、进程间通信等方面的

测试。

5. 安全性测试,测试系统的安全性,包括权限管理、防火墙、

加密等。

针对这些测试用例,可以使用各种测试工具和框架,如Jenkins、Selenium、JUnit等来执行测试并生成测试报告。

此外,

还可以使用自动化测试脚本来执行大规模的测试,以确保Linux系

统的稳定性和性能。

总之,Linux测试用例是非常重要的,可以帮

助开发人员和系统管理员评估和验证Linux系统的各项功能和性能。

LTP性能测试工具详细介绍

LTP性能测试⼯具详细介绍LTP⼯具说明1 LTP测试套件 (2)简介 (2)源⽬录结构 (2)2 LTP安装 (3)下载 (3)编译 (3)安装说明 (4)3 LTP测试套件结构说明 (4)概述 (4)⽬录介绍 (4)LTP执⾏原理 (5)4 LTP测试套件测试内容 (5)LTP测试套件测试内容 (5)commands (5)kernel (6)kdump (6)network (6)realtime (6)open_posix_testsuite (6)misc (6)测试⽅法说明 (6)commands模块内容描述及实现⽅法 (7)kernel (9)network (14)open_posix_testsuite (16)realtime (16)5 LTP测试套件配置详细 (17)脚本配置 (17)配置 (20)open_posix_testsuite测试套件 (23)realtime配置 (24)mm脚本的配置 (24)io脚本配置 (25)filecaps的配置 (25)tpm_tools的配置 (26)tcore的配置 (26)io_floppy的配置 (26)io_cd 的配置 (26)cpuhotplug的配置 (26)的配置 (27)和的配置 (28)的配置 (28)的配置 (28)的配置 (29)的配置及要求 (29)的配置及要求 (30)/ -a /dev/sda4 -b /dev/sda5–c /dev/sda6 –d /dev/sda7 –n 的配置及要求30的配置及要求 (30)rpctirpc的配置及要求 (30)的配置及要求 (31)smack的配置和要求 (32)perfcounters的配置及要求 (33)can的配置及要求 (33)的配置 (33)6 LTP测试套件使⽤说明 (34)概述 (34)初始测试 (35)runltp使⽤说明 (35)脚本说明 (36)1 LTP测试套件简介LTP(LinuxTest Project)是SGI、IBM、OSDL和Bull合作的项⽬,⽬的是为开源社区提供⼀个测试套件,⽤来验证Linux系统可靠性、健壮性和稳定性。

18_Linux固态硬盘读写性能测试脚本(fio)

18_Linux固态硬盘读写性能测试脚本(fio)18_Linux 固态硬盘读写性能测试脚本(fio)18.1、配置⽂件{"para_ssd": {"ssd_cpu": {"cpu_enable": 0,"core_num": 3,"time_num": 1,"time_unit": "d"},"ssd_cycle": 3,"ssd_dd": {"dd_bs": "M","dd_init": 500,"dd_step": 50,"dd_fins": 500},"ssd_fio": {"fio_bs": 128,"fio_direct": 1,"fio_iodepth": 1,"fio_ioengine": "libaio","fio_runtime": 60,"fio_size": "500M"},"ssd_mem": {"mem_enable": 0,"mem_proportion": 0.95,"mem_total": 1840},"ssd_png": {"display_interval": 20,"add_yrange": 50,"set_ytics": 20},"ssd_mounted": "/opt/blackbox/data","ssd_temp": "25C","ssd_type": "/dev/nvme0n1"}}18.2、测试脚本#!/bin/bashfunction ssd_function_template(){{fio -ioengine=${fio_ioengine} -bs=$1KB -direct=${fio_direct} -thread -rw=$2 -filename=${ssd_type} -name="BS-$1KB-$2-test" -iodepth=${fio_iodepth} -runtime=${fio_runtime} -size=${fio_size} -group_reporting} |tee /tmp/ssd_$2.loggrep $3 /tmp/ssd_$2.log |grep runt >> ${dir_path}/ssd_$2_$1.log}function ssd_function(){ssd_function_template $1 "read" "read"ssd_function_template $1 "randread" "read"ssd_function_template $1 "write" "write"ssd_function_template $1 "randwrite" "write"}function result_ssd_template(){local ssd_log=$1if [ -f "${ssd_log}" ]thensed -i 's/=/,/g' ${ssd_log}sed -i 's/KB\/s/,KB\/s/' ${ssd_log}local log_bw=/tmp/bw_$2.loglocal bw_sum=0local bw_avg=0{awk -F ',' '{print $4}' ${ssd_log} |awk -F '.' '{print $1}'} > ${log_bw}local count_line=$(wc -l ${log_bw} |awk '{print $1}')while read linedolet bw_sum=bw_sum+$linedone < ${log_bw}let bw_avg=$bw_sum/$count_linelocal log_iops=/tmp/iops_$2.loglocal iops_sum=0local iops_avg=0{awk -F ',' '{print $7}' ${ssd_log}} > ${log_iops}local count_line=$(wc -l ${log_iops} |awk '{print $1}')while read line1dolet iops_sum=iops_sum+$line1done < ${log_iops}let iops_avg=$iops_sum/$count_lineecho "$1,bw_avg,$bw_avg KB/S,iops_avg,$iops_avg"fi}function result_ssd(){{result_ssd_template "${dir_path}/ssd_read_$1.log" "read"result_ssd_template "${dir_path}/ssd_randread_$1.log" "randread"result_ssd_template "${dir_path}/ssd_write_$1.log" "write"result_ssd_template "${dir_path}/ssd_randwrite_$1.log" "randwrite"echo} |tee -a ${dir_path}/ssd_result.logcat ${dir_path}/ssd_result.log >> ${source_path}/log/ssd_result.log}function ssd_size_setting(){if [ "${mem_enable}" -eq 1 ]thenlocal bigfile=${ssd_path}/bigfile[ -f "${bigfile}" ] && rm ${bigfile}local mem_total=$(jq -r '.para_ssd.ssd_mem.mem_total' config.json)local mem_threshold=$(jq -r '.para_ssd.ssd_mem.mem_proportion' config.json) local mem_actual_per=$(df /dev/nvme0n1 |awk '{print $5}'|tail -1)local mem_actual=0.$(echo "$mem_actual_per" |awk -F "%" '{print $1}')local mem_compare=$(echo "${mem_actual} < ${mem_threshold}" |bc)if [ "${mem_compare}" -eq 1 ]thenlocal mem_diff=$(echo "${mem_threshold} - ${mem_actual}" |bc)local mem_diff_size=$(echo "${mem_total} * ${mem_diff}" |bc)fallocate -l ${mem_diff_size}G ${ssd_path}/bigfilefifimem_actual_use=$(df /dev/nvme0n1 |awk '{print $5}'|tail -1)}function ssd_depend_package(){which bc > /dev/nullif [ "$?" -ne 0 ]thenlocal platform=$(uname -m)if [ "${platform}" == "armv7l" ]thendpkg -i ${source_path}/lib/deb_package/bb_bc/bc_1.06.95-9build1_armhf.deb fifi}function ssd_config_check(){# ssd type and ssd mount path detectionif [ -b "${ssd_type}" ]thenlocal mounted_path=$(df -h |grep "${ssd_type}" |awk '{print $6}')if [ -d "${mounted_path}" ]thenumount -l ${mounted_path}fielseprintf "${source_path}/config.json \"para_ssd.ssd_type\" error or not exist\n"exit 1fi}function ssd_cpu_stress(){# cpu N core stressif [ "${cpu_enable}" -eq 1 ]thenlocal cpu_time_num=$(jq -r ".para_ssd.ssd_cpu.time_num" ${source_path}/config.json) local cpu_time_unit=$(jq -r ".para_ssd.ssd_cpu.time_unit" ${source_path}/config.json) stress-ng -c ${cpu_num} -t ${cpu_time_num}${cpu_time_unit}fi}function ssd_cpu_stress_ctrlc(){local pid_stress=$(pgrep stress-ng)local pid_num=$(echo "${pid_stress}" |wc -l)if [ "${pid_num}" -gt 0 ]thenlocal platform=$(uname -m)if [ "${platform}" == "armv7l" ]thenfor i in $(echo "$pid_stress")dokill -9 $idoneelif [ "${platform}" == "aarch64" ]thensudo killall stress-ng &> ${c_d_null}fifiprintf "$$\n" |xargs kill -9}function ssd_test_condition(){cat <<-eof[$(date "+%T")] platform : $(uname -m)[$(date "+%T")] ssd type : ${ssd_type}[$(date "+%T")] cpu enable : ${cpu_enable}[$(date "+%T")] cpu num : ${cpu_num}00%[$(date "+%T")] mem enable : ${mem_enable}[$(date "+%T")] mem use : ${mem_actual_use}[$(date "+%T")] fio bs : ${fio_bs}KB[$(date "+%T")] fio direct : ${fio_direct}[$(date "+%T")] fio iodepth : ${fio_iodepth}[$(date "+%T")] fio ioengine: ${fio_ioengine}[$(date "+%T")] fio runtime : ${fio_runtime}[$(date "+%T")] fio size : ${fio_size}[$(date "+%T")] test temp : ${ssd_temp}eofsleep 2}function ssd_png_set(){which gnuplot > /dev/nullif [ "$?" -eq 0 ]thenecho "set terminal png size 1280,720set output \"${dir_path}/ssd_speed_fio.png\"set border lc rgb \"orange\"set multiplot layout 1,2set grid x,y lc rgb \"orange\"set datafile sep ','set key box reverseset xlabel \"${fio_bs}KB\" font \",15\"set xrange [-1:$ssd_cycle]set ytics $ssd_png_yticsset origin 0,0set title \"FIO Sequential \($ssd_type\)\n\(Temp: $ssd_temp; CPU: $cpu_enable-$cpu_num; Disk-Use: $mem_actual_use\)\" font \",16\" set ylabel \"KB/s\" font \",15\"plot \"$dir_path/ssd_read_$1.log\" u 4 smooth csplines w l lc 1 lw 2 t \"Read\",\\"$dir_path/ssd_write_$1.log\" u 4 smooth csplines w l lc 6 lw 2 t \"Write\"set origin 0.5,0set title \"FIO Random \($ssd_type\)\n\(Temp: $ssd_temp; CPU: $cpu_enable-$cpu_num; Disk-Use: $mem_actual_use\)\" font \",16\" set ylabel \"IOps\" font \",15\"plot \"$dir_path/ssd_randread_$1.log\" u 7 smooth csplines w l lc 1 lw 2 t \"Read\",\\"$dir_path/ssd_randwrite_$1.log\" u 7 smooth csplines w l lc 6 lw 2 t \"Write\" " |gnuplotfi}function ssd_stress_excute(){for ((i=1;i<=${ssd_cycle};i++))dossd_function ${fio_bs} && echodoneresult_ssd ${fio_bs}ssd_png_set ${fio_bs}}function main(){local source_path=$(pwd)local c_d_null=/dev/nulllocal c_d_zero=/dev/zerolocal cpu_enable=$(jq -r ".para_ssd.ssd_cpu.cpu_enable" ${source_path}/config.json)local cpu_num=$(jq -r ".para_ssd.ssd_cpu.core_num" ${source_path}/config.json)local fio_bs=$(jq -r ".para_ssd.ssd_fio.fio_bs" ${source_path}/config.json)local fio_direct=$(jq -r ".para_ssd.ssd_fio.fio_direct" ${source_path}/config.json)local fio_iodepth=$(jq -r ".para_ssd.ssd_fio.fio_iodepth" ${source_path}/config.json)local fio_ioengine=$(jq -r ".para_ssd.ssd_fio.fio_ioengine" ${source_path}/config.json)local fio_runtime=$(jq -r ".para_ssd.ssd_fio.fio_runtime" ${source_path}/config.json)local fio_size=$(jq -r ".para_ssd.ssd_fio.fio_size" ${source_path}/config.json)local mem_enable=$(jq -r ".para_ssd.ssd_mem.mem_enable" ${source_path}/config.json)local ssd_cycle=$(jq -r ".para_ssd.ssd_cycle" ${source_path}/config.json)local ssd_path=$(jq -r ".para_ssd.ssd_mounted" ${source_path}/config.json)local ssd_temp=$(jq -r ".para_ssd.ssd_temp" ${source_path}/config.json)local ssd_type=$(jq -r ".para_ssd.ssd_type" ${source_path}/config.json)local dir_date=$(date "+%Y-%m-%d-%H-%M-%S")local dir_path=${source_path}/log/ssd_speed_${fio_bs}kb_cpu_${cpu_enable}_${cpu_num}00/${dir_date} trap "ssd_cpu_stress_ctrlc" HUP INT QUITtrap "ssd_cpu_stress_ctrlc" EXIT[ ! -d ${dir_path} ] && mkdir -p ${dir_path}ssd_config_checkssd_depend_packagessd_size_settingssd_test_conditionssd_cpu_stress &ssd_stress_excute}main。

LTP测试——精选推荐

TP测试一.LTP介绍Linux Test Project是一个测试Linux内核和内核相关特性的工具集合。

该工具的目的是通过把测试自动化引入到Linux内核测试,验证内核的稳定性、可靠性和健壮性,提高Linux的内核质量。

1.功能测试Linux Test Project(简称LTP)是目前较为流行的Linux基本功能测试工具集。

LTP包含了众多子功能测试模块,例如系统调用,系统命令,内存分配,磁盘读写,文件系统,网络,数学运算测试等等。

为了达到快速检查内核变动的能力,繁重的内核测试任务需要有自动化的实现。

内核测试自动化的设计与普通应用程序测试自动化的设计并无太多区别,它主要包含以下几个方面:内核源代码自动化的下载,自动化的编译,自动化的安装,自动化的测试并报告测试结果。

AutoTest是目前比较有名的自动化内核测试项目,由Martin J. Bligh发起并维护。

它实现了一套较为先进的自动测试框架,并提供了一套接口供现有的测试工具(例如LTP)进行集成。

当发现有新的Linux 内核需要测试时,AutoTest便会生成一系列的测试任务,然后把测试任务分配到不同的Client Harness上进行环境准备和执行测试,最后把收集到的测试结果进行分析和发布。

2.性能测试LTP 工作组在设计Linux 内核压力测试脚本ltpstress.sh 时使用了这一设计方法,为给系统提供足够的压力,LTP工作组对这个组合测试进行了分析,以确定Linux 内核的哪些部分在测试执行中得到了使用。

然后,修改了组合测试,在保持期望的高强度系统压力的同时提高代码覆盖率的百分比。

最终得到的压力测试涵盖了Linux 内核的足够多部分,有助于稳定性声明,并且有系统使用情况和内核代码覆盖情况的数据来支持它。

有两个开放源代码工具可以帮助进行Linux 内核的代码覆盖率分析:(1) gcov:一个由LTP 维护的开放源代码工具。

这个工具分析内核代码的覆盖率,并报告哪些行、函数和分支被覆盖以及它们被访问了多少次。

对Linux系统内核版本稳定性测试介绍

对Linux系统内核版本稳定性测试介绍对Linux系统内核版本稳定性测试介绍在对 Linux 内核版本稳定性的测试中,需要明确地声明并证明为什么版本是稳定的或者是不稳定的。

然⽽还没有被证明和证实当前现有的系统范围内的压⼒测试可以测试 Linux 内核整体上的稳定性。

本⽂给出了⼀个创建系统范围内 Linux 压⼒测试并证明其结果正确性的⽅法。

不同的 Linux 开发者、⽤户和发⾏版本会使⽤他们⾃⼰的⽅法来测试内核的稳定性。

不过,关于他们决定运⾏哪些测试、覆盖的代码、达到的压⼒级别等的基础信息都没有发布,这就⼤⼤降低了结果的价值。

使⽤实验室的机器以及来⾃ Linux Test Project 测试套件的测试,我们基于系统资源的利⽤率统计开发了⼀个测试的组合,为系统提供⾜够的压⼒。

我们对这个组合测试进⾏了分析,以确定 Linux 内核的哪些部分在测试执⾏中得到了使⽤。

然后,我们修改了组合测试,在保持期望的⾼强度系统压⼒的同时提⾼代码覆盖率的百分⽐。

最终得到的压⼒测试涵盖了 Linux 内核的⾜够多部分,有助于稳定性声明,并且有系统使⽤情况和内核代码覆盖情况的数据来⽀持它。

这⼀组合测试⽅法的四个步骤是:测试选择、系统资源利⽤率评价、内核代码覆盖分析以及最终的压⼒测试评价。

选择测试 测试选择包括选择达成两⽅⾯⽬的的测试: 测试应该可以得到 CPU(s)、内存、I/O 和⽹络等主要内核区域的⾼⽔平的资源利⽤率。

测试应该充分地覆盖内核代码,以帮助⽀持⾃其结果中⽣成的稳定性声明。

只要有可能,都要使⽤⾃动化的或者易于修改的测试,以⽀持⾃动操作。

⾃动操作可以使得测试更快⽽且可以重复进⾏,并帮助降低⼈为错误的风险。

选择合适的测试时需要考虑的另⼀个⽅⾯是,使⽤可以⾃由发布结果的应⽤程序。

最好是选择坚决拥护开放源代码⽅法和/或 GPL 的测试和测试套件,以助于确保发布过程的简便。

评价系统资源利⽤率 所选择的测试的组合必须给系统的资源带来⾜够的压⼒。

Linux系统IO基准测试方法

Linux系统IO基准测试⽅法顺序读写测试主要关注磁盘的吞吐量,即每秒能够读⼊或者写出多少数据。

普通单块机械磁盘顺序写在100MB/s左右,普通单块SSD的顺序写在500MB/s左右。

该指标对MQ、ES等以append ⽅式追加数据的软件性能影响⽐较⼤测试⽅法安装软件默认情况下操作系统⾃带dd命令,不⽤安装运⾏命令:dd if=/dev/zero of=/home/wangzhen/ddtest/test.dbf bs=32k count=256k conv=fdatasync参数含义:bs=< 字节数 > 将 ibs( 输⼊ ) 与 obs( 输出 ) 设成指定的字节数。

cbs=< 字节数 > 转换时,每次只转换指定的字节数。

conv=< 关键字 > 指定⽂件转换的⽅式。

count=< 区块数 > 仅读取指定的区块数。

ibs=< 字节数 > 每次读取的字节数。

if=< ⽂件 > 从⽂件读取。

obs=< 字节数 > 每次输出的字节数。

of=< ⽂件 > 输出到⽂件。

seek=< 区块数 > ⼀开始输出时,跳过指定的区块数。

skip=< 区块数 > ⼀开始读取时,跳过指定的区块数。

--help 帮助。

--version 显⽰版本信息。

测试结果:[wangzhen@wangzhen-pc ddtest]$ dd if=/dev/zero of=/home/wangzhen/ddtest/test.dbf bs=32k count=256k conv=fdatasync记录了262144+0 的读⼊记录了262144+0 的写出8589934592 bytes (8.6 GB, 8.0 GiB) copied, 18.0831 s, 475 MB/s备注:通过fio将参数设置为rw=write时也可以达到dd测试顺序读写的效果,且测试值基本和dd⼀样(阿⾥的⽅法).fio -directory=/data/mytest.img -ioengine=sync -direct=1 -bs=1024k -iodepth=64 -rw=write -size=2G -numjobs=1 -time_based=1 -runtime=120s -group_reporting -name=mytest随机读写测试主要关注IOPS指标,即每秒磁盘能够处理的IO请求个数。

Linux实时性能测试工具—Cyclictest的使用与分析【转】

Linux实时性能测试⼯具—Cyclictest的使⽤与分析【转】转⾃:关于Cyclictest⼯具,在Wiki上有说明: Cyclictest is a high resolution test program, written by User:Tglx, maintained by Clark Williams and John KacurDocumentation Installation Get the latest sources from the git repository, do a git clone git:///pub/scm/utils/rt-tests/rt-tests.git or fetch a released tarball from the archive, untar into a directory of your choice and run make in the source directory. If you want to cross compile, just run make CROSS_COMPILE= (for example make CROSS_COMPILE=arm-v4t-linux-gnueabi-). You can run the resulting binary from there or install it.#需要安装libnuma-devel包后make编译yum install numactl-develgit clone git:///pub/scm/utils/rt-tests/rt-tests.gitcd rt-testsgit checkout stable/v1.0make allmake installmake cyclictestRun itMake sure to be root or use sudo to run cyclictest.Without parameters cyclictest creates one thread with a 1ms interval timer.cyclictest -h provides help text for the various options[root@localhost rt-tests]# ./cyclictest --helpcyclictest V 1.00Usage:cyclictest <options>-a [CPUSET] --affinity Run thread #N on processor #N, if possible, or if CPUSETgiven, pin threads to that set of processors in round-robin order. E.g. -a 2 pins all threads to CPU 2,but -a 3-5,0 -t 5 will run the first and fifththreads on CPU (0),thread #2 on CPU 3, thread #3on CPU 4, and thread #5 on CPU 5.-A USEC --aligned=USEC align thread wakeups to a specific offset-b USEC --breaktrace=USEC 当延时⼤于USEC指定的值时,发送停⽌跟踪。

压测指标 linux iops

压测指标 linux iops

在Linux系统中,IOPS(每秒输入/输出操作数)是衡量存储性能的重要指标之一。

IOPS表示在一秒钟内系统的输入/输出操作次数。

在进行压力测试时,评估IOPS可以帮助我们了解系统的存储性能和承载能力。

首先,要了解Linux系统的IOPS指标,我们需要考虑以下几个方面:

1. 存储设备类型,不同类型的存储设备(如机械硬盘、固态硬盘、RAID阵列等)对IOPS性能有不同的影响。

固态硬盘通常具有更高的IOPS性能,而机械硬盘的性能相对较低。

2. 文件系统,不同的文件系统对IOPS性能也会产生影响。

常见的文件系统如ext4、XFS等在处理I/O操作时会有不同的表现。

3. I/O调度器,Linux内核中的I/O调度器对IOPS性能也有一定的影响。

常见的调度器包括CFQ、Deadline和NOOP,它们在不同工作负载下会有不同的表现。

在进行压测时,我们可以使用一些工具来评估Linux系统的IOPS性能,例如fio(Flexible I/O Tester)。

通过fio工具可以

模拟不同类型的I/O工作负载,并输出相应的性能指标,包括IOPS。

除了工具之外,还可以通过一些系统命令来查看Linux系统的IOPS指标,例如使用iostat命令可以实时监测系统的I/O性能,

包括IOPS、吞吐量等指标。

总之,在评估Linux系统的IOPS指标时,需要考虑存储设备类型、文件系统、I/O调度器等因素,并可以借助工具和系统命令来

获取相应的性能数据,从而全面了解系统的存储性能和承载能力。

性能测试要点及用例

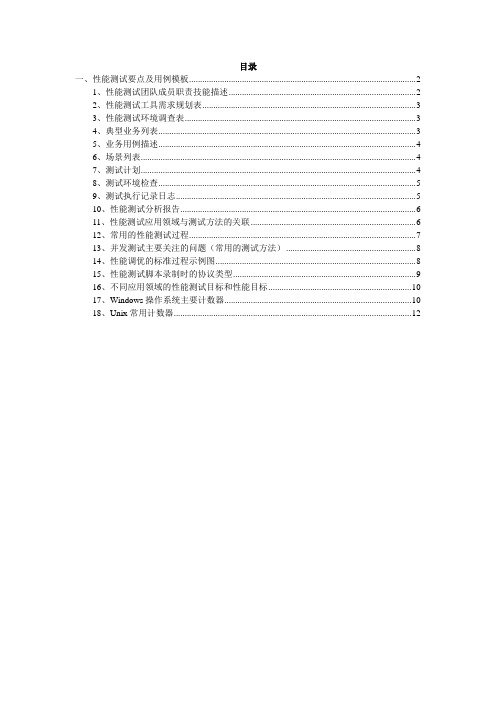

目录一、性能测试要点及用例模板 (2)1、性能测试团队成员职责技能描述 (2)2、性能测试工具需求规划表 (3)3、性能测试环境调查表 (3)4、典型业务列表 (3)5、业务用例描述 (4)6、场景列表 (4)7、测试计划 (4)8、测试环境检查 (5)9、测试执行记录日志 (5)10、性能测试分析报告 (6)11、性能测试应用领域与测试方法的关联 (6)12、常用的性能测试过程 (7)13、并发测试主要关注的问题(常用的测试方法) (8)14、性能调优的标准过程示例图 (8)15、性能测试脚本录制时的协议类型 (9)16、不同应用领域的性能测试目标和性能目标 (10)17、Windows操作系统主要计数器 (10)18、Unix常用计数器 (12)一、性能测试要点及用例模板1、性能测试团队成员职责技能描述2、性能测试工具需求规划表3、性能测试环境调查表4、典型业务列表5、业务用例描述6、场景列表7、测试计划1.引言1.1编写目的2.参考文档3.测试目的4.测试范围4.1测试对象4.2需要测试的特性4.3无需测试的特性5.测试启动与结束准则5.1启动准则5.2结束准则6.测试方法6.1测试工具6.2测试设计6.3测试用例与测试场景7.测试类型7.1能力验证测试7.2容量规划测试7.3稳定性测试8.测试环境维护原则9.测试输出10.测试资源需求与时间计划8、测试环境检查9、测试执行记录日志10、性能测试分析报告1.测试背景2.测试目的3.测试概要描述3.1被测系统描述3.2测试时间3.3测试地点3.4测试人员3.5测试工具和环境3.6测试方案简介4.测试结果和结论4.1测试结论4.2测试结论的限制4.3对系统的建议5.原始数据和报告5.1测试执行记录5.2原始数据文件5.3测试工具生成的报告11、性能测试应用领域与测试方法的关联12、常用的性能测试过程13、并发测试主要关注的问题(常用的测试方法)14、性能调优的标准过程示例图15、性能测试脚本录制时的协议类型16、不同应用领域的性能测试目标和性能目标17、Windows操作系统主要计数器18、Unix常用计数器。

12个经典性能测试面试题

12个经典性能测试⾯试题1、性能测试包含了哪些软件测试(⾄少举出3种)?负载测试(Load Testing):负载测试是⼀种主要为了测试软件系统是否达到需求⽂档设计的⽬标,譬如软件在⼀定时期内,最⼤⽀持多少并发⽤户数,软件请求出错率等,测试的主要是软件系统的性能。

压⼒测试(Stress Testing):强度测试也就是压⼒测试,压⼒测试主要是为了测试硬件系统是否达到需求⽂档设计的性能⽬标,譬如在⼀定时期内,系统的cpu利⽤率,内存使⽤率,磁盘I/O吞吐率,⽹络吞吐量等,压⼒测试和负载测试最⼤的差别在于测试⽬的不同。

容量测试(Volume Testing):确定系统最⼤承受量,譬如系统最⼤⽤户数,最⼤存储量,最多处理的数据流量等。

或者在下⾯选择⼏项:并发测试 - 测试多⽤户并发访问同⼀个应⽤、模块、数据时是否产⽣隐藏的并发问题基准测试 - ⽐较新的或未知测试对象与已知参照标准(如现有软件或评测标准)的性能。

争⽤测试:- 核实测试对象对于多个主⾓对相同资源(数据记录、内存等)的请求的处理是否可以接受。

性能配置 - 核实在操作条件保持不变的情况下,测试对象在使⽤不同配置时其性能⾏为的可接受性。

负载测试- 核实在保持配置不变的情况下,测试对象在不同操作条件(如不同⽤户数、事务数等)下性能⾏为的可接受性。

强度测试- 核实测试对象性能⾏为在异常或极端条件(如资源减少或⽤户数过多)之下的可接受性。

容量测试- 核实测试⽤户同时使⽤软件程序的最⼤数量2、请问什么是性能测试、负载测试、压⼒测试?性能测试是通过⾃动化的测试⼯具模拟多种正常、峰值以及异常负载条件来对系统的各项性能指标进⾏测试。

负载测试、压⼒测试参考答案如上题。

3、在给定的测试环境下进⾏,考虑被测系统的业务压⼒量和典型场景?负载测试负载测试是⽤来测定系统饱和状态、确定阀值。

其特点有:1)这种⽅法的⽬的是找到系统处理能⼒的极限;通过“检测、加压、阀值”⼿段找到如“响应时间不超过10秒”,“平均cpu利⽤率低于65%”等指标。

LTP性能测试工具详细介绍

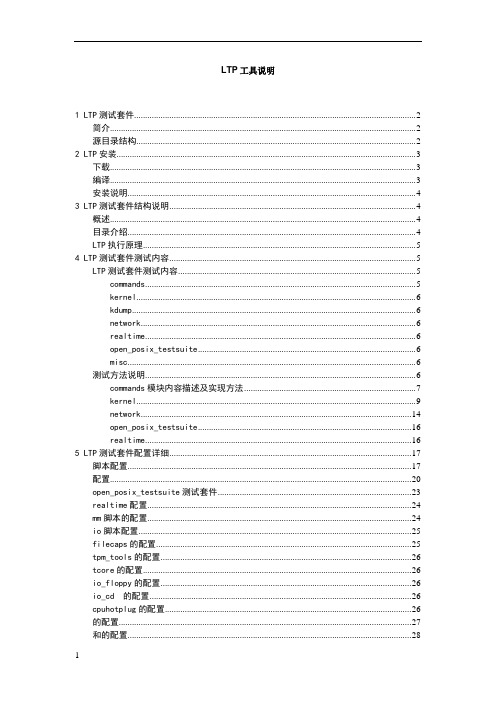

LTP工具说明1 LTP测试套件 (2)简介 (2)源目录结构 (2)2 LTP安装 (3)下载 (3)编译 (3)安装说明 (4)3 LTP测试套件结构说明 (4)概述 (4)目录介绍 (4)LTP执行原理 (5)4 LTP测试套件测试内容 (5)LTP测试套件测试内容 (5)commands (5)kernel (6)kdump (6)network (6)realtime (6)open_posix_testsuite (6)misc (6)测试方法说明 (6)commands模块内容描述及实现方法 (7)kernel (9)network (14)open_posix_testsuite (16)realtime (16)5 LTP测试套件配置详细 (17)脚本配置 (17)配置 (20)open_posix_testsuite测试套件 (23)realtime配置 (24)mm脚本的配置 (24)io脚本配置 (25)filecaps的配置 (25)tpm_tools的配置 (26)tcore的配置 (26)io_floppy的配置 (26)io_cd 的配置 (26)cpuhotplug的配置 (26)的配置 (27)和的配置 (28)的配置 (28)的配置 (28)的配置 (29)的配置及要求 (29)的配置及要求 (30)/ -a /dev/sda4 -b /dev/sda5–c /dev/sda6 –d /dev/sda7 –n 的配置及要求30的配置及要求 (30)rpctirpc的配置及要求 (30)的配置及要求 (31)smack的配置和要求 (32)perfcounters的配置及要求 (33)can的配置及要求 (33)的配置 (33)6 LTP测试套件使用说明 (34)概述 (34)初始测试 (35)runltp使用说明 (35)脚本说明 (36)1 LTP测试套件简介LTP(LinuxTest Project)是SGI、IBM、OSDL和Bull合作的项目,目的是为开源社区提供一个测试套件,用来验证Linux系统可靠性、健壮性和稳定性。

26个版本linux内核的性能对比测试

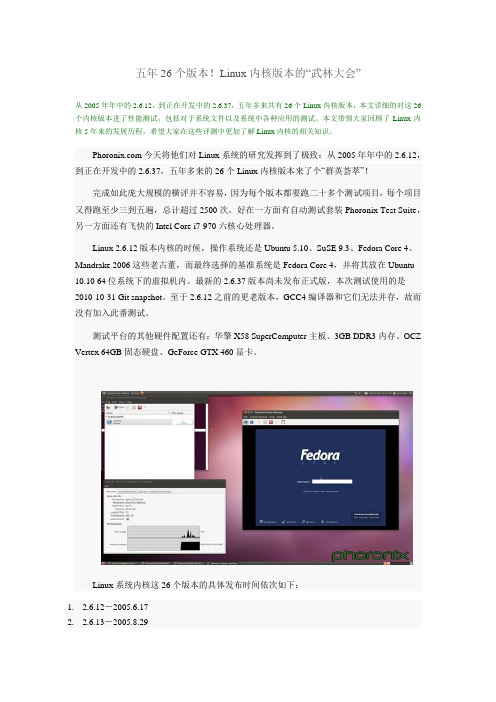

五年26个版本!Linux内核版本的“武林大会”从2005年年中的2.6.12,到正在开发中的2.6.37,五年多来共有26个Linux内核版本,本文详细的对这26个内核版本进了性能测试,包括对于系统文件以及系统中各种应用的测试。

本文带领大家回顾了Linux内核5年来的发展历程,希望大家在这些评测中更加了解Linux内核的相关知识。

今天将他们对Linux系统的研究发挥到了极致:从2005年年中的2.6.12,到正在开发中的2.6.37,五年多来的26个Linux内核版本来了个“群英荟萃”!完成如此庞大规模的横评并不容易,因为每个版本都要跑二十多个测试项目,每个项目又得跑至少三到五遍,总计超过2500次。

好在一方面有自动测试套装Phoronix Test Suite,另一方面还有飞快的Intel Core i7-970六核心处理器。

Linux 2.6.12版本内核的时候,操作系统还是Ubuntu 5.10、SuSE 9.3、Fedora Core 4、Mandrake 2006这些老古董,而最终选择的基准系统是Fedora Core 4,并将其放在Ubuntu 10.10 64位系统下的虚拟机内。

最新的2.6.37版本尚未发布正式版,本次测试使用的是2010-10-31 Git snapshot。

至于2.6.12之前的更老版本,GCC4编译器和它们无法并存,故而没有加入此番测试。

测试平台的其他硬件配置还有:华擎X58 SuperComputer主板、3GB DDR3内存、OCZ Vertex 64GB固态硬盘、GeForce GTX 460显卡。

Linux系统内核这26个版本的具体发布时间依次如下:1. 2.6.12-2005.6.172. 2.6.13-2005.8.293. 2.6.14-2005.10.174. 2.6.15-2006.1.35. 2.6.16-2006.3.206. 2.6.17-2006.6.177. 2.6.18-2006.9.208. 2.6.19-2006.11.299. 2.6.20-2007.2.510.2.6.21-2007.4.2511.2.6.22-2007.7.812.2.6.23-2007.10.913.2.6.24-2008.1.2414.2.6.25-2008.4.1715.2.6.26-2008.7.1316.2.6.27-2008.10.917.2.6.28-2008.12.2518.2.6.29-2009.3.2319.2.6.30-2009.6.920.2.6.31-2009.9.921.2.6.32-2009.12.322.2.6.33-2010.2.2423.2.6.34-2010.5.1624.2.6.35-2010.8.125.2.6.36-2010.10.2026.2.6.37-(开发中)下面就是对各个版本的Linux内核进行的评测。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Linux性能测试一、测试计划1.查找性能测试工具2.确定测试工具并对其进行安装、运行3.对运行结果进行分析4.对此测试工具未覆盖到的性能方面,查找其他工具5.继续分析工具测试内容6.编写测试报告二、C GL性能要求—实时处理Linux实时系统最重要的特点就是实时性,即系统的正确性不仅仅依赖于计算的逻辑结果的正确性,还取决于输出结果时间的及时性。

从这个角度看,实时系统是“一个能够在指定或者确定的时间内完成系统功能和对外部环境做出响应的系统”。

按对实时性能要求的程度,实时系统可分为两类:(1) 硬实时系统:要求可确定性强,具有明确的实时约束,在某个限定的时刻之前不能完成任务将造成灾难性的后果。

(2) 软实时系统:也对时间敏感,但偶尔发生不能满足严格实时要求的情况也是允许的。

Lmbench是测试Linux系统性能的实用程序集,会产生详细的结果并提供工具来处理它们。

它包括一系列微型的基准,可以测量一些基本的操作系统和硬件指标:* 文件的读取和概括* 读、写和复制时的内存带宽* 通过管道复制数据* 通过Unix套接字复制数据* 通过TCP/ IP套接字读取数据三、L mbench套件介绍(一)原理和特色Lmbench 是一套简易可移植的,符合ANSI/C 标准为UNIX/POSIX 而制定的微型测评工具。

它主要测试部分包括文件读写、内存操作、进程创建销毁开销、网络等性能。

主要思路是在不同的存储区域之间移动数据,用以考核系统的性能。

其测试的主要包括:带宽(Bandwidth benchmarks)和延时(Latency benchmarks)。

(二)测试过程使用Linux性能测试套件Lmbench的步骤:1.到Lmbench官方网站上下载LMbench version 3.网址:/lmbench/get_lmbench.html2.解压文件并查看目录内容lmbench3/results内容。

3.修改只读文件lmbench3/src/Makefile修改该文件的第231行,避免在使用命令make的时候出错。

4.配置lmbench编译成功的话,就会出现一些选择提示以对测试进行配置并生成配置脚本。

后续的测试将使用该配置脚本,在以后测试中也能够直接使用同样的配置多次测试。

配置提示除了测试的内存范围(“MB [default 1792]”时,对内存较大的应该避免选择太大值,否则测试时间会很长)和是否Mail results 外,基本上都能够选择缺省值。

5.查看结果解释:此项是性能基本参数,其中Tlb pages是TLB(Translation Lookaside Buffer)的页面数,Cache line bytes为总线宽度,Scal load:并行的lmbench数。

解释:此项显示处理器、进程的操作时间。

Null call:简单系统调用(取进程号)。

Null I/O:简单IO操作(空读写的平均)。

Stat 取文档状态的操作。

Sig hndl:捕获处理信号。

Fork proc:Fork进程后直接退出。

Exec proc:Fork后执行execve调用再退出:Sh proc //Fork后执行shell 再退出。

解释:此项显示上下文切换的相关记录。

2p/16K表示2个并行处理16K大小的数据。

解释:本地通信传输延时,通过不同通信方式发送后自己立即读。

Pipe:管道通信。

TCP conn :TCP建立connect并关闭描述字。

解释:此项显示的是文件和虚拟系统传输延时。

File Create & Delete:创建并删除文档。

MMap Latency:内存映射。

100fd selct:对100个文档描述符配置select的时间。

解释:本地通信带宽。

TCP //TCP通信。

File reread:文档重复读。

MMap reread:内存映射重复读。

Mem read:内存读。

Mem write:内存写解释:内存操作延时(单位:毫秒)。

L1:缓存1。

L2:缓存2。

Main Mem。

连续内存。

Rand Mem:存随机访问延时。

6.在Makefile目录下生成文件,记录本次测试的详细结果。

Lmbench 根据配置文档执行测试项之后,在results目录下会根据系统类型、系统名和操作系统类型等生成一个子目录,测试结果文档(system name+序号)就存放于该目录下。

测试完毕执行make see 可查看到测试结果报告及其说明。

总结:Lmbench是一套微基准,可以用来分析不同操作系统的设定。

包括Lmbench在内的基准可以度量多种操作系统的例行程序,如上下文转换、本地通讯、内存带宽和文件操作。

Lmbench 使用很简单,只需要知道三个重要的命令。

✧make results:首次运行Lmbench时,它会提示系统配置的一些详细信息和哪些测试会被执行。

✧make rerun:在初始化配置并完成首次运行基准后,使用make rerun命令可以重复基准使用由make results提供的配置。

make see:在运行最少三次后,可以使用make see命令查看结果。

显示的结果可以被复制到制表软件用于后续分析或图形化展示。

四、使用其他工具测试Linux性能1.vmstat:监视内存vmstat命令可对操作系统的命令报告关于内核线程、虚拟内存、磁盘、陷阱和CPU 活动的统计信息进行监视。

如加上-s参数会显示系统初始化后调页事件的绝对计数:解释:其中,r:运行队列中的进程数,在一个稳定的工作量下应该少于5。

而b表示等待队列中的进程数(等待I/O),通常情况下是接近0的。

bi表示向一个块设备输出的块数量。

in:每秒发生的中断数量,包括时钟。

cs:每秒发生的context switches的数量。

us:非内核代码运行的时间(用户时间,包括nice时间)。

sy:内核代码运行的时间(系统时间)。

Wa显示的是等待I/O操作的时间。

1)显示详细的内核内存利用率2)显示内存页面信息,包括活跃和不活跃的内存页面3)将总数结构中的内容写入到标准输出,该结构包含从系统初始化后调页事件的绝对计数。

2.isostat:监视系统输入/输出设备负载iostat的特点是汇报磁盘活动统计情况,同时也会汇报出CPU使用情况。

它报告CPU统计信息和整个系统、适配器、tty 设备、磁盘和CD-ROM 的输入/输出统计信息。

解释:rrqm/s、wrqm/s:每秒进行merge 的读/写操作数目。

r/s、w/s:每秒完成的读/写I/O 设备次数。

avgrq-sz:平均每次设备I/O操作的数据大小(扇区)。

avgqu-sz:平均I/O队列长度。

Await:平均每次设备I/O操作的等待时间(毫秒)。

Svctm:平均每次设备I/O操作的服务时间(毫秒)。

其中,svctm 一般要小于await (因为同时等待的请求的等待时间被重复计算了),svctm 的大小一般和磁盘性能有关,CPU/内存的负荷也会对其有影响,请求过多也会间接导致svctm 的增加。

await 的大小一般取决于服务时间(svctm) 以及I/O 队列的长度和I/O 请求的发出模式。

如果svctm 比较接近await,说明I/O 几乎没有等待时间;如果await 远大于svctm,说明I/O 队列太长,应用得到的响应时间变慢。

如果响应时间超过了用户可以容许的范围,这时可以考虑更换更快的磁盘,调整内核elevator 算法,优化应用,或者升级CPU。

队列长度(avgqu-sz)也可作为衡量系统I/O 负荷的指标,但由于avgqu-sz 是按照单位时间的平均值,所以不能反映瞬间的I/O。

如果%util 接近100%,说明产生的I/O请求太多,I/O系统已经满负荷,该磁盘可能存在瓶颈。

3.使用sar进行综合查看sar命令是系统维护的重要工具,主要帮助我们掌握系统资源的使用情况,特别是内存和CPU 的使用情况。

它的特点是可以连续对系统取样,获得大量的取样数据。

sar是目前Linux 上最为全面的系统性能分析工具之一,可以从14个大方面对系统的活动进行报告,包括文件的读写情况、系统调用的使用情况、串口、CPU效率、内存使用状况、进程活动及IPC有关的活动等。

1)使用命令行sar –n –o result 5 2。

每5秒采样一次,连续采样2次,采样结果以二进形式存入当前目录下的文件result中。

在显示内容包括:%usr:CPU处在用户模式下的时间百分比。

%sys:CPU处在系统模式下的时间百分比。

%wio:CPU等待输入输出完成时间的百分比。

%idle:CPU空闲时间百分比。

其中,%wio的值过高,表示硬盘存在I/O瓶颈。

%idle值高,表示CPU较空闲,如果%idle 值高但系统响应慢时,有可能是CPU等待分配内存,此时应加大内存容量。

%idle值如果持续低于10,那么系统的CPU处理能力相对较低,表明系统中最需要解决的资源是CPU。

2)使用命令行sar -v 5 2。

观察核心表的状态。

3)使用命令行sar -v报告系统表的内容。

其中:file-sz:目前核心中正在使用或分配的文件表的表项数。

inod-sz:目前核心中正在使用或分配的i节点表的表项数。