mfs文件系统架构分析

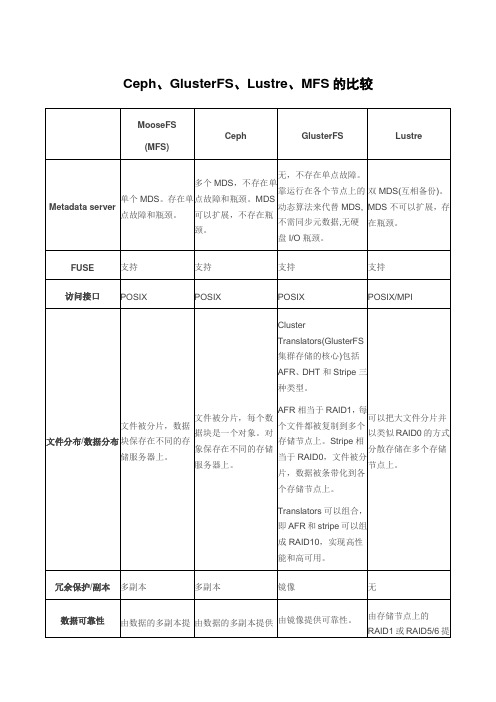

Ceph、GlusterFS、Lustre、MFS技术比较

Ceph、GlusterFS、Lustre、MFS的比较引言:开源存储软件Ceph和Gluster能够提供相似的特性并且能够为用户节省不小的开支。

那么谁更快?谁又更易用呢?开源的Ceph及Red Hat旗下的Gluster都是成熟的技术,但兴许不久之后就将经历某种重生了。

随着存储产业开始向扩展性存储及云的方向发展,将不断会有基于这些低价的软件技术的产品推向市场,而对这些自集成解决方案的补充在近一年来不断涌现。

Ceph与Gluster在原理上有着本质上的不同。

Ceph基于一个名为RADOS的对象存储系统,使用一系列API将数据以块(block)、文件(file)和对象(object)的形式展现。

Ceph存储系统的拓扑结构围绕着副本与信息分布,这使得该系统能够有效保障数据的完整性。

而Red Hat将Gluster描述为可扩展的网络存储设备(Scale-out NAS)和对象存储系统。

它使用一个哈希算法来计算数据在存储池中的存放位置,这点跟Ceph很类似。

并且这是保证扩展性的关键。

在Gluster中,所有的存储服务器使用哈希算法完成对特定数据实体的定位。

于是数据可以很容易的复制,并且没有中心元数据单点这样一个容易造成访问瓶颈的部分,这种单点在早期Hadoop上出现,对性能和可靠性造成较大影响。

Ceph与Gluster有着相似的数据分布能力。

Ceph像大多数对象存储软件那样,通过更大的节点集进行数据条带化处理。

这样的好处是能够防止数据访问的瓶颈效应。

因为默认的Ceph块比较小(仅为64KB),所以数据流被切分为许多随机的IO操作。

而磁盘在随机IO的时候一般能够达到最大值(对HDD而言最多达到150次每秒),并且这个数值不会随传输的数据大小改变多少。

所以对于Ceph而言,设置更大的IO 块意味着能够一次聚合传输更多的数据。

Gluster默认的块大小是128KB。

这是Red Hat声称在一项基准测试中Gluster的性能是Ceph的三倍的主要原因。

FastDFS架构分析

FastDFS一个高效的分布式文件系统FastDFS是一款类Google FS的开源分布式文件系统,它用纯C语言实现,支持Linux、FreeBSD、AIX等UNIX系统。

它只能通过专有API对文件进行存取访问,不支持POSIX接口方式,不能mount使用。

准确地讲,Google FS以及FastDFS、mogileFS、HDFS、TFS 等类Google FS都不是系统级的分布式文件系统,而是应用级的分布式文件存储服务。

FastDFS的设计理念FastDFS是为互联网应用量身定做的分布式文件系统,充分考虑了冗余备份、负载均衡、线性扩容等机制,并注重高可用、高性能等指标。

和现有的类Google FS分布式文件系统相比,FastDFS的架构和设计理念有其独到之处,主要体现在轻量级、分组方式和对等结构三个方面。

轻量级FastDFS只有两个角色:Tracker server和Storage server。

Tracker server作为中心结点,其主要作用是负载均衡和调度。

Tracker server在内存中记录分组和Storage server 的状态等信息,不记录文件索引信息,占用的内存量很少。

另外,客户端(应用)和Storage server访问Tracker server时,Tracker server扫描内存中的分组和Storage server信息,然后给出应答。

由此可以看出Tracker server非常轻量化,不会成为系统瓶颈。

FastDFS中的Storage server在其他文件系统中通常称作Trunk server或Data server。

Storage server直接利用OS的文件系统存储文件。

FastDFS不会对文件进行分块存储,客户端上传的文件和Storage server上的文件一一对应。

众所周知,大多数网站都需要存储用户上传的文件,如图片、视频、电子文档等。

出于降低带宽和存储成本的考虑,网站通常都会限制用户上传的文件大小,例如图片文件不能超过5MB、视频文件不能超过100MB等。

百度的分布式文件系统之路

MFS的问题和改进

• 问题 • Master元信息单点 • Master单线程性能瓶颈 • 修复与写入互斥

• 改进 • poll->epoll • 调大hash桶 • fuse调参

CCDB存储体系

Table

File

Object

Permission

Isolation

Priority

Replication

MFS

• 简介 • MFS是MooseFS的简称,是一个分布式网络文件系统, 将数据切片分散到多个存储设备上实现数据容错,可 以像本地文件系统一样进行挂载使用。

• 特点 • 类GFS的开源C实现 • 通用文件系统(POSIX支持) • 高易用性(Mount、Trash、Snapshot……)

MFS的读写流程

CCDB-NFS架构

• Master • 目录树 • 集群管理

• FileServer • 文件元信息 • 文件数据

CCDB-NFS链式复制

• 链式复制 • Primary最后Commit • 读Primary强一致 • 选主简化

CCDB-NFS的多租户支持

• User • Region • ACL • Quota

Recovery

Control

Table Engine

File Engine

KV Engine

Replica Block System

Raid-like Block System

Memory

SSD

Disk

Interface Platform Distributed Engine Block Hardware

AFS压缩支持

• DataNode透明压缩 • Client写入时压缩 • 分级压缩(LZ4/LZO->LZMA)

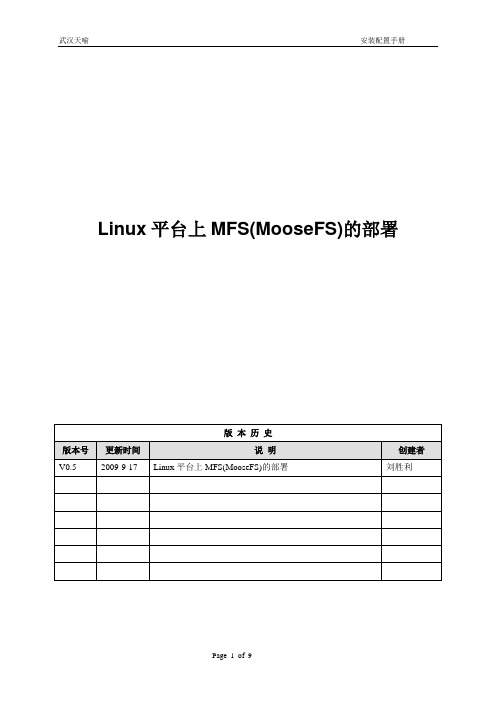

Linux平台上MFS(MooseFS)的部署v0.5

Linux平台上MFS(MooseFS)的部署目录1 概述 (3)2 实验环境 (3)3 安装和配置MFS Master (4)3.1 安装master (4)3.2 配置master (4)3.3 启动和停止master服务 (5)4 安装和配置ChunkServer (5)4.1 安装ChunkServer (5)4.2 配置ChunkServer (5)4.3 启动和停止ChunkServer服务 (6)5 安装和配置MFS Client (6)5.1 安装FUSE (6)5.2 安装MFS Client (7)5.3 使用MFS (7)5.4 设置副本数量 (7)5.5 设置空间回收时间 (8)6 破坏性测试 (9)6.1 测试数据存储服务器 (9)6.2 测试元数据服务器 (9)1 概述MFS(MooseFS)是一个Linux/Unix平台上开源的分布式文件系统。

它可以把文件复制成多份(如3份)分别放置在多个数据服务器(ChunkServer)上,实现文件的冗余。

而且可以动态的增加ChunkServer,实现动态存储容量扩展,甚至可以支持PB级的存储容量。

2 实验环境●硬件和软件环境:✓PC:Intel(R) Core(TM)2 Quad CPU Q9550@ 2.83GHz, 8G RAM✓OS: CentOS 5.2 (x86_64), Kernel: 2.6.18-92.el5xen✓MFS: MooseFS v1.5.12表2-1 安装MFS所需软件列表3 安装和配置MFS Master3.1 安装master●创建用户# useradd mfs -s /sbin/nologin●安装master# tar xvzf mfs-1.5.12.tar.gz# cd mfs-1.5.12# ./configure --prefix=/usr/local/mfs --with-default-user=mfs --with-default-group=mfs # make# make install3.2 配置master●创建目录# mkdir -p /var/run/mfs# chown mfs:mfs /var/run/mfs●更改配置文件/usr/local/mfs/etc/mfsmaster.cfg:#WORKING_USER = mfs#WORKING_GROUP = mfs#LOCK_FILE = /var/run/mfs/mfsmaster.pid#DATA_PATH = /usr/local/mfs/var/mfs#SYSLOG_IDENT = mfsmaster#BACK_LOGS = 50#REPLICATIONS_DELAY_INIT = 300#REPLICATIONS_DELAY_DISCONNECT = 3600#MATOCS_LISTEN_HOST = *#MATOCS_LISTEN_PORT = 9420#MATOCU_LISTEN_HOST = *#MATOCU_LISTEN_PORT = 9421#CHUNKS_LOOP_TIME = 300#CHUNKS_DEL_LIMIT = 100#CHUNKS_REP_LIMIT = 153.3 启动和停止master服务●启动master服务# /usr/local/mfs/sbin/mfsmaster start●停止master服务# /usr/local/mfs/sbin/mfsmaster -s●查看master日志/var/log/messages# tail -f /var/log/messages4 安装和配置ChunkServer4.1 安装ChunkServer●创建用户# useradd mfs -s /sbin/nologin●安装ChunkServer# tar xvzf mfs-1.5.12.tar.gz# cd mfs-1.5.12# ./configure --prefix=/usr/local/mfs --with-default-user=mfs --with-default-group=mfs # make# make install4.2 配置ChunkServer●创建目录# mkdir -p /var/run/mfs# chown mfs:mfs /var/run/mfs●创建共享存储的挂载点,建议分配整个磁盘分区# mount /dev/xvdb1 /data# chown mfs:mfs /data●更改配置文件/usr/local/mfs/etc/mfschunkserver.cfg:#WORKING_USER = mfs#WORKING_GROUP = mfs#DATA_PATH = /usr/local/mfs/var/mfs#LOCK_FILE = /var/run/mfs/mfschunkserver.pid#SYSLOG_IDENT = mfschunkserver#BACK_LOGS = 50#MASTER_RECONNECTION_DELAY = 30MASTER_HOST = 10.8.2.41MASTER_PORT = 9420#MASTER_TIMEOUT = 60#CSSERV_LISTEN_HOST = *#CSSERV_LISTEN_PORT = 9422#CSSERV_TIMEOUT = 60#CSTOCS_TIMEOUT = 60#HDD_CONF_FILENAME = /usr/local/mfs/etc/mfshdd.cfg●更改配置文件/usr/local/mfs/etc/mfshdd.cfg, 增加文件系统挂载点:/data1/data2注意:配置的挂载点必须让mfs用户有读写权限,如没有,用如下命令赋权限:# chown mfs:mfs /data14.3 启动和停止ChunkServer服务●启动chunkserver服务# /usr/local/mfs/sbin/mfschunkserver start●停止chunkserver服务# /usr/local/mfs/sbin/mfschunkserver -s●查看chunkserver日志/var/log/messages# tail -f /var/log/messages5 安装和配置MFS Client5.1 安装FUSE●增加环境变量并使其生效export PKG_CONFIG_PATH=/usr/local/lib/pkgconfig:$PKG_CONFIG_PATHexport LD_LIBRARY_PATH=$LD_LIBRARY_PATH:/usr/local/lib:.export PATH=$PATH:/usr/local/mfs/bin:.●安装fuse# tar xvzf fuse-2.7.4.tar.gz# cd fuse-2.7.4# ./configure# make# make install5.2 安装MFS Client●创建用户# useradd mfs -s /sbin/nologin●安装MFS Client# tar xvzf mfs-1.5.12.tar.gz# cd mfs-1.5.12# ./configure --prefix=/usr/local/mfs --with-default-user=mfs --with-default-group=mfs --enable-mfsmount# make# make install5.3 使用MFS●如果报错fuse: device not found, 请先fuse mount.# modprobe fuse●挂载MFS文件系统# mkdir /mfsdata# /usr/local/mfs/bin/mfsmount -h 10.8.2.41 -w /mfsdata●使用MFS# dd if=/dev/urandom of=/mfsdata/test.dat bs=1M count=200# md5sum /mfsdata/test.dat522c27c45064c2d0463c168593f5bead /mfsdata/test.dat5.4 设置副本数量●查看目录现在的副本数量:# mfsgetgoal /mfsdata/mfsdata: 1# mfsfileinfo /mfsdata/test.dat/mfsdata/test.dat:chunk 0: 0000000000000013_00000004 / (id:19 ver:4)copy 1: 10.8.2.44:9422chunk 1: 0000000000000014_00000003 / (id:20 ver:3)copy 1: 10.8.2.42:9422chunk 2: 0000000000000015_00000003 / (id:21 ver:3)copy 1: 10.8.2.42:9422chunk 3: 0000000000000016_00000001 / (id:22 ver:1)copy 1: 10.8.2.42:9422●更改目录现在的副本数量:# mfsrsetgoal 3 /mfsdata/mfsdata/:inodes with goal changed: 3 (3)inodes with goal not changed: 0 (0)inodes with permission denied: 0 (0)●查看更改后目录的副本数量:# mfsgetgoal /mfsdata/mfsdata: 3# mfsfileinfo /mfsdata/test.dat/mfsdata/test.dat:chunk 0: 0000000000000013_00000004 / (id:19 ver:4)copy 1: 10.8.2.42:9422copy 2: 10.8.2.43:9422copy 3: 10.8.2.44:9422chunk 1: 0000000000000014_00000003 / (id:20 ver:3)copy 1: 10.8.2.42:9422copy 2: 10.8.2.43:9422copy 3: 10.8.2.44:9422chunk 2: 0000000000000015_00000003 / (id:21 ver:3)copy 1: 10.8.2.42:9422copy 2: 10.8.2.43:9422copy 3: 10.8.2.44:9422chunk 3: 0000000000000016_00000001 / (id:22 ver:1)copy 1: 10.8.2.42:9422copy 2: 10.8.2.43:9422copy 3: 10.8.2.44:94225.5 设置空间回收时间●查看目录当前回收时间:# mfsgettrashtime /mfsdata/mfsdata: 86400●设置目录当前回收时间为600秒:# mfsrsettrashtime 600 /mfsdata/mfsdata:inodes with trashtime changed: 3 (3)inodes with trashtime not changed: 0 (0)inodes with permission denied: 0 (0)●查看更改后空间回收时间:# mfsgettrashtime /mfsdata/mfsdata: 6006 破坏性测试6.1 测试数据存储服务器现在用4个服务器组成了MFS的存储平台,其中一个是master,其余三个服务器是chunkserver.先停止一个chunkserver服务,然后在某个MFS客户端往挂接点的目录(/mfsdata)里复制数据或者创建目录/文件、或者读取文件、或者删除文件,观察操作是否能正常进行。

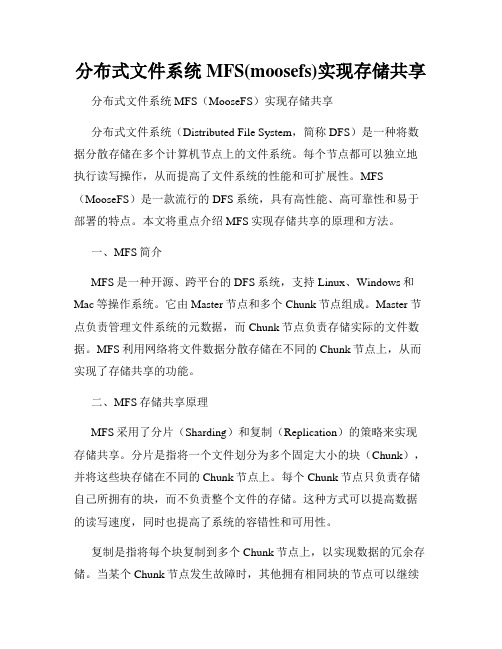

分布式文件系统MFS(moosefs)实现存储共享

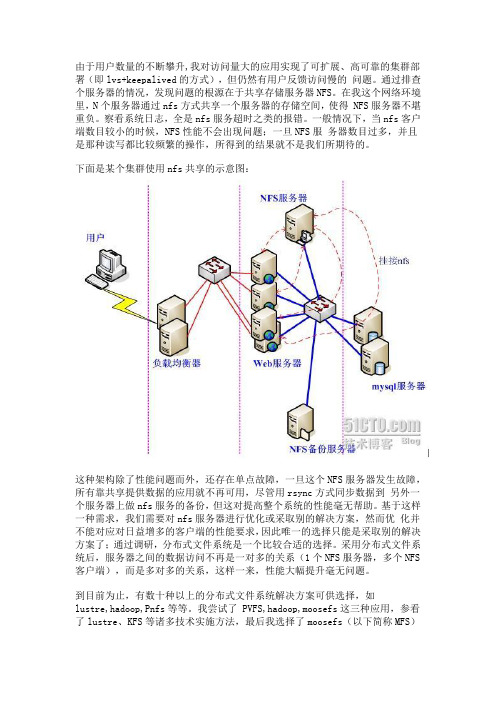

由于用户数量的不断攀升,我对访问量大的应用实现了可扩展、高可靠的集群部署(即lvs+keepalived的方式),但仍然有用户反馈访问慢的问题。

通过排查个服务器的情况,发现问题的根源在于共享存储服务器NFS。

在我这个网络环境里,N个服务器通过nfs方式共享一个服务器的存储空间,使得 NFS服务器不堪重负。

察看系统日志,全是nfs服务超时之类的报错。

一般情况下,当nfs客户端数目较小的时候,NFS性能不会出现问题;一旦NFS服务器数目过多,并且是那种读写都比较频繁的操作,所得到的结果就不是我们所期待的。

下面是某个集群使用nfs共享的示意图:这种架构除了性能问题而外,还存在单点故障,一旦这个NFS服务器发生故障,所有靠共享提供数据的应用就不再可用,尽管用rsync方式同步数据到另外一个服务器上做nfs服务的备份,但这对提高整个系统的性能毫无帮助。

基于这样一种需求,我们需要对nfs服务器进行优化或采取别的解决方案,然而优化并不能对应对日益增多的客户端的性能要求,因此唯一的选择只能是采取别的解决方案了;通过调研,分布式文件系统是一个比较合适的选择。

采用分布式文件系统后,服务器之间的数据访问不再是一对多的关系(1个NFS服务器,多个NFS 客户端),而是多对多的关系,这样一来,性能大幅提升毫无问题。

到目前为止,有数十种以上的分布式文件系统解决方案可供选择,如lustre,hadoop,Pnfs等等。

我尝试了 PVFS,hadoop,moosefs这三种应用,参看了lustre、KFS等诸多技术实施方法,最后我选择了moosefs(以下简称MFS)这种分布式文件系统来作为我的共享存储服务器。

为什么要选它呢?我来说说我的一些看法:1、实施起来简单。

MFS的安装、部署、配置相对于其他几种工具来说,要简单和容易得多。

看看lustre 700多页的pdf文档,让人头昏吧。

2、不停服务扩容。

MFS框架做好后,随时增加服务器扩充容量;扩充和减少容量皆不会影响现有的服务。

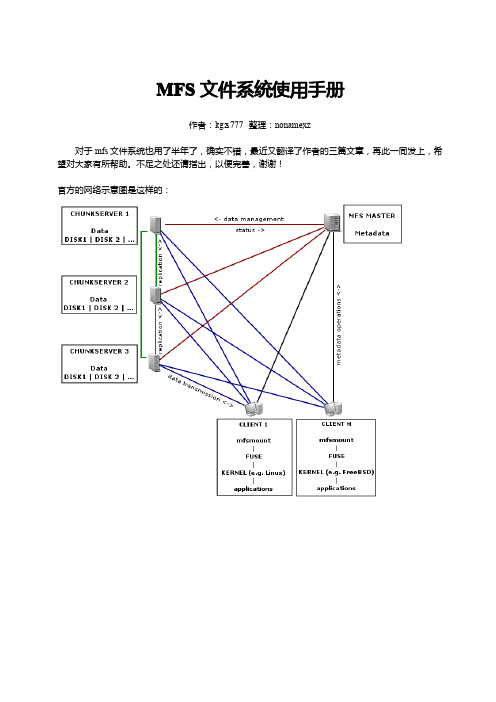

mfs文件系统使用手册

MFS文件系统使用手册作者:ltgz s777整理:nonamexz对于mfs文件系统也用了半年了,确实不错,最近又翻译了作者的三篇文章,再此一同发上,希望对大家有所帮助。

不足之处还请指出,以便完善,谢谢!官方的网络示意图是这样的:MFS 文件系统结构:具体的实例安装和配置元数据服务(master server )安装元数据服务角色角色作用管理服务器managing server (master)负责各个数据存储服务器的管理,文件读写调度,文件空间回收以及恢复.多节点拷贝元数据日志服务器Metalogger server (Metalogger )负责备份master 服务器的变化日志文件,文件类型为changelog_ml.*.mfs ,以便于在master server 出问题的时候接替其进行工作数据存储服务器data servers (chunkservers)负责连接管理服务器,听从管理服务器调度,提供存储空间,并为客户提供数据传输.客户机挂载使用client computers 通过fuse 内核接口挂接远程管理服务器上所管理的数据存储服务器,.看起来共享的文件系统和本地unix 文件系统使用一样的效果.mfsmaster.cfg的配置配置文件位于安装目录/usr/local/mfs/etc,需要的配置文件有两个:mfsmaster.cfg和mfsexports.cfg,mfsmaster.cfg是主配置文件,mfsexports.cfg是被挂接目录及权限设置。

需要注意的是,凡是用#注释掉的变量均使用其默认值。

以上是对master server的mfsmaster.cfg配置文件的解释,对于这个文件不需要做任何修改就可以工作。

mfsexports.cfg的配置该文件每一个条目分为三部分:第一部分:客户端的ip地址第二部分:被挂接的目录第三部分:客户端拥有的权限地址可以指定的几种表现形式:*所有的ip地址n.n.n.n单个ip地址n.n.n.n/b IP网络地址/位数掩码n.n.n.n/m.m.m.m IP网络地址/子网掩码f.f.f.f-t.t.t.t IP段目录部分需要注意两点:/标识MooseFS根;.表示MFSMETA文件系统权限部分:ro只读模式共享rw读写的方式共享alldirs许挂载任何指定的子目录maproot映射为root,还是指定的用户password指定客户端密码启动master servermaster server可以单独启动(所谓单独启动就是在没有数据存储服务器(chunkserver)的时候也可以启动,但是不能存储,chunkserver启动后会自动的加入)。

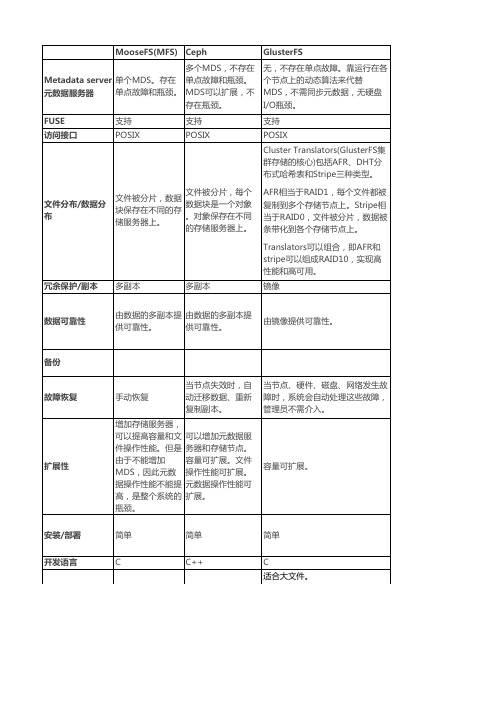

分布式文件系统MFS、Ceph、GlusterFS、Lustre的比较

文件被分片,每个 文件被分片,数据 数据块是一个对象 块保存在不同的存 。对象保存在不同 储服务器上。 的存储服务器上。

AFR相当于RAID1,每个文件都被 复制到多个存储节点上。Stripe相 当于RAID0,文件被分片,数据被 条带化到各个存储节点上。 Translators可以组合,即AFR和 stripe可以组成RAID10,实现高 性能和高可用。

可增加存储节点,提 高容量可文件操作性 能,但是由于不能增 加MDS,因此元数 据操作性能不能提 高,是整个系统的瓶 颈。 复杂。而且Lustre严 重依赖内核,需要重 新编译内核。 C

大文件读写

大文件读写

重型 HPC领域。

很成熟、很庞大。

故障恢复

手动恢复 增加存储服务器, 可以提高容量和文 件操作性能。但是 由于不能增加 MDS,因此元数 据操作性能不能提 高,是整个系统的 瓶颈。 简单 C

扩展性

容量可扩展。

安装/部署 开发语言

简单 C++

简单 C 适合大文件。

适合场景

大量小文件读写

小文件

适合场景

大量小文件读写

小文件

对于小文件,无元数据服务设计解 决了元数据的问题。但GlusterFS 并没有在I/O方面作优化,在存储 服务器底层文件系统上仍然是大量 小文件,本地文件系统元数据访问 是瓶颈,数据分布和并行性也无法 充分发挥作用。因此,GlusterFS 的小文件性能还存在很大优化空间 。 中型 较多用户使用 无元数据服务器,堆栈式架构(基 本功能模块可以进行堆栈式组合, 实现强大功能)。具有线性横向扩 展能力。 由于没有元数据服务器,因此增加 了客户端的负载,占用相当的CPU 和内存。 但遍历文件目录时,则实现较为复 杂和低效,需要搜索所有的存储节 点。因此不建议使用较深的路径。

mfs 预研遇到问题及解决办法

metalogger 进程: /usr/sbin/mfsmetalogger start

客户端挂载mfsmount: /usr/bin/mfsmount /mnt/mfs -H mfsmaster

运行CGI 监控服务/usr/sbin/mfscgiserv,这样就可以用浏览器查看整个MooseFS 的运行情况:

为了安全停止MooseFS 集群,建议执行如下的步骤:

停止chunk server 进程: /usr/sbin/mfschunkserver -s

停止 metalogger 进程: /usr/sbin/mfsmetalogger -s

在所有客户端用Unmount 命令先卸载文件系统(本例将是: umount /mnt/mfs)

解决办法:

#export PKG_CONFIG_PATH=$PKG_CONFIG_PATH:/usr/local/lib/pkgconfig

5、问题:卸载已挂载的文件系统

umount: /mnt/mfs: device is busy.

(In some cases useful info about processes that use

解决办法:

That folder was owned by 'nobody' instead of my user.

That's why you couldn't do anything with it.

I have changed the ownership of it, so you should be good to go

MooseFS文件系统

MooseFS正式的推出是在2008-05-30,到2009-01-28为止,最新的版本是1.5.12。

MFS是一款网络分布式文件系统。

它把数据分散在多台服务器上,但对于用户来讲,看到的只是一个源。

MFS也像其他类unix文件系统一样,包含了层级结构(目录树),存储着文件属性(权限,最后访问和修改时间),可以创建特殊的文件(块设备,字符设备,管道,套接字),符号链接,硬链接。

MFS的区别特征:高可用性(数据在不同的服务器上会有多分的拷贝)只需要通过添加新的服务器或者硬盘就可以做到动态的扩展可以再一个规定的时期保存执行了删除操作的文件可以创建文件的快照,保证文件在被使用的时候,整个文件的副本都是一致的MFS组成包括了三部分:管理服务器(master),单独的一台服务器,用来管理整个文件系统,存储每个文件的元数据(文件大小,文件属性,文件所在位置的这些信息),包含了所有非规则文件的全部信息,如文件夹,套接字设备,管道设备数据服务(chunkservers),任何数量的可用的服务器。

一个文件会在这些服务器上存储多份。

客户端,任何一种可以支持FUSE的服务器,服务器上会运行mfsmount进程,直接和管理服务器通信,用来接收和修改文件的信息,同时和块服务器交换真实的文件数据元数据存储在Master的内存中,同时会保存一份在硬盘上(作为临时更新的二进制文件和立即更新的增量日志方式)数据文件被分成64Mb大小的块,每个块被分散的存储在块服务器的硬盘上,同时块服务器上还会存储其他块服务器上块文件的副本。

客户端只需要mount上MFS就可像操作其他文件系统的文件一样操作MFS中的文件了。

操作系统的内核把对文件的操作传递给FUSE模块,这个模块用来和mfsmount进程进行通信。

mfsmount进程后续通过网络和管理服务器和数据块服务器进行通信。

整个过程对用户来讲是透明的。

在对所有元数据文件。

(文件创建,文件删除,读文件夹,读取和更改属性,改变文件大小等等涉及到在MFSMETA上的特殊文件)进行操作的过程中,mfsmount 和管理服务器建立通信,然后开始读取和写入数据。

MFS知识大汇总

MFS知识大汇总文档修改历史记录一、MFS介绍: (4)二、System Architecture(系统架构) (5)三、MFS各节点介绍 (5)3.1 管理服务器managing server (master) (5)3.2 元数据日志服务器Metalogger server(Metalogger) (8)3.3 数据存储服务器data servers (chunkservers) (9)3.4 MFS的client (10)四、MFS的安装全过程 (11)4.1安装和配置元数据服务(master server) (11)4.2 安装和配置元数据日志服务器(metalogger) (13)4.3 安装配置数据存储服务器(chunkserver) (15)4.4 MFS客户端的安装及配置 (17)五、MFS读写性能与总结: (18)5.1 简单测试结果: (18)5.2 总结规律: (19)5.3 常见问题问答 (19)六、灾难测试、恢复及测试总结 (20)6.1、client 机器无论怎样操作都不会影响master。

(20)6.2、关机及重启不用修复 (20)6.3、启动顺序 (20)6.4、整个mfs体系中,直接断电只有master有可能无法启动。

(21)6.5、chunker的维持:chunker的块(chunks)能够自动复制或删除 (21)6.6、chunks修复:mfsfilerepair (22)6.7、chunker的空间 (23)6.8、快照snapshot (24)6.9、回收站trash bin (25)6.10、文件描述符 (25)五、监控与报警 (25)MFS知识大汇总一、MFS介绍:Distinctive features of MooseFS are:MooseFS优越特性如下:- higher reliability (data can be stored in several copies on separate computers) 高可用性(数据可以存储在多个机器上的多个副本)- dynamically expanding disk space by attaching new computers/disks可动态扩展随时新增加机器或者是磁盘- possibility of storing deleted files for a defined period of time ("trash bin" service on a file system level)可回收在指定时间内删除的文件(“垃圾回收站”是一个系统级别的服务)- possibility of creating snapshot of a file, which means coherent copy of the whole file, even while the file is being written.可以对整个文件甚至在正在写入的文件创建文件的快照。

FreeBSD目录结构

1、FreeBSD下的分区:

一般来说,都分为以下几个区:

分区

文件系统 大小 描述

a / 100 MB 这是一个根文件系统(root filesystem)。任何其它的文件系统都会挂在根目录(译注:用根目录比较亲切)下面。 100 MB 对于要目录来说是合理的大小,因为您往后并不会在这里存放太多的数据;在安装FreeBSD后会 用掉约 40 MB 的根目录空间。剩下的空间是用来存放临时文件用的,同时,您也应该预留一些空间,因为以后的FreeBSD版本可能会需要较多的 /(根目录)空间。

b N/A 2-3 x RAM 此分区为系统磁盘交换分区(swap space)。选择正确的交换空间大小可是一门学问唷。一般来说,交换空间的大小应该是您系统上内存(RAM)大小的2到3倍。交换空间至少要有 64 MB 因此,如果您的电脑上的RAM比 32 MB 小,请将交换空间大小设为 64 MB。

/usr/X11R6/ 存放 X11R6 可执行文件、 库文件、 配置文件等的目录(可选)。

/var/ 存放多用途记录、临时性、短期的和打印假脱机系统文件.

/var/log/ 存放各种的系统记录文件。

/var/mail/ 存放用户mailbox(一种邮件存放格式)文件。

/var/spool/ 各种打印机和邮件系统spooling(回环)的目录。

/sbin/ 在单个用户和多用户环境下的存放系统程序和管理所需的基本实用目录。

/stand/ 持久独一无二的程序环境。

/tmp/ 存放临时文件,通常存放一些系统重启后不需要保护的 mfs(8) 基于内存的文件系统。

/usr/ 存放大多数用户的应用软件。

MFS文件系统用户手册

关闭底层的设备驱动程序。 示例:

该示例演示卸载 MFS1 设备上的文件系统。 error_code=_io_msf_uninstall(“MFS1:”);

3. _io_part_mgr_install 功能:在存储设备上安装分区管理驱动 原型: int_32 _io_part_mgr_install

功能:安装 MFS 文件系统

函数原型:

uint_32 _io_mfs_install

(

MQX_FILE_PTR dev_fd,

/*[IN] the device on which to install MFS */

char_ptr identifier, /*[IN] the name that should be given to mfs (ex: "C:", "MFS1:",

上一些字符构成完整文件名,这就要求 open_type_ptr 指定的文件名后面还至少有 15 个字节未用的空间;而且 open_type_ptr 指定的文件名不能以’\’或’/’结尾

示例: 下面的例子首先打开一个设备驱动(MFS 在其上运行),然后打开该设备上存储的文件,做 一些文件操作,最后关闭文件

返回值: 成功时返回指向被打开文件或设备的指针,失败时返回 NULL

说明: 这个函数是一个通用函数,不仅用于 MFS 文件系统,它同样可以用于打开任何硬件设

备,比如串口,I2C,SPI 等等。在 MFS 文件系统中该函数可以用于打开底层存储设备(如 SD 卡)的驱动程序,也可以用于打开分区管理驱动程序,还可以打开存储设备上的一个文 件。

MFS学习总结_jluzc

MFS学习总结jluzc 2012.11.13∙MFS概述、特性和新版改进∙MFS 工作原理和设计架构∙MFS的安装、部署、配置∙MFS的高级特性∙MFS的性能测试∙MFS集群的维护∙MFS的常见问题和建议对策一、MFS概述、特性和新版改进MooseFS是一个分布式存储的框架,其具有如下特性:1. Free(GPL)2. 通用文件系统,不需要修改上层应用就可以使用(那些需要专门api的dfs很麻烦!)。

3. 可以在线扩容,体系架构可伸缩性极强。

(官方的case可以扩到70台了!)4. 部署简单。

(sa们特别高兴,领导们特别happy!)5. 高可用,可设置任意的文件冗余程度(提供比raid1+0更高的冗余级别,而绝对不会影响读或者写的性能,只会加速!)6. 可回收在指定时间内删除的文件(“回收站”提供的是系统级别的服务,不怕误操作了,提供类似oralce 的闪回等高级dbms的即时回滚特性!)7. 提供netapp,emc,ibm等商业存储的snapshot特性。

(可以对整个文件甚至在正在写入的文件创建文件的快照)8. google filesystem的一个c实现。

9. 提供web gui监控接口。

10. 提高随机读或写的效率(有待进一步证明)。

11. 提高海量小文件的读写效率(有待进一步证明)。

MooseFS 1.6版本改进:∙修复1.5.x中在大批量操作时打开文件过多的bug。

报的错误说是打开的文件过多,造成chunker server的链接错误。

在1.6.x中解决此问题,就解决了很大的问题。

∙新增加了masterlogger服务器。

这是在1.5.x中所没有的,就是做了master服务器的冗余,进一步的加强的maste r服务器的稳定性。

在mfs体系中master是要求最稳定以及性能要求最高的,因此务必保证master的稳定。

∙修改1.5.x中存在的对于坏块的修复功能。

在mfs1.5.x中遇到chunker坏块校验,错误比较多的时候导致master将出现坏块的chunker自动的剔除出去的情况,此次增加了对坏块的修复功能,很方便的进行修复,简化对坏块的处理功能。

分布式文件系统MFS(moosefs)实现存储共享

分布式文件系统MFS(moosefs)实现存储共享分布式文件系统MFS(MooseFS)实现存储共享分布式文件系统(Distributed File System,简称DFS)是一种将数据分散存储在多个计算机节点上的文件系统。

每个节点都可以独立地执行读写操作,从而提高了文件系统的性能和可扩展性。

MFS (MooseFS)是一款流行的DFS系统,具有高性能、高可靠性和易于部署的特点。

本文将重点介绍MFS实现存储共享的原理和方法。

一、MFS简介MFS是一种开源、跨平台的DFS系统,支持Linux、Windows和Mac等操作系统。

它由Master节点和多个Chunk节点组成。

Master节点负责管理文件系统的元数据,而Chunk节点负责存储实际的文件数据。

MFS利用网络将文件数据分散存储在不同的Chunk节点上,从而实现了存储共享的功能。

二、MFS存储共享原理MFS采用了分片(Sharding)和复制(Replication)的策略来实现存储共享。

分片是指将一个文件划分为多个固定大小的块(Chunk),并将这些块存储在不同的Chunk节点上。

每个Chunk节点只负责存储自己所拥有的块,而不负责整个文件的存储。

这种方式可以提高数据的读写速度,同时也提高了系统的容错性和可用性。

复制是指将每个块复制到多个Chunk节点上,以实现数据的冗余存储。

当某个Chunk节点发生故障时,其他拥有相同块的节点可以继续提供服务,从而保证数据的可靠性和可用性。

MFS可以根据用户的需求设置块的复制数,以权衡系统的性能和容错性。

三、MFS存储共享方法在使用MFS实现存储共享时,需要按照以下步骤进行配置和操作:1. 安装和配置MooseFS首先,需要在每个节点上安装MooseFS软件,并进行必要的配置。

在Master节点上,需要指定Chunk节点的IP地址和端口号,以及元数据的存储路径。

在Chunk节点上,需要指定Master节点的IP地址和端口号。

第八章 分布式文件系统MooseFS

master <-> metaloggers module: listen on *:9419

master <-> chunkservers module: listen on *:9420

main master server module: listen on *:9421

# deprecated, to be removed in MooseFS 1.7

# LOCK_FILE = /var/run/mfs/mfsmetalogger.lock

启动元数据日志服务器

[root@mytest2 etc]# /usr/local/mfs/sbin/mfsmetalogger start

#元数据日志服务器运行时在系统日志输出的标识。

# SYSLOG_IDENT = mfsmetalogger

# LOCK_MEMORY = 0

# NICE_LEVEL = -19

#从元数据服务器(master)抓回文件,然后进行存放的路径。

# DATA_PATH = /usr/local/mfs/var/mfs

#存放备份日志的总个数为50并轮转。

# BACK_LOGS = 50

#元数据备份文件下载请求频率。默认为24小时。即每隔1天从源数据服务器下载一个metadata.mfs.back文件。当元数据服务器关闭或者出现故障的时候,此文件消失。如果要恢复

整个MFS,则需从元数据日志服务器取得该文件。请特别注意这个文件,它与日志文件一起,才能够恢复整个被破坏的分布式文件系统。

mfsmaster daemon initialized properly

计算机网络体系结构及协议之应用层

3.5.4应⽤层 应⽤层也称为应⽤实体(AE),它由若⼲个特定应⽤服务元素(SASE)和⼀个或多个公⽤应⽤服务元素(CASE)组成。

每个SASE提供特定的应⽤服务,例如⽂件传输访问和管理(FTAM、电⼦⽂电处理系统(MHS)、虚拟终端协议(VTP)等。

CASE提供⼀组公⽤的应⽤服务,例如联系控制服务元素(ACSE)、可靠传输服务元素(RTSE)和远程操作服务元素(ROSE)等。

1.⽂件传输、访问和管理(FTAM)功能 FTAM是⼀个⽤于传输、访问和管理开放系统中⽂件的⼀个信息标准。

FTAM服务使⽤户即使不了解所使⽤的实际⽂件系统的实现细节,也能对该⽂件系统进⾏操作,或对数据的描述进⾏维护。

⼀个具有通⽤⽬的的⽂件传输协议必须考虑异种机的环境,因为不同的系统可能有不同的⽂件格式和结构。

对于M种本地⽂件结构和N种输⼊⽂件结构来说,为了避免M×N种可能的不同⽂件结构之间的映射、转换问题,可以采⽤⼀种虚拟⽂件的⽅案。

该⽅案制定了⼀个通⽤的虚拟⽂件结构,使⽂件传输系统中交换的只是虚拟⽂件,⽽在端系统则对虚拟⽂件格式和本地⽂件格式实施⼀种局部的转换。

虚拟⽂件可以组成⼀个虚拟⽂件库,虚拟⽂件库模型是盯剧的基础。

FTAM定义了⼀系列⽤户服务原语,⽤以实现⽂件库的有关操作。

2.电⼦邮件功能 电⼦邮件是允许终端⽤户编辑⽂电并交换⽂电的⼀种设施。

这种服务是邮政发展的主要⽅向,是⼀种新的分布式综合⽂电处理系统,它可分为单系统电⼦邮件和络电⼦邮件两类。

在单系统电⼦邮件中,允许⼀个共享计算机系统上的所有⽤户交换⽂电。

每个⽤户在系统上登记,并有惟⼀的标识符,与每个⽤户相联系的是⼀个邮箱。

⽤户可以调⽤电⼦邮箱设施,准备⽂电,并把它发给此系统上的任何其它⽤户。

邮箱实际上是由⽂件管理系统维护的⼀个⽂件⽬录,每个邮箱有⼀个⽤户与之相联。

任何输⼊信件只是简单地作为⽂件存放于⽤户邮箱⽬录之下,⽤户可以取出并阅读这个⽂电。

在单系统电⼦邮件设施中,⽂电只能在特定系统的⽤户之间交换。

MooseFS分析

MooseFS分析点滴云1.官方说明1.1. 关于MooseFSMooseFS是一个容错的网络分布式文件系统。

将数据分散在多个物理服务器中,但对于用户其实是作为一个可见资源。

对于标准的文件操作MooseFS充当类似Unix操作系统中的文件系统:1、层次结构(目录树)2、POSIX文件存储属性(权限,最后访问和修改时间)3、支持特殊文件(块设备和字符设备,管道和套接字)4、符号链接(指向目标文件的文件指针,目标文件不一定在MooseFS 上)和硬链接(MooseFS相同的数据文件可以有不同的文件名)5、提供基于IP地址和/或密码两种方式,实现文件系统的授权访问1.2. MooseFS的特性1、高可靠性(分布在不同的电脑,可以存储的数据的多个副本拷贝)2、通过安装新的计算机/磁盘容量进行动态扩展3、删除的文件保留一个可配置的一段时间内(文件系统级别的“垃圾桶”)4、在文件被读写时都能保持的一致性快照1.3. 体系架构MooseFS由四部分组成:管理服务器(master server):单机管理整个文件系统,存储为每个文件元数据(大小,属性和文件的位置信息,包括非常规文件的所有信息,例如目录,插座,管道和设备等)。

数据服务器(chunk servers):任何数量的数据服务器上存储文件的数据,并且同步数据(如果某文件在一个以上的服务器上存在的话)。

元数据备份服务器(metalogger server):任何数量的服务器,所有这些存储元数据变动记录,定期下载主元数据文件;用于主服务器宕机后,提升管理服务器的有效价值。

访问MooseFS中文件的客户机:任意数量的机器,使用mfsmount 过程与管理服务器进行通信(接收和修改文件元数据)和块服务器(实际的文件数据交换)。

mfsmount是基于FUSE机制(文件系统用户空间的),所以MooseFS针对所有采用FUSE实现机制的操作系统(Linux, FreeBSD, MacOS X等)都是有效的。

开源文件系统对比

开源分布式文件系统对比MogileFS (2)简介 (2)组成 (2)特性 (3)局限性 (4)开发语言 (4)主页及资源 (4)MooseFS (4)简介 (4)组成 (5)特性 (5)局限性 (5)开发语言 (6)主页及资源 (6)Hadoop (6)简介 (6)组成 (6)特性 (6)局限性 (7)开发语言 (7)主页及资源 (7)CloudStore (7)简介 (7)组成 (7)特性 (7)局限性 (8)开发语言 (8)主页及资源 (8)其他的开源文件系统: (9)Ceph (9)FastDFS (9)Hypertable (9)MogileFS简介MogileFS是一种分布式文件存储系统。

可支持文件自动备份的功能,提供高可用性和高可扩展性。

组成1、数据库部分数据库保存了Mogilefs的所有元数据,一般使用MySQL,可以单独拿数据库服务器来做,也可以跟其他程序跑在一起。

可以用mogdbsetup程序来初始化数据库。

数据库部分非常重要,因为一个MogileFS系统的所有Tracker都必须指向同一个数据库,因此如果数据库出现问题,那么整个MogileFS系统将处于不可用状态,因此数据库最好采用HA结构,如MySQL主从复制架构,这样可以降低数据库出现问题对MogileFS系统的影响。

2、跟踪器(Tracker)mogilefsd即trackers程序,类似mogilefs的wiki上介绍,trackers做了很多工作,主要有以下几个:* Replication:机器间复制文件* Deletion:从命名空间删除是立即的,从文件系统删除是异步的* QueryWorker:响应客户端的请求* Reaper:在磁盘失败后将文件复制请求重新放到队列中* Monitor:监测主机和设配的健康度和状态Tracker是访问MogileFS的入口,所有系统管理相关的操作都要通过其中的某个trackers完成,应用系统的一些操作也要通过trackers,因此一个高业务量的MogileFS系统最好同时运行多个trackers来做负载均衡。

Jhr分布式文件系统MooseFS

分布式文件系统MFS(moosefs)实现存储共享作者:田逸()由于用户数量的不断攀升,我对访问量大的应用实现了可扩展、高可靠的集群部署(即lvs+keepalived的方式),但仍然有用户反馈访问慢的问题。

通过排查个服务器的情况,发现问题的根源在于共享存储服务器NFS。

在我这个网络环境里,N个服务器通过nfs方式共享一个服务器的存储空间,使得NFS服务器不堪重负。

察看系统日志,全是nfs服务超时之类的报错。

一般情况下,当nfs客户端数目较小的时候,NFS性能不会出现问题;一旦NFS 服务器数目过多,并且是那种读写都比较频繁的操作,所得到的结果就不是我们所期待的。

下面是某个集群使用nfs共享的示意图:nfs服务器这种架构除了性能问题而外,还存在单点故障,一旦这个NFS服务器发生故障,所有靠共享提供数据的应用就不再可用,尽管用rsync方式同步数据到另外一个服务器上做nfs服务的备份,但这对提高整个系统的性能毫无帮助。

基于这样一种需求,我们需要对nfs服务器进行优化或采取别的解决方案,然而优化并不能对应对日益增多的客户端的性能要求,因此唯一的选择只能是采取别的解决方案了;通过调研,分布式文件系统是一个比较合适的选择。

采用分布式文件系统后,服务器之间的数据访问不再是一对多的关系(1个NFS服务器,多个NFS客户端),而是多对多的关系,这样一来,性能大幅提升毫无问题。

到目前为止,有数十种以上的分布式文件系统解决方案可供选择,如lustre,hadoop,Pnfs等等。

我尝试了PVFS,hadoop,moosefs这三种应用,参看了lustre、KFS等诸多技术实施方法,最后我选择了moosefs(以下简称MFS)这种分布式文件系统来作为我的共享存储服务器。

为什么要选它呢?我来说说我的一些看法:1、实施起来简单。

MFS的安装、部署、配置相对于其他几种工具来说,要简单和容易得多。

看看lustre 700多页的pdf文档,让人头昏吧。

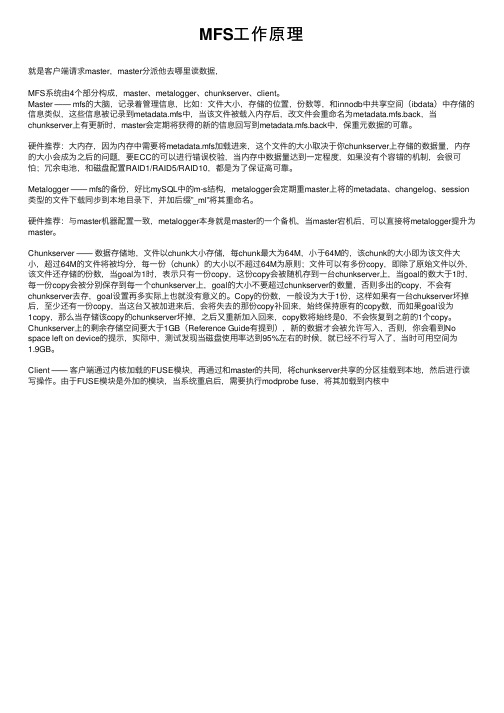

MFS工作原理

MFS⼯作原理就是客户端请求master,master分派他去哪⾥读数据,MFS系统由4个部分构成,master、metalogger、chunkserver、client。

Master —— mfs的⼤脑,记录着管理信息,⽐如:⽂件⼤⼩,存储的位置,份数等,和innodb中共享空间(ibdata)中存储的信息类似,这些信息被记录到metadata.mfs中,当该⽂件被载⼊内存后,改⽂件会重命名为metadata.mfs.back,当chunkserver上有更新时,master会定期将获得的新的信息回写到metadata.mfs.back中,保重元数据的可靠。

硬件推荐:⼤内存,因为内存中需要将metadata.mfs加载进来,这个⽂件的⼤⼩取决于你chunkserver上存储的数据量,内存的⼤⼩会成为之后的问题,要ECC的可以进⾏错误校验,当内存中数据量达到⼀定程度,如果没有个容错的机制,会很可怕;冗余电池,和磁盘配置RAID1/RAID5/RAID10,都是为了保证⾼可靠。

Metalogger —— mfs的备份,好⽐mySQL中的m-s结构,metalogger会定期重master上将的metadata、changelog、session 类型的⽂件下载同步到本地⽬录下,并加后缀”_ml”将其重命名。

硬件推荐:与master机器配置⼀致,metalogger本⾝就是master的⼀个备机,当master宕机后,可以直接将metalogger提升为master。

Chunkserver —— 数据存储地,⽂件以chunk⼤⼩存储,每chunk最⼤为64M,⼩于64M的,该chunk的⼤⼩即为该⽂件⼤⼩,超过64M的⽂件将被均分,每⼀份(chunk)的⼤⼩以不超过64M为原则;⽂件可以有多份copy,即除了原始⽂件以外,该⽂件还存储的份数,当goal为1时,表⽰只有⼀份copy,这份copy会被随机存到⼀台chunkserver上,当goal的数⼤于1时,每⼀份copy会被分别保存到每⼀个chunkserver上,goal的⼤⼩不要超过chunkserver的数量,否则多出的copy,不会有chunkserver去存,goal设置再多实际上也就没有意义的。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Moose File System2012.11.13 jluzcMooseFS is a fault tolerant, network distributed file system. It spreads data over several physical servers which are visible to the user as one resource. For standard file operations MooseFS acts as other Unix-alike file systems:∙ A hierarchical structure (directory tree)∙Stores POSIX file attributes (permissions, last access and modification times)∙Supports special files (block and character devices, pipes and sockets)∙Symbolic links (file names pointing to target files, not necessarily on MooseFS) and hard links (different names of files which refer to the same data on MooseFS)∙Access to the file system can be limited based on IP address and/or passwordDistinctive features of MooseFS are:∙High reliability (several copies of the data can be stored across separate computers)∙Capacity is dynamically expandable by attaching newcomputers/disks∙Deleted files are retained for a configurable period of time (a file system level "trash bin")∙Coherent snapshots of files, even while the file is being written/accessedARCHITECTUREMooseFS consists of four components:∙Managing server (master server) – a single machine managing the whole filesystem, storing metadata for every file (information on size, attributes and file location(s), including all informationabout non-regular files, i.e. directories, sockets, pipes anddevices).∙Data servers (chunk servers) - any number of commodity servers storing files data and synchronizing it among themselves (if acertain file is supposed to exist in more than one copy).∙Metadata backup server(s) (metalogger server) - any number of servers, all of which store metadata changelogs and periodically downloading main metadata file; so as to promote these servers to the the role of the Managing server when primary master stopsworking.∙Client computers that access (mount) the files in MooseFS - any number of machines using mfsmount process to communicate with the managing server (to receive and modify file metadata) and withchunkservers (to exchange actual file data).mfsmount is based on the FUSE mechanism (Filesystem in USErspace), so MooseFS is available on every Operating System with a working FUSE implementation (Linux, FreeBSD, MacOS X, etc.)Metadata is stored in the memory of the managing server and simultaneously saved to disk (as a periodically updated binary file and immediately updated incremental logs). The main binary file as well as the logs are synchronized to the metaloggers (if present).File data is divided into fragments (chunks) with a maximum of 64MiB each. Each chunk is itself a file on selected disks on data servers (chunkservers).High reliability is achieved by configuring as many different data servers as appropriate to realize the "goal" value (number of copies to keep) set for the given file.HOW THE SYSTEM WORKSAll file operations on a client computer that has mounted MooseFS are exactly the same as they would be with other file systems. The operating system kernel transfers all file operations to the FUSE module, which communicates with the mfsmount process. The mfsmount process communicates through the network subsequently with the managing server and data servers (chunk servers). This entire process is fully transparent to the user.mfsmount communicates with the managing server every time an operation on file metadata is required:∙creating files∙deleting files∙reading directories∙reading and changing attributes∙changing file sizes∙at the start of reading or writing data∙on any access to special files on MFSMETAmfsmount uses a direct connection to the data server (chunk server) that stores the relevant chunk of a file. When writing a file, after finishing the write process the managing server receives information from mfsmount to update a file's length and the last modification time.Furthermore, data servers (chunk servers) communicate with each other to replicate data in order to achieve the appropriate number of copies of a file on different machines.FAULT TOLERANCEAdministrative commands allow the system administrator to specify the "goal", or number of copies that should be maintained, on a per-directory or per-file level. Setting the goal to more than one and having more than one data server will provide fault tolerance. When the file data is stored in many copies (on more than one data server), the system is resistant to failures or temporary network outages of a single data server.This of course does not refer to files with the "goal" set to 1, in which case the file will only exist on a single data server irrespective of how many data servers are deployed in the system.Exceptionally important files may have their goal set to a number higher than two, which will allow these files to be resistant to a breakdown of more than one server at once.In general the setting for the number of copies available should be one more than the anticipated number of inaccessible or out-of-order servers.In the case where a single data server experiences a failure or disconnection from the network, the files stored within it that had at least two copies, will remain accessible from another data server. The data that is now 'under its goal' will be replicated on another accessible data server to again provide the required number of copies.It should be noted that if the number of available servers is lower than the "goal" set for a given file, the required number of copies cannot be preserved. Similarly if there are the same number of servers as the currently set goal and if a data server has reached 100% of its capacity, it will be unable to begin to hold a copy of a file that is now below its goal threshold due to another data server going offline. In these cases a new data server should be connected to the system as soon as possible in order to maintain the desired number of copies of the file.A new data server can be connected to the system at any time. The new capacity will immediately become available for use to store new files or to hold replicated copies of files from other data servers.Administrative utilities exist to query the status of the files within the file system to determine if any of the files are currently below their goal (set number of copies). This utility can also be used to alter the goal setting as required.The data fragments stored in the chunks are versioned, so re-connecting a data server with older copy of data (such as if it had been offline for a period of time), will not cause the files to become incoherent. The data server will synchronize itself to hold the current versions of the chunks, where the obsolete chunks will be removed and the free space will be reallocated to hold the new chunks.Failures of a client machine (that runs the mfsmount process) will haveno influence on the coherence of the file system or on the other client's operations. In the worst case scenario the data that has not yet been sent from the failed client computer may be lost.PLATFORMSMooseFS is available on every Operating System with a working FUSE implementation:∙Linux (Linux 2.6.14 and up have FUSE support included in the official kernel)∙FreeBSD∙OpenSolaris∙MacOS XThe master server, metalogger server and chunkservers can also be run on Solaris or Windows with Cygwin. Unfortunately without FUSE it won't be possible to mount the filesystem within these operating systems.。