bp算法C语言实现

bp神经网络详细步骤C实现

//更新V,V矩阵是隐藏层与输出层之间的权值for(intj=0;j<hideNum;j++)

{

v[j,k]+=rate*qq[k]*x1[j];

}

}

//计算隐层误差

for(intj=0;j<hideNum;j++)

{

//PP矩阵是隐藏层的误差

{

//★数据归一化

for(inti=0;i<inNum;i++)

{

x[i]=p[isamp,i]/in_rate;

}

for(inti=0;i<outNum;i++)

{

yd[i]=t[isamp,i]/in_rate;

}

//计算隐层的输入和输出

for(intj=0;j<hideNum;j++)

{

o1[j]=0.0;

{

w[i]+=dw[i];

}

}

//数据仿真函数

publicdouble[]sim(double[]psim)

{

for(i nti=O;i<i nN um;i++)

x[i]=psim[i]/in_rate;//in_rate为归一化系数

for(i ntj=O;j<hideNum;j++)

{

o1[j]=0.0;

{pMax=Math.Abs(p[isamp,i]);

}

}for(intj=0;j<outNum;j++)

{if(Math.Abs(t[isamp,j])>pMax)

如何用C语言编程实现多层前向BP神经网络,用来解决逻辑 XOR 运算和奇偶检验问题

6.( 1) 试用 C 语言编程实现多层前向 NN 的 BP 算法。

要求:输入、输出结点数目,隐层数目,及各隐层中结点的数目应为任意整数。

( 2) 试用所编出的 BP 算法程序训练出一个实现 XOR 运算的 2 层前向网络。

( 3) 用所编出的 BP 算法程序训练出输入矢量的维数分别为 n=7和 n=8的两个实现奇偶检验运算(即如题 2.(2)所述)的 2 层前向 NN 。

注: 对第 6 题的要求:(i) 列表给出训练收敛后的 NN 权值和所用的迭代次数;(ii) 给出训练收敛后的训练误差和检验误差,及用训练集和检验集做输入时所得到的正确输出率;(iii) 给出 NN 的学习曲线(即 E(W(k))随迭代次数 k 的变化曲线,该结果应是用计算程序计算和打印出来的曲线,而不要是用手画出的曲线)。

(1)用C 语言编程实现前向NN 的BP 算法 解:解题思路:先用 C 语言编程实现前向 NN 的 BP 算法,再将误差保存至文本文件,最后用MATLAB 绘制出误差曲线。

(1.1)开发思路奇偶检验问题可视为 XOR 问题的推广(由 2 输入到 n 输入的推广):若 n 个输入中有奇数个1,则输出为 1;若n 个输入中有偶数个1,则输出为 0。

一个 2 层的 NN 可实现奇偶检验运算。

本文选用2层神经网络,包括隐含层1层,输出层1层,来设计BP 神经网络。

x 1x 2x n2层神经网络本文隐含层和输出层的激活函数选用Sigmoid 函数,1()1ss eϕ-=+,()(1())d s s ds ϕϕϕ=- 其函数曲线如下所示:由奇偶检验问题的定义: 可定义如下分类函数:1 y>=1/2Y()0 y<1/2y ⎧=⎨⎩其中y 为BP 神经网络的输出值,Y 为分类结果。

(1.2)运行流程本文的多层前向 NN 的 BP 算法用C 语言编程实现,最后将运行结果保存成数据文件,通过MATLAB绘图显示,其运行流程图如上图所示,其源代码见附录部分。

BP算法代码实现

BP算法代码实现BP算法(Backpropagation Algorithm)是一种常用的神经网络训练算法,它主要用于监督式学习任务中的模型训练。

BP算法的核心思想是通过反向传播来更新神经网络的权重和偏差,以使得神经网络的输出逼近目标输出。

在反向传播的过程中,通过求解梯度来更新每个连接权重和偏置的值,从而最小化损失函数。

以下是BP算法的代码实现示例:```pythonimport numpy as npclass NeuralNetwork:def __init__(self, layers):yers = layersself.weights = []self.biases = []self.activations = []#初始化权重和偏置for i in range(1, len(layers)):self.weights.append(np.random.randn(layers[i], layers[i-1])) self.biases.append(np.random.randn(layers[i]))def sigmoid(self, z):return 1 / (1 + np.exp(-z))def sigmoid_derivative(self, z):return self.sigmoid(z) * (1 - self.sigmoid(z))def forward_propagate(self, X):self.activations = []activation = X#前向传播计算每一层的激活值for w, b in zip(self.weights, self.biases):z = np.dot(w, activation) + bactivation = self.sigmoid(z)self.activations.append(activation)return activationdef backward_propagate(self, X, y, output):deltas = [None] * len(yers)deltas[-1] = output - y#反向传播计算每一层的误差(梯度)for i in reversed(range(len(yers)-1)):delta = np.dot(self.weights[i].T, deltas[i+1]) * self.sigmoid_derivative(self.activations[i])deltas[i] = delta#更新权重和偏置for i in range(len(yers)-1):self.weights[i] -= 0.1 * np.dot(deltas[i+1],self.activations[i].T)self.biases[i] -= 0.1 * np.sum(deltas[i+1], axis=1)def train(self, X, y, epochs):for epoch in range(epochs):output = self.forward_propagate(X)self.backward_propagate(X, y, output)def predict(self, X):output = self.forward_propagate(X)return np.round(output)```上述代码使用numpy实现了一个简单的多层神经网络,支持任意层数和任意神经元个数的构建。

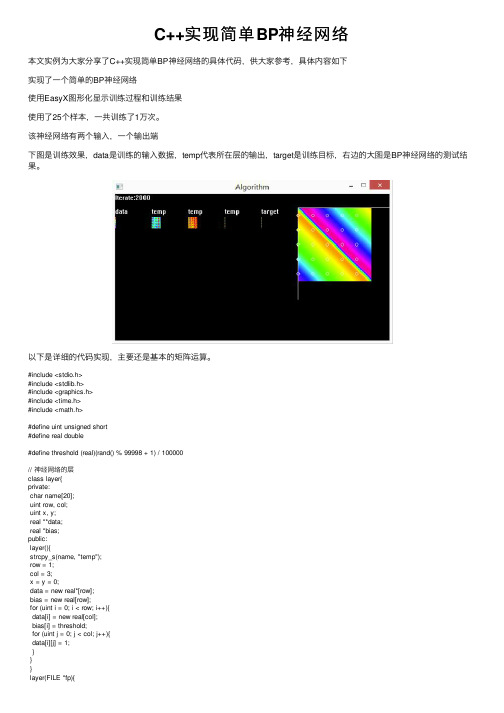

C++实现简单BP神经网络

C++实现简单BP神经⽹络本⽂实例为⼤家分享了C++实现简单BP神经⽹络的具体代码,供⼤家参考,具体内容如下实现了⼀个简单的BP神经⽹络使⽤EasyX图形化显⽰训练过程和训练结果使⽤了25个样本,⼀共训练了1万次。

该神经⽹络有两个输⼊,⼀个输出端下图是训练效果,data是训练的输⼊数据,temp代表所在层的输出,target是训练⽬标,右边的⼤图是BP神经⽹络的测试结果。

以下是详细的代码实现,主要还是基本的矩阵运算。

#include <stdio.h>#include <stdlib.h>#include <graphics.h>#include <time.h>#include <math.h>#define uint unsigned short#define real double#define threshold (real)(rand() % 99998 + 1) / 100000// 神经⽹络的层class layer{private:char name[20];uint row, col;uint x, y;real **data;real *bias;public:layer(){strcpy_s(name, "temp");row = 1;col = 3;x = y = 0;data = new real*[row];bias = new real[row];for (uint i = 0; i < row; i++){data[i] = new real[col];bias[i] = threshold;for (uint j = 0; j < col; j++){data[i][j] = 1;}}}layer(FILE *fp){fscanf_s(fp, "%d %d %d %d %s", &row, &col, &x, &y, name); data = new real*[row];bias = new real[row];for (uint i = 0; i < row; i++){data[i] = new real[col];bias[i] = threshold;for (uint j = 0; j < col; j++){fscanf_s(fp, "%lf", &data[i][j]);}}}layer(uint row, uint col){strcpy_s(name, "temp");this->row = row;this->col = col;this->x = 0;this->y = 0;this->data = new real*[row];this->bias = new real[row];for (uint i = 0; i < row; i++){data[i] = new real[col];bias[i] = threshold;for (uint j = 0; j < col; j++){data[i][j] = 1.0f;}}}layer(const layer &a){strcpy_s(name, );row = a.row, col = a.col;x = a.x, y = a.y;data = new real*[row];bias = new real[row];for (uint i = 0; i < row; i++){data[i] = new real[col];bias[i] = a.bias[i];for (uint j = 0; j < col; j++){data[i][j] = a.data[i][j];}}}~layer(){// 删除原有数据for (uint i = 0; i < row; i++){delete[]data[i];}delete[]data;}layer& operator =(const layer &a){// 删除原有数据for (uint i = 0; i < row; i++){delete[]data[i];}delete[]data;delete[]bias;// 重新分配空间strcpy_s(name, );row = a.row, col = a.col;x = a.x, y = a.y;data = new real*[row];bias = new real[row];for (uint i = 0; i < row; i++){data[i] = new real[col];bias[i] = a.bias[i];for (uint j = 0; j < col; j++){data[i][j] = a.data[i][j];}}return *this;}layer Transpose() const {layer arr(col, row);arr.x = x, arr.y = y;for (uint i = 0; i < row; i++){for (uint j = 0; j < col; j++){arr.data[j][i] = data[i][j];}}return arr;}layer sigmoid(){layer arr(col, row);arr.x = x, arr.y = y;for (uint i = 0; i < x.row; i++){for (uint j = 0; j < x.col; j++){arr.data[i][j] = 1 / (1 + exp(-data[i][j]));// 1/(1+exp(-z)) }}return arr;}layer operator *(const layer &b){layer arr(row, col);arr.x = x, arr.y = y;for (uint i = 0; i < row; i++){for (uint j = 0; j < col; j++){arr.data[i][j] = data[i][j] * b.data[i][j];}}return arr;}layer operator *(const int b){layer arr(row, col);arr.x = x, arr.y = y;for (uint i = 0; i < row; i++){for (uint j = 0; j < col; j++){arr.data[i][j] = b * data[i][j];}}return arr;}layer matmul(const layer &b){layer arr(row, b.col);arr.x = x, arr.y = y;for (uint k = 0; k < b.col; k++){for (uint i = 0; i < row; i++){arr.bias[i] = bias[i];arr.data[i][k] = 0;for (uint j = 0; j < col; j++){arr.data[i][k] += data[i][j] * b.data[j][k];}}}return arr;}layer operator -(const layer &b){layer arr(row, col);arr.x = x, arr.y = y;for (uint i = 0; i < row; i++){for (uint j = 0; j < col; j++){arr.data[i][j] = data[i][j] - b.data[i][j];}}return arr;}layer operator +(const layer &b){layer arr(row, col);arr.x = x, arr.y = y;for (uint i = 0; i < row; i++){for (uint j = 0; j < col; j++){arr.data[i][j] = data[i][j] + b.data[i][j];}}return arr;}layer neg(){layer arr(row, col);arr.x = x, arr.y = y;for (uint i = 0; i < row; i++){for (uint j = 0; j < col; j++){arr.data[i][j] = -data[i][j];}}return arr;}bool operator ==(const layer &a){bool result = true;for (uint i = 0; i < row; i++){for (uint j = 0; j < col; j++){if (abs(data[i][j] - a.data[i][j]) > 10e-6){result = false;break;}}}return result;}void randomize(){for (uint i = 0; i < row; i++){for (uint j = 0; j < col; j++){data[i][j] = threshold;}bias[i] = 0.3;}}void print(){outtextxy(x, y - 20, name);for (uint i = 0; i < row; i++){for (uint j = 0; j < col; j++){COLORREF color = HSVtoRGB(360 * data[i][j], 1, 1);putpixel(x + i, y + j, color);}}}void save(FILE *fp){fprintf_s(fp, "%d %d %d %d %s\n", row, col, x, y, name); for (uint i = 0; i < row; i++){for (uint j = 0; j < col; j++){fprintf_s(fp, "%lf ", data[i][j]);}fprintf_s(fp, "\n");}}friend class network;friend layer operator *(const double a, const layer &b); };layer operator *(const double a, const layer &b){layer arr(b.row, b.col);arr.x = b.x, arr.y = b.y;for (uint i = 0; i < arr.row; i++){for (uint j = 0; j < arr.col; j++){arr.data[i][j] = a * b.data[i][j];}}return arr;}// 神经⽹络class network{int iter;double learn;layer arr[3];layer data, target, test;layer& unit(layer &x){for (uint i = 0; i < x.row; i++){for (uint j = 0; j < x.col; j++){x.data[i][j] = i == j ? 1.0 : 0.0;}}return x;}layer grad_sigmoid(layer &x){layer e(x.row, x.col);e = x*(e - x);return e;}public:network(FILE *fp){fscanf_s(fp, "%d %lf", &iter, &learn);// 输⼊数据data = layer(fp);for (uint i = 0; i < 3; i++){arr[i] = layer(fp);//arr[i].randomize();}target = layer(fp);// 测试数据test = layer(2, 40000);for (uint i = 0; i < test.col; i++){test.data[0][i] = ((double)i / 200) / 200.0f;test.data[1][i] = (double)(i % 200) / 200.0f;}}void train(){int i = 0;char str[20];data.print();target.print();for (i = 0; i < iter; i++){sprintf_s(str, "Iterate:%d", i);outtextxy(0, 0, str);// 正向传播layer l0 = data;layer l1 = arr[0].matmul(l0).sigmoid();layer l2 = arr[1].matmul(l1).sigmoid();layer l3 = arr[2].matmul(l2).sigmoid();// 显⽰输出结果l1.print();l2.print();l3.print();if (l3 == target){break;}// 反向传播layer l3_delta = (l3 - target ) * grad_sigmoid(l3);layer l2_delta = arr[2].Transpose().matmul(l3_delta) * grad_sigmoid(l2);layer l1_delta = arr[1].Transpose().matmul(l2_delta) * grad_sigmoid(l1);// 梯度下降法arr[2] = arr[2] - learn * l3_delta.matmul(l2.Transpose());arr[1] = arr[1] - learn * l2_delta.matmul(l1.Transpose());arr[0] = arr[0] - learn * l1_delta.matmul(l0.Transpose());}sprintf_s(str, "Iterate:%d", i);outtextxy(0, 0, str);// 测试输出// selftest();}void selftest(){// 测试layer l0 = test;layer l1 = arr[0].matmul(l0).sigmoid();layer l2 = arr[1].matmul(l1).sigmoid();layer l3 = arr[2].matmul(l2).sigmoid();setlinecolor(WHITE);// 测试例for (uint j = 0; j < test.col; j++){COLORREF color = HSVtoRGB(360 * l3.data[0][j], 1, 1);// 输出颜⾊putpixel((int)(test.data[0][j] * 160) + 400, (int)(test.data[1][j] * 160) + 30, color); }// 标准例for (uint j = 0; j < data.col; j++){COLORREF color = HSVtoRGB(360 * target.data[0][j], 1, 1);// 输出颜⾊setfillcolor(color);fillcircle((int)(data.data[0][j] * 160) + 400, (int)(data.data[1][j] * 160) + 30, 3); }line(400, 30, 400, 230);line(400, 30, 600, 30);}void save(FILE *fp){fprintf_s(fp, "%d %lf\n", iter, learn);data.save(fp);for (uint i = 0; i < 3; i++){arr[i].save(fp);}target.save(fp);}};#include "network.h"void main(){FILE file;FILE *fp = &file;// 读取状态fopen_s(&fp, "Text.txt", "r");network net(fp);fclose(fp);initgraph(600, 320);net.train();// 保存状态fopen_s(&fp, "Text.txt", "w");net.save(fp);fclose(fp);getchar();closegraph();}上⾯这段代码是在2016年初实现的,⾮常简陋,且不利于扩展。

神经网络BP算法程序C语言实现

/************************************************ Back Propagation Algorithm************************************************/ #include "stdio.h"#include "stdlib.h"#include "math.h"/************************************************ The Definition of User Data************************************************/ #define MAXINPUT 1#define MAXHIDE 3#define MAXOUTPUT 1#define MAX 1#define MIN -1#define T 100#define CA 4double a=0.8;double b=0.05;double k=0;double error=0;int t=0;double sout[MAXOUTPUT];double shide[MAXHIDE];double m=2;double howchange[MAXHIDE][MAXOUTPUT];double ihwchange[MAXINPUT][MAXHIDE];double CatalogueOut[CA][MAXOUTPUT];double CatalogueIn[CA][MAXINPUT];/************************************************ The Definition of Data Structure************************************************/ struct theBP{double input[MAXINPUT];double hide[MAXHIDE];double output[MAXOUTPUT];double ihw[MAXINPUT][MAXHIDE];double how[MAXHIDE][MAXOUTPUT];};struct theBP bpa;/************************************************ Definition of Prototype************************************************/ void WeightInitial();void InitialError();void InPutCatalogue();void CalculateOut(int k);void CalculateError(int k);void ReverseHideError();void CalculateChange();void CalculateNewWeight();void Test();void TestCalculateOut();void camain();void main(){WeightInitial();// InitialError();InPutCatalogue();//doint m=0;while(1){printf("请选择要进行的操作\n");printf("0----------------学习\n");printf("1----------------测试\n");printf("2----------------退出\n");scanf("%d",&m);switch(m){case 0:camain();break;case 1:Test();break;case 2:exit(0);}//while((error)>k);;}}void camain(){for(t=0;t<T;t++){for(int k=0;k<CA;k++){CalculateOut(k);CalculateError(k);ReverseHideError();CalculateChange();CalculateNewWeight();}for(k=0;k<CA;k++){CalculateOut(k);}}}/************************************************Function:initial the weight************************************************/void WeightInitial(){//产生输入层到隐藏层的权值for(int i=0;i<MAXINPUT;i++){for(int j=0;j<MAXHIDE;j++){bpa.ihw[i][j]=0.3;//((double)rand()/(double)(RAND_MAX))*(MAX-MIN)+MIN;}}//产生从隐藏层到输出层的权值for(i=0;i<MAXHIDE;i++){for(int j=0;j<MAXOUTPUT;j++){bpa.how[i][j]=0.2;//((double)rand()/(double)(RAND_MAX))*(MAX-MIN)+MIN;}}}/************************************************Function:input the Catalogue************************************************/void InPutCatalogue(){for(int k=0;k<CA;k++){printf("请输入第%d个样本的输入值:\n",k);for(int i=0;i<MAXINPUT;i++){scanf("%lf",&bpa.input[i]);CatalogueIn[k][i]=bpa.input[i];}printf("请输入第%d个样本的输出值:\n",k);for(i=0;i<MAXOUTPUT;i++){scanf("%lf",&CatalogueOut[k][i]);}}}/************************************************Function:calculate the out************************************************/void CalculateOut(int k){//计算隐藏层的输出for(int j=0;j<MAXHIDE;j++){double sum2=0;for(int i=0;i<MAXINPUT;i++){bpa.input[i]=CatalogueIn[k][i];sum2+=bpa.ihw[i][j]*bpa.input[i];//计算输入}bpa.hide[j]=1/(1+exp(-sum2));//计算输出}//计算每输出层个单元的输入和输出for(j=0;j<MAXOUTPUT;j++){double sum3=0;for(int i=0;i<MAXHIDE;i++){sum3+=bpa.how[i][j]*bpa.hide[i];//计算输入}bpa.output[j]=m*sum3;//计算输出bpa.output[j]=1/(1+exp(-sum3))printf("第%d个样本的最后输出%lf\n",k,bpa.output[j]);}}void TestCalculateOut(){//计算隐藏层的输出for(int j=0;j<MAXHIDE;j++){double sum1=0;for(int i=0;i<MAXINPUT;i++){sum1=sum1+bpa.ihw[i][j]*bpa.input[i];//计算输入}bpa.hide[j]=1/(1+exp(-sum1));//计算输出}//计算每输出层个单元的输入和输出for(j=0;j<MAXOUTPUT;j++){double sum2=0;for(int i=0;i<MAXHIDE;i++){sum2=sum2+bpa.how[i][j]*bpa.hide[i];//计算输入}bpa.output[j]=m*sum2;//计算输出bpa.output[j]=1/(1+exp(sum2))printf("最后输出%lf\n",bpa.output[j]);}}/************************************************Function:对输出层Calculate************************************************/void CalculateError(int k){double temp=0;error=0;for(int i=0;i<MAXOUTPUT;i++){temp=(CatalogueOut[k][i]-bpa.output[i])*(CatalogueOut[k][i]-bpa.output[i]);error=(0.5)*temp+error;}for(i=0;i<MAXOUTPUT;i++){sout[i]=(CatalogueOut[k][i]-bpa.output[i])*bpa.output[i]*(1-bpa.output[i]);}}/************************************************Function: 从后向前对隐藏层************************************************/void ReverseHideError(){for(int i=0;i<MAXHIDE;i++){double sum=0;for(int j=0;j<MAXOUTPUT;j++){sum+=sout[j]*bpa.how[i][j];}shide[i]=(bpa.hide[i])*(1-bpa.hide[i])*sum;}}/************************************************Function:Calculate the 权值的变化量************************************************/void CalculateChange(){int j=0;//隐藏层到输出层for(int i=0;i<MAXHIDE;i++){for(j=0;j<MAXOUTPUT;j++){howchange[i][j]=a*(howchange[i][j])+b*(sout[i])*(bpa.hide[i]);// }}//对输入层到隐藏层for(i=0;i<MAXINPUT;i++){for(j=0;j<MAXHIDE;j++){ihwchange[i][j]=a*(ihwchange[i][j])+b*(shide[i])*(bpa.input[i]);// }}}/************************************************Function:Calculate the 新的权值************************************************/void CalculateNewWeight(){int j=0;//隐藏层到输出层for(int i=0;i<MAXHIDE;i++){for(j=0;j<MAXOUTPUT;j++){bpa.how[i][j]=bpa.how[i][j]+howchange[i][j];}}//对输入层到隐藏层for(i=0;i<MAXINPUT;i++){for(j=0;j<MAXHIDE;j++){bpa.ihw[i][j]=bpa.ihw[i][j]+ihwchange[i][j];}}}void Test(){printf("请输入测试数据的输入值:\n");for(int i=0;i<MAXINPUT;i++){scanf("%lf",&bpa.input[i]);}TestCalculateOut();}。

人工神经网络BP算法的实现

人工神经网络BP算法的实现作者:李晓歌邵丽红李娜来源:《电脑知识与技术·学术交流》2008年第05期摘要:BP网络是一种得到广泛应用的人工神经网络模型.本文简要介绍了BP算法的原理,并给出了其在VC++6.0中的实现方法。

关键词:人工神经网络;BP算法;程序中图分类号:TP183文献标识码:A文章编号:1009-3044(2008)05-00ppp-0c1 引言人工神经网络是一种信息处理系统,它有很多种模型。

其中有一种用误差传播学习算法(Error Back-Propagation,即BP算法)进行训练的多层前馈神经网络,简称为BP网络。

它是目前人工神经网络中应用最为广泛的网络,在文字识别、模式分类、文字到声音的转换、图像压缩、决策支持等方面都有广泛的应用。

本文对BP算法进行简单的介绍,并给出其在VC++6.0中的实现方法。

2 BP算法的原理2.1 BP网络的结构BP网络是由一组相互连接的运算单元组成,其中每一个连接都有相对应的权值。

网络结构如图1(以三层网络为例)所示,它包括输入层节点、输出层节点,一层或多层隐含层节点。

在BP网络中,层与层之间采用全互连方式,同一层的节点之间不存在相互连接。

2.2 BP算法的原理BP算法简单的来说,是把训练样本从输入层输入,通过每个节点对应的阈值、函数以及节点之间连接权值的运算,经过输入层、隐含层,传播到输出层得到计算输出,该输出和其对应的期望输出比较,得出误差。

如果误差不符合要求,将误差沿输入相反的方向进行传播并沿误差降低方向调节权值和函数的阈值。

用多个训练样本对网络进行反复的训练,直至误差符合要求。

2.3 算法中主要的数据结构和用到的公式为方便说明,对算法中的主要数据结构做如下约定。

网络为三层,P[m]为单个样本输入数据, m为输入向量维数,也等于输入层节点数;T[n]为单个样本期望输出数据,n为输出向量维数,也等于输出层节点数;W[h][m]为输入层至隐层权值,其中h为隐层节点数;V[n][h]为隐层至输出层权值;X[h]为隐层的输入;O[h]为隐层的输出;U[n]为输出层的输入;Y[n]为输出层的计算输出;YZH[h]为隐层的阈值;YZO[n]为输出层的阈值;DeltaO[n]为输出层一般化误差;DeltaH[h]为隐层一般化误差;E为预先设定的总体误差;η为学习速率参数;设隐含层和输出层的激活函数采用S型函数,即lxg02.tif。

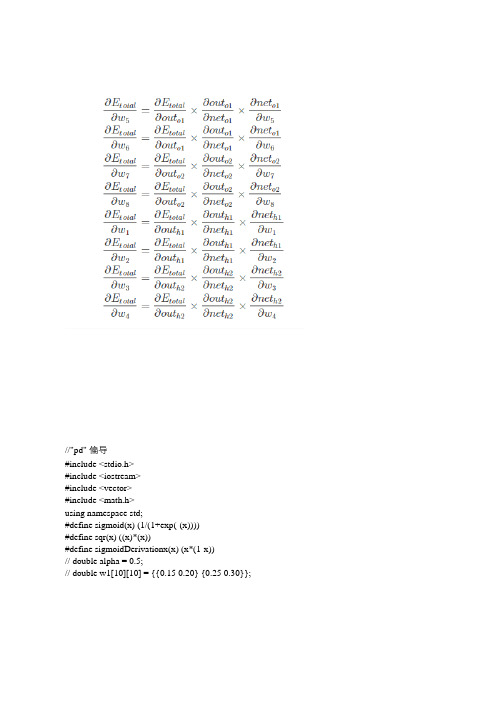

bp算法简单实现——c

//"pd" 偏导#include <stdio.h>#include <iostream>#include <vector>#include <math.h>using namespace std;#define sigmoid(x) (1/(1+exp(-(x))))#define sqr(x) ((x)*(x))#define sigmoidDerivationx(x) (x*(1-x))// double alpha = 0.5;// double w1[10][10] = {{0.15 0.20} {0.25 0.30}}; int main(){double bias[2] = {0.350.60};double weight[8] = {0.15 0.2 0.25 0.3 0.4 0.45 0.5 0.55};double output_laxxxxyer_weights[4] = {0.4 0.45 0.5 0.55};double i1 = 0.05;double i2 = 0.10;double target1 = 0.01;double target2 = 0.99;double alpha= 0.5;//学习率double numIter = 50000;//迭代次数for (int i = 0; i < numIter; i++){double neth1 = i1*weight[1] + i2*weight[2] + bias[1];double neth2 = i1*weight[3-1] + i2*weight[4-1] + bias[0];double outh1 = sigmoid(neth1);double outh2 = sigmoid(neth2);double neto1 = outh1*weight[5-1] + outh2*weight[6-1] + bias[1];double neto2 = outh2*weight[7-1] + outh2*weight[8-1] + bias[1];double outo1 = sigmoid(neto1);double outo2 = sigmoid(neto2);printf("%dtarget1:%ftarget2:%f\n"itarget1-outo1target2-outo2);if (i==numIter-1){printf("lastst result : %.4f %.4f\n\n" outo1 outo2);}//计算w5到w8(输出层权重)的误差double pdEOuto1 = - (target1 - outo1);double pdOuto1Neto1 = sigmoidDerivationx(outo1);double pdNeto1W5 = outh1;double pdEW5 = pdEOuto1 * pdOuto1Neto1 * pdNeto1W5;double pdNeto1W6 = outh2;double pdEW6 = pdEOuto1 * pdOuto1Neto1 * pdNeto1W6;double pdEOuto2 = - (target2 - outo2);double pdOuto2Neto2 = sigmoidDerivationx(outo2);double pdNeto1W7 = outh1;double pdEW7 = pdEOuto2 * pdOuto2Neto2 * pdNeto1W7;double pdNeto1W8 = outh2;double pdEW8 = pdEOuto2 * pdOuto2Neto2 * pdNeto1W8;//计算w1-w4(输出层权重)的误差pdEOuto1 = - (target1 - outo1);// #之前算过pdEOuto2 = - (target2 - outo2);// #之前算过pdOuto1Neto1 = sigmoidDerivationx(outo1) ; // #之前算过pdOuto2Neto2 = sigmoidDerivationx(outo2) ; // #之前算过double pdNeto1Outh1 = weight[5];double pdNeto1Outh2 = weight[7];double pdENeth1 = pdEOuto1 * pdOuto1Neto1 * pdNeto1Outh1 + pdEOuto2 * pdOuto2Neto2 * pdNeto1Outh2;double pdOuth1Neth1 = sigmoidDerivationx(outh1);double pdNeth1W1 = i1;double pdNeth1W2 = i2;double pdEW1 = pdENeth1 * pdOuth1Neth1 * pdNeth1W1;double pdEW2 = pdENeth1 * pdOuth1Neth1 * pdNeth1W2;pdNeto1Outh2 = weight[6];double pdNeto2Outh2 = weight[8];double pdOuth2Neth2 = sigmoidDerivationx(outh2);double pdNeth1W3 = i1;double pdNeth1W4 = i2;double pdENeth2 = pdEOuto1 *pdOuto1Neto1 * pdNeto1Outh2 + pdEOuto2 * pdOuto2Neto2 * pdNeto2Outh2;double pdEW3 = pdENeth2 * pdOuth2Neth2 * pdNeth1W3;double pdEW4 = pdENeth2 * pdOuth2Neth2 * pdNeth1W4;//权重更新weight[1] = weight[1] - alpha * pdEW1;weight[2] = weight[2] - alpha * pdEW2;weight[3] = weight[3] - alpha * pdEW3;weight[4] = weight[4] - alpha * pdEW4;weight[5] = weight[5] - alpha * pdEW5;weight[6] = weight[6] - alpha * pdEW6;weight[7] = weight[7] - alpha * pdEW7;weight[8] = weight[8] - alpha * pdEW8;}}。

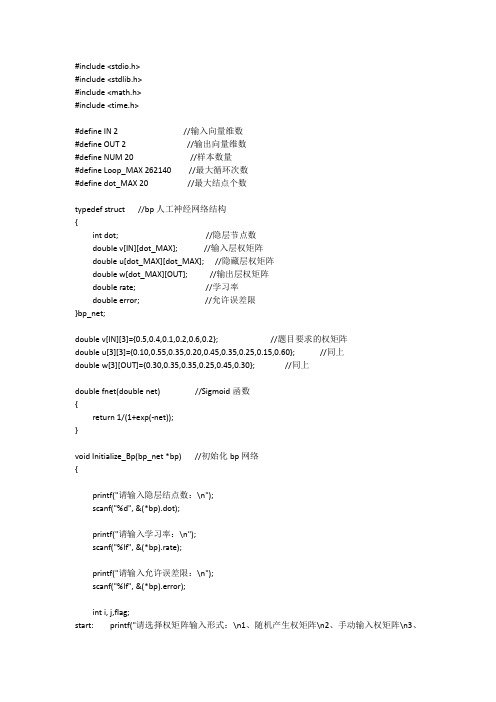

Bp网络算法源代码

#include <stdio.h>#include <stdlib.h>#include <math.h>#include <time.h>#define IN 2 //输入向量维数#define OUT 2 //输出向量维数#define NUM 20 //样本数量#define Loop_MAX 262140 //最大循环次数#define dot_MAX 20 //最大结点个数typedef struct //bp人工神经网络结构{int dot; //隐层节点数double v[IN][dot_MAX]; //输入层权矩阵double u[dot_MAX][dot_MAX]; //隐藏层权矩阵double w[dot_MAX][OUT]; //输出层权矩阵double rate; //学习率double error; //允许误差限}bp_net;double v[IN][3]={0.5,0.4,0.1,0.2,0.6,0.2}; //题目要求的权矩阵double u[3][3]={0.10,0.55,0.35,0.20,0.45,0.35,0.25,0.15,0.60}; //同上double w[3][OUT]={0.30,0.35,0.35,0.25,0.45,0.30}; //同上double fnet(double net) //Sigmoid函数{return 1/(1+exp(-net));}void Initialize_Bp(bp_net *bp) //初始化bp网络{printf("请输入隐层结点数:\n");scanf("%d", &(*bp).dot);printf("请输入学习率:\n");scanf("%lf", &(*bp).rate);printf("请输入允许误差限:\n");scanf("%lf", &(*bp).error);int i, j,flag;start: printf("请选择权矩阵输入形式:\n1、随机产生权矩阵\n2、手动输入权矩阵\n3、载入题目要求权矩阵\n");scanf("%d",&flag);if(flag==1){srand((unsigned)time(NULL)); //随机函数产生随机权矩阵for (i = 0; i < IN; i++)for (j = 0; j < (*bp).dot; j++)(*bp).v[i][j] = rand() / (double)(RAND_MAX);for (i = 0; i < (*bp).dot; i++)for (j = 0; j < (*bp).dot; j++)(*bp).u[i][j] = rand() / (double)(RAND_MAX);for (i = 0; i < (*bp).dot; i++)for (j = 0; j < OUT; j++)(*bp).w[i][j] = rand() / (double)(RAND_MAX);}else if(flag==2){printf("输入权矩阵:\n");for (i = 0; i < IN; i++)for (j = 0; j < (*bp).dot; j++)scanf("%lf",&(*bp).v[i][j]);printf("隐藏权矩阵:\n");for (i = 0; i < (*bp).dot; i++)for (j = 0; j < (*bp).dot; j++)scanf("%lf",&(*bp).u[i][j]);printf("输出权矩阵:\n");for (i = 0; i < (*bp).dot; i++)for (j = 0; j < OUT; j++)scanf("%lf",&(*bp).w[i][j]);}else if(flag==3){for (i = 0; i < IN; i++)for (j = 0; j < 3; j++)(*bp).v[i][j] = v[i][j];for (i = 0; i < 3; i++)for (j = 0; j < 3; j++)(*bp).u[i][j] = u[i][j];for (i = 0; i < 3; i++)for (j = 0; j < OUT; j++)(*bp).w[i][j] = w[i][j];printf("载入完成!\n");}else{printf("输入错误!请重新输入!\n");goto start;}printf("初始化输入权矩阵:\n");for (i = 0; i < IN; i++){for (j = 0; j < (*bp).dot; j++)printf("%lf ",(*bp).v[i][j]);printf("\n");}printf("初始化隐藏层权矩阵:\n");for (i = 0; i < (*bp).dot; i++){for (j = 0; j < (*bp).dot; j++)printf("%lf ",(*bp).u[i][j]);printf("\n");}printf("初始化输出权矩阵:\n");for (i = 0; i < (*bp).dot; i++){for (j = 0; j < OUT; j++)printf("%lf ",(*bp).w[i][j]);printf("\n");}printf("\n");}void Train_Bp(bp_net *bp, double x[NUM][IN], int y[NUM][OUT]) //训练bp网络{double e = (*bp).error; //允许误差限double rate = (*bp).rate; //学习率int dot = (*bp).dot; //隐藏层结点double v[IN][dot_MAX],w[dot_MAX][OUT],u[dot_MAX][dot_MAX]; //权矩阵double Error_Input[dot_MAX],Error_hider[dot_MAX], Error_Output[OUT]; //各个结点的反向误差double Input[dot_MAX],hider[dot_MAX],Output[OUT]; //各个层的结点输出int i,j,k,n,flag; //flag为是否继续修改权矩阵标志量double temp;for (i = 0; i < IN; i++) //复制结构体中的权矩阵for (j = 0; j < dot; j++)v[i][j] = (*bp).v[i][j];for (i = 0; i < dot; i++)for (j = 0; j < dot; j++)u[i][j] = (*bp).u[i][j];for (i = 0; i < dot; i++)for (j = 0; j < OUT; j++)w[i][j] = (*bp).w[i][j];for (n = 0;n<Loop_MAX; n++) //反向误差计算{flag=1;for (i= 0; i < NUM; i++){for (k= 0; k < dot; k++) //计算输入层输出向量{temp = 0;for (j = 0; j < IN; j++)temp += x[i][j] * v[j][k];Input[k] = fnet(temp);}for (k= 0; k < dot; k++) //计算隐藏层输出向量{temp = 0;for (j = 0; j < dot; j++)temp +=Input[j] * u[j][k];hider[k] = fnet(temp);}for (k = 0; k < OUT; k++) //计算输出层输出向量{temp = 0;for (j = 0; j < dot; j++)temp += hider[j] * w[j][k];Output[k] = fnet(temp);}for (j = 0; j < OUT ; j++) //测试结果与是否在误差范围内{if(fabs(y[i][j]-Output[j])<e)continue; //如果满足精度要求,则继续测试下一个结点的情况else{flag=0; //修改了权矩阵for (j = 0; j < OUT; j++)Error_Output[j] = y[i][j] - Output[j];for (j = 0; j < dot; j++) //计算隐层权修改量{temp = 0;for (k = 0; k < OUT; k++)temp += w[j][k] * Error_Output[k];Error_hider[j] = temp * hider[j] * (1-hider[j]);}for (j = 0; j < dot; j++) //修改输出层权矩阵for (k = 0; k < OUT; k++)w[j][k] += rate * hider[j] * Error_Output[k];for(j = 0;j < dot;j ++) //计算输入层修改量{temp = 0;for(k = 0;k< dot; k++)temp += u[j][k] * Error_hider[k];Error_Input[j]= temp * Input[j] * (1-Input[j]);}for (j = 0; j < dot; j++) //修改隐藏层权矩阵for (k = 0; k < dot; k++)u[j][k] += rate * Input[j] * Error_hider[k];for(j = 0;j < IN; j++) //修改输入层权矩阵for(k =0 ;k< dot;k ++)v[j][k] += rate * x[i][j] * Error_Input[k];}}}if(!flag)continue; //若flag=0,标明修改了权矩阵,需重新训练实例直到满足精度条件else //相反,当所有实例均循环一次后,仍未修改权矩阵,标明满足要求,结束循环break;}printf("总共循环次数:%d\n", n);printf("\n");printf("修改后的输入权矩阵:\n"); //输出修改后的输入层权矩阵for (i = 0; i < IN; i++){for (j = 0; j < dot; j++)printf("%f ", v[i][j]);printf("\n");}printf("修改后的隐藏层权矩阵:\n"); //输出修改后的隐藏层权矩阵for (i = 0; i < dot; i++){for (j = 0; j < dot; j++)printf("%f ", u[i][j]);printf("\n");}printf("修改后的输出层权矩阵:\n"); //输出修改后的输出权矩阵for (i = 0; i < dot; i++){for (j = 0; j < OUT; j++)printf("%f ", w[i][j]);printf("\n");}for (i = 0; i < IN; i++) //将修改后的输入层权矩阵返回给bp结构体for (j = 0; j < dot; j++)(*bp).v[i][j] = v[i][j];for (i = 0; i < dot; i++) //将修改后的隐藏层权矩阵返回给bp结构体for (j = 0; j < dot; j++)(*bp).u[i][j] = u[i][j];for (i = 0; i < dot; i++) //将修改后的输出层权矩阵返回给bp结构体for (j = 0; j < OUT; j++)(*bp).w[i][j] = w[i][j];printf("bp网络训练结束!\n");}void Test_Bp(bp_net *bp) //使用bp网络测试结果{float Input[IN]; //输入实例double Output_In[dot_MAX]; //输入层输出double Output_Hi[dot_MAX]; //隐藏层输出double Output_Ou[OUT]; //输出层输出double temp;while (1){printf("请输入一个实例:\n");int i, j;for (i = 0; i <IN ; i++)scanf("%f", &Input[i]);for (i = 0; i < (*bp).dot; i++) //计算输入层输出{temp = 0;for (j = 0; j < IN; j++)temp += Input[j] * (*bp).v[j][i];Output_In[i] = fnet(temp);}for (i = 0; i < (*bp).dot; i++) //计算隐藏层输出{temp = 0;for (j = 0; j < (*bp).dot; j++)temp += Output_In[j] * (*bp).u[j][i];Output_Hi[i] = fnet(temp);}for (i = 0; i < OUT; i++) //计算输出层输出{temp = 0;for (j = 0; j < (*bp).dot; j++)temp += Output_Hi[j] * (*bp).w[j][i];Output_Ou[i] = fnet(temp);}printf("bp网络计算结果:\n");printf("\n");for (i = 0; i < OUT; i++){printf("%.6f ", Output_Ou[i]);if(Output_Ou[i]>=1)printf(" 肯定是!\n");elseswitch((int)(Output_Ou[i]*10)){case 0:printf(" 肯定不是!");break;case 1:printf(" 稍稍像是!");break;case 2:printf(" 有点像是!");break;case 3:printf(" 有些像是!");break;case 4:printf(" 比较像是!");break;case 5:printf(" 差不多是!");break;case 6:printf(" 相当是!");break;case 7:printf(" 很是!");break;case 8:printf(" 极是!");break;case 9:printf(" 几乎是!");break;}printf("\n");}}}void main(void){double x[NUM][IN]= //训练样本{{0.05,0.02},{0.09,0.11},{0.12,0.20},{0.15,0.22},{0.20,0.25},{0.75,0.75},{0.80,0.83},{0.82,0.80},{0.90,0.89},{0.95,0.89},{0.09,0.04},{0.10,0.10},{0.14,0.21},{0.18,0.24},{0.22,0.28},{0.77,0.78},{0.79,0.81},{0.84,0.82},{0.94,0.93},{0.98,0.99},};int y[NUM][OUT] = //理想输出{{1,0},{1,0},{1,0},{1,0},{1,0},{0,1},{0,1},{0,1},{0,1},{0,1},{1,0},{1,0},{1,0},{1,0},{1,0},{0,1},{0,1},{0,1},{0,1},{0,1},};bp_net bp; //定义bp结构体Initialize_Bp(&bp); //初始化bp网络结构Train_Bp(&bp, x, y); //训练bp神经网络Test_Bp(&bp); //测试bp神经网络}。

BP神经网络--C语言实现下

BP神经⽹络--C语⾔实现下上⼀篇 C语⾔实现上中介绍了程序实现时定义的⼀些数据结构、程序执⾏的流程以及程序的基本⾻架(详情见)。

留下了两个关键函数computO(i) 和 backUpdate(i) 没有分析实现,参数 i 代表的是第 i 个样本,本篇我们⼀起来分析下这两个函数的实现。

BP神经⽹络输出函数 computO(i) 负责的是通过BP神经⽹络的机制对样本 i 的输⼊,预测其输出。

回想BP神经⽹络的基本模型(详情见)对应的公式(1)还有激活函数对应的公式(2):在前篇设计的BP神经⽹络中,输⼊层与隐藏层权重对应的数据结构是w[Neuron][In],隐藏层与输出层权重对应的数据结构是v[Out] [Neuron],并且数组 o[Neuron] 记录的是神经元通过激活函数对外的输出,BP神经⽹络预测的样本结果保存在OutputData[Out]中。

由此,就可以得到以下实现的参考代码:void computO(int var){int i,j;double sum,y;/*神经元输出*/for (i = 0; i < Neuron; ++i){sum=0;for (j = 0; j < In; ++j)sum+=w[i][j]*d_in[var][j];o[i]=1/(1+exp(-1*sum));}/* 隐藏层到输出层输出 */for (i = 0; i < Out; ++i){sum=0;for (j = 0; j < Neuron; ++j)sum+=v[i][j]*o[j];OutputData[i]=sum;}}BP神经⽹络的反馈学习函数 backUpdate(i) 负责的是将预测输出的结果与样本真实的结果进⾏⽐对,然后对神经⽹络中涉及到的权重进⾏修正,也这是BP神经⽹络实现的关键所在。

如何求到对于 w[Neuron][In] 和 v[Out][Neuron] 进⾏修正的误差量便是关键所在!误差修正量的求法在基本模型⼀⽂中数学分析部分有解答,具体问题具体分析,落实到我们设计的这个BP神经⽹络上来说,需要得到的是对w[Neuron][In] 和 v[Out][Neuron]两个数据进⾏修正误差,误差量⽤数据结构 dw[Neuron][In] 和 dv[Out][Neuron] 来进⾏存储。

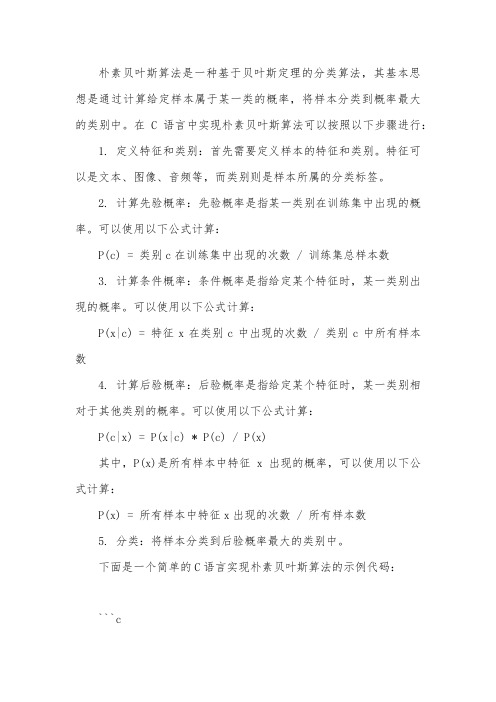

c语言 朴素贝叶斯算法

朴素贝叶斯算法是一种基于贝叶斯定理的分类算法,其基本思想是通过计算给定样本属于某一类的概率,将样本分类到概率最大的类别中。

在C语言中实现朴素贝叶斯算法可以按照以下步骤进行: 1. 定义特征和类别:首先需要定义样本的特征和类别。

特征可以是文本、图像、音频等,而类别则是样本所属的分类标签。

2. 计算先验概率:先验概率是指某一类别在训练集中出现的概率。

可以使用以下公式计算:P(c) = 类别c在训练集中出现的次数 / 训练集总样本数3. 计算条件概率:条件概率是指给定某个特征时,某一类别出现的概率。

可以使用以下公式计算:P(x|c) = 特征x在类别c中出现的次数 / 类别c中所有样本数4. 计算后验概率:后验概率是指给定某个特征时,某一类别相对于其他类别的概率。

可以使用以下公式计算:P(c|x) = P(x|c) * P(c) / P(x)其中,P(x)是所有样本中特征x出现的概率,可以使用以下公式计算:P(x) = 所有样本中特征x出现的次数 / 所有样本数5. 分类:将样本分类到后验概率最大的类别中。

下面是一个简单的C语言实现朴素贝叶斯算法的示例代码:```c#include <stdio.h>#include <stdlib.h>#include <math.h>#define NUM_CLASSES 2 // 类别数量#define NUM_FEATURES 2 // 特征数量#define NUM_SAMPLES 100 // 训练集样本数量#define NUM_TEST_SAMPLES 10 // 测试集样本数量// 训练集样本数据double train_data[NUM_SAMPLES][NUM_FEATURES] = { /* ... */ };// 训练集样本类别标签int train_labels[NUM_SAMPLES] = { /* ... */ };// 测试集样本数据double test_data[NUM_TEST_SAMPLES][NUM_FEATURES] = { /* ... */ };// 测试集样本类别标签(用于输出结果)int test_labels[NUM_TEST_SAMPLES] = { /* ... */ };// 计算先验概率double prior_probability(int class_index) {int count = 0;for (int i = 0; i < NUM_SAMPLES; i++) {if (train_labels[i] == class_index) {count++;}}return (double)count / NUM_SAMPLES;}// 计算条件概率double conditional_probability(int class_index, int feature_index, double value) {int count = 0;for (int i = 0; i < NUM_SAMPLES; i++) {if (train_labels[i] == class_index && train_data[i][feature_index] == value) {count++;}}return (double)count / (NUM_SAMPLES - count); // 使用拉普拉斯平滑处理0的情况}// 计算后验概率并分类int classify(double data[NUM_FEATURES]) {double max_probability = -1;int max_class = -1;for (int i = 0; i < NUM_CLASSES; i++) {double probability = prior_probability(i); // 先验概率for (int j = 0; j < NUM_FEATURES; j++) { // 计算每个特征的条件概率并累乘得到后验概率probability *= conditional_probability(i, j, data[j]); // 使用拉普拉斯平滑处理0的情况}if (probability > max_probability) { // 找到后验概率最大的类别标签和概率值max_probability = probability;max_class = i;}}return max_class; // 返回分类结果标签值(0或1)}```。

BP神经网络算法的C语言实现代码

BP神经网络算法的C语言实现代码以下是一个BP神经网络的C语言实现代码,代码的详细说明可以帮助理解代码逻辑:```c#include <stdio.h>#include <stdlib.h>#include <math.h>#define INPUT_SIZE 2#define HIDDEN_SIZE 2#define OUTPUT_SIZE 1#define LEARNING_RATE 0.1//定义神经网络结构体typedef structdouble input[INPUT_SIZE];double hidden[HIDDEN_SIZE];double output[OUTPUT_SIZE];double weights_ih[INPUT_SIZE][HIDDEN_SIZE];double weights_ho[HIDDEN_SIZE][OUTPUT_SIZE];} NeuralNetwork;//激活函数double sigmoid(double x)return 1 / (1 + exp(-x));//创建神经网络NeuralNetwork* create_neural_networNeuralNetwork* nn =(NeuralNetwork*)malloc(sizeof(NeuralNetwork));//初始化权重for (int i = 0; i < INPUT_SIZE; i++)for (int j = 0; j < HIDDEN_SIZE; j++)nn->weights_ih[i][j] = (double)rand( / RAND_MAX * 2 - 1;}}for (int i = 0; i < HIDDEN_SIZE; i++)for (int j = 0; j < OUTPUT_SIZE; j++)nn->weights_ho[i][j] = (double)rand( / RAND_MAX * 2 - 1;}}return nn;//前向传播void forward(NeuralNetwork* nn)//计算隐藏层输出for (int i = 0; i < HIDDEN_SIZE; i++)double sum = 0;for (int j = 0; j < INPUT_SIZE; j++)sum += nn->input[j] * nn->weights_ih[j][i];}nn->hidden[i] = sigmoid(sum);}//计算输出层输出for (int i = 0; i < OUTPUT_SIZE; i++)double sum = 0;for (int j = 0; j < HIDDEN_SIZE; j++)sum += nn->hidden[j] * nn->weights_ho[j][i];}nn->output[i] = sigmoid(sum);}void backpropagation(NeuralNetwork* nn, double target)//计算输出层误差double output_error[OUTPUT_SIZE];for (int i = 0; i < OUTPUT_SIZE; i++)double delta = target - nn->output[i];output_error[i] = nn->output[i] * (1 - nn->output[i]) * delta;}//更新隐藏层到输出层权重for (int i = 0; i < HIDDEN_SIZE; i++)for (int j = 0; j < OUTPUT_SIZE; j++)nn->weights_ho[i][j] += LEARNING_RATE * nn->hidden[i] * output_error[j];}}//计算隐藏层误差double hidden_error[HIDDEN_SIZE];for (int i = 0; i < HIDDEN_SIZE; i++)double delta = 0;for (int j = 0; j < OUTPUT_SIZE; j++)delta += output_error[j] * nn->weights_ho[i][j];}hidden_error[i] = nn->hidden[i] * (1 - nn->hidden[i]) * delta;}//更新输入层到隐藏层权重for (int i = 0; i < INPUT_SIZE; i++)for (int j = 0; j < HIDDEN_SIZE; j++)nn->weights_ih[i][j] += LEARNING_RATE * nn->input[i] * hidden_error[j];}}void train(NeuralNetwork* nn, double input[][2], double target[], int num_examples)int iteration = 0;while (iteration < MAX_ITERATIONS)double error = 0;for (int i = 0; i < num_examples; i++)for (int j = 0; j < INPUT_SIZE; j++)nn->input[j] = input[i][j];}forward(nn);backpropagation(nn, target[i]);error += fabs(target[i] - nn->output[0]);}//判断误差是否已达到允许范围if (error < 0.01)break;}iteration++;}if (iteration == MAX_ITERATIONS)printf("Training failed! Error: %.8lf\n", error); }void predict(NeuralNetwork* nn, double input[]) for (int i = 0; i < INPUT_SIZE; i++)nn->input[i] = input[i];}forward(nn);printf("Prediction: %.8lf\n", nn->output[0]); int maiNeuralNetwork* nn = create_neural_network(; double input[4][2] ={0,0},{0,1},{1,0},{1,1}};double target[4] =0,1,1,};train(nn, input, target, 4);predict(nn, input[0]);predict(nn, input[1]);predict(nn, input[2]);predict(nn, input[3]);free(nn);return 0;```以上代码实现了一个简单的BP神经网络,该神经网络包含一个输入层、一个隐藏层和一个输出层。

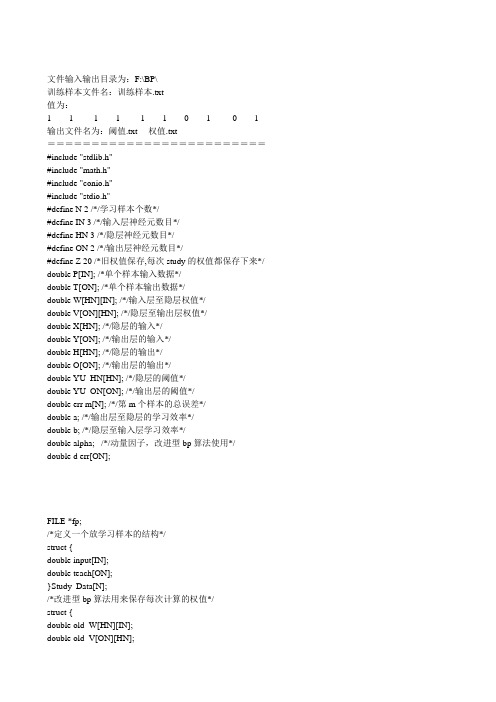

BP算法程序C语言实现

文件输入输出目录为:F:\BP\训练样本文件名:训练样本.txt值为:1 1 -1 1 -1 1 0 1 0 1 输出文件名为:阈值.txt 权值.txt=========================#include "stdlib.h"#include "math.h"#include "conio.h"#include "stdio.h"#define N 2 /*/学习样本个数*/#define IN 3 /*/输入层神经元数目*/#define HN 3 /*/隐层神经元数目*/#define ON 2 /*/输出层神经元数目*/#define Z 20 /*旧权值保存,每次study的权值都保存下来*/ double P[IN]; /*单个样本输入数据*/double T[ON]; /*单个样本输出数据*/double W[HN][IN]; /*/输入层至隐层权值*/double V[ON][HN]; /*/隐层至输出层权值*/double X[HN]; /*/隐层的输入*/double Y[ON]; /*/输出层的输入*/double H[HN]; /*/隐层的输出*/double O[ON]; /*/输出层的输出*/double YU_HN[HN]; /*/隐层的阈值*/double YU_ON[ON]; /*/输出层的阈值*/double err m[N]; /*/第m个样本的总误差*/double a; /*/输出层至隐层的学习效率*/double b; /*/隐层至输入层学习效率*/double alpha; /*/动量因子,改进型bp算法使用*/ double d err[ON];FILE *fp;/*定义一个放学习样本的结构*/struct {double input[IN];double teach[ON];}Study_Data[N];/*改进型bp算法用来保存每次计算的权值*/struct {double old_W[HN][IN];}Old_WV[Z];显示开始界面int Start_Show(){clrscr();printf("\n ***********************\n");printf(" * Welcome to use *\n");printf(" * this program of *\n");printf(" * calculating the BP *\n");printf(" * model! *\n");printf(" * Happy every day! *\n");printf(" ***********************\n");printf("\n\n Before starting, please read the follows carefully:\n\n");printf(" 1.Please ensure the Path of the '训练样本.txt'(xunlianyangben.txt) is \n correct, like 'F:\BP\训练样本.txt'!\n");printf(" 2.The calculating results will be saved in the Path of 'F:\\BP\\'!\n");printf(" 3.The program will load 10 datas when running from 'F:\\BP\\训练样本.txt'!\n");printf(" 4.The program of BP can study itself for no more than 30000 times.\n And surpassing the number, the program will be ended by itself in\n preventing running infinitely because of error!\n");printf("\n\n\n");printf("Now press any key to start...\n");getch();getch();clrscr();}显示结束界面int End_Show(){printf("\n\n---------------------------------------------------\n");printf("The program has reached the end successfully!\n\n Press any key to exit!\n\n");printf("\n ***********************\n");printf(" * This is the end *\n");printf(" * of the program which*\n");printf(" * can calculate the BP*\n");printf(" * model! *\n");printf(" ***********************\n");printf(" * Thanks for using! *\n");printf(" * Happy every day! *\n");printf(" ***********************\n");getch();exit(0);}获取训练样本GetTrainingData() /*OK*/{ int m,i,j;int datr;if((fp=fopen("f:\\bp\\训练样本.txt","r"))==NULL) /*读取训练样本*/{printf("Cannot open file and strike any key exit!");getch();exit(1);}m=0;i=0;j=0;while(fscanf(fp,"%d",&datr)!=EOF){ j++;if(j<=(N*IN)) /*N为学习样本个数;IN为输入层神经元数目*/{if(i<IN){Study_Data[m].input[i]=datr;/*printf("\nthe Study_Datat[%d].input[%d]=%f\n",m,i,Study_Data[m].input[i]);getch();*/ /*use to check the loaded training datas*/}if(m==(N-1)&&i==(IN-1)){m=0;i=-1;}if(i==(IN-1)){m++;i=-1;}}else if((N*IN)<J&&J<=(N*(IN+ON))){if(i<ON){Study_Data[m].teach[i]=datr;/*printf("\nThe Study_Data[%d].teach[%d]=%f",m,i,Study_Data[m].teach[i]);getch();*/ /*use to check the loaded training datas*/}if(m==(N-1)&&i==(ON-1))printf("\n");if(i==(ON-1)){m++;}}i++;}fclose(fp);printf("\nThere are [%d] datats that have been loaded successfully!\n",j);/*show the data which has been loaded!*/printf("\nShow the data which has been loaded as follows:\n");for(m=0;m<N;M++){for(i=0;i<IN;I++){printf("\nStudy_Data[%d].input[%d]=%f",m,i,Study_Data[m].input[i]);}for(j=0;j<ON;J++){printf("\nStudy_Data[%d].teach[%d]=%f",m,j,Study_Data[m].teach[j]);}}printf("\n\nPress any key to start calculating...");getch();return 1;}/*///////////////////////////////////*//*初始化权、阈值子程序*//*///////////////////////////////////*/initial(){int i;int ii;int j;int jj;int k;int kk;/*隐层权、阈值初始化*/for(i=0;i<HN;i++){for(j=1;j<IN;j++){W[i][j]=(double)((rand()/32767.0)*2-1); /*初始化输入层到隐层的权值,随机模拟0 和1 -1 */ printf("w[%d][%d]=%f\n",i,j,W[i][j]);}}for(ii=0;ii<ON;II++){{V[ii][jj]= (double)((rand()/32767.0)*2-1); /*初始化隐层到输出层的权值,随机模拟0 和1 -1*/ printf("V[%d][%d]=%f\n",ii,jj,V[ii][jj]);}}for(k=0;k<HN;K++){YU_HN[k] = (double)((rand()/32767.0)*2-1); /*隐层阈值初始化,-0.01 ~ 0.01 之间*/printf("YU_HN[%d]=%f\n",k,YU_HN[k]);}for(kk=0;kk<ON;KK++){YU_ON[kk] = (double)((rand()/32767.0)*2-1); /*输出层阈值初始化,-0.01 ~ 0.01 之间*/}return 1;}/*子程序initial()结束*//*//////////////////////////////////////////*//*第m个学习样本输入子程序*//*/////////////////////////////////////////*/input_P(int m){ int i,j;for(i=0;i<IN;I++){P[i]=Study_Data[m].input[i];printf("P[%d]=%f\n",i,P[i]);}/*获得第m个样本的数据*/return 1;}/*子程序input_P(m)结束*//*/////////////////////////////////////////*//*第m个样本教师信号子程序*//*/////////////////////////////////////////*/input_T(int m){int k;for(k=0;k<ON;k++)T[k]=Study_Data[m].teach[k];return 1;}/*子程序input_T(m)结束*/H_I_O(){double sigma;int i,j;for(j=0;j<HN;j++){sigma=0;{sigma+=W[j][i]*P[i];/*求隐层内积*/}X[j]=sigma-YU_HN[i];/*求隐层净输入,为什么减隐层的阀值*/ H[j]=1.0/(1.0+exp(-X[j]));/*求隐层输出siglon算法*/}return 1;}/*子程序H_I_O()结束*/O_I_O(){int k;int j;double sigma;for(k=0;k<ON;k++){sigma=0.0;for(j=0;j<HN;j++){sigma+=V[k][j]*H[k];}Y[k]=sigma-YU_ON[k];O[k]=1.0/(1.0+exp(-Y[k]));}return 1;}int Err_O_H(int m){int k;double abs_err[ON];double sqr_err=0;for (k=0;k<ON;k++){abs_err[k]=T[k]-O[k];sqr_err+=(abs_err[k])*(abs_err[k]);d_err[k]=abs_err[k]*O[k]*(1.0-O[k]);err_m[m]=sqr_err/2;}return 1;}double e_err[HN];int Err_H_I(){int j,k;double sigma;for(j=0;j<HN;j++){sigma=0.0;sigma+=d_err[k]*V[k][j];}e_err[j]=sigma*H[j]*(1-H[j]);}return 1;}saveWV(int m){int i;int ii;int j;int jj;for(i=0;i<HN;i++){for(j=0;j<IN;j++){Old_WV[m].old_W[i][j] = W[i][j];}}for(ii=0;ii<ON;ii++){for(jj=0;jj<HN;jj++){Old_WV[m].old_V[ii][jj] = V[ii][jj];}}return 1;}int Delta_O_H(int n) /*(int m,int n)*/ {int k,j;if(n<1) /*n<=1*/{for (k=0;k<ON;k++){for (j=0;j<HN;j++){V[k][j]=V[k][j]+a*d_err[k]*H[j];}YU_ON[k]+=a*d_err[k];}}else if(n>1){for (j=0;j<HN;j++){V[k][j]=V[k][j]+a*d_err[k]*H[j]+alpha*(V[k][j]-Old_WV[(n-1)].old_V[k][j]);}YU_ON[k]+=a*d_err[k];}}return 1;}Delta_H_I(int n) /*(int m,int n)*/{ int i,j;if(n<=1) /*n<=1*/{for (j=0;j<HN;j++){for (i=0;i<IN;i++){W[j][i]=W[j][i]+b*e_err[j]*P[i];}YU_HN[j]+=b*e_err[j];}}else if(n>1){for(j=0;j<HN;j++){for(i=0;i<IN;i++){W[j][i]=W[j][i]+b*e_err[j]*P[i]+alpha*(W[j][i]-Old_WV[(n-1)].old_W[j][i]);}YU_HN[j]+=b*e_err[j];}}return 1;}double Err_Sum(){int m;double total_err=0;for(m=0;m<N;m++){total_err+=err_m[m];}return total_err;}int ii,jj,kk;if((fp=fopen("f:\\bp\\权值.txt","a"))==NULL) /*save the result at f:\hsz\bpc\*.txt*/{printf("Cannot open file strike any key exit!");getch();exit(1);}fprintf(fp,"Save the result of “权值”(quanzhi) as follows:\n");for(i=0;i<HN;i++){for(j=0;j<IN;j++)fprintf(fp,"W[%d][%d]=%f\n",i,j,W[i][j]);}fprintf(fp,"\n");for(ii=0;ii<ON;ii++){for(jj=0;jj<HN;jj++)fprintf(fp,"V[%d][%d]=%f\n",ii,jj,V[ii][jj]);}fclose(fp);printf("\nThe result of “权值.txt”(quanzhi) has been saved successfully!\nPress any key to continue..."); getch();if((fp=fopen("f:\\bp\\阈值.txt","a"))==NULL) /*save the result at f:\hsz\bpc\*/{printf("Cannot open file strike any key exit!");getch();exit(1);}fprintf(fp,"Save the result of “输出层的阈值”(huozhi) as follows:\n");for(k=0;k<ON;K++)fprintf(fp,"YU_ON[%d]=%f\n",k,YU_ON[k]);fprintf(fp,"\nSave the resul t of “隐层的阈值为”(huozhi) as follows:\n");for(kk=0;kk<HN;KK++)fprintf(fp,"YU_HN[%d]=%f\n",kk,YU_HN[kk]);fclose(fp);printf("\nThe result of “阈值.txt”(huozhi) has been saved successfully!\nPress any key to continue..."); getch ();}/**********************//**程序入口,即主程序**//**********************/void main(){double Pre_error;int flag;flag=30000;a=0.7;b=0.7;alpha=0.9;study=0;Pre_error=0.0001;/*实际值为Pre_error=0.0001;*/Start_Show(); /*调用函数,显示开始界面*/GetTrainingData();initial ();do{int m;++study;for(m=0;m<N;m++){input_P(m);input_T(m);H_I_O();O_I_O();Err_O_H(m);Err_H_I();saveWV(m); /****************/Delta_O_H(m); /*(m,study)*/Delta_H_I(m); /*(m,study)*/}sum_err=Err_Sum();printf("sum_err=%f\n",sum_err);printf("Pre_error=%f\n\n",Pre_error);if(study>flag){printf("\n*******************************\n");printf("The program is ended by itself because of error!\n The learning times is surpassed!\n");printf("*****************************\n");getch();break;}} while (sum_err>Pre_error);printf("\n****************\n");printf("\nThe program have studyed for [%d] times!\n",study);printf("\n****************\n");savequan(); /*save the results,保存计算权值*/End_Show();}=========================={Save the result of “权值”(quanzhi) as follows:W[0][0]=0.350578W[0][1]=-1.008697W[0][2]=-0.962250W[1][0]=0.055661W[1][1]=-0.372367W[1][2]=-0.890795W[2][0]=0.129752W[2][1]=-0.332591W[2][2]=-0.521561V[0][0]=-2.932654V[0][1]=-3.720583V[0][2]=-2.648183V[1][0]=2.938970V[1][1]=1.633281V[1][2]=1.944077}阈值.txt{Save the result of “输出层的阈值”(huozhi) as follows: YU_ON[0]=-4.226843YU_ON[1]=1.501791Save the result of “隐层的阈值为”(huozhi) as follows: YU_HN[0]=-0.431459YU_HN[1]=0.452127YU_HN[2]=0.258449}==================================。

BP算法程序实现

BP算法程序实现BP算法(Back Propagation Algorithm,即反向传播算法)是一种用于训练神经网络的常用算法。

它的基本思想是通过不断地调整神经元之间的连接权值,使得网络的输出接近于期望的输出。

在实现BP算法时,需要进行以下几个步骤:1.初始化参数:首先,需要初始化神经网络的权值和偏置,通常可以使用随机的小数来初始化。

同时,需要设置好网络的学习率和最大迭代次数。

2.前向传播:通过前向传播过程,将输入数据输入到神经网络中,并计算出每个神经元的输出。

具体来说,对于第一层的神经元,它们的输出即为输入数据。

对于后续的层,可以使用如下公式计算输出:a[i] = sigmoid(z[i])其中,a[i]表示第i层的输出,z[i]为第i层的输入加权和,sigmoid为激活函数。

3.计算误差:根据网络的输出和期望的输出,可以计算出网络的误差。

一般来说,可以使用均方差作为误差的度量指标。

loss = 1/(2 * n) * Σ(y - a)^2其中,n为训练样本的数量,y为期望输出,a为网络的实际输出。

4.反向传播:通过反向传播算法,将误差从输出层向输入层逐层传播,更新权值和偏置。

具体来说,需要计算每一层神经元的误差,并使用如下公式更新权值和偏置:delta[i] = delta[i+1] * W[i+1]' * sigmoid_derivative(z[i])W[i] = W[i] + learning_rate * delta[i] * a[i-1]'b[i] = b[i] + learning_rate * delta[i]其中,delta[i]为第i层的误差,W[i]为第i层与i+1层之间的权值,b[i]为第i层的偏置,learning_rate为学习率,sigmoid_derivative为sigmoid函数的导数。

5.迭代更新:根据步骤4中的更新公式,不断迭代调整权值和偏置,直到达到最大迭代次数或误差小于一些阈值。

基于BP网络的自学习算法和C语言实现

步减 少 网络 的实际输 出和期 望输 出之 间的误 差 。 12 B P网络 的学 习算 法 设 B 网络 结 构 如 图 1所 示 。 假 设 给 定 训 练 P

nt : w h e h∑ T ; b b

b =feb 0 1 + x (n tn; f tn=, / ep 一 eb 门 O o t[P 【 ] 7 /1 + x fs m) uln Jh = . e p - u 0 O

集:

× i0Y 丢9 + ./ . n 告; =2 =

s m= u 入误 差 后 向传 播 , 将误 差值沿 连 接通 路逐 层传送 并修 正各层 连接 权值 本算 法是 对 6 习规则 的推广 学 和发 展 , 在权 值 更新算 式 中增加 了势 态项 以加 速收敛 过 程 。 习 因子 和势态 因子根 据 实验选 取 。 定 ・ 学 给 组

入总和记为, 输出记为 0 , 权值记为 Wi 则:

根误 差要求 时 , BP网络就 学 习好 了。 1 B P网络 学习算 法

州

E ∑ =

E 百∑ ( 一 1 y o} =

输 。模 式 I I

输 八层

一

若权 值 W. 的变化 量记 为 zW & . : 则有

6

权 可训

61

收 可调

隆

输 层

维普资讯

《 业控 制 计 算 机} 0 2年 1 工 2O 5卷 第 4期

1 3

基于 B P网络的 自学习算法和 C语言实现

尚 丽 中国科 学技 术 大 学经济技 术 学院机 电系(3 0 2 2 05 )

Ab tac st t

Th la nn ue o P n t rs s a c a a tr t t d ig f h vn e c e e c luain o e- e e r ig r l f B ewo k i h rce i i su yn o a ig ta h r sc Th ac lt fBP n t o wo k i t e e t n in n d v lp n o te ue Ths a t l if r h la nn c luai f B n t rs s h xe so a d e eo me t f h 8 r l i ri e ne s t e e r ig ac lt c on o P e- wo k n t m s o ie r i ig at r rs i er f gv n tann p t n.p o m s i u ig e r gr a t sn C a gu g ln a e.a d drws t e is c re b u nn n a h ba uv y r n ig t e prgr ia l.e e a lws o ewo k r oit d ou n o e p o r s ie s lt n r dvs d. h o m a Fn l s v r lf y a fBP n t rs ae p ne ta d s m r g e sv oui s a e a ie o Ke wo d :P e o k .}a nn ac lt n riig mo . s uc r g am,is c re y r sB n t rs e rig c luai .t nn deC o e p o r w o a r ba u v

编程实现标准bp算法和累积bp算法

编程实现标准BP算法和累积BP算法1. 介绍在机器学习和神经网络中,BP算法是一种常用的反向传播算法,用于训练神经网络。

标准BP算法是最基本的反向传播算法,而累积BP算法则是对标准BP算法的改进。

本文将介绍如何编程实现这两种算法,并比较它们之间的差异和优劣。

2. 标准BP算法标准BP算法是基于梯度下降的优化算法,用于调整神经网络中的权重和偏置,使得网络的输出与实际值之间的误差最小化。

其主要步骤包括前向传播和反向传播两个过程。

在前向传播过程中,输入数据经过各层神经元的计算,得到网络的输出;在反向传播过程中,根据输出误差,通过链式求导法则计算各层权重和偏置的梯度,并进行参数更新。

标准BP算法简单易懂,但容易陷入局部最优解,收敛速度慢。

3. 累积BP算法累积BP算法是对标准BP算法的改进,主要是通过累积历史梯度来更新参数,以加速收敛速度。

其主要思想是在计算梯度时,不仅考虑当前的梯度值,还考虑历史时刻的梯度值,通过对梯度进行累积,可以减小参数更新的方差,从而提高收敛速度。

累积BP算法相对于标准BP算法收敛速度更快,但在处理非凸函数时可能会出现震荡的现象。

4. 编程实现我们需要实现神经网络的前向传播和反向传播过程。

在前向传播过程中,根据输入数据和当前的权重和偏置,逐层计算神经元的输出;在反向传播过程中,根据输出误差,计算各层权重和偏置的梯度,并更新参数。

在标准BP算法中,参数更新公式为: [w^{(t+1)} = w^{(t)} - ]在累积BP算法中,参数更新公式为: [w^{(t+1)} = w^{(t)} - _{i=1}^{T} ]其中,(w^{(t)})为第t次迭代时的参数值,()为学习率,(E)为误差函数,(T)为累积的历史时刻个数。

5. 比较与总结标准BP算法和累积BP算法各有优劣。

标准BP算法简单易懂,但收敛速度较慢;累积BP算法收敛速度更快,但在处理非凸函数时可能会震荡。

在实际应用中,可以根据具体问题的特点选择合适的算法。

BP神经网络算法的C语言实现代码

//BP神经网络算法,c语言版本//VS2010下,无语法错误,可直接运行//添加了简单注释//欢迎学习交流#include <yerNum>#include <yerNum>#include <yerNum>#include <yerNum>#define N_Out 2 //输出向量维数#define N_In 3 //输入向量维数#define N_Sample 6 //样本数量//BP人工神经网络typedef struct{int LayerNum; //中间层数量double v[N_In][50]; //中间层权矩阵i,中间层节点最大数量为50double w[50][N_Out]; //输出层权矩阵double StudyRate; //学习率double Accuracy; //精度控制参数int MaxLoop; //最大循环次数} BPNet;//Sigmoid函数double fnet(double net){return 1/(1+exp(-net));}//初始化int InitBpNet(BPNet *BP);//训练BP网络,样本为x,理想输出为yint TrainBpNet(BPNet *BP, double x[N_Sample][N_In], int y[N_Sample][N_Out]) ; //使用BP网络int UseBpNet(BPNet *BP);//主函数int main(){//训练样本double x[N_Sample][N_In] = {{0.8,0.5,0},{0.9,0.7,0.3},{1,0.8,0.5},{0,0.2,0.3},{0.2,0.1,1.3},{0.2,0.7,0.8}};//理想输出int y[N_Sample][N_Out] = {{0,1},{0,1},{0,1},{1,1},{1,0},{1,0}};BPNet BP;InitBpNet(&BP); //初始化BP网络结构TrainBpNet(&BP, x, y); //训练BP神经网络UseBpNet(&BP); //测试BP神经网络return 1;}//使用BP网络int UseBpNet(BPNet *BP){double Input[N_In];double Out1[50];double Out2[N_Out]; //Out1为中间层输出,Out2为输出层输出//持续执行,除非中断程序while (1){printf("请输入3个数:\n");int i, j;for (i = 0; i < N_In; i++)scanf_s("%f", &Input[i]);double Tmp;for (i = 0; i < (*BP).LayerNum; i++){Tmp = 0;for (j = 0; j < N_In; j++)Tmp += Input[j] * (*BP).v[j][i];Out1[i] = fnet(Tmp);}for (i = 0; i < N_Out; i++){Tmp = 0;for (j = 0; j < (*BP).LayerNum; j++)Tmp += Out1[j] * (*BP).w[j][i];Out2[i] = fnet(Tmp);}printf("结果:");for (i = 0; i < N_Out; i++)printf("%.3f ", Out2[i]);printf("\n");}return 1;}//训练BP网络,样本为x,理想输出为yint TrainBpNet(BPNet *BP, double x[N_Sample][N_In], int y[N_Sample][N_Out]) {double f = (*BP).Accuracy; //精度控制参数double a = (*BP).StudyRate; //学习率int LayerNum = (*BP).LayerNum; //中间层节点数double v[N_In][50], w[50][N_Out]; //权矩阵double ChgH[50], ChgO[N_Out]; //修改量矩阵double Out1[50], Out2[N_Out]; //中间层和输出层输出量int MaxLoop = (*BP).MaxLoop; //最大循环次数int i, j, k, n;double Tmp;for (i = 0; i < N_In; i++)// 复制结构体中的权矩阵for (j = 0; j < LayerNum; j++)v[i][j] = (*BP).v[i][j];for (i = 0; i < LayerNum; i++)for (j = 0; j < N_Out; j++)w[i][j] = (*BP).w[i][j];double e = f + 1;//对每个样本训练网络for (n = 0; e > f && n < MaxLoop; n++){e = 0;for (i= 0; i < N_Sample; i++){//计算中间层输出向量for (k= 0; k < LayerNum; k++){Tmp = 0;for (j = 0; j < N_In; j++)Tmp = Tmp + x[i][j] * v[j][k];Out1[k] = fnet(Tmp);}//计算输出层输出向量for (k = 0; k < N_Out; k++){Tmp = 0;for (j = 0; j < LayerNum; j++)Tmp = Tmp + Out1[j] * w[j][k];Out2[k] = fnet(Tmp);}//计算输出层的权修改量for (j = 0; j < N_Out; j++)ChgO[j] = Out2[j] * (1 - Out2[j]) * (y[i][j] - Out2[j]);//计算输出误差for (j = 0; j < N_Out ; j++)e = e + (y[i][j] - Out2[j]) * (y[i][j] - Out2[j]);//计算中间层权修改量for (j = 0; j < LayerNum; j++){Tmp = 0;for (k = 0; k < N_Out; k++)Tmp = Tmp + w[j][k] * ChgO[k];ChgH[j] = Tmp * Out1[j] * (1 - Out1[j]);}//修改输出层权矩阵for (j = 0; j < LayerNum; j++)for (k = 0; k < N_Out; k++)w[j][k] = w[j][k] + a * Out1[j] * ChgO[k];for (j = 0; j < N_In; j++)for (k = 0; k < LayerNum; k++)v[j][k] = v[j][k] + a * x[i][j] * ChgH[k];}if (n % 10 == 0)printf("误差: %f\n", e);}printf("总共循环次数:%d\n", n);printf("调整后的中间层权矩阵:\n");for (i = 0; i < N_In; i++){for (j = 0; j < LayerNum; j++)printf("%f ", v[i][j]);printf("\n");}printf("调整后的输出层权矩阵:\n");for (i = 0; i < LayerNum; i++) {for (j = 0; j < N_Out; j++)printf("%f ", w[i][j]);printf("\n");}//把结果复制回结构体for (i = 0; i < N_In; i++)for (j = 0; j < LayerNum; j++)(*BP).v[i][j] = v[i][j];for (i = 0; i < LayerNum; i++)for (j = 0; j < N_Out; j++)(*BP).w[i][j] = w[i][j];printf("BP网络训练结束!\n");return 1;}//初始化int InitBpNet(BPNet *BP){printf("请输入中间层节点数,最大数为100:\n");scanf_s("%d", &(*BP).LayerNum);printf("请输入学习率:\n");scanf_s("%lf", &(*BP).StudyRate); //(*BP).StudyRate为double型数据,所以必须是lf printf("请输入精度控制参数:\n");scanf_s("%lf", &(*BP).Accuracy);printf("请输入最大循环次数:\n");scanf_s("%d", &(*BP).MaxLoop);int i, j;srand((unsigned)time(NULL));for (i = 0; i < N_In; i++)for (j = 0; j < (*BP).LayerNum; j++)(*BP).v[i][j] = rand() / (double)(RAND_MAX);for (i = 0; i < (*BP).LayerNum; i++)for (j = 0; j < N_Out; j++)(*BP).w[i][j] = rand() / (double)(RAND_MAX);return 1;}。

C++实现神经BP神经网络

C++实现神经BP神经⽹络本⽂实例为⼤家分享了C++实现神经BP神经⽹络的具体代码,供⼤家参考,具体内容如下BP.h#pragma once#include<vector>#include<stdlib.h>#include<time.h>#include<cmath>#include<iostream>using std::vector;using std::exp;using std::cout;using std::endl;class BP{private:int studyNum;//允许学习次数double h;//学习率double allowError;//允许误差vector<int> layerNum;//每层的节点数,不包括常量节点1vector<vector<vector<double>>> w;//权重vector<vector<vector<double>>> dw;//权重增量vector<vector<double>> b;//偏置vector<vector<double>> db;//偏置增量vector<vector<vector<double>>> a;//节点值vector<vector<double>> x;//输⼊vector<vector<double>> y;//期望输出void iniwb();//初始化w与bvoid inidwdb();//初始化dw与dbdouble sigmoid(double z);//激活函数void forward();//前向传播void backward();//后向传播double Error();//计算误差public:BP(vector<int>const& layer_num, vector<vector<double>>const & input_a0,vector<vector<double>> const & output_y, double hh = 0.5, double allerror = 0.001, int studynum = 1000); BP();void setLayerNumInput(vector<int>const& layer_num, vector<vector<double>> const & input);void setOutputy(vector<vector<double>> const & output_y);void setHErrorStudyNum(double hh, double allerror,int studynum);void run();//运⾏BP神经⽹络vector<double> predict(vector<double>& input);//使⽤已经学习好的神经⽹络进⾏预测~BP();};BP.cpp#include "BP.h"BP::BP(vector<int>const& layer_num, vector<vector<double>>const & input,vector<vector<double>> const & output_y, double hh, double allerror,int studynum){layerNum = layer_num;x = input;//输⼊多少个节点的数据,每个节点有多少份数据y = output_y;h = hh;allowError = allerror;a.resize(layerNum.size());//有这么多层⽹络节点for (int i = 0; i < layerNum.size(); i++){a[i].resize(layerNum[i]);//每层⽹络节点有这么多个节点for (int j = 0; j < layerNum[i]; j++)a[i][j].resize(input[0].size());}a[0] = input;studyNum = studynum;}BP::BP(){a = {};y = {};h = 0;allowError = 0;}BP::~BP(){}void BP::setLayerNumInput(vector<int>const& layer_num, vector<vector<double>> const & input) {layerNum = layer_num;x = input;a.resize(layerNum.size());//有这么多层⽹络节点for (int i = 0; i < layerNum.size(); i++){a[i].resize(layerNum[i]);//每层⽹络节点有这么多个节点for (int j = 0; j < layerNum[i]; j++)a[i][j].resize(input[0].size());}a[0] = input;}void BP::setOutputy(vector<vector<double>> const & output_y){y = output_y;}void BP::setHErrorStudyNum(double hh, double allerror,int studynum){h = hh;allowError = allerror;studyNum = studynum;}//初始化权重矩阵void BP::iniwb(){w.resize(layerNum.size() - 1);b.resize(layerNum.size() - 1);srand((unsigned)time(NULL));//节点层数层数for (int l = 0; l < layerNum.size() - 1; l++){w[l].resize(layerNum[l + 1]);b[l].resize(layerNum[l + 1]);//对应后层的节点for (int j = 0; j < layerNum[l + 1]; j++){w[l][j].resize(layerNum[l]);b[l][j] = -1 + 2 * (rand() / RAND_MAX);//对应前层的节点for (int k = 0; k < layerNum[l]; k++)w[l][j][k] = -1 + 2 * (rand() / RAND_MAX);}}}void BP::inidwdb(){dw.resize(layerNum.size() - 1);db.resize(layerNum.size() - 1);//节点层数层数for (int l = 0; l < layerNum.size() - 1; l++){dw[l].resize(layerNum[l + 1]);db[l].resize(layerNum[l + 1]);//对应后层的节点for (int j = 0; j < layerNum[l + 1]; j++){dw[l][j].resize(layerNum[l]);db[l][j] = 0;for (int k = 0; k < layerNum[l]; k++)w[l][j][k] = 0;}}}//激活函数double BP::sigmoid(double z){return 1.0 / (1 + exp(-z));}void BP::forward(){for (int l = 1; l < layerNum.size(); l++){for (int i = 0; i < layerNum[l]; i++){for (int j = 0; j < x[0].size(); j++){a[l][i][j] = 0;//第l层第i个节点第j个数据样本//计算变量节点乘权值的和for (int k = 0; k < layerNum[l - 1]; k++)a[l][i][j] += a[l - 1][k][j] * w[l - 1][i][k];//加上节点偏置a[l][i][j] += b[l - 1][i];a[l][i][j] = sigmoid(a[l][i][j]);}}}}void BP::backward(){int xNum = x[0].size();//样本个数//daP第l层da,daB第l+1层davector<double> daP, daB;for (int j = 0; j < xNum; j++){//处理最后⼀层的dwdaP.clear();daP.resize(layerNum[layerNum.size() - 1]);for (int i = 0, l = layerNum.size() - 1; i < layerNum[l]; i++){daP[i] = a[l][i][j] - y[i][j];for (int k = 0; k < layerNum[l - 1]; k++)dw[l - 1][i][k] += daP[i] * a[l][i][j] * (1 - a[l][i][j])*a[l - 1][k][j]; db[l - 1][i] += daP[i] * a[l][i][j] * (1 - a[l][i][j]);}//处理剩下层的权重w的增量Dwfor (int l = layerNum.size() - 2; l > 0; l--){daB = daP;daP.clear();daP.resize(layerNum[l]);for (int k = 0; k < layerNum[l]; k++){daP[k] = 0;for (int i = 0; i < layerNum[l + 1]; i++)daP[k] += daB[i] * a[l + 1][i][j] * (1 - a[l + 1][i][j])*w[l][i][k]; //dwfor (int i = 0; i < layerNum[l - 1]; i++)dw[l - 1][k][i] += daP[k] * a[l][k][j] * (1 - a[l][k][j])*a[l - 1][i][j]; //dbdb[l-1][k] += daP[k] * a[l][k][j] * (1 - a[l][k][j]);}}}//计算dw与db平均值{//对应后层的节点for (int j = 0; j < layerNum[l + 1]; j++){db[l][j] = db[l][j] / xNum;//对应前层的节点for (int k = 0; k < layerNum[l]; k++)w[l][j][k] = w[l][j][k] / xNum;}}//更新参数w与bfor (int l = 0; l < layerNum.size() - 1; l++){for (int j = 0; j < layerNum[l + 1]; j++){b[l][j] = b[l][j] - h * db[l][j];//对应前层的节点for (int k = 0; k < layerNum[l]; k++)w[l][j][k] = w[l][j][k] - h * dw[l][j][k];}}}double BP::Error(){int l = layerNum.size() - 1;double temp = 0, error = 0;for (int i = 0; i < layerNum[l]; i++)for (int j = 0; j < x[0].size(); j++){temp = a[l][i][j] - y[i][j];error += temp * temp;}error = error / x[0].size();//求对每⼀组样本的误差平均 error = error / 2;cout << error << endl;return error;}//运⾏神经⽹络void BP::run(){iniwb();inidwdb();int i = 0;for (; i < studyNum; i++){forward();if (Error() <= allowError){cout << "Study Success!" << endl;break;}backward();}if (i == 10000)cout << "Study Failed!" << endl;}vector<double> BP::predict(vector<double>& input) {vector<vector<double>> a1;a1.resize(layerNum.size());for (int l = 0; l < layerNum.size(); l++)a1[l].resize(layerNum[l]);a1[0] = input;for (int l = 1; l < layerNum.size(); l++)for (int i = 0; i < layerNum[l]; i++){a1[l][i] = 0;//第l层第i个节点第j个数据样本//计算变量节点乘权值的和for (int k = 0; k < layerNum[l - 1]; k++)a1[l][i] += a1[l - 1][k] * w[l - 1][i][k];//加上节点偏置a1[l][i] = sigmoid(a1[l][i]);}return a1[layerNum.size() - 1];}验证程序:#include"BP.h"int main(){vector<int> layer_num = { 1, 10, 1 };vector<vector<double>> input_a0 = { { 1,2,3,4,5,6,7,8,9,10 } };vector<vector<double>> output_y = { {0,0,0,0,1,1,1,1,1,1} };BP bp(layer_num, input_a0,output_y,0.6,0.001, 2000);bp.run();for (int j = 0; j < 30; j++){vector<double> input = { 0.5*j };vector<double> output = bp.predict(input);for (auto i : output)cout << "j:" << 0.5*j <<" pridict:" << i << " ";cout << endl;}system("pause");return 0;}输出:以上就是本⽂的全部内容,希望对⼤家的学习有所帮助,也希望⼤家多多⽀持。

BP神经网络C语言代码 可以直接VC++上运行

//输出只有一个,如果多个,增加输出

return sum*(Maxout[0]-Minout[0]+1)+Minout[0]-1; //数据反归一化,回来到原来的值 }

void writeNeuron() {

FILE *fp1; int i,j; if((fp1=fopen("neuron.txt","w"))==NULL) {

//输入数据归一化处理 for (i = 0; i < In; i++)

for(j = 0; j < Data; j++) d_in[j][i]=(d_in[j][i]-Minin[i]+1)/(Maxin[i]-Minin[i]+1);

//输出数据归一化处理 for (i = 0; i < Out; i++)

writeNeuron();

return 0;

//测试数据 1

}

for (i = 0; i < Neuron; ++i) for (j = 0; j < Out; ++j){ fprintf(fp1,"%lf ",v[j][i]); }

fclose(fp1); }

void trainNetwork() {

int i,c=0;

do{

e=0;

for (i = 0; i < Data; ++i)

}

void computO(int var) //var 为某一个样本数据 {

int i,j; double sum,y; for (i = 0; i < Neuron; ++i) 个神经元的值 {

c语言编bp算法及使用说明

c语言编bp算法及使用说明训练样本数据文件sample.txt输入格式:(单样本对)(x1,x2,x3....xh,d1,d2,d3,...dj)测试样本数据输入:(从键盘输入)x1,x2,x3...xh屏幕输出:y1,y2,y3...yj在确定网络结构以后,即可确定(输入层)nh,(隐层)ni,(输出层)nj,(样本容量)nk每次使用之前请修改网络结构数据。

#include <stdio.h>#include <math.h>#include <conio.h>#include <stdlib.h>#define nh 4 //输入层节点个数#define ni 9 //隐层节点个数#define nj 3 //输出层节点个数#define nk 30 //样本个数#define nr 0.85/*学习效率*/#define EPS 0.00001float x[nk][nh],//每个样本在输入层每个节点的值d[nk][nj],// 每个样本在输出层每个节点的值whi[nh][ni] ,//输入层和隐藏层每个节点的连接权重wij[ni][nj],// 隐藏层和输出层的连接权重thi[ni],thj[nj];// 隐藏层和输出层每个节点的阈植int h,i,j,k;float xmin[nh],xmax[nh],//存放输入层中每个属性节点的最小和最大值,便于归一化dmin[nj],dmax[nj];FILE *fp1,*fp2;void init(void);void startleaning(void);void testsample(void);void readw(void);void writew(void);float sigmoid(float a);double ranu(void);void init(void){int min,max;if(fp1==0){clrscr();printf("Can not find the learning sample file!\n");exit(0);}for(k=0;k<nk;k++) //对每一个输入样本进行处理,输入每个训练样本和类别信息{for(h=0;h<nh;h++)fscanf(fp1,"%f",&x[k][h]);for(j=0;j<nj;j++)fscanf(fp1,"%f",&d[k][j]);}for(h=0;h<nh;h++) //对输入层的每个节点进行处理{min=1;max=1;for(k=0;k<nk;k++) //在输入层接点上,对每个样本{if(x[k][h]<x[min][h]) min=k;if(x[k][h]>x[max][h]) max=k;}xmin[h]=x[min][h]; //所有样本中h属性上最小的值xmax[h]=x[max][h];for(k=0;k<nk;k++)/*归一化*/x[k][h]=(x[k][h]-xmin[h])/(xmax[h]-xmin[h]);}for(j=0;j<nj;j++){min=1;max=1;for(k=0;k<nk;k++){if(d[k][j]<d[min][j]) min=k;if(d[k][j]>d[max][j]) max=k;}dmin[j]=d[min][j];dmax[j]=d[max][j];for(k=0;k<nk;k++)/*归一化*/d[k][j]=(d[k][j]-dmin[j])/(dmax[j]-dmin[j]);}}/*----------------------------------------------------*/void startlearning(void){long int nt,n;floatt,error[nk],gerror,xj[nj],xi[ni],yj[nj],yi[ni],pxi[ni],pxj[ nj];if(fp2==0){for(i=0;i<ni;i++) //初始化权重和阈值{for(h=0;h<nh;h++)whi [h] [i]=-0.1+0.2*ranu();for(j=0;j<nj;j++)wij[i] [j]=-0.1+0.2*ranu();thi[i]=-0.1+0.2*ranu();}for(j=0;j<nj;j++)thj[j]=-0.1+0.2*ranu();fp2=fopen("w.txt","w+");}elsereadw();/*学习开始*/printf("\t\nPlease enter the learning times:\n"); scanf("%ld",&nt);for(n=0;n<nt;n++) /*学习次数*/{gerror=0;for(k=0;k<nk;k++)/*单样本循环*/{for(i=0;i<ni;i++){t=0;for(h=0;h<nh;h++)t+=whi[h] [i]*x[k][h];xi=t+thi; 隐藏层的输入yi=sigmoid(xi); 隐藏层的输出}for(j=0;j<nj;j++){t=0;for(i=0;i<ni;i++)t+=wij[j]*yi;xj[j]=t+thj[j];yj[j]=sigmoid(xj[j]); 输出层的输出}for(j=0;j<nj;j++)/*输出层单样本点误差变化率*/ pxj[j]=yj[j]*(1-yj[j])*(yj[j]-d[k][j]);for(i=0;i<ni;i++)/*隐层单样本点误差变化率*/{t=0;for(j=0;j<nj;j++)t+=pxj[j]*wij[j];pxi=yi*(1-yi)*t;}for(j=0;j<nj;j++){thj[j]=thj[j]-nr*pxj[j]; //输出层权重和阈值的更新for(i=0;i<ni;i++)wij[j]=wij[j]-nr*pxj[j]*yi;}for(i=0;i<ni;i++){thi=thi-nr*pxi;for(h=0;h<nh;h++)whi[h]=whi[h]-nr*pxi*x[k][h]; //隐藏层权重和阈值的更新}t=0;for(j=0;j<nj;j++)t+=(yj[j]-d[k][j])*(yj[j]-d[k][j])/2.0;error[k]=t; //第 k个样本的误差gerror+=error[k];/*全局误差 g(lobal)error*/}/*单样本循环结束*/if(gerror<EPS) break;}/* 学习循环结束*/writew();printf("\t\nGlobal error=%f\n",gerror);printf("\t\nAre you satisfied with the global error?\n"); printf("Press any key to choose a next task!\n");getch();}/*-------------------------------------------------*/void testsample(void) //测试{float tx[nh],t,xj[nj],xi[ni],yj[nj],yi[ni];if(fp2==0){clrscr();printf("\t\ncan not find the weight file:w.txt\n");exit(0);}readw();printf("\t\nPlease enter the test data:\n");for(h=0;h<nh;h++)scanf("%f",&tx[h]);for(h=0;h<nh;h++)tx[h]=(tx[h]-xmin[h])/(xmax[h]-xmin[h]);//测试样本归一化 for(i=0;i<ni;i++){t=0;for(h=0;h<nh;h++)t+=whi[h]*tx[h];xi=t+thi;yi=sigmoid(xi);}for(j=0;j<nj;j++){t=0;for(i=0;i<ni;i++)t+=wij[j]*yi;xj[j]=t+thj[j];yj[j]=sigmoid(xj[j]);}printf("\t\nNetwork output:\n");for(j=0;j<nj;j++){yj[j]=yj[j]*(dmax[j]-dmin[j])+dmin[j];printf("%f ",yj[j]);}printf("\t\nAre you satisfied with the output?\n"); printf("Press any key to choose a next task!\n"); getch();}/*----------------------------------------------*/ void writew(void){rewind(fp2);for(h=0;h<nh;h++){for(i=0;i<ni;i++)fprintf(fp2,"%8.3f ",whi[h]);fprintf(fp2,"\n");}fprintf(fp2,"\n");for(i=0;i<ni;i++)fprintf(fp2,"%8.3f ",thi);fprintf(fp2,"\n\n");for(j=0;j<nj;j++){for(i=0;i<ni;i++)fprintf(fp2,"%8.3f ",wij[j]);fprintf(fp2,"\n");}fprintf(fp2,"\n");for(j=0;j<nj;j++)fprintf(fp2,"%8.3f ",thj[j]);}/*------------------------------------------------*/ void readw(void){for(h=0;h<nh;h++)for(i=0;i<ni;i++)fscanf(fp2,"%f",&whi[h]);for(i=0;i<ni;i++)fscanf(fp2,"%f",&thi);for(j=0;j<nj;j++)for(i=0;i<ni;i++)fscanf(fp2,"%f",&wij[j]);for(j=0;j<nj;j++)fscanf(fp2,"%f",&thj[j]);}/*--------------------------------*/ float sigmoid(float a){return(1.0/(1+exp(-a)));}/*----------------------------------*/ double ranu(void){static double xrand=3.0;double m=8589934592.0,a=30517578125.0;lp: xrand=fmod(xrand*a,m);if(xrand>1.0) return(xrand/m);else { xrand=1.0;goto lp;}}/*----------------------------------*/void main(){fp1=fopen("sample.txt","r");fp2=fopen("w.txt","r+");init();while(1){clrscr();printf("\t\n Please choose a next task...\n\n"); printf("\t\n (S) to start learning.\n");printf("\t\n (T) to test samples.\n");printf("\t\n (R) to resume learning.\n");printf("\t\n (Q)uit.\n");switch(getchar()){case 's': startlearning();break;case 't': testsample();break;case 'r': startlearning();break;case 'q': exit(0);break;}}fclose(fp1);fclose(fp2); }。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

}

for (k = 0; k < OUT_COUT; k++)

{ //计算输出层输出向量

temp = 0;

for (j = 0; j < h; j++)

}

int TrainBp(bp_nn *bp, double x[COUT][IN_COUT], int y[COUT][OUT_COUT])

{ //训练bp网络,样本为x,理想输出为y

double f = (*bp).b; //精度控制参数

srand((unsigned) time(&t));

还有一个经常用法,不需要定义time_t型t变量,即:

srand((unsigned) time(NULL));

直接传入一个空指针,因为你的程序中往往并不需要经过参数获得的t数据。*/

e = e + (y[i][j] - O2[j]) * (y[i][j] - O2[j]);

for (j = 0; j < h; j++)

{ //计算隐层权修改量

temp = 0;

double a = (*bp).a; //学习率

int h = (*bp).h; //隐层节点数

double v[IN_COUT][50], w[50][OUT_COUT]; //权矩阵

while (1)

{ //持续执行,除非中断程序

for (k = 0; k < OUT_COUT; k++)

temp = temp + w[j][k] * ChgO[k];

ChgH[j] = temp * O1[j] * (1 - O1[j]);

if (n % 10 == 0)

printf("误差 : %f\n", e);

}

printf("总共循环次数:%d\n", n);

printf("调整后的隐层权矩阵:\n");

for (i = 0; i < IN_COUT; i++)

{ //Sigmoid函数,神经网络激活函数

return 1/(1+exp(-net));

}

int InitBp(bp_nn *bp)

{ //初始化bp网络

printf("请输入隐层节点数,最大数为100:\n");

#include "iostream.h"

#include <stdlib.h>

#include <math.h>

#include <stdio.h>

#include <time.h>

#define OUT_COUT 2 //输出向量维数

#define IN_COUT 3 //输入向量维数

for (i = 0; i < (*bp).h; i++)

for (j = 0; j < OUT_COUT; j++)

(*bp).w[i][j] = rand() / (double)(RAND_MAX);

return 1;

#define COUT 6 //样本数量

typedef struct { //bp人工神经网络结构

int h; //实际使用隐层数量

double v[IN_COUT][50]; //隐藏层权矩阵i,隐层节点最大数量为50

for (j = 0; j < IN_COUT; j++)

for (k = 0; k < h; k++)

v[j][k] = v[j][k] + a * x[i][j] * ChgH[k];

}

double w[50][OUT_COUT]; //输出层权矩阵

double a; //学习率

double b; //精度控制参数

int LoopCout; //最大循环次数

} bp_nn;

double fnet(double net)

{

for (j = 0; j < h; j++)

printf("%6f ", v[i][j]);

printf("\n");

}

printf("调整后的输出层权矩阵:\n");

for (i = 0; i < h; i++)

temp = temp + O1[j] * w[j][k]; //

O2[k] = fnet(temp);

}

for (j = 0; j < h; j++)

(*bp).v[i][j] = v[i][j];

for (i = 0; i < h; i++)

for (j = 0; j < OUT_COUT; j++)

(*bp).w[i][j] = w[i][j];

for (j = 0; j < OUT_COUT; j++) //计算输出层的权修改量

ChgO[j] = O2[j] * (1 - O2[j]) * (y[i][j] - O2[j]);

for (j = 0; j < OUT_COUT ; j++) //计算输出误差

for (i = 0; i < IN_COUT; i++)

for (j = 0; j < (*bp).h; j++)

(*bp).v[i][j] = rand() / (double)(RAND_MAX); //RAND_MAX是系统值,本机为32767

}

for (j = 0; j < h; j++) //修改输出层权矩阵

for (k = 0; k < OUT_COUT; k++)

w[j][k] = w[j][k] + a * O1[j] * ChgO[k];

srand((unsigned) time(&t));

srand函数是随机数发生器的初始化函数,原型:

void srand(unsigned seed);

它需要提供一个种子,如:

srand(1);

scanf("%d", &(*bp).h);

printf("请输入学习率:\n");

scanf("%lf", &(*bp).a); //(*bp).a为double型数据,所以必须是lf

printf("请输入精度控制参数:\n");

scanf("%lf", &(*bp).b);

printf("bp网络训练结束!\n");

return 1;

}

int UseBp(bp_nn *bp)

{ //使用bp网络

float Input[IN_COUT];

double O1[50];

double O2[OUT_COUT]; //O1为隐层输出,O2为输出层输出

double ChgH[50], ChgO[OUT_COUT]; //修改量矩阵

double O1[50], O2[OUT_COUT]; //隐层和输出层输出量

int LoopCout = (*bp).LoopCout; //最大循环次数

{ //对每个样本训练网络

e = 0;

for (i= 0; i < COUT; i++)

{

for (k= 0; k < h; k++)

{ //计算隐层输出向量

temp = 0;

for (j = 0; j < IN_COUT; j++)

temp = temp + x[i][j] * v[j][k]; //

int i, j, k, n;

double temp;

for (i = 0; i < IN_COUT; i++) //复制结构体中的权矩阵

for (j = 0; j < h; j++)

v[i][j] = (*bp).v[i][j];

直接使用1来初始化种子。不过常常使用系统时间来初始化,即使用

time函数来获得系统时间,它的返回值为从 00:00:00 GMT, January 1, 1970

到现在所持续的秒数,然后将time_t型数据转化为(unsigned)型在传给srand函数,即:

{

for (j = 0; j < OUT_COUT; j++)

printf("%f ", w[i][j]);

printf("\n");

}

for (i = 0; i < IN_COUT; i++) //把结果复制回结构体

for (i = 0; i < h; i++)

for (j = 0; j < OUT_COUT; j++)

w[i][j] = (*bp).w[i][j];

double e = f + 1; //f 是精度控制参数