kNN算法c语言实现

knn算法的实现方法

knn算法的实现方法KNN算法是一种常见的分类算法,其全称为K-Nearest Neighbor算法,即K近邻算法。

该算法的基本思想是:对于一个未知样本,找到与其最近的K个已知样本,将这K个样本中出现最多的类别作为该未知样本的类别。

KNN算法的实现方法主要包括以下几个步骤:1. 数据预处理在使用KNN算法进行分类之前,需要对数据进行预处理。

预处理的主要目的是将数据转换为算法能够处理的形式。

具体来说,需要将数据转换为数值型数据,并进行归一化处理。

这样可以避免不同特征之间的差异对分类结果的影响。

2. 计算距离KNN算法的核心是计算样本之间的距离。

常用的距离计算方法有欧氏距离、曼哈顿距离、切比雪夫距离等。

在计算距离时,需要考虑不同特征之间的权重,以避免某些特征对距离的影响过大。

3. 选择K值K值的选择对KNN算法的分类结果有很大的影响。

一般来说,K值越小,模型越复杂,容易出现过拟合;K值越大,模型越简单,容易出现欠拟合。

因此,需要通过交叉验证等方法来选择合适的K值。

4. 进行分类在计算出样本之间的距离并选择好K值之后,就可以进行分类了。

具体来说,需要找到与未知样本最近的K个已知样本,并统计这K个样本中出现最多的类别。

将该类别作为未知样本的类别即可。

KNN算法的优缺点:优点:1. 简单易懂,易于实现。

2. 对于非线性数据具有较好的分类效果。

3. 对于小样本数据具有较好的分类效果。

缺点:1. 计算复杂度高,需要计算每个未知样本与所有已知样本之间的距离。

2. 对于高维数据,距离计算会受到维度灾难的影响。

3. 对于不平衡数据,容易出现分类偏差。

总结:KNN算法是一种简单易懂的分类算法,其实现方法也比较简单。

但是,KNN算法也存在一些缺点,如计算复杂度高、对高维数据不适用等。

因此,在实际应用中需要根据具体情况选择合适的算法。

卡尔曼滤波代码c

卡尔曼滤波代码c卡尔曼滤波是一种常用的估计和预测算法,广泛应用于信号处理、控制系统、机器学习等领域。

本文将介绍卡尔曼滤波的原理,并提供一个简单的C语言实现示例。

卡尔曼滤波是一种基于线性高斯模型的递推滤波算法。

它通过将系统的状态分为观测变量和内部状态变量,并建立观测模型和状态转移模型来估计系统的内部状态。

卡尔曼滤波的基本思想是,通过对观测数据进行动态修正和整合,提高对内部状态的估计精度。

以下是一个简单的C语言实现示例,用于演示一维卡尔曼滤波的过程:```c#include <stdio.h>#define Q 0.01 // 系统噪声协方差#define R 0.1 // 观测噪声协方差float kalman_filter(float z){static float x_hat = 0; // 状态估计static float P = 1; // 状态估计协方差static float K = 0; // 卡尔曼增益// 预测float x_hat_minus = x_hat; // 先验估计float P_minus = P + Q; // 先验估计协方差// 更新K = P_minus / (P_minus + R); // 计算卡尔曼增益x_hat = x_hat_minus + K * (z - x_hat_minus); // 更新状态估计P = (1 - K) * P_minus; // 更新状态估计协方差return x_hat;}int main() {float measurements[] = {1.1, 1.2, 1.3, 1.4, 1.5}; // 观测数据int num_measurements = sizeof(measurements) / sizeof(measurements[0]);for (int i = 0; i < num_measurements; ++i) {float estimate = kalman_filter(measurements[i]);printf("Measurement: %.1f, Estimate: %.3f\n", measurements[i], estimate);}return 0;}```在上述示例代码中,我们定义了卡尔曼滤波的噪声协方差Q和R,分别表示系统和观测的噪声。

K近邻算法(KNN)的C++实现

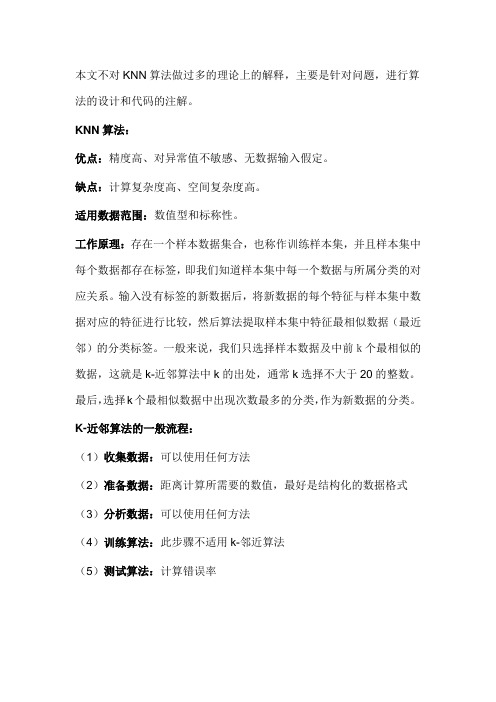

本文不对KNN算法做过多的理论上的解释,主要是针对问题,进行算法的设计和代码的注解。

KNN算法:优点:精度高、对异常值不敏感、无数据输入假定。

缺点:计算复杂度高、空间复杂度高。

适用数据范围:数值型和标称性。

工作原理:存在一个样本数据集合,也称作训练样本集,并且样本集中每个数据都存在标签,即我们知道样本集中每一个数据与所属分类的对应关系。

输入没有标签的新数据后,将新数据的每个特征与样本集中数据对应的特征进行比较,然后算法提取样本集中特征最相似数据(最近邻)的分类标签。

一般来说,我们只选择样本数据及中前k个最相似的数据,这就是k-近邻算法中k的出处,通常k选择不大于20的整数。

最后,选择k个最相似数据中出现次数最多的分类,作为新数据的分类。

K-近邻算法的一般流程:(1)收集数据:可以使用任何方法(2)准备数据:距离计算所需要的数值,最好是结构化的数据格式(3)分析数据:可以使用任何方法(4)训练算法:此步骤不适用k-邻近算法(5)测试算法:计算错误率(6)使用算法:首先需要输入样本数据和结构化的输出结果,然后运行k-近邻算法判定输入数据分别属于哪个分类,最后应用对计算出的分类执行后续的处理。

问题一:现在我们假设一个场景,就是要为左边上的点进行分类,如下图所示:上图一共12个左边点,每个坐标点都有相应的坐标(x,y)以及它所属的类别A/B,那么现在需要做的就是给定一个点坐标(x1,y1),判断它属于的类别A或者B。

所有的坐标点在data.txt文件中:0.0 1.1 A1.0 1.0 A2.0 1.0 B0.5 0.5 A2.5 0.5 B0.0 0.0 A1.0 0.0 A2.0 0.0 B3.0 0.0 B0.0 -1.0 A1.0 -1.0 A2.0 -1.0 Bstep1:通过类的默认构造函数去初始化训练数据集dataSet和测试数据testData。

step2:用get_distance()来计算测试数据testData和每一个训练数据dataSet[index]的距离,用map_index_dis来保存键值对<index,distance>,其中index代表第几个训练数据,distance代表第index个训练数据和测试数据的距离。

knnC++代码

engPutVariable(ep, "Y", Y);

engEvalString(ep, "scatter(T(:,1),T(:,4),'r+');");

engEvalString(ep, "hold on;");

engEvalString(ep, "scatter(T(:,2),T(:,5),'r*');");

}

void SeekPath(KD &p)//保存搜索路径

{

if (p != NULL)

{

int split = p->split;

if (a[split] < p->node_data[split])

{

path.push_back(p);

for (int j = 0; j < dim+1; j++)

leftDate[i].push_back(data[i][j]);

sumLeft = i+1;

}

if (middle + 1 < n)

{

for (int i = middle + 1; i < n; i++)

printR();

}

KD ReturnN()

{

return nearest;

}

private:

double Distance(vector<double> data)

KNN算法c++实现

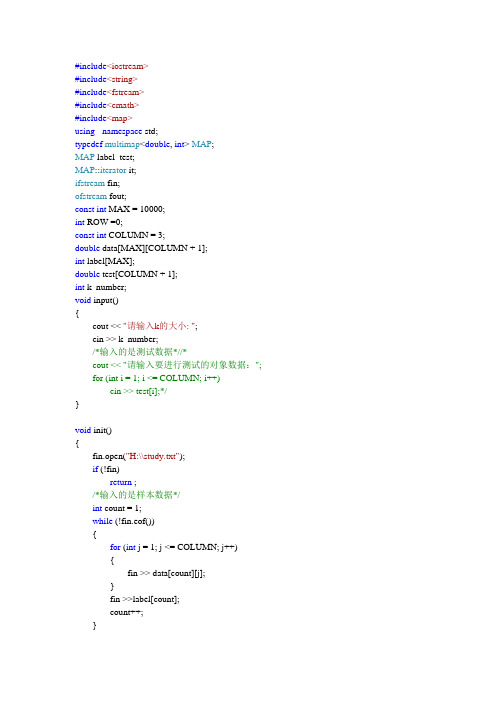

#include<iostream>#include<string>#include<fstream>#include<cmath>#include<map>using namespace std;typedef multimap<double, int> MAP;MAP label_test;MAP::iterator it;ifstream fin;ofstream fout;const int MAX = 10000;int ROW =0;const int COLUMN = 3;double data[MAX][COLUMN + 1];int label[MAX];double test[COLUMN + 1];int k_number;void input(){cout << "请输入k的大小: ";cin >> k_number;/*输入的是测试数据*//*cout << "请输入要进行测试的对象数据:";for (int i = 1; i <= COLUMN; i++)cin >> test[i];*/}void init(){fin.open("H:\\study.txt");if (!fin)return ;/*输入的是样本数据*/int count = 1;while (!fin.eof()){for (int j = 1; j <= COLUMN; j++){fin >> data[count][j];}fin >>label[count];count++;}ROW = --count;/*for (int i = 1; i <= ROW; i++){for (int j = 1; j <= COLUMN; j++){cout << data[i][j] << " ";}cout << label[i] << endl;}*/fin.close();}void procesing() //归一化处理{double max[COLUMN+1] = { 0 }, min[COLUMN + 1] = {10000};//记录每个属性的最大,最小值for (int i = 1; i <= ROW; i++) //获取最大最小值{for (int j = 1; j <= COLUMN; j++){if (max[j] < data[i][j])max[j] = data[i][j];if (min[j]>data[i][j])min[j] = data[i][j];}}for (int i = 1; i <= ROW; i++) //进行归一化操作{for (int j = 1; j <= COLUMN; j++){data[i][j] = (data[i][j] - min[j])/(max[j] - min[j]);}}}int maxvalue(int a,int b){return a > b ? a : b;}int calcurate(int number){label_test.clear(); //非常重要/*计算样本与测试数据的距离,并放入到map中去*/for (int k = 1; k <= ROW-100; k++){double sum = 0;for (int j = 1; j <= COLUMN; j++)sum += pow(data[k][j] - data[number][j], 2);label_test.insert(pair<double, int>(sqrt(sum), k));}/*计算样本距离和类型*//*for (it = label_test.begin(); it != label_test.end(); it++){cout << "距离大小:" << it->first << " " << "下标距离:" << it->second << endl;}*//*取出前k个数*/it = label_test.begin();int count1 = 0, count2 = 0, count3 = 0;for (int k = 1; k <= k_number; k++, it++){if (label[it->second]==1)count1++;else if (label[it->second] ==2)count2++;elsecount3++;}if (count1 >= count2&&count1 >= count3)return 1;if (count2 >= count1&&count2 >= count3)return 2;if (count3 >= count1&&count3 >= count2)return 3;}void error(){double error = 0;for (int i = ROW - 99; i <= ROW; i++){int m = calcurate(i);cout << "预测值是: " << m << " " << "真实值是:" << label[i] << endl;if (m != label[i]){error++;cout << "出现异常";}}error = error / 100;cout << "error= " << error << endl; }int main(){input();init();procesing();error();return 0;}。

c分类算法

在C语言中,有许多种常用的分类算法可以用于数据挖掘和机器学习任务。

以下是一些常见的C语言实现的分类算法:1. 决策树(Decision Tree):ID3算法:一种基于信息熵的决策树构建算法。

C4.5算法:ID3算法的改进版本,使用信息增益率代替信息熵,并支持处理连续属性。

2. 朴素贝叶斯(Naive Bayes):朴素贝叶斯分类器是一种基于贝叶斯定理的概率分类模型,尤其适用于文本分类问题。

在C语言中,可以通过计算每个特征的条件概率和先验概率来实现。

3. K-最近邻(K-Nearest Neighbors, KNN):KNN是一种基于实例的学习方法,通过计算新样本与训练集中每个样本的距离,然后选取最近的k个邻居进行多数表决或加权平均等方式进行分类。

4. 支持向量机(Support Vector Machine, SVM):虽然SVM的理论较为复杂,但在C语言中也可以实现基本的线性SVM分类器,通过构建最大边距超平面来划分不同类别的数据。

5. 逻辑回归(Logistic Regression):逻辑回归是一种广义线性模型,常用于二分类问题。

在C语言中,可以通过优化算法(如梯度下降法)求解模型参数。

6. ABC分类算法(Activity-Based Costing Classification):ABC分类算法主要用于库存管理和运营管理,根据物品的价值和使用频率将其分为A、B、C三类,以便进行不同的管理策略。

7. 神经网络(Artificial Neural Networks, ANN):虽然神经网络的实现通常较为复杂,但在C语言中也可以实现简单的前馈神经网络用于分类任务。

在实现这些算法时,需要注意数据预处理、模型训练、模型评估等步骤,并且可能需要使用到一些数值计算库,如BLAS和LAPACK,或者专门的机器学习库,如LibSVM和OpenCV等。

同时,由于C语言的特性,代码可能会比其他高级语言(如Python或R)更为复杂和低级,但其执行效率通常更高。

k近邻算法c语言

k近邻算法c语言K近邻算法(K-Nearest Neighbors,KNN)是一种基本的分类和回归算法。

下面是一个简单的KNN算法的C语言实现,用于分类问题。

这个例子中,我们假设有一个二维的数据集,并且我们想要根据这个数据集的类别标签来预测新的数据点的类别。

```cinclude <>include <>include <>define DATA_SIZE 4define K 3typedef struct {double x;double y;int label;} Data;double distance(Data d1, Data d2) {return sqrt(pow( - , 2) + pow( - , 2));}int main() {Data data[DATA_SIZE] = {{0, 0, 1}, {1, 0, 1}, {0, 1, 1}, {1, 1, 0}}; // 输入数据,类别标签为1或0Data newData = {, , -1}; // 需要分类的数据点int i, j, count = 0;double mindistance = 1e10, dist;int nearest[K];for (i = 0; i < DATA_SIZE; i++) {if ( == -1) { // 如果需要分类的数据点的标签为-1,则需要找到距离最近的k个点dist = distance(data[i], newData);if (dist < mindistance) {mindistance = dist;nearest[count] = i;count++;if (count == K) break; // 如果已经找到了k个点,就结束循环}}}// 根据k个最近邻点的类别标签进行投票,得到新数据点的类别标签int votes[2] = {0}; // 类别标签为0和1的票数for (j = 0; j < K; j++) {votes[data[nearest[j]].label]++; // 统计每个类别的票数}if (votes[0] > votes[1]) { // 如果类别标签为0的票数多,则新数据点的标签为0,否则为1printf("The label of new data point is: 0\n");} else {printf("The label of new data point is: 1\n");}return 0;}```这个程序首先定义了一个数据结构`Data`,用于存储每个数据点的坐标和类别标签。

knn分类算法案例

knn分类算法案例以下是一个简单的KNN分类算法案例:假设我们有一个包含10个类别的词语的词语向量表示,每个类别都有一个唯一的表示,例如:类别1 = [0, 0, 0, 0, 0, 1, 0, 0, 0, 0, 0]类别2 = [0, 0, 1, 0, 0, 0, 0, 0, 0, 0, 0]类别3 = [0, 0, 0, 0, 0, 0, 0, 1, 0, 0, 0]类别4 = [0, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0]类别5 = [0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0]类别6 = [0, 0, 0, 0, 0, 1, 0, 0, 0, 0, 0]类别7 = [0, 0, 0, 1, 0, 1, 0, 0, 0, 0, 0]类别8 = [0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0]类别9 = [0, 0, 1, 0, 0, 0, 0, 0, 0, 0, 0]类别10 = [0, 1, 0, 0, 0, 0, 0, 0, 0, 0, 0]现在我们需要对这10个类别进行分类,假设我们想要将类别1和类别2归为一类,类别3和类别4归为一类,类别5和类别6归为一类,类别7和类别8归为一类,类别9和类别10归为一类。

那么我们可以定义一个权重向量w和偏置b,将类别1和类别2的向量作为输入,输出类别3、4、5、6、7、8、9、10的向量。

具体步骤如下:1. 初始化权重向量和偏置向量w和b为0。

2. 用一个全连接层将输入向量和w和b的向量拼接起来得到一个输出向量。

3. 对于输出向量的每一个值,计算对应的类别的向量的取值范围,即类别3、4、5、6、7、8、9、10的向量的取值范围应该覆盖所有的zero值。

4. 如果输出向量对应的类别的向量的取值范围覆盖了所有zero值,并且输出向量的边缘八卦为正,则说明新类别与原类别相似,将该类别标记为一类。

否则,将该类别标记为另一类。

opencv kmeans c代码

opencv kmeans c代码在OpenCV库中,k-means算法的C语言实现是非常简单的。

下面是一个使用OpenCV进行k-means聚类的基本示例:c#include <opencv2/opencv.hpp>#include <opencv2/highgui/highgui.hpp>int main(int argc, char** argv){// 加载数据cv::Mat data = cv::imread("your_data.png", CV_LOAD_IMAGE_GRAYSCALE);if (data.empty()) {std::cout << "Could not open or find the image" << std::endl;return -1;}// 转化为浮点数矩阵cv::Mat data_fl = data.clone();cv::Mat labels;int clusterCount = 3; // 设置期望的簇的数量cv::TermCriteria criteria(cv::TermCriteria::EPS+cv::TermCriteria::COUNT, 10, 1.0);cv::Mat centers;// 进行k-means聚类cv::kmeans(data_fl, clusterCount, labels, criteria, 3, cv::KMEANS_PP_CENTERS, centers);// 绘制结果cv::Mat show_img = data.clone();int index = 0;for (int i = 0; i < data.rows; i++) {for (int j = 0; j < data.cols; j++) {show_img.at<uchar>(i,j) = centers.at<float>(labels.at<int>(i,j), 0); }}cv::imshow("k-means Clustering", show_img);cv::waitKey(0);return 0;}请注意,这段代码中的"your_data.png" 应被替换为您自己的图像路径。

掌握KNN算法的原理与实现方法

掌握KNN算法的原理与实现方法KNN算法是机器学习中的一种分类算法,其名称来源于其英文全称:K-Nearest neighbors algorithm。

该算法的基本思想是根据已知数据集中每个样本点的K个最近邻居,通过投票的方式来确定新的数据样本所属的类别。

在实际应用中,KNN算法有着广泛的应用,例如图像分类、文本分类、推荐系统等领域。

一、KNN算法的原理KNN算法的原理非常简单,可以通过以下几个步骤来描述:1. 计算新数据样本和每个已知数据样本之间的距离(可以使用欧氏距离等常见的距离计算方式)。

2. 根据距离的大小,找到K个距离最近的已知数据样本,将其归为同一类别。

3. 通过投票的方式来确定新的数据样本所属的类别,即选取K 个样本中出现最多的类别作为新数据的类别。

4. 输出新数据样本所属的类别。

需要注意的是,在选择K的值时需要根据具体问题来确定,一般来说K的大小越小,模型越复杂,容易出现过拟合,K的大小越大,模型越简单,容易出现欠拟合。

二、KNN算法的实现方法1. 数据的预处理在使用KNN算法进行分类前,需要进行数据的预处理,主要包括数据的清洗、特征的提取等,这些预处理的过程对模型的性能和准确性具有重要的影响。

常见的数据预处理方法包括标准化、归一化、主成分分析等。

2. 距离的计算KNN算法的关键在于距离的计算,一般来说可以使用欧氏距离、曼哈顿距离、余弦距离等常用的距离计算方式,其中欧氏距离最为常用。

距离的计算可以通过编写代码实现,也可以使用已有的库函数。

3. K值的选择在实际应用中,K的大小需要根据具体问题来确定,一般来说可以通过交叉验证等方法来确定最佳的K值。

4. 投票的方式在确定K个距离最近的已知数据样本后,需要通过投票的方式来确定新数据样本所属的类别。

一般来说可以使用加权投票的方式,即距离越近的已知数据样本所在类别的权重越大,距离越远的已知数据样本所在类别的权重越小。

也可以使用简单投票的方式,即K个距离最近的已知数据样本所在类别的个数进行统计,选取出现次数最多的类别作为新数据样本所属的类别。

knn算法的c语言实现

knn算法的c语⾔实现 最近研究KNN,找到了⼀些优秀的源码,贴出来,做个笔记吧。

1 #include<stdio.h>2 #include<stdlib.h>3 #include<math.h>4 #include<time.h>56 typedef struct{//数据维度7double x;8double y;9 }data_struct;1011 typedef struct kd_node{12 data_struct split_data;//数据结点13int split;//分裂维14struct kd_node *left;//由位于该结点分割超⾯左⼦空间内所有数据点构成的kd-tree15struct kd_node *right;//由位于该结点分割超⾯右⼦空间内所有数据点构成的kd-tree16 }kd_struct;1718//⽤于排序19int cmp1( const void *a , const void *b )20 {21return (*(data_struct *)a).x > (*(data_struct *)b).x ? 1:-1;22 }23//⽤于排序24int cmp2( const void *a , const void *b )25 {26return (*(data_struct *)a).y > (*(data_struct *)b).y ? 1:-1;27 }28//计算分裂维和分裂结点29void choose_split(data_struct data_set[],int size,int dimension,int *split,data_struct *split_data)30 {31int i;32 data_struct *data_temp;33 data_temp=(data_struct *)malloc(size*sizeof(data_struct));34for(i=0;i<size;i++)35 data_temp[i]=data_set[i];36static int count=0;//设为静态37 *split=(count++)%dimension;//分裂维38if((*split)==0) qsort(data_temp,size,sizeof(data_temp[0]),cmp1);39else qsort(data_temp,size,sizeof(data_temp[0]),cmp2);40 *split_data=data_temp[(size-1)/2];//分裂结点排在中位41 }42//判断两个数据点是否相等43int equal(data_struct a,data_struct b){44if(a.x==b.x && a.y==b.y) return1;45else return0;46 }47//建⽴KD树48 kd_struct *build_kdtree(data_struct data_set[],int size,int dimension,kd_struct *T)49 {50if(size==0) return NULL;//递归出⼝51else{52int sizeleft=0,sizeright=0;53int i,split;54 data_struct split_data;55 choose_split(data_set,size,dimension,&split,&split_data);56 data_struct data_right[size];57 data_struct data_left[size];5859if (split==0){//x维60for(i=0;i<size;++i){61if(!equal(data_set[i],split_data) && data_set[i].x <= split_data.x){//⽐分裂结点⼩62 data_left[sizeleft].x=data_set[i].x;63 data_left[sizeleft].y=data_set[i].y;64 sizeleft++;//位于分裂结点的左⼦空间的结点数65 }66else if(!equal(data_set[i],split_data) && data_set[i].x > split_data.x){//⽐分裂结点⼤67 data_right[sizeright].x=data_set[i].x;68 data_right[sizeright].y=data_set[i].y;69 sizeright++;//位于分裂结点的右⼦空间的结点数70 }71 }72 }73else{//y维74for(i=0;i<size;++i){75if(!equal(data_set[i],split_data) && data_set[i].y <= split_data.y){76 data_left[sizeleft].x=data_set[i].x;77 data_left[sizeleft].y=data_set[i].y;78 sizeleft++;79 }80else if (!equal(data_set[i],split_data) && data_set[i].y > split_data.y){81 data_right[sizeright].x = data_set[i].x;82 data_right[sizeright].y = data_set[i].y;83 sizeright++;84 }85 }86 }87 T=(kd_struct *)malloc(sizeof(kd_struct));88 T->split_data.x=split_data.x;89 T->split_data.y=split_data.y;90 T->split=split;91 T->left=build_kdtree(data_left,sizeleft,dimension,T->left);//左⼦空间92 T->right=build_kdtree(data_right,sizeright,dimension,T->right);//右⼦空间93return T;//返回指针94 }95 }96//计算欧⽒距离97double compute_distance(data_struct a,data_struct b){98double tmp=pow(a.x-b.x,2.0)+pow(a.y-b.y,2.0);99return sqrt(tmp);100 }101//搜索1近邻102void search_nearest(kd_struct *T,int size,data_struct test,data_struct *nearest_point,double *distance)103 {104int path_size;//搜索路径内的指针数⽬105 kd_struct *search_path[size];//搜索路径保存各结点的指针106 kd_struct* psearch=T;107 data_struct nearest;//最近邻的结点108double dist;//查询结点与最近邻结点的距离109 search_path[0]=psearch;//初始化搜索路径110 path_size=1;111while(psearch->left!=NULL || psearch->right!=NULL){112if (psearch->split==0){113if(test.x <= psearch->split_data.x)//如果⼩于就进⼊左⼦树114 psearch=psearch->left;115else116 psearch=psearch->right;117 }118else{119if(test.y <= psearch->split_data.y)//如果⼩于就进⼊右⼦树120 psearch=psearch->left;121else122 psearch=psearch->right;123 }124 search_path[path_size++]=psearch;//将经过的分裂结点保存在搜索路径中125 }126//取出search_path最后⼀个元素,即叶⼦结点赋给nearest127 nearest.x=search_path[path_size-1]->split_data.x;128 nearest.y=search_path[path_size-1]->split_data.y;129 path_size--;//search_path的指针数减⼀130 dist=compute_distance(nearest,test);//计算与该叶⼦结点的距离作为初始距离131132//回溯搜索路径133 kd_struct* pback;134while(path_size!=0){135 pback=search_path[path_size-1];//取出search_path最后⼀个结点赋给pback136 path_size--;//search_path的指针数减⼀137138if(pback->left==NULL && pback->right==NULL){//如果pback为叶⼦结点139if(dist>compute_distance(pback->split_data,test)){140 nearest=pback->split_data;141 dist=compute_distance(pback->split_data,test);142 }143 }144else{//如果pback为分裂结点145int s=pback->split;146if(s==0){//x维147if(fabs(pback->split_data.x-test.x)<dist){//若以查询点为中⼼的圆(球或超球),半径为dist的圆与分割超平⾯相交,那么就要跳到另⼀边的⼦空间去搜索148if(dist>compute_distance(pback->split_data,test)){149 nearest=pback->split_data;150 dist=compute_distance(pback->split_data, test);151 }152if(test.x<=pback->split_data.x)//若查询点位于pback的左⼦空间,那么就要跳到右⼦空间去搜索153 psearch=pback->right;154else155 psearch=pback->left;//若以查询点位于pback的右⼦空间,那么就要跳到左⼦空间去搜索156if(psearch!=NULL)157 search_path[path_size++]=psearch;//psearch加⼊到search_path中158 }159 }160else {//y维161if(fabs(pback->split_data.y-test.y)<dist){//若以查询点为中⼼的圆(球或超球),半径为dist的圆与分割超平⾯相交,那么就要跳到另⼀边的⼦空间去搜索162if(dist>compute_distance(pback->split_data,test)){163 nearest=pback->split_data;164 dist=compute_distance(pback->split_data,test);165 }166if(test.y<=pback->split_data.y)//若查询点位于pback的左⼦空间,那么就要跳到右⼦空间去搜索167 psearch=pback->right;168else169 psearch=pback->left;//若查询点位于pback的的右⼦空间,那么就要跳到左⼦空间去搜索170if(psearch!=NULL)171 search_path[path_size++]=psearch;//psearch加⼊到search_path中172 }173 }174 }175 }176177 (*nearest_point).x=nearest.x;//最近邻178 (*nearest_point).y=nearest.y;179 *distance=dist;//距离180 }181182int main()183 {184int n=6;//数据个数185 data_struct nearest_point;186double distance;187 kd_struct *root=NULL;188 data_struct data_set[6]={{2,3},{5,4},{9,6},{4,7},{8,1},{7,2}};//数据集189 data_struct test={7.1,2.1};//查询点190 root=build_kdtree(data_set,n,2,root);191192 search_nearest(root,n,test,&nearest_point,&distance);193 printf("nearest neighbor:(%.2f,%.2f)\ndistance:%.2f \n",nearest_point.x,nearest_point.y,distance);194return0;195 }196/* x 5,4197 / \198 y 2,3 7.2199 \ / \200 x 4,7 8.1 9.6201*/View Code 看了⼀些做这⽅⾯的⽂章,把写的不错的⼏个也收录了。

kNN(k近邻)算法代码实现

kNN(k近邻)算法代码实现⽬标:预测未知数据(或测试数据)X的分类y批量kNN算法1.输⼊⼀个待预测的X(⼀维或多维)给训练数据集,计算出训练集X_train中的每⼀个样本与其的距离2.找到前k个距离该数据最近的样本-->所属的分类y_train3.将前k近的样本进⾏统计,哪个分类多,则我们将x分类为哪个分类# 准备阶段:import numpy as np# import matplotlib.pyplot as pltraw_data_X = [[3.393533211, 2.331273381],[3.110073483, 1.781539638],[1.343808831, 3.368360954],[3.582294042, 4.679179110],[2.280362439, 2.866990263],[7.423436942, 4.696522875],[5.745051997, 3.533989803],[9.172168622, 2.511101045],[7.792783481, 3.424088941],[7.939820817, 0.791637231]]raw_data_y = [0, 0, 0, 0, 0, 1, 1, 1, 1, 1]X_train = np.array(raw_data_X)y_train = np.array(raw_data_y)x = np.array([8.093607318, 3.365731514])核⼼代码:⽬标:预测未知数据(或测试数据)X的分类y批量kNN算法1.输⼊⼀个待预测的X(⼀维或多维)给训练数据集,计算出训练集X_train中的每⼀个样本与其的距离2.找到前k个距离该数据最近的样本-->所属的分类y_train3.将前k近的样本进⾏统计,哪个分类多,则我们将x分类为哪个分类from math import sqrtfrom collections import Counter# 已知X_train,y_train# 预测x的分类def predict(x, k=5):# 计算训练集每个样本与x的距离distances = [sqrt(np.sum((x-x_train)**2)) for x_train in X_train] # 这⾥⽤了numpy的fancy⽅法,np.sum((x-x_train)**2) # 获得距离对应的索引,可以通过这些索引找到其所属分类y_trainnearest = np.argsort(distances)# 得到前k近的分类ytopK_y = [y_train[neighbor] for neighbor in nearest[:k]]# 投票的⽅式,得到⼀个字典,key是分类,value数个数votes = Counter(topK_y)# 取出得票第⼀名的分类return votes.most_common(1)[0][0] # 得到y_predictpredict(x, k=6)⾯向对象的⽅式,模仿sklearn中的⽅法实现kNN算法:import numpy as npfrom math import sqrtfrom collections import Counterclass kNN_classify:def__init__(self, n_neighbor=5):self.k = n_neighborself._X_train = Noneself._y_train = Nonedef fit(self, X_train, y_train):self._X_train = X_trainself._y_train = y_trainreturn selfdef predict(self, X):'''接收多维数据,返回y_predict也是多维的'''y_predict = [self._predict(x) for x in X]# return y_predictreturn np.array(y_predict) # 返回array的格式def _predict(self, x):'''接收⼀个待预测的x,返回y_predict'''distances = [sqrt(np.sum((x-x_train)**2)) for x_train in self._X_train] nearest = np.argsort(distances)topK_y = [self._y_train[neighbor] for neighbor in nearest[:self.k]]votes = Counter(topK_y)return votes.most_common(1)[0][0]def__repr__(self):return'kNN_clf(k=%d)' % self.k。

k-近邻算法(kNN)完整代码

k-近邻算法(kNN)完整代码 1from numpy import *#科学计算包2from numpy import tile3from numpy import zeros4import operator #运算符模块5import importlib6import sys7 importlib.reload(sys)89def createDataSet():10 group = array([[1.0,1.1],[1.0,1.0],[0,0],[0,0.1]])11 labels = ['A','A','B','B']12return group,labels1314def classify0(inX, dataSet, labels, k):15 dataSetSize = dataSet.shape[0]16#距离计算17 diffMat = tile(inX, (dataSetSize,1)) - dataSet18 sqDiffMat = diffMat**2 #平⽅19 sqDistances = sqDiffMat.sum(axis=1) #根号下平⽅相加20 distances = sqDistances**0.5 #根号21 sortedDistIndicies = distances.argsort() #排序22 classCount={}23#选择距离最⼩的k个点24for i in range(k):25 voteIlabel = labels[sortedDistIndicies[i]]26 classCount[voteIlabel] = classCount.get(voteIlabel,0) + 127#排序,将classCount字典分解为元祖列表,导⼊itemgeeter⽅法,按照第⼆个元素的次序对元祖进⾏排序28#此处排序为逆序,即从⼤到⼩排序,最后返回发⽣频率最⾼的元素标签。

KNN算法原理以及代码实现

KNN算法原理以及代码实现⼀、KNN简述KNN是⽐较经典的算法,也是是数据挖掘分类技术中最简单的⽅法之⼀。

KNN的核⼼思想很简单:离谁近就是谁。

具体解释为如果⼀个实例在特征空间中的K个最相似(即特征空间中最近邻)的实例中的⼤多数属于某⼀个类别,则该实例也属于这个类别。

换个说法可能更好理解,⽐如⼀个⼀定范围的平⾯随机分布着两种颜⾊的样本点,在这个平⾯内有个实例点不知道它是什么颜⾊,因此通过它周边的不同颜⾊的点分布情况进⾏推测,假设取K=3,意思是在离这个实例点最近的样本点中去前三个最近的,然后看这三个当中那种类别占⽐⼤,就判断该实例点属于那个类别的,当k=5的时候也⼀样这样判断,因此k的取值很关键,通常不会超过20。

当然,因为每个样本有多个特征,因此实际⼯作中,这个‘平⾯’就是三维甚⾄是多维的,道理是⼀样的。

如图:⼆、KNN算法原理在KNN中,通过计算对象间距离来作为各个对象之间的⾮相似性指标,避免了对象之间的匹配问题,在这⾥距离⼀般使⽤欧⽒距离或曼哈顿距离:对KNN算法的思想总结⼀下:就是在训练集中数据和标签已知的情况下,输⼊测试数据,将测试数据的特征与训练集中对应的特征进⾏相互⽐较,找到训练集中与之最为相似的前K个数据,则该测试数据对应的类别就是K个数据中出现次数最多的那个分类,其算法的描述为:1)计算测试数据与各个训练数据之间的距离;2)按照距离的递增关系进⾏排序;3)选取距离最⼩的K个点;4)确定前K个点所在类别的出现频率;5)返回前K个点中出现频率最⾼的类别作为测试数据的预测分类。

三、KNN算法优缺点以及算法改进优缺点:1、简单,易于理解,是⼀个天然的多分类器;2、不需要庞⼤的样本数据也可以完成⼀个简单的分类;3、不需要训练和求解参数(既是优点也是缺点);4、数据量⼤的时候,计算量也⾮常⼤(样本多,特征多);5、不平衡样本处理能⼒差;6、并没有学习和优化的过程,严格来说不算是机器学习。

改进:进⾏加权平均,离得近的样本给予更⼤的权重,离得远的样本使其权重变⼩。

Knn算法C++实现

Knn算法C++实现相对简单的模拟。

C++11/* ***********************************************Author :guanjunCreated Time :2016/6/20 18:22:32File Name :1.cpp************************************************ */#include <iostream>#include <cstring>#include <cstdlib>#include <stdio.h>#include <algorithm>#include <map>#include <string>#include <math.h>#include <stdlib.h>#include <fstream>#define maxn 10010using namespace std;int k;struct node{double x1,x2,x3,x4,x5;string s;}nod[maxn];pair<double,string>p[maxn];map<string,int>mp;ifstream fin;int input(string s){fin.open(s);if(!fin){cout<<"can not open the file "<<s<<endl;exit(1);}int i=1;while(fin>>nod[i].x1>>nod[i].x2>>nod[i].x3>>nod[i].x4>>nod[i].x5>>nod[i].s){nod[i].x1*=100.0;nod[i].x2*=100.0;nod[i].x3*=100.0;nod[i].x4*=100.0;nod[i].x5*=100.0;i++;}return i;}double mul(double x,double y){return (x-y)*(x-y);}double dis(node a,node b){double tmp=mul(a.x1,b.x1)+mul(a.x2,b.x2)+mul(a.x3,b.x3)+mul(a.x4,b.x4)+mul(a.x5,b.x5);return sqrt(tmp);}string knn(int n,node x){for(int i=1;i<=n;i++){p[i]={dis(x,nod[i]),nod[i].s};}//for(int i=1;i<=n;i++)cout<<p[i].first<<endl;sort(p+1,p+1+n);//for(int i=1;i<=n;i++)cout<<p[i].first<<endl;mp.clear();for(int i=1;i<=k;i++)mp[p[i].second]++;int Max=0;string ans;for(auto x:mp){if(x.second>Max){Max=x.second;ans=x.first;}}return ans;}int main(){int n,m;puts("input k");cin>>k;n=input("in.txt");puts("input the test case");cin>>m;node tes;for(int i=1;i<=m;i++){cin>>tes.x1>>tes.x2>>tes.x3>>tes.x4>>tes.x5;tes.x1*=100.0;tes.x2*=100.0;tes.x3*=100.0;tes.x4*=100.0;tes.x5*=100.0;cout<<"belong to "<<knn(n,tes)<<endl; }return0;}训练数据:0 0 0 0 0 very_low0.08 0.08 0.1 0.24 0.9 High0.06 0.06 0.05 0.25 0.33 Low0.1 0.1 0.15 0.65 0.3 Middle0.08 0.08 0.08 0.98 0.24 Low0.09 0.15 0.4 0.1 0.66 Middle0.1 0.1 0.43 0.29 0.56 Middle0.15 0.02 0.34 0.4 0.01 very_low 0.2 0.14 0.35 0.72 0.25 Low0 0 0.5 0.2 0.85 High0.18 0.18 0.55 0.3 0.81 High0.06 0.06 0.51 0.41 0.3 Low0.1 0.1 0.52 0.78 0.34 Middle0.1 0.1 0.7 0.15 0.9 High0.2 0.2 0.7 0.3 0.6 Middle0.12 0.12 0.75 0.35 0.8 High0.05 0.07 0.7 0.01 0.05 very_low 0.1 0.25 0.1 0.08 0.33 Low0.15 0.32 0.05 0.27 0.29 Low0.2 0.29 0.25 0.49 0.56 Middle0.12 0.28 0.2 0.78 0.2 Low0.18 0.3 0.37 0.12 0.66 Middle0.1 0.27 0.31 0.29 0.65 Middle0.18 0.31 0.32 0.42 0.28 Low0.06 0.29 0.35 0.76 0.25 Low0.09 0.3 0.68 0.18 0.85 High0.04 0.28 0.55 0.25 0.1 very_low 0.09 0.255 0.6 0.45 0.25 Low0.08 0.325 0.62 0.94 0.56 High0.15 0.275 0.8 0.21 0.81 High0.12 0.245 0.75 0.31 0.59 Middle 0.15 0.295 0.75 0.65 0.24 Low0.1 0.256 0.7 0.76 0.16 Low0.18 0.32 0.04 0.19 0.82 High0.2 0.45 0.28 0.31 0.78 High0.06 0.35 0.12 0.43 0.29 Low0.1 0.42 0.22 0.72 0.26 Low0.18 0.4 0.32 0.08 0.33 Low0.09 0.33 0.31 0.26 0 very_low0.19 0.38 0.38 0.49 0.45 Middle0.02 0.33 0.36 0.76 0.1 Low0.2 0.49 0.6 0.2 0.78 High0.14 0.49 0.55 0.29 0.6 Middle0.18 0.33 0.61 0.64 0.25 Middle0.115 0.35 0.65 0.27 0.04 very_low 0.17 0.36 0.8 0.14 0.66 Middle0.1 0.39 0.75 0.31 0.62 Middle0.13 0.39 0.85 0.38 0.77 High0.18 0.34 0.71 0.71 0.9 High0.09 0.51 0.02 0.18 0.67 Middle0.06 0.5 0.09 0.28 0.25 Low0.23 0.7 0.19 0.51 0.45 Middle0.09 0.55 0.12 0.78 0.05 Low0.24 0.75 0.32 0.18 0.86 High0.18 0.72 0.37 0.29 0.55 Middle0.1 0.6 0.33 0.42 0.26 Low0.2 0.52 0.36 0.84 0.25 Middle0.09 0.6 0.66 0.19 0.59 Middle0.18 0.51 0.58 0.33 0.82 High0.08 0.58 0.6 0.64 0.1 Low0.09 0.61 0.53 0.75 0.01 Low0.06 0.77 0.72 0.19 0.56 Middle0.15 0.79 0.78 0.3 0.51 Middle 0.2 0.68 0.73 0.48 0.28 Low0.24 0.58 0.76 0.8 0.28 Middle 0.25 0.1 0.03 0.09 0.15 very_low 0.32 0.2 0.06 0.26 0.24 very_low 0.29 0.06 0.19 0.55 0.51 Middle 0.28 0.1 0.12 0.28 0.32 Low0.3 0.08 0.4 0.02 0.67 Middle0.27 0.12 0.37 0.29 0.58 Middle 0.31 0.1 0.41 0.42 0.75 High0.29 0.15 0.33 0.66 0.08 very_low 0.3 0.2 0.52 0.3 0.53 Middle0.28 0.16 0.69 0.33 0.78 High0.255 0.18 0.5 0.4 0.1 very_low 0.265 0.06 0.57 0.75 0.1 Low0.275 0.1 0.72 0.1 0.3 Low0.245 0.1 0.71 0.26 0.2 very_low 0.295 0.2 0.86 0.44 0.28 Low0.32 0.12 0.79 0.76 0.24 Low0.295 0.25 0.26 0.12 0.67 Middle 0.315 0.32 0.29 0.29 0.62 Middle 0.25 0.29 0.15 0.48 0.26 Low0.27 0.1 0.1 0.7 0.25 Low0.248 0.3 0.31 0.2 0.03 very_low 0.325 0.25 0.38 0.31 0.79 High 0.27 0.31 0.32 0.41 0.28 Low0.29 0.29 0.4 0.78 0.18 Low0.29 0.3 0.52 0.09 0.67 Middle 0.258 0.28 0.64 0.29 0.56 Middle 0.32 0.255 0.55 0.78 0.34 Middle 0.251 0.265 0.57 0.6 0.09 very_low 0.288 0.31 0.79 0.23 0.24 Low 0.323 0.32 0.89 0.32 0.8 High0.255 0.305 0.86 0.62 0.15 Low 0.295 0.25 0.73 0.77 0.19 Low 0.258 0.25 0.295 0.33 0.77 High 0.29 0.25 0.29 0.29 0.57 Middle 0.243 0.27 0.08 0.42 0.29 Low 0.27 0.28 0.18 0.48 0.26 Low0.299 0.32 0.31 0.33 0.87 High 0.3 0.27 0.31 0.31 0.54 Middle 0.245 0.26 0.38 0.49 0.27 Low 0.295 0.29 0.31 0.76 0.1 Low0.29 0.3 0.56 0.25 0.67 Middle 0.26 0.28 0.6 0.29 0.59 Middle 0.305 0.255 0.63 0.4 0.54 Middle 0.32 0.27 0.52 0.81 0.3 Middle 0.299 0.295 0.8 0.37 0.84 High 0.276 0.255 0.81 0.27 0.33 Low 0.258 0.31 0.88 0.4 0.3 Low0.32 0.28 0.72 0.89 0.58 High0.329 0.55 0.02 0.4 0.79 High0.295 0.59 0.29 0.31 0.55 Middle 0.285 0.64 0.18 0.61 0.45 Middle 0.265 0.6 0.28 0.66 0.07 very_low 0.315 0.69 0.28 0.8 0.7 High0.28 0.78 0.44 0.17 0.66 Middle 0.325 0.61 0.46 0.32 0.81 High 0.28 0.65 0.4 0.65 0.13 Low0.255 0.75 0.35 0.72 0.25 Low 0.305 0.55 0.5 0.11 0.333 Low 0.3 0.85 0.54 0.25 0.83 Middle 0.325 0.9 0.52 0.49 0.76 High0.312 0.8 0.67 0.92 0.5 High0.299 0.7 0.95 0.22 0.66 High0.265 0.76 0.8 0.28 0.28 Low0.255 0.72 0.72 0.63 0.14 Low 0.295 0.6 0.72 0.88 0.28 Middle0.4 0.18 0.26 0.26 0.67 Middle 0.45 0.04 0.18 0.55 0.07 very_low 0.48 0.12 0.28 0.7 0.71 High0.4 0.12 0.41 0.1 0.65 Middle0.41 0.18 0.33 0.31 0.5 Middle 0.38 0.1 0.4 0.48 0.26 Low0.37 0.06 0.32 0.78 0.1 Low0.41 0.09 0.58 0.18 0.58 Middle 0.38 0.01 0.53 0.27 0.3 Low0.33 0.04 0.5 0.55 0.1 very_low 0.42 0.15 0.66 0.78 0.4 Middle 0.44 0.08 0.8 0.22 0.56 Middle 0.39 0.15 0.81 0.22 0.29 Low0.42 0.21 0.87 0.56 0.48 Middle 0.46 0.2 0.76 0.95 0.65 High0.365 0.243 0.19 0.24 0.35 Low 0.33 0.27 0.2 0.33 0.1 very_low 0.345 0.299 0.1 0.64 0.13 Low 0.48 0.3 0.15 0.65 0.77 High0.49 0.245 0.38 0.14 0.86 High 0.334 0.295 0.33 0.32 0.3 Low 0.36 0.29 0.37 0.48 0.13 very_low 0.39 0.26 0.39 0.77 0.14 Low0.43 0.305 0.51 0.09 0.64 Middle 0.44 0.32 0.55 0.33 0.52 Middle 0.45 0.299 0.63 0.36 0.51 Middle 0.495 0.276 0.58 0.77 0.83 High 0.465 0.258 0.73 0.18 0.59 Middle 0.475 0.32 0.79 0.31 0.54 Middle 0.348 0.329 0.83 0.61 0.18 Low 0.385 0.26 0.76 0.84 0.3 Middle 0.445 0.39 0.02 0.24 0.88 High 0.43 0.45 0.27 0.27 0.89 High 0.33 0.34 0.1 0.49 0.12 very_low 0.4 0.33 0.12 0.3 0.9 High0.34 0.4 0.38 0.2 0.61 Middle0.38 0.36 0.46 0.49 0.78 High 0.35 0.38 0.32 0.6 0.16 Low0.41 0.49 0.34 0.21 0.92 High 0.42 0.36 0.63 0.04 0.25 Low0.43 0.38 0.62 0.33 0.49 Middle 0.44 0.33 0.59 0.53 0.85 High 0.4 0.42 0.58 0.75 0.16 Low0.46 0.44 0.89 0.12 0.66 Middle 0.38 0.39 0.79 0.33 0.3 Low0.39 0.42 0.83 0.65 0.19 Low0.49 0.34 0.88 0.75 0.71 High 0.46 0.64 0.22 0.22 0.6 Middle 0.44 0.55 0.11 0.26 0.83 High 0.365 0.68 0.1 0.63 0.18 Low0.45 0.65 0.19 0.99 0.55 High 0.46 0.78 0.38 0.24 0.89 High 0.37 0.55 0.41 0.29 0.3 Low0.38 0.59 0.31 0.62 0.2 Low0.49 0.64 0.34 0.78 0.21 Low0.495 0.82 0.67 0.01 0.93 High 0.44 0.69 0.61 0.29 0.57 Middle 0.365 0.57 0.59 0.55 0.25 Low 0.49 0.9 0.52 0.9 0.47 High0.445 0.7 0.82 0.16 0.64 Middle 0.42 0.7 0.72 0.3 0.8 High0.37 0.6 0.77 0.4 0.5 Middle0.4 0.61 0.71 0.88 0.67 High0.6 0.14 0.22 0.11 0.66 Middle 0.55 0.1 0.27 0.25 0.29 Low0.68 0.19 0.19 0.48 0.1 very_low 0.73 0.2 0.07 0.72 0.26 Low0.55 0.1 0.34 0.3 0.1 very_low 0.59 0.18 0.31 0.55 0.09 very_low 测试数据0.64 0.09 0.33 0.65 0.5 Middle 0.6 0.19 0.55 0.08 0.1 very_low 0.69 0.02 0.62 0.3 0.29 Low0.78 0.21 0.68 0.65 0.75 High 0.62 0.14 0.52 0.81 0.15 Low 0.7 0.18 0.88 0.09 0.66 Middle 0.75 0.015 0.78 0.31 0.53 Middle 0.55 0.17 0.71 0.48 0.11 very_low 0.85 0.05 0.91 0.8 0.68 High0.78 0.27 0.13 0.14 0.62 Middle 0.8 0.29 0.06 0.31 0.51 Middle 0.9 0.26 0.19 0.58 0.79 High0.76 0.258 0.07 0.83 0.34 Middle 0.72 0.32 0.48 0.2 0.6 Middle 0.6 0.251 0.39 0.29 0.3 Low0.52 0.288 0.32 0.5 0.3 Low0.6 0.31 0.31 0.87 0.58 High0.51 0.255 0.55 0.17 0.64 Middle 0.58 0.295 0.62 0.28 0.3 Low 0.61 0.258 0.56 0.62 0.24 Low 0.77 0.267 0.59 0.78 0.28 Middle 0.79 0.28 0.88 0.2 0.66 Middle 0.68 0.27 0.78 0.31 0.57 Middle 0.58 0.299 0.73 0.63 0.21 Low 0.77 0.29 0.74 0.82 0.68 High 0.71 0.475 0.13 0.23 0.59 Middle 0.58 0.348 0.06 0.29 0.31 Low 0.88 0.335 0.19 0.55 0.78 High 0.99 0.49 0.07 0.7 0.69 High0.73 0.43 0.32 0.12 0.65 Middle 0.61 0.33 0.36 0.28 0.28 Low 0.51 0.4 0.4 0.59 0.23 Low0.83 0.44 0.49 0.91 0.66 High 0.66 0.38 0.55 0.15 0.62 Middle 0.58 0.35 0.51 0.27 0.3 Low0.523 0.41 0.55 0.6 0.22 Low 0.66 0.36 0.56 0.4 0.83 High0.62 0.37 0.81 0.13 0.64 Middle 0.52 0.44 0.82 0.3 0.52 Middle 0.5 0.4 0.73 0.62 0.2 Low0.71 0.46 0.95 0.78 0.86 High 0.64 0.55 0.15 0.18 0.63 Middle 0.52 0.85 0.06 0.27 0.25 Low 0.62 0.62 0.24 0.65 0.25 Middle 0.91 0.58 0.26 0.89 0.88 High 0.62 0.67 0.39 0.1 0.66 Middle 0.58 0.58 0.31 0.29 0.29 Low 0.89 0.68 0.49 0.65 0.9 High0.72 0.6 0.45 0.79 0.45 Middle 0.68 0.63 0.65 0.09 0.66 Middle 0.56 0.6 0.6 0.31 0.5 Middle0.54 0.51 0.55 0.64 0.19 Low 0.61 0.78 0.69 0.92 0.58 High 0.78 0.61 0.71 0.19 0.6 Middle 0.54 0.82 0.71 0.29 0.77 High 0.5 0.75 0.81 0.61 0.26 Middle 0.66 0.9 0.76 0.87 0.74 High。

KNN算法原理及代码实现

KNN算法原理及代码实现在本文中,我们将讨论一种广泛使用的分类技术,称为K最近邻(KNN)。

我们的重点主要集中在算法如何工作以及输入参数如何影响预测结果。

内容包括:•何时使用KNN算法?•KNN算法原理•如何选择K值•KNN算法伪码•Python实现KNN算法•与scikit-learn比较何时使用KNN算法KNN算法可以同时应用到分类和回归问题。

然而,KNN在实际应用中更多的是用于分类问题。

为了更好的评价一个算法优劣,我们从以下三个重要的指标分析:1.预测结果的可解读性2.运行时间3.预测准确性KNN算法与逻辑回归(Logistic Regression)、决策树CART(Classification And Regression Tree,简称CART)、随机森林(Random Forest)对比如下表相对于其他算法,KNN算法在这三个评价指标表现相对均衡优异。

如何选择K值让我们看一个简单的例子来理解KNN。

下图中有三种点,红色类(3个带你)、绿色类(3个点)以及未知类别的某蓝星。

我们试图找到蓝星的所属类别,它要么属于红色类要么属于绿色类。

算法KNN中的K指的是某点的K个用来投票的邻居,少数服从多数。

K个邻居中投票最多的属性代表该点的属性。

在本例子中我们将K 设置为3,我们会给蓝星画一个圈围住最近的K=3个点。

最终大概类似于下图我们看到蓝星最近的三个邻居都是红色类,所以我们可以认为蓝星的类别是红色类。

在本例中,对蓝星的分类是非常明显的,因为来自最近邻居的三张选票都投给了红色类。

参数K的选择在该算法中非常重要。

接下来我们将了解哪些因素需要考虑,以得出最佳的K。

如何选择K值首先让我们理解K值到底如何影响KNN算法。

如果我们有很多蓝色点和红色点数据,使用不同K值,最终的分类效果大概如下图。

我们发现随着K值的增大,分界面越来越平滑。

一般在机器学习中我们要将数据集分为训练集和测试集,用训练集训练模型,再用测试集评价模型效果。

knn算法的实现流程

knn算法的实现流程knn算法(k-Nearest Neighbors)是一种基于实例的学习方法,它的核心思想是通过找到与要预测数据最相似的k个样本来进行分类或回归。

knn算法在分类、回归和数据挖掘等领域都有着广泛的应用。

本文将介绍knn算法的实现流程。

1. 收集数据我们需要收集训练数据。

训练数据通常由多个样本组成,每个样本都有多个特征和一个标签。

在分类问题中,标签表示样本所属的类别;在回归问题中,标签则表示样本的目标值。

在实际应用中,我们可以通过爬虫、采集和数据库等方式来获取训练数据。

2. 数据预处理在收集到数据后,我们需要对数据进行预处理。

预处理的目的是为了让数据适合knn算法的要求。

首先,我们需要对数据进行归一化处理,将所有特征的值缩放到同一范围内。

其次,我们需要对数据进行清洗和去重,确保数据的质量和准确性。

3. 选择k值knn算法中的k值表示需要选择的最近邻居个数。

k值的选择对算法的性能和准确性有着重要的影响。

通常,我们可以通过交叉验证等方式来选择最合适的k值。

4. 计算距离在knn算法中,我们需要计算目标样本与所有训练样本之间的距离。

距离计算通常采用欧氏距离、曼哈顿距离、闵可夫斯基距离等方式。

距离计算的目的是为了找到与目标样本最相似的k个训练样本。

5. 选择k个最近邻居在计算完目标样本与所有训练样本之间的距离后,我们需要选择与目标样本最相似的k个训练样本。

通常,我们可以采用堆排序等方式来实现k个最近邻居的选择。

6. 进行分类或回归在选择完k个最近邻居后,我们需要根据这k个训练样本的标签来进行分类或回归。

在分类问题中,我们可以采用多数表决等方式来确定目标样本所属的类别;在回归问题中,我们可以采用加权平均等方式来预测目标样本的目标值。

7. 评估算法性能在完成knn算法的实现后,我们需要对算法的性能进行评估。

通常,我们可以采用精确度、召回率、F1值等指标来评估算法的性能。

同时,我们也可以通过与其他算法进行比较来评估算法的优劣。

knn算法的实现过程

knn算法的实现过程KNN算法是一种基于距离最近的分类算法,KNN全称为K-Nearest-Neighbors,也就是K个最近邻点。

在分类的时候,对于一个新的数据点,KNN算法会先找到K个与该数据点距离最近的已知类别样本,接着根据这K个样本的类别进行投票,选择票数最多的类别作为新数据点的类别。

这种算法简单有效,又不需要太多的先验信息和经验,因此在很多实际应用案例中得到了广泛的应用。

KNN算法实现的前提是我们需要有一些已知类别的样本点,作为算法的训练数据,这些训练数据的类别应该尽可能地代表我们将来需要进行分类的实例的不同状态。

当然,在数据的质量和样本的选取上,对于KNN算法的效果也有很大的影响。

一般实现KNN算法的流程如下:1. 数据预处理:首先我们需要将数据预处理成算法能够处理的矩阵数据,一般来说,我们需要将每个数据点的所有属性值都存放到该点的特征向量中,对于一个d维的数据点,其特征向量x可以表示成:x = [x1, x2, x3, …, xd]在实际应用中,比较常见的数据预处理工作包括数据清洗、数据离散化和数据归一化等。

2. 计算距离:在将预处理后的数据存储为矩阵数据后,我们需要计算新数据点与旧数据点之间的距离,这里一般可以使用欧氏距离、曼哈顿距离、余弦距离、皮尔森相关系数等距离计算法。

例如,使用欧式距离的公式为:d(x,y) = sqrt(∑(xi-yi)^2)其中Xi和Yi分别是特征向量X和Y的第i个属性值,∑是对所有i的和。

3. 寻找最近邻点:根据我们计算出来的距离,我们需要寻找出与新数据点距离最近的K个训练样本点,并统计这K个点所属的不同的分类结果,选取票数最多的类别作为新数据点所属类别。

4. 输出分类结果:根据我们上一步寻找到的K个最近邻点所属的类别,并根据投票的结果,我们就可以得出新数据点的分类结果。

通常情况下,当我们寻找到K个最近邻点时,我们可以为每个点设置权重,将距离近的点赋予更高的权重,可提升算法的分类结果。

knn算法的实现流程

knn算法的实现流程KNN算法的实现流程KNN算法是一种基于实例的学习方法,它的核心思想是通过计算样本之间的距离来确定新样本的类别。

KNN算法的实现流程可以分为以下几个步骤:1. 收集数据KNN算法需要大量的数据来进行训练和测试。

在收集数据时,需要注意数据的质量和数量,以及数据的特征是否能够反映出问题的本质。

2. 准备数据在准备数据时,需要对数据进行清洗、预处理和特征选择等操作。

清洗数据可以去除重复、缺失和异常值等无效数据;预处理数据可以对数据进行归一化、标准化和降维等操作;特征选择可以选择对分类有帮助的特征,去除对分类无帮助的特征。

3. 分析数据在分析数据时,需要对数据进行可视化和统计分析等操作,以便更好地理解数据的特征和分布规律。

可视化可以使用散点图、直方图和箱线图等图表来展示数据的分布情况;统计分析可以使用均值、方差和相关系数等指标来描述数据的特征和关系。

4. 训练算法在训练算法时,需要将数据集分为训练集和测试集两部分。

训练集用于训练模型,测试集用于评估模型的性能。

KNN算法的训练过程就是将训练集中的样本存储起来,以便在预测时使用。

5. 测试算法在测试算法时,需要使用测试集来评估模型的性能。

KNN算法的测试过程就是将测试集中的每个样本与训练集中的所有样本进行距离计算,然后选择距离最近的K个样本作为预测结果。

预测结果可以使用多数表决法来确定,即选择K个样本中出现次数最多的类别作为预测结果。

6. 使用算法在使用算法时,需要将新样本输入到模型中进行预测。

KNN算法的预测过程就是将新样本与训练集中的所有样本进行距离计算,然后选择距离最近的K个样本作为预测结果。

预测结果可以使用多数表决法来确定,即选择K个样本中出现次数最多的类别作为预测结果。

7. 评估算法在评估算法时,需要使用各种评估指标来评估模型的性能。

常用的评估指标包括准确率、精确率、召回率和F1值等。

准确率是指预测正确的样本数占总样本数的比例;精确率是指预测为正例的样本中真正为正例的比例;召回率是指真正为正例的样本中被预测为正例的比例;F1值是精确率和召回率的调和平均数。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

while((c = fgetc(fp)) != EOF)

{

if(c == '0' || c == '1')

{

Train.train_mat[train_i][train_j] = c - '0';

train_j++;

}

case '1': Train.train_label[count_train] = 1;break;

case '2': Train.train_label[count_train] = 2;break;

case '3': Train.train_label[count_train] = 3;break;

for(j = i+1;j < num_train;j++)

{

if(mat_dist_row[i] > mat_dist_row[j])

{

temp = mat_dist_row[i];

default: break;

}

count_train++;

if((fp = fopen(str_adr,"r")) == NULL)

printf("Error!Can't open the file!\n");

else //将文件中'0'和'1'字符转化为数字0,1,并储存

{

Train.train_mat[train_i][train_j] = c - '0';

train_j++;

}

}

}

count_train++;

fclose(fp);

}

}

_findclose(handle);

struct _finddata_t fileinfo; //文件信息的结构体

handle = _findfirst(to_search_train,&fileinfo); //第一次查找

sprintf(str_adr, "F:\\kNN\\train\\%s", ); //文件名赋给str_adr

float rate; //错误率

char str_adr[255]; //fopen函数读入文件名时地址

long handle; //用于查找的句柄

//下面重复上面文件读入和储存的过程,读入并储存所有test数据

handle = _findfirst(to_search_test,&fileinfo);

sprintf(str_adr, "F:\\kNN\\test\\%s", );

#include <stdio.h>

#include <io.h>

#include <math.h>

#include <stdlib.h>

#define K 10 //kNN中选取最近邻居的个数

#define LINE 1024 //每个文件字符数

//定义子函数,功能:将每个test数据与所有train数据的距离进行排序,选取距离最小的前K个,这K个数据标签类型最多的,将此标签返回给主函数

int BubbleSort(float mat_dist_row[], int label[],int num_train)

{

int i,j,k;

int train_i = 0,train_j = 0,test_i = 0,test_j = 0; //用于循环

int count_train = 0,count_test = 0; //用于统计train和test文件的个数

int i,j,k,l; //用于循环

case '5': Train.train_label[count_train] = 5;break;

case '6': Train.train_label[count_train] = 6;break;

case '7': Train.train_label[count_train] = 7;break;

case '7': Train.train_label[count_train] = 7;break;

case '8': Train.train_label[count_train] = 8;break;

case '9': Train.train_label[count_train] = 9;break;

switch([0]) //给后面文件赋予标签

{

case '0': Train.train_label[count_train] = 0;break;

case '1': Train.train_label[count_train] = 1;break;

case '8': Train.train_label[count_train] = 8;break;

case '9': Train.train_label[count_train] = 9;break;

default: break;

}

if((fp = fopen(str_adr,"r")) == NULL)

mat_dist_row[i] = mat_dist_row[j];

mat_dist_row[j] = temp;

temp_label = label[i];

label[i] = label[j];

int temp,temp_label;

int num[K] = {0};

int max = 0;

int label_final = 0;

for(i = 0;i < num_train;i++) //冒泡排序,距离从小到大,同时将label对应跟随

{

int sum = 0; //距离求和

int update_label[2000]; //每次调用函数,更新label

int classifier; //记录返回的标签类型

int count = 0; //错误的个数

case '4': Train.train_label[count_train] = 4;break;

case '5': Train.train_label[count_train] = 5;break;

case '6': Train.train_label[count_train] = 6;break;

case 1: num[1]++;break;

case 2: num[2]++;break;

case 3: num[3]++;break;

case 4: num[4]++;break;

case 5: num[5]++;break;

case 6: num[6]++;break;

struct //定义结构体 储存train数据和标签

{

int train_mat[2000][LINE]; //矩阵每一行都是1*LINE的矩阵

int train_label[2000]; //储存每个数据的标签

}Train;

printf("Error!Can't open the file!\n");

else //将文件中'0'和'1'字符转化为数字0,1,并储存

{

while((c = fgetc(fp)) != EOF)

{

if(c == '0' || c == '1')

}

}

fclose(fp);

while(!_findnext(handle,&fileinfo)) //循环查找其他符合的文件,知道找不到其他的为止

{

train_j = 0;

train_i++;

sprintf(str_adr, "F:\\kNN\\train\\%s", );

case 7: num[7]++;break;

case 8: num[8]++;break;

case 9: num[9]++;break;

default: break;

}

}

max = num[0];

for(i = 0;i < K;i++) //标签类型最多的,选择次标签

{

if (num[i] > max )

{

max = num[i];

label_final = i;

}

}

return label_final;

}

int main()

{

FILE *fp;

int c; //用于逐个读入字符数据

label[j] = temp_label;

}

}

}

for (k = 0;k < K;k++) //统计前K个数据,各种标签的个数