Matlab2011b的HMM(隐马尔可夫模型)相关函数介绍

隐马尔可夫模型

…

问题 1 – 评估问题

给定 一个骰子掷出的点数记录

124552646214614613613666166466163661636616361651561511514612356234

问题 会出现这个点数记录的概率有多大?

求P(O|λ)

问题 2 – 解码问题

给定 一个骰子掷出的点数记录

124552646214614613613666166466163661636616361651561511514612356234

1点 2点 3点 4点 5点 6点

一次连续掷骰子的过程模拟

时间 骰子 掷出 点数

1 A 3 2 A 3 3 A 4 4 B 5 5 A 1 6 A 6 7 A 2 明序列 隐序列

查封赌场后, 调查人员发现了一些连续掷骰子的记录, 其中有一个骰子掷出的点数记录如下:

124552646214614613613666166466163661636616361651561511514612356234

本例中三个基本问题

1.评估问题

• 给定观察序列O和HMM =(π, A, B), 判断O是由产 生出来的可能性有多大

• 计算骰子点数序列的确由“作弊”模型生成的可能性

2.解码问题

• 给定观察序列O和HMM λ =(π, A, B), 计算与序列O相 对应的状态序列是什么 • 在骰子点数序列中, 判断哪些点数是用骰子B掷出的

本例中HMM的定义

赌场的例子中:

隐状态集: S={骰子A, 骰子B} 明字符集: V={1,2,3,4,5,6} 初始状态概率: π1=1, π2=0 隐状态转移概率 :

a11=0.9, a12=0.1 a21=0.8, a22=0.2

隐马尔可夫模型的基本用法

隐马尔可夫模型的基本用法隐马尔可夫模型(HiddenMarkovModel,HMM)是一种用于描述随机过程的概率模型,它在自然语言处理、语音识别、生物信息学、金融分析等领域得到了广泛应用。

本文将介绍隐马尔可夫模型的基本概念、数学表达、参数估计、解码算法等内容,希望对读者理解和应用该模型有所帮助。

一、隐马尔可夫模型的基本概念隐马尔可夫模型是一个二元组(Q, O, A, B, π),其中:Q = {q1, q2, …, qN}是状态集合,表示模型中可能出现的所有状态;O = {o1, o2, …, oT}是观测集合,表示模型中可能出现的所有观测;A = [aij]是状态转移矩阵,其中aij表示从状态i转移到状态j的概率;B = [bj(k)]是观测概率矩阵,其中bj(k)表示在状态j下观测到k的概率;π = [πi]是初始状态概率向量,其中πi表示模型开始时处于状态i的概率。

隐马尔可夫模型的基本假设是:每个时刻系统处于某一状态,但是我们无法观测到该状态,只能观测到该状态下产生的某个观测。

因此,我们称该状态为隐状态,称观测为可观测状态。

隐马尔可夫模型的任务就是根据观测序列推断出最有可能的隐状态序列。

二、隐马尔可夫模型的数学表达隐马尔可夫模型的数学表达可以用贝叶斯公式表示:P(O|λ) = ∑Q P(O|Q, λ)P(Q|λ)其中,O表示观测序列,Q表示隐状态序列,λ表示模型参数。

P(O|Q, λ)表示在给定隐状态序列Q和模型参数λ的条件下,观测序列O出现的概率;P(Q|λ)表示在给定模型参数λ的条件下,隐状态序列Q出现的概率。

P(O|λ)表示在给定模型参数λ的条件下,观测序列O出现的概率。

根据贝叶斯公式,我们可以得到隐状态序列的后验概率:P(Q|O,λ) = P(O|Q,λ)P(Q|λ)/P(O|λ)其中,P(O|Q,λ)和P(Q|λ)可以通过模型参数计算,P(O|λ)可以通过前向算法或后向算法计算。

隐马尔可夫模型(HMM)中文分词

隐马尔可夫模型(HMM)中⽂分词1. 马尔可夫模型 如果⼀个系统有n个有限状态S={s1,s2,…s n},随着时间推移,该系统将从某⼀状态转移到另⼀状态,Q={q1,q2,…q n}位⼀个随机变量序列,该序列中的变量取值为状态集S中的某个状态,其中q t表⽰系统在时间t的状态。

那么:系统在时间t处于状态s j的概率取决于其在时间1,2, … t-1的状态,该概率为:P(q t=s j|q t−1=s i,q t−2=s k…)如果在特定条件下,系统在时间t的状态只与其在时间t-1的状态相关,即:P(q t=s j|q t−1=s i,q t−2=s k…)=P(q t=s j|q t−1=s i)则该系统构成⼀个离散的⼀阶马尔可夫链。

进⼀步,如果只考虑上述公式独⽴于时间t的随机过程:P(q t=s j|q t−1=s i)=a ij,1≤i,j≤N该随机过程为马尔可夫模型。

其中,状态转移概率aij 必须满⾜以下条件:a ij≥0,N∑j=1a ij=12.隐马尔可夫模型 相对于马尔可夫模型,在隐马尔可夫模型中,我们不知道模型经过的状态序列,只知道状态的概率函数,即,观察到的事件是状态的随机函数,因此,该模型是⼀个双重的随机过程。

其中,模型的状态转换过程是不可观察的,即隐蔽的,可观察事件的随机过程是隐蔽的观察状态转换过程的随机函数。

隐马尔可夫模型可以⽤五个元素来描述,包括2个状态集合和三个概率矩阵: (1)隐含状态 S 这些状态之间满⾜马尔可夫性质,是马尔可夫模型中实际所隐含的状态。

这些状态通常⽆法通过直接观测⽽得到。

(例如S1,S2,S3等等) (2)可观测状态 O 在模型中与隐含状态相关联,可通过直接观测⽽得到。

(例如O1,O2,O3等等,可观测状态的数⽬不⼀定要和隐含状态的数⽬⼀致。

(3)初始状态概率矩阵π 表⽰隐含状态在初始时刻t=1的概率矩阵,(例如t=1时,P(S1)=p1,P(S2)=P2,P(S3)=p3,则初始状态概率矩阵π=[ p1 p2 p3 ] (4)隐含状态转移概率矩阵A 描述了HMM模型中各个状态之间的转移概率。

一文搞懂HMM(隐马尔可夫模型)

⼀⽂搞懂HMM(隐马尔可夫模型)什么是熵(Entropy)简单来说,熵是表⽰物质系统状态的⼀种度量,⽤它⽼表征系统的⽆序程度。

熵越⼤,系统越⽆序,意味着系统结构和运动的不确定和⽆规则;反之,,熵越⼩,系统越有序,意味着具有确定和有规则的运动状态。

熵的中⽂意思是热量被温度除的商。

负熵是物质系统有序化,组织化,复杂化状态的⼀种度量。

熵最早来原于物理学. 德国物理学家鲁道夫·克劳修斯⾸次提出熵的概念,⽤来表⽰任何⼀种能量在空间中分布的均匀程度,能量分布得越均匀,熵就越⼤。

1. ⼀滴墨⽔滴在清⽔中,部成了⼀杯淡蓝⾊溶液2. 热⽔晾在空⽓中,热量会传到空⽓中,最后使得温度⼀致更多的⼀些⽣活中的例⼦:1. 熵⼒的⼀个例⼦是⽿机线,我们将⽿机线整理好放进⼝袋,下次再拿出来已经乱了。

让⽿机线乱掉的看不见的“⼒”就是熵⼒,⽿机线喜欢变成更混乱。

2. 熵⼒另⼀个具体的例⼦是弹性⼒。

⼀根弹簧的⼒,就是熵⼒。

胡克定律其实也是⼀种熵⼒的表现。

3. 万有引⼒也是熵⼒的⼀种(热烈讨论的话题)。

4. 浑⽔澄清[1]于是从微观看,熵就表现了这个系统所处状态的不确定性程度。

⾹农,描述⼀个信息系统的时候就借⽤了熵的概念,这⾥熵表⽰的是这个信息系统的平均信息量(平均不确定程度)。

最⼤熵模型我们在投资时常常讲不要把所有的鸡蛋放在⼀个篮⼦⾥,这样可以降低风险。

在信息处理中,这个原理同样适⽤。

在数学上,这个原理称为最⼤熵原理(the maximum entropy principle)。

让我们看⼀个拼⾳转汉字的简单的例⼦。

假如输⼊的拼⾳是"wang-xiao-bo",利⽤语⾔模型,根据有限的上下⽂(⽐如前两个词),我们能给出两个最常见的名字“王⼩波”和“王晓波 ”。

⾄于要唯⼀确定是哪个名字就难了,即使利⽤较长的上下⽂也做不到。

当然,我们知道如果通篇⽂章是介绍⽂学的,作家王⼩波的可能性就较⼤;⽽在讨论两岸关系时,台湾学者王晓波的可能性会较⼤。

HMM隐马尔可夫模型解析课件

的颜色为O1,并把球放回缸中 n 根据描述缸的转移的概率分布,随机选择下一口缸,

重复以上步骤。

n 为最观后察得值到序一列个O描。述球的颜色的序列O1,O2, … ,称

HMM实例——约束

在上述实验中,有几个要点需要注意:

n (a)转移矩阵没有零值 的Markov链

n (b)转移矩阵有零值的 Markov链

n (c)和(d)是左-右形式表 示的Markov链

HMM实例

Urn 3 Urn 2 Urn 1

Veil

Observed Ball Sequence

HMM实例——描述

n 设有N个缸,每个缸中装有很多彩球,球的颜色 由一组概率分布描述。实验进行方式如下

的统计特性,即状态转移概率确定;这个 状态产生的输出亦为随机的,取决于该状 态生成语音观察量的概率。

n 无跨越模型符合人类的语音特点,广泛应 用于语音识别中。

n 有跨越用于反映音素在发音中可能被吸收 或删除的情况。

Two types of HMM

n State-emission HMM (Moore machine):

n X(t+1) = f(X(t) ) n 现实中存在很多马尔可夫过程

马尔可夫链

n 时间和状态都离散的马尔可夫过程称为马尔可夫链

n 记作{Xn = X(n), n = 0,1,2, …}

n 在时间集T1 = {0,1,2, …}上对离散状态的过程相继观察的结果

n 链的状态空间记做I = {a1, a2, …}, ai∈R.

隐马尔可夫模型 Hidden Markov model

隐马尔科夫(HMM)模型详解及代码实现

机器学习之隐马尔科夫模型(HMM)机器学习之隐马尔科夫模型(HMM)1、隐马尔科夫模型介绍2、隐马尔科夫数学原理3、Python代码实现隐马尔科夫模型4、总结隐马尔可夫模型介绍马尔科夫模型(hidden Markov model,HMM)是关于时序的概率模型,描述由一个隐藏的马尔科夫随机生成不可观测的状态随机序列,再由各个状态生成一个观测从而产生观测随机序列的过程,属于一个生成模型。

下面我们来从概率学角度定义马尔科夫模型,从一个典型例子开始:假设有4个盒子,每个盒子里面有不同数量的红、白两种颜色的球,具体如下表:盒子编号1234红球数5368白球数5742现在从这些盒子中取出T个球,取样规则为每次选择一个盒子取出一个球,记录其颜色,放回。

在这个过程中,我们只能观测到球的颜色的序列,观测不到球是从哪个盒子中取出来的,即观测不到盒子的序列,这里有两个随机序列,一个是盒子的序列(状态序列),一个是球的颜色的观测序列(观测序列),前者是隐藏的,只有后者是可观测的。

这里就构成了一个马尔科夫的例子。

定义是所有的可能的状态集合,V是所有的可能的观测的集合:其中,N是可能的状态数,M是可能的观测数,例如上例中N=4,M=2。

是长度为T的状态序列,是对应的观测序列:A是状态转移概率矩阵:其中, 是指在时刻处于状态的条件下在时刻转移到状态的概率。

B是观测概率矩阵:其中, 是指在时刻处于状态的条件下生成观测的概率。

是初始状态概率向量:其中, 是指在时刻=1处于状态的概率。

由此可得到,隐马尔可夫模型的三元符号表示,即称为隐马尔可夫模型的三要素。

由定义可知隐马尔可夫模型做了两个基本假设:(1)齐次马尔科夫性假设,即假设隐藏的马尔科夫链在任意时刻的状态只和-1状态有关;(2)观测独立性假设,观测只和当前时刻状态有关;仍以上面的盒子取球为例,假设我们定义盒子和球模型:状态集合: = {盒子1,盒子2,盒子3,盒子4}, N=4观测集合: = {红球,白球} M=2初始化概率分布:状态转移矩阵:观测矩阵:(1)转移概率的估计:假设样本中时刻t处于状态i,时刻t+1转移到状态j 的频数为那么转台转移概率的估计是:(2)观测概率的估计:设样本中状态为j并观测为k的频数是那么状态j观测为k的概率, (3)初始状态概率的估计为S个样本中初始状态为的频率。

HMM(隐马尔可夫)推导(下)-参数估计(EM)

HMM(隐马尔可夫)推导(下)-参数估计(EM)HMM (隐马尔可夫) 推导 (下) - 参数估计 (EM)回顾 HMM上篇介绍了HMM这样的⼀种时序类模型, 即描述了⼀些观测现象的产⽣, 是由我们很难观测到的 "隐变量因⼦", 产⽣的, 同时这些隐变量因⼦之间的变化也有⼀个状态转移概率的过程.HMM 的推导过程, 也就两个部分, Z 过程 (推断过程) 和 Estimation(参数估计)过程.上篇对于 Z 过程, 有通过类似于枚举法和⼀种 DP (动态规划) 算法来求解最好的 Z, 其前提假设是模型的参数 (初始状态, 状态转移概率矩阵,发射概率) 已知下来求解的. 嗯. 推导思路过程有点类似之前的 XGBoost 算法, 也是先假定, 再推导, 在证明假设前提这样的套路, 过程⼜⽤到了 EM算法来求解.如果我是⾯试官, 问HMM, 这相当于将 EM 和 DP 算法同时问了, 这样的问题就很有质量哦.12⽉底恰好tableau⽼铁跟我分享动态规划,果然数学系就是不⼀样, ⽤爬n阶楼梯来说明, 斐波那契数. DP的核⼼思想就是将问题规模不断缩⼩求解, 不同于递归哈, 后⾯可以单独举个 DP 栗⼦.so, 本篇就来整⼀波, 如何进⾏参数求解.θ=(π,A,B)假设有5个状态, 同样是扔2个硬币π表⽰初始状态, 如: π=[0.8,b,c,d,e]A 表⽰两个状态的转移矩阵; 是⼀个 5x5 的⽅阵B 表⽰发射概率 (隐含规则->观测的概率值); 是⼀个 5x2 的矩阵如果是词性分析, 则矩阵就⾮常⼤了, 如果观测是连续型则需要⽤概率分布来描述了.对于, HMM, 要求解出这3个参数, 主要有两个步骤, 或者说是2个关键点:给定模型的参数, 找出最适合的 Z => Inference (推断过程)估计模型参数的θ => Parameter Estimation (估计过程)Complete VS lncomplete "Z"Z 就是隐变量, X 是对应的观测值.X 已知, Z 已知, 则通过简单的频率统计即可求解出参数X 已知, Z 未知, 则通过 EM 算法求解. (E 步更新发射概率, M 步更新参数值, 这样循环交替直到收敛, 即得参数发射概率就是隐变量 z1 -> x1 (观测值) 的概率. 可参考EM篇的扔硬币, 上帝视⾓, 事先知道试验结果是由哪个硬币产⽣的, 或知道概率. (如第1次是 "正", 我知道有 70% 概率来⾃ A 硬币, 30%概率来⾃ B硬币, 这个概率矩阵 [0.7, 0.3] 就是发射概率)转移概率描述状态之间的变化规律. 如还是扔硬币, 每次对 A, B 硬币的选择策略不同, 如 AAB, ABA ... 的场景, 可通过转移概率矩阵来描述.ps: ⽼铁昨天问我是数论强, 还是分析强...嗯, 我只想说, 作为⽂科⽣(商科), 只是熟练使⽤数学⼯具⽽已....另外想分享⼀点⼯具论, 在我眼⾥, 数学符号, 公式, 代码, 其实本质都是⼀样的, 就是⼀个靠谱的⼯具, ⽬标都是为了对现实世界的另⼀种刻画. 当然世界很⼤, 可以感性认知, 也可理性认知, 探索的过程是其乐⽆穷的. 我感觉⾃⼰内⼼还是⼀个⽂艺青年的特征, 追求内⼼的感受, 也有故作伤春悲秋....不说这些了..Complete "Z"假设有 3个观测样本, Z 是已知时:s1:z : 1, 1, 2, 2, 2, 3x : a, b, a, c, c, bs2:z : 2, 1, 3, 3, 2x : a, a, c, b, as3:z : 1, 1, 3, 2x : b, a, a, c在 z 已知道的这种上帝视⾓下, 求解参数 (初始状态, 状态转移矩阵, 发射概率) 就是词频统计, 然后归⼀化作为概率值 , ⾮常容易的.为了⽅便简单演⽰, 假设样本空间就是上⾯这3个样本, 观测值和其隐变量状态都是已知的.⾸先来估计π (初始状态) 即每⼀个样本(向量 1x3) 的第⼀状态分量的频数统计, (约定先⾏后列哦)状态1状态2状态3频次210然后再归⼀化得到初始状态 (向量) :π=[23,1 3,3]接着来估计 A (状态转移矩阵), 状态与状态间的, 即 3x3 的矩阵. 同时, 状态要横向来看, 统计是先⾏后列--->状态1状态2状态3状态1212状态2121状态3021按⾏进⾏归⼀化即可得到概率 (严格来说, "频率" 应该更适合, 但我们通常都是⽤样本估计总体, 也说得通哈)--->状态1状态2状态3状态12/51/52/5状态21/42/41/4状态30/32/31/3最后来估计 B (发射概率矩阵), 即每个状态下, 每个观测值的概率, 即可 3x3 的矩阵 (统计也是约定, 先⾏后列哈)--->a b c状态1320状态2303状态3121同样按⾏做归⼀化可得到发射概率矩阵 B:--->a b c状态13/52/50/5状态23/60/63/6状态31/42/41/4因此, 在已知 Z 的情况下, 要做的就是直接统计出了模型的参数: 初始概率状态(向量), 状态转移概率 (矩阵), 发射概率 (矩阵). 站在上帝视⾓, 果然爽歪歪. 此处突然想到了基本经济社会问题. 就是, 你所掌握资源越多, 就越有发⾔权, 做事情成功的概率必然很⼤和相对轻松.Incomplete "Z"⽽我们⾝处的现实世界, ⼏乎是没有上帝视⾓的. 它只存在于理论的乌托邦世界. 于是在现世的洪流, 我们通常只是看到观测到的现象, ⽽⽆法得知现象背后的上帝,是如何扔骰⼦的, 即便如此, 我们依旧去进⾏⼀个逼近, 利⽤智慧, 嗯, 说得有⾼⼤上, 这⾥其实就⽤到 EM 算法来进⾏⼀个参数估计即可.(x,z)−简单统计−θ⽽,(x,)−how−θF/B 算法 ( Forward And Backward)就要要计算出p(z k|x) 即在给定 x 的情况下, 可以计算任意时刻状态下的 z 的期望通过 F/B 算法, 可以计算出: p(z k=1|x),p(z k=2|x),....p(z k=m|x)也就是说, 通过观测 X, 计算出了 Z, 然后简单统计则可估计出模型的参数, 再来捋⼀波条件F / B : p(z|x)Forward : ⽤来计算p(z k|x1...k)Backward : ⽤来计算p(x k+1,...n|z k)如何将它们关联起来呢, , 涉及条件概率, 同时也会想到贝叶斯公式呀.p(z k|x)=p(z k,x) p(x)这⾥的 x 表⽰所有的 n 个样本嘛, 因此为了和 F, B 产⽣联系, 可以将 x 进⾏划分 (展开).p(z k,x)=p(z k,x1...k,x k+1...n)=p(z k,x1...k) p(x k+1...n|z k,x1..k)可以省略掉x1...k考虑条件独⽴的情况下, 其对条件概率是没有影响的.=p(z k,x1...k) p(x k+1...n|z k)为啥是条件独⽴成⽴?因为, directional separation 性质: (嗯, 就可理解为条件独⽴的⼀种更⾼级的⼀个性质), ⽤处就是帮助我们来判断多个变量中, 有哪⼀些变量之间, 是有条件独⽴的性质的, 或者是把很多的变量看作⼀个集合.我们在谈条件独⽴的时候, 通常是以单个变量来参照的. 然⽽涉及多个变量, 则需⽤的 D-separation 性质了呀. 嗯....举个栗⼦, 假设我有两波变量, 然后通过 D-separation 性质, 可以帮我们判断, 其中⼀波变量, 是否对其条件概率产⽣了影响. 算是⼀个更加泛化的⼀个条件独⽴性质.在本例中, 我们把 X, 拆分成了x1...k−1,x k,x k+1...n在 D-separation 性质中, x k这个分割点被称为 Block , 如果当存在变量 (可以多个) x - Block - y 且指向关系是 x -> Block -> y 的时候, 则可以认为, x(变量集合) 是条件独⽴于 Block 的. 因此可以省略掉. (具体D-separation 性质证明, 后⾯再补⼀波百度吧, 先⽤上再说)最终p(z k,x)=p(z k,x1...k) p(x k+1...n|z k) 即通过计算 Forward 和 Backward 完成最终求解.重要信息,再重复⼀遍: 我们为了计算p(z|k) 其实只需要计算出 Forward 和 Backward 即可, 这也就是通过 X 计算出了 Z, 从⽽依上 complete 的简单统计, 求解出模型参数然后关如何去定义 Z 的个数, 其实是⼀个超参数, 有点类似于 EM算法中, 最开始 E部的初始值, ⼈⼯可以根据经验来控制的.⼩结然后好像有点⼤篇幅的在弄 F/B 算法, ⽽开篇主要想阐明参数估计的核⼼是 EM算法, 那体现在何处呢? 我们捋⼀波求解参数的过程:⾸先, 我们是要通过在给定 X 的情况下, 求解出 Z 的期望, 这个求解过程⽤到了 F/B 算法;其次, 我们通过已知 (X, Z) 来求解出了参数θ这, 不就是 EM 算法的 E步和 M 步了呀.最后, 其实还遗留了⼀个问题, 就是如何求解 F/B 嗯, 想⼀波先. 框架是没问题了, 这就跟写代码⼀样, 逻辑结构, 模块划分已经搭起来了, 然后就是慢慢去找别⼈的代码来复制粘贴的过程, 先想⼀波哈.Processing math: 100%。

Matlab统计学工具箱之(隐)马尔可夫模型:MarkovModels-Matlab

Matlab统计学工具箱之(隐)马尔可夫模型:MarkovModels-Matlab此文讲述的内容在Matlab 7.0、7.5(R2007b)中均有——马尔可夫工具箱,主要内容如下。

简介:马尔可夫处理是随机处理的一个典型例子——此种处理根据特定的概率产生随机输出或状态序列。

马尔可夫处理的特别之处在于它的无记忆性——他的下一个状态仅依赖他的当前状态,不考虑导致他们的历史。

马尔可夫处理的模型在实际应用中使用非常广泛,从每日股票价格到染色体中的基因位置都有应用。

马尔可夫链马尔可夫模型用状态图可视化描述如下。

MarkovModel.jpg在图中,矩形代表你要描述的模型在处理中可能出现的状态,箭头描述了状态之间的转换。

每个箭头上的标签表明了该转换出现的概率。

在处理的每一步,模型都可能根据当前状态产生一种output或emission,然后做一个到另一状态的转换。

马尔可夫模型的一个重要特点是:他的下个状态仅仅依赖当前状态,而与导致其成为当前状态的历史变换无关。

马尔可夫链是马尔可夫模型的一组离散状态集合的数学描述形式。

马尔可夫链特征归纳如下:1. 一个状态的集合{1, 2, ..., M}2. 一个M * M的转移矩阵T,(i, j)位置的数据是从状态i转到状态j的概率。

T的每一行值的和必然是1,因为这是从一个给定状态转移到其他所有可能状态的概率之和。

3. 一个可能的输出(output)或发布(emissions)的集合{S1, S2, ..., SN}。

默认情况下,发布的集合是{1, 2, ..., N},这里N是可能的发布的个数,当然,你也可以选择一个不同的数字或符号的集合。

4. 一个M * N的发布矩阵E,(i, k)入口给出了从状态i得到发布的标志Sk的概率。

马尔可夫链在第0步,从一个初始状态i0开始。

接着,此链按照T(1, i1)概率转移到状态i1,且按概率E(i1, k1)概率发布一个输出S(k1)。

HMM隐马尔可夫模型MATLAB

HMM隐马尔可夫模型MATLABHMM 隐马尔可夫模型Intro维基百科定义:隐马尔可夫模型⽤来描述⼀个含有隐含未知参数的,⽽马尔可夫过程是是⼀个具备了的,当⼀个在给定现在状态及所有过去状态情况下,其未来状态的条件仅依赖于当前状态;换句话说,在给定现在状态时,它与过去状态(即该过程的历史路径)是的,那么此即具有马尔可夫性质。

Matlab HMM 定义:A hidden Markov model (HMM) is one in which you observe a sequence of emissions, but do not know the sequence of statesthe model went through to generate the emissions. Analyses of hidden Markov models seek to recover the sequence of states from the observed data.⼈话(个⼈理解):我们可以做⼀个假设:世界上的很多随机现象,⽐如天⽓(晴天或是下⾬天),看似随机其实背后都是有其真正的原因,我们假设这些随机表象背后是由数个真正的原因所决定的,⽽且每⼀个状态只与上⼀个状态相关(今天的天⽓只与昨天天⽓背后的隐藏状态有关),我们称满⾜这样假设的模型为马尔可夫模型。

我们在这⾥称表象(晴天或是下⾬天)为emissions(发射)或者the observed data,称背后真正的原因为hidden state(隐藏状态)。

之所以将表象称为发射,是因为⼀个表象是由⼀个隐藏状态“发射”⽽来,每⼀天都是由⼀个隐藏状态产⽣,⽽每⼀个隐藏状态都可能产⽣其他的表象,产⽣表象的概率矩阵被称为发射矩阵B。

每⼀天的隐藏状态之间也存在转移概率,此概率矩阵被称为转移矩阵A。

初始隐藏状态的概率矩阵被称为π于是这就是隐马尔可夫模型(HMM)的重要三个矩阵A,B,π隐马尔可夫模型提出以下问题:给定的发射序列,求最可能的状态序列给定的发射序列,你将如何估计模型的转移概率和输出概率?模型⽣成给定序列的先验概率是多少?在给定序列中某个状态时,模型的后验概率是多少?Hidden Markov models raise the following questions:Given a sequence of emissions, what is the most likely state path?Given a sequence of emissions, how can you estimate transition and emission probabilities of the model?What is the forward probability that the model generates a given sequence?What is the posterior probability that the model is in a particular state at any point in the sequence?模型需要指定⼀个转移矩阵TRANS和⼀个发射矩阵EMIS,TRANS(i,j)是隐藏状态i转移到j的概率,EMIS(i,j)是序列seq在隐藏状态i时发射出符号j 的概率。

隐马尔科夫模型(HMM)详解

马尔科夫过程马尔科夫过程可以看做是一个自动机,以一定的概率在各个状态之间跳转。

考虑一个系统,在每个时刻都可能处于N个状态中的一个,N个状态集合是{S1,S2,S3,...S N}。

我们如今用q1,q2,q3,…q n来表示系统在t=1,2,3,…n时刻下的状态。

在t=1时,系统所在的状态q取决于一个初始概率分布PI,PI(S N)表示t=1时系统状态为S N的概率。

马尔科夫模型有两个假设:1. 系统在时刻t的状态只与时刻t-1处的状态相关;〔也称为无后效性〕2. 状态转移概率与时间无关;〔也称为齐次性或时齐性〕第一条详细可以用如下公式表示:P(q t=S j|q t-1=S i,q t-2=S k,…)= P(q t=S j|q t-1=S i)其中,t为大于1的任意数值,S k为任意状态第二个假设那么可以用如下公式表示:P(q t=S j|q t-1=S i)= P(q k=S j|q k-1=S i)其中,k为任意时刻。

下列图是一个马尔科夫过程的样例图:可以把状态转移概率用矩阵A表示,矩阵的行列长度均为状态数目,a ij表示P(S i|S i-1)。

隐马尔科夫过程与马尔科夫相比,隐马尔科夫模型那么是双重随机过程,不仅状态转移之间是个随机事件,状态和输出之间也是一个随机过程,如下列图所示:此图是从别处找来的,可能符号与我之前描绘马尔科夫时不同,相信大家也能理解。

该图分为上下两行,上面那行就是一个马尔科夫转移过程,下面这一行那么是输出,即我们可以观察到的值,如今,我们将上面那行的马尔科夫转移过程中的状态称为隐藏状态,下面的观察到的值称为观察状态,观察状态的集合表示为O={O1,O2,O3,…O M}。

相应的,隐马尔科夫也比马尔科夫多了一个假设,即输出仅与当前状态有关,可以用如下公式表示:P(O1,O2,…,O t|S1,S2,…,S t)=P(O1|S1)*P(O2|S2)*...*P(O t|S t) 其中,O1,O2,…,O t为从时刻1到时刻t的观测状态序列,S1,S2,…,S t那么为隐藏状态序列。

隐马尔可夫模型(HMM)简介

隐马尔可夫模型(HMM)简介(一)阿黄是大家敬爱的警官,他性格开朗,身体强壮,是大家心目中健康的典范。

但是,近一个月来阿黄的身体状况出现异常:情绪失控的状况时有发生。

有时候忍不住放声大笑,有时候有时候愁眉不展,有时候老泪纵横,有时候勃然大怒……如此变化无常的情绪失控是由什么引起的呢?据警队同事勇男描述,由于复习考试寝室不熄灯与多媒体作业的困扰,阿黄近日出现了失眠等症状;与此同时,阿黄近日登陆一个叫做“xiaonei网”的网站十分频繁。

经医生进一步诊断,由于其他人也遇到同样的考试压力、作息不规律的情况而并未出现情绪失控;并且,其它登陆XIAONEI网的众多同学表现正常,因此可基本排除它们是情绪失控的原因。

黄SIR的病情一度陷入僵局……最近,阿黄的病情有了新的眉目:据一位对手相学与占卜术十分精通的小巫婆透露,阿黄曾经私下请她对自己的病情进行诊断。

经过观察与分析终于有了重大发现:原来阿黄的病情正在被潜伏在他体内的三种侍神控制!他们是:修罗王、阿修罗、罗刹神。

据悉,这三种侍神是情绪积聚激化而形成的自然神灵,他们相克相生,是游离于个体意识之外的精神产物,可以对人的情绪起到支配作用。

每一天,都会有一位侍神主宰阿黄的情绪。

并且,不同的侍神会导致不同的情绪突然表现。

然而,当前的科技水平无法帮助我们诊断,当前哪位侍神是主宰侍神;更糟的是,不同的侍神(3个)与不同的情绪(4种)并不存在显而易见的一一对应关系。

所以,乍看上去,阿黄的病情再次陷入僵局……我们怎样才能把握阿黄情绪变化的规律?我们怎样才能通过阿黄的情绪变化,推测他体内侍神的变化规律?关键词:两类状态:情绪状态(观察状态):放声大笑,愁眉不展,老泪纵横,勃然大怒侍神状态(隐状态):修罗王,阿修罗,罗刹神(二)阿黄的病情引来了很多好心人的关心。

这与阿黄真诚善良的品格不无关系。

关于侍神的特点,占卜师和很多好心人找来了许多珍贵资料。

其中很多人经过一段时间的观察与记录后,在貌似毫无规律的数据背后,发现了侍神与情绪之间的内在规律!!他们在多次观测后,建立在大量数据基础上,表现出宏观的内在联系!由于这些好心人大部分是TONGJI大学的人,所以,这种规律被称作统计规律。

HMM 隐马尔科夫 matlab工具箱中英文对照.

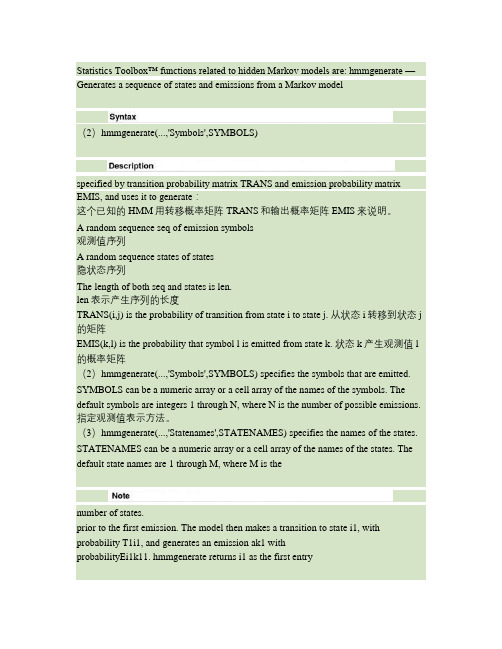

Statistics Toolbox™ functions related to hidden Markov models are: hmmgenerate —Generates a sequence of states and emissions from a Markov model(2)hmmgenerate(...,'Symbols',SYMBOLS)specified by transition probability matrix TRANS and emission probability matrix EMIS, and uses it to generate:这个已知的HMM用转移概率矩阵TRANS和输出概率矩阵EMIS来说明。

A random sequence seq of emission symbols观测值序列A random sequence states of states隐状态序列The length of both seq and states is len.len表示产生序列的长度TRANS(i,j) is the probability of transition from state i to state j. 从状态i转移到状态j 的矩阵EMIS(k,l) is the probability that symbol l is emitted from state k. 状态k产生观测值l 的概率矩阵(2)hmmgenerate(...,'Symbols',SYMBOLS) specifies the symbols that are emitted. SYMBOLS can be a numeric array or a cell array of the names of the symbols. The default symbols are integers 1 through N, where N is the number of possible emissions. 指定观测值表示方法。

隐马尔可夫模型(hmm)的matlab实现

隐马尔可夫模型(HMM)是一种用于对时序数据进行建模和分析的概率模型,特别适用于具有一定的隐含结构和状态转移概率的数据。

在自然语言处理、语音识别、生物信息学等领域中,HMM都有着广泛的应用。

在本文中,我将向您介绍HMM的基本概念和原理,并共享如何使用Matlab来实现HMM模型。

1. HMM基本概念和原理隐马尔可夫模型是由隐含状态和可见观测两部分组成的,其中隐含状态是不可见的,而可见观测是可以被观测到的。

在HMM中,隐含状态和可见观测之间存在转移概率和发射概率。

通过这些概率,HMM可以描述一个系统在不同隐含状态下观测到不同可见观测的概率分布。

HMM可以用状态转移矩阵A和发射矩阵B来表示,同时也需要一个初始状态分布π来描述系统的初始状态。

2. Matlab实现HMM模型在Matlab中,我们可以使用HMM工具箱(HMM Toolbox)来实现隐马尔可夫模型。

我们需要定义系统的隐含状态数目、可见观测的数目以及状态转移概率矩阵A和发射概率矩阵B。

利用Matlab提供的函数,可以方便地计算出系统在给定观测下的概率分布,以及通过学习的方法来调整参数以适应实际数据。

3. 在Matlab中实现HMM模型需要注意的问题在实现HMM模型时,需要注意参数的初始化和调整,以及对于不同类型的数据如何选择合适的模型和算法。

在使用HMM模型对实际问题进行建模时,需要考虑到过拟合和欠拟合等问题,以及如何有效地利用HMM模型进行预测和决策。

总结通过本文的介绍,我们可以了解到隐马尔可夫模型在时序数据建模中的重要性,以及如何使用Matlab来实现HMM模型。

对于HMM的进一步学习和实践,我个人认为需要多实践、多探索,并结合具体应用场景来深入理解HMM模型的原理和方法。

在今后的学习和工作中,我相信掌握HMM模型的实现和应用将对我具有重要的帮助。

我会继续深入学习HMM模型,并将其运用到实际问题中,以提升自己的能力和水平。

以上是我对隐马尔可夫模型的个人理解和观点,希望对您有所帮助。

隐马尔可夫模型(hmm)参数迭代与语音识别

隐马尔可夫模型(HMM)是一种统计模型,常用于语音识别、自然语言处理等领域。

它主要用来描述隐藏的马尔可夫链,即一种具有未知状态的马尔可夫链。

在语音识别中,HMM被广泛应用于对语音信号进行建模和识别。

下面我将从HMM的基本概念、参数迭代和语音识别应用等方面展开阐述。

1. HMM的基本概念在隐马尔可夫模型中,有三种基本要素:状态、观测值和状态转移概率及观测概率。

状态表示未知的系统状态,它是隐藏的,无法直接观测到。

观测值则是我们可以观测到的数据,比如语音信号中的频谱特征等。

状态转移概率描述了在不同状态之间转移的概率,而观测概率则表示在每个状态下观测到不同观测值的概率分布。

2. HMM参数迭代HMM的参数包括初始状态概率、状态转移概率和观测概率。

在实际应用中,这些参数通常是未知的,需要通过观测数据进行估计。

参数迭代是指通过一定的算法不断更新参数的过程,以使模型更好地拟合观测数据。

常见的参数迭代算法包括Baum-Welch算法和Viterbi算法。

其中,Baum-Welch算法通过最大化似然函数来估计模型的参数,Viterbi算法则用于解码和预测。

3. HMM在语音识别中的应用在语音识别中,HMM被广泛用于建模和识别语音信号。

语音信号被转换成一系列的特征向量,比如MFCC(Mel-Frequency Cepstral Coefficients)特征。

这些特征向量被用来训练HMM模型,学习模型的参数。

在识别阶段,通过Viterbi算法对输入语音进行解码,得到最可能的文本输出。

4. 个人观点和理解从个人角度看,HMM作为一种强大的统计模型,在语音识别领域有着重要的应用。

通过不断迭代参数,HMM能够更好地建模语音信号,提高语音识别的准确性和鲁棒性。

然而,HMM也面临着状态空间爆炸、参数收敛速度慢等问题,需要结合其他模型和算法进行改进和优化。

总结回顾通过本文对隐马尔可夫模型(HMM)的介绍,我们从基本概念、参数迭代和语音识别应用等方面对HMM有了更深入的了解。

Matlab中的隐马尔科夫模型建模方法概述

Matlab中的隐马尔科夫模型建模方法概述引言:在现代数据分析和机器学习中,隐马尔科夫模型(Hidden Markov Model,HMM)是一种用于建模时间序列数据的强大工具。

HMM在自然语言处理、语音识别、生物信息学等领域有广泛应用。

Matlab作为一种强大的数学软件,在HMM 的建模和分析方面也提供了丰富的工具和函数。

本文将概述Matlab中使用HMM 进行建模的方法。

一、隐马尔科夫模型简介隐马尔科夫模型是一种通过观察序列推断潜在状态的统计模型。

其中,状态是不可见的,而观察到的只有与状态相关的输出。

HMM将系统抽象为可达到的状态集合和状态之间的转移概率,以及每个状态输出特定观察的概率分布。

这种模型适用于许多实际问题,如序列标注、序列分类、语音识别等。

二、Matlab中的隐马尔科夫模型函数Matlab在Statistics and Machine Learning Toolbox(统计与机器学习工具箱)中提供了丰富的HMM模型建模与分析函数。

以下是其中常用的几个函数:1. hmmgenerate:用于生成服从HMM模型的观察序列。

通过指定转移矩阵、发射矩阵和初始状态概率,可以生成满足HMM模型的观察序列。

2. hmmtrain:用于基于给定观察序列估计HMM模型的参数。

通过最大似然估计方法,可以根据观察序列来估计转移矩阵、发射矩阵和初始状态概率。

3. hmmdecode:给定观察序列和HMM模型的参数,用于计算给定观察序列的状态序列。

这个函数可以用于解码隐藏的状态序列,从而理解观察序列背后的潜在状态。

以上三个函数是使用HMM进行建模的关键函数。

使用这些函数,我们可以根据观察序列和问题需求,进行模型训练、生成和解码等操作。

三、隐马尔科夫模型建模步骤在使用Matlab进行HMM建模时,可以按照以下步骤进行:1. 数据准备:收集与问题相关的训练数据,并进行预处理和特征提取。

将数据划分为观察序列和状态序列。

HMM及其算法介绍

HMM及其算法介绍隐马尔可夫模型(Hidden Markov Model,HMM)是一种统计模型,用于描述具有潜在不可见状态的动态系统。

HMM主要用于序列数据的建模与分析,特别适用于语音识别、自然语言处理、语言模型、机器翻译等领域。

HMM是一种二层结构的概率图模型,包括状态序列和观测序列。

其中,状态序列代表系统内部的状态变化,而观测序列是根据系统状态产生的可见数据。

HMM的基本假设是系统状态满足马尔可夫性质,即当前状态只依赖于前一个状态。

HMM模型的核心是三个问题:评估问题、解码问题和学习问题。

评估问题是给定一个观测序列和模型参数,计算该观测序列出现的概率。

该问题可以使用前向算法和后向算法来解决。

前向算法从初始状态开始,计算每个时刻观测序列的概率;后向算法从最后一个状态开始,计算每个时刻观测序列的概率。

最后,两个算法的结果相乘得到观测序列的概率。

解码问题是给定一个观测序列和模型参数,找到最有可能的状态序列。

常用的解码算法有维特比算法和后向算法。

维特比算法通过动态规划的方式,计算每个时刻的最大概率状态,并在整个过程中维护一个路径矩阵,得到最有可能的状态序列。

学习问题是给定观测序列,估计模型参数。

通常使用的方法是极大似然估计,通过最大化观测序列的似然函数来估计模型参数。

Baum-Welch算法是HMM中常用的学习算法,它利用了前向算法和后向算法的结果,通过迭代优化模型参数,直到收敛。

HMM模型的应用之一是语音识别。

在语音识别中,观测序列是听到的声音,而状态序列代表对应的语音单元(如音素、词语)。

通过训练HMM模型,可以将声音与语音单元映射起来,从而实现语音的识别。

另一个常见的应用是自然语言处理中的词性标注。

词性标注是给每个词语标注上对应的词性,如名词、动词、形容词等。

通过训练HMM模型,可以将词语作为观测序列,词性作为状态序列,从而实现词性标注的任务。

总结来说,HMM是一种用于序列数据建模的统计模型,具有评估问题、解码问题和学习问题等核心问题。

用隐马尔可夫模型进行预测的matlab代码

使用隐马尔可夫模型进行预测的matlab代码一、概述隐马尔可夫模型(Hidden Markov Model,HMM)是一种统计模型,被广泛应用于语音识别、自然语言处理、生物信息学等领域。

它是一种具有隐含状态的动态贝叶斯网络模型。

在本文中,我们将介绍如何使用Matlab编写隐马尔可夫模型进行预测的代码。

二、隐马尔可夫模型的基本原理1. 隐马尔可夫模型由状态空间、观测空间、状态转移概率矩阵、观测概率矩阵和初始状态概率向量组成。

2. 隐马尔可夫模型假设系统的状态是隐藏的,并且通过对系统的观测来推断状态的变化。

3. 隐马尔可夫模型可以用来描述观测序列与状态序列之间的关系,以及根据观测序列推断状态序列的概率分布。

三、Matlab编写隐马尔可夫模型的预测代码以下是使用Matlab编写的隐马尔可夫模型进行预测的代码:```matlab1. 定义隐马尔可夫模型的参数states = {'sunny', 'cloudy', 'r本人ny'}; 定义状态空间obser = {'umbrella', 'no umbrella'}; 定义观测空间transMatrix = [0.8, 0.1, 0.1; 0.3, 0.4, 0.3; 0.2, 0.2, 0.6]; 定义状态转移概率矩阵emissMatrix = [0.2, 0.8; 0.7, 0.3; 0.6, 0.4]; 定义观测概率矩阵initProb = [0.2, 0.4, 0.4]; 定义初始状态概率向量2. 使用HMM的工具箱创建隐马尔可夫模型对象hmmModel = hmmCreate('States', states, 'Symbols', obser,'Transitions', transMatrix, 'Emissions', emissMatrix,'InitialProbabilities', initProb);3. 定义观测序列observations = [2, 1, 2]; 观测序列对应的索引4. 使用隐马尔可夫模型进行预测[path, logP] = hmmViterbi(hmmModel, observations);disp(path);disp(logP);```四、代码解释1. 在上述代码中,我们首先定义了隐马尔可夫模型的参数,包括状态空间、观测空间、状态转移概率矩阵、观测概率矩阵和初始状态概率向量。

隐马尔科夫模型(HMM).

隐马尔科夫模型(HMM作者:leivo 来源:博客园发布时间:2010-10-29 00:59 阅读:497 次原文链接[收藏]介绍我们通常都习惯寻找一个事物在一段时间里的变化规律。

在很多领域我们都希望找到这个规律,比如计算机中的指令顺序,句子中的词顺序和语音中的词顺序等等。

一个最适用的例子就是天气的预测。

首先,本文会介绍声称概率模式的系统,用来预测天气的变化然后,我们会分析这样一个系统,我们希望预测的状态是隐藏在表象之后的,并不是我们观察到的现象。

比如,我们会根据观察到的植物海藻的表象来预测天气的状态变化。

最后,我们会利用已经建立的模型解决一些实际的问题,比如根据一些列海藻的观察记录,分析出这几天的天气状态。

Generating Patterns有两种生成模式:确定性的和非确定性的。

确定性的生成模式:就好比日常生活中的红绿灯,我们知道每个灯的变化规律是固定的。

我们可以轻松的根据当前的灯的状态,判断出下一状态。

非确定性的生成模式:比如说天气晴、多云、和雨。

与红绿灯不同,我们不能确定下一时刻的天气状态,但是我们希望能够生成一个模式来得出天气的变化规律。

我们可以简单的假设当前的天气只与以前的天气情况有关,这被称为马尔科夫假设。

虽然这是一个大概的估计,会丢失一些信息。

但是这个方法非常适于分析。

马尔科夫过程就是当前的状态只与前n个状态有关。

这被称作n阶马尔科夫模型。

最简单的模型就当n=1时的一阶模型。

就当前的状态只与前一状态有关。

(这里要注意它和确定性生成模式的区别,这里我们得到的是一个概率模型)。

下图是所有可能的天气转变情况:对于有M个状态的一阶马尔科夫模型,共有M*M个状态转移。

每一个状态转移都有其一定的概率,我们叫做转移概率,所有的转移概率可以用一个矩阵表示。

在整个建模的过程中,我们假设这个转移矩阵是不变的。

该矩阵的意义是:如果昨天是晴,那么今天是晴的概率为0.5,多云的概率是0.25,雨的概率是0.25。

高斯隐马尔可夫模型 matlab

高斯隐马尔可夫模型(Gaussian Hidden Markov Model, GHMM)是一种用于建模时序数据的统计模型,它被广泛应用于语音识别、手写体识别、生物信息学等领域。

在本文中,我们将结合实际案例介绍如何使用MATLAB实现高斯隐马尔可夫模型。

1. GHMM概述高斯隐马尔可夫模型是一种具有状态转移概率和观测概率的动态贝叶斯网络,在模式识别和机器学习领域有着重要的应用。

其基本思想是假设系统的状态是一个不可被观测到的隐变量序列,系统的行为是由这个隐变量序列决定的。

系统的状态会产生观测数据,而观测数据与系统的状态之间存在某种概率关系。

2. GHMM的模型参数高斯隐马尔可夫模型有三组参数:初始状态概率向量、状态转移概率矩阵和观测概率分布。

初始状态概率向量表示系统在某一时刻处于各个状态的概率;状态转移概率矩阵表示系统从一个状态转移到另一个状态的概率;观测概率分布则表示系统在某一状态下产生某个观测值的概率。

3. 使用MATLAB实现GHMM在MATLAB中,可以使用HMM Toolbox或者Statistics and Machine Learning Toolbox来实现高斯隐马尔可夫模型。

下面是使用Statistics and Machine Learning Toolbox实现GHMM的简单示例代码:```生成随机观测数据seqLength = 100;numStates = 3;[estTR,estE] = hmmestimate(seq,seq, 'Symbols', {'r本人ny','sunny'}, 'Pseudocount', 1);使用统计工具箱中的函数进行参数估计estTR = ones(numStates,numStates) + diag(ones(1,numStates)); estE = ones(numStates,numEmmissions) +diag(ones(1,numEmmissions));通过Baum-Welch算法进行参数估计[estTR,estE] = hmmtr本人n(seq,estTR,estE, 'Symbols', {'r本人ny', 'sunny'}, 'Maxiterations', 10);```4. 实际案例假设我们有一组连续的温度传感器数据,我们希望用高斯隐马尔可夫模型对这组数据进行建模,以便可以根据前几个时刻的观测数据来预测下一个时刻的温度。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Matlab 2011b Statistics Toolbox HMM作者:yuheng666Email:wuyuheng666@关键字:HMM,隐马尔科夫模型,Matlab,Statistics Toolbox声明:本文主要介绍Matlab2011b中Statistics Toolbox工具箱里与隐马尔科夫模型相关的函数及其用法(请勿与其它HMM工具箱混淆)。

本文的主要内容来自Matlab 2011b的帮助文档,为作者自学笔记。

水平有限,笔记粗糙,本着“交流探讨,知识分享”的宗旨,希望对HMM感兴趣的同学有些许帮助,欢迎指教,共同进步。

有关马尔科夫模型的基本知识,请参考其他资料。

如:/~lliao/cis841s06/hmmtutorialpart1.pdf/~lliao/cis841s06/hmmtutorialpart2.pdf/section/cs229-hmm.pdfhttp://jedlik.phy.bme.hu/~gerjanos/HMM/node2.html/dugad/hmm_tut.html.......变量说明:设有M个状态,N个符号Markov模型。

TRANS:对应状态转移矩阵,大小为M*M,表示各状态相互转换的概率,TRANS(i,j)表示从状态i转换到状态j的概率。

EMIS:对应符号生成矩阵,又叫混淆矩阵,观察符号概率分布。

EMIS(i,j)代表在状态i时,产生符号j的概率。

函数介绍:hmmgenerate — Generates a sequence of states and emissions from a Markov model 从一个马尔科夫模型产生状态序列和输出序列,该序列具有模型所表达的随机性特征。

A random sequence seq of emission symbolsA random sequence states of states用法:[seq,states] = hmmgenerate(len,TRANS,EMIS)hmmgenerate(...,'Symbols',SYMBOLS)hmmgenerate(...,'Statenames',STATENAMES)示例:trans = [0.95,0.05; 0.10,0.90];emis = [1/6 1/6 1/6 1/6 1/6 1/6;1/10 1/10 1/10 1/10 1/10 1/2];[seq,states] = hmmgenerate(100,trans,emis)[seq,states] = hmmgenerate(100,trans,emis,...'Symbols',{'one','two','three','four','five','six'},...'Statenames',{'fair';'loaded'})估计状态序列:Estimating the State Sequencehmmviterbi — Calculates the most probable state path for a hidden Markov model Given the transition and emission matrices TRANS and EMIS, the function hmmviterbi uses the Viterbi algorithm to compute the most likely sequence of states the model would go through to generate a given sequence seq of emissions:给定状态转移矩阵TRANS和混淆矩阵EMIS,hmmviterbi使用Viterbi算法计算该模型最相似的状态序列。

用法:STATES = hmmviterbi(seq,TRANS,EMIS)hmmviterbi(...,'Symbols',SYMBOLS)hmmviterbi(...,'Statenames',STATENAMES)示例:likelystates = hmmviterbi(seq, TRANS, EMIS);trans = [0.95,0.05;0.10,0.90];emis = [1/6 1/6 1/6 1/6 1/6 1/6;1/10 1/10 1/10 1/10 1/10 1/2];[seq,states] = hmmgenerate(100,trans,emis);estimatedStates = hmmviterbi(seq,trans,emis);[seq,states] = hmmgenerate(100,trans,emis,...'Statenames',{'fair';'loaded'});estimatesStates = hmmviterbi(seq,trans,emis,...'Statenames',{'fair';'loaded'});hmmestimate和hmmtrain用于通过给定的输出序列估计转移矩阵TRANS和混淆矩阵EMIS。

hmmestimate — Calculates maximum likelihood estimates of transition and emission probabilities from a sequence of emissions and a known sequence of states通过一个输出序列和已知的状态序列,计算转移概率和输出概率的最大似然估计。

用法:[TRANS,EMIS] = hmmestimate(seq,states)hmmestimate(...,'Symbols',SYMBOLS)hmmestimate(...,'Statenames',STATENAMES)hmmestimate(...,'Pseudoemissions',PSEUDOE)hmmestimate(...,'Pseudotransitions',PSEUDOTR)示例:通过已知的输出序列和状态序列估计出转移状态和混淆矩阵。

[TRANS_EST, EMIS_EST] = hmmestimate(seq, states)TRANS_EST =0.8989 0.10110.0585 0.9415EMIS_EST =0.1721 0.1721 0.1749 0.1612 0.1803 0.13930.5836 0.0741 0.0804 0.0789 0.0726 0.1104hmmtrain —Calculates maximum likelihood estimates of transition and emission probabilities from a sequence of emissions.在知道输出序列,不知道状态转移序列,但是对转移矩阵和混淆矩阵有个初始猜测的情况下,可以使用hmmtrain估计转移状态和混淆矩阵,改函数可以选择使用BaumWelch或者Viterbi算法,通过迭代的方式进行估计,可以设置迭代次数Maxiterations和精度Tolerance。

用法:[ESTTR,ESTEMIT] = hmmtrain(seq,TRGUESS,EMITGUESS)hmmtrain(...,'Algorithm',algorithm)hmmtrain(...,'Symbols',SYMBOLS)hmmtrain(...,'Tolerance',tol)hmmtrain(...,'Maxiterations',maxiter)hmmtrain(...,'Verbose',true)hmmtrain(...,'Pseudoemissions',PSEUDOE)hmmtrain(...,'Pseudotransitions',PSEUDOTR)示例:TRANS_GUESS = [.85 .15; .1 .9];EMIS_GUESS = [.17 .16 .17 .16 .17 .17;.6 .08 .08 .08 .08 08];You estimate TRANS and EMIS as follows:[TRANS_EST2, EMIS_EST2] = hmmtrain(seq, TRANS_GUESS, EMIS_GUESS)TRANS_EST2 =0.2286 0.77140.0032 0.9968EMIS_EST2 =0.1436 0.2348 0.1837 0.1963 0.2350 0.00660.4355 0.1089 0.1144 0.1082 0.1109 0.1220hmmdecode — Calculates the posterior state probabilities of a sequence of emissions 用于估计后验状态概率。

对于一个输出序列seq的后验状态概率,是指这个模型在确定的状态下产生seq中一个符号的条件概率。

PSTATES = hmmdecode(seq,TRANS,EMIS)The output PSTATES is an M-by-L matrix, where M is the number of states and L is the length of seq. PSTATES(i,j) is the conditional probability that the model is in state i when it generates the jth symbol of seq, given that seq is emitted.PSTATES是一个M×L的矩阵,M是状态的个数,L是输出序列seq的长度。

PSTATES(i,j)是在状态i时,产生seq的第j个符号的条件概率。

细心的读者可能会发现,上面都没有使用到Markov模型的初始状态概率矩阵。