帧差法

帧间差分法运动目标检测过程及原理

帧间差分法运动目标检测过程及原理帧间差分法是一种常用的运动目标检测方法,依靠帧与帧之间的差异来实现对运动目标的检测。

其原理是通过计算相邻帧之间的差异,将运动目标从静态背景中分离出来,从而实现目标检测。

1. 获取视频流或者图像序列,并将其转换为灰度图像。

该过程可以使用OpenCV等图像处理库实现。

2. 按照时间顺序,每隔一定的时间间隔(例如,每秒钟、每隔几帧)取一帧图像,形成连续的图像序列(也可以直接读取视频流)。

如果采用的是视频流,还需将视频流的时间基准与实际时间对齐。

3. 对于每一帧图像,先将其与上一帧图像做差,得到当前帧的差分图像。

若没有前一帧图像,则将当前帧图像作为背景参考。

4. 对于差分图像,可以应用阈值分割算法(例如Otsu算法、自适应阈值法等)来将其二值化。

此时,目标物体所在的像素值区域将为前景,而背景则为另一种像素值。

5. 对于二值化后的图像,可以应用形态学处理(例如开操作、闭操作等)来去除噪声点和孔洞,从而更准确地提取目标轮廓。

6. 最后,可以利用cv2.findContours()函数查找目标的轮廓。

这些轮廓可以代表单个运动目标或者多个运动目标。

且可以通过测量轮廓的面积、宽度、高度、位置等属性,进一步对目标进行分类与识别。

总结起来,帧间差分法是一种基于视频或图像序列的运动目标检测方法,它的优点是实现简单、速度较快,且对于CMOS或CCD摄像头等图像采集设备不稳定、背景不纯,亮度不均等问题具有较好的适应性。

不足之处在于对于复杂的场景或目标缩放、旋转、部分遮挡等情况,其检测效果容易受到影响。

因此,在实际应用中,我们需根据具体情况选择不同的算法方法来实现更准确、可靠的目标检测。

【目标追踪】三帧差法原理及实现

【目标追踪】三帧差法原理及实现三帧差法原理及实现•(一)帧差法原理及实现:•(二)帧差法存在的问题:•(三)三帧差法的原理:•(四)三帧差法的实现代码:•(五)视频中的目标追踪效果:(一)帧差法原理及实现:这里可以看一下我的这篇博客,这里就不赘述了:【目标追踪】python帧差法原理及其实现(二)帧差法存在的问题:运动物体本身颜色相近时,会出现较大的空洞。

位置变化缓慢时,难以检测到目标。

对光线非常敏感。

(三)三帧差法的原理:三帧差法的关键是,不再仅仅采用相邻的两帧图片作差查找运动目标,而是在相邻三帧图片的两张帧差图中取“与”操作,即:(四)三帧差法的实现代码:(具体处理和代码解析还是推荐看一下我的上一篇博客:【目标追踪】python帧差法原理及其实现)代码:import cv2import numpy as npfrom nms import py_cpu_nmsfrom time import sleepclass Detector(object):def __init__(self, name='my_video', frame_num=10, k_size=7, color=(0, 255, 0)): = nameself.color = colorself.nms_threshold = 0.3self.time = 1/frame_num # 频率self.es = cv2.getStructuringElement(cv2.MORPH_ELLIPSE, (k_size, k_size))def catch_video(self, video_index=0, k_size=7,iterations=3, threshold=20, bias_num=1,min_area=360, show_test=True, nms=True,logical='or'):# video_index:摄像头索引(数字)或者视频路径(字符路径)# k_size:中值滤波的滤波器大小# iteration:腐蚀+膨胀的次数,0表示不进行腐蚀和膨胀操作# threshold:二值化阙值# bias_num:计算帧差图时的帧数差# min_area:目标的最小面积# show_test:是否显示二值化图片# nms:是否进行非极大值抑制# logical:三帧差取or或andlogical = logical.lower()if not bias_num > 0:raise Exception('bias_num must > 0')if isinstance(video_index, str):is_camera = False# 如果是视频,则需要调整帧率else:is_camera = Truecap = cv2.VideoCapture(video_index) # 创建摄像头识别类if not cap.isOpened():# 如果没有检测到摄像头,报错raise Exception('Check if the camera is on.')frame_num = 0previous = []while cap.isOpened():catch, frame = cap.read() # 读取每一帧图片if not catch:raise Exception('Unexpected Error.')if frame_num < bias_num:value = cv2.cvtColor(frame, cv2.COLOR_BGR2GRAY) previous = [value]*bias_numframe_num += 1raw = frame.copy()gray1 = cv2.cvtColor(frame, cv2.COLOR_BGR2GRAY)gray1 = cv2.absdiff(gray1, previous[0])gray1 = cv2.medianBlur(gray1, k_size)_, mask1 = cv2.threshold(gray1, threshold, 255, cv2.THRESH_BINARY)gray2 = cv2.cvtColor(frame, cv2.COLOR_BGR2GRAY)gray2 = cv2.absdiff(gray2, previous[1])gray2 = cv2.medianBlur(gray2, k_size)_, mask2 = cv2.threshold(gray2, threshold, 255, cv2.THRESH_BINARY)if logical == 'or':mask = (np.logical_or(mask1, mask2) + 0)elif logical == 'and':mask = (np.logical_and(mask1, mask2) + 0)else:raise Exception('Logical must be \'OR\' or \'AND\'')mask = (mask * 255).astype(np.uint8)mask = cv2.dilate(mask, self.es, iterations)mask = cv2.erode(mask, self.es, iterations)_, cnts, _ = cv2.findContours(mask.copy(), cv2.RETR_EXTERNAL, cv2.CHAIN_APPROX_SIMPLE)bounds = self.nms_cnts(cnts, mask, min_area, nms=nms)for b in bounds:x, y, w, h = bthickness = (w*h)//min_areathickness = thickness if thickness <= 3 else 3thickness = thickness if thickness >= 1 else 1cv2.rectangle(frame, (x, y), (x+w, y+h), self.color, thickness) if not is_camera:sleep(self.time)cv2.imshow(, frame) # 在window上显示图片if show_test:cv2.imshow(+'_frame', mask) # 边界value = cv2.cvtColor(raw, cv2.COLOR_BGR2GRAY)previous = self.pop(previous, value)cv2.waitKey(10)if cv2.getWindowProperty(, cv2.WND_PROP_AUTOSIZE) < 1:# 点x退出breakif show_test and cv2.getWindowProperty(+'_frame', cv2.WND_PROP_AUTOSIZE) < 1:# 点x退出break# 释放摄像头cap.release()cv2.destroyAllWindows()def nms_cnts(self, cnts, mask, min_area, nms=True):# 对检测到的边界框使用非极大值抑制bounds = [cv2.boundingRect(c) for c in cnts if cv2.contourArea(c) > min_area]if len(bounds) == 0:return []if not nms:return boundsscores = [self.calculate(b, mask) for b in bounds]bounds = np.array(bounds)scores = np.expand_dims(np.array(scores), axis=-1)keep = py_cpu_nms(np.hstack([bounds, scores]), self.nms_threshold)return bounds[keep]def calculate(self, bound, mask):x, y, w, h = boundarea = mask[y:y+h, x:x+w]pos = area > 0pos = pos.astype(np.float)# 得分应与检测框大小也有关系score = np.sum(pos)/(w*h)return scoredef pop(self, l, value):l.pop(0)l.append(value)return lif __name__ == "__main__":detector = Detector(name='test')detector.catch_video('./test.avi', bias_num=2, iterations=1,k_size=5, show_test=True, min_area=360, nms=False) (五)视频中的目标追踪效果:。

opencv 帧差法 抖动

opencv 帧差法抖动## OpenCV Frame Differencing and Jittering.Frame differencing is a technique used in computer vision to detect changes in a sequence of images. It involves computing the absolute difference between two consecutive frames and thresholding the result to identify significant changes. This technique is often used for motion detection, object tracking, and other applications that require detecting changes in a video stream.However, frame differencing can sometimes produce noisy or jittery results, especially when the camera is moving or the scene contains moving objects. This is because thepixel values in the difference image can be affected by noise, motion blur, and other factors.To reduce jitter in frame differencing, several techniques can be used:1. Smoothing: Applying a Gaussian blur or other smoothing filter to the input frames before computing the difference can help reduce noise and jitter.2. Median filtering: Median filtering is a non-linear filtering technique that can effectively remove isolated noise pixels while preserving edges. Applying a medianfilter to the difference image can help reduce jitter caused by noise.3. Morphological operations: Morphological operations such as erosion and dilation can be used to remove small noise regions and fill in gaps in the difference image. This can help reduce jitter caused by motion blur.4. Temporal filtering: Temporal filtering techniques such as Kalman filtering or particle filtering can be used to smooth out the difference image over time. This can help reduce jitter caused by camera motion or moving objects.Here is an example of how to reduce jitter in frame differencing using OpenCV in Python:python.import cv2。

帧间差分法车速测算技术误差分析与处理

帧间差分法车速测算技术误差分析与处理帧间差分法是一种常用的车速测算技术,通过分析连续图像帧之间的差异来计算物体的移动速度。

然而,在实际应用中,帧间差分法存在一定的误差,因此需要进行误差分析和处理。

下面将对帧间差分技术误差进行详细分析,并提出相应的处理方法。

1.图像质量误差:图像质量是影响帧间差分法准确性的重要因素。

图像质量越高,帧间差分法测算车速的准确性越高。

但是,由于图像采集设备的限制、光照条件等原因,图像质量可能存在误差。

解决这个问题的一种方法是增加图像源数量,通过对多个图像帧进行差分来减小误差。

2.物体形变误差:当物体处于高速移动状态时,图像中的物体会发生形变。

这种形变引入了帧间差分法的误差。

为了减小形变误差,可以采用自适应帧间差分算法。

该算法可以根据物体移动速度,自适应地选择合适的帧差分间隔,从而减小形变误差。

3.背景干扰误差:背景干扰是另一个影响帧间差分法准确性的因素。

当背景中存在其他移动物体或噪声时,帧间差分法可能将这些干扰物体识别为目标物体,从而引入误差。

为了减小背景干扰误差,可以采用背景建模算法。

该算法可以通过对目标物体的动态背景进行建模和分析,从而减小干扰的影响。

4.噪声误差:图像采集过程中可能存在噪声,导致帧间差分法的误差增加。

为了减小噪声误差,可以采用图像滤波技术。

滤波技术可以对图像进行平滑处理,减小噪声的干扰,从而提高帧间差分法的准确性。

5.目标物体模糊误差:当目标物体处于快速移动状态时,图像中的目标物体可能出现模糊。

这种模糊会增加帧间差分法的误差。

为了减小模糊误差,可以采用图像去模糊技术。

该技术可以通过提取图像中的目标物体特征,并对其进行模糊处理,从而消除模糊误差。

综上所述,帧间差分法车速测算技术存在多种误差,并且每种误差都可以采用不同的处理方法来减小。

通过综合运用图像滤波、背景建模、自适应帧间差分等技术,可以有效降低误差,提高帧间差分法的准确性和可靠性。

帧间差分法运动目标检测过程及原理

帧间差分法运动目标检测过程及原理帧间差分法是一种广泛应用于视频图像处理中的运动目标检测方法。

在该方法中,通过同一场景下不同帧间像素值的变化来判断是否有物体运动的情况发生。

本文将具体介绍帧间差分法运动目标检测的过程和原理。

一、图像预处理帧间差分法首先需要将视频帧进行预处理,包括去除噪声和灰度化两个步骤。

1.去噪处理。

由于采集设备和信号传输等原因,视频帧中可能会出现一些毛刺、线条等噪声。

将这些噪声去除后,可以更好地提取物体的运动信息。

去噪的方法包括高斯滤波、中值滤波等,其中高斯滤波是一种广泛应用的方法。

2.灰度化。

将视频帧转化为灰度图像,可以简化像素值的处理过程,降低计算机资源的消耗。

灰度化的方法包括平均值法、最大值法、加权平均法等。

二、运动物体检测经过预处理后,图像中会出现明暗程度发生变化的区域,这些区域即为可能存在运动物体的区域。

帧间差分法通过计算两帧图像之间的差值来检测这些运动物体。

1.差值计算。

将预处理后的两帧图像进行逐像素比较,计算出两帧图像中每个像素的灰度值差。

如果该像素灰度值差超过了设定的阈值,则判断该像素处存在运动物体。

2.二值化处理。

将差值图像进行二值化处理,将灰度值超过设定阈值的像素点设为1,其他像素点设为0。

经过二值化处理后,得到了一个二值图像,其中的白色像素标记了可能存在运动物体的位置。

3.运动物体判定。

通过对二值图像进行连通区域分析,将那些像素点数量超过一定阈值的连通区域判定为运动物体。

通过此方法,可以将可能存在的多个运动目标分离,并得到它们的位置、大小等信息。

三、总结帧间差分法是一种简单而有效的运动目标检测方法,具有实时性和可适应性等优势。

但也存在一些缺点,比如对于光照变化、背景复杂等情况的适应度较差。

因此,在实际应用中需要根据具体情况选择合适的方法,并进行必要的优化和改进。

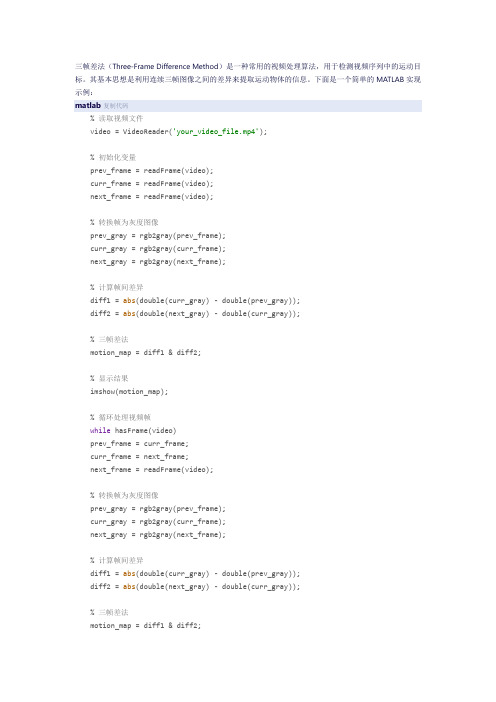

三帧差法 matlab

三帧差法(Three-Frame Difference Method)是一种常用的视频处理算法,用于检测视频序列中的运动目标。

其基本思想是利用连续三帧图像之间的差异来提取运动物体的信息。

下面是一个简单的MATLAB实现示例:matlab复制代码% 读取视频文件video = VideoReader('your_video_file.mp4');% 初始化变量prev_frame = readFrame(video);curr_frame = readFrame(video);next_frame = readFrame(video);% 转换帧为灰度图像prev_gray = rgb2gray(prev_frame);curr_gray = rgb2gray(curr_frame);next_gray = rgb2gray(next_frame);% 计算帧间差异diff1 = abs(double(curr_gray) - double(prev_gray));diff2 = abs(double(next_gray) - double(curr_gray));% 三帧差法motion_map = diff1 & diff2;% 显示结果imshow(motion_map);% 循环处理视频帧while hasFrame(video)prev_frame = curr_frame;curr_frame = next_frame;next_frame = readFrame(video);% 转换帧为灰度图像prev_gray = rgb2gray(prev_frame);curr_gray = rgb2gray(curr_frame);next_gray = rgb2gray(next_frame);% 计算帧间差异diff1 = abs(double(curr_gray) - double(prev_gray));diff2 = abs(double(next_gray) - double(curr_gray));% 三帧差法motion_map = diff1 & diff2;% 显示结果imshow(motion_map);% 暂停以便观察结果pause(0.01);end% 释放视频文件release(video);在这个示例中,我们首先使用VideoReader对象读取视频文件,并将连续的三帧转换为灰度图像。

帧间差分法运动目标检测过程及原理

帧间差分法运动目标检测过程及原理帧间差分法是一种运动目标检测方法,基于视频帧间像素差异性和连续性的特点。

帧间差分法可以通过对比相邻帧像素的差异值来检测运动目标。

这种方法通常被用于视频监控、安防和视频分析领域。

帧间差分法的工作原理是基于两个假设,第一是背景在相邻帧之间变化很小,第二是运动物体在相邻帧之间变化明显。

基于这两个假设,我们可以使用帧间像素差分来检测运动目标。

帧间差分法的基本思路是将当前帧和之前的帧进行像素比较,以确定每个像素点之间的差值。

如果像素值之间的差异超过一定的阈值,就将该像素点标记为前景物体,否则将其视为背景。

例如,如果我们将当前帧和前一个帧进行比较,如果像素的差异在阈值范围内,那么像素被视为不变。

如果像素的差异超过阈值,那么像素就会被视为运动目标。

因此,我们可以将这些运动目标像素标记为前景物体,形成一个二值图像。

可以通过对前景像素进行计数、分析、过滤和跟踪来检测运动物体。

帧间差分法的实现可以通过以下步骤来完成:1. 读取视频帧序列首先,需要从视频中获得连续的帧序列。

可以使用OpenCV的VideoCapture库读取视频文件或从实时视频流中获取帧。

2. 前后帧差分使用前面序列的帧与当前帧的像素值做差,即用当前帧减去前一帧。

此时,差异较大的部分就是前景物体。

3. 阈值处理对于运动目标和背景的差异会受到噪声和照明变化等多种因素影响,因此需要进行阈值处理,以区分背景和前景像素。

阈值处理可以根据帧间像素差异的特点和实际情况进行调整。

4. 前景目标检测将阈值处理后的二值图像形成前景掩模,标记出运动目标的位置。

5. 目标跟踪通过对前景内像素的计数、分析和过滤等方法,对运动目标的大小、形状、位置等信息进行跟踪。

帧间差分法的优点在于简单易懂,适用于实时视频处理。

但是,该方法依赖于阈值处理的参数和初始帧的选择,因此在复杂场景下会存在误检和漏检的情况。

针对这些问题,可以通过结合其他技术,如背景建模、光流法等来提高检测精度和鲁棒性。

帧间差分法运动目标检测过程及原理

帧间差分法运动目标检测过程及原理帧间差分法运动目标检测,是一种常用的视频目标检测方法。

它通过比较视频序列中相邻帧之间的差异,来识别出视频中的运动目标。

这种方法具有简单、快速、实时性强的特点,因此在视频监控、智能交通、安防监控等领域得到了广泛的应用。

下面将介绍帧间差分法运动目标检测的原理和实现过程。

一、原理帧间差分法的原理是通过比较视频序列中相邻帧的像素值差异来识别出视频中的运动目标。

一般来说,视频中的运动目标在相邻帧之间会引起像素值的变化,而静止的背景则保持相对稳定的像素值。

我们可以通过计算相邻帧之间的像素值差异来找出视频中的运动目标。

具体来说,对于视频序列中的每一帧图片,我们可以将其表示为一个像素矩阵。

假设当前帧为I(x, y, t),而前一帧为I(x, y, t-1),那么我们可以通过以下公式计算出两帧之间的像素差异:D(x, y, t) = |I(x, y, t) - I(x, y, t-1)|D(x, y, t)表示像素点(x, y)在时间t上的差分值。

通过计算所有像素点的差分值,我们就可以得到一张差分图像。

在这张差分图像中,像素值较大的地方表示有较大的像素差异,而像素值较小的地方则表示像素差异较小。

通过阈值处理和连通域分析,我们就可以找出视频中的运动目标。

二、实现过程帧间差分法运动目标检测的实现过程可以分为以下几个步骤:1. 读取视频我们需要从视频文件中读取视频序列,并将每一帧的图片进行提取,以便后续的处理。

2. 计算帧间差分对于视频序列中的每一帧图片,我们需要计算其与前一帧之间的差分图像。

这可以通过上文提到的差分公式来实现。

3. 阈值处理得到差分图像之后,我们可以对其进行阈值处理。

通过设定一个合适的阈值,将差分图像中较大的像素差异点标记为前景点,而将较小的像素差异点标记为背景点。

4. 连通域分析通过连通域分析,我们可以将前景点连接成一个个连通区域,从而得到视频中的运动目标。

5. 目标跟踪我们还可以对检测出的运动目标进行跟踪,以便进行后续的分析和处理。

帧差法原理

帧差法原理帧差法是一种常用的视频图像处理算法,它通过比较相邻帧之间的像素变化来检测视频中的运动物体。

该算法广泛应用于视频监控、智能交通、动态目标追踪等领域。

下面我们将详细介绍帧差法的原理和实现过程。

一、帧差法原理帧差法是一种以运动物体像素变化为基础,通过像素点连续性つ计算出目标位置和大小的一种方法。

它的基本原理是利用相邻帧之间的差异信息计算出图像中的运动物体,并对其进行分析和处理。

帧差法的基本步骤如下:1. 提取视频帧首先需要从视频中提取帧数据,这一过程称为视频帧提取。

2. 帧间差分利用相邻帧像素信息的差异计算出差分图像,常见的通过前一帧和当前帧的信息计算出它们之间的像素差异,得到的差分图像可以表示为:d(x, y, t) = |I(x, y, t)-I(x, y, t-1)|其中,d表示差分图像,x,y表示像素坐标,t表示帧序号,I表示图像。

显然,通过差分图像我们可以得到相邻帧之间存在的运动物体像素变化。

3. 去除噪声由于摄像头噪声,运动物体遮挡、变形等因素的干扰,我们需要对差分图像进行处理,去除噪声。

这可以通过一些滤波算法来完成,例如中值滤波、高斯滤波等。

4. 运动物体检测差分图像中的像素变化可以看作是运动物体的轮廓线,我们需要进一步将这些轮廓线进行分析,得到运动目标的位置和大小。

这可以通过一些形态学分析算法来完成,例如连通域分析、形态学操作等。

二、帧差法实现Python是一个很好的图像处理语言,它有着丰富的图像处理库及工具,如OpenCV、Matplotlib等。

下面我们将以Python为例,简单介绍帧差法的实现过程。

1. 导入库首先需要导入Python图像处理库OpenCV的相关工具。

OpenCV是一个广泛使用的图像处理库,它提供了各种图像处理函数和算法的实现工具。

import cv22. 视频帧提取在视频帧提取的过程中,我们需要指定视频文件,然后从中提取帧数据。

cap = cv2.VideoCapture(0)while True:ret, frame = cap.read()cv2.imshow('frame', frame)if cv2.waitKey(1) & 0xFF == ord('q'):breakcap.release()cv2.destroyAllWindows()这里我们使用VideoCapture函数打开摄像头,循环读取摄像头的每一帧数据,并使用imshow函数将帧数据显示在窗口中,当按下q键时退出循环。

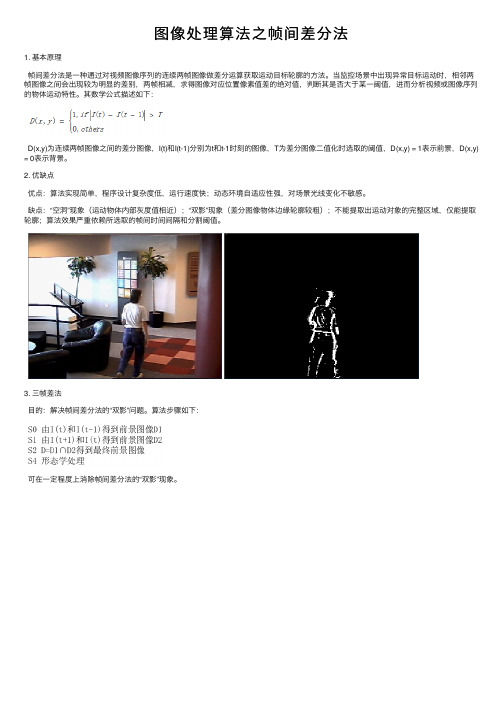

图像处理算法之帧间差分法

图像处理算法之帧间差分法

1. 基本原理

帧间差分法是⼀种通过对视频图像序列的连续两帧图像做差分运算获取运动⽬标轮廓的⽅法。

当监控场景中出现异常⽬标运动时,相邻两帧图像之间会出现较为明显的差别,两帧相减,求得图像对应位置像素值差的绝对值,判断其是否⼤于某⼀阈值,进⽽分析视频或图像序列的物体运动特性。

其数学公式描述如下:

D(x,y)为连续两帧图像之间的差分图像,I(t)和I(t-1)分别为t 和t-1时刻的图像,T 为差分图像⼆值化时选取的阈值,D(x,y) = 1表⽰前景,D(x,y)= 0表⽰背景。

2. 优缺点

优点:算法实现简单,程序设计复杂度低,运⾏速度快;动态环境⾃适应性强,对场景光线变化不敏感。

缺点:“空洞”现象(运动物体内部灰度值相近);“双影”现象(差分图像物体边缘轮廓较粗);不能提取出运动对象的完整区域,仅能提取轮廓;算法效果严重依赖所选取的帧间时间间隔和分割阈值。

3. 三帧差法

⽬的:解决帧间差分法的“双影”问题。

算法步骤如下:

可在⼀定程度上消除帧间差分法的“双影”现象。

帧间差分法运动目标检测过程及原理

帧间差分法运动目标检测过程及原理帧间差分法是一种基于视频图像的运动目标检测的方法,其原理是通过比较相邻帧之间的像素差异来检测出移动的目标。

具体来说,该方法将视频帧按照时间顺序排列,对相邻两帧进行像素差分操作,即将当前帧的像素值减去上一帧的像素值,得到差分图像。

然后,利用阈值二值化处理差分图像,得到二值化图像。

最后,对二值化图像进行连通区域分析或运动目标跟踪,即可得到视频中的运动目标。

帧间差分法的优势在于其实现简单,适用于高速移动的目标以及背景复杂的场景。

但是,由于此方法仅考虑相邻帧之间的差异,可能会受到噪声等因素的干扰而产生误检。

帧间差分法的主要步骤如下:1. 读取视频帧序列。

将视频帧序列从磁盘或存储设备中读取到内存中。

2. 帧间差分处理。

将相邻两帧进行像素差分操作,得到差分图像。

3. 阈值处理。

对差分图像进行阈值二值化处理,得到二值化图像。

4. 对二值化图像进行连通区域分析,得到目标区域。

5. 运动目标跟踪。

对目标区域进行运动目标跟踪并更新目标位置。

帧间差分法的原理是基于运动物体在连续帧中像素值的变化。

例如,在一张静止的背景中,运动目标的像素值会有明显的变化。

因此,通过比较相邻帧之间的像素值的差异大小,可以检测到运动目标的存在。

帧间差分法的实现基于以下公式:D(x,y,t)=|I(x,y,t)-I(x,y,t-1)|其中,D(x,y,t)表示第t帧与第t-1帧的像素差分图像;I(x,y,t)表示第t帧的灰度值。

当像素值的差异超过设定的阈值时,就将差异分为前景像素;否则,差异可认为是噪声或背景变化,将其分为背景像素。

经过阈值处理和二值化处理得到的二值化图像即为前景像素。

总之,帧间差分法是一种简单且有效的运动目标检测方法,但其存在着一定的局限性和误差。

需要根据实际应用场景和要求选择合适的方法。

帧间差分法运动目标检测过程及原理

帧间差分法运动目标检测过程及原理帧间差分法是一种常用的运动目标检测方法,其原理是通过比较连续视频帧之间的差异来识别出运动的目标。

帧间差分法的具体步骤如下:1. 彩色图像转为灰度图像:将连续的彩色图像转换为灰度图像,这样可以减少计算量,并保留图像中的大部分运动信息。

2. 选择参考帧:从视频流中选择一个帧作为参考帧。

3. 计算差分图像:将参考帧与其后的每一帧进行差分操作,得到差分图像。

差分图像的每个像素点表示了相邻两帧之间的像素差异。

4. 二值化处理:将差分图像进行二值化处理,得到二值化差分图像。

可以采用简单的阈值分割方法,将差分图像中像素值大于某个阈值的点标记为前景点,即表示运动目标。

5. 形态学处理:对二值化差分图像进行形态学处理,可以进一步去除噪声和连通不完整的运动目标。

常用的形态学处理操作包括膨胀、腐蚀等。

6. 特征提取与轨迹跟踪:对得到的运动目标进行轮廓提取、面积计算等操作,可以提取出一些目标的特征信息。

通过对多个连续帧之间运动目标的匹配及轨迹跟踪,可以实现目标的检测和跟踪。

帧间差分法的原理基于连续视频帧之间的像素变化,通过计算相邻帧之间的灰度差异,可以得到物体的运动信息。

当物体发生运动时,相邻帧之间的灰度值会发生较大的变化,而静止物体的灰度值变化较小。

通过对差分图像进行二值化处理,可以将运动目标从背景中分离出来。

帧间差分法的优点是实现简单、计算速度快,适用于实时视频监控和目标跟踪等应用。

但同时也存在一些局限性,比如对光照变化敏感、对背景杂乱的环境容易产生误检和误识别等问题。

帧差法原理

帧差法原理帧差法是一种常用的视频运动目标检测方法,它通过比较视频序列中相邻帧之间的差异来实现目标的检测和跟踪。

在实际应用中,帧差法被广泛应用于视频监控、智能交通系统、人脸识别等领域。

本文将介绍帧差法的原理及其在目标检测中的应用。

帧差法的原理是基于视频序列中相邻帧之间的像素差异来实现目标的检测。

在视频中,目标的运动会导致相邻帧之间的像素值发生变化,通过比较这些变化,可以实现目标的检测。

帧差法的实现过程包括以下几个步骤:首先,将视频序列分解为一系列的帧,然后对相邻帧进行像素级的比较。

通常情况下,可以选择两帧之间的差值作为像素差异的度量。

如果像素差异超过设定的阈值,就可以认为目标在该位置发生了运动。

其次,根据像素差异的位置和大小,可以确定目标的位置和运动方向。

通过对像素差异进行连通域分析,可以得到目标的位置信息,从而实现目标的检测和跟踪。

最后,可以根据目标的位置信息对视频序列进行目标标记或者跟踪。

通过在视频序列中标记目标的位置,可以实现对目标的实时监控和跟踪。

帧差法在目标检测中具有较高的实时性和准确性,因此被广泛应用于视频监控、智能交通系统、人脸识别等领域。

在视频监控领域,帧差法可以实现对目标的实时检测和跟踪,从而提高监控系统的效率和准确性。

在智能交通系统中,帧差法可以实现对车辆和行人的检测,从而提高交通管理的效率和安全性。

在人脸识别领域,帧差法可以实现对人脸的检测和识别,从而应用于安防监控和身份识别等场景。

总之,帧差法作为一种常用的视频运动目标检测方法,具有较高的实时性和准确性,被广泛应用于视频监控、智能交通系统、人脸识别等领域。

通过对视频序列中相邻帧之间的像素差异进行比较,可以实现对目标的检测和跟踪,从而提高系统的效率和准确性。

希望本文对帧差法的原理及其在目标检测中的应用有所帮助。

帧差法实验报告

一、实验目的1. 了解帧差法的基本原理和实现方法;2. 掌握帧差法在视频移动物体识别中的应用;3. 通过实验验证帧差法的有效性,并分析其优缺点。

二、实验原理帧差法是一种视频移动物体识别的方法,其核心思想是利用连续两帧之间的像素差异来检测移动对象。

具体步骤如下:1. 读取视频文件;2. 创建背景减除器,对每一帧进行背景减除;3. 对背景减除后的前景进行形态学开运算,去除噪点;4. 查找前景掩码中的轮廓,筛选出移动对象;5. 在原始帧上绘制边界矩形,标记出移动对象。

三、实验环境1. 操作系统:Windows 102. 编程语言:Python3. 库:OpenCV四、实验步骤1. 导入所需的库和函数;2. 创建视频捕捉对象,读取视频文件;3. 创建背景减除器,使用OpenCV中的MOG2方法;4. 循环读取视频帧,对每一帧进行以下操作:a. 应用背景减除器,得到前景掩码;b. 对前景掩码进行形态学开运算,去除噪点;c. 在处理后的掩码中查找轮廓;d. 对每个轮廓计算周长,筛选出移动对象;e. 在原始帧上绘制边界矩形,标记出移动对象;5. 按下ESC键退出循环。

五、实验结果与分析1. 实验结果展示通过实验,我们得到了一系列标记了移动对象的视频帧。

以下是实验结果的一部分截图:(此处插入实验结果截图)2. 实验结果分析(1)帧差法的优点:a. 简单高效:帧差法原理简单,易于实现;b. 实时性能好:帧差法对实时性要求较高,适合应用于动态场景;c. 无需背景模型:帧差法不依赖于背景模型,对背景变化不敏感;d. 适应性强:帧差法对光照、颜色等条件要求不高,适应性强;e. 易于调整阈值:帧差法的阈值可以根据实际情况进行调整。

(2)帧差法的缺点:a. 对光照敏感:在光照变化较大的场景下,帧差法的效果可能受到影响;b. 阴影问题:阴影可能会被误判为移动对象;c. 对背景变化和摄像头抖动敏感:背景变化和摄像头抖动会影响帧差法的效果;d. 难以区分动态背景:动态背景可能会被误判为移动对象;e. 颜色相似物体的识别问题:颜色相似的物体可能会被误判;f. 快速移动对象的漏检:快速移动的对象可能无法被检测到;g. 遮挡问题:被遮挡的物体无法被检测到;h. 噪声敏感:噪声可能会影响帧差法的效果。

前景检测算法_2(帧差法1)

前景检测算法_2(帧差法1) 帧差法是背景减图法中的⼀种,只不过是帧差法不需要建模,因为它的背景模型就是上⼀帧的图,所以速度⾮常快,另外帧差法对缓慢变换的光照不是很敏感,所以其⽤途还是有的,有不少学者对其做出了出⾊的改进。

其基本原理可以⽤下⾯公式看出: |i(t)-i(t-1)|<T 背景 |i(t)-i(t-1)|>=T 前景 其中i(t),i(t-1)分别为t,t-1时刻对应像素点的像素值,T为阈值。

当然其缺点也不少,容易出现”双影”和”空洞”现象。

⽤opencv2.3.1+vs2010做了个简单的实验,其实验代码如下:1// frame_diff.cpp : 定义控制台应⽤程序的⼊⼝点。

2//34 #include "stdafx.h"5 #include <opencv2/highgui/highgui.hpp>6 #include <opencv2/imgproc/imgproc.hpp>7 #include <opencv2/core/core.hpp>89#define threshold_diff 20 //设置简单帧差法阈值1011using namespace cv;12using namespace std;1314int main(int argc,unsigned char* argv[])15 {16 Mat img_src1,img_src2,img_dst,gray1,gray2,gray_diff;17bool pause=false;1819 VideoCapture vido_file("IndoorGTTest1.avi");//在这⾥改相应的⽂件名20 namedWindow("foreground",0);21for (;;)22 {23if(!pause)24 {25 vido_file >>img_src1; //因为视频⽂件帧数已经固定了,所以每次到这句语句都是读取相邻的帧数,没到时间视频并不向前⾛26 cvtColor(img_src1,gray1,CV_BGR2GRAY);27 imshow("video_src",img_src1);//可以事先不⽤新建⼀个窗⼝28 waitKey(5);2930 vido_file >>img_src2;31 cvtColor(img_src2,gray2,CV_BGR2GRAY);32 imshow("video_src",img_src2);//可以事先不⽤新建⼀个窗⼝3334 waitKey(5);35 subtract(gray1,gray2,gray_diff);36for(int i=0;i<gray_diff.rows;i++)37for(int j=0;j<gray_diff.cols;j++)38if(abs(gray_diff.at<unsigned char>(i,j))>=threshold_diff)//这⾥模板参数⼀定要⽤unsigned char,否则就⼀直报错39 gray_diff.at<unsigned char>(i,j)=255;40else gray_diff.at<unsigned char>(i,j)=0;4142 imshow("foreground",gray_diff);43 }44char c=(char)waitKey(10);45if (c==27)46 {47break;48 }49if(c=='')50 pause=!pause;51 }52return0;53 } 实验结果如下: 可以看出其“双影”和”空洞”⽐较明显。

帧间差分法运动目标检测过程及原理

帧间差分法运动目标检测过程及原理帧间差分法是一种常用的视频运动目标检测方法,其原理是通过比较连续两帧图像之间的差异来判断图像中的运动目标。

以下是帧间差分法的运动目标检测过程及原理的详细介绍:1. 获取连续帧图像:首先需要获取前后两帧的视频图像,这两帧图像应该是时间上连续的。

2. 图像灰度化:将获取到的图像进行灰度化处理,将彩色图像转化为灰度图像,此步骤的目的是简化图像处理的计算量。

3. 计算图像差异:比较前后两帧图像的差异,可以使用以下公式计算每个像素的差异:差异 = abs(I1(x, y) - I2(x, y))I1表示前一帧的图像,I2表示后一帧的图像,(x, y)表示像素的坐标。

4. 提取运动目标:根据计算得到的图像差异,可以设置一个阈值(比如差异大于某个阈值的像素点认为是运动目标),将差异大于阈值的像素点提取出来,形成运动目标区域。

5. 运动目标跟踪:对于提取出的运动目标区域,可以根据需要进行进一步的处理,例如检测运动目标的位置、大小、运动轨迹等。

6. 更新帧图像:将当前的图像帧作为前一帧,继续进行后续帧间差分,实现连续的目标检测和跟踪。

帧间差分法的原理是基于连续图像帧之间的变化,当有运动目标出现时,前后两帧图像中相应位置的像素值会发生明显的变化。

通过比较像素点的差异,可以较好地检测出这些运动目标。

这种方法的优势在于简单、实时性较高,适合于动态目标较为明显的场景。

帧间差分法容易受到光照变化、摄像机抖动等因素的影响,可能会导致误检测或漏检测的情况出现。

为了提高准确性,可以结合其他的图像处理方法,例如背景建模等,以进一步优化运动目标检测的效果。

帧差法目标识别

本文展示了一种自动识别视频中移动目标的方法。

论文中提取移动目标通过帧序列,这种方法不需要先验知识,比如:时间阈值调整。

基于相邻帧的连续对称差分,我们能得到全分辨率显著图;然后利用最大熵方法计算阈值决定候选区域和获得兴趣点的种子;最后用修改的模糊生长方法获得最终的结果。

本文中提出的算法是有效的、具有鲁棒性的。

实验结果也证明它具有很好的效果。

移动目标检测在计算机视觉中有广泛应用,但是在研究过程中也有很多挑战。

通常目标检测方法被分为三类:(1)基于时间信息。

例如:帧差法能很快检测出目标,但很难得到整个物体的轮廓,并且易受背景的影响。

(2)基于空间信息的。

(3)基于时间和空间信息的。

有较好的效果,计算复杂度高。

本文提出了一种基于时间信息的方法。

(1)通过相邻帧对称差分获得显著图;(2)使用最大熵模型得到一个阈值去二值化时间显著图和获得候选区域。

然后选择候选区域最显著的点作为兴趣种子点。

(3)对于每一兴趣种子点,在显著图上应用模糊生长方法直到没有点能被聚集和能获得移动物体的轮廓A.移动显著图的产生①获得一段连续帧②相邻帧做差分得到移动目标。

③对得到的差分显著图做开运算。

作用:消除小的和亮的细节。

④为了去除噪声和背景运动的影响,对差分得到的显著图做和再平均。

B.兴趣种子选择由于图像是连续变化的,一个固定的阈值不能很好的二值化显著图,本文采用最大熵方法得到一个变化的阈值去二值化显著图和提取候选兴趣区域。

然后选择兴趣种子点。

C.移动目标检测为了提取移动的目标,本论文应用模糊生长方法去使兴趣点的种子生长成一片区域。

如果像素值满足下列条件,对兴趣点的种子使用模糊生长算法。

a和u表示如下图实验数据集:PETS2000, PETS2001 and Dataset2014设备:The algorithm is implemented with C++ on a personal computer with Core i3 3.3 GHz CPU and 2G RAM.评价标准:假负率(False Negative Rate , FNR) :FNR = FN /(TP + FN) ,即被预测为负的正样本结果数/正样本实际数假正率(False Positive Rate , FPR) :FPR = FP /(FP + TN) ,即被预测为正的负样本结果数/负样本实际数Specificity (负例的覆盖率,True Negative Rate) =正确预测到的负例个数/实际负例总数PBC :Percentage of Bad Classifications召回率(Re、recall):预测为真实正例除以所有真实正例样本的个数准确率(Precision) :预测为真实正例除以所有被预测为正例样本的个数F-measure:查准率和查全率的调和平均值, 更接近于P, R两个数较小的那个: F=2* P* R/(P + R)实验结果如下图表一表示的是本论文实验得出的结果;Fig7和Fig8本文的实验结果与图中方法的比较,可以看出本文中的方法表现很出色。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

帧差法近些年来, 世界各地的学者们针对视频图像中的运动目标检测与跟踪问题做了大量而深入的研究, 提出了很多极其有效的算法难点主要在于视频序列中有各种不同的干扰因素, 这些因素主要包括: 光线明暗的变化、成像传感器本身的固有噪声、运动目标自身的形变或位移变化、背景中的杂波、运动目标的互相遮挡或者自遮挡等, 这些问题还有待于做进一步的研究。

目前, 常用的运动目标检侧方法有: 光流法、背景差分法和帧间差分法。

1.光流法光流法能够检测出运动目标较完整的运动信息, 不需要预先知道场景的任何信息, 能够较好的处理运动背景的情况, 并且可以用于摄像机运动的情况, 适用于帧间位移较大的情况。

但是由于透明性、阴影、多光源、遮挡和噪声等原因,利用光流法进行运动物体检测时, 计算量很大, 无法保证实时性和实用性, 故难以应用到实时系统, 同时对噪声比较敏感, 计算结果精度较低, 难以得到运动目标的精确边界。

2 .背景差分法操作简单, 能够提供完全的特征数据, 但对目标的检测能力较低, 尤其对天气、光照等噪声的影响极其敏感,3T 为预先设定的阈值, 可根据经验选取T , 若选取过大, 则检测的目标则可能出现较大的空洞甚至漏检, 若T 选取过小, 将出现大量噪声。

由于帧间差分法的不足, 就有学者提出了三帧差法, 三帧差法充分考虑了动像素的时间相关性, 对动态检测比较灵敏, 对随机噪声也有很好的抑制作用,但也存在一定缺陷, 即差分图像的检测阈值需手动设定, 大多数情况下只能依据实践经验。

三帧差分法的关键是选取合适的阈值对图像进行二值化。

运动目标自动跟踪是指对目标进行连续的检测并确定其运动轨迹[1].在视频监控领域中,目标智能识别与自动跟踪系统是近几年来的研究重点.在军事、国防和工业等领域有着广泛的应用前景.当前运动目标的检测方法主要有3类:光流法[2]、帧间差分法[3]和背景差分法[4].背景差分法具有简单、运算速度快等诸多优点,使得该法作为运动目标检测的基本方法被普遍采用.但该法暴露出若干问题:一种是因外部条件引起的,如对光线的变化、噪声等造成差分图像检测精度不高,甚至失效;另一种是由差分图像法本身内在局限引起的,主要有空洞[5]、拖影,以及运动目标被拉长等现象.光流法[6]虽然能够适用于静态背景和动态背景两种环境,有较好的适应性,但是其计算复杂度高,运算时间开销很大,不能满足实时性的要求.帧差法[7]比较简单,实时性高,它主要包括减背景方法和相邻帧相减法,即三帧差分法.减背景方法存在背景获取困难、受光照影响严重且更新困难等问题.三帧差分法受光照和阴影影响较小.笔者对三帧差分法进行改进,提出了一种简单有效的运动目标检测方法.1 运动目标实时跟踪系统1. 1 帧差法的基本原理帧间差分法的基本原理就是将前后两帧图像对应像素点的灰度值相减,在环境亮度变化不大的情况下,如果对应像素灰度相差很小,可以认为此处物是静止的;如果图像区域某处的灰度变化很大,可以认为这是由于图像中运动物体引起的,将这些区域标记下来,利用这些标记的像素区域,就可以求出运动目标在图像中的位置.一般采用的帧差法是在连续的图像序列[8]中2个或3个相邻帧间采用基于像素的时间差分并且阈值化来提取图像的运动区域.该运动目标实时跟踪系统是采用三帧差分来进行运动目标检测,这种方法不仅能提高运动目标检测[9]的速度,而且提高了所检测运动目标图像的完整性.均值滤波均值滤波是典型的线性滤波算法,它是指在图像上对目标像素给一个模板,该模板包括了其周围的临近像素(以目标象素为中心的周围8个像素,构成一个滤波模板,即去掉目标像素本身),再用模板中的全体像素的平均值来代替原来像素值。

不足之处:均值滤波本身存在着固有的缺陷,即它不能很好地保护图像细节,在图像去噪的同时也破坏了图像的细节部分,从而使图像变得模糊,不能很好地去除噪声点。

均值滤波原来是不做图像处理这块的,所以对这里的专用名字不是特别感冒,滤波器听来玄而又玄。

真正拿来看了之后就不过尔尔了,这把拿了一个均值滤波器的例子来做记录,希望可以依次把一些median filter, gaussian blur都拿来说说。

好吧言归正传,这里就具体说说均值滤波器是什么东西吧。

其实这个东西就是在图像处理的时候,“把每个像素都用周围的8个像素来做均值操作”,比如说这里有一个例子:图通常是最能说明问题的东西,非常明显的,这个3*3区域像素的颜色值分别是5,3,6,2,1,9,8,4,7那么中间的1这个像素的过滤后的值就是这些值的平均值,也就是前面的计算方法:(5+3+6+2+1+9+8+4+7)/9=5一目了然。

那么这个均值滤波器有什么用处呢?主要还是平滑图像的用处,有的图像的锐度很高,用这样的均值算法,可以把锐度降低。

使得图像看上去更加自然,下面就有几幅图我们可以看出一些端倪:原图:平滑处理之后:这里还是可以明显的感觉到不同的,没有好坏之分,就是第二幅图片看上去更为平滑。

继续我们的问题,那这里均值平滑是否具有去除噪声的功能呢?我们搞来了椒盐噪声(就是随机的白点,黑点)来试试手:噪声图(5%):平滑处理之后:首先这里的噪声还是比较小的,只有5%,从均值的效果来看的话,我可以说几乎没有用,其实直观的想也可以判断,因为这里的处理并没有剔除这些噪声点,而只是微弱地降低了噪声,所以效果可以想见的。

总结:均值滤波器就是为了平滑周边的效果,不会因为图像上突出的点而感到难受,达到一种“Softened”的效果。

RGB565RGB565使用16位表示一个像素,这16位中的5位用于R,6位用于G,5位用于B。

程序中通常使用一个字(WORD,一个字等于两个字节)来操作一个像素。

当读出一个像素后,这个字的各个位意义如下:RGB和YUV都是色彩空间,用于表示颜色,两者可以相互转化。

YUV(亦称YCrCb)是被欧洲电视系统所采用的一种颜色编码方法(属于PAL)。

YUV主要用于优化彩色视频信号的传输,使其向后兼容老式黑白电视。

与R GB视频信号传输相比,它最大的优点在于只需占用极少的带宽(RGB要求三个独立的视频信号同时传输)。

中"Y"表示明亮度(Lumina nce或Luma),也就是灰阶值;是个基带信号。

而"U"和"V"表示的则是色度(Chrominance或Chroma),作用是描述影像色彩及饱和度,用于指定像素的颜色。

U和V不是基带信号,它俩是被正交调制了的。

"亮度"是通过RGB输入信号来创建的,方法是将RGB信号的特定部分叠加到一起。

"色度"则定义了颜色的两个方面-色调与饱和度,分别用Cr和CB来表示。

其中,Cr反映了RGB输入信号红色部分与RGB信号亮度值之间的差异。

而CB反映的是RGB输入信号蓝色部分与RGB 信号亮度值之同的差异。

通过运算,YUV三分量可以还原出R(红),G(绿),B(兰)。

亚稳态接下来我们将系统地开始探讨亚稳态,并解决由亚稳态产生的问题。

首先我们来了解一下什么是亚稳态。

亚稳态是一种物理现象的名称,它发生在一个事件试图取样[1](sample)另一事件的时候。

亚稳态可以描述如下:假设一个信号在t = 0时刻瞬间从0变为1,那么信号在t = 0时刻的值究竟是多少?是0还是1,或者在两者之间?在亚稳态中,这个问题被定义的两个时刻回避了,分别是0-和0+。

在t = 0-时刻,规定信号的取值为0,t = 0+ 时刻规定信号的取值为1。

显然,0- = 0 - 0,0+ =0 + 0。

注意,这仅仅是一个数学定义,如果你正在用实际的电路做同样的事,输出将有可能是逻辑0(0伏)或者逻辑1(5伏),或者是介于0 ~5伏中间的某个值。

正如在数学中描述的一样,物理系统中一个事件取样另一个事件产生了不可预知的结果。

不可预知性也就意味着另一个迹象——亚稳态很危险。

同步FIFO之VHDL描述同步FIFO的意思是说FIFO的读写时钟是同一个时钟,不同于异步FIFO,异步FIFO的读写时钟是完全异步的。

同步FIFO的对外接口包括时钟,清零,读请求,写请求,数据输入总线,数据输出总线,空以及满信号。

下面分别对同步FIFO的对外接口信号作一描述:1.时钟,输入,用于同步FIFO的读和写,上升沿有效;2.清零,输入,异步清零信号,低电平有效,该信号有效时,FIFO被清空;3.写请求,输入,低电平有效,该信号有效时,表明外部电路请求向FIFO写入数据;4.读请求,输入,低电平有效,该信号有效时,表明外部电路请求从FIFO中读取数据;5.数据输入总线,输入,当写信号有效时,数据输入总线上的数据被写入到FIFO中;6.数据输出总线,输出,当读信号有效时,数据从FIFO中被读出并放到数据输出总线上;7.空,输出,高电平有效,当该信号有效时,表明FIFO中没有任何数据,全部为空;8.满,输出,高电平有效,当该信号有效时,表明FIFO已经满了,没有空间可用来存贮数据。

使用VHDL描述的FIFO将以上面的接口为基础,并且可以参数化配置FIFO的宽度和深度。

先把对外接口描述出来吧。

下面的框图主要描述同步FIFO的内部结构,画出框图有助于对电路结构的理解,同样也有助于RTL 代码的编写:异步FIFOFIFO (先进先出队列)是一种在电子系统得到广泛应用的器件,通常用于数据的缓存和用于容纳异步信号的频率或相位的差异。

FIFO的实现通常是利用双口RAM和读写地址产生模块来实现的。

FIFO的接口信号包括异步的写时钟(wr_clk)和读时钟(rd_clk)、与写时钟同步的写有效(wre n)和写数据(wr_data)、与读时钟同步的读有效(rden)和读数据(rd_data)。

为了实现正确的读写和避免FIFO的上溢或下溢,通常还应该给出与读时钟和写时钟同步的FIFO的空标志(emp ty)和满标志(full)以禁止读写操作。

1 异步FIFO功能描述图1给出了FIFO的接口信号和内部模块图。

由图1可以看出,写地址产生模块根据写时钟和写有效信号产生递增的写地址,读地址产生模块根据读时钟和读有效信号产生递增的读地址。

FIFO的操作如下:在写时钟wr_clk的升沿,当wren 有效时,将wr_data写入双口RAM中写地址对应的位置中;始终将读地址对应的双口RAM中的数据输出到读数据总线上。

这样就实现了先进先出的功能。

写地址产生模块还根据读地址和写地址关系产生FIFO的满标志。

当wren有效时,若写地址+2 =读地址时,full为1;当wren无效时,若写地址+ 1=读地址时,full为1。

读地址产生模块还根据读地址和写地址的差产生FIFO的空标志。

当rden有效时,若写地址-1=读地址时,empty为1;当rden无效时,若写地址=读地址时,empty为1。