贝叶斯网络-代码学习

贝叶斯网络-代码学习

版权所有,仿冒必究-------全同学

// initialize ADTree

if (m_bUseADTree) {//weka里默认是是false

m_ADTree = ADNode.makeADTree(instances);

//

System.out.println("Oef, done!");

} if (nParent< bayesNet.getNrOfNodes()) {

bayesNet.getParentSet(iAttribute).addParent(nParent, instances);

3

版权所有,仿冒必究-------全同学

} else { System.err.println("Warning: Node " + sParent + " is

initialNet.getNodeName(initialNet.getParent(iNode, iParent)); int nParent = 0; while (nParent < bayesNet.getNrOfNodes()

&& !bayesNet.getNodeName(nParent).equals(sParent)) { nParent++;

// reserve memory m_ParentSets = new ParentSet[m_Instances.numAttributes()]; // m_Instances.numAttributes()返回的是训练数据的实际属性个数,包括了目标属性在内。 m_ParentSets 是表示所有属性节点的父节点,比如性别属性,如果性别属性id是4,那么 m_ParentSets[4]就存储的是性别属性节点的父节点

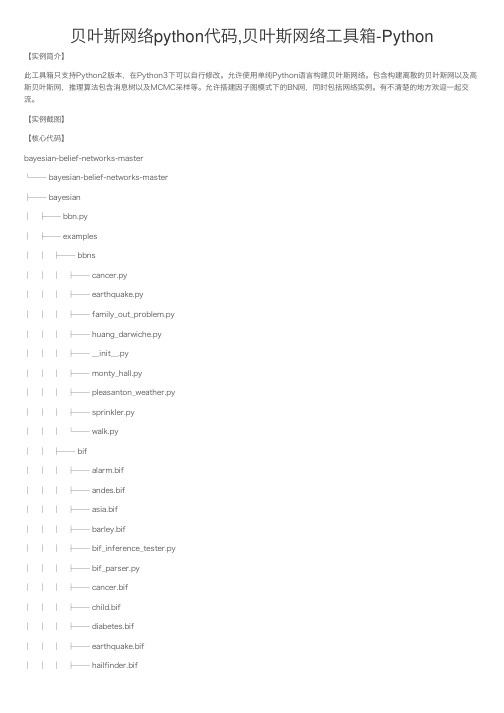

贝叶斯网络python代码,贝叶斯网络工具箱-Python

贝叶斯⽹络python代码,贝叶斯⽹络⼯具箱-Python【实例简介】此⼯具箱只⽀持Python2版本,在Python3下可以⾃⾏修改。

允许使⽤单纯Python语⾔构建贝叶斯⽹络。

包含构建离散的贝叶斯⽹以及⾼斯贝叶斯⽹,推理算法包含消息树以及MCMC采样等。

允许搭建因⼦图模式下的BN⽹,同时包括⽹络实例。

有不清楚的地⽅欢迎⼀起交流。

【实例截图】【核⼼代码】bayesian-belief-networks-master└── bayesian-belief-networks-master├── bayesian│ ├── bbn.py│ ├── examples│ │ ├── bbns│ │ │ ├── cancer.py│ │ │ ├── earthquake.py│ │ │ ├── family_out_problem.py│ │ │ ├── huang_darwiche.py│ │ │ ├── __init__.py│ │ │ ├── monty_hall.py│ │ │ ├── pleasanton_weather.py│ │ │ ├── sprinkler.py│ │ │ └── walk.py│ │ ├── bif│ │ │ ├── alarm.bif│ │ │ ├── andes.bif│ │ │ ├── asia.bif│ │ │ ├── barley.bif│ │ │ ├── bif_inference_tester.py│ │ │ ├── bif_parser.py│ │ │ ├── cancer.bif│ │ │ ├── child.bif│ │ │ ├── diabetes.bif│ │ │ ├── earthquake.bif│ │ │ ├── hailfinder.bif│ │ │ ├── hepar2.bif│ │ │ ├── insurance.bif│ │ │ ├── link.bif│ │ │ ├── mildew.bif│ │ │ ├── munin.bif│ │ │ ├── pathfinder.bif│ │ │ ├── pigs.bif│ │ │ ├── README.txt│ │ │ ├── water.bif│ │ │ └── win95pts.bif│ │ ├── factor_graphs│ │ │ ├── cancer.py│ │ │ ├── earthquake.py│ │ │ ├── huang_darwiche.py│ │ │ ├── __init__.py│ │ │ ├── monty_hall.py│ │ │ ├── monty_hall_sampled.py │ │ │ └── walk.py│ │ ├── gaussian_bayesian_networks │ │ │ ├── __init__.py│ │ │ ├── koller.py│ │ │ └── river.py│ │ └── __init__.py│ ├── exceptions.py│ ├── factor_graph.py│ ├── gaussian_bayesian_network.py │ ├── gaussian_node.py│ ├── gaussian.py│ ├── graph.py│ ├── __init__.py│ ├── linear_algebra.py│ ├── persistance.py│ ├── stats.py│ ├── test│ │ ├── examples│ │ │ ├── bbns│ │ │ │ ├── test_cancer.py│ │ │ │ ├── test_earthquake.py│ │ │ │ ├── test_huang_darwiche.py│ │ │ │ └── test_monty_hall.py│ │ │ └── factor_graphs│ │ │ └── test_earthquake_fg.py│ │ ├── test_bbn.py│ │ ├── test_examples.py│ │ ├── test_factor_graph_verify.py│ │ ├── test_gaussian_bayesian_network.py │ │ ├── test_gaussian.py│ │ ├── test_gbn_examples.py│ │ ├── test_graph.py│ │ ├── test_linear_algebra.py│ │ ├── test_persistance.py│ │ └── test_undirected_graph.py│ └── utils.py├── docs│ └── tutorial│ ├── conf.py│ ├── index.rst│ ├── Makefile│ ├── _static│ │ ├── monty_hall_bbn.png│ │ └── monty_hall_bbn_variables.png│ ├── _themes│ │ ├── agogo_nn│ │ │ ├── layout.html│ │ │ ├── static│ │ │ │ ├── agogo.css_t│ │ │ │ ├── bgfooter.png│ │ │ │ └── bgtop.png│ │ │ └── theme.conf │ │ └── LICENSE│ └── tutorial.rst├── LICENSE.txt├── MANIFEST.in├── README.txt├── requirements.txt└── setup.py17 directories, 85 files。

贝叶斯优化的bpnn模型python代码-概述说明以及解释

贝叶斯优化的bpnn模型python代码-概述说明以及解释1.引言1.1 概述在这个部分,你可以描述贝叶斯优化和BP神经网络模型的基本概念和背景。

可以简要介绍贝叶斯优化是一种基于概率和贝叶斯理论的优化方法,用于在给定的限制条件下寻找最优解。

同时也可以介绍BP神经网络是一种常用的人工神经网络模型,用于解决分类和回归等问题。

你可以讨论贝叶斯优化和BP神经网络在不同领域的应用,以及它们之间结合起来的潜在优势。

可以指出这种结合可以帮助优化神经网络的超参数,提高训练效率和准确性。

最后,可以强调本文旨在探讨如何使用贝叶斯优化优化BP神经网络的参数,以提高其性能和应用范围。

1.2文章结构1.2 文章结构本文主要分为引言、正文和结论三部分。

具体结构安排如下:引言部分将会首先概述贝叶斯优化和BP神经网络,并介绍本文的研究目的。

正文部分主要分为三个小节。

首先是贝叶斯优化简介,介绍这一优化方法的原理和应用场景;接着是BP神经网络模型概述,解释BP神经网络的基本原理和结构;最后是结合贝叶斯优化和BP神经网络的优势,探讨将两者结合应用的好处和可行性。

结论部分将总结贝叶斯优化在BP神经网络中的应用情况,展望未来研究方向,并对整个文章进行总结概括。

1.3 目的:本文旨在探讨贝叶斯优化在BP神经网络中的应用,并分析结合两者的优势。

通过对贝叶斯优化和BP神经网络的简介,以及它们各自的优势进行论述,旨在为读者提供一个全面的了解和认识。

同时,本文也将总结贝叶斯优化在BP神经网络中的实际应用和未来研究方向,为相关领域的研究者和从业者提供参考和启发。

通过本文的阐述,希望能够为贝叶斯优化和BP神经网络的进一步研究和应用提供一定的指导和帮助。

2.正文2.1 贝叶斯优化简介:贝叶斯优化是一种通过在可能的目标函数空间中建立高斯过程来优化目标函数的方法。

其主要思想是在探索和利用之间进行权衡,通过不断地试验目标函数来找到最优解。

贝叶斯优化通常用于处理黑箱函数,即目标函数的具体形式未知,只能通过输入输出的对应关系进行观测。

贝叶斯分类器代码

贝叶斯分类器代码1. 介绍贝叶斯分类器是一种基于贝叶斯定理的概率分类器。

它通过学习一组训练数据,构建一个由特征和类别之间的条件概率组成的模型,然后用该模型对新的未知样本进行分类。

贝叶斯分类器在文本分类、垃圾邮件过滤、情感分析等任务中都得到了广泛应用。

本文将详细探讨贝叶斯分类器的代码实现,在Python中使用scikit-learn库进行演示。

2. 贝叶斯分类器原理贝叶斯分类器基于贝叶斯定理,根据条件概率计算样本的后验概率。

具体来说,给定一个样本x和一组类别y_1, y_2, …, y_n,贝叶斯分类器的任务是预测样本x 属于每个类别的概率,然后选择具有最高概率的类别作为预测结果。

贝叶斯分类器通过以下公式计算后验概率:P(y|x) = (P(x|y) * P(y)) / P(x)其中,P(y|x)是给定样本x的条件下样本属于类别y的概率,P(x|y)是属于类别y 的样本中具有特征x的概率,P(y)是类别y发生的先验概率,P(x)是样本具有特征x的概率。

3. 数据准备在编写贝叶斯分类器代码之前,首先需要准备用于训练和测试的数据。

这里以一个文本分类任务为例,使用20类新闻文本数据集(20 Newsgroups)作为示范数据。

首先,从库中加载新闻数据集:from sklearn.datasets import fetch_20newsgroupscategories = ['alt.atheism', 'sci.med', 'comp.graphics', 'sci.space'] # 选择四个类别作为示例data_train = fetch_20newsgroups(subset='train', categories=categories, shuffle =True, random_state=42)data_test = fetch_20newsgroups(subset='test', categories=categories, shuffle=T rue, random_state=42)加载数据后,我们得到两个对象data_train和data_test,它们分别表示训练集和测试集。

贝叶斯网络

3.5 贝叶斯网络贝叶斯网络是一系列变量的联合概率分布的图形表示。

一般包含两个部分,一个就是贝叶斯网络结构图,这是一个有向无环图(DAG),其中图中的每个节点代表相应的变量,节点之间的连接关系代表了贝叶斯网络的条件独立语义。

另一部分,就是节点和节点之间的条件概率表(CPT),也就是一系列的概率值。

如果一个贝叶斯网络提供了足够的条件概率值,足以计算任何给定的联合概率,我们就称,它是可计算的,即可推理的。

3.5.1 贝叶斯网络基础首先从一个具体的实例(医疗诊断的例子)来说明贝叶斯网络的构造。

假设:命题S(moker):该患者是一个吸烟者命题C(oal Miner):该患者是一个煤矿矿井工人命题L(ung Cancer):他患了肺癌命题E(mphysema):他患了肺气肿命题S对命题L和命题E有因果影响,而C对E也有因果影响.命题之间的关系可以描绘成如右图所示的因果关系网.因此,贝叶斯网有时也叫因果网,因为可以将连接结点的弧认为是表达了直接的因果关系。

图3-5 贝叶斯网络的实例图中表达了贝叶斯网的两个要素:其一为贝叶斯网的结构,也就是各节点的继承关系,其二就是条件概率表CPT。

若一个贝叶斯网可计算,则这两个条件缺一不可。

贝叶斯网由一个有向无环图(DAG)及描述顶点之间的概率表组成.其中每个顶点对应一个随机变量。

这个图表达了分布的一系列有条件独立属性:在给定了父亲节点的状态后,每个变量与它在图中的非继承节点在概率上是独立的。

该图抓住了概率分布的定性结构,并被开发来做高效推理和决策。

贝叶斯网络能表示任意概率分布的同时,它们为这些能用简单结构表示的分布提供了可计算优势.假设对于顶点xi,其双亲节点集为Pai,每个变量xi的条件概率P(xi|Pai)。

则顶点集合X={x1,x2,…,xn}的联合概率分布可如下计算:。

双亲结点。

该结点得上一代结点。

该等式暗示了早先给定的图结构有条件独立语义。

它说明贝叶斯网络所表示的联合分布作为一些单独的局部交互作用模型的结果具有因式分解的表示形式。

机器学习--朴素贝叶斯算法原理、方法及代码实现

机器学习--朴素贝叶斯算法原理、⽅法及代码实现⼀、朴素的贝叶斯算法原理 贝叶斯分类算法以样本可能属于某类的概率来作为分类依据,朴素贝叶斯分类算法是贝叶斯分类算法中最简单的⼀种,朴素的意思是条件概率独⽴性。

条件概率的三个重要公式: (1)概率乘法公式: P(AB)= P(B) P(A|B) = P(A) P(B|A) =P(BA) (2)全概率公式: (3)贝叶斯公式: 如果⼀个事物在⼀些属性条件发⽣的情况下,事物属于A的概率>属于B的概率,则判定事物属于A,这就是朴素贝叶斯的基本思想。

⼆、算法实现⼀般步骤 (1)分解各类先验样本数据中的特征。

(2)计算各类数据中,各特征的条件概率(⽐如:特征1出现的情况下,属于A类的概率p(A|特征1),属于B类的概率p(B|特征1),属于C类的概率p(C|特征1)......)。

(3)分解待分类数据中的特征(特征1、特征2、特征3、特征4......)。

(4)计算各特征的各条件概率的乘积,如下所⽰: 判断为A类的概率:p(A|特征1)*p(A|特征2)*p(A|特征3)*p(A|特征4)..... 判断为B类的概率:p(B|特征1)*p(B|特征2)*p(B|特征3)*p(B|特征4)..... 判断为C类的概率:p(C|特征1)*p(C|特征2)*p(C|特征3)*p(C|特征4)..... ...... (5)结果中的最⼤值就是该样本所属的类别。

三、应⽤举例 ⼆分类问题:⼤众点评、淘宝等电商上都会有⼤量的⽤户评论,有差评(1),有好评(0),现需要使⽤朴素贝叶斯分类算法来⾃动分类⽤户评论。

四、实际问题代码实现from numpy import *#贝叶斯算法def loadDataSet():trainData=[['my', 'dog', 'has', 'flea', 'problems', 'help', 'please'],['maybe', 'not', 'take', 'him', 'to', 'dog', 'park', 'stupid'],['my', 'dalmation', 'is', 'so', 'cute', 'I', 'love', 'him'],['stop', 'posting', 'stupid', 'worthless', 'garbage'],['mr', 'licks', 'ate', 'my', 'steak', 'how', 'to', 'stop', 'him'],['quit', 'buying', 'worthless', 'dog', 'food', 'stupid']]labels=[0, 1, 0, 1, 0, 1] #1表⽰侮辱性⾔论,0表⽰正常⾔论return trainData, labels#⽣成词汇表def createVocabList(trainData):VocabList = set([])for item in trainData:VocabList = VocabList|set(item) #取两个集合的并集return sorted(list(VocabList)) #对结果排序后返回#对训练数据⽣成只包含0和1的向量集def createWordSet(VocabList, trainData):VocabList_len = len(VocabList) #词汇集的长度trainData_len = len(trainData) #训练数据的长度WordSet = zeros((trainData_len,VocabList_len)) #⽣成⾏长度为训练数据的长度列长度为词汇集的长度的列表for index in range(0,trainData_len):for word in trainData[index]:if word in VocabList: #其实也就是,训练数据包含的单词对应的位置为1其他为0WordSet[index][VocabList.index(word)] = 1return WordSet#计算向量集每个的概率def opreationProbability(WordSet, labels):WordSet_col = len(WordSet[0])labels_len = len(labels)WordSet_labels_0 = zeros(WordSet_col)WordSet_labels_1 = zeros(WordSet_col)num_labels_0 = 0num_labels_1 = 0for index in range(0,labels_len):if labels[index] == 0:WordSet_labels_0 += WordSet[index] #向量相加num_labels_0 += 1 #计数else:WordSet_labels_1 += WordSet[index] #向量相加num_labels_1 += 1 #计数p0 = WordSet_labels_0 * num_labels_0 / labels_lenp1 = WordSet_labels_1 * num_labels_1 / labels_lenreturn p0, p1trainData, labels = loadDataSet()VocabList = createVocabList(trainData)train_WordSet = createWordSet(VocabList,trainData)p0, p1 = opreationProbability(train_WordSet, labels)#到此就算是训练完成#开始测试testData = [['not', 'take', 'ate', 'my', 'stupid']] #测试数据test_WordSet = createWordSet(VocabList, testData) #测试数据的向量集res_test_0 = []res_test_1 = []for index in range(0,len(p0)):print(p0[index])if test_WordSet[0][index] == 0:res_test_0.append((1-p0[index]) * test_WordSet[0][index])res_test_1.append((1-p1[index]) * test_WordSet[0][index])else:res_test_0.append(p0[index] * test_WordSet[0][index])res_test_1.append(p1[index] * test_WordSet[0][index])if sum(res_test_0) > sum(res_test_1):print("属于0类别")else:print("属于1类别")运⾏结果:。

朴素贝叶斯的python源码实现

朴素贝叶斯的python源码实现朴素贝叶斯是一种简单但非常强大的分类算法,它基于贝叶斯定理和特征条件独立假设,被广泛应用于文本分类、垃圾邮件过滤、情感分析等领域。

在本文中,我们将通过Python源码实现朴素贝叶斯分类器,并详细解释其原理和实现步骤。

朴素贝叶斯算法的核心思想是利用已知类别的训练样本,通过计算每个特征在每个类别下的条件概率,来预测新样本的类别。

在实现朴素贝叶斯分类器之前,我们需要了解一些基本概念。

我们需要定义文档和类别。

文档是由词汇组成的集合,类别是文档所属的类别。

在文本分类中,文档即为文本,类别可以是正面评价和负面评价。

我们需要训练样本集,其中包含了已知类别的文档。

接下来,我们需要计算每个类别的先验概率,即P(c),表示一个文档属于某一类别的概率。

这可以通过统计训练样本中每个类别的文档数量来计算。

然后,我们需要计算每个词汇在每个类别下的条件概率,即P(w|c),表示在已知文档属于某一类别的情况下,该文档包含某个词汇的概率。

这可以通过统计训练样本中每个类别下每个词汇出现的次数来计算。

在实现朴素贝叶斯分类器时,我们首先需要进行训练。

我们将训练样本分为正面评价和负面评价两类,并统计每个类别的先验概率。

然后,我们统计每个类别下每个词汇出现的次数,并计算每个词汇在每个类别下的条件概率。

接着,我们需要对新样本进行分类。

给定一个新的文档,我们需要计算该文档属于每个类别的概率,并选择概率最大的类别作为分类结果。

计算文档属于某个类别的概率可以通过将文档中每个词汇在该类别下的条件概率相乘,并乘以该类别的先验概率得到。

下面是使用Python实现朴素贝叶斯分类器的源码:```pythonimport numpy as npclass NaiveBayesClassifier:def __init__(self):self.classes = Noneself.class_priors = Noneself.word_counts = Noneself.word_probs = Nonedef fit(self, X, y):self.classes = np.unique(y)self.class_priors = self.calculate_class_priors(y) self.word_counts = self.calculate_word_counts(X, y) self.word_probs = self.calculate_word_probs()def calculate_class_priors(self, y):class_priors = {}total_samples = len(y)for cls in self.classes:class_count = np.sum(y == cls)class_priors[cls] = class_count / total_samples return class_priorsdef calculate_word_counts(self, X, y):word_counts = {}for cls in self.classes:class_indices = np.where(y == cls)class_word_counts = np.sum(X[class_indices], axis=0)word_counts[cls] = class_word_countsreturn word_countsdef calculate_word_probs(self):word_probs = {}for cls in self.classes:total_words = np.sum(self.word_counts[cls])word_probs[cls] = (self.word_counts[cls] + 1) / (total_words + len(self.word_counts[cls]))return word_probsdef predict(self, X):predictions = []for x in X:class_probs = {}for cls in self.classes:class_prob = np.log(self.class_priors[cls]) for i, word in enumerate(x):if word > 0:class_prob += np.log(self.word_probs[cls][i]) * wordclass_probs[cls] = class_probpredicted_class = max(class_probs, key=class_probs.get)predictions.append(predicted_class)return predictions```在上述代码中,我们首先定义了一个NaiveBayesClassifier类,并初始化了一些成员变量。

贝叶斯网络全解 共64页

A和B的“head-to-tail型”和“tail-to-tail型”路径都通过C; A和B的“head-to-head型”路径不通过C以及C的子孙;

32

有向分离的举例

每个结点在给定其直接前驱时,条件独立于其非后继。

稍后详细解释此结论

18

一个简单的贝叶斯网络

19

全连接贝叶斯网络

每一对结点之间都有边连接

20

一个“正常”的贝叶斯网络

有些边缺失 直观上:

x1和x2独立 x6和x7在x4给定的条件下独立

x1,x2,…x7的联合分布:

21

BN(G, Θ) G:有向无环图 G的结点:随机变量 G的边:结点间的有向依赖 Θ:所有条件概率分布的参数集合 结点X的条件概率:P(X|parent(X))

思考:需要多少参数才能确定上述网络呢? 每个结点所需参数的个数:结点的parent数目是M,结点和 parent的可取值数目都是K:KM*(K-1) 为什么? 考察结点的parent对该结点形成了多少种情况(条件分布)

贝叶斯网络(Bayesian Network),又称有向无环图模 型(directed acyclic graphical model),是一种概率图 模型,借由有向无环图(Directed Acyclic Graphs, DAG)中得知一组随机变量{X1,X2...Xn}及其n组条 件概率分布(Conditional Probability Distributions, CPD)的性质。

Gas和Radio是独立的吗?给定Battery呢? Ignition呢?Starts呢?Moves呢?(答:IIIDD)

Matlab中的机器学习和贝叶斯网络技巧

Matlab中的机器学习和贝叶斯网络技巧机器学习是一门涵盖统计学、人工智能和计算机科学等多学科知识的领域,它通过让计算机从数据中学习并逐步改进性能,来完成特定任务。

而贝叶斯网络是机器学习中一种常用的概率图模型,它能够建模和推断变量之间的依赖关系。

本文将介绍在Matlab中应用机器学习和贝叶斯网络的技巧和方法。

一、机器学习基础机器学习的基本任务是通过对已有数据的学习来构建一个预测模型,并用该模型对新的数据进行预测。

在Matlab中,我们可以使用一些常用的机器学习工具箱,如Statistics and Machine Learning Toolbox和Neural Network Toolbox等,来实现各种机器学习算法。

1. 数据准备在进行机器学习之前,我们首先需要准备好适合建模的数据。

这包括数据的采集、预处理和特征提取等步骤。

Matlab提供了丰富的数据处理和可视化函数,如readtable、preprocess和feature_extraction等,来帮助我们完成这些任务。

2. 特征选择在建模之前,我们需要从原始数据中选择出对预测结果有重要影响的特征。

Matlab中提供了一些特征选择工具函数,如sequentialfs、relieff和lasso等,可以帮助我们进行特征选择。

3. 模型训练在数据准备和特征选择之后,我们就可以使用机器学习算法进行模型训练了。

根据不同的问题和数据类型,我们可以选择适合的算法,如支持向量机、决策树、随机森林等。

Matlab提供了这些算法的实现函数,如svmtrain、treefit和randomForest等,可以方便地进行模型训练。

4. 模型评估模型训练完成后,我们需要对模型进行评估,以了解其性能和泛化能力。

在Matlab中,我们可以使用一些评估指标,如准确率、精确率、召回率和F1值等,来评估模型的效果。

此外,还可以使用交叉验证、学习曲线和混淆矩阵等方法来进行模型评估。

贝叶斯网络Matlab

Matlab贝叶斯网络建模1 FullBNT简介基于Matlab的贝叶斯网络工具箱BNT是kevin p.murphy基于matlab语言开发的关于贝叶斯网络学习的开源软件包,提供了许多贝叶斯网络学习的底层基础函数库,支持多种类型的节点(概率分布)、精确推理和近似推理、参数学习及结构学习、静态模型和动态模型。

1.1贝叶斯网络表示BNT中使用矩阵方式表示贝叶斯网络,即若节点i到j有一条弧,则对应矩阵中值为1,否则为0。

1.2结构学习算法函数BNT中提供了较为丰富的结构学习函数,都有:1. 学习树扩展贝叶斯网络结构的算法.2. 数据完整条件下学习一般贝叶斯网络结构学习算法表1-1 数据完整条件下贝叶斯结构算法算法名称调用函数K2算法learn_struct_k2()贪婪搜索GS(greedy search)算法earn_struct_gs()3. 缺失数据条件下学习一般贝叶斯网络结构学习算法表1-2 缺失数据条件下贝叶斯结构算法1.3参数学习算法函数1. BNT中也提供了丰富的参数学习函数,都有:2. 完整数据时,学习参数的方法主要有两种:最大似然估计learn_params()和贝叶斯方法bayes_update_params();3. 数据缺失时,如果已知网络拓扑结构,用EM算法来计算参数,learn_params_em ()。

1.4推理机制及推理引擎为了提高运算速度,使各种推理算法能够有效应用,BNT工具箱采用了引擎机制,不同的引擎根据不同的算法来完成模型转换、细化和求解。

这个推理过程如下:BNT中提供了多种推理引擎,都有:表1-3 BNT推理引擎算法名称调用函数联合树推理引擎jtree_inf_engine()全局联合树推理引擎global_joint_inf_engine()信念传播推理引擎belprop_inf_engine()变量消元推理引擎var_elim_inf_engine()采样传播引擎gibbs_sampling_inf_engine2 参数学习在BNT中,参数评估程序可以分为4类。

贝叶斯网络的参数学习方法(六)

贝叶斯网络是一种概率图模型,它以有向无环图的形式表示随机变量之间的依赖关系。

贝叶斯网络的参数学习是指在已知数据集的情况下,通过对数据进行学习,来估计贝叶斯网络中的概率分布参数。

本文将从贝叶斯网络的参数学习方法入手,介绍常见的参数学习算法及其应用。

1. 极大似然估计法极大似然估计法是最简单的参数学习方法之一。

对于贝叶斯网络中的每个节点,我们可以根据观测到的数据来估计其条件概率分布。

以一个简单的例子来说明,假设有两个随机变量X和Y,它们之间存在依赖关系。

对于X和Y的联合分布P(X,Y),我们可以通过观测到的数据样本来估计条件概率P(X|Y)。

假设我们观测到了n组(Xi,Yi)的数据样本,那么P(X|Y)的估计值可以通过计算在给定Y的条件下X的分布来得到。

具体地,P(X|Y)的估计值可以通过统计每个Y取值对应的X的分布来得到。

极大似然估计法简单直观,但是在数据较少或者存在稀疏数据时容易出现过拟合问题。

2. 贝叶斯估计法贝叶斯估计法是对极大似然估计法的改进。

在贝叶斯估计法中,我们引入了先验概率分布来对参数进行估计。

通过引入先验概率分布,我们可以在一定程度上减小对观测数据的过拟合。

对于贝叶斯网络中的每个节点,我们可以通过最大后验估计来估计其条件概率分布参数。

具体地,我们可以通过观测到的数据样本来更新先验概率分布,得到后验概率分布,然后再根据后验概率分布得到条件概率分布参数的估计值。

贝叶斯估计法在参数学习中更加稳健,尤其在数据较少的情况下表现更好。

3. EM算法EM算法是一种常见的参数学习算法,它在贝叶斯网络中也有广泛的应用。

EM 算法通过迭代的方式来估计模型参数。

在每一次迭代中,EM算法分两步进行:E步(Expectation step)和M步(Maximization step)。

在E步中,我们计算隐变量的期望值,然后在M步中,基于这些期望值来更新模型参数。

EM算法在处理存在隐变量的情况下具有很好的效果,所以在贝叶斯网络中也有着广泛的应用。

python实现贝叶斯知识追踪模型代码

Python实现贝叶斯知识追踪模型代码1. 简介贝叶斯知识追踪模型是一种基于贝叶斯统计原理的机器学习模型,用于追踪知识的演化过程。

它能够根据已有的知识数据和新的观测数据,通过贝叶斯推断方法更新知识模型的概率分布,从而实现对知识的追踪和更新。

在本文中,我们将使用Python语言实现贝叶斯知识追踪模型的代码,并详细介绍算法的原理和实现细节。

2. 贝叶斯知识追踪模型原理2.1 贝叶斯统计原理贝叶斯统计原理是一种基于条件概率的统计推断方法。

在贝叶斯统计中,我们将待推断的未知量称为参数,将已观测到的数据称为观测量。

贝叶斯统计的核心思想是通过已观测数据更新对参数的先验概率分布,得到参数的后验概率分布。

具体地,假设我们有一个参数θ和一组观测数据D,我们希望推断参数θ的概率分布。

根据贝叶斯统计原理,我们可以通过以下公式计算参数θ的后验概率分布:P(θ|D)=P(D|θ)⋅P(θ)P(D)其中,$ P(θ|D) $ 表示参数θ在给定观测数据D下的后验概率,$ P(D|θ)$ 表示观测数据D在给定参数θ下的概率,$ P(θ) $ 表示参数θ的先验概率,$ P(D) $ 表示观测数据D的边缘概率。

2.2 贝叶斯知识追踪模型贝叶斯知识追踪模型是基于贝叶斯统计原理的推断模型,用于追踪知识的演化过程。

在贝叶斯知识追踪模型中,我们将知识的状态变化看作是参数的变化,将观测数据看作是对知识状态的观测。

具体地,假设我们有一个知识模型,其中每个知识点对应一个参数θ,表示该知识点的概率。

我们还有一组观测数据D,表示新的知识点观测结果。

根据贝叶斯统计原理,我们可以通过观测数据D更新知识模型的概率分布。

具体步骤如下:1.初始化知识模型的先验概率分布P(θ);2.根据观测数据D计算每个知识点的似然概率P(D|θ);3.根据贝叶斯统计原理计算每个知识点的后验概率分布P(θ|D)。

在实际应用中,我们可以使用迭代的方式,每次观测到新的数据时更新知识模型的概率分布。

贝叶斯网络简介

? Dealing with time ? In many systems, data arrives sequentially ? Dynamic Bayes nets (DBNs) can be used to

分类语义理解军事目标识别多目标跟踪战争身份识别生态学生物信息学贝叶斯网络在基因连锁分析中应编码学分类聚类时序数据和动态模型图分割有向分割dseparated分割变量x和y通过第三个变量z间接相连的三种情况

贝叶斯网络简介

Introduction to Bayesian Networks

基本框架

? 贝叶斯网络: ? 概率论 ? 图论

hidden structure learning)

一个简单贝叶斯网络例子

一个简单贝叶斯网络例子

? 计算过程:

? (1)

? P(y1|x1)=0.9

? P(z1|x1)=P(z1|y1,x1)P(y1|x1)+P(z1|y2,x1)P(y2|x1)

?

=P(z1|y1)P(y1|x1)+P(z1|y2)P(y2|x1)

? 使得运算局部化。消元过程实质上就是一个边缘化的过程。 ? 最优消元顺序:最大势搜索,最小缺边搜索

贝叶斯网络推理(Inference)

2. 团树传播算法

?利用步骤共享来加快推理的算法。

?团树(clique tree)是一种无向树,其中每 一个节点代表一个变量集合,称为团(clique) 。团树必须满足变量连通性,即包含同一变 量的所有团所导出的子图必须是连通的。

Conditional Independence

基本概念

例子

P(C, S,R,W) = P(C)P(S|C)P(R|S,C)P(W|S,R,C) chain rule = P(C)P(S|C)P(R|C)P(W|S,R,C) since = P(C)P(S|C)P(R|C)P(W|S,R) since

Python中的贝叶斯网络学习

Python中的贝叶斯网络学习贝叶斯网络学习(Bayesian Network Learning)是一种基于贝叶斯统计理论的机器学习方法,它是一种主要用于处理和分析随机结果的形式化数学技术。

它最早来源于图案识别领域,但随着人工智能和机器学习的发展,贝叶斯网络的应用也在不断扩大,并被广泛用于许多复杂的学习或推理任务,包括模式分析、信息检索和数据挖掘。

贝叶斯网络学习在Python中具有相当重要的意义,它可以帮助用户更好地理解机器学习。

在Python中,贝叶斯网络学习的实现可以使用多种模式实现,比如通过Scikit-learn、PyMC 和Graphlab create模块。

这些模块都支持贝叶斯网络学习,可以帮助用户构建网络模型并使用它们进行更有效和准确的学习任务。

贝叶斯网络学习可以在Python中用于各种复杂的学习或推理任务,它可以帮助用户根据学习数据估计参数,从而构建贝叶斯网络模型,从而获取有价值的信息和结果。

例如,贝叶斯网络可以用来预测用户购买产品的可能性,或者为新的社交媒体帖子确定有吸引力的属性,以帮助用户更好地理解各种现实用例中的问题和机会。

另外,贝叶斯网络学习在Python中还可以用于个性化服务,即为用户提供特定信息,以满足消费者的需求。

例如,在信息检索领域,贝叶斯网络可以用来分析用户的搜索历史记录,从而推断用户的兴趣,并根据用户的兴趣推荐有价值的内容。

此外,贝叶斯网络学习也可以用来构建智能系统,并帮助机器更好地理解自然语言,以便更有效地将它们与现实世界相联系。

总之,贝叶斯网络学习在Python中具有重要意义,它可以用来处理大量复杂数据,从而发现有价值的信息,并用于实际应用。

它可以帮助用户处理非常复杂的推理任务,从而获得更准确更可靠的结果,并有助于更有效地了解机器学习和信息处理技术。

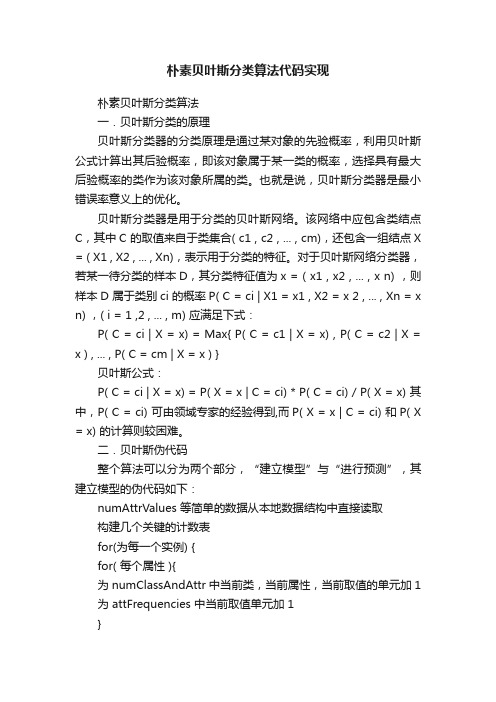

朴素贝叶斯分类算法代码实现

朴素贝叶斯分类算法代码实现朴素贝叶斯分类算法一.贝叶斯分类的原理贝叶斯分类器的分类原理是通过某对象的先验概率,利用贝叶斯公式计算出其后验概率,即该对象属于某一类的概率,选择具有最大后验概率的类作为该对象所属的类。

也就是说,贝叶斯分类器是最小错误率意义上的优化。

贝叶斯分类器是用于分类的贝叶斯网络。

该网络中应包含类结点C,其中C 的取值来自于类集合( c1 , c2 , ... , cm),还包含一组结点X = ( X1 , X2 , ... , Xn),表示用于分类的特征。

对于贝叶斯网络分类器,若某一待分类的样本D,其分类特征值为x = ( x1 , x2 , ... , x n) ,则样本D 属于类别ci 的概率P( C = ci | X1 = x1 , X2 = x 2 , ... , Xn = x n) ,( i = 1 ,2 , ... , m) 应满足下式:P( C = ci | X = x) = Max{ P( C = c1 | X = x) , P( C = c2 | X = x ) , ... , P( C = cm | X = x ) }贝叶斯公式:P( C = ci | X = x) = P( X = x | C = ci) * P( C = ci) / P( X = x) 其中,P( C = ci) 可由领域专家的经验得到,而P( X = x | C = ci) 和P( X = x) 的计算则较困难。

二.贝叶斯伪代码整个算法可以分为两个部分,“建立模型”与“进行预测”,其建立模型的伪代码如下:numAttrValues 等简单的数据从本地数据结构中直接读取构建几个关键的计数表for(为每一个实例) {for( 每个属性 ){为 numClassAndAttr 中当前类,当前属性,当前取值的单元加 1 为 attFrequencies 中当前取值单元加 1}}预测的伪代码如下:for(每一个类别){for(对每个属性 xj){for(对每个属性 xi){if(F(xi)小于 m){出现的次数没有超过阀值,不予考虑}else {查 numClassAndAttr 计算 F(y, xi, xj)}}查 numClassAndAttr 计算 F(y, xi)}计算公式(7)中的评价函数,记录下这个类别的评价函数值}得到了各个类别上的条件概率,再带入贝叶斯公式算出最后的概率三、算法实现代码(1)建立模型void GetModel::TrainModel(){int SplitVal;Cache();//为模型分配内存for(int i=0;i<=gi->MaxAttNo;i++){if(!gi->MaxAttValNo[i])SplitPoint[i]=gi->SplitContinuousAtt(i);}for(int i=0;i<=gi->MaxItemNo;i++){for(int j=0;j<=gi->MaxAttNo;j++){if(gi->MaxAttValNo[j])PostFreq[gi->Item[i][gi->MaxAttNo+1].DiscrValue][j][gi->It em[i][j].DiscrValue]+ +;else{if(gi->Item[i][j].continuousVal<=SplitPoint[j])SplitVal=1;elseSplitVal=2;PostFreq[gi->Item[i][gi->MaxAttNo+1].DiscrValue][j][SplitV al]++;}}}}void GetModel::Cache(){PostFreq=(float ***) calloc(gi->MaxClassNo+1,sizeof(float **));for(int i=0;i<=gi->MaxClassNo;i++){PostFreq[i]=(float **) calloc(gi->MaxAttNo+1,sizeof(float *));for(int j=0;j<=gi->MaxAttNo;j++){if(gi->MaxAttValNo[j])PostFreq[i][j]=(float*)calloc(gi->MaxAttValNo[j]+1,sizeof(float));elsePostFreq[i][j]=(float *)calloc(3,sizeof(float));}}SplitPoint=(float *)calloc(gi->MaxAttNo+1,sizeof(float));}(2)预测PredictClass::PredictClass(GetInfo *i,GetModel *m,string name,string Attname):MaxClassNo(-1),MaxDiscrValNo(2),MaxAttNo (-1){gi=i;gm=m;filename=name;this->Inc=1024;AttFileName=Attname;}void PredictClass::Predict(){float *prob;int BestI=-1;float MaxProb=0;int j;GetName();GetData();prob=(float *)calloc(MaxClassNo+1,sizeof(float));for(int i=0;i<=MaxClassNo;i++)prob[i]=1.0;for(int i=0;i<=MaxItemNo;i++){for(j=0;j<=MaxClassNo;j++){for(int k=0;k<=MaxAttNo;k++){if(MaxAttValNo[k])prob[j]*=(gm->PostFreq[j][k][Item[i][k].DiscrValue]/gi->Clas sFreq[j]);else{if(Item[i][k].continuousVal<=gm->SplitPoint[k])prob[j]*=(gm->PostFreq[j][k][1]/gi->ClassFreq[j]);elseprob[j]*=(gm->PostFreq[j][k][2]/gi->ClassFreq[j]);}}prob[j]*=(gi->ClassFreq[j]/(gi->MaxItemNo+1));if(prob[j]>MaxProb){MaxProb=prob[j];BestI=j;}}cout<<"概率最大"<<maxprob<<" ";<="" p="" 类别="<<ClassName[BestI]<<endl;</p><p>Item[i][MaxAttNo+1].Di scrValue=BestI;</p><p>/*重置*/</p><p>{</p><p>BestI=-1;</p><p>MaxProb=0;</p><p>for(inti=0;i<=MaxClassNo;i++)</p><p>prob[i]=1.0;</p><p>}</p>< p>}</p><p>show();</p><p>}</p><p>void PredictClass::show()</p><p>{</p><p>inti,j;</p><p>for( i=0;i<=MaxItemNo;i++)</p><p>{</p><p>for( j=0;j<=MaxAttNo;j++)</p><p>{</p><p>if(MaxAttValNo[j])</p><p>cout<<AttValName[j][Item[i][j].DiscrValue]<<"> elsecout<<item[i][j].continuousval<<" ";<="" p="">}cout<<"预测结果为:"<<classname[item[i][j].discrvalue]<<endl;< p=""> }}void PredictClass::GetData(){FILE *Nf;char Fn[50];filename=filename+".data";filename.copy(Fn,filename.length());Fn[filename.length()]=NULL;if ( ! ( Nf = fopen(Fn, "r") ) )Error(0, Fn, "");int ItemNo=0;int ItemSpace=0;do{MaxItemNo = ItemNo;/* Make sure there is room for another item */if ( ItemNo >= ItemSpace ){if ( ItemSpace ){ItemSpace += Inc;Item = (Description *)realloc(Item, ItemSpace*sizeof(Description));}else{Item = (Description *)malloc((ItemSpace=Inc)*sizeof(Description));}}Item[ItemNo] = GetDescription(Nf);}while ( Item[ItemNo] != 0 && ++ItemNo);fclose(Nf);MaxItemNo=ItemNo - 1;}void PredictClass::Error(int n, string s1, string s2)/* ----- */{cout<<"ERROR: ";switch(n){case 0: cout<<"cannot open file "<<s1<<s2<<endl;< p=""> break;case 1: cout<<"colon expected after attribute name "<<s1<<endl;< p="">break;case 2: cout<<"unexpected EOF while reading attribute "<< s1<<endl;< p="">break;case 3:cout<<"attribute "<<s1<<" has="" one="" only="" p="" value"<<endl;<="">break;case4:cout<<"case "<< MaxItemNo+1<<"'s value of'"<<s2<<"' "<<s1<<"is="" attname[attno],="" attribute="" error(4,="" for="" illegal"<<="" p="">break;case5:cout<<"case "<<maxitemno+1<<"'s '"<<s2<<"'="" class="" illegal"<<endl;<="" is="" of="" p="">break;}cout<<"process stop!"<<endl;< p="">exit(1);}Description PredictClass::GetDescription(FILE *Df){int AttNo;/* attribute number, 0..MaxAttNo */char name[50], *endname;int Dv;float Cv;Description Dvec;if ( ReadName(Df, name) ){Dvec = (Description)calloc(MaxAttNo+2, sizeof(AttValue));//因为aMaxAttNo 是从a开始计数的在加上类别属性,所以+2 for(AttNo=0;AttNo<=MaxAttNo;AttNo++){if ( MaxAttValNo[AttNo]){/* Discrete value */Dv = Which(name, AttValName[AttNo], 1, MaxAttValNo[AttNo]);if ( ! Dv ){Error(4, AttName[AttNo], name);}Dvec[AttNo].DiscrValue=Dv;}else{/* Continuous value */Cv = (float)strtod(name, &endname);if ( endname == name || *endname != '\0' ) Error(4, AttName[AttNo], name);Dvec[AttNo].continuousVal=Cv;}ReadName(Df,name);}return Dvec;}else{return 0;}}void PredictClass::GetName(){FILE *Nf;char Buffer[1000];char Fn[100];int AttCeiling=100;int ClassCeiling=100;int ValCeiling;AttFileName.copy(Fn,AttFileName.length());Fn[AttFileName.length()]=NULL;strcat_s(Fn,".names");if ( ! ( Nf = fopen(Fn, "r") ) )Error(0, Fn, "");ClassName = (string *) calloc(ClassCeiling, sizeof(string));do{ReadName(Nf, Buffer);if ( ++MaxClassNo >= ClassCeiling){ClassCeiling += 100;ClassName = (string *) realloc(ClassName, ClassCeiling*sizeof(string));}ClassName[MaxClassNo]=string(Buffer);}while ( Delimiter == ',' );/* Get attribute and attribute value names from names file */ AttName = (string *) calloc(AttCeiling, sizeof(string));MaxAttValNo = (short *) calloc(AttCeiling, sizeof(short));AttValName = (string **) calloc(AttCeiling, sizeof(string *));//SpecialStatus = (char *) malloc(AttCeiling);while ( ReadName(Nf, Buffer) ){if ( Delimiter != ':' )Error(1, Buffer, "");if ( ++MaxAttNo >= AttCeiling )//扩大空间{AttCeiling += 100;AttName = (string *) realloc(AttName,AttCeiling*sizeof(string));MaxAttValNo = (short*) realloc(MaxAttValNo, AttCeiling*sizeof(short));AttValName = (string **) realloc(AttValName, AttCeiling*sizeof(string *));//SpecialStatus = (char *) realloc(SpecialStatus, AttCeiling);}AttName[MaxAttNo] = string(Buffer);//SpecialStatus[MaxAttNo] = 0;MaxAttValNo[MaxAttNo] = 0;ValCeiling = 100;AttValName[MaxAttNo] = (string *) calloc(ValCeiling, sizeof(string));do{if ( ! ( ReadName(Nf, Buffer) ) )Error(2, AttName[MaxAttNo], "");if ( ++MaxAttValNo[MaxAttNo] >= ValCeiling ){ValCeiling += 100;AttValName[MaxAttNo] =(string *) realloc(AttValName[MaxAttNo], ValCeiling*sizeof(string));}AttValName[MaxAttNo][MaxAttValNo[MaxAttNo]] = string(Buffer);}while ( Delimiter == ',' );if ( MaxAttValNo[MaxAttNo] == 1 ){/* Check for special treatment */if (!strcmp(Buffer, "continuous") ){//MaxContAttNo++;}else{/* Cannot have only one discrete value for an attribute */ Error(3, AttName[MaxAttNo], "");}MaxAttValNo[MaxAttNo] = 0;}else if ( MaxAttValNo[MaxAttNo] > MaxDiscrValNo )MaxDiscrValNo = MaxAttValNo[MaxAttNo];}fclose(Nf);}bool PredictClass::ReadName(FILE *f,char *Buffer){register char *Sp=Buffer;register int c;while ( ( c = getc(f) ) == '|' || space(c) ){if ( c == '|' )SkipComment;}if ( c == EOF ){Delimiter = EOF;return false;}//读数据while ( c != ':' && c != ',' && c != '\n' && c != '|' && c != EOF ) {if ( c == '.' ){if ( ( c = getc(f) ) == '|' || space(c) ) //遇到‘。

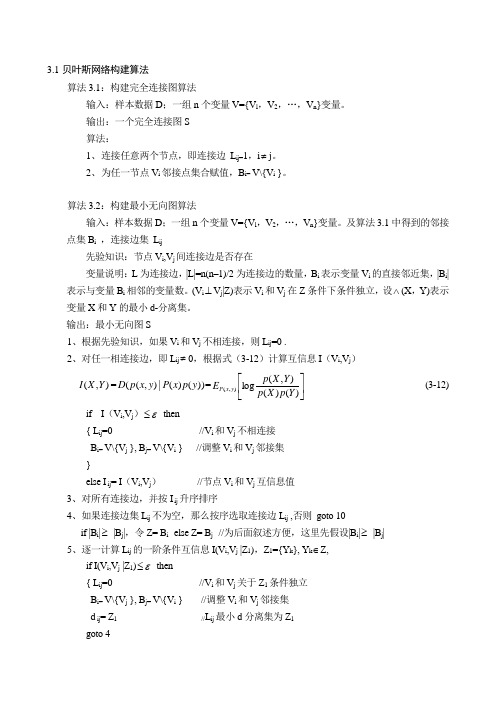

贝叶斯网络构建算法

3.1 贝叶斯网络构建算法算法3.1:构建完全连接图算法输入:样本数据D ;一组n 个变量V={V l ,V 2,…,V n }变量。

输出:一个完全连接图S算法:1、 连接任意两个节点,即连接边 L ij=1,i ≠j 。

2、 为任一节点V i 邻接点集合赋值,B i= V\{V i }。

算法3.2:构建最小无向图算法输入:样本数据D ;一组n 个变量V={V l ,V 2,…,V n }变量。

及算法3.1中得到的邻接点集B i ,连接边集 L ij先验知识:节点V i ,V j 间连接边是否存在变量说明:L 为连接边,|L|=n(n –1)/2为连接边的数量,B i 表示变量V i 的直接邻近集,|B i |表示与变量B i 相邻的变量数。

(V i ⊥V j |Z)表示V i 和V j 在Z 条件下条件独立,设∧(X ,Y)表示变量X 和Y 的最小d-分离集。

输出:最小无向图S1、根据先验知识,如果V i 和V j 不相连接,则L ij =0 .2、对任一相连接边,即L ij ≠0,根据式(3-12)计算互信息I (V i ,V j )),(Y X I =))()(|),((y p x P y x p D =⎥⎦⎤⎢⎣⎡)()(),(log ),(Y p X p Y X p E y x P (3-12) if I (V i ,V j )ε≤ then{ L ij =0 //V i 和V j 不相连接B i= V\{V j }, B j= V\{V i } //调整V i 和V j 邻接集}else I ij = I (V i ,V j ) //节点V i 和V j 互信息值3、对所有连接边,并按I ij 升序排序4、如果连接边集L ij 不为空,那么按序选取连接边L ij ,否则 goto 10 if |B i |≥ |B j |,令Z= B i else Z= B j //为后面叙述方便,这里先假设|B i |≥ |B j |5、逐一计算L ij 的一阶条件互信息I(V i ,V j |Z 1),Z 1={Y k }, Y k ∈Z,if I(V i ,V j |Z 1)ε≤ then{ L ij =0 //V i 和V j 关于Z 1条件独立B i= V\{V j }, B j= V\{V i } //调整V i 和V j 邻接集d ij = Z 1 //L ij 最小d 分离集为Z 1goto 4}elseif I ij> I(V i,V j |Z1) then I ij= I(V i,V j |Z1)6、逐一计算L ij的二阶条件互信息I(V i,V j |Z1),Z2=Z\{Y k, Y l },其中Y k ,Y l∈Z, k≠l if I(V i,V j |Z2)ε≤then{ L ij=0 //V i和V j关于Z2条件独立B i= V\{V j }, B j= V\{V i } //调整V i和V j邻接集d ij= Z1 //L ij最小d分离集为Z2goto 4}elseif I ij> I(V i,V j |Z2) then I ij= I(V i,V j |Z2)7、逐一计算L ij的n-1阶条件互信息I(V i,V j |Z n-1),Z n-1=Z\{Y k}, Y k∈Zif I(V i,V j | Z n-1)ε≤then{ L ij=0 //V i和V j关于Z n-1条件独立B i= V\{V j }, B j= V\{V i } //调整V i和V j邻接集d ij= Z n-1 //L ij最小d分离集为Z n-1goto 4}elseif I ij> I(V i,V j | Z n-1) then I ij= I(V i,V j | Z n-1)8、逐一计算L ij的n阶条件互信息I(V i,V j |Z ni),Z ni=B iif I(V i,V j | Z ni)ε≤then{ L ij=0 //V i和V j关于Z ni条件独立B i= V\{V j }, B j= V\{V i } //调整V i和V j邻接集d ij= Z ni //L ij最小d分离集为Z nigoto 4}elseif I ij> I(V i,V j | Z ni) then I ij= I(V i,V j | Z ni)9、逐一计算L ij的n阶条件互信息I(V i,V j |Z nj),Z nj=B jif I(V i,V j | Z nj)ε≤then{ L ij=0 //V i和V j关于Z nj条件独立B i= V\{V j }, B j= V\{V i } //调整V i和V j邻接集d ij= Z nj //L ij最小d分离集为Z nj}elseif I ij> I(V i,V j | Z nj) then I ij= I(V i,V j | Z nj)goto 410、对于2中得到的不相连接边L ij=0if |B i|≥|B j|,令d ij= B i else d ij= B j //为L ij赋最小d分离集算法3.3:基于规则一的最小无向图边定向算法输入:样本数据D;一组n个变量V={V l,V2,…,V n}变量。

贝叶斯网络结构学习总结

贝叶斯网络结构学习总结贝叶斯网络构造学习总结本文关键词:构造,学习,网络,贝叶斯贝叶斯网络构造学习总结本文简介:贝叶斯网络构造学习总结一、贝叶斯网络构造学习的原理从数据中学习贝叶斯网络构造就是对给定的数据集,找到一个与数据集拟合最好的网络。

首先定义一个随机变量,表示网络构造的不确定性,并给予先验概率分布。

然后计算后验概率分布。

依据Bayesian定理有其中是一个与构造无关的正规化常数,是边界似然。

于是确定网络贝叶斯网络构造学习总结本文内容:贝叶斯网络构造学习总结一、贝叶斯网络构造学习的原理从数据中学习贝叶斯网络构造就是对给定的数据集,找到一个与数据集拟合最好的网络。

首先定义一个随机变量,表示网络构造的不确定性,并给予先验概率分布。

然后计算后验概率分布。

依据Bayesian定理有其中是一个与构造无关的正规化常数,是边界似然。

于是确定网络构造的后验分布只须要为每一个可能的构造计算数据的边界似然。

在无约束多项分布、参数独立、采纳Dirichlet先验和数据完整的前提下,数据的边界似然正好等于每一个〔i,j〕对的边界似然的乘积,即二、贝叶斯网络完整数据集下构造学习方法贝叶斯网络建模一般有三种方法:1〕依靠专家建模;2〕从数据中学习;3〕从学问库中创立。

在实际建模过程中时时综合运用这些方法,以专家学问为主导,以数据库和学问库为协助手段,扬长避短,发挥各自优势,来保证建模的效率和精确性。

但是,在不具备专家学问或学问库的前提下,从数据中学习贝叶斯网络模型构造的探究显得尤为重要。

常用的构造学习方法主要有两类,分别是基于依靠性测试的学习和基于搜寻评分的学习。

第一类方法是基于依靠性测试的方法,它是在给定数据集D中评估变量之间的条件独立性关系,构建网络构造。

基于条件独立测试方法学习效率最好,典型的算法包括三阶段分析算法〔TPDA〕。

基于依靠性测试的方法比拟直观,贴近贝叶斯网络的语义,把条件独立性测试和网络构造的搜寻分别开,缺乏之处是对条件独立性测试产生的误差特别敏感。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

}

// build the network structure initStructure(); //初始化贝叶斯网络

// build the network structure buildStructure(); //根据实际的训练数据,设置每个属性节点的父节点

// build the set of CPTs estimateCPTs(); //根据已经创建好的贝叶斯网络,再一次根据实际的训练数据,获得每个属 性节点下的属性值,在不同的父节点组合情况下的出现次数的统计。

// reserve memory m_ParentSets = new ParentSet[m_Instances.numAttributes()]; // m_Instances.numAttributes()返回的是训练数据的实际属性个数,包括了目标属性在内。 m_ParentSets 是表示所有属性节点的父节点,比如性别属性,如果性别属性id是4,那么 m_ParentSets[4]就存储的是性别属性节点的父节点

iAttribute++) { int iNode = initialNet.getNode(bayesNet.getNodeName(iAttribute)); for (int iParent = 0; iParent <

initialNet.getNrOfParents(iAttribute);iParent++) { String sParent =

ignored. It is found in initial network but not in data set."); }

} } } else if (m_bInitAsNaiveBayes) { //这个if也不会执行,因为选择的是贝叶斯网络,所 以不会用朴素贝叶斯来完成。 int iClass = instances.classIndex(); // initialize parent sets to have arrow from classifier node to // each of the other nodes for (int iAttribute = 0; iAttribute < instances.numAttributes(); iAttribute++) {

//下面这个if语句可以略去,因为它表示是否有已经构建好的贝叶斯网络图文件,如果有,直接 读入完成贝叶斯网络的构建。但是weka中是么有的。而且实际大的贝叶斯网络也很少有专家指导直接 只用子父类关系图的。

if (m_sInitalBIFFile != null && !m_sInitalBIFFile.equals("")) { BIFReader initialNet = new BIFReader().processFile(m_sInitalBIFFile); for (int iAttribute = 0; iAttribute < instances.numAttributes();

-------------------------------------------------------------------------//K2 类中的 search 函数,K2 继承了 LocalScoreSearchAlgorithm 类,LocalScoreSearchAlgorithm 继承了 SearchAlgorithm 类 public void search (BayesNet bayesNet, Instances instances) throws Exception {

initialNet.getNodeName(initialNet.getParent(iNode, iParent)); int nParent = 0; while (nParent < bayesNet.getNrOfNodes()

&& !bayesNet.getNodeName(nParent).equals(sParent)) { nParent++;

nAttribute++;

}

//

m_nOrder[iOrder] = nAttribute++;

}//上面这个for循环其实在这个函数中一点用都没有,而且贝叶斯分类的默认目标分类属性,是

训练数据中的最后一个属性,所以该for循环中判断毫无作用,且nAttribute这个参数在这个函数内

也没有被实际使用

2

版权所有,仿冒必究-------全同学

//ParentSet这个类的构造函数

public ParentSet(int nMaxNrOfParents) { m_nParents = new int[nMaxNrOfParents];//创建一个长度为训练数据属

性个数的数组,用来存储当前节点的所有可能父节点

for (int iAttribute = 0; iAttribute < m_Instances.numAttributes(); iAttribute++) {//java中的数据实例化风格,需要每个元素都单独实例化。

m_ParentSets[iAttribute] = new ParentSet(m_Instances.numAttributes());

类,buildStructure也是SearchAlgorithm这个类的函数。 } // buildStructure

------------------------------------------------------------------------//SearchAlgorithm 类中的 buildStructure 函数 public void buildStructure(BayesNet bayesNet, Instances instances) throws Exception {

iesNet.getParentSet(iAttribute).addParent(iClass, instances);

} } } search(bayesNet, instances); //search算法是实际子类中实现的,及K2这个类中的search函数 if (m_bMarkovBlanketClassifier) { doMarkovBlanketCorrection(bayesNet, instances); } } // buildStructure

// Copy the instances m_Instances = new Instances(instances);//给本类自己的成员变量

// sanity check: need more than 1 variable in datat set m_NumClasses = instances.numClasses();//这个函数主要返回目标分类的属性具体的属性 值的个数,比如我们要对性别进行分类,那么性别在训练数据中的属性值只有男和女,那么属性值的 个数就是2,同理,如果我们要对国际分类,也要看国际在训练数据中具体的属性值的种类有多少个。

1

版权所有,仿冒必究-------全同学

// initialize ADTree

if (m_bUseADTree) {//weka里默认是是false

m_ADTree = ADNode.makeADTree(instances);

//

System.out.println("Oef, done!");

public void initStructure() throws Exception { int nAttribute = 0;

for (int iOrder = 1; iOrder < m_Instances.numAttributes(); iOrder++) {

if (nAttribute == m_Instances.classIndex()) {

} if (nParent< bayesNet.getNrOfNodes()) {

bayesNet.getParentSet(iAttribute).addParent(nParent, instances);

3

版权所有,仿冒必究-------全同学

} else { System.err.println("Warning: Node " + sParent + " is

// Save space // m_Instances = new Instances(m_Instances, 0); m_ADTree = null;

补充介绍对测试数据进行实际分类的函数:distributionForInstance

BayesNet 类中的 initStructure 函数介绍: initStructure(); //初始化贝叶斯网络

m_nNrOfParents = 0;//当前的父节点的个数 m_nCardinalityOfParents = 1;//当前包含父节点属性值的组合个数。这里

设置为1,是为了方便后面当出现多个父节点后的组合条件,如何在一维数组中表示

}

} }

BayesNet 类中的 buildStructure 函数介绍: buildStructure(); //根据实际的训练数据,设置每个属性节点的父节点

具体的代码和函数为: BayesNet 的主要函数,buildClassifier

buildClassifier 函数

// remove instances with missing class instances = new Instances(instances); instances.deleteWithMissingClass();//这个函数主要是通过训练每个实例,检查是否包含 要分类的那个属性,比如现在要对国家进行分类,但是发现某条实例数据内,没有国家这个属性,那 么这个实例就不能参与到实际的模型训练中,就要删除掉;但是该函数的实际方法是将可用的实例单 独存储,最后在直接赋值替换。(实际是把有值的部分copy出来)