k-Means-Clustering

stata 多变量k均值聚类

stata 多变量k均值聚类详解在Stata中,进行多变量k均值聚类(k-means clustering)涉及使用`kmeans`命令。

这个命令用于将观测值划分为给定数量的簇,以便最小化簇内变量的平方和。

以下是在Stata中进行多变量k均值聚类的基本步骤:1. 加载数据:首先,确保你已经加载了你的数据集。

```statause your_dataset```2. 选择变量:选择你想要用于聚类的多个变量。

```statakeep var1 var2 var3```3. 标准化变量(可选):对于k均值聚类,通常建议对变量进行标准化,以确保它们在相同的尺度上。

你可以使用`standardize`命令。

```statastandardize var1 var2 var3, replace```4. 运行k均值聚类:使用`kmeans`命令来运行k均值聚类。

```statakmeans var1 var2 var3, k(number_of_clusters)```请将`number_of_clusters`替换为你想要的簇的数量。

5. 查看聚类结果:使用`cluster`命令来查看每个观测值被分配到哪个簇。

```statacluster kmeans, clusterid(cluster_variable)```请将`cluster_variable`替换为包含簇分配的新变量的名称。

6. 可视化聚类结果(可选):你可以使用各种图表和可视化工具来展示聚类结果。

```statascatter var1 var2, mcolor(cluster_variable)```这将在散点图上用不同的颜色显示不同的簇。

请注意,以上步骤是一个基本的框架。

你可能需要根据你的具体数据和研究问题进行一些调整。

此外,k均值聚类的结果可能会受到初始聚类中心的选择影响,因此你可能需要多次运行并比较不同结果。

记得查看Stata的帮助文件以获取更详细的信息:```statahelp kmeanshelp cluster```。

k-Means-Clustering

合肥工业大学—数学建模组k-Means ClusteringOn this page…Introduction to k-Means Clustering Create Clusters and Determine Separation Determine the Correct Number of Clusters Avoid Local MinimaIntroduction to k-Means Clusteringk-means clustering is a partitioning method. The function kmeans partitions data into k mutuallyexclusive clusters, and returns the index of the cluster to which it has assigned each observation. Unlike hierarchical clustering, k-means clustering operates on actual observations (rather than the larger set of dissimilarity measures), and creates a single level of clusters. The distinctions mean that k-means clustering is often more suitable than hierarchical clustering for large amounts of data.kmeans treats each observation in your data as an object having a location in space. It finds apartition in which objects within each cluster are as close to each other as possible, and as far from objects in other clusters as possible. You can choose from five different distance measures, depending on the kind of data you are clustering.Each cluster in the partition is defined by its member objects and by its centroid, or center. The centroid for each cluster is the point to which the sum of distances from all objects in that clusteris minimized. kmeanscomputes cluster centroids differently for each distance measure, tominimize the sum with respect to the measure that you specify.kmeans uses an iterative algorithm that minimizes the sum of distances from each object to itscluster centroid, over all clusters. This algorithm moves objects between clusters until the sum cannot be decreased further. The result is a set of clusters that are as compact and well-separated as possible. You can control the details of the minimization using several optional inputparameters to kmeans, including ones for the initial values of the cluster centroids, and for themaximum number of iterations.Create Clusters and Determine SeparationThe following example explores possible clustering in four-dimensional data by analyzing the results of partitioning the points into three, four, and five clusters.Note Because each part of this example generates random numbers sequentially, i.e., without setting a new state, you must perform all steps in sequence to duplicate the results shown. If you perform the steps out of sequence, the answers will be essentially the same, but the intermediate results, number of iterations, or ordering of the silhouette plots may differ.王刚合肥工业大学—数学建模组 First, load some data:rng('default'); % For reproducibility load kmeansdata; size(X) ans =560 4 Even though these data are four-dimensional, and cannot be easily visualized, kmeans enables you to investigate whether a group structure exists in them. Call kmeans with k, the desired number of clusters, equal to 3. For this example, specify the city block distance measure, and usethe default starting method of initializing centroids from randomly selected data points.idx3 = kmeans(X,3,'distance','city');To get an idea of how well-separated the resulting clusters are, you can make a silhouette plotusing the cluster indices output from kmeans. The silhouette plot displays a measure of howclose each point in one cluster is to points in the neighboring clusters. This measure ranges from +1, indicating points that are very distant from neighboring clusters, through 0, indicating points that are not distinctly in one cluster or another, to -1, indicating points that are probably assignedto the wrong cluster. silhouette returns these values in its first output. [silh3,h] = silhouette(X,idx3,'city'); set(get(gca,'Children'),'FaceColor',[.8 .8 1]) xlabel('Silhouette Value') ylabel('Cluster')王刚合肥工业大学—数学建模组From the silhouette plot, you can see that most points in the second cluster have a large silhouette value, greater than 0.6, indicating that the cluster is somewhat separated from neighboring clusters. However, the third cluster contains many points with low silhouette values, and the first contains a few points with negative values, indicating that those two clusters are not well separated.Determine the Correct Number of ClustersIncrease the number of clusters to see if kmeans can find a better grouping of the data. This time, use the optional 'display' parameter to print information about each iteration.idx4 = kmeans(X,4, 'dist','city', 'display','iter');iter phasenumsum115602077.4321511778.643131771.14201771.1Best total sum of distances = 1771.1Notice that the total sum of distances decreases at each iteration as kmeans reassigns pointsbetween clusters and recomputes cluster centroids. In this case, the second phase of the algorithm did not make any reassignments, indicating that the first phase reached a minimum after five iterations. In some problems, the first phase might not reach a minimum, but the second phase always will.A silhouette plot for this solution indicates that these four clusters are better separated than the three in the previous solution.[silh4,h] = silhouette(X,idx4,'city'); set(get(gca,'Children'),'FaceColor',[.8 .8 1]) xlabel('Silhouette Value') ylabel('Cluster')王刚合肥工业大学—数学建模组A more quantitative way to compare the two solutions is to look at the average silhouette values for the two cases.cluster3 = mean(silh3) cluster4 = mean(silh4) cluster3 =0.5352 cluster4 =0.6400Finally, try clustering the data using five clusters.idx5 = kmeans(X,5,'dist','city','replicates',5); [silh5,h] = silhouette(X,idx5,'city'); set(get(gca,'Children'),'FaceColor',[.8 .8 1]) xlabel('Silhouette Value') ylabel('Cluster') mean(silh5) ans =0.5266王刚合肥工业大学—数学建模组This silhouette plot indicates that this is probably not the right number of clusters, since two of the clusters contain points with mostly low silhouette values. Without some knowledge of howmany clusters are really in the data, it is a good idea to experiment with a range of values for k.Avoid Local MinimaLike many other types of numerical minimizations, the solution that kmeans reaches often depends on the starting points. It is possible for kmeans to reach a local minimum, wherereassigning any one point to a new cluster would increase the total sum of point-to-centroid distances, but where a better solution does exist. However, you can use theoptional 'replicates' parameter to overcome that problem. For four clusters, specify five replicates, and use the 'display' parameter to print out the finalsum of distances for each of the solutions.[idx4,cent4,sumdist] = kmeans(X,4,'dist','city',... 'display','final','replicates',5);Replicate 1, 4 iterations, total sum of distances = 1771.1. Replicate 2, 7 iterations, total sum of distances = 1771.1. Replicate 3, 8 iterations, total sum of distances = 1771.1. Replicate 4, 5 iterations, total sum of distances = 1771.1. Replicate 5, 6 iterations, total sum of distances = 1771.1. Best total sum of distances = 1771.1王刚合肥工业大学—数学建模组In this example, kmeans found the same minimum in all five replications. However, even forrelatively simple problems, nonglobal minima do exist. Each of these five replicates began from adifferent randomly selected set of initial centroids, so sometimes kmeans finds more than one local minimum. However, the final solution that kmeans returns is the one with the lowest totalsum of distances, over all replicates.sum(sumdist) ans =1.7711e+03王刚。

kmeans文献

K均值聚类算法(K-means clustering algorithm)是一种常用的无监督机器学习算法,常用于将数据集划分成具有相似特征的类别。

K均值聚类算法的核心思想是根据样本之间的相似性(距离)将样本划分到不同的类别中,使得同一类别内的样本相似度最大,不同类别之间的样本相似度最小。

下面是一些关于K均值聚类算法的相关参考文献,讨论了K均值聚类算法的性质、改进方法以及在实际应用中的应用情况。

1.“A Comparative Study on K-means Algorithm” (2004) by M. Hamerlyand C. Elkan. 该文献通过对K均值算法进行了深入的研究,探讨了不同初始点对聚类效果的影响,同时比较了K均值算法与其他聚类算法的性能。

2.“K-means++: The Advantages of Careful Seeding” (2007) by D. Arthurand S. Vassilvitskii. 该文献提出了一种改进的K均值算法初始点选择方法,称为K-means++。

通过使用K-means++方法选择初始点,可以更快地收敛到全局最优解。

3.“A Kernel K-means Clustering Algorithm” (2004) by I. Gath and A. B.Geva. 该文献提出了一种基于核函数的K均值聚类算法,在处理非线性数据时表现出色。

通过将样本数据映射到高维特征空间,可以更好地解决非线性聚类问题。

4.“Robust K-means Clustering with Outliers” (2004) by C. C. Aggarwaland P. S. Yu. 该文献讨论了K均值聚类算法在存在离群点(outliers)情况下的性能问题,并提出了一种鲁棒性更强的K均值聚类算法。

5.“A Comparative Study of K-means Variants on Clustering Algorithm”(2012) by N. K. Jha and S. C. Tripathy. 该文献对多种K均值聚类算法进行了比较研究,包括K-means、K-medoids、K-harmonic means等,分析了它们在不同数据集上的性能差异。

k-means的卡林斯基-哈拉巴斯系数

K-均值聚类(k-means clustering)是一种常用的聚类算法,它可以有效地将数据点划分为不同的群集。

而卡林斯基-哈拉巴斯系数(Calinski-Harabasz index)则是评估k-means聚类效果的一种指标。

本文将深入探讨卡林斯基-哈拉巴斯系数的概念、计算方法以及在实际应用中的意义。

一、卡林斯基-哈拉巴斯系数的概念卡林斯基-哈拉巴斯系数是一种用于评估k-means聚类结果的指标。

它基于聚类内部的紧密度和聚类之间的分离度来进行评估,因此可以有效地反映出聚类的紧凑程度和分离程度。

在实际应用中,通过比较不同k-means聚类结果的卡林斯基-哈拉巴斯系数,可以帮助我们选择最优的聚类数目。

二、卡林斯基-哈拉巴斯系数的计算方法1. 计算聚类内部的紧密度我们需要计算每个聚类内部的紧密度。

这可以通过计算每个数据点与其所在聚类中心的距离之和来实现。

假设Ci代表第i个聚类,N(Ci)代表Ci中的数据点数量,μ(Ci)代表Ci的中心点,则Ci内部的紧密度可以用以下公式表示:\[SS_{\text{within}}(Ci) = \sum_{x_i \in Ci}||x_i - \mu(Ci)||^2\]其中,||xi - μ(Ci)||代表数据点xi与Ci的中心点μ(Ci)之间的欧式距离。

2. 计算聚类之间的分离度接下来,我们需要计算不同聚类之间的分离度。

这可以通过计算各个聚类中心之间的距离来实现。

假设k代表聚类的数量,μ代表k个聚类的中心点集合,则聚类之间的分离度可以用以下公式表示:\[SS_{\text{between}} = \sum_{i=1}^{k} N(Ci) \cdot ||\mu(Ci) -\mu||^2\]其中,||μ(Ci) - μ||代表第i个聚类中心点μ(Ci)与整体中心点μ之间的欧式距离。

3. 计算卡林斯基-哈拉巴斯系数通过将聚类内部的紧密度和聚类之间的分离度作为分子和分母,就可以计算出卡林斯基-哈拉巴斯系数。

kmeans肘部法则

kmeans肘部法则

K-means clustering是一种常见的聚类方法,它将样本数据划分为k个不同的簇。

在使用k-means算法时,我们需要选择k的值,也就是要分成几个簇。

这个选择通常使用肘部法则来帮助决定。

肘部法则可以帮助我们选择最佳的k值,它基于计算簇内平方和(SSE)与簇数量的关系。

SSE是指每个数据点到其所属簇的质心的距离平方和,它是衡量簇内数据点的离散度的重要指标。

随着K 值逐渐增加,簇内的人均平方和也会逐渐减小。

当添加更多的簇时,SSE 的下降速度会逐渐变慢,这个点所在的K 值即被称为" 肘 "点。

在进行k-means聚类时,可以从k=1开始,逐渐增加k值,并计算每个k值下的SSE。

我们可以使用SSE绘制图表来观察SSE与k的关系,并观察到在某个k值下SSE的变化开始变缓,这个点就是肘点。

肘部法则的重点是找到拐点,拐点在图表中看起来像一个手肘,因此称为“肘部”。

在这个点之后,再增加簇的数量将带来较少的好处,而增加误差因素和复杂度的增加很可能会对聚类结果产生负面影响。

具体实施时,可以在关键值左右进行探索,以确保选择的k值是最优的。

然而,在数据极端值较多和数据分布不正常的情况下,可能不适合使用肘部法则。

因为在这种情况下,SSE可能在一个较宽的范围内变化,这样就难以确定k的最佳值。

总之,k-means聚类是一个非常有用的算法,它可以将数据划分为不同的簇。

在进行聚类时,使用肘部法则可以帮助我们选择最优的k 值,从而获得更好的聚类效果。

但需要注意不同数据可以有不同的特点,所以具体情况还需要具体分析。

k均值聚类算法例题

k均值聚类算法例题k均值聚类(k-means clustering)是一种常用的无监督学习算法,用于将一组数据分成k个不同的群集。

本文将通过例题的方式介绍k均值聚类算法,并提供相关参考内容。

例题:假设有一组包含10个点的二维数据集,需要将其分成3个不同的群集。

我们可以使用k均值聚类算法来解决这个问题。

步骤1:初始化聚类中心首先,从数据集中随机选择k个点作为初始聚类中心。

在这个例题中,我们选择3个点作为初始聚类中心。

步骤2:分配数据点到最近的聚类中心对于每个数据点,计算其与每个聚类中心的距离,并将其分配到最近的聚类中心。

距离的计算通常使用欧几里得距离(Euclidean distance)。

步骤3:更新聚类中心对于每个聚类,计算其所有数据点的平均值,并将该平均值作为新的聚类中心。

步骤4:重复步骤2和步骤3重复执行步骤2和步骤3,直到聚类中心不再改变或达到预定的迭代次数。

参考内容:1. 《机器学习实战》(Machine Learning in Action)- 书中的第10章介绍了k均值聚类算法,并提供了相应的Python代码实现。

该书详细介绍了k均值聚类算法的原理、实现步骤以及应用案例,是学习和理解k均值聚类的重要参考书籍。

2. 《Pattern Recognition and Machine Learning》- 该书由机器学习领域的权威Christopher M. Bishop撰写,在第9章介绍了k均值聚类算法。

书中详细介绍了k均值聚类的数学原理,从最优化的角度解释了算法的过程,并提供了相关代码示例。

3. 《数据挖掘导论》(Introduction to Data Mining)- 该书由数据挖掘领域的专家Pang-Ning Tan、Michael Steinbach和Vipin Kumar合著,在第10章中介绍了k均值聚类算法及其变体。

该书提供了理论和应用层面的讲解,包括如何选择最佳的k值、处理异常值和空值等问题。

r语言的kmeans方法

r语言的kmeans方法R语言中的k均值聚类方法(k-means clustering)是一种常用的无监督学习方法,用于将数据集划分为K个不相交的类别。

本文将详细介绍R语言中的k均值聚类算法的原理、使用方法以及相关注意事项。

原理:k均值聚类算法的目标是将数据集划分为K个簇,使得同一簇内的样本点之间的距离尽可能小,而不同簇之间的距离尽可能大。

算法的基本思想是:首先随机选择K个初始质心(簇的中心点),然后将每个样本点分配到与其最近的质心所在的簇中。

接下来,计算每个簇的新质心,再次将每个样本点重新分配到新的质心所在的簇中。

不断重复这个过程,直到质心不再发生变化或达到最大迭代次数。

最终,得到的簇就是我们需要的聚类结果。

实现:在R语言中,我们可以使用kmeans(函数来实现k均值聚类。

该函数的基本用法如下:kmeans(x, centers, iter.max = 10, nstart = 1)-x:要进行聚类的数据集,可以是矩阵、数据框或向量。

- centers:指定聚类的个数K,即要划分为K个簇。

- iter.max:迭代的最大次数,默认为10。

- nstart:进行多次聚类的次数,默认为1,选取最优结果。

聚类结果:聚类的结果包含以下内容:- cluster:每个样本所属的簇的编号。

- centers:最终每个簇的质心坐标。

- tot.withinss:簇内平方和,即同一簇内各个样本点到质心的距离总和。

示例:为了更好地理解k均值聚类的使用方法,我们将通过一个具体的示例来进行演示:```R#生成示例数据set.seed(123)x <- rbind(matrix(rnorm(100, mean = 0), ncol = 2),matrix(rnorm(100, mean = 3), ncol = 2))#执行k均值聚类kmeans_res <- kmeans(x, centers = 2)#打印聚类结果print(kmeans_res)```上述代码中,我们首先生成了一个包含两个簇的示例数据集x(每个簇100个样本点),然后使用kmeans(函数进行聚类,指定了聚类的个数为2、最后,通过print(函数来打印聚类的结果。

k均值分类

k均值分类(原创实用版)目录1.K 均值分类简介2.K 均值分类原理3.K 均值分类步骤4.K 均值分类应用实例5.K 均值分类优缺点正文1.K 均值分类简介K 均值分类(K-means Clustering)是一种基于划分的聚类方法,它是通过将数据集划分为 K 个不同的簇(cluster),使得每个数据点与其所属簇的中心点(均值)距离最小。

这种方法被广泛应用于数据挖掘、模式识别以及图像处理等领域。

2.K 均值分类原理K 均值分类的原理可以概括为以下两个步骤:(1)初始化:首先选择 K 个数据点作为初始簇的中心点。

这些中心点可以是随机选择的,也可以是通过一定方法进行选择的。

(2)迭代:计算每个数据点与各个簇中心点的距离,将数据点划分到距离最近的簇。

然后重新计算每个簇的中心点,并重复上述过程,直至中心点不再发生变化。

3.K 均值分类步骤K 均值分类的具体步骤如下:(1)确定 K 值:根据数据特点和需求确定聚类的数量 K。

(2)初始化中心点:随机选择 K 个数据点作为初始簇的中心点,也可以通过一定方法进行选择。

(3)计算距离:计算每个数据点与各个簇中心点的距离。

(4)划分簇:将数据点划分到距离最近的簇。

(5)更新中心点:重新计算每个簇的中心点。

(6)迭代:重复步骤(3)至(5),直至中心点不再发生变化。

4.K 均值分类应用实例K 均值分类在许多领域都有广泛应用,例如在图像处理中,可以将图像划分为不同的区域,以便进行后续的处理;在数据挖掘中,可以将客户划分为不同的群体,以便进行精准营销。

5.K 均值分类优缺点优点:(1)简单、易于理解;(2)可以应用于大规模数据集;(3)不需要先验知识。

k-平均算法

k-均值起源于信号处理领域,并且现在也能在这一领域找到应用。

例如在计算机图形学中,色彩量化的任务,就是要把一张图像的色彩范围减少到一个固定的数目k上来。

k-均值算法就能很容易地被用来处理这一任务,并得到不错的结果。

其它得向量量化的例子有非随机抽样,在这里,为了进一步的分析,使用k-均值算法能很容易的从大规模数据集中选出k个合适的不同观测。

聚类分析在聚类分析中,k-均值算法被用来将输入数据划分到k个部分(聚类)中。

然而,纯粹的k-均值算法并不是非常灵活,同样地,在使用上有一定局限(不过上面说到得向量量化,确实是一个理想的应用场景)。

特别是,当没有额外的限制条件时,参数k是很难选择的(真如上面讨论过的一样)。

算法的另一个限制就是它不能和任意的距离函数一起使用、不能处理非数值数据。

而正是为了满足这些使用条件,许多其他的算法才被发展起来。

特征学习在(半)监督学习或无监督学习中,k-均值聚类被用来进行特征学习(或字典学习)步骤[18]。

基本方法是,首先使用输入数据训练出一个k-均值聚类表示,然后把任意的输入数据投射到这一新的特征空间。

k-均值的这一应用能成功地与自然语言处理和计算机视觉中半监督学习的简单线性分类器结合起来。

在对象识别任务中,它能展现出与其他复杂特征学习方法(如自动编码器、受限Boltzmann机等)相当的效果。

然而,相比复杂方法,它需要更多的数据来达到相同的效果,因为每个数据点都只贡献了一个特征(而不是多重特征)。

与其他统计机器学习方法的关系k-均值聚类,以及它与EM算法的联系,是高斯混合模型的一个特例。

很容易能把k-均值问题一般化为高斯混合模型[19]。

另一个k-均值算法的推广则是k-SVD算法,后者把数据点视为“编码本向量”的稀疏线性组合。

而k-均值对应于使用单编码本向量的特殊情形(其权重为1)[20]。

Mean Shift 聚类基本的Mean Shift聚类要维护一个与输入数据集规模大小相同的数据点集。

kmean算法实例

kmean算法实例英文回答:K-means clustering is a widely used unsupervised learning algorithm that partitions a set of data points into a specified number of clusters. The goal is to find clusters with high intra-cluster similarity and low inter-cluster similarity.The K-means algorithm works as follows:1. Initialization: Randomly select K cluster centroids from the dataset.2. Assignment: Assign each data point to the cluster with the closest centroid.3. Update: Recalculate the cluster centroids as the mean of the data points assigned to each cluster.4. Repeat: Repeat steps 2 and 3 until the cluster centroids no longer change or a predefined number of iterations is reached.The choice of K, the number of clusters, is crucial and can be determined using techniques like the elbow method or silhouette coefficient.Here is an example of K-means clustering:Suppose we have a dataset of customer spending habits and want to segment customers into three clusters: low spenders, moderate spenders, and high spenders. We can use K-means clustering with K=3 to achieve this.1. Initialization: Randomly select three customers as the initial cluster centroids.2. Assignment: Assign each customer to the cluster with the closest centroid based on their spending habits.3. Update: Recalculate the centroids of the threeclusters as the mean spending habits of the customers in each cluster.4. Repeat: Repeat steps 2 and 3 until the centroids no longer change.After running the K-means algorithm, we will have three clusters of customers with similar spending habits. These clusters can be used for targeted marketing campaigns or to identify customers at risk of churn.中文回答:k均值算法。

聚类分割算法

聚类分割算法聚类分割算法是一类常用于将数据集划分成具有相似特征的子集的方法。

这些算法主要用于无监督学习,即在没有先验标签的情况下,自动发现数据集内在的模式。

以下是一些常见的聚类分割算法:1. K均值聚类(K-Means Clustering):- K均值是最常见的聚类算法之一。

它将数据集分为K个簇,每个簇由其质心表示。

算法的目标是使每个数据点到其所属簇的质心的距离最小化。

2. 层次聚类(Hierarchical Clustering):-层次聚类根据数据点之间的相似性构建树状结构。

可以通过聚合或分割来创建簇。

分为凝聚式层次聚类(自底向上)和分裂式层次聚类(自顶向下)。

3. DBSCAN(Density-Based Spatial Clustering of Applications with Noise):- DBSCAN基于密度的聚类算法,能够发现具有足够密度的区域,并将稀疏区域视为噪声。

它不需要预先指定簇的数量。

4. Mean Shift聚类:- Mean Shift是一种基于梯度上升的聚类算法。

它通过不断迭代调整数据点的位置,使其移向密度最大的区域,从而找到簇的中心。

5. OPTICS(Ordering Points To Identify the Clustering Structure):- OPTICS是一种基于密度的聚类算法,类似于DBSCAN,但允许在数据集中存在不同密度的区域,并通过产生一系列密度相关的点来表示簇。

6. 谱聚类(Spectral Clustering):-谱聚类利用数据集的谱信息,通过将数据投影到低维子空间来执行聚类。

它在处理非凸形状的簇和图分割问题时效果较好。

7. 模糊聚类(Fuzzy Clustering):-模糊聚类考虑了数据点与簇的隶属度,而不是将每个数据点硬性地分配到一个簇。

模糊c均值(FCM)是模糊聚类的一个典型算法。

这只是聚类分割算法的一小部分,每个算法都有其适用的场景和限制。

kmeans算法公式

kmeans算法公式K均值聚类算法(K-means clustering algorithm)是一种常用的无监督学习算法,用于将一组数据点划分为K个不同的组或聚类。

该算法的目标是最小化数据点与其所属聚类中心之间的平方距离。

算法步骤如下:1. 随机选择K个数据点作为初始聚类中心。

2. 将每个数据点分配给距离最近的聚类中心。

3. 更新每个聚类中心的位置,将其设为该聚类中所有点的均值。

4. 重复步骤2和3,直到聚类中心不再改变或达到最大迭代次数。

具体而言,K均值算法可用以下公式表示:1. 选择K个聚类中心:C = {c1, c2, ..., ck}其中,ci表示第i个聚类中心。

2. 分配数据点到最近的聚类中心:使用欧氏距离作为度量衡量数据点xi与聚类中心cj之间的距离:dist(xi, cj) = sqrt((xi1 - cj1)^2 + (xi2 - cj2)^2 + ... + (xid - cjd)^2)其中,d表示数据点的维度。

将每个数据点xi分配给最近的聚类中心:ci = arg minj(dist(xi, cj))3. 更新聚类中心的位置:计算每个聚类中心包含的数据点的均值,作为新的聚类中心的位置。

cj = (1/|ci|) * sum(xi)其中,|ci|表示聚类中心ci包含的数据点数量,sum(xi)表示所有聚类中心ci包含的数据点xi的和。

4. 重复步骤2和3,直到聚类中心不再改变或达到最大迭代次数。

K均值算法的优点是简单而高效,适用于大规模数据集。

然而,它也存在一些限制,比如对初始聚类中心的敏感性和对数据点分布的假设(即聚类簇的凸性)。

此外,当数据点的维度较高时,K均值算法的性能可能下降。

参考内容:- Christopher M. Bishop, "Pattern Recognition and Machine Learning". Springer, 2006.- Richard O. Duda, Peter E. Hart, David G. Stork, "Pattern Classification". Wiley, 2001.- Machine Learning, Tom Mitchell, "Machine Learning". McGraw-Hill, 1997.- Kevin P. Murphy, "Machine Learning: A Probabilistic Perspective". MIT Press, 2012.- Sebastian Raschka, Vahid Mirjalili, "Python Machine Learning". Packt Publishing, 2017.这些参考内容提供了对K均值算法的详细解释、数学推导和实际应用示例,对于深入理解和使用该算法非常有帮助。

简述k均值聚类的实现步骤

k均值聚类的实现步骤1. 简介k均值聚类(k-means clustering)是一种常用的无监督学习算法,用于将数据集划分为k个不重叠的类别。

该算法通过寻找数据集中各个样本之间的相似性,将相似的样本归为一类,从而实现聚类分析。

2. 算法步骤k均值聚类算法主要包含以下几个步骤:步骤1:初始化首先需要确定要划分的类别数k,并随机选择k个样本作为初始聚类中心。

这些聚类中心可以是随机选择的,也可以根据领域知识或经验来确定。

步骤2:分配样本到最近的聚类中心对于每个样本,计算它与各个聚类中心之间的距离,并将其分配到距离最近的聚类中心所代表的类别。

步骤3:更新聚类中心对于每个聚类,计算该类别内所有样本的平均值,作为新的聚类中心。

步骤4:重复步骤2和步骤3重复执行步骤2和步骤3,直到满足停止条件。

停止条件可以是达到最大迭代次数、聚类中心不再发生变化等。

步骤5:输出聚类结果k均值聚类算法输出每个样本所属的类别,即完成了对数据集的聚类分析。

3. 距离度量在k均值聚类算法中,需要选择合适的距离度量方法来计算样本之间的相似性。

常用的距离度量方法包括欧氏距离、曼哈顿距离和余弦相似度等。

欧氏距离欧氏距离是最常用的距离度量方法之一,它表示两个点在n维空间中的直线距离。

假设有两个点A(x1, y1)和B(x2, y2),则它们之间的欧氏距离为:d(A, B) = sqrt((x2 - x1)^2 + (y2 - y1)^2)曼哈顿距离曼哈顿距离是另一种常用的距离度量方法,它表示两个点在n维空间中沿坐标轴方向的绝对差值之和。

假设有两个点A(x1, y1)和B(x2, y2),则它们之间的曼哈顿距离为:d(A, B) = |x2 - x1| + |y2 - y1|余弦相似度余弦相似度是用于衡量两个向量之间的相似性的度量方法,它通过计算两个向量的夹角余弦值来确定它们的相似程度。

假设有两个向量A和B,则它们之间的余弦相似度为:sim(A, B) = (A·B) / (||A|| * ||B||)其中,A·B表示向量A和向量B的内积,||A||和||B||分别表示向量A和向量B 的模长。

matlab的kmeans函数

MATLAB的kmeans函数概述在数据分析和机器学习领域,k均值聚类(k-means clustering)是一种常用的无监督学习算法,用于将一组数据点分成k个不同的簇。

在MATLAB中,我们可以使用kmeans函数来实现这一算法。

本文将详细介绍kmeans函数的使用方法以及一些相关的概念和注意事项。

kmeans函数的语法和参数在MATLAB中,我们可以使用如下的语法来调用kmeans函数:[idx, C] = kmeans(X, k);其中,输入参数X是一个m×n的矩阵,表示m个n维数据点的集合。

k是一个正整数,表示要将数据点分成k个簇。

输出参数idx是一个长度为m的向量,表示每个数据点所属的簇的索引。

输出参数C是一个k×n的矩阵,表示k个簇的中心点。

除了必需的输入参数外,kmeans函数还有许多可选的参数,用于控制聚类的细节。

下面是一些常用的可选参数:’Start’参数[idx, C] = kmeans(X, k, 'Start', start);start是一个k×n的矩阵,表示k个初始簇中心点的位置。

可以使用k-means++算法或者随机生成初始点。

’EmptyAction’参数[idx, C] = kmeans(X, k, 'EmptyAction', action);action可以是以下三种字符串之一:‘error’、‘singleton’或者’drop’。

’error’表示如果某个簇为空,则报错;’singleton’表示如果某个簇为空,则将该簇的中心点设置为当前最远的数据点;’drop’表示如果某个簇为空,则将其从聚类中删除。

’MaxIter’参数[idx, C] = kmeans(X, k, 'MaxIter', maxIter);maxIter表示算法的最大迭代次数。

当算法达到最大迭代次数后仍未收敛,将会终止。

离群值检测算法和kmeans

离群值检测算法和kmeans离群值检测算法(Outlier Detection)和K均值聚类算法(K-means Clustering)是机器学习和数据分析领域中两个不同的概念。

1. 离群值检测算法(Outlier Detection):离群值指的是在数据集中与其他样本明显不同的异常数据点。

离群值检测算法的目标是识别这些异常点,这些异常点可能是由于数据损坏、错误采样、异常行为等原因导致的。

离群值检测是一种无监督学习任务,它不需要事先有标记的异常样本。

常见的离群值检测算法包括:-基于统计方法的离群值检测算法:例如基于均值和标准差的Z-Score方法、基于箱线图的IQR方法等。

-基于距离的离群值检测算法:例如基于密度的LOF(局部异常因子)算法、基于距离阈值的DBSCAN算法等。

-基于概率模型的离群值检测算法:例如高斯混合模型(GMM)方法等。

-基于深度学习的离群值检测算法:例如自编码器(Autoencoder)方法等。

2. K均值聚类算法(K-means Clustering):K均值聚类是一种常见的无监督学习算法,用于将数据集中的样本分为K个类别或簇。

它的目标是将样本划分到K个簇中,使得每个样本与所属簇的中心(质心)的距离最小化。

K均值聚类算法的步骤如下:-随机选择K个初始质心。

-将每个样本分配到距离其最近的质心所在的簇。

-更新每个簇的质心,使其成为该簇中所有样本的平均值。

-重复上述两个步骤,直到质心不再发生显著变化或达到预定的迭代次数。

K均值聚类是一种迭代算法,结果可能受到初始质心的选择和迭代次数的影响。

它适用于数据集中簇结构明显的情况。

尽管离群值检测和K均值聚类都是无监督学习任务,但它们的目标和方法是不同的。

离群值检测是识别异常点,而K均值聚类是将数据样本划分为簇。

在实际应用中,可以将它们结合使用,对数据进行聚类后再检测离群值,以更好地理解数据的结构和异常情况。

kmeans 聚类系数

kmeans 聚类系数Kmeans聚类系数(K-MeansClusteringCoefficients)是一种常用的数据挖掘算法,它源于西班牙数学家Juan Carlos Martínez的研究,概括而言,Kmeans系数是一种用于在给定数据集中组合不相关的模式和特征的数据挖掘技术。

它旨在判断接近数据空间中存在的数据点之间的联系和它们差异的程度,以提升数据集的紧凑性和可解释性。

Kmeans系数可以通过一种叫做k-means的算法来实现。

输入的数据空间可以是任意大小的,但它必须包含至少两个属性,并且这些属性必须有一定的关联性。

算法就是根据属性中对于每个点之间的距离来将点分组,以实现最佳聚类。

具体而言,算法将数据集中的数据点相互比较并将其分为从小到大,不同的组。

同时,将参数称为“k-means系数”,它将每个组的大小缩小到最小。

Kmeans系数的优势在于它可以区分不同的模式与特征,因此有助于形成具有对比性的数据集,以及使数据集更容易分析。

因此,Kmeans系数可以用来处理模式分析、模式识别和其他相关任务,如聚类分析、社会网络分析、文本挖掘等等。

Kmeans系数有很多应用,在商业分析中,它可以用来分析营销渠道、客户以及品牌信息,分析客户行为模式,以确定客户忠诚度,发现客户最有可能购买的产品,甚至可以识别客户的价值。

此外,Kmeans系数在自然语言处理、机器学习和图像处理等领域也有大量应用。

Kmeans系数可以让数据科学家从大量混合数据中发现有用的信息,使用Kmeans系数可以开发出可重复使用的模式,这些模式可以在将来的分析工作中进行重用,从而使数据分析更加有效高效。

它在精确性和稳定性方面也有不错的表现,它可以以更少的计算量创建更稳定的模型,因此更加有效地处理大规模数据集。

总之,Kmeans系数是一种高效的数据挖掘技术,它可以帮助数据科学家从大量混合数据中发现有用的信息,它的应用可以极大地提高数据分析的准确性,有助于理解数据集的联系和它们的重要性,并为未来的数据分析提供基础。

简述k均值聚类算法的流程

简述k均值聚类算法的流程K均值聚类算法(K-meansclusteringalgorithm)是一种基于距离计算的聚类分析算法,它是一种最广泛使用的聚类算法。

K均值算法通过计算距离确定给定数据集中样本与样本之间的相似度,进而将样本分组到类似的聚类中。

K均值聚类算法的主要流程包括数据准备、类中心的初始化、类中心的计算及划分样本的四个步骤。

第一步:数据准备K均值聚类算法的最初步是准备相应的数据。

首先,数据需要有可比较的特征,可以通过某种特征空间或者属性空间来表示。

这些特征空间可以是一维、二维、三维或者多维的,既可以是数值型的,也可以是符号型的,甚至可以是混合的,但最终要转换成数值型的,以便计算距离。

第二步:类中心的初始化当算法具备相应的数据后,就可以开始计算K均值聚类算法的第二步--类中心的初始化。

在这一步,需要根据数据类型自动确定聚类的个数K,并随机选取K个对象作为初始的聚类中心,这些随机选取的对象就被视为类中心,用来代表各个聚类。

第三步:类中心的计算第三步是类中心的计算,是K均值聚类算法的核心。

这一步的目的是计算每个聚类的中心,并以此更新类中心,从而确定数据点归属的类别。

计算类中心的算法如下:其中N表示所有数据点的个数,Ci表示第i个类中心,xi表示第i个样本点。

第四步:划分样本第四步是划分样本,即根据类中心进行样本的划分。

在划分样本之前,通常先将所有样本点距离中心最近的聚类标记出来,以确定其归属的类别。

计算每个样本点距离类中心的距离,即可以确定该样本点所在的类。

K均值聚类算法的核心在于不断的计算类中心,不断的更新类中心,以及不断重新划分样本点归属的类别,直到类中心不能再更新,或者更新的类中心重合的情况下,迭代终止。

K均值聚类算法可以智能有效地对大量复杂数据进行聚类,解决聚类分析问题。

K均值聚类算法是一种很有效的多维数据分析方法,它能够将数据集中的相似元素进行聚类,从而帮助用户更加容易地理解和管理数据。

k均值聚类(k-meansclustering)

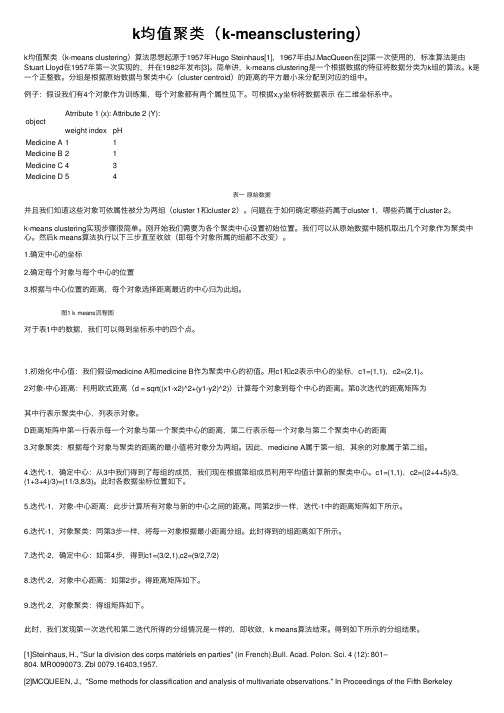

k均值聚类(k-meansclustering)k均值聚类(k-means clustering)算法思想起源于1957年Hugo Steinhaus[1],1967年由J.MacQueen在[2]第⼀次使⽤的,标准算法是由Stuart Lloyd在1957年第⼀次实现的,并在1982年发布[3]。

简单讲,k-means clustering是⼀个根据数据的特征将数据分类为k组的算法。

k是⼀个正整数。

分组是根据原始数据与聚类中⼼(cluster centroid)的距离的平⽅最⼩来分配到对应的组中。

例⼦:假设我们有4个对象作为训练集,每个对象都有两个属性见下。

可根据x,y坐标将数据表⽰在⼆维坐标系中。

object Atrribute 1 (x):weight indexAttribute 2 (Y):pHMedicine A11Medicine B21Medicine C43Medicine D54表⼀原始数据并且我们知道这些对象可依属性被分为两组(cluster 1和cluster 2)。

问题在于如何确定哪些药属于cluster 1,哪些药属于cluster 2。

k-means clustering实现步骤很简单。

刚开始我们需要为各个聚类中⼼设置初始位置。

我们可以从原始数据中随机取出⼏个对象作为聚类中⼼。

然后k means算法执⾏以下三步直⾄收敛(即每个对象所属的组都不改变)。

1.确定中⼼的坐标2.确定每个对象与每个中⼼的位置3.根据与中⼼位置的距离,每个对象选择距离最近的中⼼归为此组。

图1 k means流程图对于表1中的数据,我们可以得到坐标系中的四个点。

1.初始化中⼼值:我们假设medicine A和medicine B作为聚类中⼼的初值。

⽤c1和c2表⽰中⼼的坐标,c1=(1,1),c2=(2,1)。

2对象-中⼼距离:利⽤欧式距离(d = sqrt((x1-x2)^2+(y1-y2)^2))计算每个对象到每个中⼼的距离。

如何使用K均值算法进行聚类分析(五)

K均值算法(K-means clustering)是一种经典的聚类分析方法,它能够将数据集中的观测值按照它们的特征进行分组。

这种算法在数据挖掘、模式识别和机器学习等领域中被广泛应用。

在本文中,我们将介绍如何使用K均值算法进行聚类分析,并探讨一些相关的技巧和注意事项。

数据预处理在使用K均值算法进行聚类分析之前,首先需要对数据进行预处理。

这包括对数据进行清洗、标准化和降维处理。

清洗数据是为了去除异常值和缺失值,以保证数据的准确性和完整性。

标准化数据是为了使不同特征的数据具有相同的尺度,以便在计算距离时能够进行比较。

而降维处理则是为了减少数据的维度,以便降低计算复杂度和提高算法的效率。

确定聚类数在使用K均值算法进行聚类分析时,需要事先确定分成的聚类数。

这是一个非常重要的步骤,因为聚类数的选择会直接影响到最终的聚类效果。

一般来说,可以通过肘部法则(elbow method)或者轮廓系数(silhouette score)等方法来确定最佳的聚类数。

肘部法则是指随着聚类数的增加,聚类内部的平方和误差(SSE)会逐渐减小,而当聚类数达到一个临界点时,SSE的下降幅度会急剧减小,形成一个“肘部”,这个肘部对应的聚类数即为最佳聚类数。

而轮廓系数则是通过计算每个观测值的轮廓系数来评估聚类的紧密度和分离度,从而确定最佳的聚类数。

初始化聚类中心在确定了聚类数之后,接下来需要初始化聚类中心。

一般来说,可以随机选择一些观测值作为初始的聚类中心,或者通过一些启发式算法来确定初始的聚类中心。

这个步骤是非常关键的,因为初始的聚类中心会直接影响到最终的聚类结果。

迭代优化一旦确定了初始的聚类中心,K均值算法就会开始进行迭代优化。

在每一次迭代中,算法会根据观测值与聚类中心的距离来更新每个观测值所属的聚类,并重新计算每个聚类的中心。

这个过程会一直进行下去,直到达到了预定的迭代次数或者收敛到了一个稳定的状态。

评估聚类结果最后,需要对聚类结果进行评估。

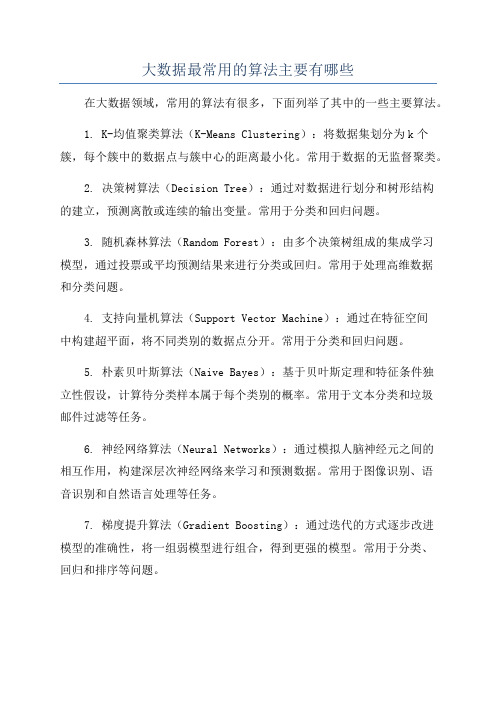

大数据最常用的算法主要有哪些

大数据最常用的算法主要有哪些在大数据领域,常用的算法有很多,下面列举了其中的一些主要算法。

1. K-均值聚类算法(K-Means Clustering):将数据集划分为k个簇,每个簇中的数据点与簇中心的距离最小化。

常用于数据的无监督聚类。

2. 决策树算法(Decision Tree):通过对数据进行划分和树形结构的建立,预测离散或连续的输出变量。

常用于分类和回归问题。

3. 随机森林算法(Random Forest):由多个决策树组成的集成学习模型,通过投票或平均预测结果来进行分类或回归。

常用于处理高维数据和分类问题。

4. 支持向量机算法(Support Vector Machine):通过在特征空间中构建超平面,将不同类别的数据点分开。

常用于分类和回归问题。

5. 朴素贝叶斯算法(Naive Bayes):基于贝叶斯定理和特征条件独立性假设,计算待分类样本属于每个类别的概率。

常用于文本分类和垃圾邮件过滤等任务。

6. 神经网络算法(Neural Networks):通过模拟人脑神经元之间的相互作用,构建深层次神经网络来学习和预测数据。

常用于图像识别、语音识别和自然语言处理等任务。

7. 梯度提升算法(Gradient Boosting):通过迭代的方式逐步改进模型的准确性,将一组弱模型进行组合,得到更强的模型。

常用于分类、回归和排序等问题。

8. 关联规则挖掘算法(Association Rule Mining):通过寻找数据集中的项集之间的关联关系,发现频繁项集和关联规则。

常用于市场篮子分析和推荐系统等任务。

9. PageRank算法:用于对网页进行排序,通过考虑网页之间的链接关系,给予网页权重值。

常用于引擎的结果排序。

10. 马尔可夫链算法(Markov Chain):描述系统随时间的状态转移情况,用于模拟具备随机性的过程。

常用于自然语言处理和图像识别等任务。

11. 最大期望算法(Expectation-Maximization):用于估计有隐含变量的概率模型参数,通过迭代的方式求解最大似然估计。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

合肥工业大学—数学建模组k-Means ClusteringOn this page…Introduction to k-Means Clustering Create Clusters and Determine Separation Determine the Correct Number of Clusters Avoid Local MinimaIntroduction to k-Means Clusteringk-means clustering is a partitioning method. The function kmeans partitions data into k mutuallyexclusive clusters, and returns the index of the cluster to which it has assigned each observation. Unlike hierarchical clustering, k-means clustering operates on actual observations (rather than the larger set of dissimilarity measures), and creates a single level of clusters. The distinctions mean that k-means clustering is often more suitable than hierarchical clustering for large amounts of data.kmeans treats each observation in your data as an object having a location in space. It finds apartition in which objects within each cluster are as close to each other as possible, and as far from objects in other clusters as possible. You can choose from five different distance measures, depending on the kind of data you are clustering.Each cluster in the partition is defined by its member objects and by its centroid, or center. The centroid for each cluster is the point to which the sum of distances from all objects in that clusteris minimized. kmeanscomputes cluster centroids differently for each distance measure, tominimize the sum with respect to the measure that you specify.kmeans uses an iterative algorithm that minimizes the sum of distances from each object to itscluster centroid, over all clusters. This algorithm moves objects between clusters until the sum cannot be decreased further. The result is a set of clusters that are as compact and well-separated as possible. You can control the details of the minimization using several optional inputparameters to kmeans, including ones for the initial values of the cluster centroids, and for themaximum number of iterations.Create Clusters and Determine SeparationThe following example explores possible clustering in four-dimensional data by analyzing the results of partitioning the points into three, four, and five clusters.Note Because each part of this example generates random numbers sequentially, i.e., without setting a new state, you must perform all steps in sequence to duplicate the results shown. If you perform the steps out of sequence, the answers will be essentially the same, but the intermediate results, number of iterations, or ordering of the silhouette plots may differ.王刚合肥工业大学—数学建模组 First, load some data:rng('default'); % For reproducibility load kmeansdata; size(X) ans =560 4 Even though these data are four-dimensional, and cannot be easily visualized, kmeans enables you to investigate whether a group structure exists in them. Call kmeans with k, the desired number of clusters, equal to 3. For this example, specify the city block distance measure, and usethe default starting method of initializing centroids from randomly selected data points.idx3 = kmeans(X,3,'distance','city');To get an idea of how well-separated the resulting clusters are, you can make a silhouette plotusing the cluster indices output from kmeans. The silhouette plot displays a measure of howclose each point in one cluster is to points in the neighboring clusters. This measure ranges from +1, indicating points that are very distant from neighboring clusters, through 0, indicating points that are not distinctly in one cluster or another, to -1, indicating points that are probably assignedto the wrong cluster. silhouette returns these values in its first output. [silh3,h] = silhouette(X,idx3,'city'); set(get(gca,'Children'),'FaceColor',[.8 .8 1]) xlabel('Silhouette Value') ylabel('Cluster')王刚合肥工业大学—数学建模组From the silhouette plot, you can see that most points in the second cluster have a large silhouette value, greater than 0.6, indicating that the cluster is somewhat separated from neighboring clusters. However, the third cluster contains many points with low silhouette values, and the first contains a few points with negative values, indicating that those two clusters are not well separated.Determine the Correct Number of ClustersIncrease the number of clusters to see if kmeans can find a better grouping of the data. This time, use the optional 'display' parameter to print information about each iteration.idx4 = kmeans(X,4, 'dist','city', 'display','iter');iter phasenumsum115602077.4321511778.643131771.14201771.1Best total sum of distances = 1771.1Notice that the total sum of distances decreases at each iteration as kmeans reassigns pointsbetween clusters and recomputes cluster centroids. In this case, the second phase of the algorithm did not make any reassignments, indicating that the first phase reached a minimum after five iterations. In some problems, the first phase might not reach a minimum, but the second phase always will.A silhouette plot for this solution indicates that these four clusters are better separated than the three in the previous solution.[silh4,h] = silhouette(X,idx4,'city'); set(get(gca,'Children'),'FaceColor',[.8 .8 1]) xlabel('Silhouette Value') ylabel('Cluster')王刚合肥工业大学—数学建模组A more quantitative way to compare the two solutions is to look at the average silhouette values for the two cases.cluster3 = mean(silh3) cluster4 = mean(silh4) cluster3 =0.5352 cluster4 =0.6400Finally, try clustering the data using five clusters.idx5 = kmeans(X,5,'dist','city','replicates',5); [silh5,h] = silhouette(X,idx5,'city'); set(get(gca,'Children'),'FaceColor',[.8 .8 1]) xlabel('Silhouette Value') ylabel('Cluster') mean(silh5) ans =0.5266王刚合肥工业大学—数学建模组This silhouette plot indicates that this is probably not the right number of clusters, since two of the clusters contain points with mostly low silhouette values. Without some knowledge of howmany clusters are really in the data, it is a good idea to experiment with a range of values for k.Avoid Local MinimaLike many other types of numerical minimizations, the solution that kmeans reaches often depends on the starting points. It is possible for kmeans to reach a local minimum, wherereassigning any one point to a new cluster would increase the total sum of point-to-centroid distances, but where a better solution does exist. However, you can use theoptional 'replicates' parameter to overcome that problem. For four clusters, specify five replicates, and use the 'display' parameter to print out the finalsum of distances for each of the solutions.[idx4,cent4,sumdist] = kmeans(X,4,'dist','city',... 'display','final','replicates',5);Replicate 1, 4 iterations, total sum of distances = 1771.1. Replicate 2, 7 iterations, total sum of distances = 1771.1. Replicate 3, 8 iterations, total sum of distances = 1771.1. Replicate 4, 5 iterations, total sum of distances = 1771.1. Replicate 5, 6 iterations, total sum of distances = 1771.1. Best total sum of distances = 1771.1王刚合肥工业大学—数学建模组In this example, kmeans found the same minimum in all five replications. However, even forrelatively simple problems, nonglobal minima do exist. Each of these five replicates began from adifferent randomly selected set of initial centroids, so sometimes kmeans finds more than one local minimum. However, the final solution that kmeans returns is the one with the lowest totalsum of distances, over all replicates.sum(sumdist) ans =1.7711e+03王刚。