Hadoop fs 命令详解

hadoop命令及使用方法

hadoop命令及使用方法Hadoop是一个分布式计算框架,用于存储和处理大规模数据集。

下面是一些常用的Hadoop命令及其使用方法:1. hdfs命令:- hdfs dfs -ls <路径>:列出指定路径下的文件和目录。

- hdfs dfs -mkdir <路径>:创建一个新的目录。

- hdfs dfs -copyFromLocal <本地路径> <HDFS路径>:将本地文件复制到HDFS 上。

- hdfs dfs -copyToLocal <HDFS路径> <本地路径>:将HDFS上的文件复制到本地。

- hdfs dfs -cat <文件路径>:显示HDFS上的文件内容。

2. mapred命令:- mapred job -list:列出当前正在运行的MapReduce作业。

- mapred job -kill <job_id>:终止指定的MapReduce作业。

3. yarn命令:- yarn application -list:列出当前正在运行的应用程序。

- yarn application -kill <application_id>:终止指定的应用程序。

4. hadoop fs命令(与hdfs dfs命令功能相似):- hadoop fs -ls <路径>:列出指定路径下的文件和目录。

- hadoop fs -cat <文件路径>:显示HDFS上的文件内容。

- hadoop fs -mkdir <路径>:创建一个新的目录。

- hadoop fs -put <本地文件路径> <HDFS路径>:将本地文件复制到HDFS上。

- hadoop fs -get <HDFS路径> <本地文件路径>:将HDFS上的文件复制到本地。

hdfs 常用命令

hdfs 常用命令HDFS(Hadoop分布式文件系统)是ApacheHadoop项目的一部分,是一种分布式文件系统,它为应用程序提供高可用性,稳定性和可扩展性。

HDFS中的文件可以以分布式方式存储在不同的节点服务器上,从而允许存储容量更大的文件,因此可以更有效地处理海量数据。

HDFS也支持由命令行控制的文件和数据操作。

本文将介绍HDFS 的常用命令,以便在HDFS系统中更有效地管理文件和数据。

一、管理文件1. hadoop fslshadoop fsls命令用于查看HDFS文件,可以获得文件的元数据信息,包括文件名,权限,访问时间,文件大小等。

例如:hadoop fsls /user/hadoop/word.txt,可以查看用户hadoop下word.txt文件的基本信息。

2. hadoop fsmkdirhadoop fsmkdir命令用于创建HDFS目录,一次只能创建一级子目录,例如:hadoop fsmkdir /user/hadoop/test,可以创建用户hadoop下test目录。

3. hadoop fsputhadoop fsput命令用于将本地文件上传到HDFS上,例如:hadoop fsput /home/user/Desktop/word.txt /user/hadoop/word.txt,可以将本地的word.txt文件上传到用户hadoop的根目录下。

4. hadoop fsgethadoop fsget命令用于从HDFS上下载文件到本地,例如:hadoop fsget /user/hadoop/test/test.txt /home/user/Desktop/test.txt,可以将用户hadoop下test目录下的test.txt文件下载到本地桌面。

5. hadoop fsrmhadoop fsrm命令用于删除HDFS中的文件,例如:hadoop fsrm /user/hadoop/word.txt,可以删除用户hadoop下的word.txt文件。

hdfs操作方法

hdfs操作方法Hadoop Distributed File System (HDFS)是Hadoop框架中的一部分,它是一个可伸缩、可靠的分布式文件系统。

HDFS设计用于处理大数据集,提供了高吞吐量的数据访问以及数据冗余和容错功能。

以下是HDFS的一些常见操作方法。

1.文件系统操作:- 创建目录:使用hadoop fs -mkdir命令来创建一个新的目录。

例如,hadoop fs -mkdir /user/mydirectory。

- 上传文件:使用hadoop fs -put命令将本地文件上传到HDFS中。

例如,hadoop fs -put myfile.txt /user/mydirectory。

- 列出文件/目录:使用hadoop fs -ls命令列出HDFS中的文件和目录。

例如,hadoop fs -ls /user/mydirectory。

- 删除文件/目录:使用hadoop fs -rm命令删除HDFS中的文件或目录。

例如,hadoop fs -rm /user/mydirectory/myfile.txt。

2.文件操作:- 读取文件:使用hadoop fs -cat命令来读取HDFS中的文件内容。

例如,hadoop fs -cat /user/mydirectory/myfile.txt。

- 复制文件:使用hadoop fs -cp命令在HDFS中复制文件。

例如,hadoop fs -cp /user/mydirectory/myfile.txt/user/newdirectory/myfile.txt。

- 移动文件:使用hadoop fs -mv命令将文件从一个目录移动到另一个目录。

例如,hadoop fs -mv /user/mydirectory/myfile.txt/user/newdirectory/myfile.txt。

- 修改文件名:使用hadoop fs -mv命令将文件改名。

hdp 常用命令

hdp 常用命令(原创版)目录1.概述2.hdp 常用命令分类3.具体命令介绍3.1 环境变量设置3.2 创建与删除目录3.3 文件操作3.4 系统管理3.5 网络管理4.命令使用示例5.总结正文1.概述Hadoop 是一种大数据处理框架,它提供了一种分布式计算的方式来处理海量数据。

在 Hadoop 中,用户可以通过执行一些命令来管理和操作Hadoop 分布式文件系统 (HDFS) 上的数据。

本文将为您介绍一些常用的Hadoop 命令,帮助您更好地了解 Hadoop 的命令行操作。

2.hdp 常用命令分类Hadoop 的命令主要分为以下几类:- 环境变量设置:用于设置 Hadoop 的配置参数。

- 创建与删除目录:用于在 HDFS 上创建和删除目录。

- 文件操作:用于在 HDFS 上执行文件的读写操作。

- 系统管理:用于管理 Hadoop 集群的节点和任务。

- 网络管理:用于管理 Hadoop 集群的网络设置。

3.具体命令介绍3.1 环境变量设置Hadoop 提供了一些命令来设置环境变量,例如:- `hadoop config set`:设置 Hadoop 配置参数。

- `hadoop config get`:查看 Hadoop 配置参数。

- `hadoop env`:查看当前 Hadoop 环境变量设置。

3.2 创建与删除目录在 HDFS 上创建和删除目录可以使用以下命令:- `hadoop fs -mkdir`:在 HDFS 上创建目录。

- `hadoop fs -rm`:在 HDFS 上删除目录。

3.3 文件操作在 HDFS 上执行文件的读写操作可以使用以下命令:- `hadoop fs -get`:从 HDFS 上下载文件到本地。

- `hadoop fs -put`:将本地文件上传到 HDFS 上。

- `hadoop fs -text`:查看 HDFS 上的文件内容。

- `hadoop fs -ls`:列出 HDFS 上的文件列表。

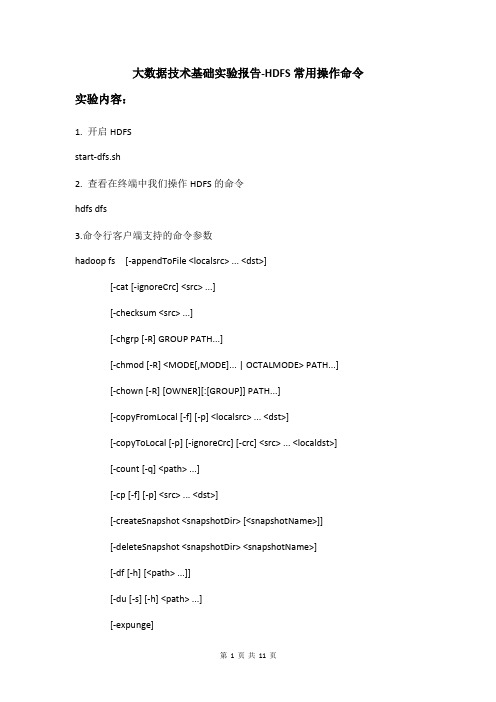

大数据技术基础实验报告-HDFS常用操作命令

大数据技术基础实验报告-HDFS常用操作命令实验内容:1. 开启HDFSstart-dfs.sh2. 查看在终端中我们操作HDFS的命令hdfs dfs3.命令行客户端支持的命令参数hadoop fs [-appendToFile <localsrc> ... <dst>][-cat [-ignoreCrc] <src> ...][-checksum <src> ...][-chgrp [-R] GROUP PATH...][-chmod [-R] <MODE[,MODE]... | OCTALMODE> PATH...][-chown [-R] [OWNER][:[GROUP]] PATH...][-copyFromLocal [-f] [-p] <localsrc> ... <dst>][-copyToLocal [-p] [-ignoreCrc] [-crc] <src> ... <localdst>][-count [-q] <path> ...][-cp [-f] [-p] <src> ... <dst>][-createSnapshot <snapshotDir> [<snapshotName>]][-deleteSnapshot <snapshotDir> <snapshotName>][-df [-h] [<path> ...]][-du [-s] [-h] <path> ...][-expunge][-get [-p] [-ignoreCrc] [-crc] <src> ... <localdst>][-getfacl [-R] <path>][-getmerge [-nl] <src> <localdst>][-help [cmd ...]][-ls [-d] [-h] [-R] [<path> ...]][-mkdir [-p] <path> ...][-moveFromLocal <localsrc> ... <dst>][-moveToLocal <src> <localdst>][-mv <src> ... <dst>][-put [-f] [-p] <localsrc> ... <dst>][-renameSnapshot <snapshotDir> <oldName> <newName>][-rm [-f] [-r|-R] [-skipTrash] <src> ...][-rmdir [--ignore-fail-on-non-empty] <dir> ...][-setfacl [-R] [{-b|-k} {-m|-x <acl_spec>} <path>]|[--set <acl_spec> <path>]] [-setrep [-R] [-w] <rep> <path> ...][-stat [format] <path> ...][-tail [-f] <file>][-test -[defsz] <path>][-text [-ignoreCrc] <src> ...][-touchz <path> ...][-usage [cmd ...]]图中显示很多命令选项信息,以上截图补全,下面的表格能够完整的列出了支持的命令选项。

hdfs常用命令

hdfs常用命令hdfs 命令最常用的就是: hdfs dfs -[linux的命令]通过查看Hadoop的命令与 hdfs 的命令并不相同,且不存在包含关系。

仅仅是 hadoop fs 与 hdfs dfs 可以等价。

hadoop 常用命令查看hadoop 命令所有参数:hadoophadoop checknative // 检查当前版本hadoop内库支持哪些压缩。

如果是false,则需要自己编译支持此压缩。

如果使用CDH则都支持。

hadoop classpath // 打印当前hadoop的环境hadoop jar // 等价于 yarn jar ,提交jar 包到yarnhdfs 常用命令查看hdfs 命令所有参数:hdfshdfs dfsadminhdfs dfsadmin -report // 报告当前集群的情况hdfs dfsadmin -safemode // 安全模式。

hdfs dfsadmin -safemode leave // leave代表关闭,安全模式关闭才是读写正常的。

hdfs dfsadmin -safemode enter // 进入安全模式。

如正在做集群维护时,就可以手动进入安全模式,维护完再离开>Safemode is On // 安全模式下,能读不能写// hdfs dfsadmin 还有其他很多参数hdfs fsckhdfs fsck // 对hdfs 做检查。

如发现 Target Replicas is 3 but 1 live replica(s) 代表有副本丢失。

文件权限后的数据就代表当前文件本来需有多少副本平衡// hdfs balancer // 集群平衡。

DN1 与 DN2 间节点平衡。

封装到脚本,每天晚上定执行hdfs balancer -policy datanode -threshold 10 // 让每个节点磁盘使用率,减去平均磁盘使用率 < 10%// hdfs diskbalancer // 磁盘平衡。

hadoop的基本操作命令

hadoop的基本操作命令Hadoop是目前最流行的分布式计算框架之一,其强大的数据处理能力和可扩展性使其成为企业级应用的首选。

在使用Hadoop时,熟悉一些基本操作命令是必不可少的。

以下是Hadoop的基本操作命令:1. 文件系统命令Hadoop的文件系统命令与Linux系统类似,可以用于管理Hadoop的文件系统。

以下是一些常用的文件系统命令:- hdfs dfs -ls:列出文件系统中的文件和目录。

- hdfs dfs -mkdir:创建一个新目录。

- hdfs dfs -put:将本地文件上传到Hadoop文件系统中。

- hdfs dfs -get:将Hadoop文件系统中的文件下载到本地。

- hdfs dfs -rm:删除文件系统中的文件或目录。

- hdfs dfs -du:显示文件或目录的大小。

- hdfs dfs -chmod:更改文件或目录的权限。

2. MapReduce命令MapReduce是Hadoop的核心计算框架,用于处理大规模数据集。

以下是一些常用的MapReduce命令:- hadoop jar:运行MapReduce作业。

- hadoop job -list:列出所有正在运行的作业。

- hadoop job -kill:终止正在运行的作业。

- hadoop fs -copyFromLocal:将本地文件复制到Hadoop文件系统中。

- hadoop fs -copyToLocal:将Hadoop文件系统中的文件复制到本地。

- hadoop fs -rmr:删除指定目录及其所有子目录和文件。

3. YARN命令YARN是Hadoop的资源管理器,用于管理Hadoop集群中的资源。

以下是一些常用的YARN命令:- yarn node -list:列出所有节点的状态。

- yarn application -list:列出所有正在运行的应用程序。

- yarn application -kill:终止正在运行的应用程序。

hadoop常用命令详细解释

hadoop常⽤命令详细解释hadoop命令分为2级,在linux命令⾏中输⼊hadoop,会提⽰输⼊规则Usage: hadoop [--config confdir] COMMANDwhere COMMAND is one of:namenode -format format the DFS filesystem#这个命令⽤于格式化DFS系统:hadoop namenode -formatesecondarynamenode run the DFS secondary namenode#运⾏第⼆个namenodenamenode run the DFS namenode#运⾏DFS的namenodedatanode run a DFS datanode#运⾏DFS的datanodedfsadmin run a DFS admin client#运⾏⼀个DFS的admin客户端mradmin run a Map-Reduce admin client#运⾏⼀个map-reduce⽂件系统的检查⼯具fsck run a DFS filesystem checking utility#运⾏⼀个DFS⽂件系统的检查⼯具fs run a generic filesystem user client#这个是daoop⽂件的系统的⼀级命令,这个⾮常常见稍后详细讲解这个命令:例如hadoop fs -ls /balancer run a cluster balancing utility#作⽤于让各个datanode之间的数据平衡,例如:sh $HADOOP_HOME/bin/start-balancer.sh –t 15%oiv apply the offline fsimage viewer to an fsimage#将fsimage⽂件的内容转储到指定⽂件中以便于阅读,oiv⽀持三种输出处理器,分别为Ls、XML和FileDistribution,通过选项-p指定 fetchdt fetch a delegation token from the NameNode#运⾏⼀个代理的namenodejobtracker run the MapReduce job Tracker node#运⾏⼀个MapReduce的taskTracker节点pipes run a Pipes job#运⾏⼀个pipes作业tasktracker run a MapReduce task Tracker node#运⾏⼀个MapReduce的taskTracker节点historyserver run job history servers as a standalone daemon#运⾏历史服务作为⼀个单独的线程job manipulate MapReduce jobs#处理mapReduce作业,这个命令可以查看提交的mapreduce状态,杀掉不需要的jobqueue get information regarding JobQueues#队列管理,在后续版本中这个命名取消了version print the version#打印haoop版本jar <jar> run a jar file#运⾏⼀个jar包,⽐如mapreduce可以通过hadoop-streaming-1.2.1.jar进⾏开发distcp <srcurl> <desturl> copy file or directories recursively#distcp⼀般⽤于在两个HDFS集群中传输数据。

hadoopFS

hadoopFS一、导读:Hadoop框架中最核心的设计就是:MapReduce和HDFS。

MapReduce是任务的分解与结果的汇总。

HDFS是Hadoop分布式文件系统的缩写,为分布式计算存储提供了底层支持。

1.可扩展:不论是存储的可扩展还是计算的可扩展都是Hadoop 的设计根本。

2.经济:框架可以运行在任何普通的PC上。

3.可靠:分布式文件系统的备份恢复机制以及MapReduce的任务监控保证了分布式处理的可靠性。

4.高效:分布式文件系统的高效数据交互实现以及MapReduce结合Local Data处理的模式,为高效处理海量的信息作了基础准备。

最适合的就是海量数据的分析。

二、下载最新的hadoop稳定版:/doc/7a5420325.html,//hadoop/common/三、硬件服务器环境:192.168.101.163 NameNode192.168.101.157 DataNode192.168.101.160 DataNode四、各节点创建hadoop用户:useradd hadooppasswd hadoop(技巧:for i in {10..19}; do ssh 192.168.50.$i useradd hadoop; ssh 192.168.50.$i echo "hadoop" | passwd --stdin hadoop; done)五、NameNode与DateNode无密码访问:su - hadoopssh-keygen –t rsassh-agent $SHELLssh-addssh-add –Lssh-copy-id –i 192.168.101.157ssh-copy-id –i 192.168.101.160ssh-copy-id –i 192.168.101.163。

六、安装JAVA环境:mv jdk-6u7-linux-x64.bin /usr/local/./ jdk-6u7-linux-x64.bin七、JAVA环境配置:当默认已安装有JAVA环境:Vi /etc/profileexport JAVA_HOME=/usr/lib/jvm/java-1.6.0-openjdk-1.6.0.0.x86_64export JRE_HOME=$JAVA_HOME/jreexportCLASSPATH=$CLASSPATH:$JAVA_HOME/lib:$JAVA_HOME/jre/lib exportPATH=$JAVA_HOME/bin:$JAVA_HOME/jre/bin:$PATH:$HOME/bi nexport HADOOP_HOME=/usr/local/hadoopexport PATH=$PATH:$HADOOP_HOME/binsource /etc/profile手动安装JAVA环境:vi /etc/profileJAVA_HOME=/usr/local/ jdk1.6.0_07JRE_HOME=$ JAVA_HOME/jrePATH=$PATH:$JAVA_HOME/bin:JRE_HOME/binCLASSPATH=.:$JAVA_HOME/lib/: $JRE_HOME/lib:export JAVA_HOME JRE_HOME PATH CLASSPATHexport HADOOP_HOME=/usr/local/hadoopexport PATH=$PATH:$HADOOP_HOME/binsource /etc/profilejava -version 查看是否安装成功八、机器名设置:cat /etc/hosts192.168.101.157 cluster1 /doc/7a5420325.html,192.168.101.160 cluster2 /doc/7a5420325.html,192.168.101.163 cluster3 /doc/7a5420325.html,九、设置:1.tar zxvf hadoop-0.20.203.0rc1.tar.gz2.mv hadoop-0.20.203.0 /usr/local/hadoop3.vi hadoop/conf/hadoop-env.shexport JAVA_HOME=/usr/lib/jvm/java-1.6.0-openjdk-1.6.0.0.x86_64/(注:文件需用UTF-8编码保存)4.mkdir /usr/local/hadoop/hadooptmp #这是下面配置文件的hadoop.tmp.dir目录5.vim hadoop/conf/core-site.xml6.vim hadoop/conf/hdfs-site.xml7.vim hadoop/conf/mapred-site.xml8.vim hadoop/conf/slaves192.168.101.157192.168.101.1609.vim hadoop/conf/masters192.168.101.16310. scp –pr hadoop 192.168.101.157:/usr/local/scp –pr hadoop 192.168.101.160:/usr/local/分别chown -R hadoop:hadoop hadoop/十、初始化并启动:名称节点上:su – hadoophadoop namenode –formatstart-all.shjps #查看进程hadoop dfsadmin –report #查看群集状态检查Master的logs目录,看看Namenode日志以及JobTracker 日志是否正常启动# NameNode - http://192.168.101.163:50070/ #JobTracker - http://192.168.101.163:50030/十一、测试:hadoop fs -mkdir testdirhadoop fs –ls执行wordcount:(计算文本中词语数量的程序)上传数据:hadoop fs -mkdir inputhadoop fs -put /home/aa/*.txt input #将txt文件放入input目录或:hadoop fs –mkdir inputhadoop fs –copyFromLocal /home/aa/*.txt input提交作业cd /usr/local/hadoophadoop jar hadoop-examples-0.20.203.0.jar wordcount input output在http://192.168.101.163:50030查看作业执行情况。

hadoop命令手册

【IT168 资讯】所有的hadoop命令均由bin/hadoop脚本引发。

不指定参数运行hadoop脚本会打印所有命令的描述。

用法:hadoop [--config confdir] [COMMAND] [GENERIC_OPTIONS] [COMMAND_OPTIONS]Hadoop有一个选项解析框架用于解析一般的选项和运行类。

命令选项描述--config confdir 覆盖缺省配置目录。

缺省是${HADOOP_HOME}/conf。

GENERIC_OPTIONS 多个命令都支持的通用选项。

COMMAND命令选项S 各种各样的命令和它们的选项会在下面提到。

这些命令被分为用户命令管理命令两组。

常规选项下面的选项被 dfsadmin, fs, fsck和 job支持。

应用程序要实现 Tool来支持常规选项。

GENERIC_OPTION 描述-conf <configuration file> 指定应用程序的配置文件。

-D <property=value> 为指定property指定值value。

-fs <local|namenode:port> 指定namenode。

-jt <local|jobtracker:port> 指定job tracker。

只适用于job。

-files <逗号分隔的文件列表> 指定要拷贝到map reduce集群的文件的逗号分隔的列表。

只适用于job。

-libjars <逗号分隔的jar列表> 指定要包含到classpath中的jar文件的逗号分隔的列表。

只适用于job。

-archives <逗号分隔的archive列表> 指定要被解压到计算节点上的档案文件的逗号分割的列表。

只适用于job。

用户命令hadoop集群用户的常用命令。

archive创建一个hadoop档案文件。

参考 Hadoop Archives.用法:hadoop archive -archiveName NAME <src>* <dest>命令选项描述-archiveName NAME 要创建的档案的名字。

Hadoop FS 命令

1.1.11 test使用方法:hadoop fs -test -[ezd] URI 选项:-e 检查文件是否存在。

如果存在则返回0;否则返回1。

-z 检查文件是否是0字节。

如果是则返回0;否则返回1。

-d 检查路径是否是目录。

如果是则返回0;否则返回1。

失去与Namenode的连接返回255。

示例:hadoop fs -test -e filename1.1.12 du使用方法:hadoop fs -du URI [URI …]显示目录中所有文件的大小,或者当只指定一个文件时,显示此文件的大小。

示例:hadoop fs -du /user/hadoop/dir1 /user/hadoop/file1 hdfs://host:port/user/hadoop/dir1 返回值:成功返回0,失败返回255(文件或目录不存在;失去与Namenode的连接)。

1.1.13 dus使用方法:hadoop fs -dus URI [URI …]显示目录中所有文件的总大小,而不会分别显示出目录中各个文件的大小;当只指定一个文件时,显示此文件的大小。

1.1.14 touchz使用方法:hadoop fs -touchz URI [URI …]创建一个0字节的空文件;如果文件已存在则修改相应的mtime。

示例:hadoop -touchz pathname成功返回0,失败返回255(失去与Namenode的连接或Namenode处于安全模式)。

1.1.15 mv使用方法:hadoop fs -mv URI [URI …] <dest>将文件从源路径移动到目标路径。

该命令允许有多个源路径,此时目标路径必须是一个目录。

不允许在不同的文件系统间移动文件。

示例:hadoop fs -mv /user/hadoop/file1 /user/hadoop/file2hadoop fs -mv hdfs://host:port/file1 hdfs://host:port/file2 hdfs://host:port/file3 hdfs://host:port/dir1返回值:成功返回0,失败返回255(源路径不存在或目标路径已存在;失去与Namenode的连接或Namenode处于安全模式)。

Hadoop中的文件系统操作指南

Hadoop中的文件系统操作指南Hadoop是一个开源的分布式计算平台,广泛应用于大数据处理和分析领域。

作为Hadoop的核心组件之一,Hadoop分布式文件系统(Hadoop Distributed File System,简称HDFS)提供了高可靠性、高容错性和高性能的文件存储服务。

本文将为读者介绍Hadoop中的文件系统操作指南,帮助读者更好地了解和使用HDFS。

一、HDFS的基本概念和特点HDFS是Hadoop的默认文件系统,它将大文件切分为多个数据块,并将这些数据块分布式存储在Hadoop集群的不同节点上。

HDFS的设计目标是适用于大规模数据集的存储和处理,具有以下特点:1. 高可靠性:HDFS通过数据冗余和自动故障恢复机制,确保数据的持久性和可靠性。

每个数据块默认会有三个副本存储在不同的节点上,一旦某个节点发生故障,系统会自动将副本复制到其他节点上。

2. 高容错性:HDFS通过检测和自动恢复数据块的损坏或丢失,保证数据的完整性。

当一个数据块损坏或丢失时,系统会自动使用其他副本进行替换,从而实现容错性。

3. 高性能:HDFS采用了流式数据访问模式,适用于一次写入、多次读取的数据访问场景。

HDFS将数据块存储在本地磁盘上,避免了网络传输的瓶颈,从而提高了数据的读写性能。

二、HDFS的文件操作1. 文件上传:使用Hadoop的命令行工具或编程接口,可以将本地文件上传到HDFS中。

例如,使用命令行工具的hadoop fs -put命令可以将本地文件复制到HDFS中指定的路径下。

2. 文件下载:类似地,可以使用hadoop fs -get命令将HDFS中的文件下载到本地文件系统中。

也可以使用编程接口实现文件的下载操作。

3. 文件删除:使用hadoop fs -rm命令可以删除HDFS中的文件。

需要注意的是,删除文件时会连同其所有副本一起删除,因此需要谨慎操作。

4. 文件重命名:使用hadoop fs -mv命令可以对HDFS中的文件进行重命名操作。

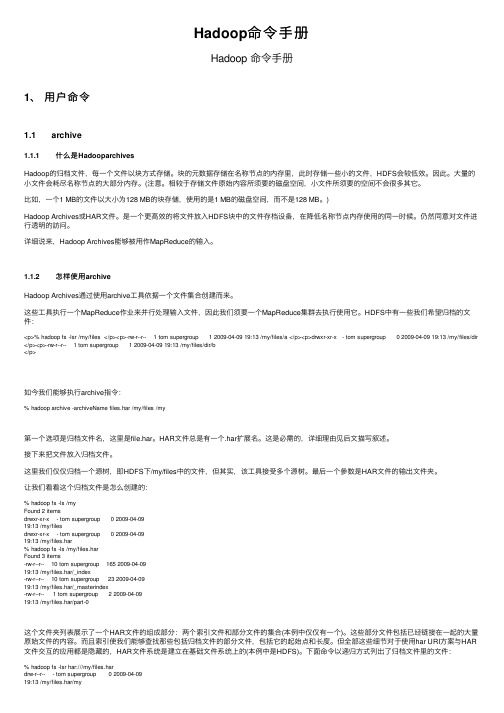

Hadoop命令手册

Hadoop命令⼿册Hadoop 命令⼿册1、⽤户命令1.1 archive1.1.1 什么是HadooparchivesHadoop的归档⽂件,每⼀个⽂件以块⽅式存储。

块的元数据存储在名称节点的内存⾥,此时存储⼀些⼩的⽂件,HDFS会较低效。

因此。

⼤量的⼩⽂件会耗尽名称节点的⼤部分内存。

(注意。

相较于存储⽂件原始内容所须要的磁盘空间,⼩⽂件所须要的空间不会很多其它。

⽐如,⼀个1 MB的⽂件以⼤⼩为128 MB的块存储,使⽤的是1 MB的磁盘空间,⽽不是128 MB。

)Hadoop Archives或HAR⽂件。

是⼀个更⾼效的将⽂件放⼊HDFS块中的⽂件存档设备,在降低名称节点内存使⽤的同⼀时候。

仍然同意对⽂件进⾏透明的訪问。

详细说来,Hadoop Archives能够被⽤作MapReduce的输⼊。

1.1.2 怎样使⽤archiveHadoop Archives通过使⽤archive⼯具依据⼀个⽂件集合创建⽽来。

这些⼯具执⾏⼀个MapReduce作业来并⾏处理输⼊⽂件,因此我们须要⼀个MapReduce集群去执⾏使⽤它。

HDFS中有⼀些我们希望归档的⽂件:<p>% hadoop fs -lsr /my/files </p><p>-rw-r--r-- 1 tom supergroup 1 2009-04-09 19:13 /my/files/a </p><p>drwxr-xr-x - tom supergroup 0 2009-04-09 19:13 /my/files/dir </p><p>-rw-r--r-- 1 tom supergroup 1 2009-04-09 19:13 /my/files/dir/b</p>如今我们能够执⾏archive指令:% hadoop archive -archiveName files.har /my/files /my第⼀个选项是归档⽂件名,这⾥是file.har。

hadoop数据副本数量相关命令;

Hadoop是一种开源的分布式文件存储和计算系统,被广泛应用于大数据领域。

在Hadoop中,数据的可靠性和容错性是至关重要的,因此Hadoop引入了数据副本机制来保障数据的可靠性。

在Hadoop集裙中,数据会被分成多个块,并将这些块保存在不同的计算机上,以防止单点故障和数据丢失。

在本文中,我们将介绍Hadoop中与数据副本数量相关的一些命令和操作。

1. 查看数据块的副本情况在Hadoop中,可以使用以下命令来查看数据块的副本情况:hdfs fsck / -files -blocks -locations该命令会列出Hadoop集裙中所有块的副本情况,包括块的ID、复本数量、所在的数据节点等信息。

通过这些信息,可以清楚地了解每个数据块的副本情况,从而评估数据的可靠性和容错性。

2. 修改数据块的副本数量在Hadoop中,可以通过以下命令来修改数据块的副本数量:hdfs dfs -setrep -w 3 /user/hadoop/data.txt该命令会将指定文件的副本数量修改为3,这样可以增加数据的容错性和可靠性。

在某些情况下,可能需要根据实际情况来调整数据块的副本数量,以满足系统的要求。

3. 查看集裙的副本数量配置在Hadoop集裙中,可以通过以下命令来查看副本数量的相关配置信息:hadoop fs -getconf dfs.replication该命令会显示Hadoop集裙当前的副本数量配置,可以了解到集裙中数据块的默认副本数量是多少。

在实际应用中,可以根据业务需求和系统性能来调整副本数量的配置。

4. 修改集裙的副本数量配置如果需要修改集裙的副本数量配置,可以通过以下方式来实现:a. 打开Hadoop的配置文件hdfs-site.xml。

b. 修改配置项dfs.replication的值,将其设置为新的副本数量。

c. 保存文件并重启Hadoop集裙。

通过以上步骤,就可以修改Hadoop集裙的副本数量配置,从而影响整个集裙的数据副本情况。

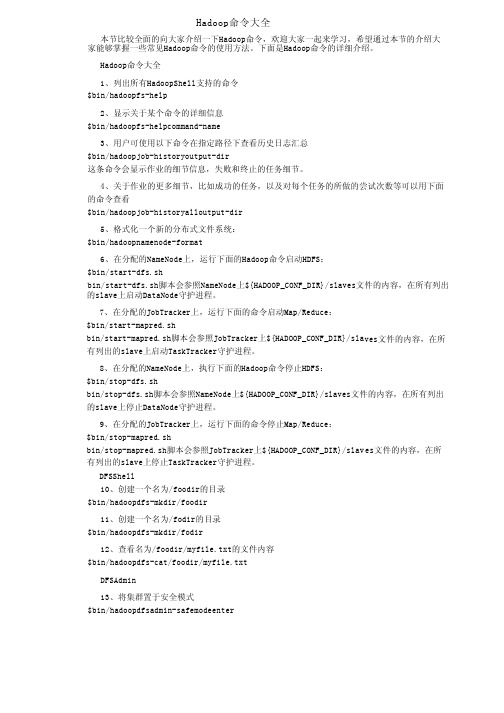

Hadoop命令大全

Hadoop命令大全本节比较全面的向大家介绍一下Hadoop命令,欢迎大家一起来学习,希望通过本节的介绍大家能够掌握一些常见Hadoop命令的使用方法。

下面是Hadoop命令的详细介绍。

Hadoop命令大全1、列出所有HadoopShell支持的命令$bin/hadoopfs-help2、显示关于某个命令的详细信息$bin/hadoopfs-helpcommand-name3、用户可使用以下命令在指定路径下查看历史日志汇总$bin/hadoopjob-historyoutput-dir这条命令会显示作业的细节信息,失败和终止的任务细节。

4、关于作业的更多细节,比如成功的任务,以及对每个任务的所做的尝试次数等可以用下面的命令查看$bin/hadoopjob-historyalloutput-dir5、格式化一个新的分布式文件系统:$bin/hadoopnamenode-format6、在分配的NameNode上,运行下面的Hadoop命令启动HDFS:$bin/start-dfs.shbin/start-dfs.sh脚本会参照NameNode上${HADOOP_CONF_DIR}/slaves文件的内容,在所有列出的slave上启动DataNode守护进程。

7、在分配的JobTracker上,运行下面的命令启动Map/Reduce:$bin/start-mapred.shbin/start-mapred.sh脚本会参照JobTracker上${HADOOP_CONF_DIR}/sla ves文件的内容,在所有列出的slave上启动TaskTracker守护进程。

8、在分配的NameNode上,执行下面的Hadoop命令停止HDFS:$bin/stop-dfs.shbin/stop-dfs.sh脚本会参照NameNode上${HADOOP_CONF_DIR}/slaves文件的内容,在所有列出的slave上停止DataNode守护进程。

hdfs的文件操作命令以及mapreduce程序设计

hdfs的文件操作命令以及mapreduce程序设计Hadoop分布式文件系统(HDFS)是Hadoop框架的一部分,用于存储和处理大规模数据集。

以下是HDFS的一些常见文件操作命令:1. 查看文件和目录:- `hadoop fs -ls <path>`:列出指定路径下的文件和目录。

- `hadoop fs -du <path>`:查看指定路径下的文件和目录的大小。

2. 创建和删除目录:- `hadoop fs -mkdir <path>`:创建一个新目录。

- `hadoop fs -rmr <path>`:递归删除指定路径下的所有文件和目录。

3. 文件复制和移动:- `hadoop fs -cp <src> <dest>`:将源路径中的文件复制到目标路径。

- `hadoop fs -mv <src> <dest>`:将源路径中的文件移动到目标路径。

4. 文件上传和下载:- `hadoop fs -put <localSrc> <dest>`:将本地文件上传到HDFS中的指定路径。

- `hadoop fs -get <src> <localDest>`:将HDFS中的文件下载到本地目录。

5. 查看文件内容:- `hadoop fs -cat <path>`:显示指定路径下文件的内容。

- `hadoop fs -tail <path>`:显示指定文件的最后几行内容。

上述命令可以在命令行中使用。

此外,Hadoop还提供了Java 编程接口(API)和命令行工具(如`hadoop jar`)来编写和运行MapReduce程序。

以下是使用Java编写的简单MapReduce程序的示例:```javaimport org.apache.hadoop.fs.Path;import org.apache.hadoop.io.IntWritable;import org.apache.hadoop.io.Text;import org.apache.hadoop.mapreduce.Job;import org.apache.hadoop.mapreduce.Mapper;import org.apache.hadoop.mapreduce.Reducer;import org.apache.hadoop.mapreduce.lib.input.FileInputFormat; import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat; import java.io.IOException;public class WordCount {public static class TokenizerMapper extends Mapper<Object, Text, Text, IntWritable> {private final IntWritable one = new IntWritable(1);private Text word = new Text();public void map(Object key, Text value, Context context) throws IOException, InterruptedException {String[] words = value.toString().split(" ");for (String w : words) {word.set(w);context.write(word, one);}}}public static class IntSumReducer extends Reducer<Text, IntWritable, Text, IntWritable> {private IntWritable result = new IntWritable();public void reduce(Text key, Iterable<IntWritable> values, Context context) throws IOException, InterruptedException { int sum = 0;for (IntWritable val : values) {sum += val.get();}result.set(sum);context.write(key, result);}}public static void main(String[] args) throws Exception {Job job = Job.getInstance();job.setJarByClass(WordCount.class);job.setMapperClass(TokenizerMapper.class);job.setCombinerClass(IntSumReducer.class);job.setReducerClass(IntSumReducer.class);job.setOutputKeyClass(Text.class);job.setOutputValueClass(IntWritable.class);FileInputFormat.addInputPath(job, new Path(args[0]));FileOutputFormat.setOutputPath(job, new Path(args[1]));System.exit(job.waitForCompletion(true) ? 0 : 1);}}```该示例是一个简单的词频统计程序。

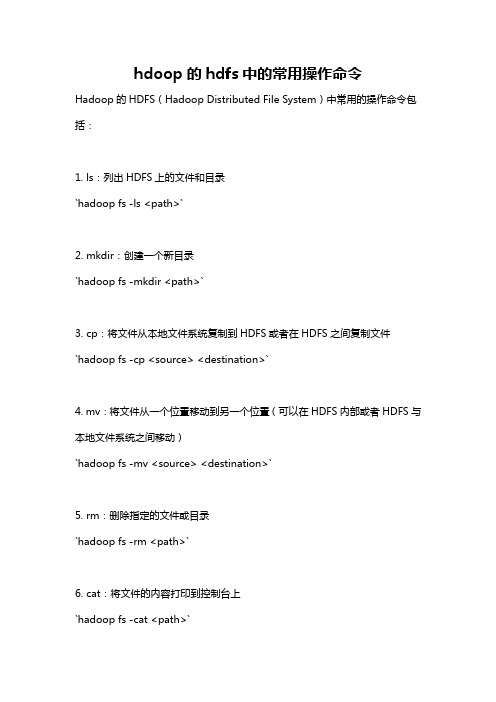

hdoop的hdfs中的常用操作命令

hdoop的hdfs中的常用操作命令Hadoop的HDFS(Hadoop Distributed File System)中常用的操作命令包括:1. ls:列出HDFS上的文件和目录`hadoop fs -ls <path>`2. mkdir:创建一个新目录`hadoop fs -mkdir <path>`3. cp:将文件从本地文件系统复制到HDFS或者在HDFS之间复制文件`hadoop fs -cp <source> <destination>`4. mv:将文件从一个位置移动到另一个位置(可以在HDFS内部或者HDFS与本地文件系统之间移动)`hadoop fs -mv <source> <destination>`5. rm:删除指定的文件或目录`hadoop fs -rm <path>`6. cat:将文件的内容打印到控制台上`hadoop fs -cat <path>`7. tail:显示文件的最后几行`hadoop fs -tail <path>`8. get:将文件从HDFS复制到本地文件系统`hadoop fs -get <source> <destination>`9. put:将文件从本地文件系统复制到HDFS`hadoop fs -put <source> <destination>`10. chmod:更改文件的权限`hadoop fs -chmod <mode> <path>`以上是HDFS中常用的操作命令。

可以使用命令`hadoop fs -help`查看更多的HDFS命令及其用法。

Hadoop常用命令及范例

Hadoop常⽤命令及范例 hadoop中的zookeeper,hdfs,以及hive,hbase都是hadoop的组件,要学会熟练掌握相关的命令及其使⽤规则,下⾯就是⼀些常⽤命令及对hbase和hive的操作语句,同时也列出了⼀些范例。

start-dfs.sh NameNode 进程启动:hadoop-daemon.sh start namenode DataNode 进程启动:hadoop-daemon.sh start datanode HA ⾼可⽤环境中需要启动的进程: zookeeper: zkServer.sh start 启动 zkServer.sh stop 停⽌ zkServer.sh status 查看状态 leader follwer journalnode 集群命令 hadoop-daemon.sh start journalnode 启动 hadoop-daemon.sh stop journalnode 停⽌ ZKFC 启动 zkfc 进程: hadoop-daemon.sh start zkfc 停⽌ zkfc 进程: hadoop-daemon.sh stop zkfc 1. shell命令管理和 HDFS 的⽂件管理。

(1)启动 Zookeeper zkServer.sh start (2)启动 HDFS 的命令 start-dfs.sh (3)启动 Yarn 的命令 start-yarn.sh (4)显⽰ HDFS 中/data/test ⽬录信息 hadoop fs -mkdir /data/test hadoop fs -lsr /data/test (5)将本地⽂件/tmp/log.txt ⽂件上传到/data/test ⽬录中 hadoop fs -put /tmp/log.txt /data/test (6)设置⽂件/data/test/log.txt 的副本数为 3 hadoop fs -setrep -w 3 /data/test/log.txt (7)显⽰/data/test/log.txt ⽂件内容 hadoop fs -cat /data/test/log.txt (8)将/data/test/log.txt ⽂件移动到集群/user/hadoop ⽬录下 hadoop fs -mkdir /user/hadoop hadoop fs -mv /data/test/log.txt /user/hadoop (9)将/data/test/log.txt ⽂件下载到/home/hadoop ⽬录下 hadoop fs -copyToLocal /data/test/log.txt /home/hadoop/ (10)关闭 HDFS 命令 stop-dfs.sh (11)停⽌ Zookeeper zkServer.sh stop 2.将学⽣数据存储到 Hive 数据仓库中,信息包括(学号,姓名,性别,年龄,联系⽅式, 邮箱),创建表语法如下: 启动 hive 前切记要先启动 mysql 数据库 create table student(sno string ,name string ,sex string ,age int ,phone string, email string) row format delimited fields terminated by ',' ;(1)将本地数据“/tmp/student.dat”加载到 student 表,写出操作语句 load data local inpath '/tmp/student.dat' overwrite into table student; (2)写 HQL 语句查询全部学⽣信息 select * from student; (3)写 HQL 语句查询各个年龄及对应学⽣数量 (4) select age,count(*) from student group by age; (5)写 HQL 语句查询全部学⽣的姓名和性别 select name,sex from student; (6)写 HQL 语句查询年龄为 18 的学⽣姓名和联系⽅式 select name,phone from student where age=18; (7)写 HQL 语句查看 student 表结构 describe student; (8)写 HQL 语句删除 student 表 drop table student; (9)导出⽣地/home/hadoop/out ⽬录,写出语 from student insert overwrite local directory '/home/hadoop/out' select *; 3.员⼯表 employee 包含两个列族 basic 和 info,使⽤ shell 命令完成以下操作。

copytolocalfile参数

copytolocalfile参数copytolocalfile参数是指Hadoop文件系统(HDFS)中文件的复制操作。

它通过将HDFS中的文件复制到本地文件系统来实现。

copytolocalfile参数是Hadoop中的一个非常重要的参数,可以帮助用户将HDFS中的文件复制到本地文件系统中供使用。

下面我们来分步骤阐述如何使用copytolocalfile参数实现将HDFS中的文件复制到本地文件系统中。

第一步:在Hadoop环境中运行命令在Hadoop环境中选择一台机器,在命令行中输入以下命令:hadoop fs -copyToLocal <source> <destination>其中,<source>指的是要从HDFS中复制的文件的路径,<destination>指的是文件将被复制到本地文件系统的路径。

第二步:检查复制后的文件一旦操作成功,复制后的文件将被存储在本地文件系统的路径中。

在本地文件系统中检查文件以确保文件已成功复制。

需要注意的是,如果要从HDFS中复制一个目录,可以使用-r选项。

例如:hadoop fs -copyToLocal -r <source_dir> <destination_dir> 这将复制整个目录到本地文件系统中。

总而言之,copytolocalfile参数是实现文件从HDFS复制到本地文件系统中的重要步骤。

如果您需要从HDFS获取数据并在本地进行处理,这个参数是您不可或缺的工具。

通过这种方法实现数据的快速读取和导出,可以为您的分析工作节省时间,最大程度地提高数据分析效率。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Hadoop fs 命令详解hadoop fs -ls<path>:等同于本地系统的ls,列出在指定目录下的文件内容,支持pattern 匹配。

输出格式如filename(full path) <r n> size.其中n代表replica的个数,size代表大小(单位bytes)。

hadoop fs -lsr <path>:递归列出匹配pattern的文件信息,类似ls,只不过递归列出所有子目录信息。

hadoop fs -du<path>:列出匹配pattern的指定的文件系统空间总量(单位bytes),等价于unix下的针对目录的du –sb <path>/*和针对文件的du –b <path> ,输出格式如name(full path) size(in bytes)。

-s Rather than showing the size of each individual file that matches thepattern, shows the total (summary) size.-h Formats the sizes of files in a human-readable fashion rather than a numberof bytes.hadoop fs -dus <path>:等价于-du -s输出格式也相同,只不过等价于unix的du -sb。

hadoop fs -mv <src> <dst>:将制定格式的文件move到指定的目标位置。

当src为多个文件时,dst必须是个目录。

hadoop fs -cp<src> <dst>:拷贝文件到目标位置,当src为多个文件时,dst必须是个目录。

hadoop fs -rm [-skipTrash] <src>:删除匹配pattern的指定文件,等价于unix下的rm <src>。

hadoop fs -rmr [skipTrash] <src>:递归删掉所有的文件和目录,等价于unix下的rm –rf <src>。

hadoop fs -rmi [skipTrash] <src>:等价于unix的rm –rfi <src>。

hadoop fs -put <localsrc> …<hdfs path dst>:从本地系统拷贝文件到HDFS。

hadoop fs -copyFromLocal <localsrc> …<hdfs path dst >:等价于-put。

hadoop fs -moveFromLocal<localsrc> …<dst>:等同于-put,只不过源文件在拷贝后被删除。

hadoop fs -get <hdfs path> <localdst>:从HDFS拷贝文件到本地文件系统,文件匹配pattern,若是多个文件,则dst必须是目录。

hadoop fs -getmerge <hdfs path> <localdst>:顾名思义,从HDFS拷贝多个文件、合并排序为一个文件到本地文件系统。

假设在你的hdfs集群上有一个/user/hadoop/output目录里面有作业执行的结果(多个文件组成)part-000000,part-000001,part-000002然后你想把所有的文件合拢来一起看可以使用命令:hadoop fs -getmerge /user/hadoop/output local_file然后就可以在本地使用vi local_file查看内容了hadoop fs -cat <src>:展示文件内容。

hadoop fs -copyToLocal <hdfs path> <localdst>:等价于-get。

hadoop fs -mkdir <path>:在指定位置创建目录。

hadoop fs -chmod [-R] <MODE[,MODE]…|OCTALMODE> PATH…:修改文件的权限,-R 标记递归修改。

MODE为a+r,g-w,+rwx等,OCTALMODE为755这样。

hadoop fs -chown [-R] [OWNER][:[GROUP]] PATH…:修改文件的所有者和组。

-R表示递归。

hadoop fs -chgrp [-R] GROUP PA TH…:等价于-chown …:GROUP …。

hadoop fs -count [-q] <path>:计数文件个数及所占空间的详情,输出表格的列的含义依次为:DIR_COUNT, FILE_COUNT ,CONTENT_SIZE, FILE_NAME 。

hadoop fs -help [cmd] 查看命令功能明细,相当于linux的man命令。

hadoop fs -setrep [-R] [-w] <rep> <path/file>:设置文件的备份级别,-R标志控制是否递归设置子目录及文件。

Hadoop fs –srtrep –R 2 / 递归设置节点根目录及子目录的副本数为2hadoop fs -count[-q] <path>:计数文件个数及所占空间的详情,输出表格的列的含义依次为:hadoop fs -count -q /path/to/directory 可以看到这个目录真正的空间使用情况,比较详细的空间和qutoa占用情况,包含了物理空间、逻辑空间、文件数、目录数、qutoa剩余量等。

[wqm@DRM001 conf]$ hadoop fs -count /49 25 309948 /49表示根目录下有49个文件夹25表示根目录下有25个文件309948表示根目录下的所有文件总占空间大小,不包括副本[wqm@DRM001 conf]$ hadoop fs -count -q /9223372036854775807 9223372036854775729 none inf 49 29 313982 /命名空间的quota(限制文件数)剩余的命名空间quota物理空间的quota(限制空间占用大小)剩余的物理空间目录数统计文件数统计目录逻辑空间总大小路径setrep使用方法:Hadoop fs -setrep [-R] <path>改变一个文件的副本系数。

-R选项用于递归改变目录下所有文件的副本系数。

示例:hadoop fs -setrep -w 3 -R /user/hadoop/dir1返回值:成功返回0,失败返回-1。

stat使用方法:hadoop fs -stat URI [URI …]返回指定路径的统计信息。

示例:hadoop fs -stat path返回值:成功返回0,失败返回-1。

tail使用方法:hadoop fs -tail [-f] URI将文件尾部1K字节的内容输出到stdout。

支持-f选项,行为和Unix中一致。

示例:hadoop fs -tail pathname返回值:成功返回0,失败返回-1。

test使用方法:hadoop fs -test -[ezd] URI选项:-e 检查文件是否存在。

如果存在则返回0。

-z 检查文件是否是0字节。

如果是则返回0。

-d 如果路径是个目录,则返回1,否则返回0。

示例:hadoop fs -test -e filenametext使用方法:hadoop fs -text <src>将源文件输出为文本格式。

允许的格式是zip和TextRecordInputStream。

touchz使用方法:hadoop fs -touchz URI [URI …]创建一个0字节的空文件。

示例:hadoop -touchz pathname返回值:成功返回0,失败返回-1。

[-appendToFile <localsrc> ... <dst>]-appendToFile <localsrc> ... <dst> :Appends the contents of all the given local files to the given dst file. The dstfile will be created if it does not exist. If <localSrc> is -, then the input isread from stdin.追加写文件,比如Hadoop fs -appendToFile *.txt test.txt 将所有txt文件内容追加到新的test文件[-cat [-ignoreCrc] <src> ...][-checksum <src> ...] 校验和信息[-chgrp [-R] GROUP PATH...][-chmod [-R] <MODE[,MODE]... | OCTALMODE> PA TH...][-chown [-R] [OWNER][:[GROUP]] PA TH...][-copyFromLocal [-f] [-p] [-l] <localsrc> ... <dst>][-copyToLocal [-p] [-ignoreCrc] [-crc] <src> ... <localdst>][-count [-q] [-h] [-v] <path> ...][-cp [-f] [-p | -p[topax]] <src> ... <dst>][-createSnapshot <snapshotDir> [<snapshotName>]][-deleteSnapshot <snapshotDir> <snapshotName>][-df [-h] [<path> ...]][-du [-s] [-h] <path> ...][-expunge][-find <path> ... <expression> ...][-get [-p] [-ignoreCrc] [-crc] <src> ... <localdst>][-getfacl [-R] <path>][-getfattr [-R] {-n name | -d} [-e en] <path>][-getmerge [-nl] <src> <localdst>][-help [cmd ...]][-ls [-d] [-h] [-R] [<path> ...]][-mkdir [-p] <path> ...][-moveFromLocal <localsrc> ... <dst>][-moveToLocal <src> <localdst>][-mv <src> ... <dst>][-put [-f] [-p] [-l] <localsrc> ... <dst>][-renameSnapshot <snapshotDir> <oldName> <newName>][-rm [-f] [-r|-R] [-skipTrash] <src> ...][-rmdir [--ignore-fail-on-non-empty] <dir> ...][-setfacl [-R] [{-b|-k} {-m|-x <acl_spec>} <path>]|[--set <acl_spec> <path>]] [-setfattr {-n name [-v value] | -x name} <path>][-setrep [-R] [-w] <rep> <path> ...][-stat [format] <path> ...][-tail [-f] <file>][-test -[defsz] <path>][-text [-ignoreCrc] <src> ...][-touchz <path> ...][-usage [cmd ...]]。