centos bond配置

CentOS7设置双网卡bond详解

nmcli conn modify $Bond ipv4.addresses "$IP/24" ipv4.gateway "$Gateway" ipv4.dns "$DNS" nmcli conn modify $Bond ipv4.method manual

启动接口

nmcli connection up $Lan1 nmcli connection up $Lan2 nmcli connection up $Bond

本文版权归作者和博客园共有欢迎转载但未经作者同意必须保留此段声明且在文章页面明显位置给出原文连接否则保留追究法律责任的权利

CentOS7设置双网卡 bond详解

设置变量

Bond=bond0 Lan1=em2 Lan2=em3 IP=10.2.1.21 Gateway=10.2.1.1 DNS="172.16.11.14 172.16.11.13" Dir=/etc/sysconfig/network-scripts

nmcli conn add type bond con-name $Bond ifname $Bond mode balance-rr nmcli conn add type bond-slave con-name $Lan1 ifname $Lan1 master $Bond nmcli conn add type bond-slave con-name $Lan2 ifname $Lan2 master $Bond

重启网络服务

systemctl restart network

关闭接口

nmcli conn down $Lan1 li conn down $Lan2 nmcli conn down $Bond

centos6.5双网卡bonding

一定要在服务管理中关闭NetworkManager服务并禁用自动启动。

第一步:先查看下本机网卡,使用命令到network-scripts 下1 2 3 4 5[root@root~]# cd /etc/sysconfig/network-scripts/[root@root network-scripts~]# lltotal 202-rw-r--r--1 root root 212 Mar 15 15:40 ifcfg-eth0-rw-r--r-- 1 root root 212 Mar 15 15:40 ifcfg-eth1第二步:复制ifcfg-bond0或者自己创造一个都可以,下面我介绍复制的命令1 [root@root network-scripts]# cp ifcfg-eth0 ifcfg-bond0复制好了查看一下1 2 3 4 5[root@root network-scripts]# lltotal 204-rw-r--r-- 1 root root 212 Mar 23 15.42 ifcfg-bond0-rw-r--r--1 root root 212 Mar 15 15:40 ifcfg-eth0-rw-r--r-- 1 root root 212 Mar 15 15:40 ifcfg-eth1第三步:编辑ifcfg-bond0、ifcfg-eth0、ifcfg-eth1 把里面内容替换一下内容[root@root network-scripts]# vim ifcfg-eth0 BOOTPROTO=noneDEVICE=eth0ONBOOT=yesMASTER=bond0SLAVE=yesUSERCTL=noTYPE=EthernetIPV6INIT=no[root@root network-scripts]# vim ifcfg-eth1 BOOTPROTO=noneDEVICE=eth1ONBOOT=yesMASTER=bond0SLAVE=yesUSERCTL=noTYPE=EthernetIPV6INIT=no[root@root network-scripts]# vim ifcfg-bond0BOOTPROTO=noneDEVICE=bond0ONBOOT=yesIPADDR=172.26.5.16NETMASK=255.255.255.128GATEWAY=172.26.5.126USERCTL=noTYPE=EthernetIPV6INIT=noDNS1=172.26.1.1第四步:模块加载[root@root ~]# cd /etc/modprobe.d/切换到modprobe.d目录下[root@root ~modprobe.d]#vi dist.conf#加载bonding模块,对外虚拟网络接口设备为bond0,在最后加入以下2行alias bond0 bondingoptions bond0 mode=1 miimon=100(备注本人试用mode=0,因为本人的交换机上做了双活)第五步:启动eth0和eth1网卡(有的人可以不用做这一步,因为本人的服务器是刚刚装的,eth0和eth1网卡都没有启动)1 2[root@root network-scripts]# ifconfig eth0 up [root@root network-scripts]# ifconfig eth1 up第七步:重启网络服务,使配置生效1 2 3 4 5 6 7 8 [root@root network-scripts]# service network restartShutting down interface bond0: [正确] Shutting down interface eth0: [正确] Shutting down interface eth1: [正确] Shutting down loopback interface: [正确] Bringing up loopback interface: [正确] Error adding address 10.1.3.210 for bond0.RTNETLINK answers: File exists [正确]第八步:验证是否双网卡绑定成功方法一:[root@root network-scripts]#ifconfig 成功的话显示的内容是bond0和em1、em2网卡的MAC地址是一样的。

linux中bonding配置步骤详解

本文介绍linux下的bonding 技术,linux 2.4.x 的内核中采用了这种技术,利用bonding 技术可以将多块网卡接口通过绑定虚拟成为一块网卡,在用户看来这个聚合起来的设备好像是一个单独的以太网接口设备,通俗点讲就是多块网卡具有相同的IP 地址而并行连接聚合成一个逻辑链路工作。

二、bond的几种算法Linux的bond支持7种工作模式,可以参考内核源码包文件:Documentation/networking/bonding.txt 。

这里逐一介绍。

模式1:mode=0 ,即:(balance-rr) Round-robin policy(平衡轮循策略)特点:传输数据包顺序是依次传输(即:第1个包走eth0,下一个包就走eth1….一直循环下去,直到最后一个传输完毕),此模式提供负载平衡和容错能力;但是我们知道如果一个连接或者会话的数据包从不同的接口发出的话,中途再经过不同的链路,在客户端很有可能会出现数据包无序到达的问题,而无序到达的数据包需要重新要求被发送,这样网络的吞吐量就会下降。

模式2:mode=1,即:(active-backup) Active-backup policy(主-备份策略)特点:只有一个设备处于活动状态,当一个宕掉另一个马上由备份转换为主设备。

mac地址是外部可见得,从外面看来,bond的MAC地址是唯一的,以避免switch(交换机)发生混乱。

此模式只提供了容错能力;由此可见此算法的优点是可以提供高网络连接的可用性,但是它的资源利用率较低,只有一个接口处于工作状态,在有N 个网络接口的情况下,资源利用率为1/N模式3:mode=2,即:(balance-xor) XOR policy(平衡策略)特点:基于指定的传输HASH策略传输数据包。

缺省的策略是:(源MAC地址XOR 目标MAC地址) % slave数量。

其他的传输策略可以通过xmit_hash_policy选项指定,此模式提供负载平衡和容错能力。

Centos7服务器Bond子接口配置文档

Centos7服务器Bond子接口配置文档目录Centos7服务器Bond子接口配置文档 (1)1.什么是bond? (2)2.为什么使用bond? (2)3.bonding的七种工作模式: (2)4.使用场景 (3)*5.Centos7配置bonding (3)5.1创建基于bond0接口的配置文件 (3)5.2 bond4下启动vlan子接口 (4)5.3 修改用于做bond的物理网卡接口的配置文件 (4)5.4 bonding模式4配置 (6)5.5 关闭和停止NetworkManager服务 (6)5.6 重启网络服务 (7)5.7 查看bond0的接口状态信息 (7)5.8 配置完成后重启测试ping网关 (9)1.什么是bond?CentOS7系统可以将多个网络接口绑定在一起,来作为单一的接口去给上层应用使用。

2.为什么使用bond?bong可以将多个网卡绑定到一起,可以让两个或多个接口作为一个接口,同时提高带宽,并提供网络链路的冗余,当有其中一块网卡故障的时候,不会中断服务器的业务。

3.bonding的七种工作模式:bonding技术提供了七种工作模式,在使用的时候需要指定一种,每种有各自的优缺点.balance-rr (mode=0) 默认,有高可用 (容错) 和负载均衡的功能,需要交换机的配置,每块网卡轮询发包 (流量分发比较均衡). active-backup (mode=1) 只有高可用 (容错) 功能, 不需要交换机配置, 这种模式只有一块网卡工作, 对外只有一个mac地址。

缺点是端口利用率比较低balance-xor (mode=2) 不常用broadcast (mode=3) 不常用802.3ad (mode=4) IEEE 802.3ad动态链路聚合需要交换机配置balance-tlb (mode=5) 不常用balance-alb (mode=6) 有高可用 ( 容错 )和负载均衡的功能,不需要交换机配置 (流量分发到每个接口不是特别均衡)。

centos 双网卡绑定

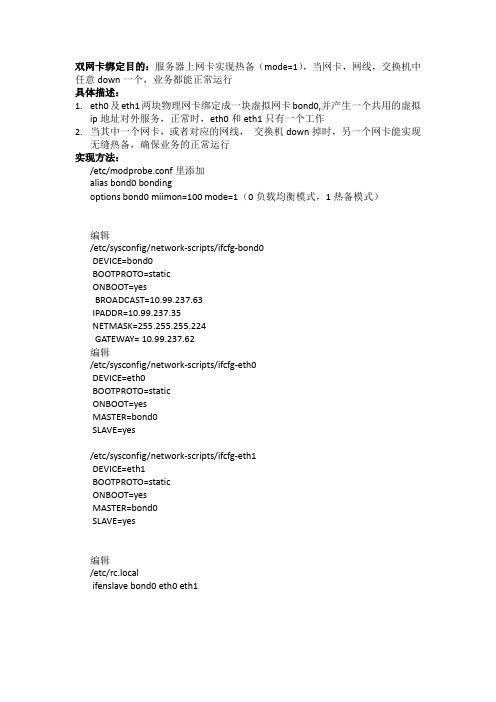

双网卡绑定目的:服务器上网卡实现热备(mode=1),当网卡,网线,交换机中任意down一个,业务都能正常运行具体描述:1.eth0及eth1两块物理网卡绑定成一块虚拟网卡bond0,并产生一个共用的虚拟ip地址对外服务,正常时,eth0和eth1只有一个工作2.当其中一个网卡,或者对应的网线,交换机down掉时,另一个网卡能实现无缝热备,确保业务的正常运行实现方法:/etc/modprobe.conf里添加alias bond0 bondingoptions bond0 miimon=100 mode=1(0负载均衡模式,1热备模式)编辑/etc/sysconfig/network-scripts/ifcfg-bond0DEVICE=bond0BOOTPROTO=staticONBOOT=yesBROADCAST=10.99.237.63IPADDR=10.99.237.35NETMASK=255.255.255.224GATEWAY= 10.99.237.62编辑/etc/sysconfig/network-scripts/ifcfg-eth0DEVICE=eth0BOOTPROTO=staticONBOOT=yesMASTER=bond0SLAVE=yes/etc/sysconfig/network-scripts/ifcfg-eth1DEVICE=eth1BOOTPROTO=staticONBOOT=yesMASTER=bond0SLAVE=yes编辑/etc/rc.localifenslave bond0 eth0 eth1实施后的测试:重启网卡进行测试,cat /proc/net/bonding/bond0 然后重启机器进行测试,任意拔掉其中一根网线,看是否能ping通最后步骤:机器接线复原。

centos系统多网卡的负载均衡设置

Centos多网卡负载均衡配置方法:1、查看bonding模块是否加载lsmod | grep bondingbonding 136705 0如果没有加载,手动先加载modprobe bonding2、三种绑定模式:① mode=0:平衡负载模式,有自动备援,但需要交换机支持及设定,两个交换机端口需要做聚合,该模式下bond所绑定的网卡的IP都被修改成相同的mac地址,交换机做了聚合后,聚合下的几个端口也被捆绑成一个mac地址。

②mode=1:自动备援模式,其中一条线若断线,其他线路将会自动备援。

③mode=6:平衡负载模式,有自动备援,不用交换机支持,绑定的是不同的MAC地址。

所以一定要根据自己的网络环境和实际的硬件设备,来选择其中一种绑定的模式,选择错误就会不生效哦!3、绑定完成后,就要进行以下网卡配置:1)新建或者修改虚拟网卡:vi /etc/sysconfig/network-scxxxxripts/ifcfg-bond0DEVICE=bond0IPADDR=192.168.0.193NETMASK=255.255.255.0BOOTPROTO=staticONBOOT=yesGATEWAY=192.168.0.12)修改需要加入负载均衡的网卡vi /etc/sysconfig/network-scxxxxripts/ifcfg-eth1DEVICE=eth0BOOTPROTO=noneONBOOT=yesMASTER=bond0SLAVE=yesvi /etc/sysconfig/network-scxxxxripts/ifcfg-eth2DEVICE=eth1BOOTPROTO=noneONBOOT=yesMASTER=bond0SLAVE=yes4、新增或修改虚拟网卡类型配置(一定要结合实际环境选择mode的模式)vi /etc/modprobe.confalias bond0 bondingoptions bonding miimon=100 mode=65、以上配置修改完成后执行reboot重启即可。

centos系统网口聚合(bonding)的配置

Memory:fba00000-fba20000

另外,还可以看/sys/class/net/下面的bonding驱动的模块参数的值,比如:

# cat /sys/class/net/bonding_masters

# ifconfig eth1

eth1 Link encap:Ethernet HWaddr 50:B3:42:00:01:08

UP BROADCAST SLAVE MULTICAST MTU:1500 Metric:1

RX packets:0 errors:0 dropped:0 overruns:0 frame:0

USERCTL=no

然后再修改ifcfg-eth1~ifcfg-eth4文件的内容,记住,先将备份原来的ifcfg-eth1,以便于恢复配置,^_^,例如ifcfg-eth1的内容为:

#cat ifcfg-eth1

DEVICE=eth1

USERCTL=no

ONBOOT=yes

MASTER=bond2 #belong to bond2

SLAVE=yes #is bond1's slave

BOOTPROTO=none

文件ifcfg-eth2~ifcfg-eth4只需要修改对应的DEVIE后面的值即可,记住添加文件的可执行属性。

配置网口聚合的时候,我选择了两种模式:balance-rr和active-backup。balance-rr模式采用的是轮转算法(round-robin),即数据包会按顺序从第一个可用的绑定网口(即该聚合口的slave)到最后一个slave中传输,此时每个slave上都会有数据流量,而active-backup模式采用的是备份算法,此时只有一个slave是激活的,只有该salve上有数据流量,当该slave有问题不能正常工作时,其他的某个slave会被激活,

CentOS6.5网卡绑定配置

CentOS6.5 网卡绑定配置1、环境描述安装Centos 6.5 64位加上双口的Intel千兆网卡,通过ifconfig -a|grep eth 命令看到eth0和eth1两张网卡。

2、双网卡绑定步骤:2.1 修改/etc/sysconfig/network-scripts/ifcfg-eth2配置文档,修改后的内容如下:代码如下:DEVICE=eth0ONBOOT=yes #系统启动时自动启用该设备BOOTPROTO=none #启动时不使用任何协议MASTER=bond0SLAVE=yes2.2 修改/etc/sysconfig/network-scripts/ifcfg-eth3配置文档,修改后的内容如下:代码如下:DEVICE=eth1ONBOOT=yes #系统启动时自动启用该设备BOOTPROTO=none #启动时不使用任何协议MASTER=bond0SLAVE=yes2.3 创建一个绑定网络口的配置文档/etc/sysconfig/network-scripts/ifcfg-bond0,内容如下:代码如下:DEVICE=bond0 #虚拟网卡名称BOOTPROTO=staticIPADDR=192.168.11.77 #IP地址NETMASK=255.255.255.0 #子网掩码GATEWAY=192.168.11.1 #网关BORADCAST=192.168.88.255 #广播地址,可忽略不写DNS1=1.2.4.8DNS2=180.76.76.76ONBOOT=yesTYPE=Ethernet2.4 修改/etc/modprobe.d/dist.conf,配置绑定模型,配置文件最后加入以下内容:alias bond0 bondingoptions bond0 miimon=100 mode=0#选项 millmon 是指定隔多长时间来进行链路监测,单位是ms。

#选项 mode 是表示绑定口的工作模式,有0-7共7种模式,常用的有0和1模式,mode=0表示"round-robin"策略,两张卡同时工作在负载均衡状态。

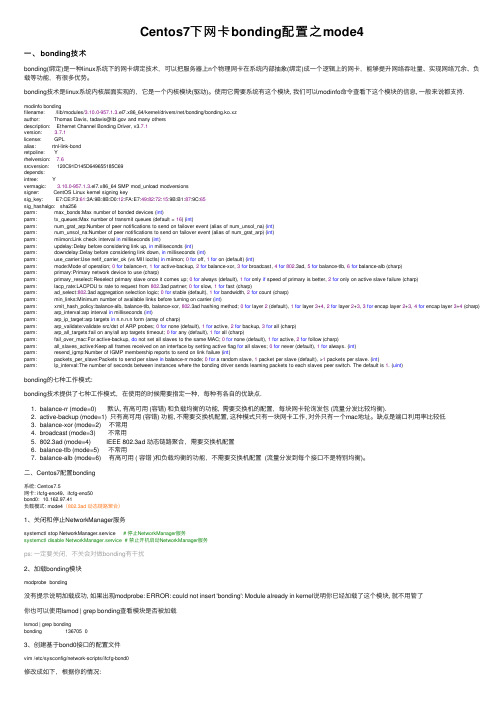

Centos7下网卡bonding配置之mode4

Centos7下⽹卡bonding配置之mode4⼀、bonding技术bonding(绑定)是⼀种linux系统下的⽹卡绑定技术,可以把服务器上n个物理⽹卡在系统内部抽象(绑定)成⼀个逻辑上的⽹卡,能够提升⽹络吞吐量、实现⽹络冗余、负载等功能,有很多优势。

bonding技术是linux系统内核层⾯实现的,它是⼀个内核模块(驱动)。

使⽤它需要系统有这个模块, 我们可以modinfo命令查看下这个模块的信息, ⼀般来说都⽀持. modinfo bondingfilename: /lib/modules/3.10.0-957.1.3.el7.x86_64/kernel/drivers/net/bonding/bonding.ko.xzauthor: Thomas Davis, tadavis@ and many othersdescription: Ethernet Channel Bonding Driver, v3.7.1version: 3.7.1license: GPLalias: rtnl-link-bondretpoline: Yrhelversion: 7.6srcversion: 120C91D145D649655185C69depends:intree: Yvermagic: 3.10.0-957.1.3.el7.x86_64 SMP mod_unload modversionssigner: CentOS Linux kernel signing keysig_key: E7:CE:F3:61:3A:9B:8B:D0:12:FA:E7:49:82:72:15:9B:B1:87:9C:65sig_hashalgo: sha256parm: max_bonds:Max number of bonded devices (int)parm: tx_queues:Max number of transmit queues (default = 16) (int)parm: num_grat_arp:Number of peer notifications to send on failover event (alias of num_unsol_na) (int)parm: num_unsol_na:Number of peer notifications to send on failover event (alias of num_grat_arp) (int)parm: miimon:Link check interval in milliseconds (int)parm: updelay:Delay before considering link up, in milliseconds (int)parm: downdelay:Delay before considering link down, in milliseconds (int)parm: use_carrier:Use netif_carrier_ok (vs MII ioctls) in miimon; 0for off, 1for on (default) (int)parm: mode:Mode of operation; 0for balance-rr, 1for active-backup, 2for balance-xor, 3for broadcast, 4for802.3ad, 5for balance-tlb, 6for balance-alb (charp)parm: primary:Primary network device to use (charp)parm: primary_reselect:Reselect primary slave once it comes up; 0for always (default), 1for only if speed of primary is better, 2for only on active slave failure (charp)parm: lacp_rate:LACPDU tx rate to request from 802.3ad partner; 0for slow, 1for fast (charp)parm: ad_select:802.3ad aggregation selection logic; 0for stable (default), 1for bandwidth, 2for count (charp)parm: min_links:Minimum number of available links before turning on carrier (int)parm: xmit_hash_policy:balance-alb, balance-tlb, balance-xor, 802.3ad hashing method; 0for layer 2 (default), 1for layer 3+4, 2for layer 2+3, 3for encap layer 2+3, 4for encap layer 3+4 (charp) parm: arp_interval:arp interval in milliseconds (int)parm: arp_ip_target:arp targets in n.n.n.n form (array of charp)parm: arp_validate:validate src/dst of ARP probes; 0for none (default), 1for active, 2for backup, 3for all (charp)parm: arp_all_targets:fail on any/all arp targets timeout; 0for any (default), 1for all (charp)parm: fail_over_mac:For active-backup, do not set all slaves to the same MAC; 0for none (default), 1for active, 2for follow (charp)parm: all_slaves_active:Keep all frames received on an interface by setting active flag for all slaves; 0for never (default), 1for always. (int)parm: resend_igmp:Number of IGMP membership reports to send on link failure (int)parm: packets_per_slave:Packets to send per slave in balance-rr mode; 0for a random slave, 1 packet per slave (default), >1 packets per slave. (int)parm: lp_interval:The number of seconds between instances where the bonding driver sends learning packets to each slaves peer switch. The default is 1. (uint)bonding的七种⼯作模式:bonding技术提供了七种⼯作模式,在使⽤的时候需要指定⼀种,每种有各⾃的优缺点.1. balance-rr (mode=0) 默认, 有⾼可⽤ (容错) 和负载均衡的功能, 需要交换机的配置,每块⽹卡轮询发包 (流量分发⽐较均衡).2. active-backup (mode=1) 只有⾼可⽤ (容错) 功能, 不需要交换机配置, 这种模式只有⼀块⽹卡⼯作, 对外只有⼀个mac地址。

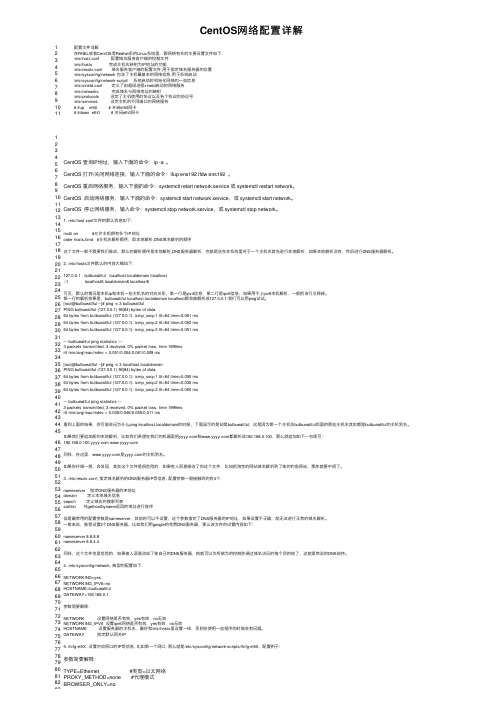

CentOS网络配置详解

CentOS⽹络配置详解1 2 3 4 5 6 7 8 9 10 11配置⽂件详解在RHEL或者CentOS等Redhat系的Linux系统⾥,跟⽹络有关的主要设置⽂件如下:/etc/host.conf 配置域名服务客户端的控制⽂件/etc/hosts 完成主机名映射为IP地址的功能/etc/resolv.conf 域名服务客户端的配置⽂件,⽤于指定域名服务器的位置/etc/sysconfig/network 包含了主机最基本的⽹络信息,⽤于系统启动./etc/sysconfig/network-script/ 系统启动时初始化⽹络的⼀些信息/etc/xinetd.conf 定义了由超级进程xinetd启动的⽹络服务/etc/networks 完成域名与⽹络地址的映射/etc/protocols 设定了主机使⽤的协议以及各个协议的协议号/etc/services 设定主机的不同端⼝的⽹络服务# ifup eth0 # 开启eth0⽹卡# ifdown eth0 # 关闭eth0⽹卡 1234 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83CentOS 查询IP地址,输⼊下⾯的命令:ip -a 。

CentOS 打开/关闭⽹络连接,输⼊下⾯的命令:ifup ens192 ifdw ens192 。

CentOS 重启⽹络服务,输⼊下⾯的命令:systemctl retart network.service 或 systemctl restart network。

Centos双网卡绑定教程

1、环境描述我的Vmware workstation 10 安装Centos 6.5 64位加上双口的Intel千兆网卡,通过ifconfig -a|grep e th命令看到eth2和eth3两张网卡。

2、双网卡绑定步骤:2.1 修改/etc/sysconfig/network-scripts/ifcfg-eth2配置文档,修改后的内容如下:2.2 修改/etc/sysconfig/network-scripts/ifcfg-eth3配置文档,修改后的内容如下:2.3 创建一个绑定网络口的配置文档/etc/sysconfig/network-scripts/ifcfg-bond0,内容如下:2.4 修改/etc/modprobe.d/dist.conf,配置绑定模型,配置文件最后加入以下内容:alias bond0 bondingoptions bond0 miimon=100 mode=0#选项millmon 是指定隔多长时间来进行链路监测,单位是ms。

#选项mode 是表示绑定口的工作模式,有0-7共7种模式,常用的有0和1模式,mode=0表示"round-robi n"策略,两张卡同时工作在负载均衡状态。

mode=1表示"active-backup"策略,两张卡一用一备的备份状态。

2.5 修改的是/etc/rc.local,负责在系统启动时将虚拟网卡和两张物理网卡相绑定,增加以下内容:ifenslave bond0 eth2 eth33、重启网卡使操作生效service network restart注意:将networkmanager服务关闭并设置为开机不启动以防止干扰相关的操作4、测试任何一块网卡被ifdown后,不影响服务器的正常通讯ifdown /etc/sysconfig/network-scripts/ifcfg-eth2 (通过这样可以down了其中一个网卡,如果网络正常,证明成功)Ifup /etc/sysconfig/network-scripts/ifcfg-eth 2 (把网卡up起来,正常使用)。

bond绑定模式与操作(centos7)

bond绑定模式与操作(centos7)标签:centos bond 一、简介二、模式注*建议学之前先看这个文章/galdys/article/details/7506495 1、balance-rr 轮转策略:按照顺序轮流使用每个接口来发送和接收数据包,提高了负载均衡的能力,但是需要交换机的支持,因为该模式所有端口的mac地址相同,交换机不能识别多个一个Mac地址对应多个端口,所以需要做链路聚合----Ethernet Channel mode=02、active-backup 主备策略:只使用其中一个网卡,当网卡损坏时激活另外的一个网卡mode=13、balance-xor 平衡策略:基于所选择的传送hash策略mode=24、广播策略:所有卡上都接收和发送报文,提高了容错性mode=35、802.3ad 链路聚合模式802.3ad策略:LACP 链路聚合模式,交换机得开启链路聚合,将两张网卡当做一张来使用,提高链路性能,需要交换机支持802.3ad 动态链路聚合和服务器硬件支持ethtool。

mode=4 6、balance-tlb 自适应传输负载均衡不需要配置交换机。

在每个网卡会根据上根据当前的负载情况来分配流量。

如果一个网卡出现故障,那么另外一个网卡会接管故障网卡mode=57、balance-alb 自适应负载均衡:包括balance-tlb,不需要另外配置交换机,接受负载均衡通过ARP协商实现当本机发送ARP请求时,bonding驱动把对端的IP信息从ARP包中复制并保存下来,当ARP 应答从对端到达时,bonding驱动把它的硬件地址提取出来,并发起一个ARP应答给bond中的某个slave。

使用ARP协商进行负载均衡的一个问题是:每次广播ARP请求时都会使用bond的硬件地址,因此对端学习到这个硬件地址后,接收流量将会全部流向当前的slave。

这个问题可以通过给所有的对端发送更新(ARP应答)来解决,应答中包含他们独一无二的硬件地址,从而导致流量重新分布。

CentOS 7 网卡bond配置

CentOS 7 网卡bond配置对p1p1 p1p2两张网卡做bond步骤1) 做之前请对各网卡配置进行备份1 使用root账号登录服务器2 cp p1p1 p1p2网卡的初始配置到tmp 目录下,进行备份。

-------------------------------------------------------------- [root@XACR-aliware04 ~]# cd /etc/sysconfig/network-scripts/ [root@XACR-aliware04 network-scripts]# cp ifcfg-p1p1 /tmp [root@XACR-aliware04 network-scripts]# cp ifcfg-p1p2 /tmp-------------------------------------------------------------- 2) 使用nmcli命令配置bond生成bond配置-------------------------------------------------------------- nmcli con add type bond ifname bond0 mode 1nmcli con add type bond-slave ifname p1p1 master bond0 nmcli con add type bond-slave ifname p1p2 master bond0注:p1p1 p1p2 为物理网卡的名字bond的mode如下:balance-rr (0) --轮询模式(bond默认的模式)active-backup (1) --主备模式(常用)balance-xor (2)broadcast (3)802.3ad (4) --聚合模式balance-tlb (5)balance-alb (6)-------------------------------------------------------------- 3) 修改bond0网卡配置修改下面表格中标红的内容--------------------------------------------------------------- cd /etc/sysconfig/network-scripts[root@XACR-aliware04 network-scripts]# vim ifcfg-bond-bond0 DEVICE=bond0BONDING_OPTS=mode=active-backupTYPE=BondBONDING_MASTER=yesBOOTPROTO=static ---将原来的dhcp 改成static DEFROUTE=yesPEERDNS=yesPEERROUTES=yesIPV4_FAILURE_FATAL=noNAME=bond-bond0UUID=f4146d29-d694-4f13-ae59-56f940c7d120ONBOOT=yesIPADDR=192.168.80.7 ---配置分配给服务器的IP地址PREFIX=24 --配置子网掩码GATEWAY=192.168.80.1 ---配置网关保存并退出--------------------------------------------------------------- 4) 重启网络systemctl restart network –重启网络服务cat /proc/net/bonding/bond0 ---查看bond0接口的相关信息---------------------------------------------------------------- [root@XACR-aliware04 network-scripts]# cat /proc/net/bonding/bond0 Ethernet Channel Bonding Driver: v3.7.1 (April 27, 2011)Bonding Mode: fault-tolerance (active-backup)Primary Slave: NoneCurrently Active Slave: p1p2MII Status: upMII Polling Interval (ms): 100Up Delay (ms): 0Down Delay (ms): 0Slave Interface: p1p1MII Status: upSpeed: 10000 MbpsDuplex: fullLink Failure Count: 2Permanent HW addr: f4:e9:d4:9a:f1:a0Slave queue ID: 0Slave Interface: p1p2MII Status: upSpeed: 10000 MbpsDuplex: fullLink Failure Count: 2Permanent HW addr: f4:e9:d4:9a:f1:a2Slave queue ID: 0---------------------------------------------------------------- ---到此就完成bond配置了---。

Centos7bond(lacp)及vlan配置

[root@kunpeng-2 network-scripts]# cat ifcfg-bond0.700 DEVICE=bond0.700 VLAN=yes BOOTPROTO=none #USERCTL=no ONBOOT=yes #BRIDGE=virbr600 IPADDR=10.255.70.10 NETMASK=255.255.255.0 GATEWAY=10.255.70.254 DNS1=114.114.114.114

vlan600

注意:配置文件名称必须为:ifcfg-bond0.vlanid,设备DEVICE=bond0.vlanid,否则不生效。

[root@kunpeng-2 network-scripts]# cat ifcfg-bond0.600 DEVICE=bond0.600 VLAN=yes BOOTPROTO=none #USERCTL=no ONBOOT=yes #BRIDGE=virbr600 IPADDR=10.255.60.10 NETMASK=255.255.255.0 #GATEWAY=10.255.60.254 #

鲲鹏服务器配置

bond配置

网口连接使用enp125s0f2、enp125s0f3网口。

注:bond网口,ip配置非必须

注意:BONDING_OPTS="mode=4 miimon=100",“mode=4 miimon=100”应小写,不要大写

[root@kunpeng-2 network-scripts]# cat ifcfg-bond0 DEVICE=bond0 TYPE=Bond BONDING MASTER=yes BOOTPROTO=none USERCTL=no ONBOOT=yes BONDING_OPTS="mode=4 miimon=100" #BRIDGE=virbr1 IPADDR=10.255.50.17 NETMASK=255.255.255.0 GATEWAY=10.255.50.254 #

Centos 6.5 64位双网卡绑定教程

Centos 6.5 64 位双网卡绑定教程来源:互联网 作者:佚名 时间:12-13 20:56:03 【大 中 小】这篇文章主要介绍了 Centos 6.5 64 位双网卡绑定教程,需要的朋友可以参考下 1、环境描述 我的 Vmware workstation 10 安装 Centos 6.5 64 位加上双口的 Intel 千兆网卡,通 过 ifconfig -a|grep eth 命令看到 eth2 和 eth3 两张网卡。

2、双网卡绑定步骤: 2.1 修改/etc/sysconfig/network-scripts/ifcfg-eth2 配置文档,修改后的内容如下: 操作前需要确定 NetworkManager 服务是否已经停止,否则容易报错。

#service NetworkManager status Chkconfig NetworkManager off 务必要执行这个复制代码 代码如下:DEVICE=eth2 ONBOOT=yes #系统启动时自动启用该设备 BOOTPROTO=none MASTER=bond0 SLAVE=yes 2.2 修改/etc/sysconfig/network-scripts/ifcfg-eth3 配置文档,修改后的内容如下: #启动时不使用任何协议复制代码 代码如下:DEVICE=eth3 ONBOOT=yes #系统启动时自动启用该设备 BOOTPROTO=none MASTER=bond0 SLAVE=yes #启动时不使用任何协议2.3 创建一个绑定网络口的配置文档/etc/sysconfig/network-scripts/ifcfg-bond0, 内容如下:复制代码 代码如下:DEVICE=bond0 #虚拟网卡名称 BOOTPROTO=static IPADDR=192.168.88.11 #IP 地址 NETMASK=255.255.255.0 #子网掩码 GATEWAY=192.168.88.1 #网关 BORADCAST=192.168.88.255 #广播地址 DNS1=8.8.8.8 DNS2=222.88.88.88 ONBOOT=yes TYPE=Ethernet 2.4 修改/etc/modprobe.d/dist.conf,配置绑定模型,配置文件最后加入以下内容: alias bond0 bonding options bond0 miimon=100 mode=0 #选项 millmon 是指定隔多长时间来进行链路监测,单位是 ms。

Centos5.5配置双TOE网卡bonding

默认分类 2010-06-28 23:54:58 阅读162 评论0

字号:大中小

订阅

新建一个虚拟网卡bond0,可以复制eth0的,复制后要修改内容.

复制 (cp –a /etc/sysconfig/network-scripts/ifcfg-eth0 ifcfg-bond0)修改内容为如下:

modprobe bonding

重新起动网络

service netowrk res结果,cat /proc/net/bonding/bond0

4.修改/etc/modprobe.conf,添加内容如下:

alias bond0 bonding

options bond0 miimon=100 mode=1

注意:mode可以为0, 1, 0为冗余负载均衡,1为失效保护,

5、测试之前,先看看有没有加载bonding内核模块(使用lsmod | grep bonding命令),如果没有,那就加载它,使用下面的命令;

DEVICE=eth0

BOOTPROTO=none

MASTER=bond0

SLAVE=yes

ONBOOT=yes

3、 eth1 也是同样的修改.如下:

DEVICE=eth1

BOOTPROTO=none

MASTER=bond0

SLAVE=yes

ONBOOT=yes

DEVICE=bond0

BOOTPROTO=none

IPADDR=192.168.100.100

NETMASK=255.255.255.0

NETWORK=192.168.100.0

Linux bonding配置指导书(CentOS5.3)

1 CentOS5.3配置指导1.1 网络规划举例来说,服务器有网卡eth0、eth1,需要将这两个进行绑定使用,绑定后虚拟网卡为bond0.1.2 内核模块加载设置在/etc/modprobe.conf 文件中,增加启用的bond口的内核模块,形式如下:alias bond0 bonding这里表示需要生效bond0口,并为其加载bonding内核模块。

1.3 增加网口配置信息修改/etc/sysconfig/network-scripts/ 目录下对应的网卡配置文件,并新增bond0口的配置,配置文件信息内容如下:[root@vm25481 network-scripts]# cat ifcfg-bond0DEVICE=bond0BOOTPROTO=staticONBOOT=yesIPADDR=192.168.254.89NETMASK=255.255.255.0GATEWAY=192.168.254.1TYPE=EthernetUSERCTL=noBONDING_OPTS="mode=2 xmit_hash_policy=1 miimon=100"[root@vm25481 network-scripts]# cat ifcfg-eth0DEVICE=eth0BOOTPROTO=noneONBOOT=yesMASTER=bond0USERCTL=noSLAVE=yes[root@vm25481 network-scripts]# cat ifcfg-eth1DEVICE=eth1BOOTPROTO=noneONBOOT=yesMASTER=bond0USERCTL=noSLAVE=yes注意:要去除物理网卡配置中mac地址的信息。

1.4 连接网线并进行交换机配置由于选用的是“mode=2 xmit_hash_policy=1”,若接到同一交换机,交换机上需做手工聚合,同时配置负载分摊模式,否则会产生MAC地址振荡,最终配置聚合配置及模式如下:[H3C-Bridge-Aggregation1]display link-aggregation load-sharing modeLink-Aggregation Load-Sharing Mode:Layer 2 traffic: destination-mac address, source-mac addressLayer 3 traffic: destination-ip address, source-ip address[H3C-Bridge-Aggregation1]1.5 配置生效确认[root@vm25481 ~]# routeKernel IP routing tableDestination Gateway Genmask Flags Metric Ref Use Iface 192.168.254.0 * 255.255.255.0 U 0 0 0 bond0 169.254.0.0 * 255.255.0.0 U 0 0 0 bond0 default 192.168.254.1 0.0.0.0 UG 0 0 0 bond02 部署过程中问题2.1 启动过程打印网卡为百兆设备启动过程中打印如下信息:bonding: bond0: Warning: failed to get speed and duplex from eth1, assumed to be100Mb/sec and Full.bnx2: eth0 NIC Link is Up, 1000 Mbps full duplex, receive & transmit flow control ONbonding: bond0: backup interface eth1 is now up上述信息是由于bond0先于物理网卡启动,因此,无法获取到相关信息,当物理网卡启动后,会通知bond来更新速率和双工信息。

centos网卡bonding配置方法和管理技巧

centos网卡bonding配置方法和管理技巧2014年12月5日 by gaoqing1、修改网卡配置文件编辑/etc/sysconfig/network-scripts/目录下的网卡配置文件,一般情况下网卡是以eth+数字命名,但也有其它命名方式。

需要以自己的主机系统实际的网卡配置文件名称为准。

1.1 在该目录下创建一个虚拟网卡#vi ifcfg-bond0DEVICE=bond0TYPE=EthernetONBOOT=yesNM_CONTROLLED=noBOOTPROTO=staticIPADDR=192.168.120.18PREFIX=24GATEWAY=192.168.120.1DNS1=8.8.8.8以上文件中的IPADDR,GATEWAY需要改成自己的IP地址,其它可不变。

1.2 修改编号最小的两块网卡的配置文件#vi ifcfg-eth0DEVICE=eth0HWADDR=D9:9D:67:23:01:8CTYPE=EthernetUUID=b81edbe0-f469-49f9-8add-6b7deb4d65bfONBOOT=yesNM_CONTROLLED=noBOOTPROTO=noneMASTER=bond0SLAVE=yes以上文件中HWADDR,UUID需要修改成自己主机的配置信息。

#vi ifcfg-eth1DEVICE=eth1HWADDR=D9:9D:67:23:01:8DTYPE=EthernetUUID=9d7af089-666d-42d4-9246-444e0e243d10ONBOOT=yesNM_CONTROLLED=noBOOTPROTO=noneMASTER=bond0SLAVE=yes以上文件中HWADDR,UUID需要修改成自己主机的配置信息。

2、增加/etc下的系统加载模块配置文件#cd /etc/modprobe.d#vi /etc/modprobe.d/modprobe.conf输入内容为:alias bond0 bondingoptions bond0 miimon=100 mode=13、设置系统启动时自动启用网卡绑定功能#vi /etc/rc.d/rc.local在最后增加一行,内容如下:#!/bin/sh## This script will be executed *after* all the other init scripts. # You can put your own initialization stuff in here if you don't # want to do the full Sys V style init stuff.touch /var/lock/subsys/localifenslave bond0 eth0 eth14、重启5、查看网卡绑定的效果命令1:$ ifconfigbond0 Link encap:Ethernet HWaddr D9:9D:67:23:01:8Cinet addr:192.168.120.18 Bcast:192.168.120.255 Mask:255.255.255.0inet6 addr: fe80::da9d:67ff:fe23:18c/64 Scope:LinkUP BROADCAST RUNNING MASTER MULTICAST MTU:1500 Metric:1RX packets:5030148 errors:0 dropped:0 overruns:0 frame:0TX packets:432215 errors:0 dropped:0 overruns:0 carrier:0collisions:0 txqueuelen:0RX bytes:410554080 (391.5 MiB) TX bytes:74281439 (70.8 MiB)eth0 Link encap:Ethernet HWaddr D9:9D:67:23:01:8CUP BROADCAST RUNNING SLAVE MULTICAST MTU:1500 Metric:1RX packets:2719184 errors:0 dropped:0 overruns:0 frame:0TX packets:409744 errors:0 dropped:0 overruns:0 carrier:0collisions:0 txqueuelen:1000RX bytes:234166640 (223.3 MiB) TX bytes:71259924 (67.9 MiB)Interrupt:32eth1 Link encap:Ethernet HWaddr D9:9D:67:23:01:8CUP BROADCAST RUNNING SLAVE MULTICAST MTU:1500 Metric:1RX packets:2310964 errors:0 dropped:0 overruns:0 frame:0TX packets:22471 errors:0 dropped:0 overruns:0 carrier:0collisions:0 txqueuelen:1000RX bytes:176387440 (168.2 MiB) TX bytes:3021515 (2.8 MiB)Interrupt:36命令2:#cat /proc/net/bonding/bond0Ethernet Channel Bonding Driver: v3.6.0 (September 26, 2009) Bonding Mode: fault-tolerance (active-backup)Primary Slave: eth0 (primary_reselect always)Currently Active Slave: eth0MII Status: upMII Polling Interval (ms): 100Up Delay (ms): 0Down Delay (ms): 0Slave Interface: eth0MII Status: upSpeed: 1000 MbpsDuplex: fullLink Failure Count: 4Permanent HW addr: d8:d3:85:a5:74:72 Slave queue ID: 0Slave Interface: eth1MII Status: upSpeed: 1000 MbpsDuplex: fullLink Failure Count: 1Permanent HW addr: d8:d3:85:a5:74:74 Slave queue ID: 0命令3:#ethtool eth0#ethtool eth1命令4:可以使用该命令切换主备网卡如果当前是eth0为主,eth1为备,那么ifenslave -c bond0 eth1 将网卡eth1切换为active。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

centos bond配置

1.编辑虚拟网络接口配置文件,指定网卡IP:

# vi /etc/sysconfig/network-scripts/ifcfg-bond0

DEVICE=bond0

TYPE=ethernet

ONBOOT=yes

BOOTPROTO=static

IPADDR=10.9.1.24

NETMASK=255.255.255.0

IPV6INIT=no

USERCTL=no

GATEWAY=10.9.1.254

DNS1=114.114.114.114(此为服务器可出外网配置,内网可不配)

2.配置eth0、eth1网卡

DEVICE=eth0

HWADDR=1C:98:EC:14:5B:40

TYPE=Ethernet

UUID=(以实际为准)

ONBOOT=yes

NM_CONTROLLED=yes

BOOTPROTO=none

MASTER=bond0

Eth1与eth0配法相同。

3.# vi /etc/modules.conf

编辑 /etc/modprobe.conf或者/etc/modules.conf或者/etc/modprobe.d/dist.conf,加入如下两行内容,以使系统在启动时加载bonding模块,对外虚拟网络接口设备为bond0.加入下列两行:

alias bond0 bonding

options bond0 miimon=100 mode=1 primary=eth0

说明:miimon是用来进行链路监测的。

比如:miimon=100,那么系统每100ms监测一次路连接状态,如果有一条线路不通就转入另一条线路;mode的值表示工作模式。

mode=0 表示负载均衡方式,两块网卡都工作,需要交换机作支持

mode=1 表示冗余方式,网卡只有一个工作,一个出问题启用另外的

mode=6 表示负载均衡方式,两块网卡都工作,不需要交换机作支持

primary指定主网卡

4、编辑开机启动项

vi /etc/rc.d/rc.local 加入两行,加在启动自运行文件里面ifenslave bond0 eth0 eth1

modprobe bonding miimon=100 mode=1。