Web缓存系统组网方式研究

Web搜索引擎的缓存策略研究的开题报告

Web搜索引擎的缓存策略研究的开题报告

一、选题背景

Web搜索引擎是现代人日常使用频率较高的网络服务之一,其功能主要是能够从互联网上搜索相关的网页信息,以供用户查看和使用。

而作为搜索引擎的核心技术之一,缓存策略的设计和实现对提高搜索引擎的性能和用户体验非常重要。

因此,在Web搜索引擎的性能优化和用户体验提升方面,研究缓存策略是必不可少的。

二、研究目的

本研究的主要目的是深入研究Web搜索引擎的缓存策略,并通过对现有缓存策略的分析和对相关技术的学习,提出一种更加优化的缓存策略,以提高搜索引擎的性能并改善用户体验。

三、研究内容

(1)Web搜索引擎的缓存策略研究现状和相关技术的研究成果及应用情况的调研和分析,深入了解现有缓存策略的特点和不足。

(2)分析Web搜索引擎运行流程,结合缓存策略的设计原则,探索更加智能化、高效化的缓存策略设计。

(3)设计和实现Web搜索引擎的缓存策略,并与现有搜索引擎进行比较分析,验证新策略的高效性和优越性。

四、研究方法

本文主要采用文献资料法、案例研究法、实验研究法等多种研究方法。

具体地,对Web搜索引擎的现状和相关技术,主要通过查阅文献资料和分析实际案例,了解缓存策略的设计特点和局限性。

而对于新策略的设计和实现,主要采用实验研究法,通过模拟和对比实验等方法,验证其高效和优越性。

五、研究意义

Web搜索引擎涉及到大量数据的处理和传输,其性能和用户体验直

接影响着广大用户的使用体验和使用效率。

本研究主要通过对缓存策略

的研究和优化,为改善Web搜索引擎的性能和用户体验做出贡献,对于

推动搜索引擎技术的发展以及提升用户的使用体验具有非常重要的意义。

Web代理服务器的缓存技术研究中期报告

Web代理服务器的缓存技术研究中期报告本次研究旨在探究Web代理服务器缓存技术的实现原理及其在提高Web访问效率方面的作用。

在此中期报告中,我将介绍研究的背景和目的,研究所涉及到的相关概念和技术,以及已经进行的研究和所取得的进展。

一、研究背景和目的由于互联网广泛的应用,人们对Web应用的访问也日益增加,这对Web服务器的性能提出了更高的要求。

为了缓解Web服务器的负载,提高Web访问效率,Web代理服务器被广泛用于减轻Web服务器的压力。

Web代理服务器可以对Web请求进行拦截和缓存,提高用户Web访问的响应速度。

因此,研究Web代理服务器缓存技术对于优化Web应用性能具有重要的意义。

本次研究的目的是探索Web代理服务器缓存技术的原理和实现方式,分析其优缺点,比较不同的缓存策略对Web应用性能的影响,并根据实验结果给出一些建议。

二、相关概念和技术1. Web代理服务器Web代理服务器是一种位于客户端和Web服务器之间的服务器,它可以接收客户端的请求并进行处理,也可以向Web服务器发送请求并接收响应。

2. 缓存缓存是一种在本地存储数据的技术,可以节省网络流量并提高数据访问速度。

3. 缓存策略缓存策略是指在缓存中保存和更新数据的规则和方法,包括FIFO、LRU、LFU等。

三、已进行的研究和进展在研究过程中,我们重点研究了Web代理服务器的缓存技术,并通过实验模拟Web请求和Web服务器响应的过程,对比了不同的缓存策略对Web应用性能的影响。

目前,我们已经完成了对标准Web响应模型的分析,包括Web请求过程、Web响应过程和Web代理服务器缓存的实现原理。

我们还分别实现了FIFO、LRU、LFU三种不同的缓存策略,并进行实验测试。

实验结果显示,采用缓存技术可以明显提高Web应用的访问速度,而不同的缓存策略对提高Web访问速度的效果也有所不同。

接下来,我们会继续深入地研究Web代理服务器的缓存技术,包括优化缓存算法、探索动态缓存策略、以及研究缓存一致性等问题。

无线局域网的Web缓存系统研究

sse rwi ls AN ,a dp ee t h aap eec n lo i m E rmo i o tsc c ewhc eest aami— y t f r esL m o e n rsnst ed t rfthg ag r h S DP f bl h s’ ah i rfr od t n i t o e h

维普资讯

计算机科学 2 0 Vo. 4 o 8 0 7 13 N .

无 线 局 域 网 的 We b缓 存 系统 研 究 )

鑫 金 蓓 弘 ( 中国科 学院软 件研 究所 软件 工 程技 术 中心 北 京 108 ) ( 国科 学 院研 究生 院 北 京 10 8 ) 0 00 中 0 00

算法 SD E P。模拟 实验数据表 明 S D E P算 法取得 了良好 的效果 。

关键词 缓 存 , 取 , 动 环 境 预 移

Re e r h o e c i s e i iee sLAN s a c n W b Ca h ng Sy t m n W r ls

TI AN i u PEN n J N iHo g S- a H Xi I Be- n

Ab ta t Ca h n c & Jm lya o tn o ei r vn h e fr n eo b l y tmswh c s a et e c n sr c c ig me h l s p a n i q mp r t l n i o i t ep ro ma c f a r mp g mo i s s e i mu tfc h o — e h s r it n h n h l e i sa dm b l n t r .Th sp p rd c i st ei lme t t n o a y c es se ,aW e a h n tan s i a d ed d v c n e o i e e wo k i a e e r h s  ̄. mpe n a i f s (a h y tm o E网络的普及 和移动设 备 的广泛应 用 , 越来越 多 的人 习惯 于使用手持设备随时随地访 问 Itrel 。 nen tj 】 基 于基 础设 施 的移 动 网络 (nrsrcue ae bl If tutr- sdMo i a b e Newok l 是移 动计 算 环境 中发展 最 快 的一 个部 分 。图 1 t r )2 ] 给出了这样的一个 网络环境 。这 里, 移动无线设备 ( 通称移动 主机 , 写 成 MH) 于 I E S 2 1 标 准 ( F) 简 基 E E 0. 1 Wii与访 问点 ( 简称 A ) P 建立无线 通信 , 并通 过 A P连 接到 有线 局域 网 , 从

基于.NET Cache+Memcached Web缓存技术的研究与应用

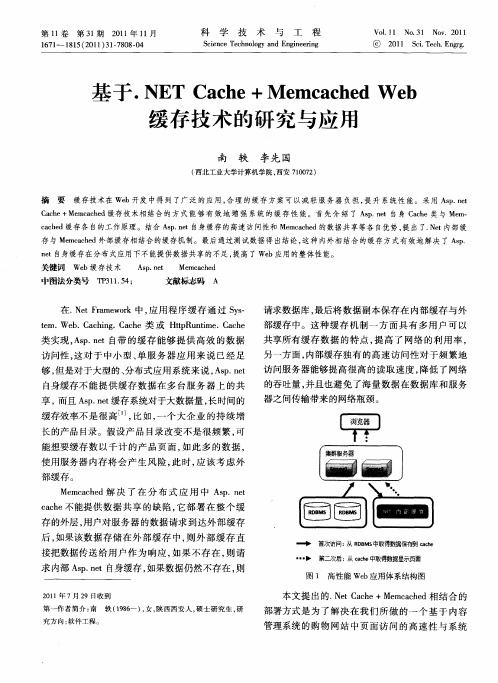

共享所有缓存数据 的特点 , 提高 了网络 的利用率 ,

另一 方 面 , 内部 缓存 独 有 的 高速 访 问 性 对 于频 繁 地 访 问服务 器能 够提 高很 高 的读 取 速度 , 降低 了 网络 的吞 吐量 , 并且 也避 免 了海 量数 据 在 数 据库 和 服 务 器之 问传 输带来 的网络瓶 颈 。

首次访问 : R B S 从 D M 中取得数据保有到 cce ah

-- -

第二次后 : c e 从 8 中取得数据显示页面

求内部 Ap nt s.e 自身缓存 , 如果数据仍然不存在 , 则

21 0 1年 7月 2 9日收到 第 一作者简介 : 南 轶 ( 96 18 一), , 女 陕西西安 人 , 硕士研 究生 , 研

南

轶 , : 于. E ah +M mcc e b 等 基 N TC c e e ahdWe 缓存技术 的研究 与应用

的稳定性所 提 出 的解决 方案 , 其体 系结 构如 图 1

所示 。

扩 展性 的 We 用 。Me cce b应 m ahd的分 布式如 图 2

所示。

1 We b缓存技术的研究

11 A p n t ah . s . e c e的研究 C

日

日

日

在. e Fa eo Nt r wr m k中, 用程序缓 存通过 Ss 应 y.

t We . tR ni e C c e t u t ' ah p m.

Me ahd解 决 了 在 分 布 式 应 用 中 A p nt mcce s. e cce 能提 供 数 据 共 享 的 缺 陷 , 部 署 在 整个 缓 ah 不 它 存 的外层 , 用户 对 服务 器 的数 据请 求 到达 外 部 缓 存

缓存技术在Web中的应用研究

第 4期

王鑫 : 存技术在 We 缓 b中的应 用研 究

求 都经 过缓存 的代 理访 问 Itre。在缓存 服务 器代 理用 户请 求访 问 Itre 之 前 , nent nent 它先 检查 自身是 否 已 经 缓存 了用 户请求 访 问 的 we b对象 , 果 已经缓 存并 且没 有过期 , 么 就用 本 地缓 存 的 we 如 那 b对象 响 应 客

Itr e 的快速 发展使 We nen t b服务器 必须 面对访 问者数量 快 速增 加 的局 面 , 这就 要求 网络服 务器 需 要

具备 提供大量并 发访 问服务 的能力 。因此 , 于提 供大 负载 We 对 b服务 的服 务器 来讲 , P To处 理能 力 C U、/ 很快会 成为瓶颈 , 用户访 问的速度会 下降 , 等待 网络 反应 的时 间将加 长 。调查 证 明 , 用户 愿 意等 待 网站 反 应 的平 均时 间不 足 1 。所 以 , 多运营 商和服 务提供商 正在斥 巨资来 提高 网络带宽 。 O秒 许 然而, 仅仅依 靠额外 的带 宽还不 能解决 网络等 待时 间或 加速 响应缓慢 的源服 务器 的问题 。研究 发现 , HTT P协议 在等待 建立 连接方 面花费 了 比传输 数据更 多 的时间 , 如果 能够减 少等待 的时 间 , 也就 可 以加速 网络的反 应速度 。我们 再看一下 W e b服务 器 方从 接 收到 一个 用 户 的请求 到将 用 户所 要 的数 据传 输 给对 方 的过程 , 对每 一个请求 , 服务 器都要先 在硬 盘上找 到相应 的对象 , 某些请 求还要访 问数据 库 , 后将 数据 然

读出, 放入 内存 中 , 再传输 给用户 。所 以 , 以通 过 减少 建立 网络连 接 的次 数 和加 快服 务器 端 的处 理 速度 可 来 提高整 个 网络 的反应 速度 。 缓存技 术有效 地缩短 了网络 用户取 回文档 的时 间 , 加快 了 We b服务 器 的反应 速度 。它 通过将 内容移 到距 离用户 更近 的地方解 决 了这 些 问题 。缓存 技术 不仅 有 利 于终端 用 户 , 而且 也 有利 于互 联 网服务 提供

Web代理服务器的缓存技术研究开题报告

Web代理服务器的缓存技术研究开题报告

一、研究背景

Web代理服务器是指一种网络代理服务器,负责请求转发或响应传回的信息。

代理服务器通常位于客户端和目标服务器之间,可用于提高网络性能、保护客户端网络安全和访问限制。

代理服务器的缓存技术是对Web请求和响应信息进行存储和重用,以减少对服务器的访问并提高性能。

因此,研究Web代理服务器的缓存技术能够有效提高网络的效率和响应速度,减缓服务器的压力,对于互联网应用的提升具有重要意义。

二、研究目的

本研究旨在探究Web代理服务器的缓存技术,结合实际应用场景,提出一种针对不同应用场景的缓存策略,提高网络性能和响应速度。

三、研究内容

1、 Web代理服务器的概述及缓存原理

2、 Web代理服务器缓存技术分类

3、 Web代理服务器缓存策略

4、 Web代理服务器缓存技术在不同场景下的应用

四、研究方法

1、文献调研

通过对Web代理服务器缓存技术相关的文献、论文以及国内外相关应用案例的调查和分析,掌握Web代理服务器缓存技术的基础知识,研究不同缓存技术的特点和优缺点,进而制定出一种符合应用实际的缓存策略。

2、实验研究

通过在实际场景下搭建Web代理服务器,依据制定好的缓存策略对不同类型的Web请求进行缓存,测试分析缓存策略的性能,比较不同缓

存策略的优劣。

五、研究意义

本研究通过对Web代理服务器缓存技术的研究和探讨,可以提出一种实用的缓存策略,可以提高Web访问的响应速度,缩短Web请求时间。

与此同时,也可以减少网络拥塞,降低服务器负载,为互联网应用的提

升和网络性能的改善发挥重要作用。

无线局域网的Web缓存研究与实现的开题报告

无线局域网的Web缓存研究与实现的开题报告一、研究背景随着无线局域网(Wireless Local Area Network,简称WLAN)的发展,WLAN已成为现代移动通信的重要组成部分。

然而,随着用户数量的不断增加,网络流量也急剧增加,导致WLAN的效率降低。

在大量用户同时使用WLAN的情况下,网络延迟和响应时间会显著增加,这对用户的体验和满意度造成严重影响。

Web缓存技术作为一种提高网络性能和用户体验的常见方法,可以有效解决WLAN网络效率低下的问题。

二、研究目的与意义本文旨在研究并实现WLAN的Web缓存技术,利用缓存技术减少Web请求的响应时间,提高WLAN网络的效率,提高用户的体验和满意度。

本文的研究方法将是基于深度学习算法建立Web数据包的特征库,并通过网络结构进行缓存数据的预测与匹配,以达到加快数据请求的响应速度和减少网络负载的效果。

三、研究内容与方法本文将主要研究Web缓存的工作原理和实现方法,建立数据包特征库和WLAN网络的缓存预测模型,并针对WLAN网络特点进行优化。

本文的研究方法主要是基于深度学习相关算法,包括卷积神经网络(Convolutional Neural Network,简称CNN)和长短时记忆神经网络(Long Short-Term Memory,简称LSTM)等,以构建Web数据包的特征库,并通过预测模型进行网络缓存数据的匹配和预测,达到提高WLAN网络效率的目的。

四、预期成果本文的预期成果包括:1.建立适用于WLAN网络的Web数据包特征库。

2.设计并实现能够预测网络缓存需求的Web缓存模型。

3.通过实验数据对比,证明本文提出的WLAN Web缓存模型对网路效率性能的提升。

五、进度计划本文的进度计划如下:第一阶段:调研及相关技术研究,包括WLAN网络和Web缓存技术的特点、常用算法及其优缺点等。

第二阶段:构建Web数据包的特征库,建立适用于WLAN网络的Web缓存模型,并进行模型测试和性能分析.第三阶段:总结并撰写完整的论文,并进行论文答辩。

Web前端的缓存策略与实现

Web前端的缓存策略与实现缓存是Web前端优化的重要手段之一,可以显著提升网页的加载速度和用户体验。

在本文中,我们将探讨Web前端的缓存策略及其实现方法。

一、为什么需要缓存策略Web前端的缓存策略是为了减少网络请求的次数,降低服务器负载,提高网页加载速度。

通过缓存,在用户首次访问网页时,可以将一些静态资源保存在本地,当用户再次访问时,就可以直接从本地获取资源,减少了网络请求的时间和带宽消耗。

二、缓存的分类1. 强缓存:通过设置HTTP响应头信息中的Expires或Cache-Control字段,告诉浏览器资源的有效期限。

在有效期内,浏览器可以直接从本地缓存读取资源,而无需再次发起请求。

2. 协商缓存:在资源的有效期过期后,浏览器会向服务器发送请求,通过检查Last-Modified和ETag等字段来判断资源是否有更新。

如果资源没有变化,服务器会返回304状态码,告知浏览器可以使用本地缓存的资源。

三、缓存策略的实现方法1. 强缓存实现:设置HTTP响应头在服务器返回资源时,可以通过设置HTTP响应头中的Expires和Cache-Control字段来控制缓存时间。

例如,通过设置Cache-Control为max-age=3600,表示缓存有效期为3600秒。

当浏览器再次请求该资源时,在有效期内将直接使用本地缓存。

2. 协商缓存实现:设置Last-Modified和ETag字段在服务器返回资源时,可以通过设置Last-Modified字段表示资源的最后修改时间,同时设置ETag字段表示资源的唯一标识符。

当浏览器再次请求该资源时,会通过If-Modified-Since和If-None-Match字段将Last-Modified和ETag发送给服务器,服务器根据这些字段判断资源是否有更新。

四、缓存策略的应用场景1. 静态资源缓存:对于一些不经常更新的静态资源,如图片、样式表和脚本文件,可以设置较长的缓存时间,以减少网络请求次数。

网络缓存算法的研究与设计

网络缓存算法的研究与设计随着互联网的快速发展,网络的使用已经成为人们日常生活中的必要组成部分。

而在网络的使用中,缓存是不可或缺的一部分,它可以大大缩短用户访问网页的时间,提高网络的效率。

因此,在网络缓存算法的研究与设计上,越来越受到了人们的关注。

一、网络缓存的定义和作用网络缓存可以理解为一种将数据存储在某处,以备之后使用的技术。

在互联网中,缓存服务器就是典型的网络缓存技术。

缓存器的作用是将常用的数据储存在本地,进一步减少对原始服务器的请求时间,从而提高数据的访问效率。

对于访问量很大的网站,缓存技术可以显著提高网站的访问速度,从而为网站的用户提供更好的服务。

二、网络缓存算法的种类1. 最近最少使用算法(LRU算法)LRU(Least Recently Used)算法是一种较为常见的缓存算法,它将最近没有使用过的缓存数据替换为新的数据,以保持缓存的效率。

在对缓存进行替换时,LRU算法会遍历每个缓存项,并将被访问的元素置于链表的末尾。

如果缓存已经满了,LRU算法会将链表头部的元素删除。

2. 先进先出算法(FIFO算法)FIFO(First In First Out)算法是一种最简单的缓存替换算法。

它按照访问缓存的时间先后,将时间最早的数据替换成新的数据。

当新增一条数据时,FIFO算法会先删除先前缓存进入缓存器最久的数据,在将新数据存储到缓存器中。

FIFO算法需要维护一个队列来存储缓存数据,缓存的替换就是将队列头部的数据删除。

3. 最不经常使用算法(LFU算法)LFU(Least Frequently Used)算法是一种按照数据使用频率进行缓存替换的算法。

首先,LFU会记录缓存数据在一段时间内的使用频率,然后选择使用频率最低的数据进行替换。

如果在同一时间段内,频率相同,则选择最早进入缓存的数据进行替换。

三、网络缓存算法的优缺点1. LRU算法的优缺点LRU算法的优点在于在缓存大小不变的情况下,对于没有使用过的数据进行替换时,可以有效地提高缓存的命中率。

Web缓存技术研究与应用

Web缓存技术研究与应用摘要:文章详细阐述了web缓存技术的原理,研究了在具有web 缓存器的网络中本地存储器对请求对象拷贝传送的过程,深入讲解了web缓存替换的思想,以及利用web缓存如何有效的降低网络业务流量,缓解网络拥塞等问题。

关键词:网络;流量;缓存;服务器中图分类号:tp393 文献标识码:a 文章编号:1007-9599 (2012)18-0000-021 引言近年来,伴随着网络的飞速发展,越来越多的用户接入到因特网中,使网络承载的业务量越来越繁重,网络流量呈爆炸式增长。

据统计因特网的上网用户和业务量几乎平均每6个月就翻一番,网络的应用以前所未有的速度增长。

用户对web服务器的访问量过大,导致系统难以承受其压力,如何缓解网络中业务流量的增长,减小访问时延,提高网络性能等一系列问题逐渐成为人们关注的焦点。

2 web缓存web缓存正是缓解这一矛盾的有效技术手段。

web缓存技术采用信息本地化的机制,将缓存器布置于距客户端较近的位置,把客户端最近请求过的对象的拷贝保存到本地缓存器中。

采用web缓存技术可以降低对初始服务器的访问压力,缩短用户发送请求时由于需要到达初始服务器而产生的信息传输距离和时延。

3 web缓存技术的原理那么,web缓存技术的工作原理是怎样实现的,我们看一下客户端浏览器对一个对象的请求过程。

当浏览器准备请求一个对象时,首先浏览器与web缓存器之间建立一个tcp连接,客户端浏览器向web缓存器中的对象发送一个http请求。

web缓存器将检查本地磁盘空间中是否对该对象的拷贝进行了存储,如果在本地存储空间中找到了该对象的储存副本,则web缓存器就用http响应报文将该对象的拷贝发送给客户端浏览器,这时的web缓存器就相当于初始服务器,因为在这个过程中web缓存器具与初始服务器同样的功能,接收了浏览器的请求,并发回了http响应报文。

当web缓存器在本地存储空间中未找到该请求对象的存储副本,它就会与该对象的初始服务器建立tcp连接,web缓存这时就相当于客户端浏览器。

集群式Web缓存系统的研究与实现的开题报告

集群式Web缓存系统的研究与实现的开题报告一、选题背景随着互联网的快速发展,Web应用程序的使用规模也越来越大,这导致了许多网站在访问量增加时出现了性能问题。

为了解决这种问题,Web缓存系统逐渐被引入各种规模的网络中。

Web缓存系统可以在用户请求到达服务器之前拦截它们并提供先前缓存下来的内容,从而降低了服务器的负载,缩短了响应时间,并减少了网络带宽的使用。

各种规模的网络都使用Web缓存系统,但在大型网络中,引入单个Web缓存服务器可能会成为系统的瓶颈,导致延迟和性能问题。

为了克服这个限制,集群式Web缓存系统应运而生。

在集群式Web缓存系统中,多个Web缓存服务器相互协作,共同提供服务。

因此,集群式Web缓存系统比单个Web缓存服务器更强大且更可靠。

二、研究内容和技术路线本文将研究如何设计和实现一个集群式Web缓存系统,以在大型网络中提高性能和可靠性。

具体研究内容如下:1. 集群式Web缓存系统的架构设计:本文将讨论集群式Web缓存系统的基本架构设计,包括如何选择缓存算法、如何分配缓存资源以及如何实现高可用性和可扩展性等。

2. 缓存算法的选择:集群式Web缓存系统的性能和可靠性与缓存算法密切相关。

本文将评估各种缓存算法,并选择最适合集群式Web缓存系统的算法。

3. 集群间通信的实现与协议设计:多个Web缓存服务器之间需要通信以共享缓存数据。

本文将研究一些常用的通信协议,并实现一个通信协议以共享缓存数据。

4. 集群管理系统的设计与实现:在集群式Web缓存系统中,需要对缓存服务器的状态和性能进行监视和管理。

本文将研究如何设计和实现一个集群管理系统以监视和管理集群中的服务器。

技术路线如下:1. 使用linux环境下的C++语言进行代码的编写。

2. 使用Socket进行集群间的通信。

3. 使用HTTP协议进行Web缓存服务的实现。

4. 使用epoll进行网络事件的IO多路复用。

三、预期结果本文将实现一个集群式Web缓存系统,并通过测试和性能比较来验证其性能和可靠性。

Web集群缓存系统中代理缓存技术的研究.doc

Web集群缓存系统中代理缓存技术的研究随着Internet迅猛发展,出现了访问延迟过长、服务器过载等一系列问题。

代理缓存技术能很好的解决上述问题,并得到了广泛应用。

然而由于用户的增多和Web流量的迅速增加,单个代理缓存的性能难以满足实际需要,因此本课题对集群缓存系统的研究,具有很强的现实意义。

本文着重从以下几个方面进行深入地研究和探讨。

首先,在缓存副本的存储方面,针对目前没有注意到对象的类型、访问次序等信息联系的现状,采用面向站点的存储结构,方便智能化管理。

其次,在副本管理方面,鉴于目前没有将一致性和替换算法很好结合起来的现状,本文设计了替换一致性算法RCA(Replacement ConsistentArithmetic)。

它能较好地反映Web用户访问的特点而且计算简便,体现了替换和一致性结合起来的优越性。

再次,在代理间通信协作方面,提出了新的协作代理缓存机制NCPCP(New Cooperative Proxy Cache Protocol)。

它通过重定向的方法减少系统内部的通信量,使用访问登记表减轻管理器的负担。

只转发请求,在集群中避免不必要的对象复制,大大提高了集群缓存系统的整体命中率。

最后,通过理论分析证明了NCPCP的性能要优于CRISP(Caching andReplication for Internet Service Performance)和ICP(Internet Cache Protocol),并通过实验,验证了NCPCP的整体命中率高于CRISP和ICP。

为今后的进一步研究提供了宝贵经验。

基于代理服务器的Web智能缓存系统研究与设计的开题报告

基于代理服务器的Web智能缓存系统研究与设计的开题报告一、选题背景在现代化互联网应用系统中,Web缓存技术是提升系统性能的重要手段。

Web缓存利用本地存储器(如硬盘、固态硬盘等)存储经常访问的Web页面或文件,将它们保存在本地,并在用户再次请求时直接从本地读取,从而避免了重复下载页面或文件的时间和带宽浪费,同时也减轻了源服务器的负载。

然而,随着Web应用规模和用户数量的增长,传统的Web缓存方式已经无法满足需求。

传统的Web缓存系统主要是以透明代理方式实现的,它们位于源服务器和客户端之间,对于客户端和源服务器来说都是透明的,缓存系统不会改变HTTP请求和响应的内容。

而这种透明代理的方式也造成了一些问题,如缓存任意内容、对缓存的控制不灵活等。

因此,基于代理服务器的Web智能缓存系统逐渐成为研究热点。

这种缓存系统在代理服务器上实现,它利用代理服务器的智能和控制能力,能够更好地控制缓存内容,智能选择缓存策略,提高缓存的命中率,从而提升系统的性能。

二、研究内容本课题主要研究基于代理服务器的Web智能缓存系统,包括以下内容:1. 总体设计:基于代理服务器的Web缓存系统的总体设计,包括系统结构、模块划分、模块接口设计等。

2. 缓存策略:研究和实现一些有效的缓存策略,包括基于LRU、LFU、随机等算法的缓存策略,以及针对动态Web应用的缓存策略等。

3. 缓存控制:利用代理服务器的控制能力,研究和实现合理的缓存控制机制,包括缓存资源的预取、更新、回收等控制策略。

4. 缓存监控:设计和实现一套缓存监控系统,能够实时监控缓存状态、命中率和效果等,并根据实时数据调整缓存策略和控制机制。

三、研究方法本课题的研究方法主要包括以下几个方面:1. 理论研究:通过对缓存策略、缓存控制和系统设计等领域的相关文献资料的调研与分析,了解国内外相关研究成果和最新进展,明确本文的研究方向和内容。

2. 系统设计:根据前期调研和分析,结合实际应用需求,设计系统结构、模块划分、接口设计等,明确系统开发的技术方向和难点。

一种基于Peer_to_Peer技术的Web缓存共享系统研究

第28卷 第2期2005年2月计 算 机 学 报C HIN ESE J OU RNAL OF COM PU TERSVol.28No.2Feb.2005一种基于Peer 2to 2Peer 技术的W eb 缓存共享系统研究凌 波1) 王晓宇2) 周傲英2) Ng Wee 2Siong3)1)(中国浦东干部学院 上海 200233)2)(复旦大学计算机科学与工程系 上海 200433)3)(新加坡国立大学计算机科学系 新加坡 117576)收稿日期:2003204224;修改稿收到日期:2004210208.凌 波,男,1974年生,博士,主要研究兴趣包括对等计算、基于对等计算的数据管理和信息检索、信息经济和领导科学等.E 2mail :bling @.王晓宇,男,1975年生,博士,主要研究兴趣包括Web 数据管理、对等计算和嵌入式系统等.周傲英,男,1965年生,博士,教授,博士生导师,主要研究兴趣包括Web 数据管理、数据挖掘、数据流管理与分析、对等计算、金融数据管理与分析等.N g Wee 2Siong ,男,1973年生,马来西亚人,2004年在新加坡国立大学获得计算机科学专业理学博士学位,主要研究兴趣包括数据库性能、对等计算和基于Internet 的应用等.摘 要 提出了一种基于peer 2to 2peer 技术的分布式Web 缓存共享系统:BuddyWeb.该系统的核心理念是让企业网络中的所有PC 能够相互共享浏览器中的本地缓存,从而形成一个高效的、大规模的分布式缓存共享系统,并使系统具备易管理、易实现、低成本等优点;接着详细阐述了BuddyWeb 的工作原理和算法策略;然后,针对Buddy 2Web 系统的特性提出了仿真实验模型和评估方法.实验结果证明了BuddyWeb 在命中率、网络通信流量负荷、系统响应延迟等诸方面均能取得令人满意的效果.关键词 peer 2to 2peer Web 缓存;动态自配置;自适应跳步中图法分类号TP303A Collaborative Web C aching SystemB ased on Peer 2to 2Peer ArchitectureL IN G Bo 1) WAN G Xiao 2Yu 2) ZHOU Ao 2Y ing 2) Ng Wee 2Siong 3)1)(China Executive L eadershi p A cadem y Pu dong ,S hanghai 200233)2)(Depart ment of Com p uter Science &Engineering ,Fu dan Universit y ,S hanghai 200433)3)(Depart ment of Com puter Science ,N ational Universit y of S ingapore ,S ingapore 117576)Abstract In t his paper ,a collaborative P2P 2based Web caching system ,named BuddyWeb ,has been p roposed ,whose underlying ideology is t hat all t he PCs in an Int ranet are able to share t heir local caching to constit ute a large 2scale ,effective collaborative Web caching system.BuddyWeb distinguishes it self from ot hers wit h t he advantages of scalability ,effectiveness and low cost.Furt hermore ,t he working mechanism and t he algorit hm of t he system have also been detailed.In addition ,a simulation model has been devised to evaluate such a system.And t he evaluation re 2sult s show BuddyWeb achieves a satisfied performance in hit s 2ratio ,t raffic 2load and latency of re 2sponse.K eyw ords peer 2to 2peer Web caching ;dynamic self 2reco nfiguration ;self 2adaptive hopping1 引 言Peer 2to 2Peer (简称P2P )计算模型正越来越广泛地应用于数据挖掘、资源交换、数据管理、文件共享等领域.P2P 技术得以风行的最初动机是人们希望创建属于自己的在线通信通道,以实时地访问和交换信息,典型的P2P 系统有Napster 和Gnutella 等.本文提出了一种新型的P2P 应用:Web 缓存共享.不同于以往基于proxy 端的Web 缓存技术,本文着眼于如何在一个企业局域网环境中利用所有节点(PC) (浏览器中)的本地缓存.企业环境P2P模型与互联网资源共享模型的主要区别为:(1)连结节点(peer)间的带宽不同,企业局域网的带宽比广域网带宽高得多;(2)企业局域网的安全性好,因为局域网中的所有节点都受防火墙保护;(3)企业环境中整个网络都是可控制和可管理的.为了更好地阐述本文的研究背景和动机,让我们考虑复旦大学校园网这样一个企业级局域网.在这类网络中,有成千台PC相互连接在一起,每台PC都有一个Web浏览器.这里,防火墙把校园网与“外面的世界”隔离开,任何进入和外出的请求都要通过一个中心p roxy;另外,中心proxy还承担数据流量“计费器”的角色,每个通过它出入的字节都要收费.在当前的计算模式下,用户不能相互共享节点浏览器中的缓存内容,即使正查找的信息已缓存在校园网(L AN)内的其它节点,也不能在L AN内获得.所有查询不得不通过中心proxy发送到远程服务器,这样既导致了较长的响应时间,又增加了额外的费用.相反,如果能利用P2P技术使L AN内所有PC共享本地缓存,则不但能缩短响应时间,而且能节省费用.带着这样的动机,本文设计了基于P2P技术的Web缓存共享系统:BuddyWeb.在BuddyWeb中,所有参与节点的本地缓存都可共享,在触发外部(到Int ranet之外的)访问之前,首先搜索L AN内节点的缓存.总之,BuddyWeb具有以下独特性:(1)网络的拓扑结构可以依据节点的兴趣而自调整.运行一段时间后,网络中将形成不同兴趣的虚拟社区.例如,数据库研究社区,生物信息研究社区等.(2)采用了基于节点缓存内容相似度的路由策略.基于相似度的判断,查询将从一个节点路由到和该节点具有较高相似度的相邻节点.(3)实现了基于兴趣相似度的自适应跳步策略(self2adaptive hopping st rategy),每个查询消息的T TL值(Time2To2Live,生命周期)会自动调整,从而实现最大化搜索结果和最小化带宽消耗的优化目标.本文第2节介绍BuddyWeb的体系结构,首先回顾实现系统的P2P系统平台Best Peer,然后描述BuddyWeb节点的体系结构;第3节介绍Buddy2 Web的特性和算法,包括基于兴趣相似度的动态自配置策略以及基于兴趣相似度的路由策略与自适应跳步机制;第4节提出仿真实验模型并展示实验结果;第5节讨论相关的工作;第6节总结全文.2 BuddyWeb系统体系结构本节首先介绍实现BuddyWeb系统的P2P平台,以更好地理解系统的工作机制,然后详细描述BuddyWeb节点的体系结构和工作流程.2.1 B estPeer平台BuddyWeb是在Best Peer[1]平台上实现的. Best Peer是集成了移动Agent技术的通用P2P平台,可以在它上面有效地开发各种P2P应用.平台系统由两类实体组成:大量的对等节点和少量的位置独立全局名查找服务器(L IG LO).每个对等节点都运行一个基于J ava的Best Peer软件,并能互相通信和共享资源.L IG LO服务器是有固定IP地址并运行着L IG LO软件的特殊节点,主要有两个功能: (1)为每个对等节点分配全局唯一的标识符(BPID),即使一个节点以不同IP地址登录,也能被唯一地识别出来;(2)维护自己所管辖的对等节点的当前状态信息,包括在线与否及当前IP地址等元数据.图1 Best Peer节点自配置过程在传统的P2P系统(如Gnutella)中,邻居节点(直接相连的节点)一般是人工静态指定或随机决定的,而Best Peer的节点可以动态地重新配置自己的邻居.该机制基于以下简单假设:对于任意一个给定的节点,曾经对它有益的节点,在以后的查询中很可能仍然有益.因此,Best Peer的节点会把曾经对自己最有益的节点维护成直接邻居;由于自身资源的限制,每个节点的邻居数量受限.图1展示了节点重新配置邻居的过程.在图1(a)中,Peer X发出的请求直接发送给Peer B和Peer A.但是,只有Peer C和Peer E才有Peer X当前请求的对象.那么Peer X 从Peer C和Peer E获得结果;并且,Peer X发现虽然Peer C和Peer E对它有益,却不是直接邻居,因此,Peer X重新配置自己的邻居节点,将Peer C和Peer E节点加入自己的邻居列表中,结果网络拓扑1712期凌 波等:一种基于Peer2to2Peer技术的Web缓存共享系统研究结构如图1(b ).自配置策略的实质就是将最有益的节点保持在近邻位置上,以便为自己提供更好的服务.Best Peer 支持两种缺省动态自配置策略[1]:(1)MaxCount ,以提供有效查询结果数最大化为基准;(2)Min Hop ,以获得相同查询结果所历经的跳数(hop )最少为基准.2.2 BuddyWeb 节点体系结构BuddyWeb 节点的体系结构如图2所示.Web 浏览器充当前端用户界面,采用Microsoft Internet Explorer (IE ).在BuddyWeb 支持的浏览器中由一个本地proxy 来操纵本地Web 缓存;用一个H T TP 后台线程支持H T TP 请求.底层数据通信由Best Peer 平台管理.BuddyWeb 节点正是借助于Best Peer 平台与其它节点共享缓存内容.对用户而言,这种设置是透明的,用户觉察不到BuddyWeb 浏览器和普通浏览器的差别.图2 BuddyWeb 节点体系结构当用户从浏览器提交一个U RL 查询,本地p roxy 将其改写成Best Peer 平台可以接受的输入形式并传送给底层Best Peer 平台.接着,Best Peer 产生一个移动Agent 并将其派到BuddyWeb 网络中搜寻匹配结果.一旦查找到匹配结果,Best Peer 将结果的位置等元数据返回给发出查询的本地p roxy ;本地p roxy 立刻使H T TP 后台线程直接向存有匹配文档的节点发出H T TP 连接请求;一旦收到H T TP 连接请求,被请求节点上的H T TP 后台线程立即处理该请求,并传送被请求的结果.3 BuddyWeb 的特性与算法本节详细介绍BuddyWeb 的特性与算法,包括基于兴趣相似度的自配置策略、基于兴趣相似度路由策略和自适应跳步,并展示了L IG LO 和对等节点的工作算法.3.1 基于兴趣相似度的动态自配置策略由于Best Peer 的缺省自配置策略是基于查询行为的,不能有效利用共享内容的语义信息.在BuddyWeb 中,我们提出了一种基于兴趣(或内容语义)相似度的动态配置策略.该策略充分利用了Best Peer 中的L IG LO 服务器.即每个注册的节点不仅要将当前IP 地址传送给管辖它的L IG LO 服务器,同时还要定期向L IG LO 发送关于自己浏览兴趣的信息.节点浏览兴趣是通过它浏览过的网页信息来提取的.虽然具体方法很多,但抽取的浏览兴趣信息必须同时满足代表性和简练性的要求.BuddyWeb 通过节点浏览过网页的部分元数据(meta 2data ,例如〈TITL E 〉〈/TITL E 〉)来定义节点的浏览兴趣.每个节点的浏览兴趣会在管辖它的L IG LO 服务器用一组词列表的形式来表示.本文提出的动态自配置策略就是基于这些词列表进行的.我们可以把所有词列表中的词看作一个词袋(wordbag ),并用这个词袋构造一个向量空间.基于向量空间,每个词列表可以依据某种权重方案映射为该向量空间中的向量,最简单的权重方案是布尔权重.这样,每个节点的浏览兴趣就由向量表示.由于BuddyWeb 有多个L IG LO 服务器,每个L IG LO 服务器中仅保存了在它登记的节点浏览兴趣词列表.因此,所有L IG LO 必须相互协商,从而决定由谁接收其它L IG LO 所保存的兴趣词列表信息.解决该问题的另一种方法是通过哈希影射的方法,这样可以避免所有的向量计算在一个服务器上进行.但由于在企业网环境中,BuddyWeb 的L IG LO 服务器数量有限,而且L IG LO 服务器间传输的词列表只是一些“轻量级”文件,因此采用协商方法.基于上述定义的向量空间,节点可以采用余弦相似度函数来计算它们之间的兴趣相似度.为了使浏览兴趣最相近的节点直接连接在一起,每个节点都仅将跟自己具有最高相似度的数个节点维护为邻居.当网络中很多节点时,计算节点浏览兴趣向量的两两相似度非常耗时.解决这个问题的简单方法是将相似度的计算分布到每个节点.这样,负责计算的L IG LO 服务器只要计算向量空间及每个节点在该空间中的向量.计算完成后,这些向量会传发网络中的所有L IG LO 服务器.基于兴趣相似度的动态自配置的具体过程如下:(1)经过一个指定的时间周期(如一天)后,L IG LO 在特定时间(如午夜)相互协商并推举一台L IG LO 计算向量空间和所有登记节点的向量.(2)当一个节点登陆时,首先跟它登记的L IG LO 通信,上传其当前IP 地址,并接收当前网络中所有271计 算 机 学 报2005年节点(包括该登陆节点本身)的浏览兴趣向量.该节点与其它节点间的两两相似度就在登陆节点本地计算出来,并按由高到低排序.(3)k个具有最高相似度的节点将保持为直接连接邻居,k是一个指定的系统参数.采用基于兴趣的自配置策略,BuddyWeb系统运行一段时间后,会形成特定的(节点)虚拟社区. 3.2 基于兴趣相似度的路由与自适应跳步目前,大多数P2P系统(如Gnutella)的查询采用广播路由策略,即查询节点把查询广播给所有邻居,邻居收到查询后在本地检索的同时,继续把查询转发给它们的所有邻居,直到查询转发次数达到限制值(T TL).这种广播路由策略导致了很高的网络通信流量负担.在BuddyWeb中,每个节点都保存自配置过程中计算得到的节点间兴趣相似度值.由于该值实际上是节点缓存内容的相似度,因而,当节点转发查询时,只需转发至和该节点具有很高相似度值的邻居,而不是转发给所有邻居.注意,查询提交节点将查询传播给所有邻居.利用节点间的兴趣相似性度,BuddyWeb还实现了一种自适应查询跳步策略.以往的P2P系统(包括Best Peer)都预先设定查询跳数(T TL值).如果T TL值设得太小,那么查询处理被限制在很小范围,查全率低;反之,如果T TL设得过大,网络的通信流量负担非常沉重.因此,不可能事先为不同的查询设定一个相同的T TL值,并同时达到上面两种考虑的折衷.BuddyWeb充分利用了Best Peer提供的Agent 机制,所有查询被封装在Agent中,Agent在路由途中记录一些“历史”信息.为了更直观地阐述自适应跳步策略,我们用距离(跟相似度本质相同)来描述节点间的关系.在网络中,两节点间最长的距离被看作BuddyWeb概念空间的直径,即所有节点的兴趣所覆盖范围.自适应跳步策略的具体工作过程如下:(1)节点发起一个携带一个参数s(而不是T TL 定值)的查询Agent.这里参数s是一个由P2P网络预先设定值,称为概念空间参数.网络直径用D表示,其值在动态自配置的过程中计算出.(2)当查询Agent被转发到邻居节点,Agent记录下当前节点与其邻近节点间的“距离”.并且,该距离跟以前路由路径上的距离值累加.(3)如果累加值超过s・D的值,那么查询路由终止(查询Agent不再被转发).否则,节点继续将查询Agent向其直接相连的节点转发.采用该策略,每个查询的T TL会依据它所搜索的概念空间范围而自适应调整.概念空间参数s 反映了系统希望节点在概念空间中搜索的范围.通过设定参数s可以使BuddyWeb在通信量和查全率两方面动态实现折衷.BuddyWeb系统中的L IG LO服务器和对等节点的工作算法分别如算法1与算法2所示.算法1. L IG LO工作算法.For L IG LO server:void ProcessPeerLogin() //等待Peer登陆{while(true){if(AnyPeerRequest ToLogin())//是否有Peer请求登陆{Accept PeerRequest();//接受登陆请求Get PeerIP();//获得登陆节点IPSendCurrent RegisteredPeersInterest();//将当前所有登陆节点的兴趣向量发给请求节点}else{Sleep(WA IT_IN TERVAL);}}}算法2. 对等节点的工作算法.For each peer:bool Login(){bool bRet=Connect ToL IG LOServer();//请求连接到L IG LO服务器if(bRet){SendCurrent IPAddress();//将当前IP地址发送给L IG LO服务器G et RegisteredPeer Interests();//获得当前登记的所有节点的兴趣向量ComputeSimlarities();//计算同其它节点的相似度RankSimilarities();//对兴趣相似度排序Connet To KNeighbors();//同相似度最高的k个节点建立连接}return bRet;}//发起查询void Query(StringList str Keys,float s)//StringList为关键字组,s为概念空间参数3712期凌 波等:一种基于Peer2to2Peer技术的Web缓存共享系统研究{int D=G etCurrentNetworkDiameter();//获得或者计算当前网络的近似直径int T TL=D×s;SendCurrentQueryToNeibs(str Keys,T TL,0);//将当前查询发送到邻居节点开始查询,0表示当前查询经过的距离为0int i Total W ait Time=0;while(i Total W ait Time<MAX_WA IT_TIM E){G otQueryResult();//取得当前返回的查询结果DisplayResults();//将查询结果显示给用户Sleep(WA IT_IN TERVAL);i Total W ait Time+=WAIT_IN TERVAL;}}//收到查询请求的节点处理查询void ProcessQuery(StringList str Keys,int T TL,intcurS te ps){Result Info result=SearchIn ThisPeer(str Keys);//在当前节点上查找查询结果ReturnResults To InitialPeer(result);//将查询结果返回给查询节点if(curS teps<T TL)SendCurrentQueryT oNeibs(str K eys,T TL,curSteps+1);//将当前查询发送到邻居节点开始查询}4 系统评估4.1 仿真评估模型Web缓存系统的性能很大程度上取决于实际环境的工作负荷.因此,为了比较客观地评估Bud2 dyWeb系统算法的有效性,本文采用仿真模拟的方法,并建立一个可控的仿真环境.并且,可假设Bud2 dyWeb节点所请求的都是静态可缓存对象.虽然这和实际环境存在差异,但由于不可缓存的对象对于任何缓存方法的影响都是同样的(H T TP请求都被直接发至原始站点),所以并不影响仿真的有效性.实际上,仿真实验的目的是验证BuddyWeb在一般情况下的行为特征,而不是具体模拟某种现实的Web缓存实例.4.1.1 仿真模型初始数据集的构造假设在某段时间内BuddyWeb所有节点所请求的Internet对象集合为Q={q1,q2,…,q n},被定义为仿真试验对象全集.设对象集合Q一共包含u 个不同的主题,每个主题的对象集合用Q T表示.为简化仿真过程,可假设不同主题的对象集合间不存在交集,即Q T1∪Q T2∪…∪Q T u=Q;Q T i∩Q T j= ,其中i,j∈{1,2,…,u}.因为仿真过程并不需要真实存在可缓存对象集合Q,因而可用一组映射关系来模拟从对象的元数据中抽取关键词的过程.设从每个主题集中的对象的元数据中抽取的关键词集为T,那么,对象主题集Q T 与其相应的关键词集T之间的抽取关系可以通过一个映射来表达,F(Q T i)→T i,其中i∈{1,2,…,u}.通过映射F可以为每个主题对象集Q T与其相应的关键词集T之间建立一个一一对应的关系.为简化仿真过程,可设每个关键词集T中含有同样数目的关键词m个,且T i∩T j= ,其中i,j∈{1,2,…,u}.另外,对于Internet对象实验全集Q中的对象,我们将为其中每一个对象的大小分配一个值.其分布符合在[1K,1M]上的正态分布.4.1.2 BuddyWeb仿真网络节点的构造创建一个BuddyWeb的仿真网络,设网络一共有w个节点,每个节点由一个BuddyWeb本地proxy操纵该节点的缓存、发送H T TP请求及响应其它节点的H T TP请求.每个节点的本地缓存能保存k兆的可缓存静态对象.在仿真实验之前,首先为每个节点初始化本地缓存内容,具体过程如下:从u个主题对象集合{Q T1,Q T2,…,Q T u}中随机地挑选1~p个主题集合(p为仿真实验参数,称为最大主题浏览数).然后从挑中的主体集合中随机选取其中的静态可缓存对象,直至达到该节点本地缓存容量,即k MB.BuddyWeb仿真网络的每个节点在选择了x(1ΦxΦp)个主题对象集合后,就依据映射F得到x个相应的关键词集合.按照该节点从这x个不同的主题对象集合中随机选取的对象数目的比例,可从相应的x个关键词集合中随机地挑选出q个不同的关键词构成该节点的浏览兴趣词列表.如果该节点的本地缓存中存有y个对象,则q=Δ・y,Δ是仿真实验参数,该参数定义为节点浏览兴趣词列表生成系数. 4.1.3 BuddyWeb网络行为的模拟为了比较全面模拟BuddyWeb网络的实际运作过程,仿真模型需要确定以下两个因素:(1)每个节点发出的H T TP所请求的对象;(2)每个节点发出H T TP请求的时间间隔.设节点i为BuddyWeb中的任意一个节点,它本地缓存中的Internet对象所涉及的主题对象集合的并集为N Q T i.节点的浏览过程(发出H T TP请求的过程)直接受到浏览者浏览兴趣的影响.浏览者既会保持一定的浏览兴趣连续性(继续浏览和其缓471计 算 机 学 报2005年存中对象主题相同的主题),也会浏览一些以前没有浏览过的主题,后一种现象称为浏览者的浏览兴趣漂移.因此,仿真模型引入了浏览兴趣飘移系数μ来刻画这种现象.μ=1表示节点浏览的Internet对象和它本地缓存中的对象完全没有重合的主题,μ=0表示节点浏览的Internet对象和它本地缓存中对象的主题完全重合.节点i所产生的H TTP请求对象有100μ%从集合N Q T i中随机地产生,有1-100μ%从Q-NQ T i中随机产生.节点产生H T TP请求的时间间隔直接影响整个BuddyWeb网络中通信流量的负荷.如果节点发出请求的时间间隔很短,那么网络的信息流量负荷就会很重,否则,流量负荷就很轻.为此,仿真模型引入请求间隔参数t,节点产生H T TP请求的时间间隔将从[0,t]范围内随机地产生一个值来确定.由于实验对象全集是所有网络中的节点所发出的H TTP 请求对象,因此实验结束时,实验对象全集Q中所有对象都被仿真网络的节点请求过.最后,因为每个节点的缓存容量都是有限的,所以仿真实验还要为网络节点所缓存的对象确定替换策略,本研究采用L RU缓存替换策略.表1展示了仿真模型参数的预设定值.表1 仿真模型参数缺省值仿真模型参数代表符号设定值BuddyWeb网络中的节点数目w2000实验对象全集Q中的对象数目n1000000实验对象中包含的主题数目u20每个节点本地缓存中包括的最大主题数目p8节点浏览兴趣词列表生成系数Δ3每个主题关键词集合中含有的关键词数目m500表1中未被列出的参数为评估实验参变量,用于研究BuddyWeb网络的行为特征.参变量的具体设定将在评估实验过程中详细说明.4.2 仿真实验评估本节评估BuddyWeb系统的基于相似度的动态自配置策略以及路由与自适应动态跳步方法的有效性.实验评估主要基于以下度量指标:系统性能(外部带宽或命中率,系统响应延迟或跳步数)和网络通信流量负荷.实验比较了加入动态自配置策略的BuddyWeb系统和没有自配置的策略的静态BuddyWeb系统,评估了自适应动态跳步算法对系统性能和网络通信负荷的影响.实验结果表明了基于兴趣相似度的动态自配置策略的优越性;同时也证明了自适应动态跳步算法在没有牺牲系统性能的前提下,有效地降低了网络的通信流量负荷.4.2.1 命中率与外部带宽命中率定义为网络中所有节点发出的请求被BuddyWeb网络中缓存所响应的百分比.本小节首先研究基于相似度的动态自配置策略对BuddyWeb 命中率的影响以及节点缓存对提高整个系统命中率的贡献;接着研究浏览者行为(不同的浏览兴趣漂移系数)对整个系统的命中率的影响;最后比较自适应跳步算法与路对系统命中率的影响.未加入动态自配置策略的BuddyWeb系统等同于一个传统的静态P2P系统,称为静态Buddy2 Web系统(简称SBW);采用了动态自配置策略的BuddyWeb系统称为动态BuddyWeb系统(简称DBW).为了研究自适应跳步算法与路由策略的影响,动态BuddyWeb系统分为加入自适应跳步算法与路由策略的动态BuddyWeb系统(简称ADBW)和未加入的动态BuddyWeb系统(DBW).DBW采用传统P2P系统的广播策略,每个消息的T TL=7.图3横坐标为每个节点的本地缓存的容量,纵坐标为系统的命中率.实验结果表明采用动态配置策略的BuddyWeb系统(DBW)的命中率明显高于静态BuddyWeb系统(SBW).并且,随着本地缓存容量的增加,DBW越来越优于SBW.这充分说明了动态自配置策略对有效利用本地缓存的作用.图3 加入动态自配置策略前后系统的命中率另外,由图3可知,在较为合理的缓存容量上(例如100MB),动态自配置的BuddyWeb系统能获得满意的命中率,这说明有基于兴趣相似的动态自配置策略的BuddyWeb系统能有效利用网络中每个节点的本地缓存.所以随着每个本地节点本地缓存的增加,命中率得到了极大的提高.注意到水平坐标的刻度是对数级的.这也说明即使每个节点的本地缓存容量很小,大量节点的协作能够取得较高较好的命中率.图4展示了在不同浏览兴趣漂移系数下,Buddy2 Web的命中率(节点缓存容量为100MB).5712期凌 波等:一种基于Peer2to2Peer技术的Web缓存共享系统研究图4 不同浏览兴趣漂移系数下的命中率 由图4可见,无动态自配置策略的BuddyWeb系统几乎不受浏览漂移系数变化的影响,而动态自配置系统则随着浏览漂移系数增加,系统的命中率呈下降趋势,并且浏览漂移系数超过0.6时,动态自配置策略下的BuddyWeb 系统的命中率开始低于不采用自配置策略的系统.接下来评价自适应跳步算法与路由策略.加入自适应跳步算法与路由算法后,BuddyWeb 可以依据预设定的概念空间参数s 自适应地决定跳步的数目.实验中,s =0.7.图5 加入自适应跳步算法与路由策略前后DBW 系统的命中率由图5可见在较小的节点本地缓存容量下,ADBW 系统的命中率较低于DBW 系统.当节点本地缓存达到或超过10MB 时,ADBW 系统的命中率开始接近甚至优于DBW 系统.该结果说明了自适应跳步算法与路由策略在本地缓存达到一定的容量时,不会降低系统命中率,但有效地下降了整个网络的通信流量负荷(见4.2.2节).现在研究概念空间参数s 对于系统命中率的影响,实验结果如图6所示.由图6可知,随着概念空间参数s 的增加,系统的命中率得到了显著的提高,但s 超过017时,它对系统命中率的提高作用开始减缓.但随着s 的增大,网络的通信流量负荷也会相应地增加.4.2.2节将图6 概念空间参数s 在ADBW 系统中对于命中率的影响会进一步研究概念空间参数s 对网络流量负荷的影响.并且,由上述实验结果可知,BuddyWeb 系统的缓存命中率已经和集中式的proxy 缓存系统相当.4.2.2 网络通信流量负荷网络通信流量负荷定义为单位时间内Buddy 2Web 网络中传输字节数量的总和.表2列出了估算通信流量参数.表2 通信流量相关信息字节数的估计值请求头(Request headers )信息字节数350字节(估计值)响应头(Response headers )信息字节数150字节(估计值)传输的对象字节数在实验对象全集中相应对象的大小接下来研究自适应跳步算法与路由策略对减轻BuddyWeb 网络通信流量负荷的作用以及参数s 对网络通信流量负荷的影响.图7给出了在不同的请求间隔参数t 下,ADBW 与DBW 系统在单位时间内的通信流量.实验随机地选取了10个单位采样时间段,每个采样时间段设为1min.实验中节点本地缓存容量设为100MB ,DBW 的T TL =7,ADBW 系统的概念空间参数s 设为017.图7 不同请求间隔参数下,BuddyWeb 网络通信流量负荷由图7可知,采用自适应跳步算法和路由策略的BuddyWeb 系统的网络通信流量负荷得到了极大的改善,而传统的P2P 系统的广播式路由机制导671计 算 机 学 报2005年。

Web开发中分布式缓存技术的研究

C H I N A S C I E N C E A N D T E C H N O L OG Y I N F O R M A T I ON J u l 2 0 1 7・ 中国科技信息 2 0 1 7 年第 1 3期

首先查看该数据是否存在于缓存中 , 如果在缓存 中找到该数据 ,

次 被访 问的 时间进行排 序 ,当缓存空 间已满后 ,剔除队列 中最 后一个缓 存项 ,也就是最 后被访 问的时间距离 当前最久 的元素 。并将 新元 素加 入队列的首部 。 3 . L F U( 最近最少使用算法 )

次被 访问 。 空 间局部性原理 :当前访 问的 数据邻近 的数据很可 能也 会被访问 。

缓存 的理论正 是基于上述 两种局部性 原理的基础 上 。从

通过 引入分布式缓存技术可以有效减轻业务端的负载 ,降低请求延时 。同 时借助分布式的优势 ,在数 据的冗余备份和失败恢复机制方面也有很完善 的保障。本文深入分析缓存理论的基本原理 ,以及分析分布式缓存在企业 级 应用中的实践案例 ,为 分布式缓存技术在 We b 开发 中的应用提供了可

F I F 0 算法 的思想 很简 单 :先进 入缓存 区的 数据最 先被

还探讨了分布式缓存在大型网站 中的时 间应用 。

置换 出去 。也就是在缓存 中待得 时间最久 的数据最先被清除 。

2 . L RU ( 最近最久未使用 算法 )

缓 存基 本原 理

缓 存技 术 最早 应 用于 计 算机 硬件 领 域 ,主 要 为 了解 决

靠 的参考依据。

程序代码 角度很好 理解这一原 理 :即一 段时间 内 ,c p u仅会

执行 程序 代码的 某一 部分 。比如 :f o r 或 wh i l e循 环 。又因 为大多数 情况下程 序是顺序执# 2B 9 ,那么在 空间上也 是符合 空间局部性原理的 。

Web Cache系统部署方案研究

Web Cache系统部署方案研究于绍晨【摘要】本文首先介绍了Web Cache的3种技术实现方式,明确了运营商对Web Cache技术实现方式的选择,并结合运营商的具体情况,对Web Cache系统在运营商的部署方案进行了分析和探讨。

% This article firstly describes three kinds of technology implementations about Web Cache and proposes choice of the operator of technology implementations. And combined with the specific circumstances of the operator, the operator's deployment scenarios was analyzed and discussed.【期刊名称】《电信工程技术与标准化》【年(卷),期】2012(000)011【总页数】4页(P37-40)【关键词】Web Cache;DNS重定向;深度分组解析;全局负载均衡【作者】于绍晨【作者单位】中国移动通信集团设计院有限公司,北京 100080【正文语种】中文【中图分类】TN929.51 引言随着3G业务和宽带接入的高速发展,某国内电信运营商的移动和固网用户的数量及带宽增长迅速。

如此庞大的用户需求强烈刺激各类信息业务的发展,从而对IP 网络的结构和容量都提出了很大的挑战。

目前,由于国内的源站服务器(如新浪、网易、腾讯等)大都部署在其他运营商的IDC数据中心机房内,对于国内某运营商来说,这势必带来了以下问题:某通信运营商和其他通信运营商的互联互通上存在带宽瓶颈问题,网间内容访问带宽受限,内网用户访问外网内容质量差,以及外网用户访问本网内容质量差,导致用户体验下降。

由于国内Internet资源,主要在其他运营商网内,某运营商必须依赖与其他运营商的网间链路带宽,网间链路带宽的扩容需要与其他运营商进行协商,有可能赶不上业务发展的需求。

合作式Web缓存系统的性能分析

合作式Web缓存系统的性能分析

杨玉海;宾雪莲;郑玉墙

【期刊名称】《计算机研究与发展》

【年(卷),期】2003(040)005

【摘要】共享不同代理的缓存文件是减少Web通信量和减轻网络瓶颈的重要方法.在分析现有合作式缓存系统的基础上,提出一种基于混合管理的合作式Web缓存系统(HMCS).HMCS采用重定向的方法将请求从未命中的代理转发给缓存了请求文件的代理.采用这种方法可以减少缓存文件的冗余度,从而提高了缓存系统的存储利用率,进而提高系统的命中率.性能分析和仿真结果表明HMCS系统性能要优于CRISP和ICPS系统.

【总页数】6页(P757-762)

【作者】杨玉海;宾雪莲;郑玉墙

【作者单位】空军雷达学院计算机教研室,武汉,430010;华中科技大学计算机学院,武汉,430074;国防科学技术大学计算机学院P&D国家重点实验室,长沙,410073;空军雷达学院计算机教研室,武汉,430010

【正文语种】中文

【中图分类】TP393

【相关文献】

1.Web缓存系统组网方式研究 [J], 孙育;程凯

2.一种有效的混合式P2P Web缓存系统HCache [J], 李天亮;石磊

3.一种新的基于连续哈希函数的合作式Web缓存系统 [J], 周刚;周建国;晏蒲柳

4.企业环境P2P模型下的合作式Web缓存系统研究 [J], 周刚;周建国;郑丽霞

5.集中管理式Web缓存系统及性能分析 [J], 姜彩萍;李子木;杨凤杰

因版权原因,仅展示原文概要,查看原文内容请购买。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

直接使用保存 的副本进行响应客户端请求。只有 当网站 明确标识资源已经更新 , We b 缓存系统才 会更新 We b 资 源副本。由于 We b 缓存系统部署距离用户客户端较近 ,

相 当于将 访 问远端 We b服务 器流 量 留在本 地 网 内 , 从 而

减少热点重复流量在互联网上进行传输 , 可实现加快 页

功率比较低。

( 2 ) 内容 更新 问题 流 量劫 持组 网方 式缓 存 系统 的 内容抓 取

We b 缓存 系统中没有缓存用户访 问的资源 , 其

访 问流程为 :

模块和 C a c h e O u t 模块是完全独立的 , 劫持缓存不会 实时更新缓存的内容 ,不会实时检查缓存对象是否

藤 《 《 《 》鞋 # 嚣 《 辑 # 蒜

件传给用户 , 并保存在其存储设备 中。

以后 再 有 用 户 访 问 同样 的 内 容 ,只 需 要 重 复

流量劫持组 网方式优点主要有 : ( 1 ) 部署相对方便 , 对现 网网络结构没有改变 , 适合于快速部署; 从设备维护上讲相对简单 ;

同, 又可分为 D N S 劫持与 H T T P劫持。

3 . 1 . 1 D N S劫 持组 网方 式原 理

D N S劫 持 组 网方 式 原 理 为 客 户 端 D N S

解析请求 U R L中相关域名的时候 , D N S系统 劫持其 D N S 请求 ,不返 回正常 D N S 解析结

统流量导入方式不同 ,可以分为流量劫持与策略路

由。

3 . 1 流 量劫 持 组 网方 式

量存储在 We b 缓存系统中 , We b 缓存系统 向用户 回 吐流量 , 利用存储空间换带宽 , 从而将可缓存重复的 We b 流量 留在本地互联 网内, 减少上行带宽压力。

流量劫持根据劫持缓存系统导人流量类型的不

无效 占用带宽。另流量劫持组网方式缓存系统内容 服务器就相当于普通的 H T I ? P资源服务器 ,若没有 作任何限定 , 互联 网所有用户均可以访问下载其中 的资源 , 消耗电信运营商的上行带宽资源。

( 4 ) D N S劫持 组 网方式不 可持续 2 0 1 0年 5月 5 日 , 由 I C A N N、美 国 政 府 和 V e r i s i g n管 理 的全 球 1 3台根 域 名 服务 器 已经 完 成

面 打开 速 度 , 提升 用 户上 网感 知 , 减少 网络 延 迟 , 并 可减 少 上行 网络带 宽消 耗与拥 塞 。

Q

2 0

…

…

…

…

…

…

…

…

撇

o f T

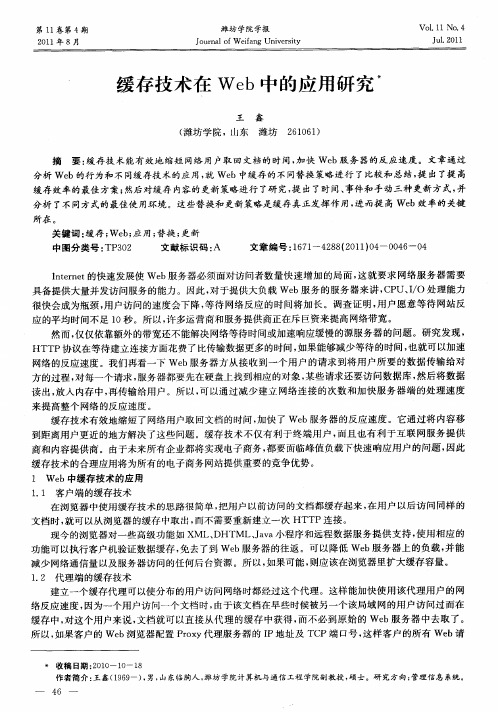

2 We b缓 存 系统 工作 原 理

We b 缓存 系统一般部署在本地互联 网出口处 ,

通 过 一定 的 流 量 引导 方 式 将 可 缓存 重 复 的 We b流

图 2中的①②③ 。

3 . 1 . 3 流量 劫持组 网方 式特 点及优 缺点分 析 流 量 劫持 组 网方 式 We b缓 存 系 统从 源 网站 获 取 内容方 式是 利用独 立 的 内容抓 取模块 ,并通 过分

析用户的访问行为 , 将下载数量超过某一设置阈值

了域名系统安全扩展( D N S S E C : D o m a i n N a m e S y s t e m

关键 词: we b , 缓存 系统 , 组 网方式

Ab s t r a c t :T h i s a r t i c l e i n t r o d u c e s t h e me c h a n i s m

a n d w o r k p oc r e s s o f We b c a c h e s y s t e m. T h e i n c o m-

出请求 , 并从 W e b 服务器下载文件 ;

③F D N S 把 We b缓存 系统 服务器地址 回应给

D N S服务 器 ;

@D N S 服务器把 D N S 解析结果返 回给用户 ; ⑤⑥⑦⑧同图 1 中的①②③④ , 即: ⑤ 用户发 出访 问某 We b服务器上某个文件 的

We b缓存系统工作原理图见 图 1 ,其具体工作

流程 为 :

②D N S服 务器 将 D N S解 析请 求 转发 给指 向

We b缓存 系统 F D N S ;

① 用户一发 出访 问某 We b服务器上某个文件

的请求 , 其请求被转发给 We b 缓存系统 ; @We b 缓存系统收到请求后 , 向 We b 服务器发

的U R L都是直接指向缓存系统的内容服务器 , 用户 可以直接感知缓存系统的存在 。此种类型组网方式 实际上就相 当于将 We b资源站点服务器搬到本地 城域网内, 严格意义上相 当于镜像服务器 。

技术 广角 … … … … … … … … … ・

嚣 ec 0 o 蝴 # 0

We b缓存系统组 网方式研 究

孙 程 育 中国移 动通信 集 团江苏 有限公 司徐 州分公 司工 程师 凯 中国移动 通信 集 团江苏有 限公 司徐 州分公 司 工程师

摘 要 :本文介 绍 We b缓存 系统工作原理与流程 , 根据 流量 导入 方式将其组 网方式分为流量劫持 与

t h e s e wo t t y p e s o f d a t a t r a f i c .U s e t s c a n d e c i d e

客户端发起的请求保存输 出内容 的副本 , 当再次访问这

个U R L地址 的时候 ,如 果 网页没 有更 新 , We b缓存 系统

流量劫持组网方式缓存系统仍然进行 内容抓取 , ③ We b缓存 系统并 向 We b服 务器 发 送 T C P 容,

R E S E T 报文, 终止用户访 问 We b 服务器请求 ; ④⑤⑥ 同图 1 中的②③④ 。

以 后 再 有 用 户 访 问 同样 的 资 源 ,只 需 要 重 复

传送给 We b 缓存系统 , 指定过期时间等信息 ;

⑧We b缓存系统在接 收下载文 件的同时将文

务

3 We b缓 存 系 统 组 网 方 2 D N S 劫持组网方 式We b 缓存系统原理图

…

…

…

3

…

囝

技术 广角 … … … … … … … … … .

更新 , 用户 可能会 看到过 期 的 内容 。 ( 3 ) 消 耗带宽 由于互 联 网内容 的复杂性 ,用 户不再 访 问 的内

①用户访问 We b 服务器资源 , 其请求通过分光 被劫持到 We b 缓存 系统; ② We b缓存 系统 向用户发出伪造 的 3 0 2 调 转

应答 , 指 向其 We b缓存 系统 中的内容 ;

请求 , 其请求被转发给 We b 缓存系统 ; @We b 缓存 系统收到请求后 , 向 We b 服务器发 出请求 , 并从 We b 服务器下载文件 ; ( 7 ) We b 服务器响应 We b 缓存系统请求 , 将文件

̄ ) We b 服务器响应 We b 缓存系统请求 , 将文件

传送给 We b 缓存系统 , 指定过期时间等信息 ; ④We b 缓存 系统在接收下载文件 的同时将文 件传给用户一, 并保存在其存储设备 中; ⑤用户二 由于上网发出访 问某 We b 服务器 上 同一文件 的请求 ;

@We b缓存 系统查询其存储设备 , 发现文件 已

经缓存 , 且未过期 , 直接将从存储设备读 出该文件数 据并传送给用户二 ,如果过期 ,则 We b 缓存 系统再次 向 We b站点请求下 载该 文件 , 即重复② 、 ③步骤。

e c u r i t y E x t e n s i o n s , ) 升级。升级后 , 反 馈 给 用 户 的 的热点对象进行主动抓取, 保存在内容服务器中, 供 S

N S请 求 应答 中会 插入 数 字签 名 , 确 保返 回的 域名 用户访问使用。 另通过流量劫持方式组网 , 用户看到 D

果, 而返 回伪造 的解析结果 , 指向其缓存系

统中的内容服务器 , 具体访问流程见图 2 。 We b 缓存 系统 中没有缓存用 户访 问 的

用 户:

内容 , 其访 问流程为:

图1 W e b缓 存 系 统 工 作原 理 图

①用户访问 We b 服务器资源 ,首先 向 D N S服务器发起 D N S 解析请求 ;

w h i c h o n e t o c h o o s e b a s e d O i l t h e i r r e q u i r e me n t s .

Ke y wo r d s : We b , C a c h e S y s t e m, n e t w o r k i n g mo d e

1 前言

中国互联 网发展 速度 比较迅 猛 , 无 论 是 网 民数 量 还

策略路 由, 并对两种组网方式工作流程 、 特点及其 优缺点进行 对比,流量劫持组 网方式与策略路 由

组网方式各具优 势,可根据具体组 网需求进行 选

择。

是互联网服务种类 ,但从统计来看 , We b 服务是最基本 的服务 , 而且是网民使用次数最多的服务, 其绝对流量不 断增长 , 忙时对电信运营商与 We b网站运营者带来的带

宽 压力很 大 , 导致用 户反 映访 问网站 速度较慢 。 采用 We b缓存 系统 可 以解 决 以上 问题 , We b缓 存 系 统 是 部署 在 用 户客 户 端与 被 访 问 We b服 务器 之 间 的存 储 设备 ,用 于保存 We b资源 副本 , We b 缓 存 系统会 根据

一 一 l I

图 2中①②③④⑤和⑧。