高性能计算集群系统上机申请表

某高校高性能集群部署文档

某高校高性能计算集群部署文档(瘦节点部分)2012年11月25日目录1.文档更新历史........................................................................................................ 错误!未定义书签。

2.集群概览 (5)3.准备工作 (5)3.1.对所有节点的内置硬盘建立RAID (5)3.2.收集物理信息 (6)4.部署管理节点操作系统 (6)4.1.安装操作系统 (6)4.2.系统安装完之后配置 (7)5.安装配置Platform HPC集群管理软件 (8)5.1.安装包准备 (8)5.2.执行安装程序 (8)5.3.安装过程中的操作 (8)6.使用Platform HPC做操作系统分发 (9)6.1.配置网络接口 (9)6.2.为刀片机HS22操作系统分发 (12)6.3.对刀片组HS12操作系统分发 (16)6.4.对IO节点做系统分发 (20)6.5.对Login节点做系统分发 (23)7.使用Platform HPC维护操作系统分发 (26)7.1.移除已经部署的操作系统 (26)7.2.重新部署操作系统 (26)7.3.部署新的机器 (27)7.4.维护部署模板内容 (28)8.GPFS配置方法 ...................................................................................................... 错误!未定义书签。

8.1.XIV近线存储划分 ..................................................................................... 错误!未定义书签。

8.2.XIV存储驱动安装 ..................................................................................... 错误!未定义书签。

常州大学高性能计算集群系统上机申请表(试用)

常州大学高性能计算集群系统上机申请表(试用)

1、用户必须严格遵守国家、学校、信息中心颁布的有关管理规章制度。

2、用户应承担计算项目涉及的信息安全、保密职责。

3、申请帐号仅供申请者本人及其研究团队提交计算任务使用,请妥善保管帐号和密码。

4、用户不得上传与并行计算无关的文件。

5、管理员有权关闭违规用户帐号,并保留追究责任的权利。

6、帐号初始密码为111111。

帐号开通将通过电子邮件通知。

7、管理节点只做提交任务用,尽量不得直接用于计算任务,以免管理节点崩溃。

8、使用学校高性能计算系统发表的成果,在发表时注明“常州大学高性能计算中心支持。

”。

用户签字:日期:。

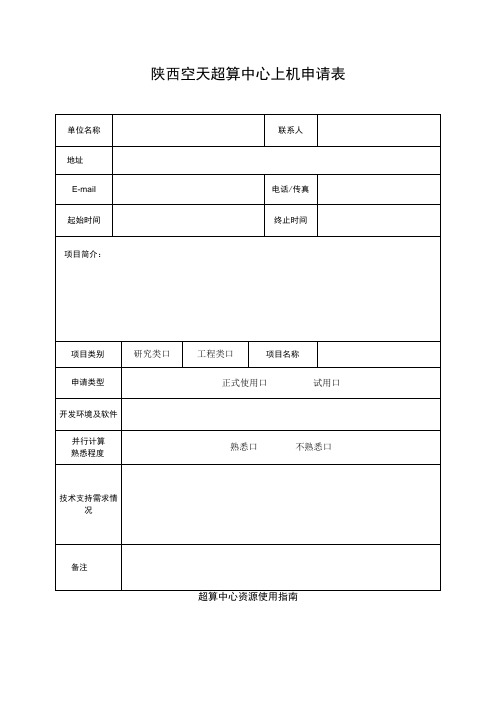

陕西空天超算中心上机申请表

陕西空天超算中心上机申请表

陕西空天超算中心高性能计算平台采用C1USTER开放架构构建通用计算平台,以国际商用X86处理器作为计算核心部件,同时增加国产X86处理器作为实验平台,是一个适用面非常广的高性能超算平台。

配置海量高性能分布式存储系统,构建稳定、可靠、高效的存储平台。

公司开发了定制化的工业云计算平台,为不同客户提供了既可按需定制计算及存储资源,也可前处理、高性能计算、后处理一体化的CAE仿真计算云平台。

本计算平台总计算能力为双精度浮点峰值2100OTfIoPS(IP),可提供物理计算核心数H1OOOO核,采用IOOG高速互联网络全线速互联,数据存储总容量⅛1PB o。

高性能计算集群的设计与实现

高性能计算集群的设计与实现一、引言随着信息技术的飞速发展和普及,大数据和人工智能等领域的深度学习和机器学习等算法的应用越来越广泛,需要处理大量数据和运算量,导致传统的计算机无法满足高性能计算需求。

因此,高性能计算集群的设计与实现成为了当前计算机领域中一个热门话题。

二、高性能计算集群的基本概念高性能计算集群是指将多台计算机通过网络互连,并配备相应的硬件、软件和操作系统,形成一个具有共享资源的整体处理系统,以实现高性能、高并发、高可靠的计算和处理任务。

高性能计算集群的主要构成部分包括控制节点、计算节点、存储节点和交换节点等。

其中,控制节点用于控制和管理整个集群的行为,计算节点用于进行各种计算任务,存储节点用于存储处理数据,交换节点用于进行不同节点之间的数据交换和传输。

高性能计算集群的运作过程可以简单分为三个步骤:任务提交、任务调度和任务执行。

首先,用户将任务提交到控制节点上;然后,控制节点根据任务的性质和资源情况,调度适当的计算节点进行计算;最后,计算节点执行分配给它的任务,完成计算并将结果返回给控制节点。

三、高性能计算集群的设计与实现高性能计算集群的设计与实现需要考虑多种因素,包括硬件架构、软件框架、存储系统、网络互连等等。

1.硬件架构高性能计算集群的硬件架构应该具备高性能、高可靠和可扩展性的特点。

具体来说,需要选择高性能的CPU、GPU、FPGA等计算芯片,并配置大容量的内存和硬盘。

此外,还需要注意各个节点之间的互连方式和网络带宽,以确保数据传输的速度和稳定性。

2.软件框架高性能计算集群的软件框架是支持集群运行的关键。

其中,操作系统、进程管理、作业调度等高效管理和控制系统是必不可少的。

此外,还需要选择适合集群的并行计算框架,例如MPI、OpenMP、CUDA等。

3.存储系统高性能计算集群的存储系统是决定数据读写速度和存储空间大小的关键因素。

在设计存储系统时,需要综合考虑数据类型、读写速度、存储容量和可靠性等因素。

北高性能计算校级公共平台快速入门

登录IP 162.105.133.134 162.105.133.209 162.105.133.164

16

3.1 Linux/Mac用户登录

$ ssh username@ip_address $ ssh -X username@ip_address

其中uername为统一认证账号,ip_address为需要登录 集群的IP,如果需要使用图形界面的话还需要加参数-X。

8

收费标准

未名一号和未名生科一号为收费集群,其中CPU节点 及胖节点按照核心计费,GPU节点按照GPU卡计费,KNL 以台为单位计费。收费详情请查看 (/guide_6.html)

9

以下为生科一号的收费详情,假设用户在C032M0128G节点提交作 业,指定作业优先级为low,那么作业的费用=0.04*使用核心数*作业运 行时长。

节点数 140 51 5 10

8 1 2 227

6

硬件环境:未名生科一号

节点类别 CPU 节 点 GPU 节 点

合计

型号

主要规格

节点数

Lenovo SD530

2*Intel Xeon Gold 6142,128G,双口万兆

129

Hale Waihona Puke Lenovo XS1500

2*Intel Xeon E5-2690 V4,256G,4* NVIDIA Tesla V100,双口千兆

7

CPU节点配120G SSD、GPU节点配1920G SSD、并均配有Intel OPA 100 Series Single-port PCIe 3.0 x16 HFA

136

7

硬件环境:未名教学一号

• 物理机配置

型号 Inspur NF5280M5 Inspur NF5280M5

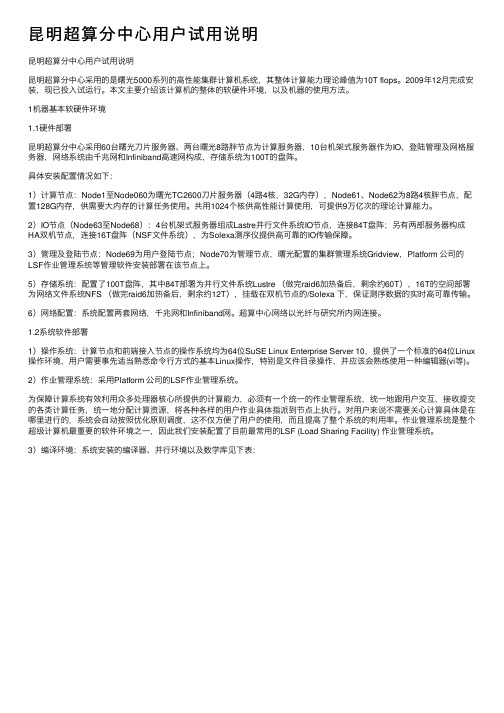

昆明超算分中心用户试用说明

昆明超算分中⼼⽤户试⽤说明昆明超算分中⼼⽤户试⽤说明昆明超算分中⼼采⽤的是曙光5000系列的⾼性能集群计算机系统,其整体计算能⼒理论峰值为10T flops。

2009年12⽉完成安装,现已投⼊试运⾏。

本⽂主要介绍该计算机的整体的软硬件环境,以及机器的使⽤⽅法。

1机器基本软硬件环境1.1硬件部署昆明超算分中⼼采⽤60台曙光⼑⽚服务器、两台曙光8路胖节点为计算服务器,10台机架式服务器作为IO、登陆管理及⽹格服务器,⽹络系统由千兆⽹和Infiniband⾼速⽹构成,存储系统为100T的盘阵。

具体安装配置情况如下:1)计算节点:Node1⾄Node060为曙光TC2600⼑⽚服务器(4路4核,32G内存),Node61、Node62为8路4核胖节点,配置128G内存,供需要⼤内存的计算任务使⽤。

共⽤1024个核供⾼性能计算使⽤,可提供9万亿次的理论计算能⼒。

2)IO节点(Node63⾄Node68):4台机架式服务器组成Lastre并⾏⽂件系统IO节点,连接84T盘阵;另有两部服务器构成HA双机节点,连接16T盘阵(NSF⽂件系统),为Solexa测序仪提供⾼可靠的IO传输保障。

3)管理及登陆节点:Node69为⽤户登陆节点;Node70为管理节点,曙光配置的集群管理系统Gridview,Platform 公司的LSF作业管理系统等管理软件安装部署在该节点上。

5)存储系统:配置了100T盘阵,其中84T部署为并⾏⽂件系统Lustre (做完raid6加热备后,剩余约60T),16T的空间部署为⽹络⽂件系统NFS (做完raid6加热备后,剩余约12T),挂载在双机节点的/Solexa 下,保证测序数据的实时⾼可靠传输。

6)⽹络配置:系统配置两套⽹络,千兆⽹和Infiniband⽹。

超算中⼼⽹络以光纤与研究所内⽹连接。

1.2系统软件部署1)操作系统:计算节点和前端接⼊节点的操作系统均为64位SuSE Linux Enterprise Server 10,提供了⼀个标准的64位Linux 操作环境,⽤户需要事先适当熟悉命令⾏⽅式的基本Linux操作,特别是⽂件⽬录操作,并应该会熟练使⽤⼀种编辑器(vi等)。

高性能计算集群(HPC_CLUSTER)

高性能计算集群(HPC CLUSTER)1.1什么是高性能计算集群?简单地说,高性能计算(High-Performance Computing)是计算机科学的一个分支,它致力于开发超级计算机,研究并行算法和开发相关软件。

高性能集群主要用于处理复杂的计算问题,应用在需要大规模科学计算的环境中,如天气预报、石油勘探与油藏模拟、分子模拟、基因测序等。

高性能集群上运行的应用程序一般使用并行算法,把一个大的普通问题根据一定的规则分为许多小的子问题,在集群内的不同节点上进行计算,而这些小问题的处理结果,经过处理可合并为原问题的最终结果。

由于这些小问题的计算一般是可以并行完成的,从而可以缩短问题的处理时间。

高性能集群在计算过程中,各节点是协同工作的,它们分别处理大问题的一部分,并在处理中根据需要进行数据交换,各节点的处理结果都是最终结果的一部分。

高性能集群的处理能力与集群的规模成正比,是集群内各节点处理能力之和,但这种集群一般没有高可用性。

1.2高性能计算分类高性能计算的分类方法很多。

这里从并行任务间的关系角度来对高性能计算分类。

1.2.1高吞吐计算(High-throughput Computing)有一类高性能计算,可以把它分成若干可以并行的子任务,而且各个子任务彼此间没有什么关联。

因为这种类型应用的一个共同特征是在海量数据上搜索某些特定模式,所以把这类计算称为高吞吐计算。

所谓的Internet计算都属于这一类。

按照Flynn的分类,高吞吐计算属于SIMD(Single Instruction/Multiple Data,单指令流-多数据流)的范畴。

1.2.2分布计算(Distributed Computing)另一类计算刚好和高吞吐计算相反,它们虽然可以给分成若干并行的子任务,但是子任务间联系很紧密,需要大量的数据交换。

按照Flynn的分类,分布式的高性能计算属于MIMD (Multiple Instruction/Multiple Data,多指令流-多数据流)的范畴。

超级计算实验室用户申请表.doc

(研究内容、

计算方法等)

承诺

□遵守《超级计算实验室用户管理条例》

签名栏

开户申请人:

账号负责人/付费人:

实验室主任

意见

备注栏

超级计算实验室用户申请表

日期:年月日

申请人

账号负责人/付费人

申请人类型

□固定人员□访问学者□博士后□研究生□所外人员

VPN账号名称

VPN账号使用时间

年月至年月

计算账号名称

申请使用资源类型

□公共□自有

办公地点

联系电话

电子邮件

申请公共资源

集群名称:

CPU核数:

GPU卡数:Байду номын сангаас

内存需求:

存储需求:

软件需求:

申请自有资源

高性能计算(HPC)

可扩展性

总结词

高性能计算系统的可扩展性是指其随着规模扩大而性能提升的能力。

详细描述

可扩展性是高性能计算系统的一个重要评价指标。为了实现可扩展性,需要解决如何有效地将任务分配给多个处 理器核心、如何实现高效的节点间通信以及如何管理大规模系统的资源等问题。这需要采用先进的并行计算框架、 资源管理和调度算法等技术。

02

HPC系统架构

硬件架构

处理器架构

使用多核处理器和加速器(如GPU、FPGA)以提 高计算性能。

存储架构

采用高速缓存、分布式文件系统、内存数据库等 技术,提高数据访问速度。

网络架构

使用高速InfiniBand、以太网或定制网络技术,实 现节点间高速通信。

软件架构

01

并行计算框架

使用MPI、OpenMP、CUDA等 并行计算框架,实现任务和数据 的并行处理。

使用如Fortran、C/C、Python等语言进行高性能计 算应用程序开发。

性能优化技术

采用向量化、自动并行化、内存优化等技术,提高高 性能计算应用程序性能。

03

HPC应用案例

气候模拟

1

气候模拟是高性能计算的重要应用之一,通过模 拟大气、海洋、陆地等复杂系统的相互作用,预 测未来气候变化趋势。

05

HPC未来展望

异构计算

异构计算是指利用不同类型处理器(如CPU、GPU、FPGA等)协同完成 计算任务的技术。随着处理器技术的不断发展,异构计算在HPC中越来 越受到重视。

异构计算能够充分发挥不同类型处理器的优势,提高计算性能和能效。 例如,GPU适合于并行计算,而CPU则擅长控制和调度。通过合理地组

性能瓶颈

总结词

随着处理器性能的不断提升,高性能计算系统在内存带宽、 I/O性能以及处理器间通信等方面出现了性能瓶颈。

高性能计算集群的使用方法及性能调优

高性能计算集群的使用方法及性能调优高性能计算集群是一种用于处理大规模计算任务的分布式计算环境。

它能够利用多台计算机的计算资源来达到高性能计算的目的。

对于需要进行大规模数据处理、复杂模拟与计算的任务,如天气预测、基因序列分析等,使用高性能计算集群可以显著提升计算效率。

本文将介绍高性能计算集群的使用方法以及性能调优的一些技巧,帮助用户充分利用集群资源,提高计算效率。

一、高性能计算集群的使用方法1.选择合适的集群:在选择使用高性能计算集群之前,需要根据自己的任务需求和预算来选择合适的集群。

可以考虑集群的硬件配置、网络带宽、存储容量等因素,以及集群提供的服务支持。

2.提交任务:在使用高性能计算集群之前,需要准备好需要计算的任务。

一般来说,任务会被拆分为多个小的计算单元,每个计算单元可以在集群中的不同节点上运行。

可以使用集群提供的作业调度系统来提交任务。

3.编写任务脚本:在提交任务之前,需要编写一个任务脚本。

这个脚本可以用来描述任务的运行环境、所需资源以及运行的流程。

脚本可以使用编程语言或者脚本语言编写,提供了一个自动化的方式来管理和运行任务。

4.调试和优化:在提交任务之后,可以通过监控任务的运行状态来进行调试和优化。

可以根据任务的运行日志来分析任务的瓶颈,找出性能瓶颈并进行优化。

5.结果分析:在任务完成之后,需要对结果进行分析。

可以使用数据分析工具来处理和可视化结果,以便更好地理解和解释结果。

二、高性能计算集群的性能调优1.任务并行化:高性能计算集群通常有多个计算节点,可以将任务拆分为多个子任务,并将这些子任务分配到不同的计算节点上并行运行。

通过合理划分任务,可以充分利用集群的计算资源,提高计算效率。

2.数据分区与通信优化:针对需要处理大规模数据的任务,在划分任务的同时,还需要考虑数据的分布和通信的开销。

可以将数据分布在集群的不同节点上,以减少数据传输的开销。

同时,可以选择合适的通信模式和算法来减少通信的延迟和带宽占用。

人大考研-理学院物理系研究生导师简介-刘凯

爱考机构-人大考研-理学院物理系研究生导师简介-刘凯材料计算与物质模拟(点击次数:16058)刘凯基本信息(CV)职称:讲师办公地点:理工楼809室电子邮箱:kliu@电话:0086-10-82502638传真:0086-10-62517887高性能并行计算物理实验室高性能并行计算物理实验室介绍;集群用户上机申请表;高性能计算集群"Kohn"介绍;高性能计算集群"Newton"介绍;GPU服务器"Einstein"介绍;下载专区HPuniversalprinterdrivers(32-bitwindows;64-bitwindows)教育经历1999年09月至2003年06月武汉大学物理系基地班学士2003年09月至2008年06月中国科学院物理研究所博士2005年06月至2005年08月瑞典哥德堡大学物理系短期访问2007年07月至2007年09月瑞典哥德堡大学物理系短期访问工作经历2008年08月至今中国人民大学物理系讲师讲授课程《计算机语言与程序设计I》(课程网站);《计算机语言与程序设计II》(课程网站)研究兴趣主要采用第一性原理方法和多体经验势方法从事表面和纳米结构体系的计算与模拟,并关注新的交换关联势在材料模拟中的应用。

具体包括(1)固体表面吸附的原子/分子体系的电子态、振动谱和动力学;(2)铁基超导材料的体/表面的电子结构、磁结构和晶格动力学及其相互耦合。

科研基金中国人民大学新教师启动金一项(主持),国家自然科学基金一项(主持),校内重大基础研究计划一项(参与)。

获奖情况2006年中国科学院院长奖学金优秀奖主要工作固体表面吸附的原子/分子体系的电子态、振动谱和动力学(1)第一性原理方法研究非弹性隧道电子引起的吸附原子的振动模的激发:与STM实验相结合,揭示出STM沿表面操纵单个原子的新模式ExcitationofFrustratedTranslationandNonadiabaticAdatomHoppingInducedbyInela sticTunneling,KaiLiuandShiwuGao,Phys.Rev.Lett.95,226102(2005).(2)多体经验势方法研究吸附原子的振动模的衰减AdsorbatevibrationandresonancelifetimebroadeningofacobaltadatomonaCu(111)s urface,KaiLiuandShiwuGao,Phys.Rev.B74,195433(2006).(3)第一性原理方法研究表面吸附分子的动力学行为:量子阱态对水分子分解的影响WateradsorptiononNa/Cu(111):State-specificcouplingwithquantumwellstates,KaiLi uandShiwuGao,J.Phys.Chem.C116,17613(2012).(4)第一性原理方法研究表面吸附的原子尺度薄膜中振动模的光学激发:与Raman散射实验相结合,对实验中的振动模进行指认Low-frequencyRamanmodesandelectronicexcitationsinatomicicallythinMoS2films, HualingZeng,BairenZhu,KaiLiu,JiaheFan,XiaodongCui,andQ.M.Zhang,Phys.Rev.B86, 241301(R)(2012).铁基超导材料的体/表面的电子结构、磁结构和晶格动力学及其相互耦合(1)与多种实验手段相结合,采用第一性原理方法对44K铁基超导体的原子结构进行研究Superconductivityat44KinKintercalatedFeSesystemwithexcessFe,An-minZhang,Tian -longXia,KaiLiu,WeiTong,Zhao-rongYang,andQing-mingZhang,ScientificReports3,1 216(2013).(2)第一性原理方法研究铁基超导人工薄膜的电子结构和磁结构AtomicandelectronicstructuresofFeSemonolayerandbilayerthinfilmsonSrTiO3(001): First-principlesstudy,KaiLiu,Zhong-YiLu,andTaoXiang,Phys.Rev.B85,235123(2012). (3)第一性原理方法研究铁基超导体的晶格动力学:与Raman散射实验相结合,对振动模进行指认;此外,计算预测了一种新的手性振动模式Vacancyorderingandphononspectrumoftheiron-basedsuperconductorK0.8Fe1.6Se2 ,A.M.Zhang,K.Liu,J.H.Xiao,J.B.He,D.M.Wang,G.F.Chen,B.Normand,andQ.M.Zhang,Phy s.Rev.B85,024518(2012). EffectofironcontentandpotassiumsubstitutioninA0.8Fe1.6Se2(A=K,Rb,Tl)supercond uctors:ARamanscatteringinvestigation,A.M.Zhang,K.Liu,J.B.He,D.M.Wang,G.F.Chen,B .Normand,andQ.M.Zhang,Phys.Rev.B86,134502(2012).(4)新的交换关联势在铁基超导材料中的应用:杂化泛函的应用First-principlesstudyofFe-basedsuperconductors:Acomparisonofscreenedhybridfun ctionalwithgradientcorrectedfunctional,KaiLiuandZhong-YiLu,Comput.Mater.Sci.55, 284(2012).培养研究生情况在读硕士生1名,联合培养研究生1名,拟每年招收研究生1名。

银河群星高性能计算服务系统YHStarW10T技术方案用户手册国家超级计算长沙中心

中心软件的使用方法

4、读入.cas、.dat文件

中心软件的使用方法

中心软件的使用方法

中心软件的使用方法

5、进行并行计算:点击solve->Iterate,设置需要 计算的步数其他参数后,点击Iterate进行计算

中心软件的使用方法

中心软件的使用方法

(2)命令行方式: a.首先编写一个可自动执行的命令文件. vi fluent_test file/read-case sample.cas file/read-dat sample.dat it 10 file/write-case sample_end.cas file/write-dat sample_end.dat exit

中心软件的使用方法

(2)命令行方式: b.编辑machinefile vi machinefile node1-b node1-b node1-b node1-b node1-b node1-b

中心软件的使用方法

c.编写作业运行脚本 vi task #!/bin/sh export

IBA_MPIRUN=/usr/local/mvapich_zm/bin/mp irun_rsh export IBA_MPILIB=/usr/local/mvapich_zm/lib/sh ared

同时,系统会在当前目录下生成一个类似于slurm-23371.out的文件,系统会将

拟输出到屏幕的内容保存到这个文件中,其中23371是作业ID号。

用户作业管理

注意: ➢ 任务数n=节点数N*单个节点的CPU核数.

yhrun -N 1 -n 8 -w node4 job_name

➢ 用户在提交作业时,一定要指明所需的节点数,即在命令行设置 参数-N,以防作业提交出错.

高性能计算平台(HPC)简介 - 通用

高性能计算平台(HPC)简介SHPC概念简介HPC技术架构HPC应用分析123HPC案例实践4HPC面临挑战5普通计算—传统列车高性能计算—高铁列车 高性能计算好比“高铁列车”,除了车头,每节车厢都有动力,所以算得快。

普通计算好比“传统列车”,只有车头有动力,所以算得慢。

高性能计算(High Performance Computing),通过软件和网络将多台独立的计算机组建成为一个统一系统,通过将一个大规模计算任务进行分割并分发至内部各个计算节点上来实现对中大规模计算任务的支持。

目标:提高大规模应用问题的求解速度,包括但不限于工程仿真、材料科学、生命医药等领域。

l 计算性能强大l 具有海量级存储空间l 高速数据通讯l 完整的软件基础平台软件部分:集群管理软件、作业调度软件、并行存储软件,并行环境,操作系统,行业应用软件硬件部分:服务器、网络、存储数据中心服务部分:专业售后服务,专业应用调优、开发服务,专业设计咨询服务生命科学气象预报数值计算石油勘探生物物理汽车设计药物设计航空航天国防军事云计算中心/省市计算中心异构集群芯片设计基因信息影视渲染船舶制造高性能计算机是一个国家综合实力的体现HPC行业应用HPC超级计算快速发展我国超级计算系统研制过去十年,我国在顶尖超算系统研制处于国际领先行列我国超级计算系统部署情况2023.062022.11过去十年,我国超算系统部署数量处于国际领先行列我国应用情况(以入围ACM Gordon Bell Prize为例)2014地震模拟2016大气动力框架相场模拟海浪模拟地震模拟气候模拟20172018图计算框架量子模拟人造太阳第一性原理过去十年,依托我国顶尖超算系统,大规模并行应用设计和研制方面取得显著进步2021获得国际超算最高奖ACM Gordon Bell奖CPU计算节点硬件平台软件平台应用场景GPU计算节点整机柜产品并行文件存储高性能计算管理平台基础设施管理平台高性能计算行业应用大内存服务器通用服务器气象海洋生命科学物理化学材料科学工业仿真高能物理石油勘探动漫渲染天文遥感基础设施数据中心高密服务器HGX机型PCIe机型整机柜服务器高速网络InfiniBand网络RoCE网络全闪存储混闪存储集群管理集群调度作业提交精细计费应用特征分析平台系统环境微模块数据中心(MDC)液冷MDC 风液式解决方案操作系统编译器并行环境数学库HPC全栈方案架构HPC集群软硬件层次架构SAAS 并行环境PAAS 节点X86机架异构节点X86刀片Gauss Fluent Vasp Wien2k 基础设施供电系统(UPS&PDU)机房机柜系统(水冷/风冷)空调系统(精密空调)……Material studio Matlab 异构开发并行开发集群管理平台网络IB/OPA 千/万兆以太网络KVM IPMIIAAS 存储存储服务器IB/FC 存储阵列集群软件操作系统Linux(RedHat,CentOS…)Windows Server 编译环境环境工具并行文件系统调试工具应用软件应用开发……并行化应用模式应用结点间通讯系统与控制内部互连计算单元处理器,物理层设计,硬件管理Linux, Windows 操作系统与配置管理 操作系统中间件通讯函数库 (MPI, DVSM, PVM, etc) 集群控制与管理编译器,函数库,性能分析与调试工具开发工具作业管理批作业序列与调度,集群监控,系统扩展工具用户, ISV’s 软件工具 HPC 增值供应商 平台与网络供应商供电系统,制冷系统,机房环境基础架构机房方HPC集群硬件拓扑图通用计算——双路计算机架(高密度)、刀片通用计算——胖节点异构节点虚拟工作站区满足所有应用的可视化需求管理登陆机架高速计算网络并行存储区:满足所有应用的共享存储需求KVM、机柜、供电等附属设施CPU Memory I/O Channel ...CPU Memory I/O Channel CPU Memory I/O Channel CPUMemoryI/O Channel CPU Memory I/O Channel 网 络集群(Cluster):将多台计算机组织起来,通过网络连接在一起,进行协同工作,来模拟一台功能更强大的计算机,叫做集群。

xx市工业大学信息中心高性能计算集群

南京工业大学信息中心高性能计算集群用户开户/资源变更申请表附:南京工业大学高性能计算中心用户管理条例(试行)为了充分发挥南京工业大学高性能计算集群大规模科学计算的服务作用,有效规范资源管理,保护其产权,提高科学研究与管理水平,经南京工业大学信息服务部信息中心研究,制定以下的《南京工业大学高性能计算集群用户管理条例》。

一、用户账号管理原则南京工业大学高性能计算集群的大规模计算设备投入大、建设和维护成本高,为使计算资源充分发挥效用,在对用户开放服务中,将遵循以下原则:1. 本校凡需使用高性能计算环境进行科学计算的课题或项目,均可申请使用本中心的计算资源。

本中心为需要科学计算的用户开设用户账号,原则上每位教师可开设1个计算账号,研究生只能使用其导师的计算账号;若确实需要开设两个以上(含)账号的教师,需要获得高性能计算中心批准。

博士后、专职科研岗等非固定职位研究人员开户时需携带工作证原件(“中心”留存复印件)来“中心”办理开户事宜;其账号有效期为工作证上注明的有效日期。

需要延期使用的人员,必须向“中心”提交新申请和学校的相关证明文件,经过“中心”审核批准后方可继续使用。

2. 注重科研效益,优先保证对高性能计算需求强烈的用户使用,特别是涉及国际前沿水平的、国家重点科研项目的、国民经济重大应用的课题及能产生重大经济效益的示范性项目。

二、账号申请手续须知1. 到南京工业大学高性能计算中心领取<<南京工业大学信息中心高性能计算集群用户开户/账号变更申请表>>(或通过网络下载打印此表),如实填写相关信息,加盖所在院系公章,送交信息中心。

2. 完成申请手续后,由系统管理员开设账户,并Email通知用户本人有关开户信息、注意事项及使用方法。

用户应注意保护自己的账号安全,及时修改初始密码。

3. 请用户经常关注校方高性能计算通知,遇到问题及时提问,进行经验交流。

三、计算标准(暂定)本中心的计算资源采用每CPU(核)计时,将在开设账号时根据用户计算需要设定相应的计算时长。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

高性能计算集群系统上机申请表

1、用户必须严格遵守国家、学校、信息中心颁布的有关管理规章制度。

2、用户应承担计算项目涉及的信息安全、保密职责。

3、申请帐号仅供申请者本人及其研究团队提交计算任务使用,请妥善保管帐号和密码。

4、用户不得上传与并行计算无关的文件。

5、管理员有权关闭违规用户帐号,并保留追究责任的权利。

6、帐号初始密码为111111。

帐号开通将通过电子邮件通知。

7、管理节点只做提交任务用,尽量不得直接用于计算任务,以免管理节点崩溃。

8、使用学校高性能计算系统发表的成果,在发表时注明“**大学高性能计算中心支持。

”。

用户签字:日期:。