openstack虚拟化云计算平台详细安装流程报告-单机

openstack安装图解

本帖最后由cryboy2001 于2014-08-15 14:52 编辑目录1、云计算与openstack介绍传统的信息中心云计算介绍openstack介绍物理架构2、openstack架构3、安装openstack方法4、使用openstack5、openstack配置文件6、管理openstack7、详解openstack计算资源池存储资源池网络资源池Glance镜像资源池前端界面Keystone认证管理(不管会不会写完,象openstack一样,先把框架搞大点)一、云计算与openstack介绍1、传统的信息中心。

当然下面画的很简单(自己画的),如果加上多个出口、设备冗余、线路冗余、服务器集群就会复杂。

云计算就是用虚拟技术实现以下功能,如果理解了下面的网络功能,要理解openstack会很简单的,在openstack中都有与下面图中对应的模块。

缺点:1、部署应用时间长,工作量大,至少几个月2、资源利用率,有的服务器资源不够用,有的服务器大量资源浪费。

2、管理复杂3、扩展麻烦,灵活性差。

等等,这些也是云计算的优点。

2、云计算介绍云计算(Cloud Computing )是网格计算(Grid Computing )、分布式计算(Distributed Computing )、并行计算(Parallel Computing )、效用计算(Utility Computing )、网络存储(Network Storage Technologies )、虚拟化(Virtualization )、负载均衡(Load Balance )等传统计算机技术(如以上图)和网络技术发展融合的产物。

个人理解:把一堆功能小的设备,整合成一大个功能强大设备,再把这个强大的设备划分成小设备,然后按你的需要买给你。

公用云(Public Cloud)、私有云(Private Cloud)、混合云(Hybrid Cloud)云计算解决方案:VMware vSphere、微软云计算解决方案、亚马逊AWS、OpenStack 等等3、openstack介绍OpenStack是一个NASA和Rackspace2010年6月合作成立的,以Apache许可证授权,并且是一个自由软件和开放源代码项目。

openstack操作手册

以下是使用openstack的基本操作手册:

1. 安装openstack:根据您的系统和环境要求,遵循官方的安装指南进行安装。

2. 创建项目:使用命令行或管理界面创建一个新的项目。

项目将包含一组资源,包括计算、网络和存储资源。

3. 创建网络:在项目中创建一个新的网络。

网络是用于连接云中的虚拟机和其他资源的虚拟架构。

4. 创建虚拟机:使用命令行或管理界面在项目中创建一个新的虚拟机。

您需要指定所需的配置选项,例如操作系统、处理器、内存和存储。

5. 连接到虚拟机:使用SSH或其他远程桌面工具连接到虚拟机。

您需要提供虚拟机的IP地址和密码或密钥。

6. 配置和管理虚拟机:根据需要配置和管理虚拟机,例如安装软件、配置网络设置等。

7. 创建和管理云存储:使用命令行或管理界面在项目中创建一个新的云存储后端。

您可以定义存储的容量、访问级别和其他配置选项。

8. 创建和管理镜像:使用命令行或管理界面在项目中创建一个新的镜像。

镜像是虚拟机的完整快照,可用于创建新的虚拟机实例。

9. 管理和监控资源:使用命令行或管理界面监控和管理项目中的资源使用情况,例如CPU、内存和存储。

10. 删除项目和资源:根据需要删除项目和其中的资源,以释放云资源并降低成本。

以上是openstack的基本操作手册,根据您的具体需求,您可能需要进行其他高级配置和管理操作。

建议参考openstack的官方文档以获取更详细的信息和指导。

openstack实施手册

3.7RHEV、KVM虚拟化3.7.1 RHEV安装RHEV 虚拟环境由RHEV-H (虚拟服务器)和RHEV-M(管理平台)组成。

RHEV-H安装在裸机上。

RHEV-M安装在redhat linux6.3上,要求4G以上内存。

RHEV3.1版本开始,RHEV-M 安装在linux系统平台。

RHEV3.0版本,只支持windows平台。

1、安装RHEV-H2、安装RHEV-M管理端(1)rhev3.1目录下的内容上传到/root/目录下:(2)配置yum源#cd /etc/yum.repos.d#vi local.repo[rhev]name=Red Hat Enterprise Virtualizationbaseurl=file:///root/rhev3.1enabled=1gpgcheck=1gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-redhat-release(3)安装RHEV-M# yum install rhevm rhevm-reports(4)配置RHEV-M# rhevm-setup在配置过程中,需要输入admin、数据等密码,建议的输入的密码全部相同。

(5)IE访问测试(6)配置报表# rhevm-reports-setup在登录界面选择“Reports Portal”,(默认用户为rhevm-admin,密码是安装时输入的密码)3、RHEV-M管理界面疑问2:RHEV-M、ESXi均无法继承到openstack,除非vmware和redhat开发api疑问3:Pureflex的FSM中不是内置了SCE功能吗,如果Pureflex算P团队的单,FSM 应该内置一个安装SCE云平台的虚拟机。

疑问4:KVM的正版授权。

3.7.2 KVM安装1、重新驱动虚拟机测试物理主机:32C+64GB虚拟机1:8C+32GB虚拟机2:8C+16GB虚拟机3:8C+16GB同时重启三台虚拟机,发现物理主机内存使用率100%后,使用部分swap分区。

Openstack实验手册

.Word 文档计算机新技术综合实践研究生实验手册课程名称:计算机新技术综合实践实验名称:安装部署OpenStack 实验地点:专业:班级:指导教师:吴含前实验时间:年月日实验一64位Linux下手动安装OpenStack Icehouse版本【实验容】学习VMware workstation虚拟机的使用,在CentOS 64位环境下安装搭建OpenStack环境,熟悉Linux基本操作,锻炼同学学习能力、动手能力和分析问题能力。

【实验目的】1、熟悉VMware workstation虚拟机使用2、了解OpenStack整体架构3、了解OpenStack各组件功能4、能够在Linux下手动搭建OpenStack云计算环境【实验环境】计算机实验室VMware workstation虚拟机【实验步骤】一、VMware workstation下安装CentOS 6.5 x64操作系统1、首先安装VMware Workstation2、创建OpenStack控制节点,文件→新建虚拟机3、选择典型(推荐)→下一步4、稍后安装操作系统5、选择操作系统和版本6、输入虚拟机名称和安装路径7、设置磁盘大小8、自定义硬件9、选择CentOS安装镜像文件10、点击完成11、启动虚拟机12、选择第一项,安装全新操作系统或升级现有操作系统13、Tab键进行选择,选择Skip,退出检测14、点击Next15、选择语言,这里选择的是中文简体16、选择键盘样式17、选择存储设备18、输入主机名19、配置网络20、设置时区,勾选使用UTC时间21、输入根用户(root)的密码22、根据此Linux具体功能,选择不同的方式23、选择现在自定义,自定义安装需要的软件,如桌面配置24、点击下一步,开始安装25、安装完成后,点击重新导引26、点击前进按钮27、点击是,同意许可,再点击前进按钮28、创建用户29、设置日期和时间,如果可以上网,勾选在网上同步日期和时间二、OpenStack环境预配置1、设置OpenStack网络,一块NAT网卡,一块仅主机网卡2、同理创建另外两台虚拟机,一台计算节点,一台网络节点3、配置虚拟机网络环境,如下表三、OpenStack环境搭建1、安装部署控制节点(1)首先配置Linux能上网,可以ping通.baidu.(2)安装MySQL数据库如下执行命令# yum install ntp# service ntpd start# chkconfig ntpd on# yum install mysql mysql-server MySQL-python编辑/etc/f 文件:# vi /etc/f[mysqld]...bind-address = 10.6.12.130 #添加这句[mysqld]...default-storage-engine = innodb #添加这句innodb_file_per_table #添加这句collation-server = utf8_general_ci #添加这句init-connect = 'SET NAMES utf8' #添加这句character-set-server = utf8 #添加这句保存退出# service mysqld start# chkconfig mysqld on# mysql_install_db# mysql_secure_installation(3)安装OpenStack软件源包# yum install yum-plugin-priorities# yum install /repos/openstack/openstack-icehouse/rdo-release-i cehouse-3.noarch.rpm# yum install /pub/epel/6/x86_64/epel-release-6-8.noarch.rpm# yum install openstack-utils# yum install openstack-selinux# yum upgrade# reboot(4)安装qpid# yum install qpid-cpp-server编辑/etc/qpidd.conf文件# vi /etc/qpidd.confauth=no #修改为no保存退出# service qpidd start# chkconfig qpidd on(5)安装keystone组件# yum install openstack-keystone python-keystoneclient# openstack-config --set /etc/keystone/keystone.conf database connection mysql://keys tone:keystonecontroller/keystone$ mysql -u root -pmysql> CREATE DATABASE keystone;mysql> GRANT ALL PRIVILEGES ON keystone.* TO 'keystone''localhost' IDENTIFIED BY ' keystone';mysql> GRANT ALL PRIVILEGES ON keystone.* TO 'keystone''%' IDENTIFIED BY 'keyston e';mysql> exit# su -s /bin/sh -c "keystone-manage db_sync" keystone# ADMIN_TOKEN=$(openssl rand -hex 10)# echo $ADMIN_TOKEN# openstack-config --set /etc/keystone/keystone.conf DEFAULT admin_token $ADMIN_T OKEN# keystone-manage pki_setup --keystone-user keystone --keystone-group keystone # chown -R keystone:keystone /etc/keystone/ssl# chmod -R o-rwx /etc/keystone/ssl# service openstack-keystone start# chkconfig openstack-keystone on# (crontab -l -u keystone 2>&1 | grep -q token_flush) || echo 'hourly /usr/bin/keysto ne-manage token_flush >/var/log/keystone/keystone-tokenflush.log 2>&1' >> /var/spoo l/cron/keystone编辑~/.bash_profile文件,在最后添加export OS_USERNAME=adminexport OS_PASSWORD=adminexport OS_TENANT_NAME=adminexport OS_AUTH_URL=controller:35357/v2.0export ADMIN_TOKEN=223e5aa00e1401925a5d【注意此值与ADMIN_TOKEN值一样】export SERVICE_TOKEN=$ADMIN_TOKENexport SERVICE_ENDPOINT=controller:35357/v2.0export OS_SERVICE_TOKEN=$ADMIN_TOKENexport OS_SERVICE_ENDPOINT=controller:35357/v2.0保存退出#source ~/.bash_profile$ keystone user-create --name=admin --pass=admin --email=admintest.$ keystone role-create --name=admin$ keystone tenant-create --name=admin --description="Admin Tenant"$ keystone user-role-add --user=admin --tenant=admin --role=admin$ keystone user-role-add --user=admin --role=_member_ --tenant=admin$ keystone user-create --name=demo --pass=demo --email=demotest.$ keystone tenant-create --name=demo --description="Demo Tenant"$ keystone user-role-add --user=demo --role=_member_ --tenant=demo$ keystone tenant-create --name=service --description="Service Tenant"$ keystone service-create --name=keystone --type=identity --description="OpenStack I dentity"$ keystone endpoint-create --service-id=$(keystone service-list | awk '/ identity / {prin t $2}') --publicurl=controller:5000/v2.0 --internalurl=controller:500key0/v2.0 --adminurl= controller:35357/v2.0(6)安装glance组件# yum install openstack-glance python-glanceclient# openstack-config --set /etc/glance/glance-api.conf database connection mysql://glanc e:glancecontroller/glance# openstack-config --set /etc/glance/glance-registry.conf database connection mysql://glance:glancecontroller/glance$ mysql -u root -pmysql> CREATE DATABASE glance;mysql> GRANT ALL PRIVILEGES ON glance.* TO 'glance''localhost' IDENTIFIED BY 'glan ce';mysql> GRANT ALL PRIVILEGES ON glance.* TO 'glance''%' IDENTIFIED BY 'glance'; mysql> exit;# openstack-db --init --service glance# keystone user-create --name=glance --pass=glance --email=glancetest.# keystone user-role-add --user=glance --tenant=service --role=admin# openstack-config --set /etc/glance/glance-api.conf keystone_authtoken auth_uri contr oller:5000# openstack-config --set /etc/glance/glance-api.conf keystone_authtoken auth_host con troller# openstack-config --set /etc/glance/glance-api.conf keystone_authtoken auth_port 353 57# openstack-config --set /etc/glance/glance-api.conf keystone_authtoken auth_protocol http# openstack-config --set /etc/glance/glance-api.conf keystone_authtoken admin_tenant_ name service# openstack-config --set /etc/glance/glance-api.conf keystone_authtoken admin_user gl ance# openstack-config --set /etc/glance/glance-api.conf keystone_authtoken admin_passwo rd glance# openstack-config --set /etc/glance/glance-api.conf paste_deploy flavor keystone# openstack-config --set /etc/glance/glance-registry.conf keystone_authtoken auth_uri c ontroller:5000# openstack-config --set /etc/glance/glance-registry.conf keystone_authtoken auth_host controller# openstack-config --set /etc/glance/glance-registry.conf keystone_authtoken auth_port 35357# openstack-config --set /etc/glance/glance-registry.conf keystone_authtoken auth_prot ocol http# openstack-config --set /etc/glance/glance-registry.conf keystone_authtoken admin_ten ant_name service# openstack-config --set /etc/glance/glance-registry.conf keystone_authtoken admin_us er glance# openstack-config --set /etc/glance/glance-registry.conf keystone_authtoken admin_pa ssword glance# openstack-config --set /etc/glance/glance-registry.conf paste_deploy flavor keystone# keystone service-create --name=glance --type=image --description="OpenStack Ima ge Service"# keystone endpoint-create --service-id=$(keystone service-list | awk '/ image / {print $2}') --publicurl=controller:9292 --internalurl=controller:9292 --adminurl=controller:929 2# service openstack-glance-api restart# service openstack-glance-registry restart# chkconfig openstack-glance-api on# chkconfig openstack-glance-registry on(7)安装Nova组件# yum install openstack-nova-api openstack-nova-cert openstack-nova-conductor ope nstack-nova-console openstack-nova-novncproxy openstack-nova-scheduler python-nov aclient# openstack-config --set /etc/nova/nova.conf database connection mysql://nova:novac ontroller/nova# openstack-config --set /etc/nova/nova.conf DEFAULT rpc_backend qpid# openstack-config --set /etc/nova/nova.conf DEFAULT qpid_hostname controller# openstack-config --set /etc/nova/nova.conf DEFAULT my_ip 10.6.12.130# openstack-config --set /etc/nova/nova.conf DEFAULT vncserver_listen 10.6.12.130 # openstack-config --set /etc/nova/nova.conf DEFAULT vncserver_proxyclient_address 10.6.12.130(控制节点Controller IP地址)$ mysql -u root -pmysql> CREATE DATABASE nova;mysql> GRANT ALL PRIVILEGES ON nova.* TO 'nova''localhost' IDENTIFIED BY 'nova';mysql> GRANT ALL PRIVILEGES ON nova.* TO 'nova''%' IDENTIFIED BY 'nova';mysql> exit;# su -s /bin/sh -c "nova-manage db sync" nova# keystone user-create --name=nova --pass=nova --email=novaexample.# keystone user-role-add --user=nova --tenant=service --role=admin# openstack-config --set /etc/nova/nova.conf DEFAULT auth_strategy keystone# openstack-config --set /etc/nova/nova.conf keystone_authtoken auth_uri controller:5000# openstack-config --set /etc/nova/nova.conf keystone_authtoken auth_host controller # openstack-config --set /etc/nova/nova.conf keystone_authtoken auth_protocol http # openstack-config --set /etc/nova/nova.conf keystone_authtoken auth_port 35357 # openstack-config --set /etc/nova/nova.conf keystone_authtoken admin_user nova # openstack-config --set /etc/nova/nova.conf keystone_authtoken admin_tenant_name s ervice# openstack-config --set /etc/nova/nova.conf keystone_authtoken admin_password nov a# keystone service-create --name=nova --type=compute --description="OpenStack Co mpute"# keystone endpoint-create --service-id=$(keystone service-list | awk '/ compute / {pri nt $2}') --publicurl=controller:8774/v2/%\(tenant_id\)s --internalurl=controller:8774/v2/%\(t enant_id\)s --adminurl=controller:8774/v2/%\(tenant_id\)s# service openstack-nova-api restart# service openstack-nova-cert restart# service openstack-nova-consoleauth restart# service openstack-nova-scheduler restart# service openstack-nova-conductor restart# service openstack-nova-novncproxy restart# chkconfig openstack-nova-api on# chkconfig openstack-nova-cert on# chkconfig openstack-nova-consoleauth on# chkconfig openstack-nova-scheduler on# chkconfig openstack-nova-conductor on# chkconfig openstack-nova-novncproxy on(8)安装Neutron组件# yum install openstack-neutron openstack-neutron-ml2 python-neutronclient$ mysql -u root -pmysql> CREATE DATABASE neutron;mysql> GRANT ALL PRIVILEGES ON neutron.* TO 'neutron''localhost' IDENTIFIED BY 'n eutron';mysql> GRANT ALL PRIVILEGES ON neutron.* TO 'neutron''%' IDENTIFIED BY 'neutron';mysql> exit;$ keystone user-create --name neutron --pass neutron --email neutronexample.$ keystone user-role-add --user neutron --tenant service --role admin$ keystone service-create --name=neutron --type=network --description="OpenStack Networking"$ keystone endpoint-create --service-id $(keystone service-list | awk '/ network / {prin t $2}') --publicurl controller:9696 --adminurl controller:9696 --internalurl controller:969 6# openstack-config --set /etc/neutron/neutron.conf database connection mysql://neutro n:neutroncontroller/neutron# openstack-config --set /etc/neutron/neutron.conf DEFAULT auth_strategy keystone # openstack-config --set /etc/neutron/neutron.conf keystone_authtoken auth_uri control ler:5000# openstack-config --set /etc/neutron/neutron.conf keystone_authtoken auth_host contr oller# openstack-config --set /etc/neutron/neutron.conf keystone_authtoken auth_protocol h ttp# openstack-config --set /etc/neutron/neutron.conf keystone_authtoken auth_port 3535 7# openstack-config --set /etc/neutron/neutron.conf keystone_authtoken admin_tenant_n ame service# openstack-config --set /etc/neutron/neutron.conf keystone_authtoken admin_user ne utron# openstack-config --set /etc/neutron/neutron.conf keystone_authtoken admin_passwor d neutron# openstack-config --set /etc/neutron/neutron.conf DEFAULT rpc_backend neutron.ope mon.rpc.impl_qpid# openstack-config --set /etc/neutron/neutron.conf DEFAULT qpid_hostname controller# openstack-config --set /etc/neutron/neutron.conf DEFAULT notify_nova_on_port_status _changes True# openstack-config --set /etc/neutron/neutron.conf DEFAULT notify_nova_on_port_data_ changes True# openstack-config --set /etc/neutron/neutron.conf DEFAULT nova_url controller:8774/v 2# openstack-config --set /etc/neutron/neutron.conf DEFAULT nova_admin_username no va# openstack-config --set /etc/neutron/neutron.conf DEFAULT nova_admin_tenant_id $(k eystone tenant-list | awk '/ service / { print $2 }')# openstack-config --set /etc/neutron/neutron.conf DEFAULT nova_admin_password no va# openstack-config --set /etc/neutron/neutron.conf DEFAULT nova_admin_auth_url cont roller:35357/v2.0# openstack-config --set /etc/neutron/neutron.conf DEFAULT core_plugin ml2# openstack-config --set /etc/neutron/neutron.conf DEFAULT service_plugins router# openstack-config --set /etc/neutron/plugins/ml2/ml2_conf.ini ml2 type_drivers gre# openstack-config --set /etc/neutron/plugins/ml2/ml2_conf.ini ml2 tenant_network_type s gre# openstack-config --set /etc/neutron/plugins/ml2/ml2_conf.ini ml2 mechanism_drivers openvswitch# openstack-config --set /etc/neutron/plugins/ml2/ml2_conf.ini ml2_type_gre tunnel_id_r anges 1:1000# openstack-config --set /etc/neutron/plugins/ml2/ml2_conf.ini securitygroup firewall_dri ver neutron.agent.linux.iptables_firewall.OVSHybridIptablesFirewallDriver# openstack-config --set /etc/neutron/plugins/ml2/ml2_conf.ini securitygroup enable_se curity_group True# openstack-config --set /etc/nova/nova.conf DEFAULT network_api_class work.neutronv2.api.API# openstack-config --set /etc/nova/nova.conf DEFAULT neutron_url controller:9696 # openstack-config --set /etc/nova/nova.conf DEFAULT neutron_auth_strategy keystone # openstack-config --set /etc/nova/nova.conf DEFAULT neutron_admin_tenant_name se rvice# openstack-config --set /etc/nova/nova.conf DEFAULT neutron_admin_username neutr on# openstack-config --set /etc/nova/nova.conf DEFAULT neutron_admin_password neutr on# openstack-config --set /etc/nova/nova.conf DEFAULT neutron_admin_auth_url controll er:35357/v2.0# openstack-config --set /etc/nova/nova.conf DEFAULT linuxnet_interface_driver nova.ne twork.linux_net.LinuxOVSInterfaceDriver# openstack-config --set /etc/nova/nova.conf DEFAULT firewall_driver nova.virt.firewall.N oopFirewallDriver# openstack-config --set /etc/nova/nova.conf DEFAULT security_group_api neutron sec urity_group_api neutron# ln -s plugins/ml2/ml2_conf.ini /etc/neutron/plugin.ini# service openstack-nova-api restart# service openstack-nova-scheduler restart# service openstack-nova-conductor restart# service neutron-server restart# chkconfig neutron-server on2、安装部署计算节点(1)首先配置Linux能上网,可以ping通.baidu.(2)安装OpenStack软件包源# yum install yum-plugin-priorities# yum install /repos/openstack/openstack-icehouse/rdo-release-ic ehouse-3.noarch.rpm# yum install /pub/epel/6/x86_64/epel-release-6-8.noarch.rpm# yum install openstack-utils# yum install openstack-selinux# yum upgrade# reboot(3)安装Nova组件# openstack-config --set /etc/nova/nova.conf database connection mysql://nova:novaco ntroller/nova# openstack-config --set /etc/nova/nova.conf DEFAULT auth_strategy keystone# openstack-config --set /etc/nova/nova.conf keystone_authtoken auth_uri controller:50 00# openstack-config --set /etc/nova/nova.conf keystone_authtoken auth_host controller # openstack-config --set /etc/nova/nova.conf keystone_authtoken auth_protocol http # openstack-config --set /etc/nova/nova.conf keystone_authtoken auth_port 35357# openstack-config --set /etc/nova/nova.conf keystone_authtoken admin_user nova# openstack-config --set /etc/nova/nova.conf keystone_authtoken admin_tenant_name s ervice# openstack-config --set /etc/nova/nova.conf keystone_authtoken admin_password nov a# openstack-config --set /etc/nova/nova.conf DEFAULT rpc_backend qpid# openstack-config --set /etc/nova/nova.conf DEFAULT qpid_hostname controller# openstack-config --set /etc/nova/nova.conf DEFAULT my_ip 10.6.12.131# openstack-config --set /etc/nova/nova.conf DEFAULT vnc_enabled True# openstack-config --set /etc/nova/nova.conf DEFAULT vncserver_listen 0.0.0.0# openstack-config --set /etc/nova/nova.conf DEFAULT vncserver_proxyclient_address 1 0.6.12.131# openstack-config --set /etc/nova/nova.conf DEFAULT novncproxy_base_url controller: 6080/vnc_auto.html# openstack-config --set /etc/nova/nova.conf DEFAULT glance_host controller# egrep -c '(vmx|svm)' /proc/cpuinfo(如果返回0,执行下面这句,否则不执行)# openstack-config --set /etc/nova/nova.conf libvirt virt_type qemu# service libvirtd start# service messagebus start# chkconfig libvirtd on# chkconfig messagebus on# chkconfig openstack-nova-compute on(4)安装Neutron组件编辑/etc/sysctl.conf文件# vi /etc/sysctl.confnet.ipv4.conf.all.rp_filter=0net.ipv4.conf.default.rp_filter=0保存退出# modprobe bridge# sysctl -p# yum install openstack-neutron-ml2 openstack-neutron-openvswitch# openstack-config --set /etc/neutron/neutron.conf DEFAULT auth_strategy keystone # openstack-config --set /etc/neutron/neutron.conf keystone_authtoken auth_uri control ler:5000# openstack-config --set /etc/neutron/neutron.conf keystone_authtoken auth_host contr oller# openstack-config --set /etc/neutron/neutron.conf keystone_authtoken auth_protocol h ttp# openstack-config --set /etc/neutron/neutron.conf keystone_authtoken auth_port 3535 7# openstack-config --set /etc/neutron/neutron.conf keystone_authtoken admin_tenant_n ame service# openstack-config --set /etc/neutron/neutron.conf keystone_authtoken admin_user ne utron# openstack-config --set /etc/neutron/neutron.conf keystone_authtoken admin_password neutron# openstack-config --set /etc/neutron/neutron.conf DEFAULT rpc_backend neutron.ope mon.rpc.impl_qpid# openstack-config --set /etc/neutron/neutron.conf DEFAULT qpid_hostname controller# openstack-config --set /etc/neutron/neutron.conf DEFAULT core_plugin ml2# openstack-config --set /etc/neutron/neutron.conf DEFAULT service_plugins router# openstack-config --set /etc/neutron/plugins/ml2/ml2_conf.ini ml2 type_drivers gre# openstack-config --set /etc/neutron/plugins/ml2/ml2_conf.ini ml2 tenant_network_type s gre# openstack-config --set /etc/neutron/plugins/ml2/ml2_conf.ini ml2 mechanism_drivers openvswitch# openstack-config --set /etc/neutron/plugins/ml2/ml2_conf.ini ml2_type_gre tunnel_id_r anges 1:1000# openstack-config --set /etc/neutron/plugins/ml2/ml2_conf.ini ovs local_ip 10.6.12.131 # openstack-config --set /etc/neutron/plugins/ml2/ml2_conf.ini ovs tunnel_type gre# openstack-config --set /etc/neutron/plugins/ml2/ml2_conf.ini ovs enable_tunneling Tr ue# openstack-config --set /etc/neutron/plugins/ml2/ml2_conf.ini securitygroup firewall_dri ver neutron.agent.linux.iptables_firewall.OVSHybridIptablesFirewallDriver# openstack-config --set /etc/neutron/plugins/ml2/ml2_conf.ini securitygroup enable_se curity_group True# service openvswitch start# chkconfig openvswitch on# ovs-vsctl add-br br-int# openstack-config --set /etc/nova/nova.conf DEFAULT network_api_class work.neutronv2.api.API# openstack-config --set /etc/nova/nova.conf DEFAULT neutron_url controller:9696 # openstack-config --set /etc/nova/nova.conf DEFAULT neutron_auth_strategy keystone # openstack-config --set /etc/nova/nova.conf DEFAULT neutron_admin_tenant_name se rvice# openstack-config --set /etc/nova/nova.conf DEFAULT neutron_admin_username neutr on# openstack-config --set /etc/nova/nova.conf DEFAULT neutron_admin_password neutr on# openstack-config --set /etc/nova/nova.conf DEFAULT neutron_admin_auth_url controll er:35357/v2.0# openstack-config --set /etc/nova/nova.conf DEFAULT linuxnet_interface_driver nova.ne twork.linux_net.LinuxOVSInterfaceDriver# openstack-config --set /etc/nova/nova.conf DEFAULT firewall_driver nova.virt.firewall.N oopFirewallDriver# openstack-config --set /etc/nova/nova.conf DEFAULT security_group_api neutron# ln -s plugins/ml2/ml2_conf.ini /etc/neutron/plugin.ini# cp /etc/init.d/neutron-openvswitch-agent /etc/init.d/neutronopenvswitch-agent.orig # sed -i 's,plugins/openvswitch/ovs_neutron_plugin.ini,plugin.ini,g' /etc/init.d/neutron-ope nvswitch-agent# service openstack-nova-compute restart# service neutron-openvswitch-agent start# chkconfig neutron-openvswitch-agent on3、安装部署网络节点(1)首先配置Linux能上网,可以ping通www.baidu.(2)安装OpenStack软件包源# yum install yum-plugin-priorities# yum install /repos/openstack/openstack-icehouse/rdo-release-ic ehouse-3.noarch.rpm# yum install /pub/epel/6/x86_64/epel-release-6-8.noarch.rpm# yum install openstack-utils# yum install openstack-selinux# yum upgrade# reboot(3)配置网络转发编辑/etc/sysctl.conf文件# vi /etc/sysctl.confnet.ipv4.ip_forward=1 #改为1net.ipv4.conf.all.rp_filter=0net.ipv4.conf.default.rp_filter=0保存退出# modprobe bridge# sysctl -p(4)安装Neutron组件# yum install openstack-neutron openstack-neutron-ml2 openstack-neutron-openvswitc h# openstack-config --set /etc/neutron/neutron.conf DEFAULT auth_strategy keystone # openstack-config --set /etc/neutron/neutron.conf keystone_authtoken auth_uri control ler:5000# openstack-config --set /etc/neutron/neutron.conf keystone_authtoken auth_host contr oller# openstack-config --set /etc/neutron/neutron.conf keystone_authtoken auth_protocol h ttp# openstack-config --set /etc/neutron/neutron.conf keystone_authtoken auth_port 35357# openstack-config --set /etc/neutron/neutron.conf keystone_authtoken dmin_tenant_na me service# openstack-config --set /etc/neutron/neutron.conf keystone_authtoken admin_user ne utron# openstack-config --set /etc/neutron/neutron.conf keystone_authtoken admin_passwor d neutron# openstack-config --set /etc/neutron/neutron.conf DEFAULT rpc_backend neutron.ope mon.rpc.impl_qpid# openstack-config --set /etc/neutron/neutron.conf DEFAULT qpid_hostname controller# openstack-config --set /etc/neutron/neutron.conf DEFAULT core_plugin ml2# openstack-config --set /etc/neutron/neutron.conf DEFAULT service_plugins router# openstack-config --set /etc/neutron/l3_agent.ini DEFAULT interface_driver neutron.age nt.linux.interface.OVSInterfaceDriver# openstack-config --set /etc/neutron/l3_agent.ini DEFAULT use_namespaces True# openstack-config --set /etc/neutron/dhcp_agent.ini DEFAULT interface_driver neutron. agent.linux.interface.OVSInterfaceDriver# openstack-config --set /etc/neutron/dhcp_agent.ini DEFAULT dhcp_driver neutron.age nt.linux.dhcp.Dnsmasq# openstack-config --set /etc/neutron/dhcp_agent.ini DEFAULT use_namespaces True# openstack-config --set /etc/neutron/dhcp_agent.ini DEFAULT dnsmasq_config_file /etc /neutron/dnsmasq-neutron.conf# vim /etc/neutron/dnsmasq-neutron.confdhcp-option-force=26,1454# killall dnsmasq# openstack-config --set /etc/neutron/metadata_agent.ini DEFAULT auth_url controller:5 000/v2.0# openstack-config --set /etc/neutron/metadata_agent.ini DEFAULT auth_region region One# openstack-config --set /etc/neutron/metadata_agent.ini DEFAULT admin_tenant_name service# openstack-config --set /etc/neutron/metadata_agent.ini DEFAULT admin_user neutron # openstack-config --set /etc/neutron/metadata_agent.ini DEFAULT admin_password ne utron# openstack-config --set /etc/neutron/metadata_agent.ini DEFAULT nova_metadata_ip c ontroller# openstack-config --set /etc/neutron/metadata_agent.ini DEFAULT metadata_proxy_sha red_secret metadata# openstack-config --set /etc/neutron/plugins/ml2/ml2_conf.ini ml2 type_drivers gre# openstack-config --set /etc/neutron/plugins/ml2/ml2_conf.ini ml2 tenant_network_type s gre# openstack-config --set /etc/neutron/plugins/ml2/ml2_conf.ini ml2 mechanism_drivers openvswitch# openstack-config --set /etc/neutron/plugins/ml2/ml2_conf.ini ml2_type_gre tunnel_id_r anges 1:1000# openstack-config --set /etc/neutron/plugins/ml2/ml2_conf.ini ovs local_ip 10.6.12.132 # openstack-config --set /etc/neutron/plugins/ml2/ml2_conf.ini ovs tunnel_type gre# openstack-config --set /etc/neutron/plugins/ml2/ml2_conf.ini ovs enable_tunneling Tr ue# openstack-config --set /etc/neutron/plugins/ml2/ml2_conf.ini securitygroup firewall_dri ver neutron.agent.linux.iptables_firewall.OVSHybridIptablesFirewallDriver# openstack-config --set /etc/neutron/plugins/ml2/ml2_conf.ini securitygroup enable_se curity_group True# service openvswitch start# chkconfig openvswitch on# ovs-vsctl add-br br-int# ovs-vsctl add-br br-ex# ovs-vsctl add-port br-ex eth2# ln -s plugins/ml2/ml2_conf.ini /etc/neutron/plugin.ini# cp /etc/init.d/neutron-openvswitch-agent /etc/init.d/neutronopenvswitch-agent.orig # sed -i 's,plugins/openvswitch/ovs_neutron_plugin.ini,plugin.ini,g' /etc/init.d/neutron-ope nvswitch-agent# service neutron-openvswitch-agent start# service neutron-l3-agent start# service neutron-dhcp-agent start# service neutron-metadata-agent start# chkconfig neutron-openvswitch-agent on# chkconfig neutron-l3-agent on# chkconfig neutron-dhcp-agent on# chkconfig neutron-metadata-agent on(5)控制节点配置neutron信息# openstack-config --set /etc/nova/nova.conf DEFAULT service_neutron_metadata_proxy true# openstack-config --set /etc/nova/nova.conf DEFAULT neutron_metadata_proxy_shared _secret metadata# service openstack-nova-api restart4、控制节点安装部署Horizon组件# yum install memcached python-memcached mod_wsgi openstack-dashboard将/etc/openstackdashboard/local_settings中的CACHES['default']['LOCATION']值改为和/etc/sys config/memcached 中的一样。

《2024年基于OpenStack构建私有云计算平台》范文

《基于OpenStack构建私有云计算平台》篇一一、引言随着信息技术的迅猛发展,云计算作为一种新型的计算模式,已成为企业和组织进行信息化建设的重要方向。

私有云计算平台作为一种安全、高效、灵活的云计算解决方案,被越来越多的企业所采用。

本文将详细介绍如何基于OpenStack构建私有云计算平台,以实现企业信息化的高效管理和应用。

二、OpenStack概述OpenStack是一个开源的云计算管理平台项目,它提供了一整套的管理工具,用于构建和管理大规模的云计算环境。

OpenStack具有高度的可扩展性、灵活性和可靠性,可以满足不同企业和组织的需求。

通过使用OpenStack,企业可以构建自己的私有云计算平台,实现计算资源的集中管理和动态分配。

三、构建私有云计算平台的步骤1. 需求分析:首先,根据企业的实际需求,进行需求分析,明确私有云计算平台的建设目标、功能需求、性能指标等。

2. 硬件准备:根据需求分析结果,选择合适的服务器、存储设备、网络设备等硬件设备,搭建云计算平台的物理基础。

3. 软件选择与安装:选择适合的OpenStack版本,并安装必要的软件和依赖库。

同时,还需要安装虚拟机管理程序(如KVM)等。

4. 网络配置:配置网络设备,建立内部网络和外部网络,确保云计算平台内部和外部的通信畅通。

5. 存储配置:根据需求,配置相应的存储设备,如SAN、NAS等,以满足云计算平台对存储的需求。

6. 部署服务:在云计算平台上部署必要的服务,如计算服务、存储服务、网络服务等。

7. 配置管理:通过OpenStack的管理工具,对云计算平台进行配置和管理,实现计算资源的动态分配和调度。

四、关键技术与挑战在构建私有云计算平台的过程中,需要掌握一些关键技术,如虚拟化技术、分布式存储技术、网络技术等。

同时,还需要面对一些挑战,如如何保证云计算平台的安全性和稳定性、如何实现计算资源的动态分配和调度等。

为了解决这些问题,需要采取一系列的措施,如加强安全防护、优化资源配置、定期维护等。

OpenStack创建虚机流程

OpenStack创建虚机流程1. 创建虚机的总体流程原⽂(英⽂)链接:创建虚机的请求流如下:1. Dashboard 或者 CLI 获取⽤户的登录信息,调⽤ Keystone 的 REST API 去做⽤户⾝份验证。

2. Keystone 对⽤户登录信息进⾏校验,然后产⽣验证token并发回。

它会被⽤于后续 REST 调⽤请求。

3. Dashboard 或者 CLI 将创建虚机的 REST请求中的‘launch instance’ 或‘nova-boot’ 部分进⾏转换,然后调⽤ nova-api 的 REST 接⼝。

4. nova-api 接到请求,向 keystone 发送 auth-token 校验和权限认证请求。

5. Keystone 校验 token,并将 auth headers 发回,它包括了 roles 和 permissions。

6. nova-api 和 nova-database 进⾏交互。

7. nova-database 为新实例创建⼀个数据库条⽬。

8. nova-api 向 nova-scheduler 发送 rpc.call 请求,期望它能通过附带的 host ID 获取到数据库条⽬。

9. nova-scheduler 从 queue 中获取到请求。

10. nova-scheduler 和 nova-database 交互,获取集群中计算节点的信息和状态。

11. nova-scheuler 通过过滤(filtering)和称重(weighting)找到⼀个合适的计算节点(host)。

12. nova-scheduler 向找到的那个host上的 nova-compute 发送 rpc.cast 请求去启动虚机。

13. ⽬标 host 上的 nova-compute 从 queue 中获取到请求。

14. nova-compute 向 nova-condutor 发送 rpc.call 请求去获取待创建虚机的信息⽐如 host ID 和 flavor 等。

openstack的安装和部署

openstack的安装和部署1.什么是云计算1:什么是云计算?云计算是通过虚拟化技术去实现的,它是⼀种按量付费的模式!2:为什么要⽤云计算?⼩公司:1年,20⼈+,500w,招⼀个运维,15k,(10台*1.5w,托管IDC机房,8k/年,带宽 100M,5个公⽹ip, 10k/⽉), 买10台云主机,600*10=6000⼤公司:举⾏活动,加集群,把闲置时间出租,超卖(kvm)16G,kvm,64G(ksm),⾦牌⽤户(200w+/⽉)3:云计算有哪些功能?虚拟机的管理平台(计费)kvm:1000宿主机(agent),虚拟出2w虚拟机,虚拟机的详细情况:硬件资源,ip情况统计?虚拟机管理平台:每台虚拟机的管理,都⽤数据库来统计4:云计算的服务类型IAAS 基础设施即服务 ECS云主机⾃⼰部署环境,⾃⼰管理代码和数据infrastructure as an servicePAAS(docker) 平台即服务提供软件的运⾏环境,java ,python,go, c#,nodejs ⾃⼰管理代码和数据platfrom as an serviceSAAS 软件即服务企业邮箱,cdn,rdssoftware as an serviceopenstack实现的是云计算IAAS,开源的云计算平台,apache 2.0,阿⾥云(飞天云平台)2.openstack (soa架构)云平台(keystone认证服务,glance镜像服务,nova计算服务,neutron⽹络服务,cinder存储服务,horizon web界⾯)每个服务:数据库,消息队列,memcached缓存,时间同步⾸页/index.html秒杀/miaosha/index.html会员:/plus/index.html登录:/login/indexnginx+php +mysql(500张表)SOA(拆业务,把每⼀个功能都拆成⼀个独⽴的web服务,每⼀个独⽴的web服务,⾄少拥有⼀个集群)微服务架构:亿级⽤户开源的微服框架阿⾥开源的dubbospring boot⾃动化代码上线 Jenkins + gitlab ci⾃动化代码质量检查 sonarqube官⽹:openstack 版本A-Z 开头3.虚拟机规划controller:内存3G,cpu开启虚拟化,ip:10.0.0.11compute01:内存1G,cpu开启虚拟化(必开),ip:10.0.0.31host解析,[root@controller ~]# vim /etc/hosts127.0.0.1 localhost localhost.localdomain localhost4 localhost4.localdomain4::1 localhost localhost.localdomain localhost6 localhost6.localdomain610.0.0.11 controller10.0.0.31 computer1[root@controller ~]# scp -rp /etc/hosts 10.0.0.31 /etc/hosts4.配置yum源1.挂载光盘[root@computer1 ~]# mount /dev/cdrom /mntmount: /dev/sr0 is write-protected, mounting read-only[root@controller ~]# mount /dev/cdrom /mntmount: /dev/sr0 is write-protected, mounting read-only#查看(如果有内容代表挂载成功)[root@computer1 ~]# ll /mnttotal 686-rw-rw-r-- 1 root root 14 Nov 26 2018 CentOS_BuildTagdrwxr-xr-x 3 root root 2048 Nov 26 2018 EFI-rw-rw-r-- 1 root root 227 Aug 30 2017 EULA-rw-rw-r-- 1 root root 18009 Dec 10 2015 GPLdrwxr-xr-x 3 root root 2048 Nov 26 2018 imagesdrwxr-xr-x 2 root root 2048 Nov 26 2018 isolinuxdrwxr-xr-x 2 root root 2048 Nov 26 2018 LiveOSdrwxrwxr-x 2 root root 663552 Nov 26 2018 Packagesdrwxrwxr-x 2 root root 4096 Nov 26 2018 repodata-rw-rw-r-- 1 root root 1690 Dec 10 2015 RPM-GPG-KEY-CentOS-7-rw-rw-r-- 1 root root 1690 Dec 10 2015 RPM-GPG-KEY-CentOS-Testing-7-r--r--r-- 1 root root 2883 Nov 26 2018 TRANS.TBL[root@controller ~]# scp -rp openstack_rpm.tar.gz 10.0.0.31:/optrz 上传openstack_rpm.tar.gz到/opt,并解压⽣成repo配置⽂件root@controller opt]# vim/etc/yum.repos.d/local.repo[local]name=localbaseurl=file:///mntgpgcheck=0[openstack]name=openstackbaseurl=file:///opt/repogpgcheck=0root@controller opt]#echo 'mount /dev/cdrom /mnt' >>/etc/rc.localroot@controller opt]# chmod +x /etc/rc.d/rc.local[root@controller opt]# scp -rp /etc/yum.repos.d/local.repo 10.0.0.31:/etc/yum.repos.d/local.repo [root@computer1 opt]# vim /etc/yum.repos.d/local.repo[root@computer1 opt]# echo 'mount /dev/cdrom /mnt' >>/etc/rc.local[root@computer1 opt]# chmod +x /etc/rc.d/rc.local#注意:两台都要配2.安装基础服务在所有节点上执⾏:a:时间同步[root@controller opt]# yum install -y chrony[root@computer1 opt]# yum install -y chrony#编辑控制节点配置⽂件[root@controller opt]# vim /etc/chrony.conf1.将 server iburst 改成server iburst另三⾏删掉2.将 #allow 192.168.0.0/1改成allow 10.0.0.0/24#重启服务[root@controller opt]# vim /etc/chrony.confsystemctl restart chronyd#编辑计算节点[root@computer1 opt]# vim /etc/chrony.conf将 server iburst 改成server 10.0.0.11 iburst另三⾏删掉[root@computer1 opt]# systemctl restart chronyd5.安装openstack客户端和openstack-selinux1.在所有节点上执⾏[root@control ~]# yum install python-openstackclient openstack-selinux -y[root@computer1 ~]# yum install python-openstackclient openstack-selinux -y查看官⽅⽂档6.安装数据库以及安全初始化2.仅控制节点执⾏:[root@control ~]# yum install mariadb mariadb-server python2-PyMySQL -y在官⽅⽂档上有https:///mitaka/zh_CN/install-guide-obs/environment-sql-database.html3.创建并编辑 /etc/f.d/f[root@control ~]# cat /etc/f.d/f[mysqld]bind-address = 10.0.0.11 # 值为控制节点的管理⽹络IP地址以使得其它节点可以通过管理⽹络访问数据库default-storage-engine = innodb #默认存储引擎innodb_file_per_table #为每个表独⽴表空间⽂件max_connections = 4096 #最⼤连接数collation-server = utf8_general_ci # 默认字符集character-set-server = utf84.启动mariadb 并加⼊开机⾃启[root@control ~]# systemctl start mariadb[root@control ~]# systemctl enable mariadb5. 为了保证数据库服务的安全性,运⾏[root@control ~]# mysql_secure_installation ⼀定要执⾏要不然后⾯时间同步会有坑脚本。

云计算技术OpenStack云计算平台应用OpenStack安装

项目一 OpenStack安装云计算技术OpenStack云计算平台能力CAPACITY 要求了解云计算的概念、架构和模式,以及主流的云计算平台了解OpenStack项目,调查OpenStack的应用情况理解OpenStack的架构,了解OpenStack的物理部署了解OpenStack部署工具,掌握OpenStack的快捷安装方法内容导航CONTENTS任务一了解云计算任务二了解OpenStack项目任务三理解OpenStack架构任务四部署与安装OpenStack任务说明01OPTION02OPTION03OPTION了解OpenStack部署拓扑了解OpenStack部署工具准备OpenStack安装环境04OPTION使用Packstack安装器安装OpenStack知识引入•什么是虚拟化•虚拟化是云计算的基础。

•虚拟化是指计算元件在虚拟的而不是真实的硬件基础上运行。

•虚拟化将物理资源转变为具有可管理性的逻辑资源,以消除物理结构之间的隔离,将物理资源融为一个整体。

虚拟化是一种简化管理和优化资源的解决方案。

知识引入•什么是云计算•云(Cloud)是网络、互联网的一种比喻说法。

•云计算是提供虚拟化资源的模式。

•云计算提供的是IT资源租用服务。

•云计算是IT系统架构不断发展的产物。

知识引入•云计算架构知识引入云计算部署模式公有云(Public Cloud)私有云(Private Cloud )混合云(Hybrid Cloud )知识引入•裸金属云•裸金属云(Bare Metal Cloud)是一种提供物理服务器服务的云产品。

•裸金属云没有虚拟机管理程序(Hypervisor)。

•裸金属云支持的处理器ØIntelØPOWERØARMØGPUØFPGA•随着容器技术的兴起,物理服务器正成为更多用户的选择。

•Amazon 公司的AWS(Amazon Web Services )•Microsoft 公司的Azure •阿里云(AliCloud )了解商用云计算平台任务实现11项目一 OpenStack安装任务一 了解云计算开源云计算平台OpenStack OpenNebula Eucalyptus CloudStack任务实现项目一 OpenStack安装12 内容导航CONTENTS任务一了解云计算任务二了解OpenStack项目任务三理解OpenStack架构任务四部署与安装OpenStack任务说明01OPTION 02OPTION 03OPTION 了解OpenStack的概念了解OpenStack项目的组成了解OpenStack版本演变04OPTION 了解OpenStack基金会与社区05OPTION 调查OpenStack的应用情况知识引入•什么是OpenStack•OpenStack是一系列开源软件项目的组合。

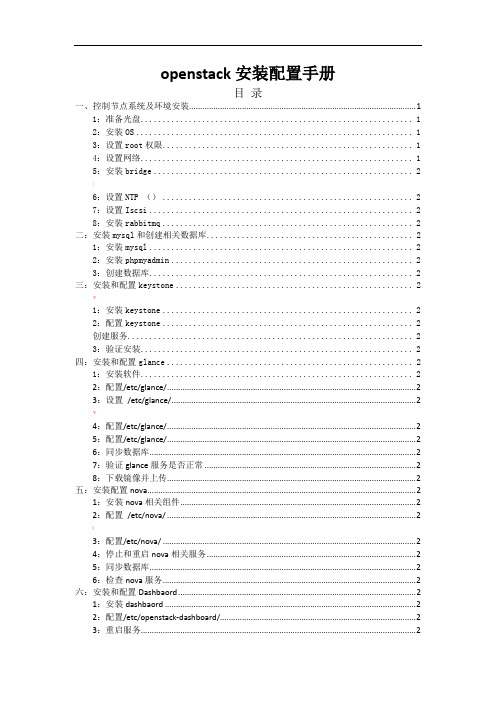

openstack安装配置文档

openstack(kilo版)安装配置文档写在前面:本文档所有指令在拷贝的时候注意空格和换行,由于文档的排版原因可能会出现自动换行等误差。

一、实验环境物理机器上的3台虚拟机分别模拟控制节点、网络节点、计算节点。

采用VMware虚拟机管理软件,首先建立一个模板,在上面安装第五部分所涉及到的基本组件,分别克隆出3台虚拟机作为控制、网络、计算节点。

虚拟机操作系统为Ubuntu 14.04.3,openstack版本为kilo版。

所需各部分组件均采用apt-get自动安装。

二、openstack的两种常用上网方式1、在官方文档的三个网卡基础上,我们使用第四个网卡上网(NAT 方式或桥接方式均可)。

另外三个网卡采用host-only方式。

2、使用管理网络上网。

本文采用第二种方式对网络进行配置,即将管理网络根据自己的网络环境配置成可上网的IP地址段(NAT和host-only均可)。

由于对第一种方式进行尝试时最终会遇到ping不通外网的情况,所以不建议尝试。

具体可见/thread-13508-1-1.html三、各节点的网络配置各节点建立好以后,根据openstack-install-guide-apt-kilo官方文档对各节点进行网络配置。

本例采用OpenStack Networking (neutron)方式进行网络配置。

使用OpenStack网络(neutron)的架构样例中,需要一个控制节点、一个网络节点以及至少一个计算节点。

控制节点包含一个在管理网络上的网络接口。

网络节点在包含一个在管理网络上的网络接口,一个在实例隧道网络上的网络接口和一个在外部网络上的网络接口。

计算节点包含一个在管理网络上的网络接口和一个在实例隧道网络上的接口。

所以此时需要在虚拟机管理界面添加虚拟网络,由于采用第二部分提到的第二种方式(即管理网络上网),所以网络分配如下:◆管理网络使用 192.168.109.0/24 带有网关 192.168.109.2◆实例隧道网络使用 10.0.1.0/24 无网关◆外部通道网络使用192.168.109.0/24 带有网关192.168.109.2首先需要配置管理网络采用NAT方式上网:VMware默认VMnet8为NAT模式,打开系统的网络适配器设置,可以看到VMnet8的网络配置信息,如下图:这个ip地址,因个人而异,也就是说不同网络,不同环境,这个ip变化的概率是很大的。

linux云计算Openstack创建虚拟机步骤2(nova组件控制节点和计算节点)

linux云计算Openstack创建虚拟机步骤2(nova组件控制节点和计算节点)Nova服务组件介绍1.Nova服务部署⼯作流程nova 计算服务(经典)⼀套控制器openstack 框架nova- api: 接收处理外界实例相关请求(创建实例) (os cpu⽹络等配置 )把实例元数据写到nova数据库请求放到消息队列(消息队列实现异步通信 )nova-scheduler: 调度-- 选择最合适的计算节点来创建实例nova- compute: 创建实例(具体⼲活) -- hypervisor来管理⼀ drivernova-conductor: 对接nova数据库 computer通过消息队列连接到数据库openstack 分布式nova 分层各司其职公司2.⼯作流程 6步简单来说1.⽤户发起请求2.Apl请求发送消息队列进⾏调度scheduler(Apl接受请求,写到数据库中)3.调度结果放到队列中分配到主机上的任务分配到哪台机器哪台机器取这个调度结果消息4.消息队列通过conductor从数据库中取消息5.取完之后将信息通过消息队列发送到computer主机上1.客户(可以是OpenStack最终⽤户,也可以是其他程序)向API(nova-api)发送请求:“帮我创建⼀个虚机”;2.API对请求做⼀些必要处理后,向Messaging(RabbitMQ)发送了⼀条消息:“让Scheduler创建⼀个虚机”;3.Scheduler(nova-scheduler)从Messaging获取到API发给它的消息,然后执⾏调度算法,从若⼲计算节点中选出节点 A ;4.Scheduler向Messaging发送了⼀条消息:“在计算节点 A 上创建这个虚机”5.计算节点 A 的Compute(nova-compute)从Messaging中获取到Scheduler发给它的消息,然后在本节点的Hypervisor上启动虚机;6.在虚机创建的过程中,Compute如果需要查询或更新数据库信息,会通过Messaging向Conductor(nova-conductor)发送消息,Conductor负责数据库访问。

openstack安装配置详细手册(单节点)

openstack安装配置手册目录一、控制节点系统及环境安装 (1)1:准备光盘 (1)2:安装OS (1)3:设置root权限 (1)4:设置网络 (1)5:安装bridge (2);6:设置NTP () (2)7:设置Iscsi (2)8:安装rabbitmq (2)二:安装mysql和创建相关数据库 (2)1:安装mysql (2)2:安装phpmyadmin (2)3:创建数据库 (2)三:安装和配置keystone (2)¥1:安装keystone (2)2:配置keystone (2)创建服务 (2)3:验证安装 (2)四:安装和配置glance (2)1:安装软件 (2)2:配置/etc/glance/ (2)3:设置/etc/glance/ (2)¥4:配置/etc/glance/ (2)5:配置/etc/glance/ (2)6:同步数据库 (2)7:验证glance服务是否正常 (2)8:下载镜像并上传 (2)五:安装配置nova (2)1:安装nova相关组件 (2)2:配置/etc/nova/ (2)(3:配置/etc/nova/ (2)4:停止和重启nova相关服务 (2)5:同步数据库 (2)6:检查nova服务 (2)六:安装和配置Dashbaord (2)1:安装dashbaord (2)2:配置/etc/openstack-dashboard/ (2)3:重启服务 (2)]Appendix A: 使用nova-volume (2)Appendix B: glance使用swift存储镜像 (2)Appendix C: 多计算节点配置 (2)一、控制节点系统及环境安装1:准备光盘:安装OS服务器是两块硬盘,将一个单独的分区专门给nova-volume使用(nova-volume一般不用)。

系统最小化安装,只需要安装ssh server就可以。

装完系统后。

apt-get updateapt-get upgrade更新源里的包,更新系统。

OpenStack安装手册

OpenStack安装手册目录OpenStack安装手册 (1)一、安装环境 (4)1、示例架构 (4)2、网络 (4)3、安全 (5)4、主机网络配置 (5)5、NTP (7)6、安装OpenStack包 (9)7、安装数据库 (10)8、消息队列 (11)9、缓存令牌 (12)二、认证服务 (12)在控制节点上配置。

(13)1、前提条件 (13)配置Apache服务器 (15)3、创建一个域、项目、用户和角色 (16)4、验证操作 (17)1、前提条件 (20)2、安装并配置组件 (22)5、验证操作 (24)四、计算服务 (25)1、安装和配置控制节点 (25)∙安装并配置组件 (26)∙完成安装 (30)3、安装并配置计算节点 (30)∙安装并配置组件 (30)∙验证操作 (33)一、安装环境1、示例架构根据官方文档,本文架构采用一个控制节点和一个计算节点。

(The example architecture requires at least twonodes (hosts) to launch a basic virtual machine or instance. )控制节点运行认证服务、镜像服务、计算服务的管理部分、网络服务的管理部分、各种网络代理以及Dashboard,还包括一些基础服务如数据库、消息队列以及NTP。

计算节点上运行计算服务中管理实例的管理程序部分。

默认情况下,计算服务使用KVM。

还运行网络代理服务,用来连接实例和虚拟网络以及通过安全组给实例提供防火墙服务。

2、网络∙公有网络公有网络选项以尽可能简单的方式通过layer-2(网桥/交换机)服务以及VLAN网络的分割来部署OpenStack网络服务。

实际上,它将虚拟网络桥接到物理网络,并依靠物理网络基础设施提供layer-3服务(路由)。

另外,DHCP服务为实例提供IP地址。

∙私有网络私有网络选项扩展了公有网络选项,增加了layer-3(路由)服务,使用VXLAN类似的方式。

openstack安装手册(半中文版)

翻译说明:由于名词和软件指令、脚本容易混淆,,导致无法与实际安装配置环境对应,本文会尽量不去翻译这些内容。

实际上,直接看原文,至少对照原文学习和操作,会避免很多因翻译产生的问题。

光头猪猪1.OpenStack基本安装简介如果你想利用Ubuntu 12.04 LTS (使用 Ubuntu Cloud Archive)来部署OpenStack Folsom平台用于开发测试,本文会为你提供帮助。

我们将完成一套三节点的安装,包括一个控制器、一个网络节点和一个计算节点。

当然,你也可以按你的需要安装尽可能多的计算节点。

对于希望安装测试基础平台的OpenStack初学者,本文会成为一个良好的开始。

Architecture一个标准的Quantum安装包括多达四个物理上分离的数据中心网络:• 管理网络。

用于OpenStack组件之间的内部通信。

在此网络上的IP地址应仅在数据中心内部可达。

• 数据网络。

用于所部署的云内部的虚拟机数据通信。

该网络的IP地址分配需求取决于使用中的Quan tum 插件。

• 外部网络。

用在某些部署方案中提供可访问Internet的虚拟机。

此网络上的IP地址应对Internet上的任何人都可达。

• API网络。

向租户公开所有OpenStack Api,包括Quantum API。

此网络上的IP地址应对Internet上的任何人都可达。

本网络可能和外部网络是同一个网络,因为你可以划分整个IP地址分配范围的一部分在外部网络建立一个Quantum子网。

必要条件您需要至少3台装好Ubuntu 12.04 (LTS)的计算机(虚拟或物理)。

表1.1结构和节点信息控制器节点简介控制器节点将提供:• Databases (with MySQL)• Queues (with RabbitMQ)• Keystone• Glance• Nova (without nova-compute)• Cinder• Quantum Server (with Open-vSwitch plugin)• Dashboard (with Horizon)公共服务操作系统1.使用此参数安装Ubuntu:• Time zone :UTC• Hostname :folsom-controller• Packages :OpenSSH-Server操作系统安装完成后,重新启动服务器。

openstack创建虚拟机的流程

openstack创建虚拟机的流程

OpenStack是一种开源的云计算平台,它可以帮助用户快速创建和管理虚拟机。

下面是使用OpenStack创建虚拟机的流程:

1. 登录OpenStack控制台

需要使用管理员账号登录OpenStack控制台。

在控制台中,可以看到所有的云计算资源,包括虚拟机、存储和网络等。

2. 创建虚拟机

在控制台中,选择“虚拟机”选项卡,然后点击“创建虚拟机”按钮。

在弹出的窗口中,需要填写虚拟机的名称、镜像、规格和网络等信息。

其中,镜像是虚拟机的操作系统,规格是虚拟机的CPU、内存和磁盘等配置。

3. 配置虚拟机

创建虚拟机后,需要对其进行配置。

在控制台中,选择“虚拟机”选项卡,然后点击虚拟机的名称。

在虚拟机的详情页面中,可以对虚拟机进行操作,如修改配置、启动和停止虚拟机等。

4. 访问虚拟机

创建虚拟机后,可以通过SSH或VNC等方式访问虚拟机。

在控制

台中,选择“虚拟机”选项卡,然后点击虚拟机的名称。

在虚拟机的详情页面中,可以看到虚拟机的IP地址和登录方式。

根据需要,选择合适的方式访问虚拟机。

5. 删除虚拟机

当虚拟机不再需要时,可以在控制台中删除虚拟机。

在控制台中,选择“虚拟机”选项卡,然后选择要删除的虚拟机。

在虚拟机的详情页面中,点击“删除虚拟机”按钮,然后确认删除操作。

总结

使用OpenStack创建虚拟机的流程包括登录控制台、创建虚拟机、配置虚拟机、访问虚拟机和删除虚拟机等步骤。

通过这些步骤,用户可以快速创建和管理虚拟机,实现云计算的应用。

OpenStack安装指南

11 添加遥测模块目录遥测模块 121安装和配置控制节点 122配置计算服务 125配置镜像服务 127配置块儿存储服务 127配置对象存储服务 128遥测安装的检测 129下一步 130遥测提供了一个监控和计量OpenStack的一个框架,这也被称为测云仪项目。

遥测模块遥测模块可以实现如下的功能:有效地调整与OpenStack服务相关的测量数据。

收集监控通知发送事件和计量数据的服务。

将收集到的数据发送到不同的数据存储块儿和消息队列中。

在收集中断定义规则的数据时创建警报。

这个遥测模块包含以下组件:计算代理(测云仪-代理-计算)运行在每个计算节点上,对这些节点的利用情况进行调查。

在将来可能有其他类型的代理,现在的重点是创建计算代理。

中心代理(测云仪中枢代理)运行在一个中枢管理服务器上,并对资源利用进行调查统计,这里的资源不把实例或计算节点绑定在一起。

多个代理可以开始规模服务水平。

通知代理(测云仪的通知代理)运行在一个中枢管理服务器上,从消息队列中得到消息,从而来构建事件和计量数据。

收集者(测云仪收集者)运行在一个中枢管理服务器上,分派收集遥测数据到数据仓储里面或者对外部消费者的数据不做修改。

报警评估(测云仪的报警评估)运行在一个或多个中枢管理服务器上决定那些火灾警报,这里的火灾警报是因为在一个滑动的时间窗口上跨越了一个阙值所做出的相关统计。

警报通知(测云仪警报通知)运行在一个或多个中枢管理服务器上并允许警报设置基于阈值评估样本的集合。

API服务器(测云仪的API)运行在一个或多个中央管理服务器上,并提供访问数据存储的数据。

这些服务通过使用OpenStack消息总线进行通信。

只有收集器和API 服务器访问数据存储。

安装和配置控制器节点本节描述了在控制器节点上如何安装和配置遥测模块、测云仪的代号。

这个遥测模块使用独立的代理从你环境的每一个OpenStack中收集测量值。

配置的先决条件在你安装和配置遥测模块之前,你必须先安装MongoDB,创建一个MongoDB数据库、服务凭证和API端点。

FusionSphere-OpenStack部署配置指南

AZ间不允许共享,每套blockstorage-driver对接一套存储,默认部署 一套blockstorage-driver 使用FusionStorage分布式存储服务时需要部署,默认每个节点都部 署

AZ间不允许共享,每个AZ都需要部署swift,默认部署3个实例

OpenStack部署方案2 - 3Controller

Sys-server controller

auth zookeeper

image router measure database Sys-client compute Blockstorag e driver

FM VM

baremetal rabbitMQ

在WEB UI的配置界面选择配置网络

配置物理网络

系统默认创建一个物理网络,系统平面默认承载在该物理网络上,用户 可根据实际情况新增物理网络

第22页

配置物理网络 (2/3)

配置物理网络和网口的映射关系

第23页

配置物理网络(3/3)

配置系统平面和物理网络的对应关系

external_api和external_om默认承载在默认的物理网络上,用户可 根据 实际情况调整:

第6页

角色介绍 (2/2)

database:提供OpenStack管理数据存储服务 mongodb:提供OpenStack采样数据存储服务 zookeeper:提供分布式集群服务 rabbitMQ:提供分布式通信服务 baremetal :提供裸机管理服务 loadbalancer:提供网络负载均衡能力 sys-client:提供配置代理和组件状态监控的能力

swift

host3

云计算平台的部署教程及注意事项

云计算平台的部署教程及注意事项云计算已成为现代IT领域中的一项重要技术,为企业提供了更高效、灵活和可靠的计算能力。

云计算平台的部署是实现云计算服务的关键步骤之一。

本文将介绍云计算平台的部署教程,并提供一些部署时需要注意的事项。

1. 准备工作在部署云计算平台之前,首先需要进行一些准备工作。

以下是一些准备工作的主要步骤:1.1 确定部署的目标和需求:确保明确所需的云计算平台的功能和规模,了解用户的需求,以便进行正确的部署。

1.2 选择适合的云计算平台:根据业务需求和技术要求,选择适合的云计算平台方案,如AWS、Azure、Google Cloud等。

1.3 确定硬件要求:根据所选平台的要求,确定所需的硬件配置,包括服务器、存储和网络设备。

1.4 准备软件环境:安装和配置所选云计算平台所需的操作系统、数据库和其他相关软件。

2. 部署云计算平台2.1 安装和配置服务器:根据硬件要求,安装和配置服务器。

确保服务器的性能和稳定性,以满足云计算平台的需求。

2.2 安装和配置操作系统:根据所选的云计算平台,安装并配置操作系统。

确保操作系统的稳定性和安全性。

2.3 安装和配置云计算平台软件:根据所选平台的要求,安装并配置云计算平台软件。

确保软件的正常运行,并进行必要的优化和调整。

2.4 配置网络和存储:根据云计算平台的需求,进行网络和存储的配置。

确保网络的稳定性和安全性,以及存储的可靠性和高性能。

3. 注意事项在部署云计算平台时,需要注意以下事项,以确保平台的正常运行和安全性:3.1 安全性:云计算平台通常处理大量敏感数据,因此必须确保平台的安全性。

采取必要的措施,如访问控制、防火墙和加密,以保护数据的机密性和完整性。

3.2 可扩展性:云计算平台通常需要处理大量的用户请求和数据流量。

因此,平台应具备良好的可扩展性,以便根据需要增加或减少计算和存储资源。

3.3 可用性:云计算平台应具备高可用性,以确保用户随时能够访问和使用平台。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Openstack虚拟化云计算平台详细安装流程报告1.写在前面的话Openstack到目前为止(201403),已经包含多个稳定版本(A-H),最新的稳定版本是Havana版,我们现在使用的实验版本也是havana版本。

由于openstack的版本相互之间差异比较大,组件的安装命令等也略有相同,所以在参考此文档时要注意区别openstack的版本。

Openstack的各个组件相互之间是通过网络来进行互联互通,不同的组件理论上都可以部署在不同的节点上,可以通过一些的额外的步骤来提高openstack的可用性。

基于我们的实验环境和现实情况,我们选择了官网推荐的最经典的安装方式,因此阅读此文档的读者在阅读文档时,注意我们使用的安装方式不是openstack的唯一安装方式。

2.Openstack架构2.1基础组件2.2组件对应关系3.基础配置1.硬件配置情况介绍:2.节点情况介绍:3.网络情况介绍:通过一台单独的交换机进行网络访问,因此网络中有大量可用的10.10.70.XX段地址,可以分配给不同的虚拟机。

实验环境的网络速度有限速,所以很多措施是节省网络代码,如果网络条件好,很多步骤可以省略或者替换。

4.相关密码统计所属机器用户名密码用户名密码说明Centos的用户密码root/rootpass Root用户的密码openstack/openstack Openstack的用户名密码mySQL数据库服务器Root/mysqlrootOpenstack服务密码Nova/novaKeystone/keystoneGlance/glanceCinder/cinderOpenstack数据库密码Nova/nova Keystone/keystone Glance/glance Cinder/cinder4.基本的操作系统配置在进行下面的所有操作时,必须要有root权限,如果root权限不好获取,可以通过sudo命令来获取。

重要提醒4.1基础网络设置1.将节点的IP设置成静态的IP地址。

修改文件:vi /etc/sysconfig/network-scripts/ifcfg-eth0需要注意的内容如下:DEVICE=eth0网卡的名称HWADDR=00:1E:67:24:E7:31 Mac地址的名称TYPE=Ethernet 网络类型UUID=c6ee6fd1-467b-4f36-bcdc-307bc678191bONBOOT=yes 这是随系统启动而启动的选项NM_CONTROLLED=no这是由系统的networkmanager来管理IP地址,设置为No BOOTPROTO=static 设置网卡获取IP地址方式有static,DHCP,bootp. 分别对应静态指定的ip地址,通过dhcp协议获得的ip地址,通过bootp协议获得的ip地址IPADDR=10.10.70.20如果设置网卡获得ip地址的方式为静态指定,此字段就指定了网卡对应的ip地址NETMASK=255.255.255.0子网掩码GATEWAY=10.10.70.211网关地址ARPCHECK=noDNS1=10.10.70.211设置完成之后,重启网络:service network restart重要提醒1.有些教程中说ifcfg-eth0中的配置网关的GATEWAY关键字是NETWORK,是不对的,实现发现如果设置错误,上不了外网。

2.ARPCHECK=no的作用是解决错误:网络重启报错:Bringing up interfaceeth0: Determining if ip address 10.10.70.20 is already in use for device eth0...2.设置节点的网关修改对应网卡的网关的配置文件vi /etc/sysconfig/network修改以下内容NETWORKING=yes(表示系统是否使用网络,一般设置为yes。

如果设为no,则不能使用网络,而且很多系统服务程序将无法启动)HOSTNAME=centos(设置本机的主机名,这里设置的主机名要和/etc/hosts中设置的主机名对应)GATEWAY=10.10.70.211(设置本机连接的网关的IP地址。

)设置完成之后,重启网络:service network restart3.设置节点的DNS修改对应网卡的DNS的配置文件vi /etc/resolv.conf修改一下内容:nameserver 10.10.70.211设置完成之后,重启网络:service network restart4.设置节点的主机名IP对应关系1、修改文件:vi /etc/sysconfig/network设置:HOSTNAME=centos2、修改文件:vi etc/hosts在以前的内容上增加:127.0.0.1 centos10.10.70.20 centos重要提醒设置节点的主机名和IP对应关系时要注意,每个节点都要配置此项,而且每个节点都要配置整个网络中其他节点的IP和主机名的对应关系。

这样做的目的是为了在整个网络中,可以通过主机名来访问其他的机器。

5.关闭节点的防火墙以及其他安全策略。

1. 重启网络运行以下命令service NetworkManager stopservice network startchkconfig NetworkManager offchkconfig network on2. 关闭防火墙service iptables stopchkconfig iptables offservice ip6tables stopchkconfig ip6tables off3. 关闭SELinuxsetenforce 0vi etc/sysconfig/selinux修改SELINUX=permissive重要提醒4.2时间同步服务器设置因为是单节点所以可以省略掉4.3MySQL数据库设置1.节点安装步骤:●运行以下命令,安装mysql服务器和客户端yum install -y mysql mysql-server MySQL-python●启动MySQL服务service mysqld startchkconfig mysqld on初始化MYSQL数据库mysql_install_dbmysql_secure_installation重要提醒初始化MYSQL数据库的目的是为了删除mysql自带的测试数据库以及为mysql的root用户增加密码:实验环境的密码为:mysqlroot4.4Openstack基础包下载设置在各个节点中,按照以下步骤安装:yum install -yyum install -yyum install openstack-utils -yyum install openstack-selinux -yyum upgrade -yreboot重要提醒5.5消息服务器设置在节点进行消息服务器的安装工作:1.安装消息服务器yum install qpid-cpp-server memcached -y2. 修改/etc/qpidd.conf文件,将auth的选项设置no,来禁用qpidd的认证。

auth=no3.启动消息服务器,并设置为自动启动。

service qpidd startchkconfig qpidd on5.配置用户权限服务Idenitity Service5.1用户权限服务的基本概念用户权限服务主要包含两个功能:●用户管理:管理用户以及用户的权限。

●服务目录:通过服务终端提供相应的服务目录。

主要涉及的名词有:●用户(user):用户指的是使用openstack云服务的使用者,用户具有登录和使用资源的权限,用户隶属于租户。

●证书(Credentials):有且只有用户自己知道的一组数据,比如:密码,认证令牌等等●认证(Authentication):确定一个用户身份的动作。

●令牌(token):组用来访问资源的随机数字,令牌中包含了访问资源的范围和权限等等。

●租户(tenant):租户可以被理解为一个项目,团队或组织。

你必须指定一个相应的租户(tenant)才可以申请OpenStack服务●服务(Service):openstack的组件表现形式,提供了一个或者多个终端,用户可以通过访问终端来资源。

●终端(Endpoint):通过网络访问服务的一种方式,通常是URL地址等。

●角色(Role):角色代表特定的租户中的用户操作权限5.2安装和配置用户权限服务在节点中完成以下操作:1.在节点中安装keystone服务包yum install openstack-keystone python-keystoneclient -y2.用户权限服务通过数据库来存储基本信息。

因此需要在数据库中修改数据库的位置,本实验中使用了mysql数据,通过以下命令来修改数据库配置信息。

openstack-config --set /etc/keystone/keystone.conf sql connectionmysql://keystone:keystone@centos/keystone3.通过openstack-db 命令来初始化数据库表,同时创建相应的数据库和用户。

openstack-db --init --service keystone --password keystone4.使用openssl来生成认证令牌,用来使用用户权限服务和openstack的其他服务之间共享数据。

ADMIN_TOKEN=$(openssl rand -hex 10)echo $ADMIN_TOKENopenstack-config --set /etc/keystone/keystone.conf DEFAULT admin_token $ADMIN_TOKEN重要提醒这个步骤里生成ADMIN_TOKEN,后面需要频繁的使用到,所以此时要记录下来。

5.KeyStone使用了PKI令牌,执行下面的名来安装关键字和证书。

keystone-manage pki_setup --keystone-user keystone --keystone-group keystone chown -R keystone:keystone /etc/keystone/* /var/log/keystone/keystone.log 6.启动keystone的服务并设置为开机自启动。

service openstack-keystone start&&chkconfig openstack-keystone on5.3定义用户,租户,角色等安装完用户权限服务之后,可以增加相应的角色,租户,用户等。