Cache优化的并发无锁队列

高性能队列技术Disruptor及其应用

目录

01 Disruptor: 高性能队列技术 02 Java中的加锁与原子变量 03 伪共享 04 Disruptor的设计方案

1

Disruptor: 高性能队列技术

Disruptor简介

1. Disruptor是由英国外汇交易公司LMAX开发的一款高性能队列。 2. Disruptor的主要目的是解决内存队列的延迟问题。 3. 基于Disruptor开发的系统单线程能支撑每秒600万订单。 4. Disruptor曾在2011年获得Oracle官方的Duke大奖。

通过比较Disruptor和ArrayBlockingQueue的吞吐量,展示了在并发竞争激烈程度不同下的性能差异 。

延迟测试结果

按照Pipeline: 1P – 3C的连接模式测试延迟,生产者两次写入之间的延迟为1ms,展示了不同环境 下的延迟情况。

感谢

原子变量与CAS实现线程安全

1. 原子变量:确保数据在多线程环境下的唯一性和完整性。 2. CAS(Compare-And-Swap):一种基于硬件原子操作的同步原语。 3. 线程安全:提高程序在多线程并发访问时的正确性和效率。

原子变量的工作原理

1. 原子变量:基本数据单位,不可再分。 2. 工作原理:基于量子力学,遵循海森堡不确定性原理。 3. 波动性:原子变量的状态呈波状分布。 4. 测量问题:测量原子变量值具有一定的随机性,影响量子态的确定。

Disruptor架构

1. Disruptor采用了一种独特的内存队列技术来解决延迟问题。 2. Disruptor的架构设计简单而高效,基于C++编写。 3. Disruptor将队列操作和处理器调度分离,实现了高内聚性和可扩展性。 4. Disruptor支持多种队列类型,可以灵活应对不同需求。 5. Disruptor使用了事件驱动的方式来实现多线程协作。

cache命中率例题

cache命中率例题缓存命中率是指在缓存系统中请求的对象在缓存中已经存在的概率。

当请求的对象在缓存中存在时,就可以直接从缓存中取出数据,而无需访问主存或者远程服务器,从而加快了数据的获取速度。

缓存命中率可以影响系统的性能和用户体验。

高命中率可以减少对底层存储系统的访问,节省了网络带宽,减少了延迟,提高了系统的响应速度。

另一方面,低命中率意味着大量的请求需要从主存或者远程服务器中获取数据,增加了网络带宽的占用和延迟,导致系统的响应速度变慢,影响用户体验。

要提高缓存命中率,需要从以下几个方面进行考虑和优化:1. 缓存策略选择:- 最常见的缓存策略是LRU(Least Recently Used),即最近最少使用。

这种策略会将最长时间未被访问的数据从缓存中淘汰,从而给新的数据腾出空间。

其他常见的策略还包括LFU(Least Frequently Used),即最不经常使用,以及FIFO(First In, First Out),即先进先出。

选择适合应用场景的缓存策略可以提高命中率。

- 可以考虑使用一些高级的缓存策略,如热点缓存、分布式缓存等。

热点缓存指的是将热点数据放入缓存中,以应对高频访问的情况。

分布式缓存可以将缓存数据分散存储在多个节点上,提高缓存容量和并发能力。

2. 缓存预热:- 在系统启动或者重启时,可以提前加载一些常用的数据到缓存中,以提高命中率。

可以通过定时任务或预热接口来实现。

3. 缓存更新策略:- 当缓存中的数据被更新时,需要及时将新数据写入缓存中,以确保缓存中的数据和底层存储的数据一致。

可以采用主动更新策略,即在数据更新时直接更新缓存;或者采用延迟更新策略,即等到下次访问时再更新缓存。

4. 缓存容量评估:- 针对不同的应用场景,需要评估缓存的容量。

容量太小会导致频繁的缓存淘汰和缓存失效,从而降低命中率;容量太大则会浪费内存资源。

可以通过监控缓存的使用情况,分析数据的访问模式来确定合适的缓存容量。

基于DPDK和LX2160A的高效数据包捕获方法研究与应用

数据库技术Database Technology电子技术与软件工程Electronic Technology&Software Engineering 基于DPDK和LX2160A的高效数据包捕获方法研究与应用杨勇(中兴通讯股份有限公司广东省深圳市518057)摘要:本文先是研究了数据平面开发套件(DPDK⑴,Data Plane Development Kit)的技术特点和价值,以及恩智浦LX2160A芯片DPAA2(Data Path Acceleration Architecture,Second Generat ion)的结构和应用方法;接着重点介绍基于DPDK和LX2160A的高性能数据包捕获应用方案以及测试方案;然后分析数据包捕茯测试结果,表明基于DPDK和LX2160A的网络设备整体系统性能提高显著。

关键词:数据平面开发套件;数据包捕获;DPAA2;5G1概述随着5G通信网络基础设施规模部署,大流量、高速率、低延时等特点的业务将会日渐上线。

为了承载更多5G业务流量和用户需求,通信运营服务商对通信网络设备提岀了更严格的要求,即要求支持高可用、髙带宽、海量连接数、低时延等特点。

另外在聚焦5G技术的优化设计时,要注重资源利用率、吞吐率等的提升与研究,逐渐转变传统的设计理念团。

面对高带宽数据处理需求,这些设备的CPU须具备高效数据包捕获处理能力。

数据平面开发套件DPDK,区别于Linux操作系统通用性设计目标,DPDK致力于提供快速数据包处理的函数库与用户态网卡等驱动集合,聚焦于网络应用数据包的高性能捕获处理。

恩智浦LX2160A多核CPU处理器是Layerscape系列中性能最高的成员,尤其适合于极具挑战性的高性能网络应用。

本文主要研究基于DPDK和LX2160A的数据包捕获应用方案。

本文先是通过仔细研究DPDK的技术特点和价值。

接着详细介绍了LX2160A芯片技术特征,用于高效数据包捕获的数据通道加速架构及其关键组成部件和DPAA2虚拟对象概念,还有在具体实践应用时需使用的接口文件。

互联网架构的演变过程(一)

互联⽹架构的演变过程(⼀)简介web1.0时代web2.0时代互联⽹时代互联⽹+ --》智慧城市。

2012年提出。

云计算+⼤数据时代背景随着互联⽹的发展,⽹站应⽤的规模不断扩⼤,常规的垂直应⽤架构已⽆法应对,分布式服务架构以及流动计算架构势在必⾏,亟需⼀个治理系统确保架构有条不紊的演进。

1、第⼀时期单⼀应⽤架构all in one(所有的模块在⼀起,技术也不分层)⽹站的初期,也认为互联⽹发展的最早时期。

会在单机部署上所有的应⽤程序和软件。

所有的代码都是写在JSP⾥⾯,所有的代码都写在⼀起。

这种⽅式称为all in one。

特点:1、不具备代码的可维护性。

2、容错性差。

因为我们所有的代码都写在JSP页⾥。

当⽤户或某些原因发⽣异常。

(1、⽤户直接看到异常错误信息。

2、这个错误会导致服务器宕机)容错性,是指软件检测应⽤程序所运⾏的软件或硬件中发⽣的错误并从错误中恢复的能⼒,通常可以从系统的可靠性、可⽤性、可测性等⼏个⽅⾯来衡量。

单体地狱。

:只需⼀个应⽤,将所有功能都部署在⼀起,以减少部署节点和成本。

2 第⼀时期后阶段解决⽅案:1、分层开发(提⾼维护性)【解决容错性】2、MVC架构(Web应⽤程序的设计模式)3、服务器的分离部署特点:1、MVC分层开发(解决容错性问题)2、数据库和项⽬部署分离问题:随着⽤户的访问量持续增加,单台应⽤服务器已经⽆法满⾜需求。

解决⽅案:集群。

3 可能会产⽣的⼏个问题:1.1. ⾼可⽤“⾼可⽤性”(High Availability)通常来描述⼀个系统经过专门的设计,从⽽减少停⼯时间,⽽保持其服务的⾼度可⽤性。

(⼀直都能⽤)1.2. ⾼并发⾼并发(High Concurrency)是互联⽹分布式系统架构设计中必须考虑的因素之⼀,它通常是指,通过设计保证系统能够同时并⾏处理很多请求。

⾼并发相关常⽤的⼀些指标有响应时间(Response Time),吞吐量(Throughput),每秒查询率QPS(Query Per Second),并发⽤户数等。

EhCache缓存系统的使用

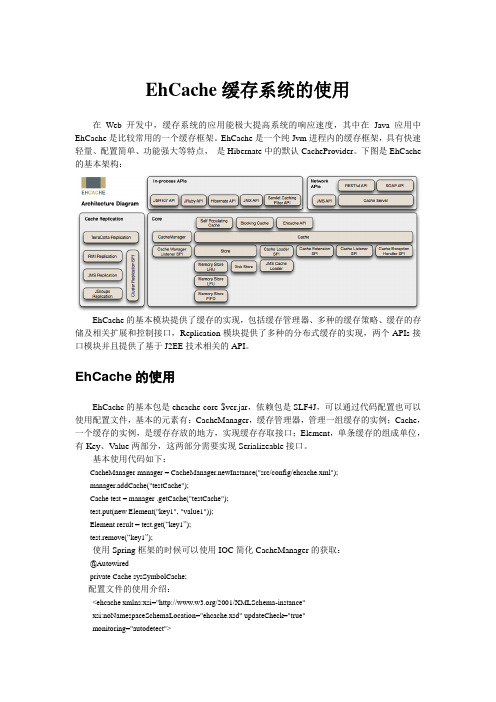

EhCache缓存系统的使用在Web开发中,缓存系统的应用能极大提高系统的响应速度,其中在Java应用中EhCache是比较常用的一个缓存框架。

EhCache是一个纯Jvm进程内的缓存框架,具有快速轻量、配置简单、功能强大等特点,是Hibernate中的默认CacheProvider。

下图是EhCache 的基本架构:EhCache的基本模块提供了缓存的实现,包括缓存管理器、多种的缓存策略、缓存的存储及相关扩展和控制接口,Replication模块提供了多种的分布式缓存的实现,两个APIs接口模块并且提供了基于J2EE技术相关的API。

EhCache的使用EhCache的基本包是ehcache-core-$ver.jar,依赖包是SLF4J,可以通过代码配置也可以使用配置文件,基本的元素有:CacheManager,缓存管理器,管理一组缓存的实例;Cache,一个缓存的实例,是缓存存放的地方,实现缓存存取接口;Element,单条缓存的组成单位,有Key、Value两部分,这两部分需要实现Serializeable接口。

基本使用代码如下:CacheManager manager = CacheManager.newInstance("src/config/ehcache.xml");manager.addCache("testCache");Cache test = manager .getCache("testCache");test.put(new Element("key1", "value1"));Element result = test.get(“key1”);test.remove(“key1”);使用Spring框架的时候可以使用IOC简化CacheManager的获取:@Autowiredprivate Cache sysSymbolCache;配置文件的使用介绍:<ehcache xmlns:xsi="/2001/XMLSchema-instance"xsi:noNamespaceSchemaLocation="ehcache.xsd" updateCheck="true"monitoring="autodetect"><diskStore path="atoscache" /><defaultCache maxElementsInMemory="100000" eternal="false"timeToIdleSeconds="300" timeToLiveSeconds="720000" overflowToDisk="true"memoryStoreEvictionPolicy="LRU" /><cache name="sysSymbolCache" maxElementsInMemory="200000"eternal="false" overflowToDisk="true" diskPersistent="true" timeToIdleSeconds="216000"timeToLiveSeconds="720000"memoryStoreEvictionPolicy="LFU"></cache></ehcache>diskStore代表存储的目录名,默认是java.io.tmpdir,defaultCache是默认的Cache配置。

Redis优化高并发下的秒杀性能

Redis优化⾼并发下的秒杀性能本⽂内容使⽤Redis优化⾼并发场景下的接⼝性能数据库乐观锁前提活动规则奖品数量有限,⽐如100个不限制参与⽤户数每个⽤户只能参与1次秒杀活动要求不能多发,也不能少发,100个奖品要全部发出去1个⽤户最多抢1个奖品遵循先到先得原则,先来的⽤户有奖品数据库实现悲观锁性能太差,本⽂不予讨论,讨论⼀下使⽤乐观锁解决⾼并发问题的优缺点。

数据库结构ID Code UserId CreatedAt RewardAt奖品ID奖品码⽤户ID创建时间中奖时间未中奖时UserId为0,RewardAt为NULL中奖时UserId为中奖⽤户ID,RewardAt为中奖时间乐观锁实现乐观锁实际上并不存在真正的锁,乐观锁是利⽤数据的某个字段来做的,⽐如本⽂的例⼦就是以UserId来实现的。

实现流程如下:1. 查询UserId为0的奖品,如果未找到则提⽰⽆奖品SELECT * FROM envelope WHERE user_id=0 LIMIT 12. 更新奖品的⽤户ID和中奖时间(假设奖品ID为1,中奖⽤户ID为100,当前时间为2019-10-29 12:00:00),这⾥的user_id=0就是我们的乐观锁了。

UPDATE envelope SET user_id=100, reward_at='2019-10-29 12:00:00' WHERE user_id=0 AND id=13. 检测UPDATE语句的执⾏返回值,如果返回1证明中奖成功,否则证明该奖品被其他⼈抢了为什么要添加乐观锁正常情况下获取奖品、然后把奖品更新给指定⽤户是没问题的。

如果不添加user_id=0时,⾼并发场景下会出现下⾯的问题:1. 两个⽤户同时查询到了1个未中奖的奖品(发⽣并发问题)2. 将奖品的中奖⽤户更新为⽤户1,更新条件只有ID=奖品ID3. 上述SQL执⾏是成功的,影响⾏数也是1,此时接⼝会返回⽤户1中奖4. 接下来将中奖⽤户更新为⽤户2,更新条件也只有ID=奖品ID5. 由于是同⼀个奖品,已经发给⽤户1的奖品会重新发放给⽤户2,此时影响⾏数为1,接⼝返回⽤户2也中奖6. 所以该奖品的最终结果是发放给⽤户27. ⽤户1就会过来投诉活动⽅了,因为抽奖接⼝返回⽤户1中奖,但他的奖品被抢了,此时活动⽅只能赔钱了添加乐观锁之后的抽奖流程1. 更新⽤户1时的条件为id=红包ID AND user_id=0 ,由于此时红包未分配给任何⼈,⽤户1更新成功,接⼝返回⽤户1中奖2. 当更新⽤户2时更新条件为id=红包ID AND user_id=0,由于此时该红包已经分配给⽤户1了,所以该条件不会更新任何记录,接⼝返回⽤户2中奖乐观锁优缺点优点性能尚可,因为⽆锁不会超发缺点通常不满⾜“先到先得”的活动规则,⼀旦发⽣并发,就会发⽣未中奖的情况,此时奖品库还有奖品压测在MacBook Pro 2018上的压测表现如下(Golang实现的HTTP服务器,MySQL连接池⼤⼩100,Jmeter压测):500并发 500总请求数平均响应时间331ms 发放成功数为31 吞吐量458.7/sRedis实现可以看到乐观锁的实现下争抢⽐太⾼,不是推荐的实现⽅法,下⾯通过Redis来优化这个秒杀业务。

java高并发:CAS无锁原理及广泛应用

java高并发:CAS无锁原理及广泛应用前言在现在的互联网技术领域,用户流量越来越大,系统中并发量越来越大,大公司的日活动辄成百上千万。

如何面对如此高的并发是当今互联网技术圈一直在努力的事情。

应对高并发需要在各个技术层面进行合理的设计和技术选型才可以。

本文只讲述微观层面是如何应对多线程高并发的,介绍著名的CAS原理以及其广泛应用。

本文中jdk版本使用的是jdk1.7.0_55. 不同版本实现可能稍有差异.CAS无锁实现原理为什么要用CAS在多线程高并发编程的时候,最关键的问题就是保证临界区的对象的安全访问。

通常是用加锁来处理,其实加锁本质上是将并发转变为串行来实现的,势必会影响吞吐量。

而且线程的数量是有限的,依赖于操作系统,而且线程的创建和销毁带来的性能损耗是不可以忽略掉的。

虽然现在基本都是用线程池来尽可能的降低不断创建线程带来的性能损耗。

对于并发控制而言,锁是一种悲观策略,会阻塞线程执行。

而无锁是一种乐观策略,它会假设对资源的访问时没有冲突的,既然没有冲突就不需要等待,线程不需要阻塞。

那多个线程共同访问临界区的资源怎么办呢,无锁的策略采用一种比较交换技术CAS(compare and swap)来鉴别线程冲突,一旦检测到冲突,就充实当前操作指导没有冲突为止。

与锁相比,CAS会使得程序设计比较负责,但是由于其优越的性能优势,以及天生免疫死锁(根本就没有锁,当然就不会有线程一直阻塞了),更为重要的是,使用无锁的方式没有所竞争带来的开销,也没有线程间频繁调度带来的开销,他比基于锁的方式有更优越的性能,所以在目前被广泛应用,我们在程序设计时也可以适当的使用.不过由于CAS编码确实稍微复杂,而且jdk作者本身也不希望你直接使用unsafe(后面会讲到)来进行代码的编写,所以如果不能深刻理解CAS以及unsafe还是要慎用,使用一些别人已经实现好的无锁类或者框架就好了。

CAS原理分析CAS算法一个CAS方法包含三个参数CAS(V,E,N)。

java轻松实现无锁队列

java 轻松实现⽆锁队列1、什么是⽆锁(Lock-Free)编程当谈及 Lock-Free 编程时,我们常将其概念与 Mutex(互斥) 或 Lock(锁) 联系在⼀起,描述要在编程中尽量少使⽤这些锁结构,降低线程间互相阻塞的机会,以提⾼应⽤程序的性能。

类同的概念还有 "Lockless" 和 "Non-Blocking" 等。

实际上,这样的描述只涵盖了 Lock-Free 编程的⼀部分内容。

本质上说,Lock-Free 编程仅描述了代码所表述的性质,⽽没有限定或要求代码该如何编写。

基本上,如果程序中的某⼀部分符合下⾯的条件判定描述,则我们称这部分程序是符合 Lock-Free 的。

反过来说,如果某⼀部分程序不符合下⾯的条件描述,则称这部分程序是不符合 Lock-Free的。

上⾯的英⽂翻译成中⽂就是很简单的:如果你的应⽤程序是多线程并且它们之间都有访问共享内存但是访问时并没有相互阻塞,那它就是lock-free 编程。

注意lock-free 只是强调了编程概念并没指定其具体的实现形式,其强调的概念是「线程间访问共享内存时不会相互阻塞」。

那如果没有lock 或者Mutex 就⼀定是lock-free 编程了吗,看下⾯的代码⽚段:x = 0;while(x == 0){x = 1 - x;}假设有线程T1,T2同时调⽤这段代码,T1,T2都判断x == 0,进⾏到循环。

T1先执⾏ x = 1 - 0,此时 x = 1后 T2 执⾏ x = 1 - 1。

x = 0。

T1,T2此时判断x == 0,结果两者⼜进⼊了循环。

线程T1,T2相互影响,两者都陷⼊了死循环,这种某种意义也算得上是相互阻塞使线程,所以这不算是lock-free 编程。

ok ,了解了lock-free 编程的相关概念那要怎么实现呢。

在开始说⽆锁队列之前,我们需要知道⼀个很重要的技术就是CAS 操作——Compare & Set ,或是 Compare & Swap ,现在⼏乎所有的CPU 指令都⽀持CAS 的原⼦操作,X86下对应的是 CMPXCHG 汇编指令。

高并发与低延时注意事项

高并发与低延时注意事项高并发和低延时是现代计算机系统设计中非常重要的概念,尤其是在处理大量用户请求的系统中,如电子商务、社交媒体、金融交易等。

以下是设计高并发和低延时系统时需要注意的一些关键点:1. 优化算法和数据结构:在高并发系统中,算法的效率至关重要。

通过选择更高效的算法和数据结构可以显著降低系统的延时。

例如,使用哈希表代替线性搜索可以提高查询效率,使用二叉搜索树可以加快插入和删除操作。

2. 多线程和异步编程:通过利用多线程和异步编程技术,可以使系统能够同时处理多个并发请求,从而提高系统的吞吐量和并发能力。

使用线程池可以避免频繁地创建和销毁线程,提高性能。

3. 缓存使用和优化:缓存是提高系统性能的关键因素之一。

合理使用缓存可以减少对后台数据库或其他存储系统的访问次数,从而减少延时。

但需要注意缓存的一致性和更新策略,避免数据不一致的问题。

4. 负载均衡:在高并发系统中,分布式负载均衡可以将请求分散到多个服务器上,从而提高系统的并发能力。

常用的负载均衡算法有轮询、加权轮询、哈希等。

同时,需要及时监测和调整负载均衡策略,以适应系统的动态变化。

5. 高效的数据库设计:一个高效的数据库设计可以减少数据库操作的次数和数据检索的时间,提高系统的响应速度。

例如,使用合适的索引、优化查询语句、避免全表扫描等。

6. 队列和消息中间件:使用队列和消息中间件可以解耦系统的不同模块,实现异步消息传递,从而提高系统的并发性和响应能力。

消息中间件可以支持消息持久化、重试机制、消息分发等功能,提高系统的可靠性和稳定性。

7. 垂直扩展和水平扩展:在高并发系统设计中,可以通过垂直扩展(增加服务器的硬件配置)和水平扩展(增加服务器的数量)来提高系统的并发能力和容量。

垂直扩展适用于单个请求的计算量较大的情况,而水平扩展适用于大量并发请求的情况。

8. 流量控制和熔断机制:在高并发系统中,流量控制和熔断机制可以避免系统过载、雪崩效应等问题。

操作系统的并发控制与调度算法

操作系统的并发控制与调度算法操作系统是计算机系统的核心组成部分,它负责管理计算机系统中的硬件和软件资源。

在现代计算机系统中,要实现多任务处理和资源共享,就需要对并发控制和调度算法进行有效管理。

本文将重点探讨操作系统中的并发控制与调度算法,并介绍其原理和应用。

一、并发控制在操作系统中,多个进程或线程可以同时执行,这就是并发的基本特性。

然而,并发执行可能会导致资源竞争的问题,比如对共享数据的修改,如果没有合适的并发控制机制,就会导致数据不一致或错误的结果。

因此,并发控制是操作系统中非常重要的一项功能。

1. 锁机制锁机制是最常见的并发控制技术之一。

当多个进程或线程需要访问同一个共享资源时,可以使用锁来控制资源的访问权限。

常见的锁包括互斥锁、读写锁和条件变量等。

互斥锁用于串行化对共享资源的访问,一次只允许一个进程或线程访问资源;读写锁允许多个读者同时访问共享资源,但只允许一个写者独占访问;条件变量用于线程之间的通信和同步,当某个条件满足时,通知等待线程执行。

2. 信号量机制信号量机制是另一种常用的并发控制技术。

信号量是一个计数器,用于控制对资源的访问。

当一个进程或线程要访问资源时,会尝试将信号量减一,如果信号量为负,则表示资源正在被占用,进程或线程需要等待;当一个进程或线程释放资源后,会将信号量加一,唤醒等待的进程或线程。

二、调度算法在操作系统中,调度算法用于决定哪个进程或线程获得执行的机会。

调度算法的目标是提高系统的性能和吞吐量,同时保证公平性和响应性。

下面介绍几种常见的调度算法。

1. 先来先服务(FCFS)先来先服务算法是最简单的调度算法之一。

按照进程或线程的到达顺序为它们分配CPU的执行时间。

优点是简单易实现,但缺点是平均等待时间较长,容易产生“饥饿”现象。

2. 短作业优先(SJF)短作业优先算法根据进程或线程的执行时间来进行调度,执行时间短的优先获取CPU的执行时间。

这样可以减少平均等待时间,提高系统的性能和响应速度。

jctools 队列原理

jctools 队列原理JCTools队列原理简介JCTools是一个开源的Java并发编程工具包,它提供了一系列高效的数据结构和算法,用于解决多线程环境下的并发问题。

其中,JCTools队列是其核心组件之一,在并发编程中具有重要的作用。

什么是JCTools队列JCTools队列是一种基于无锁算法的并发队列实现,它通过避免使用锁来提高并发性能。

相比于传统的阻塞队列,JCTools队列在高并发场景下具有更好的性能和可伸缩性。

队列的基本原理1.无锁算法:JCTools队列采用无锁算法实现,避免了使用锁的开销和竞争。

无锁算法通过使用原子操作和CAS(Compare andSwap)指令来保证多线程之间的数据一致性。

2.环形缓冲区:JCTools队列内部使用一个环形缓冲区作为底层数据结构。

该缓冲区由固定大小的数组构成,通过循环计数器来实现环形的特性。

3.多生产者-多消费者模型:JCTools队列支持多个生产者和多个消费者并发操作。

它通过一些高效的并发逻辑,确保生产者和消费者之间的数据操作是安全的,不会出现数据丢失或覆盖的问题。

JCTools队列的特性•高并发性能:JCTools队列通过使用无锁算法和环形缓冲区,可以支持大量线程的高并发操作,提供出色的性能表现。

•可伸缩性:JCTools队列在多生产者-多消费者模型下,能够很好地适应不同线程数的并发需求,具有良好的可伸缩性。

•内存友好:JCTools队列在设计时考虑了内存分配和回收的效率,并且避免了不必要的内存开销,提供了更好的内存友好性。

•灵活性:JCTools队列提供不同类型的队列实现,例如单生产者-单消费者队列、多生产者-单消费者队列和多生产者-多消费者队列等,以满足不同场景下的需求。

使用JCTools队列的注意事项1.适当选择队列类型:根据实际情况选择适合的队列类型,避免过度设计或低效率的使用。

2.合理设置队列容量:根据业务需求设置合理的队列容量,避免队列溢出或造成过多的内存开销。

多核处理器体系结构设计考试

多核处理器体系结构设计考试(答案见尾页)一、选择题1. 多核处理器的基本工作原理是什么?A. 它们通过将多个CPU核心集成到一个芯片上来实现高性能计算。

B. 它们通过将多个任务分配给不同的核心来提高系统响应速度。

C. 它们通过增加缓存容量来提高数据处理速度。

D. 它们通过使用专用硬件来加速特定类型的计算任务。

2. 在多核处理器中,核间通信的主要方式有哪些?A. 管道通信B. 共享内存通信C. 消息传递通信D. 事件驱动通信3. 多核处理器的性能主要受哪些因素影响?A. 核心数量B. 链路带宽C. 缓存大小D. 电源管理效率4. 在多核处理器的设计中,如何平衡性能和功耗?A. 通过降低每个核心的功耗来实现节能。

B. 通过优化任务调度来减少空闲核心的功耗。

C. 通过增加核心数量来提高并行处理能力。

D. 通过使用更先进的制程技术来减小芯片面积和功耗。

5. 多核处理器中的任务分配通常是如何进行的?A. 由操作系统根据系统负载动态分配。

B. 由用户直接指定每个任务在哪个核心上运行。

C. 由编译器在编译时预先分配。

D. 由硬件自动分配,无需人工干预。

6. 在多核处理器的调试过程中,常用的工具和技术有哪些?A. 性能分析工具B. 调试器C. 监控工具D. 仿真器7. 多核处理器在哪些应用场景下表现最为出色?A. 计算密集型任务B. 内存密集型任务C. 多媒体处理D. 网络安全8. 在多核处理器的设计中,如何防止一个核过载而影响系统性能?A. 使用负载均衡技术B. 对于关键任务进行优先级调度C. 增加更多的核心数量D. 使用专用硬件加速器9. 多核处理器的发展趋势是什么?A. 更高的核数B. 更低的功耗C. 更强的并行处理能力D. 更高的单核性能10. 在多核处理器的应用中,如何确保数据的一致性和线程安全?A. 使用锁机制B. 使用原子操作C. 使用无锁数据结构D. 使用操作系统提供的同步原语11. 在多核处理器体系结构设计中,哪种类型的缓存通常被用来提高数据访问速度?A. 一级缓存(L1)B. 二级缓存(L2)C. 三级缓存(L3)D. 四级缓存(L4)12. 在多核处理器的设计中,为了实现高效的并行处理,以下哪个因素不是关键考虑点?A. 指令级并行(ILP)B. 核心间通信带宽C. 能耗D. 缓存一致性协议13. 在多核处理器的性能优化中,哪种技术通常用于减少缓存未命中率?A. 预取算法B. 乱序执行C. 动态调度D. 多线程技术14. 在多核处理器的资源管理中,哪种机制用于确保每个核都能公平地访问其分配的资源?A. 资源预留B. 资源分配算法C. 负载均衡D. 优先级调度15. 在多核处理器的设计中,为了提高能源效率,哪种技术被广泛采用?A. 超线程技术(Hyper-Threading)B. 硬件加速C. 微架构优化D. 低功耗工艺16. 在多核处理器的体系结构中,哪种类型的指令集被设计来支持复杂的数据处理任务?A. 简单指令集计算(SISD)B. 复杂指令集计算(CISC)C. 精简指令集计算(RISC)D. 并行指令集计算(IPC)17. 在多核处理器的设计中,为了提高系统的可靠性和稳定性,通常会采用哪种技术?A. 冗余设计B. 故障检测与纠正(FEC)C. 电源管理D. 热插拔技术18. 在多核处理器的性能测试中,哪种基准测试最能反映处理器在真实世界应用中的表现?A. 基准测试软件(如SPEC)B. 游戏测试C. 3D渲染测试D. 网络传输测试19. 在多核处理器的调试过程中,哪种工具用于监控和分析处理器在运行时的行为?A. 性能分析器(Profiler)B. 调试器(Debugger)C. 仿真器(Emulator)D. 逻辑分析仪(Logic Analyzer)20. 在多核处理器的安全设计中,哪种加密技术用于保护多核处理器免受侧信道攻击?A. 对称密钥加密B. 非对称密钥加密C. 密码分组链接(GCM)D. 访问控制列表(ACL)21. 在多核处理器中,以下哪个不是常见的核间通信方式?A. 管道通信B. 共享内存通信C. 消息队列通信D. 电路交换通信22. 在多核处理器的设计中,为了平衡负载和提高性能,通常会采取哪种策略?A. 随机分配任务B. 根据核心性能分配任务C. 固定分配任务D. 动态任务调度23. 多核处理器中的缓存一致性协议主要用于解决什么问题?A. 提高缓存的访问速度B. 防止数据竞争和一致性问题C. 增加处理器的计算能力D. 降低功耗24. 在多核处理器的设计中,为了提高系统的可扩展性,通常会选择哪种类型的核间通信机制?A. 管道通信B. 共享内存通信C. 消息队列通信D. 无锁机制25. 多核处理器在面对单核处理器无法处理的复杂任务时,表现如何?A. 性能显著提升B. 性能下降C. 性能无变化D. 可能会降低性能26. 在多核处理器的设计中,为了避免某个核心过载而其他核心闲置,通常会采用哪种技术?A. 负载均衡B. 缓存一致性C. 任务调度D. 中断处理27. 在多核处理器的应用场景中,以下哪个不是其主要的应用领域?A. 高性能计算B. 数据库处理C. 智能手机D. 家庭自动化28. 在多核处理器的设计中,为了提高处理器的能效比,通常会考虑哪些因素?A. 核心数量B. 缓存大小C. 电源管理D. 以上都是29. 在多核处理器的设计中,为了实现更高的吞吐量,通常会采用哪种优化技术?A. 多线程技术B. 数据压缩技术C. 并行计算技术D. 以上都是30. 在多核处理器中,核间通信通常使用什么方式?A. 系统总线B. 内存总线C. 专用指令集D. 中断驱动31. 多核处理器的性能主要取决于哪些因素?A. CPU核心数量B. 缓存大小C. 主频D. 内存容量32. 在多核处理器的设计中,如何平衡各个核的性能和功耗?A. 通过调整CPU频率B. 通过增加缓存容量C. 通过引入任务调度算法D. 通过优化内存访问策略33. 下列哪种多核处理器的架构不是对称多核架构?A. 超线程技术(Hyper-Threading)B. 图形多处理器(GPGPU)C. 对称多核处理器(SMP)D. 异构多核处理器(HMP)34. 在多核处理器的性能测试中,常用的基准测试程序包括哪些?A. LINPACKB. Prime95C. FIOD. DBench35. 在多核处理器的安全设计中,常见的安全漏洞有哪些?A. 数据竞争(Data Race)B. 死锁(Deadlock)C. 缓冲区溢出(Buffer Overflow)D. 侧信道攻击(Side-Channel Attack)36. 在多核处理器的编程模型中,有哪些常用的编程范式?A. 异步编程B. 并发编程C. 多线程编程D. 事件驱动编程37. 在未来多核处理器的发展趋势中,可能会出现哪些新技术?A. 多核与GPU的融合B. 量子计算与多核处理器的结合C. 机器学习加速与多核处理器的集成D. 基于光子的多核处理器38. 在多核处理器体系中,什么是Cache?A. 一种快速存储器,用于存储CPU频繁访问的数据和指令。

优化指南-Ampere Altra系列处理器的锁和内存序

优化指南-AmPere®AItra®系列处理器的锁和内存序AMPEREA1TRA和AMPEREA1TRAMAX的锁机制让我们先来了解一些基本的问题。

Arm在Armv8.2-A架构中引入了大型系统扩展(1arge S)^stem Extensions,1SE),它用单个原子指令取代了锁操作的指令序列。

一个非常不错的总结。

虽然旧的Arm版本在功能上可以很好地工作,但随着核心数量的增加和锁的争用更加频繁,预计性能会受到影响。

AmpereA1tra和AmpereA1traMax支持1SE,并配备了可扩展的锁性能。

为了说明使用的指令之间的差异,让我们看看gcc的处理方式_atomicfetchaddO在本例中,将锁值减1:_atomic_fetch_add(&1ockptr->Iockva1,-1,_ATOMICACQRE1);使用*-march=armv8.2-a*选项编译,编译器生成带有原子指令的代码:998: f8f60280 Idadda1x22,xθ,[x20]另一方面,设置*-march=armv8-a*(不支持1SE),生成一个不同的序列:9a4: c85ffe60Idaxrxθ,[x19]9a8: d1000400SUb xθ,xθ,#0x19ac: 9b0: c801fe60st1xrw1,xθ,[x19]35ffffa1cbnz w1,9a4<main+0x104>为了使序列具有原子性,需要一个单独的监视器。

IdaXr获得一个地址标记,在本例中为[x19]o然后执行减法,然后存储回内存位置。

但是,只有当存储(st*e)时的标记与加载(1oad)中的标记匹配时,存储才会成功。

St1xr之后的条件分支cbnz检查存储是否成功,这意味着1oad和store 中的标记匹配。

如果不是,则跳回序列的开头,在本例中是地址0x9a4o这里值得注意的是,如果没有1SE指令,这个指令序列可能要执行几次才能被认为成功。

c语言多线程缓冲队列无锁设计思路

c语⾔多线程缓冲队列⽆锁设计思路公司⾥开发的⼀个项⽬需要在server端添加多线程缓冲队列,来存取数据,我也是初出茅庐没有太多经验,在⽹上搜集了⼤量资料后,终于有了⼀套⾃⼰的设计思路,并解决了项⽬⾥的问题,因为当时搜集资料时,发现⽹上这个的具体⽂章不是太多或者要么太复杂,要么太简陋,对于新⼿很难能看懂,所有我就打算将我的设计思路发出来,希望能帮助和我⼀样的同学朋友们,如有不⾜请指导!谢谢项⽬需求:两个线程,线程1接收客户端数据并有序的存⼊缓冲队列;线程2从缓冲队列有序的取出数据并解析插⼊数据库;解决⽅法:1:新建⼀个结构体buff_quere,内有⼀个枚举类型buffstatus缓冲区状态,为空已读已写,和⼀个缓存数据的数组类型buff_up_quere,接收的数据存在这⾥;(全局)1/* 缓冲区结构体 */2struct buff_quere{3enum buffstatus{empty,wirte,reads}bufstatus; //为空,已写,已读4 uint8_t buff_up_quere[RX_BUFF_SIZE]; //缓冲区5 };View Code2:创建结构体数组为缓冲区,需要⼏个就建⼏个;(全局)1static struct buff_quere buff_data1[BUFFER_QUEUE_LEN];//缓冲区12static int count_len1 = 0; //缓冲区1计数器3static struct buff_quere buff_data2[BUFFER_QUEUE_LEN];//缓冲区24static int count_len2 = 0; //缓冲区2计数器View Code3:线程1接收并储存数据到缓冲区;1int buff_nb = 1;//默认从第⼀个缓冲区开始储存2int nb_next = 0;//下⼀个缓冲区3int len=0;4while(true)5{6//缓冲队列7 nb_next = buff_nb+1;8if(nb_next == 2){9 nb_next = 1;10}11switch(buff_nb){12case1:13 printf("进⼊缓冲区%d进⾏写⼊缓冲区index=%d\n",buff_nb,len);14 buff_data1[len].bufstatus = wirte;15 memcpy(&buff_data1[len].buff_up_quere, &buff_up, sizeof(buff_up));16 len++;17if (len == BUFFER_QUEUE_LEN)18 {19 printf("缓冲区%d已写⼊完毕",buff_nb);20while(count_len2 != 0){21 printf("警告:缓冲区%d还未清空,停⽌缓存数据\n",nb_next);22 sleep(1);23 }24 printf(",转到缓冲区%d进⾏缓存\n",nb_next);25 len = 0;26 buff_nb = nb_next;27 }28break;29case2:30 printf("进⼊缓冲区%d进⾏写⼊缓冲区index=%d\n",buff_nb,len);31 buff_data2[len].bufstatus = wirte;32 memcpy(&buff_data2[len].buff_up_quere, &buff_up, sizeof(buff_up));33 len++;34if (len == BUFFER_QUEUE_LEN)35 {36 printf("缓冲区%d已写⼊完毕",buff_nb);37while(count_len1 != 0){38 printf("警告:缓冲区%d还未清空,停⽌缓存数据\n",nb_next);39 sleep(1);40 }41 printf(",转到缓冲区%d进⾏缓存\n",nb_next);42 len = 0;43 buff_nb = nb_next;44 }45break;46default:47continue;48break;49 }View Code4:线程2从缓冲区获取数据并操作数据;1int buff_nb = 1;//获取缓冲区编号,默认为12int nb_next = 0;//下⼀个缓冲区3int len=0;4while (true)5{6//缓冲队列7 nb_next = buff_nb+1;8if(nb_next == 11){9 nb_next = 1;10 }11switch(buff_nb){12case1:13if(buff_data1[len].bufstatus == wirte){14 printf("进⼊缓冲区%d进⾏读取缓冲区数据index=%d\n",buff_nb,len);15 buff_data1[len].bufstatus = reads;16 memcpy(&buff_up, &buff_data1[len].buff_up_quere, sizeof(buff_data1[len].buff_up_quere));17 len++;18if (len == BUFFER_QUEUE_LEN)19 {20 printf("缓冲区%d已读取完毕index=%d,清空此缓冲区\n",buff_nb,len);21 len = 0;22 buff_nb = nb_next;23 memset(buff_data1, 0, sizeof(buff_data1));24 }25 }else{26 printf("缓冲区%d为空或已读,请等待...\n",buff_nb);27 sleep(1);28continue;29 }30 count_len1 = len;31break;32case2:33if(buff_data2[len].bufstatus == wirte){34 printf("进⼊缓冲区%d进⾏读取缓冲区数据index=%d\n",buff_nb,len);35 buff_data2[len].bufstatus = reads;36 memcpy(&buff_up, &buff_data2[len].buff_up_quere, sizeof(buff_data2[len].buff_up_quere));37 len++;38if (len == BUFFER_QUEUE_LEN)39 {40 printf("缓冲区%d已读取完毕index=%d,清空此缓冲区\n",buff_nb,len);41 len = 0;42 buff_nb = nb_next;43 memset(buff_data2, 0, sizeof(buff_data2));44 }45 }else{46 printf("缓冲区%d为空或已读,请等待...\n",buff_nb);47 sleep(1);48continue;49 }50 count_len2 = len;51break;52default:53continue;54break;55 }View Code总结思路:当线程1将数据储存到缓冲区1(buff_data1[BUFFER_QUEUE_LEN])的时候先将缓冲区1当前储存的元素赋值⼀个写⼊的状态(buff_data1[len].bufstatus = wirte;),然后再写⼊(memcpy(&buff_data1[len].buff_up_quere, &buff_up, sizeof(buff_up)););当缓冲区1写满后通过count_len2是否为0判断缓冲区2是否为空,为空就切换缓冲区2并将下标设为0继续写⼊(len = 0;buff_nb = nb_next;),否则进⾏等待;当线程2从缓冲区1(buff_data1[BUFFER_QUEUE_LEN])获取数据的时候,先判断缓冲区1⾥当前元素的状态是否为写⼊(if(buff_data1[len].bufstatus == wirte)),是则给当前元素赋值⼀个读取的状态(buff_data1[len].bufstatus = reads;)然后再获取(memcpy(&buff_up, &buff_data1[len].buff_up_quere, sizeof(buff_data1[len].buff_up_quere));),不是就等待(sleep(1);continue;),当获取完此缓冲区就清空掉,(memset(buff_data1, 0, sizeof(buff_data1));)并将count_len2=0,告诉线程1我清空了,你可以写了!然后读取下⼀个缓冲区(len = 0;buff_nb = nb_next;)。

cache的基本原理

cache的基本原理Cache的基本什么是Cache?•Cache(缓存)是一种存储数据的技术,它提供了一种快速访问数据的方式。

•作为一种高速缓存,Cache通常是位于主存(main memory)和处理器之间的存储器,存储着最常用或者最近使用的数据。

•Cache通过减少对主存的访问,提高了计算机系统的性能。

Cache的工作原理•当程序需要访问数据时,计算机会优先检查Cache中是否存在需要的数据。

•如果Cache中有请求的数据,称为命中(hit),计算机直接从Cache中获取数据,而不必访问主存。

•如果Cache中没有请求的数据,称为未命中(miss),计算机就会从主存中读取数据,并将数据存储到Cache中。

Cache的基本原理局部性原理•Cache的原理基于计算机程序的局部性原理。

•局部性原理分为时间局部性和空间局部性:–时间局部性:如果程序中某个数据项被访问,那么在不久的将来它极有可能再次被访问。

–空间局部性:如果程序中某个数据项被访问,那么在不久的将来其附近的数据极有可能被访问。

•Cache利用局部性原理,将经常使用的数据存储在靠近处理器的快速存储器中,提高了数据的访问速度。

Cache的层次结构•Cache的设计通常采用多级层次结构,例如L1、L2、L3 Cache等。

–L1 Cache是离处理器最近的Cache,速度最快。

–L2 Cache位于L1 Cache之后,容量更大,速度较慢。

–L3 Cache相对L2 Cache再远一些,容量更大,速度更慢。

•多级Cache的设计是为了兼顾容量和速度的平衡,提高整体系统性能。

Cache的替换策略•Cache的容量是有限的,当Cache已满时,需要替换掉一些数据来为新数据腾出空间。

•常见的替换策略包括:–最近最少使用(LRU):替换最近最久未使用的数据。

–最不经常使用(LFU):替换使用频率最低的数据。

–随机替换:随机选择一个数据进行替换。

Cache的写策略•当处理器需要写入数据时,Cache可以采用以下两种策略:–写回(write back):只将数据更新写入Cache,并在有需要时再一次性写回主存。

服务器资源调度算法优化性能和响应时间

服务器资源调度算法优化性能和响应时间在现代信息技术的发展中,服务器承载着大量的数据和请求处理任务。

为了提高服务器的性能和响应时间,调度算法被广泛应用于服务器资源的管理。

本文将探讨如何优化服务器资源调度算法,以达到最佳性能和最短的响应时间。

一、资源调度算法的概述服务器资源调度算法是指在多个请求同时到达服务器时,如何合理分配服务器资源以满足各个请求的需求。

常见的调度算法包括先来先服务(FCFS)、最短作业优先(SJF)、轮转调度(RR)等。

每种算法都有其特点和适用场景,但都需要考虑如何优化性能和响应时间。

二、优化性能的策略1. 硬件增强:首先,优化服务器的硬件设备可以提升整体性能。

例如增加服务器的处理器核心数、内存容量等,以增加服务器的并发处理能力。

2. 负载均衡:将请求均匀地分发到不同的服务器节点,以避免某个节点过载。

常见的负载均衡算法包括轮询、加权轮询、最少连接等。

通过合理选择负载均衡算法,可以使服务器资源得到充分利用,提高整体性能。

3. 预调度策略:通过预先将任务分配给可用的资源,可以减少等待时间和响应延迟。

预调度策略可以根据任务的特点和优先级来进行选择,例如将短作业或紧急任务优先调度。

4. 动态调整策略:根据当前服务器的负载情况和资源利用率,动态调整资源分配策略。

当服务器负载高时,可以增加处理器核心数或分配更多的内存资源,以提高处理能力。

当负载较低时,可以减少资源分配,以节省成本和能源消耗。

三、优化响应时间的策略1. 缓存技术:通过使用缓存来存储经常访问的数据,可以减少对存储或数据库的访问次数,从而提高响应速度。

常见的缓存技术有内存缓存和分布式缓存等,可以根据实际情况选择合适的缓存方案。

2. 并发处理:通过并发处理多个请求,可以提高服务器的响应能力。

可以利用多线程或多进程技术,将任务并行执行,以缩短响应时间。

3. 响应压缩:对于传输到客户端的数据,可以使用压缩算法进行压缩,以减少数据传输量,从而提高响应速度。

LruCache:提高DSP系统性能的高效缓存机制

缓存机制

目录

CONTENTS

01

DSP系统中的LruCache缓存机制

02

引入LruCache提高美团DSP系统性 能

DSP系统中的LruCache缓存机制

引入LruCache的原因

1. LruCache是一种高效的缓存机制,可降低DSP系统中的平均响应时 间。 2. 美团平台引入LruCache,以提高DSP系统的性能。 3. LruCache + 键值存储数据库的机制将远端数据变为本地缓存数据, 提高数据获取速度。 4. LruCache通过清退机制,维持服务内存占用在安全区间,保证系统 稳定运行。

幻灯片3

1. 幻灯片3:产品特性与优势 2. 幻灯片3:市场定位与目标客户 3. 幻灯片3:竞争分析与差异化策略 4. 幻灯片3:营销策略与推广方案

幻灯片4

幻灯片4: 1. 主题:探讨人工智能在医疗领域的应用 2. 内容:介绍AI辅助诊断、智能手术、药物研发等方面的实际案例 3. 结论:人工智能技术为医疗行业带来显著的效率提升和质量改善 4. 展望:未来AI将会在更多领域发挥巨大作用,助力医疗行业的创新与 发展

1. 比较实验:引入HashLruCache前后Top999耗时对比 2. 数据收集:记录HashLruCache使用前后的请求耗时 3. 实验结果:展示两组数据的对比图表 4. 趋势分析:分析Top999耗时变化趋势 5. 结论:评估HashLruCache对性能的改善效果

HashLruCache分片数量耗时对比图

应用演进

1. 引入LruCache。 2. LruCache增加时效清退机制。 3. HashLruCache满足高QPS应用场景。 4. 零拷贝机制。 5. 不断优化系统性能。

矿产

矿产资源开发利用方案编写内容要求及审查大纲

矿产资源开发利用方案编写内容要求及《矿产资源开发利用方案》审查大纲一、概述

㈠矿区位置、隶属关系和企业性质。

如为改扩建矿山, 应说明矿山现状、

特点及存在的主要问题。

㈡编制依据

(1简述项目前期工作进展情况及与有关方面对项目的意向性协议情况。

(2 列出开发利用方案编制所依据的主要基础性资料的名称。

如经储量管理部门认定的矿区地质勘探报告、选矿试验报告、加工利用试验报告、工程地质初评资料、矿区水文资料和供水资料等。

对改、扩建矿山应有生产实际资料, 如矿山总平面现状图、矿床开拓系统图、采场现状图和主要采选设备清单等。

二、矿产品需求现状和预测

㈠该矿产在国内需求情况和市场供应情况

1、矿产品现状及加工利用趋向。

2、国内近、远期的需求量及主要销向预测。

㈡产品价格分析

1、国内矿产品价格现状。

2、矿产品价格稳定性及变化趋势。

三、矿产资源概况

㈠矿区总体概况

1、矿区总体规划情况。

2、矿区矿产资源概况。

3、该设计与矿区总体开发的关系。

㈡该设计项目的资源概况

1、矿床地质及构造特征。

2、矿床开采技术条件及水文地质条件。