R. Nesting OpenMP in MPI to implement a hybrid communication method of parallel simulated a

openmpi跨节点执行命令参数

openmpi跨节点执行命令参数【原创版】目录1.openmpi 概述2.openmpi 跨节点执行的命令参数3.实例说明正文1.openmpi 概述OpenMPI(Open-source MPI)是一个开源的并行计算框架,可以用于构建高性能计算(HPC)系统。

MPI(Message Passing Interface)是一种并行计算的通信协议,OpenMPI 是 MPI 的一种实现。

OpenMPI 提供了一种在分布式系统上实现并行计算的方法,它的设计目标是为了提供高性能、可移植性和易用性。

在 OpenMPI 中,可以通过 mpirun 命令来执行并行任务,这个命令可以跨节点分配任务和资源。

2.openmpi 跨节点执行的命令参数openmpi 跨节点执行的命令参数主要包括以下几个:- "-n":指定并行度,即并行处理的节点数目。

- "-l":指定每个节点上的进程数。

- "-o":指定输出文件。

- "-f":指定输入文件。

- "- Host":指定主机名,用于与主机进行通信。

- "- Port":指定端口号,用于与主机进行通信。

3.实例说明假设我们有一个名为“example.mpi”的并行计算程序,我们希望在两台节点(node1 和 node2)上执行它。

那么,我们可以使用以下命令:```mpirun -n 2 -l 2 -o output -f input example.mpi```这条命令的含义如下:- "-n 2":指定并行度为 2,即在两台节点上执行任务。

- "-l 2":指定每台节点上运行 2 个进程。

- "-o output":指定输出文件名为“output”。

- "-f input":指定输入文件名为“input”。

openfoam mpi编译

OpenFOAM是一个由英国OpenCFD公司开发的开源计算流体力学软件。

它采用C++编程语言,可以在Linux操作系统上运行。

OpenFOAM具有模块化的结构,使得用户可以方便地定制和扩展其功能。

为了加快计算速度,OpenFOAM还支持MPI并行计算。

MPI(Message Passing Interface)是一种用于编写并行程序的标准。

使用MPI,用户可以在多个处理器上同时执行程序,从而加快计算速度。

在OpenFOAM中,MPI被用于加速求解大规模计算流体力学问题的速度。

在本文中,我们将介绍如何在OpenFOAM中使用MPI进行编译。

一、安装MPI库我们需要安装MPI库。

在Linux系统中,MPI一般通过包管理器进行安装。

以Ubuntu系统为例,可以使用以下命令安装MPI库:sudo apt-get install mpich二、配置MPI环境安装完MPI库后,需要配置MPI环境。

在OpenFOAM中,MPI的配置是通过修改OpenFOAM的环境变量来实现的。

我们需要找到OpenFOAM的安装路径,然后在用户目录下找到.bashrc文件,在其中添加如下行:export WM_MPLIB=SYSTEMOPENMPIexport WM_COMPILE_OPTION=mpi其中,WM_MPLIB指定了使用的MPI库,这里我们使用了OpenMPI;WM_COMPILE_OPTION指定了编译选项为MPI。

三、进行编译配置完成后,就可以进行编译了。

需要清理之前的编译结果,可以使用以下命令进行清理:wclean all进行新的编译:wmake这样就可以在OpenFOAM中使用MPI进行编译了。

四、检查编译结果需要检查编译结果是否正确。

可以通过运行一个包含MPI并行计算的例子来验证编译是否成功。

如果例子能够正确运行并且加速效果明显,说明MPI编译成功。

总结通过本文介绍,我们了解了如何在OpenFOAM中使用MPI进行编译。

openmpi多节点通信编程实例

openmpi多节点通信编程实例OpenMPI 是一个高性能的 MPI (Message Passing Interface) 实现,用于在多节点系统上进行并行计算。

以下是一个简单的 OpenMPI 多节点通信编程实例:首先,确保你已经正确安装了 OpenMPI。

然后,你可以使用以下的 C++ 代码来创建一个简单的 MPI 程序。

这个程序将使用 `MPI_Send` 和 `MPI_Recv` 来发送和接收消息。

```c++include <>include <iostream>include <string>int main(int argc, char argv) {// 初始化 MPI 环境MPI_Init(NULL, NULL);// 获取总的进程数和当前进程的 IDint world_size;int world_rank;MPI_Comm_size(MPI_COMM_WORLD, &world_size);MPI_Comm_rank(MPI_COMM_WORLD, &world_rank);// 检查命令行参数,查看是否有指定主机文件if (argc > 1) {MPI_Comm_set_errhandler(MPI_COMM_WORLD,MPI_ERRORS_RETURN);MPI_File file;MPI_File_open(MPI_COMM_WORLD, argv[1],MPI_MODE_RDONLY, MPI_INFO_NULL, &file);MPI_Status status;char host[MPI_MAX_PROCESSOR_NAME];int nameLen;MPI_File_read_at(file, 0, host, MPI_MAX_PROCESSOR_NAME, MPI_CHAR, &status);host[_OFF_SET] = '\0'; // NULL terminate the string.MPI_File_close(&file);if (world_rank == 0) std::cout << "Host name is: " << host << std::endl;MPI_Bcast(host, MPI_MAX_PROCESSOR_NAME, MPI_CHAR, 0, MPI_COMM_WORLD);} else {if (world_rank == 0) std::cout << "No host file specified." << std::endl;}// 使用 "Hello, World!" 消息进行通信std::string message = "Hello, World!";int dest = world_rank == 0 ? world_size - 1 : world_rank - 1; // 将消息发送给前一个进程int tag = 1234; // 可以是任何整数,用于区分不同的消息类型int sendbufsize = (); // 消息的大小(以字节为单位)char sendbuffer[sendbufsize]; // 消息的内容(以字节为单位)for (int i = 0; i < sendbufsize; ++i) { // 将字符串转换为字节数组sendbuffer[i] = message[i];}MPI_Send(sendbuffer, sendbufsize, MPI_CHAR, dest, tag,MPI_COMM_WORLD); // 将消息发送给指定的进程if (world_rank == world_size - 1) { // 只最后一个进程接收消息并打印出来char receivebuffer[sendbufsize]; // 用于接收消息的缓冲区MPI_Recv(receivebuffer, sendbufsize, MPI_CHAR,MPI_ANY_SOURCE, tag, MPI_COMM_WORLD, &status); // 从任何发送进程接收消息int source = _SOURCE; // 获取发送进程的 IDstd::cout << "Process " << world_rank << " received the following message from process " << source << ":" << std::endl;for (int i = 0; i < sendbufsize; ++i) { // 将字节数组转换回字符串,并打印出来std::cout << ((char) receivebuffer[i]);}std::cout << std::endl;} else if (world_rank > 0) { // 其他进程什么都不做,只是等待接收消息(这里可以加入其他并行任务)// ...(这里可以加入其他并行任务)...} else { // 第一个进程只发送消息,不接收(这里可以加入其他并行任务) // ...(这里可以加入其他并行任务)...}// 清理 MPI 环境并退出程序MPI_Finalize();return 0;}```这个程序使用了 `MPI_Send` 和 `MPI_Recv` 来发送和接收消息。

mpi-init函数的两个参数

mpi-init函数的两个参数MPI_Init函数是MPI库中用于初始化MPI环境的函数,它有两个参数,分别是argc和argv。

1. argc:argc是一个整数类型的参数,表示命令行参数的数量。

在C程序中,命令行参数通常作为main函数的参数传递给程序。

MPI_Init函数的argc参数用于传递命令行参数的数量给MPI库,以便MPI库在初始化时可以正确处理命令行参数。

通常情况下,MPI_Init函数会将argc传递给MPI库内部的解析函数,用于解析处理MPI相关的命令行参数。

2. argv:argv是一个字符指针数组,表示命令行参数的值。

在C程序中,命令行参数通常作为main函数的参数传递给程序。

MPI_Init函数的argv参数用于传递命令行参数的值给MPI库,以便MPI库在初始化时可以正确处理命令行参数。

通常情况下,MPI_Init函数会将argv传递给MPI库内部的解析函数,用于解析处理MPI相关的命令行参数。

MPI_Init函数的作用是在每个MPI进程中初始化MPI环境,它会完成以下几个任务:1.初始化MPI库所需的内部数据结构和变量;2.解析和处理命令行参数,如解析并处理与MPI相关的命令行参数;3.建立MPI进程间的通信通道,如创建并初始化MPI通信域,用于进程间的通信;4.分配和管理MPI进程的资源,如内存分配、进程ID分配等;5.设置并初始化MPI底层的通信机制,如创建并初始化网络连接、建立节点间的通信线路等;6. 调用底层通信库的初始化函数,如调用底层TCP/IP协议栈的初始化函数、调用底层InfiniBand通信库的初始化函数等。

MPI_Init函数通常是在MPI程序的入口处调用的,它是MPI程序执行的第一个函数。

调用MPI_Init函数后,MPI库会在每个MPI进程中初始化MPI环境,并返回一个整数类型的返回值,表示MPI初始化的状态。

通常情况下,如果MPI初始化成功,返回值为MPI_SUCCESS;如果MPI初始化失败,返回值为一个非零的错误码,可以通过调用MPI_Error_string函数将错误码转换为错误信息字符串进行打印输出或记录。

openMP(并行计算) 超简单快速上手

openMP(并行计算)超简单快速上手简介:•OpenMp是并已被广泛接受的,用于共享内存并行系统的多处理器程序设计的一套指导性的编译处理方案。

•OpenMP支持的编程语言包括C语言、C++和Fortran;•OpenMp提供了对并行算法的高层的抽象描述,程序员通过在源代码中加入专用的pragma来指明自己的意图,由此编译器可以自动将程序进行并行化,并在必要之处加入同步互斥以及通信。

当选择忽略这些pragma,或者编译器不支持OpenMp时,程序又可退化为通常的程序(一般为串行),代码仍然可以正常运作,只是不能利用多线程来加速程序执行。

openMP并行化for循环(只需三步)1.vs等编译器中开启openMP支持2.将 Project 的Properties中C/C++里Language的OpenMP Support开启(参数为 /openmp)3.4.包含头文件5.#include<omp.h>6.7.在需要并行化的for循环前加入pragma指令8.#pragma omp parallel for9.这就三步就够了,是不是非常简单啊,赶快用起来吧。

使用技巧1.2.不是给所有的for都加并行化就会变更快,如果for的次数不是很多,就没必要使用并行了,反而会变慢3.多层for循环的情况#pragma omp parallel for是放在内层还是外层要视情况而定,绝对不能一概而论。

•如果内层的计算复杂度很高,比如循环次数多,每次循环计算量也比较大,放在内层可能效果要大大地好于外层。

•如果内层访问的内存比较多,#pragma omp parallel for放在外层的话,可能导致cache命中率大大降低,计算速度可能会是几十倍的下降。

openmpi跨节点执行命令参数

openmpi跨节点执行命令参数摘要:1.OpenMPI 简介2.OpenMPi 参数与mpirun 命令参数3.跨节点执行的实践方法4.实例与注意事项正文:1.OpenMPI 简介OpenMPI(Open Multi-Processing Interface)是一个用于并行处理的应用程序编程接口(API),支持Fortran 和C 语言。

它提供了一组API,用于在多个处理器核心和节点上平衡负载、同步和通信。

OpenMPI 在高性能计算领域广泛应用,特别是在超算和集群系统中。

2.OpenMPi 参数与mpirun 命令参数OpenMPI 提供了一系列参数,用于调整并行处理的行为。

这些参数可以通过环境变量或命令行中的参数传递给OpenMPI。

其中,mpirun 是OpenMPI 的执行命令,它可以在命令行中指定各种参数,以便在运行时调整OpenMPI 的行为。

常见的OpenMPi 参数包括:- `OMP_NUM_THREADS`:控制并行度,即并行处理的线程数量。

- `OMP_PROC_BIND`:指定并行任务绑定到哪个处理器上。

- `OMP_PLACEMENT`:指定并行任务在哪个节点上执行。

mpirun 命令的参数示例:```mpirun -np 4 -host myhost -mca orphan -mca port 4444 myprogram```其中,`-np 4`指定并行度为4,`-host myhost`指定任务运行在名为`myhost`的主机上,`-mca orphan`指定允许孤立任务,`-mca port 4444`指定使用端口4444 进行通信。

3.跨节点执行的实践方法在OpenMPI 中,要实现跨节点执行,需要使用`OMP_PLACEMENT`参数。

`OMP_PLACEMENT`参数可以指定并行任务在哪个节点上执行。

在实践中,可以通过以下方法实现跨节点执行:- 直接在命令行中指定节点,例如:`mpirun -np 4 -host node1 -mca orphan -mca port 4444 myprogram`。

openmp用法

openmp用法OpenMP是一种支持共享内存多线程编程的标准API。

它提供了一种简单而有效的方法,用于在计算机系统中利用多核和多处理器资源。

本文将逐步介绍OpenMP的用法和基本概念,从简单的并行循环到复杂的并行任务。

让我们一步一步来学习OpenMP吧。

第一步:环境设置要开始使用OpenMP,我们首先需要一个支持OpenMP的编译器。

常见的编译器如GCC、Clang和Intel编译器都支持OpenMP。

我们需要确保在编译时启用OpenMP支持。

例如,在GCC中,可以使用以下命令来编译包含OpenMP指令的程序:gcc -fopenmp program.c -o program第二步:并行循环最简单的OpenMP并行化形式是并行循环。

在循环的前面加上`#pragma omp parallel for`指令,就可以让循环被多个线程并行执行。

例如,下面的代码演示了如何使用OpenMP并行化一个简单的for循环:c#include <stdio.h>#include <omp.h>int main() {int i;#pragma omp parallel forfor (i = 0; i < 10; i++) {printf("Thread d: d\n", omp_get_thread_num(), i);}return 0;}在上面的例子中,`#pragma omp parallel for`指令会告诉编译器将for 循环并行化。

`omp_get_thread_num()`函数可以获取当前线程的编号。

第三步:数据共享与私有变量在并行编程中,多个线程可能会同时访问和修改共享的数据。

为了避免数据竞争和不一致的结果,我们需要显式地指定哪些变量是共享的,哪些变量是私有的。

我们可以使用`shared`和`private`子句来指定。

`shared`子句指定某个变量为共享变量,对所有线程可见。

openmpi跨节点执行命令参数

openmpi跨节点执行命令参数摘要:1.Open MPI 简介2.跨节点执行命令参数a.参数说明b.参数设置示例3.总结正文:Open MPI 是一种高性能的MPI 实现,广泛应用于高性能计算和大规模并行处理领域。

它支持多种编程语言,包括C、C++、Fortran 等,提供了丰富的功能和优秀的性能。

在Open MPI 中,跨节点执行命令参数是用于控制MPI 进程在多个计算节点上运行的关键参数。

通过设置这些参数,可以有效地调整MPI 进程的执行策略,从而提高计算效率和性能。

以下是一些常用的跨节点执行命令参数及其设置示例:1.`-np`:用于指定MPI 进程的数量。

例如,`mpirun -np 4` 表示启动4 个MPI 进程。

2.`-host`:用于指定计算节点的主机名或IP 地址。

例如,`mpirun -host node1,node2 -np 4` 表示在node1 和node2 两个计算节点上启动4 个MPI 进程。

3.`-bind-to`:用于指定MPI 进程绑定到的CPU 核心。

例如,`mpirun-bind-to none -np 4` 表示启动的MPI 进程不绑定到任何特定的CPU 核心。

4.`-map-by`:用于指定MPI 进程映射到计算节点的方式。

例如,`mpirun -map-by slot -np 4` 表示将MPI 进程映射到计算节点的每个插槽(slot)上。

5.`-oversubscribe`:用于指定是否允许MPI 进程数超过计算节点的物理核心数。

例如,`mpirun -oversubscribe -np 6` 表示在计算节点上启动6 个MPI 进程,即使物理核心数不足6 个。

6.`-allow-run-as-root`:用于指定是否允许MPI 进程以root 用户身份运行。

例如,`mpirun -allow-run-as-root -np 4` 表示启动4 个MPI 进程,允许以root 用户身份运行。

mpi 过程 -回复

mpi 过程-回复什么是MPI?MPI,全称为Message Passing Interface,即消息传递接口,是一种用于并行计算的通信标准。

MPI定义了一套接口和语义,允许多个并行进程在分布式内存系统中相互通信和协同工作。

MPI被广泛应用于高性能计算领域,特别是在大规模科学和工程计算中,以提高计算性能和效率。

MPI实现了一系列的函数和语义,用于在多个进程之间进行信息的传递和同步。

这些进程可以在同一台计算机上,也可以在分布式内存系统中的不同计算节点上。

MPI借助点对点通信、广播、约减、收集等操作,提供了一种并行计算领域通用、高效的通信机制。

MPI可以用于编写并行程序,在同一份代码中定义了各个进程的任务和交互方式。

在使用MPI编写并行程序时,首先需要初始化MPI环境。

在程序的起始处调用MPI_Init函数,这个函数会为每个进程分配一些必要的资源,并建立通信通道。

随后,每个进程可以通过调用MPI_Comm_rank函数获取自己的进程标识符,以便对不同的进程进行区分。

调用MPI_Comm_size函数可以获取整个并行程序中进程的总数。

进程间的通信是MPI的核心功能。

MPI中的通信模型主要有点对点通信和集体通信两类。

点对点通信是指两个进程之间直接的双向信息传递,包括发送和接收操作。

调用MPI_Send函数可以将数据发送给指定的进程,而调用MPI_Recv函数可以接收其他进程发送的数据。

集体通信是指多个进程之间进行的协作和通信,包括广播、约减、收集等操作。

调用MPI_Bcast函数可以将数据广播给所有其他进程,而调用MPI_Reduce函数可以将多个进程的数据约减为一个结果,调用MPI_Gather函数可以收集多个进程的数据。

MPI还提供了进程的同步机制,以保证并行计算的正确性和一致性。

最常用的同步操作是MPI_Barrier函数,调用该函数的进程会在该位置等待,直到所有其他进程也都调用了MPI_Barrier函数后,才会继续执行。

mpi程序编译运行指令

mpi程序编译运行指令MPI(Message Passing Interface)是一种用于并行计算的编程模型。

下面将介绍MPI程序的编译和运行指令。

编译MPI程序通常需要使用MPI编译器,常见的MPI编译器有MPICH、OpenMPI等。

在编译MPI程序之前,需要确保已经正确安装了MPI编译器和相关的库文件。

编译MPI程序的指令通常为:```mpiicc -o program program.c```其中,`mpiicc`是MPI编译器的命令,`-o program`指定输出的可执行文件名为`program`,`program.c`是要编译的MPI程序源代码文件。

运行MPI程序的指令通常为:```mpiexec -n <进程数> ./program```其中,`mpiexec`是MPI程序运行的命令,`-n <进程数>`指定运行时的进程数,`./program`指定要运行的MPI可执行文件。

在MPI程序中,可以使用MPI库中的函数来实现进程间的通信和协调。

常用的MPI函数包括`MPI_Init`、`MPI_Finalize`、`MPI_Comm_size`、`MPI_Comm_rank`、`MPI_Send`、`MPI_Recv`等。

这些函数可以实现进程的初始化、获取进程数和进程编号、发送和接收消息等功能。

MPI程序的运行流程一般为:1. 所有进程调用`MPI_Init`进行初始化。

2. 调用`MPI_Comm_size`获取进程总数,调用`MPI_Comm_rank`获取当前进程编号。

3. 根据进程编号的不同,执行不同的代码逻辑。

4. 进程间需要通信时,使用`MPI_Send`和`MPI_Recv`进行消息的发送和接收。

5. 所有进程执行完毕后,调用`MPI_Finalize`进行清理工作。

MPI程序的并行计算模型是基于消息传递的,即进程之间通过发送和接收消息来实现数据的交换和协同计算。

mpi基本用法 -回复

mpi基本用法-回复「MPI基本用法」是一种用于并行计算的编程模型和库。

MPI是Message Passing Interface的缩写,它提供了一系列的函数和语义,用于在多个进程之间进行通信和同步。

MPI的主要目标是提高并行计算的速度和效率,并使得并行计算程序易于开发和维护。

本文将逐步回答关于MPI基本用法的问题,并介绍如何使用MPI进行并行计算。

1. 什么是MPI?MPI是一种用于并行计算的编程模型和库。

它由一组函数和语义组成,用于在多个进程之间进行通信和同步。

MPI旨在提高并行计算的速度和效率,并使得并行计算程序易于开发和维护。

2. MPI的基本概念是什么?MPI的基本概念是进程和通信。

每个并行计算程序都由多个进程组成,这些进程在不同的处理器上独立运行。

MPI提供了一种机制,使得这些进程能够在执行过程中进行通信和同步,以实现并行计算的目标。

3. MPI的基本通信模式有哪些?MPI提供了多种基本通信模式,包括点对点通信和集体通信。

点对点通信是指两个进程之间的直接通信,例如发送和接收消息。

集体通信是指多个进程之间的协作通信,例如广播和归约操作。

4. 如何在MPI程序中发送和接收消息?MPI提供了一对发送和接收函数,用于在进程之间发送和接收消息。

发送函数将数据从一个进程发送给另一个进程,而接收函数用于接收来自其他进程的数据。

要发送消息,可以使用MPI_Send函数,而要接收消息,可以使用MPI_Recv函数。

5. MPI如何进行同步操作?MPI提供了多种同步操作,包括阻塞和非阻塞操作。

阻塞操作意味着进程将被阻塞,直到某个操作完成。

非阻塞操作允许进程在操作进行的同时执行其他操作。

要进行阻塞同步,可以使用MPI_Barrier函数;而要进行非阻塞同步,可以使用MPI_Ibarrier函数。

6. 如何在MPI程序中使用集体通信?MPI提供了一系列的集体通信函数,用于实现多个进程之间的协作通信。

其中,广播操作将一个进程的数据发送给所有其他进程,而归约操作将多个进程的数据合并为一个结果。

openmp的使用

openmp的使用OpenMP是一种用于并行编程的编程模型,它可以帮助开发人员在共享内存系统中并行化程序。

它是一种基于指令集架构的并行编程模型,因此可以在多种平台上使用。

OpenMP的主要目标是通过利用多核处理器的并行计算能力来提高程序的性能。

在OpenMP中,程序员使用指令集来标识并行区域,并指定如何将工作分配给不同的线程。

通过使用指令集,程序员可以指定哪些部分的代码应该并行执行,以及应该有多少线程参与并行计算。

OpenMP提供了一套指令和库函数,用于管理线程的创建、同步和通信。

在使用OpenMP进行并行编程时,程序员可以使用不同的指令来指定并行区域。

例如,可以使用#pragma omp parallel指令来标识一个并行区域,其中的代码将由多个线程并行执行。

可以使用#pragma omp for指令来指定一个循环应该以并行方式执行。

还可以使用其他指令来指定线程之间的同步和通信操作。

OpenMP还提供了一些库函数,用于处理线程的创建、同步和通信。

例如,可以使用omp_get_num_threads函数来获取当前并行区域中线程的数量。

可以使用omp_get_thread_num函数来获取当前线程的编号。

还可以使用omp_barrier函数来同步线程的执行。

OpenMP还提供了一些环境变量和编译器选项,用于控制并行程序的行为。

例如,可以使用OMP_NUM_THREADS环境变量来设置并行计算时使用的线程数。

可以使用OMP_SCHEDULE编译器选项来指定循环调度策略。

这些环境变量和编译器选项可以帮助程序员优化并行程序的性能。

使用OpenMP进行并行编程时,程序员需要注意一些问题。

首先,程序员需要确保并行化的代码是可重入的,即不依赖于全局状态。

其次,程序员需要避免竞争条件,即多个线程同时访问共享数据时可能导致不确定的结果。

为了避免竞争条件,可以使用锁、原子操作或其他同步机制。

程序员还可以使用OpenMP的一些高级特性来进一步优化程序的性能。

MPI的搭建及OpenMP的配置实验指导书

MPI的搭建及OpenMP的配置实验指导书1.MPI简介消息传递接口(Message Passing Interface,MPI)是目前应用较广泛的一种并行计算软件环境,是在集群系统上实现并行计算的软件接口。

为了统一互不兼容的的用户界面,1992年成立了MPI委员会,负责制定MPI的新标准,支持最佳的可移植平台。

MPI不是一门新的语言,确切地说它是一个C和Fortran的函数库,用户通过调用这些函数接口并采用并行编译器编译源代码就可以生成可并行运行的代码。

MPI的目标是要开发一个广泛用于编写消息传递程序的标准,要求用户界面实用、可移植,并且高效、灵活,能广泛应用于各类并行机,特别是分布式存储的计算机。

每个计算机厂商都在开发标准平台上做了大量的工作,出现了一批可移植的消息传递环境。

MPI吸收了它们的经验,同时从句法和语法方面确定核心库函数,使之能适用于更多的并行机。

MPI在标准化过程中吸收了许多代表参加,包括研制并行计算机的大多数厂商,以及来自大学、实验室与工业界的研究人员。

1992年开始正式标准化MPI,1994年发布了MPI的定义与实验标准MPI 1,相应的MPI 2标准也已经发布。

MPI吸取了众多消息传递系统的优点,具有很好的可以执行、易用性和完备的异步通信功能等。

MPI事实上只是一个消息传递标准,并不是软件实现并行执行的具体实现,目前比较著名的MPI具体实现有MPICH、LAM MPI等,其中MPICH是目前使用最广泛的免费MPI系统,MPICH2是MPI 2标准的一个具体实现,它具有较好的兼容性和可扩展性,目前在高性能计算集群上使用非常广泛。

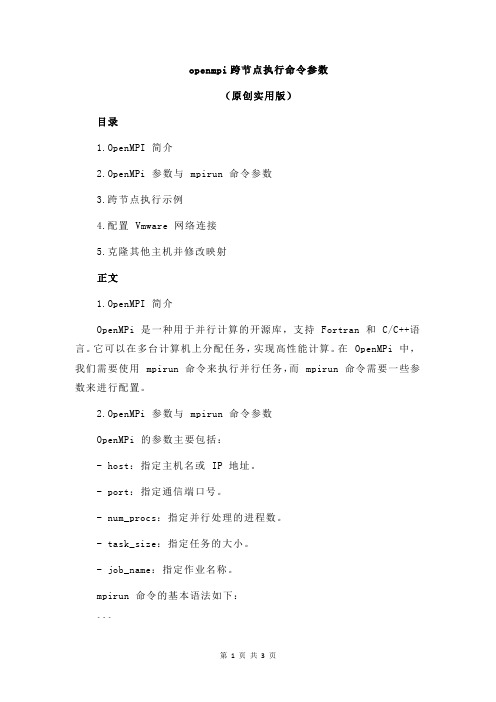

MPICH2的使用也非常简单,用户只需在并行程序中包含MPICH的头文件,然后调用一些MPICH2函数接口将计算任务分发到其他计算节点即可,MPICH2为并行计算用户提供了100多个C和Fortran函数接口,表1-1列出了一些常用的MPICH2的C语言函数接口,用户可以像调用普通函数一样,只需要做少量的代码改动就可以实现程序的并行运行,MPICH并行代码结构如图1-1所示。

mpi基本用法 -回复

mpi基本用法-回复MPI基本用法MPI(Message Passing Interface)是一种常用的并行计算编程模型,它允许在分布式内存系统中进行进程间通信。

MPI被广泛应用于科学计算、高性能计算以及大规模数据处理等领域。

本文将介绍MPI的基本用法,为大家一步一步解释如何使用MPI进行并行计算。

第一步:MPI的安装和设置1.1 安装MPI库首先,要在计算机上安装MPI库。

常用的MPI库包括Open MPI、MPICH 和Intel MPI等。

根据操作系统的不同,可以选择合适的MPI库进行安装。

1.2 环境变量设置安装完成后,需要设置相应的环境变量。

将MPI的安装目录添加到系统路径(PATH)中,以便系统可以找到MPI的执行程序。

同时,还需要设置LD_LIBRARY_PATH环境变量,以指定MPI库的位置。

第二步:MPI的编程模型MPI的编程模型基于进程间的消息传递。

每个进程都有自己的地址空间,并且可以通过MPI的函数进行相互通信。

MPI定义了一系列的函数和数据类型,用于实现进程间的消息传递和同步操作。

2.1 初始化MPI环境在开始使用MPI之前,需要调用MPI的初始化函数来建立MPI的运行环境。

可以通过以下代码来完成初始化操作:c#include <mpi.h>int main(int argc, char argv) {MPI_Init(&argc, &argv);TODO: MPI代码MPI_Finalize();return 0;}在这段代码中,`MPI_Init()`函数用于初始化MPI环境,`MPI_Finalize()`函数用于关闭MPI环境。

`argc`和`argv`是命令行参数,通过它们可以传递程序运行所需的参数。

2.2 进程间通信MPI提供了一系列的通信函数,用于实现进程间的消息传递。

常用的通信函数包括`MPI_Send()`、`MPI_Recv()`、`MPI_Bcast()`和`MPI_Reduce()`等。

OpenMP和MPI之对比知识讲解

OpenMP和MPI之对比

嵌套并行执行模型

OpenMP 采用fork-join (分叉- 合并)并行执行模式。

线程遇到并行构造时,就会创建由其自身及其他一些额外(可能为零个)线程组成的线程组。

遇到并行构造的线程成为新组中的主线程。

组中的其他线程称为组的从属线程。

所有组成员都执行并行构造内的代码。

如果某个线程完成了其在并行构造内的工作,它就会在并行构造末尾的隐式屏障处等待。

当所有组成员都到达该屏障时,这些线程就可以离开该屏障了。

主线程继续执行并行构造之后的用户代码,而从属线程则等待被召集加入到其他组。

OpenMP 并行区域之间可以互相嵌套。

如果禁用嵌套并行操作,则由遇到并行区域内并行构造的线程所创建的新组仅包含遇到并行构造的线程。

如果启用嵌套并行操作,则新组可以包含多个线程。

OpenMP 运行时库维护一个线程池,该线程池可用作并行区域中的从属线程。

当线程遇到并行构造并需要创建包含多个线程的线程组时,该线程将检查该池,从池中获取空闲线程,将其作为组的从属线程。

如果池中没有足够的空闲线程,则主线程获取的从属线程可

能会比所需的要少。

组完成执行并行区域时,从属线程就会返回到池中。

openmp手册

openmp手册OpenMP手册本文档旨在为使用OpenMP(Open Multi-Processing)编程模型的开发人员提供详细的参考指南和使用范例。

OpenMP是一套用于共享内存并行编程的API(Application Programming Interface)。

它允许程序员利用多线程并行化程序,以便在多个处理器上执行计算任务,以提高性能。

1、简介1.1 OpenMP的背景1.2 OpenMP的概述1.3 OpenMP的优势1.4 OpenMP的特性2、OpenMP基础指令2.1 并行区域(Parallel Regions)2.2 线程同步(Thread Synchronization)2.3 数据范围(Data Scoping)2.4 工作分配(Work Sharing)2.5 循环指令(Loop Directive)2.6 条件指令(Conditional Directive)2.7 函数指令(Function Directive)2.8并行性管理(Parallelism Management)3、OpenMP环境设置3.1 编译器支持3.2 编译选项3.3 运行时库3.4 环境变量4、OpenMP任务(Task)4.1 任务创建与同步4.2 任务调度4.3 任务优先级4.4 任务捕获变量5、OpenMP并行循环5.1 并行循环概述5.2 循环调度5.3 循环依赖5.4 循环优化6、OpenMP同步6.1 同步指令6.2 互斥锁6.3 条件变量6.4 同步的最佳实践7、OpenMP并行化任务图7.1 并行化任务图的概念 7.2 创建和管理任务图 7.3 数据依赖性和同步7.4 任务图调度8、OpenMP并行化内存管理 8.1 共享内存的访问模型 8.2 数据共享与私有化 8.3 内存一致性8.4 直接存储器访问模型9、OpenMP性能分析与优化9.1 性能分析工具9.2 优化技术9.3 并行编程陷阱9.4 调试OpenMP程序附件:附件一、OpenMP示例代码附件二、OpenMP编程规范附件三、OpenMP常见问题解答法律名词及注释:1、API(Application Programming Interface):应用程序编程接口,定义了软件组件之间的通信协议和接口规范。

MPI+OpenMP混合编程技术总结

MPI+OpenMP混合编程一、引言MPI是集群计算中广为流行的编程平台。

但是在很多情况下,采用纯的MPI 消息传递编程模式并不能在这种多处理器构成的集群上取得理想的性能。

为了结合分布式内存结构和共享式内存结构两者的优势,人们提出了分布式/共享内存层次结构。

OpenMP是共享存储编程的实际工业标准,分布式/共享内存层次结构用OpenMP+MPI实现应用更为广泛。

OpenMP+MPI这种混合编程模式提供结点内和结点间的两级并行,能充分利用共享存储模型和消息传递模型的优点,有效地改善系统的性能。

二、OpenMP+MPI混合编程模式使用混合编程模式的模型结构图如图1在每个MPI进程中可以在#pragma omp parallel编译制导所标示的区域内产生线程级的并行而在区域之外仍然是单线程。

混合编程模型可以充分利用两种编程模式的优点MPI可以解决多处理器问的粗粒度通信而OpenMP提供轻量级线程可以和好地解决每个多处理器计算机内部各处理器间的交互。

大多数混合模式应用是一种层次模型MPI并行位于顶层OpenMP位于底层。

比如处理一个二维数组可以先把它分割成结点个子数组每个进程处理其中一个子数组而子数组可以进一步被划分给若干个线程。

这种模型很好的映射了多处理器计算机组成的集群体系结构MPI并行在结点问OpenMP并行在结点内部。

也有部分应用是不符合这种层次模型的比如说消息传递模型用于相对易实现的代码中而共享内存并行用于消息传递模型难以实现的代码中还有计算和通信的重叠问题等。

三、OpenMP+MR混合编程模式的优缺点分析3.1优点分析(1)有效的改善MPI代码可扩展性MPI代码不易进行扩展的一个重要原因就是负载均衡。

它的一些不规则的应用都会存在负载不均的问题。

采用混合编程模式,能够实现更好的并行粒度。

MPI仅仅负责结点间的通信,实行粗粒度并行:OpenMP实现结点内部的并行,因为OpenMP不存在负载均衡问题,从而提高了性能。

OpenMP编程技术总结

OpenMP并行编程介绍一、OpenMP产生背景OpenMP是国际上继MPI之后于I998年推出的工业标准。

由DEC、IBM、lntel、Kuck&Assiciates、SGI等公司共同定义。

它解决了不同并行计算机系统上应用系统难以移植的问题,将可移植性带到可缩放的、共享主存的程序设计之中。

对不同的语言,有不同的OpenMP标准,现在基于C/C++和Fortran语言都已经更新至3.0版本。

OpenMP推出后,基本上每个包含共享体系结构的并行计算机的推出,都配置了该语言,而且多家厂商针对自己的体系结构特点还对OpenMP做了扩充,例如:COMPAQ公司扩充了分布、重分布、亲缘性调度等指标。

OpenMP则应用于共享内存的并行计算平台,它是一组编译指导语句和可调用运行时库函数的集合,可被直接嵌入源程序而无需作较大的修改,编程简单,为任一现有软件的并行转换提供了一条渐进路径。

二、OpenMP原理与特征OpenMP是一个为在共享存储的多处理机上编写并行程序而设计的应用编程接口,由一个小型的编译器命令集组成,包括一套编译制导语句和一个用来支持它的函数库。

OpenMP是通过与标准Fortran,C和C++结合进行工作的,对于同步共享变量、合理分配负载等任务,都提供了有效的支持,具有简单通用、开发快速的特点。

OpenMP是可移植多线程应用程序开发的行业标准,在细粒度(循环级别)与粗粒度(函数级别)线程技术上具有很高的效率。

对于将串行应用程序转换成并行应用程序,OpenMP指令是一种容易使用且作用强大的工具,它具有使应用程序因为在对称多处理器或多核系统上并行执行而获得大幅性能提升的潜力。

OpmMP自动将循环线程化,提高多处理器系统上的应用程序性能。

用户不必处理迭代划分、数据共享、线程调度及同步等低级别的细节。

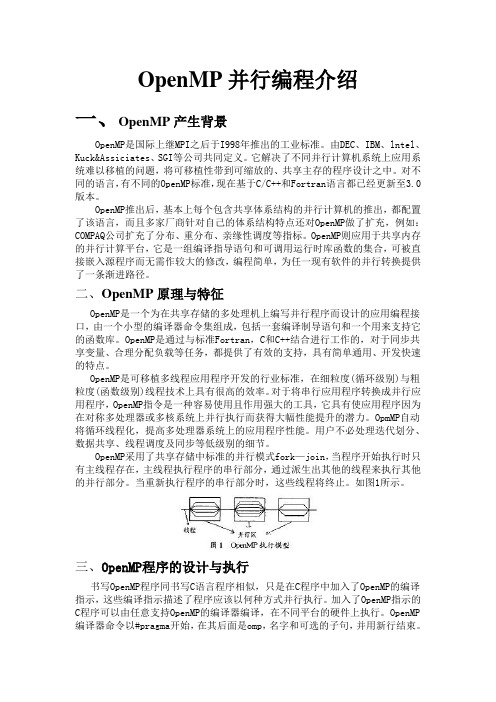

OpenMP采用了共享存储中标准的并行模式fork—join,当程序开始执行时只有主线程存在,主线程执行程序的串行部分,通过派生出其他的线程来执行其他的并行部分。

openmp原理

openmp原理OpenMP(Open Multi-Processing)是一种并行编程模型,可简化共享内存编程中多线程编程的任务。

该编程模型利用编译器扩展语法和库等工具提供并行性,使得程序员无需显式地用锁和信号量等同步机制来管理线程。

OpenMP是一个针对共享内存多处理器(SMP)系统的编程打包标准。

OpenMP允许应用程序开发者通过为程序添加特殊的编译指示来创建线程。

这些线程可以并行运行,而不需要开发者显式地进行线程管理。

这种方法可以减少开发时间和代码复杂性,并且可以简化并行化过程。

OpenMP 的原理主要基于以下三个方面:1.编译器扩展语法OpenMP允许编译器对代码进行扩展,以便在代码中添加并行化的指令。

这些指令用于指示编译器在编译期间将计算分割成子任务,并在多线程环境中执行这些子任务。

该指令可以被嵌入到C、C++和Fortran程序中。

以下是OpenMP实现的一个简单的并行 for 循环示例:```c#include <omp.h>#include <stdio.h>int i;#pragma omp parallel for num_threads(4)for (i = 0; i < 8; i++) {printf("Thread %d is running for i=%d.\n", omp_get_thread_num(), i);}return 0;}```omp_get_thread_num()指示当前线程的编号,num_threads()指定使用 4 个线程,使 for 循环分配给这 4 个线程进行并行处理。

在运行上述代码时,将看到 4 个线程交替运行。

2.运行时库OpenMP 运行时库负责管理线程、同步和共享内存访问等操作。

它位于编译器和操作系统之间,是连接应用代码的关键。

在启动程序后,运行时库会自动创建相应数量的线程,根据代码中OpenMP指令控制线程数、同步和并行化任务等。

openmpi跨节点执行命令参数

openmpi跨节点执行命令参数(原创实用版)目录1.OpenMPI 简介2.OpenMPi 参数与 mpirun 命令参数3.跨节点执行示例4.配置 Vmware 网络连接5.克隆其他主机并修改映射正文1.OpenMPI 简介OpenMPi 是一种用于并行计算的开源库,支持 Fortran 和 C/C++语言。

它可以在多台计算机上分配任务,实现高性能计算。

在 OpenMPi 中,我们需要使用 mpirun 命令来执行并行任务,而 mpirun 命令需要一些参数来进行配置。

2.OpenMPi 参数与 mpirun 命令参数OpenMPi 的参数主要包括:- host:指定主机名或 IP 地址。

- port:指定通信端口号。

- num_procs:指定并行处理的进程数。

- task_size:指定任务的大小。

- job_name:指定作业名称。

mpirun 命令的基本语法如下:```mpirun -host <host> -port <port> -num_procs <num_procs>-task_size <task_size> -job_name <job_name> <command> ```3.跨节点执行示例例如,我们有一个名为“hello_world”的简单程序,它将在每个节点上打印“Hello, World!”。

首先,我们需要创建一个名为“hello_world”的脚本文件,内容如下:```#include <mpi.h>#include <stdio.h>int main(int argc, char *argv[]) {MPI_Init(&argc, &argv);MPI_Comm_size(MPI_COMM_WORLD, &num_procs);MPI_Comm_rank(MPI_COMM_WORLD, &rank);if (rank == 0) {printf("Hello, World!");}MPI_Finalize();return 0;}```然后,我们可以使用 mpirun 命令来执行这个程序:```mpirun -host 192.168.1.10 -port 49152 -num_procs 2 -task_size 1 -job_name hello_world hello_world```在这个示例中,我们将程序运行在了两台计算机上,其中一台计算机的 IP 地址为 192.168.1.10。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Nesting OpenMP in MPI to Implement aHybrid Communication Method of ParallelSimulated Annealing on a Cluster of SMP NodesAgnieszka Debudaj-Grabysz 1and Rolf Rabenseifner 21Silesian University of Technology,Department of Computer Science Akademicka 16,44-100Gliwice,Poland agrabysz@star.iinf.polsl.gliwice.pl 2High-Performance Computing-Center (HLRS),University of StuttgartNobelstr.19,D-70550Stuttgart,Germanyrabenseifner@hlrs.de ,www.hlrs.de/people/rabenseifnerProceedings,EuroPVM/MPI 2005,Sep.18-21,Sorrento,Italy,LNCS,Springer-Verlag,2005.cSpringer-Verlag,http://www.springer.de/comp/lncs/index.html Abstract.Concurrent computing can be applied to heuristic methodsfor combinatorial optimization to shorten computation time,or equiva-lently,to improve the solution when time is fixed.This paper presentsseveral communication schemes for parallel simulated annealing,focus-ing on a combination of OpenMP nested in MPI.Strikingly,even thoughmany publications devoted to either intensive or sparse communicationmethods in parallel simulated annealing exist,only a few comparisonsof methods from these two distinctive families have been published;the present paper aspires to partially fill this gap.Implementation forVRPTW—a generally accepted benchmark problem—is used to illus-trate the advantages of the hybrid method over others tested.Key words:parallel processing,MPI,OpenMP,communication,simulated annealing1IntroductionThe paper presents a new algorithm for parallel simulated annealing—a heuristic method of optimization—that uses both MPI [9]and OpenMP [12]to achieve significantly better performance than a pure MPI implementation.This new hybrid method is compared to other versions of parallel simulated annealing,distinguished by varying level of inter-process communication intensity.Defining the problem as searching for the optimal solution given a pool of processors available for a specified period of time,the hybrid method yields distinctively better optima as compared to other parallel methods.The general reader (i.e.,not familiar with simulated annealing)will find the paper interesting as it refers to a practical parallel application run on a cluster of SMPs with the number of processors ranging into hundreds.Simulated annealing (SA)is a heuristic optimization method used when the solution space is too large to explore all possibilities within a reasonable amount2 A.Debudaj-Grabysz and R.Rabenseifnerof time.The vehicle routing problem with time windows(VRPTW)is an example of such a problem.Other examples of VRPTW are school bus routing,newspaper and mail distribution or delivery of goods to department stores.Optimization of routing lowers distribution costs and parallelization allows tofind a better route within the given time constraints.The SA bibliography focuses on the sequential version of the algorithm (e.g.,[2,15]),however parallel versions are investigated too,as the sequential method is considered to be slow when compared with other heuristics[16].In[1, 3,8,10,17]and many others,directional recommendations for parallelization of SA can be found.The only known detailed performance analyses of intensive versus sparse communication algorithms are in[4,11,13].VRPTW—formally formulated by Solomon[14],who also proposed a suite of tests for benchmarking,has a rich bibliography as well(e.g.,[16]).Nevertheless, parallel SA to solve the VRPTW is discussed only in[4,6,7].The parallel implementation of SA presented in this paper had to overcome many practical issues in order to achieve good parallel speedups and efficiency. Tuning of the algorithms for distributed as well as for shared memory environ-ment was conducted.The plan of the paper is as follows:Section2presents the theoretical basis of the sequential and parallel SA algorithm.Section3describes how the MPI and OpenMP parallelization was done,while Section4presents the results of the experiments.Conclusions follows.2Parallel simulated annealingIn simulated annealing,one searches for the optimal state,i.e.,the state that gives either the minimum or maximum value of the cost function.It is achieved by comparing the current solution with a random solution from a specific neigh-borhood.With some probability,worse solutions could be accepted as well,which can prevent convergence to local optima.However,the probability of accepting a worse solution decreases during the process of annealing,in sync with the parameter called temperature.An outline of the SA algorithm is presented in Figure1,where a single execution of the innermost loop step is called a trial. The sequence of all trials within a temperature level forms a chain.The returned final solution is the best one ever found.2.1Decomposition and communicationAlthough SA is often considered to be an inherently sequential process since each new state contains modifications to the previous state,one can isolate serialisable sets[8]—a collection of rejected trials which can be executed in any order,and the result will be the same(starting state).Independence of searches within a serialisable set makes the algorithm suitable for parallelization,where the creation of random solutions is decomposed among processors.From the communication point of view SA may require broadcasting when an acceptableNesting OpenMP in MPI to Implement a Hybrid Communication Method3 01S←GetInitialSolution();02T←InitialTemperature;03for i←1to NumberOfTemperatureReduction do04for j←1to EpochLength do05S ←GetSolutionFromNeighborhood();06∆C←CostFunction(S )-CostFunction(S);07if(∆C<0or AcceptWithProbabilityP(∆C,T))08S←S ;{i.e.,the trial is accepted}09end if;10end for;11T←λT;{withλ<1}12end for;Fig.1.SA algorithmsolution is found.This communication requirement suggests message passing as the suitable paradigm of communication,particularly if intended to run on a cluster.2.2Possible intensity of communication in parallel simulatedannealingSelection of both decomposition and communication paradigms seems to be nat-urally driven by the nature of the problem,but setting the right intensity of com-munication is not a trivial task.The universe of possible solutions is spanned by two extremes:communicating each event,where event means an accepted trial, and,independent runs method,where no event is communicated.The former method results in the single chain algorithm—only a single path in the search space is carried out,while the latter results in the multiple chains algorithm—several different paths are evaluated simultaneously(see Figure2).The location of starting points depends on implementation.Intensive communication algorithm—the time stamp method.In cur-rent research the intensive communication algorithm is represented by its speed-up optimized version called the time stamp method.The communication model with synchronization at solution acceptance events proposed in[7]was the start-ing point.The main modification,made for efficiency reasons,is to let processes work in an asynchronous way,instead of frequent computation interruptions by synchronization requests that resulted in idle time.Afterfinding an accepted trial,the process announces the event and continues its computation without any synchronization.In the absence of the mechanism which ensures that all processes are aware of the same,global state and choose the same,accepted solution,a single process can decide only locally,based on its own state and in-formation included in received rmation about the real time when the accepted solution was found—the time stamp—is used as the criterion for4choosing among a few acceptable solutions(known locally).The solution with the most recent time stamp is accepted,while older ones are rejected.From the global point of view the same solutions will be preferred.Generally,the single chain approach is believed to have two main drawbacks: only limited parallelism is exploited due to the reduction to a single search path and noticeable communication overhead.The second drawback especially re-duces the application of this method to a small number of engaged processes. Non-communication algorithm—independent runs.The main assump-tions for independent runs were formulated in[2],where the division algorithm is proposed.The method uses all available processors to run basically sequential algorithms,where the original chain is split into subchains of EpochLength(see Figure1)divided by the number of processes.At the end,the best solution found is picked up as thefinal one;thus the communication is limited to merely one reduction operation.Although the search space is exploited in a better way than in the approach described previously,very likely only a few processes work in the“right”areas while the rest perform useless computation.Additionally,excessive shortening of the chain length negatively affects the quality of results,so application of this method is not suitable for a great number(e.g.,hundreds)of engaged processes. Lightweight communication—periodically interacting searches.Recog-nizing the extreme character of the independent runs method,especially when using a large number of processes,one is tempted to look for the golden mean in the form of periodic communication.The idea was fully developed in[11].In that approach processes communicate after performing a subchain called a segment, and the best solution is selected and mandated for all of them.In this study a segment length is defined by a number of temperature decreases.As suggested in[11]to prevent search paths from being trapped in local minima areas as a result of communication,the period of the information exchange needs to be carefully selected.Additionally,the influence of the periodic exchange doesn’t always result in a positive effect and varies according to the optimized problem. Hybrid communication method—nesting OpenMP in MPI.In this study a new approach is proposed,which tries to adopt the advantages of the meth-ods mentioned above while minimizing their disadvantages.In contrast withNesting OpenMP in MPI to Implement a Hybrid Communication Method5 these methods,this implementation is intended to run on modern clusters of SMP nodes.The parallelization is accomplished using two levels:the outer par-allelization which uses MPI to communicate between SMP nodes,and the inner parallelization which uses OpenMP for shared memory parallelization within nodes.Outer-level parallelization.It can be assumed that the choice of an appropriate algorithm should be made between independent runs or periodically interacting searches,as they are more suitable for more than few processes.The maximal number of engaged nodes is limited by reasonable shortening of the chain length, to preserve an acceptable quality of results.Inner-level parallelization.Within a node a few threads can build one subchain of a length determined at the outer-level.Negligible deterioration of quality is a key requirement.If this requirement is met,the limit on the total number of processors to achieve both speed-up and preserve quality is determined by the product of the processes number limit at the outer level and the threads number limit at the inner level.An efficient implementation can also take advantage of the fact that CPUs on SMP nodes communicate by fast shared memory and communication overhead should be minimal relative to that between nodes.In this study a modified version of the simple serialisable set algorithm[8]was ap-plied(see Section3).For a small number of processors(i.e.,2to8),apart from preserving the quality of solutions,it should provide speed-up.3Implementation of communication with MPI and OpenMP3.1Intensive communication algorithmEvery message contains a solution together with its time stamp.As the assump-tion was to let the processes work asynchronously polling is applied to detect moments when data is to be received.An outline of the algorithm is presented in Figure3.In practice,as described in[7],the implementation underwent a few stages of improvement to yield acceptable speed-up.Among others:a long message containing a solution was split into two,to test the differences in performance when sending different types of data,data structure was reorganized—an array of structures was substituted by a structure of arrays,MPICH2was used since there was a bug in MPICH that prevented the program from running.3.2Non–and lightweight communication algorithmsIn case of both independent runs and periodically interacting searches methods, MPI reduction instructions(MPI Allreduce)are the best tools for exchanging the data.6 A.Debudaj-Grabysz and R.Rabenseifner01MyData.TimeStamp←0;02do in parallel03do04MPIRecv(ReceivedData,...);07if(MyData.TimeStamp<ReceivedData.TimeStamp)08update MyData and current TimeStamp;09end if;10end if;11while(there is any message to receive);12performTrial();13if(an acceptable solution was found,placed in MyData.Solution)14MyData.TimeStamp←MPISend(MyData,...);17end for;18end if;19while(not Finish);Fig.3.The outline of the intensive communication algorithm3.3Hybrid communication methodThe duality of the method is extended to its communication environment:MPI is used for communication between the nodes and OpenMP for communication among processors within a single node.The former algorithm is implemented as described in the previous section(3.2),whereas an outline of the latter one is presented in Figure4.At the inner-level,the total number of trials(EpochLength from the outer level)in each temperature step is divided into short sets of trials All trials in such a set are done independently.This modification is the basis for the OpenMP parallelization with loop worksharing.To achieve an acceptable speed-up,the following optimizations are necessary:–The parallel threads must not be forked and joined for each inner loop be-cause the total execution time for a set of trials can be too short,compared to the OpenMP fork-join overhead;–The size of such a set must be larger than the number of threads to minimize the load imbalance due to the potentially extremely varying execution time for each trial.Nevertheless,for keeping quality,the size of the set of trials should be as short as possible to minimize the number of accepted but unused trials;–Each thread has to use its own independent random number generator to minimize OpenMP synchronization points.Nesting OpenMP in MPI to Implement a Hybrid Communication Method7 01for i←1to NumberOfTemperatureReduction do02{entering OpenMP parallel region}03for j←1to EpochLength do04{OpenMP parallel for loop worksharing}05for i←0to set trialsof size;11{OpenMP end of master section}12end for;13{end of OpenMP parallel region}14T←λT;15end for;Fig.4.Parallel SA algorithm within a single node4Experimental resultsIn the vehicle routing problem with time windows it is assumed that there is a warehouse,centrally located to n customers.The objective is to supply goods to all customers at the minimum cost.The solution with lesser number of route legs(thefirst goal of optimization)is better then a solution with smaller total distance traveled(the second goal of optimization).Each customer as well as the warehouse has a time window.Each customer has its own demand level and should be visited only once.Each route must start and terminate at the ware-house and should preserve maximum vehicle capacity.The sequential algorithm from[5]was the basis for parallelization.Experiments were carried out on NEC Xeon EM64T Cluster installed at the High Performance Computing Center Stuttgart(HLRS).Additionally,for tests of the OpenMP algorithm,NEC TX-7(ccNUMA)system was used.The numer-ical data were obtained by running the program100times for Solomon’s[14] R108set with100customers and the same set of parameters.The quality of results,namely the number offinal solutions with the minimal number of route legs generated by pure MPI-based algorithms in100experiments is shown in Table1.Experiments stopped after30consecutive temperature de-creases without improving the best solution.As can be seen in the table,the in-tensive communication method gives acceptable results only for a small number of cooperating processes.Secondly,excessively frequent periodical communica-tion hampers the annealing process and deteriorates the convergence.The best algorithm for the investigated problem on a large number of CPUs,as far as the quality of results is concerned,is the algorithm of independent runs,so this one was chosen for the development of the hybrid method.8 A.Debudaj-Grabysz and R.Rabenseifnerparison of quality results for MPI based methods processes Non-comm.Periodic communication with the period of Intensiveseq94N/A N/A N/A N/A N/A N/A29795.696.296.894.296914959396939396968919182869091931094858885889682208470777774896940855660637174N/A60763046556068N/A 100603238354455N/A 200351223303837N/ANesting OpenMP in MPI to Implement a Hybrid Communication Method9 parison of quality results for hybrid and independent runs methodsTotal ed Speed No.of No.of sol.No.of No.of sol.No.of sol.of used time-up MPI with min.MPI with min.with min. processors limit processes no.of route processes no.of route no.of route [s]legs legs legssingle chain parallel SA,a time-stamp method was proposed.Based on experi-mental results the following conclusions may be drawn:–Multiple chain methods outperform single chain algorithms,as the latter lead to a faster worsening of results quality and are not scalable.Single chain methods could be used only in environments with a few processors;–The periodically interacting searches method prevails only in some specific situations;generally the independent runs method achieves better results;–The hybrid method is very promising,as it gives distinctively better results than other tested algorithms and satisfactory speed-up;–Emulated results shown need verification on a cluster of SMPs with4CPUs on a single node.Specifying the time limit for the computation,by measurements of the elapsed time,gives a new opportunity to determine the exact moment to exchange data. Such a time-based scheduling could result in much better balancing than the investigated temperature-decreases-based one(used within the periodically in-teracting searches method).The former could minimize idle times,as well as enables setting the number of data exchanges.Therefore,future work will focus on forcing a data exchange(e.g.,after90%of specified limit time),when—very likely—the number of route legs wasfinally minimized(first goal of op-timization).Then,after selecting the best solution found so far,all working processes—instead of only one—could minimize the total distance(the second goal of optimization),leading to significant improvement of the quality of results.10 A.Debudaj-Grabysz and R.RabenseifnerAcknowledgmentThis work was supported by the EC-funded project puting time was also provided within the framework of the HLRS-NEC cooperation. References1.Aarts,E.,de Bont,F.,Habers,J.,van Laarhoven,P.:Parallel implementations ofthe statistical cooling algorithm.Integration,the VLSI journal(1986)209–238 2.Aarts,E.,Korst,J.:Simulated Annealing and Boltzman Machines,John Wiley&Sons(1989)3.Azencott,R.(ed):Simulated Annealing Parallelization Techniques.John Wiley&Sons,New York(1992)4.Arbelaitz,O.,Rodriguez,C.,Zamakola,I.:Low Cost Parallel Solutions for theVRPTW Optimization Problem,Proceedings of the International Conference on Parallel Processing Workshops,IEEE Computer Society,Valencia–Spain,(2001) 176–1815.Czarnas,P.:Traveling Salesman Problem With Time Windows.Solution by Simu-lated Annealing.MSc thesis(in Polish),Uniwersytet Wroc l awski,Wroc l aw(2001) 6.Czech,Z.J.,Czarnas,P.:Parallel simulated annealing for the vehicle routing prob-lem with time windows.10th Euromicro Workshop on Parallel,Distributed and Network-based Processing,Canary Islands–Spain,(2002)376–3837.Debudaj-Grabysz,A.,Czech,Z.J.:A concurrent implementation of simulated an-nealing and its application to the VRPTW optimization problem,in Juhasz Z., Kacsuk P.,Kranzlmuller D.(ed),Distributed and Parallel Systems.Cluster and Grid Computing.Kluwer International Series in Engineering and Computer Sci-ence,Vol.777(2004)201–2098.Greening,D.R.:Parallel Simulated Annealing Techniques.Physica D,42,(1990)293–3069.Gropp,W.,Lusk,E.,Doss,N.,Skjellum,A.:A high-performance,portable im-plementation of the MPI message passing interface standard,Parallel Computing 22(6)(1996)789–82810.Lee,F.A.:Parallel Simulated Annealing on a Message-Passing Multi-Computer.PhD thesis,Utah State University(1995)11.Lee,K.–G.,Lee,S.–Y.:Synchronous and Asynchronous Parallel Simulated Anneal-ing with Multiple Markov Chains,IEEE Transactions on Parallel and Distributed Systems,Vol.7,No.10(1996)993–100812.OpenMP C and C++API2.0Specification,from /specs/13.Onbaoglu,E.,¨Ozdamar,L.:Parallel Simulated Annealing Algorithms in GlobalOptimization,Journal of Global Optimization,Vol.19,Issue1(2001)27–50 14.Solomon,M.:Algorithms for the vehicle routing and scheduling problem withtime windows constraints,Operation Research35(1987)254–265,see also /˜msolomon/problems.htm15.Salamon,P.,Sibani,P.,and Frost,R.:Facts,Conjectures and Improvements forSimulated Annealing,SIAM(2002)16.Tan,K.C,Lee,L.H.,Zhu,Q.L.,Ou,K.:Heuristic methods for vehicle routingproblem with time windows.Artificial Intelligent in Engineering,Elsevier(2001) 281–29517.Zomaya,A.Y.,Kazman,R.:Simulated Annealing Techniques,in Algorithms andTheory of Computation Handbook,CRC Press LLC,(1999)。