全结构遗传优化径向基概率神经网络

BP神经网络以及径向基网络的研究RBF毕业论文

Chen等人提出的正交最小二乘(Orthogonal Least Squares,OLS)算法,每次选择对网络输出影响最大的输入数据作为隐节点的中心,逐个加入RBF网络中,直到适当的网络构造出来为止[23]。这种方法不存在数值病态问题,简单高效,但是选择出来的网络结构不一定是最简单的。Chen又提出了正则化正交最小二乘(Regularized orthogonal least squares, ROLS),把OLS方法和正则化方法相结合,可以训练出网络结构简单泛化、性能优越的RBF网络[24]。Mao使用OLS消除隐层各单元响应的相关性[25],从而每个RBF隐层神经元的分类能力可以分别估计,此方法选择的网络结构简洁,而且隐节点的中心具有很强的分类能力。

2006年,Barreto等人提出了RBF网络基因正交最小二乘算法[39],这个算法在同一层次上混合了正交最小二乘算法和基因算法,吸收了两原始算法的长处,训练出来的RBF网络比仅试用正交最小二乘算法训练出来的网络的泛化性能要优越,而且计算复杂度小于标准遗传算法。

(7)离群点

1995年Sánchez提出了一种针对离群点的RBF网络的鲁棒学习算法[40],用定标鲁棒代价函数(Scaled Robust Loss Function,SRLF)代替通常学习算法使用的平方代价函数,然后使用共轭梯度法完成非线性优化过程,但这种算法不能自动选择隐节点的中心。1999年Chien-Cheng等提出了一种新的鲁棒RBF神经网络[41],具有高效的学习速率,合理的网络结构,可以用于拟合常数值函数,并且对离群点具有鲁棒性。1999年,刘妹琴等提出了一种结合改进遗传算法的RBF网络鲁棒学习算法[42],可以提高RBF网络的泛化性能,消除噪声影响,揭示训练数据的潜在规律,但是该算法的复杂度比较高。

径向基函数(RBF)神经网络

径向基函数(RBF)神经⽹络RBF⽹络能够逼近任意的⾮线性函数,可以处理系统内的难以解析的规律性,具有良好的泛化能⼒,并有很快的学习收敛速度,已成功应⽤于⾮线性函数逼近、时间序列分析、数据分类、模式识别、信息处理、图像处理、系统建模、控制和故障诊断等。

简单说明⼀下为什么RBF⽹络学习收敛得⽐较快。

当⽹络的⼀个或多个可调参数(权值或阈值)对任何⼀个输出都有影响时,这样的⽹络称为全局逼近⽹络。

由于对于每次输⼊,⽹络上的每⼀个权值都要调整,从⽽导致全局逼近⽹络的学习速度很慢。

BP⽹络就是⼀个典型的例⼦。

如果对于输⼊空间的某个局部区域只有少数⼏个连接权值影响输出,则该⽹络称为局部逼近⽹络。

常见的局部逼近⽹络有RBF⽹络、⼩脑模型(CMAC)⽹络、B样条⽹络等。

径向基函数解决插值问题完全内插法要求插值函数经过每个样本点,即。

样本点总共有P个。

RBF的⽅法是要选择P个基函数,每个基函数对应⼀个训练数据,各基函数形式为,由于距离是径向同性的,因此称为径向基函数。

||X-X p||表⽰差向量的模,或者叫2范数。

基于为径向基函数的插值函数为:输⼊X是个m维的向量,样本容量为P,P>m。

可以看到输⼊数据点X p是径向基函数φp的中⼼。

隐藏层的作⽤是把向量从低维m映射到⾼维P,低维线性不可分的情况到⾼维就线性可分了。

将插值条件代⼊:写成向量的形式为,显然Φ是个规模这P对称矩阵,且与X的维度⽆关,当Φ可逆时,有。

对于⼀⼤类函数,当输⼊的X各不相同时,Φ就是可逆的。

下⾯的⼏个函数就属于这“⼀⼤类”函数:1)Gauss(⾼斯)函数2)Reflected Sigmoidal(反常S型)函数3)Inverse multiquadrics(拟多⼆次)函数σ称为径向基函数的扩展常数,它反应了函数图像的宽度,σ越⼩,宽度越窄,函数越具有选择性。

完全内插存在⼀些问题:1)插值曲⾯必须经过所有样本点,当样本中包含噪声时,神经⽹络将拟合出⼀个错误的曲⾯,从⽽使泛化能⼒下降。

径向基概率神经网络的实例(实现预测分类)

径向基概率神经网络的实例(实现预测分类)径向基概率神经网络(Radial Basis Probabilistic Neural Network)是一种基于径向基函数的概率神经网络模型,可以用于预测和分类任务。

它在概率神经网络的基础上引入了径向基函数的概念,并对输出层进行了改进,使得网络具备了更好的非线性表达能力和泛化性能。

下面,我将以一个实例来介绍径向基概率神经网络的应用,包括实现预测和分类任务。

首先,假设我们有一个数据集,包含了一些人的身高和体重信息,以及他们的性别(男或女)。

我们的目标是根据人的身高和体重预测他们的性别,同时进行性别分类。

1.数据集准备:我们需要将数据集分为训练集和测试集。

假设我们有1000个样本,我们可以将800个样本作为训练集,剩下的200个样本作为测试集。

每个样本包含两个输入特征(身高和体重)和一个输出类别(性别)。

2.网络结构搭建:输入层:包含两个神经元,对应身高和体重这两个特征。

隐藏层:包含若干个径向基函数神经元,用于提取特征。

输出层:包含两个神经元,对应男性和女性两个类别。

3.网络训练:首先,我们需要对输入特征进行归一化处理,以提高模型训练的收敛速度和准确性。

然后,使用训练集对网络进行训练。

训练的过程包括以下几个步骤:-使用径向基函数对隐藏层进行初始化,初始化方法可以选用均匀分布或高斯分布。

-使用前向传播计算每个神经元的输出值。

-使用最小化损失函数的方法(如交叉熵损失函数)进行反向传播,更新网络参数。

-重复以上步骤直至达到预定的停止条件(如达到最大迭代次数或误差小于一些阈值)。

4.预测和分类:训练完成后,我们可以使用测试集对网络进行预测和分类。

对于预测任务,给定一个人的身高和体重,我们可以输入这些特征到网络中,通过前向传播计算得到网络的输出,即性别的概率。

我们可以根据输出概率选择概率值较大的性别作为预测结果。

对于分类任务,给定一个人的身高和体重,我们可以输入这些特征到网络中,通过前向传播计算得到网络的输出向量。

径向基函数神经网络课件

小批量梯度下降算法

01

总结词

小批量梯度下降算法是一种折中的方法,每次使用一小批 样本来更新模型参数,既保持了计算量小的优点,又提高 了模型的稳定性。

02 03

详细描述

小批量梯度下降算法的核心思想是在每次迭代时,随机选 择一小批样本来计算损失函数,并使用梯度下降法或其他 优化方法来更新模型参数。这种方法可以平衡计算量和训 练时间的关系,同时提高模型的稳定性。

径向基函数神经网络课件

目 录

• 径向基函数神经网络概述 • 径向基函数神经网络的基本结构 • 径向基函数神经网络的学习算法 • 径向基函数神经网络的优化策略 • 径向基函数神经网络的实现细节 • 径向基函数神经网络的实例展示 • 总结与展望

01

径向基函数神经网络概述

神经网络简介

神经网络的定义

神经网络是一种模拟人脑神经元网络结构的计算模型,通过学习样 本数据来自动提取特征和规律,并完成分类、回归等任务。

02 03

详细描述

随机梯度下降算法的核心思想是在每次迭代时,随机选择一个样本来计 算损失函数,并使用梯度下降法或其他优化方法来更新模型参数。这种 方法可以大大减少计算量和训练时间。

优缺点

随机梯度下降算法的优点是计算量小,训练时间短,适用于大规模数据 集。但是,由于只使用一个样本进行更新,可能会造成模型训练的不稳 定,有时会出现训练效果不佳的情况。

2

输出层的节点数通常与输出数据的维度相等。

3

输出层的激活函数通常采用线性函数或softmax 函数。

训练过程

01

神经网络的训练过程是通过反向 传播算法实现的。

02

通过计算损失函数对网络权重的 梯度,更新权重以减小损失函数

两种截然不同的PNN

关于两个PNN杂七杂八关于PNN其实有两种说法,一种是概率神经网络(Probabilistic Neural Network),另一种是基于产品的神经网络Product-based Neural Network,所以在使用PNN的时候要格外注意,要不然你的领导你的导师都不知道你说的是哪一个,常用的是第一种PNN,概率神经网络,北京航空航天大学的王小川老师在其著作中提到的PNN也指代的是概率神经网络下面先说概率神经网络1 概率神经网络的原理概率神经网络(Probabilistic Neural Network)的网络结构类似于RBF神经网络,但不同的是,PNN是一个前向传播的网络,不需要反向传播优化参数。

这是因为PNN结合了贝叶斯决策,来判断测试样本的类别。

1.1关于贝叶斯决策1.2关于概率神经网络的结构其网络并不算很主流的3层,而是4层图中样本特征维度为3,由上图可知,PNN的网络结构分为四层:输入层,模式层、求和层、输出层。

假设训练样本为PNN各层的作用于相互之间关系描述如下:输入层:输入测试样本,节点个数等于样本的特征维度。

感觉根据实际含义输入层中节点个数的确定依据与理由也大都同BP中的相关说法相似。

模式层:计算测试样本与训练样本中的每一个样本的Gauss函数的取值,节点个数等于训练样本的个数。

机器学习模型中,超参数是在开始学习过程之前设置值的参数这个时候不得不设定一些合适的寻址算法,相关的能够使用的寻址算法其实有很多,可以是GA算法,可以是SA(模拟退火),可以是PSO(粒子群算法),可以是AFSA(人工鱼群算法),可以是萤火虫算法,相关套路很多。

求和层:求取相同类别测试样本对应的模式层节点输出之和,节点个数等于训练样本的类别个数。

训练样本的类别个数其实就是侧面反映的label的个数输出层:对上述求和层输出进行归一化处理求取测试样本对应不同类别的概率,根据概率大小判断测试样本的类别,节点个数为1。

RBF(径向基)神经网络

RBF(径向基)神经⽹络 只要模型是⼀层⼀层的,并使⽤AD/BP算法,就能称作 BP神经⽹络。

RBF 神经⽹络是其中⼀个特例。

本⽂主要包括以下内容:什么是径向基函数RBF神经⽹络RBF神经⽹络的学习问题RBF神经⽹络与BP神经⽹络的区别RBF神经⽹络与SVM的区别为什么⾼斯核函数就是映射到⾼维区间前馈⽹络、递归⽹络和反馈⽹络完全内插法⼀、什么是径向基函数 1985年,Powell提出了多变量插值的径向基函数(RBF)⽅法。

径向基函数是⼀个取值仅仅依赖于离原点距离的实值函数,也就是Φ(x)=Φ(‖x‖),或者还可以是到任意⼀点c的距离,c点称为中⼼点,也就是Φ(x,c)=Φ(‖x-c‖)。

任意⼀个满⾜Φ(x)=Φ(‖x‖)特性的函数Φ都叫做径向基函数,标准的⼀般使⽤欧⽒距离(也叫做欧式径向基函数),尽管其他距离函数也是可以的。

最常⽤的径向基函数是⾼斯核函数 ,形式为 k(||x-xc||)=exp{- ||x-xc||^2/(2*σ)^2) } 其中x_c为核函数中⼼,σ为函数的宽度参数 , 控制了函数的径向作⽤范围。

⼆、RBF神经⽹络 RBF神将⽹络是⼀种三层神经⽹络,其包括输⼊层、隐层、输出层。

从输⼊空间到隐层空间的变换是⾮线性的,⽽从隐层空间到输出层空间变换是线性的。

流图如下: RBF⽹络的基本思想是:⽤RBF作为隐单元的“基”构成隐含层空间,这样就可以将输⼊⽮量直接映射到隐空间,⽽不需要通过权连接。

当RBF的中⼼点确定以后,这种映射关系也就确定了。

⽽隐含层空间到输出空间的映射是线性的,即⽹络的输出是隐单元输出的线性加权和,此处的权即为⽹络可调参数。

其中,隐含层的作⽤是把向量从低维度的p映射到⾼维度的h,这样低维度线性不可分的情况到⾼维度就可以变得线性可分了,主要就是核函数的思想。

这样,⽹络由输⼊到输出的映射是⾮线性的,⽽⽹络输出对可调参数⽽⾔却⼜是线性的。

⽹络的权就可由线性⽅程组直接解出,从⽽⼤⼤加快学习速度并避免局部极⼩问题。

BP神经网络以及径向基网络的研究RBF毕业论文

BP神经网络以及径向基网络的研究RBF毕业论文BP神经网络(Backpropagation Neural Network)和径向基网络(Radial Basis Function Network)是常用的神经网络模型,在许多领域都有广泛的研究和应用。

本文将从两个方面分别介绍BP神经网络和径向基网络的研究,并讨论它们的优缺点。

首先是BP神经网络的研究。

BP神经网络是一种前馈式神经网络,具有多层结构,其中包含输入层、隐藏层和输出层。

BP神经网络通过反向传播算法来训练模型,根据输入数据和期望输出之间的误差来调整网络的权重和阈值,使得模型能够逐步优化。

BP神经网络具有灵活的拟合能力和较强的普适性,可以用于解决分类、回归和预测等问题。

在BP神经网络的研究中,一些学者提出了改进的算法和结构来提升其性能。

例如,对于训练速度较慢的问题,可以使用改进的优化算法,如共轭梯度法、遗传算法等,来加速权重和阈值的更新过程。

另外,为了防止过拟合现象,可以使用正则化方法或交叉验证等技术来选择最佳的模型参数。

此外,还可以通过调整隐藏层的节点数和层数等来改进模型的表达能力和泛化能力。

接下来是径向基网络的研究。

径向基网络是一种基于径向基函数的神经网络,通常包括输入层、隐藏层和输出层。

其中隐藏层使用径向基函数作为激活函数,将输入数据映射到高维特征空间中,然后通过线性函数进行分类或回归。

径向基函数具有局部性质和非线性拟合能力,适用于解决非线性问题。

在径向基网络的研究中,一些学者提出了不同的径向基函数和网络结构来适应不同的问题。

例如,高斯函数、多项式函数和多小波函数等都被用作径向基函数的选择。

此外,也有学者研究了递归径向基网络和自适应径向基网络等改进的算法和结构。

这些方法在模型的表达能力和泛化能力方面具有一定的优势。

综上所述,BP神经网络和径向基网络是两种常见的神经网络模型,在研究和应用中具有广泛的应用。

它们分别具有灵活的拟合能力和非线性拟合能力,可以用于解决各种问题。

径向基神经网络学习算法(RBF)

Mezer chen 2018.5.9

RBF简介

1989年,Moody和Darken提出了一种由两个阶段组成的混 合学习过程的思路。

①无监督的自组织学习阶段 ②有监督学习阶段

其任务是用自组织聚类方法为隐 层节点的径向基函数确定合适的 数据中心,并根据各中心之间的 距离确定隐节点的扩展常数。 一般采用Duda和Hart1973年提 出的k-means聚类算法。

其任务是用有监督 学习算法训练输出 层权值,一般采用 梯度法进行训练。

RBF网络的工作原理

RBF网络特点

只有一个隐含层,且隐层神经元与输出层神经元的模型不同。 隐层节点激活函数为径向基函数,输出层节点激活函数为线 性函数。 隐层节点激活函数的净输入是输入向量与节点中心的距离 (范数)而非向量内积,且节点中心不可调。 隐层节点参数确定后,输出权值可通过解线性方程组得到。 隐层节点的非线性变换把线性不可分问题转化为线性可分问 题。 局部逼近网络(MLP是全局逼近网络),这意味着逼近一个输 入输出映射时,在相同逼近精度要求下,RBF所需的时间要 比MLP少。 具有唯一最佳逼近的特性,无局部极小。 合适的隐层节点数、节点中心和宽度不易确定。

RBF神经网络中心选取

① 从样本输入中选取中心

一般来说,样本密集的地方中心点可以适当多些,样本 稀疏的地方中心点可以少些;若数据本身是均匀分布的,

中心点也可以均匀分布。总之,选出的数据中心应具有代

表性。径向基函数的扩展常数是根据数据中心的散布而确 定的,为了避免每个径向基函数太尖或太平,一种选择方 法是将所有径向基函数的扩展常数设为

d max 2I

② 自组织选取中心法

常采用各种动态聚类算法对数据中心进行自组织选择,在

径向基神经网络的介绍及其案例实现

径向基神经网络的介绍及其案例实现径向基(RBF)神经网络是一种常用的人工神经网络模型,它以径向基函数作为激活函数来进行模式分类和回归任务。

该网络在模式识别、函数逼近、数据挖掘等领域都具有良好的性能,并且具有较好的泛化能力。

引言:径向基(RBF)神经网络最早是由Broomhead和Lowe于1988年引入的,它是一种前馈式神经网络。

RBF神经网络的主要思想是以输入向量与一组高斯函数的基函数作为输入层,然后再通过隐藏层进行特征映射,最后通过输出层进行模式分类或回归。

1.RBF神经网络的结构:RBF神经网络包括输入层、隐藏层和输出层三层。

输入层负责接收输入向量,隐藏层负责特征映射,输出层负责输出结果。

输入层:输入层接收具有所要分类或回归的特征的数据,通常使用欧几里德距离计算输入层的神经元与输入向量之间的距离。

隐藏层:隐藏层是RBF神经网络的核心部分,它通过一组径向基函数来进行特征映射。

隐藏层的神经元数量通常和训练样本数量相同,每个神经元负责响应一个数据样本。

输出层:输出层根据隐藏层的输出结果进行模式分类或回归预测,并输出网络的最终结果。

2.RBF神经网络的训练:RBF神经网络的训练主要包括两个步骤:聚类和权值调整。

聚类:首先通过K-means等聚类算法将训练样本划分为若干个类别,每个类别对应一个隐藏层神经元。

这样可以将输入空间划分为若干个区域,每个区域中只有一个样本。

权值调整:通过最小化残差误差或最小化目标函数来优化隐藏层和输出层的权值。

常用的优化算法有最小二乘法、梯度下降法等。

3.RBF神经网络的案例实现:案例1:手写数字识别案例2:股票市场预测RBF神经网络也可以应用于股票市场的预测。

该案例中,RBF神经网络接收一组与股票相关的指标作为输入,通过隐藏层的特征映射将指标转化为更有意义的特征表示,最后通过输出层进行未来股价的回归预测。

该系统的训练样本为历史股票数据以及与之对应的未来股价。

结论:径向基(RBF)神经网络是一种应用广泛且效果良好的人工神经网络模型。

径向基神经网络学习算法

径向基神经网络学习算法径向基神经网络(Radial Basis Function Neural Network, RBF)是一种人工神经网络,常用于模式识别、函数逼近和分类问题等。

它的核心思想是利用径向基函数对输入数据进行映射,并通过训练来优化网络参数。

本文将介绍径向基神经网络的学习算法,并解释其算法步骤。

以下是径向基神经网络学习算法的步骤:1.数据预处理:将原始数据划分为训练集和测试集。

通常,训练集用于训练网络参数,而测试集用于评估网络性能。

2. 参数初始化:初始化径向基函数的中心和宽度,通常可以使用聚类算法(如K-means)对训练集进行聚类,其中每个聚类中心作为一个径向基函数的中心。

宽度可以根据聚类结果设置为聚类中心之间的最大距离。

3.训练隐含层权重:对于每个训练样本,计算其到每个径向基函数中心的距离,并将距离作为隐含层神经元的输入。

可以选择不同的径向基函数,常用的包括高斯函数和多项式函数。

然后,通过解线性回归问题,以最小化误差来调整隐含层的权重。

5.网络评估:使用测试集评估网络性能。

可以使用各种指标(如精确度、召回率和均方根误差)来评估网络的准确性和鲁棒性。

径向基神经网络的优点是可以处理非线性问题,并且在训练过程中可以进行参数的在线调整。

此外,它还避免了梯度消失问题。

然而,径向基神经网络也有一些缺点,如需要选择合适的径向基函数和确定合适的隐含层神经元数量。

在实际应用中,径向基神经网络在模式识别、函数逼近和分类问题等方面取得了很多成功。

它可以用于人脸识别、语音识别、股票预测和异常检测等领域。

总之,径向基神经网络是一种有效的学习算法,可以用于解决非线性问题。

通过合适的参数初始化和训练过程,它可以准确地拟合数据,并在实际应用中获得良好的性能。

rbf神经网络原理

rbf神经网络原理

RBF神经网络,即径向基函数神经网络,是一种常用的神经网络模型。

它的核心思想是通过选择合适的基函数来近似非线性函数关系,从而实现对复杂模式的学习与分类。

RBF神经网络由三层组成:输入层,隐含层和输出层。

输入层接收外部输入的数据,每个输入节点对应一个特征。

隐含层是RBF神经网络的核心,其中的每个神经元都是一个径向基函数。

在隐含层中,每个神经元都有一个中心向量和一个标准差,用于确定其基函数的形状和大小。

通过计算输入向量与神经元中心之间的距离,再经过基函数的转换,即可得到神经元的输出。

输出层是整个神经网络的分类器,它通常采用线性组合来产生最终的输出。

常见的方法是采用最小均方误差(MSE)准则函数来训练神经网络,通过调整神经元中心和标准差的参数,以最小化实际输出与期望输出之间的误差。

RBF神经网络具有以下优点:

1. 相较于传统的前馈神经网络,RBF神经网络对线性可分和线性不可分问题的逼近能力更强。

2. RBF神经网络的训练速度较快,且容易实现并行计算。

3. 网络结构简单,参数少,不容易出现过拟合问题。

4. 对于输入输出空间中的噪声和干扰具有较强的鲁棒性。

总而言之,RBF神经网络通过径向基函数的选取,能够有效地近似非线性函数,并在模式分类等任务中取得较好的结果。

神经网络算法优化研究

神经网络算法优化研究随着信息时代的发展,数据量的不断增加和复杂度的加大,人们需要更加高效的算法来处理数据,神经网络算法成为了热门的研究方向。

神经网络算法优化研究,就是通过优化神经网络算法,提高其处理数据的精度和效率。

本文将从神经网络算法的发展、优化技术、优化方法以及未来趋势四个方面介绍神经网络算法优化研究。

一、神经网络算法的发展神经网络是模拟人类神经系统的计算机系统。

在已有的数据集上,通过训练使其自主学习识别特征。

神经网络算法的原理是模拟人脑的神经元,通过大量的样本和不断的迭代训练,提取数据的各个特征,从而达到分类或者预测的目的。

二、神经网络算法优化技术神经网络算法优化技术主要包括正确的神经网络结构设计、合理的算法选择和优化算法的应用,其中神经网络结构设计是关键。

1. 神经网络结构设计神经网络结构设计可以分为前馈神经网络和循环神经网络两种结构。

前馈神经网络是最常见的结构,数据的传输是单向的,输出端只与输入端相连,没有回路;循环神经网络则是有回路的神经网络,能够实现短期记忆之类的功能,但相应的优化难度也较大。

2. 算法选择目前,常用的神经网络算法有BP(反向传播算法)、RBF(径向基核函数神经网络)和SVM(支持向量机)等。

BP算法是最常用的神经网络优化算法,其优点就是梯度下降算法可以快速找到一个全局最优值。

RBF神经网络借助径向基核函数,支持变换后的特征,能够更好地学习数据,但对高维数据不太友好。

SVM能够很好地处理高维数据,具有良好的泛化能力。

3. 优化算法的应用优化算法是神经网络算法中最为重要的一步。

目前常用的优化算法包括遗传算法、蚁群算法、粒子群算法等。

遗传算法和蚁群算法以及粒子群算法基于不同的奖惩制度,通过迭代寻找最优解。

优化算法的选择将直接决定神经网络算法的精度和处理效率。

三、神经网络算法的优化方法优化神经网络算法,需要从不同的角度考虑。

以下分别介绍几种常用的优化方法。

1. 学习率变化学习率变化是常见的优化方法,可以通过缩小学习率,使训练达到更优的结果,可以起到加速收敛和防止震荡的作用。

基于遗传算法的径向基神经网络学习算法

、

y ,

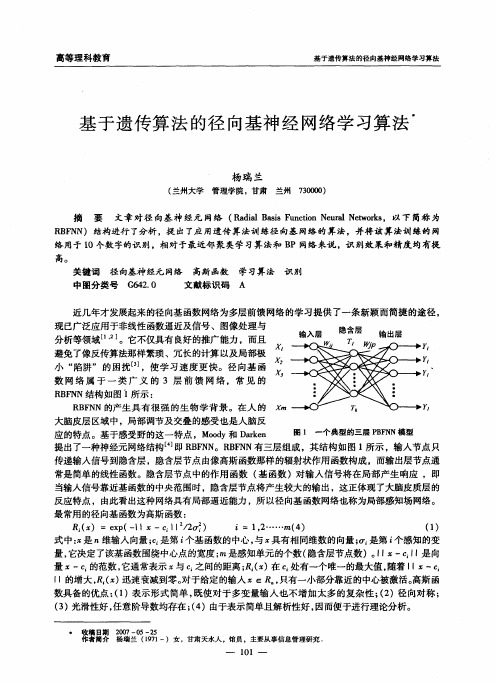

图 1 一个典型的三层 P F N模 型 BN 应 的特点 。基 于感 受野 的这 一 特点 ,Mod oy和 D re akn 提出了一种神经元网络结构 即 R F N B N B N 。R F N有三层组成 ,其结构如图 l 所示 ,输入节点只

高等理科教育

基于 传 法的 基 经网 学习 法 遗 算 径向 神 络 算

基 于遗传算 法 的径 向基神经 网络学 习算法

杨 瑞 兰

( 兰州大学 管理学 院 ,甘肃 兰州 7 0 0 ) 30 0

摘 要 文章对 径 向基神 经元 网络 ( ai ai F ntnN u l e o s R da B s uco er t r ,以下 简称 为 l s i aN w k

・ 收稿 日期 2 0 0 7—0 5—2 5 作者简介 杨瑞兰 ( 9 1 17 一)女 ,甘肃天水人 。 馆员 ,主要从 事信息

高等理 科教 育

28 0 年第5 ( 第8期) 0 期 总 1

一

、

R F N学习算法简介 BN

R F神经网络的学习算法主要有 :随机算法 、自组织学习算法和最 近邻聚类学 习算法 ,它 B

RFN B N )结构进行 了分析 ,提 出了应用遗传算法训练径 向基 网络的算法,并将 该算法训练的 网 络 用于 l 0个数字的识另 ,相对于最近邻聚类学习算法和 B l 3 P网络来说 ,识 剐效果和精度 均有提

径向基概率神经网络的结构优化算法研究

【 src]h ai1 ai poa isi nua n tok (B NN ianvled fr adnua n tokm dl eeoe rm terda b s AbtatT erda b s rb blt erl ew r R P )s o e fe—ow r erl ew r o e d vl df a i ai s ic p o h l s

lt rn urln t r d l.ti e d li o h d a tg ss c slwe o uain c mplxt n a trc n eg n p e .Th lo i ms at e a ewok mo es hsn w mo e s ft ea v na e u h a o rc mp tt o e o e i a d fse o vr e ts e d y eag rt h

【 关键 词】 向基概率神经网络 ; 径 递推 正Βιβλιοθήκη 最小二 乘算 法; 梯度 学习算法

RE E S ARC ON HEALG0RI HM oR T CT E OP I I H T T F S RU UR T M ZAT ON HE AD AL B I ROB I I T C N RAL I OFT R I ASSP AB L S I EU

【 yw r sT erda b s rb bl t e rl e ok; c r v r oo a lat q aea o tm; a i tbsdagrh Ke o d ]h a i ai poa iscn ua t rs eus eot gnl essu r grh g de - ae oi m; l s ii nw r i h l i r n l t

遗传算法在神经网络结构优化中的应用

遗传算法在神经网络结构优化中的应用随着人工智能的不断发展,神经网络技术愈发重要。

神经网络中的结构对于算法的性能和鲁棒性有着极大的影响。

针对不同的问题,不同的神经网络结构会呈现不同的优势。

但是如何找到最佳的神经网络结构仍然是一个广泛关注的问题。

随着遗传算法的出现,它被广泛地应用在神经网络结构的优化中。

本文将介绍遗传算法在神经网络结构优化中的应用。

一、神经网络结构优化神经网络结构优化的目的是通过找到最优的神经网络结构来提高网络的性能。

以分类问题为例,网络的性能通常可以用分类准确率来衡量。

在结构中,包含了神经元的数量、层数、激活函数等组成要素。

但是结构的优化是一个十分困难的问题。

基于精密的数学模型的优化问题通常可以通过求解解析解的方法快速确定。

但是神经网络结构的优化问题相当复杂,无法用解析方法求解。

此外,神经网络的性能难以直接计算,通常需要通过训练集和测试集的分类准确率来进行预测。

所以,可以通过试错来寻找最佳的神经网络结构。

不过,这种方法往往需要大量的计算资源和耗费大量的时间。

因此,科学家们开始寻找一些更为有效的方法,来提高神经网络结构的优化效率。

二、遗传算法遗传算法是一种仿生算法,其灵感来源于生物进化过程中的基因遗传過程。

遗传算法的主要思路是通过创造“个体”、环境选择和遗传方法结合的方式,逐步迭代出更优秀的解决方案。

在经过多次迭代后,遗传算法能够找到最优解(或者达到更优近似解)。

基于遗传算法的优点,科学家们开始将其应用在神经网络结构的优化中。

以“群体创新”为核心思想的遗传算法可以大幅提高神经网络结构优化的效率。

三、遗传算法在神经网络的应用在神经网络结构的寻优过程中,遗传算法的主要任务是搜索最优的结构。

一般来讲,遗传算法选择的参数包括神经元的数量、网络的层数和激活函数等。

遗传算法通常考虑的是在上一代神经网络结构的基础上进行修改。

首先,遗传算法生成一组随机解,也就是神经网络结构的种群。

然后,对这一组解进行评估,并仅仅选择其中最优秀的结构。

径向基(Radialbasisfunction)神经网络、核函数的一些理解

径向基(Radialbasisfunction)神经⽹络、核函数的⼀些理解径向基函数(RBF)在神经⽹络领域扮演着重要的⾓⾊,如RBF神经⽹络具有唯⼀最佳逼近的特性,径向基作为核函数在SVM中能将输⼊样本映射到⾼维特征空间,解决⼀些原本线性不可分的问题。

本⽂主要讨论:1. 先讨论核函数是如何把数据映射到⾼维空间的,然后引⼊径向基函数作核函数,并特别说明⾼斯径向基函数的⼏何意义,以及它作为核函数时为什么能把数据映射到⽆限维空间。

2.提到了径向基函数,就继续讨论下径向基函数神经⽹络为什么能⽤来逼近。

再看这⽂章的时候,注意核函数是⼀回事,径向基函数是另⼀回事。

核函数表⽰的是⾼维空间⾥由于向量内积⽽计算出来的⼀个函数表达式(后⾯将见到)。

⽽径向基函数是⼀类函数,径向基函数是⼀个它的值(y)只依赖于变量(x)距原点距离的函数,即;也可以是距其他某个中⼼点的距离,即. . 也就是说,可以选定径向基函数来当核函数,譬如SVM⾥⼀般都⽤⾼斯径向基作为核函数,但是核函数不⼀定要选择径向基这⼀类函数。

如果感觉这段话有点绕没关系,往下看就能慢慢体会了。

为什么要将核函数和RBF神经⽹络放在⼀起,是希望学习它们的时候即能看到它们的联系⼜能找到其差别。

⼀.由⾮线性映射引⼊核函数概念,之后介绍⾼斯径向基及其⼏何意义。

预先规定是⼀个⾮线性映射函数,能够把空间中任⼀点,映射到空间中。

下⾯先⽤⼀个例⼦说明这种映射的好处。

例:假设⼆维平⾯上有⼀些系列样本点,他们的分布近似是⼀个围绕着原点的圆(见图1)。

那么在这个⼆维的样本空间⾥,这些样本点满⾜的曲线⽅程为:如果设⾮线性映射为:那么在映射后的的空间⾥,曲线⽅程变成了:这意味着在新空间⾥,样本点是分布在⼀条近似直线上的,⽽不是之前的圆,很明显这是有利于我们的。

图1.左图为原来的x所在的⼆维空间,右图为映射后的新的y空间继续这个例⼦,我们已经知道了映射关系,那么在y空间中的向量内积会是什么样⼦的呢?注意公式⾥的各种括号。

概率神经网络

• 多源异构数据融合:在实际应用中,数据往往来自多个源和具有不同的形式和 结构。如何设计概率神经网络模型以有效地融合多源异构数据,提取有用信息 并进行概率推断,是一个值得探索的研究方向。

特点

概率神经网络具有强大的概率建模能力,能够学习到数据的内在结构和概率分 布,同时利用神经网络的非线性映射能力,能够处理复杂的、非线性数据。

概率神经网络的应用领域

分类

概率神经网络广泛应用于分类问 题,如图像分类、语音识别、自

然语言处理等。

回归

概率神经网络也可用于回归问题, 如预测股票价格、预测天气等。

概率神经网络需要大量的标注数据进行训 练,对于数据稀疏或标注成本高的任务可 能不太适用。

模型解释性差

稳定性问题

概率神经网络通常比传统的神经网络模型 更加复杂,导致模型解释性较差,难以理 解模型内部的决策机制。

概率神经网络的训练过程可能不稳定,容 易受到噪声和异常值的影响,导致模型性 能下降。

如何克服概率神经网络的局限性

异常检测

概率神经网络通过学习数据的内在 结构和概率分布,能够检测出异常 数据,如金融欺诈检测、网络安全 监测等。

概率神经网络的发展历程

早期发展

概率神经网络最早可以追溯到上世纪80年代,随着神经网络的兴起,研究者开始尝试将概率模型与神经网络相结 合。

近期进展

近年来,随着深度学习技术的快速发展,概率神经网络在理论和应用方面都取得了重要进展。研究者不断提出新 的模型和算法,提高了概率神经网络的性能和实用性。同时,随着大数据和云计算技术的发展,概率神经网络在 各个领域的应用也越来越广泛。

径向基函数神经网络的训练与预测

径向基函数神经网络的训练与预测近年来,人工智能技术的快速发展使得神经网络成为了热门的研究领域之一。

径向基函数神经网络(Radial Basis Function Neural Network,简称RBFNN)作为一种非常有效的神经网络模型,被广泛应用于各种领域的训练与预测任务中。

RBFNN是一种前向反馈神经网络,其神经元模型的激活函数采用径向基函数。

径向基函数是一种基于距离的非线性函数,常用的径向基函数有高斯函数、多项式函数等。

RBFNN的训练与预测过程相对简单,但却能够提供较高的准确性和泛化能力。

在RBFNN的训练过程中,首先需要确定网络的结构。

网络结构包括输入层、隐藏层和输出层。

输入层接收外部数据,并将其传递给隐藏层。

隐藏层中的神经元使用径向基函数计算输入数据与神经元中心之间的距离,并将计算结果作为激活函数的输入。

输出层根据隐藏层的输出进行计算,并产生最终的预测结果。

确定网络结构后,接下来需要进行权重的训练。

权重的训练过程可以通过最小二乘法、梯度下降法等方法进行。

最小二乘法是一种常用的训练方法,它通过最小化预测结果与实际结果之间的误差来调整权重。

梯度下降法则是一种迭代的优化算法,通过不断调整权重来最小化损失函数。

RBFNN的预测过程相对简单,只需要将输入数据传递给网络,并根据输出层的结果进行预测。

由于RBFNN具有较强的非线性拟合能力,因此在许多实际应用中取得了良好的效果。

例如,在股票市场的预测中,RBFNN能够根据历史数据和市场情况准确预测未来的股价走势。

除了股票市场预测外,RBFNN还被广泛应用于其他领域,如医学诊断、图像识别、语音识别等。

在医学诊断中,RBFNN可以根据患者的病历数据和临床特征,准确预测患者是否患有某种疾病。

在图像识别中,RBFNN可以通过学习大量图像数据,实现对图像内容的准确分类和识别。

在语音识别中,RBFNN可以根据语音信号的频谱特征,实现对语音内容的准确识别和理解。

径向基函数神经网络模型及其在预测系统中的应用

径向基函数神经网络模型及其在预测系统中的应用概述:径向基函数神经网络(Radial Basis Function Neural Network, RBFNN)是一种基于神经网络的非线性模型,具有广泛的应用领域。

在预测系统中,RBFNN能够准确预测未知输入与输出之间的关系,从而为预测问题的解决提供了有效的方法。

一、径向基函数神经网络模型的基本原理1.1 RBFNN的结构径向基函数神经网络由输入层、隐含层和输出层构成。

输入层接受原始数据,隐含层通过径向基函数对输入数据进行转换,输出层将转换后的数据映射到期望的输出。

1.2 径向基函数的选择径向基函数的选择对RBFNN的性能有重要影响。

常用的径向基函数有高斯函数、多项式函数和细分函数等。

根据问题的需求和特点选择合适的径向基函数,以提高模型的预测能力。

1.3 模型的训练与优化通过使用已知输入与输出的训练数据,结合误差反向传播算法,可以对RBFNN的参数进行学习和优化。

训练的目标是使得模型的输出与实际输出之间的误差最小化,从而提高预测的准确性。

二、径向基函数神经网络模型在预测系统中的应用2.1 股票市场预测股票市场价格的预测一直是金融领域的研究热点。

RBFNN通过学习历史价格与因素的关系,能够预测未来的股票价格走势。

通过准确的预测,投资者可以做出更明智的决策,提高投资回报率。

2.2 污染物浓度预测环境污染是当今社会面临的严重问题之一。

RBFNN可以利用区域内的环境数据,如气象数据、监测数据等,预测出某个时刻某地区的污染物浓度。

这有助于预警系统的建立,提前采取措施避免污染的扩散。

2.3 交通流量预测交通流量的预测在城市交通管理中具有重要意义。

通过收集历史交通流量和相关影响因素的数据,RBFNN能够准确预测未来某个时间段某条道路的交通流量。

这有助于交通规划和拥堵疏导的决策。

2.4 预测市场需求在制造业和零售业等领域,准确预测市场的需求对企业决策具有重要影响。

RBFNN可以通过学习历史销售数据和市场因素的关系,预测未来某段时间内产品的需求量。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

1 遗传算法的构造

通常 ,设计遗传算法时需要遵循以下几个步骤 , 即确定编码方式 、 构造适应度函数 、 选择 ( 繁殖) 策略 的确定 、 设计遗传算子等 . 下面我们来详细讨论针对 RBPNN 全结构优化时 G A 的设计 . 1. 1 染色体编码 如何选择 RBPNN 第一隐层必需的隐中心矢量及 核函数控制参数是设计的关键 . 隐中心矢量的选择不

第 23 卷第 2 期 2004 年 4 月 文章编号 :1001 - 9014 (2004) 02 - 0113 - 06

红外与毫米波学报

J . Infrared Millim. Waves

Vol. 23 , No. 2 April ,2004

全结构遗传优化径向基概率神经网络

赵温波1 ,2 , 黄德双2

© 1995-2004 Tsinghua Tongfang Optical Disc Co., Ltd. All rights reserved.

114

n

i

红外与ห้องสมุดไป่ตู้米波学报

23 卷

hj ( xj ) =

j =1

∑< ( ‖x

ij

i

). - c ij ‖ 2 ,σ

( 2)

其中 , ni 为网络第一隐层第 i 个类别的隐中心矢量 数 ; cij是第一隐层第 i 个类别第 j 个隐中心矢量 ; ‖ ・ ) 为第一隐 ‖ 2 为 22范数 ,σ为核函数控制参数 ; < ( ・ 层的非线性映射函数 ( 核函数) ,通常取高斯形式 ,即 2 2 ) = exp ( - ‖x - c ij ‖ ). <ij ( ‖x - c ij ‖ / 2σ 2 ,σ

( 3)

图1 染色体编码结构 Fig. 1 The decoding scheme of the individual

隐中心矢量和核函数控制参数是 PBPNN 的主 要结构参数 ,是其性能发挥的关键 . 如果把所有训练 样本都作为隐中心矢量 ,尽管有可能使得 RBPNN 收 敛到满意的精度 ,但这会使得网络结构过于庞大 ,造 成训练和测试时间过长 . 核函数控制参数的作用机 理与人类视神经系统的感受极为相似 ,取值过大 ,则 只能观察到目标的 “概貌” ,很难分辨其细微特征 ,反 之 ,得到的只是目标的局部信息 ,而无法了解整体情 况 . 因此 , 如何找到合适的核函数控制参数 , 使得 RBPNN 在不损失网络性能的条件下 , 得到最小的网 络规模是本文研究的重点 . 遗传算法 ( Genetic Algorithm ,简称 G A) 是一种模 拟自然选择和遗传机制 , 在计算机上实现的概率性 全局寻优搜索算法 . 同其它的传统优化方法相比 , G A 不仅具有搜索区域宽 、 效率高等优点 , 重要的是 G A 无需计算梯度等启发信息 ,因而对求解的目标函 数也没有严格的限制 ,不要求目标函数具有连续 、 可 微等数学条件 . 对于 RBPNN 来说 , 由于结构中必需 的隐中心矢量和核函数控制参数受多种因素所制 约 ,属于多目标优化问题 ,很难用精确的数学模型来 求解 ,即使能把模型解析式表达出来 ,也无法满足可 微、 连续等严格的数学条件 ,从而不能采用传统的最 优化方法来解决 . 而 G A 在这方面却没有严格的限 制 ,它只要求被求解问题具有可比性就可以了 . 因 此 ,本文讨论使用 G A 来实现 RBPNN 的全结构优 化.

1. 2 适应度函数构造 RBPNN 结构优化的目标是 , 在满足网络收敛误

3

5J 5 J ( W) T ( ) = 5 w uv M ×M = - H D - HW , 5W 如果希望 J ( W ) 取得最小值 ,令 5 J ( W) = 0, 5W 即

- H D + H HW = 0 ,

T T

输入样本的非线性划分 ; 第二隐层对第一隐层的输 出进行有选择性的求和与聚类 . 假定 RBPNN 第二隐 层和输出层各有 M 个结点 ,即输出有 M 个模式 ,共 有 N 个训练样本参与训练 , 则 RBPNN 的映射方程 为 ( 1) Y = HW . 其中 , Y = [ y ij ] N ×M 、 H = [ h ij ] N ×M 、 W = [ w ij ] M ×M 分 别为实际输出矩阵 , 第二隐层输出矩阵和第二隐层 与输出层间的连接权重矩阵 . 对应于输入样本 xi , 第二隐层的第 j 个单元输出可以表示为

RADIAL BASIS PROBABILISTIC NEURAL NETWORKS OF GENETIC OPTIMIZATION OF FULL STRUCTURE

ZHAO Wen2Bo1 ,2 , HUANG De2Shuang2

(1. Institute of Intelligent Machines , Chinese Academy of Sciences , Hefei 230031 , China ; 2. Artillery Academy of People Liberation Army , Hefei 230031 , China) Abstract :The genetic algorithm was used to optimize the full structure radial basis probabilistic neural networks( RBPNN) , includ2 ing selecting the hidden centers vectors of the first hidden layer and determining the matching controlling parameters of kernel func 2 tion of RBPNN. The proposed genetic encoding method not only completely embodies the space distribution characterizes of pattern samples , but also simultaneously achieves the optimum number of the selected hidden centers vectors and the matching controlling parameters of the kernel function. The novelly constructed fitting function can efficiently control the error accuracy of the RBPNN output. The experimental results show that the algorithm effectivelfies simpliy the structure of PBPNN. Key words :radial basis probabilistic neural networks ; genetic algorithms ; full structure optimization ; hidden centers vectors

(1. 中国科学院合肥智能机械研究所 ,安徽 合肥 230031 ; 2. 解放军炮兵学院 ,安徽 合肥 230031)

摘要 : 使用遗传算法来实现径向基概率神经网络 ( RBPNN) 的全结构遗传优化 , 包括优选网络第一隐层节点数和求 取匹配的核函数控制参数 . 提出了适用于 RBPNN 的染色体编码方式 ,不仅使得所选隐中心矢量充分体现了模式样 本的空间分布特征 ,同时还能够获得隐中心矢量的最佳数目及匹配的核函数控制参数 . 新构造的适应度函数能够 有效地控制网络输出的误差精度 . 实验结果表明 ,该算法有效地简化了 RBPNN 模型的结构 . 关 键 词 :径向基概率神经网络 ; 遗传算法 ; 全结构优化 ; 隐中心矢量 中图分类号 :TP183 文献标识码 :A

( 10)

( 11)

差的条件下 ,尽可能少选隐中心矢量 ,同时查找最匹 配的核函数控制参数 . 所以在适应度函数构造的过 程中 ,隐中心矢量的数目 、 给定的误差精度及每个个 体的实际误差都必须同时考虑 . 根据适应度函数最 大化原则 ,在满足给定的误差标准时 ,个体的适应度 值应该随着选择的隐中心矢量数目的增加而减少 . 但是 ,当某一个体对应的网络实际误差超过给定的 误差标准时 ,说明该个体的隐中心矢量的选取不合 适或者相应的核函数控制参数的取值不当 , 这时该 个体的适应度值应该取 0 , 不必再去探讨隐中心矢 量分布及相应的控制参数取值 . 所以本文的适应度 函数定义如下

仅与数目有关 ,还与其空间分布有关 . 一般希望 ,在不 损失网络收敛精度的条件下 ,选择的隐中心矢量在数 目上要尽可能少 . 因为较少的隐中心矢量不仅能简化 网络的训练和测试过程 ,而且还可以改善推广能力 . 核函数控制参数取值与隐中心矢量的数目及分布密 切相关 ,二者共同作用于 RBPNN 的第一隐层 ,相互依 存 ,互为补充 . 有鉴于此 ,在确定染色体编码方式时 , 应该同时考虑隐中心矢量及核函数控制参数 ,期望满 足网络精度且得到隐中心矢量数目最少这一优化目 标时 ,找出最佳的隐中心矢量数目及空间分布以及最 佳匹配的核函数控制参数取值 . 为此 ,本文提出一种如图 1 所示的新编码方式 . 考虑到隐中心矢量与控制参数的优化目标不同 , 采 用二进制与实数混合编码来构造染色体 . 图中前 p 个二进编码代表备选的隐中心矢量 “ , 1” 表示样本被 选择 ,而 “0” 表示不被选择 , 染色体中二进制基因位 中的 “1” 的个数即表示选择的隐中心矢量的数目 . 后 t 个实数编码代表与隐中心矢量相匹配的核函数控 制参数 . 对于实数基因 , 我们采用十进制数编码 , 用 t 个十进制数代表核函数控制参数 . 采用十进制数 编码主要是为了提高对核函数控制参数的求解精 度 ,使其与选取的隐中心矢量精确匹配 . 但固定长度 的十进制数编码还是只能代表有限范围的核函数控 制参数 ,从算法的通用性方面来考虑 ,需要对该编码 所代表的实数进行变换 , 使其对所有问题具有普遍 的适用性 ,为此 ,我们增加了量程系数对编码实数进 行扩展或压缩 ,使其所代表的核函数控制参数能够 覆盖整个正实数空间 . 假定 t 个十进制数编码只代 表为取值介于 0 与 1 之间的实数 R , 令量程系数为 k ,则求解的核函数控制参数实际取值为 σ = k ・R . ( 4) 其中 ,量程系数 k 可能取值为 1 ,10 ,100 , … . 针对不 同的求解问题 ,量程系数可能取值不同 . 为了实现算 法的可操作性 ,本文给出如下的启发性表达式来求 取量程系数 k ,即