基于决策树算法的爬虫识别技术

Python网络爬虫的数据挖掘与机器学习应用

Python网络爬虫的数据挖掘与机器学习应用Python作为一种强大的编程语言,被广泛应用于网络爬虫、数据挖掘和机器学习等领域。

本文将探讨Python在网络爬虫中的应用,以及如何利用数据挖掘和机器学习算法对爬取到的数据进行分析和预测。

一、Python网络爬虫的应用1. 网络爬虫的定义和原理网络爬虫是一种自动化的程序,可以模拟人的行为在互联网上抓取信息。

其原理主要是通过发送HTTP请求,获取网页的HTML源代码,并解析提取所需的数据。

2. Python中的网络爬虫库Python中有众多成熟的网络爬虫库,例如Scrapy、BeautifulSoup和Requests等。

利用这些库,我们可以快速编写爬虫程序,实现数据的抓取和解析。

3. 爬虫的应用场景网络爬虫在各个领域都有广泛的应用,例如搜索引擎的索引、价格比较网站的数据抓取和舆情监控等。

通过Python的网络爬虫,我们可以轻松获取大量的数据,为后续的数据挖掘和机器学习提供数据基础。

二、数据挖掘的基本概念和方法1. 数据挖掘的定义和作用数据挖掘是从大量的数据中发现潜在的、以前未知的、有价值的信息的过程。

它可以帮助我们发现数据中的模式、规律和趋势,为业务决策和问题解决提供支持。

2. Python中的数据挖掘库Python中有许多强大的数据挖掘库,例如NumPy、Pandas和Scikit-learn等。

这些库提供了丰富的数据处理、特征工程和机器学习算法,方便我们进行数据挖掘的各个环节。

3. 常用的数据挖掘方法数据挖掘方法包括聚类、分类、回归、关联规则挖掘等。

通过这些方法,我们可以对数据进行分组、预测和分析,发现数据中的规律和信息。

三、机器学习在数据挖掘中的应用1. 机器学习的基本概念和分类机器学习是通过计算机算法从数据中学习,并根据学习结果进行预测和决策的过程。

机器学习可以分为监督学习、无监督学习和半监督学习等几种类型,每种类型有不同的应用场景和算法模型。

使用Python实现决策树算法

使用Python实现决策树算法

Python实现决策树算法的主要思路是通过使用训练数据装载

特征和标签,然后使用分类算法来从实例数据中学习可以形成一个决策树。

决策树算法中,根节点表示当前所要求解的决策问题,每一个内部节点表示某个特征值,二叉树中的每一个非叶节点都有两个分支,每一个分支代表一个特征值的取值。

叶节点表示对应的决策结果。

Python实现决策树算法的具体步骤如下:

1、首先要准备训练数据,它要包含所有的特征和标签,这些

数据需要被组织成一个矩阵,其中的每一行代表一个样本,每一列代表一个特征或者标签。

2、接下来就是确定最佳划分特征以及相应的取值。

在这里,

会采用ID3或者C4.5算法来选择合适的划分特征以及相应值,它们能够帮助机器在建立决策树的过程中做出精确判断。

3、接下来就是通过训练数据生成决策树,在这里,我们采用

信息增益指标来判断每一个特征在划分数据集上的信息增益,随后,将每一个特征值一一检测,然后决定其作为首要划分特征。

然后,得到一个最优决策树。

4、最后,使用训练得到的决策树来对新的输入进行分类,比如,给定一组数据,我们可以得到相应的特征取值,然后输入

到决策树中,根据输入特征取值的路径,从而判断该数据属于哪个类别。

总的来说,Python实现决策树算法的主要步骤有:准备训练数据,确定最佳划分特征,使用训练数据建立决策树,最后使用决策树进行分类。

AI技术中的决策树算法解析

AI技术中的决策树算法解析一、决策树算法简介决策树算法是一种常用的机器学习方法,它通过对数据集进行分类或回归来做出决策。

这种算法模拟了人类的思维流程,将问题划分为一个个小问题,并构建出一棵树形结构进行决策。

在人工智能技术中,决策树算法被广泛应用于数据挖掘、模式识别、预测分析等场景。

二、决策树算法原理1. 特征选择:在构建决策树之前,需要选择最佳的特征。

特征选择可以通过信息增益、基尼系数等方法来评估特征与目标变量之间的关联性。

2. 决策节点生成:利用特征选择确定划分的节点。

每个节点代表一个问题,将数据集划分为更小的子集。

3. 子节点递归构建:对于每个子数据集,重复执行特征选择和决策节点生成的过程,直到满足停止条件。

4. 剪枝处理:为了避免过拟合现象,在生成完全展开的决策树后,需要对其进行剪枝处理。

剪枝是通过减去一些决策树的分支,从而减少模型复杂度,并提高泛化能力。

三、决策树算法的优点1. 简单直观:决策树模型可以通过图形展示,易于理解和解释。

它们提供了清晰的决策规则,使得结果具有直观性和可解释性。

2. 适应各种数据类型:决策树算法能够处理多种类型的特征变量,包括连续型、离散型和序号型,对数据的要求相对较低。

3. 可处理缺失值和异常值:在决策树中,缺失值不会影响特征选择过程,并且可以在生成节点时考虑到异常值。

4. 处理非线性关系:与传统线性回归方法相比,决策树可以更好地捕捉到非线性关系。

四、决策树算法的局限性1. 过拟合问题:当决策树生长过深时,容易过拟合训练数据,并在新样本上产生较差的预测效果。

剪枝技术可以一定程度上缓解过拟合问题。

2. 忽略相关特征:决策树算法是通过单个特征来切分数据集,可能忽略多个相关变量之间的关系。

3. 对噪声敏感:决策树对于噪声数据非常敏感,容易受到异常值的影响。

五、决策树算法在AI技术中的应用1. 数据挖掘:决策树算法可以用于从大规模数据集中提取有用信息。

它可以发现关联规则,找出分类依据,并为进一步分析和预测提供基础。

Python网络爬虫的数据采集与分析案例分享

Python网络爬虫的数据采集与分析案例分享随着互联网的快速发展,数据成为了当今社会的一项重要资源。

而网络爬虫作为一种自动化工具,能够帮助我们从互联网上获取大量的数据,为我们的数据分析提供了很大的便利。

本文将分享几个实际案例,演示如何使用Python网络爬虫进行数据采集与分析。

案例一:天气数据采集与分析在实际生活中,我们经常需要了解天气情况以便做出相应的安排。

而许多网站提供了天气预报的信息,我们可以使用Python爬虫库来获取这些数据。

通过分析历史天气数据,我们可以揭示出一些有趣的趋势和规律,如某地区的季节性变化、气温变化趋势等。

这些数据可以帮助我们做出更准确的天气预测和决策。

案例二:股票数据采集与分析股票市场一直是人们关注的焦点,而股票数据的采集和分析对于投资者来说尤为重要。

我们可以使用Python爬虫从金融网站获取股票的实时价格、历史数据和相关新闻等信息。

通过分析这些数据,我们可以发现股票价格的波动规律,预测趋势,制定相应的投资策略,提高投资收益。

案例三:舆情数据采集与分析舆情分析是一种通过网络爬虫收集大众言论,并对其进行情感分析和主题分析的方法。

舆情分析可以用于政府决策、企业品牌建设、新闻报道等方面。

我们可以使用Python爬虫从社交媒体平台、论坛等网站上获取公众对某个事件、产品或者品牌的评论和评价。

通过情感分析和主题分析,我们可以了解到大众的看法和反应,为决策提供参考。

案例四:电影数据采集与分析电影作为一种重要的文化载体,一直受到人们的喜爱。

我们可以使用Python爬虫从电影评价网站获取电影的评分、评论、导演等信息。

通过分析这些数据,我们可以了解到观众对于不同类型电影的喜好、各个导演的特点等。

这些信息对于电影业的发展和电影推荐系统的建立都具有重要意义。

综上所述,Python网络爬虫是一种强大的工具,通过它我们能够方便地从互联网上获取各种数据资源。

在数据采集的基础上,我们可以对这些数据进行深入的分析,揭示出一些有价值的信息和规律,为决策和研究提供帮助。

基于深度学习的网络爬虫技术在大数据分析中的应用研究

基于深度学习的网络爬虫技术在大数据分析中的应用研究在当今互联网时代,人们在生产和生活中所接触到的数据量越来越大,如何有效地利用这些数据对经济和社会发展做出贡献,是摆在我们面前的一个巨大挑战。

而基于深度学习的网络爬虫技术,已经成为大数据分析领域中应用最广泛和效果最好的技术之一。

一、深度学习网络爬虫技术的原理深度学习网络爬虫技术是通过模拟人类的搜索方式,通过深度学习技术识别网站中的信息,并将其存储到数据库中。

其原理是通过数据的训练和学习,实现自动提取网站中的信息。

具体而言,深度学习网络爬虫技术通过两个主要步骤实现数据的抓取。

首先,需要收集与目标网站相关的信息,例如网站页面的结构、元素的属性和链接等。

其次,利用深度学习算法实现数据的提取,主要是通过对页面中的内容进行识别和分类。

这样就可以提取出所有符合要求的信息,并将其按照一定的规则保存到数据库中。

二、深度学习网络爬虫技术在大数据分析中的应用深度学习网络爬虫技术在大数据分析中具有广泛的应用前景,并已经被广泛应用于各个领域,例如金融、医疗、教育等。

主要应用如下:1. 情感分析深度学习网络爬虫技术可以自动爬取社交媒体内容、电商评论等有关大众情感的数据,并通过其情感识别模型进行分析和挖掘,得出人们对某个产品或服务的态度和观点,这对于企业营销决策具有重要意义。

2. 产品推荐深度学习网络爬虫技术可以爬取大量的产品信息数据,并使用机器学习技术进行数据分析,以提高推荐的精准度。

这使得企业能够更好地为客户提供个性化的产品推荐服务,从而提高客户满意度和忠诚度。

3. 健康管理深度学习网络爬虫技术可以爬取医学文献、病历记录等大量的医学数据,并使用自然语言处理技术对其进行分析和挖掘,从而为病人和医生提供更好的健康管理服务。

4. 舆情监测深度学习网络爬虫技术可以爬取新闻、博客、微博等大量的社会公共事件信息,并利用机器学习技术进行情感分析和事件跟踪,为政府、企业等提供重要的决策参考。

一种基于锚文本和改进C4.5决策树算法的主题爬行方法

0 引言

传统的We 信息采集的目标是尽可能多地采集信息页 b

面, 甚至 是整 个 We b上的资 源, 而在 这一过程 中它并 不太在 意页面采集 的顺序和被采集页 面的相关主题 。这样做 的一个

1 基于锚文本和决策树 的主题爬行方法

1 1 爬 行 空 间 假 设 .

对本 文的主题网络爬 虫爬 行的网络空间有两个假设 : 1 假定 网络爬虫在 一个 受限的 U L领域 内爬行 , ) R 比如 一 所 大学校 园网或一个 企业 的内部网络 ; 2 认为存在一个到达 主题相关 网页 U L的人 口网页 , ) R 比

Ab t a t n w f c s d rwl g sr c :A e o u e ca i meh d a e o n h r t x n i r v d 4 d cso t e ag r h wa n t o b s d n a c o e t d mp o e C .5 e iin r lo i m s a e t p o o e .I e po td t e a c o e to L t r i h e iin t e a d t e p l d t e d c s n te d e t d cd r p s d t x li h n h rtx f UR o t n t e d cso r , n h n a p i h e ii r e mo l o e i e e a e e o

爬虫开发中如何处理网站的Captcha验证

爬虫开发中如何处理网站的Captcha验证在当今的网络世界中,爬虫技术被广泛应用于数据采集、信息检索等领域。

然而,当我们在进行爬虫开发时,经常会遇到网站设置的Captcha(验证码)验证这一障碍。

这给爬虫程序的正常运行带来了不小的挑战。

那么,我们应该如何有效地处理网站的 Captcha 验证呢?首先,我们需要了解什么是 Captcha 验证。

Captcha 即“全自动区分计算机和人类的图灵测试”,它的主要目的是区分是人类在访问网站还是机器程序(如爬虫)。

常见的 Captcha 形式包括图像验证码、短信验证码、语音验证码、滑动验证码等等。

这些验证码通常要求用户识别图像中的文字、数字、物体,或者完成某种特定的操作,以证明其为人类用户。

当面对 Captcha 验证时,一种常见的处理方法是使用第三方验证码识别服务。

目前市场上有一些专门提供验证码识别服务的供应商,他们通常使用深度学习技术和大量的训练数据来提高识别准确率。

我们可以将获取到的验证码图片发送给这些服务,然后接收其返回的识别结果。

不过,使用第三方服务需要支付一定的费用,并且可能存在法律和道德方面的风险。

此外,验证码识别的准确率也并非百分之百,对于一些复杂的验证码,识别效果可能不尽如人意。

另一种方法是手动输入验证码。

这种方法虽然比较原始,但在某些情况下却是可行的。

例如,对于少量的爬虫任务,或者验证码较为简单且出现频率不高的情况,我们可以通过人工观察验证码并手动输入来完成验证。

但这种方法显然不适合大规模的爬虫应用,因为其效率低下且成本较高。

如果我们想要自己实现验证码的识别,就需要对图像处理和机器学习有一定的了解。

对于图像验证码,我们首先需要对获取到的验证码图片进行预处理,例如灰度化、二值化、去噪等操作,以提高图像的质量和清晰度。

然后,我们可以使用特征提取算法,如 SIFT (ScaleInvariant Feature Transform,尺度不变特征变换)、HOG (Histogram of Oriented Gradients,方向梯度直方图)等,提取图像的特征。

Python网络爬虫的数据爬取与金融风控案例

Python网络爬虫的数据爬取与金融风控案例随着互联网的飞速发展和数据的日益重要,金融行业对于数据的需求也越来越大。

而Python作为一种功能强大且易于使用的编程语言,被广泛应用于金融领域的数据爬取和风控分析。

本文将介绍Python网络爬虫的原理和应用,并结合金融风控领域的案例,展示Python在数据爬取和风控中的重要作用。

一、Python网络爬虫的工作原理及应用1.1 网络爬虫的工作原理网络爬虫是一种自动化程序,通过模拟人的操作,访问互联网上的网页并提取有用的信息。

Python作为一种强大的编程语言,提供了许多功能丰富的库来实现网络爬虫,如BeautifulSoup、Scrapy等。

网络爬虫的工作原理包括以下几个步骤:(1)发送HTTP请求获取网页内容。

(2)解析HTML文档,提取所需数据。

(3)存储数据,进行后续处理或分析。

1.2 网络爬虫在金融领域的应用网络爬虫在金融领域有着广泛的应用,常见的应用场景包括:(1)股票数据爬取:爬取金融网站上的股票数据,用于分析和预测股市走势。

(2)新闻数据爬取:爬取新闻网站上的新闻内容,用于舆情分析和事件监测。

(3)财经数据爬取:爬取各大财经网站上的财经数据,用于金融分析和决策支持。

二、Python网络爬虫的金融风控案例2.1 数据爬取与金融风控的关系金融风控是指通过分析和监控金融数据,识别和管理风险的过程。

而数据爬取是金融风控的重要环节之一,通过获取各类金融数据,可以更加全面地了解市场情况和投资机会,提高风险管理的准确性和及时性。

2.2 网络爬虫在金融风控中的应用案例以股票数据爬取为例,展示网络爬虫在金融风控中的应用。

案例描述:为了提高投资者对股票市场的了解,一家金融机构决定开展股票市场风控工作。

他们需要从多个股票交易网站上爬取历史交易数据,以便进行分析和预测。

解决方案:该金融机构使用Python编写网络爬虫程序,通过模拟浏览器的方式访问股票交易网站,并提取所需的交易数据。

python爬虫10例经典例子

python爬虫10例经典例子当谈到Python爬虫,经典的例子可能包括以下几种:1. 爬取静态网页数据,使用库如requests或urllib来获取网页内容,然后使用正则表达式或者BeautifulSoup来解析页面,提取所需数据。

2. 爬取动态网页数据,使用Selenium或者PhantomJS等工具模拟浏览器行为,获取JavaScript渲染的页面内容。

3. 爬取图片,通过爬虫下载图片,可以使用requests库发送HTTP请求,获取图片的URL,然后使用openCV或者PIL库来处理图片。

4. 爬取视频,类似图片爬取,但需要考虑视频文件的大小和格式,可能需要使用FFmpeg等工具进行处理。

5. 爬取特定网站,例如爬取新闻网站的新闻内容,或者爬取电商网站的商品信息,需要根据网站的结构和特点编写相应的爬虫程序。

6. 爬取社交媒体数据,可以通过API或者模拟登录的方式爬取Twitter、Facebook等社交媒体平台的数据。

7. 数据存储,将爬取的数据存储到数据库中,可以使用MySQL、MongoDB等数据库,也可以将数据保存为CSV、JSON等格式。

8. 数据清洗和分析,对爬取的数据进行清洗和分析,去除重复数据、处理缺失值,进行数据可视化等操作。

9. 自动化爬虫,编写定时任务或者事件触发的爬虫程序,实现自动化的数据采集和更新。

10. 反爬虫策略,了解和应对网站的反爬虫机制,如设置请求头、使用代理IP、限制访问频率等,以确保爬虫程序的稳定运行。

以上是一些Python爬虫的经典例子,涵盖了静态网页、动态网页、多媒体文件、特定网站、社交媒体等不同类型的数据爬取和处理方法。

希望这些例子能够帮助你更好地理解Python爬虫的应用和实现。

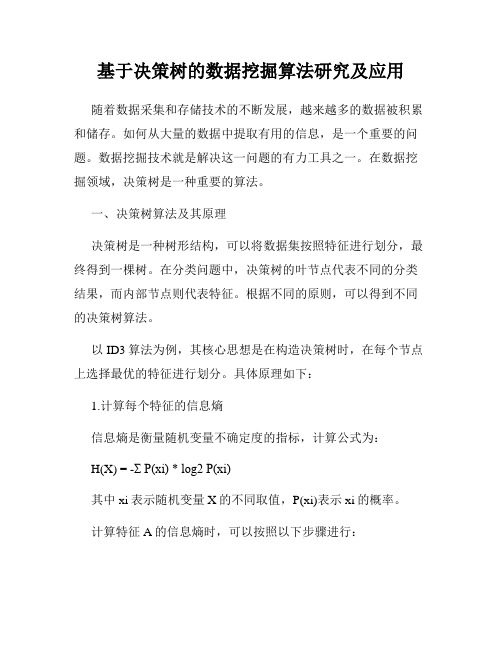

基于决策树的数据挖掘算法研究及应用

基于决策树的数据挖掘算法研究及应用随着数据采集和存储技术的不断发展,越来越多的数据被积累和储存。

如何从大量的数据中提取有用的信息,是一个重要的问题。

数据挖掘技术就是解决这一问题的有力工具之一。

在数据挖掘领域,决策树是一种重要的算法。

一、决策树算法及其原理决策树是一种树形结构,可以将数据集按照特征进行划分,最终得到一棵树。

在分类问题中,决策树的叶节点代表不同的分类结果,而内部节点则代表特征。

根据不同的原则,可以得到不同的决策树算法。

以ID3算法为例,其核心思想是在构造决策树时,在每个节点上选择最优的特征进行划分。

具体原理如下:1.计算每个特征的信息熵信息熵是衡量随机变量不确定度的指标,计算公式为:H(X) = -Σ P(xi) * log2 P(xi)其中xi表示随机变量X的不同取值,P(xi)表示xi的概率。

计算特征A的信息熵时,可以按照以下步骤进行:1)对于特征A的每个取值ai,计算数据集D中该取值出现的概率P(ai);2)根据当前特征A的取值ai将数据集D分为若干个子集Di,每个子集Di包含特征A取值为ai的数据样本;3)计算每个子集Di的信息熵,记为H(Di);4)根据子集Di的大小,计算特征A的信息熵:H(A) = -Σ P(ai) * H(Di)2.计算每个特征的信息增益信息增益是指使用特征A对数据集D进行划分所获得的纯度提升。

信息增益越大,说明特征A对分类结果的影响越大。

计算特征A的信息增益的公式为:Gain(A) = H(D) - H(A)其中H(D)为数据集D的信息熵。

3.构造决策树根据信息增益排序选择最优特征A,以该特征为节点划分数据集。

对于特征A的每个取值ai,生成一个子节点,并以该子集Di 为数据集,递归构建决策树。

二、决策树算法的应用决策树算法在数据挖掘领域广泛应用。

以下是几种常见的应用场景。

1.客户分类在销售和营销领域,决策树可以用于客户分类。

以银行为例,客户可以根据年龄、收入、教育程度等特征进行分类,然后针对不同客户群体推出相应的金融产品。

学习如何进行网络爬虫与数据挖掘

学习如何进行网络爬虫与数据挖掘网络爬虫与数据挖掘是当今互联网时代中广泛应用的技术,具有极大的潜力和重要性。

本文将介绍网络爬虫和数据挖掘的基本概念、实施步骤和相关工具,帮助读者全面了解这一领域,并具备一定的实践能力。

一、网络爬虫概述网络爬虫是一种自动提取互联网上信息的程序,它通过模拟浏览器访问网页并解析HTML代码,从中提取所需的数据。

网络爬虫主要由以下几个步骤组成:1. 确定爬取目标:明确爬取的网站和需要收集的信息。

2. 发起请求:使用编程语言中的HTTP库发起请求,获取网页HTML代码。

3. 解析HTML:使用HTML解析库解析网页HTML代码,提取需要的数据。

4. 数据存储:将提取的数据存储到数据库或者文本文件中,便于后续的分析和应用。

二、数据挖掘概述数据挖掘是对大量数据进行自动化分析的过程,通过发现数据中的隐藏模式、关联规则和趋势,从而获得有用的信息。

数据挖掘可以助力企业决策、市场营销、推荐系统等领域。

数据挖掘的基本步骤如下:1. 数据收集:获取所需的数据集,可以通过网络爬虫获取。

2. 数据预处理:对数据进行清洗、去重、填充缺失值等处理,确保数据质量。

3. 特征选择:从海量特征中选择出与目标变量相关性较高的特征。

4. 模型构建:选择合适的数据挖掘算法,构建预测或分类模型。

5. 模型评估:使用评价指标对模型进行评估,确定模型的有效性。

6. 结果应用:将数据挖掘的结果应用到实际问题中,支持决策和改进。

三、网络爬虫与数据挖掘工具为了简化爬虫和数据挖掘的实施,许多开源工具和框架被广泛应用。

以下是几个常用的工具:1. Scrapy:基于Python的爬虫框架,它提供了高效的页面下载和数据提取功能,支持多线程和分布式爬取。

2. Beautiful Soup:一款用于解析HTML/XML的Python库,它能够从HTML代码中提取有用的数据,并提供简便的API进行数据处理。

3. Selenium:一款用于Web自动化测试的工具,它可以模拟用户的行为,实现页面动态加载和JavaScript渲染的爬取。

手把手教你使用AI技术进行网络爬虫

手把手教你使用AI技术进行网络爬虫一、网络爬虫的介绍网络爬虫是一种自动化程序,通过获取互联网上的信息来构建数据集。

随着人工智能(AI)技术的发展,它在数据挖掘和信息收集方面的作用越来越大。

本文将手把手教你使用AI技术进行网络爬虫,让你能够更好地利用这一技术获取所需的信息。

二、理解AI技术在网络爬虫中的应用AI技术在网络爬虫中主要有两方面的应用:智能识别和自动化处理。

首先,智能识别是指利用机器学习和深度学习等AI算法来识别网页中的结构和内容。

通过分析网页,可以自动提取出关键信息,并进行分类、过滤或者标记;其次,自动化处理是指利用AI技术编写脚本实现爬取、解析和存储等操作,减少人工操作的复杂性和重复性。

三、选择合适的AI算法与工具在进行网络爬虫时,选择合适的AI算法与工具可以极大地提高效率和准确性。

常见的AI算法包括神经网络、支持向量机以及随机森林等;而在工具方面,Scrapy、Beautiful Soup和Selenium等被广泛应用于网络爬虫。

根据具体需求,选择适合的算法和工具可以极大地提高数据的质量和效率。

四、Step1:准备开发环境在使用AI技术进行网络爬虫之前,我们首先需要准备相应的开发环境。

安装Python与所需的库是必须的。

Python是一种常用的编程语言,并且有着丰富的第三方库支持。

通过pip命令安装Scrapy、Beautiful Soup和Selenium等库,为后续程序开发做好准备。

五、Step2:分析目标网站结构在使用AI技术进行网络爬虫前,需要对目标网站进行结构分析。

分析包括查看网页源码、识别页面元素以及确定抓取规则等步骤。

这些分析都能够帮助你了解目标网站的结构与内容,并为下一步编写爬虫程序提供指导和依据。

六、Step3:编写网络爬虫程序根据前面的结构分析结果,现在开始编写网络爬虫程序。

根据选择的工具不同,具体代码也会有所差异。

例如,在使用Scrapy时,你需要定义一个Spider类并实现相应方法;而在使用Selenium时,你需要编写相应的脚本来模拟浏览器操作。

基于遗传算法的聚焦爬虫搜索策略

[ src]I re rv h erhe ce c f ou e rwl bsdo c eGeei Aloi m( GA)ti pprpo o e lb l Ab ta t nod roi o etesac f inyo c sdca e ae nNi n t g rh N t mp i f h c t ,hs a e rp ssago a

[ ywo d l fc sdca e; e ei agrtm; i e tpc ee ac Ke r s o ue rwl g nt loi r c h nc ;o irlvn y h

l 概 述

聚焦 爬虫是专 为查询某一领域或主题信息而 出现 的网页 抓取工具 。不 同于通 用搜索 引擎 ,由于聚焦爬 虫抓取 的内容 只 限于特定 的主题 或专门领域 ,因此其在搜索过程 中无须对 整个 We b进行遍历 ,只需选择与主题相 关的页面进行 访问。 相对于通 用网络爬虫 ,聚焦 网络爬虫需要解决 的关键 问题是

文献标识码:A

中 图分类号: P 11 T 31 3 .

基 于遗传 算 法的聚焦爬 虫搜 索策略

曾广朴 ,范会联

( 长江 师范学院数学与计算机学 院 ,涪陵 4 8 0 ) 0 0 1

摘

要 : 了提高聚焦爬 虫的搜索效率 , 出一种结合 内容评价 和链接 结构搜索策略的优点并利 用小 牛境遗 传算法进行全局寻优 的搜索策 为 提

o tmi a i n f s a c sr t g i h c mb n s h a v n a e o t n va u t n a d l k sr c u .URI e r h die t n i u d d b p i z to o e r h ta e y wh c o i e t e d a t g s of c n e t e l a i n i t u t l o n e s a c r c i s g i e y o i p o n e g n t p r t r n m r vi g t e e i o e a o sa d NGA. m p r d wi t e l o ih , x e i n a e u t n i a e t a ss r t g a i h rp e ii n a d h c Co a e t o h ra g rt ms e p r me t lr s lsi d c t h t hi ta e y h sh g e r c so n h t r c l i e r h ngt et p c p g s e a l n s a c i h o i a e .

数据挖掘中的决策树算法应用案例分析

数据挖掘中的决策树算法应用案例分析决策树算法是一种常用的数据挖掘方法,它通过构建一棵树型模型来对数据进行分类或预测。

决策树算法的应用非常广泛,涵盖了许多领域,例如金融、医疗、销售等。

本文将通过分析几个实际案例,介绍决策树算法在数据挖掘中的应用。

案例一:银行行销在银行的行销活动中,如何判断哪些客户更有可能购买银行的产品是一个重要问题。

一家银行通过收集客户的个人和金融信息,利用决策树算法构建了一个模型来预测客户是否会购买银行的产品。

该模型的输入特征包括客户年龄、工作类型、婚姻状况等,输出为客户是否购买产品。

通过训练决策树模型,银行可以根据客户的个人信息判断其购买意愿,从而有针对性地进行行销活动,提高销售效果。

案例二:疾病诊断决策树算法在医疗领域也有着广泛的应用。

以疾病诊断为例,医生需要根据患者的症状和检查结果判断其可能的疾病类型。

一个医院利用决策树算法构建了一个疾病诊断模型,通过输入患者的病症特征,模型能够输出患者可能患有的疾病类型及其概率。

这有助于医生做出更准确的诊断,从而提高治疗效果。

案例三:客户信用评级在金融领域,客户信用评级是一项重要的任务。

一家信用卡公司利用决策树算法构建了一个客户信用评级模型,通过客户的个人信息、财务状况等特征,模型可以预测客户的信用等级。

这对信用卡公司来说非常有价值,它可以根据客户的信用等级制定相应的信用额度和利率,并更好地管理风险。

案例四:商品推荐电子商务平台通过推荐系统来为用户推荐感兴趣的商品。

其中,决策树算法常被用来构建商品推荐模型。

通过分析用户的购买历史、浏览行为等特征,模型可以预测用户对某个商品的喜好程度,并给出相应的推荐。

这种个性化推荐不仅能提高用户体验,还可以促进电商平台的销售额。

案例五:道路交通流量预测交通流量的预测在城市规划和交通管理中起着重要作用。

以道路交通流量预测为例,一个研究团队利用决策树算法构建了一个交通流量预测模型。

模型利用历史交通数据、天气情况、时间等特征,可以预测未来某个时间段某条道路的交通流量。

网络爬虫的技术:如何使用代码自动提取网页数据

网络爬虫的技术:如何使用代码自动提取网页数据网络爬虫是一种自动化的程序工具,用于在互联网上抓取信息。

通过网络爬虫,我们可以快速、自动地从互联网上的网页中提取所需要的信息,而不需要人工手动去浏览、复制、粘贴这些数据。

在实际应用中,网络爬虫被广泛应用于搜索引擎、数据挖掘、网络监控等领域。

下面我将介绍一些网络爬虫的技术,以及如何使用代码自动提取网页数据:一、选择合适的爬虫框架在编写网络爬虫代码之前,首先需要选择一个合适的爬虫框架来帮助我们快速搭建爬虫程序。

目前比较流行的爬虫框架有Scrapy、BeautifulSoup、Requests等。

其中,Scrapy是一个功能强大的爬虫框架,提供了很多便捷的工具和方法来实现爬虫任务,并且具有良好的可扩展性。

二、编写爬虫程序1.准备工作:在编写爬虫程序之前,首先需要安装相应的爬虫框架。

以Scrapy为例,可以通过pip install scrapy命令来安装Scrapy框架。

2.创建项目:在命令行中输入scrapy startproject<project_name>来创建一个新的Scrapy项目。

3.编写爬虫程序:在项目中创建一个新的Spider,继承自scrapy.Spider,并重写start_requests和parse方法来定义爬取逻辑。

在parse方法中,可以使用XPath或CSS选择器来定位所需的数据,并提取出来。

4.启动爬虫:在命令行中输入scrapy crawl <spider_name>来启动爬虫程序,程序将开始抓取指定网站的数据。

三、数据提取技术1. XPath:XPath是一种在XML文档中定位节点的语言,也可以用于网页中的数据提取。

通过XPath表达式,可以精确地定位到所需的数据,并提取出来。

2. CSS选择器:CSS选择器是一种在网页中定位元素的方法,使用简单、灵活,适合于提取网页中的文本、链接等信息。

3.正则表达式:正则表达式是一种强大的文本匹配工具,可以用于从网页中提取特定格式的数据。

基于Python的网络爬虫技术综述

基于Python的网络爬虫技术综述随着互联网的快速发展与普及,我们可以在浩瀚的网络空间中体验丰富多彩的信息世界。

然而,由于信息数量的爆炸式增长,人类对数据的需求也变得更加迫切,同时也使得信息的获取变得更加复杂。

这时候,爬虫技术就能够派上用场。

本文将对基于Python的网络爬虫技术进行综述,从其定义、特点、应用和常用库以及爬虫原理等方面进行简要介绍。

1.定义网络爬虫(Web Crawler)是一种自动化程序,用于自动从互联网上获取数据(如文本、图像、音频等),并将其存储在本地或者其他数据库中。

爬虫技术是一种网络爬虫的实现方式,它可以通过特定的算法和网络协议来发现、下载、解析、存储和处理网页信息。

2.特点(1)自动化:网络爬虫可以自动实现对网页信息的获取、解析和存储,大大减轻了人工获取信息的压力。

(2)高效性:网络爬虫可以在短时间内实现对大量信息的获取。

(3)实时性:网络爬虫可以实时监控和获取信息,保证数据的及时性和准确性。

3.应用(1)搜索引擎:搜索引擎通过网络爬虫来抓取互联网上的各种网页信息,将这些信息进行分析和整理,然后建立索引,同时提供搜索服务,为用户提供快速准确的搜索结果。

(2)数据挖掘:网络爬虫还可以用于数据挖掘领域,通过对网页文本、图片、音频等信息的自动化提取和分析,来进行商业分析、金融研究、网络安全等方面的工作。

(3)社交媒体:网络爬虫还可以用于社交媒体,通过对社交媒体平台的用户信息、文本信息进行获取和分析,来进行用户行为分析、舆情监测、营销策略等方面的工作。

4.常用库Python中常用的网络爬虫库有:BeautifulSoup、Scrapy、Requests、Selenium等。

其中,BeautifulSoup用于解析HTML和XML文件,Scrapy是Python的一个高效、快速和强大的网络爬虫框架,Requests用于处理HTTP请求和响应,Selenium则主要用于Web自动化测试。

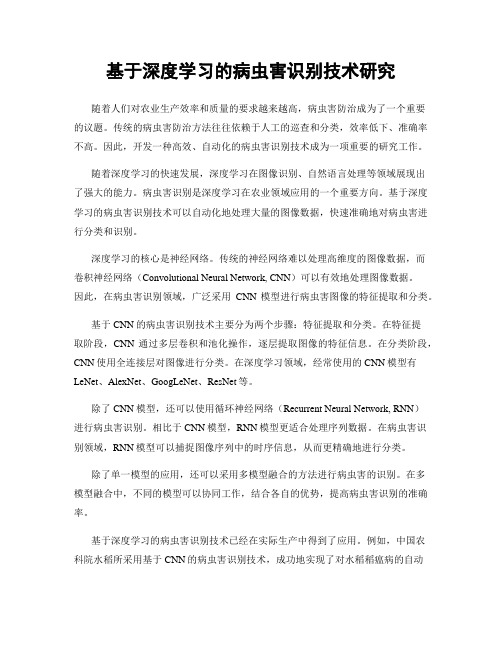

基于深度学习的病虫害识别技术研究

基于深度学习的病虫害识别技术研究随着人们对农业生产效率和质量的要求越来越高,病虫害防治成为了一个重要的议题。

传统的病虫害防治方法往往依赖于人工的巡查和分类,效率低下、准确率不高。

因此,开发一种高效、自动化的病虫害识别技术成为一项重要的研究工作。

随着深度学习的快速发展,深度学习在图像识别、自然语言处理等领域展现出了强大的能力。

病虫害识别是深度学习在农业领域应用的一个重要方向。

基于深度学习的病虫害识别技术可以自动化地处理大量的图像数据,快速准确地对病虫害进行分类和识别。

深度学习的核心是神经网络。

传统的神经网络难以处理高维度的图像数据,而卷积神经网络(Convolutional Neural Network, CNN)可以有效地处理图像数据。

因此,在病虫害识别领域,广泛采用CNN模型进行病虫害图像的特征提取和分类。

基于CNN的病虫害识别技术主要分为两个步骤:特征提取和分类。

在特征提取阶段,CNN通过多层卷积和池化操作,逐层提取图像的特征信息。

在分类阶段,CNN使用全连接层对图像进行分类。

在深度学习领域,经常使用的CNN模型有LeNet、AlexNet、GoogLeNet、ResNet等。

除了CNN模型,还可以使用循环神经网络(Recurrent Neural Network, RNN)进行病虫害识别。

相比于CNN模型,RNN模型更适合处理序列数据。

在病虫害识别领域,RNN模型可以捕捉图像序列中的时序信息,从而更精确地进行分类。

除了单一模型的应用,还可以采用多模型融合的方法进行病虫害的识别。

在多模型融合中,不同的模型可以协同工作,结合各自的优势,提高病虫害识别的准确率。

基于深度学习的病虫害识别技术已经在实际生产中得到了应用。

例如,中国农科院水稻所采用基于CNN的病虫害识别技术,成功地实现了对水稻稻瘟病的自动化检测。

同时,南京农业大学也研究出一套基于CNN和RNN的葡萄病虫害智能诊断系统,能够快速高效地对葡萄病虫害进行诊断和分类。

基于决策树的网络安全检测技术研究

基于决策树的网络安全检测技术研究网络安全是当今世界面临的一个重大挑战。

随着网络的普及和使用人数的急剧增长,互联网面临的风险和威胁越来越多。

网络攻击和黑客入侵已经成为日常生活中无法避免的风险。

在这个背景下,如何保护网络安全已经成为一项重要的任务。

本文将主要探讨基于决策树的网络安全检测技术。

决策树作为一种常见的分类方法,已经被广泛应用在各个领域,如医疗、金融、农业等。

其中,在网络安全领域,决策树也被广泛应用。

决策树是一种基于树形结构的分类模型,可以帮助我们分析和决策问题。

在网络安全中,决策树可以帮助我们判断一些网络流是不是恶意的,并提供相应的响应措施。

在网络安全领域,基于决策树的网络安全检测技术已经得到了很多研究者的关注。

其中,最常见的技术是基于数据挖掘和机器学习的决策树技术。

该技术主要是通过构建一个决策树模型,来识别和分类网络流量数据,并判断其是否为恶意行为。

下面将重点介绍影响基于决策树的网络安全检测技术的几个因素:1. 特征选择决策树需要输入特征集合来构建模型。

在网络安全中,特征集合是指网络流量数据的一些属性、指标或特性。

如:协议类型、源地址、目标地址、端口等。

在构建决策树之前,必须选择合适的特征集合。

特征选择的核心目标是通过简化特征集合来提高效率,并增加决策树的精度。

因此,特征选择是影响决策树性能的重要因素。

2. 样本选择网络安全领域中,数据集一般包含大量的数据,这些数据中只有极少数是恶意流量。

这种不平衡的数据集会影响决策树模型的性能。

在样本选择时,必须采用合适的策略,来保证样本的平衡性,从而提高决策树的性能。

3. 模型训练在决策树技术中,模型训练是一个非常重要的过程。

在训练决策树模型时,必须采用合适的算法和策略。

在网络安全中,常用的算法有C4.5、ID3以及CART等。

通过模型训练,可以得出一个高度准确的决策树模型,用于判断网络流量是否为恶意数据。

综上所述,基于决策树的网络安全检测技术是目前网络安全领域的一项重要技术。

基于深度学习的植物病虫害识别方法

基于深度学习的植物病虫害识别方法植物病虫害对于农业生产造成了严重的损失,因此,快速、准确地进行病虫害识别是保护植物健康的重要任务。

近年来,随着深度学习技术的发展与应用,基于深度学习的植物病虫害识别方法逐渐成为主流。

本文将介绍基于深度学习的植物病虫害识别方法及其在农业生产中的应用。

一、深度学习概述深度学习是一种人工智能技术,借助神经网络模型进行数据的学习与处理。

相比传统的机器学习算法,深度学习通过多层次的神经网络结构,能够更好地提取特征并进行高级抽象。

深度学习在图像、语音、自然语言处理等领域取得了重大突破,为植物病虫害识别提供了有力的工具和方法。

二、基于深度学习的植物病虫害识别方法1. 数据采集与预处理在植物病虫害识别中,首先需要采集大量的病虫害图像数据,并进行标注。

这些数据可以包括不同种类植物叶片上的病虫害图像,对这些图像进行标注,如分类标签、边界框等。

预处理步骤包括图像去噪、尺寸调整、颜色标准化等,以确保输入的图像具有一致的特征和格式。

2. 神经网络模型构建常用的深度学习模型包括卷积神经网络(Convolutional Neural Network, CNN)和迁移学习模型。

CNN模型通过多层卷积核提取图像的空间特征,通过池化层降低维度,最后通过全连接层进行分类或回归分析。

对于植物病虫害识别,可以使用已经经过大规模训练的基础CNN网络,如ResNet、Inception 等,也可以根据具体任务进行网络的自定义。

3. 模型训练与优化在模型训练过程中,需要将数据集划分为训练集和测试集,其中训练集用于模型的参数学习,测试集用于模型的性能评估。

为了提升模型的准确性和泛化能力,通常使用数据增强技术,如旋转、翻转、剪裁等方式扩充训练集的规模,增加模型的泛化能力。

优化算法方面,一般采用随机梯度下降法(Stochastic Gradient Descent, SGD)或其变种,通过调整学习率、正则化等参数来实现模型的快速收敛和泛化能力的提升。

Python网络爬虫技术在农业大数据分析中的应用案例

Python网络爬虫技术在农业大数据分析中的应用案例农业是国民经济的重要支柱产业,而大数据分析正逐渐成为农业科技进步的重要手段。

随着互联网的普及和发展,Python网络爬虫技术得以广泛应用于农业领域,为农业大数据分析提供了有效的数据获取途径。

本文将介绍几个Python网络爬虫技术在农业大数据分析中的应用案例。

一、天气数据采集农业生产对气象因素具有很高的依赖性,而天气数据是农业决策与生产管理的重要参考依据。

利用Python网络爬虫技术,可以从各大气象网站上自动获取实时天气数据,并进行数据清洗和分析。

例如,可以爬取全国各地的温度、降雨量、湿度等数据,对农作物的生长环境进行评估和预测。

二、市场行情数据获取农业产品的市场行情对农民的收入和农产品的供应链管理有着重要影响。

Python网络爬虫技术可以通过爬取各大农产品市场网站或电商平台的数据,实时获取农产品的价格和交易信息。

这些数据可以为农民提供决策参考,帮助他们灵活调整种植计划,以适应市场需求变化。

三、病虫害监测与预测病虫害是农作物生产中的常见问题,对减产甚至农作物死亡造成严重影响。

利用Python网络爬虫技术,可以收集各地病虫害监测站的数据,实时获取病虫害的发生情况。

通过对这些数据进行分析和建模,可以预测病虫害的发展趋势和帮助制定相应防治措施,提高农作物的产量和质量。

四、土壤质量评估土壤是农作物生长的基础,而土壤质量对农作物的产量和品质有着直接影响。

通过采集并分析土壤样本,可以评估土壤的有机质含量、养分含量、酸碱度等指标。

Python网络爬虫技术可以帮助快速获取各个农业研究机构或监测站点的土壤质量数据,提供农民合理施肥和土壤改良的依据。

五、农业政策与法规分析农业政策与法规对农业生产和经营管理具有重要影响。

Python网络爬虫技术可以用于抓取国家和地方政府网站上发布的农业政策和法规文件,提供给农民、农业企业和农业研究机构参考和分析。

这些数据可以帮助农业从业者了解最新的政策变化,及时调整经营策略,提高农业生产效率。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

2017 年 软件2017,V〇1.38,No.7第 3 8 卷第7 期 COM PUTER ENGINEERING&SO FTW A RE国际 IT传媒品牌设讨研尧与启用基于决策树算法的爬虫识别技术刘宇,程学林(浙江大学软件学院,浙江宁波315000)摘要:网络爬虫指的是一种按照一定的规则,自动地抓取万维网信息的程序或者脚本[1]。

但是实际上爬虫还 分为正规爬虫和非正规爬虫,所谓的正规爬虫就是通过正规途径和手段获取网站信息和数据,非正规爬虫又称为恶 意爬虫,主要用于非法盗窃数据,给网站服务器增加负担以及偷窥一些敏感信息数据等。

本文将会基于决策树算法 设计一种新爬虫检测技术,并根据爬虫检测结果提供一些反爬机制,对恶意爬虫进行进行评屏蔽等,进而实现对网 站和服务器以及部分数据,信息的保护,降低互联网资源重叠现象。

关键词:网络爬虫;爬虫检测;恶意爬虫;反爬虫中图分类号:TP314 文献标识码:A DOI: 10.3969/j.issn.l003-6970.2017.07.028本文著录格式:刘宇,程学林.基于决策树算法的爬虫识别技术m.软件,2017, 38 (7): 122-125 Crawler Recognition Technology Based on Decision Tree AlgorithmLIU Yu,CHENG Xue-lin(Zhejiang University of S oftware College, Zhejiang Ningbo315000)【Abstract】:Web crawler refers to a program or script that automatically captures World Wide Web information according to certain rules[1].But in fact the crawler is divided into formal and informal crawler,web crawler is the so-called formal information and data through formal channels,the non formal also means malicious crawler, mainly used for illegal theft of data,increase the burden and peep some sensitive information to the web server data. This paper will design a new decision仕ee algorithm based on crawler identification technology,which gives some anti-climbing mechanism according to the recognition result of malicious crawler,and shield some malicious crawler,and thus we can realize the protection of the website and server as well as part of the data to reduce the Internet resource overlap.【Key words】:Web-crawler;Crawlerdetection;Maliciouscrawler;Anti-crawler0引言随着网络的迅速发展,万维网成为大量信息的 载体,如何有效地提取并利用这些信息成为一个巨 大的挑战[2]。

为了快速从互联网中获得大量目标数 据,就需要编写一些脚本程序,按照一定规律批量 获取数据,这就是所谓的爬虫,但是在一部分通过 正常途径,即先请求网站Robottxt之后,再在不影 响对方网站前提下,获取相关资料的正规爬虫之外,还有一些恶意爬虫,它们通常表现为无论网站是的 Robottxt是否允许爬虫爬取,都会强制性,批量性 获取网站数据,同时会在短时间内大量的发起请求,还有一部分恶意爬虫会恶意制造虚假PV,模拟点击 付费广告链接,批量检索网站禁止爬虫爬取信息,用于商业性质分析等。

这类爬虫在给互联网带来巨 大的机器流量同时,也会给网站带来极大的负担,使得网站性能大大降低,目前互联网内有40%-60% 的流量来自爬虫或者相关机器流量[3],已经严重妨 碍核威胁互联网相关的产业健康发展!为了应对爬虫带来的危害,国内外相关学者和 各大公司企业,教育机构甚至很多个人网站站长等,都对爬虫检测,识别等技术进行了深入的研究,例 如目前常见的爬虫检测有判断请求的Headers,查看 请求频率等众多方法。

但是由于常见的这些检测方作者简介:刘宇(1993-),男,吉林省吉林市人,浙江大学软件学院研究生,吉林省群龙科技有限公司CEO,Anycodes在线编程平台开发人,Anycodes在线编程平台(2015SR164783)以及在线编程平台(2015SR164783)以及在线编程软件(2017SR105637)著作权所有人。

同时也是Anycodes在线编程专利所有人;程学林,男,浙江大学软件学院教师,高级工程师。

刘宇等:基于决策树算法的爬虫识别技术法并不能灵活快速的检测请求类型,所以本文将会 基于决策树算法建立一种新的爬虫检测方式,同时 做一些相关的反爬设计。

1请求与爬虫检测对于网络爬虫的检测,其实就是对请求的分析,一般情况下判断一个请求是否是爬虫,通常是:(1) 单位时间内同一 IP 请求频率:如果在某一 段时间内,某个IP 发出大量请求,而这种请求又不 是正常人工可以发出的(例如一分钟发出上千次请 求等),那么可以基本判定该请求属于爬虫行为;(2)单位时间内同一 IP 请求时间间隔:正常人 为访问时,访问时间间隔是不固定的,但是很多时 候爬虫的访问时间间隔是固定的或者在某段时间范 围内,如果同一 IP 每次发起请求时间间隔都是在一 个固定时间间隔内或者波动范围极小的时间间隔 内,那么也可以基本判定该行为属于爬虫行为;(3 ) U ser-A gent 是否为常用浏览器User -Agent : 通常情况下每个浏览器具有特定的 User -Agent , 以让服务器识别该请求是通过哪个浏览器 发起的,但是很多爬虫在设计时,并未设置User -Agent , 所以如果非常见浏览器 User-Agent 或者带 有编程语言名称的User-Agent 基本可以判定为该 行为是爬虫行为[4];(4 )请求是否为全部请求:一般情况一个网站 如果有图片或者link 标签等,这样打开一个网页通 常会加载多个资源,如CSS , JS 等,但是爬虫访问 的时候,通常不会做这些额外的请求。

所以当一个 请求发起之后,只请求了页面源代码而未请求相关关联资源,那么可以基本判定,该请求是爬虫行为;(5) 是否请求robot :通常情况,爬虫都会请求Robottxt ,而用户是不会请求这个文档的,所以请 求Robottxt 的通常为爬虫行为,当然也是有一部分 爬虫不会请求该文件的,所以未请求该文档的并不代表非爬虫行为[4];(6) 请求时是否会带有Cookies : —般情况下 爬虫请求页面的时候,都不会带有Cookies ,而人为 访问的时候,都会带有前一页面或者前一次访问的 Cookies ,所以在没有前一次Cookies 的请求中,有 极大可能是爬虫发起的请求;(7) 是否触发爬虫陷阱:通常情况下,爬虫陷 阱指的是将Spider 访问引入到能产生无限循环的 页面,或者带入其他特殊页面中,正常情况下,人 为访问是不会走人该陷阱的,而爬虫是“无思维”请求,所以极有可能会自动走人该陷阱。

一般情况 下走入该陷阱并在陷阱中无法跳出的行为是爬虫 行为[6]。

2使用决策树算法分析访问性质决策树(Decision Tree )是在已知各种情况发生概率的基础上,通过构成决策树来求取净现值的期 望值大于等于零的概率,评价项目风险,判断其可 行性的决策分析方法,是直观运用概率分析的一种 图解法[7]。

为了方便研究此处将上文中,爬虫常见检测指标1-7做以下编号:表1爬虫检测类型编号表T a b.lN u m b er tab le o f craw ler d etection type指标全称1 单位时间内同一 IP 请求频率2 单位时间内同一 IP 请求时间间隔3 User -Agent 是否为常用浏览器User-Agent4 请求是否为全部请求5 是否请求robot6 请求时是否会带有cookies 7是否触发爬虫陷阱对上述指标进行详细分析,例如编号1评价包 括高,低,即单位时间内同一 i p 请求频率高,或者 低,当然,此处的高低是相对的,此处以总请求量/ 总i p 量为标准,即高于此标准为高,小于等于此标准为低,编号2评价包括固定与不固定,编号3评 价包括是,否,以此类推,总结出以下表格:表2爬虫检测类型评价内容表Tab.2E v alu ation tab le o f cra w ler d etection type编号指标全称评价内容1单位时间内同一 IP 请求频率高、低2单位时间内同一 i p 请求时间间隔固定、不固定3User -Agent 是否为常用浏览器User-Agent 是、否4请求是否为全部请求是、否5是否请求robot是、否6请求时是否会带有cookies 是、否7是否触发爬虫陷阱是、否根据常见爬虫特性获得数据集如下:以Python 为例,使用skleam 包的决策树模型,将数据整理如下,其中数据1-8为学习集,9-11为 测试集:123《软件》杂志欢迎推荐投稿:cosoft @vip 第38卷第7期软 件表3请求行为原始数据集Tab.3 Request the original data set1234567判定1高不固定否否是否是是2高固定否否否否否是3高固定否否否否是是4低不固定否否是否是是5低固定否是是否是是6低不固定是是否是否否7低不固定是是否否否否8低不固定是是否否是是9低固定是是否是否否10髙不固定是是否是否否11低不固定否是否是否否注:第一行数字表示编号,第一列数字表示数据集表4请求行为学习数据集Table 4 Request behavior learning data set1234567 1High No No No Yes No Yes TRUE 2High Yes No No No No No TRUE 3High Yes No No No No Yes TRUE 4Low No No No Yes No Yes TRUE 5Low Yes No Yes Yes No Yes TRUE 6Low No Yes Yes No Yes No FALSE 7Low No Yes Yes No No No FALSE 8Low Yes Yes Yes No Yes No FALSE代码如下[8]:from skleam.feature extraction import DictVec-torizerimport csvfrom skleam import treefrom skleam import preprocessingimport osSourceData= open("des_csvM,encoding=’’utf-8")reader= csv.reader(SourceData)featureList=[]labelList=[]headers= f,nfor row in reader:if headers== ’"’:headers= rowelse:rowDict= {}for i in range(l,len(row)-l):rowDict[headers[i]]= row[i]featureList.append(rowDict)labelList.append(row[len(row)-1])vec= DictVectorizer()dummyX yec.fit_transform(featureList).toarray()lb= preprocessing丄a belBinarizer()dummy Y= lb.fittransform(labelList)elf = tree.DecisionTreeClassifier(criterion=,entr-opy')elf= elf.f it(dummyX,d ummy Y)with open(M des.dotM,V)as f:f = tree.export_graphviz(clf5feature—nam-es=vec.get_feature_names(),out_file=f)os.popenCVusr/local/bin/dot-Tpng-O des.dot")决策树图像如下:图i爬虫行为判定决策树图Fig.l Judgment and decision tree diagramof craw;er behavior测试集数据如下:表5请求行为测试数据集Tab.5 Request behavior test data set1234567 9Low No Yes Yes No No Yes TRUE 10High No Yes Yes No Yes No FALSE 11Low No No Yes No Yes No FALSE对测试集进行验证:newRow9 ==[〇,1,1,〇,〇,1,〇,1, i,〇,i,〇,〇,1]newRowlO[1,〇,1,〇,〇,1,〇,1, i,〇,〇,1,1,〇]newRowl1=[〇,1,1,〇,1,〇,〇,1, i,〇,〇,1,1,〇]newRowY9 = clf.predict(newRow9)newRowYlO= clf.predict(newRowlO)newRowY11= clf.predict(newRowl1)print(newRowY9)print(newRo w Y10)《软件》杂志欢迎推荐投稿:cosoft@vip.163 .com124刘宇等:基于决策树算法的爬虫识别技术print(newRowY 11)输出结果对应为TRUE ,FALSE ,FALSE ,和源数 据结果吻合!3根据性质判断设定反爬规则当决策树在检验某一类请求或者某个请求之后,确定该请求具备爬虫特性的时候,通常我们就 需要对该请求进行限制,常见的限制策略如下:(1)禁止访问:该方法是非友好方法,但是可以说该方法是有效方法。