CUDA_MPI和OpenMP三级混合并行模型的研究

并行程序设计实验报告-OpenMP 进阶实验

实验2:OpenMP 进阶实验1、实验目的掌握生产者-消费者模型,具备运用OpenMP相关知识进行综合分析,可实现实际工程背景下生产者-消费者模型的线程级负责均衡规划和调优。

2、实验要求1)single与master语句制导语句single 和master 都是指定相关的并行区域只由一个线程执行,区别在于使用master 则由主线程(0 号线程)执行,使用single 则由运行时的具体情况决定。

两者还有一个区别是single 在结束处隐含栅栏同步,而master 没有。

在没有特殊需求时,建议使用single 语句。

程序代码见程序2-12)barrier语句在多线程编程中必须考虑到不同的线程对同一个变量进行读写访问引起的数据竞争问题。

如果线程间没有互斥机制,则不同线程对同一变量的访问顺序是不确定的,有可能导致错误的执行结果。

OpenMP中有两种不同类型的线程同步机制,一种是互斥机制,一种是事件同步机制。

其中事件同步机制的设计思路是控制线程的执行顺序,可以通过设置barrier同步路障实现。

3)atomic、critical与锁通过critical 临界区实现的线程同步机制也可以通过原子(atomic)和锁实现。

后两者功能更具特点,并且使用更为灵活。

程序代码见程序2-2、2-3、2-44)schedule语句在使用parallel 语句进行累加计算时是通过编写代码来划分任务,再将划分后的任务分配给不同的线程去执行。

后来使用paralle for 语句实现是基于OpenMP 的自动划分,如果有n 次循环迭代k 个线程,大致会为每一个线程分配[n/k]各迭代。

由于n/k 不一定是整数,所以存在轻微的负载均衡问题。

我们可以通过子句schedule 来对影响负载的调度划分方式进行设置。

5)循环依赖性检查以对π 的数值估计的方法为例子来探讨OpenMP 中的循环依赖问题。

圆周率π(Pi)是数学中最重要和最奇妙的数字之一,对它的计算方法也是多种多样,其中适合采用计算机编程来计算并且精确度较高的方法是通过使用无穷级数来计算π 值。

并行计算编程模型及系统架构研究

并行计算编程模型及系统架构研究一、综述随着信息技术的飞速发展,计算任务的数量和复杂性呈现出迅速增长的态势。

传统的单处理器计算系统已经无法满足这些日益增长的需求,因此并行计算技术在众多领域得到了广泛的关注和研究。

并行计算编程模型及系统架构的研究不仅具有理论价值,而且在实际应用中具有广泛的意义。

在过去的几十年里,人们提出了许多并行计算编程模型,包括共享存储模型、分布式内存模型和图形处理器模型等。

这些模型各自具有一定的优势和局限性,适用于不同类型的应用场景。

本文将对这些并行计算编程模型及系统架构进行综述,以期为相关领域的研究和应用提供有益的参考。

随着芯片技术的发展,硬件性能得到了极大的提升,这为新并行计算模型的出现提供了物质基础。

随着计算机体系结构的改进,如多核处理器、GPU和分布式计算机系统等,也为新并行计算模型的实现提供了可能。

在并行计算编程模型方面,本文将重点关注共享存储模型、分布式内存模型和图形处理器模型等方面的研究进展。

在分布式内存模型方面,本文将介绍一致性哈希、目录一致性协议等相关技术。

在图形处理器模型方面,本文将探讨通用计算GPU和图形处理器编程模型(GPGPU)的发展及其在密码学、科学计算和机器学习等领域的应用。

在并行计算系统架构方面,本文将分析多种计算系统的结构,如层次结构、众核计算系统和可扩展计算系统等。

本文还将关注如何提高并行计算系统的可扩展性、性能和容错性等方面的研究。

本文将对并行计算编程模型及系统架构进行深入的综述,为相关领域的研究和应用提供有价值的参考。

1. 并行计算的重要性与挑战随着信息技术的飞速发展,数字数据处理和存储的需求呈现出爆炸性增长。

在这种背景下,并行计算逐渐成为解决复杂计算问题和提高计算效率的关键手段。

并行计算不仅能够缩短计算时间,提高资源利用率,还能为多学科领域的研究提供强大的支持,推动科学研究的进步。

提升计算效率:并行计算通过在多个处理器上同时执行多个任务,显著提高了计算速度,缩短了问题的解决周期。

高性能计算与并行程序设计

高性能计算与并行程序设计近年来,随着科学技术的不断发展,人们对计算机性能的需求也越来越高。

为了满足这种需求,高性能计算和并行程序设计成为了重要的研究领域。

本文将介绍高性能计算的概念、并行程序设计的原理和应用,并探讨两者之间的关系。

高性能计算是指利用计算机技术,通过并行处理和优化算法,以提高计算速度和处理能力的一种计算方法。

它通常用于处理大规模数据和复杂问题,如科学计算、气候预测、基因组学等领域。

高性能计算的关键在于充分利用计算机系统的硬件资源,如多核处理器、图形处理器和分布式存储等。

并行程序设计是实现高性能计算的关键技术之一。

它通过将计算任务分解为多个子任务,并在多个处理器上同步执行,以实现任务的并行处理。

并行程序设计有两个重要的概念:并行度和吞吐量。

并行度是指在同一时刻可以同时执行的任务数。

吞吐量是指单位时间内可以完成的任务数量。

通过合理设计并行程序,可以最大限度地提高并行度和吞吐量,从而提高计算性能。

在并行程序设计中,有两种主要的并行模式:数据并行和任务并行。

数据并行是将数据划分为多个部分,分配给不同的处理器并独立处理。

任务并行是将不同的任务分配给不同的处理器并同时执行。

数据并行主要适用于大规模数据的处理,例如图像处理或科学模拟等。

任务并行主要适用于处理大量独立任务的情况,例如搜索引擎的网页爬虫或分布式数据库管理系统等。

为了实现高性能计算和并行程序设计,有一些常用的编程模型和工具可以使用。

其中最常见的是消息传递接口(MPI)和共享内存模型。

MPI是一种用于编写并行程序的通信库,通过在不同的进程之间传递消息来实现通信和同步。

共享内存模型则是通过共享内存区域来实现不同线程之间的数据共享和通信。

除了这些基本的编程模型,还有一些高级的并行编程工具和库,如OpenMP和CUDA等。

高性能计算和并行程序设计在许多领域都有广泛的应用。

在科学研究中,高性能计算和并行程序设计可以用于加速各种科学计算,如天体物理学的星系模拟、分子动力学模拟和量子化学计算等。

高性能计算在科学研究中的应用考核试卷

B. TCP/IP

C. UDP

D. SCSI

5.以下哪些是高性能计算中常见的并行编程模型?()

A. OpenMP

B. MPI

C. CUDA

D. Java RMI

6.高性能计算在物理学中的应用包括以下哪些?()

A.量子力学模拟

B.粒子物理实验数据分析

C.流体力学模拟

D.天体物理模拟

7.以下哪些是影响高性能计算系统性能的因素?()

D.在不同地理位置的计算机之间进行计算

8.以下哪种存储技术不适合高性能计算?()

A. SSD

B. HDD

C. NVRAM

D.磁带存储

9.在高性能计算中,哪种网络技术主要用于节点间的通信?()

A. Ethernet

B. InfiniBand

C. Wi-Fi

D. DSL

10.关于高性能计算集群,以下哪项描述是错误的?()

B.量子化学计算

C.药物设计

D.化学反应机理研究

11.以下哪些是高性能计算系统中的存储层次结构?()

A.寄存器

B.缓存

C.主存

D.分布式文件系统

12.高性能计算在气候模型中的应用包括以下哪些?()

A.气候变化的长期预测

B.灾害性天气事件的短期预测

C.大气化学成分的研究

D.海洋环流模拟

13.以下哪些是高性能计算中的能效优化策略?()

2.高性能计算中的并行计算只能通过增加处理器数量来提高性能。()

3.在分布式计算中,所有节点都共享一个公共的内存空间。()

4.高性能计算中的异构计算是指在一个系统中结合使用CPU和GPU。()

5.高性能计算系统中的负载平衡是在计算开始前分配任务。()

MPI在大规模并行计算中的应用

MPI在大规模并行计算中的应用一、MPI的介绍MPI(Message Passing Interface)是一种消息传递接口标准,用于在多个计算节点之间进行通信和数据传递。

MPI的出现极大地推动了科学计算和工程计算的大规模并行化和分布式计算。

MPI 有多种实现,如MPICH、OpenMPI和MVAPICH等。

二、MPI的工作原理MPI的工作原理是基于点对点通信,即两个节点之间的通信。

通信方式分为同步和异步两种。

同步通信是指发送方将数据发送到接收端并等待接收端接收,然后才继续执行后续操作。

异步通信则是发送方将数据发送给接收方,而不等待接收端接收,然后就可以继续执行后续操作。

三、MPI在大规模并行计算中广泛应用,如天气预测、生物制药、核物理、空气动力学等领域。

以下是介绍MPI在大规模并行计算中的应用:1. 生物制药生物制药的工艺流程非常复杂,需要处理大量的数据和复杂算法。

MPI可以实现多个生物反应器之间的并行计算,加速反应速率和节省计算时间,同时保证结果的准确性和可靠性。

例如,在DNA分子建模中,MPI可以将一份任务分配给多个计算节点,以提高计算速度。

2. 天气预测天气预测需要处理大量气象数据,包括风速、温度、湿度等。

MPI可以将这些数据分配给计算节点进行处理,以减少计算时间和提高准确性。

例如,在大气模型预测方面,MPI可以将模型分散到多个节点中进行模拟,模拟结果交换并合并成一个预测结果。

3. 核物理在核物理领域,MPI可以实现大规模的数据交换和复杂算法计算。

例如,MPI可以处理以太核物质的模拟和分析,以提高核物理实验的效率和准确性。

4. 空气动力学在航空航天工程中,MPI可以模拟航空器受到的气动力,提高航天飞行器的效率和性能。

例如,在飞机设计方面,MPI可以将模拟数据分配到多个计算节点上进行分析和计算,以提高计算速度和准确性。

四、本文的结论MPI在大规模并行计算中有着广泛的应用,可以提高计算速度和准确性,同时保证数据的可靠性。

并行计算机程序设计导论pdf

CUDA最佳实践

总结CUDA编程的最佳实践, 包括编写高效的CUDA内核函 数、使用异步操作、避免不 必要的内存拷贝等方面的内 容。

43

07

并行计算应用案例分析

BIG DATA EMPOWERS TO CREATE A NEW

ERA

2024/1/25

44

气象模拟应用案例分析

气候模型

使用并行计算模拟大气、海洋和陆地之间的相互作用,以预测气 候变化。

42

CUDA性能优化策略

CUDA性能分析

介绍如何使用CUDA性能分析 工具(如NVIDIA Visual

Profiler和Nsight)来评估和 优化CUDA程序的性能。

CUDA优化技术

详细讲解CUDA优化的关键技 术,包括内存访问优化、线 程同步优化、指令级优化和 算法级优化等。

2024,并行计算的应用前景更加广阔。未来,量子计算等新型计算技术的发展将进一 步推动并行计算的进步,为解决复杂问题提供更加高效的方法。

2024/1/25

6

02

并行计算机体系结构

BIG DATA EMPOWERS TO CREATE A NEW

ERA

2024/1/25

7

并行计算机分类与特点

// 计算点积并汇总结果

03

for (int i = rank; i < n; i += size) {

27

MPI编程实例分析

• dot_product += a[i] * b[i];

2024/1/25

28

MPI编程实例分析

}

// 使用MPI_Reduce函数汇总各个进程的计算结果

2024/1/25

CUDA与OpenMP、MPI的比较

CUDA Kernels

A kernel is the piece of code executed on the CUDA device by a single CUDA thread. Each kernel is run in a thread. Threads are grouped into warps of 32 threads. Warps are grouped into thread blocks. Thread blocks are grouped into grids. Blocks and grids may be 1d, 2d, or 3d Each kernel has access to certain variables that define its position – gridDim, blockIdx, blockDim, threadIdx. Useful for a dataset index While host code may be C++, this must be C along with CUDA syntax extensions

Can also branch off, though, so not strictly SIMD

Provides a small amount of additional syntax to C or C++ which allows parallel “kernels” to be run on the device

“DeviceToHost “DeviceToDevice

MPI的搭建及OpenMP的配置实验指导书

MPI的搭建及OpenMP的配置实验指导书1.MPI简介消息传递接口(Message Passing Interface,MPI)是目前应用较广泛的一种并行计算软件环境,是在集群系统上实现并行计算的软件接口。

为了统一互不兼容的的用户界面,1992年成立了MPI委员会,负责制定MPI的新标准,支持最佳的可移植平台。

MPI不是一门新的语言,确切地说它是一个C和Fortran的函数库,用户通过调用这些函数接口并采用并行编译器编译源代码就可以生成可并行运行的代码。

MPI的目标是要开发一个广泛用于编写消息传递程序的标准,要求用户界面实用、可移植,并且高效、灵活,能广泛应用于各类并行机,特别是分布式存储的计算机。

每个计算机厂商都在开发标准平台上做了大量的工作,出现了一批可移植的消息传递环境。

MPI吸收了它们的经验,同时从句法和语法方面确定核心库函数,使之能适用于更多的并行机。

MPI在标准化过程中吸收了许多代表参加,包括研制并行计算机的大多数厂商,以及来自大学、实验室与工业界的研究人员。

1992年开始正式标准化MPI,1994年发布了MPI的定义与实验标准MPI 1,相应的MPI 2标准也已经发布。

MPI吸取了众多消息传递系统的优点,具有很好的可以执行、易用性和完备的异步通信功能等。

MPI事实上只是一个消息传递标准,并不是软件实现并行执行的具体实现,目前比较著名的MPI具体实现有MPICH、LAM MPI等,其中MPICH是目前使用最广泛的免费MPI系统,MPICH2是MPI 2标准的一个具体实现,它具有较好的兼容性和可扩展性,目前在高性能计算集群上使用非常广泛。

MPICH2的使用也非常简单,用户只需在并行程序中包含MPICH的头文件,然后调用一些MPICH2函数接口将计算任务分发到其他计算节点即可,MPICH2为并行计算用户提供了100多个C和Fortran函数接口,表1-1列出了一些常用的MPICH2的C语言函数接口,用户可以像调用普通函数一样,只需要做少量的代码改动就可以实现程序的并行运行,MPICH并行代码结构如图1-1所示。

基于MPI与OpenMP混合并行计算技术的研究

基于MPI与OpenMP混合并行计算技术的研究李苏平,刘羽,刘彦宇(桂林理工大学信息科学与工程学院,广西桂林541004)摘要:针对多核机群系统的硬件体系结构特点,提出了节点间MPI消息传递、节点内部OpenMP共享存储的混合并行编程技术。

该编程模型结合了两者的优点,更为有效地利用了多核机群的硬件资源。

建立了单层混合并行的Jacobi求对称矩阵特征值算法。

实验结果表明,与纯MPI算法相比,混合并行算法能够取得更好的加速比。

关键词:混合编程模型;多核机群;MPI; OpenMPTP312:A:1672-7800(2010)03-0050-031 MPI与OpenMP混合模型MPI( Message Passing Interface)是消息传递并行编程模型的代表和事实标准,可以轻松地支持分布存储和共享存储拓扑结构;OpenMP是为共享存储环境编写并行程序而设计的一个应用编程接口,是当前支持共享存储并行编程的工业标准。

在SMP机群系统中,混合编程模型已经有一些成功的应用,对于多核PC机群的混合编程模型研究才开始起步。

在多核PC 机群中,结合MPI与OpenMP技术,充分利用这两种编程模型的优点,在付出较小的开发代价基础上,尽可能获得较高的性能。

按照在MPI进程间消息传递方式和时机,即消息何时由哪个或哪些线程在MPI进程间传递进行分类,混合模型可以分为以下两种:(1)单层混合模型(Hybrid master- only)。

MPI调用发生在应用程序多线程并行区域之外,MPI实现进程间的通信由主线程执行。

该混合模型编程易于实现,即在基于MPI模型程序的关键计算部分加上OpenMP循环命令#pramgma omp par-allel- -即可。

(2)多层混合模型(Hybrid multiple)。

MPI调用可以发生在应用程序多线程并行区域内,进程间通信的可由程序任何区域内的任何一个或一些线程完成。

在该模型中,当某些线程进行通信时,其它的非通信线程同时进行计算,实现了通信与计算的并行执行,优化了进程间的通信阻塞问题。

《并行程序设计导论》第三章

常见实现

MPI、PVM、Concurrent ML等。

数据并行编程模型

定义

数据并行编程模型将数据划分为多个独立的部分,每个 部分可在不同的处理器上并行处理。

缺点

需要对数据进行合理的划分和调度,以确保负载均衡和 避免数据依赖问题。

ABCD

优点

适用于数据密集型应用,可充分利用多核/多线程处理器 的计算能力,提高程序执行效率。

并行算法设计原则

分解

将问题分解成若干个可以并行执行的子问题,以便在多个处理单元上 同时进行计算。

平衡负载

确保各个处理单元的计算负载大致相等,避免出现某些处理单元空闲 而其他处理单元过载的情况。

减少通信

尽量减少处理单元之间的通信开销,因为通信通常比计算更耗时。可 以通过采用局部性原理和选择合适的数据分布策略来实现。

• 信号(Signal):信号是一种比较复杂的通信方式,用于通知接收进程有某种 事件发生。

• 共享内存(Shared Memory):共享内存就是映射一段能被其他进程所访问 的内存,这段共享内存由一个进程创建,但多个进程都可以访问。共享内存是 最快的 IPC 方式,它是针对其他进程间通信方式运行效率低而专门设计的。它 往往与其他通信机制,如信号量,配合使用来实现进程间的同步和通信。

进程同步机制

信号量(Semaphore)

信号量是一个计数器,可以用来控制多个进程对共享资源的访问。它常作为一种锁机制,防止某进程 正在访问共享资源时,其他进程也访问该资源。因此,主要作为进程间以及同一进程内不同线程之间 的同步手段。

互斥锁(Mutex)

互斥锁是一种简单的加锁的方法来控制对共享资源的访问,互斥锁只有两种状态,即上锁( lock )和解锁 ( unlock )。

并行优化算法研究

目录页

Contents Page

1. 并行优化算法简介 2. 并行计算基础知识 3. 并行优化算法分类 4. 经典并行优化算法 5. 并行优化算法应用领域 6. 并行优化算法挑战与未来发展 7. 并行优化算法实例分析 8. 总结与展望

并行优化算法研究

并行优化算法简介

并行优化算法简介

新型硬件和计算架构

1.随着新型硬件和计算架构的不断涌现,并行优化算法需要适应这些新的计算环境,以提高性能和 效率。 2.例如,利用GPU和TPU等加速器可以大幅提高并行优化算法的计算速度,而采用分布式存储和计 算架构可以扩展算法的处理能力。 3.在未来的研究中,需要关注新型硬件和计算架构的发展趋势,探索更为高效和稳定的并行优化算 法。

并行计算基础知识

▪ 并行计算应用领域

1.并行计算在科学计算、工程仿真、数据分析等领域得到广泛应用。 2.并行计算可以加速计算过程,提高计算效率,为应用领域提供更好的解决方案。 3.随着并行计算技术的发展,其应用领域也将不断扩大。

▪ 并行计算发展趋势

1.并行计算将继续向更高效、更可扩展的方向发展。 2.人工智能、量子计算等前沿技术将与并行计算相结合,推动其发展。 3.并行计算将成为未来计算机科学技术的重要组成部分,为各领域的发展提供支持。

▪ 遗传算法

1.遗传算法是一种基于生物进化原理的优化算法,它通过模拟自然选择和遗传机制来搜索问题 的最优解。 2.在并行环境中,可以将种群划分成多个子种群,每个子种群在一个处理节点上进行进化计算 ,然后定期交换信息,以加速搜索过程。 3.遗传算法的并行化需要考虑种群划分和交换策略,以及如何处理进化过程中的多样性问题。

1.粒子群优化算法是一种基于群体协作的优化算法,通过粒子间的相互作用搜索最优解。 2.并行化粒子群优化算法可利用多个计算节点同时更新粒子位置和速度,提高搜索效率。 3.针对非凸、多峰的优化问题,需要设计合适的粒子初始化和更新策略。

并行计算实验报告

并行计算实验报告《并行计算实验报告》摘要:本实验报告旨在介绍并行计算的基本概念和原理,并通过实验结果展示并行计算在提高计算效率和性能方面的优势。

实验采用了不同的并行计算技术和工具,并对比了串行计算和并行计算的性能表现,以验证并行计算在处理大规模数据和复杂计算任务时的优越性。

1. 引言并行计算是一种利用多个处理器或计算节点同时进行计算任务的技术。

它可以显著提高计算效率和性能,特别是在处理大规模数据和复杂计算任务时。

本实验报告将通过一系列实验来展示并行计算的优势和应用场景。

2. 实验设计本次实验采用了多种并行计算技术和工具,包括MPI(Message Passing Interface)、OpenMP和CUDA。

实验分为两个部分:第一部分是对比串行计算和并行计算的性能表现,第二部分是针对特定应用场景的并行计算实验。

3. 实验结果在第一部分实验中,我们对比了串行计算和MPI并行计算的性能表现。

实验结果显示,随着计算规模的增加,MPI并行计算的性能优势逐渐显现,尤其在处理大规模数据时表现更为明显。

而在第二部分实验中,我们针对图像处理任务使用了OpenMP和CUDA进行并行计算,实验结果显示,这两种并行计算技术都能够显著提高图像处理的速度和效率。

4. 结论通过实验结果的对比和分析,我们可以得出结论:并行计算在处理大规模数据和复杂计算任务时具有明显的优势,能够显著提高计算效率和性能。

不同的并行计算技术和工具适用于不同的应用场景,选择合适的并行计算方案可以最大程度地发挥计算资源的潜力。

5. 展望未来,随着计算资源的不断增加和并行计算技术的不断发展,我们相信并行计算将在更多领域得到应用,为我们解决更多复杂的计算问题提供强大的支持和帮助。

综上所述,本实验报告通过实验结果展示了并行计算在提高计算效率和性能方面的优势,为并行计算技术的应用和发展提供了有力的支持和验证。

大规模平行计算模型与算法研究

大规模平行计算模型与算法研究在当今信息时代,计算机技术日益发展,人们对高效的计算有着更加迫切的需求。

大规模平行计算模型和算法是当前计算机领域的热门研究方向,归纳起来就是如何将计算任务分配到多台计算机上进行并行计算,以提高计算效率、降低计算时间和成本。

一、大规模平行计算模型大规模平行计算模型是指利用多台计算机进行分布式计算,以完成一个或多个计算任务的过程。

目前,常用的大规模平行计算模型主要有SPMD(Single Program Multiple Data)、MPMD(Multiple Program Multiple Data)和MIMD (Multiple Instruction Multiple Data)三种。

首先是SPMD模型,这种模型比较简单易懂,多个计算机执行相同的程序,但每个计算机执行的数据不同,相互之间不进行通信。

这种模型的好处是程序的编写和调试比较方便,但是由于计算节点之间缺乏通信,也就限制了其应用的范围。

其次是MPMD模型,多个计算机执行不同的程序,但是数据相同,这样计算任务间相互独立。

这种模型的好处是能够充分利用节点之间的通信,计算效率高,但是需要对程序进行分布式编程。

最后是MIMD模型,多个计算机执行不同的程序,数据也不同,这种模型应用范围最广,但是也是最复杂的。

在这种模型下,计算节点之间需要进行通信和同步,而程序也需要进行分布式编程。

二、大规模平行计算算法大规模平行计算算法主要是针对分布式环境下的并行计算而设计的。

目前常见的大规模平行计算算法包括MapReduce、MPI、OpenMP和CUDA等。

MapReduce是由谷歌公司开发的一种分布式计算模型,它将一个较大的计算任务分为许多小的子任务,并将这些子任务分配到不同的计算节点上进行计算,最后再将结果合并。

MapReduce的优势在于可以很好地适应大规模计算任务以及海量数据处理,尤其是在搜索引擎和网站日志处理方面的应用非常广泛。

机器学习知识:机器学习中的并行计算

机器学习知识:机器学习中的并行计算在机器学习领域中,对于大规模数据集和复杂模型的训练,计算能力的要求往往是巨大的,而并行计算技术则能够满足这些需求,并将训练时间减少到可接受的范围内。

本文将介绍机器学习中的并行计算技术及其应用。

一、并行计算概述并行计算是指在多个处理器之间同时完成任务,以共同完成被分解的任务,通过充分利用多处理器处理同一任务的优势,加速计算过程,降低计算成本,提高运算效率。

在计算机领域,并行计算通常分为两种方式:并发计算、分布式计算。

1.并发计算并发计算(Concurrency)指在一个时间段内,有多个程序在同一系统内运行,它们共享系统资源,但每个程序都可以并行独立地执行。

并发计算有对称型多处理机、共享内存计算机和计算网格等几种实现方法。

在机器学习中,使用多个CPU核心对数据进行并发处理,以加快模型训练的速度。

2.分布式计算分布式计算(Distributed Computing)指在多个计算机上分别处理同一任务并通过网络互相连通完成任务。

它是一种通过将一个大规模的计算问题划分成许多小规模的子问题,分别在不同的计算机上计算并处理后再将结果进行合并的计算方式,也称为网格计算。

在机器学习领域中,分布式计算技术通常被用于大规模数据集的训练,发挥其大规模分布式的优势。

二、在机器学习中的并行计算技术机器学习中的并行计算技术是通过并行算法、并行模型和并行编程技术实现的。

1.并行算法并行计算的核心是并行算法,对于不同的模型和任务,采用不同的并行算法可以取得更好的效果。

并行算法的主要方法有分治法、图算法、遗传算法、神经网络算法等。

为了加快训练速度,机器学习领域中的算法更多地运用了分治和图算法。

分治算法(Divide and Conquer)是一个解决问题的思维方法,将一个大问题拆解成许多小问题,同时使用不同的处理器来处理不同的小问题,提高了计算能力。

图算法(Graph-Based)是机器学习中最常见的一种并行算法,它是指将图表示的数据集进行划分,让不同的处理器计算不同的子图,然后再将计算结果进行合并。

面向大数据高通量计算的CPU-GPU并行优化技术研究

面对大数据高通量计算的CPU-GPU并行优化技术探究摘要:随着互联网技术的不息进步,数据量呈现爆炸性增长,在海量数据的处理过程中,高速计算能力的提升是至关重要的。

本文针对大数据高通量计算对计算能力的要求,提出了CPU/GPU并行优化技术。

起首介绍了大数据高通量计算的应用领域和背景,然后分别从数据划分、数据通信、并行计算以及算法优化等方面探讨了CPU/GPU并行优化的技术方法,包括任务并行、数据并行、混合并行等,解决了数据规模大、计算量大、时间效率低下等问题。

最后,通过试验测试验证了此方法的有效性,提高了计算速度和性能等指标。

关键词:大数据,高通量计算,CPU/GPU并行优化,任务并行,数据并行,混合并行1. 引言随着互联网技术、人工智能技术和物联网技术的不息进步和应用,大数据处理呈现出爆炸式增长的态势,对计算能力提出了更高的要求。

近年来,CPU/GPU并行计算技术得到了广泛的应用,其中GPU作为一种高效能的加速器,在大数据高通量计算方面具有不行替代的优势,通过其高并行的处理能力来解决数据量大、计算量大、时间效率低下等问题。

本文针对大数据高通量计算的需求,探究了CPU/GPU并行优化技术,以提高计算速度和性能。

2. 大数据高通量计算的应用领域和背景随着数据量的不息增大,大数据高通量计算得到了广泛的应用。

在金融、医疗、教育、电商以及企业的生产与管理等多个领域,都需要对大量数据进行快速计算和分析。

例如,在金融领域,需要对来往数据进行快速处理,做出智能决策;在医疗领域,需要对大量病例数据进行统计和分析,为医生提供可靠的诊断依据;在电商领域,需要对海量商品数据进行分析和分类,实现个性化推举等。

3. CPU/GPU并行优化技术的方法针对大数据高通量计算的需求,我们提出了一种基于CPU/GPU并行优化技术的方法。

主要包括任务并行、数据并行和混合并行等几个方面。

3.1 任务并行任务并行是指将一个大的任务分解成若干个小的任务,分别在不同的CPU核心和GPU流处理器上运行,使不同的任务可以同时执行,达到加速处理的目标。

热传导问题高效并行算法设计与实现研究

热传导问题高效并行算法设计与实现研究一、热传导问题概述热传导问题,作为物理学中的一个重要分支,主要研究热量在物体内部或不同物体之间的传递过程。

在工程应用中,热传导问题广泛存在于电子设备散热、建筑节能、材料加工等多个领域。

随着现代科技的发展,对于热传导问题的精确模拟和高效计算需求日益增长,这促使了高效并行算法设计与实现研究的不断深入。

1.1 热传导问题的基本理论热传导问题基于傅里叶热传导定律,该定律指出,热量的传递速率与物体内部温度梯度成正比,并且热量总是从高温区域向低温区域传递。

在三维空间中,热传导方程可以表示为偏微分方程的形式,即:\[\frac{\partial T}{\partial t} = \alpha \left( \frac{\partial^2 T}{\partial x^2} + \frac{\partial^2 T}{\partial y^2} + \frac{\partial^2 T}{\partial z^2} \right)\]其中,\( T \) 表示温度,\( \alpha \) 为热扩散率,\( t \) 为时间,\( x, y, z \) 为空间坐标。

1.2 热传导问题的数值方法为了求解热传导方程,常用的数值方法包括有限差分法、有限元法和有限体积法等。

这些方法通过将连续的偏微分方程离散化为代数方程组,从而利用计算机进行求解。

然而,随着问题的规模增大,传统的串行算法在计算效率和处理能力上逐渐显得力不从心,因此,研究高效的并行算法成为了解决大规模热传导问题的关键。

二、高效并行算法设计在并行计算领域,算法设计的核心目标是提高计算效率和缩短计算时间。

针对热传导问题,高效并行算法的设计主要涉及以下几个方面:2.1 并行计算模型并行计算模型是实现并行算法的基础,常见的并行计算模型包括共享内存模型(如OpenMP)和分布式内存模型(如MPI)。

在热传导问题中,根据问题的规模和复杂度,选择合适的并行计算模型对于算法性能有着重要影响。

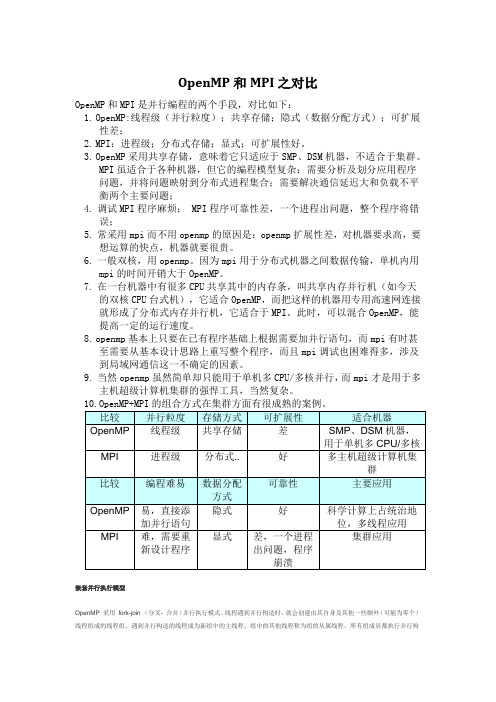

OpenMP和MPI之对比

OpenMP和MPI之对比

嵌套并行执行模型

OpenMP 采用fork-join (分叉- 合并)并行执行模式。

线程遇到并行构造时,就会创建由其自身及其他一些额外(可能为零个)线程组成的线程组。

遇到并行构造的线程成为新组中的主线程。

组中的其他线程称为组的从属线程。

所有组成员都执行并行构

造内的代码。

如果某个线程完成了其在并行构造内的工作,它就会在并行构造末尾的隐式屏障处等待。

当所有组成员都到达该屏障时,这些线程就可以离开该屏障了。

主线程继续执行并行构造之后的用户代码,而从属线程则等待被召集加入到其他组。

OpenMP 并行区域之间可以互相嵌套。

如果禁用嵌套并行操作,则由遇到并行区域内并行构造的线程所创建的新组仅包含遇到并行构造的线程。

如果启用嵌套并行操作,则新组可以包含多个线程。

OpenMP 运行时库维护一个线程池,该线程池可用作并行区域中的从属线程。

当线程遇到并行构造并需要创建包含多个线程的线程组时,该线程将检查该池,从池中获取空闲线程,将其作为组的从属线程。

如果池中没有足够的空闲线程,则主线程获取的从属线程可

能会比所需的要少。

组完成执行并行区域时,从属线程就会返回到池中。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

第31卷第9期2010年9月微 计 算 机 应 用M I CROCOMP UTER APP L I CATI O NSVol131No19Sep12010CU DA、M P I和O penM P三级混合并行模型的研究滕人达 刘青昆(辽宁师范大学 计算机与信息技术学院 大连 116081)摘要:采用CUDA+MP I+Open MP的三级并行编程模式,实现节点间的粗粒度并行,节点内的细粒度并行以及将GP U作为并行计算设备的C UDA编程模型。

这种新的三级并行混合编程模式为S M P机群提供了一种更为高效的并行策略。

本文讨论了三级并行编程环境的快速搭建以及多粒度混合并行编程方法,并在多个节点的机群环境中完成测试工作。

关键词:CUDA M P I O pen M P 图形处理器 机群系统M i xed CUDA、M P I and O pen M P i n Three M ode Para llel Programm i n gTENG Renda,L IU Q ingkun(College of Computer and I nfor mati on Technol ogy,L iaoning Nor mal University,Dalian,116081,China)Abstract:U sing C UDA+M P I+Open M P parallel p r ogramm ing model of the three t o achieve the coarse-grained parallelbet w een nodes,node fine-grained parallelis m as well as within the GP U as a parallel computing devices C UDA p r ogra mm ing model1This ne w three parallel hybrid p r ogra mm ing way S M P cluster p r ovides a more efficient parallel strategy1This article discusses the three parallel p r ogramm ing envir on ment t o build fast and multi2granular hybrid parallel p r ogra mm ing method,and in a nu mber of nodes in the cluster envir on ment,the comp leti on of testing1Keywords:CUDA,MP I,OPen MP,GP U,cluster parallelS MP(Sy mmetric Multi p r ocess or)机群系统已经成为一种并行计算机体系中的主流体系结构。

它是由拥有多个处理器的S MP节点和高速网络连接设备组成的多级体系结构。

这种体系提供了节点间的粗粒度和节点内的细粒度的两级并行。

目前较为流行的并行程序设计模型为基于消息传递的MP I(Message Passing I nterface)编程模式,S MP节点内的Open MP模式,结合MP I和Open MP的混合编程模型,以及利用GP U作为并行数据计算设备的MP I+Open MP+CUDA的三级混合编程模型。

这种三级混合编程模型在节点间使用消息传递模型,在节点内使用共享内存的模型和CUDA编程模型。

CUDA编程模型中GP U作为一个协处理器能产生大量的线程,这种优势要得益于GP U的物理构造, GP U由许多晶体管组成,专为计算密集型、高度并行化的计算而设计,因而GP U的设计能使更多晶体管用于数据处理,而非数据缓存和流控制,GP U专用于解决可表示为数据并行计算的问题———在许多数据元素上并行执行的程序,具有极高的计算密度(数学运算与存储器运算的比率)。

由于所有数据元素都执行相同的程序,因此对精密流控制的要求不高;由于在许多数据元素上运行,且具有较高的计算密度,因而可通过计算隐藏存储器访问延迟,而不必使用较大的数据缓存。

这些晶体管能够执行大量线程并行,程序员把问题分解成粗粒度的子问题,这些子问题可以独立的并行解决。

然后把这些子问题细分为更小的细粒度任务,将本文于2010-07-19收到。

微 计 算 机 应 用2010年每个子任务放到任何一个可用的处理核心上处理。

这样经过编译的CUDA程序就可以在任何处理器核心上运行。

这种新型的三级混合编程模型可以更好的发挥S MP机群的优势,近年来这种混合编程模型已经得到越来越多科学领域的认可由于涉及到三种不同的并行环境,普通用户面临并行环境搭建耗费时间的为题,同时这种混合编程模型要求系统管理三种不同的内存模型,这使得程序设计更加的复杂。

本文在双节点的S MP机群上建立了CUDA+MP I+Open MP的混合编程环境,并采用细粒度的数据并行化和线程并行化,嵌套于粗粒度的数据并行化和任务并行化之中,并在搭好的三级并行S MP机群环境上通过了测试。

1 CU DA、M P I以及O penM P模型111 CU DACUDA是NV I D I A公司的并行计算架构,该架构通过利用GP U(图形处理器)的处理能力,能够大幅提升计算性能。

该架构通过利用GP U(图形处理器)的处理能力,能够大幅提升计算性能。

CUDA采用C语言作为编程语言提供大量的高性能计算指令开发能力,使开发者能够在GP U的强大计算能力的基础上建立起一种效率更高的密集数据计算解决方案。

CUDA是首款并行运算语言。

GP U专用于解决可表示为数据并行计算的问题———在许多数据元素上并行执行的程序,具有极高的计算密度(数学运算与存储器运算的比率)。

由于所有数据元素都执行相同的程序,因此对精密流控制的要求不高;由于在许多数据元素上运行,且具有较高的计算密度,因而可通过计算隐藏存储器访问延迟,而不必使用较大的数据缓存。

CUDA把GP U当成CP U的协调处理器,提供了大规模多线程架构。

通常CP U提供2-4个核心处理器,而GP U架构提供了百倍数的核心,甚至更多,使得利用很多线程来进行并行处理。

数据并行处理会将数据元素映射到并行处理线程。

许多处理大型数据集的应用程序都可使用数据并行编程模型来加速计算。

随着数百万支持CUDA的GP U已经遍布全球计算机,软件开发人员、科学人士和研究人员正在利用CUDA探测到更多更广的领域中,包括图像和视频编辑、计算生物学和计算化学、流体力学模拟、CT图像重组、地震分析、光线追踪以及其它更多。

计算行业正在从只使用CP U的“中央处理”向CP U与GP U并用的“协同处理”发展。

为打造这一全新的计算典范,NV I D I A发明了CUDA并行计算架构,该架构现已应用于GeForce(精视)、I O N(翼扬)、Quadr o 以及Tesla GP U(图形处理器)上。

GP U相对于CP U的优缺点如表1所示。

表1 GPU的优缺点GP U2advantage GP U2disadvantage具有更大的内存带宽GPGP U程序模型不成熟具有更大量的执行单元不完全支持I EEE-754规格具有比高级CP U低廉的价格不具有分支预测等复杂的流程控制单元11111 CUDA架构在CUDA的架构下,程序分为两个部份:host端和device端。

Host端是指在CP U上执行的部份,而device端则是在显示芯片上执行的部份。

Device端的程序又称为kernel程序。

通常host端程序会将准备好的数据拷贝到显卡的内存中,再由显示芯片执行device端程序,完成后再由host端程序将结果从显卡的内存中取回。

由于CP U存取显卡内存时只能透过PC I Exp ress接口,因此速度较慢(PC I Exp ress x16的理论带宽是双向各4G B/s),因此不能频繁进行此类操作,以免降低程序执行效率。

在CUDA架构下,显示芯片执行时的最小单位是thread。

数个thread可以组成一个bl ock。

一个bl ock中的thread能存取同一块共享的内存,而且可以快速进行同步的动作。

每一个bl ock中所包含的thread数目是有限的。

不过,执行相同程序的46 9期 滕人达等:CUDA 、MP I 和Open MP三级混合并行模型的研究bl ock,可以组成grid 。

不同bl ock 中的thread 无法存取同一个共享的内存,因此无法直接互通或进行同步。

因此,不同bl ock 中的thread 能合作的程度是比较低的。

不过,利用这个模式,可以让程序不用担心GP U 实际上能同时执行的thread 数目限制。

Grid 、bl ock 和thread 的关系,如图1所示。

图1 host 2device 关系图每个thread 都有自己的一份register 和l ocal me mory 的空间。

同一个bl ock 中的每个thread 则有共享的一份share me mory 。

此外,所有的thread (包括不同bl ock 的thread )都共享一份gl obal me mory 、constant me mory 、和texture me mory 。

不同的grid 则有各自的gl obal me mory 、constant me mory 和texture me mory 。

CUDA 的核心有三个重要抽象概念:线程组层次结构、共享存储器、屏蔽同步(barrier synchr onizati on ),可轻松将其作为C 语言的最小扩展级公开给程序员。

这些抽象提供了细粒度的数据并行化和线程并行化,嵌套于粗粒度的数据并行化和任务并行化之中。

它们将指导程序员将问题分解为更小的片段,以便通过协作的方法并行解决。

这样的分解保留了语言表达,允许线程在解决各子问题时协作,同时支持透明的可伸缩性,使您可以安排在任何可用处理器内核上处理各子问题:因而,编译后的CUDA 程序可以在任何数量的处理器内核上执行,只有运行时系统需要了解物理处理器数量。

在定义内核时,需要使用_gl obal_声明说明符,使用一种全新的<<<…>>>语法指定每次调用的CUDA 线程数。

执行内核的每个线程都会被分配一个独特的线程I D ,可通过内置的thread I dx 变量在内核中访问此I D 。

线程块是可以协调工作的一批线程,它们通过高速共享内存有效地共享数据,并同步执行以协调访56微 计 算 机 应 用2010年存。