信息论与编码_第2讲_信源及其信息量1_自信息与熵

信息论与编码-第2讲-信源及信息度量1

自信息含义

当事件xi发生以前:表示事件xi发生的不确定性。 当事件xi发生以后:表示事件xi所含有(或所提供)的信

息量。在无噪信道中,事件xi发生后,能正确无误地传输到 收信者,所以I(xi)可代表接收到消息xi后所获得的信息量。 这是因为消除了I(xi)大小的不确定性,才获得这么大小的信 息量。

2.1.1 单符号离散信源的数学模型

(1) 信源的描述方法 (2) 单符号离散信源数学模型

(1) 信源的描述方法

在通信系统中收信者在未收到消息以前,对信源发出 什么消息是不确定的。

① 离散信源:输出的消息常常是以一个个符号形式出现,

这些符号的取值是有限的或可数的。 单符号离散信源:只涉及一个随机事件,可用随机变量描述。 多符号离散信源:每次输出是一个符号序列,序列中每一位出现

② 联合自信息量

信源模型为

x2 y1 ,, x2 ym ,, xn y1 ,, xn y m XY x1 y1 ,, x1 ym , P( XY ) p( x y ),, p( x y ), p( x y ),, p( x y ),, p( x y ),, p( x y ) 1 m 2 1 2 m n 1 n m 1 1

计算y1与各种天气之间的互信息量 对天气x1,不必再考虑 对天气x2, I ( x2 ; y1 ) log2 p( x2 / y1 ) log2 1/ 2 1(比特) p( x ) 1/ 4

i i

验概率的函数。

函数f [p(xi)]应满足以下4个条件 根据上述条件可以从数学上证明这种函数形式是对 数形式。

信息论与编码信源与信息熵

• 联合熵H(X1,X2)表达平均每二个信源符号所携带 旳信息量。

• 我们用1/2H(X1,X2)作为二维平稳信源X旳信息熵 旳近似值。那么平均每一种信源符号携带旳信

息量近似为:

– 信源符号分布旳不均匀性。 • 等概率分布时信源熵最大。

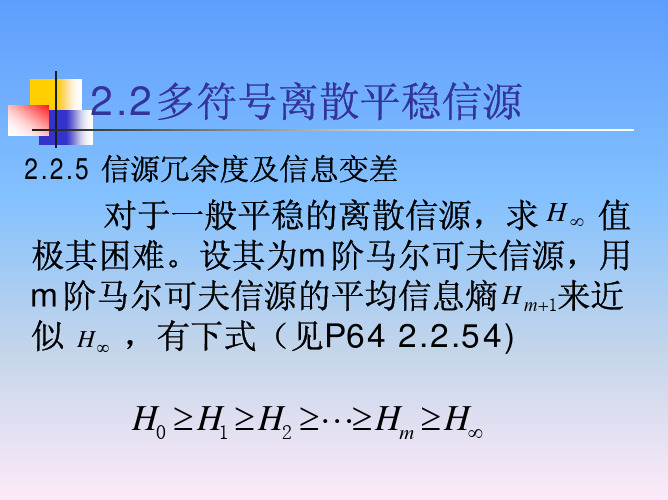

log 2 n H0 (X ) H1(X ) H2 (X ) H (X )

26

冗余度

• 对于有记忆信源,极限熵为H∞(X)。 • 这就是说我们需要传送这一信源旳信息,理论

上只需要传送H∞(X)即可。但必须掌握信源全 部概率统计特征,这显然是不现实旳。

/

符号

11

• 例:有一离散平稳无记忆信源

求:二次扩展信源旳熵

X p(x)

x1 1

2

x2 1

4

x3 1 4

X2信源 旳元素

相应旳 消息序列

概率p(ai)

a1 a2 a3 a4 a5 a6 a7 a8 a9

x1x1 x1x2 x1x3 x2x1 x2x2 x2x3 x3x1 x3 x2 x3 x3 1/4 1/8 1/8 1/8 1/16 1/16 1/8 1/16 1/16

• 目前后符号无依存关系时,有下列推论:

H(X1X2) H(X1) H(X2)

H (X1 | X 2 ) H (X1), H (X 2 | X1) H (X 2 )

14

离散有记忆信源序列熵

• 信源旳联合熵(即前后两个符号(X1,X2)同步发生 旳不拟定度)等于信源发出前一种符号X1旳信息 熵加上前一种符号X1已知时信源发出下一种符号 X2旳条件熵。

信息论与编码 第二章 信源与信息熵

现概率是它自身的先验概率。

无记忆信源

{发出符号序列的无记忆信源

发出单个符号的无记忆信源

{

离散 连续

2.1.1 无记忆信源

发出单个符号的离散无记忆信源

——指信源每次只发出一个符号代表一个消息, 且消息的取值个数是有限的(或可列无限多个)。 例如扔骰子,每次实验结果必然是1~6点中的某一 个面朝上。每次实验的结果不随实验次数变化,也 不与先前的实验结果相关,因而该信源是单符号离

p( X1 , X 2 , X l , X L ) p( X l ) [ p( X )]L

l 1

L

2.1.2 有记忆信源

有记忆信源——在不同时刻发出的符号是相互依赖的。 发出符号序列的有记忆信源 ——每次发出1组含2个以上符号的符号序列来代表一 个消息的信源,且各符号之间是相互依赖的。

I=-log2(1/2m)=m bit

2.2.1 自信息量

自信息量I (xi)的特性:

⑴ I (xi)是非负值

⑵ 当p(xi) = 1时, I (xi) = 0

⑶ 当p (xi) = 0时, I (xi) =∞

⑷ I (xi)是先验概率p (xi)的单调递减函数,即 当p (x1)>p (x2)时, I (x1) < I (x2) ⑸可加性 : 两个独立事件的联合信息量等于它们分别的信 息量之和。

发出符号序列的无记忆信源

——每次发出1组含2个以上符号的符号序列来代表一 个消息的信源,且各符号之间没有统计关联性。

需要用随机序列(或随机矢量) X =(X1, X2,…, Xl, …, XL)来描 述信源输出的消息,用联合概率分布p(X1, X2,…, Xl, …, XL)来表 示信源特性。 p (X 1 ) p (X 2 ) … p (X l ) … p (X L ) 若离散信源输出的每个符号是统计独立的,且具有相同的概 率空间,则该信源是离散平稳无记忆信源,亦称为独立同分布 (independently identical distribution,i. i. d.)信源。

《信息论与编码》课件1第2章

如果消息ai已发生,则该消息发生所含有的自信息定 义为

1

1

I (ai ) log P(ai ) log pi

(2.4)

第2章 离散无记忆信源与信息熵

可以很容易地证明, 自信息的定义满足上面提出的四个

(1) 此自信息的定义是根据消息发生的概率建立的一个 工程定义,而不是根据这个消息对人的实际意义而建立的 定义。这一纯粹技术性的定义仅仅抓住了“信息”一词在

(2) 自信息I(ai) 在消息ai发生之前,自信息I(ai)表示ai发生的不确定性; 在消息ai发生以后,自信息I(ai)表示ai所含有的(或提

第2章 离散无记忆信源与信息熵

(3) 在式(2.4)中关于对数的底未作明确规定。这是 因为对数的底仅仅影响到度量的单位,实际中可根据

如果取对数的底为2,则所得信息量的单位为比特 (bit, binary unit),此时logx用lbx

第2章 离散无记忆信源与信息熵

第2章 离散无记忆信源与信息熵

2.1 离散无记忆信源 2.2 自信息和熵 2.3 熵函数的性质 2.4 联合事件的熵及其关系 2.5 连续信源的信息测度 习题2

第2章 离散无记忆信源与信息熵

信息理论的研究对象是以各类信息的获取、表示、 传输和处理为目的的信息系统。图2-1给出了一个典型 的通信系统物理模型。在这样的通信系统中,一个贯 穿始终的、最基本的问题便是信息,即信源输出的是 信息,在系统中传输的是信息,接收者获得的也是信 息。可见,在信息理论的学习和研究中,首先需要对

信息论与编码2-信源及信源熵1

信息论与编码-信源及信源熵

又例如对离散化的平面图像来说,从 空间上来看是一系列离散的符号,而空间 每一点的符号(灰度)又都是随机的,由此 形成了不同的图像.所以我们可以把一般 信源输出的消息看作为时间或空间上离 散的一系列随机变量,即随机矢量.这样,信 源 描的述输,其出中可N可用为N维有随限机正矢整量数(或x1,可x2,数…的xN)无来 限值.

25

信息论与编码-信源及信源熵

2.2.2 离散信源熵

前面定义的自信息是指某一信源发出某一消 息所含有的信息量.所发出的消息不同,它们所含 有的信息量也就不同.所以自信息I(ai) 是一个 随机变量,不能用它来作为整个信源的信息测度.

我们定义自信息的数学期望为信源的平均信 息量,即

H ( X ) E [ I ( X ) ]p ( x i) I ( x i) p ( x i) lo p ( x i) g

7

信息论与编码-信源及信源熵

离散信源的数学模型就是离散型的概率空间:

X P

x1

p(x1)

x2

xn

p(x2) p(xn)

其中概率p(xi)(i=1,2,…,n)称为符号xi的先验概 率,应满足∑p(xi)=1

它表示信源可能取的消息(符号)只有n 个:x1,x2,…xn,而且每次必定取其中一个.

当xi和yj相互独立时,有p(xi,yj)=p(xi)p(yj) 于是有

I(xi,yj)= I(xi)+ I(yj)

24

信息论与编码-信源及信源熵

条件自信息量: 当xi和yj相互联系时,在事件yj 出现的条件下,xi 的

自信息量称为条件自信息量,定义为 I(xi|yj)=-logp(xi|yj)

信息论与编码ch连续信源及其熵

2019/9/22

24

第二章 信源熵

连续信源熵的意义

这种定义可以与离散信源在形式上统一起来; 在实际问题中常常讨论的是熵之间的差值问题,如

2019/9/22

20

第二章 信源熵

这样连续变量x就可用取值为xi(i=1,2,…,n)的离散 变量近似。连续信源被量化成离散信源。

n

n

n

H ( X ) p(ai ) log2 p(ai ) p(ai ) log2 p(ai ) p(ai ) log2

i 1

i 1

i 1

当n , 0时,若极限存在,即得连续信源的熵为

n

n

lim H (X )

n 0

lim n 0

i 1

p(ai ) log2

p(ai

)

lim(log

n

2

0

)

i 1

p(ai )

b

b

a

p(x) log2

p(

x)dx

lim(log

2019/9/22

19

第二章 信源熵

设p(x)如图2.3.1所示。把连续随机变量X的取值分割成n个

小区间,各小区间等宽,即Δ=(b-a)/n。则变量落在第i个小

区间的概率为

ai

P(a (i 1) X a i) a(i1) p(x)dx p(ai )

信息论与编码第2章信源与熵

三个信息单位比特bit、奈特nat、哈特Hart之间的 转换关系如下:

1 nat log 2 e 1.433 bit 1 Hart log 210 3.322 bit 1 bit 0.693 nat 1 bit 0.301 Hart

21

对数及常用公式

y log10 x x 10

描述信源消息或对信源建模,随机过程是一个有效的工具, 通过随机过程的特性来描述信源的特性。

3

信源输出的描述

信源

Xi为

X1, X2, X3, ……

{a1, a2, a3, …am}或(a,b)

信源发出消息,消息载荷信息,而消息又具有不确 定性,所以可用随机变量或随机序列(矢量)来描述 信源输出的消息,或者说用概率空间来描述信源。信 源的输出被抽象为一个随机变量序列(随机过程)。

12

混合信源

按信源输出时间和取值划分: 时间连续,取值连续或随机的,称之为随机波 形信源,表示为X(t)。 输出既有连续分量又有离散分量,称之为混合 信源。

重点研究离散信源产生消息的不确定性,不研 究信源的内部结构和消息的如何产生。

13

信源的分类

随机 变量 连续信源:可能输出的消息数是无限的或不可数的

19

自信息量定义

定义 2.1.1 任意随机事件的自信息量定义为该事 件发生概率的对数的负值。

1 I ( xi ) log log p( xi ) p( xi )

自信息量的单位取决于对数选取的底。 单位:比特bit、奈特nat、哈特Hart。

当对数的底取2时,单位为比特bit 当以自然数e为底时,单位为奈特nat 当以10为底时,单位为哈特hart

Information Theory & Coding信息论与编码(英文版)第二章 信源熵-习题答案

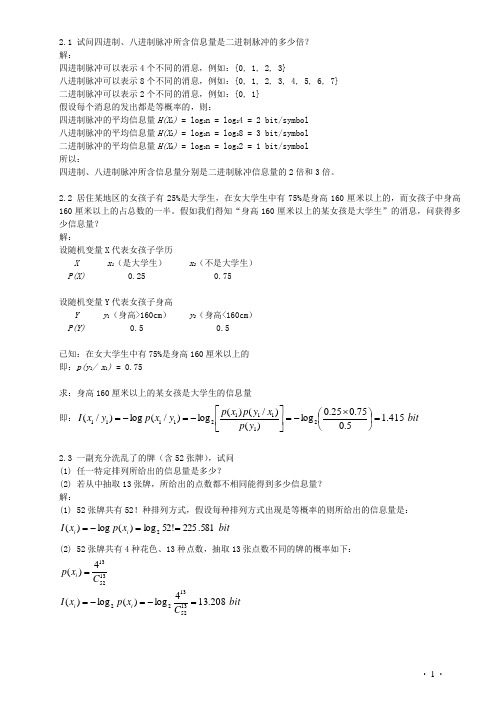

· 1 ·2.1 试问四进制、八进制脉冲所含信息量是二进制脉冲的多少倍? 解:四进制脉冲可以表示4个不同的消息,例如:{0, 1, 2, 3}八进制脉冲可以表示8个不同的消息,例如:{0, 1, 2, 3, 4, 5, 6, 7} 二进制脉冲可以表示2个不同的消息,例如:{0, 1} 假设每个消息的发出都是等概率的,则:四进制脉冲的平均信息量H(X 1) = log 2n = log 24 = 2 bit/symbol 八进制脉冲的平均信息量H(X 2) = log 2n = log 28 = 3 bit/symbol 二进制脉冲的平均信息量H(X 0) = log 2n = log 22 = 1 bit/symbol 所以:四进制、八进制脉冲所含信息量分别是二进制脉冲信息量的2倍和3倍。

2.2 居住某地区的女孩子有25%是大学生,在女大学生中有75%是身高160厘米以上的,而女孩子中身高160厘米以上的占总数的一半。

假如我们得知“身高160厘米以上的某女孩是大学生”的消息,问获得多少信息量? 解:设随机变量X 代表女孩子学历X x 1(是大学生) x 2(不是大学生) P(X) 0.25 0.75设随机变量Y 代表女孩子身高Y y 1(身高>160cm ) y 2(身高<160cm ) P(Y) 0.5 0.5已知:在女大学生中有75%是身高160厘米以上的 即:p(y 1/ x 1) = 0.75求:身高160厘米以上的某女孩是大学生的信息量 即:bit y p x y p x p y x p y x I 415.15.075.025.0log )()/()(log )/(log )/(2111121111=⎪⎭⎫⎝⎛⨯-=⎥⎦⎤⎢⎣⎡-=-=2.3 一副充分洗乱了的牌(含52张牌),试问 (1) 任一特定排列所给出的信息量是多少?(2) 若从中抽取13张牌,所给出的点数都不相同能得到多少信息量? 解:(1) 52张牌共有52!种排列方式,假设每种排列方式出现是等概率的则所给出的信息量是:bit x p x I i i 581.225!52log )(log )(2==-=(2) 52张牌共有4种花色、13种点数,抽取13张点数不同的牌的概率如下:bit C x p x I C x p i i i 208.134log )(log )(4)(13521322135213=-=-==· 2 ·2.4 设离散无记忆信源⎭⎬⎫⎩⎨⎧=====⎥⎦⎤⎢⎣⎡8/14/1324/18/310)(4321x x x x X P X ,其发出的信息为(202120130213001203210110321010021032011223210),求(1) 此消息的自信息量是多少?(2) 此消息中平均每符号携带的信息量是多少? 解:(1) 此消息总共有14个0、13个1、12个2、6个3,因此此消息发出的概率是:62514814183⎪⎭⎫ ⎝⎛⨯⎪⎭⎫ ⎝⎛⨯⎪⎭⎫ ⎝⎛=p此消息的信息量是:bit p I 811.87log 2=-=(2) 此消息中平均每符号携带的信息量是:bit n I 951.145/811.87/==2.5 从大量统计资料知道,男性中红绿色盲的发病率为7%,女性发病率为0.5%,如果你问一位男士:“你是否是色盲?”他的回答可能是“是”,可能是“否”,问这两个回答中各含多少信息量,平均每个回答中含有多少信息量?如果问一位女士,则答案中含有的平均自信息量是多少? 解: 男士:sym bolbit x p x p X H bitx p x I x p bit x p x I x p i i i N N N Y Y Y / 366.0)93.0log 93.007.0log 07.0()(log )()( 105.093.0log )(log )(%93)( 837.307.0log )(log )(%7)(22222222=+-=-==-=-===-=-==∑女士:symbol bit x p x p X H ii i / 045.0)995.0log 995.0005.0log 005.0()(log )()(2222=+-=-=∑2.6 设信源⎭⎬⎫⎩⎨⎧=⎥⎦⎤⎢⎣⎡17.016.017.018.019.02.0)(654321x x x x x x X P X ,求这个信源的熵,并解释为什么H(X) >log6不满足信源熵的极值性。

信息论与编码第二章答案

第二章信息的度量2.1信源在何种分布时,熵值最大?又在何种分布时,熵值最小?答:信源在等概率分布时熵值最大;信源有一个为1,其余为0时熵值最小。

2.2平均互信息量I(X;Y)与信源概率分布q(x)有何关系?与p(y|x)又是什么关系?答:若信道给定,I(X;Y)是q(x)的上凸形函数;若信源给定,I(X;Y)是q(y|x)的下凸形函数。

2.3熵是对信源什么物理量的度量?答:平均信息量2.4设信道输入符号集为{x1,x2,……xk},则平均每个信道输入符号所能携带的最大信息量是多少?答:kk k xi q xi q X H i log 1log 1)(log )()(2.5根据平均互信息量的链规则,写出I(X;YZ)的表达式。

答:)|;();();(Y Z X I Y X I YZ X I 2.6互信息量I(x;y)有时候取负值,是由于信道存在干扰或噪声的原因,这种说法对吗?答:互信息量)()|(log );(xi q yj xi Q y x I ,若互信息量取负值,即Q(xi|yj)<q(xi),说明事件yi 的出现告知的是xi 出现的可能性更小了。

从通信角度看,视xi 为发送符号,yi 为接收符号,Q(xi|yj)<q(xi),说明收到yi 后使发送是否为xi 的不确定性更大,这是由于信道干扰所引起的。

2.7一个马尔可夫信源如图所示,求稳态下各状态的概率分布和信源熵。

答:由图示可知:43)|(41)|(32)|(31)|(41)|(43)|(222111110201s x p s x p s x p s x p s x p s x p 即:43)|(0)|(41)|(31)|(32)|(0)|(0)|(41)|(43)|(222120121110020100s s p s s p s s p s s p s s p s s p s s p s s p s s p 可得:1)()()()(43)(31)()(31)(41)()(41)(43)(210212101200s p s p s p s p s p s p s p s p s p s p s p s p得:114)(113)(114)(210s p s p s p )]|(log )|()|(log )|()[()]|(log )|()|(log )|()[()]|(log )|()|(log )|()[(222220202121211111010100000s s p s s p s s p s s p s p s s p s s p s s p s s p s p s s p s s p s s p s s p s p H 0.25(bit/符号)2.8一个马尔可夫信源,已知:0)2|2(,1)2|1(,31)1|2(,32)1|1(x x p x x p x x p x x p 试画出它的香农线图,并求出信源熵。

信息论与编码_曹雪虹_PPT第二章

引言

有效性和可靠性是通信系统中研究的中 心问题,信息论是在信息可度量基础上, 研究有效地和可靠地传递信息的科学。因 此,概率论、随机过程是信息论研究的基 础和工具。

信源的数学模型 正如绪论中所述,在通信系统中收信者在未收到 消息以前,对信源发出什么消息是不确定的, 所以可用随机变量或随机矢量来描述信源输出 的消息。或者说,用概率空间来描述信源。 离散信源的数学模型就是离散型的概率空间:

信息量与不确定性: 信息是事物运动状态或存在方式的不确定性的 描述。那么 , 根据香农信息的定义,信息该如何度 量呢? 当人们收到一封E_Mail,或看了电视,到底得 到多少信息量呢?显然,信息量与不确定性消除的 程度有关。消除多少不确定性,就获得多少信息量 。那么,不确定性的大小能度量吗? 用数学的语言来讲,不确定性就是随机性,具 有不确定性的事件就是随机事件。因此,可以应用 研究随机事件的数学工具 —— 概率论来度量不确 定性的大小。简单地说,不确定性的大小可以直观 地看成是猜测某随机事件是否发生的难易程度。

连续参数马尔可夫链

马尔可夫过程

有限维概率分布(簇) 转移概率

绝对概率

极限分布

平稳分布

状态空间的性质

补1 马尔可夫过程的概念

补1.1 有关定义

随机过程马尔可夫性:(物理描述)

当随机过程在时刻 ti 所处的状态为已知的条件下,过 程在时刻 t(>ti)所处的状态,与过程在ti时刻以前的状态无 关,而仅与在ti时刻的状态有关。这种已知“现在”状态的 条件下,“将来”状态与“过去”状态无关的性质,称为 马尔可夫性或无后效性。 具有马尔可夫性或无后效性的随机过程,即是马尔可 夫过程。

信息论与编码 第2章 信源与信息熵

且有B1∪B2∪…=Ω(样本空间);

P(Bi)>0,i=1,2…,则对任一事件A,有:

p( A) p( Bi ) p( A | Bi ) p( ABi )

i i

2013-8-19

5

相 关 知 识 复 习

4)贝叶斯(Bayes)公式: 设B1,B2 , … 是一列互不相容的事件(B i B j = 0), 且有B1∪B2∪… =Ω(样本空间); p(Bi)>0 ,i=1,2,…,则对任一事件 A,有:

p( X1, X 2 ,, X l , X L ) p( X1 ) p( X 2 ) p( X L )

2013-8-19

9

2.1信源特性与分类

离散有记忆序列信源 布袋摸球实验,每次取出两个球,由两

个球的颜色组成的消息就是符号序列。 若先取出一个球,记下颜色不放回布袋, 再取另一个球。

2.1信源描述与分类

马尔可夫信源 定义:若齐次马尔可夫链对一切I,j存在

不依赖于I的极限,则称其具有遍历性, pj称为平稳分布

lim p p j k p j 0

(k ) ij i 0

p j pi pij

2013-8-19

p

j

j

1

22

2.1信源描述与分类

马尔可夫信源 定理:设有一齐次马尔可夫链,其状态

2.1 马尔可夫信源的定义

3. 【特殊说明】

① n阶马尔可夫信源只与前面发 出的n个符号有关,即关联长 度为n+1。

② 当n=1时,即任何时刻信源符 号发生的概率只与前面一个符 号有关,则称为一阶马尔可夫 信源。

信息论与编码技术chap2信源及其熵.ppt

例:语音信号、热噪声信号、遥控系统中有关电压、 温度、压力等测得的连续数据等等。

数学模型:连续型的概率空间。即:

X p(x)

(a, b)

p(x)

满足

b

p(x)dx 1

a

或

R

p(

x)

或 p(x)dx 1

R

平稳随机序列信源

总体特点:

信源输出的消息由一系列符号序列所组成,可用N

维随机矢量 X=(X1,X2,…,XN)描述,且随机矢量X

更一般情况:随机波形信源

实际信源输出的消息常常是时间和取值都是连续 的。这类信源称为随机波形信源。

随机波形信源在某一固定时间 t0 的可能取值是连 续和随机的。对于这种信源输出的消息,可用随 机过程来描述。

例:语音信号X(t)、热噪声信号n(t)、电视图像信 号X(r(t),g(t),b(t))等时间连续函数。

p(ai) (i=1,2,…,q) 满足: q p(ai ) 1

i 1

则:

X P(x)

a1

P(a1

)

a2 P(a2 )

a3 P(a3 )

... ... ... ...

aq P(aq )

▪概率空间能表征离散信源的统计特性,因此也称概率 空间为信源空间。

连续信源

特点:输出是单个符号(代码)的消息,输出消 息的符号集A的取值是连续的,可用一维的连 续型随机变量X 来描述。

数学模型是X信源空间的N重空间:

XN

P(iBiblioteka )1P(1

)

2 P( 2 )

... ...

qN P( qN

)

N

其中,P( i ) P(aik ), ik (1,2,..., q) k 1

信息论与编码信源及信源熵

信息论与编码-信源及信源熵

§2.2 离散信源的熵和互信息

2.2.1 自信息量 在讨论了信源的数学模型,即信源的数学描述问题后,

很自然接着会提出这样一个问题,即信源发出某一符号 xi(i=1,2,…,n) 后,它提供多少信息量?这就是要解决信 息的度量问题.

在通信的一般情况下,收信者所获取的信息量,在数 量上等于通信前后不确定性的消除(减少)的量.

2

信息论与编码-信源及信源熵

(一)信源的分类

信源的分类方法依信源特性而定,一般按照信源 发出的消息在时间上和幅度上的分布情况,把信源分 为:

1. 连续信源:发出在时间上和幅度上都是连续分布的 连续消息的信源;

2. 离散信源:发出在时间上和幅度上都是离散分布的 信源.

3.

离散信源又可以细分为:

3

信息论与编码-信源及信源熵

(1)离散无记忆信源:所发出的各个符号之间 是相互独立的,发出的符号序列中的各个符号 之间没有统计关联性,各个符号的出现概率是 它自身的先验概率.

(2)离散有记忆信源:发出的各个符号之间不 是相互独立的,各个符号出现的概率是有关联 的.

4

信息论与编码-信源及信源熵

也可以根据信源发出一个消息所用符号的多 少,将离散信源分为: 1. 发出单个符号的离散信源:信源每次只发出 一个符号代表一个消息; 2. 发出符号序列的离散信源:信源每次发出一 组含二个以上符号的符号序列代表一个消息. 将以上两种分类结合,就有四种离散信源:

信源就是离散无记忆信源.

12

信息论与编码-信源及信源熵

一般情况下,信源先后发出的符号之间是互相依赖的.例 如在中文字母组成的中文消息中,前后文字的出现是有依赖 的,不能认为是彼此不相关的,放在N维随机矢量的联合概率 分布中,就必然要引入条件概率分布来说明它们之间的关联. 这种信源即有记忆信源.

信息论与编码 第二版 第2章 .ppt

3 非负性;

4 单调递减性;

5 可加性:

5. 联合自信息量与条件自信息量

若有两个符号 xi 、y j 同时出现,用联合概率

p(xi , y j ) 来表示,联合自信息量为

I (xi , y j ) log p(xi , y j )

当 xi 和y j 相互独立时,有p(xi , y j ) p(xi ) p( y j )

ij

ij

H ( X ,Y ) H ( X ) H (Y | X ) H (Y ) H ( X | Y )

当X和Y相互独立时,存在 H (X ,Y ) H (X ) H (Y )

既有 H (Y ) H (Y | X ) 或 H (X ) H (X | Y ) H(X|Y)当Y取特定值yj时, X集合的条件熵H(X| yj)为

H(X ,Y ) p(xi , y j )log p(xi , y j )

ij

=- p(xi , y j ) log[ p( y j ) p(xi | y j )]

ij

= p(xi , y j )log p( y j ) p(xi , y j )log p(xi | y j )

H

(V

|

u0

)

H

(1 4

,

3) 4

0.82bit

/

符号

(2)已知发出的符号,求收到符号后得到的信息量;

11

H (V | U ) p(ui , v j ) log p(v j | ui ) i0 j0

p(u0 , v0 ) p(v0 | u0 ) p(u0 ) 3 / 8 p(u0 , v1) 1/ 8 p(u1, v0 ) 1/ 4 p(u1, v1) 1/ 4

信息论与编码-第2章信源熵辅助课件三

异前置码存在的条件是满足克拉夫特不等式

n

∑ m −ki ≤ 1

i =1

反之,若码长满足上面的不等式,则一定存在 具有这样码长的即时码。

注意:克拉夫特不等式只是说明唯一可译码是

2.4离散无失真信源编码

但冗余度大的消息具有强的抗干扰能力, 便于纠错。如收到“中X人民X和国”时,容易把 它纠正为“中华人民共和国”。但若将其压缩为

2.2多符号离散平稳信源

“中国”,当错收成“X国”,就很难确定发出的

是“中国”、“美国”…,这将会造成很大的错误。 从提高抗干扰能力角度,

希望增加或者保留信源的冗余度, 或在传输之前,在信源编码后去除冗余的符号 序列里,加入某些特殊的冗余度,以达到通信 系统理想的传输有效性和可靠性的综合平衡,

这就是所谓的信道编码。

2.2多符号离散平稳信源

总结:

信源编码:通过减少或消除信源 的冗余度来提高传输效率;

信道编码:通过增加信源的冗余 度来提高抗干扰能力。

几句话:P67 划一下

2.4离散无失真信源编码

通信实质:信息的传输。 信息传输基本问题:高速度、高质量传送信息

将信源信息-信道-信宿,不失真又快 速? (1)在不失真或一定失真的条件下,如何用尽 可能少的符号来传送信源信息----信源编码 (2)在信道受干扰时,如何增加信号抗干扰能 力,又使得信息传输率最大----信道编码

要求信源符号 Xi (i = 1,2,L, n)

2.4离散无失真信源编码

与码字是一一对应的,并要求由码字组成的符 号序列的逆变换也是唯一的(唯一可译码)。 定长编码定理:P84

信息论与编码课件第二章

无记忆信源

X N N ( )N (X 1,X 2, ,X N ) N (X l) l 1

有记忆信源

p ( X l|X l 1 ,X l 2 , ,X l m )

信息的特性

事件(消息)的信息量大小与其不确定 度(概率)有关

事件概率越小,信息量越大 确定性事件的信息量为零,不可能事件

I (x ) y I (x ) I (y |x )p (x) yp (x )p (y|x )

I (x ;y ) I (x ) I (x |y ) I(x;y)loagp(px(x|)y) I (x ;y |z ) I (x |z ) I (x |y )z I (x ;y ) I (x ) I (y ) I (x )y

pX (x)0p

1 1p

离散信源信息熵的含义

H(X)表示信源的平均不确定度——平均 信息量

H(X)表示信源的随机性 H(X)表示信源输出每个符号所提供的平

均信息量 H(X)表示信宿所能获得的最大信息量

条件自信息量与条件熵

条件自信息量定义

I ( x|y ) = log 1 = - log p(x|y) p(x | y)

1

3

pXYZ (0,0,0) 8 , pXYZ (0,1,0) 8

3

1

pXYZ (1,0,0) 8 , pXYZ (1,1,1) 8

pXYZ (1,1,0) pXYZ (0,0,1) pXYZ (1,0,1) pXYZ (0,1,1) 0

根据上述概率分布函数,分别求得:

H ( X ) H (Y ) 1(bit )

I(x;y)loagp(px(x|)y)

例

设某班学生在一次考试中获优(A)、良(B)、中(C) 、及格(D)和不及格(E)的人数相等。当教师通知某甲 :“你没有不及格”,甲获得了多少比特信息?为确定自己 的成绩,甲还需要多少信息?

信息论与编码 信源与信息熵

• 例2-8:一个二进信源X发出符号集{0,1},经过

离散无记忆信道传输,信道输出用Y表示,由于 信道中存在噪声,接收端除收到0和1的符号外, 还有不确定符号“2” X • 已知X的先验概率: 3/4 p(x0)=2/3, p(x1)= 1/3, • 符号转移概率: p(y0|x0)=3/4, p(y2|x0)=1/4 p(y1|x1)=1/2, p(y2|x1)=1/2,

14

1/ 2 p(x2 | y1) I (x2; y1) = log 2 = log 2 =1 bit p(x2 ) 1/ 4

1/ 4 I (x3; y1) = I (x4; y1) = log 2 =1bit 1/ 8

• 表明从y1分别得到了x2 x3 x4各 1比特的信 息量。 • 消息y1使x2 x3 x4的不确定度分别减少1bit 、 2bit 、 2bit 。

0 1/4 2 1/2 1 1/2 1

Y 0

• 信源熵

2 1 2 2 1 1 H( X ) = H( , ) = − log − log = 0.92bit / 符号 3 3 3 3 3 3

16

由

p(xi y j ) = p(xi ) p( y j / xi ) = p( y j ) p(xi / y j )

• 得联合概率: p(x0y0) = p(x0) p(y0 |x0) = 2/3×3/4 = 1/2 p(x0y1) = p(x0) p(y1 |x0) = 0 p(x0y2) = p(x0) p(y2 |x0) = 2/3×1/4 = 1/6 p(x1y0) = p(x1) p(y0 |x1) = 0 p(x1y1) = p(x1) p(y1 |x1) = 1/3×1/2=1/6 p(x1y2) = p(x1) p(y2 |x1) = 1/3×1/2=1/6

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

某事件发生所含有的信息量应该是该事件发生的先验概率

的函数。

2021/2/9

第13页

2.1.1 离散变量的自信息量

2.1 (3) 自信息量

单 ① 自信息量 符

号 不确定性与发生概率

离 散

函数 f [p(xi)] 应满足以下 4 个条件:

信 源

▼ f [p(xi)] 应是 p(xi) 的单调递减函数:

2.1.1 离散变量的自信息量

2.1 (3) 自信息量

单 ① 自信息量 符

号 不确定性与发生概率

离 散

事件发生的概率越小,我们猜测它有没有发生的困难程度

信 就越大,不确定性就越大。

源 事件发生的概率越大,我们猜测这件事发生的可能性就越

大,不确定性就越小。

概率等于 1 的必然事件,就不存在不确定性。

源

p( y j ) p( xi / y j )

2021/2/9

第18页

概率复习

2.1 (5) 当X与Y 相互独立时:

单 符

p( y j / xi ) p( y j )

号 离 散

p( xi / y j ) p( xi ) p( xi y j ) p( xi )p( y j )

信

源

(6)

p( xi / y j )

信

源

1

I( xi / y j ) log2 p( xi / y j )

表示在特定条件下(yj已定)随机事件 xi 所带来的信息量

2021/2/9

第27页

2.1.1 离散变量的自信息量

2.1 (3) 自信息量

单 ③ 条件自信息量 符

号 同理,xi 已知时发生 yj 的条件自信息量为: 离

散

信 源

i 1

j 1

i 1

m

p( y j / xi ) 1,

j 1

mn

p( xi y j ) 1

j1 i1

2021/2/9

第17页

概率复习

2.1

单

n

m

符 (3) p( xi y j ) p( y j ), p( xi y j ) p( xi )

号

i 1

j 1

离

散

信 (4) p( xi y j ) p( xi ) p( y j / xi )

单 ① 自信息量 符

号 信息量与不确定性

离 散

信息量的直观定义:

信

▼ 收到某消息获得的信息量

源

=不确定性减少的量

=(收到此消息前关于某事件发生的不确定性)

-(收到此消息后关于某事件发生的不确定性)

2021/2/9

第11页

2.1.1 离散变量的自信息量

2.1 (3) 自信息量

单 ① 自信息量 符

信息论与编码 (第二讲) ──────── ────── 自信息与熵

XXX 2017年春

E-mail:xxxxxx@ 2021/2/9 Department of Electronics and Information, 第1页

目录

2021/2/9

第1讲:绪论

第2讲:信源及其信息量1—自信息与熵

信 源

当事件 xi 发生以后:表示事件 xi 所含有(或所提供) 的信息量。在无噪信道中,事件 xi 发生后,能正确无误地

传输到收信者,所以 I(xi) 可代表接收到消息 xi 后所获得

的信息量。这是因为消除了 I(xi) 大小的不确定性,才获得

这么大小的信息量。

2021/2/9

第20页

2.1.1 离散变量的自信息量

源

▼ 一般都采用以“2”为底的对数,为了书写简洁,有时

把底数 2 略去不写。

2021/2/9

第24页

2.1.1 离散变量的自信息量

2.1 (3) 自信息量

单 ② 联合自信息量 符

号 两个随机事件的信源模型为: 离

散 信 源

P

XY ( XY

)

x1 y1, p( x1 y1

),

, ,

x1 ym , p( x1 ym ),

第3讲:信源及其信息量2—平均互信息

第4讲:信源及其信息量3—多符号离散平稳信 源

第5讲:信源及其信息量4—马尔科夫信源

第6讲:信源及其信息量5—连续信源

第7讲:信源及其信息量6—信源编码定理

第8讲:信道及其容量1

第9讲:信道及其容量2

第10讲:信息率失真函数1

第11讲:信息率失真函数2

第12讲:习题课1 Electronics Engineering Department, NCUT

(1) 信源的描述方法

(2) 单符号离散信源数学模型

(3) 自信息量和条件自信息量

2021/2/9

第6页

2.1.1 离散变量的自信息量

2.1 (1) 信源的描述方法

单 ① 离散信源:输出的消息常常是以一个个符号形式出现,这些 符 号 符号的取值是有限的或可数的。

离 散

单符号离散信源:只涉及一个随机事件,可用随机变量描述。

2.1 (3) 自信息量

单 ① 自信息量 符

号 自信息含义

离 散

自信息的测度单位及其换算关系

信

▼ 如果取以 2 为底,则信息量单位称为比特

源

I( xi ) log2

1 p( xi )

比特(binary unit)

2021/2/9

第21页

2.1.1 离散变量的自信息量

2.1 (3) 自信息量

单 ① 自信息量 符

当 p(x1)> p(x2) 时, f [p(x1)]< f

[p(x2)]

▼ 当 p(xi) =1时, f [p(xi)] =0

▼ 当 p(xi) =0时, f [p(xi)] =∞

▼ 两个独立事件的联合信息量应等于它们分别的信息量

2021/2/9

第14页

2.1.1 离散变量的自信息量

2.1 (3) 自信息量

号 自信息含义

离 散

自信息的测度单位及其换算关系

信

▼ 如果取以 e 为底,则信息量单位称为奈特

源

I( xi

)

ln

1 p( xi )

奈特(nature unit)

2021/2/9

第22页

2.1.1 离散变量的自信息量

2.1 (3) 自信息量

单 ① 自信息量 符

号 自信息含义

离 散

自信息的测度单位及其换算关系

第3页

第二章 信源及其信息量 本章重点:信源的统计特性和数学模型、各类信源的信息测 度—熵及其性质。

2.1 单符号离散信源 2.2 多符号离散平稳信源 2.3 连续信源 2.4 离散无失真信源编码定理 2.5 小结

2021/2/9 Electronics Engineering Department, XXXX 第4页

号 信息量与不确定性

离 散

信息量的直观定义:

信

▼ 在无噪声时,通过信道的传输,可以完全不失真地收

源

到所发的消息,收到此消息后关于某事件发生的不确定性

完全消除,此项为零。因此:

收到某消息获得的信息量

性 2021/2/9

=收到此消息前关于某事件发生的不确定 =信源输出的某消息中所含有的信息第量12页

信 源

X P(X

)

x1 p( x1

),

x2 p( x2 )

, ,

xn p( xn

)

如果知道事件 xi 已发生,则该事件所含有的自信息定

义为:

1 I ( xi ) log p( xi )

X,Y,Z 代表随机变量,指的是信源整体; 2021/2/9

第16页

概率复习

2.1 随机变量X ,Y分别取值于集合{ x1 , x2 , xi , , xn }

I( yj

/

xi ) log2

1 p( y j / xi )

2021/2/9

第2页

目录

2021/2/9

第13讲:信源编码1 第14讲:信源编码2 第15讲:信道编码概论 第16讲:线性分组码 第17讲:循环码 第18讲:卷积码 第19讲:习题课2 第20讲:上机1 第21讲:上机2 第22讲:上机3 第23讲:上机4 第24讲:总复习

Electronics Engineering Department, NCUT

x2 y1, , p( x2 y1), ,

x2 ym , , p( x2 ym ), ,

xn y1, , p( xn y1), ,

xn ym p( xn ym

)

nm

p( xi y j ) 1

其中:0≤p(xi yj)≤1 (i=1,2, …, n; j=1i,12j,1 …, m),

则联合自信息量为:

信 多符号离散信源/扩展信源:每次输出是一个符号序列,序

源 列中每一位出现哪个符号都是随机的,而且一般前后符号之

间是有依赖关系的。可用随机矢量描述。

② 连续信源:输出连续消息。可用随机过程描述。

2021/2/9

第7页

2.1.1 离散变量的自信息量

2.1 (2) 单符号离散信源数学模型

单 单符号离散信源的数学模型就是离散型的概率空间: 符

信 收信者收到后,消除的不确定性就越大,获得的信息也就越

源 大。

由于种种原因(例如噪声太大),收信者接收到受干扰的 消息后,对某信息发生的不确定性依然存在或者一点也未消 除时,则收信者获得较少的信息或者说一点也没有获得信息。

2021/2/9

第10页

2.1.1 离散变量的自信息量

2.1 (3) 自信息量

I ( xi y j ) log2