信息论与编码 第3讲

信息论与编码理论-第3章信道容量-习题解答

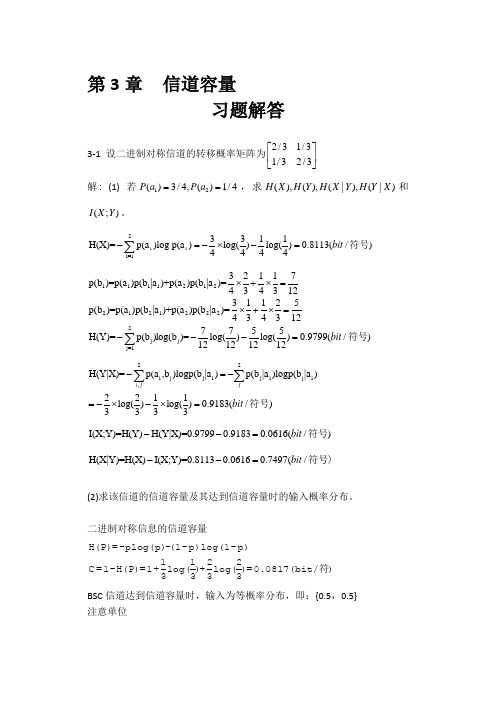

信息论与编码理论-第3章信道容量-习题解答-071102(总11页)--本页仅作为文档封面,使用时请直接删除即可----内页可以根据需求调整合适字体及大小--第3章 信道容量习题解答3-1 设二进制对称信道的转移概率矩阵为2/31/31/32/3⎡⎤⎢⎥⎣⎦解: (1) 若12()3/4,()1/4P a P a ==,求(),(),(|),(|)H X H Y H X Y H Y X 和(;)I X Y 。

i i 2i=13311H(X)=p(a )log p(a )log()log()0.8113(/)4444bit -=-⨯-=∑符号111121*********j j j=132117p(b )=p(a )p(b |a )+p(a )p(b |a )=43431231125p(b )=p(a )p(b |a )+p(a )p(b |a )=4343127755H(Y)=p(b )log(b )=log()log()0.9799(/)12121212bit ⨯+⨯=⨯+⨯=---=∑符号22i j j i j i j i ,H(Y|X)=p(a ,b )logp(b |a )p(b |a )logp(b |a )2211log()log()0.9183(/)3333i jjbit -=-=-⨯-⨯=∑∑符号I(X;Y)=H(Y)H(Y|X)=0.97990.91830.0616(/)bit --=符号 H(X|Y)=H(X)I(X;Y)=0.81130.06160.7497(/bit --=符号)(2)求该信道的信道容量及其达到信道容量时的输入概率分布。

二进制对称信息的信道容量H(P)=-plog(p)-(1-p)log(1-p)1122C =1-H(P)=1+log()+log()=0.0817(bit/)3333符 BSC 信道达到信道容量时,输入为等概率分布,即:{,} 注意单位3-2 求下列三个信道的信道容量及其最佳的输入概率分布。

信息论与编码课件第三章

离散无记忆信道的信道容量

I( x

0;Y )

2 j 1

p(b j

0) log

p(b j 0) p(b j )

log 2

I( x 2;Y ) log 2

而I( x

1;Y )

2 j 1

p(b j 1) log

p(b j 1) p(b j )

0

1

I( x 0;Y ) I( x 2;Y ) log 2, p(0) p(2) 0

C

I ( x ai ;Y )

m j 1

p(b j ai ) log

p(b j ai ) p(b j )

特殊DMC的信道容量

例:准对称信道

准对称信道

0.8 0.1 0.1 P3 0.1 0.1 0.8

1 p(a1 ) p(a2 ) 2

n

p(b j ) p(ai ) p(b j ai ) i 1

H (Y

|

a2 )

H(Y | an )

P 1 M

C

log

n

ห้องสมุดไป่ตู้

2

j

j1

P P 1 C p(bj ) p(ai )

达到信道容量时输入、输出概率分布的唯一性

例:

1 / 2 1 / 2 0 0

P

0

1/2 1/2

0

0 0 1/ 2 1/ 2

1 / 2 0 0 1 / 2

取

p(a1 )

p(a3 )

1, 2

p(a2 ) p(a4 ) 0

4

C

信息论及编码理论基础(第三章)讲诉

2018/11/16

9

§3.2 离散无记忆(简单)信 源的等长编码

(9)在无错编码的前提下,编码的最低代价 当R≥logK时,能够实现无错编码。 (DN≥KL) 当R<H(U1)时,无论怎样编码都是有错编码。这是因为 R<H(U1)≤logK。 (DN<KL) (如果H(U1)=logK,则以上两种情形已经概括了全部情形。 但如果H(U1)<logK,则还有一种情形) 当logK>R>H(U1)时,虽然无论怎样编码都是有错编码, 但可以适当地编码和译码使译码错误的概率pe任意小。这 就是所谓“渐进无错编码”。

EV1 qk loga

k 1

2018/11/16

qk

H (U1 )

13

§3.2 离散无记忆(简单)信 源的等长编码

取IL是(V1V2…VL)的如下函数: I L

1 L Vl L l 1

则 ① IL最终是(U1U2…UL)的函数; ② 1 L 1 L 1 EI L EVl H (U1 ) DI L D Vl 2 L l 1 L l 1 L

2018/11/16

12

§3.2 离散无记忆(简单)信 源的等长编码

设…U-2U-1U0U1U2…是离散无记忆(简单)信源的输出随机变 量序列。设U1的概率分布为

a1 a2 aK U1 ~ q q q K 1 2

取Vl是Ul的如下函数:当Ul=ak时, Vl=loga(1/qk)。则 ①随机变量序列…V-2V-1V0V1V2…相互独立,具有相同的概率 分布; K ② 1

2018/11/16 5

§3.2 离散无记忆(简单)信 源的等长编码

例:离散无记忆简单信源发出的随机变量序列为:…U-2U1U0U1U2…。其中U1的事件有3个:{晴, 云, 阴}。 (U1U2)有9个事件 {(晴晴),(晴云),(晴阴),(云晴),(云云), (云阴),(阴晴),(阴云), (阴阴)}。 用字母表{0, 1}对(U1U2)的事件进行2元编码如下: (晴晴)→0000,(晴云)→0001,(晴阴)→0011, (云晴)→0100,(云云)→0101,(云阴)→0111, (阴晴)→1100,(阴云)→1101,(阴阴)→1111。

信息论与编码技术第三章课后习题答案

Chap3 思考题与习题 参考答案3.1 设有一个信源,它产生0、1 序列的消息。

它在任意时间而且不论以前发生过什么符号,均按P(0)=0.4,P(1)=0.6 的概率发出符号。

(1) 试问这个信源是否平稳的? (2) 试计算H(X 2),H(X 3/X 1X 2)及H ∞。

(3) 试计算H(X 4),并写出X 4 信源中可能有的所有符号。

解:(1)根据题意,此信源在任何时刻发出的符号概率都是相同的,均按p(0)=0.4,p(1)=0.6,即信源发出符号的概率分布与时间平移无关,而且信源发出的序列之间也是彼此无信赖的。

所以这信源是平稳信源。

(2)23123121()2()2(0.4log 0.40.6log 0.6) 1.942(/)(|)()()log ()(0.4log 0.40.6log 0.6)0.971(/)lim (|)()0.971(/)i i iN N N N H X H X bit symbols H X X X H X p x p x bit symbol H H X X X X H X bit symbol ∞−→∞==−×+===−=−+====∑" (3)4()4()4(0.4log 0.40.6log 0.6) 3.884(/)H X H X bit symbols ==−×+=4X 的所有符号:0000 0001 0010 0011 0100 0101 0110 0111 1000 1001 1010 1011 1100 1101 1110 11113.2 在一个二进制的信道中,信源消息集X={0,1}且p(1)=p(0),信宿的消息集Y={0,1},信道传输概率(10)1/p y x ===4,(01)1/p y x ===8。

求:(1) 在接收端收到y=0后,所提供的关于传输消息x 的平均条件互信息I(X ;y=0); (2) 该情况下所能提供的平均互信息量I(X ;Y)。

信息论与编码第三版 第3章

(2)增强通信的可靠性: 综上所述,提高抗干扰能力往往是以降低信息传输效率为代价

信息论与编码

信源编码的概念:对信源的原始符号按一定的数学规则进行变换的一种

代码。

信源编码包括两个功能:

(1)将信源符号变换成适合信道传输的符号; {b1, b2,…, bD}是适合 编码输出码字cm = cm1 cm2 … {a1, a2, …, (2)压缩信源冗余度,提高传输效率。 ak}为信 信道传输的D个符号, cmn, c mk∈{b1, b2,…, bD}, 源符号集,序列中 用作信源编码器的 k = 1, 2 , …, n ,n表示码字 每一个符号uml都取 信源编码模型: 编码符号。 长度,简称码长。 自信源符号集。

1 1 1 n 2 2 2 3 4 4 2.75 (码元/符号) 4 8 16

RD

H X n

2.75 1 (比特/码元时间) 2.75

信息论与编码

§3.2 等长码及等长编码定理

一.等长编码定理

考虑对一简单信源S进行等长编码,信源符号集有K个符号,码符号集 含D个符号,码字长度记为n。对信源作等长无差错编码,要得到惟一可译 码,必须满足下式:

扩展信源

信源编码器

信道符号(码符号)集{b1,b2,...bD}

信源符号集{a1,a2,...ak}

原码的N次扩展码是将信源作N次扩展得到的新信源符号序列u(N) =u1 …uN = (u11 u12 … u1L) … (uN1 uN2 … uNL),对应码符号序列c(N) =c1 …cN = (c11 c12 … c1n) … (cN1 cN2 … cNn) ,记集合C (N) = {c1(N), c2(N), …},C (N) 即原码C的N次扩展码。

信息论与编码理论-第3章信道容量-习题解答-071102

第3章 信道容量习题解答3-1 设二进制对称信道的转移概率矩阵为2/31/31/32/3⎡⎤⎢⎥⎣⎦解: (1) 若12()3/4,()1/4P a P a ==,求(),(),(|),(|)H X H Y H X Y H Y X 和(;)I X Y 。

i i 2i=13311H(X)=p(a )log p(a )log()log()0.8113(/)4444bit -=-⨯-=∑符号111121*********j j j=132117p(b )=p(a )p(b |a )+p(a )p(b |a )=43431231125p(b )=p(a )p(b |a )+p(a )p(b |a )=4343127755H(Y)=p(b )log(b )=log()log()0.9799(/)12121212bit ⨯+⨯=⨯+⨯=---=∑符号 22i j j i j i j i ,H(Y|X)=p(a ,b )logp(b |a )p(b |a )logp(b |a )2211log()log()0.9183(/)3333i jjbit -=-=-⨯-⨯=∑∑符号I(X;Y)=H(Y)H(Y|X)=0.97990.91830.0616(/)bit --=符号 H(X|Y)=H(X)I(X;Y)=0.81130.06160.7497(/bit --=符号)(2)求该信道的信道容量及其达到信道容量时的输入概率分布。

二进制对称信息的信道容量H(P)=-plog(p)-(1-p)log(1-p)1122C =1-H(P)=1+log()+log()=0.0817(bit/)3333符 BSC 信道达到信道容量时,输入为等概率分布,即:{,}注意单位3-4 设BSC 信道的转移概率矩阵为112211Q εεεε-⎡⎤=⎢⎥-⎣⎦1)写出信息熵()H Y 和条件熵(|)H Y X 的关于1()H ε和2()H ε表达式,其中()log (1)log(1)H εεεεε=----。

《信息论与编码》第三章习题解答

1 p(i, j ) 3 1 , 3

所以从编码树每个内节点长出的三个分支都具有等概率,即第一层节点概率为 第二层节点概率为

1 1 ,…。从而任何一个消息(树叶)出现概率必定为 的整数次幂。 9 3

I (u L ) − H (U ) > δ L

求在(a) , (b)给定的 L=L0 情况下 A 中元素数目的上、下限。 [解] 由概率论中切比雪夫不等式

P{|

其中

σ2 I (U L ) − H (U ) |> δ } ≤ I 2 = ε L Lδ 3 1 3 1 H (U ) = − log − log = 0.81bit 4 4 4 4

H (X ) ,所以 log 3

其 中 (i, k1 ) , (k1 + 1, k 2 ) , (k 2 + 1, j ) 是 由 内 节 点 (i, j ) 分 岔 出 去 的 三 个 节 点 , 所 以

p (i, k1 ) + p(k1 + 1, k 2 ) + p (k 2 + 1, j ) = p(i, j ) 。由于码 D 的平均码长 L =

(b) 求三元 Huffman 码,计算 n 和 η ; [解] (a) 由信源概率分布可知

H (U ) = −

∑p

i =1

10

i

log p i = 3.234bit

相应的 Huffman 编码过程如下图所示; 111 a1 101 a2 100 a3 011 a4 001 a5 000 a6 1101 a7 1100 a8 0101 a9 0100 a10

0.16 (1) 0.14 (1) 0.13 (0) 0.12 (1) 0.1 (1) 0.09 (0) 0.08 (1) 0.07 (0) 0.06 (1) 0.05 (0)

《信息论与编码》习题解答-第三章

第三章 信道容量-习题答案3.1 设二元对称信道的传递矩阵为⎥⎦⎤⎢⎣⎡3/23/13/13/2 (1) 若P(0) = 3/4, P(1) = 1/4,求H(X), H(X/Y), H(Y/X)和I(X;Y); (2) 求该信道的信道容量及其达到信道容量时的输入概率分布;解: 1)symbolbit Y X H X H Y X I symbol bit X Y H Y H X H Y X H X Y H Y H Y X H X H Y X I symbol bit y p Y H x y p x p x y p x p y x p y x p y p x y p x p x y p x p y x p y x p y p symbolbit x y p x y p x p X Y H symbolbit x p X H jj iji j i j i i i / 062.0749.0811.0)/()();(/ 749.0918.0980.0811.0)/()()()/()/()()/()();(/ 980.0)4167.0log 4167.05833.0log 5833.0()()(4167.032413143)/()()/()()()()(5833.031413243)/()()/()()()()(/ 918.0 10log )32lg 324131lg 314131lg 314332lg 3243( )/(log )/()()/(/ 811.0)41log 4143log 43()()(222221212221221211112111222=-==-==+-=+-=-=-==⨯+⨯-=-==⨯+⨯=+=+==⨯+⨯=+=+==⨯⨯+⨯+⨯+⨯-=-==⨯+⨯-=-=∑∑∑∑2)21)(/ 082.010log )32lg 3231lg 31(2log log );(max 222==⨯++=-==i mi x p symbolbit H m Y X I C3.2 解:(1)αα-==1)(,)(21x p x p⎥⎦⎤⎢⎣⎡=4/14/12/102/12/1P ,⎥⎦⎤⎢⎣⎡---=4/)1(4/)1(2/)1(02/12/1)(αααααj i y x P 4/)1()(,4/14/)(,2/1)(321αα-=+==y p y p y p接收端的不确定度:))1(41log()1(41)4141log()4141()2log(21)(αααα---++-=Y H)1log(41)1log(4123αααα---++-= (2))4log()1(41)4log()1(41)2log()1(210)2log(21)2log(21)|(ααααα-+-+-+++=X Y H α2123-= (3))|()();(X Y H Y H Y X I -=);(max )()(Y X C i x p =α,0)(=ααC d d,得到5/3=α 161.0)5/3();max(===C Y X C 3.3∑==⨯++=+=21919.001.0log 01.099.0log 99.02log log )log(j ij ij p p m C0.919*1000=919bit/s 3.4 3.5 3.6⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎣⎡=2/1002/12/12/10002/12/10002/12/1P 121log 2121log 214log log )log(41=++=+=∑=ij j ij p p m C3.7(1)联合概率⎥⎥⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎢⎢⎣⎡=010330110110115215110161ij p ,⎥⎥⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎢⎢⎣⎡=0103101535152525121)|(j i y x p 31)(0=y p ,21)(1=y p ,61)(3=y p499.16log 612log 213log 31)(=++=Y H(2)175.1910log 30310log 301310log 101310log10152log 1525log 151310log 1012log 61)|(log )()|(=+++++++=-=∑ij i j j i x y p y x p X Y H (3)当接收为2y ,发送为2x 时正确,如果发送为1x 和3x 为错误,各自的概率为: 5/1)|(21=y x p ,5/1)|(22=y x p ,5/3)|(23=y x p它的错误概率为:5/4)|()|(2321=+=y x p y x p p e(4)平均错误概率为:733.010/115/110/310/130/115/2=+++++ (5)同样为0.733 (6)此信道不好,因为信源等概率分布,从转移信道来看,正确发送的概率11y x >-为0.5,有一半失真;22y x >-为0.3,严重失真;33y x >-为0,完全失真。

信息论与编码理论-第3章信道容量-习题解答-071102

第3章 信道容量习题解答3-1 设二进制对称信道的转移概率矩阵为2/31/31/32/3⎡⎤⎢⎥⎣⎦解: (1) 若12()3/4,()1/4P a P a ==,求(),(),(|),(|)H X H Y H X Y H Y X 和(;)I X Y 。

i i 2i=13311H(X)=p(a )log p(a )log()log()0.8113(/)4444bit -=-⨯-=∑符号111121*********j j j=132117p(b )=p(a )p(b |a )+p(a )p(b |a )=43431231125p(b )=p(a )p(b |a )+p(a )p(b |a )=4343127755H(Y)=p(b )log(b )=log()log()0.9799(/)12121212bit ⨯+⨯=⨯+⨯=---=∑符号 22i j j i j i j i ,H(Y|X)=p(a ,b )logp(b |a )p(b |a )logp(b |a )2211log()log()0.9183(/)3333i jjbit -=-=-⨯-⨯=∑∑符号I(X;Y)=H(Y)H(Y|X)=0.97990.91830.0616(/)bit --=符号 H(X|Y)=H(X)I(X;Y)=0.81130.06160.7497(/bit --=符号)(2)求该信道的信道容量及其达到信道容量时的输入概率分布。

二进制对称信息的信道容量H(P)=-plog(p)-(1-p)log(1-p)1122C =1-H(P)=1+log()+log()=0.0817(bit/)3333符 BSC 信道达到信道容量时,输入为等概率分布,即:{0.5,0.5} 注意单位3-2 求下列三个信道的信道容量及其最佳的输入概率分布。

1b 2b 3b 3a 2a 1a Y X 1b 2b 3a 2a 1a Y X 1b 2b 2a 1a Y X 3b 11111110.70.3第一种:无噪无损信道,其概率转移矩阵为: 1 0 0P=0 1 00 0 1⎡⎤⎢⎥⎢⎥⎢⎥⎣⎦信道容量:()max (;)P X C I X Y @ bit/符号()()()()max{(;)}max{()(|)}(|)0max{(;)}max{()}p x p x p x p x C I X Y H X H X Y H X Y C I X Y H X ==-∴=∴==离散无记忆信道(DMC)只有输入为等概率分布时才能达到信道容量,C=log3=1.5850 bit/符号输入最佳概率分布如下:111,,333⎧⎫⎨⎬⎩⎭第二种:无噪有损信道,其概率转移矩阵为: 1 0P=0 10 1⎡⎤⎢⎥⎢⎥⎢⎥⎣⎦,离散输入信道, ()()()()max{(;)}max{()(|)}(|)0max{(;)}max{()}p x p x p x p x C I X Y H Y H Y X H Y X C I X Y H Y ==-∴=∴==H(Y)输出为等概率分布时可达到最大值,此值就是信道容量 此时最佳输入概率:123p(a )+p(a )=0.5,p(a )=0.5 信道容量:C=log(2)=1 bit/符号 第三种:有噪无损信道,由图可知:()()()()max{(;)}max{()(|)}(|)0max{(;)}max{()}p x p x p x p x C I X Y H X H X Y H X Y C I X Y H X ==-∴=∴==输入为等概率分布时可达到信道容量,此时信道容量p(x)C=max{H(X)}=log(2)=1 bit/符号 输入最佳概率分布:11,22⎧⎫⎨⎬⎩⎭3-3 设4元删除信道的输入量{1,2,3,4}X ∈,输出量{1,2,3,4,}Y E ∈,转移概率为(|)1(|)1-ε 0 0 0 ε0 1-ε 0 0 ε P=0 0 1-ε 0 ε0 0 0 1-ε ε1-ε 0 0 0 ε0 1-ε 0 0 ε p1= p2=0 0 1-ε 0 ε0 0 0 1-ε εP Y i X i P Y E X i εε===-===⎡⎤⎢⎥⎢⎥⎢⎥⎢⎥⎣⎦⎡⎤⎡⎤⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎣⎦⎣⎦其中1,2,3,4i = 1)该信道是对称DMC 信道吗? 2)计算该信道的信道容量;3)比较该信道与两个独立并联的二元删除信道的信道容量。

信息论与编码理论—第三章习题解答

2013-8-4

0.020

15

111 112 121 211 113 131 311 122 212 221 123 132 213 312 231 321 222 133 313 331 223 232 322 233 323 332 333

0.125 0.075 0.075 0.075 0.050 0.050 0.050 0.045 0.045 0.045 0.030 0.030 0.030 0.030 0.030 0.030 0.027 0.020 0.020 0.020 0.018 0.018 0.018 0.012 0.012 0.012 0.008 0 1 0 1 0 1 0.036

2013-8-4

7

(c) “当收到1时得到多少关于信源的平均信息”,这是求信 源随机变量U与事件“收到1”的(半平均)互信息量。 以码A为例。

I(收到1;U)=

P ( a1 , 且收到1) P ( a1 | 收到1) log P ( a1 ) P (收到1) P ( a2 , 且收到1) P ( a2 | 收到1) log P ( a2 ) P (收到1) P ( a3 , 且收到1) P ( a3 | 收到1) log P ( a3 ) P (收到1) P ( a4 , 且收到1) P ( a4 | 收到1) log P ( a4 ) P (收到1)

0.036

0.024

2013-8-4

0.020

17

111 112 121 211 113 131 311 122 212 221 123 132 213 312 231 321 222 133 313 331 223 232 322 233 323 332 333

信息论与编码课件第三章

利用信息论中的信号分析原理,检 测网络中的异常流量和行为,及时 发现和防范网络攻击。

THANKS FOR WATCHING

感谢您的观看

解码卷积码的方法包括最大似然解码、维特比解 码等,其中维特比解码算法具有较低的复杂度。

03 第三章 加密编码

加密编码的基本概念

加密编码是信息隐藏的一种形式, 通过将信息转化为难以理解的形 式,保护信息的机密性和完整性。

加密编码的基本要素包括明文、 密文、加密算法和解密算法。

加密编码的目标是确保只有授权 用户能够解密和读取密文,而未 经授权的用户无法获取明文信息。

离散无记忆信源的熵计算公式为$H(X) = - sum p(x) log_2 p(x)$,其中 $p(x)$表示输出符号$x$的概率。

离散无记忆信源的熵

离散无记忆信源的熵是用来度量其信 息量的一个重要参数,它表示在给定 概率分布下,输出符号所包含的平均 信息量。

离散有记忆信源的熵

离散有记忆信源的定义

信息论与编码课件第三章

contents

目录

• 第三章 信源编码 • 第三章 信道编码 • 第三章 加密编码 • 第三章 信息论与编码的应用

01 第三章 信源编码

信源编码的基本概念

01

信源编码的定义

信源编码是对信源输出的符号序列进行变换,使其满足某种特定规则的

过程。

02

信源编码的目的

信源编码的主要目的是在保证通信质量的前提下,尽可能地压缩信源输

对称密钥密码体制

对称密钥密码体制是指加密和 解密使用相同密钥的密码体制。

对称密钥密码体制的优点是加 密和解密速度快,适合于大量 数据的加密。

常见的对称密钥密码体制包括 AES(高级加密标准)和DES (数据加密标准)。

信息论与编码教学课件(全)

目录

• 课程介绍与背景 • 信息论基础 • 编码理论基础 • 信道编码技术 • 数据压缩技术 • 多媒体信息编码技术 • 课程总结与展望

01

课程介绍与背景

Chapter

信息论与编码概述

信息论的基本概念

01

信息、信息量、信息熵等

编码的基本概念

02

信源编码、信道编码、加密编码等

02

极化码(Polar Codes)

一种新型信道编码方式,通过信道极化现象实现高效可靠的信息传输。

03

深度学习在信道编码中的应用

利用深度学习技术优化传统信道编码算法,提高编码性能和效率。

05

数据压缩技术

Chapter

数据压缩概述与分类

数据压缩定义

通过去除冗余信息或使用更高效的编码方式,减小数据表示所需存储空间的过 程。

线性分组码原理:线性分组码是一 种将信息序列划分为等长的组,然 后对每组信息进行线性变换得到相 应监督位的编码方式。

具有严谨的代数结构,易于分析和 设计;

具有一定的检错和纠错能力,适用 于各种通信和存储系统。

循环码原理及特点

循环码原理:循环码是一种特殊的线 性分组码,其任意两个码字循环移位

后仍为该码的码字。

03

编码理论基础

Chapter

编码的基本概念与分类

编码的基本概念

编码是将信息从一种形式或格式转换为另一种形式的过程,以 满足传输、存储或处理的需要。

编码的分类

根据编码的目的和原理,可分为信源编码、信道编码、加密编 码等。

线性分组码原理及特点

线性分组码特点

监督位与信息位之间呈线性关系, 编码和解码电路简单;

信息论与编码理论-第三章

03 信源编码理论

离散无记忆信源的编码定理

香农第一定理

对于离散无记忆信源,存在一种码字, 使得码字的平均长度等于信源熵,且 可以无失真地恢复原始信源。

香农第二定理

对于离散有记忆信源,当码长趋于无 穷时,最理想的无失真编码方法的码 字平均长度趋近于信源熵。

连续信源的编码定理

连续信源熵的定义

连续信源熵是描述连续随机变量不确定性的量度,其值等于该随机变量取值范围所占据的微分体积。

信道编码

通过在信息中加入冗余,以降低 信息传输过程中的误码率,提高 通信的可靠性。

在数据压缩中的应用

无损压缩

利用信息论中的熵概念,将数据压缩至其理 论最小值,同时保持数据的完整性。

有损压缩

通过去除数据中的冗余和无关信息,实现数 据的较大程度压缩,常见于图像、音频和视

频压缩。

在网络安全中的应用

要点一

连续信源的编码定理

对于连续信源,存在一种码字,使得码字的平均长度等于连续信源熵,且可以无失真地恢复原始信源 。

预测编码与变换编码

预测编码

预测编码是根据原始信号的过去值来预测当前值,然后对预测误差进行编码。这种方法 常用于消除时间相关性,减少数据冗余。

变换编码

变换编码是将信号从时域变换到频域进行编码,通过去除信号中的冗余成分来压缩数据。 常见的变换编码方法包括离散余弦变换(DCT)和快速傅里叶变换(FFT)。

3

信道编码是一种主动的错误控制方法,它通过在 信息中添加冗余信息,使得接收端能够检测和纠 正传输过程中的错误。

线性码与循环码

线性码是一类特殊的码,它的编 码规则满足线性性质,即对于任 意两个码字进行线性运算,其结

果仍然是码字。

循环码是线性码的一种,它的码 字具有循环移位的性质,即一个

信息论与编码(第三章PPT)

Information and Coding Theory

第3章 信道容量

1

第3章 信道容量

3.1 信道基本概念 3.2 离散无记忆信道容量 3.3 组合信道的容量 3.4 连续无记忆信道的容量 3.5 波型信道的容量

2

3.1 信道基本概念

信道物理模型 输入消息X 输出消息Y 干扰

求X的概率分布 :由方程组

0.5z1 0.25z4 0.1

0z3.250z1.25zz24

0.4 0.4

0.25z1 0.5z4 0.1

求出解为: p1 p4 4 / 30, p2 p3 11/ 30.

pi (i 1,2,3,4)是一个概率分布,必是最佳分布, C是信道容量.

3.2 离散无记忆信道容量

log p(b1) C

(1 log

)log p(b2) log p(b2) (1 )log

p(b3) p(b3)

[C [C

log log

(1 )log(1 (1 )log(1

X

信道

Y

干扰

3

3.1 信道基本概念

信道分类 根据信道用户的多少 单用户信道 多用户信道 根据信道输入端与输出端的关系 无反馈信道 有反馈信道 根据信道的参数与时间的关系 固定参数信道 时变参数信道

4

3.1 信道基本概念

根据输入与输出 随机变量的取值分类 离散信道(数字信道: 时间、取值离散) 连续信道(模拟信道: 取值连续) 半连续信道( 时间、取值一个离散,另一个连续) 波形信道(时间、取值连续)

18

3.2 离散无记忆信道容量

例3-2-2 设DMC的转移概率矩阵为

信息论与编码原理第三章讲课文档

3.2.1 数学模型

信道模型:

1-P

0

0

P

P

1

1

1-P

这种信道的输出符号仅与对应时刻输入符号 有关,与以前输入无关,故称此信道是无记忆信道 的.

第23页,共149页。

3.2.1 数学模型

2.离散无记忆信道 若输入值的集合 X={X0,X1…Xr-1}

输出 Y={y0,y1…ys-1} 且信道和调制过程是无记忆的

信息论与编码原理第三章

第1页,共149页。

本次课内容

3.1 信道的基本概念 3.2 离散单符号信道及容量

3.2.1 数学模型

3.2.2 信道容量

第2页,共149页。

相 关

信道(information channels):

知 识

是信号的传输媒质。

复

信道的作用:

习

把携有信息的信号从它的输入端传递到输出

信道输入、输出符号之间的联合分布为

p(ai,bj)p(ai)p(bj ai)

p(bj ai )

前向概率,表示在输入为x=ai 时,通 过信道后接收为bj 的概率,描述了信 道噪声的特性。P(ai) 为先验概率。

联合分布还可以表示为

p(ai bj )

第19页,共149页。

后验概率,表示当接收符号为bj时,信 道输入为ai的概率。

第13页,共149页。

3.2

3.2离散单符号信道及容量

离 散

3.2.1 数学模型

单 符

若信道的输入符号之间、输出符号之间都不存

号 在关联性,信道的分析可简化为对单个符号的信道

信

道 分析,此时输入、输出可以看做是单符号的,称这

及 容

信息论与编码-第三章ppt课件

R

R

pX (x)dx pn (n) log pn (n)dn

R

R

pn (n) log pn (n)dn Hc (n)

R

信息论与编码-信道与信道容量

• 上式说明条件熵是由噪声引起的,它等于噪声信 源的熵。故条件熵也称噪声熵。

• 在加性多维连续信道中,输入矢量X、输出矢量Y 和噪声矢量n之间的关系是

信息论与编码-信道与信道容量

➢ 信道分类和表示参数 ➢ 通信系统中,信道是非常重要的部分。信道的任务是

以信号方式传输信息。在信道中会引入噪声,这些都 会使信号通过信道后产生错误和失真,故信道的输入 和输出之间一般不是确定的函数关系,而是统计依赖 关系。

➢ 只要知到了信道的输入信号和输出信号以及它们之间 的统计依赖关系,则信道的全部特性就确定了。所以 可以用信道的转移概率矩阵P(Y/X)来描述信道、信道 的数学模型及分类

信息论与编码-信道与信道容量

➢ 对称DMC信道的容量 ➢ 对称DMC信道的定义: ➢ 如果一个DMC信道的转移概率矩阵P中的每一行

都是第一行的置换〔包含同样的元素,但位置可 以不同),则称该矩阵是输入对称的, ➢ 如果转移概率矩阵P的每一列都是第一列的置换, 则称该矩阵是输出对称的, ➢ 如果一个DMC信道的输入、输出都对称,则称 该DMC信道为对称DMC信道。

信息论与编码-信道与信道容量

➢ 信道参数 ➢ 设信道的输入矢量和输出矢量分别是

X(X 1 ,X 2 , ,X i, ) X i A {a 1,a2, ,an}

Y(Y 1 ,Y 2, ,Y j, ) Y i B{b1,b2, ,bm }

➢ 通常采用条件概率 p(Y/X) 来描述信道输入输出 信号之间统计的依赖关系。

12953_精品课课件信息论与编码(全套讲义)

2024/1/28

10

03

信道编码

2024/1/28

11

信道编码概述

01

信道编码的基本概念

为了提高信息传输的可靠性,在信源编码的基础上增加一些监督码元,

这些多余的码元与信息码元之间以某种确定的规则相互关联(约束)。

02

信道编码的目的

对传输的信息码元进行检错和纠错,提高信息传输的可靠性。

2024/1/28

编码的基本原则

有效性、可靠性、安全性、经 济性。

8

编码的分类与原理

2024/1/28

分类

根据编码对象的不同,可分为信源编码、信道编码和加密 编码等。

原理

不同的编码方式采用不同的编码原理和算法,如信源编码 中的哈夫曼编码、信道编码中的卷积码和LDPC码等。

编码与调制的关系

编码是数字通信中的关键技术之一,与调制技术密切相关 。编码后的信号需要通过调制技术转换为适合在信道中传 输的信号。

2024/1/28

信宿

接收并处理信息的实体或系统, 如人、计算机等。

译码器

将信道中传输的信号还原成原始 信息。

6

02

编码理论

2024/1/28

7

编码的基本概念

编码定义

将信息从一种形式或格式转换 为另一种形式的过程。

2024/1/28

编码的目的

提高信息传输效率,增强信息 抗干扰能力,实现信息的可靠 传输。

共同应对挑战

在信息传输和存储领域,信息论 和编码技术将共同应对诸如信道 噪声、数据压缩等挑战。

创新应用领域

通过信息论与编码的交叉融合, 将产生更多创新性的应用,如无 损压缩、加密通信等。

2024/1/28

教学课件 信息论与编码(第三版)邓家先

消息

信息的表现形 式;

文字,图像, 声音等;

信号

信号的变化描 述消息;

信息的基本特点

1.不确定性

受信者在接收到信息之前,不知道信源发送 的内容是什么,是未知的、不确定性事件;

2.受信者接收到信息后,可以减少或者消除不确定性;

3. 可以产生、消失、存储,还可以进行加工、处理;

4. 可以度量

1.2 通信系统的模型

冗 信源符号 余 变 相关性强 化 统计冗余强

信源编码器

码序列 相关性减弱 统计冗余弱

相关冗余 统计冗余 生理冗余

模型简化

信源输出前后符号之间存在一定相关性

信源输出符号不服从等概率分布

听音乐时,调节不同频率增益

调音

台

人的耳朵对相位引起失真不敏感

人的视觉对幅值失真不特别 敏感,但是对相位引起失真 很敏感

信息论主要立足点

基础:

信息可以度量

研究

通过

有效性

可靠性

目的 提高传输数据中每个码元

信源

携带的信息量,从而提高

编码

数据传输效率。

信道

编码

使系统能够检测、纠正传

输过程中的数据错误。

1.1信息论的形成与发展

信息论研究范围

信息度量

狭

义 信 息

信息特征 信息容量

论

干扰对信息传

递影响

除了狭义信息论内容

之外,还有

Z=Zˆ 并不是总是成立

信息

差错控制编码、译码足够好

无失真编码

符号

限失真失真

编码

Z=Zˆ Z Zˆ

Y=Yˆ 一般总是成立

1.2 通信系统的模型

信源

• 产生消息的来源,可以是文字、语言、图像等;

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

2.1.4 平均互信息量

2.1 单 符 号 离 散 信 源

(1) 互信息量和条件互信息量

① 互信息量 互信息量的三种不同表达式 观察者站在通信系统总体立场上

▼ 通信后:输入随机变量 X 和输出随机变量 Y 之间由信道的统计

特性相联系,其联合概率密度: p(xi yj)=p(xi)p(yj /xi )= p(yj)p(xi / yj) 后验不确定度:

(1) 互信息量和条件互信息量

① 互信息量 互信息量定义: 最简单的通信系统模型: X—信源发出的离散消息集合 Y—信宿收到的离散消息集合 信源通过有干扰的信道发出消息传递给信宿; 信宿事先不知道某一时刻发出的是哪一个消息,所以每 个消息是随机事件的一个结果。

信源X 有扰信道 信宿Y

干扰源 图2.1.3 简单通信系统模型

▼ 自信息量:对 yj 一无所知的情况下 xi 存在的不确定度; ▼ 条件自信息量:已知 yj 的条件下 xi 仍然存在的不确定度; ▼ 互信息量:两个不确定度之差是不确定度被消除的部分,即等

于自信息量减去条件自信息量。

2010-3-11

The Department of Communication Engineering, NCUT

▼ 通信后的互信息量,等于前后不确定度的差:

I ( x i ; y j ) = log 2

1 1 − log 2 p( x i ) p( y j ) p( x i y j )

= I ' ( x i y j ) − I '' ( x i y j ) = I ( x i ) + I ( y j ) − I ( x i y j )

14

2.1.4 平均互信息量

2.1 单 符 号 离 散 信 源

(1) 互信息量和条件互信息量

① 互信息量 互信息量的三种不同表达式 观察者站在输入端

I ( y j ; x i ) = log 2 1 1 − log 2 = I ( y j ) − I ( y j / xi ) p( y j ) p( y j / x i )

▼ 通信前:输入随机变量 X 和输出随机变量 Y 之间没有任何关联

关系,即 X,Y 统计独立;

▼ p(xi yj)=p(xi) y j ) = log 2

2010-3-11

1 p( x i ) p( y j )

16

The Department of Communication Engineering, NCUT

▼ 两个随机事件的可能结果 xi 和 yj 之间的统计约束程度; ▼ 从 yj 得到的关于 xi 的信息量 I(xi;yj) 与从 xi 得到的关于 yj 的信息

量 I(yj; xi) 是一样的,只是观察的角度不同而已。

2010-3-11

The Department of Communication Engineering, NCUT

13

2.1.4 平均互信息量

2.1 单 符 号 离 散 信 源

(1) 互信息量和条件互信息量

① 互信息量 互信息量的三种不同表达式 观察者站在输出端

1 1 I ( x i ; y j ) = log 2 − log 2 = I ( xi ) − I ( xi / y j ) p( x i ) p( x i / y j )

I ( x i ; y j ) = log 2 = log 2 p( x i / y i ) p( x i ) ( i = 1,2, … , n; j = 1,2, … , m )

1 1 − log 2 p( x i ) p( x i / y j )

= I ( xi ) − I ( xi / y j )

I ( xi y j ) = I ( xi ) + I ( y j / xi )

2010-3-11

The Department of Communication Engineering, NCUT

10

2.1.4 平均互信息量

2.1 单 符 号 离 散 信 源

(1) 互信息量和条件互信息量

① 互信息量 举例 某地二月份天气构成的信源为:

2

第二章 信源及其信息量

本章重点:信源的统计特性和数学模型、各类信源的信息测 度—熵及其性质。

2.1 单符号离散信源 2.2 扩展信源 2.3 连续信源 2.4 离散无失真信源编码定理 2.5 小结

2010-3-11

The Department of Communication Engineering, NCUT

▼ 这三种表达式实际上是等效的,在实际应用中可根据具体情况

选用一种较为方便的表达式。

2010-3-11

返回目录

18

The Department of Communication Engineering, NCUT

2.1.4 平均互信息量

2.1 单 符 号 离 散 信 源

(1) 互信息量和条件互信息量

I '' ( x i y j ) = log 2

2010-3-11

1 p( x i y j )

17

The Department of Communication Engineering, NCUT

2.1.4 平均互信息量

2.1 单 符 号 离 散 信 源

(1) 互信息量和条件互信息量

① 互信息量 互信息量的三种不同表达式 观察者站在通信系统总体立场上

2010-3-11

The Department of Communication Engineering, NCUT

9

2.1.4 平均互信息量

2.1 单 符 号 离 散 信 源

(1) 互信息量和条件互信息量

① 互信息量 互信息量定义: 互信息量: yj 对 xi 的互信息量定义为后验概率与先验 概率比值的对数。

2010-3-11

The Department of Communication Engineering, NCUT

8

2.1.4 平均互信息量

2.1 单 符 号 离 散 信 源

(1) 互信息量和条件互信息量

① 互信息量 互信息量定义: 先验概率:信源发出消息 xi 的概率 p(xi )。 后验概率:信宿收到 yj 后推测信源发出 xi 的概率: p(xi / yj )。

2010-3-11

The Department of Communication Engineering, NCUT

11

2.1.4 平均互信息量

2.1 单 符 号 离 散 信 源

(1) 互信息量和条件互信息量

① 互信息量 举例

计算 y1 与各种天气之间的互信息量 对天气 x1,不必再考虑 对天气 x2, I ( x 2 ; y1 ) = log 2 p( x 2 / y1 ) = log 2 1 / 2 = 1(比特 ) p( x 2 ) 1/ 4 对天气 x3, I ( x 3 ; y1 ) = log 2 对天气 x4 , I ( x4 ; y1 ) = log 2

观察者得知输入端发出 xi 前、后对输出端出现 yj 的不确 定度的差。

2010-3-11

The Department of Communication Engineering, NCUT

15

2.1.4 平均互信息量

2.1 单 符 号 离 散 信 源

(1) 互信息量和条件互信息量

① 互信息量 互信息量的三种不同表达式 观察者站在通信系统总体立场上

② 互信息的性质 对称性 I(xi ; yj) = I(yj ; xi) 推导过程:

I ( x i ; y j ) = log 2 = log 2 p( x i / y j ) p( x i ) = log 2 p( x i / y j ) p( y j ) p ( x i ) p( y j ) p( y j / x i ) p( y j ) = I ( y j ; xi )

2.1 单 符 号 离 散 信 源

将信道的发送和接收端分别看成是两个“信源”,则两者 之间的统计依赖关系(信道输入和输出之间)描述了信道 的特性。

(1) 互信息量和条件互信息量 (2) 平均互信息量的定义 (3) 平均互信息量的物理含义 (4) 平均互信息量的性质

2010-3-11

The Department of Communication Engineering, NCUT

⎡ Y ⎤ ⎧ y1 , ⎢ P (Y )⎥ = ⎨ p( y ), 1 ⎣ ⎦ ⎩ 0 ≤ p( y j ) ≤ 1,

∑ p( x ) = 1

i =1 i

n

ym ⎫ ⎬ p( y2 ), …, p( y j ), …, p( ym )⎭ y2 ,

m

…,

yj,

…,

∑ p( y ) = 1

j =1 j

p( x i y j ) / p ( x i ) p( y j )

= log 2

2010-3-11

The Department of Communication Engineering, NCUT

19

2.1.4 平均互信息量

2.1 单 符 号 离 散 信 源

(1) 互信息量和条件互信息量

② 互信息的性质 对称性 互信息量的对称性表明:

⎡ X ⎤ ⎧x1(晴), x2 (阴), x3 (雨), x4 (雪)⎫ ⎬ ⎢P( X )⎥ = ⎨ 1, 1 1 1 , , ⎦ ⎩ 2 ⎣ 4 8 8 ⎭

收到消息 y1:“今天不是晴天” 收到 y1 后:p(x1/y1)=0, p(x2/y1)=1/2, p(x3/y1)=1/4,p(x4/y1)=1/4

20

2.1.4 平均互信息量

2.1 单 符 号 离 散 信 源