GPU编程入门系列视频教程

AMD OpenCL大学课程(10) GPU线程及调度

AMD OpenCL大学课程(10) GPU线程及调度本节主要讲述OpenCL中的Workgroup如何在硬件设备中被调度执行。

同时也会讲一下同一个workgroup中的workitem,如果它们执行的指令发生diverage(就是执行指令不一致)对性能的影响。

学习OpenCL并行编程,不仅仅是对OpenCL Spec本身了解,更重要的是了解OpenCL 硬件设备的特性,现阶段来说,主要是了解GPU的的架构特性,这样才能针对硬件特性优化算法。

现在OpenCL的Spec是1.1,随着硬件的发展,相信OpenCL会支持更多的并行计算特性。

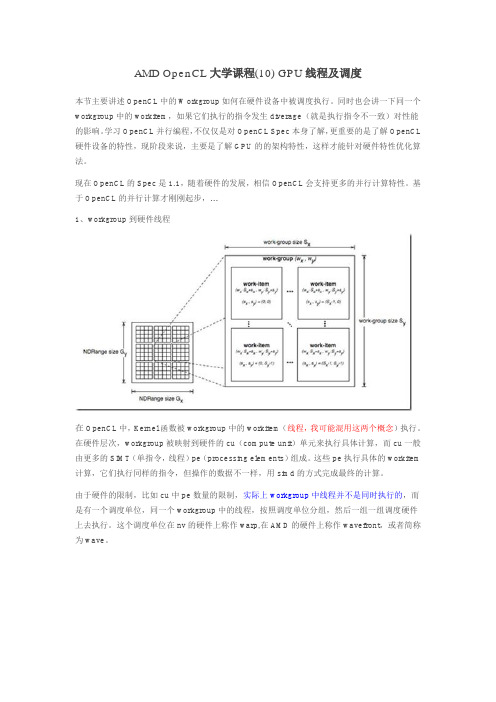

基于OpenCL的并行计算才刚刚起步,…1、workgroup到硬件线程在OpenCL中,Kernel函数被workgroup中的workitem(线程,我可能混用这两个概念)执行。

在硬件层次,workgroup被映射到硬件的cu(compute unit)单元来执行具体计算,而cu一般由更多的SIMT(单指令,线程)pe(processing elements)组成。

这些pe执行具体的workitem 计算,它们执行同样的指令,但操作的数据不一样,用simd的方式完成最终的计算。

由于硬件的限制,比如cu中pe数量的限制,实际上workgroup中线程并不是同时执行的,而是有一个调度单位,同一个workgroup中的线程,按照调度单位分组,然后一组一组调度硬件上去执行。

这个调度单位在nv的硬件上称作warp,在AMD的硬件上称作wavefront,或者简称为wave。

上图显示了workgroup中,线程被划分为不同wave的分组情况。

wave中的线程同步执行相同的指令,但每个线程都有自己的register状态,可以执行不同的控制分支。

比如一个控制语句if(A){… //分支A}else{… //分支B}假设wave中的64个线程中,奇数线程执行分支A,偶数线程执行分支B,由于wave中的线程必须执行相同的指令,所以这条控制语句被拆分为两次执行[编译阶段进行了分支预测],第一次分支A的奇数线程执行,偶数线程进行空操作,第二次偶数线程执行,奇数线程空操作。

2024版CUDA编程入门极简教程

行划分,每个线程处理一部分数据;任务并行是将任务划分为多个子任

务,每个线程执行一个子任务。

02

共享内存与全局内存

CUDA提供共享内存和全局内存两种存储空间。共享内存位于处理器内

部,访问速度较快,可用于线程间通信;全局内存位于处理器外部,访

问速度较慢,用于存储大量数据。

03

异步执行与流

CUDA支持异步执行,即CPU和GPU可以同时执行不同的任务。通过创

2023

PART 02

CUDA环境搭建与配置

REPORTING

安装CUDA工具包

下载CUDA工具包

01

访问NVIDIA官网,下载适用于您的操作系统的CUDA工具包。

安装CUDA工具包

02

按照安装向导的指示,完成CUDA工具包的安装。

验证安装

03

安装完成后,可以通过运行CUDA自带的示例程序来验证算,每个线 程处理一个子任务。计算完成后, 将结果从设备内存传输回主机内 存,并进行必要的后处理操作。

2023

PART 05

CUDA优化策略与技巧

REPORTING

优化内存访问模式

合并内存访问

通过确保线程访问连续的内存地址,最大化内 存带宽利用率。

使用共享内存

利用CUDA的共享内存来减少全局内存访问, 提高数据重用。

避免不必要的内存访问

精心设计算法和数据结构,减少不必要的内存读写操作。

减少全局内存访问延迟

使用纹理内存和常量内存

利用CUDA的特殊内存类型,如纹理内存和常量内存,来加速数 据访问。

数据预取和缓存

通过预取数据到缓存或寄存器中,减少全局内存访问次数。

展望未来发展趋势

CUDA与深度学习

CUDA编程入门

/*

在GPU上计算PI的程序,要求块数和块内线程数都是2的幂

前一部分为计算block内归约,最后大小为块数

后一部分为单个block归约,最后存储到*pi中。

*/

/*

在GPU上计算PI的程序,要求块数和块内线程数都是2的幂

前一部分为计算block内归约,最后大小为块数

for(int i=0;i<num;i++){

temp=(i+0.5f)/num;

// printf("%f\n",temp);

sum+=4/(1+temp*temp);

// printf("%f\n",sum);

blockIdx, blockIdx也是一个包含三个元素x,y,z的结构体,分别表示当前线程所在块在网格中x,y,z三个方向上的索引;

threadIdx, threadIdx也是一个包含三个元素x,y,z的结构体,分别表示当前线程在其所在块中x,y,z三个方向上的索引;

warpSize,warpSize表明warp的尺寸,在计算能力为1.0的设备中,这个值是24,在1.0以上的idia官方网站(/object/cuda_get_cn.html)上下载对应操作系统的驱动(driver)和工具包(toolkit)。

再次,转换到控制台,命令为Ctrl+Alt+F1/F2/F3/F4,关掉gdm,命令为:sudo /etc/init.d/gdm stop,要确定已经关闭,否则在安装时会提示你有x server程序在运行。

再次,进入driver和toolkit目录,执行安装命令,为了方便,请一定按照默认安装。

GPU编程自学教程

GPU编程自学教程VR的发展已步入正轨,硬件头盔和内容平台等都有了不错的成果,但这个广袤的市场迫切的需要技术精英跟上它发展的脚步。

因此,若还有小伙伴想从事VR行业,不妨在校先学好技术。

学习VR开发GPU编程是重中之重。

GPU英文全称Graphic Processing Unit,中文翻译为“图形处理器”。

GPU是相对于CPU的一个概念。

在现代的计算机中(尤其是家用系统,游戏发烧友)图形处理变得越来越重要,因此需要一个专门的图形核心处理器。

GPU是显示卡的“心脏”,也就相当于CPU在电脑中的作用,它决定了该显卡的档次和大部分性能,同时也是2D显示卡和3D显示卡的区别依据。

2D 显示芯片在处理3D图像和特效时主要依赖CPU的处理能力,称为“软加速”。

3D显示芯片是将三维图像和特效处理功能集中在显示芯片内,也即所谓的“硬件加速”功能。

显示芯片通常是显示卡上最大的芯片(也是引脚最多的)。

现在市场上的显卡大多采用NVIDIA和ATI两家公司的图形处理芯片。

于是NVIDIA公司在1999年发布GeForce256图形处理芯片时首先提出GPU的概念。

GPU使显卡减少了对CPU的依赖,并进行部分原本CPU的工作,尤其是在3D图形处理时。

GPU所采用的核心技术有硬体T&L、立方环境材质贴图和顶点混合、纹理压缩和凹凸映射贴图、双重纹理四像素256位渲染引擎等,而硬体T&L技术可以说是GPU的标志。

目前最新的可编程图形硬件已经具备了如下功能:1、支持vertex programmability和fragment programmability。

2、支持IEEE32位浮点运算。

3、支持4元向量,4阶矩阵计算。

4、提供分支指令,支持循环控制语句。

5、具有高带宽的内存传输能力(>27.1GB/s)。

6、支持1D、2D、3D纹理像素查询和使用,且速度极快。

7、支持绘制到纹理功能(Render to Texture,RTT)。

如何通过编程将GPU用于通用计算任务

如何通过编程将GPU用于通用计算任务随着现代图形处理器(GPU)可编程能力及性能的提高,应用开发商们一直希望图形硬件可以解决以前只有通用CPU才能完成的高密集计算任务。

尽管利用通用GPU进行计算很有发展前景,但传统图像应用编程接口仍然将GPU抽象成一个包括纹理、三角形和像素在内的图像绘制器。

寻找一种能够使用这些基本元素的映射算法并不是一项简单的操作,即便对最先进的图形开发商而言也是如此。

幸运的是,基于GPU的计算从概念上讲很容易理解,并且现有多种高级语言和软件工具可以简化GPU的编程工作。

但是,开发商必须首先了解GPU在图像绘制过程中是如何工作的,然后才能确定可用于计算的各个组件。

在绘制图像时,GPU首先接收宿主系统以三角顶点形式发送的几何数据。

这些顶点数据由一个可编程的顶点处理器进行处理,该处理器可以完成几何变换、亮度计算等任何三角形计算。

接下来,这些三角形由一个固定功能的光栅器转换成显示在屏幕上的单独“碎片(fragment)”。

在屏幕显示之前,每个碎片都通过一个可编程的碎片处理器计算最终颜色值。

图1:执行两向量相加的简单Brook代码示例。

Brook支持所有带附加流数据的C句法,流数据存储于GPU的存储器中,而核函数也在GPU上执行。

计算碎片颜色的运算一般包括集合向量数学操作以及从“纹理”中提取存储数据,“纹理”是一种存储表面材料颜色的位图。

最终绘制的场景可以显示在输出设备上,或是从GPU的存储器重新复制到宿主处理器中。

可编程顶点处理器和碎片处理器提供了许多相同的功能和指令集。

但是,大部分GPU编程人员只将碎片处理器用于通用计算任务,因为它通常提供更优的性能,而且可以直接输出到存储器。

利用碎片处理器进行计算的一个简单例子是对两个向量进行相加。

首先,我们发布一个大三角形,其所包含的碎片数量和向量大小(容纳的元素)相同。

产生的碎片通过碎片处理器进行处理,处理器以单指令多数据(SIMD)的并行方式执行代码。

Cuda教程范文

Cuda教程范文一、CUDA基本概念1.GPU:图形处理器,用于处理图形渲染任务的特殊硬件。

2.CPU:中央处理器,用于执行通用计算任务的主要硬件。

3.线程:并行计算的最小执行单元,由大量线程组成。

4.块:线程的集合,通过共享内存进行交互。

5.网格:块的集合,用于组织线程的层次结构。

6.设备:指GPU设备,用于执行CUDA并行计算的硬件。

7.主机:指CPU设备,用于控制和调度GPU设备。

二、CUDA编程模型1.主机代码:在主机上执行的代码,用于控制和调度GPU设备的任务。

2.设备代码:在GPU上执行的代码,用于实现并行计算任务。

3.主机和设备之间的数据传输:通过主机和设备之间的内存传输实现数据共享。

三、CUDA编程步骤1.设备选择和初始化:通过CUDAAPI选择并初始化要使用的GPU设备。

2.主机和设备内存管理:使用CUDAAPI分配和管理主机和设备内存。

3.主机和设备之间的数据传输:使用CUDAAPI实现主机和设备之间的数据传输。

4.设备代码编写和调用:编写并实现在GPU上执行的并行计算任务,并通过CUDAAPI调用设备代码。

5.并行计算的同步和通信:使用CUDAAPI实现并行计算任务中的同步和通信操作。

6.结果处理和输出:使用CUDAAPI将计算结果从设备内存传输到主机内存,并进行结果处理和输出。

四、CUDA常用技术1.核函数:在设备上执行的函数,用于实现并行计算任务。

2.线程块和网格的设置:通过设置线程块和网格的数量和大小来实现并行计算的优化。

3.共享内存:在线程块内部共享的内存,用于提高线程间的通信和数据传输效率。

4.原子操作:用于实现线程间的同步和数据更新的原子操作。

5.线程间的通信:使用共享内存和原子操作等技术实现线程间的通信和协作。

6.CUDA库函数的使用:使用CUDA库函数来实现并行计算任务,如线性代数、图像处理等。

通过本教程的学习,您将能够了解CUDA的基本概念和编程模型,学会使用CUDA编程进行高效的并行计算。

09276_电脑入门培训教程

内存(RAM)

临时存储数据,供CPU快速访问。

硬盘(HDD或SSD)

永久存储数据,包括操作系统、应用 程序和文件。

2024/1/26

显卡(GPU)

处理图形数据,将图像显示在显示器 上。

电源

为电脑提供电力。

其他硬件

包括主板、机箱、散热器、键盘、鼠 标等。

4

电脑软件概述

Photoshop基础

了解图层、选区、滤镜等核心概念,学习图像调整、修饰和合成 等基本操作。

GIMP入门

掌握GIMP的界面布局、工具使用、图层管理等基础知识,进行图 像编辑和美化。

批量处理技巧

学习使用批处理命令或第三方插件,提高处理大量图片的效率。

2024/1/26

23

多媒体播放软件使用方法

本地视频播放

2024/1/26

插入与编辑图片

学习如何在文档中插入图片,并 对图片进行编辑和美化。

段落排版

了解并掌握段落缩进、间距、分 栏等排版技巧。

16

04文件管理与ຫໍສະໝຸດ 作2024/1/2617

文件类型及查看方式

常见文件类型

文本文件、图像文件、音 频文件、视频文件、压缩 文件等。

2024/1/26

查看文件类型

掌握使用VLC、PotPlayer等播放 器播放本地视频文件的方法,了

解常见视频格式及转码工具。

网络流媒体播放

学习使用腾讯视频、爱奇艺等在 线视频平台观看网络流媒体内容

,掌握搜索和筛选功能。

音乐播放与管理

了解使用网易云音乐、QQ音乐 等软件播放和管理音乐文件的方 法,包括创建歌单、同步歌词等

操作。

最全与最好的CUDA入门教程

图形图像处理应用

图像滤波与增强

CUDA可用于实现高效的图像滤波算法,如 高斯滤波、中值滤波等,以及图像增强技术 ,如直方图均衡化、锐化等。

图像压缩与编码

CUDA可加速图像压缩算法,如JPEG、PNG等格式 的编码和解码过程,提高图像处理的实时性。

最全与最好的CUDA 入门教程

目录

• CUDA概述与基础 • CUDA编程基础 • CUDA进阶技术 • CUDA高级特性 • CUDA实战案例解析 • 总结与展望

01 CUDA概述与基础

CUDA定义及发展历程

CUDA(Compute Unified Device Architecture)是 NVIDIA推出的并行计算平台和API模型,它允许开发者使用 NVIDIA GPU进行通用计算。

其他框架支持

CUDA还支持与其他深度学习框架(如Caffe、Keras等) 的集成,为各种深度学习应用提供统一的GPU加速方案。

性能评估与调优方法

性能分析工具

CUDA提供了一套完整的性能分析工具,如NVIDIA Visual Profiler、Nsight等,帮助开发者定位性能瓶颈并进行优化 。

优化策略

针对CUDA程序的性能问题,可以采用一系列优化策略,如 减少全局内存访问、优化内存访问模式、利用并行化减少 计算复杂度等。

最佳实践

在编写CUDA程序时,遵循一些最佳实践可以提高程序性能 ,如合理划分任务、减少线程同步、优化内核函数设计等 。

05 CUDA实战案例解析

矩阵乘法加速实现

01

利用CUDA进行矩阵乘法的并行化处理和优化,包括 分块处理、共享内存使用等策略。

gpu并行计算编程基础

gpu并行计算编程基础GPU并行计算编程是指利用图形处理器(Graphic Processing Unit,简称GPU)进行并行计算的编程技术。

相比于传统的中央处理器(Central Processing Unit,简称CPU),GPU在处理大规模数据时具备更强的并行计算能力。

以下是GPU并行计算编程的基础知识与常见技术:1. GPU架构:GPU由许多计算单元(也被称为流处理器或CUDA核心)组成,在同一时间内可以执行大量相似的计算任务。

现代GPU通常由数百甚至数千个计算单元组成。

2. 并行编程模型:GPU并行计算涉及使用并行编程模型来利用GPU的计算能力。

最常用的两个并行编程模型是CUDA(Compute Unified Device Architecture)和OpenCL(Open Computing Language)。

CUDA是NVIDIA提供的并行计算框架,而OpenCL是一个跨硬件平台的开放标准。

3. 核心概念:在GPU并行计算中,核心概念是线程(Thread)和线程块(Thread Block)。

线程是最小的并行执行单元,而线程块则是一组线程的集合。

线程块可以共享数据和同步执行,从而使并行计算更高效。

4. 内存层次结构:GPU具有多种类型的内存,包括全局内存、共享内存和本地内存。

全局内存是所有线程都可以访问的内存,而共享内存则是线程块内部的内存。

合理地使用内存可以提高并行计算的性能。

5. 数据传输:在GPU编程中,还需要考虑数据在CPU和GPU之间的传输。

数据传输的频率和效率会影响整体性能。

通常,尽量减少CPU和GPU之间的数据传输次数,并使用异步传输操作来隐藏数据传输的延迟。

6. 并行算法设计:设计并行算法时,需要考虑如何将计算任务划分为多个并行的子任务,以利用GPU的并行能力。

通常,可以将问题划分为多个独立的子任务,每个子任务由一个线程块处理。

7. 性能优化:为了获得最佳性能,GPU并行计算编程需要进行性能优化。

cuda教程

cuda教程CUDA 是一种并行计算平台和编程模型,用于利用 NVIDIA GPU 的计算能力。

本教程旨在介绍 CUDA 并提供一些基本的示例代码,以帮助初学者理解和使用 CUDA 编程。

安装 CUDA要开始使用 CUDA,首先需要在计算机上安装 CUDA 工具包和驱动程序。

您可以从 NVIDIA 的官方网站上下载相应的安装包,并按照指示进行安装。

安装完成后,您就可以使用CUDA 了。

编写 CUDA 程序CUDA 程序是由 CPU 和 GPU 两部分组成的。

CPU 部分负责协调和控制计算任务的分发,而 GPU 部分则负责实际的计算工作。

在编写 CUDA 程序时,您需要区分 CPU 和 GPU 代码,并合理地进行任务分配。

CUDA 编程模型CUDA 使用了一种称为「流式处理」的并行计算模型。

在CUDA 中,将计算任务划分为多个线程块(thread block),并将线程块分配给 GPU 的多个处理器进行并行计算。

每个线程块里面又包含多个线程,线程之间可以进行通信和同步。

CUDA 编程语言CUDA 可以使用多种编程语言进行开发,包括 C、C++ 和Fortran 等。

下面是一个简单的示例,演示了如何使用 CUDAC 编写一个向量相加的程序。

```c#include <stdio.h>__global__ void vector_add(int *a, int *b, int *c, int n) { int i = threadIdx.x;if (i < n) {c[i] = a[i] + b[i];}}int main(void) {int n = 10;int *a, *b, *c;int *d_a, *d_b, *d_c;int size = n * sizeof(int);// 分配设备内存cudaMalloc((void **)&d_a, size);cudaMalloc((void **)&d_b, size);cudaMalloc((void **)&d_c, size);// 分配主机内存a = (int *)malloc(size);b = (int *)malloc(size);c = (int *)malloc(size);// 初始化向量for (int i = 0; i < n; i++) {a[i] = i;b[i] = i * 2;}// 将数据从主机内存复制到设备内存cudaMemcpy(d_a, a, size, cudaMemcpyHostToDevice); cudaMemcpy(d_b, b, size, cudaMemcpyHostToDevice);// 启动 GPU 计算vector_add<<<1, n>>>(d_a, d_b, d_c, n);// 将结果从设备内存复制到主机内存cudaMemcpy(c, d_c, size, cudaMemcpyDeviceToHost);// 打印结果for (int i = 0; i < n; i++) {printf("%d + %d = %d\n", a[i], b[i], c[i]);}// 释放内存free(a);free(b);free(c);cudaFree(d_a);cudaFree(d_b);cudaFree(d_c);return 0;}```在这个示例中,我们定义了一个向量相加函数 `vector_add`,并在主函数中调用它。

学习使用CUDA进行GPU编程

学习使用CUDA进行GPU编程第一章:概述GPU编程和CUDA技术GPU(Graphics Processing Unit)是一种专门用于图形处理的处理器。

由于其高度并行的特点,GPU逐渐被应用于科学计算、机器学习等领域。

CUDA(Compute Unified Device Architecture)是由NVIDIA公司推出的一种GPU编程技术,它允许程序员直接利用GPU的高并行性进行计算。

1.1 GPU的特点GPU相比于传统的CPU,具有以下几个显著的特点:高并行计算能力、大规模数据处理能力和高带宽存储。

1.2 CUDA的优势CUDA提供了一种简洁高效的编程模型,使程序员能够充分利用GPU的计算能力。

CUDA还提供了丰富的库函数和工具,方便程序员进行开发和调试。

第二章:CUDA编程模型和基本概念2.1 CUDA编程模型CUDA编程模型采用主机(Host)和设备(Device)之间的工作分配方式。

主机负责数据的传输和控制流程的管理,而设备则负责并行计算任务的执行。

2.2 核函数(Kernel)核函数是在GPU上并行执行的函数,程序员可以通过定义核函数来描述并行算法的执行过程。

2.3 线程块(Thread Block)和网格(Grid)线程块是核函数执行的最小单位,一个线程块中包含多个线程。

线程块可以组成网格,通过设置网格的大小和线程块的大小来控制并行计算的规模。

第三章:CUDA编程步骤和流程3.1 准备GPU环境在开始CUDA编程之前,需要先配置好GPU环境,包括安装适当的驱动程序和CUDA库。

3.2 分配和传输内存在CUDA编程中,需要手动管理GPU和CPU内存的分配和传输。

程序员需要使用cudaMalloc和cudaMemcpy等函数来完成数据的分配和传输。

3.3 编写核函数核函数是GPU上并行执行的任务,程序员需要编写核函数来描述计算任务的具体过程。

在核函数中,可以使用特殊的线程ID来确定不同线程中的计算任务。

(2024年)CUDA教程新手入门学编程

管理、并行计算等关键技能。

图像处理算法并行化

02

学习如何将图像处理算法进行并行化设计,以便在GPU上实现

高效处理。

CUDA优化技巧

03

了解CUDA编程中的优化技巧,如内存访问优化、线程同步等

,以提高图像处理程序的性能。

21

效果展示与性能对比

效果展示

性能分析

案例分享

将基于CUDA实现的图像处理 程序与常规CPU处理程序进行 对比,展示其在处理速度、效 果等方面的优势。

内存管理

合理利用CUDA的内存层次结构,如全局内存、 共享内存和寄存器,以提高程序性能。

优化同步

避免不必要的线程同步,减少等待时间,提高并 行计算效率。

ABCD

2024/3/26

并行化策略

设计高效的并行算法,利用CUDA的多线程并行 计算能力,加速程序运行。

错误处理

编写健壮的错误处理代码,确保程序在出现异常 时能够正确处理。

配置开发环境

在安装CUDA工具包后,需要配 置开发环境,包括设置环境变量 、添加库文件路径等。这些配置 可以确保在编译和运行CUDA程 序时能够找到正确的库和工具。

2024/3/26

选择合适的IDE

为了方便编写和调试CUDA程序 ,可以选择一个合适的集成开发 环境(IDE),如NVIDIA Nsight 、Visual Studio等。这些IDE提 供了丰富的功能和工具,可以提 高开发效率。

2024/3/26

04

使用共享内存来减少访存延迟。

05

对数据进行合理的划分和排布,以减少数据传输的开销。

06

使用CUDA提供的数学库函数(如cublas、cusparse等) 来加速计算。

GPU编程实战(基于Python和CUDA)

5.1技术要求 5.2 CUDA设备同步

5.3事件 5.4上下文

5.5小结

5.6习题

6.2在CUDA内核函 数中使用printf函

数

6.1技术要求

6.3 CUDA C编程简 介

6.4利用Nsight IDE开发和调试CUDA

C代码

6.5使用NVIDIA性能 分析工具——

nvprof与Visual Profiler

6.6小结 6.7习题

1

7.1技术要求

7.2安装

2

Scikit-CUDA

3

7.3利用 cuBLAS库处理

基本线性代数

运算

4 7.4利用cuFFT

库进行快速傅

里叶变换

5 7.5通过

Scikit-CUDA 使用cuSolver

7.6小结

7.7习题

8.2 cuRAND设备函 数库

8.1技术要求

8.3 CUDA Math API

3.1技术要求 3.2查询GPU

3.3使用PyCUDA的 gpuarray类

3.4使用PyCUDA的 ElementwiseKerne l执行逐元素运算

3.5小结

3.6习题

4.1技术要求 4.2内核函数

4.3线程、线程块与 网格

4.4线程同步与线程 通信

4.6小结

4.5并行前缀算法

4.7习题

8.5小结

8.4 CUDA Thrust 库

8.6习题

9.1技术要求

9.2人工神经元与神 经网络

9.3 softmax层的实 现

9.4交叉熵损失函数 的实现

9.5序贯网络的实现 9.6 Iris数据集

9.7小结 9.8习题

风辰的CUDA培训教程(含多款)

风辰的CUDA培训教程一、引言二、CUDA编程基础1.GPU架构在介绍CUDA编程之前,需要了解GPU的架构。

GPU由成百上千个核心组成,每个核心都可以执行相同的指令,因此GPU具有极高的并行计算能力。

CUDA编程模型允许开发者将计算任务分配给GPU 上的多个核心,从而实现高效的并行计算。

2.CUDA编程模型(1)主机(Host):指CPU及其内存,用于执行串行代码和CUDA代码的调度。

(2)设备(Device):指GPU及其内存,用于执行并行计算任务。

(3)内核(Kernel):指在设备上执行的并行函数,用于执行具体的计算任务。

(4)线程层次结构:CUDA中的线程被组织成三维的线程块(threadblock)和一维的网格(grid)。

线程块内的线程可以协作,而不同线程块之间的线程相互独立。

3.CUDA程序结构(1)主机端:分配主机和设备内存,将数据从主机传输到设备。

(2)设备端:编写内核函数,定义并行计算任务。

(3)主机端:调用内核函数,启动GPU上的并行计算。

(4)主机端:从设备内存中读取计算结果,释放主机和设备内存。

三、CUDA编程实践1.环境搭建在进行CUDA编程之前,需要搭建相应的开发环境。

具体步骤如下:(1)安装NVIDIAGPU驱动程序。

(2)安装CUDAToolkit,包含CUDA开发工具和运行时库。

(3)配置CUDA开发环境,如VisualStudio、Eclipse等。

2.编写第一个CUDA程序在本节中,我们将编写一个简单的CUDA程序,实现向量加法。

具体步骤如下:(1)在主机端分配内存,初始化输入向量。

(2)将输入向量传输到设备内存。

(3)编写向量加法的内核函数。

(4)在主机端调用内核函数,启动GPU上的并行计算。

(5)从设备内存中读取计算结果,并验证正确性。

(6)释放主机和设备内存。

3.性能优化(1)合理设置线程块大小和网格大小,以充分利用GPU资源。

(2)减少主机与设备之间的数据传输,以降低延迟。

Python基于pyCUDA实现GPU加速并行计算功能入门教程

Python基于pyCUDA实现GPU加速并⾏计算功能⼊门教程这篇⽂章主要介绍了Python基于pyCUDA实现GPU加速并⾏计算功能,结合实例形式分析了Python使⽤pyCUDA进⾏GPU加速并⾏计算的原理与相关实现操作技巧,需要的朋友可以参考下⽬录本⽂实例讲述了Python基于pyCUDA实现GPU加速并⾏计算功能。

分享给⼤家供⼤家参考,具体如下:Nvidia的CUDA 架构为我们提供了⼀种便捷的⽅式来直接操纵GPU 并进⾏编程,但是基于 C语⾔的CUDA实现较为复杂,开发周期较长。

⽽python 作为⼀门⼴泛使⽤的语⾔,具有简单易学、语法简单、开发迅速等优点。

作为第四种CUDA⽀持语⾔,相信python⼀定会在⾼性能计算上有杰出的贡献–pyCUDA。

pyCUDA特点CUDA完全的python实现编码更为灵活、迅速、⾃适应调节代码更好的鲁棒性,⾃动管理⽬标⽣命周期和错误检测包含易⽤的⼯具包,包括基于GPU的线性代数库、reduction和scan,添加了快速傅⾥叶变换包和线性代数包LAPACK完整的帮助⽂档pyCUDA的⼯作流程具体的调⽤流程如下:调⽤基本例⼦12 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20import pycuda.autoinitimport pycuda.driver as drvimport numpyfrom piler import SourceModulemod =SourceModule("""__global__ void multiply_them(float *dest, float *a, float *b) {const int i = threadIdx.x;dest[i] = a[i] * b[i];}""")multiply_them =mod.get_function("multiply_them")a =numpy.random.randn(400).astype(numpy.float32)b =numpy.random.randn(400).astype(numpy.float32) dest =numpy.zeros_like(a)multiply_them(drv.Out(dest), drv.In(a), drv.In(b),block=(400,1,1), grid=(1,1))print dest-a*b#tips: copy from hello_gpu.py in the package.具体内容设备交互Profiler Control动态编译OpenGL交互GPU数组补充内容:对于GPU 加速python还有功能包,例如处理图像的pythonGPU加速包——以及专门的GPU 加速python机器学习包——Matlab对应的⼯具包并⾏和以及和更多关于Python相关内容感兴趣的读者可查看本站专题:《》、《》、《》、《》、《》及《》希望本⽂所述对⼤家Python程序设计有所帮助。

使用GPU视频编码,比CPU快10倍,甚至更多,支持IntelGPU

使⽤GPU视频编码,⽐CPU快10倍,甚⾄更多,⽀持IntelGPU 如果您使⽤ Intel 酷睿第⼆代及之后的处理器,您可以使⽤ Intel CPU 的集成显卡(Intel® QuickSync Video H.264 编码器)进⾏视频硬件编码。

Intel 第5代及之后的处理器还可以使⽤硬件编码 HEVC (H.265) ,相⽐ H.264 ,如果⽂件⼤⼩相同 H.265 的视频质量优于 H.264,如果视频质量相同,H.265 的⽂件⼤⼩⼩于 H.264。

GPU 硬件编码可以⽐ CPU 编码快10倍,甚⾄更多。

如果使⽤ GPU 编码StaxRip 是⼀款免费的绿⾊软件⽀持 AMD,Intel 和 NVIDIA(GPU)视频编码系统要求:Windows 7 x64 及更新版本的系统(x64 版)。

.NET 4.7NVIDIA: NVENC:H.264 或 H.265 需要 GeForce 900 (Maxwell 第⼆代及之后)显卡Intel: 第⼆代-第四代酷睿系列处理器可以使⽤ QSEncC:H.264 编码,H.265 编码需要第 5 代和之后的处理器。

AMD: AMD Polaris(AMD Radeon RX 400 及之后)H.265 编码AviSynth+StaxRip 下载后解压即可使⽤,⽆需安装。

1. 解压下载的压缩包2. 打开 StaxRip ⽂件夹,双击打开“StaxRip.exe”第⼀次打开软件需要设置配置⽂件的保存⽬录,推荐保存在软件解压⽬录⾥⾯。

打开今⽇头条,查看更多图⽚StaxRip 软件主界⾯软件使⽤将要编码的⽂件拖拽到 'Source' 处,软件会识别源视频信息和分离出源视频的⾳频⽂件并保存在源⽂件⽬录的 xxx_temp ⽂件夹内。

如果系统没有安装 AviSynth+,请在软件弹出的窗⼝提⽰中点击“Install AviSynth”安装AviSynth。

Matlab编程实例视频教程系列45:深度学习(卷积神经网络)图像数据集读取输入 卷积层全连接层

freexyn编程实例视频教程系列45Matlab与深度学习(卷积神经网络)45.0 概述1.主要内容运用Matlab编程处理深度学习在图像的分类识别和回归预测方面的应用,主要内容就是学习卷积神经网络。

作者:freexyn45.1一个实例入门深度学习1 深度学习概念2 流程数据准备:训练数据,验证数据,测试数据知识准备:神经网络的概念和用法(推荐系列43)典型的深度学习神经网络:卷积神经网络3 编程演示:一个手写体识别实例入门深度学习45.2 图像数据集读取并输入网络:表table1 介绍图像数据集(看66.35)THE MNIST DATABASE of handwritten digits2 图像数据(灰度图和彩色图)在Matlab中表达方式3 数据集读取到Matlab,介绍图像集和标签集数据格式(元胞数组,分类数组),并预览图像;4 作为训练/验证数据传递给卷积神经网络的格式(table)45.3 网络分类识别并计算准确率classify1 使用已训练好的深度神经网络对图像进行分类识别;2 计算识别准确率;3 可视化预览识别结果,以及识别有误的结果。

45.4 图像输入层imageInputLayer1 图像输入层(imageInputLayer)把二维图像输入到网络2 数据归一化(四种归一化方法);'zerocenter' (default)'zscore''rescale-symmetric''rescale-zero-one''none'45.5 卷积的原理1 卷积的基本概念和运算定义2 深度网络中卷积的原理3 概念:滤波器filter、步长stride、特征图Feature Maps、填充Padding、膨胀因子DilationFactor45.6 卷积层convolution2dLayer1 卷积层属性列表介绍;2 权重参数可视化。

GPU入门技术介绍

GPU入门技术介绍GPU(Graphics Processing Unit,图形处理器)是一种专门用于处理图形和图像的微处理器。

在计算机图形学中,GPU是用于加速图形和影像处理的关键部件。

近年来,随着计算机图形学和机器学习领域的发展,GPU开始广泛应用于各种领域。

GPU最早起源于计算机游戏产业,作为一种高性能图像渲染器,GPU能够处理大量的图形数据,提供流畅的游戏体验。

随着3D游戏的迅猛发展,对于更高的图形性能需求推动着GPU的技术进步。

GPU与CPU(Central Processing Unit,中央处理器)的最大区别在于并行性。

CPU是一种通用处理器,用于执行各种任务,但是它的处理能力是基于单一线程或少量线程的。

而GPU则是专门用于并行计算的处理器,它包含大量的计算单元和大规模的并行运算架构,能够同时处理大量的任务。

由于GPU具有强大的并行计算能力,使其不仅适用于游戏图像渲染,也广泛应用于科学计算、数据分析和机器学习等领域。

在科学计算中,GPU能够加速各种计算任务,如物理模拟、天气预测、药物研发等。

在数据分析中,GPU能够加速大规模数据的处理和分析,提高效率。

在机器学习中,GPU能够加速神经网络的训练和推理过程,缩短训练时间。

为了更好地支持并行计算,GPU采用了一些特殊的技术和架构。

首先,GPU包含大量的计算单元,每个计算单元都有自己的算术逻辑单元(ALU)和寄存器文件。

这使得GPU能够同时执行多个计算任务。

其次,GPU采用了SIMD(Single Instruction, Multiple Data)架构,即一个指令可以同时处理多个数据。

这种架构非常适合于图形渲染和并行计算任务。

此外,GPU还采用了高速缓存和内存控制器等技术,以提高数据访问速度。

与GPU相关的编程模型也得到了发展。

最早的GPU编程模型是固定功能管线(Fixed Function Pipeline)模型,开发人员只能通过设置一些参数来控制图形渲染过程。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

GPU编程入门系列视频教程

VR是虚拟现实,通过构建三维动态实景,让用户真实的沉浸其中毋庸置疑,这是科技发展的全新阶段。

随着Oculus、HTC、谷歌等一线大厂多年的付出与努力,虚拟现实生态系统逐步完善,内容、软件等盈利模式也将走向成熟。

VR 产品在2016年迎来了一场大爆发。

学习VR开发GPU编程是重中之重。

GPU英文全称Graphic Processing Unit,中文翻译为“图形处理器”。

GPU是相对于CPU的一个概念。

在现代的计算机中(尤其是家用系统,游戏发烧友)图形处理变得越来越重要,因此需要一个专门的图形核心处理器。

GPU是显示卡的“心脏”,也就相当于CPU在电脑中的作用,它决定了该显卡的档次和大部分性能,同时也是2D显示卡和3D显示卡的区别依据。

2D 显示芯片在处理3D图像和特效时主要依赖CPU的处理能力,称为“软加速”。

3D显示芯片是将三维图像和特效处理功能集中在显示芯片内,也即所谓的“硬件加速”功能。

显示芯片通常是显示卡上最大的芯片(也是引脚最多的)。

现在市场上的显卡大多采用NVIDIA和ATI两家公司的图形处理芯片。

于是NVIDIA公司在1999年发布GeForce256图形处理芯片时首先提出GPU的概念。

GPU使显卡减少了对CPU的依赖,并进行部分原本CPU的工作,尤其是在3D图形处理时。

GPU所采用的核心技术有硬体T&L、立方环境材质贴图和顶点混合、纹理压缩和凹凸映射贴图、双重纹理四像素256位渲染引擎等,而硬体T&L技术可以说是GPU的标志。

目前最新的可编程图形硬件已经具备了如下功能:

1、支持vertex programmability和fragment programmability。

2、支持IEEE32位浮点运算。

3、支持4元向量,4阶矩阵计算。

4、提供分支指令,支持循环控制语句。

5、具有高带宽的内存传输能力(>27.1GB/s)。

6、支持1D、2D、3D纹理像素查询和使用,且速度极快。

7、支持绘制到纹理功能(Render to Texture,RTT)。

即使CPU的工作频率超过1GHz或更高,对它的帮助也不大,由于这是PC 本身设计造成的问题,与CPU的速度没有太大关系。

学习GPU编程的好处:

1.不单能学会如何使用GPU解决问题,更让我们更加深入地了解并行编程思想,为以后全面掌握各种并行技术打下铺垫。

2.因为计算相关知识的研究与发展,它也会成为未来IT业界与学界的热点。

想以最快的速度踏进VR圈?想拥有最系统的VR知识体系?千锋教育你不容错过!千锋最新推出VR/AR混合现实培训课程,让学员快速掌握VR开发技术。