基于协同机制的web服务器集群负载均衡技术

网站集群解决方案

(1)网络层防护:部署防火墙,防止非法访问与攻击。

(2)系统层防护:采用安全加固的操作系统,降低系统漏洞风险。

(3)应用层防护:部署Web应用防火墙(WAF),防护SQL注入、跨站脚本攻击等。

(4)定期安全审计:开展安全漏洞扫描、渗透测试等,及时发现并修复安全隐患。

五、实施步骤

1.服务器选型与采购:根据业务需求,选择合适的服务器硬件。

本方案旨在为用户提供一个高效、稳定、安全的网站集群解决方案,满足不断增长的互联网需求。在实施过程中,需遵循相关法律法规,确保合法合规。同时,根据业务发展,不断调整优化方案,提升网站集群的性能与可用性。

(2)后端服务器:选用高计算能力的服务器,部署应用服务器软件,如Tomcat、JBoss等。

(3)数据库服务器:选用高存储容量、高性能的数据库服务器,部署MySQL、Oracle等数据库。

2.负载均衡策略

采用轮询、加权轮询、最小连接数等负载均衡算法,实现用户请求的合理分发。

3.数据同步机制

(1)数据库同步:采用主从复制技术,实现数据库数据的一致性。

网站集群解决方案

第1篇

网站集群解决方案

一、背景与目的

随着互联网技术的飞速发展,单一服务器已无法满足日益增长的网站访问需求。为提高网站访问速度、数据存储能力以及系统稳定性,本项目将采用网站集群解决方案,通过多台服务器协同工作,实现资源的优化配置与高效处理。

二、方案概述

1.网站集群架构:采用分布式部署方式,将网站前端、后端及数据库分别部署在不同的服务器上,实现负载均衡与数据冗余。

7.系统测试:对整个网站集群进行性能测试、安全测试,确保系统稳定可靠。

五、后期维护

1.监控系统:部署监控系统,实时监控服务器性能、网络状况、系统负载等。

服务器集群与负载均衡-推荐优秀PPT

集群系统

二、集群技术的目的

3 提高可扩展性 用户若想扩展系统能力,不得不购买更高性能的服务器,才能获得额外 所需的CPU 和存储器。如果采用集群技术,则只需要将新的服务器加入 集群中即可,对于客户来看,服务无论从连续性还是性能上都几乎没有 变化,好像系统在不知不觉中完成了升级。 4 增强可靠性 集群技术使系统在故障发生时仍可以继续工作,将系统停运时间减到最 小。集群系统在提高系统的可靠性的同时,也大大减小了故障损失。

集群系统

三、集群系统的分类

硬件设备更稳定 2. HAProxy运行的硬件上,完全可以支持数以万计的并发连接, 同时可以保护你的web服务器不被暴露到网络上。

如果采用1集、群高技性术,能则计只算需要集将群新的(H服P务C 器C加lu入s集te群r中) 即可,对于客户来看,服务无论从连续性还是性能上都几乎没有变化,好像系

越来越高,服务器的负载也就越来越高。

——1H)AP升ro级xy提网供络高可服用务性器、负,载采均衡用以更及快基于的TCCPP和UH,TTP应用的代理,支持虚拟主机,它是免费、快速并且可靠的一种解决方案。 增加更多的内存,使其具有更强的性能;

但日益增长的服务请求又会使服务器再

次过载,需要再次升级,这样就陷入了

软件负载均 衡技术是指在服务器集群中的代理服务器上安装一个相应的负载均衡软件来实现的一种负载均衡技术。

1)基础防2、火墙高功可能用——性数集据群包过(H滤A Clu2s)t资er源)隐藏和内容安全

该技术通过对服务器进行性能优化,使流量能够平均分配在服务器群中的各个服务器上,其能有效地解决数据流量过大、网络负荷过 重的问题,并且不需花费昂贵开支购置性能卓越的服务器,充分利用现有设备,避免服务器单点故障造成数据流量的损失。

服务器负载均衡

服务器负载均衡服务器负载均衡是一种用于提高网络性能和可靠性的关键技术。

它的基本原理是将网络流量分配到多个服务器上,以均衡每台服务器的负载,从而提高整个系统的响应速度和可用性。

在本文中,我们将介绍服务器负载均衡的原理、常见的负载均衡算法以及其在企业中的应用。

一、服务器负载均衡的原理服务器负载均衡的原理是通过在网络前端引入一台或多台负载均衡设备,将外部请求分发到多个服务器上,从而均衡服务器的负载。

当一个服务器出现故障或性能下降时,负载均衡设备会自动将请求转发到其他正常运行的服务器上,保证整个系统的稳定性和可用性。

为了实现负载均衡,负载均衡设备通常会采用两种主要的分发策略:基于连接的负载均衡和基于内容的负载均衡。

基于连接的负载均衡是根据请求的源IP地址或目标IP地址进行分发,从而保证同一用户的请求始终由同一台服务器处理。

基于内容的负载均衡则是根据请求的内容特征进行匹配和分发,以实现更精确的负载均衡。

此外,服务器负载均衡还可以通过动态调整服务器的权重来实现更细粒度的负载均衡。

权重值越高的服务器将处理更多的请求,即分配更大的负载。

二、常见的负载均衡算法在服务器负载均衡中,常见的负载均衡算法包括轮询、最小连接数、源地址散列等。

1. 轮询算法轮询算法是最简单的负载均衡算法之一,它将请求依次分发给每台服务器。

当有新的请求到达时,请求将依次分配给下一台服务器,直到所有服务器都处理了同样数量的请求。

然后,这个过程重新开始,从第一台服务器开始分发。

轮询算法适用于负载均衡设备和服务器性能相似的场景。

2. 最小连接数算法最小连接数算法会优先将请求转发到当前连接数最少的服务器上。

通过实时监测服务器的连接数,并将请求发送到连接数最少的服务器,可以有效地将负载均衡到不同的服务器上,从而提高系统的整体性能和可用性。

3. 源地址散列算法源地址散列算法根据请求的源IP地址,通过散列算法计算出一个哈希值,并将请求转发到对应哈希值的服务器上。

服务器集群与负载均衡(两篇)

引言:服务器集群与负载均衡是现代网络架构中关键的组成部分。

在互联网时代,随着网络流量的不断增加和用户对稳定性要求的提高,单一服务器无法满足大规模用户的需求。

因此,通过将多台服务器连接在一起组成集群,并且通过负载均衡技术将流量均匀分配到各个服务器上,可以提高系统的可用性和性能。

正文:一、集群模式选择:1.1 单向链接模式:该模式中,多台服务器按照一定的顺序连接在一起,流量仅从第一台服务器经过,逐级传递到其他服务器。

这种模式适用于需要特定服务器处理的请求。

1.2 双向链接模式:该模式中,多台服务器之间互相连接,流量可以从任意一台服务器进入集群,并且能够灵活地在各服务器之间传递。

这种模式适用于需要多台服务器协同处理请求的情况。

二、负载均衡算法:2.1 轮询算法:按照顺序将每个请求依次分配给集群中的服务器。

优点是简单高效,适用于请求分配数量相对均匀的场景。

2.2 权重算法:根据服务器的性能、负载情况等设定不同的权重值,将请求分配给权重较高的服务器。

优点是能够根据服务器性能动态调整分配比例,适用于服务器性能差异较大的场景。

2.3 最短响应时间算法:根据每台服务器的响应时间,将请求分配给响应时间最短的服务器。

优点是能够尽可能地提高用户体验,适用于需要快速响应的场景。

三、集群管理:3.1 服务器动态扩缩容:根据系统负载情况,自动增加或减少集群中的服务器数量,以保持系统的负载均衡。

3.2 服务冗余与高可用性:通过将相同服务部署到多台服务器上,并在主服务器出现故障时自动切换到备份服务器,保证系统的高可用性。

3.3 集群监控与故障诊断:利用监控系统对集群中的服务器进行实时监控,并能够及时发现故障,并进行诊断和解决。

四、容灾备份:4.1 数据备份:将集群中的数据进行定期备份,以防止数据丢失或损坏。

4.2 容灾方案:制定有效的容灾方案,包括备份数据的恢复、故障服务器的替换等,以保证集群在面临自然灾害、硬件故障等情况下的可靠性。

负载均衡技术在Web应用中的应用方法

负载均衡技术在Web应用中的应用方法Web应用程序的流量,通常是难以预测的。

流量峰值时所需的资源远高于正常流量时所需的资源,这将导致Web应用程序出现延迟或停机。

为了解决这个问题,需要使用负载均衡技术来平衡负载并在Web应用程序的多个服务器之间分发流量。

负载均衡简介负载均衡技术的基本原则是将工作分发到多个计算机上,这些计算机作为一个整体看待,例如作为一个Web服务器集群。

负载均衡器接收客户端请求,并将请求分发到服务器集群中的一个或多个计算机上。

由于请求被均衡地分发,因此负载也被均衡地分布在服务器集群中。

Web负载均衡器通常会根据服务器的负载,以及诸如访问地址、HTTP头、用户IP地址等信息将请求分配给不同的服务器。

当某台服务器停机或负载过高时,请求将被重定向到其他服务器。

这有助于确保始终有至少一个服务器可用于响应请求。

负载均衡技术的优点负载均衡技术具有以下几个优点:1. 提高可用性:负载均衡器可以确保始终有至少一个服务器可用于响应请求。

如果负载均衡器检测到某个服务器故障,它将自动将请求转发到其他可用的服务器上。

2. 提高性能:当Web应用程序流量峰值时,对于单个服务器而言,负载变得太高,甚至可能导致停机。

负载均衡技术可以确保流量被均衡地分发到多个服务器上,从而提高整个Web应用程序的性能。

3. 扩展性:当需要扩展Web应用程序时,可以添加更多的服务器,并使用负载均衡器将流量分发到这些服务器上。

这有助于扩展Web应用程序的规模,并应对日益增长的流量。

4. 灵活性:负载均衡技术可以根据需要自动调整Web应用程序的规模。

例如,当有更多的流量到达时,负载均衡器可以自动添加更多的服务器以应对流量峰值。

同时,当流量减少时,负载均衡器可以自动删除服务器以减少成本。

Web应用程序中的负载均衡技术Web应用程序中使用的负载均衡技术通常有以下几种:1. 硬件负载均衡器:硬件负载均衡器是一种特殊的硬件设备,用于平衡流量并分发到多个Web服务器上。

服务器负载均衡方案

服务器负载均衡方案第1篇服务器负载均衡方案一、背景随着互联网的迅速发展,业务量不断攀升,服务器承受的压力越来越大。

为保障业务连续性和用户体验,提高服务器资源利用率,降低单点故障风险,有必要引入服务器负载均衡技术。

本方案旨在制定一套合法合规的服务器负载均衡方案,确保业务稳定、高效运行。

二、目标1. 提高服务器资源利用率,降低硬件投资成本。

2. 确保业务连续性,提高系统可用性。

3. 提升用户体验,降低访问延迟。

4. 合法合规,确保数据安全。

三、方案设计1. 负载均衡器选型根据业务需求,选择合适的负载均衡器。

本方案推荐使用硬件负载均衡器,如F5、深信服等品牌。

硬件负载均衡器具有高性能、高可靠性、易于管理等优点,适用于大型企业及重要业务场景。

2. 负载均衡策略(1)轮询(Round Robin)将客户端请求按顺序分配到后端服务器,适用于服务器性能相近的场景。

(2)最小连接数(Least Connections)将客户端请求分配给当前连接数最少的服务器,适用于服务器性能不均的场景。

(3)源地址哈希(Source Hash)根据客户端IP地址进行哈希计算,将请求分配到固定的服务器,适用于有状态业务场景。

(4)权重(Weight)为每台服务器分配不同的权重,根据权重比例分配请求,适用于服务器性能差异较大的场景。

3. 健康检查负载均衡器定期对后端服务器进行健康检查,确保服务器正常运行。

检查方式包括:TCP连接、HTTP请求等。

当检测到服务器故障时,自动将其从负载均衡列表中剔除,待服务器恢复正常后,重新加入负载均衡列表。

4. 会话保持为保持用户会话状态,负载均衡器支持会话保持功能。

可根据业务需求选择以下方式:(1)源地址保持:根据客户端IP地址保持会话。

(2)Cookie保持:根据客户端Cookie信息保持会话。

5. 安全防护(1)负载均衡器支持SSL加密,确保数据传输安全。

(2)负载均衡器支持防火墙功能,对非法请求进行过滤,防止恶意攻击。

基于Nginx的Web服务器负载均衡策略改进与实现

基于Nginx的Web服务器负载均衡策略改进与实现随着互联网用户数量不断增加和网站访问量的持续增长,现有的Web服务器负载均衡策略已经无法满足高并发访问的需求。

为了提高网站的性能和可用性,需要对基于Nginx的负载均衡策略进行改进和实现。

本文将分析Nginx的负载均衡机制,并提出改进策略,最后通过实际案例验证改进策略的有效性。

一、Nginx的负载均衡机制Nginx是一个高性能的HTTP和反向代理服务器,具有负载均衡功能。

Nginx的负载均衡是基于upstream模块实现的,可以通过upstream配置多个后端服务器,并按照一定的策略将请求分发到不同的后端服务器上。

目前Nginx支持的负载均衡策略主要包括轮询(round-robin)、加权轮询(weight)、IP哈希(ip_hash)、最小连接数(least_conn)等,每种策略都有其适用的场景和局限性。

轮询策略将请求依次分配给后端服务器,适用于后端服务器性能相近的情况。

加权轮询策略可以根据后端服务器的性能设置权重,适用于不同性能服务器间的负载均衡。

IP哈希策略则根据客户端IP地址对后端服务器进行哈希映射,适用于需要保持会话一致性的场景。

最小连接数策略将请求分配给当前连接数最少的后端服务器,适用于后端服务器性能差异较大的情况。

二、负载均衡策略改进针对现有的Nginx负载均衡策略,我们提出了以下改进策略:1. 动态权重调整:基于实际情况动态调整后端服务器的权重,使得服务器负载更加均衡。

在高峰时段提高性能较好的服务器的权重,避免出现性能不均衡的情况;在低谷时段降低性能较差服务器的权重,避免浪费资源。

2. 响应时间加权:根据后端服务器的响应时间对其权重进行加权,将请求分配给响应时间较短的服务器。

这样可以更好地利用服务器资源,提高网站的访问速度和性能。

3. 状态监控策略:通过监控后端服务器的状态(如连接数、CPU利用率、内存使用等),将请求分配给状态良好的服务器,避免请求发送到负载较高或故障的服务器上,提高网站的可用性。

论负载均衡技术在Web系统中的应用

论负载均衡技术在Web系统中的应用第一章项目摘要2023年,我有幸参与了某公司电子商务平台的研发项目,担任系统架构设计师一职。

该项目旨在构建一个高性能、高可用性的电子商务平台,以支撑公司日益增长的在线业务需求。

作为系统架构设计的核心成员,我主要负责平台的整体架构设计,并特别关注于通过引入负载均衡技术来提升Web系统的性能。

在项目的架构设计中,我深入研究了负载均衡技术的原理与应用,并将其巧妙地融入到平台的整体架构中。

通过精心设计的负载均衡策略,我们成功地将用户请求均匀地分配到多个服务器上,实现了服务器资源的最大化利用,同时显著提升了平台的响应速度和处理能力。

本文将以该项目为例,详细阐述负载均衡技术在Web系统中的应用及其带来的显著效益。

我将从项目概述、负载均衡算法的基本原理、负载均衡技术的具体实现以及项目成果与反思等多个方面进行深入的探讨和分析。

通过本项目的实践,我们不仅成功验证了负载均衡技术在提升Web系统性能方面的有效性,还为公司的电子商务平台打下了坚实的技术基础,为其未来的快速发展提供了有力的保障。

第二章项目背景近年来,随着电子商务的迅猛发展,公司原有的Web系统已经难以满足日益增长的业务需求。

为了应对高并发访问、提升用户体验,公司决定研发一个新的电子商务平台。

该项目旨在构建一个能够支撑大规模用户访问、具备高可用性和可扩展性的Web系统,以助力公司的业务快速发展。

在项目启动之初,我们面临着诸多挑战。

其中,如何提升Web系统的性能,确保在高并发访问下仍能保持稳定的响应速度和处理能力,是我们亟需解决的关键问题。

经过深入调研和分析,我们决定引入负载均衡技术作为提升系统性能的重要手段。

负载均衡技术通过将负载(工作任务)进行平衡、分摊到多个操作单元上执行,可以协同完成工作任务,从而达到提升Web系统性能的目的。

这一技术的引入,不仅有望解决我们面临的性能瓶颈问题,还能提高系统的可用性和可扩展性,为公司的电子商务平台打造一个坚实的技术底座。

Web服务器负载均衡定义和作用及类型

一、负载均衡的定义负载均衡是由多台服务器以对称的方式组成一个服务器集合,每台服务器都具有等价的地位,都可以单独对外提供服务而无须其他服务器的辅助。

通过某种负载分担技术,将外部发送来的请求均匀分配到对称结构中的某一台服务器上,而接收到请求的服务器独立地回应客户的请求。

二、负载均衡的作用如果你发现你的Web站点负载量非常大时,应当考虑使用负载均衡技术来将负载平均分摊到多个内部服务器上。

如果有多个服务器同时执行某一个任务时,这些服务器就构成一个集群(clustering)。

使用集群技术可以用最少的投资获得接近于大型主机的性能。

三、类型目前比较常用的负载均衡技术主要有:1. 基于DNS的负载均衡通过DNS服务中的随机名字解析来实现负载均衡,在DNS服务器中,可以为多个不同的地址配置同一个名字,而最终查询这个名字的客户机将在解析这个名字时得到其中一个地址。

因此,对于同一个名字,不同的客户机会得到不同的地址,他们也就访问不同地址上的Web服务器,从而达到负载均衡的目的。

2. 反向代理负载均衡使用代理服务器可以将请求转发给内部的Web服务器,让代理服务器将请求均匀地转发给多台内部Web服务器之一上,从而达到负载均衡的目的。

这种代理方式与普通的代理方式有所不同,标准代理方式是客户使用代理访问多个外部Web服务器,而这种代理方式是多个客户使用它访问内部Web服务器,因此也被称为反向代理模式。

Apusic负载均衡器就属于这种类型的。

3. 基于NAT的负载均衡技术网络地址转换为在内部地址和外部地址之间进行转换,以便具备内部地址的计算机能访问外部网络,而当外部网络中的计算机访问地址转换网关拥有的某一外部地址时,地址转换网关能将其转发到一个映射的内部地址上。

因此如果地址转换网关能将每个连接均匀转换为不同的内部服务器地址,此后外部网络中的计算机就各自与自己转换得到的地址上服务器进行通信,从而达到负载分担的目的。

负载均衡服务器的好处由于网民数量激增,网络访问路径过长,用户的访问质量容易受到严重影响,尤其是当用户与网站之间的链路被突如其来的流量拥塞时。

服务器负载均衡技术

HUAWEI USG6000V系列NFV防火墙技术白皮书之---服务器负载均衡技术白皮书华为技术有限公司Huawei Technologies Co., Ltd.目录1背景和概述 (2)2全局服务器负载均衡(GSLB) (3)3本地服务器负载均衡(LSLB) (4)3.1使用目的MAC地址转换的服务器负载均衡(DR) (4)3.2使用网络地址转换实现的服务器负载均衡(L4 SLB) (5)3.3使用轻量代理和网络地址转换的服务器负载均衡(L4 lwProxy SLB) (7)3.4使用全量Socket 代理的服务器负载均衡(L7 Socket Proxy SLB) (9)3.4.1socket代理加业务会话关联保持 (9)3.4.2根据URL类型不同的分担,静态资源访问和动态计算访问分开多种服务器103.4.3SSL卸载 (10)3.4.4链路优化:压缩、协议优化、本地cache、多路复用 (11)3.5业务保持技术 (13)4华为USG防火墙支持的SLB功能列表 (14)1 背景和概述随着互联网的快速发展,用户访问量的快速增长,使得单一的服务器性能已经无法满足大量用户的访问,企业开始通过部署多台服务器来解决性能的问题,由此就产生了服务器负载均衡的相关技术方案。

在实际的服务器负载均衡应用中,由于需要均衡的业务种类以及实际服务器部署场景的不同(比如是否跨地域、跨ISP数据中心等),存在多种负载均衡的技术。

如下典型的组网方式如图所示:服务提供方为了支撑大批量的用户访问,以及跨不同地域、不同接入ISP的用户都能够获得高质量的业务访问体验,其已经在不同地域、不同ISP数据中心搭建了服务器,这样就带来一个需求,也就是客户的访问能够就近、优先选择同一个ISP数据中心的服务器,从而获得高质量的业务访问体验。

同时,基于单台服务器能够提供的业务访问并发是有限的,那么就自然想到使用多台服务器来形成一个“集群”,对外展现出一个业务访问服务器,以满足大量用户访问、而且可以根据业务访问量的上升可以动态的进行业务能力扩容的需要。

基于Haproxy+Keepalived的Web集群负载均衡研究与应用

Vol.38,No.1Mar.2019第38卷第1期2019年3月《新疆师范大学学报》(自然科学版)Journal of Xinjiang Normal University(Natural Sciences Edition )基于Haproxy+Keepalived 的Web 集群负载均衡研究与应用张奎(喀什大学计算机科学与技术学院,新疆喀什844006)摘要:针对Web 集群中硬件负载均衡存在单点故障和无法获取服务器状态的情况,在深入分析负载均衡基本原理的基础上,设计一种基于Haproxy (负载均衡软件)+Keepalived (高可用软件)结构的Web 集群负载均衡实验系统。

该系统基于主/从负载调度模式,采用轮询调度算法,并对负载均衡和高可用性进行实现。

实验结果表明,该系统能够有效均衡用户的负载请求,以及调度器角色切换,解决了硬件负载均衡的缺陷,提高了Web 集群系统的综合性能。

关键词:Web 集群;负载均衡;单点故障;高可用性中图分类号:TP393文献标识码:A 文章编号:1008-9659(2019)01-0091-06随着ICT (Information Communications Technology,即信息通信技术)的快速发展,因特网产生的数据量呈“井喷”式的增长,客户端的增加和网络请求的大容量、实时性、并发性、突发性等特征,对网络服务器提出了更高的要求。

而网络服务器在运行过程中可能会出现单点故障、过载等问题,目前主要通过集群技术来解决以上问题[1-2]。

集群的核心技术之一在于负载均衡,其实现方法分为两种:硬件负载均衡和软件负载均衡。

第一,硬件负载均衡,即不断升级服务器硬件配置使其具有更高性能,满足用户需求。

但是单纯依靠硬件升级会导致网络升级复杂以及管理成本较高,这对于侧重QoS (Quality of Service,即服务质量)的网络来说,并非最佳选择;第二,软件负载均衡,即将服务器加入到集群当中,由软件来调度实现负载均衡。

负载均衡、高可用web集群介绍

2

负载均衡、高可用Web集群介绍

负载均衡、高可用性集群介绍

3

单台服务器

负载均衡及高可用web集群

“云”

负载均衡、高可用Web集群介绍

负载均衡、高可用性集群介绍

4

用户 互联网

1 负载均衡节点1

3 web节点1

2 负载均衡节点2

4 web节点2

目前比较成熟的方案不只一个(有人用mon+heartbeat+fake+coda方案,也有人用 Idirectord+heartbeal方案),HAProxy+Keepalived解决方案配置极为方便。

10

负载均衡、高可用Web集群介绍

总结

1. 负载均衡、高可用性集群 2. HAProxy 3. Keepalived 4. HAProxy+Keepalived

11

负载均衡、高可用Web集群介绍

负载均衡、高可用Web集群介绍

5

负载均衡、高可用Web集群介绍

HAProxy介绍

HAProxy是一个பைடு நூலகம்性能的TCP/HTTP负载 均衡服务器软件,速度非常快,可用性极 高。它适用于所有基于TCP或者HTTP的 应用程序,尤其适用于繁忙的Web服务。 在当今主流的服务器配置上,可以轻松地 支持几万的并发连接。

6

负载均衡、高可用Web集群介绍

7

负载均衡、高可用Web集群介绍

keepalived介绍

从Keepalived的作用就是"keep alive”,让你的系统 正常运转,永不岩机。使用Keepalived的目的,就是 检测众多Web服务器的状态;如果有一台Web服务器 出现故障,Keepalived将很快检测到并把它从系统中 剔除,待其恢复正常后,Keepalived会自动将其重新 加入到服务器群中。整个过程不需要人工干涉,你所 要做的,只是对发生故障的节点进行修复。

计算机网络中的负载均衡技术研究

计算机网络中的负载均衡技术研究随着计算机网络和互联网的快速发展,越来越多的企业和组织开始依赖于网络来提供服务。

然而,在高并发的情况下,如何保证网络的高可用性和稳定性,成为了这些企业和组织最关心的问题。

负载均衡技术就是为了解决这一问题而出现的。

本文将针对计算机网络中的负载均衡技术进行研究和探讨。

一、什么是负载均衡技术负载均衡技术是指将多台服务器共同承担同一个服务的请求,通过一定的算法来分配请求的过程。

在这个过程中,负载均衡器将请求均衡地分发到每台服务器上,从而达到服务的高可用性和稳定性。

相较于将所有请求集中到一台服务器上,负载均衡技术可以提高整个系统的性能和吞吐量。

二、负载均衡技术的分类常见的负载均衡技术可以分为软件负载均衡和硬件负载均衡两大类。

(一)软件负载均衡软件负载均衡是建立在软件层的负载均衡技术。

通过在服务器内部或者外部增加一个软件层来实现负载均衡的目的。

一般来说,软件负载均衡器可以运行在一台或多台服务器上。

常见的软件负载均衡器有:Nginx、Apache、HAProxy等。

软件负载均衡器的优点在于灵活性较高,可以根据需要动态扩容和缩容。

而且,对于小型和中型企业来说,软件负载均衡器的成本相对较低。

(二)硬件负载均衡硬件负载均衡是建立在硬件层的负载均衡技术。

通过在网络中添加专用的负载均衡设备(Load Balancer),来实现负载均衡的目的。

硬件负载均衡器一般集成了负载均衡算法、数据缓存、安全防护等功能。

与软件负载均衡器相比,硬件负载均衡器更加稳定和可靠。

但是,硬件负载均衡器的价格比较高,对于中小型企业来说并不易于承受。

三、负载均衡技术的算法负载均衡技术的算法决定了请求分配的权重和方式。

常见的负载均衡算法包括:轮询算法、IP哈希算法、最少连接算法、加权轮询算法等。

下面将对它们进行详细介绍。

(一)轮询算法轮询算法是负载均衡技术中最简单、最基础的一种算法。

它是一种均分请求的算法,即请求按照固定的顺序分配到不同的服务器上。

如何实现服务器的负载均衡

如何实现服务器的负载均衡服务器负载均衡是指在高访问量的情况下,将网络请求均匀地分配到多个服务器上,以提高系统的可用性、稳定性和性能。

本文将介绍如何实现服务器的负载均衡,包括硬件负载均衡和软件负载均衡两个方面。

一、硬件负载均衡硬件负载均衡是通过专门的负载均衡设备来实现的,这些设备通常被称为负载均衡器或负载均衡交换机。

硬件负载均衡器可以根据预设的负载均衡算法将网络请求分发到后端多个服务器上。

1. 服务器集群首先,需要配置一个服务器集群,该集群由多台服务器组成,每台服务器都装有相同的系统和应用程序,并且能够提供相同的服务。

服务器集群的规模可以根据实际需求进行扩展。

2. 负载均衡器配置将负载均衡器安装在服务器集群之前,配置其网络接口和IP地址。

然后,通过负载均衡器的管理界面,添加服务器集群的成员,并为每个成员分配权重,用于控制负载均衡器将请求发送到每个成员的比例。

3. 负载均衡算法负载均衡器使用的算法决定了将请求分发到服务器集群中的哪个成员。

常用的负载均衡算法包括轮询、最小连接数和源IP Hash等。

轮询算法会依次将请求分发到每个成员上,最小连接数算法会将请求分发到当前连接数最少的成员上,源IP Hash算法会根据客户端的IP地址将请求分发到相同服务器上。

4. 健康检查健康检查是负载均衡器保证服务器集群可用性的重要机制。

负载均衡器会定期发送请求到服务器成员,并根据响应状态判断服务器是否正常工作。

如果某个服务器无法响应或响应较慢,负载均衡器会将该服务器从集群中暂时移除,待其恢复正常后再加入集群。

二、软件负载均衡软件负载均衡是借助软件来实现服务器负载均衡的方法,其中最常见的方式是使用反向代理服务器来分发网络请求。

1. 反向代理服务器反向代理服务器是位于客户端与服务器之间的一个中间层,客户端的请求首先到达反向代理服务器,然后由代理服务器将请求转发到后端的服务器上。

客户端并不知道实际提供服务的后端服务器,而是与反向代理服务器进行通信。

基于协同机制的Web服务器集群负载均衡技术

0 引 言

随着 It nt 务 规 模 的 不 断 增 加 , 多 网站 的 w 、 , ne e服 r 许 ^ 服 务 器 经 常 面 临超 载 的 问题 , 高 We 提 b服 务 器 性 能 的 传 统 方 法

1 基 于分 配 器 的 We 务 器 集 群 的 结 构原 理 b服

维普资讯

第2卷 7

VO . 7 12

第 1 4期

N O. 4 1

计 算 机 工程 与 设 计

Co u e gn eiga dDe in mp tr En ie r n sg n

20 年 7 06 月

J y 0 ul 2 06

基于协同机制的 We 服务器集群负载均衡技术 b

c u t r o s a et e c so r’ e u s h b i g t e , wh c e dt e o v ep o lmso eb r e q i b u a n e l se h u t me s r q e t o t ewe s et eh r t r h t t o ih n e r s l et r b e f u d n e u l r m mo g t o h h t ii h

sres (a e a aa c) T ecmmo a a c r et f b e e ay e,t igo -n u br s h frn e f e r n l l db l e. h o v m yo n n o d l e o co we r rs l d a n nl e m e e eeec l ba pj n sv ia z n k i n at r o

同 工 作 机 制 , 实现 We 务 器 的 负 载 均 衡 。 以 b服 关键 词 : 负载 均 衡 ; We 务 器 集 群 ; 协 同 工 作 ;Ap lai b服 pi t n对 象 ; 在 线 量 c o

websocket集群解决方案

websocket集群解决方案WebSocket集群解决方案。

随着互联网的快速发展,实时通讯和数据交互需求日益增加,而传统的HTTP 协议在这方面显得力不从心。

WebSocket作为一种全双工通讯协议,可以在客户端和服务器之间建立持久的连接,实现实时通讯和数据传输,成为了众多互联网应用的首选方案。

然而,随着用户量的增加和业务的扩展,单一WebSocket服务器已经无法满足需求,因此需要构建WebSocket集群来解决这一问题。

WebSocket集群的搭建可以有效地提高系统的并发处理能力和稳定性,保证用户的实时通讯和数据传输体验。

在构建WebSocket集群时,需要考虑以下几个方面:1. 负载均衡。

负载均衡是构建WebSocket集群的关键。

通过负载均衡,可以将用户的连接请求分发到不同的WebSocket服务器上,避免单一服务器负载过重,提高系统的并发处理能力。

常见的负载均衡算法包括轮询、最小连接数和最小响应时间等,可以根据实际需求选择合适的算法。

2. 连接复用。

在WebSocket集群中,连接复用可以减少服务器和客户端之间的连接建立和断开次数,提高系统的性能和效率。

通过连接复用,可以在客户端和服务器之间建立持久的连接,减少握手和关闭的开销,提高数据传输的速度和稳定性。

3. 会话同步。

在WebSocket集群中,会话同步可以保证用户的连接状态和数据一致性。

通过会话同步,可以将用户的会话信息和数据同步到所有的WebSocket服务器上,避免用户在不同服务器之间切换时出现数据丢失或不一致的情况,提高系统的稳定性和可靠性。

4. 异地多活。

在构建WebSocket集群时,需要考虑异地多活的需求。

通过异地多活,可以在不同地域部署WebSocket服务器,提高系统的容灾能力和可用性。

当某个地域发生故障时,可以自动切换到其他地域,保证用户的实时通讯和数据传输不受影响。

5. 监控和调度。

在WebSocket集群中,监控和调度是非常重要的。

网络中的链路聚合与负载均衡

网络中的链路聚合与负载均衡随着互联网的迅猛发展,网络通信负载越来越大,传统的网络架构已经不能满足现代应用的需求。

为了提高网络的带宽利用率和可靠性,网络中的链路聚合与负载均衡技术应运而生。

本文将以网络中的链路聚合与负载均衡为题,探讨其背后的原理、应用以及未来的发展前景。

一、链路聚合技术链路聚合技术,又称为端口聚合技术(Port Aggregation),是指将多个物理链路(如以太网链路)捆绑成一个逻辑链路的过程,通过增加带宽来提高网络的传输能力。

链路聚合的实现方式有许多种,常见的有静态链路聚合和动态链路聚合。

静态链路聚合是在网络设备配置时就预先设定好链路聚合的组成方式和参数,通常使用静态配置的方式进行链路的绑定。

这种方式的优点是简单易行,但灵活性较差,无法自动适应网络状况的变化。

动态链路聚合使用动态协议来实现链路的自动聚合和解聚,网络设备通过协议进行链路状态的交换,以确定最佳的链路组合方式。

相对于静态链路聚合,动态链路聚合具有更高的灵活性和自适应能力。

二、负载均衡技术负载均衡技术是指将网络流量在多个网络链路或服务器之间均匀分配,以提高整个网络的性能和可靠性。

负载均衡可以分为多种形式,包括基于链路层的负载均衡、基于网络层的负载均衡和基于应用层的负载均衡。

基于链路层的负载均衡是在数据链路层对数据进行划分和分发,用于将数据均匀地发送到多个链路上。

这种负载均衡方式通常需要交换机等链路层设备的支持,有效地利用了网络带宽。

基于网络层的负载均衡是在网络层对数据进行划分和分发,用于将数据均匀地发送到多个服务器上。

这种负载均衡方式通常需要路由器等网络层设备的支持,能够实现对整个网络流量的均衡分发。

基于应用层的负载均衡是在应用层对数据进行划分和分发,用于将请求均匀地发送到多个服务器上。

这种负载均衡方式通常需要负载均衡器等应用层设备的支持,能够实现对特定应用的负载均衡。

三、链路聚合与负载均衡的应用链路聚合与负载均衡技术在互联网中具有广泛的应用。

websphere 集群与负载均衡

Websphere集群与负载均衡1.配置集群说明:日常使用中为了保证websphere系统可用性,提高系统性能,一般处理方法为配置集群,本文将记录我创建、配置集群的整个过程1)集群系统架构操作系统: linux as4Websphere版本 was6.12)系统整体架构为了保证高可用性环境,一般使用如下拓扑:本例中的部署如下所示:Dm 和一个应用安装在主机itatmp3(22.5.232.195),一个应用单独安装主机名为itatmp4(22.5.232.196),组成一个集群,然后通过一个IHS 来完成负载均衡,HIS也安装在主机itatmp3 (22.5.232.195)上注意:自己在配置请用根据自己的情况用自己的主机名与IP替换上面红色的部分3)检查程序包及其版本有两个程序。

C88STML.tar.gz为application server与Deployment manager的安装包C88T0ML_WAS61ND_Supplements_Linux32B.tar.gz 包有IBM http Server与插件的安装程序4)安装集群(1)以下安装在itatmp3(22.5.232.195)主机上安装:获得的WEBSPHERE 的安装包可能为C88STML.tar.gz先将其解压。

解压缩后的文件运行./launchpad.sh。

launchpad.sh启动安装界面注意: 假如没有window-x. 就安装一个Xmanager软件安装界面如下:首先安装:安装后会启动向导,提示接受协议等,并选择安装路径。

选择默认路径后,进行安装,安装时会提示创建的类型注意,此处选择 None 。

稍后我们会单独创建概要文件。

直到安装完成。

(3)安装完成后,我们开始创建概要文件。

概要文件是WEBSPHERE的重要概念,相当于一个独立的配置文件,每个应用都必须有一个单独的概要文件。

创建概要文件的方法:因为我们是默认安装,所以我们此处给出路径:/opt/IBM/WebSphere/AppServer执行以下命令创建概要文件/opt/IBM/WebSphere/AppServer/bin/ProfileManagement/pmt.sh会弹出以下界面:接着选择创建概要文件的类型。

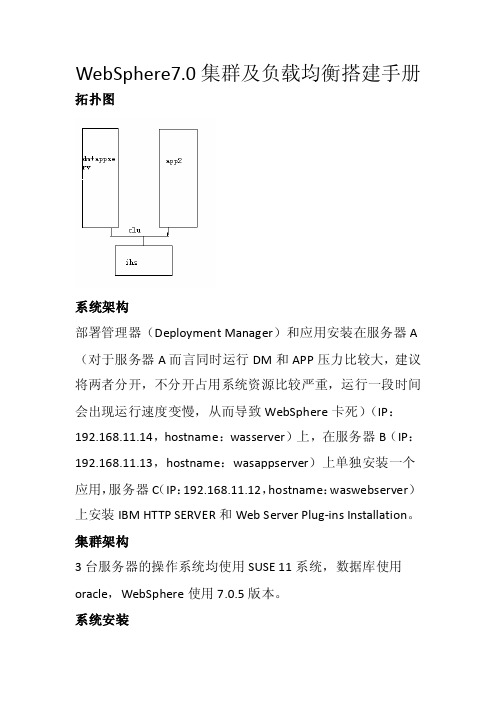

WebSphere7.0集群及负载均衡搭建手册

WebSphere7.0集群及负载均衡搭建手册拓扑图系统架构部署管理器(Deployment Manager)和应用安装在服务器A (对于服务器A而言同时运行DM和APP压力比较大,建议将两者分开,不分开占用系统资源比较严重,运行一段时间会出现运行速度变慢,从而导致WebSphere卡死)(IP:192.168.11.14,hostname:wasserver)上,在服务器B(IP:192.168.11.13,hostname:wasappserver)上单独安装一个应用,服务器C(IP:192.168.11.12,hostname:waswebserver)上安装IBM HTTP SERVER和Web Server Plug-ins Installation。

集群架构3台服务器的操作系统均使用SUSE 11系统,数据库使用oracle,WebSphere使用7.0.5版本。

系统安装将WebSphere安装包上传至所有服务器上,将安装包解压,使用命令tar –zxf file.tar.gz,安装之前编辑/etc/hosts文件将3台服务器的主机名及ip添加上,并且将3台服务器的主机名更改成不一致的,以免在安装后出现无法自动创建概要文件的故障,在服务器A上运行launchpad.sh,使用./launchpad.sh 运行(/与l之间无空格),运行后将出现上图界面,在左侧选择WebSphere Application Server Installation选择Launch the installation wizard for the WebSphere Application Server Network Deploment,选择完后会弹出界面,点击next,之后出现下图选择第一项,点击next点击next将出现下图将后2项打钩之后点击next选择安装路径,点击next选择Management,点击next按照默认所选直接next开启安全管理选项,输入用户名及密码,点击next选择Create a repository for Centralized Installation Managers 点击next,等待一会后将出现图中的检查是否有安装权限的选项,使用root用户安装的可以不选,但是使用其他用户安装的建议选择,这样可以避免不必要的麻烦,点击next选择next后,将开始进行安装,安装完成后出现则表示成功,如果提示success但是没有创建概要文件则到/opt/IBM/WebSphere/AppServer/bin/ProfileManagement目录下运行pmt.sh进行创建概要文件如图点击create…点击next保持默认,点击next保持默认点击next输入用户名及密码点击next确认Cell name,Nodename,Host name是否正确,点击create 进行概要文件的创建,创建成功后,查看PMT创建的概要文件是否已经存在点击create选择Application server点击next保持默认点击next同样Application server也建议开启安全管理选项,输入用户名、密码点击next确认信息无误后,点击create进行创建出现如上信息表示已经成功,点击finish,创建完成启动服务可以使用first steps(/opt/IBM/WebSphere/AppServer/firststeps目录下运行firststeps.sh)也可以使用命令(/opt/IBM/WebSphere/AppServer/profiles/Dmgr01/bin目录下运行startManager.sh及/opt/IBM/WebSphere/AppServer/profiles/AppSrv01/bin目下运行startServer.sh,命令./startServer.sh server1)进行启动。

基于Web服务的协同制造控制方法及控制系统

基于Web服务的协同制造控制方法及控制系统随着信息技术的不断发展和普及,协同制造成为现代制造业的核心竞争力之一。

而基于Web服务的协同制造控制方法及控制系统正是为了实现制造过程中的信息共享和协同决策而提出的一种新型的控制方法和系统。

本文将对基于Web服务的协同制造控制方法及控制系统进行详细的介绍和分析。

一、基于Web服务的协同制造控制方法基于Web服务的协同制造控制方法主要包括以下几个方面的内容:1.1 Web服务技术Web服务是一种通过互联网进行信息交互和数据传输的技术,它基于标准的HTTP协议和XML语言,具有跨平台、跨语言、易于集成等优点。

在协同制造中,Web服务可以用于不同制造环节之间的信息传递和数据共享,从而实现协同制造过程中的数据集成和流程协同。

1.2 协同制造控制方法基于Web服务的协同制造控制方法主要包括四个方面的内容:任务分配、资源调度、工艺规划和质量控制。

任务分配是指根据任务的特点和要求,将任务分配给合适的人员和设备进行执行。

资源调度是指根据任务的紧急程度和资源的可用性,合理调度和安排生产资源的使用。

工艺规划是指根据生产任务和工艺要求,合理安排生产工艺和操作步骤。

质量控制是指通过监控和检测等手段,确保产品在生产过程中达到预期的质量要求。

1.3 Web服务的应用基于Web服务的协同制造控制方法可以应用于不同的制造环节和领域,如生产计划、物流管理、供应链管理等。

通过应用Web服务技术,可以实现不同制造环节之间的信息共享和协同决策,提高生产效率和产品质量。

二、基于Web服务的协同制造控制系统基于Web服务的协同制造控制系统是将Web服务技术应用于协同制造控制中的一种实现方式,主要包括系统架构、功能模块和实现方法。

2.1 系统架构基于Web服务的协同制造控制系统的架构包括客户端、服务器和数据库三个层次。

客户端负责与用户进行交互,接收用户的指令并将其发送给服务器;服务器负责处理用户的请求,并将结果返回给客户端;数据库用于存储和管理制造过程中产生的数据和信息。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

StrConn.Provider="sqloledb"

0引 言

随着 Internet 服务规模的 不断增加,许多网站的 WWW 服 务 器经常面临 超载的问题 ,提高 Web 服务 器性能的传 统方法 有 两种:一种是 升级单机系 统,这种做法 简单易行,但 由于业 务 的发展和多 种随机事件 的发生,准确预 测网站的访 问量几 乎 是不可能的 ;另外,被替换 下来的机器 很可能被闲 置,造成 资 源和资金的 浪费[1];而另一种 就是采用 服务器镜像 方式,在 网 页上列出多 个镜像站点 的链接让用 户自己选 择,无 须改动 Web 服务器或浏 览器,但用户的 盲目性请 求也可能因 发送往 某 个已满负荷 运行或发生 故障的镜像 站点而得 不到服务 。 [2] 目前比较流行的方案是采用 Web 服务器集群技术[3],即将多台 服务器用局域网联结成一个局域集群(也有称其为“并行服务 器 集群”),或由多个 局域集群在 地理上广 域分布形成 的广域 集 群。服务器 集群方案相 对成本更低 、灵活 性更大、可靠性 也更高。

本文提出 了一种以 网站在线量 为负载参考 ,将多 台 Web 服务器构成一个集群,各服务器之间随时沟通本机负载能力、 当 前负荷状况 以及本机可 用状态等信 息,彼此间既有 主次之 分,又有相互配合,形成一种协同工作的机 制以实现 Web 服务

器的负载均衡。

1 基于分配器的 Web 服务器集群的结构原理

基于分配 器的 Web 服务器集 群可以分 为两种类型(如图 1 所示),一种是以 Cisco 的 LocalDirector [2] 为代 表的隔离 式结 构,采用最少 连接法或最 快连接法 进行请求分 配;另一 种以 NCSA 的 Scalable Web Server[5]为代表 的非隔离 式结构,采 用转 轮法 进行请求 分配。这两种 结构的所有 服务器上 的 Web 信息 的访 问路径和 内容都必须 完全一致,从而对外 部访问来 看就 好像 是同一台 服务器一样 。二者的 区别在于这 些服务器 是否 直接 连接在 Internet 上 ,对用户可 见。隔离式 集群采用 类似 Proxy[6]的技术,只有请 求分配器具有一个虚 拟的 IP 地址 ,应答 结果 经由分配 器传给用户 ;非隔离 式集群中的 每一台服 务器 都具 有独立的 IP 地 址,请求分 配是通过动 态 DNS[5]、HTTP Redirect[4]等技术实现的,服务器的应答结果不经分配器而直接传 给用户。

StrConn.Open "database=web_load;server=;uid=;pwd= "

%> (2)负载均 衡判断与 服务器选择 文件 default.asp: 该文件分 别存于各服 务器中,但数据库联 接文件(OpenBase.asp)不 同,此处省 略。

Abstract:In order to satisfy a great deal of internet interview and the better QoS guarantees, the general project will set up a web server cluster to share the customers' request to the website together, which need to resolve the problems of the burden equilibrium among the servers (namely load balance). The common load balance project of web server is analyzed, taking on-line number as the reference of server's load, taking into account the load ability of the different function web servers at the same time, a kind of cooperative work mechanism among the servers is built to fulfill the balance of web server cluster. Key words:load balancing;web server clustering;cooperative work;application object;on-line quantity

链接#i Server 具体内容页

N 错误链接说明 (e rror_info .h tm)

说明: 1. 括号内为完成对应功能的

具体文件 (文件具体脚本见 下文分析); 2. 标号对应图 2 对象间的执行 关系; 3. 1≤i≤n 。

图 3 Web 服务器集群工作流程

因特网用 户(如图 2 所 示)首次链 接本网站 ,经 DNS 解析 后即 指向#1 主服务器 ,但用户也可 能通过代理 服务器或 历史 记录 直接链接 非主 Web 服 务器(图 2 中 的 Internet 虚线连接), 但首 先链接的 都是对应服 务器上的初 始主页 default.asp,然后 按照 图 3 所示流 程依次执行 ,直到进入 相应的集群 服务器。

Y

a. ②传递 ID Session 值 (default.asp) b. ②重定向#i Server (default.asp)

经 default.asp 提交 i nde x.asp Y

a. ③#i Server 主页 (index.asp) b. ③#i Server 在线数加 1 (index.asp)

Load balance technology of web server cluster based on cooperative work mechanism

YU Guo-fang, WANG Yao-cai (College of Information and Electronic Engineering , China University of Mining and Technology, Xuzhou 221008, China)

然后创建 用于存储 Web 服务 器基本信 息的数据库 ,该数 据 库既可与主 服务器共用 一个系统,也可单独 设置一台 专用 Database Server,本文示例以第 1 种方式 构建,并选用微软公司 的 SQL Server,创建 的名为 web_load 的数据库 ,在此库中 建立 名 为 server_LoadInfo 的 数据表,表 结构如表 1 所示。

2 基于协同机制的 Web 服务器集群的结构 与工作原理

目前的许 多 Web 服 务器都具有 记录在线 访问量的功 能,

收稿日期:2005-05-12。 作者简介:于国防 (1965-),男,山东高青人,博士,副教授,研究方向为因特网 QoS 技术、计算机网络与通讯、多媒体计算机技术; 王耀才 (1938-),男,黑龙江青岗人,教授,博士生导师,研究方向为工业控制自动化、信息集成、计算机网络。

字段名称 serverID serverLink serverLoad serverState

表 1 服务器信息表

字段类型 smallint smallint smallint

bit

备注 服务器编号 当前在线数量 允许最大在线数量(因服务器性能而异) 服务器状态(正常运行/故障或维修停用)

由于该表 实际存储 的记录数少(等于集群 中的服务 器台 数),且实际 运行中会比 较多地进行 数据的更新 操作,所 以该

Web 服务 器集群结构 如图 2 所示。

Internet

LAN/WAN #1 WWW ① 服务器

#2 WWW ① 服务器

服务器信息表 ABC

③③ ③ ②

②ቤተ መጻሕፍቲ ባይዱ

#n WWW ① 服务器

②

图 2 基于协同机制的 Web 服务器集群的组成结构

构建服务 器集群,即设置 多台 Web 服务器,依次编 号为 1,2,…,n,并规定 1 号(在图中用#1 表示,其它服务器标识同此) 为主服务器,这些服务器可 以分布于局域网中,也可以分布于 广 域网中,每 台服务器具 有各自独立 的 IP 地址 ,但是,所 申请 的 域名仅指向 主服务器(#1 服务 器)。

第 27 卷 第 14 期 Vol. 27 No. 14

计算机工程与设计

Computer Engineering and Design

2006 年 7 月 July 2006

基于协同机制的 Web 服务器集群负载均衡技术

于国防, 王耀才 (中国矿业大学 信电学院, 江苏 徐州 221008)

摘 要 :网 站 为了 满足 因特 网 的大 量访 问以 及 更好 的 QoS 保障 ,目前 通用 的方 案 是多 台 Web 服 务 器构 成一 个集 群 ,共 同分 担 用 户对 站点 的 请求 负荷 ,这 就 需要 解决 负荷 在 各服 务器 之间 的 平衡(即 负载 均 衡)问题 。简要 分析 当前 常 用的 Web 服 务器 集 群 负载 均衡 方 案,提出 了以 在 线量 为负 载参 考 点,同时 兼顾 不 同性 能 Web 服务 器 的负 载能 力,建 立一 种集 群服 务 器之 间的 协 同 工作 机制 ,以实 现 Web 服务 器的 负 载均 衡。 关 键词 :负 载 均衡 ; Web 服务 器集 群; 协同 工作 ; Application 对象 ; 在线 量 中 图法 分类 号 :TP393.4 文献 标识 码 :A 文章 编 号:1000-7024 (2006) 14-2650-03