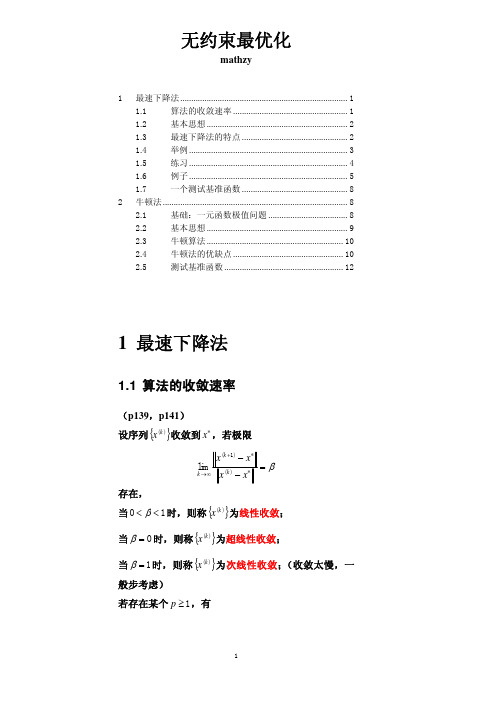

最佳最速下降法

最优化方法第二章_线搜索算法_最速下降法

f x1 , x2 c, c>0,

2

改写为:

x12 2c 1

2 x2

2c 2

2

1

二、最速下降法

x2

这是以

2c

1

和

2c

2

为半轴的椭圆

2c

2c

2

2

从下面的分析可见 两个特征值的相对

x1

大小决定最速下降法的收敛性。

(1)当 1 2 时,等值线变为圆

2 2

4 f x , 2

2 x1 2 x2 4 f ( x) , 2 x1 +4x2

4 d = f x , 2

0 0

=40 2 20 3 令 0= ' ( ) 80 20, 得 0 =1/4,

一

一维搜索

二 三 四

下 降 算 法

五

最速下降法 Newton法 共轭梯度法

多尺度法 (拟Newton法)

二、最速下降法 假设 f 连续可微,取 线搜索方向

k

d f ( x )

k

步长k 由精确一维搜索得到。 从而得到第 k+1次迭代点,即

f ( x k k d k ) min f ( x k d k )

(推论)在收敛定理的假设下,若f (x)为凸函数,则最速下降 法或在有限迭代步后达到最小点;或得到点列 x k ,它的任 何聚点都是 f (x)的全局最小点。

二、最速下降法

最速下降法特征:相邻两次迭代的方向互相垂直。

令

( ) f ( x d ), 利用精确一维搜索,可得

最速下降法

最速下降法姓名:沈东东 班级:研1404 学号:1415033005一、最速下降法的原理目标函数:(1)n f R R n →>在决策变量的当前点()k n x R ∈处的一阶Taylor 展开式为()()()()()()()k k k T f x f x g x δδοδ+=++式中,()()k n g x R ∈为f 在点()k x 处的梯度向量。

当扰动量n R δ∈充分小时,有()()()()()()k k k T f x f x g x δδ+≈+设新的迭代点为(1)()k k x x δ+=+,于是得到(1)()()()()()k k k T f x f x g x δ+-≈为了使(1)k x +处的目标函数值比()k x 处有所下降,需要满足()()0k T g x δ<此外,梯度向量()()k g x 和扰动量δ的内积可以表示为()()()()cos k T k g x g x δδθ=式中,θ为两向量之间的夹角。

若要使目标函数值的下降量尽可能大,可知δ的方向应该为梯度方向的负方向,即cos 1θ=-。

函数f 在点()k x 处的负梯度方向称为该点的最速下降方向。

在每次迭代时都取最速下降方向作为搜索方向的方法就称为最速下降法。

二、最速下降法的特点1.若()k x 不是极小点,则f 在点()k x 处的最速下降方向总是下降方向。

2.如果每次迭代时都用精确搜索方法得到最佳步长作为搜索步长,则寻优过程中相邻的最速下降方向是正交的。

3最速下降法产生的迭代点序列在一定条件下是线性收敛的,其收敛性质与极小点*x 处的Hesse 矩阵有关。

三、最速下降法的计算步骤最速下降法的计算步骤如下:步骤1:已知待求问题的目标函数()f x ,选择初始点(0)x ,并设定精度要求tol ,令:0k =。

步骤2:计算()f x 在点()k x 处的梯度向量()()k g x ,得到最速下降方向()()()k k d g x =-。

最速下降法原理及例题实例

Xk (0.00,3.00)T (2.70,1.51)T (2.52,1.20)T (2.43,1.25)T (2.37,1.16)T (2.33,1.18)T (2.30,1.14)T (2.28,1.15)T

f (X k ) 52.00

0.34 0.09

∇f ( X k ) (−44, 24)T (0.73,1.28)T (0.80, −0.48)T (0.18, 0.28)T (0.30, −0.20)T (0.08, 0.12)T (0.15, −0.08)T (0.0算目标函数的梯度和 Hesse 阵

设d

(k )

= [ d1 , d 2 ] , ∇f ( X ( k ) ) = [ g1 , g 2 ] 得到精确一维搜索步长 αk = g1d1 + g 2 d 2 3d + d 2 2 − 2d1d 2

2 1

取X

(1)

= (0, 0)T ,则 ∇f ( X (1) ) = [ −2, 0] ,所以 d (1) = −∇f ( X (1) ) = [ 2, 0 ] ,

求单变量极小化问题:

min f ( x 0 + tp 0 ) = min f (44t , 3 − 24t )

t ≥0 t ≥0

= min(44t − 2)4 + (92t − 6)2

t ≥0

的最优解 t 0 ,由 0.618 法可得 t 0 = 0.06 ,于是

X 1 = x 0 + t 0 p 0 = (2.70,1.51)T ∇f ( X 1 ) = (0.73,1.28)T ∇f ( X 1 ) = 1.47 > ε

10 −2 ,停止计算,所以 X (9) = [ 0.988, 0.988] 作为问题的最优解。

最优化之最速下降法PPT课件

那么目标函数 f(x)在Xk处沿方向dk下降的变化率为

5

最速下降法的方向选择

LLOOGGOO

lim lim fxkdkfxk gkTdk

0Leabharlann 0gkTdkgk dk cos

其中 为gk与dk的夹角。要使得变化率最小,只有当cos值为-1 时,才能达到,也即dk应取得负梯度方向。

J (a)

J (a)

11

开始

给定初始点, x 0 E n , 0

程序图

LOGO

求 k 使其满足

m i0 nf(xkpk)f(xkkpk)

k : 0

计算 pk f (xk)

令

xk1xk kpk

是

pk

否

输出: xmin x k

结束

12

matlab仿真实例

LOGO

13

matlab仿真实例

LOGO

14

最速下降法的优缺点

LOGO

• 由于沿负梯度方向目标函数的最速下降性,很容易使人们误认为负梯 度方向是最理想的搜索方向,最速下降法是一种理想的极小化方法。 必须指出的是,某点的负梯度方向,通常只是在该点附近才具有这种 最速下降的性质。在一般情况下,当用最速下降法寻找极小点时,其 搜索路径呈直角锯齿状,在开头几步,目标函数下降较快;但在接近 极小点时,收敛速度长久不理想了。特别适当目标函数的等值线为比 较扁平的椭圆时,收敛就更慢了。优点是:程序简单,计算量小;并 且对初始点没有特别的要求。

7

•由式 dkf xk得,

LOGO

fx k 1T fx k0

即新点xk+1处的梯度是正交的,也就是说,迭代点列所走

的路线是锯齿型的,故收敛速度是很慢的。

最速下降法原理及例题实例

−1 1

=

G

αk

=

g1d1 + g2d2 3d12 + d22 − 2d1d2

[ ] [ ] 取 X (1) = (0, 0)T ,则 ∇f ( X (1) ) = −2, 0 T ,所以 d (1) = −∇f ( X (1) ) = 2, 0 T ,

因此

α1

=

22 3× 22

=

1 3

[ ] [ ] X (2) = X (1) + α1d (1) =

=

1 + 4x1 + 2x2 −1+ 2x1 + 2x2

∂(x2 )

∇f

(X

(1) )

=

1 −1

令搜索方向 d (1)

=

−∇f

(X

(1) )

=

−1 1

再从

X

(1) 出发,沿

d (1) 方向作一维寻优,令

步长变量为 λ

,最优步长为 λ1 ,则有

X

(1)

+

λd (1)

=

0 0

+

λ

−1 1

min f ( X ) = (x1 − 2)4 + (x1 − 2x2 )2

其中 X = (x1, x2 )T ,要求选取初始点 X 0 = (0, 3)T ,终止误差 ε = 0.1.

解:因

∇f ( X ) = [4(x1 − 2)3 + 2(x1 − 2x2 ), −4(x1 − 2x2 )]T

∇f (x∗ ) = 0源自(二)最速下降法的基本思想和迭代步骤

最速下降法又称为梯度法,是 1847 年由著名数学家 Cauchy 给出的。他是解析法中最古老的一 种,其他解析方法或是它的变形,或是受它的启发而得到的,因此它是最优化方法的基础。

最速下降法

随着人工智能、模糊控制、模式识别、人工网络等新技术的应用和发展。

可以让它们与广义预测控制相结合,建立高精度、多模态的预测模型。

使广义预测控制在异常情况下可以稳定运行,推进广义预测控制的进一步发展。

2.2.1最速下降法最速下降法是无约束最优化中是比较有效的方法,它是以d}=一可(x})作为下降方向的算法。

其迭代格式为xx+i=xx一。

*Of (xk)上式中,一般通过精确线搜索准则求得步长因子。

*,当然也不排除可以利用非精确线搜索准则来求得步长因子。

*。

不管最速下降法采取何种线搜索准则,它均具有全局收敛性,但是这也不能直接就认为最速下降算法就是一个良好的优化算法。

在实际试验中,有很多优化问题利用最速下降法并不是下降的特快,反而下将的十分缓慢。

这是因为出现了锯齿现象:就是在计算过程中,最速下降法开始几步还是挺快的,但是当目标函数f (x)的等高线接近于一个球的时候,就出现了类似锯齿现象,前进十分缓慢,降低了算法的效能。

2.2.12.2.2牛顿法牛顿法也是无约束最优化问题中的一种经典算法,它是利用目标函数.f (x)的二次泰勒展开式,并将二次泰勒展开式进行极小化。

其迭代格式为x}+}=xA十d}(2-5)其中步长因子。

、=l} d、为02f (x} )d + Of (xA ) = 0的解。

当目标函数f(x)是正定二次函数的时候,牛顿法可以一步达到最优解;当目标函数f (x)是非二次函数的时候,牛顿法经过有限次迭代之后就不能确保求得目标函数f (x)的最优解。

我们知道目标函数f (x)在极小点附近是很接近于二次函数的,所以,假如初始点非常靠近无约束最优化问题((1-1)的最优解x的时候,并且}Z.f (x.)正定的时候,那么牛顿法就会有很快的收敛速度,而由此算法产生的点列也具有了超线性收敛速度,同时还在一定条件下具有二次收敛性;假如初始点与无约束最优化问题(1-1)的最优解x’相距比较远的时候,这时的}Z.}(x})就不一定是正定的了,也就存在了一个问题,那就是此时的牛顿方向就不一定是下降方向,有可能是上升方向,此时由此算法产生的点列可能也就不收敛于无约束最优化问题((1-1)的最优解了。

机器学习算法系列最速下降法牛顿法拟牛顿法

机器学习算法系列最速下降法牛顿法拟牛顿法最速下降法(Gradient Descent)最速下降法是一种常用的优化算法,用于求解无约束的最小化问题。

其原理是通过不断迭代更新参数的方式来逼近最优解。

在最速下降法中,每次迭代的方向是当前位置的负梯度方向,即沿着目标函数下降最快的方向前进。

具体地,对于目标函数f(x),在当前位置x_k处的梯度为g_k=▽f(x_k),则下一次迭代的位置x_{k+1}可以通过以下公式计算:x_{k+1}=x_k-α*g_k其中,α 是一个称为学习率(learning rate)的参数,用于控制每次迭代的步长。

最速下降法的优点是简单易实现,收敛速度较快。

然而,它也有一些缺点。

首先,最速下降法的收敛速度依赖于学习率的选择,过小的学习率会导致收敛速度过慢,而过大的学习率可能会导致跳过最优解。

其次,最速下降法通常会在目标函数呈现弯曲或者高度相关的情况下表现不佳,很难快速收敛到最优解。

牛顿法(Newton's Method)牛顿法是一种通过二阶导数信息来优化的算法,可以更快地收敛到目标函数的最优解。

在牛顿法中,每次迭代的位置x_{k+1}可以通过以下公式计算:x_{k+1}=x_k-(H_k)^{-1}*▽f(x_k)其中,H_k是目标函数f(x)在当前位置x_k处的黑塞矩阵。

黑塞矩阵描述了目标函数的二阶导数信息,可以帮助更准确地估计参数的更新方向。

牛顿法的优点是收敛速度较快,特别是对于目标函数呈现弯曲或者高度相关的情况下,相较于最速下降法可以更快地达到最优解。

然而,牛顿法也有一些缺点。

首先,计算黑塞矩阵的代价较高,尤其是当参数较多时。

其次,黑塞矩阵可能不可逆或者计算代价较大,这时可以通过使用拟牛顿法来避免。

拟牛顿法(Quasi-Newton Method)拟牛顿法是一类基于牛顿法的优化算法,通过估计黑塞矩阵的逆来逼近最优解,从而避免了计算黑塞矩阵的代价较高的问题。

在拟牛顿法中,每次迭代的位置x_{k+1}可以通过以下公式计算:x_{k+1}=x_k-B_k*▽f(x_k)其中,B_k是一个对黑塞矩阵逆的估计。

最速下降法和牛顿法

f ( x ) ≈ P( x ) = f x

由 P′( x ) = 0 ,即

( )

(k )

+ f ′ x (k ) x − x (k ) +

( )(

)

f ′′ x (k ) x − x (k ) 2

( )(

)

2

f ′ x (k ) +

( )

f ′′ x (k ) × 2 × x − x (k ) = 0 , 2

T

3

[ 0, 2] itrcount= H= 4 0 g= -4 -2 t= x= 5/18 1 0 2

10/9 5/9 看看前后梯度是否正交,g0'*g1=-8.881784e-016 itrcount= 2 H= 4 0 0 2 g= 4/9 -8/9 t= 5/12 x= 25/27 25/27 看看前后梯度是否正交,g0'*g1=1.387779e-016 itrcount= 3 H= 4 0 0 2 g= -8/27 -4/27 t= 5/18 x= 245/243 235/243 看看前后梯度是否正交,g0'*g1=7.979728e-017

T

0 2

1 1 看看前后梯度是否正交,g0'*g1=0.000000e+000

例子 2: 试用最速下降法求下列函数的极小点,已知 ε = 0.1 :

f ( x ) = 2( x1 − 1) + ( x2 − 1)

2

2

初始解: x = (0,0) 程序运行结果: gfun = [ 4*x1-4] [ 2*x2-2] Hfun = [ 4, 0]

P k = −∇f X k

( )

( )

在射线 X 上做直线搜索,以确定搜索步长 tk 。 满足条件:

最优化方法-最速下降法

计算步骤

设f (X )是可微函数,精度要求为

X f ( ) K 1

,

X 0 为初始点。

(1)计算梯度

f

(

X

)

k

,初始k=0;

(2)

Pk

f

(

X

)

k

(3)求解 k

min f ( X k Pk)

s.t. 0

设 k 是一维搜索的最优解;

(4)求下一个点

评价

由例题中可以发现两次迭代的搜索方向满足:

P P P P T 0, T 0,...,

01

12

即相邻两个搜索方向 PK 与 PK1 正交,这是最速下降

法的搜索方向的基本形质。因此,最速下降法的迭代

路线呈锯齿形,尤其是在极小点附近,锯齿现象尤为

严重,从而影响了迭代速度。

评价

锯齿现象

最优化技术

第三章 7节 最速下降法

主要内容

1原 理

2 计算步骤

3 例题分析 4评 价

原理

定义:用来求解无约束多元函数 min f(x)

极小化问题的一种迭代算法。

拓展:

最速下降法又称梯度法,是 1847 年由著名数学家

Cauchy 给出的,它是解析法中最古老的一种,其他解析 方法或是它的变形,或是受它的启发而得到的,因此它是 最优化方法的基础。

X

)

0

(1,1)T

3-最优步长

2

X P ( ) f 5

0

0 2

1

0

应用一维搜索技术,解得函数最小值点 0 =0.2

举例分析

4-下一搜索点

X1

最速下降法-最优化方法

(4)f

(

X

)

3

(0.04,0.04)T

,

f ( X 3) 2 0.0032 0.01

X 3 已达到预定精度要求,迭代终止。

故f(x)的无约束近似极小点为

X X 3 (0.96,1.44)T

注:原问题的精确极小点为

X (1,1.5)T

3. 最速下降法性质与评价

x1 x1

2 2

x2 x2

1 1

(1) X 0 (1,1)T

,

f

(

X

)

0

(1,1)T

,

P0

f

(

X

)

0

(1,1)T

X P (t ) f( 0 t

)

0

5t 2

2t

1

,t>0

ቤተ መጻሕፍቲ ባይዱ

应用一维搜索技术,可解得 (t) 的极小点为t0=0.2

所以 X 1 X 0 t0 P0 (1,1)T 0.2(1,1)T (0.8,1.2)T

X X P

Y f (X ) N 输出X

停止

例3.18 用最速下降法求解无约束优化问题:

x x x x x x min f (X ) 2 2 2

2

1

12

2

1

2

初始点 X 0 (1,1)T

,迭代终止准则为

f

(X k)

2

0.01

。

解:

f

(

X

)

4 2

1. 最速下降法原理 2. 最速下降法算法 3. 最速下降法性质与评价

最优化方3.3法最速下降法(梯度法)

例 3.4.4 用 Newton 法求解问题 min f (x) 4x12+x22-x12x2

取初始点为 xA (1,1)T , xB (3, 4)T , xC (2, 0)T 。

min f (x) 4x12+x22-x12x2

g

(

x)

8x1-2x1 x2 2 x2-x12

G(

x)

0.1273 0.0003 0.0000

1.3388 0.0511 0.0001

xk (0,0) 严格局部极小点

g

(

x)

8x1-2x1 x2 2x2-x12

G(0,0) 8 0 0 2

G(

x)

8-2x2 -2 x1

-2x1 2

解: (2)用 Newton 法得到得迭代点如表所示:

开域内有极小点 x*,设G* G(x*)正定,则当 x0与 x*充分

接近时,对一切k ,Newton 法有定义,且当xk 为无穷 点列时,xk 二阶收敛于 x*,即hk 0且

f

( xk

)存在,所以有

fk fk1 0。 (3.8)

用反证法。假设 gk 0不成立,则0 0及无穷多个 k ,使 gk 0。对这样的k ,有

gkT pk pk 0,

于是,由 Taylor 公式

f (xk pk ) f (xk ) g(k )T pk

f

(

xk

)

g

T k

pk

g(k ) gk T

最速下降法

k=k+1

x(1), ε >0, k=1

Yes

|| ▽f(x(k) ) ||< ε?

No

d(k)= -▽f(x(k) )

stop. x(k) –解

最速下降法

随着人工智能、模糊控制、模式识别、人工网络等新技术的应用和发展。

可以让它们与广义预测控制相结合,建立高精度、多模态的预测模型。

使广义预测控制在异常情况下可以稳定运行,推进广义预测控制的进一步发展。

2.2.1最速下降法最速下降法是无约束最优化中是比较有效的方法,它是以d}=一可(x})作为下降方向的算法。

其迭代格式为xx+i=xx一。

*Of (xk)上式中,一般通过精确线搜索准则求得步长因子。

*,当然也不排除可以利用非精确线搜索准则来求得步长因子。

*。

不管最速下降法采取何种线搜索准则,它均具有全局收敛性,但是这也不能直接就认为最速下降算法就是一个良好的优化算法。

在实际试验中,有很多优化问题利用最速下降法并不是下降的特快,反而下将的十分缓慢。

这是因为出现了锯齿现象:就是在计算过程中,最速下降法开始几步还是挺快的,但是当目标函数f (x)的等高线接近于一个球的时候,就出现了类似锯齿现象,前进十分缓慢,降低了算法的效能。

2.2.12.2.2牛顿法牛顿法也是无约束最优化问题中的一种经典算法,它是利用目标函数.f (x)的二次泰勒展开式,并将二次泰勒展开式进行极小化。

其迭代格式为x}+}=xA十d}(2-5)其中步长因子。

、=l} d、为02f (x} )d + Of (xA ) = 0的解。

当目标函数f(x)是正定二次函数的时候,牛顿法可以一步达到最优解;当目标函数f (x)是非二次函数的时候,牛顿法经过有限次迭代之后就不能确保求得目标函数f (x)的最优解。

我们知道目标函数f (x)在极小点附近是很接近于二次函数的,所以,假如初始点非常靠近无约束最优化问题((1-1)的最优解x的时候,并且}Z.f (x.)正定的时候,那么牛顿法就会有很快的收敛速度,而由此算法产生的点列也具有了超线性收敛速度,同时还在一定条件下具有二次收敛性;假如初始点与无约束最优化问题(1-1)的最优解x’相距比较远的时候,这时的}Z.}(x})就不一定是正定的了,也就存在了一个问题,那就是此时的牛顿方向就不一定是下降方向,有可能是上升方向,此时由此算法产生的点列可能也就不收敛于无约束最优化问题((1-1)的最优解了。

最速下降法

1.给定初始点x0,置k:=0. 2.计算xk点的梯度,若梯度小于等于事先给 定的非常小的正数 ,则终止,否则,下 一步。

3.令z k f ( x k ).

4.求使f ( x k z k )最小的 , 记为k ,即最佳步长. 令x k 1 x k k z k , 转2.

d T 2 f ( x* )d r 即: 1 2 T 2 d f ( x * )d o(2 ) 1 2 o ( ) 2 r 0 2 2 2

即当小到一定程度时, f ( x d )-f ( x ) 0

* *

也即:x*是严格局部极小点。

算法迭代步骤(求出的是极小值点)

因为x 是局部极小值点,所以当 充分小时, f ( x d )-f ( x ) 0 令 0, 取极限可知,

1 T 2 d f ( x )d 0 2

即2 f ( x )半正定

充分条件如下(即局部最优解的刻画,当满足什么 条件,所得的解就是局部最优解)

定理3:若f 是连续可微的凸函数,则x 是 min f ( x) 问题 的最优解的充分必要条件是: n x E f ( x ) 0 进一步,若f ( x)是严格凸函数,则 x 是 唯一的最优解。

(k ) (k )

lim x ( k ) x *

k

局部收敛,全局收敛

收敛速度:设序列x k 收敛到x*,若

k

lim

x k 1 - x * x x*

k

存在,

(0,1), 线性收敛; 0,超线性收敛;

若存在p, 使得 lim

k

x k 1 - x * xk x *

第一节、最速下降法

数值最优化李董辉第三章最速下降法和Newton法

Newton法 的优点:收敛快 缺点:对初始点要求很高,而且计算量大

从Newton法出发进行修改 ,利用其优点,克服 其缺点,产生很多效果非常好的其他新算法

第三章 无约束问题算法(I)—— 最速下降法、 Newton法

第一节 最速下降法 第二节 Newton法及其修正形式

第一节 最速下降法

1、 思想 :每次沿最速下降方向进行搜索

2、 算法步骤

3、 最速下降法的收敛性

全局收敛性

收敛速度估计

从上图可以看出,最速下降法 具有锯齿现象

由上面的分析可知,最速下降法的收敛速度 比较慢,通常将其用在某些算法的初始阶段 求较好的初始点

第二节 Newton法及其修正形式

1、思想:用近似二次函数的极小点作为原问题的新的近似解

2、 Newton法的算法步骤

(3.3)

3、Newton的 收敛性

4、 局部二次收敛性

5、 n法的修正形式

上面的Newton法的两种修正形式,在较弱的条件下 具有超线性收敛性或二次收敛性

本章要点最速下降法的基本思想及特点牛顿方向Newton法

例4.1 用最速下降法求函数 f (x1, x2)=x12+4x22 的极小点,(迭代两次), 并验证相邻两个搜索方向是正交的。初始点取为x(0)=[1,1]T 。

x1

因而由上述定理知: x1

0 0 || x1 || 0

x1

即只需迭代一步就到了极小点,这表明最速下降法用于等值线为圆的目标 函数时,从任意初始点出发,只需迭代一步就到了极小点。

(2)当 1 2 时, 等值线为椭圆。此时对于一般的初始点将产生锯齿现象。

(3)当 1 2

d kT g k d k g k

当且仅当dk=-gk时, (dk)Tgk 最小,从而-gk是最速下降方向。

最速下降法的迭代格式为:

x( k 1) x( k ) tk f ( x( k ) )

(二)算法

开始

给定x(0) , M , 1 , 2 , 令 k=0 计算f( x(k ) ) ||f( x(k ) )|| < 1 否 k>M 是 是

而采用固定步长λ的方法,称为固定步长最速下降法。只要λ充分小,总有:

f x k f xk 1 f xk f x k

f xk

但λ到底取多大,没有统一的标准, λ取小了,收敛太慢,而λ取大了, 又会漏掉极小点。——不精确线搜索解决这个问题

x1 x0 0f x0 1.919877 0.3071785 10

f ( x1 ) 3.686164.

2

T

然后再从 x1开始新的迭代,经过10次迭代,得最优解 x* (0, 0)T 计算中可 以发现,开始几次迭代,步长比较大,函数值下将降较快但当接进最优点 时,步长很小,目标函数值下降很慢。如果不取初点为 x0 (2, 2)T 而取 x0 (100,0)T 虽然后一初点较前一初点离最优点 x* (0, 0)T 远,但迭代中 不会出现上面的锯齿现象。这时:

最速下降法收敛阶

最速下降法收敛阶

最速下降法是一种经典的优化算法,它可以在短时间内找到函数的最佳解。

但是,最速下降法的求解效率与收敛速度也成为该算法应用的瓶颈之一,因此提高最速下降法的收敛阶对于优化算法的发展也是至关重要的。

下面将介绍最速下降法的收敛阶。

1. 最速下降法简介

最速下降法是一种基于负梯度方向的优化算法。

它的基本思想是沿着函数的梯度方向,不断地迭代寻找函数的最小值。

最速下降法在求解非线性方程和非线性规划问题中应用非常广泛。

2. 最速下降法的收敛阶

最速下降法的收敛阶决定了该算法求解的速度和效率。

当最速下降法的迭代次数 n 趋近于无穷大时,其收敛误差的下限为 O(1/n) 或O(1/n^2),称为一阶或二阶收敛。

具体来说,当最速下降法的收敛阶为一阶时,其收敛速度较慢,迭代次数需要很大才能达到期望的精度。

而当最速下降法的收敛阶为二阶时,其收敛速度较快,收敛精度达到期望的精度所需要的迭代次数会大大减少。

3. 最速下降法收敛阶的提高

为了提高最速下降法的收敛阶,有些学者提出了一些改进方法,例如共轭梯度法、Broyden-Fletcher-Goldfarb-Shanno (BFGS) 算法等。

通过这些改进方法,可以在保证算法求解精度的前提下,加速最速下降法的求解速度。

4. 结语

最速下降法作为一种基础的优化算法,其收敛阶的提高是优化算法发展的一个重要方向。

通过改进算法的迭代方式和步长来提高算法的收敛性能,可以更快地求解非线性方程和非线性规划问题。

最速下降法 解释

最速下降法解释嘿,朋友!今儿咱来聊聊“最速下降法”。

您知道不,这最速下降法就好比是在一个黑漆漆的大山里头找下山的最快路径。

想象一下,您被困在山顶,周围啥也看不清,只能靠摸索来找到最快回家的路。

这最速下降法呢,就是帮您在这迷茫中找到那个最快捷的方向。

它的原理其实不难理解。

就好像您在走迷宫,每一步都在找那个让您能更快走到出口的方向。

最速下降法就是不断地去试探,看看哪个方向能让目标函数下降得最快。

比如说,您想找到一个函数的最小值。

那最速下降法就会从一个初始点开始,然后计算这个点的梯度。

这梯度就像是给您指了一个下山的大致方向。

您顺着这个方向走一小段路,再重新计算梯度,再调整方向,一直这么走下去,直到您觉得差不多走到谷底了,也就是找到了那个最小值。

这过程是不是有点像您迷路了,靠着指南针一直朝着南边走,走一段看看情况,再决定是不是继续朝南?最速下降法也是这样,不断地调整方向,不断地靠近目标。

可别觉得这方法是万能的哟!有时候它可能会像个迷糊的小孩,在山里转来转去,走了不少冤枉路。

为啥呢?因为它太依赖初始点的选择啦,如果一开始就选错了地方,那可能要费好大的劲才能找到正确的路。

而且啊,这方法在一些复杂的地形里,也就是复杂的函数里,可能会变得很慢很慢,就像您在荆棘丛中艰难前行,半天也走不了多远。

但不管怎么说,最速下降法在很多问题里还是能派上大用场的。

比如说优化一些简单的模型,或者在没有更好的办法时,先试试它,说不定就有惊喜呢!总之,最速下降法是数学世界里的一个有趣的工具,虽然它有缺点,可就像一把不那么完美的钥匙,有时候也能打开一些重要的锁。

您说是不是这个理儿?。

最速下降法原理

最速下降法原理嘿,朋友们!今天咱来聊聊最速下降法原理。

这玩意儿啊,就好比你在一个大山里找下山的最快路。

想象一下,你站在山顶,周围都是迷雾,你不知道哪条路是最快能到山底的。

那咋办呢?最速下降法就来帮忙啦!它就像是你手里的指南针,给你指引一个大致的方向。

你就沿着这个方向先走一小步,然后看看,哎呀,是不是离山底更近了点呢?如果是,那就好,接着再沿着这个方向走一小步。

可要是发现好像不太对,那就稍微调整一下方向。

这就好像你走路,有时候会走偏一点,那你就得赶紧调整回来,不然不就越走越远啦?最速下降法就是这么神奇,让你不断地靠近目标。

你说这像不像我们平时做事啊?我们一开始也不知道怎么做才是最好的,那就先试着来嘛!走一步看一步,发现不对就赶紧调整。

比如说你想学会一门乐器,一开始可能弹得乱七八糟的,但是你每次都发现问题,然后改正,慢慢地不就越来越好了嘛!这和最速下降法是一个道理呀!而且哦,这个过程中可不能着急。

就像下山一样,你要是急急忙忙地乱跑,说不定就摔跟头啦!得稳稳地,一步一步来。

最速下降法也不是一下子就能让你找到最好的路,它只是给你一个指引。

有时候可能会走一些弯路,但没关系呀,这都是过程嘛!你想想,要是一下子就找到了最好的路,那多没意思呀,一点挑战都没有。

就是因为有这些曲折,我们才会更加珍惜最后到达目的地的那一刻呀!我们的生活不也是这样嘛?总是会遇到各种各样的问题,但只要我们有最速下降法这样的精神,不断地去尝试,去调整,就一定能找到属于我们自己的路,走向成功的彼岸。

所以啊,别害怕困难,别害怕走弯路,就大胆地去尝试吧!让最速下降法带着我们在生活的大山里找到下山的最快路径!相信自己,一定可以的!。