Chinese Word Segmentation

数据展示平台需求规格说明书

通过指定的规则发现及纠正数据中可识别的错误,检查数据的一致性、处理无效值和缺失值等。

数据转换(data transformation)

将数据从一种组织形式变为另一种组织形式的过程。

数据加载(data loading)

将清洗、转换好的数据保存到目标数据库的过程和行为。

5.3.1能源21

5.3.2主要经济指标24

5.3.3税收26

5.3.4产业32

5.3.5产值34

5.3.6创新36

5.3.7开放40

5.4综合管理42

5.4.1功能描述42

5.4.2功能结构42

5.4.3数据描述43

5.4.4界面原型46

5.5二次开发46

5.5.1功能描述46

5.5.2界面原型47

数据展示平台

需求规格说明书

1.引言1

1.1文档编制目的1

1.2阅读对象1

1.3项目建设背景1

1.4术语表2

1.5参考资料3

2.概述3

2.1项目建设目标3

2.2项目建设内容3

2.3与其他系统关系4

2.3.1服务器端运行环境4

2.3.2客户端运行环境

3.业务需求5

3.1总体数据流程5

4.系统功能规划6

4.1系统功能架构6

4.2功能需求列表7

5.功能需求10

5.1演示模式10

5.1.1功能描述10

5.1.2功能结构10

5.1.3界面原型10

5.2基本情况14

5.2.1功能描述14

5.2.2功能结构14

5.2.3数据描述15

5.2.4界面原型20

5.3经济情况20

CTM包:中文文本挖掘工具包说明书

Package‘CTM’October12,2022Type PackageTitle A Text Mining Toolkit for Chinese DocumentVersion0.2Date2016-11-28Author Jim Liu,Quan GuMaintainer Jim Liu<**********************>Description The CTM package is designed to solve problems of text mining and is specific for Chi-nese document.License GPL-3LazyData TRUERoxygenNote5.0.1Imports jiebaR,plyrNeedsCompilation noRepository CRANDate/Publication2016-11-2808:20:59R topics documented:CDTM (2)CTDM (3)termCount (4)Index512CDTM CDTM Document Term MatrixDescriptionConstructs Document-Term Matrix from Chinese Text Documents.UsageCDTM(doc,weighting,EngTermDeleted=TRUE,NumTermDeleted=TRUE,shortTermDeleted=TRUE)Argumentsdoc The Chinese text document.A vector of Chinese strings.weighting Available weighting function with matrix are binary,count,tf,tfidf.See details.EngTermDeleted remove English from text documents.NumTermDeleted remove Numbers from text documents.shortTermDeletedDeltected short word when nchar<2.DetailsThis function run a Chinese word segmentation by jiebeR and build document-term matrix,and there is four weighting function with matrix,and"binary"means value can only be1if the term occurs,"count"means how many times the term occurs in a doc,"tf"means term frequency and "tfidf"means term frequency inverse document frequency.Author(s)Jim Liu,Quan GuExampleslibrary(CTM)a1<-"hello taiwan"b1<-"world of tank"c1<-"taiwan weather"d1<-"local weather"text1<-t(data.frame(a1,b1,c1,d1))dtm1<-CTDM(doc=text1,weighting="tfidf",EngTermDeleted=FALSE,shortTermDeleted=FALSE)CTDM3 CTDM Term Document MatrixDescriptionConstructs Term-Document Matrix from Chinese Text Documents.UsageCTDM(doc,weighting,EngTermDeleted=TRUE,NumTermDeleted=TRUE,shortTermDeleted=TRUE)Argumentsdoc The Chinese text document.A vector of Chinese strings.weighting Available weighting function with matrix are binary,count,tf,tfidf.See details.EngTermDeleted remove English from text documents.NumTermDeleted remove Numbers from text documents.shortTermDeletedDeltected short word when nchar<2.DetailsThis function run a Chinese word segmentation by jiebeR and build term-document matrix,and there is four weighting function with matrix,and"binary"means value can only be1if the term occurs,"count"means how many times the term occurs in a doc,"tf"means term frequency and "tfidf"means term frequency inverse document frequency.Author(s)Jim Liu,Quan GuExampleslibrary(CTM)a1<-"hello taiwan"b1<-"world of tank"c1<-"taiwan weather"d1<-"local weather"text1<-t(data.frame(a1,b1,c1,d1))tdm1<-CTDM(doc=text1,weighting="tfidf",EngTermDeleted=FALSE,shortTermDeleted=FALSE)4termCount termCount Term CountDescriptionComputing term count from text documentsUsagetermCount(doc,EngTermDeleted=TRUE,NumTermDeleted=TRUE,shortTermDeleted=TRUE)Argumentsdoc The Chinese text document.EngTermDeleted remove English from text documents.NumTermDeleted remove Numbers from text documents.shortTermDeletedDeltected short word when nchar<2.DetailsThis function run a Chinese word segmentation by jiebeR and compute term count from all these text document.Author(s)Jim LiuExampleslibrary(CTM)a1<-"hello taiwan"b1<-"world of tank"c1<-"taiwan weather"d1<-"local weather"text1<-t(data.frame(a1,b1,c1,d1))count1<-termCount(doc=text1,EngTermDeleted=FALSE,shortTermDeleted=FALSE)IndexCDTM,2CTDM,3termCount,45。

npl中英文分词方法

npl中英文分词方法English:There are various methods for segmenting Chinese and English text in Natural Language Processing (NLP). For English, the most common method is to simply split the text based on spaces or punctuation marks. More advanced techniques include using Part-of-Speech (POS) tagging to identify word boundaries and compound words. For Chinese, the most common method is to use word segmentation algorithms such as the Maximum Match method, which involves matching the longest possible word from a dictionary, or the Bi-LSTM-CRF model, which is a neural network model specifically designed for Chinese word segmentation. Additionally, character-based word segmentation methods can also be used for Chinese text, where words are segmented based on constituent characters and language-specific rules.中文翻译:在自然语言处理(NLP)中,有多种方法可以对中文和英文文本进行分词处理。

数据共享交换平台需求规格说明书

数据共享交换平台需求规格说明书

2020年10月

目录

1.引言 (1)

1.1文档编制目的 (1)

1.2阅读对象 (1)

1.3项目建设背景 (1)

1.4术语表 (2)

1.5参考资料 (4)

2.概述 (5)

2.1项目建设目标 (5)

2.2项目建设内容 (5)

2.3与其他系统关系 (6)

2.4系统运行环境 (6)

2.4.1服务器端运行环境 (7)

2.4.2客户端运行环境 (7)

2.4.3支撑软件 (7)

3.业务需求 (8)

3.1总体业务流程 (8)

3.2总体数据流程 (9)

3.3总体业务结构 (10)

3.4用户业务需求 (12)

4.系统功能规划 (12)

4.1系统功能架构 (12)

4.2功能需求列表 (14)

5.功能需求 (18)

5.1数据采集 (18)

5.1.1功能描述 (18)

5.1.2功能结构 (18)

5.1.3界面原型 (20)

5.2模型管理 (28)

5.2.1功能描述 (28)

5.2.2功能结构 (28)

5.2.3界面原型 (29)

5.3数据主题管理 (32)

5.3.1功能描述 (32)

5.3.2功能结构 (32)

5.3.3界面原型 (32)

5.4统计分析 (35)

5.4.1功能描述 (35)

5.4.2功能结构 (36)

5.4.3界面原型 (36)

5.5数据质量管理 (36)

5.5.1功能描述 (36)

5.5.2功能结构 (37)。

数据管理服务平台需求规格说明书

数据管理服务平台需求规格说明书

目录

1.引言 (1)

1.1文档编制目的 (1)

1.2阅读对象 (1)

1.3项目建设背景 (1)

1.4术语表 (2)

1.5参考资料 (3)

2.概述 (3)

2.1项目建设目标 (3)

2.2项目建设内容 (3)

2.3与其他系统关系 (4)

2.4系统运行环境 (4)

2.4.1服务器端运行环境 (4)

2.4.2客户端运行环境 (4)

2.4.3支撑软件 (5)

2.5假定和依赖 (5)

3.业务需求 (6)

3.1总体业务流程 (6)

3.2总体数据流程 (7)

3.3总体业务结构 (8)

3.4用户需求列表 (8)

4.系统功能规划 (9)

4.1系统功能架构 (9)

4.2功能需求列表 (9)

5.功能需求 (11)

5.1数据治理与监控系统 (11)

5.1.1功能描述 (11)

5.1.2功能结构 (11)

5.1.3界面原型 (13)

5.2数据服务集成管理系统 (21)

5.2.1功能描述 (21)

5.2.2功能结构 (21)

5.2.3界面原型 (22)。

语义分析的一些方法

语义分析的一些方法语义分析的一些方法(上篇)•5040语义分析,本文指运用各种机器学习方法,挖掘与学习文本、图片等的深层次概念。

wikipedia上的解释:In machine learning, semantic analysis of a corpus is the task of building structures that approximate concepts from a large set of documents(or images)。

工作这几年,陆陆续续实践过一些项目,有搜索广告,社交广告,微博广告,品牌广告,内容广告等。

要使我们广告平台效益最大化,首先需要理解用户,Context(将展示广告的上下文)和广告,才能将最合适的广告展示给用户。

而这其中,就离不开对用户,对上下文,对广告的语义分析,由此催生了一些子项目,例如文本语义分析,图片语义理解,语义索引,短串语义关联,用户广告语义匹配等。

接下来我将写一写我所认识的语义分析的一些方法,虽说我们在做的时候,效果导向居多,方法理论理解也许并不深入,不过权当个人知识点总结,有任何不当之处请指正,谢谢。

本文主要由以下四部分组成:文本基本处理,文本语义分析,图片语义分析,语义分析小结。

先讲述文本处理的基本方法,这构成了语义分析的基础。

接着分文本和图片两节讲述各自语义分析的一些方法,值得注意的是,虽说分为两节,但文本和图片在语义分析方法上有很多共通与关联。

最后我们简单介绍下语义分析在广点通“用户广告匹配”上的应用,并展望一下未来的语义分析方法。

1 文本基本处理在讲文本语义分析之前,我们先说下文本基本处理,因为它构成了语义分析的基础。

而文本处理有很多方面,考虑到本文主题,这里只介绍中文分词以及Term Weighting。

1.1 中文分词拿到一段文本后,通常情况下,首先要做分词。

分词的方法一般有如下几种:•基于字符串匹配的分词方法。

此方法按照不同的扫描方式,逐个查找词库进行分词。

《自然语言理解》课程作业

《自然语言理解》课程作业课程编号:71253Z课程属性:专业基础课 学时/学分:40/2预修课程:概率论与数理统计、算法分析与程序设计主讲人:宗成庆联系方式:E-mail: cqzong@ Tel. 6255 4263一、作业目的:通过本课程作业加深对自然语言理解基础理论的认识和了解,锻炼和提高分析问题、解决问题的能力。

通过对具体项目的任务分析、技术调研、数据准备、算法设计和编码实现以及系统调试等几个环节的练习,基本掌握实现一个自然语言处理系统的基本过程。

二、作业题目:1.实现一个汉语或英语的命名实体自动识别系统(Named entity identification)命名实体一般指如下几类专用名词:人名、地名和组织机构名。

选做本题目时,可实现汉语或英语中任意一种类型的命名实体识别。

2.实现一个汉英人名自动互译系统(Chinese-English person name translation)本题目要求实现一个汉语人名(包括中国人名和外国人译名)和英语人名的自动翻译系统。

3.实现一个汉语自动分词系统(Chinese word segmentation)本题目要求实现一个汉语自动分词系统。

如果在本题目中不考虑命名实体识别问题,歧义消解和集外词处理是汉语自动分词中的关键问题。

4.实现一个汉语或英语的词类自动标注系统(Automatic part-of-speech tagging)本题目要求实现一个汉语或英语的词类自动标注系统。

5.实现一个汉语和英语两种语言中数字、日期或时间、货币数量表达的自动识别和翻译系统数字、日期或时间、货币数量等在自然语言中有特殊的表达方式。

如汉语:“2011年3月8日”的英语表达是:“March 8, 2011”或“3 March 2011”等。

选做本题目时可实现某一种表达的识别和单向翻译,也可实现双向互译。

6.实现一个(汉语/英语)词义自动消歧系统(Word sense disambiguation)很多词汇具有一词多义的特点,但一个词在特定的上下文语境中其含义却是确定的。

bert-chinese-wwm-ext中文文本分词

bert-chinese-wwm-ext中文文本分词中文文本分词是指将连续的中文文本按照词语的切分规则进行分割,将文本分解为一个个的词语。

在自然语言处理任务中,文本分词是很重要的一步,能够为后续的文本处理和语义理解提供基础。

中文文本的分词相较于英文文本的分词更加复杂,主要因为中文是以词语为基本的语言单位,而英文是以字母为基本的语言单位。

中文中的一个词语通常由若干个汉字组成,而同样的汉字可以在不同的词语中扮演不同的角色,因此中文分词需要解决歧义问题。

针对中文文本分词,近年来随着深度学习方法的发展,基于神经网络的分词模型取得了很好的效果。

其中,BERT(Bidirectional Encoder Representations from Transformers)模型是一种自然语言处理的模型,在中文分词任务中也被广泛应用。

BERT模型是由Google Research于2018年提出的,其借鉴了Transformer模型的思想,通过预训练和微调的方式,在多个自然语言处理任务上取得了顶尖表现。

BERT-chinese-wwm-ext是一个基于BERT模型的中文文本处理的扩展模型。

它是在BERT-chinese模型的基础上进行预训练得到的,其中"wwm"表示采用了Whole Word Masking的预训练方式,即连续的词语会作为整体进行遮盖,从而解决文本分词中的歧义问题。

BERT-chinese-wwm-ext模型对中文文本进行分词有以下几个关键步骤:1.输入处理:将待分词的中文文本作为输入,首先进行基本的文本预处理,如去除标点符号、特殊字符等。

然后,根据BERT模型的要求,将文本分割为固定长度的token序列。

2.词向量表示:通过BERT-chinese-wwm-ext模型,将输入的token序列转换为对应的词向量表示。

BERT模型会利用上下文信息,将每个token转换为一个固定维度的向量,其中包含了丰富的语义信息。

语言学术语中英对照

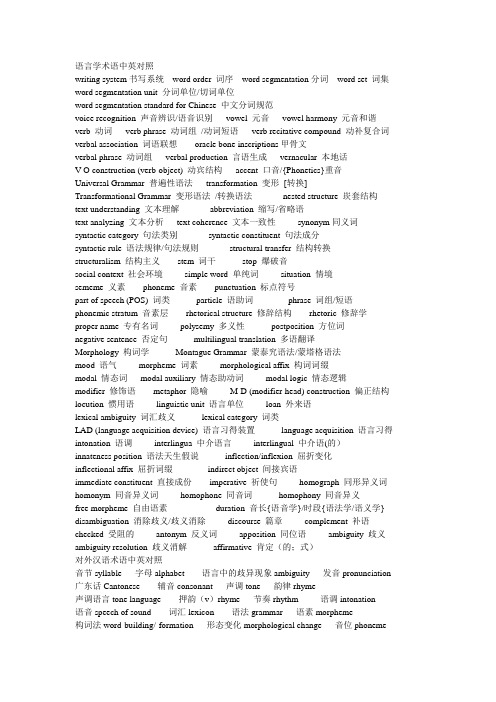

语言学术语中英对照writing system书写系统 word order 词序 word segmentation分词 word set 词集word segmentation unit 分词单位/切词单位word segmentation standard for Chinese 中文分词规范voice recognition 声音辨识/语音识别 vowel 元音 vowel harmony 元音和谐verb 动词verb phrase 动词组/动词短语 verb recitative compound 动补复合词verbal association 词语联想 oracle bone inscriptions甲骨文verbal phrase 动词组verbal production 言语生成vernacular 本地话V-O construction (verb-object) 动宾结构accent 口音/{Phonetics}重音Universal Grammar 普遍性语法transformation 变形[转换]Transformational Grammar 变形语法/转换语法nested structure 崁套结构text understanding 文本理解abbreviation 缩写/省略语text analyzing 文本分析 text coherence 文本一致性synonym同义词syntactic category 句法类别syntactic constituent 句法成分syntactic rule 语法规律/句法规则 structural transfer 结构转换structuralism 结构主义 stem 词干 stop 爆破音social context 社会环境 simple word 单纯词situation 情境sememe 义素 phoneme 音素 punctuation 标点符号part of speech (POS) 词类 particle 语助词 phrase 词组/短语phonemic stratum 音素层 rhetorical structure 修辞结构 rhetoric 修辞学proper name 专有名词polysemy 多义性 postposition 方位词negative sentence 否定句 multilingual translation 多语翻译Morphology 构词学 Montague Grammar 蒙泰究语法/蒙塔格语法mood 语气morpheme 词素 morphological affix 构词词缀modal 情态词 modal auxiliary 情态助动词 modal logic 情态逻辑modifier 修饰语 metaphor 隐喻M-D (modifier-head) construction 偏正结构locution 惯用语 linguistic unit 语言单位 loan 外来语lexical ambiguity 词汇歧义 lexical category 词类LAD (language acquisition device) 语言习得装置 language acquisition 语言习得intonation 语调interlingua 中介语言interlingual 中介语(的)innateness position 语法天生假说 inflection/inflexion 屈折变化inflectional affix 屈折词缀 indirect object 间接宾语immediate constituent 直接成份 imperative 祈使句 homograph 同形异义词homonym 同音异义词homophone 同音词 homophony 同音异义free morpheme 自由语素 duration 音长{语音学}/时段{语法学/语义学} disambiguation 消除歧义/歧义消除discourse 篇章 complement 补语checked 受阻的antonym 反义词apposition 同位语 ambiguity 歧义ambiguity resolution 歧义消解 affirmative 肯定(的;式)对外汉语术语中英对照音节syllable 字母alphabet 语言中的歧异现象ambiguity 发音pronunciation 广东话Cantonese 辅音consonant 声调tone 韵律rhyme声调语言tone language 押韵(v)rhyme 节奏rhythm 语调intonation语音speech of sound 词汇lexicon 语法grammar 语素morpheme构词法word-building/-formation 形态变化morphological change 音位phoneme声带vocal cords 发音器官organs of speech 呼吸器官respiratory organs音标phonetic alphabet 汉语拼音Chinese Phonetic Alphabet 属性attribute 发音articulation 甲骨文oracle bone inscriptions 笔画stroke 名词noun部首character component 表意文字ideograph 象形文字pictograph实词notional word 动词verb 形容词adjective 副词adverb代词pronoun 虚词function word 连词conjunction 语气词mood word 介词preposition 叹词interjection 助词auxiliary word 情态动词modal verb 主语subject 宾语object 定语attribute 补语complement谓语predicate 表语predicative 状语adverbial 修饰语modifier同义词synonym 反义词antonym 词组word group 时态tense专有名词proper noun 专业术语register 语境context 词尾ending后缀suffix 前缀infix 本义original meaning 基本义basic meaning引申义extended meaning 成语set phrase / idiom 方言dialect句法学Synt。

中文分词技术的研究现状与困难

中图分类号:TP391.1 文献标识码:A 文章编号:1009-2552(2009)07-0187-03中文分词技术的研究现状与困难孙铁利,刘延吉(东北师范大学计算机学院,长春130117)摘 要:中文分词技术是中文信息处理领域的基础研究课题。

而分词对于中文信息处理的诸多领域都是一个非常重要的基本组成部分。

首先对中文分词的基本概念与应用,以及中文分词的基本方法进行了概述。

然后分析了分词中存在的两个最大困难。

最后指出了中文分词未来的研究方向。

关键词:中文分词;分词算法;歧义;未登录词State of the art and difficulties in Chinesew ord segmentation technologyS UN T ie2li,LI U Y an2ji(School of Computer,N ortheast N orm al U niversity,Ch angchun130117,China) Abstract:Chinese w ord segmentation is a basic research issue on Chinese in formation processing tasks.And Chinese w ord segmentation is a very im portant com ponent in many field of Chinese information process.The paper proposes an unsupervised training method for acquiring probability m odels that accurately segment Chinese character sequences into w ords.Then it presents a detailed analysis of the tw o great dificulties in w ord segmentation.And finally,it points out the research problems to be res olved on Chinese w ord segmentation.K ey w ords:Chinese w ord segmentation;segmentation alg orithm;ambiguity;unlisted w ords0 引言随着计算机网络的飞速普及,人们已经进入了信息时代。

Trados2021对齐已翻译文档导入记忆库

Trados2021对齐已翻译文档导入记忆库对齐已翻译文档导入翻译记忆库-WinalignTrados2021对齐已翻译文档(来自网页)对于从未使用过 Trados 的译员来说,积累翻译记忆库是一个漫长而艰巨的过程,因此在刚开始使用时,没有可以参照的库直接拿来使用。

因此 Trados 具有对齐已翻译文档的功能,帮助译员将之前未使用 Trados 时翻译的原文和译文创建成相关的翻译记忆库。

这个功能称为 Winalign。

在本节中,我们准备了一篇英文和对应的中文 Word 文档用来对齐译文。

请注意,原文和译文的文档类型必须一致,否则无法进行 Winalign 操作。

新建对齐已翻译文档项目打开 SDL Trados 2021,并在主页的工具栏中,点击按键“对齐已翻译文档”,便会跳出 Winalign 界面。

点击“File”菜单并新建一个项目“New Project”,会跳出一个名为“New Winalign Project” 的对话框,我们需要在这个对话框调整语言、文件等一系列设置。

点击“General”常规选项卡,在“Project Name”中填写项目名称,并设置原语言和目标语言,分别为英文和中文。

对于文件类型而言,由于准备的是 word 文档,则选择“Microsoft Word Document (*.doc)”文件。

需要注意的是,Winalign 是根据设置的断句规则来进行断句并自动对齐的。

对于中文而言,需要对断句规则略作调整。

点击“Chinese (PRC)”下方的“TargetSegmentation”设置中文的断句规则。

由于中文的冒号、问号和感叹号之后都没有空格,因此点击“Colon”,将“Trailing WhiteSpaces”前的数字改成 0。

同样需要修改的还有“Marks”。

General 常规选项设置完成,第二步便是加载需要对齐的原文及译文。

点击第二个选项卡“Files”。

在英文栏和中文栏中分别添加原文及译文,并点击按钮“Align File Name”,将两个文件之间相连。

结巴 中文分词 流程

结巴中文分词流程英文回答:The process of Chinese word segmentation using the Jieba library involves several steps. First, the text is preprocessed to remove any unnecessary characters or symbols. This may include removing punctuation marks, special characters, or numbers.Next, the text is tokenized into individual words or characters. Jieba provides different tokenization methods, such as using the default mode, which separates words based on maximum probability, or using the full mode, which includes all possible word combinations.After tokenization, the words are assigned part-of-speech (POS) tags. Jieba uses a Hidden Markov Model (HMM) to determine the most likely POS tags for each word. These tags provide information about the grammatical function of the word in the sentence, such as whether it is a noun,verb, adjective, etc.Once the words are tagged, Jieba applies a process called word segmentation. This involves determining the boundaries between words in the text. Jieba uses a combination of statistical and rule-based methods to identify the most likely word boundaries. For example, it may consider the frequency of word combinations in a large corpus of text to determine the most likely boundaries.Finally, the segmented words are returned as a list or a string, depending on the desired output format. The resulting segmented text can then be used for further analysis, such as text classification, sentiment analysis, or information retrieval.中文回答:结巴中文分词的流程包括几个步骤。

分词方法基于字符串匹配的分词基于理解的分词基于统计的分词

吕先超 20150108

目录

中文分词概况

分词算法 分词难点 已经存在的项目 基于CRFs的中文分词算法

中文分词概况

中文分词 (Chinese Word Segmentation) 指的是将一个汉字序列切分成一个一个 单独的词。词是最小的能够独立活动的有意义的语言成分,分词就是将连续的字序 列按照一定的规范重新组合成词序列的过程。我们知道,在英文的行文中,单词之 间是以空格作为自然分界符的,而中文只是字、句和段能通过明显的分界符来简单 划界,唯独词没有一个形式上的分界符,虽然英文也同样存在短语的划分问题,不 过在词这一层上,中文比之英文要复杂的多、困难的多。中文分词是汉语自然语言 处理的基础性任务,分词的准确度直接影响到后续处理任务,分词的速度影响一些系 统的实际应用"因此,中文词语分析是中文信息处理的基础与关键。

基于字符串的分词算法:无法正确识别未登录词,因为这种算法 仅仅与词典中存在的词语进行比较。 基于理解的分词算法:理解字符串的含义,从而有很强的新词识 别能力。

基于统计的分词算法:这种算法对第二种未登录词有很强的识别 能力,因为出现的次数多,才会当作一个新词;对于第二类未登 录词,这类词语有一定的规律,如姓名:姓+名字,如杨利伟;机 构名:前缀+称谓,如联想集团;故需要结合一定的规则进行识别, 仅仅统计方法难以正确识别。

分词难点(1)

歧义的处理

从歧义字段的切分结果来看, 歧义字段可以分为真歧义字段和伪歧义 字段。 真歧义

歧义字段在不同的语境中确实有多种切分形式 例: 地面积

这块/地/面积/还真不小 地面/积/了厚厚的雪

伪歧义

歧义字段单独拿出来看有歧义,但在所有真实语境中,仅有一种切分形 式可接受 例: 挨批评

python利用jieba进行中文分词去停用词

python利⽤jieba进⾏中⽂分词去停⽤词中⽂分词(Chinese Word Segmentation) 指的是将⼀个汉字序列切分成⼀个⼀个单独的词。

分词模块jieba,它是python⽐较好⽤的分词模块。

待分词的字符串可以是 unicode 或 UTF-8 字符串、GBK 字符串。

注意:不建议直接输⼊ GBK 字符串,可能⽆法预料地错误解码成 UTF-8⽀持三种分词模式1 精确模式,试图将句⼦最精确地切开,适合⽂本分析;2 全模式,把句⼦中所有的可以成词的词语都扫描出来, 速度⾮常快,但是不能解决歧义;3 搜索引擎模式,在精确模式的基础上,对长词再次切分,提⾼召回率,适合⽤于搜索引擎分词。

# 精确模式 seg_list = jieba.cut("我去过清华⼤学和北京⼤学。

")# 全模式 seg_list = jieba.cut("我去过清华⼤学和北京⼤学。

", cut_all=True)# 搜索引擎模式 seg_list = jieba.cut_for_search("我去过清华⼤学和北京⼤学。

")#精确模式: 我/ 去过/ 清华⼤学/ 和/ 北京⼤学/ 。

#全模式: 我/ 去过/ 清华/ 清华⼤学/ 华⼤/ ⼤学/ 和/ 北京/ 北京⼤学/ ⼤学/ /#搜索引擎模式: 我/ 去过/ 清华/ 华⼤/ ⼤学/ 清华⼤学/ 和/ 北京/ ⼤学/ 北京⼤学/#coding=utf-8import jieba. analysestopwords=[]for word in open('stopwords.txt','r'):stopwords.append(word.strip())article=open('1.txt','r').read()words=jieba.cut(article,cut_all=False)stayed_line=""for word in words:if word.encode("utf-8")not in stopwords:stayed_line+=word+" "print stayed_linew=open('2.txt','w')w.write(stayed_line.encode('utf-8'))。

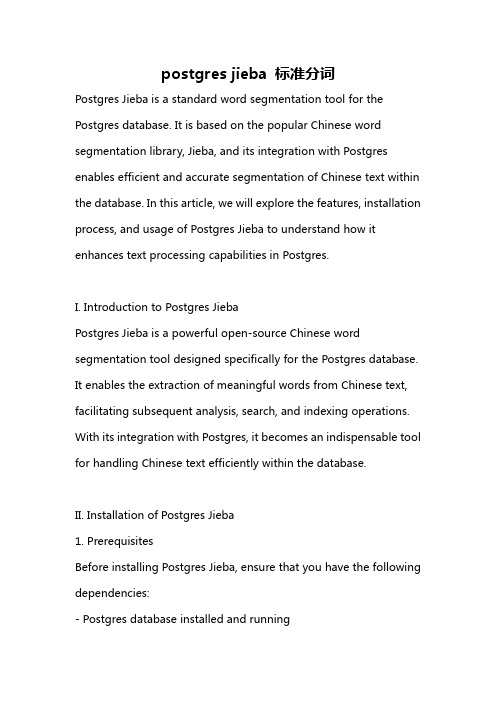

postgres jieba 标准分词

postgres jieba 标准分词Postgres Jieba is a standard word segmentation tool for the Postgres database. It is based on the popular Chinese word segmentation library, Jieba, and its integration with Postgres enables efficient and accurate segmentation of Chinese text within the database. In this article, we will explore the features, installation process, and usage of Postgres Jieba to understand how it enhances text processing capabilities in Postgres.I. Introduction to Postgres JiebaPostgres Jieba is a powerful open-source Chinese word segmentation tool designed specifically for the Postgres database. It enables the extraction of meaningful words from Chinese text, facilitating subsequent analysis, search, and indexing operations. With its integration with Postgres, it becomes an indispensable tool for handling Chinese text efficiently within the database.II. Installation of Postgres Jieba1. PrerequisitesBefore installing Postgres Jieba, ensure that you have the following dependencies:- Postgres database installed and running- Access to the database with administrative privileges2. Installation StepsTo install Postgres Jieba, follow these steps:Step 1: Download Postgres JiebaStart by obtaining the Postgres Jieba extension from the official GitHub repository. You can either clone the repository or download the source code as a zip file.Step 2: Compile and InstallOnce you have the source code, navigate to the downloaded directory and execute the following commands:makesudo make installThese commands will compile the extension and install it into your Postgres database.Step 3: Enable the ExtensionAfter successful installation, connect to your Postgres database using a superuser account and enable the Postgres Jieba extension by running the following SQL command:CREATE EXTENSION jieba;III. Usage of Postgres JiebaPostgres Jieba provides various functions that allow you to perform segmentation and analysis on Chinese text data stored in your Postgres database. Let's explore some of the key functionalities:1. Segmentation FunctionThe primary function offered by Postgres Jieba is the word segmentation function, which splits Chinese text into meaningful words. To segment a text column in a table, use the following syntax:SELECT jieba.cut('你好世界!') AS segmented_text;This will return the segmented_text column with the segmented words. You can also segment a specific column of a table by substituting '你好世界!' with the column name.2. Part-of-Speech TaggingPostgres Jieba provides a function for part-of-speech tagging, which assigns a grammatical tag to each word in the segmented text. This feature enables more advanced analysis andunderstanding of the Chinese text. To perform part-of-speech tagging, use the following syntax:SELECT jieba.posseg_cut('你好世界!') AS segmented_text_with_tags;This will return the segmented_text_with_tags column, where each word is accompanied by its corresponding tag.3. Custom DictionaryPostgres Jieba allows the creation of a custom dictionary to include domain-specific terms or specialized vocabulary. To add words to the custom dictionary, use the following syntax:SELECT jieba.insert_word('新冠病毒') AS added_word;This will add '新冠病毒' (COVID-19) to the custom dictionary. The added_word column will display the word that was successfully added.4. Stop WordsPostgres Jieba provides a mechanism to exclude certain words from the segmentation process. These words, known as stop words, are commonly used words with little semantic value. To define stop words, use the following syntax:SELECT jieba.add_stop_word('的') AS added_stop_word;This will exclude the word '的' (of) from the segmentation process. The added_stop_word column will display the stop word that was successfully added.IV. ConclusionPostgres Jieba is a valuable tool for handling Chinese text within the Postgres database. Its integration allows efficient segmentation, part-of-speech tagging, and customization options, enhancing the database's text processing capabilities. By using Postgres Jieba, developers and data analysts can extract meaningful information from Chinese text, enabling advanced analysis and search operations.。

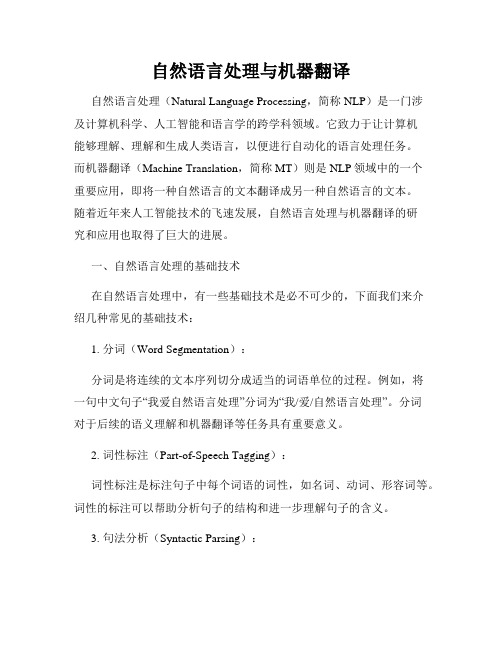

自然语言处理与机器翻译

自然语言处理与机器翻译自然语言处理(Natural Language Processing,简称NLP)是一门涉及计算机科学、人工智能和语言学的跨学科领域。

它致力于让计算机能够理解、理解和生成人类语言,以便进行自动化的语言处理任务。

而机器翻译(Machine Translation,简称MT)则是NLP领域中的一个重要应用,即将一种自然语言的文本翻译成另一种自然语言的文本。

随着近年来人工智能技术的飞速发展,自然语言处理与机器翻译的研究和应用也取得了巨大的进展。

一、自然语言处理的基础技术在自然语言处理中,有一些基础技术是必不可少的,下面我们来介绍几种常见的基础技术:1. 分词(Word Segmentation):分词是将连续的文本序列切分成适当的词语单位的过程。

例如,将一句中文句子“我爱自然语言处理”分词为“我/爱/自然语言处理”。

分词对于后续的语义理解和机器翻译等任务具有重要意义。

2. 词性标注(Part-of-Speech Tagging):词性标注是标注句子中每个词语的词性,如名词、动词、形容词等。

词性的标注可以帮助分析句子的结构和进一步理解句子的含义。

3. 句法分析(Syntactic Parsing):句法分析是为了确定句子中词语之间的关系和句子的结构。

通过句法分析,可以建立句子的语法树,从而深入理解句子的组成和语法结构。

4. 语义分析(Semantic Analysis):语义分析是为了理解句子的意义和语义关系。

语义分析可以将句子中的词语和短语映射到语义空间中,并通过逻辑推理和语义关系来识别句子的语义结构。

二、机器翻译的发展历程机器翻译作为自然语言处理的一个重要应用领域,经历了多年的发展。

下面我们来简要介绍机器翻译的发展历程:1. 规则化机器翻译:规则化机器翻译是早期机器翻译的一种方法,它基于人工编写的规则和双语词典来进行翻译。

这种方法需要大量的人工劳动来编写规则,并且对于有限领域的翻译效果相对较好。

自然语言处理-中文分词程序实验报告(含源代码)

9

infile.open("dict/number.txt.utf8"); if (!infile.is_open()) { cerr << "Unable to open input file: " << "wordlexicon" << " -- bailing out!" << endl; exit(-1); } while (getline(infile, strtmp)) // 读入词典的每一行并将其添加入哈希中 { istringstream istr(strtmp); istr >> word; //读入每行第一个词 numberhash.insert(sipair(word, 1)); //插入到哈希中 } infile.close(); infile.open("dict/unit.txt.utf8"); if (!infile.is_open()) { cerr << "Unable to open input file: " << "wordlexicon" << " -- bailing out!" << endl; exit(-1); } while (getline(infile, strtmp)) // 读入词典的每一行并将其添加入哈希中 { istringstream istr(strtmp); istr >> word; //读入每行第一个词 unithash.insert(sipair(word, 1)); //插入到哈希中 } infile.close(); } //删除语料库中已有的分词空格,由本程序重新分词 string eat_space(string s1) { int p1=0,p2=0; int count; string s2; while(p2 < s1.length()){ //删除全角空格 // if((s1[p2]-0xffffffe3)==0 && // s1[p2+1]-0xffffff80==0 && // s1[p2+2]-0xffffff80==0){//空格

jieba模块基本介绍

jieba模块基本介绍⼀.jieba模块基本介绍1.1 jieba模块的作⽤jieba是优秀的第三⽅中⽂词库中⽂分词(Chinese Word Segmentation) 指的是将⼀个汉字序列切分成⼀个⼀个单独的词。

分词就是将连续的字序列按照⼀定的规范重新组合成词序列的过程1.2 jieba模块的安装pip install jieba #cmd命令⾏⼆.jieba库的使⽤说明2.1 jieba分词的三种模式精确模式:将句⼦最精确的分开,适合⽂本分析(⽆冗余)全模式:句⼦中所有可以成词的词语都扫描出来,速度快,不能解决歧义(有冗余)搜索引擎模式:在精确的基础上,对长词再次切分,提⾼召回率(有冗余)三.jieba分词的使⽤⽅法3.1 三种模式的使⽤⽅法#调⽤jieba词库 import jieba#精确模式jieba.cut(⽂件/⽂本等内容) #获取可迭代对象jieba.lcut()#全模式jieba.cut(cut_all=True) #获取可迭代对象jieba.lcut(cut_all=True)#搜索引擎模式jieba.cut_for_search() # 获取可迭代对象jieba.lcut_for_search()3.2 jieba.cut与jieba.lcut的区别jieba.cut⽣成的是⼀个⽣成器,generator,也就是可以通过for循环来取⾥⾯的每⼀个词。

import jiebatxt = '狗⽐胡晨阳'print(jieba.cut(txt))#打印的内容<generator object Tokenizer.cut at 0x000002004F5B8348>jieba.lcut 直接⽣成的就是⼀个listimport jiebatxt = '狗⽐胡晨阳'print(jieba.lcut(txt))#打印的内容runfile('E:/python项⽬/test.py', wdir='E:/python项⽬')Building prefix dict from the default dictionary ...Loading model from cache C:\Users\ADMINI~1\AppData\Local\Temp\jieba.cache Loading model cost 1.374 seconds.Prefix dict has been built succesfully.['狗', '⽐', '胡晨阳']。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

What’s a word? (Cont.)

Gao Jianfeng defines Chinese words in his paper as one of the following four types:

(1) entries in a lexicon words, (2) morphologically derived words, e.g.研究研究 (3) factoids, e.g.日期、时间、货币, etc

Agenda

Why Segment? Significant Problems, Classic Methods Overview of IRSEG The Mathematics Model Best Path/N-Best Paths Algorithm Unknown Words Ambiguities, Solutions

Agenda

Why Segment? Significant Problems, Classic Methods Overview of IRSEG The Mathematics Model Best Path/N-Best Paths Algorithm Unknown Words Ambiguities, Solutions

W * arg maxw P(W ) P(S | W )

The Mathematics Model (Cont.)

According to Law of Large Number

P( wi ) ki

k

j 0

M

j

ki represents how many times wi appears in samples for training. M represents the total number of words.

Agenda

Why Segment? Significant Problems, Classic Methods Overview of IRSEG The Mathematics Model Best Path/N-Best Paths Algorithm Unknown Words Ambiguities, Solutions

Classic Methods (Cont.)

Shortest-path Method

Find a shortest path in a directed graph of

words. No frequency An Example

的确 他 说 的 2 1 1 确 实 实在 在 5 1 确实 1 在理 6 1 理 7

What’s a word?

Standard

《信息处理现代汉语分词规范》GB13715 汉语信息处理词汇 GB12200[2]

Definition

WORD: 最小的能独立运用的语言单位。[2]

Words for segment: 汉语信息处理使用的、具有

确定的语义或语法功能的基本单位。它包括本规 范的规则限定的词和词组。

1 10 0 5 2 5 2 1 10 8 2 5 2 9 3 7 10 9 3

1 ∞ 6 10 0 2 5 2 1 8 9 3 7 ∞ 9 6 7 7 6 14

9

7 5

8 9

3 7

13 6

7

10

0 5

8

9 9 3 7 6 7 2

0

2

5

5

The Best Path

According to the maximum likelihood model, we add a weight to every edge of the graph with the formula:

The most probable sequence of segmentation

The Mathematics Model (Cont.)

According to the Bayes Formula

W * arg maxw P(W | S )

P(W ) P( S | W ) W * arg maxw P( S )

Chinese Word Segmentation

Liqi Gao, Zhuoran Wang IR Lab, HIT 2003-11-8

Outline

Why Segment? Significant Problems, Classic Methods Overview of IRSEG The Mathematics Model Best Path/N-Best Paths Algorithm Unknown Words Ambiguities, Solutions

(4) named entities,

Agenda

Why Segment? Significant Problems, Classic Methods Overview of IRSEG The Mathematics Model Best Path/N-Best Paths Algorithm Unknown Words Ambiguities, Solutions

The Mathematics Model (Cont.)

Following the maximum likelihood the combined probability is

P(W ) P( wi ) (ki / k j )

i 1 i 1 j 0 m m M

For convenience,

Chinese personal names commonly consist of a

monosyllabic surname followed by a bisyllabic given name.

Ambiguities

Intersecting ambiguity e.g.: 结合成 Combining ambiguity e.g.: 他将来北京

Lw

[ln ( k

i 0 j 0

m

M

j

M ) ln( ki 1)]

Then a Dijkstra algorithm is used to find the best path.

的确 他 0 1 说 2 的 3 确 4 确实 实 5 实在 在 6 在理 理 7

The sequence found is of the maximum probability.

N-Best Paths

An improved best path searching [Zhang 2001]

0

1

1

3 1

4

Classic Methods (Cont.)

Statistical-based MM Expert system based method Neural network based method Hidden Markov Model method Brill transformation based method ……

P * (W ) ln P(W ) ln P( wi ) ln(ki / k j )

i 1

i 1 j 0

m

m

M

(ln k j ln ki )

i 0 j 0

m

M

The Mathematics Model (Cont.)

A statistical-based directed graph

Classic Methods

MM (The Maximum Matching Method) Example: 计算机科学和工程 计算机科学和工 计算机科学和 计算机

Classic Methods (Cont.)

RMM (The reversal directional maximum matching method) [3]

Significant Problems

Dictionary

No dictionary is going to be complete. No dictionary can capture the vocabulary across all

domains.[1]

Unknown names and words

It demands a special dictionary, which is

reversal.

OM (The optimum matching method)

FOM,BOM It optimized the searching time of dictionaries

but the segmenting complexity.

Overview of IRSEG

IRSEG Word Segment of IR Lab

Split Creating Atom a Segment Directed Graph The Best Path

Output

Numerical Unknown Word Ambiguity Word Recogni- Recogni- Section tion tion N-Best Paths

Why Segment?

There are many applications where accurately segmented text is a necessity, or at the very least where it is useful to know where the correct word breaks appear in a text. [1] Information Retrieval Text Processing