CUDA 编程指南

2024版CUDA编程入门极简教程

行划分,每个线程处理一部分数据;任务并行是将任务划分为多个子任

务,每个线程执行一个子任务。

02

共享内存与全局内存

CUDA提供共享内存和全局内存两种存储空间。共享内存位于处理器内

部,访问速度较快,可用于线程间通信;全局内存位于处理器外部,访

问速度较慢,用于存储大量数据。

03

异步执行与流

CUDA支持异步执行,即CPU和GPU可以同时执行不同的任务。通过创

2023

PART 02

CUDA环境搭建与配置

REPORTING

安装CUDA工具包

下载CUDA工具包

01

访问NVIDIA官网,下载适用于您的操作系统的CUDA工具包。

安装CUDA工具包

02

按照安装向导的指示,完成CUDA工具包的安装。

验证安装

03

安装完成后,可以通过运行CUDA自带的示例程序来验证算,每个线 程处理一个子任务。计算完成后, 将结果从设备内存传输回主机内 存,并进行必要的后处理操作。

2023

PART 05

CUDA优化策略与技巧

REPORTING

优化内存访问模式

合并内存访问

通过确保线程访问连续的内存地址,最大化内 存带宽利用率。

使用共享内存

利用CUDA的共享内存来减少全局内存访问, 提高数据重用。

避免不必要的内存访问

精心设计算法和数据结构,减少不必要的内存读写操作。

减少全局内存访问延迟

使用纹理内存和常量内存

利用CUDA的特殊内存类型,如纹理内存和常量内存,来加速数 据访问。

数据预取和缓存

通过预取数据到缓存或寄存器中,减少全局内存访问次数。

展望未来发展趋势

CUDA与深度学习

CUDA编程入门

/*

在GPU上计算PI的程序,要求块数和块内线程数都是2的幂

前一部分为计算block内归约,最后大小为块数

后一部分为单个block归约,最后存储到*pi中。

*/

/*

在GPU上计算PI的程序,要求块数和块内线程数都是2的幂

前一部分为计算block内归约,最后大小为块数

for(int i=0;i<num;i++){

temp=(i+0.5f)/num;

// printf("%f\n",temp);

sum+=4/(1+temp*temp);

// printf("%f\n",sum);

blockIdx, blockIdx也是一个包含三个元素x,y,z的结构体,分别表示当前线程所在块在网格中x,y,z三个方向上的索引;

threadIdx, threadIdx也是一个包含三个元素x,y,z的结构体,分别表示当前线程在其所在块中x,y,z三个方向上的索引;

warpSize,warpSize表明warp的尺寸,在计算能力为1.0的设备中,这个值是24,在1.0以上的idia官方网站(/object/cuda_get_cn.html)上下载对应操作系统的驱动(driver)和工具包(toolkit)。

再次,转换到控制台,命令为Ctrl+Alt+F1/F2/F3/F4,关掉gdm,命令为:sudo /etc/init.d/gdm stop,要确定已经关闭,否则在安装时会提示你有x server程序在运行。

再次,进入driver和toolkit目录,执行安装命令,为了方便,请一定按照默认安装。

CUDA编程指南中文版

CUDA编程指南中文版CUDA架构是基于并行计算的理念,通过利用GPU上的众多计算核心,实现并行计算任务的加速。

而CUDA编程模型则是为了方便开发者利用GPU进行并行计算而设计的,它借鉴了传统的C语言结构,提供了一系列的API供开发者使用。

其中,CUDA内存模型是CUDA编程中一个非常重要的概念。

在GPU中,存在全局内存、共享内存和寄存器等不同的内存空间。

全局内存是GPU中最大的一块内存,用于存储全局变量和数组等数据。

共享内存则是一块高速的本地内存,通过在计算核心之间共享数据,可以显著提高访问效率。

而寄存器则是存储在计算核心内部的一种非常快速的内存空间,用于存储局部变量和寄存器变量等。

在进行CUDA编程时,开发者需要特别关注的一个重点是如何优化CUDA程序。

CUDA编程指南对于CUDA程序的优化提供了详细的说明。

其中包括如何合理的利用GPU的并行计算能力、如何减少全局内存的访问、如何利用共享内存提高数据访问效率等。

通过合理的优化CUDA程序,可以显著提高程序的性能。

除了以上内容,CUDA编程指南还介绍了一些其他有关CUDA的相关技术。

比如,CUDA编程中的流(stream)概念,可以用于控制CUDA函数的执行顺序,有效提高程序的并行性能。

还介绍了GPU内存分配和释放的一些技巧,以及CUDA中的调试工具和性能分析工具等。

总之,CUDA编程指南是CUDA开发者进行CUDA编程时的必备参考资料。

它详细的介绍了CUDA的架构、编程模型、内存模型和优化技术等内容。

通过学习和理解CUDA编程指南,开发者可以更好地利用GPU进行高性能计算,提高程序的性能。

NVIDIACUDA编程指南

NVIDIACUDA编程指南一、CUDA的基本概念1. GPU(Graphics Processing Unit):GPU是一种专门用于图形处理的处理器,但随着计算需求的增加,GPU也被用于进行通用计算。

相比于CPU,GPU拥有更多的处理单元和更高的并行计算能力,能够在相同的时间内处理更多的数据。

2. CUDA核心(CUDA core):CUDA核心是GPU的计算单元,每个核心可以执行一个线程的计算任务。

不同型号的GPU会包含不同数量的CUDA核心,因此也会有不同的并行计算能力。

3. 线程(Thread):在CUDA编程中,线程是最基本的并行计算单元。

每个CUDA核心可以执行多个线程的计算任务,从而实现并行计算。

开发者可以使用CUDA编程语言控制线程的创建、销毁和同步。

4. 线程块(Thread Block):线程块是一组线程的集合,这些线程会被分配到同一个GPU的处理器上执行。

线程块中的线程可以共享数据,并且可以通过共享内存进行通信和同步。

5. 网格(Grid):网格是线程块的集合,由多个线程块组成。

网格提供了一种组织线程块的方式,可以更好地利用GPU的并行计算能力。

不同的线程块可以在不同的处理器上并行执行。

6.内存模型:在CUDA编程中,GPU内存被划分为全局内存、共享内存、寄存器和常量内存等几种类型。

全局内存是所有线程可访问的内存空间,而共享内存只能被同一个线程块的线程访问。

寄存器用于存储线程的局部变量,常量内存用于存储只读数据。

二、CUDA编程模型1.编程语言:CUDA编程语言是一种基于C语言的扩展,可在C/C++代码中嵌入CUDA核函数。

开发者可以使用CUDA编程语言定义并行计算任务、管理线程和内存、以及调度计算任务的执行。

2. 核函数(Kernel Function):核函数是在GPU上执行的并行计算任务,由开发者编写并在主机端调用。

核函数会被多个线程并行执行,每个线程会处理一部分数据,从而实现高效的并行计算。

CUDA C编程权威指南

4 全局内存

4.7 习题

4 全局内存

4.1.1 内存层次结 构的优点

4.1.2 CUDA内存模 型

4.1 CUDA内存模型概述

4.2.1 内 存分配和 释放

4.2.4 零拷贝 内存

4 全局内存

4.2 内存管理

4.2.2 内存传 输

4.2.5 统一虚 拟寻址

4.2.3 固定内 存

4.2.6 统一内 存寻址

6.3.2 使用 广度优先调 度重叠

6.3 重叠内核执行和数据传输

08

7 调整指令级原语

7 调整指令级原语

01

02

03

04

7.1 CUDA 7.2 程序 7.3 总结 7.4 习题 指令概述 优化指令

7 调整指令级原语

7.1.1 浮点指令

A

7.1.2 内部函数和标 准函数

B

7.1.3 原子操作指令

10

9 多GPU编程

9 多GPU编程

9.1 从一个GPU到多GPU 9.3 多GPU上的点对点通

信 9.5 跨GPU集群扩展应用

程序

9.2 多GPU间细分计算 9.4 多GPU上的有限差分

9.6 总结

9 多GPU编程

9.7 习题

9 多GPU编程

9.1.1 在多GPU上执 行

A

9.1.2 点对点通信

配

03

5.1.3 共享 内存存储体 和访问模式

04

5.1.4 配 置共享内

存量

05

5.1.5 同 步

5.1 CUDA共享内存概述

5 共享内存和常量内存

5.2.1 方形共享 内存

A

5.2.2 矩形共享 内存

CUDA 编程与调试指南说明书

A n d D e b ug g i ngCUDA Programming on the Tegra Xavier-BY KRISTOFFER ROBIN STOKKEKeep This Under Your Pillow q Volta Tuning Guidel https:///cuda/archive/10.2/volta-tuning-guide/index.html q CUDA Programmer’s Guideq https:///cuda/archive/10.2/cuda-c-programming-guide/index.html q CUDA for Tegraq https:///cuda/archive/10.2/cuda-for-tegra-appnote/index.htmlq Tegra X1 Whitepaperq https:///blog/nvidia-jetson-agx-xavier-32-teraops-ai-robotics/ q Last but not leastq CUDA-GDBq You will need itq NVPROF –if you care about performanceq https:///cuda/archive/10.2/profiler-users-guide/index.htmlTegra Xavier vs.Tegra X1Tegra Xavier Tegra X1High Performance CPU8 x Carmel 2 MB L2 +128 kB $I, 64 kB $D 4 x Cortex-A57 2 MB L2 +48 kB $I, 32 kB $DLow Power CPU None 4 x Cortex-A53512 kB L2 +32 kB $I/$D Architecture Volta MaxwellCores512 Cores (8 Volta SM)256 Cores (2 SMM, 128 Cores / SMM) Memory bitwidth256-bit64-bitL2 cache512 kB256 kBL1 cache128 kB (shared memory + L1 RO cache)•64 kB (unique shared memory)•64 kB read-only cacheGPU Compute CapabilityCompute Capability Generation1.x Tesla2.x Fermi3.x Kepler (Tegra K1)4.x5.x Maxwell (Tegra X1)6.x Pascal (Tegra X2)7.x (7.2)Volta (Tegra Xavier)7.5Turing8.x Ampere You are here•«The functional development of GPUs»•For Maxwell:•Half-precision (16-bit) floating point•Dynamic parallelism•Kernels can launch kernels•Newest CC•Tensor Core (neural network support)•CUDA Toolkits•Compiler, doc, examples etc•nvcc–version•Already installed for you•If interested:•https:///wiki/CUDAParallelism in GPUs •Massive.•Volta SM –Volta Streaming Multiprocessor •Four Warp Schedulers(WS)•4 x 16 CUDA cores•4 x 8 LD/ST units, ~16k 32-bit registers•4 x 4 Special Function Units (SFUs)•8 Tensor CoresGroup of 32 threads •128 kB shared memory*•At every clock cycle..•Each WS selects an eligible warp..•.. and dispatches two instructions•All threads should follow, more or less, thesame execution pathVolta GPU Memories§256-bit RAM interface§512kB, GPU-global L2 cache§Shared between all Volta SMs§128 kB, read-only L1 cache/ shared memory §Shared texture/ local l1 cache§Local to the SM§SM-local L1 cache§Directly addressable through sharedmemory§Local to the SM§Registers FasterThisWay§A flexible, multi-layered cache hierarchy§Improves memory bandwidth§WS selects ready (non-stalling warps)§Highly programmableGPU Memories (Continued)§The CUDA toolkit documentation introduces the following memory spaces and naming conventions..§Global memory loads: Loads from RAM, possibly through caches§«Local memory»: Register spills, code, and other§Resides in RAM or «somewhere» in the cache hierarchy, hopefully in the right place§«Shared memory»: RW L1 cache shared in a thread block§«L1 RO cache»: Cache global, read-only memory loadsCUDA Programmer’s Perspectiveq Schedule blocks of threads (execution configuration syntax )q WS schedules eligible 32-thread groups of blocksFrom CUDA Programmer’s guide.__global__ void memcpy( uint32_t * src, uint32_t * dst) {...}void main(void){dim3 block_dim(1024, 1, 1);dim3 grid_dim(1024, 1, 1);uint32_t *src, *dst;memcpy<<<grid_dim, block_dim, 0, 0>>(src, dst);...}Shared memory per blockCuda stream (default 0)CUDA Programmer’s Perspective (Cont.)__global__ void memcpy( uint32_t * src, uint32_t * dst) {int idx;idx = threadIdx.x + ( blockIdx.x * blockDim.x );dst[idx] = src[idx];return;}q Special purpose registersq threadIdx.[x/y/z] -> block index coords q blockIdx.[x/y/z] -> grid index coords q blockDim.[x/y/z] -> grid dimension sizesq In example:q blockDim.x = 1024, blockIdx.x \in [0, 1023]q Index into contiguous memorySynchronisationq ECS kernel_symbol_name<<< gridDim, blkDim, shared, stream>>> ( __VA_ARGS__ ) q Kernel launches are always asynchronousq Executing thread immediately returnsq«Worst» sync: cudaDeviceSynchronise()q Blocks until all pending GPU activity is doneq However good for debugging / testing purposesq Streamsq Streams created with cudaStreamCreate()-> + flags!q Run kernel launches and asynchronous memory copies in streamsq Sync on streams with cudaStreamSynchronize( stream)Other API Specific Detailsq Two APISq Driver APIq Runtime API <-use this(https:///cuda/archive/10.2/cuda-runtime-api/index.html) q Other modules you should have a look atq Device managementq Error handlingq Memory management, unified addressingq CUDA samples: deviceQueryq CUDA Compiler: nvccq Source files with CUDA code(*.cu) are compiled as .cpp filesq nvcc extracts CUDA code, passes rest to native c++compilerWhen Things Aren’t Going Your Way q Cuda-gdbq Just like gdbq Main advantage: captures error conditions for youq But this doesn’t mean you can get lazyq Always check error codes and break on anything != cudaSuccessq Make a macroGPU Performance Analysisq CUPTI: GPU Hardware Performance Counters (HPCs)q Usage: nvprof –e <event counters> -m <metrics> <binary> <arguments>q Summary modes, counter collection modes....q Tells you about resource usage –time, memory, floating point performance, elapsed cycles q Takes time to profile –be patient or use ./c63enc –f 5 <-make sure to trigger ME & MCq Check HPC availability with nvprof –query-events –query-metricsq Notice there are well above 100 HPCs to choose from..q...which ones matter?q I will tell you! J J JGPU Performance Analysis (Continued) q Memory usageq L1_global_load_hit, l1_local_{store/load}_hit, l1_shared_{store/load}_transactions, shared_efficiency q Instructionsq Inst_integer, inst_bit_convert, inst_control, inst_misc, inst_fp_{16/32/64}q Causes of stallingq Memory, instruction dependencies, sync...q Otherq Elapsed_cycles_smq These are for the TK1, but should be at least similar for TX1q Don’t get confused by HPCs such as {gld/gst}_throughputCode Examples。

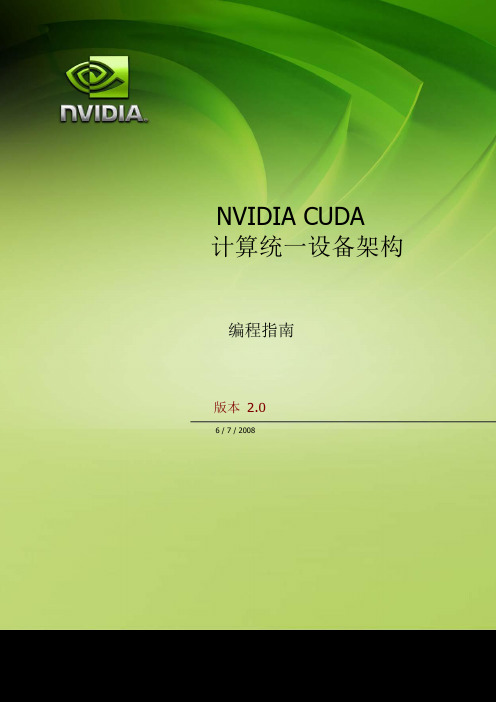

CUDA编程指南

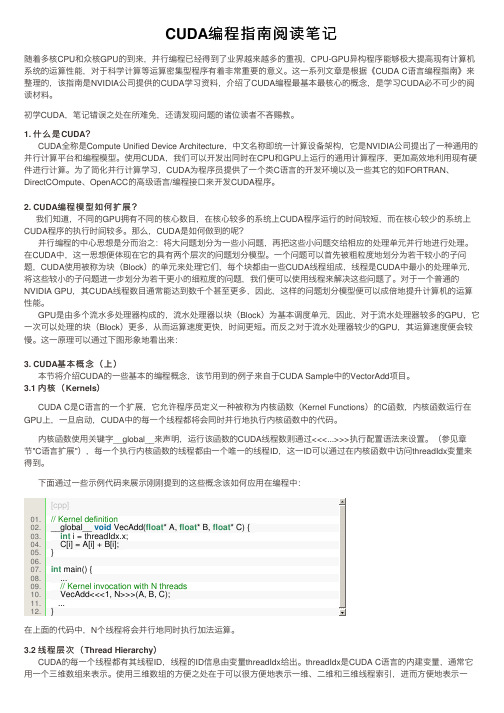

NVIDIA CUDA计算统一设备架构编程指南版本 2.06 /7 / 2008目录第 1 章简介 (1)1.1 CUDA:可伸缩并行编程模型 (1)1.2 GPU:高度并行化、多线程、多核处理器 (1)1.3 文档结构 (3)第2章编程模型 (4)2.1 线程层次结构 (4)2.2 存储器层次结构 (6)2.3 主机和设备 (6)2.4 软件栈 (7)2.5 计算能力 (8)第 3 章GPU 实现 (9)3.1 具有芯片共享存储器的一组SIMT 多处理器 (9)3.2 多个设备 (11)3.3 模式切换 (11)第 4 章应用程序编程接口 (12)4.1 C 编程语言的扩展 (12)4.2 语言扩展 (12)4.2.1 函数类型限定符 (12)4.2.1.1 _device_ (12)4.2.1.2 _global_ (13)4.2.1.3 _host_ (13)4.2.1.4 限制 (13)4.2.2 变量类型限定符 (13)4.2.2.1 _device_ (13)4.2.2.2 _constant_ (13)4.2.2.3 _shared_ (14)4.2.2.4 限制 (14)4.2.3 执行配置 (15)4.2.4 内置变量 (15)4.2.4.1 gridDim (15)4.2.4.2 blockIdx (15)4.2.4.3 blockDim (15)4.2.4.4 threadIdx (15)4.2.4.5 warpSize (16)4.2.4.6 限制 (16)4.2.5 使用NVCC 进行编译 (16)4.2.5.1 _noinline_ (16)4.2.5.2 #pragma unroll (16)4.3 通用运行时组件 (17)4.3.1 内置向量类型 (17)4.3.1.1 char1、uchar1、char2、uchar2、char3、uchar3、char4、uchar4、short1、ushort1、short2、ushort2、short3、ushort3、short4、ushort4、int1、uint1、int2、uint2、int3、uint3、int4、uint4、long1、ulong1、long2、ulong2、long3、ulong3、long4、ulong4、float1、float2、float3、float4、double2 (17)4.3.1.2 dim3 类型 (17)4.3.2 数学函数 (17)4.3.3 计时函数 (17)4.3.4 纹理类型 (18)4.3.4.1 纹理参考声明 (18)4.3.4.2 运行时纹理参考属性 (18)4.3.4.3 来自线性存储器的纹理与来自CUDA 数组的纹理 (19)4.4 设备运行时组件 (19)4.4.1 数学函数 (19)4.4.2 同步函数 (19)4.4.3 纹理函数 (19)4.4.3.1 来自线性存储器的纹理 (19)4.4.3.2 来自CUDA 数组的纹理 (20)4.4.4 原子函数 (20)4.4.5 warp vote 函数 (20)4.5 主机运行时组件 (21)4.5.1 一般概念 (21)4.5.1.1 设备 (21)4.5.1.2 存储器 (22)4.5.1.3 OpenGL 互操作性 (22)4.5.1.4 Direct3D 互操作性 (22)4.5.1.5 异步并发执行 (22)4.5.2 运行时API (23)4.5.2.1 初始化 (23)4.5.2.2 设备管理 (23)4.5.2.3 存储器管理 (24)4.5.2.4 流管理 (25)4.5.2.5 事件管理 (25)4.5.2.6 纹理参考管理 (25)4.5.2.7 OpenGL 互操作性 (27)4.5.2.8 Direct3D 互操作性 (27)4.5.2.9 使用设备模拟模式进行调试 (28)4.5.3 驱动程序API (29)4.5.3.1 初始化 (29)4.5.3.2 设备管理 (29)4.5.3.3 上下文管理 (29)4.5.3.4 模块管理 (30)4.5.3.5 执行控制 (30)4.5.3.6 存储器管理 (31)4.5.3.7 流管理 (32)4.5.3.8 事件管理 (32)4.5.3.9 纹理参考管理 (33)4.5.3.10 OpenGL 互操作性 (33)4.5.3.11 Direct3D 互操作性 (33)第 5 章性能指南 (35)5.1 指令性能 (35)5.1.1 指令吞吐量 (35)5.1.1.1 数学指令 (35)5.1.1.2 控制流指令 (36)5.1.1.3 存储器指令 (36)5.1.1.4 同步指令 (37)5.1.2 存储器带宽 (37)5.1.2.1 全局存储器 (37)5.1.2.2 本地存储器 (43)5.1.2.3 固定存储器 (43)5.1.2.4 纹理存储器 (43)5.1.2.5 共享存储器 (43)5.1.2.6 寄存器 (48)5.2 每个块的线程数量 (49)5.3 主机和设备间的数据传输 (49)5.4 纹理获取与全局或固定存储器读取的对比 (50)5.5 整体性能优化战略 (50)第 6 章矩阵乘法示例 (52)6.1 概述 (52)6.2 源代码清单 (53)6.3 源代码说明 (54)6.3.1 Mul() (54)6.3.2 Muld() (54)附录A 技术规范 (56)A.1 一般规范 (56)A.1.1 计算能力1.0 的规范 (56)A.1.2 计算能力1.1 的规范 (57)A.1.3 计算能力1.2 的规范 (57)A.1.4 计算能力1.3 的规范 (57)A.2 浮点标准 (57)附录B 标准数学函数 (59)B.1 一般运行时组件 (59)B.1.1 单精度浮点函数 (59)B.1.2 双精度浮点函数 (60)B.1.3 整型函数 (62)B.2 设备运行时组件 (62)B.2.1 单精度浮点函数 (62)B.2.2 双精度浮点函数 (63)B.2.3 整型函数 (64)附录C 原子函数 (65)C.1 数学函数 (65)C.1.1 atomicAdd() (65)C.1.2 atomicSub() (65)C.1.3 atomicExch() (65)C.1.4 atomicMin() (65)C.1.5 atomicMax() (66)C.1.6 atomicInc() (66)C.1.7 atomicDec() (66)C.1.8 atomicCAS() (66)C.2 位逻辑函数 (66)C.2.1 atomicAnd() (66)C.2.2 atomicOr() (67)C.2.3 atomicXor() (67)附录D 纹理获取 (68)D.1 最近点取样 (68)D.2 线性过滤 (69)D.3 表查找 (69)图表目录图1-1. CPU 和GPU 的每秒浮点运算次数和存储器带宽图1-2. GPU 中的更多晶体管用于数据处理...... .............. .......... .............. .............. (2)图2-1. 线程块网格.......................................... ....... ..................... (5)图2-2. 存储器层次结构................................. .............. . (6)图2-3. 异构编程............................................... .............. .............. .............. (7)图2-4. 计算统一设备架构软件栈................ .............. .............. .............. .. .. (8)图3-1. 硬件模型................................................................... .............. . (10)图4-1. 库上下文管理......................................................... .............. ....... ......... (30)图5-1. 接合后的存储器访问模式示例................... .............. .............. .............. .............. . (39)图5-2. 未为计算能力是 1.0 或1.1 的设备接合的全局存储器访问模式示例 (40)图5-3. 未为计算能力是 1.0 或1.1 的设备接合的全局存储器访问模式示例 (41)图5-4. 计算能力为 1.2 或更高的设备的全局存储器访问示例..... .............. ............ .. .. (42)图5-5. 无存储体冲突的共享存储器访问模式示例... .............. .............. .............. .............. (45)图5-6. 无存储体冲突的共享存储器访问模式示例... .............. .............. .............. .............. (46)图5-7. 有存储体冲突的共享存储器访问模式示例......... .............. .............. .............. (47)图5-8. 使用广播机制的共享存储器读取访问模式示例... .............. .............. .............. (48)图6-1. 矩阵乘法........................................................... .............. .............. (52)第 1 章简介1.1 CUDA:可伸缩并行编程模型多核CPU 和多核GPU 的出现意味着并行系统已成为主流处理器芯片。

cuda编程 c语言

cuda编程c语言摘要:1.CUDA 编程概述2.CUDA 与C 语言的关系3.CUDA 编程的基本步骤4.CUDA 编程的实例分析5.总结正文:【CUDA 编程概述】CUDA(Compute Unified Device Architecture)是NVIDIA 推出的一种通用并行计算架构,旨在利用GPU 的强大计算能力进行高性能计算。

CUDA 编程就是利用CUDA 架构进行编程,可以实现在NVIDIA GPU 上运行C 语言、C++等语言编写的程序。

【CUDA 与C 语言的关系】CUDA 是基于C 语言的编程模型,也就是说,CUDA 编程主要使用C 语言进行编写。

CUDA 提供了一系列C 语言的扩展,这些扩展使得C 语言能够更好地支持并行计算,从而在GPU 上实现高效的计算。

【CUDA 编程的基本步骤】进行CUDA 编程,一般需要遵循以下步骤:1.安装CUDA SDK:首先需要在开发环境中安装CUDA SDK,包括CUDA Toolkit、CUDA C/C++ Compiler 等。

2.编写CUDA 代码:使用C 语言编写CUDA 代码,需要使用CUDA提供的扩展,如__global__、__shared__等。

3.编译CUDA 代码:使用CUDA C/C++ Compiler 编译CUDA 代码,生成.ptx 文件。

4.运行CUDA 程序:将.ptx 文件加载到GPU 上,使用NVIDIA 驱动程序运行CUDA 程序。

【CUDA 编程的实例分析】以一个简单的矩阵乘法为例,展示CUDA 编程的基本过程:1.编写CUDA 代码:```c#include <iostream>#include <cuda_runtime.h>#define N 100__global__ void matrix_multiply(int *A, int *B, int *C, int N) { int i = blockIdx.x * blockDim.x + threadIdx.x;if (i < N) {C[i] = A[i] * B[i];}}int main() {int A[N][N], B[N][N], C[N][N];for (int i = 0; i < N; i++) {for (int j = 0; j < N; j++) {A[i][j] = i * j;B[i][j] = i + j;}}int *A_gpu, *B_gpu, *C_gpu;cudaMalloc((void**)&A_gpu, N * N * sizeof(int));cudaMalloc((void**)&B_gpu, N * N * sizeof(int));cudaMalloc((void**)&C_gpu, N * N * sizeof(int));cudaMemcpy(A_gpu, A, N * N * sizeof(int), cudaMemcpyHostToDevice);cudaMemcpy(B_gpu, B, N * N * sizeof(int), cudaMemcpyHostToDevice);matrix_multiply<<<1, N>>>(A_gpu, B_gpu, C_gpu, N);cudaMemcpy(C, C_gpu, N * N * sizeof(int), cudaMemcpyDeviceT oHost);for (int i = 0; i < N; i++) {for (int j = 0; j < N; j++) {std::cout << C[i][j] << " ";}std::cout << std::endl;}cudaFree(A_gpu);cudaFree(B_gpu);cudaFree(C_gpu);return 0;}```2.编译CUDA 代码:使用CUDA C/C++ Compiler 编译上述代码,生成matrix_multiply.ptx 文件。

cuda并行编程指南 pdf

cuda并行编程指南 pdfCUDA并行编程指南PDF是一份介绍CUDA并行编程的电子书。

编写该书的目的是为了帮助读者理解CUDA技术,掌握CUDA编程技巧,以更好地开发并行计算应用程序。

本文将从以下三个方面介绍并分析该电子书。

一、《CUDA并行编程指南PDF》的主要内容该电子书共分为七章,内容涵盖CUDA编程的方方面面,从基础概念到高级技巧,从基本语法到优化策略,全面深入地介绍了CUDA并行编程的核心要点。

具体内容如下:第一章:介绍CUDA编程的背景和基本概念,探究CUDA在并行计算中的优势和应用场景。

第二章:介绍CUDA编程的基本语法,包括CUDA核函数的定义、调用、线程块和网格的概念、内存管理等。

第三章:介绍了CUDA的并行模型和编程范式,包括线程同步、原子操作、共享内存等,并通过编写程序实践了这些概念。

第四章:介绍CUDA的高级主题,包括文本处理、图像和视频处理、线程块和网格的优化策略等。

第五章:介绍了CUDA的性能优化策略,包括内存访问优化、处理器调度和优化、算法优化等。

第六章:介绍CUDA在数值计算中的应用,具体包括矩阵运算、积分、微分、求解微分方程等。

第七章:介绍如何使用CUDA进行机器学习计算和深度学习计算,包括神经网络的训练、卷积神经网络的实现、循环神经网络的实现等。

二、电子书的特点1. 系统性强:从基本概念到高级技巧全面介绍CUDA并行编程的要点,具备很强的系统性和完整性,对读者来说很有价值。

2. 实践性强:每一章都包含了实例程序,通过具体代码实践帮助读者理解CUDA编程技术,学习也更加高效。

3. 详细讲解:每一个概念和技术点都有详细的解释和讲解,避免了读者在编写程序时的盲目性和困惑,使读者更加深入地理解了CUDA技术。

三、《CUDA并行编程指南PDF》的应用CUDA并行编程玩家可以使用本书进行学习和实践,尤其适合广大CUDA编程初学者。

CUDA已经成为了众多科学工作者的重要工具之一,其已经不仅仅是在图像处理方面发挥作用,而是在金融、物理、生物、气象等各个领域中都有着广泛的应用。

visual studio cuda 程序编译

visual studio cuda 程序编译CUDA 是 NVIDIA 提供的一种并行计算平台和编程模型,它允许开发者使用 C/C++ 和 FORTRAN 语言进行 GPU 加速计算。

Visual Studio 是微软开发的一款集成开发环境,它支持多种编程语言,并提供了丰富的工具和功能,使得开发者可以更加高效地进行软件开发。

本文将介绍如何使用 Visual Studio 编译 CUDA 程序。

一、安装 Visual Studio首先,你需要安装 Visual Studio。

可以从微软官网下载并安装适合你操作系统的版本。

安装完成后,打开 Visual Studio,确保CUDA 工具包已经正确安装。

二、创建 CUDA 项目打开 Visual Studio,选择“新建项目”->“Visual C++”->“CUDA”,选择适合你的项目类型和配置,例如“CUDA C/C++ 控制台应用程序”。

为项目命名并设置路径,点击“创建”。

三、编写 CUDA 代码在项目中添加你的 CUDA 代码文件。

你可以直接在 Visual Studio 中编写 CUDA 代码,或者使用支持 CUDA 的文本编辑器编写代码后,将其复制到 Visual Studio 中。

四、配置编译选项在“解决方案资源管理器”中,右键单击项目名称,选择“属性”。

在“配置属性”->“VC++ 目录”中,确保包含了正确的 CUDA 头文件和库文件路径。

在“构建”选项卡中,勾选“CUDA 调试”和“生成可执行文件时生成 DWARF 数据文件”。

这将会在编译过程中生成调试信息,便于调试。

五、编译 CUDA 程序点击“生成”->“生成解决方案”来编译项目。

如果编译过程中没有错误,即可生成可执行文件。

六、运行 CUDA 程序运行可执行文件,观察其运行结果是否符合预期。

如果遇到问题,请检查 CUDA 代码和配置是否正确,并参考相关文档和论坛寻求帮助。

CUDA编程上手指南(一):CUDAC编程及GPU基本知识

CUDA编程上⼿指南(⼀):CUDAC编程及GPU基本知识本系列是为了弥补教程和实际应⽤之间的空⽩,帮助⼤家理解 CUDA 编程并最终熟练使⽤ CUDA 编程。

你不需要具备 OpenGL 或者DirectX 的知识,也不需要有计算及图形学的背景。

⽬录1 CPU 和 GPU 的基础知识2 CUDA 编程的重要概念3 并⾏计算向量相加4 实践4.1 向量相加 CUDA 代码4.2 实践向量相加5 给⼤家的⼀点参考资料1 CPU 和 GPU 的基础知识提到处理器结构,有2个指标是经常要考虑的:延迟和吞吐量。

所谓延迟,是指从发出指令到最终返回结果中间经历的时间间隔。

⽽所谓吞吐量,就是单位之间内处理的指令的条数。

下图1是 CPU 的⽰意图。

从图中可以看出 CPU 的⼏个特点:1. CPU 中包含了多级⾼速的缓存结构。

因为我们知道处理运算的速度远⾼于访问存储的速度,那么奔着空间换时间的思想,设计了多级⾼速的缓存结构,将经常访问的内容放到低级缓存中,将不经常访问的内容放到⾼级缓存中,从⽽提升了指令访问存储的速度。

2. CPU 中包含了很多控制单元。

具体有2种,⼀个是分⽀预测机制,另⼀个是流⽔线前传机制。

3. CPU 的运算单元 (Core) 强⼤,整型浮点型复杂运算速度快。

图1:CPU 的⽰意图所以综合以上三点,CPU 在设计时的导向就是减少指令的时延,我们称之为延迟导向设计,如下图3所⽰。

下图2是 GPU 的⽰意图,它与之前 CPU 的⽰意图相⽐有着⾮常⼤的不同。

从图中可以看出 GPU 的⼏个特点 (注意紫⾊和黄⾊的区域分别是缓存单元和控制单元):1. GPU 中虽有缓存结构但是数量少。

因为要减少指令访问缓存的次数。

2. GPU 中控制单元⾮常简单。

控制单元中也没有分⽀预测机制和数据转发机制。

对于复杂的指令运算就会⽐较慢。

3. GPU 的运算单元 (Core) ⾮常多,采⽤长延时流⽔线以实现⾼吞吐量。

每⼀⾏的运算单元的控制器只有⼀个,意味着每⼀⾏的运算单元使⽤的指令是相同的,不同的是它们的数据内容。

(2024年)CUDA教程新手入门学编程

管理、并行计算等关键技能。

图像处理算法并行化

02

学习如何将图像处理算法进行并行化设计,以便在GPU上实现

高效处理。

CUDA优化技巧

03

了解CUDA编程中的优化技巧,如内存访问优化、线程同步等

,以提高图像处理程序的性能。

21

效果展示与性能对比

效果展示

性能分析

案例分享

将基于CUDA实现的图像处理 程序与常规CPU处理程序进行 对比,展示其在处理速度、效 果等方面的优势。

内存管理

合理利用CUDA的内存层次结构,如全局内存、 共享内存和寄存器,以提高程序性能。

优化同步

避免不必要的线程同步,减少等待时间,提高并 行计算效率。

ABCD

2024/3/26

并行化策略

设计高效的并行算法,利用CUDA的多线程并行 计算能力,加速程序运行。

错误处理

编写健壮的错误处理代码,确保程序在出现异常 时能够正确处理。

配置开发环境

在安装CUDA工具包后,需要配 置开发环境,包括设置环境变量 、添加库文件路径等。这些配置 可以确保在编译和运行CUDA程 序时能够找到正确的库和工具。

2024/3/26

选择合适的IDE

为了方便编写和调试CUDA程序 ,可以选择一个合适的集成开发 环境(IDE),如NVIDIA Nsight 、Visual Studio等。这些IDE提 供了丰富的功能和工具,可以提 高开发效率。

2024/3/26

04

使用共享内存来减少访存延迟。

05

对数据进行合理的划分和排布,以减少数据传输的开销。

06

使用CUDA提供的数学库函数(如cublas、cusparse等) 来加速计算。

NVIDIACUDA编程指南

NVIDIACUDA编程指南引言:CUDA编程模型:CUDA编程模型是一种基于主机-设备计算模式的编程范式。

在CUDA 编程中,主机(CPU)将计算任务分配给设备(GPU)来执行,并通过主机和设备之间的数据传输来协调计算过程。

CUDA编程模型包括两个关键概念:主机代码和设备代码。

主机代码是在主机上执行的代码,通常由CPU执行。

主机代码用于控制计算过程,包括任务的创建、数据的传输和设备的管理。

主机代码使用CUDA API(Application Programming Interface)来与设备进行交互。

设备代码是在设备上执行的代码,通常由GPU执行。

设备代码是并行的,可以同时执行多个线程来进行计算。

设备代码使用CUDA核函数(Kernel)来定义并行任务,并由设备上的线程执行。

CUDA编程的基本步骤:1.初始化CUDA环境:首先,需要初始化CUDA环境,包括选择合适的设备、创建CUDA上下文等。

可以使用CUDAAPI来完成这些操作。

2.分配和传输数据:在进行计算之前,需要将数据从主机内存传输到设备内存。

可以使用CUDAAPI中的内存管理函数来分配和传输数据。

4.处理计算结果:核函数在设备上执行完毕后,可以将计算结果传输回主机内存。

可以使用CUDAAPI中的数据传输函数来完成这一步骤。

5.清理CUDA环境:最后,需要清理CUDA环境,包括释放设备内存、销毁CUDA上下文等。

同样,可以使用CUDAAPI来完成这些操作。

CUDA编程的优势和应用领域:CUDA编程具有以下优势:1.高性能:利用GPU进行并行计算可以显著提高计算性能,特别是在需要处理大量数据的科学计算、数据分析和机器学习等领域。

2.灵活性:CUDA编程提供了丰富的工具和库,可以方便地开发各种类型的并行计算应用,包括图像处理、物理模拟、信号处理等。

3.可移植性:由于CUDA是一种通用的并行计算平台,可以在不同的硬件平台上进行开发和使用。

NVIDIA还提供了一套CUDA工具链,可以方便地将CUDA代码移植到不同的平台上。

CUDA C++ 编程指南版本12.0 NVIDIA 2023年2月21日说明书

Just-in-Time Compilation . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 22

6.1.2 Binary Compatibility . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 22

5.3 Memory Hierarchy . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 16

5.4 Heterogeneous Programming . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 17

6.1.1 Compilation Workflow . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 22

Offline Compilation . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 22

6.2.8 Asynchronous Concurrent Execution . . . . . . . . . . . . . . . . . . . . . . . . . . . . 45 Concurrent Execution between Host and Device . . . . . . . . . . . . . . . . . . . . . 46 Concurrent Kernel Execution . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 46 Overlap of Data Transfer and Kernel Execution . . . . . . . . . . . . . . . . . . . . . . 47 Concurrent Data Transfers . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 47 Streams . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 47 Creation and Destruction . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 47 Default Stream . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 48 Explicit Synchronization . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 49 Implicit Synchronization . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 49 Overlapping Behavior . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 49 Host Functions (Callbacks) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 50 Stream Priorities . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 51 Programmatic Dependent Launch and Synchronization . . . . . . . . . . . . . . . . . 51 Background . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 51 API Description . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 52 CUDA Graphs . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 53 Graph Structure . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 54 Creating a Graph Using Graph APIs . . . . . . . . . . . . . . . . . . . . . . . . . 55 Creating a Graph Using Stream Capture . . . . . . . . . . . . . . . . . . . . . . 56 Updating Instantiated Graphs . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 58 Using Graph APIs . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 61 Device Graph Launch . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 62 Events . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 69 Creation and Destruction . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 69 Elapsed Time . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 70 Synchronous Calls . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 70

2024版CUDA编程指南30中文版pdf

CUDA编程指南30中文版pdf目录CATALOGUE•CUDA 概述与基础•内存管理与数据传输•线程同步与并发控制•CUDA 核函数设计与优化•多GPU 编程技术探讨•CUDA 在图像处理中的应用•总结与展望01CATALOGUE CUDA概述与基础CUDA(Compute Unified Device Architecture)是NVIDIA推出的并行计算平台和API模型,允许开发者使用NVIDIA GPU进行通用计算。

CUDA的发展历程始于2006年,当时NVIDIA发布了CUDA的第一个版本,为开发者提供了一种利用GPU进行高性能计算的新途径。

随着CUDA的不断发展,其应用领域逐渐扩展,包括科学计算、数据分析、深度学习、图形处理等多个领域。

CUDA定义及发展历程GPU(Graphics Processing Unit)架构是CUDA的基础,CUDA利用GPU中的并行处理单元进行高性能计算。

CUDA编程模型针对GPU架构进行了优化,使得开发者能够充分利用GPU的计算能力,提高程序的执行效率。

随着GPU架构的不断发展,CUDA也在不断升级和改进,以适应新的硬件特性和性能需求。

010203 GPU架构与CUDA关系编程模型及基本概念01CUDA编程模型包括主机端(Host)和设备端(Device)两部分,其中主机端负责逻辑控制和数据传输,设备端负责并行计算。

02CUDA中的基本概念包括线程(Thread)、线程块(Block)、网格(Grid)等,这些概念构成了CUDA的并行计算模型。

03开发者需要了解这些基本概念及其之间的关系,以便编写高效的CUDA程序。

开发环境搭建与配置01搭建CUDA开发环境需要安装CUDA工具包(Toolkit)和相应的驱动程序。

02配置开发环境时需要注意操作系统、编译器等软件的兼容性问题。

03在配置过程中可能遇到的一些问题包括驱动不兼容、编译错误等,需要仔细检查和调试。

CUDA C++编程指南设计指南说明书

Design GuideChanges from Version 11.0‣Added documentation for Compute Capability 8.x.‣Updated section Arithmetic Instructions for compute capability 8.6.‣Updated section Features and Technical Specifications for compute capability 8.6.Table of Contents Chapter 1. Introduction (1)1.1. The Benefits of Using GPUs (1)1.2. CUDA®: A General-Purpose Parallel Computing Platform and Programming Model (2)1.3. A Scalable Programming Model (3)1.4. Document Structure (5)Chapter 2. Programming Model (7)2.1. Kernels (7)2.2. Thread Hierarchy (8)2.3. Memory Hierarchy (10)2.4. Heterogeneous Programming (11)2.5. Compute Capability (14)Chapter 3. Programming Interface (15)3.1. Compilation with NVCC (15)3.1.1. Compilation Workflow (16)3.1.1.1. Offline Compilation (16)3.1.1.2. Just-in-Time Compilation (16)3.1.2. Binary Compatibility (17)3.1.3. PTX Compatibility (17)3.1.4. Application Compatibility (17)3.1.5. C++ Compatibility (18)3.1.6. 64-Bit Compatibility (18)3.2. CUDA Runtime (19)3.2.1. Initialization (19)3.2.2. Device Memory (20)3.2.3. Device Memory L2 Access Management (23)3.2.3.1. L2 cache Set-Aside for Persisting Accesses (23)3.2.3.2. L2 Policy for Persisting Accesses (23)3.2.3.3. L2 Access Properties (25)3.2.3.4. L2 Persistence Example (25)3.2.3.5. Reset L2 Access to Normal (26)3.2.3.6. Manage Utilization of L2 set-aside cache (27)3.2.3.7. Query L2 cache Properties (27)3.2.3.8. Control L2 Cache Set-Aside Size for Persisting Memory Access (27)3.2.4. Shared Memory (27)3.2.5. Page-Locked Host Memory (33)3.2.5.1. Portable Memory (33)3.2.5.2. Write-Combining Memory (33)3.2.5.3. Mapped Memory (34)3.2.6. Asynchronous Concurrent Execution (35)3.2.6.1. Concurrent Execution between Host and Device (35)3.2.6.2. Concurrent Kernel Execution (35)3.2.6.3. Overlap of Data Transfer and Kernel Execution (36)3.2.6.4. Concurrent Data Transfers (36)3.2.6.5. Streams (36)3.2.6.6. CUDA Graphs (40)3.2.6.7. Events (48)3.2.6.8. Synchronous Calls (49)3.2.7. Multi-Device System (49)3.2.7.1. Device Enumeration (49)3.2.7.2. Device Selection (50)3.2.7.3. Stream and Event Behavior (50)3.2.7.4. Peer-to-Peer Memory Access (51)3.2.7.5. Peer-to-Peer Memory Copy (51)3.2.8. Unified Virtual Address Space (52)3.2.9. Interprocess Communication (52)3.2.10. Error Checking (53)3.2.11. Call Stack (54)3.2.12. Texture and Surface Memory (54)3.2.12.1. Texture Memory (54)3.2.12.2. Surface Memory (63)3.2.12.3. CUDA Arrays (66)3.2.12.4. Read/Write Coherency (66)3.2.13. Graphics Interoperability (66)3.2.13.1. OpenGL Interoperability (67)3.2.13.2. Direct3D Interoperability (69)3.2.13.3. SLI Interoperability (74)3.2.14. External Resource Interoperability (75)3.2.14.1. Vulkan Interoperability (75)3.2.14.2. OpenGL Interoperability (83)3.2.14.3. Direct3D 12 Interoperability (83)3.2.14.4. Direct3D 11 Interoperability (89)3.2.14.5. NVIDIA Software Communication Interface Interoperability (NVSCI) (96)3.3. Versioning and Compatibility (100)3.5. Mode Switches (102)3.6. Tesla Compute Cluster Mode for Windows (103)Chapter 4. Hardware Implementation (104)4.1. SIMT Architecture (104)4.2. Hardware Multithreading (106)Chapter 5. Performance Guidelines (107)5.1. Overall Performance Optimization Strategies (107)5.2. Maximize Utilization (107)5.2.1. Application Level (107)5.2.2. Device Level (108)5.2.3. Multiprocessor Level (108)5.2.3.1. Occupancy Calculator (110)5.3. Maximize Memory Throughput (111)5.3.1. Data Transfer between Host and Device (112)5.3.2. Device Memory Accesses (113)5.4. Maximize Instruction Throughput (117)5.4.1. Arithmetic Instructions (117)5.4.2. Control Flow Instructions (122)5.4.3. Synchronization Instruction (123)Appendix A. CUDA-Enabled GPUs (124)Appendix B. C++ Language Extensions (125)B.1. Function Execution Space Specifiers (125)B.1.1. __global__ (125)B.1.2. __device__ (125)B.1.3. __host__ (125)B.1.4. Undefined behavior (126)B.1.5. __noinline__ and __forceinline__ (126)B.2. Variable Memory Space Specifiers (127)B.2.1. __device__ (127)B.2.2. __constant__ (127)B.2.3. __shared__ (127)B.2.4. __managed__ (128)B.2.5. __restrict__ (128)B.3. Built-in Vector Types (130)B.3.1. char, short, int, long, longlong, float, double (130)B.3.2. dim3 (131)B.4.1. gridDim (131)B.4.2. blockIdx (131)B.4.3. blockDim (131)B.4.4. threadIdx (131)B.4.5. warpSize (132)B.5. Memory Fence Functions (132)B.6. Synchronization Functions (134)B.7. Mathematical Functions (135)B.8. Texture Functions (136)B.8.1. Texture Object API (136)B.8.1.1. tex1Dfetch() (136)B.8.1.2. tex1D() (136)B.8.1.3. tex1DLod() (136)B.8.1.4. tex1DGrad() (136)B.8.1.5. tex2D() (136)B.8.1.6. tex2DLod() (137)B.8.1.7. tex2DGrad() (137)B.8.1.8. tex3D() (137)B.8.1.9. tex3DLod() (137)B.8.1.10. tex3DGrad() (137)B.8.1.11. tex1DLayered() (137)B.8.1.12. tex1DLayeredLod() (137)B.8.1.13. tex1DLayeredGrad() (138)B.8.1.14. tex2DLayered() (138)B.8.1.15. tex2DLayeredLod() (138)B.8.1.16. tex2DLayeredGrad() (138)B.8.1.17. texCubemap() (138)B.8.1.18. texCubemapLod() (138)B.8.1.19. texCubemapLayered() (139)B.8.1.20. texCubemapLayeredLod() (139)B.8.1.21. tex2Dgather() (139)B.8.2. Texture Reference API (139)B.8.2.1. tex1Dfetch() (139)B.8.2.2. tex1D() (140)B.8.2.3. tex1DLod() (140)B.8.2.4. tex1DGrad() (140)B.8.2.5. tex2D() (140)B.8.2.7. tex2DGrad() (141)B.8.2.8. tex3D() (141)B.8.2.9. tex3DLod() (141)B.8.2.10. tex3DGrad() (141)B.8.2.11. tex1DLayered() (142)B.8.2.12. tex1DLayeredLod() (142)B.8.2.13. tex1DLayeredGrad() (142)B.8.2.14. tex2DLayered() (142)B.8.2.15. tex2DLayeredLod() (143)B.8.2.16. tex2DLayeredGrad() (143)B.8.2.17. texCubemap() (143)B.8.2.18. texCubemapLod() (143)B.8.2.19. texCubemapLayered() (143)B.8.2.20. texCubemapLayeredLod() (144)B.8.2.21. tex2Dgather() (144)B.9. Surface Functions (144)B.9.1. Surface Object API (145)B.9.1.1. surf1Dread() (145)B.9.1.2. surf1Dwrite (145)B.9.1.3. surf2Dread() (145)B.9.1.4. surf2Dwrite() (145)B.9.1.5. surf3Dread() (145)B.9.1.6. surf3Dwrite() (146)B.9.1.7. surf1DLayeredread() (146)B.9.1.8. surf1DLayeredwrite() (146)B.9.1.9. surf2DLayeredread() (146)B.9.1.10. surf2DLayeredwrite() (146)B.9.1.11. surfCubemapread() (147)B.9.1.12. surfCubemapwrite() (147)B.9.1.13. surfCubemapLayeredread() (147)B.9.1.14. surfCubemapLayeredwrite() (147)B.9.2. Surface Reference API (148)B.9.2.1. surf1Dread() (148)B.9.2.2. surf1Dwrite (148)B.9.2.3. surf2Dread() (148)B.9.2.4. surf2Dwrite() (148)B.9.2.5. surf3Dread() (148)B.9.2.7. surf1DLayeredread() (149)B.9.2.8. surf1DLayeredwrite() (149)B.9.2.9. surf2DLayeredread() (149)B.9.2.10. surf2DLayeredwrite() (150)B.9.2.11. surfCubemapread() (150)B.9.2.12. surfCubemapwrite() (150)B.9.2.13. surfCubemapLayeredread() (150)B.9.2.14. surfCubemapLayeredwrite() (150)B.10. Read-Only Data Cache Load Function (151)B.11. Load Functions Using Cache Hints (151)B.12. Store Functions Using Cache Hints (151)B.13. Time Function (152)B.14. Atomic Functions (152)B.14.1. Arithmetic Functions (153)B.14.1.1. atomicAdd() (153)B.14.1.2. atomicSub() (154)B.14.1.3. atomicExch() (154)B.14.1.4. atomicMin() (154)B.14.1.5. atomicMax() (155)B.14.1.6. atomicInc() (155)B.14.1.7. atomicDec() (155)B.14.1.8. atomicCAS() (155)B.14.2. Bitwise Functions (156)B.14.2.1. atomicAnd() (156)B.14.2.2. atomicOr() (156)B.14.2.3. atomicXor() (156)B.15. Address Space Predicate Functions (157)B.15.1. __isGlobal() (157)B.15.2. __isShared() (157)B.15.3. __isConstant() (157)B.15.4. __isLocal() (157)B.16. Address Space Conversion Functions (157)B.16.1. __cvta_generic_to_global() (157)B.16.2. __cvta_generic_to_shared() (157)B.16.3. __cvta_generic_to_constant() (158)B.16.4. __cvta_generic_to_local() (158)B.16.5. __cvta_global_to_generic() (158)B.16.7. __cvta_constant_to_generic() (158)B.16.8. __cvta_local_to_generic() (158)B.17. Compiler Optimization Hint Functions (158)B.17.1. __builtin_assume_aligned() (158)B.17.2. __builtin_assume() (159)B.17.3. __assume() (159)B.17.4. __builtin_expect() (159)B.17.5. Restrictions (160)B.18. Warp Vote Functions (160)B.19. Warp Match Functions (161)B.19.1. Synopsys (161)B.19.2. Description (161)B.20. Warp Reduce Functions (162)B.20.1. Synopsys (162)B.20.2. Description (162)B.21. Warp Shuffle Functions (162)B.21.1. Synopsis (163)B.21.2. Description (163)B.21.3. Notes (164)B.21.4. Examples (164)B.21.4.1. Broadcast of a single value across a warp (164)B.21.4.2. Inclusive plus-scan across sub-partitions of 8 threads (165)B.21.4.3. Reduction across a warp (165)B.22. Nanosleep Function (166)B.22.1. Synopsis (166)B.22.2. Description (166)B.22.3. Example (166)B.23. Warp matrix functions (166)B.23.1. Description (166)B.23.2. Alternate Floating Point (169)B.23.3. Double Precision (169)B.23.4. Sub-byte Operations (169)B.23.5. Restrictions (170)B.23.6. Element Types & Matrix Sizes (171)B.23.7. Example (172)B.24. Split Arrive/Wait Barrier (173)B.24.1. Simple Synchronization Pattern (173)B.24.2. Temporal Splitting and Five Stages of Synchronization (173)B.24.3. Bootstrap Initialization, Expected Arrive Count, and Participation (174)B.24.4. Countdown, Complete, Reset, and Phase (175)B.24.5. Countdown to a Collective Operation (175)B.24.6. Spatial Partitioning (also known as Warp Specialization) (176)B.24.7. Early Exit (Dropping out of Participation) (178)B.24.8. AWBarrier Interface (179)B.24.8.1. Synopsis of cuda_awbarrier.h (179)B.24.8.2. Initialize (179)B.24.8.3. Invalidate (180)B.24.8.4. Arrive (180)B.24.8.5. Wait (180)B.24.8.6. Automatic Reset (180)B.24.8.7. Arrive and Drop (181)B.24.8.8. Pending Count (181)B.24.9. Memory Barrier Primitives Interface (181)B.24.9.1. Data Types (181)B.24.9.2. Memory Barrier Primitives API (181)B.25. Asynchronously Copy Data from Global to Shared Memory (182)B.25.1. Copy and Compute Pattern (183)B.25.1.1. Without Async-Copy (183)B.25.1.2. With Async-Copy (184)B.25.1.3. Async-Copy Pipeline Pattern (185)B.25.1.4. Async-Copy Pipeline Pattern using Split Arrive/Wait Barrier (187)B.25.2. Performance Guidance for Async-Copy (188)B.25.2.1. Warp Entanglement - Commit (188)B.25.2.2. Warp Entanglement - Wait (189)B.25.2.3. Warp Entanglement - Arrive-On (189)B.25.2.4. Keep Commit and Arrive-On Operations Converged (189)B.25.3. Pipeline Interface (190)B.25.3.1. Async-Copy an Object (190)B.25.3.2. Async-Copy an Array Segment (190)B.25.3.3. Construct Pipeline Object (191)B.25.3.4. Commit and Wait for Batch of Async-Copy (191)B.25.3.5. Commit Batch of Async-Copy (191)B.25.3.6. Wait for Committed Batches of Async-Copy (191)B.25.3.7. Wait for Committed Batches of Async-Copy by Index (192)B.25.3.8. Complete as an Arrive Operation (192)B.25.4. Pipeline Primitives Interface (192)B.25.4.1. Async-Copy Primitive (192)B.25.4.2. Commit Primitive (193)B.25.4.3. Wait Primitive (193)B.25.4.4. Arrive On Barrier Primitive (193)B.26. Profiler Counter Function (194)B.27. Assertion (194)B.28. Trap function (195)B.29. Breakpoint Function (195)B.30. Formatted Output (195)B.30.1. Format Specifiers (196)B.30.2. Limitations (196)B.30.3. Associated Host-Side API (197)B.30.4. Examples (197)B.31. Dynamic Global Memory Allocation and Operations (198)B.31.1. Heap Memory Allocation (199)B.31.2. Interoperability with Host Memory API (200)B.31.3. Examples (200)B.31.3.1. Per Thread Allocation (200)B.31.3.2. Per Thread Block Allocation (200)B.31.3.3. Allocation Persisting Between Kernel Launches (201)B.32. Execution Configuration (202)B.33. Launch Bounds (203)B.34. #pragma unroll (205)B.35. SIMD Video Instructions (206)Appendix C. Cooperative Groups (208)C.1. Introduction (208)C.2. What's New in CUDA 11.0 (208)C.3. Programming Model Concept (209)C.3.1. Composition Example (210)C.4. Group Types (210)C.4.1. Implicit Groups (210)C.4.1.1. Thread Block Group (211)C.4.1.2. Grid Group (212)C.4.1.3. Multi Grid Group (212)C.4.2. Explicit Groups (213)C.4.2.1. Thread Block Tile (213)C.4.2.2. Coalesced Groups (215)C.6. Group Collectives (219)C.6.1. Synchronization (219)C.6.2. Data Transfer (219)C.6.3. Data manipulation (221)C.7. Grid Synchronization (223)C.8. Multi-Device Synchronization (225)Appendix D. CUDA Dynamic Parallelism (227)D.1. Introduction (227)D.1.1. Overview (227)D.1.2. Glossary (227)D.2. Execution Environment and Memory Model (228)D.2.1. Execution Environment (228)D.2.1.1. Parent and Child Grids (228)D.2.1.2. Scope of CUDA Primitives (229)D.2.1.3. Synchronization (229)D.2.1.4. Streams and Events (229)D.2.1.5. Ordering and Concurrency (230)D.2.1.6. Device Management (230)D.2.2. Memory Model (230)D.2.2.1. Coherence and Consistency (231)D.3. Programming Interface (233)D.3.1. CUDA C++ Reference (233)D.3.1.1. Device-Side Kernel Launch (233)D.3.1.2. Streams (234)D.3.1.3. Events (234)D.3.1.4. Synchronization (235)D.3.1.5. Device Management (235)D.3.1.6. Memory Declarations (235)D.3.1.7. API Errors and Launch Failures (237)D.3.1.8. API Reference (238)D.3.2. Device-side Launch from PTX (239)D.3.2.1. Kernel Launch APIs (239)D.3.2.2. Parameter Buffer Layout (240)D.3.3. Toolkit Support for Dynamic Parallelism (241)D.3.3.1. Including Device Runtime API in CUDA Code (241)D.3.3.2. Compiling and Linking (241)D.4. Programming Guidelines (241)D.4.2. Performance (242)D.4.2.1. Synchronization (242)D.4.2.2. Dynamic-parallelism-enabled Kernel Overhead (242)D.4.3. Implementation Restrictions and Limitations (243)D.4.3.1. Runtime (243)Appendix E. Virtual Memory Management (246)E.1. Introduction (246)E.2. Query for support (247)E.3. Allocating Physical Memory (247)E.3.1. Shareable Memory Allocations (248)E.3.2. Memory Type (249)E.3.2.1. Compressible Memory (249)E.4. Reserving a Virtual Address Range (250)E.5. Mapping Memory (250)E.6. Control Access Rights (251)Appendix F. Mathematical Functions (252)F.1. Standard Functions (252)F.2. Intrinsic Functions (259)Appendix G. C++ Language Support (263)G.1. C++11 Language Features (263)G.2. C++14 Language Features (266)G.3. C++17 Language Features (266)G.4. Restrictions (266)G.4.1. Host Compiler Extensions (266)G.4.2. Preprocessor Symbols (267)G.4.2.1. __CUDA_ARCH__ (267)G.4.3. Qualifiers (268)G.4.3.1. Device Memory Space Specifiers (268)G.4.3.2. __managed__ Memory Space Specifier (269)G.4.3.3. Volatile Qualifier (271)G.4.4. Pointers (271)G.4.5. Operators (271)G.4.5.1. Assignment Operator (271)G.4.5.2. Address Operator (271)G.4.6. Run Time Type Information (RTTI) (271)G.4.7. Exception Handling (272)G.4.8. Standard Library (272)G.4.9.1. External Linkage (272)G.4.9.2. Implicitly-declared and explicitly-defaulted functions (272)G.4.9.3. Function Parameters (273)G.4.9.4. Static Variables within Function (273)G.4.9.5. Function Pointers (274)G.4.9.6. Function Recursion (274)G.4.9.7. Friend Functions (274)G.4.9.8. Operator Function (274)G.4.10. Classes (275)G.4.10.1. Data Members (275)G.4.10.2. Function Members (275)G.4.10.3. Virtual Functions (275)G.4.10.4. Virtual Base Classes (275)G.4.10.5. Anonymous Unions (276)G.4.10.6. Windows-Specific (276)G.4.11. Templates (276)G.4.12. Trigraphs and Digraphs (277)G.4.13. Const-qualified variables (277)G.4.14. Long Double (278)G.4.15. Deprecation Annotation (278)G.4.16. C++11 Features (278)G.4.16.1. Lambda Expressions (278)G.4.16.2. std::initializer_list (279)G.4.16.3. Rvalue references (280)G.4.16.4. Constexpr functions and function templates (280)G.4.16.5. Constexpr variables (280)G.4.16.6. Inline namespaces (281)G.4.16.7. thread_local (282)G.4.16.8. __global__ functions and function templates (282)G.4.16.9. __device__/__constant__/__shared__ variables (284)G.4.16.10. Defaulted functions (284)G.4.17. C++14 Features (284)G.4.17.1. Functions with deduced return type (285)G.4.17.2. Variable templates (285)G.4.18. C++17 Features (286)G.4.18.1. Inline Variable (286)G.4.18.2. Structured Binding (287)G.5. Polymorphic Function Wrappers (287)G.6. Extended Lambdas (289)G.6.1. Extended Lambda Type Traits (290)G.6.2. Extended Lambda Restrictions (291)G.6.3. Notes on __host__ __device__ lambdas (298)G.6.4. *this Capture By Value (298)G.6.5. Additional Notes (300)G.7. Code Samples (301)G.7.1. Data Aggregation Class (301)G.7.2. Derived Class (302)G.7.3. Class Template (302)G.7.4. Function Template (303)G.7.5. Functor Class (303)Appendix H. Texture Fetching (304)H.1. Nearest-Point Sampling (304)H.2. Linear Filtering (305)H.3. Table Lookup (306)Appendix I. Compute Capabilities (308)I.1. Features and Technical Specifications (308)I.2. Floating-Point Standard (312)I.3. Compute Capability 3.x (313)I.3.1. Architecture (313)I.3.2. Global Memory (314)I.3.3. Shared Memory (316)I.4. Compute Capability 5.x (317)I.4.1. Architecture (317)I.4.2. Global Memory (318)I.4.3. Shared Memory (318)I.5. Compute Capability 6.x (321)I.5.1. Architecture (321)I.5.2. Global Memory (321)I.5.3. Shared Memory (321)I.6. Compute Capability 7.x (322)I.6.1. Architecture (322)I.6.2. Independent Thread Scheduling (322)I.6.3. Global Memory (324)I.6.4. Shared Memory (325)I.7. Compute Capability 8.x (326)I.7.1. Architecture (326)I.7.2. Global Memory (327)I.7.3. Shared Memory (327)Appendix J. Driver API (328)J.1. Context (330)J.2. Module (331)J.3. Kernel Execution (332)J.4. Interoperability between Runtime and Driver APIs (334)Appendix K. CUDA Environment Variables (335)Appendix L. Unified Memory Programming (338)L.1. Unified Memory Introduction (338)L.1.1. System Requirements (339)L.1.2. Simplifying GPU Programming (339)L.1.3. Data Migration and Coherency (340)L.1.4. GPU Memory Oversubscription (341)L.1.5. Multi-GPU (341)L.1.6. System Allocator (342)L.1.7. Hardware Coherency (342)L.1.8. Access Counters (343)L.2. Programming Model (344)L.2.1. Managed Memory Opt In (344)L.2.1.1. Explicit Allocation Using cudaMallocManaged() (344)L.2.1.2. Global-Scope Managed Variables Using __managed__ (345)L.2.2. Coherency and Concurrency (345)L.2.2.1. GPU Exclusive Access To Managed Memory (346)L.2.2.2. Explicit Synchronization and Logical GPU Activity (347)L.2.2.3. Managing Data Visibility and Concurrent CPU + GPU Access with Streams (348)L.2.2.4. Stream Association Examples (349)L.2.2.5. Stream Attach With Multithreaded Host Programs (349)L.2.2.6. Advanced Topic: Modular Programs and Data Access Constraints (350)L.2.2.7. Memcpy()/Memset() Behavior With Managed Memory (351)L.2.3. Language Integration (352)L.2.3.1. Host Program Errors with __managed__ Variables (352)L.2.4. Querying Unified Memory Support (353)L.2.4.1. Device Properties (353)L.2.4.2. Pointer Attributes (353)L.2.5. Advanced Topics (353)L.2.5.1. Managed Memory with Multi-GPU Programs on pre-6.x Architectures (353)L.2.5.2. Using fork() with Managed Memory (354)L.3. Performance Tuning (354)L.3.1. Data Prefetching (355)L.3.2. Data Usage Hints (356)L.3.3. Querying Usage Attributes (357)Figure 1. The GPU Devotes More Transistors to Data Processing (2)Figure 2. GPU Computing Applications (3)Figure 3. Automatic Scalability (5)Figure 4. Grid of Thread Blocks (9)Figure 5. Memory Hierarchy (11)Figure 6. Heterogeneous Programming (13)Figure 7. Matrix Multiplication without Shared Memory (29)Figure 8. Matrix Multiplication with Shared Memory (32)Figure 9. Child Graph Example (42)Figure 10. Creating a Graph Using Graph APIs Example (43)Figure 11. The Driver API Is Backward but Not Forward Compatible (101)Figure 12. Parent-Child Launch Nesting (229)Figure 13. Nearest-Point Sampling Filtering Mode (305)Figure 14. Linear Filtering Mode (306)Figure 15. One-Dimensional Table Lookup Using Linear Filtering (307)Figure 16. Examples of Global Memory Accesses (316)Figure 17. Strided Shared Memory Accesses (319)Figure 18. Irregular Shared Memory Accesses (320)Figure 19. Library Context Management (331)Table 1. Linear Memory Address Space (20)Table 2. Cubemap Fetch (62)Table 3. Throughput of Native Arithmetic Instructions (117)Table 4. Alignment Requirements (130)Table 5. New Device-only Launch Implementation Functions (237)Table 6. Supported API Functions (238)Table 7. Single-Precision Mathematical Standard Library Functions with Maximum ULP Error (253)Table 8. Double-Precision Mathematical Standard Library Functions with Maximum ULP Error (256)Table 9. Functions Affected by -use_fast_math (260)Table 10. Single-Precision Floating-Point Intrinsic Functions (260)Table 11. Double-Precision Floating-Point Intrinsic Functions (262)Table 12. C++11 Language Features (263)Table 13. C++14 Language Features (266)Table 14. Feature Support per Compute Capability (308)Table 15. Technical Specifications per Compute Capability (309)Table 16. Objects Available in the CUDA Driver API (328)Table 17. CUDA Environment Variables (335)Chapter 1.Introduction1.1. The Benefits of Using GPUsThe Graphics Processing Unit (GPU)1 provides much higher instruction throughput and memory bandwidth than the CPU within a similar price and power envelope. Many applications leverage these higher capabilities to run faster on the GPU than on the CPU (see GPU Applications). Other computing devices, like FPGAs, are also very energy efficient, but offer much less programming flexibility than GPUs.This difference in capabilities between the GPU and the CPU exists because they are designed with different goals in mind. While the CPU is designed to excel at executing a sequence of operations, called a thread, as fast as possible and can execute a few tens of these threads in parallel, the GPU is designed to excel at executing thousands of them in parallel (amortizing the slower single-thread performance to achieve greater throughput).The GPU is specialized for highly parallel computations and therefore designed such that more transistors are devoted to data processing rather than data caching and flow control. The schematic Figure 1 shows an example distribution of chip resources for a CPU versus a GPU.1The graphics qualifier comes from the fact that when the GPU was originally created, two decades ago, it was designed as a specialized processor to accelerate graphics rendering. Driven by the insatiable market demand for real-time, high-definition, 3D graphics, it has evolved into a general processor used for many more workloads than just graphics rendering.Figure 1.The GPU Devotes More Transistors to Data ProcessingCPUGPUDevoting more transistors to data processing, e.g., floating-point computations, isbeneficial for highly parallel computations; the GPU can hide memory access latencies with computation, instead of relying on large data caches and complex flow control to avoid long memory access latencies, both of which are expensive in terms of transistors.In general, an application has a mix of parallel parts and sequential parts, so systems aredesigned with a mix of GPUs and CPUs in order to maximize overall performance. Applications with a high degree of parallelism can exploit this massively parallel nature of the GPU to achieve higher performance than on the CPU.1.2.CUDA ®: A General-PurposeParallel Computing Platform and Programming ModelIn November 2006, NVIDIA ® introduced CUDA ®, a general purpose parallel computingplatform and programming model that leverages the parallel compute engine in NVIDIA GPUs to solve many complex computational problems in a more efficient way than on a CPU.CUDA comes with a software environment that allows developers to use C++ as a high-level programming language. As illustrated by Figure 2, other languages, application programming interfaces, or directives-based approaches are supported, such as FORTRAN, DirectCompute,OpenACC.Figure 2.GPU Computing ApplicationsCUDA is designed to support various languages and application programming interfaces.1.3. A Scalable Programming ModelThe advent of multicore CPUs and manycore GPUs means that mainstream processor chips are now parallel systems. The challenge is to develop application software that transparently scales its parallelism to leverage the increasing number of processor cores, much as 3D graphics applications transparently scale their parallelism to manycore GPUs with widely varying numbers of cores.The CUDA parallel programming model is designed to overcome this challenge while maintaining a low learning curve for programmers familiar with standard programming languages such as C.At its core are three key abstractions - a hierarchy of thread groups, shared memories, and barrier synchronization - that are simply exposed to the programmer as a minimal set of language extensions.These abstractions provide fine-grained data parallelism and thread parallelism, nested within coarse-grained data parallelism and task parallelism. They guide the programmer to partition the problem into coarse sub-problems that can be solved independently in parallel by blocks of threads, and each sub-problem into finer pieces that can be solved cooperatively in parallel by all threads within the block.This decomposition preserves language expressivity by allowing threads to cooperate when solving each sub-problem, and at the same time enables automatic scalability. Indeed, each block of threads can be scheduled on any of the available multiprocessors within a GPU, in any order, concurrently or sequentially, so that a compiled CUDA program can execute on any number of multiprocessors as illustrated by Figure 3, and only the runtime system needs to know the physical multiprocessor count.This scalable programming model allows the GPU architecture to span a wide marketrange by simply scaling the number of multiprocessors and memory partitions: from thehigh-performance enthusiast GeForce GPUs and professional Quadro and Tesla computing products to a variety of inexpensive, mainstream GeForce GPUs (see CUDA-Enabled GPUs for a list of all CUDA-enabled GPUs).Figure 3.Automatic ScalabilityNote: A GPU is built around an array of Streaming Multiprocessors (SMs) (see HardwareImplementation for more details). A multithreaded program is partitioned into blocks ofthreads that execute independently from each other, so that a GPU with more multiprocessors will automatically execute the program in less time than a GPU with fewer multiprocessors.1.4. Document StructureThis document is organized into the following chapters:‣Chapter Introduction is a general introduction to CUDA.‣Chapter Programming Model outlines the CUDA programming model.‣Chapter Programming Interface describes the programming interface.‣Chapter Hardware Implementation describes the hardware implementation.‣Chapter Performance Guidelines gives some guidance on how to achieve maximum performance.‣Appendix CUDA-Enabled GPUs lists all CUDA-enabled devices.。

CUDAC编程权威指南

CUDAC编程权威指南《CUDAC编程权威指南》是一本关于CUDAC编程的权威性指南,该书包含了1212页。

CUDA是一种由NVIDIA开发的并行计算平台和编程模型,用于利用GPU(图形处理单元)的计算能力来加速并行计算任务。

本书旨在提供全面且系统化的学习资源,帮助读者了解CUDA的基本概念、编程模型和设计原则,以及如何正确使用CUDAC语言来实现高性能的GPU加速计算。

第一章介绍了CUDA的基本概念和编程模型。

CUDA的核心思想是将计算任务分为多个线程,并在GPU上并行执行,以提高计算性能。

读者将了解到CUDA的硬件架构、线程模型、内存模型和执行模型,以及如何正确地启动和管理CUDA线程。

第二章详细介绍了使用CUDAC语言进行开发的基本概念和技术。

CUDAC是一种基于C语言的扩展,用于编写并行计算任务的内核函数。

本章讲解了CUDAC的语法、数据类型、内存管理和运行时API等关键概念。

第三章展示了如何使用CUDAC进行向量和矩阵运算的优化。

读者将学习如何使用CUDAC编写高性能的向量和矩阵计算算法,并使用CUDAC提供的优化技术来减少内存访问延迟、提高数据局部性和利用硬件特性。

第四章介绍了如何使用CUDAC进行并行算法设计和实现。

本章详细讲解了CUDAC提供的并行算法设计模板和库,以及如何利用这些工具来实现并行算法的设计原则和最佳实践。

第五章讲解了如何进一步优化CUDAC程序的性能。

读者将学习到如何使用CUDAC提供的性能分析和优化工具来识别和解决性能瓶颈,包括内存带宽、计算资源利用率和调度等问题。

第六章介绍了如何使用CUDAC进行异步和流编程。

CUDAC支持异步执行和流控制,允许并行计算任务与主机CPU并行运行,以提高整体系统性能。

本章将详细讲解如何使用CUDAC的异步和流编程模式来实现高效的并行计算。

最后一章总结了全书的内容,并展望了CUDAC编程的未来发展方向。

读者将了解到CUDAC未来的发展趋势、新技术和挑战,以及如何持续学习和提高自己的CUDAC编程技能。

CUDA编程指南阅读笔记

CUDA编程指南阅读笔记随着多核CPU和众核GPU的到来,并⾏编程已经得到了业界越来越多的重视,CPU-GPU异构程序能够极⼤提⾼现有计算机系统的运算性能,对于科学计算等运算密集型程序有着⾮常重要的意义。

这⼀系列⽂章是根据《CUDA C语⾔编程指南》来整理的,该指南是NVIDIA公司提供的CUDA学习资料,介绍了CUDA编程最基本最核⼼的概念,是学习CUDA必不可少的阅读材料。

初学CUDA,笔记错误之处在所难免,还请发现问题的诸位读者不吝赐教。

1. 什么是CUDA?CUDA全称是Compute Unified Device Architecture,中⽂名称即统⼀计算设备架构,它是NVIDIA公司提出了⼀种通⽤的并⾏计算平台和编程模型。

使⽤CUDA,我们可以开发出同时在CPU和GPU上运⾏的通⽤计算程序,更加⾼效地利⽤现有硬件进⾏计算。

为了简化并⾏计算学习,CUDA为程序员提供了⼀个类C语⾔的开发环境以及⼀些其它的如FORTRAN、DirectCOmpute、OpenACC的⾼级语⾔/编程接⼝来开发CUDA程序。

2. CUDA编程模型如何扩展?我们知道,不同的GPU拥有不同的核⼼数⽬,在核⼼较多的系统上CUDA程序运⾏的时间较短,⽽在核⼼较少的系统上CUDA程序的执⾏时间较多。

那么,CUDA是如何做到的呢?并⾏编程的中⼼思想是分⽽治之:将⼤问题划分为⼀些⼩问题,再把这些⼩问题交给相应的处理单元并⾏地进⾏处理。

在CUDA中,这⼀思想便体现在它的具有两个层次的问题划分模型。

⼀个问题可以⾸先被粗粒度地划分为若⼲较⼩的⼦问题,CUDA使⽤被称为块(Block)的单元来处理它们,每个块都由⼀些CUDA线程组成,线程是CUDA中最⼩的处理单元,将这些较⼩的⼦问题进⼀步划分为若⼲更⼩的细粒度的问题,我们便可以使⽤线程来解决这些问题了。

对于⼀个普通的NVIDIA GPU,其CUDA线程数⽬通常能达到数千个甚⾄更多,因此,这样的问题划分模型便可以成倍地提升计算机的运算性能。

CUDA编程之快速入门

CUDA编程之快速⼊门CUDA(Compute Unified Device Architecture)的中⽂全称为计算统⼀设备架构。

做图像视觉领域的同学多多少少都会接触到CUDA,毕竟要做性能速度优化,CUDA是个很重要的⼯具,CUDA是做视觉的同学难以绕过的⼀个坑,必须踩⼀踩才踏实。

CUDA编程真的是⼊门容易精通难,具有计算机体系结构和C语⾔编程知识储备的同学上⼿CUDA编程应该难度不会很⼤。

本⽂章将通过以下五个⽅⾯帮助⼤家⽐较全⾯地了解CUDA编程最重要的知识点,做到快速⼊门:1. GPU架构特点2. CUDA线程模型3. CUDA内存模型4. CUDA编程模型5. CUDA应⽤⼩例⼦1. GPU架构特点⾸先我们先谈⼀谈串⾏计算和并⾏计算。

我们知道,⾼性能计算的关键利⽤多核处理器进⾏并⾏计算。

当我们求解⼀个计算机程序任务时,我们很⾃然的想法就是将该任务分解成⼀系列⼩任务,把这些⼩任务⼀⼀完成。

在串⾏计算时,我们的想法就是让我们的处理器每次处理⼀个计算任务,处理完⼀个计算任务后再计算下⼀个任务,直到所有⼩任务都完成了,那么这个⼤的程序任务也就完成了。

如下图所⽰,就是我们怎么⽤串⾏编程思想求解问题的步骤。

但是串⾏计算的缺点⾮常明显,如果我们拥有多核处理器,我们可以利⽤多核处理器同时处理多个任务时,⽽且这些⼩任务并没有关联关系(不需要相互依赖,⽐如我的计算任务不需要⽤到你的计算结果),那我们为什么还要使⽤串⾏编程呢?为了进⼀步加快⼤任务的计算速度,我们可以把⼀些独⽴的模块分配到不同的处理器上进⾏同时计算(这就是并⾏),最后再将这些结果进⾏整合,完成⼀次任务计算。

下图就是将⼀个⼤的计算任务分解为⼩任务,然后将独⽴的⼩任务分配到不同处理器进⾏并⾏计算,最后再通过串⾏程序把结果汇总完成这次的总的计算任务。

所以,⼀个程序可不可以进⾏并⾏计算,关键就在于我们要分析出该程序可以拆分出哪⼏个执⾏模块,这些执⾏模块哪些是独⽴的,哪些⼜是强依赖强耦合的,独⽴的模块我们可以试着设计并⾏计算,充分利⽤多核处理器的优势进⼀步加速我们的计算任务,强耦合模块我们就使⽤串⾏编程,利⽤串⾏+并⾏的编程思路完成⼀次⾼性能计算。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

编程指南

版本 2.0

6 / 7 / 2008

CUDA 编程指南,版本 2.0

i

ii

CUDA 编程指南,版本 2.0

目

第 1 章 1.1 1.2 1.3 第2章 2.1 2.2 2.3 2.4 2.5 第 3 章 3.1 3.2 3.3 第 4 章 4.1 4.2

录

简介 ................................................................................................................................................... 1 CUDA:可伸缩并行编程模型 ............................................................................................................... 1 GPU:高度并行化、多线程、多核处理器........................................................................................... 1 文档结构 .................................................................................................................................................. 3 编程模型 ........................................................................................................................................... 4 线程层次结构 .......................................................................................................................................... 4 存储器层次结构 ...................................................................................................................................... 6 主机和设备 .............................................................................................................................................. 6 软件栈 ...................................................................................................................................................... 7 计算能力 .................................................................................................................................................. 8 GPU 实现 ......................................................................................................................................... 9 具有芯片共享存储器的一组 SIMT 多处理器 ..................................................................................... 9 多个设备 .................................................................................................................................................11 模式切换 .................................................................................................................................................11 应用程序编程接口 ......................................................................................................................... 12 C 编程语言的扩展................................................................................................................................ 12 语言扩展 ................................................................................................................................................ 12 4.2.1 函数类型限定符 ......................................................................................................................... 12 4.2.1.1 _device_ ............................................................................................................................ 12 4.2.1.2 _global_ ............................................................................................................................ 13 4.2.1.3 _host_ ................................................................................................................................ 13 4.2.1.4 限制 .................................................................................................................................. 13 4.2.2 变量类型限定符 ......................................................................................................................... 13 4.2.2.1 _device_ ............................................................................................................................ 13 4.2.2.2 _constant_ ......................................................................................................................... 13 4.2.2.3 _shared_ .......................பைடு நூலகம்.................................................................................................... 14 4.2.2.4 限制 .................................................................................................................................. 14 4.2.3 执行配置 ..................................................................................................................................... 15 4.2.4 内置变量 ..................................................................................................................................... 15 4.2.4.1 gridDim