一个比较详细的Linux摄像头图像采集讲解

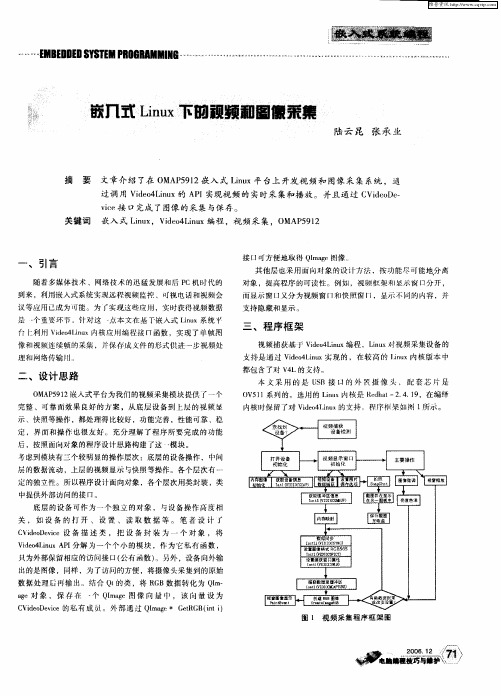

嵌入式Linux下的视频和图像采集

( ieD v e设 备 描 述 类 ,把 设 备 封 装 为 一 个 对 象 ,将 : do ei V c

V oLnxA 1 ie4 iu P 分解 为一个个 小 的模块 ,作 为它私 有 函数 , E J

只为外部保 留相应 的访 问接 口( 公有 函数 ) 。另外 ,设备 向外输 出的是 图像 ,同样 ,为 了访问的方便 ,将摄像头采集刮 的原始 数据 处理后再 输 出。结合 Q 的类 ,将 R B数据 转化 为 Q m ‘ G I— a 对 象 ,保 存 在 ・ Q m g 个 I ae图 像 向 【 , 该 向量 设 为 1 1 c ieD v e的私有 成 。外 部 通过 Ql ae G tG (n i V do ei c m g e B it ) R

号虑到模块有二个较明显的操作层次 :底层的设备操作 ,中问

层的数据流动 ,上层的视频 显示 与快照等操作。各个层次有 … ・ 定 的独立性 。所 以程序设计面 向对象 ,各个层次用类封装 ,类 中提供外部访 问的接 n。

底 层的设 备可作 为一个 独立 的对象 , 与设备操 作高 度相

关 , 如 设 备 的 打 开 、设 置 、 读 取 数 据 等 。 笔 者 设 汁 r

到来 ,利用嵌入式系统实现远程视频崎挖 、町视电话 和视 频会 议等应用 已成为可能。为 r实现这 应崩 ,实时获得 视频 数据

是 ・ 个重葛环节 针对这 一 点本 文在 基 r嵌入式 Ln x系统 、 iu

支持 隐藏 和显示 . .

仃 卜 用 VdoL u 利 i 4 i x内核 应 编程接 几函数 ,实现 了 单帧 网 e n

r ur —ern et n r o;

~

、

引言

嵌入式Linux系统中图片解码和显示的视频处理技术

嵌入式Linux系统中图片解码和显示的视频处理技术嵌入式Linux系统作为一种轻量级、高度可定制化的操作系统,被广泛应用于各种嵌入式设备中,包括智能手机、智能家居、车载系统等。

在这些设备中,图片解码和显示技术是嵌入式Linux系统中非常重要的一部分,它们直接影响到图像的质量和设备的性能。

本文将介绍在嵌入式Linux系统中实现图片解码和显示的视频处理技术。

一、嵌入式Linux系统中的图片解码技术1. 图片格式支持:在嵌入式Linux系统中,常见的图片格式包括JPEG、PNG、BMP等。

为了实现图片的解码,首先需要选择合适的图片解码库,如libjpeg、libpng等。

这些库提供了针对不同格式的解码算法,并且能够在嵌入式设备的资源有限情况下高效地进行解码。

2. 解码性能优化:由于嵌入式设备的资源有限,解码性能的优化是很重要的。

可以采用硬件加速的方式,如使用图像处理单元(IPU)或者图像信号处理器(ISP)等专门用于图像处理的硬件模块来加速解码过程。

此外,还可以通过优化解码算法、使用多线程解码等方式来提高解码性能。

3. 图片解码的内存管理:在解码过程中,需要为解码后的图像数据分配内存,并且需要合理管理内存的使用,避免内存泄漏或者内存碎片等问题。

可以使用内存池技术,预先分配一定数量的内存块,并在解码完成后及时释放,以提高内存使用效率。

二、嵌入式Linux系统中的图片显示技术1. 显示接口选择:在嵌入式Linux系统中,常见的显示接口包括LVDS、HDMI、MIPI-DSI等。

根据具体的设备需求和硬件平台,选择合适的显示接口,并确保嵌入式Linux系统能够正确识别和配置显示接口相关的硬件。

2. 显示驱动开发:根据不同的硬件平台,需要开发相应的显示驱动程序,以实现图片数据的显示。

在开发显示驱动过程中,可以利用硬件加速技术,如使用GPU加速等,提高显示性能和图像质量。

3. 显示缓冲管理:为了实现流畅的视频播放和图片显示,需要进行显示缓冲管理。

嵌入式Linux系统的图片解码和显示方法详解

嵌入式Linux系统的图片解码和显示方法详解嵌入式Linux系统在如今的物联网应用中扮演着重要的角色。

其中,图片解码和显示是嵌入式系统中常见的需求,它们对于展示图形化界面、实现图像处理等方面都具有重要意义。

本文将详细讨论嵌入式Linux系统中的图片解码和显示方法。

一、图片解码方法在嵌入式Linux系统中,常见的图片格式有JPEG、PNG、BMP等。

针对不同的图片格式,可以采用不同的解码方法。

1. JPEG解码JPEG是一种广泛应用于图像压缩和存储的格式。

在嵌入式Linux系统中,常用的JPEG解码库有libjpeg和libturbojpeg等。

libjpeg是一个开源的JPEG解码库,广泛应用于多个平台。

该解码库提供了一系列的API接口,可以方便地在嵌入式Linux系统中进行JPEG解码操作。

通过使用libjpeg库,可以将JPEG图片解码为RGB格式,从而在系统中进行后续的图像处理或显示。

libturbojpeg是libjpeg的增强版,它在性能上有一定的优化,特别适用于有限的资源嵌入式系统。

libturbojpeg同样提供了丰富的API接口,可以实现对JPEG图片的高效解码。

2. PNG解码PNG是一种无损的位图格式,广泛应用于图像存储和传输。

在嵌入式Linux系统中,可以使用libpng库进行PNG图片的解码。

libpng是一个开源的PNG解码库,它提供了灵活的API接口,可以实现对PNG图片的解码和处理。

通过libpng库,可以将PNG 图片解码为RGBA格式,方便在系统中进行进一步的图像处理或显示。

3. BMP解码BMP是一种非压缩的位图格式,可以直接在屏幕上显示。

在嵌入式Linux系统中,可以通过解析BMP文件头和像素数据,实现对BMP图片的解码。

BMP图片的解码相对简单,只需按照文件格式解析头信息,提取像素数据,并根据颜色格式进行解析,即可获取图片的RGB数据。

二、图片显示方法在嵌入式Linux系统中,图片的显示可以通过多种方式实现。

linux 摄像头数据叠加处理

linux 摄像头数据叠加处理摄像头数据叠加处理是将多个摄像头捕获的视频数据进行叠加处理,以便获得更全面和丰富的信息。

Linux系统提供了强大的工具和库来进行摄像头数据处理,本文将详细介绍在Linux下如何实现摄像头数据叠加处理。

一、摄像头数据获取在Linux系统下,我们可以使用Video4Linux库(简称V4L)来获取摄像头数据。

V4L提供了一组标准接口,使得我们可以轻松地与摄像头进行交互。

使用V4L库需要安装v4l-utils软件包,可以使用apt-get命令进行安装:```sudo apt-get install v4l-utils```安装完成后,我们可以使用v4l2-ctl命令行工具来列出系统上连接的摄像头设备,以及查看它们的参数和能力。

例如,下面的命令将列出系统上的摄像头设备列表:```v4l2-ctl --list-devices```二、摄像头数据处理1.视频流读取摄像头数据通常以视频流的形式存在,我们可以使用OpenCV库来读取和处理视频流。

OpenCV是一个用于计算机视觉和机器学习的开源库,提供了丰富的函数和工具来处理图像和视频。

首先,我们需要安装OpenCV库,可以使用以下命令进行安装:```sudo apt-get install libopencv-dev```安装完成后,我们可以使用OpenCV提供的函数来读取摄像头数据。

下面是一个简单的示例代码,用于读取摄像头数据并显示图像:```cpp#include <opencv2/opencv.hpp>int main() {cv::VideoCapture cap(0);if (!cap.isOpened()) {std::cerr << "Cannot open camera." << std::endl;return -1;}cv::Mat frame;while (true) {cap.read(frame);if (frame.empty()) {std::cerr << "Error reading frame." << std::endl;break;}cv::imshow("Camera", frame);if (cv::waitKey(10) == 27)break;}cap.release();cv::destroyAllWindows();return 0;}```该代码中,我们使用了`cv::VideoCapture`类来打开摄像头设备,并使用`cap.read(frame)`函数从摄像头中读取帧数据。

《Linux系统中如何正确安装摄像头驱动-电脑常识

本文《Linux系统中如何正确安装摄像头驱动- 电脑常识》关键词:电脑常识,网络教程1、摄像头(Webcam)驱动说明;摄像头在Windows的驱动极为容易,最多是点几下鼠标,没有什么太大的难度。

但在Linux中,驱动起来是有点困难,这并不是说Linux多高雅。

只能说开发商唯利是图,没有好处的事,他们的确不怎么积极。

Linux 的用户比较少,所以他们也不把用户当回事。

目前看来摄像头(Webcam)在Linux 中驱动基本成熟,缺少的是应用程序的支持,比如即时通讯工具支持视频的好程序比较少。

有些芯片组是没有任何问题,在国内,大多摄像头的芯片组是Z-Star,也有显示为Vimmicro(和Z-Star是同样的芯片)的。

在Fedora 5.0或SuSE 10.x中,已经支持了很多摄像头,应该说即插即用。

对于我们来说,是不是即插即用,那是另一回事,只有幸运儿才有这个的福气。

如果您的摄像头接上还是用不了,那您就有必要看一下我写的这个文档了。

本文操作环境: Fedora Core 5.0 。

由于大部份是用源码包编译,所以还是有通用性的;1.1 摄像头在Linux中是如何支持的;在Linux中,硬件的驱动程序,都是由内核支持的;目前比较新内核版本也集成了一些的摄像头驱动。

就是Fedora、SuSE最新版本所支持的内核也是来自由 。

所以支持也是极为正常的。

内核对硬件的支持分为内置于和外挂模块两种方便。

对于摄像头来说,大多是模块支持的;1.2 摄像头(Webcam)驱动网址;http://mxhaard.free.fr目前最新版本的摄像头驱动,已经到了spca5xx-20060501.tar.gz 版本;您可以在上面的地址下载;2、驱动摄像头详细过程;2.1 查看摄像头型号;我们用用到lshal 工具,在老版本的Linux是没有这个工具的。

在最新版本的Linux都有这个工具;[root@localhost ~]# lshal |grep WebCaminfo.product = 'ZC0303 WebCam' (string)usb_device.product = 'ZC0303 WebCam' (string)上面这个命令是列出系统硬件设备,然后从输出中,提取WebCam字样的信息。

Linuxv4l2架构之v4l2-ctl抓取、设置图像

Linuxv4l2架构之v4l2-ctl抓取、设置图像一、本开发、测试基于RV1126-1109的SDK上进行。

一个mipi 的摄像头,接到rv1126上看看能不能抓到图。

不需要配置寄存器。

例如这个摄像头参数:raw8,4lanes,512*192,30fps二、v4l2-ctl工具则是针对/dev/video0,/dev/video1等video 设备,它在video设备上进行set_fmt、reqbuf、qbuf、dqbuf、stream_on、stream_off 等一系列操作。

复制一份索尼imx291的代码直接修改,改完之后测试。

测试方法如下:v4l2-ctl -d /dev/video0 --set-fmt-video=width=512,height=192,pixelformat=BG10 --stream-mmap=3 --stream-to=/tmp/bg10.bin --stream-count=1 --stream-poll三、测试方法和步骤如下:执行发现,没有抓到数据也没有timeout,直接退出了。

dmesg 发现出现了如下一条信息rkcif_mipi_lvds: crop size is bigger than input这部分代码如下:rkcif_start_streaming() -> rkcif_sanity_check_fmt(stream, NULL)static int rkcif_sanity_check_fmt(struct rkcif_stream *stream, const struct v4l2_rect *s_crop){struct rkcif_device *dev = stream->cifdev;struct v4l2_device *v4l2_dev = &dev->v4l2_dev;struct v4l2_rect input, *crop;stream->cif_fmt_in = get_input_fmt(dev->active_sensor->sd, &input, stream->id + 1);if (!stream->cif_fmt_in) {v4l2_err(v4l2_dev, "Input fmt is invalid\n");return -EINVAL;}if (s_crop)crop = (struct v4l2_rect *)s_crop;elsecrop = &stream->crop[CROP_SRC_ACT];if (crop->width + crop->left > input.width ||crop->height + crop->top > input.height) {v4l2_err(v4l2_dev, "crop size is bigger than input\n");return -EINVAL;}...}查看代码可以知道input.width及heigth小于crop的width或者heigth。

linux下V4L2的USB摄像头四幅图像采集

//#Rockie Cheng#include <stdio.h>#include <stdlib.h>#include <string.h>#include <assert.h>#include <getopt.h>#include <fcntl.h>#include <unistd.h>#include <errno.h>#include <malloc.h>#include <sys/stat.h>#include <sys/types.h>#include <sys/time.h>#include <sys/mman.h>#include <sys/ioctl.h>#include <asm/types.h>#include <linux/videodev2.h>#define CLEAR(x) memset (&(x), 0, sizeof (x)) //宏定义清楚struct buffer {void * start;size_t length;}; //定义一个buffer结构体,这个结构体用于盛放申请到的内存首地址和长度static char *dev_name = "/dev/video0";//摄像头设备名static int fd = -1; //文件描述符fdstruct buffer *buffers = NULL;static unsigned int n_buffers = 0;FILE *file_fd; //static unsigned long file_length;static unsigned char *file_name;//获取一帧数据,static int read_frame (void){struct v4l2_buffer buf; //用于盛放一帧数据的信息unsigned int i;CLEAR (buf);buf.type = V4L2_BUF_TYPE_VIDEO_CAPTURE;buf.memory = V4L2_MEMORY_MMAP;int ff = ioctl (fd, VIDIOC_DQBUF, &buf); //从视频缓冲区的输出队列中取得一个已经保存有一帧视频数据的视频缓冲区if(ff<0)printf("failture\n"); //出列采集的帧缓冲assert (buf.index < n_buffers);printf ("buf.index dq is %d,\n",buf.index);fwrite(buffers[buf.index].start, buffers[buf.index].length, 1, file_fd); //将其写入文件中ff=ioctl (fd, VIDIOC_QBUF, &buf); //再将其入列,投放一个空的视频缓冲区到视频缓冲区输入队列中if(ff<0)printf("failture VIDIOC_QBUF\n");return 1;}//主函数int main (int argc,char ** argv){struct v4l2_capability cap;/*储存了硬件的信息,由驱动填写各个元素的值,包含:驱动名称,硬件名称,版本号,硬件支持的功能:V4L2_CAP_VIDEO_CAPTURE(支持视频捕捉接口)*/struct v4l2_format fmt;/*流数据的格式,struct v4l2_format{enum v4l2_buf_type type;union{struct v4l2_pix_format pix;// V4L2_BUF_TYPE_VIDEO_CAPTURE包含每幅图片的一行,一列所占的像素个数,width和heigth;//像素格式与压缩类型pixelformat;一幅图像的数据所用的最大字节数imagesize=bytesline*heigthstruct v4l2_window win; // V4L2_BUF_TYPE_VIDEO_OVERLAYstruct v4l2_vbi_format vbi; // V4L2_BUF_TYPE_VBI_CAPTUREstruct v4l2_sliced_vbi_format sliced; // V4L2_BUF_TYPE_SLICED_VBI_CAPTURE__u8 raw_data[200]; // user-defined} fmt;};*/unsigned int i;enum v4l2_buf_type type;//所申请的缓冲区的类型,与struct v4l2_format和struct v4l2_requestbuffers结构体中的type一样,//由用户定义,比如可以为V4L2_BUF_TYPE_VIDEO_CAPTUREfile_fd = fopen("test-mmap.jpg", "w");//以只写方式打开文件,返回值是锁打开的文件的首地址fd = open (dev_name, O_RDWR | O_NONBLOCK, 0);//打开摄像头设备,无阻塞方式打开int ff=ioctl (fd, VIDIOC_QUERYCAP, &cap);//获取硬件的参数,结构会存放在cap中,这是由驱动自动填写的if(ff<0)printf("failture VIDIOC_QUERYCAP\n");struct v4l2_fmtdesc fmt1;int ret;memset(&fmt1, 0, sizeof(fmt1));fmt1.index = 0;fmt1.type = V4L2_BUF_TYPE_VIDEO_CAPTURE;while ((ret = ioctl(fd, VIDIOC_ENUM_FMT, &fmt1)) == 0) //获取当前驱动支持的视频格式{fmt1.index++;printf("{ pixelformat = '%c%c%c%c', description = '%s' }\n",fmt1.pixelformat & 0xFF, (fmt1.pixelformat >> 8) & 0xFF,(fmt1.pixelformat >> 16) & 0xFF, (fmt1.pixelformat >> 24) & 0xFF,fmt1.description);}CLEAR (fmt);fmt.type = V4L2_BUF_TYPE_VIDEO_CAPTURE;fmt.fmt.pix.width = 640;fmt.fmt.pix.height = 480;fmt.fmt.pix.pixelformat = V4L2_PIX_FMT_YUYV;//V4L2_PIX_FMT_YUYV;//V4L2_PIX_FMT_YVU420;//V4L2_PIX_FMT_YUYV;图像的帧格式确定以后,就可以计算出图像的大小fmt.fmt.pix.field = V4L2_FIELD_INTERLACED; //场交错ff = ioctl (fd, VIDIOC_S_FMT, &fmt); //设置图像格式,将上面设置的帧格式写到fmt 这个结构体中if(ff<0)printf("failture VIDIOC_S_FMT\n");file_length = fmt.fmt.pix.bytesperline * fmt.fmt.pix.height; //计算图片大小struct v4l2_requestbuffers req;/*struct v4l2_requestbuffers__u32 count; //这个成员只为了给mmap使用,保存需要请求的缓冲区的个数enum v4l2_buf_type type; //所申请的缓冲区的类型,与struct v4l2_format和struct v4l2_requestbuffers结构体中的type一样,//由用户定义,比如可以为V4L2_BUF_TYPE_VIDEO_CAPTURE enum v4l2_memory memory; //设置内存的访问形式V4L2_MEMORY_MMAP orV4L2_MEMORY_USERPTR.__u32 reserved[2]; //保留*/CLEAR (req);req.count = 1; //申请1个缓冲区req.type = V4L2_BUF_TYPE_VIDEO_CAPTURE; //必须为这个格式req.memory = V4L2_MEMORY_MMAP; //内存访问形式为mmapioctl (fd, VIDIOC_REQBUFS, &req); //申请缓冲,count是申请的数量if(ff<0)printf("failture VIDIOC_REQBUFS\n");if (req.count < 1)printf("Insufficient buffer memory\n");buffers = calloc (req.count, sizeof (*buffers));//分配连续的内存给刚才申请的缓冲区,并且初始化为0,返回值是首地址(物理地址)for (n_buffers = 0; n_buffers < req.count; ++n_buffers){struct v4l2_buffer buf; //驱动中的一帧,每帧的大小有驱动填写,从上面的pix.imagesize传过来/*struct v4l2_buffer{__u32 index;enum v4l2_buf_type type; //必须为V4L2_BUF_TYPE_VIDEO_CAPTURE__u32 bytesused; //已用的字节数__u32 flags; //enum v4l2_field field; //struct timeval timestamp; //struct v4l2_timecode timecode; //__u32 sequence; //内存分配的顺序enum v4l2_memory memory;union {__u32 offset;unsigned long userptr;} m;__u32 length;__u32 input;__u32 reserved;};*/CLEAR (buf);buf.type = V4L2_BUF_TYPE_VIDEO_CAPTURE;buf.memory = V4L2_MEMORY_MMAP;buf.index = n_buffers;if (-1 == ioctl (fd, VIDIOC_QUERYBUF, &buf)) //调用这个command以后,驱动将填写buf结构体的index,length,type,offset等元素printf ("VIDIOC_QUERYBUF error\n");buffers[n_buffers].length = buf.length;buffers[n_buffers].start = mmap (NULL,buf.length,PROT_READ | PROT_WRITE,MAP_SHARED,fd, buf.m.offset);//通过mmap建立映射关系。

Linux摄像头驱动学习之:(四)UVC-摄像头驱动框架分析

Linux摄像头驱动学习之:(四)UVC-摄像头驱动框架分析UVC: USB Video ClassUVC驱动:drivers\media\video\uvc\uvc_driver.c分析:1. usb_register(&uvc_driver.driver);2. uvc_probeuvc_register_videovdev = video_device_alloc();vdev->fops = &uvc_fops;video_register_device在下载 uvc specification,UVC 1.5 Class specification.pdf : 有详细描述USB_Video_Example 1.5.pdf : 有⽰例通过VideoControl Interface来控制,通过VideoStreaming Interface来读视频数据,VC⾥含有多个Unit/Terminal等功能模块,可以通过访问这些模块进⾏控制,⽐如调亮度分析UVC驱动调⽤过程:const struct v4l2_file_operations uvc_fops = {.owner = THIS_MODULE,.open = uvc_v4l2_open,.release = uvc_v4l2_release,.ioctl = uvc_v4l2_ioctl,.read = uvc_v4l2_read,.mmap = uvc_v4l2_mmap,.poll = uvc_v4l2_poll,};1. open:uvc_v4l2_open2. VIDIOC_QUERYCAP // video->streaming->type 应该是在设备被枚举时分析描述符时设置的if (video->streaming->type == V4L2_BUF_TYPE_VIDEO_CAPTURE)cap->capabilities = V4L2_CAP_VIDEO_CAPTURE| V4L2_CAP_STREAMING;elsecap->capabilities = V4L2_CAP_VIDEO_OUTPUT| V4L2_CAP_STREAMING;3. VIDIOC_ENUM_FMT // format数组应是在设备被枚举时设置的format = &video->streaming->format[fmt->index];4. VIDIOC_G_FMTuvc_v4l2_get_format // USB摄像头⽀持多种格式fromat, 每种格式下有多种frame(⽐如分辨率)struct uvc_format *format = video->streaming->cur_format;struct uvc_frame *frame = video->streaming->cur_frame;5. VIDIOC_TRY_FMTuvc_v4l2_try_format/* Check if the hardware supports the requested format. *//* Find the closest image size. The distance between image sizes is* the size in pixels of the non-overlapping regions between the* requested size and the frame-specified size.*/6. VIDIOC_S_FMT // 只是把参数保存起来,还没有发给USB摄像头uvc_v4l2_set_formatuvc_v4l2_try_formatvideo->streaming->cur_format = format;video->streaming->cur_frame = frame;7. VIDIOC_REQBUFSuvc_alloc_buffersfor (; nbuffers > 0; --nbuffers) {mem = vmalloc_32(nbuffers * bufsize);if (mem != NULL)break;}8. VIDIOC_QUERYBUFuvc_query_buffer__uvc_query_buffermemcpy(v4l2_buf, &buf->buf, sizeof *v4l2_buf); // 复制参数9. mmapuvc_v4l2_mmap10. VIDIOC_QBUFuvc_queue_bufferlist_add_tail(&buf->stream, &queue->mainqueue);list_add_tail(&buf->queue, &queue->irqqueue);11. VIDIOC_STREAMONuvc_video_enable(video, 1) // 把所设置的参数发给硬件,然后启动摄像头/* Commit the streaming parameters. */uvc_commit_videouvc_set_video_ctrl /* 设置格式fromat, frame */ret = __uvc_query_ctrl(video->dev /* 哪⼀个USB设备 */, SET_CUR, 0,video->streaming->intfnum /* 哪⼀个接⼝: VS */,probe ? VS_PROBE_CONTROL : VS_COMMIT_CONTROL, data, size,uvc_timeout_param);/* 启动:Initialize isochronous/bulk URBs and allocate transfer buffers. */uvc_init_video(video, GFP_KERNEL);uvc_init_video_isoc / uvc_init_video_bulkurb->complete = uvc_video_complete; (收到数据后此函数被调⽤,它⼜调⽤video->decode(urb, video, buf); ==>uvc_video_decode_isoc/uvc_video_encode_bulk => uvc_queue_next_buffer => wake_up(&buf->wait);)usb_submit_urb12. polluvc_v4l2_polluvc_queue_pollpoll_wait(file, &buf->wait, wait); // 休眠等待有数据13. VIDIOC_DQBUFuvc_dequeue_bufferlist_del(&buf->stream);14. VIDIOC_STREAMOFFuvc_video_enable(video, 0);usb_kill_urb(urb);usb_free_urb(urb);分析设置亮度过程:ioctl: VIDIOC_S_CTRLuvc_ctrl_setuvc_ctrl_commit__uvc_ctrl_commit(video, 0);uvc_ctrl_commit_entity(video->dev, entity, rollback);ret = uvc_query_ctrl(dev /* 哪⼀个USB设备 */, SET_CUR, ctrl->entity->id /* 哪⼀个unit/terminal */,dev->intfnum /* 哪⼀个接⼝: VC interface */, ctrl->info->selector,uvc_ctrl_data(ctrl, UVC_CTRL_DATA_CURRENT),ctrl->info->size);总结:1. UVC设备有2个interface: VideoControl Interface, VideoStreaming Interface2. VideoControl Interface⽤于控制,⽐如设置亮度。

v4l2-ctl 常用参数

v4l2-ctl 常用参数摄像头是现代电子设备中的重要组成部分,广泛应用于视频通信、图像采集等领域。

在Linux系统中,v4l2-ctl是一个常用的命令行工具,用于控制和配置视频 4 Linux 2(V4L2)设备的参数。

本文将介绍v4l2-ctl的常用参数,并详细说明它们的用途和配置方法。

1. --list-devices:列出系统中的视频设备列表该参数用于列出系统中所有可用的视频设备,包括摄像头和视频采集卡等。

通过执行命令`v4l2-ctl --list-devices`,可以查看系统中所有视频设备的名称和路径。

这对于多个摄像头的选择和配置非常有用。

2. --list-formats:列出设备支持的视频格式该参数用于列出指定视频设备所支持的视频格式。

通过执行命令`v4l2-ctl --list-formats -d /dev/video0`,可以查看摄像头支持的视频格式和对应的分辨率。

这对于选择合适的视频格式和配置摄像头的分辨率非常重要。

3. --set-fmt-video:设置视频格式和分辨率该参数用于设置视频设备的视频格式和分辨率。

例如,执行命令`v4l2-ctl --set-fmt-video=width=1280,height=720,pixelformat=YUYV -d /dev/video0`可以将摄像头的视频格式设置为YUYV,并将分辨率设置为1280x720。

通过调整视频格式和分辨率,可以满足不同应用场景的需求。

4. --set-ctrl:设置设备的控制参数该参数用于设置视频设备的各种控制参数,如对比度、亮度、饱和度等。

通过执行命令`v4l2-ctl --set-ctrl=brightness=100 -d /dev/video0`,可以将摄像头的亮度设置为100。

通过调整控制参数,可以改善图像质量和适应不同的环境条件。

5. --get-ctrl:获取设备的控制参数该参数用于获取视频设备的各种控制参数的当前值。

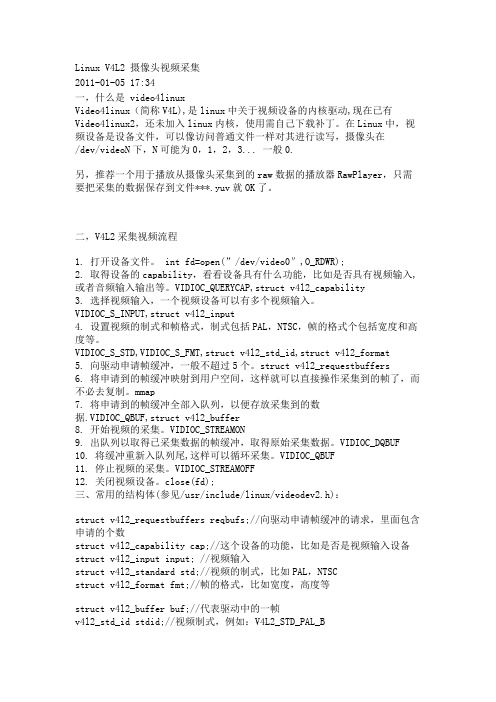

Linux V4L2 摄像头视频采集

Linux V4L2 摄像头视频采集2011-01-05 17:34一,什么是 video4linuxVideo4linux(简称V4L),是linux中关于视频设备的内核驱动,现在已有Video4linux2,还未加入linux内核,使用需自己下载补丁。

在Linux中,视频设备是设备文件,可以像访问普通文件一样对其进行读写,摄像头在/dev/videoN下,N可能为0,1,2,3... 一般0.另,推荐一个用于播放从摄像头采集到的raw数据的播放器RawPlayer,只需要把采集的数据保存到文件***.yuv就OK了。

二,V4L2采集视频流程1. 打开设备文件。

int fd=open(”/dev/video0″,O_RDWR);2. 取得设备的capability,看看设备具有什么功能,比如是否具有视频输入,或者音频输入输出等。

VIDIOC_QUERYCAP,struct v4l2_capability3. 选择视频输入,一个视频设备可以有多个视频输入。

VIDIOC_S_INPUT,struct v4l2_input4. 设置视频的制式和帧格式,制式包括PAL,NTSC,帧的格式个包括宽度和高度等。

VIDIOC_S_STD,VIDIOC_S_FMT,struct v4l2_std_id,struct v4l2_format5. 向驱动申请帧缓冲,一般不超过5个。

struct v4l2_requestbuffers6. 将申请到的帧缓冲映射到用户空间,这样就可以直接操作采集到的帧了,而不必去复制。

mmap7. 将申请到的帧缓冲全部入队列,以便存放采集到的数据.VIDIOC_QBUF,struct v4l2_buffer8. 开始视频的采集。

VIDIOC_STREAMON9. 出队列以取得已采集数据的帧缓冲,取得原始采集数据。

VIDIOC_DQBUF10. 将缓冲重新入队列尾,这样可以循环采集。

VIDIOC_QBUF11. 停止视频的采集。

基于嵌入式linux的视频图像采集

基于嵌入式linux的视频图像采集[摘要] 本文主要介绍在linux操作系统、arm xsbase270平台上,利用linux内核中已经植入video4linux函数库的数据结构和api函数,通过ov511摄像头实现视频采集的方案,本方案采用qt designer为开发环境,以效率较高的mmap(内存映射)方式截取视频;可保存单张的图片,也可保存为视频。

[关键词] 视频采集 video4linux 嵌入式linux mmap一、引言随着多媒体和通信技术的发展,越来越多的人希望能够直接通过屏幕,看到所要监控的信息。

如:视频监控、webcam、视频会议和可视电话,摄像机等。

嵌入式系统的发展越来越集成化,功能也越来越强大。

本文论述的是基于嵌入式linux系统的视频采集模块的设计与实现。

由于linux对视频的支持是通过video4linux提供的。

并且red hat9.0内核中已经包含了video4linux软件包,所以利用video4linux编程接口就可以在xscale270平台实现对ov511 usb 摄像头图像数据的采集;使用qt进行界面设计,同时对需要的图像进行保存。

最终通过交叉编译连接,生成在arm平台上运行的程序。

作为大学生创新项目,通过相关的开发与研究,可以熟练地掌握嵌入式系统的开发流程,以及对其中涉及到的相关技术有较为深入的理解。

二、系统内核的定制在linux系统下对摄像头的支持是通过内核中video4linux模块的加载来实现的,而该模块的加载可以是静态加载也可以是动态加载。

1.静态加载这种加载方式使视频支持模块嵌在新生成的内核中;虽然会使内核的尺寸变大,但系统运行可靠。

其基本流程是:(1)运行make menuconfig或make xconfig;(2)选择multimedia device->下的video for linux(选为*号标示;这个选项的目的是加载video4linux模块,为视频采集设备提供了编程接口);(3)在usb support->目录下,选择support for usb和 usb camera ov511 support(同样选为*号标示;这使在内核中加入了对ov511接口芯片的usb数字摄像头的驱动支持);(4)保存配置并退出;(5)make dep;make zimage此时在/tftpboot下就生成了带有ov511驱动的内核。

linux 显示摄像头的描述

linux 显示摄像头的描述

Linux系统可以通过多种方式来显示摄像头。

首先,可以使用

命令行工具来查看摄像头设备。

在终端中输入命令"ls /dev/video"

可以列出系统中所有的视频设备。

通常,摄像头设备会以

"/dev/video0"、"/dev/video1"等形式显示。

另外,Linux系统也提供了许多图形界面的摄像头应用程序,

比如Cheese、Guvcview等。

这些应用程序可以通过简单的图形界面

来显示摄像头的实时画面,并且提供了一些基本的调节功能,比如

亮度、对比度、饱和度等。

此外,许多视频通信应用程序(比如Skype、Zoom、微信等)

也在Linux上提供了摄像头的支持,用户可以通过这些应用程序来

进行视频通话或者视频会议,从而显示摄像头的画面。

在Linux系统中,摄像头的显示还可以通过使用一些开源的多

媒体框架和库来实现,比如GStreamer、OpenCV等。

这些框架和库

提供了丰富的功能和接口,可以用于开发自定义的摄像头应用程序,实现更多高级的视频处理和分析功能。

总之,Linux系统可以通过命令行工具、图形界面应用程序、视频通信应用程序以及多媒体框架和库等多种方式来显示摄像头的画面,用户可以根据自己的需求和技术水平选择合适的方式来实现摄像头的显示。

Linuxv4l2编程(摄像头信息采集)

Linuxv4l2编程(摄像头信息采集)基于Linux3.4.2,⾃⼰做⼀点⼉视频信息采集及⽹络传输的⼩实验,边做边学,⼀些基础知识同步整理。

1. 定义V4L2(Video For Linux Two) 是内核提供给应⽤程序访问⾳、视频驱动的统⼀接⼝。

V4L2 的相关定义包含在头⽂件<linux/videodev2.h> 中.2. ⼯作流程:打开设备-> 检查和设置设备属性-> 设置帧格式-> 设置⼀种输⼊输出⽅法(缓冲区管理)-> 循环获取数据-> 关闭设备。

3.设备打开和关闭//打开#include <fcntl.h>int open(const char *device_name, int flags);//关闭#include <unistd.h>int close(int fd);实验使⽤UVC摄像头,插⼊后⾃动⽣成设备“/dev/vedio0”,打开关闭实例如下int fd = open("/dev/video0",O_RDWR);close(fd);4. 查询设备属性: VIDIOC_QUERYCAP函数使⽤:int ioctl(int fd, int request, struct v4l2_capability *argp);v4l2相关结构体定义:struct v4l2_capability{u8 driver[16]; // 驱动名字u8 card[32]; // 设备名字u8 bus_info[32]; // 设备在系统中的位置u32 version;// 驱动版本号u32 capabilities;// 设备⽀持的操作u32 reserved[4]; // 保留字段};capabilities 常⽤值:V4L2_CAP_VIDEO_CAPTURE // 是否⽀持图像获取例:显⽰设备信息struct v4l2_capability cap;ioctl(fd,VIDIOC_QUERYCAP,&cap);printf(“Driver Name:%s\nCard Name:%s\nBus info:%s\nDriver Version:%u.%u.%u\n”,cap.driver,cap.card,cap.bus_info,cap.capabilities);5. 设置视频的制式和帧格式制式包括PAL,NTSC,帧的格式个包括宽度和⾼度等。

嵌入式Linux系统中图片解码和显示的图像分析技术

嵌入式Linux系统中图片解码和显示的图像分析技术嵌入式Linux系统中的图片解码和显示技术在各种应用中发挥着重要作用。

本文将探讨嵌入式Linux系统中使用的图像分析技术,重点讨论图像解码和图像显示的相关技术。

一、图像解码技术图像解码是将图像数据从编码格式转换为原始像素数据的过程。

在嵌入式Linux系统中,常用的图像解码技术有以下几种:1.1 JPEG解码技术JPEG(Joint Photographic Experts Group)是一种广泛使用的图像压缩标准,其解码技术在嵌入式Linux系统中得到了广泛应用。

JPEG解码技术能够高效地将JPEG格式的图像数据解码为原始的像素数据,以供后续的显示和处理。

1.2 PNG解码技术PNG(Portable Network Graphics)是一种无损压缩的图像格式,其解码技术在嵌入式Linux系统中也得到了广泛应用。

PNG解码技术能够将PNG格式的图像数据解码为原始的像素数据,同时保留图像的透明度信息,适用于需要保留背景透明效果的应用场景。

1.3 BMP解码技术BMP(Bitmap)是一种无压缩的图像格式,其解码技术在嵌入式Linux系统中也有所应用。

BMP解码技术能够将BMP格式的图像数据快速解码为原始的像素数据,但由于其无压缩的特点,文件大小较大,在资源有限的嵌入式系统中使用相对较少。

二、图像显示技术图像显示是将解码后的图像数据在屏幕上显示的过程。

在嵌入式Linux系统中,常用的图像显示技术有以下几种:2.1 Framebuffer技术Framebuffer技术是一种直接操作显存的图像显示技术,其在嵌入式Linux系统中得到了广泛应用。

Framebuffer技术通过在显存中维护一个或多个帧缓冲区,将解码后的图像数据直接写入显存,实现图像的快速显示。

2.2 DirectFB技术DirectFB技术是一种轻量级的图像显示技术,其在嵌入式Linux系统中也得到了广泛应用。

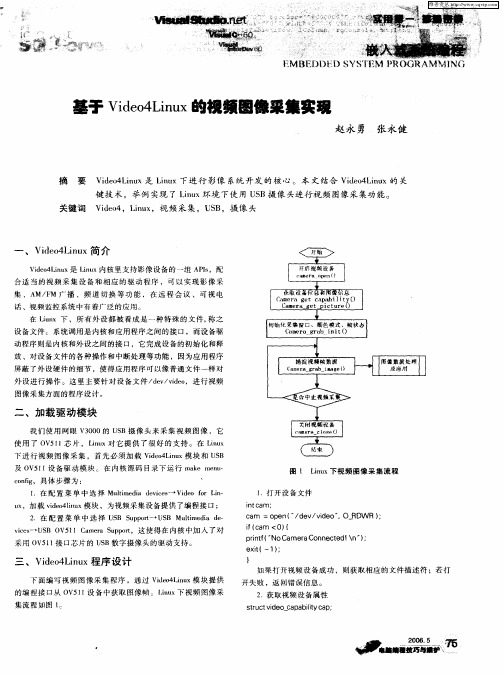

基于Video4Linux的视频图像采集实现

。…一 _ 一 。

二 、加 载 驱 动 模 块

我们使 用网眼 V 0 0的 U B摄像 头来 采集 视频 图像 ,它 30 S

使 用 了 O 5 1芯 片 ,Lnx对 它 提 供 了很 好 的 支 持 。在 Ln x VI i u iu

下进行 视频图像 采集 ,首 先必须 加载 Vd oLn x模块和 U B ie4 iu S

维普资讯

‘

:

* , ≮

诵 }|龋 殴, 鼍I 翩 |.

| 龋 囊

。

:一 1甥蠛 l l 碍 … 疆 l 遵 秘

BED1ll )t )SY M } ) R0GRAM 1 NG

VdoLnx i 4 i 的视频囝像粟集实现 e u

e i{一1 : xt ) }

三 、V d o Ln x程序 设 计 ie 4 iu

下 面 编 写 视 频 图 像 采 集 程 序 ,通 过 V do Ln x 块 提 供 ie4 iu 模

如 果 打 开 视 频 设 备 成 功 ,则 获 取 相 应 的 文件 描 述 符 ;若 打

开 失 败 ,返 回错 误 信 息 。

话 、视 频 监 控 系 统 中有 着广 泛 的 应 用 。

~

在 Lux 下 ,所 有 外 设 都 被 看 成 是 一 种 特 殊 的 文 件 , 之 in 称

。 誊__核 和外 设 之 间 的 接 口 ,它 完 成 设 备 的 初 始 化 和 释 _ 一 量 鼍则 是 序 一. * 鼻 动程 内

0操 作 ,实 现 高 速 视 频 采 集 ,还 可 以利 用 多 进 程 技 术 实 现 数 据

共享。

s r c ie b f i b f tu t d o m u d u ; v v u sg e h r:g a d t ; n i n dc a : r b a a :

基于嵌入式Linux视频图像采集系统的设计与实现

20 0 8年第 7期

福 建 电

脑

13 5

基 于嵌入式 Ln x iu 视频 图像采集 系统 的设计与 实现

许 明流 ,邓 王 国 ,刘 智 勇

( 邑大 学 34信 箱 广 东 江 f 2 0 0) 五 0 1 92 5 【 摘 要 J 利 用 AR 技 术 设 计 和 实现 了一种 基 于 嵌入 式 Lnx的视 频 采 集 系统 。 该 系统 通 过 U B摄 像 头 采 集视 频 图 : M iu S 像 , 用 Lnx的 Vdo 调 iu ie4接 口模 块进行视频截取和数 字化处理 , 用嵌入式 Q 使 T完成 图形界面的开发。系统测试结果表 明: 该

对 L n x经过 小 型 化 裁 减 后 .能 够 固化 在 容 量 只有 几 百 K字 节 iu

( h e; coys I o f ue- lfr n x gn r — + e oyseh e ). ni r pa om l u— eei g + c / c g t i c

-

或 几 兆 字 节 的储 存 器 芯 片 中 . 于 特 定 嵌入 式场 合 的 专用 Ln x 用 iu

无 线 系统 等 各类 产 品 市 场 . 于 A M 技 术 的 微处 理 器 应 用 占据 用 第 ~ 种 方 式 所 用 S C 4 0 基 R B 2 1 X开 发 板 的 U B主控 器 驱 动 程序 S 了 3 位 RS 2 IC微 处 理 器 7 % 以上 的 市 场 份 额 . R 技 术 正 在 逐 模 块 为 U B O C —s C 4 0 在 Ln x 要 采 集 视 频类 数 据 . O A M S — H I 321 。 i 下 u 还

操 作 系 统

linuxusb免驱摄像头模块原理

linuxusb免驱摄像头模块原理摄像头在现代计算机和嵌入式系统中被广泛使用,用于视频会议、视频监控、电子商务、游戏等众多应用。

在Linux系统中,摄像头模块可以直接插入,并自动识别和配置,这就是所谓的免驱动(Plug and Play)功能。

本文将介绍LinuxUSB免驱摄像头模块的原理。

1.摄像头硬件架构摄像头作为一种外部设备,需要与计算机系统进行数据交互。

它通常由图像传感器、图像处理芯片、电源芯片和USB接口等部分组成。

图像传感器负责将图像光信号转换为电信号,然后通过图像处理芯片对图像进行处理,最终通过USB接口将处理后的数据传输给计算机。

摄像头模块通常还包含一些额外的功能,如自动对焦、光圈控制、白平衡等。

2. LinuxUSB框架在Linux操作系统中,USB设备的驱动和管理是通过LinuxUSB框架实现的。

LinuxUSB由两部分组成:USB核心驱动和USB设备驱动。

USB核心驱动负责枚举、配置和通信等底层操作,而USB设备驱动则负责与特定设备进行通信。

3.摄像头驱动摄像头在Linux系统中使用的驱动程序一般是V4L2(Video4Linux2)驱动。

V4L2是Linux中用于支持视频设备的驱动框架,它定义了一套API和数据结构,用于访问和控制支持V4L2的设备。

摄像头驱动通常包括两部分:摄像头传感器驱动和摄像头设备驱动。

摄像头传感器驱动负责和硬件传感器交互,控制图像数据的采集和传输;摄像头设备驱动则负责将采集到的图像数据转换为V4L2支持的格式,并提供给上层应用程序。

4.摄像头模块工作流程当摄像头插入到Linux系统中时,USB核心驱动会自动检测到设备并加载对应的驱动程序。

在驱动加载完成后,摄像头传感器开始采集图像数据,并通过摄像头设备驱动将数据传输给V4L2驱动。

V4L2驱动在应用程序请求时会将摄像头的图像数据提供给应用程序。

应用程序可以使用V4L2提供的API进行图像的捕获、处理和显示。

基于Linux平台的图像采集系统的设计与实现

系统 ,而 Ln x系统作为一个开放 的操作 系统具有 独立性 、 iu

创新性 、可扩展性 等优点 ,适合 开发 独立 的具有创 新性 的

图像采集系统_ ,但 由于 Ln x系统是源码开放 ,没有 一 7 。 iu

-

7作模 型并且设计 实现 了系统 的硬件平 台和软件平 台,实验 结果表 明,该 系统可 以安全 可靠的控制全 方位 转动的摄像机 对 - -

环境信 息进行 高清晰 图像采集 ,有效的提 高了图像采集速 度和准确 性。

关 键 词 :Ln x 台 ; 图像 采 集 ;视 频 处 理 ;模 块 化 ;可扩 展 性 iu 平 中 图法 分 类 号 : 3 2 1 TP 0 . 文献 标 识 号 :A 文章 编 号 :10 —0 4 (0 2 62 3 —4 0 07 2 2 1 )0 —3 40

后来 随着计算机 技术 的发展 ,采 集卡作 为 图像 采集 系统不 可缺少 的硬件逐 渐被应 用在 图像采集 系统 中 ,利用 图像采 集 卡可以轻松 的将模 拟摄像 机 的图像信 号采集 进来 进行处

理 ,采集卡 的软件界 面也很轻松 的应用 在图像采集 系统 中, 所以利用采 集卡 和模 拟摄像 机可 轻松 的完成 图像采 集 系统 的设计 ,模 拟摄 像机 的 图像 采集技 术成熟 易实 现 ,但 图像 采集的速度慢 、抗干扰 能力 差 ,由于 噪声多 造成采 集 的图 像不清晰 ,操作 不方便 ,由于这 些缺 点这种技 术 已渐渐 的

在早期的 图像采集 系统 的研究 中,由于 硬件大 多采 用 的是装有 C MOS芯片的摄像机 ,由于 C S芯 片只能采集 MO 模拟信号 ,所 以要使 用模Байду номын сангаас摄 像机 进行 图像采 集系统 的研 究 ,还需要额 外 的对模 拟 信号 进行 处 理 以得 到 数 字信 号 。

Linux操作系统在图像识别中的应用

Linux操作系统在图像识别中的应用随着计算机技术的不断进步,图像识别已经成为人工智能领域的一个重要应用方向。

而作为开源操作系统的代表,Linux在图像识别领域也发挥着重要的作用。

本文将重点介绍Linux操作系统在图像识别中的应用,并探讨其在该领域的优势与挑战。

一、Linux在图像识别中的应用场景1. 人脸识别人脸识别是图像识别领域最常见的应用之一。

Linux操作系统提供了丰富的开源工具和库,如OpenCV、Dlib等,可以帮助开发人员实现人脸检测、人脸识别和人脸表情分析等功能。

通过Linux操作系统,我们可以利用这些工具与算法,开发出高效准确的人脸识别系统。

2. 图像分类图像分类指的是将图像分为不同的类别。

在图像识别中,Linux操作系统提供了多种深度学习框架,如TensorFlow、PyTorch等,这些框架可以帮助我们实现图像分类的算法与模型。

通过Linux操作系统,我们可以轻松构建高效的图像分类系统,实现对图像进行准确快速的分类。

3. 目标检测目标检测是图像识别中的重要任务之一,它不仅要求识别出图像中的目标物体,还需要对目标进行准确的定位。

Linux操作系统提供了一系列目标检测的算法与库,如YOLO、Faster R-CNN等。

通过Linux操作系统,我们可以利用这些开源工具,开发出高效准确的目标检测系统,满足不同领域的需求。

二、Linux在图像识别中的优势1. 开源平台作为开源操作系统,Linux为开发人员提供了大量开源工具、框架和库,这些工具强大且灵活,可以方便地进行图像识别算法的开发与实现。

而且,Linux的开放性也使得开发者可以自由地调整和修改算法代码,以满足实际应用中的需求。

2. 高性能计算Linux操作系统以其卓越的性能著称,能够充分发挥计算机的硬件资源,提供高效的计算能力。

在图像识别领域,计算量通常很大,需要使用大规模的数据集进行训练和推理。

Linux操作系统能够有效管理硬件资源,提供稳定可靠的计算环境,从而提高图像识别的效率和准确性。

嵌入式Linux下Camera编程--V4L2剖析

最近有个需求,要在ARM Linux上实现USB Camera 拍照功能。

0. 背景知识:首先要确认的是,Kernel是否支持USB Camera。

因为Linux下,USB协议除了电气协议和标准,还有很多Class。

这些Class就是为了支持和定义某一类设备接口和交互数据格式。

只要符合这类标准,则不同厂商的USB设备,不需要特定的driver就能在Linux下使用。

例如:USB Input class,则使所有输入设备都可以直接使用。

还有类似Audio Class,Pring Class,Ma ss Storage Class,video class等。

其中Video Class 就是我们常说的UVC(USB Video Class). 只要USB Camera符合UVC标准。

理论上在2.6 Kernel Linux 就可以正常使用。

网络上有人谈到怎样判断是否UVC Camera设备:#lsusbBus 001 Device 010: ID 046d:0825 Logitech, Inc.#lsusb -d 046d:0825 -v | grep "14 Video"如果出现:bInterfaceClass 14 VideobInterfaceClass 14 VideobInterfaceClass 14 VideobInterfaceClass 14 VideobInterfaceClass 14 VideobInterfaceClass 14 VideobInterfaceClass 14 VideobInterfaceClass 14 VideobInterfaceClass 14 VideobInterfaceClass 14 VideobInterfaceClass 14 VideobInterfaceClass 14 VideobInterfaceClass 14 Video则说明是支持UVC.1. Kernel配置:Device Drivers ---> <*> Multimedia support ---> <M> Video For LinuxDevice Drivers ---> <*> Multimedia support ---> [*] Video captureadapters ---> [*] V4L USB devices ---> <M> USB Video Class (UVC)--- V4L USB devices : 这里还有很多特定厂商的driver.可供选择。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

这一部分将会介绍如何在linux中对电视卡编程。

开始已经提到过,电视卡使用的是video for linux驱动,简称v4l,实际上,现在已经有了videofor linux two驱动 ,即v4l2.它解决了v4l中存在的一些问题,并且提高了硬件性能。

但是,目前来说,v4l2仍然没有集成到linux的内核中,要使用v4l2的话,只有去下载v4l2补丁了,以下如无特别说明,所涉及的内容只针对v4l设备而言。

我们都知道,在linux中,为了屏蔽用户对设备访问的复杂性,采用了设备文件,即可以通过像访问普通文件一样的方式来对设备进行访问读写。

电视卡在linux中和打印机,鼠标一样,属于字符设备。

其主设备号是81,在实际操作上,访问控制电视卡也和一般的设备文件没有什么不同。

用open打开设备,int fd;fd = open("/dev/video0",O_RDWR);用一系列的ioctl发命令控制设备。

v4l支持的ioctl命令大概有二十几个,为了尽快的编出一个简单的图象捕捉程序,让我们先来看看几个主要的命令:1. ioctl(fd,VIDIOCGCAP,&cap);该命令主要是为了获取电视卡的功能信息。

例如电视卡的名称,类型,channel等。

参数cap是一个结构,当ioctl命令返回时,结构的各成员就被赋值了,结构体的定义为:struct video_capability{char name[32];int type;int channels; /* Num channels */int audios; /* Num audio devices */int maxwidth; /* Supported width */int maxheight; /* And height */int minwidth; /* Supported width */int minheight; /* And height */};channel 指的是有几个信号输入源,例如television,composite,s-video等。

2.ioctl(fd,VIDIOCGCHAN,&vc)3.ioctl(fd,VIDIOCSCHAN.&vc)这两个命令用来取得和设置电视卡的channel信息,例如使用那个输入源,制式等。

vc 是一个video_channel结构,其定义为:struct video_capability{char name[32];int type;int channels; /* Num channels */int audios; /* Num audio devices */int maxwidth; /* Supported width */int maxheight; /* And height */int minwidth; /* Supported width */int minheight; /* And height */};struct video_channel{int channel;char name[32];int tuners;//number of tuners for this input__u32 flags;__u16 type;__u16 norm;};成员channel代表输入源,通常,0: television 1:composite1 2:s-videoname 表示该输入源的名称。

norm 表示制式,通常,0:pal 1:ntsc 2:secam 3:auto4. ioctl(fd,VIDIOCGMBUF,*mbuf)获得电视卡缓存的信息,参数mbuf是video_mbuf结构。

其定义如下:struct video_mbuf{int size; /* Total memory to map */int frames; /* Frames */int offsets[VIDEO_MAX_FRAME];};size是缓存的大小,frames表明该电视卡的缓存可以容纳的帧数,数组offsets则表明对应一帧的起始位置,0帧对应offsets[0],1帧对应offsets[1]....执行完该命令后,就可以用mmap函数将缓存映射到内存中了。

大致用法可以参考以下的代码struct video_mbuf mbuf;unsigned char *buf1,*buf2;if(ioctl(fd,VIDIOCGMBUF,&mbuf)<0){perror("VIDIOCGMBUF");return -1;}printf("the frame number is %d\n",mbuf.frames);buf1 = (unsigned char*)mmap(0,mbuf.size,PROT_READ|PROT_WRITE,MAP_SHARED,fd.0);buf1 = buf1 + mbuf.offset[0];buf2 = buf1 + mbuf.offset[1];//当然,如果mbuf.frames=1,就不需要下面的了。

......5. ioctl(fd.VIDIOCMCAPTURE,&mm)启动硬件去捕捉图象,mm 是video_mmap 结构,设置捕捉图象需要设置的信息。

结构体如下定义:struct video_mmap{unsigned int frame; /* Frame (0 - n) for double buffer */int height,width;unsigned int format; /* should be VIDEO_PALETTE_* */ };frame :设置当前是第几帧height,width:设置图象的高和宽。

format :颜色模式要注意的是,该命令是非阻塞的,也就是说,它仅仅设置了硬件,而不负责是否捕捉到图象。

要确定是否捕捉到图象,要用到下一个命令。

6. ioctl(fd,VIDIOCSYNC,&frame)等待捕捉到这一帧图象。

frame 是要等待的图象,它的值应和上一个命令中设置的frame相对应。

好了,说了这么多,读者大概也对视频捕捉有了一个了解,是不是想亲自动手试一下,那就让我们开始实际程序的编写吧。

下面我们会编一个程序,将捕捉到的图象存为jpeg文件。

为此,还要向大家介绍一个函数,int write_jpeg(char *filename,unsigned char *buf,int quality,int width, int height, int gray){struct jpeg_compress_struct cinfo;struct jpeg_error_mgr jerr;FILE *fp;int i;unsigned char *line;int line_length;if (NULL == (fp = fopen(filename,"w"))){fprintf(stderr,"grab: can'topen %s: %s\n",filename,strerror(errno));return -1;}cinfo.err = jpeg_std_error(&jerr);jpeg_create_compress(&cinfo);jpeg_stdio_dest(&cinfo, fp);cinfo.image_width = width;cinfo.image_height = height;cinfo.input_components = gray ? 1: 3;cinfo.in_color_space = gray ? JCS_GRAYSCALE: JCS_RGB;jpeg_set_defaults(&cinfo);jpeg_set_quality(&cinfo, quality, TRUE);jpeg_start_compress(&cinfo, TRUE);line_length = gray ? width : width * 3;for (i = 0, line = buf; i < height; i++, line += line_length) jpeg_write_scanlines(&cinfo, &line, 1);jpeg_finish_compress(&(cinfo));jpeg_destroy_compress(&(cinfo));fclose(fp);return 0;}这个函数很通用,它的作用是把buf中的数据压缩成jpeg格式。

/* 下面是一个完整的程序 test.c* gcc test.c -o test -ljpeg*/#include <stdio.h>#include <stdlib.h>#include <sys/types.h>#include <sys/stat.h>#include <fcntl.h>#include <sys/ioctl.h>#include <sys/mman.h>#include <errno.h>#include <linux/videodev.h>#include <jpeglib.h>#define WIDTH 320#define HEIGHT 240#define V4L_DEVICE "/dev/video0"main(){unsigned char* buf;int i,j;int fd;int re;struct video_capability vcap;struct video_channel vc;struct video_mbuf mbuf;struct video_mmap mm;fd = open(V4L_DEVICE, O_RDWR);if(fd<=0){perror("open");exit(1);}if(ioctl(fd, VIDIOCGCAP, &vcap)<0){perror("VIDIOCGCAP");exit(1);}fprintf(stderr,"Video Capture Device Name : %s\n",);for(i=0;i<vcap.channels;i++){vc.channel = i;if(ioctl(fd, VIDIOCGCHAN, &vc)<0){perror("VIDIOCGCHAN");exit(1);}fprintf(stderr,"Video Source (%d) Name : %s\n",i, );}vc.channel =1;vc.norm=1;if(ioctl(fd, VIDIOCSCHAN, &vc) < 0){perror("VIDIOCSCHAN");exit(1);}if(ioctl(fd, VIDIOCGMBUF, &mbuf) < 0){perror("VIDIOCGMBUF");exit(1);}fprintf(stderr,"the frames number is %d\n",mbuf.frames);buf = (unsigned char*)mmap(0, mbuf.size, PROT_READ|PROT_WRITE, MAP_SHARED, fd, 0);if((int)buf < 0){perror("mmap");exit(1);}mm.frame = 0;mm.height = HEIGHT;mm.width = WIDTH;mm.format = VIDEO_PALETTE_RGB24;if(ioctl(fd, VIDIOCMCAPTURE, &mm)<0){perror("VIDIOCMCAPTURE");exit(1);}if(ioctl(fd, VIDIOCSYNC, &mm.frame)<0){perror("VIDIOCSYNC");exit(1);}if(-1 == (write_jpeg("./pic001.jpeg",buf,75,WIDTH,HEIGHT,0))) {printf("write_jpeg error\n");exit(1);}munmap(buf,mbuf.size);close(fd);}。