细细品味Hadoop_Hadoop集群(第5期)_Hadoop安装配置_转转大师

Hadoop集群安装配置教程_Hadoop2.6.0_Ubuntu_CentOS

Hadoop集群安装配置教程_Hadoop2.6.0_Ubuntu/CentOS本教程讲述如何配置Hadoop 集群,默认读者已经掌握了Hadoop 的单机伪分布式配置,否则请先查看Hadoop安装教程_单机/伪分布式配置或CentOS安装Hadoop_单机/伪分布式配置。

本教程由厦门大学数据库实验室出品,转载请注明。

本教程适合于原生Hadoop 2,包括Hadoop 2.6.0, Hadoop 2.7.1 等版本,主要参考了官方安装教程,步骤详细,辅以适当说明,保证按照步骤来,都能顺利安装并运行Hadoop。

另外有Hadoop安装配置简略版方便有基础的读者快速完成安装。

为了方便新手入门,我们准备了两篇不同系统的Hadoop 伪分布式配置教程。

但其他Hadoop 教程我们将不再区分,可同时适用于Ubuntu 和CentOS/RedHat 系统。

例如本教程以Ubuntu 系统为主要演示环境,但对Ubuntu/CentOS 的不同配置之处、CentOS 6.x 与CentOS 7 的操作区别等都会尽量给出注明。

环境本教程使用Ubuntu 14.04 64位作为系统环境,基于原生Hadoop 2,在Hadoop 2.6.0 (stable)版本下验证通过,可适合任何Hadoop 2.x.y 版本,例如Hadoop 2.7.1,Hadoop 2.4.1 等。

本教程简单的使用两个节点作为集群环境: 一个作为Master 节点,局域网IP 为192.168.1.121;另一个作为Slave 节点,局域网IP 为192.168.1.122。

准备工作Hadoop 集群的安装配置大致为如下流程:1.选定一台机器作为Master2.在Master 节点上配置hadoop 用户、安装SSH server、安装Java 环境3.在Master 节点上安装Hadoop,并完成配置4.在其他Slave 节点上配置hadoop 用户、安装SSH server、安装Java 环境5.将Master 节点上的/usr/local/hadoop 目录复制到其他Slave 节点上6.在Master 节点上开启Hadoop配置hadoop 用户、安装SSH server、安装Java 环境、安装Hadoop 等过程已经在Hadoop安装教程_单机/伪分布式配置或CentOS安装Hadoop_单机/伪分布式配置中有详细介绍,请前往查看,不再重复叙述。

Hadoop集群部署架构解析与部署指南

Hadoop集群部署架构解析与部署指南随着大数据时代的到来,Hadoop成为了处理海量数据的重要工具。

Hadoop是一个开源的分布式计算框架,它的核心是Hadoop Distributed File System(HDFS)和MapReduce计算模型。

在本文中,我们将深入探讨Hadoop集群的部署架构,并提供一份详细的部署指南。

一、Hadoop集群的部署架构解析Hadoop集群的部署架构通常包括主节点(Master Node)和从节点(Slave Node)。

主节点负责管理整个集群的运行,从节点则负责存储和计算数据。

在一个典型的Hadoop集群中,主节点包括一个主服务器(NameNode)和一个备用服务器(Secondary NameNode),从节点则包括多个数据节点(DataNode)和任务节点(TaskTracker)。

主服务器(NameNode)是HDFS的核心组件,负责管理文件系统的命名空间和数据块的分配。

它存储了文件系统的元数据,包括文件的目录结构、文件的权限和数据块的位置等。

备用服务器(Secondary NameNode)则负责定期合并和压缩主服务器的编辑日志,以减轻主服务器的负载。

数据节点(DataNode)是HDFS中存储实际数据的节点,它们负责数据的读写和块的复制。

数据节点将数据分为多个块,并将这些块存储在本地磁盘上。

任务节点(TaskTracker)则负责执行MapReduce任务,包括数据的切分、映射和归约。

任务节点通过与数据节点的通信,将计算任务分配给适当的数据节点。

二、Hadoop集群的部署指南1. 硬件要求在部署Hadoop集群之前,首先需要考虑硬件要求。

主节点和从节点通常需要具备相同的硬件配置,包括CPU、内存和磁盘空间。

建议使用多核CPU和大容量内存,以提高集群的计算和存储能力。

此外,还需要足够的磁盘空间来存储数据块和计算结果。

2. 操作系统选择Hadoop支持多种操作系统,包括Linux、Windows和Mac OS等。

Hadoop集群配置详细解读

从当前用户切换root用户的命令如下:

Linux系统配置

操作步骤需要在HadoopMaster和HadoopSlave节点

上分别完整操作,都是用root用户。 从当前用户切换root用户的命令如下:

su root

从当前用户切换root用户的命令如下:

Linux系统配置

1拷贝软件包和数据包 mv ~/Desktop/software ~/

所有的操作都是用自定义用户(dhx)

su dhx

Hadoop安装包解压

cp hadoop-1.2.1.tar.gz ~/

cd

tar -zxvf hadoop-1.2.1.tar.gz

cd hadoop-1.2.1

从当前用户切换root用户的命令如下: 编辑主机名列表的命令

Hadoop集群配置手册(详细) 太原理工大学 邓红霞

提 纲

启动两台虚拟客户机

Linux系统配置 Hadoop配置部署 启动Hadoop集群 HDFS下的文件操作 Eclipse在Hadoop中的使用及配置

启动两台虚拟客户机

打开VMware Workstation10,打开已经安装好 的虚拟机HadoopMaster和HadoopSlave 。 如果之前没有打开过两个虚拟机,请使用文件 ->打开选项,选择之前的虚拟安装包。

Linux系统配置

6配置hosts列表 编辑主机名列表的命令,并添加如下两行到文件 gedit /etc/hosts 192.168.58.128 master 192.168.58.129 slave ping master ping slave

从当前用户切换root用户的命令如下: 编辑主机名列表的命令

一步步教你Hadoop多节点集群安装配置

⼀步步教你Hadoop多节点集群安装配置1、集群部署介绍1.1 Hadoop简介Hadoop是Apache软件基⾦会旗下的⼀个开源分布式计算平台。

以Hadoop分布式⽂件系统HDFS(Hadoop Distributed Filesystem)和MapReduce(Google MapReduce的开源实现)为核⼼的Hadoop为⽤户提供了系统底层细节透明的分布式基础架构。

对于Hadoop的集群来讲,可以分成两⼤类⾓⾊:Master和Salve。

⼀个HDFS集群是由⼀个NameNode和若⼲个DataNode组成的。

其中NameNode作为主服务器,管理⽂件系统的命名空间和客户端对⽂件系统的访问操作;集群中的DataNode管理存储的数据。

MapReduce框架是由⼀个单独运⾏在主节点上的JobTracker和运⾏在每个从节点的TaskTracker共同组成的。

主节点负责调度构成⼀个作业的所有任务,这些任务分布在不同的从节点上。

主节点监控它们的执⾏情况,并且重新执⾏之前的失败任务;从节点仅负责由主节点指派的任务。

当⼀个Job被提交时,JobTracker接收到提交作业和配置信息之后,就会将配置信息等分发给从节点,同时调度任务并监控TaskTracker的执⾏。

从上⾯的介绍可以看出,HDFS和MapReduce共同组成了Hadoop分布式系统体系结构的核⼼。

HDFS在集群上实现分布式⽂件系统,MapReduce在集群上实现了分布式计算和任务处理。

HDFS在MapReduce任务处理过程中提供了⽂件操作和存储等⽀持,MapReduce 在HDFS的基础上实现了任务的分发、跟踪、执⾏等⼯作,并收集结果,⼆者相互作⽤,完成了Hadoop分布式集群的主要任务。

1.2 环境说明我的环境是在虚拟机中配置的,Hadoop集群中包括4个节点:1个Master,2个Salve,节点之间局域⽹连接,可以相互ping通,节点IP地址分布如下:虚拟机系统机器名称IP地址Ubuntu 13.04Master.Hadoop192.168.1.141Ubuntu 9.11Salve1.Hadoop192.168.1.142Fedora 17Salve2.Hadoop192.168.1.137Master机器主要配置NameNode和JobTracker的⾓⾊,负责总管分布式数据和分解任务的执⾏;3个Salve机器配置DataNode和TaskTracker的⾓⾊,负责分布式数据存储以及任务的执⾏。

Hadoop集群安装与配置及其示例程序运行说明文件

Hadoop集群安装与配置及其示例程序的运行(虚拟机下实现)系统:Ubuntu 12.04虚拟机软件:VMware WorkstationHadoop2.6.0【特别声明:安装的Ubuntu虚拟机操作系统的位数一定要和Hadoop的位数一致!!建议都装64位的。

】单机情况下安装:一、安装jdk 【我下载的jdk版本是:jdk-7u51-linux-i586.tar.gz。

安装后的版本号是:jdk1.7.0_75】去下载jdk-***.tar.gz文件,下载完得到压缩包,解压到要安装的目录下。

(例如解压到/etc下)命令:tar -zxvf jdk-***.tar.gz -C ~/etc 【将jdk压缩包解压到/etc目录下】设置坏境变量:修改用户目录下的.bashrc文件【命令是$ gedit ~/.bashrc】,在文件末尾加入:set JAVA_HOME=/home/becy/etc/jdk1.7.0_75export JAVA_HOMEset JRE_HOME=/home/becy/etc/jdk1.7.0_75/jreExport JRE_HOMEset PATH=$JAVA_HOME/bin:$PATHexport PATHset CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jarexport CLASSPATH保存文件后退出。

然后再命令行输入$ source ~/.bashrc使刚才设置的环境变量生效。

接着输入命令$ java -version会弹出以下窗口:然后按照提示,在命令行输入$ sudo apt-get install openjdk-7-jre-headles s完成jdk 的安装工作【安装过程约20分钟】。

接着测试是否安装成功输入命令:$ java –version以上显示则安装成功。

二、添加专用的Hadoop系统用户我们将利用专用用户来运行Hadoop,这不是必须的,但是建议这么做,主要考虑安全,权限等问题。

hadoop集群配置

集群上部署HADOOP,构建HDFS(1)分布式计算开源框架Hadoop入门实践其实参看Hadoop官方文档已经能够很容易配置分布式框架运行环境了,不过这里既然写了就再多写一点,同时有一些细节需要注意的也说明一下,其实也就是这些细节会让人摸索半天。

Hadoop可以单机跑,也可以配置集群跑,单机跑就不需要多说了,只需要按照Demo的运行说明直接执行命令即可。

这里主要重点说一下集群配置运行的过程。

1环境7台普通的机器,操作系统都是Linux。

内存和CPU就不说了,反正Hadoop一大特点就是机器在多不在精。

JDK必须是1.5以上的,这个切记。

7台机器的机器名务必不同,后续会谈到机器名对于MapReduce有很大的影响。

2部署考虑正如上面我描述的,对于Hadoop的集群来说,可以分成两大类角色:Master和Slave,前者主要配置NameNode和JobTracker的角色,负责总管分布式数据和分解任务的执行,后者配置DataNode和TaskTracker的角色,负责分布式数据存储以及任务的执行。

本来我打算看看一台机器是否可以配置成Master,同时也作为Slave使用,不过发现在NameNode初始化的过程中以及TaskTracker执行过程中机器名配置好像有冲突(NameNode和TaskTracker对于Hosts的配置有些冲突,究竟是把机器名对应IP放在配置前面还是把Localhost对应IP放在前面有点问题,不过可能也是我自己的问题吧,这个大家可以根据实施情况给我反馈)。

最后反正决定一台Master,六台Slave,后续复杂的应用开发和测试结果的比对会增加机器配置。

3实施步骤1.在所有的机器上都建立相同的目录,也可以就建立相同的用户,以该用户的home路径来做hadoop的安装路径。

例如我在所有的机器上都建立了/home/wenchu。

2.下载Hadoop,先解压到Master上。

这里我是下载的0.17.1的版本。

Hadoop集群安装详细步骤

Hadoop集群安装详细步骤|Hadoop安装配置文章分类:综合技术Hadoop集群安装首先我们统一一下定义,在这里所提到的Hadoop是指Hadoop Common,主要提供DFS(分布式文件存储)与Map/Reduce的核心功能。

Hadoop在windows下还未经过很好的测试,所以笔者推荐大家在linux(cent os 5.X)下安装使用。

准备安装Hadoop集群之前我们得先检验系统是否安装了如下的必备软件:ssh、rsync和Jdk1.6(因为Hadoop需要使用到Jdk中的编译工具,所以一般不直接使用Jre)。

可以使用yum install rsync来安装rsync。

一般来说ssh是默认安装到系统中的。

Jdk1.6的安装方法这里就不多介绍了。

确保以上准备工作完了之后我们就开始安装Hadoop软件,假设我们用三台机器做Hadoop集群,分别是:192.168.1.111、192.168.1.112和192.168.1.113(下文简称111,112和113),且都使用root用户。

下面是在linux平台下安装Hadoop的过程:在所有服务器的同一路径下都进行这几步,就完成了集群Hadoop软件的安装,是不是很简单?没错安装是很简单的,下面就是比较困难的工作了。

集群配置根据Hadoop文档的描述“The Hadoop daemons are N ameNode/DataNode and JobTracker/TaskTracker.”可以看出Hadoop核心守护程序就是由NameNode/DataNode 和JobTracker/TaskTracker这几个角色构成。

Hadoop的DFS需要确立NameNode与DataNode角色,一般NameNode会部署到一台单独的服务器上而不与DataNode共同同一机器。

另外Map/Reduce服务也需要确立JobTracker和TaskTracker的角色,一般JobTracker与NameNode共用一台机器作为master,而TaskTracker与DataNode同属于slave。

centos安装配置hadoop超详细过程

1、集群部署介绍1.1 Hadoop简介Hadoop是Apache软件基金会旗下的一个开源分布式计算平台。

以Hadoop分布式文件系统(HDFS,Hadoop Distributed Filesystem)和MapReduce(Google MapReduce的开源实现)为核心的Hadoop为用户提供了系统底层细节透明的分布式基础架构。

对于Hadoop的集群来讲,可以分成两大类角色:Master和Salve。

一个HDFS集群是由一个NameNode和若干个DataNode组成的。

其中NameNode作为主服务器,管理文件系统的命名空间和客户端对文件系统的访问操作;集群中的DataNode管理存储的数据。

MapReduce框架是由一个单独运行在主节点上的JobTracker和运行在每个集群从节点的TaskTracker共同组成的。

主节点负责调度构成一个作业的所有任务,这些任务分布在不同的从节点上。

主节点监控它们的执行情况,并且重新执行之前的失败任务;从节点仅负责由主节点指派的任务。

当一个Job被提交时,JobTracker接收到提交作业和配置信息之后,就会将配置信息等分发给从节点,同时调度任务并监控TaskTracker的执行。

从上面的介绍可以看出,HDFS和MapReduce共同组成了Hadoop分布式系统体系结构的核心。

HDFS在集群上实现分布式文件系统,MapReduce在集群上实现了分布式计算和任务处理。

HDFS在MapReduce任务处理过程中提供了文件操作和存储等支持,MapReduce在HDFS的基础上实现了任务的分发、跟踪、执行等工作,并收集结果,二者相互作用,完成了Hadoop分布式集群的主要任务。

1.2 环境说明集群中包括4个节点:1个Master,3个Salve,节点之间局域网连接,可以相互ping通,具体集群信息可以查看"Hadoop集群(第2期)"。

节点IP地址分布如下:机器名称IP地址Master.Hadoo p 192.168.1 .2Salve1.Hadoo p 192.168.1 .3Salve2.Hadoo p 192.168.1 .4Salve3.Hadoo p 192.168.1 .5四个节点上均是CentOS6.0系统,并且有一个相同的用户hadoop。

hadoop安装配置

Hadoop安装配置一、环境配置:jdk版本:1.6以上二、安装jdk1.JDK下载: 下载自解压包: jdk-6u13-linux-i586.bin$sh jdk-6u13-linux-i586.bin 按提示选择yes.或者$chmod 755 jdk-6u13-linux-i586.bin$./jdk-6u13-linux-i586.bin 解压后$mv jdk1.6.0_13 /usr/local/ //将其移到相应目录下到此JDK已经安装完成2.删除原有的JDK (如果之前安装过)$ alternatives –remove java /usr/share/java/libgcj-java-placeholder.sh$ alternatives --remove javac/usr/share/java/libgcj-javac-placeholder.sh$ alternatives --remove jar /usr/bin/fastjar$ alternatives --remove jar.1.gz /usr/share/man/man1/fastjar.1.gz3.创建软连接,方便使用a、删去原有链接(如果之前安装过)到/usr/bin目录下,把原用的java, javac文件删除:$rm –rf java $rm –rf javacb、在/usr/bin 下建立软连接 java$ ln –s jdk1.6.0_13/bin/java /usr/bin/java$ ln -s jdk1.6.0_13/bin/javac /usr/bin/javacc、为了方便后面的工作建立两个软链接:$ cd /usr/local/$ ln -s jdk1.6.0_13 /usr/local/jdk$ ln -s jdk1.6.0_13/jre /usr/local/jre4.编写环境变量:编辑/etc/profile:$ sudo vi /etc/profile增加以下内容:JAVA_HOME=/usr/local/jdkJRE_HOME=/usr/local/jrePATH=$PATH:$JAVA_HOME/bin:JRE_HOME/binCLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar:$JRE_HOME/lib:export JAVA_HOME JRE_HOME PATH CLASSPATH5.使环境变量生效:$ source /etc/profile$ java -version//结果 java version "1.6.0_13" Java(TM) 2 Runtime Environment, StandardEdition (build 1.6.0_13) Java HotSpot(TM) Client VM (build 1.6.0_13, mixedmode, sharing三、安装配置ssh1、下载安装$ sudo apt-get install ssh 自动下载安装$ sudo apt-get install rsync 升级2、设置无密码访问a、在NameNode 上实现无密码登录本机:$ ssh-keygen -t dsa -P '' -f ~/.ssh/id_dsa ,直接回车,完成后会在~/.ssh/生成两个文件:id_dsa 和id_dsa.pub。

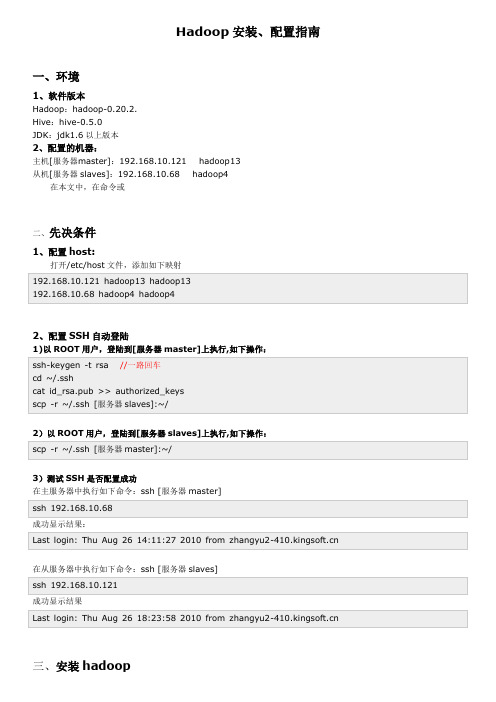

hadoop安装配置指南

Hadoop安装、配置指南一、环境1、软件版本Hadoop:hadoop-0.20.2.Hive:hive-0.5.0JDK:jdk1.6以上版本2、配置的机器:主机[服务器master]:192.168.10.121 hadoop13从机[服务器slaves]:192.168.10.68 hadoop4在本文中,在命令或二、先决条件1、配置host:打开/etc/host文件,添加如下映射192.168.10.121 hadoop13 hadoop13192.168.10.68 hadoop4 hadoop42、配置SSH自动登陆1)以ROOT用户,登陆到[服务器master]上执行,如下操作:ssh-keygen -t rsa //一路回车cd ~/.sshcat id_rsa.pub >> authorized_keysscp -r ~/.ssh [服务器slaves]:~/2)以ROOT用户,登陆到[服务器slaves]上执行,如下操作:scp -r ~/.ssh [服务器master]:~/3)测试SSH是否配置成功在主服务器中执行如下命令:ssh [服务器master]ssh 192.168.10.68成功显示结果:Last login: Thu Aug 26 14:11:27 2010 from 在从服务器中执行如下命令:ssh [服务器slaves]ssh 192.168.10.121成功显示结果Last login: Thu Aug 26 18:23:58 2010 from 三、安装hadoop1、JDK安装,解压到/usr/local/jdk1.6.0_17,并配置/etc/profile环境export JAVA_HOME=/usr/local/jdk/jdk1.7.0export PATH=$JAVA_HOME/bin:$JAVA_HOME/jre:$PATHexport CLASSPATH=$JAVA_HOME/lib:$JAVA_HOME/lib/tools.jarJDK路径:/usr/local/jdk/jdk1.7.0export JAVA_HOME=/usr/local/jdk/jdk1.7.0export PATH=$JAVA_HOME/bin:$JAVA_HOME/jre:$PATHexport CLASSPATH=$JAVA_HOME/lib:$JAVA_HOME/lib/tools.jar/usr/local/jdk/jdk1.7.02、下载Hadoop 并解压到[服务器master]的/root/zwmhadoop目录下tar zxvf hadoop-0.20.2.tar.gz四、配置hadoop1.配置主机[服务器master]到zwm hadoop/hadoop-0.20.2/ hadoop 目录下,修改以下文件:1)配置conf/hadoop-env.sh文件,在文件中添加环境变量,增加以下内容:export JAVA_HOME=/usr/local/jdk1.6.0_17export HADOOP_HOME=/root/zwmhadoop/hadoop-0.20.2/2)配置conf/core-site.xml文件,增加以下内容<?xml version="1.0"?><?xml-stylesheet type="text/xsl" href="configuration.xsl"?><!-- Put site-specific property overrides in this file. --><configuration><property><name></name><value>hdfs://192.168.10.121:9000</value>//你的namenode的配置,机器名加端口<description>The nam e of the default file system. Either the literal string "local" o r a host:port for DFS.</description></property></configuration>3)配置conf/hdfs-site.xml文件,增加以下内容<?xml version="1.0"?><?xml-stylesheet type="text/xsl" href="configuration.xsl"?><!-- Put site-specific property overrides in this file. --><configuration><property><name>hadoop.t m p.dir</name><value>/root/zwmhadoop/t m p</value>//Hadoop的默认临时路径,这个最好配置,然后在新增节点或者其他情况下莫名其妙的DataNode启动不了,就删除此文件中的t mp目录即可。

hadoop安装流程

hadoop安装流程Hadoop是一种开源的分布式数据处理框架,它的出现极大地简化了大数据处理的流程,成为了数据科学家们的有力工具。

在使用Hadoop之前,需要先完成其安装,在这里,我们将详细阐述Hadoop的安装流程。

第一步:下载Hadoop。

在Hadoop官网上,可以找到最新的Hadoop版本,选择合适的版本后进行下载。

下载完成后,需要进行解压操作,可以使用命令tar -zxvf xxxx.tar.gz 进行解压,其中xxxx 为Hadoop的安装包名称。

第二步:配置环境变量。

完成解压后,需要设置环境变量。

在bashrc文件中配置,export HADOOP_HOME=/usr/local/hadoopexport PATH=$HADOOP_HOME/bin:$PATHexport CLASSPATH=$HADOOP_HOME/lib/*:$CLASSPATH最后执行命令source ~/.bashrc,让环境变量立刻生效。

第三步:修改配置文件。

进入解压后文件夹中的/etc/hadoop文件夹,将其中的core-site.xml、hdfs-site.xml、mapred-site.xml、yarn-site.xml配置文件进行修改。

以core-site.xml为例,需要加入以下内容:<property><name></name><value>hdfs://localhost:9000</value></property>以hdfs-site.xml为例,需要加入以下内容:<property><name>dfs.replication</name><value>1</value></property><property><name>.dir</name><value>file:/usr/local/hadoop/hadoop_data/hdfs/namenode</valu e></property><property><name>dfs.datanode.data.dir</name><value>file:/usr/local/hadoop/hadoop_data/hdfs/datanode</valu e></property>以mapred-site.xml为例,需要加入以下内容:<property><name></name><value>yarn</value></property>以yarn-site.xml为例,需要加入以下内容:<property><name>yarn.nodemanager.aux-services</name><value>mapreduce_shuffle</value></property>第四步:格式化NameNode。

Hadoop安装配置超详细步骤

Hadoop安装配置超详细步骤Hadoop的安装1、实现linux的ssh无密码验证配置.2、修改linux的机器名,并配置/etc/hosts3、在linux下安装jdk,并配好环境变量4、在windows下载hadoop 1.0.1,并修改hadoop-env.sh,core-site.xml,hdfs-site.xml,mapred-site.xml,masters,slaves文件的配置5、创建一个给hadoop备份的文件。

6、把hadoop的bin加入到环境变量7、修改部分运行文件的权限8、格式化hadoop,启动hadoop注意:这个顺序并不是一个写死的顺序,就得按照这个来。

如果你知道原理,可以打乱顺序来操作,比如1、2、3,先哪个后哪个,都没问题,但是有些步骤还是得依靠一些操作完成了才能进行,新手建议按照顺序来。

一、实现linux的ssh无密码验证配置(1)配置理由和原理Hadoop需要使用SSH协议,namenode将使用SSH协议启动namenode和datanode进程,(datanode向namenode传递心跳信息可能也是使用SSH协议,这是我认为的,还没有做深入了解)。

大概意思是,namenode 和datanode之间发命令是靠ssh来发的,发命令肯定是在运行的时候发,发的时候肯定不希望发一次就弹出个框说:有一台机器连接我,让他连吗。

所以就要求后台namenode和datanode 无障碍的进行通信。

以namenode到datanode为例子:namenode作为客户端,要实现无密码公钥认证,连接到服务端datanode上时,需要在namenode上生成一个密钥对,包括一个公钥和一个私钥,而后将公钥复制到datanode上。

当namenode通过ssh连接datanode时,datanode就会生成一个随机数并用namenode的公钥对随机数进行加密,并发送给namenode。

hadoop完全分布式搭建步骤

Hadoop是一个开源的分布式计算框架,它能够处理大规模数据的存储和处理。

本文将介绍如何搭建Hadoop完全分布式集群。

一、准备工作1. 安装Java环境:Hadoop需要Java环境的支持,因此需要先安装Java环境。

2. 下载Hadoop:从官网下载Hadoop的最新版本。

3. 配置SSH:Hadoop需要通过SSH进行节点之间的通信,因此需要配置SSH。

二、安装Hadoop1. 解压Hadoop:将下载好的Hadoop压缩包解压到指定目录下。

2. 配置Hadoop环境变量:将Hadoop的bin目录添加到系统的PATH环境变量中。

3. 修改Hadoop配置文件:进入Hadoop的conf目录,修改hadoop-env.sh文件和core-site.xml 文件。

4. 配置HDFS:修改hdfs-site.xml文件,设置NameNode和DataNode的存储路径。

5. 配置YARN:修改yarn-site.xml文件,设置ResourceManager和NodeManager的地址和端口号。

6. 配置MapReduce:修改mapred-site.xml文件,设置JobTracker和TaskTracker的地址和端口号。

7. 格式化HDFS:在NameNode所在的节点上执行格式化命令:hadoop namenode -format。

8. 启动Hadoop:在NameNode所在的节点上执行启动命令:start-all.sh。

三、验证Hadoop集群1. 查看Hadoop进程:在NameNode所在的节点上执行jps命令,查看Hadoop进程是否启动成功。

2. 查看Hadoop日志:在NameNode所在的节点上查看Hadoop的日志文件,确认是否有错误信息。

3. 访问Hadoop Web界面:在浏览器中输入NameNode的地址和端口号,访问HadoopWeb界面,确认Hadoop集群是否正常运行。

GZ033 大数据应用开发赛题第10套

2023年全国职业院校技能大赛赛题第10套赛项名称:大数据应用开发英文名称: Big Data Application Development赛项组别:高等职业教育组赛项编号: GZ033背景描述工业互联网是工业全要素、全产业链、全价值链的全面连接,是人、机、物、工厂互联互通的新型工业生产制造服务体系,是互联网从消费领域向生产领域、从虚拟经济向实体经济拓展的核心载体,是建设现代化经济体系、实现高质量发展和塑造全球产业竞争力的关键支撑,工业大数据则是工业互联网实现工业要素互联之后的核心价值创造者。随着大数据行业的发展,工业数据收集呈现时间维度不断延长、数据范围不断扩大、数据粒度不断细化的趋势。以上三个维度的变化使得企业所积累的数据量以加速度的方式在增加,最终构成了工业大数据的集合。为完成工业大数据分析工作,你所在的小组将应用大数据技术,以Scala作为整个项目的基础开发语言,基于大数据平台综合利用Hudi、Spark、Flink、Vue.js等技术,对数据进行处理、分析及可视化呈现,你们作为该小组的技术人员,请按照下面任务完成本次工作。

任务A:大数据平台搭建(容器环境)(15分)环境说明:子任务一:Hadoop HA安装配置本任务需要使用root用户完成相关配置,安装Hadoop需要配置前置环境。

命令中要求使用绝对路径,具体要求如下:1、从宿主机/opt目录下将文件hadoop-3.1.3.tar.gz、jdk-8u212-linux-x64.tar.gz,apache-zookeeper-3.5.7-bin.tar.gz复制到容器Master中的/opt/software路径中(若路径不存在,则需新建),分别将Master节点Hadoop、ZooKeeper、JDK安装包解压到/opt/module路径中(若路径不存在,则需新建),其中将JDK、Hadoop解压命令复制并粘贴至客户端桌面【Release\任务A提交结果.docx】中对应的任务序号下;2、请完成host相关配置,将三个节点分别命名为master、slave1、slave2并做免密登录,修改容器中/etc/profile文件,设置JDK环境变量并使其生效,分发jdk至slave1、slave2中,均配置完毕后在Master节点分别执行“java -version”和“javac”命令,将命令行执行结果分别截图并粘贴至客户端桌面【Release\任务A提交结果.docx】中对应的任务序号下;3、配置好zookeeper,其中zookeeper使用集群模式,分别在master、slave1、slave2作为其集群的节点,使用zkServer.sh status获取zookeeper服务端状态,将命令和结果截图粘贴至客户端桌面【Release\任务A提交结果.docx】中对应的任务序号下(注:只截取三个节点中zookeeper server 角色模式为leader的节点);4、配置好Hadoop HA,请将nodes.hadoopcluster设置为nn1、nn2,同时yarn.resourcemanager.ha.rm-ids设置为rm1、rm2,并在Master启动nn1与rm1,在slave1启动nn2与rm2,将master、slave1、slave2均作为datanode,分发hadoop至slave1、slave2中,启动yarn与hdfs的HA集群(Hadoop HA集群),并在Master节点上使用命令分别查看服务nn2与rm2进程状态,并将查看命令及结果截图粘贴至客户端桌面【Release\任务A提交结果.docx】中对应的任务序号下;5、Hadoop HA配置并启动完毕后,使用jps在slave1节点查看服务进程,将查看命令及结果截图粘贴至客户端桌面【Release\任务A提交结果.docx】中对应的任务序号下。

hadoop安装与配置总结与心得

hadoop安装与配置总结与心得安装与配置Hadoop是一个相对复杂的任务,但如果按照正确的步骤进行,可以顺利完成。

以下是我在安装与配置Hadoop 过程中的总结与心得:1. 首先,确保你已经满足Hadoop的系统要求,并且已经安装了Java环境和SSH。

2. 下载Hadoop的压缩包,并解压到你想要安装的目录下。

例如,解压到/opt/hadoop目录下。

3. 配置Hadoop的环境变量。

打开你的.bashrc文件(或者.bash_profile文件),并添加以下内容:```shellexport HADOOP_HOME=/opt/hadoopexport PATH=$PATH:$HADOOP_HOME/bin```保存文件后,执行source命令使其生效。

4. 配置Hadoop的核心文件。

打开Hadoop的配置文件core-site.xml,并添加以下内容:```xml<configuration><property><name>fs.defaultFS</name><value>hdfs://localhost:9000</value></property></configuration>```5. 配置Hadoop的HDFS文件系统。

打开Hadoop的配置文件hdfs-site.xml,并添加以下内容:```xml<configuration><property><name>dfs.replication</name><value>1</value></property></configuration>```这里的dfs.replication属性指定了数据块的副本数量,可以根据实际情况进行调整。

6. 配置Hadoop的MapReduce框架。

Hadoop详细安装配置过程

1.下载并安装安装sshsudo apt-get install openssh-server openssh-client3.搭建vsftpd#sudo apt-get update#sudo apt-get install vsftpd配置参考???????????????????的开始、关闭和重启$sudo /etc/vsftpd start?? #开始$sudo /etc/vsftpd stop??? #关闭$sudo /etc/vsftpd restart?? #重启4.安装sudo chown -R hadoop:hadoop /optcp /soft/ /optsudo vi /etc/profilealias untar='tar -zxvf'sudo source /etc/profilesource /etc/profileuntar jdk*环境变量配置# vi /etc/profile●在profile文件最后加上# set java environmentexport JAVA_HOME=/opt/export CLASSPATH=.:$JAVA_HOME/lib/:$JAVA_HOME/lib/export PATH=$JAVA_HOME/bin:$PATH配置完成后,保存退出。

●不重启,更新命令#source /etc/profile●测试是否安装成功# Java –version?其他问题:出现unable to resolve host 解决方法参考??开机时停在 Starting sendmail 不动了的解决方案参考? 安装软件时出现 E: Unable to locate package vsftpd 参考? vi/vim 使用方法讲解--------------------------------------------克隆master虚拟机至node1 、node2分别修改master的主机名为master、node1的主机名为node1、node2的主机名为node2 (启动node1、node2系统默认分配递增ip,无需手动修改)分别修改/etc/hosts中的ip和主机名(包含其他节点ip和主机名)---------配置ssh免密码连入hadoop@node1:~$ ssh-keygen -t dsa -P ''-f ~/.ssh/id_dsaGenerating public/private dsa key pair.Created directory '/home/hadoop/.ssh'.Your identification has been saved in/home/hadoop/.ssh/id_dsa.Your public key has been saved in/home/hadoop/.ssh/.The key fingerprint is:SHA256:B8vBju/uc3kl/v9lrMqtltttttCcXgRkQPbVoU hadoop@node1The key's randomart image is:+---[DSA 1024]----+|....|| o+.E .||. oo +||..++||o +. o ooo +||=o.. o. ooo. o.||*o....+=o .+++.+|+----[SHA256]-----+hadoop@node1:~$ cd .sshhadoop@node1:~/.ssh$ ll总用量16drwx------ 2 hadoop hadoop 4096 Jul 24 20:31 ./drwxr-xr-x 18 hadoop hadoop 4096 Jul 2420:31../-rw------- 1 hadoop hadoop 668 Jul 24 20:31 id_dsa-rw-r--r-- 1 hadoop hadoop 602 Jul 24 20:31hadoop@node1:~/.ssh$ cat >> authorized_keyshadoop@node1:~/.ssh$ ll总用量20drwx------ 2 hadoop hadoop 4096 Jul 24 20:32 ./drwxr-xr-x 18 hadoop hadoop 4096 Jul 2420:31../-rw-rw-r-- 1 hadoop hadoop 602 Jul 24 20:32 authorized_keys-rw------- 1 hadoop hadoop 668 Jul 24 20:31 id_dsa-rw-r--r-- 1 hadoop hadoop 602 Jul 24 20:31单机回环ssh免密码登录测试hadoop@node1:~/.ssh$ ssh localhostThe authenticity of host'localhost ()' can't be established.ECDSA key fingerprint is SHA256:daO0dssyqt12tt9yGUauImOh6tt6A1SgxzSfSmpQqJVEiQTxas.Are you sure you want to continue connecting (yes/no) yesWarning: Permanently added 'localhost'(ECDSA)to the list of known hosts.Welcome to Ubuntu (GNU/Linux x86_64)* Documentation: packages can be updated.178 updates are security updates.New release' LTS' available.Run 'do-release-upgrade'to upgrade to it.Last login: Sun Jul 2420:21:392016fromhadoop@node1:~$ exit注销Connection to localhost closed.hadoop@node1:~/.ssh$出现以上信息说明操作成功,其他两个节点同样操作让主结点(master)能通过SSH免密码登录两个子结点(slave)hadoop@node1:~/.ssh$ scp hadoop@master:~/.ssh/./The authenticity of host'master ()' can't be established.ECDSA key fingerprint is SHA256:daO0dssyqtt9yGUuImOh646A1SgxzSfatSmpQqJVEiQTxas.Are you sure you want to continue connecting (yes/no) yesWarning: Permanently added 'master,'(ECDSA)to the list of known hosts.hadoop@master's password:100%603 s 00:00 hadoop@node1:~/.ssh$ cat >> authorized_keys如上过程显示了node1结点通过scp命令远程登录master结点,并复制master的公钥文件到当前的目录下,这一过程需要密码验证。

hadoop完全分布模式Hadoop集群安装配置

hadoop 完全分布模式Hadoop 集群安装配置本来这篇⽂章该在去年11⽉底写出来的,被各种繁杂的事情所烦扰,再者⽹络上也有⾮常多⽐较完善的配置的⽂章,但是依旧是表述不太清晰。

依旧写个Step By Step 的教程,留待⼰⽤。

Hadoop 的部署环境是经过虚拟化之后的四台主机,OS 是Ubuntu Server10.04。

(XenServer5.6兼容的OS 并不包括Ubuntu ,将Ubuntu 转成PV 也是⼀个折腾的过程,另⽂介绍)。

Hadoop 的版本号依旧是:0.20.2.安装Java 环境如上⼀讲所⽰。

主机名及其IP 地址对应如下:Slave&TaskTracker:dm1,IP:192.168.0.17;(datanode)Slave&TaskTracker:dm2,IP:192.168.0.18;(datanode)Slave&TaskTracker:dm3,IP:192.168.0.9;(datanode)Master&JobTracker:dm4,IP:192.168.0.10;(namenode)Master 是Hadoop 集群的管理节点,重要的配置⼯作都在它上⾯,⾄于它的功能和作⽤请参考。

具体配置步骤如下:⼀.修改各个节点(dm1-dm4)的HostName ,命令如下:如下图所⽰例:⼆.在host 中添加机器的hostname 和IP ,⽤以通讯。

Master 需要知道所有的slave 的信息。

对应的slave 只需要知道Master 和⾃⾝的信息即可。

命令如下:Master(dm4)的hosts 配置应该如下图所⽰:其它的slave(dm3……)的hosts 配置应该如下图所⽰:三.Hadoop 核⼼代码需要配置conf ⽂件夹⾥⾯的core-site.xml,hdfs-site.xml,mapread-site.xml,mapred-site.xml ,hadoop-env.sh 这⼏个⽂件。

hadoop——安装配置及简单API操作

hadoop——安装配置及简单API操作记录下hadoop集群的安装配置过程,步骤还挺多的,⽅便以后查看复习。

1、关闭防⽕墙# 关闭命令service iptables stopsystemctl stop firewalld.service# 永久关闭防⽕墙chkconfig iptables off# 查看防⽕墙关闭状态service iptables statusView Code2、安装GCCyum install gccView Code3、安装jdk配置环境变量cd download/pwdtar -zxf jdk-8u162-linux-x64.tar.gzlsmv jdk1.8.0_162/ javamv java/ /usr/local/cd /usr/local/java/lsView Code编辑配置⽂件vi /etc/profile后续补图。

刷新配置⽂件source profile检测javajavac4、在hosts中添加主、从主机名vi /etc/hosts后续补图。

5、配置免密登录ssh-keygen -t dsa -P '' -f ~/.ssh/id_dsacat ~/.ssh/id_dsa.pub >> ~/.ssh/authorized_keysView Code打开authorized_keys,将主从(t1 t2 t3)中的私钥配置成⼀样的后续补图。

6、安装hadoop配置环境变量cd download/tar -zxf hadoop-2.7.1.tar.gzlscdmkdir hadoopservercd hadoopserver/cd /cdcd download/mv hadoop-2.7.1 /root/hadoopserver/cdcd hadoopserver/View Code编辑配置⽂件vi /etc/profile后续补图。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

细细品味 Hadoop——Hadoop集群(第5期)精华集锦csAxp虾皮工作室/xia520pi/2012 年 4 月 30 日Hadoop 集群(第 5期)——Hadoop 安装配置1、集群部署介绍1.1 Hadoop 简介Hadoop 是Apache 软件基金会旗下的一个开源分布式计算平台。

以Hadoop分布式文件系统(HDFS ,Hadoop Distributed Filesystem )和 MapReduce (GoogleMapReduce 的开源实现)为核心的 Hadoop 为用户提供了系统底层细节透明的分布式基础架构。

对于 Hadoop 的集群来讲,可以分成两大类角色:Master 和 Salve 。

一个 HDFS 集群是 由一个 NameNode 和若干个 DataNode 组成的。

其中 NameNode 作为主服务器,管理文件系 统的命名空间和客户端对文件系统的访问操作;集群中的 DataNode 管理存储的数据。

MapReduce 框架是由一个单独运行在主节点上的 JobTracker 和运行在每个集群从节点的 TaskTracker 共同组成的。

主节点负责调度构成一个作业的所有任务,这些任务分布在不同 的从节点上。

主节点监控它们的执行情况,并且重新执行之前的失败任务;从节点仅负责由 主节点指派的任务。

当一个 Job 被提交时,JobTracker 接收到提交作业和配置信息之后,就 会将配置信息等分发给从节点,同时调度任务并监控 TaskTracker 的执行。

从上面的介绍可以看出,HDFS 和 MapReduce 共同组成了 Hadoop 分布式系统体系结构 的核心。

HDFS 在集群上实现分布式文件系统,MapReduce 在集群上实现了分布式计算和 任务处理。

HDFS 在 MapReduce 任务处理过程中提供了文件操作和存储等支持,MapReduce 在 HDFS 的基础上实现了任务的分发、跟踪、执行等工作,并收集结果,二者相互作用, 完成了 Hadoop 分布式集群的主要任务。

1.2环境说明集群中包括 4个节点:1个 Master ,3个 Salve ,节点之间局域网连接,可以相互 ping 通,具体集群信息可以查看“Hadoop 集群(第 2期)”。

节点 IP 地址分布如下:机器名称IP 地址Master.Hadoop192.168.1.2 192.168.1.3 192.168.1.4 192.168.1.5 Salve1.HadoopSalve2.HadoopSalve3.Hadoop 四个节点上均是 CentOS6.0系统,并且有一个相同的用户 hadoop 。

Master 机器主要配置 NameNode 和 JobTracker 的角色,负责总管分布式数据和分解任务的执行;3个 Salve 机 器配置 DataNode 和 TaskTracker 的角色,负责分布式数据存储以及任务的执行。

其实应该还 应该有 1个 Master 机器,用来作为备用,以防止 Master 服务器宕机,还有一个备用马上启用。

后续经验积累一定阶段后补上一台备用Master机器。

1.3网络配置Hadoop集群要按照1.2小节表格所示进行配置,我们在“Hadoop集群(第1期)”的CentOS6.0安装过程就按照提前规划好的主机名进行安装和配置。

如果实验室后来人在安装系统时,没有配置好,不要紧,没有必要重新安装,在安装完系统之后仍然可以根据后来的规划对机器的主机名进行修改。

下面的例子我们将以Master机器为例,即主机名为“Master.Hadoop”,IP为“192.168.1.2”进行一些主机名配置的相关操作。

其他的Slave机器以此为依据进行修改。

1)查看当前机器名称用下面命令进行显示机器名称,如果跟规划的不一致,要按照下面进行修改。

hostname上图中,用“hostname”查“Master”机器的名字为“Master.Hadoop”,与我们预先规划的一致。

2)修改当前机器名称假定我们发现我们的机器的主机名不是我们想要的,通过对“/etc/sysconfig/network”文件修改其中“HOSTNAME”后面的值,改成我们规划的名称。

这个“/etc/sysconfig/network”文件是定义hostname和是否利用网络的不接触网络设备的对系统全体定义的文件。

设定形式:设定值=值“/etc/sysconfig/network”的设定项目如下:NETWORKING是否利用网络GATEWAY默认网关IPGATEWAYDEV默认网关的接口名HOSTNAME主机名DOMAIN域名用下面命令进行修改当前机器的主机名(备注:修改系统文件一般用root用户)vim /etc/sysconfig/network通过上面的命令我们从“/etc/sysconfig/network”中找到“HOSTNAME”进行修改,查看内容如下:3)修改当前机器 IP假定我们的机器连IP在当时安装机器时都没有配置好,那此时我们需要对“ifcfg-eth0”文件进行配置,该文件位于“/etc/sysconfig/network-scripts”文件夹下。

在这个目录下面,存放的是网络接口(网卡)的制御脚本文件(控制文件),ifcfg- eth0 是默认的第一个网络接口,如果机器中有多个网络接口,那么名字就将依此类推ifcfg-eth1,ifcfg-eth2,ifcfg- eth3,……。

这里面的文件是相当重要的,涉及到网络能否正常工作。

设定形式:设定值=值设定项目项目如下:DEVICE接口名(设备,网卡)BOOTPROTO IP的配置方法(static:固定IP,dhcpHCP,none:手动)HWADDR MAC地址ONBOOT系统启动的时候网络接口是否有效(yes/no)TYPE网络类型(通常是Ethemet)NETMASK网络掩码IPADDR IP地址IPV6INIT IPV6是否有效(yes/no)GATEWAY默认网关IP地址查看“/etc/sysconfig/network-scripts/ifcfg-eth0”内容,如果IP不复核,就行修改。

如果上图中IP与规划不相符,用下面命令进行修改:vim /etc/sysconfig/network-scripts/ifcgf-eth0修改完之后可以用“ifconfig”进行查看。

4)配置hosts文件(必须)“/etc/hosts”这个文件是用来配置主机将用的DNS服务器信息,是记载LAN内接续的各主机的对应[HostName和IP]用的。

当用户在进行网络连接时,首先查找该文件,寻找对应主机名(或域名)对应的IP地址。

我们要测试两台机器之间知否连通,一般用“ping机器的IP”,如果想用“ping机器的主机名”发现找不见该名称的机器,解决的办法就是修改“/etc/hosts”这个文件,通过把LAN内的各主机的IP地址和HostName的一一对应写入这个文件的时候,就可以解决问题。

例如:机器为“Master.Hadoop:192.168.1.2”对机器为“Salve1.Hadoop:192.168.1.3”用命令“ping”记性连接测试。

测试结果如下:从上图中的值,直接对IP地址进行测试,能够ping通,但是对主机名进行测试,发现没有ping通,提示“unknown host——未知主机”,这时查看“Master.Hadoop”的“/etc/hosts”文件内容。

发现里面没有“192.168.1.3 Slave1.Hadoop ”内容,故而本机器是无法对机器的主机名为“Slave1.Hadoop ”解析。

在进行 Hadoop 集群配置中,需要在“/etc/hosts ”文件中添加集群中所有机器的 IP 与主机名,这样 Master 与所有的 Slave 机器之间不仅可以通过 IP 进行通信,而且还可以通过 主机名进行通信。

所以在所有的机器上的“/etc/hosts ”文件末尾中都要添加如下内容:192.168.1.2192.168.1.3192.168.1.4192.168.1.5 Master.Hadoop Slave1.Hadoop Slave2.Hadoop Slave3.Hadoop用以下命令进行添加:vim /etc/hosts添加结果如下:现在我们在进行对机器为“Slave1.Hadoop ”的主机名进行 ping 通测试,看是否能测试成功。

从上图中我们已经能用主机名进行 ping 通了,说明我们刚才添加的内容,在局域网内能进行 DNS 解析了,那么现在剩下的事儿就是在其余的 Slave 机器上进行相同的配置。

然 后进行测试。

(备注:当设置 SSH 无密码验证后,可以“scp ”进行复制,然后把原来的“hosts ” 文件执行覆盖即可。

)1.4所需软件1)JDK软件下载地址:/technetwork/java/javase/index.htmlJDK版本:jdk-6u31-linux-i586.bin2)Hadoop软件下载地址:/common/releases.htmlHadoop版本:hadoop-1.0.0.tar.gz1.5 VSFTP上传在“Hadoop集群(第3期)”讲了VSFTP的安装及配置,如果没有安装VSFTP可以按照该文档进行安装。

如果安装好了,就可以通过FlashFXP.exe软件把我们下载的 JDK6.0 和Hadoop1.0软件上传到“Master.Hadoop:192.168.1.2”服务器上。

刚才我们用一般用户(hadoop)通过FlashFXP软件把所需的两个软件上传了跟目下,我们通过命令查看下一下是否已经上传了。

从图中,我们的所需软件已经准备好了。

2、SSH无密码验证配置Hadoop运行过程中需要管理远端Hadoop守护进程,在Hadoop启动以后,NameNode是通过SSH(Secure Shell)来启动和停止各个DataNode上的各种守护进程的。

这就必须在节点之间执行指令的时候是不需要输入密码的形式,故我们需要配置SSH运用无密码公钥认证的形式,这样NameNode使用SSH无密码登录并启动DataName进程,同样原理,DataNode上也能使用SSH无密码登录到NameNode。

2.1安装和启动SSH协议在“Hadoop集群(第1期)”安装CentOS6.0时,我们选择了一些基本安装包,所以我们需要两个服务:ssh和rsync已经安装了。

可以通过下面命令查看结果显示如下:rpm –qa | grep opensshrpm –qa | grep rsync假设没有安装ssh和rsync,可以通过下面命令进行安装。